php 循环抓取网页内容

本文由优采云自然语言处理技术自动生成。优采云平台网站文章采集器,拥有上亿关键词库,按关键词采集,无需编写规则,NLP技术伪原创,机器学习算法文本鉴黄,指定采集最新内容,指定采集目标网站,是一个站长必备的数据采集工具。以下为优采云自动整理的关于 php 循环抓取网页内容 的内容:网络爬虫(又被称为网页蜘蛛,网络机器人,搜索引擎蜘蛛,在foaf社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动的抓取万维网信息的程序或者脚本,另外一些不常使用的名字还有蚂蚁,自动索引,模拟程序或者蠕虫。

那它的原理是由一个起始链接开始抓取网页内容,同时也采集网页上的链接,并将这些链接作为它下一步抓取的链接地址,如此循环,直到达到某个停止条件后才会停止。

抓取系统的功能:网页抓取、抓取调度、域名解析、死链检测、javascript 执行等。

。

。

。

。

爬虫抓取网站内容前会先抓取robots.txt,据此“自觉地”抓取或者不抓取该网页内容,其目的是保护网站数据和敏感信息、确保用户个人信息和隐私不被侵犯。

。

。

。

。

某网站反馈网站内容未被建索引,分析发现,网站抓取没有问题,但被抓取到的页面,都提示需要输入验证码才能查看全部页面,这类页面被判断为空短页面,这类页面在抓取后,会被判定为垃圾内容。

。

。

百度搜索引擎目前不主动抓取https网页,导致大部分https网页无法收录。

。

。

所有网页title, meta description, keywords都需要重新编写,必须根据网页内容进行编写(ibm中国网站的所有网页就是人工一个一个慢慢编写的。

网页结构改用div+css xhtm结构,利用div+css 进行网页左上角div层定位,把网页主要内容放在该层上并放置在代码的最前面,易于搜索引擎抓取文字内容以及增加主要文字内容的展示率。

网页最基础的组成元素部分就是内容,要想要好的收录让百度蜘蛛快速抓取必须满足2个必要的条件。

每次的抓取,总是需要从一个起始点开始,在得到这个起始点网页上的信息后,分析出新的地址加入抓取队列中,然后循环抓取,重复这样的过程,直到所有链接都分析完毕。

网络爬虫(又被称为网页蜘蛛,网络机器人,在 foaf 社区中间,更常被称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本,从中获取大量的信息。

。

。

java跟php都是可以用于网页开发的,这样很多同学不知道改学习哪种编程语言比较好,比较 php和jsp这两个web开发技术,在目前的情况是其实是比较php和java的web开发。

。

。

它是以asp、php、jsp或者cgi等网页文件形式存在的一种命令执行环境,也可以将其称做为一种网页后门。

还有一个是动态网页,多是以.asp、.jsp、.php形式存在的,现在的网站建设公司在做网站页面的时候,一般不采用动态网页了,因为对网站的后期优化没有好处,所以在北京网站制作中,都是在用的以.htm、.html等为后缀的静态或者伪静态网页。

上面说了如果网页内容最小宽大于body时会有水平滚动条,那么如果网页内容的高(一般来说网页元素的高不会设置百分比)大于vp的高(vp的高默认就是当前window的高,前面说过),那么就会出现垂直滚动条。

php中的循环结构大致有for循环,while循环,do{} while 循环以及foreach循环几种,不管哪种循环中,在php中跳出循环大致有这么几种方式:。

。

。

2,内容结构面包屑导航一定要做好,网站的内敛很重要,要让链路都循环起来,这样有利于访客访问,也利于搜索引擎的访问和抓取收录。

。

。

攻击者使用的很多搜索引擎优化工具(应用程序,通常作为php脚本编写,能够生成中毒网页以重定向访问者到恶意网站)都能够对用户进行区分,直接访问网站的一般用户,和从搜索引擎或搜索引擎抓取工具访问网站的用户。

这种网页被搜索引擎大量抓取,只能是占用网站宝贵的抓取配额,那么该如何避免这种情况呢。

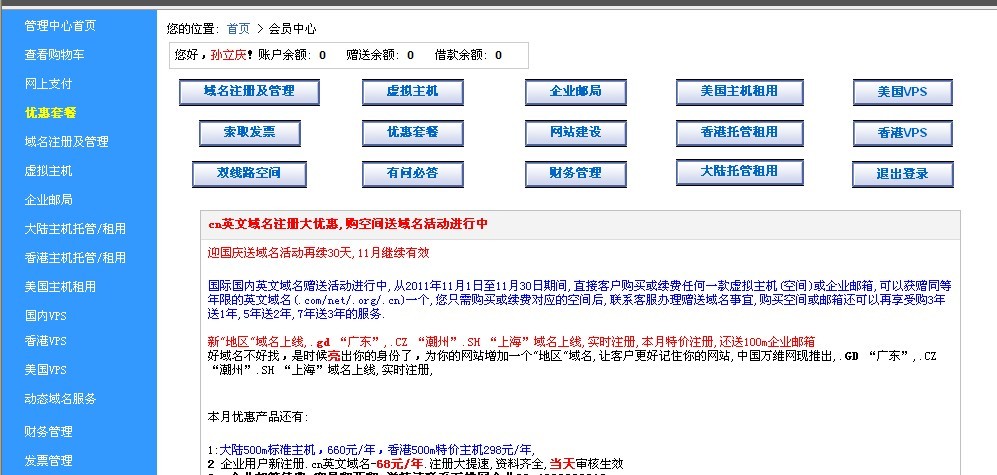

这样当我们在去访问.php的网页时,客户端会提示我们输入用户名和密码,否则看不得网页内容。以上就是优采云自动文章采集器整理的 php 循环抓取网页内容 内容,希望能对你有所帮助。

优采云采集器是一个根据用户提供的关键词,云端自动采集相关文章并发布到用户网站的网站采集器。它能够自动识别各种网页上的标题、正文等信息,不需要用户编写任何采集规则就可以实现全网采集。采集到内容后,会自动计算内容与所设定的关键词的相关度,只把相关的文章推送给用户。支持标题前缀、关键词自动加粗、插入固定链接、自动提取Tag标签、自动内链、自动配图、自动伪原创、内容过滤和替换、电话号码和网址清理、定时采集、百度主动提交等一系列SEO功能。用户只需设置好关键词和相关需求,就能实现全托管、零维护的网站内容更新。不限网站数量,不管是单个网站还是大批量站群,都可以非常方便的进行管理。