搜索引擎如何抓取网页( 搜索引擎爬虫怎么做代码去重,也就是第三部取)

优采云 发布时间: 2021-10-03 05:08搜索引擎如何抓取网页(

搜索引擎爬虫怎么做代码去重,也就是第三部取)

网页去重算法——如何与搜索引擎算法抗衡

不知道大家有没有仔细研究过搜索引擎爬虫爬取的过程。下面是一个简单的介绍:

一、Definite(你需要知道你要搜索的范围或网站要搜索的范围);百度提交,配合DNS,有爬虫入口

二、 Crawl(爬取网站的所有内容)

三、take(分析数据,去掉对我们没有用的数据);去重:Shingle 算法“SuperShinge 算法”I-Match 算法“SimHash 算法”

四、保存(按照我们想要的方式存储和使用)

五、表(可以根据数据类型通过一些图标显示)

搜索引擎的简单外观就是把页面抓取到数据库中,然后将页面存储到数据库中,然后检索页面在数据库中显示。所以里面有很多算法。到现在为止,搜索引擎一直是为了防止作弊,更好地满足用户的需求。改进了很多算法,具体的基本算法可以自己了解(点击:SEO算法-了解更多)。今天主要讲的是源码去重,也就是第三部分。

通过以上步骤可以理解,搜索引擎不可能将互联网上的所有页面都存储在数据库中。在将你的页面存入数据库之前,你必须先检查你的页面,检查你的页面是否被存储的页面重复,这也是为什么很多seoer想要做伪原创来增加收录的机会。

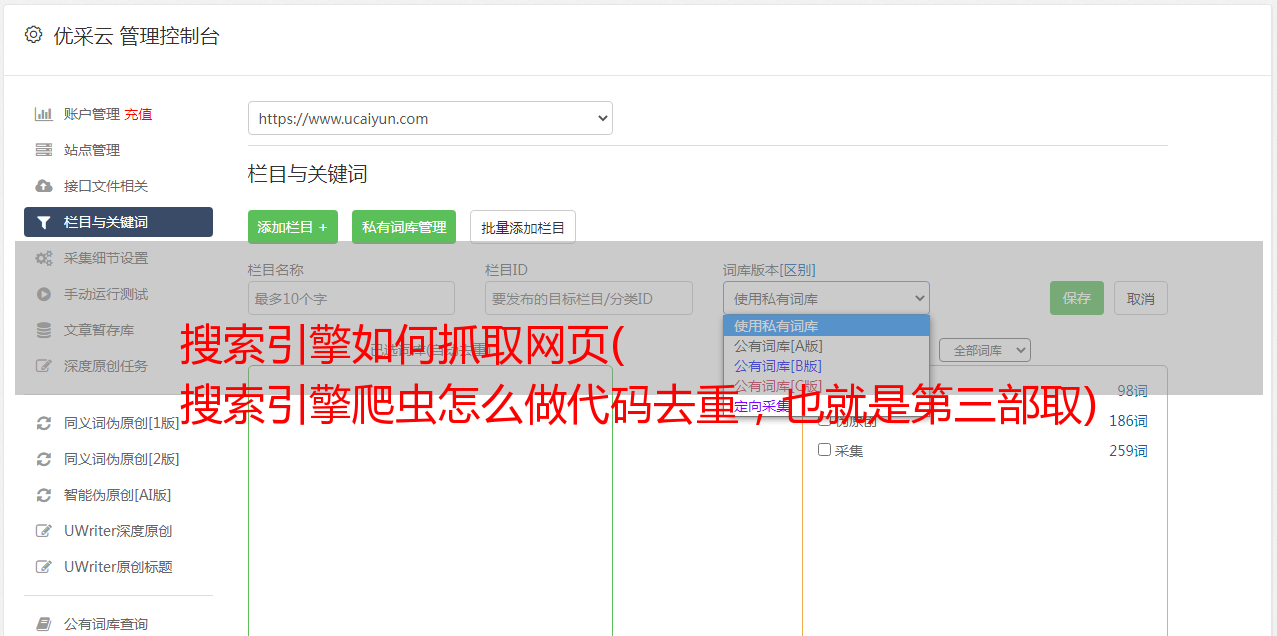

根据去重的基本算法,可以理解为页面去重分为代码去重和内容去重。如果我把别人的网站的模板程序原封不动地做成网站,那我需要怎么做去重呢?今天我将分享如何进行重复代码删除。

如图,可以看到在每个模板的class后面添加了自己的特色字符,这样既不影响CSS样式,又达到了去重、欺骗搜索引擎的效果,告诉它这是你没有的。已经看到的代码程序。

很多事情说起来简单,经过大量实际操作总结出来的。你需要做的更多,所以我会给你带来分歧的问题。

如果去重算法有效,那么网上那么多相同的程序网站的代码几乎都是一样的(很多程序都使用同一个模板:织梦、Empire等),为什么他们的都可以体重排名怎么做?很好?

他有去重算法的开发和升级。简单的说,就是开头的Shingle算法。SuperShinge算法升级为I-Match算法后,再升级为SimHash算法。现在每个搜索引擎的算法都是基于这些基础的。算法升级改进,大致原理可以理解了。

简单地说,搜索引擎给每个页面一个指纹。每个页面由许多小模块分层,一个页面由许多小模块组成,就像指纹由许多行组成。

知道了这个原理,我们就知道你现在做的伪原创是没有用的。打乱段落的顺序和改变一些单词不会影响页面指纹。

如果我可以复制他人的内容而不会被判定为重复内容,我该怎么办?

首先,了解一个机制。搜索引擎存储的页面数据是分层的。简单的说,当你输入一个搜索词时,它把优质层的数据排在第一位,其次是普通层和劣质层。我平时看到的很多高权重平台的内页排名都可以因为这个原因超过很多网站首页。

当两个网站程序代码几乎相同,内容几乎相同时,搜索引擎如何发现它们是重复的?

由于搜索引擎存储的数据量非常大,不可能每次存储新页面时都比较之前存储的所有页面。那么他就只能用算法来确定与新页面标题描述相关的高质量页面。将重复与新页面进行比较。如果重复度达到一定值,则判断为重复内容,被去重算法去除,而不是收录。如果不判断为重复内容,则为收录为劣等级别。当你想优化这个新页面以提高其排名并进入高质量层时,其相应的要求也会增加。它会调出更多的页面数据与之进行比较,而不仅仅是通过检索相关标题所描述的数据。在这种情况下,

这也是我们看到的一个现象,为什么很多抄袭的内容可以收录,却没有办法拿到好的排名。

如果我们复制一篇文章的文章,但是我们使用了不同的标题,那么对于搜索引擎来说,他将无法发现它是劣等级别的重复。这也解释了很多奇怪的现象,比如图片:

一个克隆的网站,由于标题不同,在爬取和去重的过程中搜索引擎没有找到,但是后来这个页面想要进入优质数据库,会被发现是一个重复,否 将给出一个很好的排名显示。

总结:市面上的伪原创工具没啥用,不影响页面指纹。如果非要复制别人修改过的标题,就得不到好的排名。新站前期可以通过修改标题添加收录和网站蜘蛛。在中期,您必须制作自己的内容,为良好的排名展示铺平道路。

如果你只是想复制别人的内容,放到自己的网站上,你怎么能把它变成高质量的内容呢?

文章转载:/