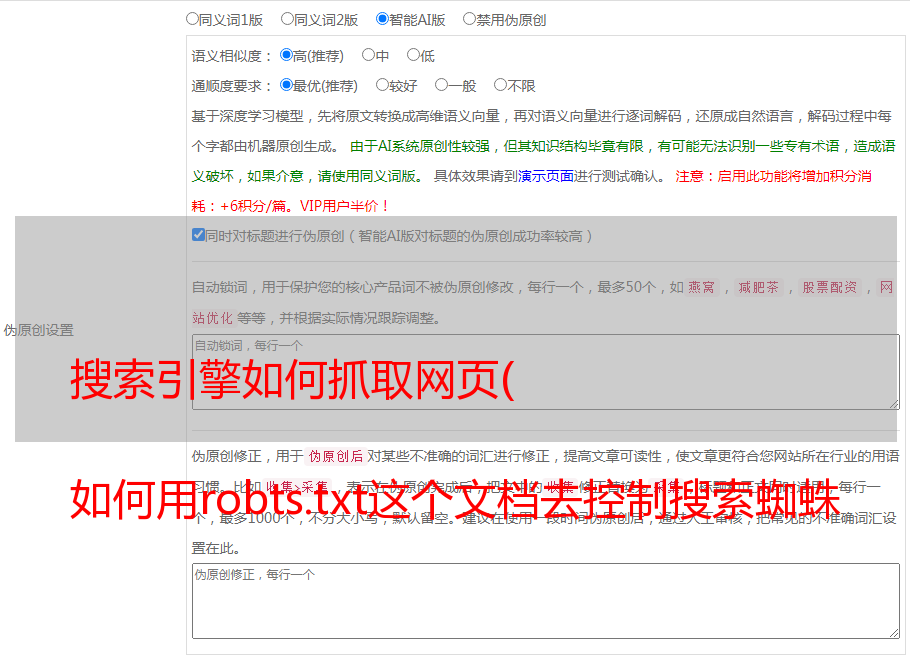

搜索引擎如何抓取网页( 如何用robts.txt这个文档去控制搜索蜘蛛网站站长)

优采云 发布时间: 2021-09-28 18:05搜索引擎如何抓取网页(

如何用robts.txt这个文档去控制搜索蜘蛛网站站长)

如何使用robots.txt防止搜索引擎爬(爬取)你的网站?

为了你的网站可以被其他人搜索到,搜索引擎爬虫,有时也被称为搜索机器人(bots)或搜索蜘蛛(spiders),会爬取你的网站,搜索可能会改变内容并重新- 更新搜索引擎的搜索和检索。

如何使用robts.txt控制搜索蜘蛛

网站站长可以使用robots.txt文档来指导搜索蜘蛛如何抓取这个网站。搜索引擎爬取网站时,会先读取robots.tx文件,并按照规则爬取网站。

※ 虽然robots.txt规则很重要,但搜索机器人不一定会遵守robot.txt规则,它只是一个操作策略。

※谷歌设置Crawl-delay必须在谷歌管理工具中设置。

※对于那些乱爬你的网站的劣质搜索蜘蛛,你应该研究如何使用.htamless中的User-agent来屏蔽不良搜索蜘蛛。

编辑并创建 robots.txt 文件

Robots.txt文件必须放在网站的根目录下,如果你的网站是可读的。

网址位置:

服务器位置:

/home/userna5/public_html/robots.txt

如果没有这个文档,可以使用纯文档文档新建一个robots.txt文档。

搜索引擎用户代理

对于搜索引擎蜘蛛的User-agent,使用robots.txt文件来控制是最常用的标准方法。

搜索蜘蛛爬取网站时,会被识别为User-agent。下面提供了一些参考示例

美国最常见的前三个搜索引擎用户代理:

谷歌机器人

雅虎!啜饮

宾博

最常被屏蔽的搜索引擎用户代理:

机器人

百度蜘蛛

放大镜

MJ12bot

Yandex机器人

搜索引擎蜘蛛会使用robots.txt文档规则进行爬取网站

robots.txt 文件有很多规则来控制搜索蜘蛛如何抓取你网站。

User-agent:可以指定哪个User-agent适用,比如*是所有User-agent的通用搭配。

禁止:设置文档或文件夹不被搜索蜘蛛抓取。

设置所有搜索引擎延迟抓取

如果您的 网站 有 1000 页,搜索蜘蛛可能会在几分钟内检索所有 网站。但是,这可能会导致系统资源的过度使用,并在短时间内使所有网页过载。结果无法浏览网页。

30 秒的延迟将允许搜索蜘蛛在 8.3 小时内检索 1,000 个网页。

500 秒的延迟将允许搜索蜘蛛在 5.8 天内检索 1,000 个网页。

也可以设置Crawl-delay:所有搜索蜘蛛立即搜索。

用户代理: *

爬行延迟:30

允许搜索蜘蛛抓取所有网站

在默认的空白条件下,搜索引擎蜘蛛仍然会抓取你的网站,但你仍然可以指定它是允许的。

用户代理: *

不允许:

不允许搜索蜘蛛抓取所有网站

用户代理: *

不允许: /

不允许搜索蜘蛛抓取特定的网站

您可以使用这些规则来禁止特定搜索引擎蜘蛛抓取您的 网站。

用户代理:百度蜘蛛

不允许: /

不允许所有搜索蜘蛛抓取特定文档

如果一些文件如contactus.htm、index.htm、store.htm不想被搜索蜘蛛抓取,我可以使用:

用户代理: *

禁止:/contactus.htm

禁止:/index.htm

禁止:/store.htm

除了指定的,所有搜索蜘蛛都不允许爬行

如果我们只想让 Googlebot 抓取我们的 /private/ 目录,而不允许其他搜索蜘蛛抓取,我们可以这样使用它:

用户代理: *

不允许: /

用户代理:Googlebot

禁止:/私人/

当Googlebot 读取我的robots.txt 文件时,它会理解该文件的内容,并且不会禁止抓取所有目录。

如果您只想抓取和检索一个网页,请参考(使用标签阻止搜索蜘蛛检索网页)