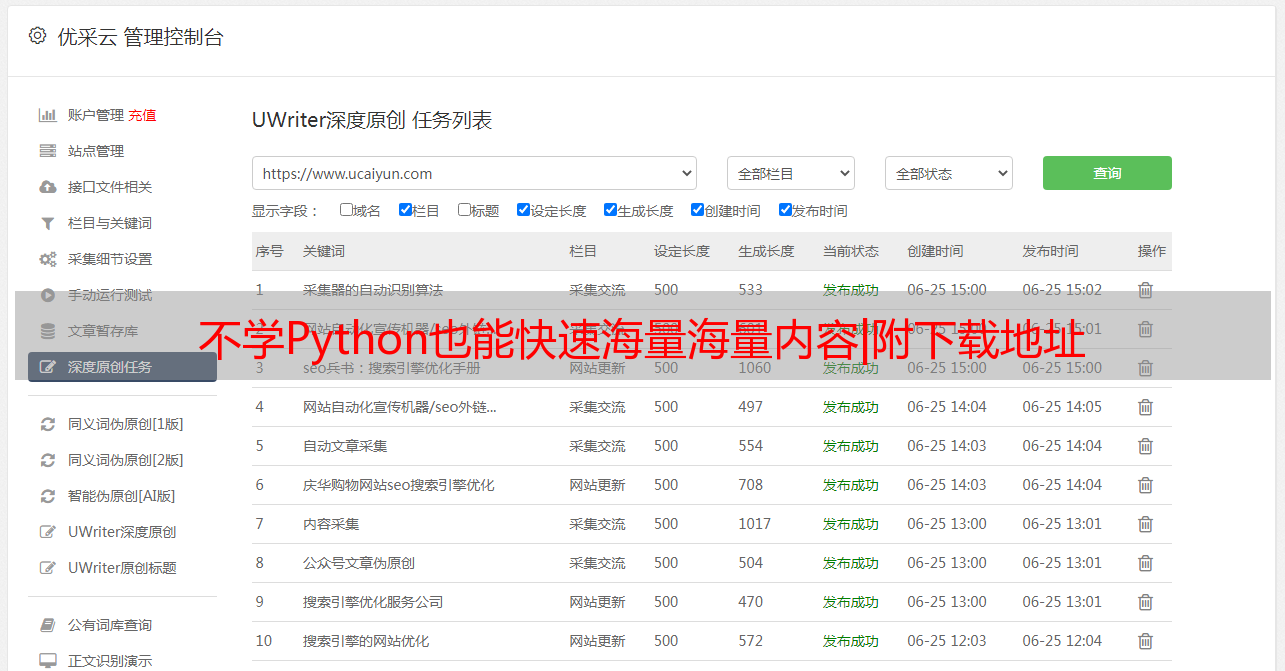

不学Python也能快速海量海量内容|附下载地址

优采云 发布时间: 2021-07-18 18:04不学Python也能快速海量海量内容|附下载地址

不知道你的朋友圈里是不是总能看到类似的广告,“Excel 用 Python 加班只需 3 分钟”,“我每天都能准时下班,因为我学了 Python”。看来,Python 已经成为了当代的年轻人。人的基本技能。

▲朋友圈广告

确实,Python作为一种简单易用的编程语言,在自动化办公中非常有用,尤其是抓取网页数据,在这样的大数据时代尤为重要。

爬取网页数据,又称“网络爬虫”,可以帮助我们快速采集互联网海量内容,进行深度数据分析和挖掘。比如抢大网站的排行榜,抢大购物网站的价格信息等等,而我们每天使用的搜索引擎都是“网络爬虫”。

但毕竟学习一门语言的成本太高了。有没有什么方法可以不学习Python就达到目标?当然,借助Chrome浏览器的“Web Scraper”插件,无需编写代码即可快速抓取大量内容。

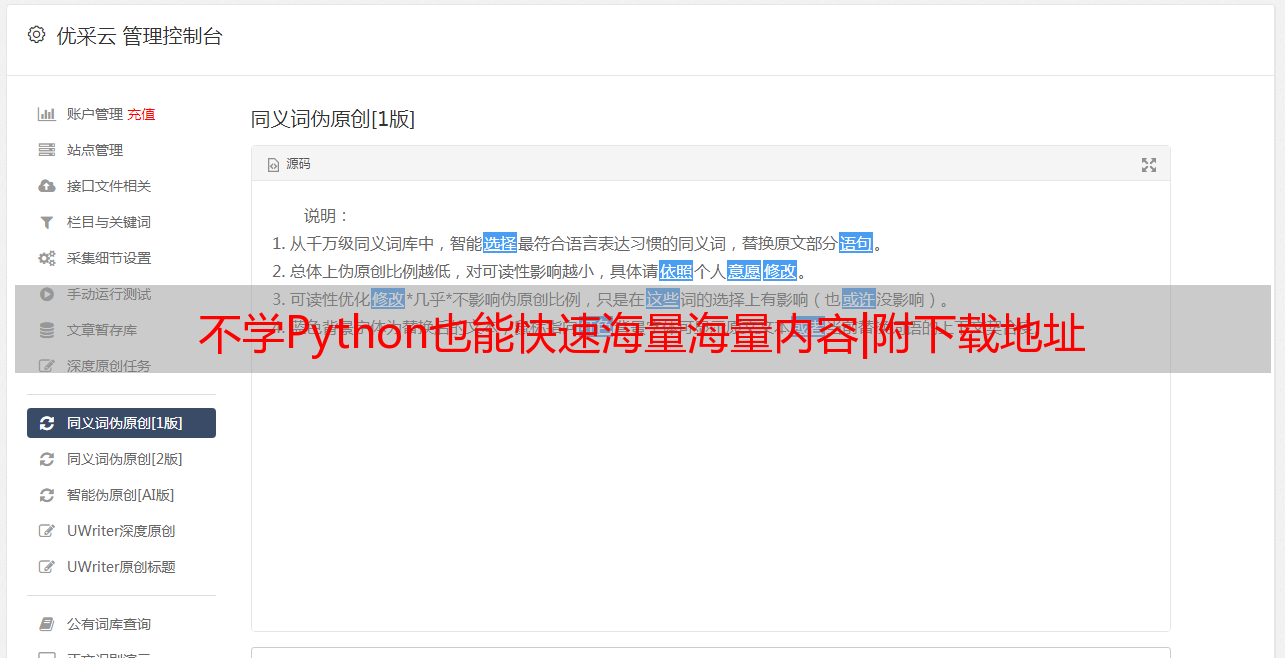

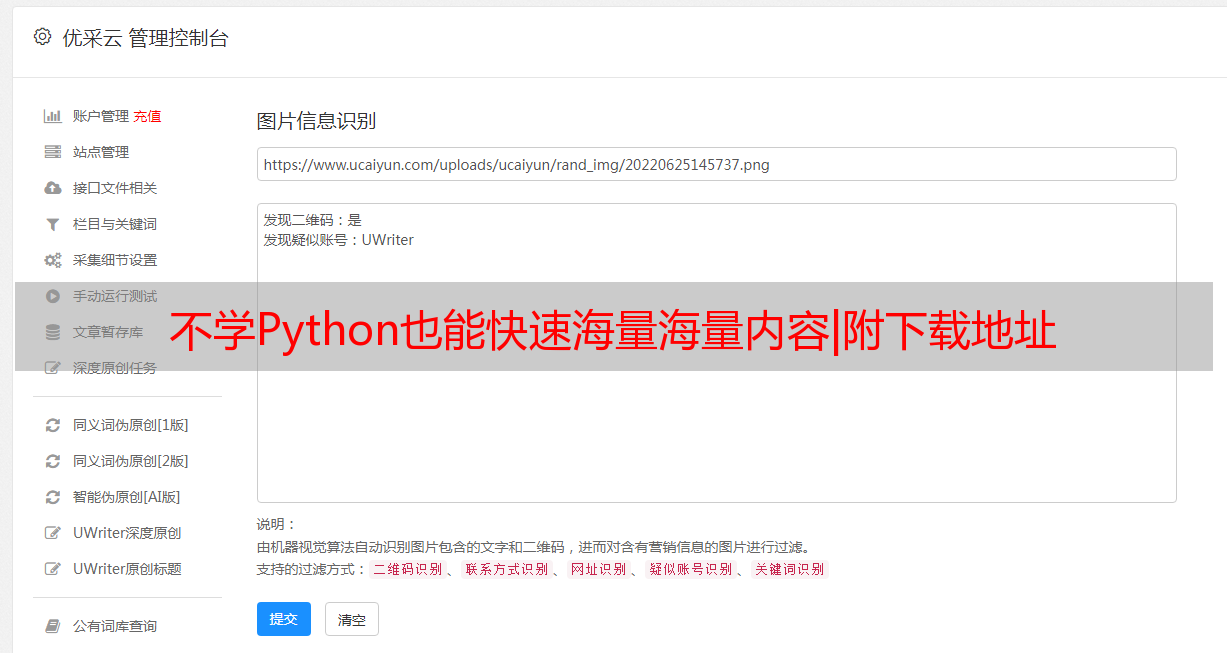

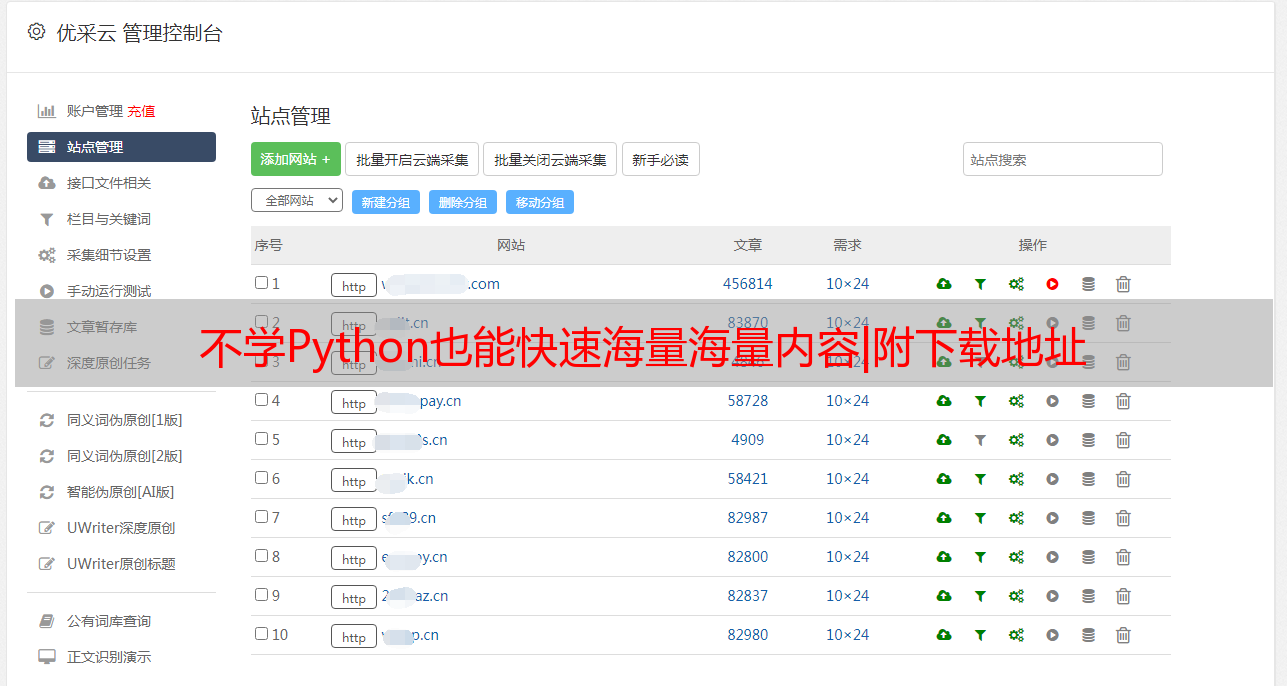

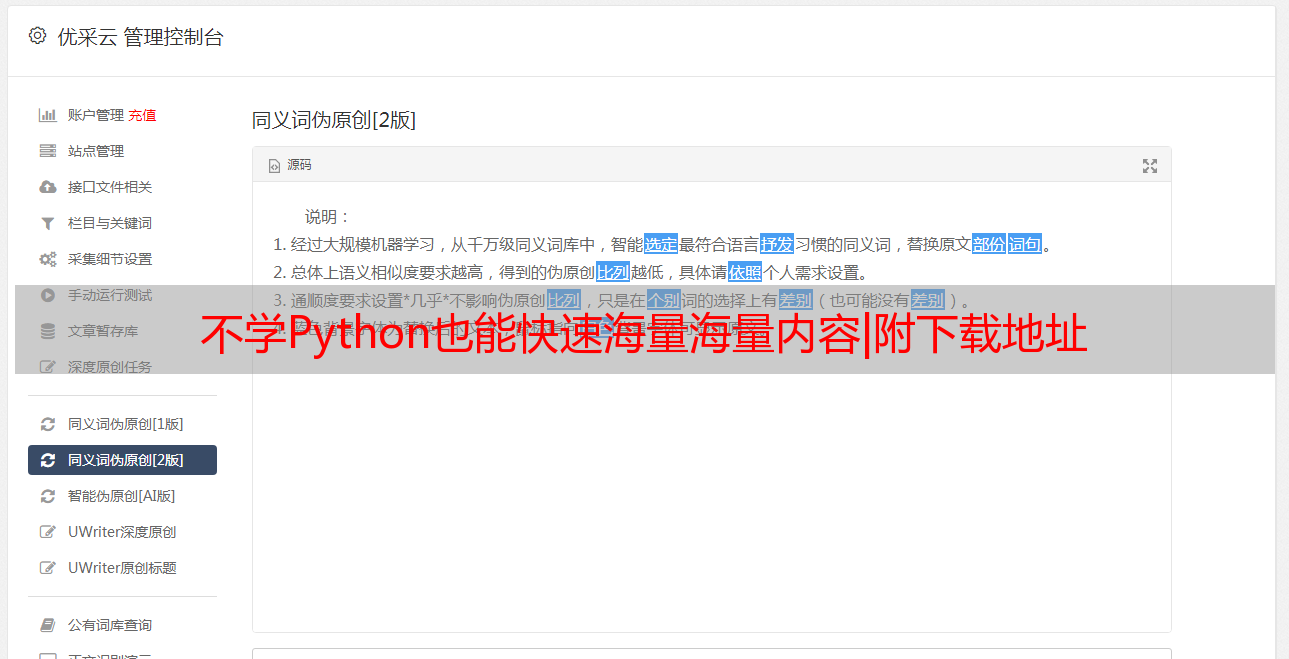

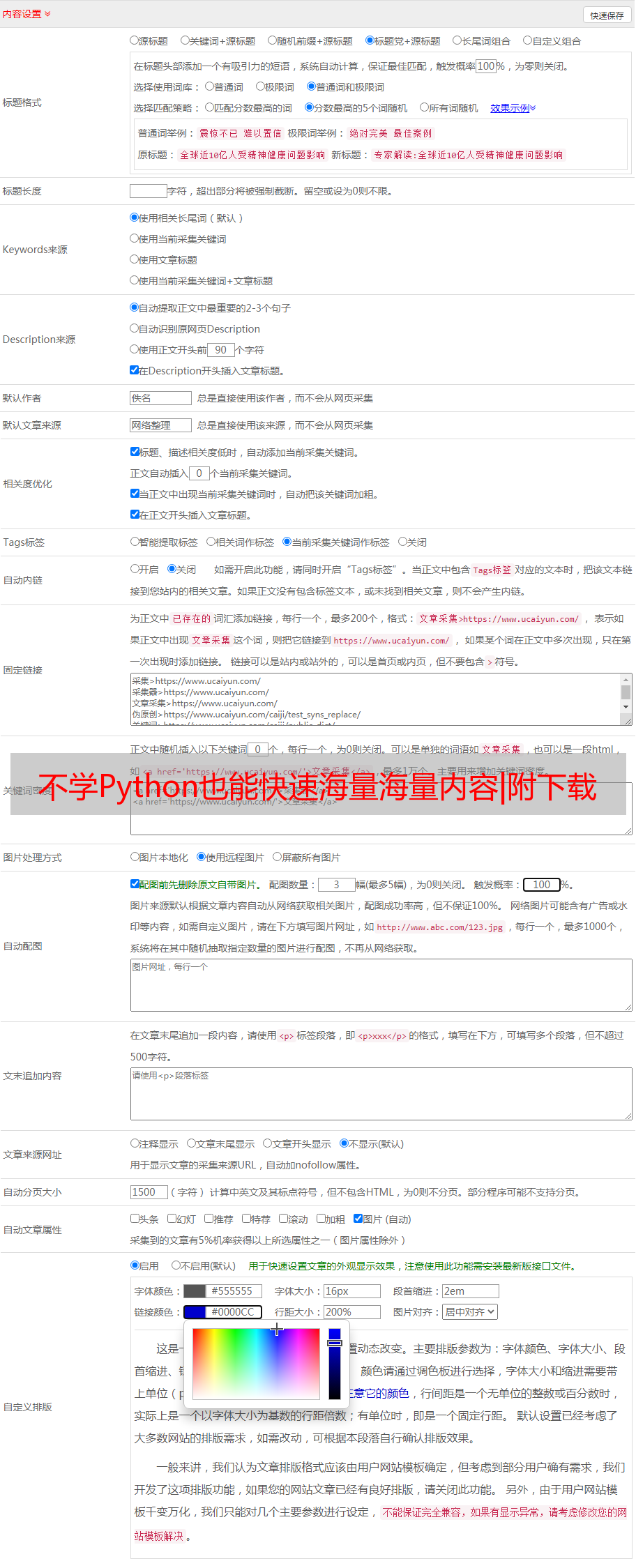

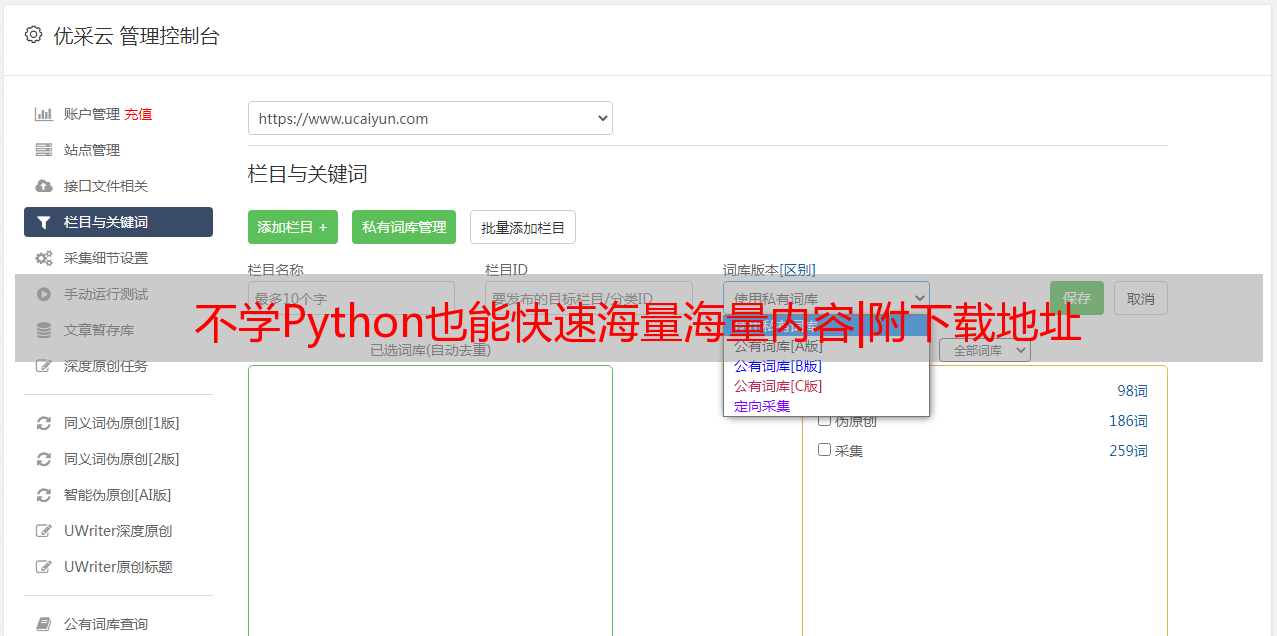

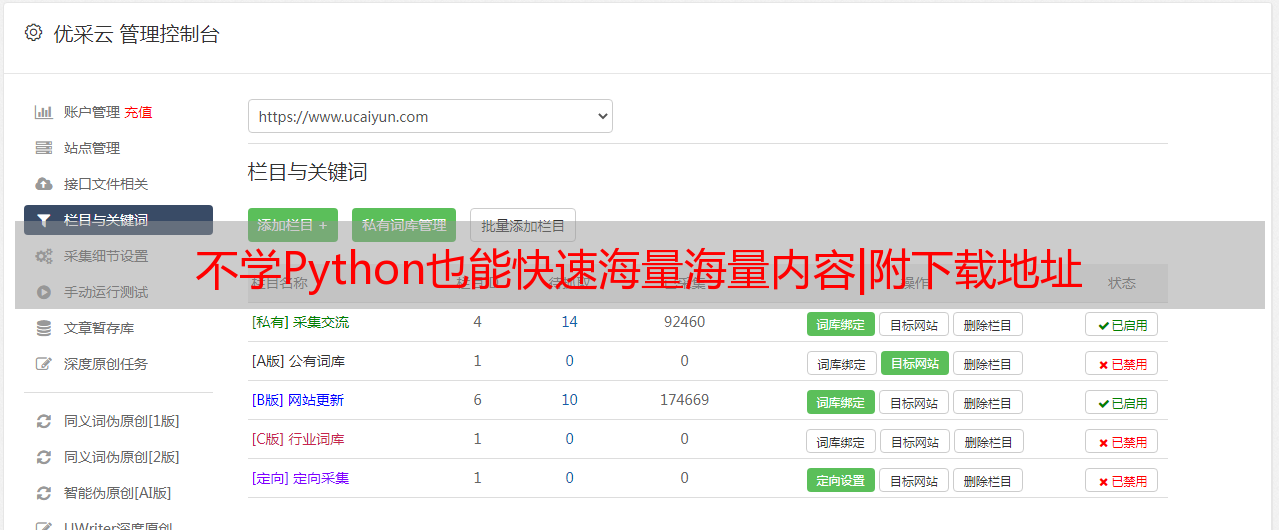

优采云directory

以page-bilibili排名的多条信息为例

自动翻页抓取——以豆瓣电影Top250为例

抓取副页内容-以知乎热榜为例

抓取页面上的多条信息-以BiliBili排名为例

安装“Web Scraper”后,在浏览器中按F12进入开发者模式,可以在最后一个标签页看到“Web Scraper”菜单。需要注意的是,如果开发者模式面板不在底部,会提示必须放在浏览器下方才能继续。

在菜单中选择“新建站点地图-创建站点地图”,新建站点地图,填写名称和起始地址即可开始。这里以BiliBili排名为例介绍如何抓取页面上的多条信息,起始地址设置为“”。

这里我们需要抓取“视频标题”、“播放量”、“弹幕数”、“上位大师”和“综合评分”,所以首先要为每条记录创建一个包装器。

点击“Add new selector”,id填写“wrapper”,type选择“element”,然后点击“selector”,选择一条记录的外框,外包框需要收录以上所有信息,然后选择第二个这样,你会发现页面上的所有记录都被自动选中了,点击“完成选择”完成数据选择。记得勾选“Multiple”,确保捕获到多条记录,最后保存选择器。

返回后,点击刚才的wrapper,进入二级路径,创建“title”选择器,id填写“video title”,type选择“text”,点击“selector”找到第一个记录突出显示。这是因为我们预先将其设置为包装器。在边框中选择标题,然后单击“完成选择”完成标题选择。注意这里不需要勾选“Multiple”,最后保存选择器。

同样,我们为“播放音量”、“弹幕数”、“上位大师”和“综合得分”创建选择器。选中后,可以通过“数据查看”预览是否选中了想要的内容。此外,您还可以通过菜单栏中的“站点地图bilibili_ranking-Selector graph”直观地查看树状结构。

继续选择刚才菜单下的“Scrape”,开始创建爬取任务。单个网页的间隔时间和响应时间是默认的。点击“开始抓取”开始抓取。这时候浏览器会自动打开一个新页面,几秒后自动关闭,表示已经获取完成。

点击“刷新数据”刷新数据,或点击“站点地图bilibili_ranking-浏览”查看数据。您可以通过“Sitemap bilibili_ranking-Export data as CSV”下载为CSV格式文件。

▲BiliBili 排名

用 Excel 打开。由于“Web Scraper”抓取的内容是乱序的,需要对“综合评分”进行降序排序,恢复原来的排名结果。

自动翻页抓取——以豆瓣电影Top250为例

Bilibili 排名只有 100 条记录,而且都在一个网页上。有分页显示怎么办?这里以豆瓣电影Top250为例介绍自动翻页抓取。

同理,新建站点地图时,在填写起始地址之前,先观察豆瓣电影Top250的构成。一共250条记录,每页显示10条,分为25页。

每一页的URL都很规则,第一页的地址是“”,第二页只是把地址中的“start=0”改成了“start=25”,所以我们填写start时地址,可以填写“[0-250:25]&filter=”,其中start=[0-250:25]表示以25为步长从0到250获取,所以start为0、2 5、 分别等待 50 次。这样,“Web Scraper”就会逐页抓取数据。

下一步类似于BiliBili排名。创建“包装器”后,添加“电影名称”、“豆瓣评分”、“电影短评”和“豆瓣排名”选择器,然后开始爬取。

可以看到浏览器会逐页翻页抓取。在这里你只需要静静等待爬行完成即可。最终得到的数据按照“豆瓣排名”升序排列,得到豆瓣电影。 Top250名单。

▲豆瓣电影Top250

当然,这只是最简单的一种分页方式,很多网站地址不一定有类似的规则。因此,“Web Scraper”的分页方法比较多,但是相对来说也比较复杂。此处不再赘述。

抓取副页内容-以知乎热榜为例

以上已经完成了对网页单页和多页内容的抓取,但并不是每次都在一页上有现成的数据,所以需要进一步搜索二级页面。以知乎热榜为例,介绍如何抓取二级页面的“关注”和“浏览”。

首先,创建一个起始地址为“”的新站点地图。然后像之前一样创建“wrapper”,然后创建三个选择器“文章title”、“文章热度”和“知乎ranked”。

下一个重要步骤是创建“二级页面”链接。点击“添加新选择器”,id填写“二级页面”,类型选择“链接”,然后点击“选择器”,选择文章的标题,即每个文章的入口,确认选择并保存并退出。

这相当于有了一个窗口,点击刚刚创建的“二级页面”进入下一级目录,然后创建“关注”和“浏览量”就像创建“文章title”一样前。选择器。最后,整个树结构如下图所示。

点击“站点地图知乎_hot-Scrape”开始爬取。在这里可以增加“页面加载延迟”的响应时间,以确保页面完全加载。这时候浏览器会依次打开各个二级页面进行抓取,需要稍等片刻。

爬取任务完成后,将结果下载为CSV文件,并按照“知乎ranking”的降序排列,得到知乎热榜的完整列表。

▲知乎热榜

至此,我已经介绍了如何使用“Web Scraper”抓取一个页面的多条信息,自动翻页,抓取二级页面的内容。显然,“Web Scraper”的功能远不止这些,还有更强大的抓图、正则表达式等功能,大家可以自行探索。

另外,如果你只是想简单的抓取信息,可以试试其他插件,比如“Simple scraper”和“Instant Data Scraper”。这些插件甚至可以一键抓取,但比起“Web Scraper”,它们的功能更加丰富,还缺少很多。

你不需要学习Python,也不需要花钱让别人帮你。您可以使用“Web Scraper”自行完成网页抓取。也许你会是下一个准时下班的人?