影响蜘蛛抓取的因素

优采云 发布时间: 2022-07-10 10:09影响蜘蛛抓取的因素

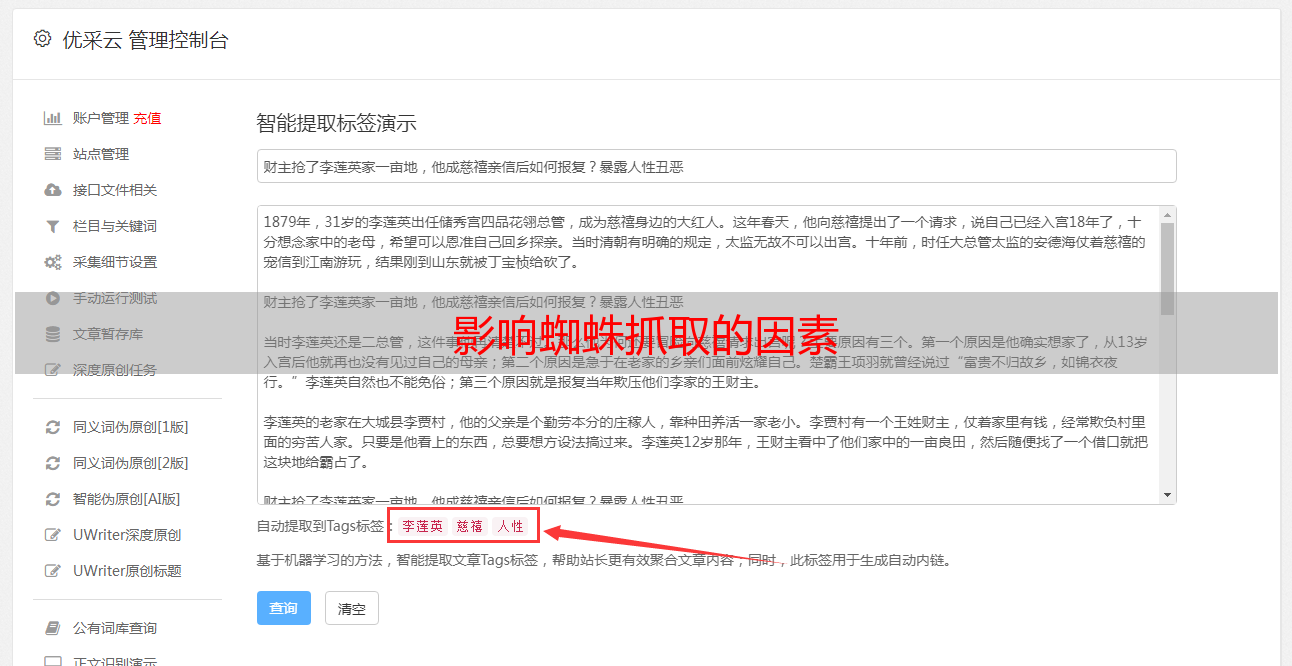

网站想要被收录,前提是页面能够被蜘蛛抓取到,当然,你可以使用第三方站长工具去模拟抓取看看,看一看能不能抓取到预期的内容,如果抓取不到,那就要整改了

那么哪些因素有可能造成蜘蛛无法正常抓取我们网页呢,下面就要讲几点最重要的

1、网页都是由html前端代码写的,现在流行的布局方式是div+css,看看有没有在用talble表格进行布局的,如果有的话,就需要找人写了,一个页面200RMB的样子,同时,也不建议使用框架,js

编辑切换为居中

html代码

2、网址不能过长:百度建议网址的长度不要超过256个字节,浏览器地址栏目最好能够显示全

3、网址中不要包含中文:百度对于中文网址的的抓取效果都是比较差的,没有看到有哪个网站是中文有很好的收录和排名的

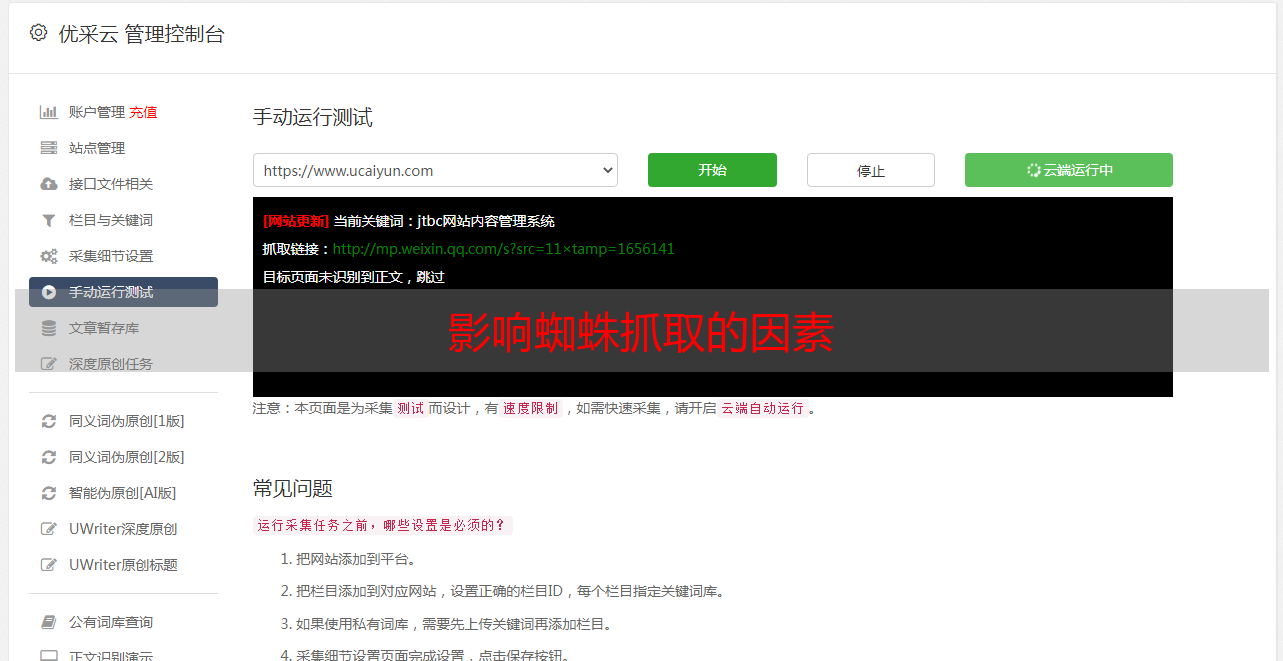

3)服务器问题:用户或蜘蛛不能访问,一访问,就提示页面打不开,如果你的服务器质量太差,是这种情况,赶紧换空间,有排名的话,排名一段时间也会掉没得,那么也会影响蜘蛛的抓取效果;

编辑切换为居中

服务器关了

4)Robots.txt屏蔽:这个是坑的,很多人在建站时,不想让蜘蛛抓取,就使用了这个,但是他不知道,这个robots这个是有生效时间的,根本就不是我们在控制,永远都是百度说得算,当以,所以人写了,但最后还是发现网站收录了,想让蜘蛛抓取了,在放行,缺发现,几个月了,还是不来抓取,所以,SEO人员别这么玩。

编辑切换为居中

robots禁封

最主要的就这几个,当然,网站如果不收录,还有可能是其它的问题,反正很多,可以看下前面发的内容,内容的质量,这个最主要的,咱们后面在讲