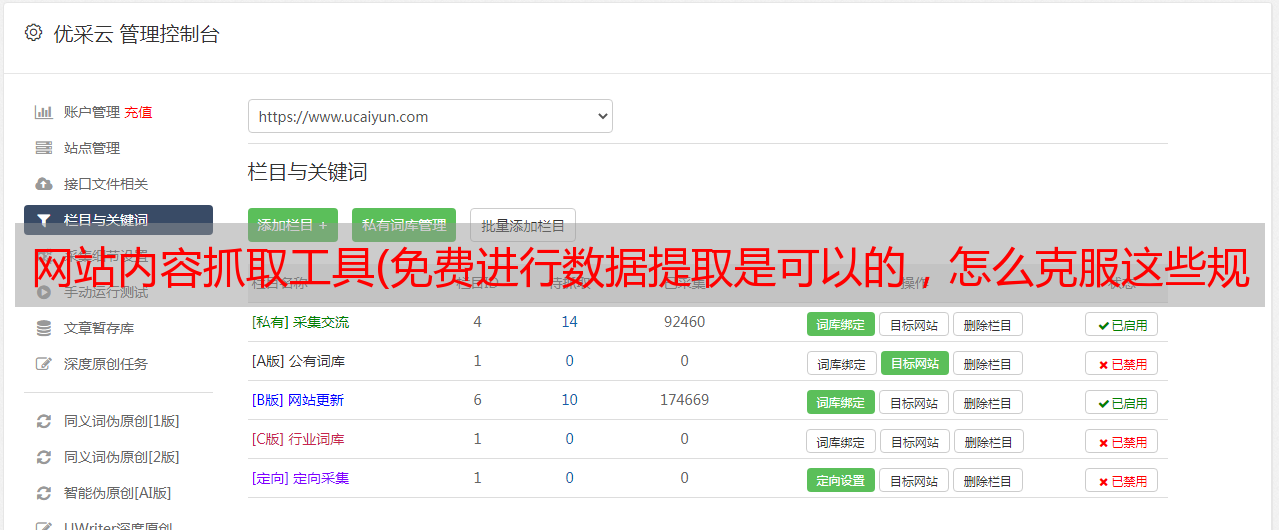

网站内容抓取工具(免费进行数据提取是可以的,怎么克服这些规则?)

优采云 发布时间: 2022-03-24 01:07网站内容抓取工具(免费进行数据提取是可以的,怎么克服这些规则?)

免费数据提取是可能的,但它有一些缺点。比如网络不够稳定,IP容易被封。事实上,数据采集中最大的开销是使用代理服务器,网络爬虫使用代理服务器来防止 网站 检测网络爬虫,因为大多数 网站 不允许对它们进行自动化活动,所以您需要采取措施克服这些规则。以下是两种不同的网页抓取方法:

一、如果网站存储了他们所有关于HTML前端的信息,可以直接使用代码下载HTML内容,提取有用信息。

步骤:

1、检查 网站HTML

你想刮

2、,使用代码访问网站的URL,下载页面上的所有HTML内容

3、将下载格式化为可读格式

4、提取有用信息并以结构化格式保存

5、对于在网站多个页面上显示的信息,您可能需要重复步骤2-4以获得完整信息。

这种方法简单明了。但是,如果 网站 的前端结构发生变化,则需要相应地调整代码。

二、如果网站将数据存储在API中,用户每次访问网站网站都会查询API,可以模拟请求查询数据直接来自 API

步骤

1、检查要抓取的 URL 的 XHR Web 部分

2、找到为您提供所需数据的请求-响应

3、在您的代码中,模拟请求并根据请求类型(post 或 get)以及请求标头和有效负载从 API 检索数据。一般来说,从 API 获取的数据格式非常简洁。

4、提取你需要的有用信息

5、对于查询大小有限的 API,您将需要使用“for 循环”来重复检索所有数据

如果您能找到 API 请求,这绝对是首选方法。您收到的数据将更加结构化和稳定。这是因为与 网站 前端相比,公司不太可能更改其后端 API。但是,它比第一种方法稍微复杂一些,尤其是在需要身份验证时。