搜索引擎如何抓取网页(网站内容如何做到被搜索引擎频繁抓取抓取的具体用途是什么)

优采云 发布时间: 2022-03-12 11:23搜索引擎如何抓取网页(网站内容如何做到被搜索引擎频繁抓取抓取的具体用途是什么)

搜索引擎爬虫爬虫是一种自动提取网页的程序,例如百度蜘蛛。如果要收录更多网站的页面,必须先爬取该页面。如果你的网站页面更新频繁,爬虫会更频繁地访问该页面,优质的内容是爬虫喜欢抓取的内容,尤其是原创内容。

我们都知道,为了保证高效率,搜索引擎蜘蛛不会抓取网站的所有页面。网站 的权重越高,爬取深度越高,爬取的页面越多。这样,可以收录更多页面。

网站服务器是网站 的基石。如果网站服务器长时间打不开,就相当于关门谢了。如果你的服务器不稳定或者卡住,每次爬虫都很难爬。有时只能抓取页面的一部分。随着时间的推移,百度蜘蛛的体验越来越差,它在你的网站上的得分越来越低。当然会影响你的网站爬取,所以选择空间服务器。

据调查,87%的网民会通过搜索引擎服务找到自己需要的信息,近70%的网民会直接在搜索结果自然排名的首页找到自己需要的信息。可见,搜索引擎优化对于企业和产品来说意义重大。

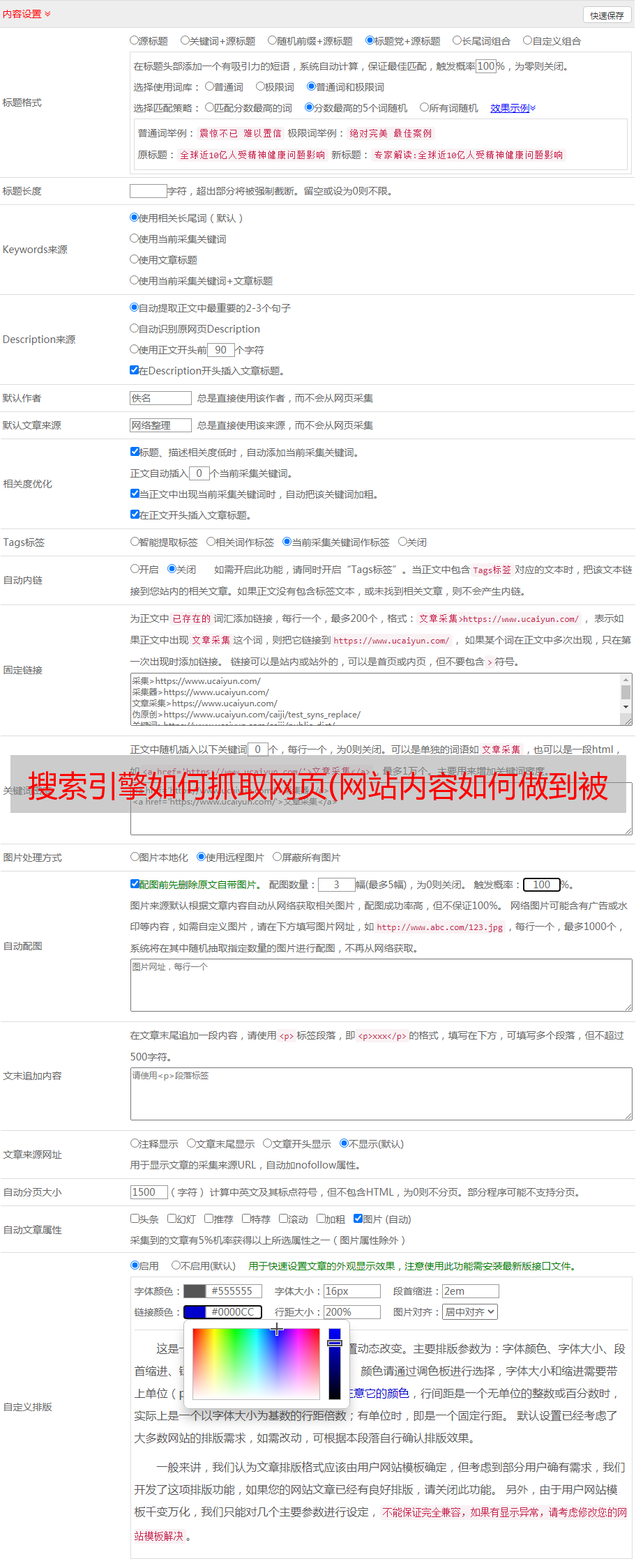

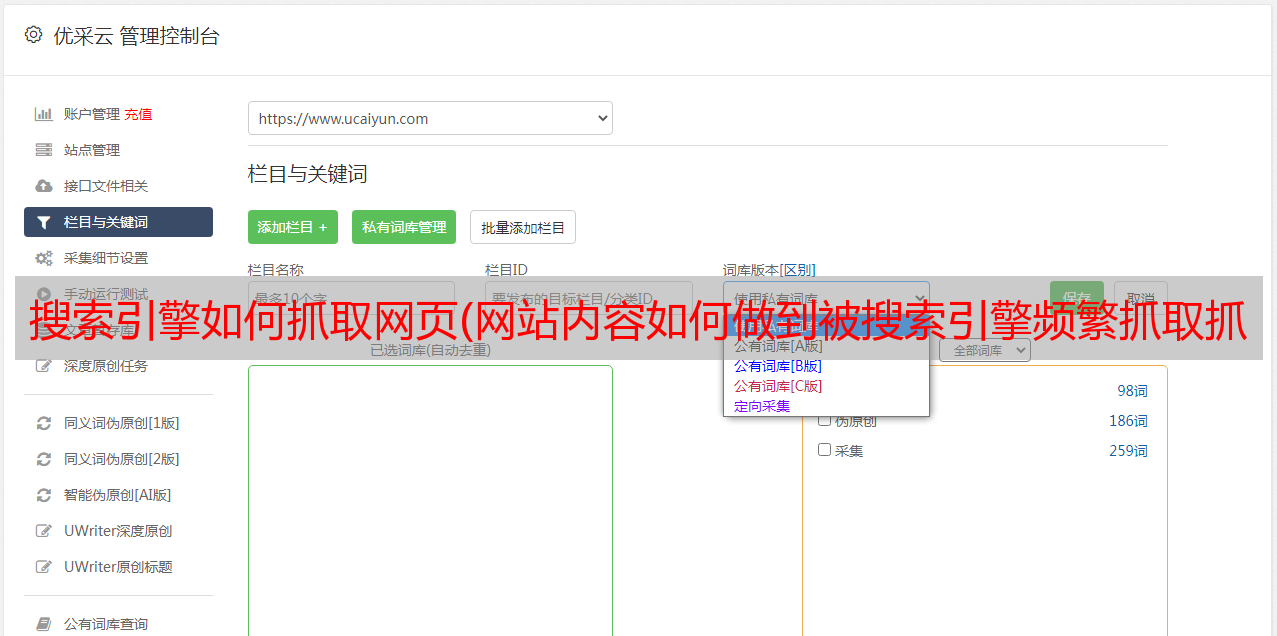

那么网站内容如何被搜索引擎频繁快速的抓取。

我们经常听到关键字,但关键字的具体用途是什么?

关键词是搜索引擎优化的核心,也是网站在搜索引擎中排名的重要因素。

入链也是网站优化的一个非常重要的过程,间接影响了网站在搜索引擎中的权重。目前我们常用的链接有:锚文本链接、超链接、纯文本链接和图片链接。

每次蜘蛛爬行时,它都会存储页面数据。如果第二次爬取发现页面收录与第一次完全相同的内容,则说明该页面没有更新,蜘蛛不需要频繁爬取。如果网页内容更新频繁,蜘蛛会更频繁地访问该网页,所以我们应该主动向蜘蛛求爱,定期更新文章,让蜘蛛有效地按照你的规则爬行< @文章 。

优质的原创内容对百度蜘蛛来说非常有吸引力。我们需要为蜘蛛提供真正有价值的 原创 内容。如果蜘蛛能得到它喜欢的东西,它自然会给你的网站留下好印象并经常回来。

同时,网站结构不能太复杂,链接层次不能太深。它也是蜘蛛的最爱。

众所周知,外链对于网站是可以吸引蜘蛛的,尤其是在新站点中,网站还不是很成熟,蜘蛛访问量比较少,外链可以增加网站页面的曝光率front of spiders rate,防止蜘蛛发现页面。在外链的建设过程中,需要注意外链的质量。不要做无用的事情来省事。

蜘蛛沿着链接爬行,所以内部链接的合理优化可以要求蜘蛛爬行更多的页面,促进网站的采集。在内链建设过程中,应合理推荐用户。除了在文章中添加锚文本,还可以设置相关推荐、热门文章等栏目。这是许多 网站 正在使用的,并且蜘蛛可以抓取更广泛的页面。

主页是蜘蛛访问次数最多的页面,也是一个具有良好权限的页面网站。可以在首页设置更新版块,不仅可以更新首页,增加蜘蛛访问频率,还可以提高对更新页面的抓取和采集。

搜索引擎蜘蛛通过链接进行搜索。如果你的链接太多,不仅页面数量会减少,你的网站在搜索引擎中的权重也会大大降低。因此,定期检查网站 的死链接并将其提交给搜索引擎非常重要。

搜索引擎蜘蛛喜欢 网站 地图。网站地图是所有网站 链接的容器。很多 网站 都有蜘蛛很难掌握的深层链接。网站地图允许搜索引擎蜘蛛抓取网站页面。通过爬网,他们可以清楚地了解网站的结构,所以构建一个网站的地图,不仅可以提高爬取率,而且对蜘蛛有很好的感觉。

同时,在每次页面更新后向搜索引擎提交内容也是一个好主意。