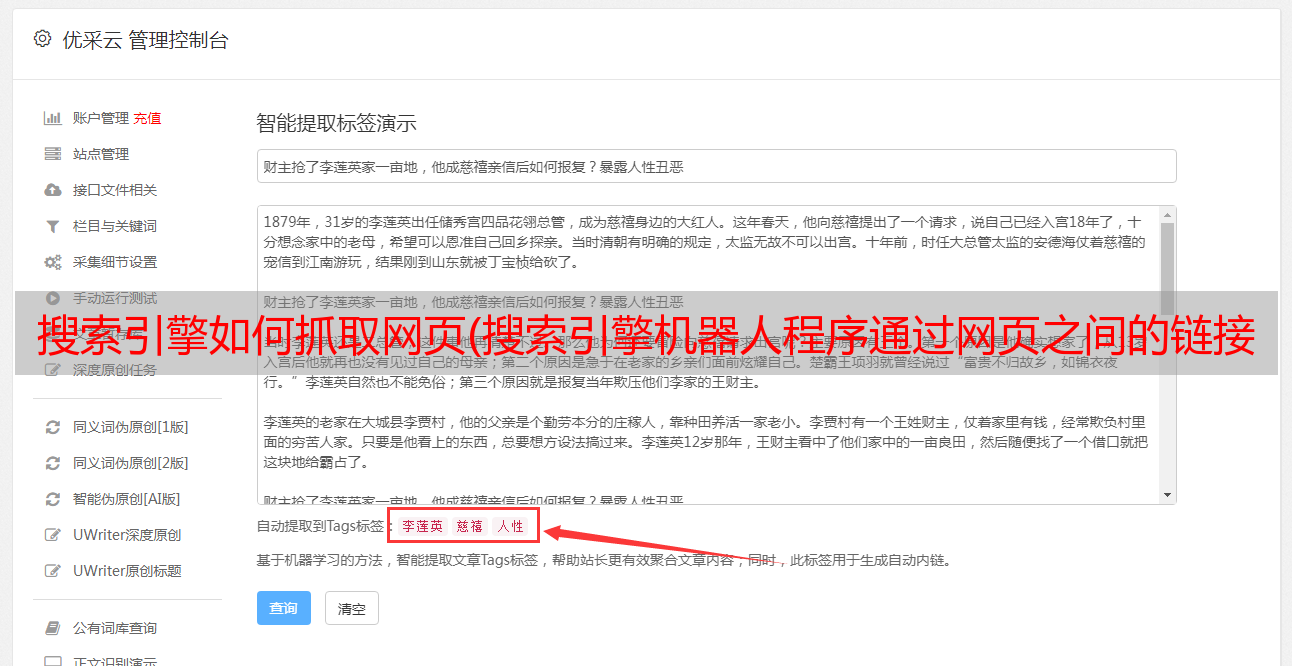

搜索引擎如何抓取网页(搜索引擎机器人程序通过网页之间的链接地爬行来抓取信息)

优采云 发布时间: 2022-03-05 14:04搜索引擎如何抓取网页(搜索引擎机器人程序通过网页之间的链接地爬行来抓取信息)

搜索引擎机器人程序日夜爬取网页之间的链接来爬取信息。不管是哪个搜索引擎,抓取网页一般有两种方式,即深度优先和广度优先 收录pages 。

1、深度优先爬取:表示搜索引擎沿着一个链接爬行,直到链接结束,然后回到起点,从第二个链接开始爬取,即A-A1- A2..An、B1-B2…Bn 等等。

2、广度优先爬取:意思是先爬取网页上的所有链接,然后从每个链接开始爬取,即ABCD;A1-A2-A3-A4等,搜索引擎爬取方式如下:

数据收录原理

然而,这两种情况在现实中一般不会同时发生。这只是搜索引擎的理论成就。如果你想让你的网站获得更多的深度和广度优化收录,那么你必须增加网站的权重和站内链接,去掉所有搜索引擎能解决的问题' t 解决以获得更多的爬网。

搜索引擎原理详解收录

1、分析网页标题内容

当搜索引擎进入服务器时,首先查看 robots.txt 文件。如果 robots.txt 文件不存在,会返回 404 错误码,但仍会继续爬取。为了获得更好的搜索引擎体验,您应该为每个 网站 robots.txt 文件编写一个。当搜索引擎抓取网页时,首先要看的是网页的标题。搜索引擎通过网页标题的内容找到已经收录的数据进行分析比较,判断该网页的价值以及是否需要收录,比如如果有更多关键词,如果直接使用“友情链接”作为网站的标题,值低于“友情链接有什么用”,因为搜索引擎数据库有太多这样的数据,对于重复的内容,只有谷歌和 SOSO收录 比较好,其他搜索引擎不好,因为他们知道这些无用的数据,没有必要浪费它的存储空间,尤其是对于新站点,百度往往不会看好新站,就算是原创,也未必是收录,在收录之后拿到排名的概率也是0。这也是百度在合同上的不公平新 网站 内页的排名。. @收录也是0。这也是百度对新网站内页排名的不公平约定。. @收录也是0。这也是百度对新网站内页排名的不公平约定。.

2、排除无价值的内容(去重)

搜索引擎去除网页的相同内容,例如:页眉、页脚、类别重复部分,然后提取核心内容。为了更好的让搜索引擎知道你的主要内容,请将网站标题放入H1标签中,至少在H2中,否则你的页面排名能力会大打折扣。

3、分析网页内容

通过分析主要内容进一步判断页面的价值,文章是原创,还是转载,内容是否过度优化,文章是否已经出现在同一个网站中,或者相似度是多少,最后判断是否是收录。这是通用搜索引擎收录的原理。对于百度搜索引擎,他会先分析网页内容的价值,再分析网站程序和权重。对于不同的程序,不同的权重,内容的收录程度是完全不同的,比如博客和论坛程序收录和排名规则也不一样。