搜索引擎优化学习(百度优化和google优化有什么区别?有好几个原因吗?)

优采云 发布时间: 2022-02-22 07:22搜索引擎优化学习(百度优化和google优化有什么区别?有好几个原因吗?)

很多网友问我如何优化百度,但我一直不知道怎么写更合适。

有几个原因。首先,知识很多,不先介绍的话,写的时候大家都不容易理解。就像我刚开始写博客一样,我想写“SEO案例:锚文本、关键字、Nofollow、Web标准化”文章,但如果我不说为什么要关注锚文本一开始,如何在关键词选择、nofollow的作用、为什么要规范等方面,可能很多人认为我只是在说一个特别注重细节的案例。

所以我先解释一下google的优势,解释一下搜索引擎是怎么工作的,然后再解释一下怎么做百度优化。我的博客里很多文章都是站在谷歌的角度谈SEO,但是你可以想想如果百度处理同样的事情怎么解决。

第二个原因是百度优化和谷歌优化在技术上有80%相似,所以百度优化和谷歌优化没有特别的区别。而且,要完成网站 SEO 工作,这些过程和方法是相同的。说到相似度,你可以看到一个网站在谷歌上排名很高,在百度上也有很好的排名。还有,几年前百度不是一直声称谷歌侵犯了百度的超链接分析方法专利吗?虽然很荒谬,但可以看出百度也很重视外链。而且现在还有一种趋势,百度在算法上越来越模仿google。

另一个原因是其他方面。互联网圈子其实很小。百度排名确实有一些技巧,但是我今天在这里讲解的技巧,明天大家就不用了。

总的来说,百度的优化比谷歌的英文优化要容易很多。现在主要从事英文优化,同时也在做一些百度优化的工作。在百度上,基本上只要你特别注意要优化的词,如果不是很受欢迎,非促销的搜索结果就会排在第一位。(但是对于一个大网站,如果你特别注意优化热门词,你会损失超过50%的原本属于你的流量。)而且我使用的一些技术在领域被滥用英语 SEO 技能。

如果你能把英文的seo做好,做百度优化就很容易了。很久以前,在一些SEOer看来,百度优化和非促销搜索结果排名第一并不难,但保住第一就很伤脑筋了。

接下来,我们来说说影响你的百度优化的几个因素。

1.百度的搜索技术很糟糕。

爬虫、索引、排序算法存在很多缺陷。比如在搜索一个词的时候,同样的网站占据了搜索结果的前几十个,这是一个非常低级的错误。而很多大型网站也应该被百度的爬虫“攻击”。反作弊的措施也很简陋,所以一大批作弊的网站还是可以过得很好的。对于那些从来没有作弊做SEO的人来说,这是无奈之举。这都是技术性的,有些是人为的。比如很多被百度认为“影响业务”的网站在爬取率和排名上都被赋予了特殊的权重,导致这些网站无法产生SEO流量. 有很多网站都是这样区别对待的。几个著名的网站 s在中国,包括阿里巴巴中文网站,都是这样的。因此,在阿里巴巴中文网站的SEO流量中,来自谷歌的流量远高于百度。. 另一方面,百度自身的业务被赋予了越来越高的权重,甚至很多明显的垃圾页面自己的网站依然有不错的排名。如:

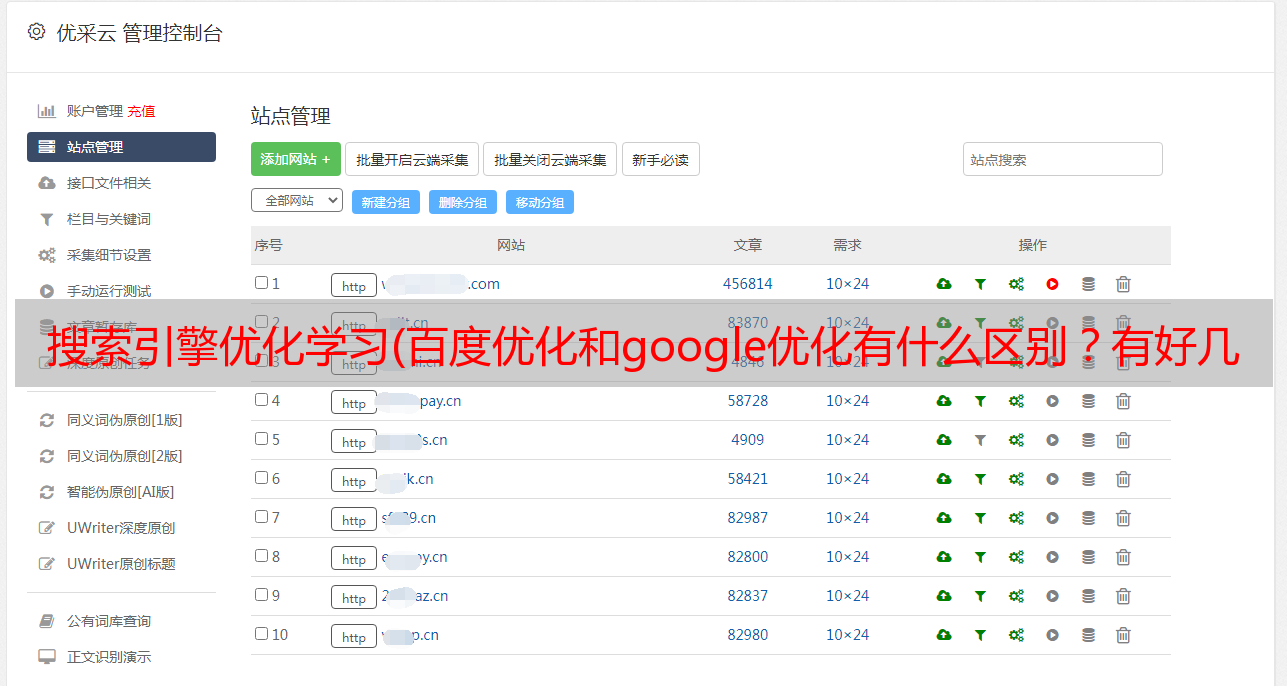

百度搜索结果

虽然我不提倡在SEO上作弊,但是如果一个小网站在做百度SEO,注意百度的一些反作弊措施,适当使用一些方法。

2、服务器效率低

《谷歌*敏*感*词*的新功能》揭示了数据中心的效率是搜索引擎的命脉。而百度的数据中心无疑是没有亮点的。频繁的崩溃和数据丢失,让很多国内SEO人认为自己的网站存在作弊问题,从搜索引擎中消失。大型服务器集群是对一个公司管理技术实力的特殊考验。管理数据中心很像“打地鼠”游戏。这里有几台宕机的服务器刚刚得到解决,还有另一台服务器在那里。谷歌在这方面也遇到了很多问题,也得益于他们的技术能力,都得到了很好的解决。虽然也有数据丢失,但是平均每个数据有2个备份副本,所以突然大量收录消失了

我经常看到很多人担心百度上网站收录的数量,但很多时候,并不是因为百度惩罚你。相反,他们有自己的问题。

三、反作弊措施

不管是百度还是谷歌,要想做好SEO,就必须站在这个搜索引擎的角度来看待自己的SEO优化工作。在百度上做 SEO 时,请记住它可能会使用什么样的反作弊措施来检查您的 网站。这是百度搜索引擎优化的秘诀。

这是我处理过的一个案例:

以前我给国内某知名网站做SEO,因为我遵循这个规律,把总的SEO流量从6万增加到267万。(之所以流量增长了40多倍,还有一部分是因为他们以前使用ajax技术,阻碍了收录。)后来流量突然下降到30万左右,因为那家公司有专门的渠道,我从百度内部得到一个意见,说 网站 过度优化,我想知道为什么它会过度优化。然后我想,如果我是百度,我会如何判断一个网站过度优化?从当时中国SEO的现状来看,我会这样判断:因为每个做SEO的人基本上都是在改标题、关键词、描述。然后我先设置一个过滤条件,就是把网站 每个页面的标题、关键词、描述都有很多内容,因为这些网站有SEO意图,所以他们也会对外部链接等因素做出很多优化动作。这类疑似网站,只要出现流量异常大的增长,就会被严格清理。那个网站在其他方面都很正常,标题、关键词、描述都没有重复关键词,只是每个网页、关键词、描述都写得很丰富。写这个内容也需要很多时间,因为每个页面都要写不同的。所以他们也会对外部链接等因素做出很多优化动作。这类疑似网站,只要出现流量异常大的增长,就会被严格清理。那个网站在其他方面都很正常,标题、关键词、描述都没有重复关键词,只是每个网页、关键词、描述都写得很丰富。写这个内容也需要很多时间,因为每个页面都要写不同的。所以他们也会对外部链接等因素做出很多优化动作。这类疑似网站,只要出现流量异常大的增长,就会被严格清理。那个网站在其他方面都很正常,标题、关键词、描述都没有重复关键词,只是每个网页、关键词、描述都写得很丰富。写这个内容也需要很多时间,因为每个页面都要写不同的。和描述都写了丰富的内容。写这个内容也需要很多时间,因为每个页面都要写不同的。和描述都写了丰富的内容。写这个内容也需要很多时间,因为每个页面都要写不同的。

想清楚了这点,会写关键词和描述的就不写了。甚至做了一个大胆的决定,就是所有网页都不写关键词。因为如果我是百度,我永远不会把关键词作为排名因素。之所以没有放弃描述,是因为人们仍然需要在搜索结果中阅读它。这一改动一个月后,流量恢复了,直到我离开公司,SEO流量一直稳定在200万以上。

因为这个文章实在是太罗嗦了,后面再讲一些其他的案例。不久前,MattCutts 在他的博客中表示,谷歌不使用关键字作为排名因素。如果你在前线修炼,这些事情你早就知道了。我以前想写这个,但MattCutts先说了。

4.人工干预

百度是一个讨厌SEO的搜索引擎。在他们看来,搜索引擎优化阻碍了他们的收入。这与我在《如何学习SEO》一文中提到的谷歌与网站的双赢策略完全相反。谷歌也有人工审核,不过说到对付作弊网站,尺度还是很松的。百度的人工干预会让你在制作一些热门词时很麻烦。这个我就不多说了,大家都经历过。

这4个影响你在百度搜索引擎优化的因素都是客观的。另一个因素是 PPC,但这正在慢慢消失。

不过在百度上做SEO还是可以的,就是整体把握一个网站的策略和方法。SEO应该做的是给网站带来收益,在各种条件和资源的约束下,最大化网站的收益。这是一个SEOer应该追求的目标,而不是今天有多少收录,哪些热门词没有排名等等。我会一一讲。