搜索引擎如何抓取网页(wordpress不抓取网站标题有什么解决办法?个人分析可能?)

优采云 发布时间: 2022-02-16 01:27搜索引擎如何抓取网页(wordpress不抓取网站标题有什么解决办法?个人分析可能?)

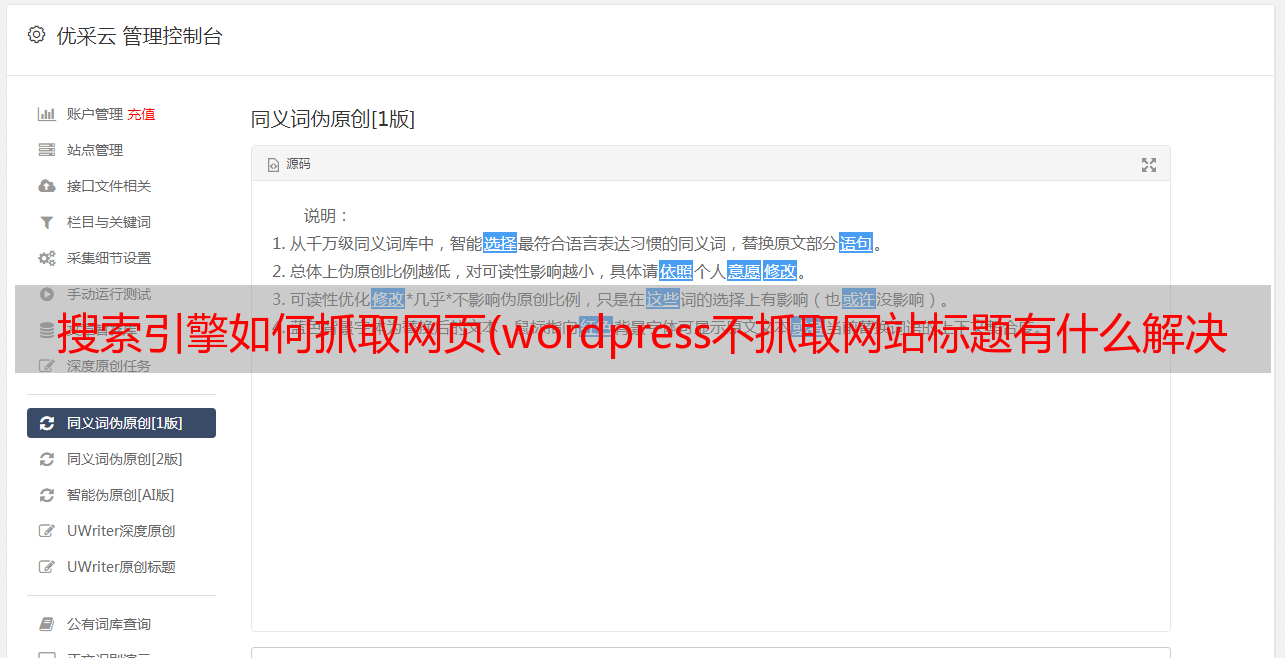

wordpress 不抓取 网站 标题的解决方案是什么?

个人分析可能是因为我安装wordpress文件的时候可能出错,点击了阻止搜索引擎索引网站的选项。但是两天后,我明明取消了这个选择,接下来几天提交的内容还是会出现同样的原因。明明我已经更新了robots文件,为什么还是这样?

今晚我用百度爬虫工具查看网站网址时,百度站长工具给出的结果依然是限制爬取的robots文件。如下所示:

如何处理这种情况?其实很简单,按照百度站长给出的说明操作即可。具体方法如下:

在爬取诊断工具中,如果返回的爬取失败结论是robots被禁止,请确认您是否为该URL设置robots,以防止百度蜘蛛爬取网站的某些内容,如果您不使用robots文件屏蔽百度,请点击旁边的错误链接,百度会立即更新您站点的机器人信息;如果您的误操作导致被封禁,请及时修改robots文件,以免造成您的网站在百度收录流量和流量下降。

事实上,我在这里分享这个问题。除了分享改善问题的解决方案外,最重要的一点是,这个问题反映了百度搜索引擎本身的一些有价值的东西。搜索引擎在处理一个网站时,一个网站的内容在一次抓取后会预先存在自己的数据库中,不会及时更新,即使我们自己的网站@ > 相关内容已更新,但未在其数据库中显示 网站 更新的内容。这意味着百度搜索引擎的预存机制有一个很长的周期,同样的情况不会出现在谷歌搜索引擎上。当我更新robots文件时,第二天谷歌蜘蛛开始抓取网站的相关内容,这是一个非常好的案例。这一点相信对我们做网站有帮助

测试网站不想被百度爬取,也不想搜索关键词的排名,应该怎么设置呢?

如果不想让百度或者谷歌抓取网站内容,需要在服务器根目录下放一个robots.txt文件,内容如下:

用户代理:*禁止:/

既然这个网站的robots.txt文件中有限制指令,那是什么情况呢?

Robots协议(也称为爬虫协议、机器人协议等)的全称是“网络爬虫排除标准”,网站通过Robots协议告诉搜索引擎哪些页面可以爬取,哪些页面可以爬取无法抓取页面。如果网站的操作者通过文件协议进行了限制,则搜索界面会提示限制指令,原因是网站的robots.txt文件。

网站不是收录,做SEO没用吗?

有的站长会在工作中发现,自己的网站经过了很多优化处理,却没能拿到搜索引擎的收录,但是一些网站优化已经完毕。很一般,但是从搜索引擎得到收录,这是为什么呢?

网站无法获取搜索引擎收录一般是以下原因造成的。

网站是否被 收录 延迟了?看看你有没有犯这四个错误

一、网站 使用了被处罚的域名

有些人在建立网站时使用旧域名是为了方便。虽然这个老域名在排名上有一定的优势,但不足以掩盖老域名被处罚的风险。如果旧域名有权利,再加上它的内容与你的网站内容相似,它确实有助于网站获得更高的排名。但如果您选择的域名之前已经注册过,请不要大意,一定要去百度查一下记录,确定这个域名是否被制裁过。

二、初始机器人设置为不可抓取

正常情况下,网站刚上线时会设置robots。这个设置是为了防止百度蜘蛛在构建未完成时爬取网站。不过有些站长可能会在网站真正上线后取消这个设置。如果无法抓取的设置还存在,自然不会被搜索引擎抓取,更别说收录了。

三、使用不稳定的服务器

有的站长会选择一些空间在国外备案,在服务器的选择上为了更快、更省时间,但这种做法不值得推广。因为国外空间的稳定性无法保证,而稳定的空间是网站长期发展的最基本条件。不稳定的空间在实际使用中会面临运行缓慢甚至崩溃的问题,从而降低用户体验。我们都知道搜索引擎会参考用户体验来工作,所以我们应该尽量摆脱这种降低用户体验风险的做法。

四、内容不足原创

在确保所有技术问题都已解决后,如果网站仍然无法获取收录,则需要反思一下内容是否有问题。原创是网站的运营和SEO优化过程中反复提及的一个问题。虽然搜索引擎是基于算法的、没有感情的机器,但我们都知道搜索引擎更喜欢 原创 内容。转载或采集的文章,再高品质,也无法替代原创的内容。

因此,网站要想被搜索引擎收录成功搜索,就需要提高网站中内容的原创度,即使这些内容可能略逊于一些<来自@采集 的内容,但它对网站 的帮助远大于来自采集 的优质内容。

如果网站不能得到搜索引擎的收录,那么肯定是工作有问题。这时候就需要停下来好好排查一下上面提到的四个问题。如果能彻底解决,相信一定能从搜索引擎中得到收录,也希望可以帮助一些困在网站而不是收录的站长。

如何解决搜索引擎爬虫重复爬取的问题?

如果爬取频率过大,可以在站长平台调整爬取频率。如果同一个链接段被抓取时间过长,可以调整链接布局,使用nofollow标签进行引导。

如何解除对我计算机上的搜索功能的阻止?

这关闭了它的管理。

先开放管理。开始 - 运行 - gpedit.msc - 用户配置 - 管理面板 - 任务栏和开始菜单

找到“从开始菜单中删除搜索菜单”。双击打开它。

启用禁用搜索菜单。

如果未启用,您可以使用搜索菜单。

您可以在离开时单击启用。

使用时,可以点击禁用。

不知道这样能不能解决你的问题?

搜索引擎如何自动抓取网站图片?

这不应该。搜索引擎可以爬取热门链接,除了flash、图片和框架,基本可以爬取。有关详细信息,您可以查看您的 网站 日志以了解它是否已被爬取!

搜索引擎抓取html内容时会先去掉js吗?

1、只要网页的内容是纯文本的,即使添加一些不相关的JS代码,也不会影响搜索引擎的抓取。2、但是如果你的内容是用JS代码插入到网页中的,是有影响的。参见示例:

这不会影响搜索引擎抓取