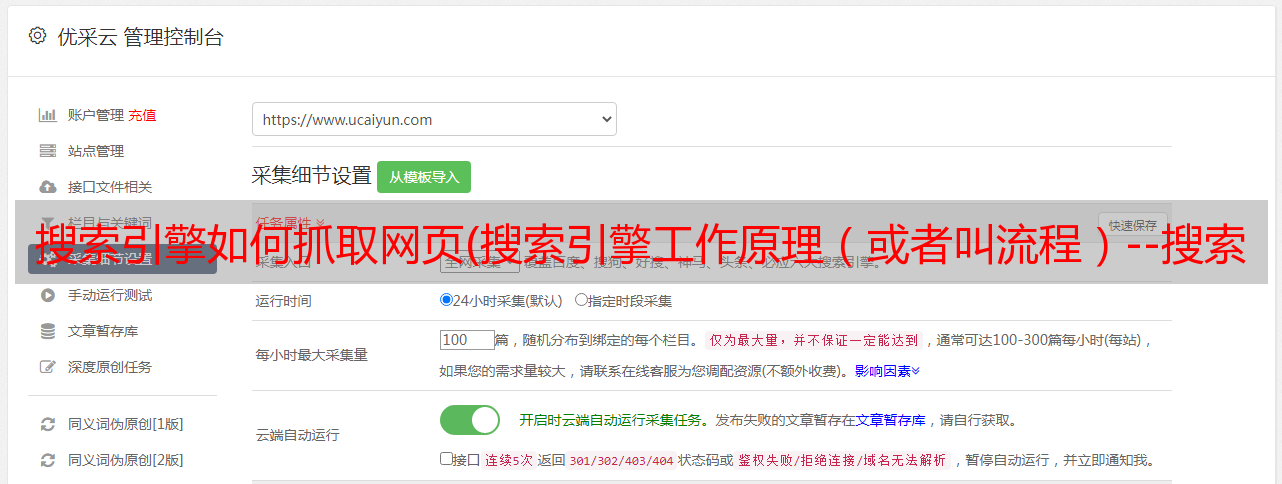

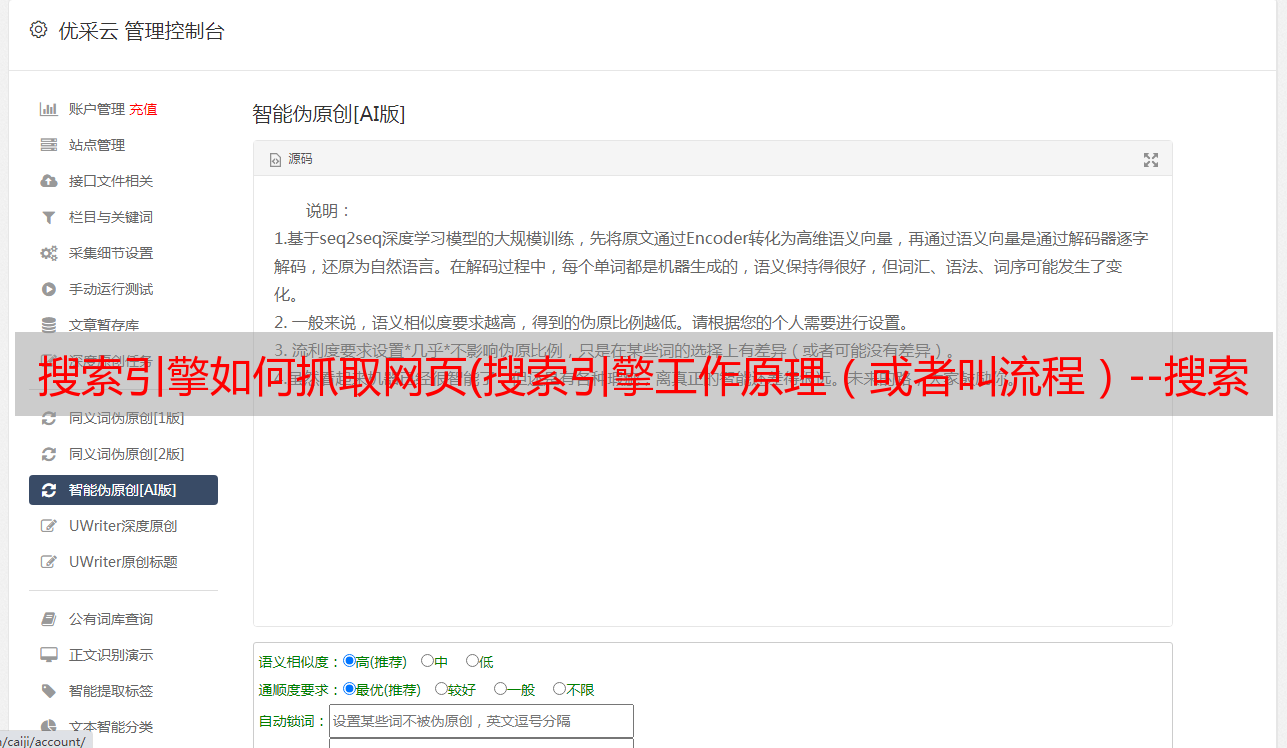

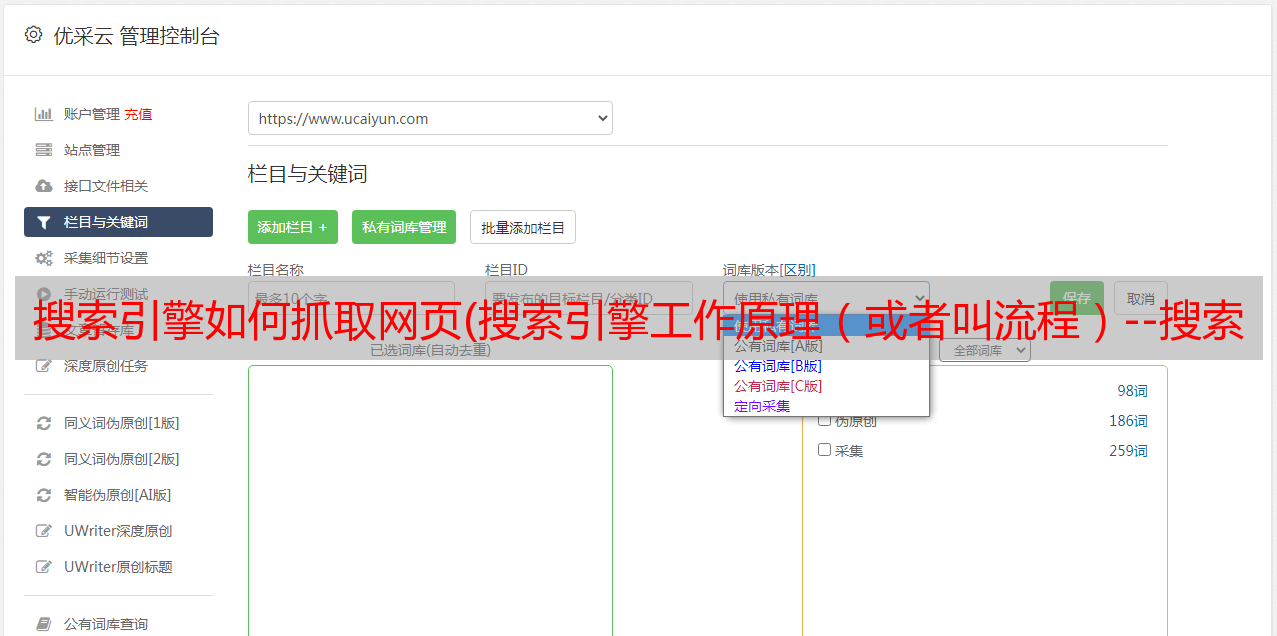

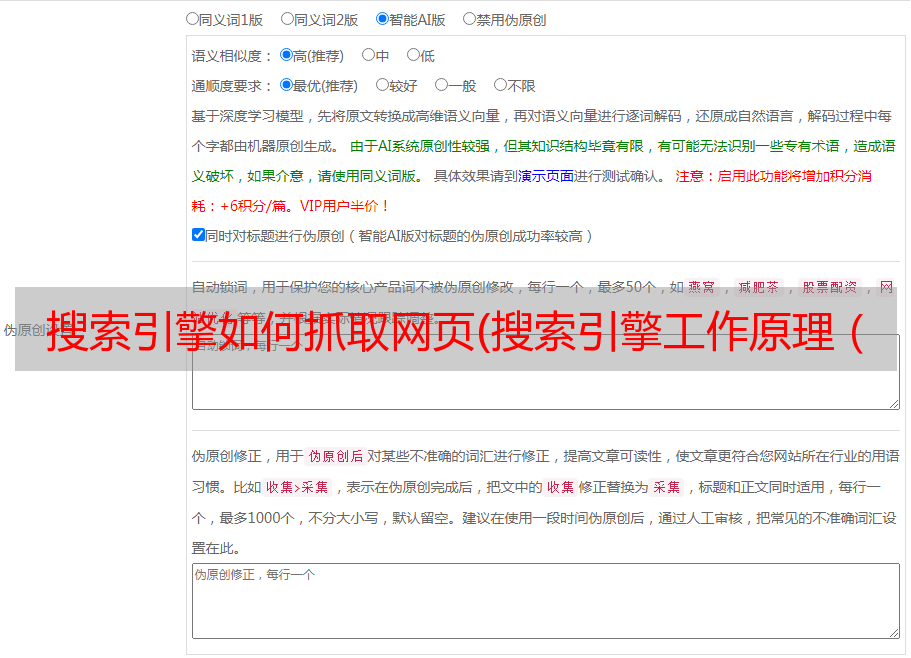

搜索引擎如何抓取网页(搜索引擎工作原理(或者叫流程)--搜索引擎的工作过程)

优采云 发布时间: 2022-02-05 23:17搜索引擎如何抓取网页(搜索引擎工作原理(或者叫流程)--搜索引擎的工作过程)

大家好,我是Beard先生,一个在seo行业工作两年的菜鸟,因为一些个人的想法。从现在开始,我们将继续分享我多年来在seo方面的一些工作经验和心得,并在接下来的两个月里与大家分享。好了,不多说了。我们开始今天分享的第一个知识点——搜索引擎的工作原理(或流程)。

搜索引擎的工作过程非常复杂。接下来简单介绍一下搜索索引是如何实现网页排名的。这里展示的内容只是真正的搜索引擎技术的皮毛,但对于我们大多数的搜索引擎来说应该已经足够了。

一个搜索引擎的工作过程大致可以分为三个阶段。

搜索引擎的工作原理

上图显示了搜索引擎的一般工作流程图。首先,搜索引擎会从索引区发送一个程序(百度也叫蜘蛛),通过链接来到网站来爬取我们的网页。到达网页后,首先将数据放入临时数据库,临时数据库会对我们的网页进行一些预处理和评估操作(如去重、中文分词、去停用词、降噪等),以及存储那些符合搜索引擎规则的。去理赔区,否则不符合规定会被清理干净。然后搜索引擎进行排序、归档和排序。最后,将结果显示给用户。

以上大致是一个搜索引擎的工作流程。接下来,我们来看看一些具体的细节。

1.1、抢

1.1.1 什么在爬网

什么爬网

1.1.2 蜘蛛爬行规则

蜘蛛爬行规则

蜘蛛爬取的规则有很多:深度优先策略、广度优先策略、大站点(高权重)优先策略、及时性优先策略、重要页面优先爬取策略等。

面条。事实上,最大的搜索引文是爬网,而 收录 只是互联网的一小部分。

1.1.3蜘蛛爬取内容

蜘蛛抓取内容

蜘蛛通过链接抓取网站的内容,对文字的识别度最高。图片由特殊的图片蜘蛛抓取。但请记住,图像需要一个 Garat 属性便签,以便蜘蛛更好地识别图像。无法识别视频、js 和 iframe 帧。

1.1.4 影响蜘蛛爬行的因素

影响蜘蛛爬行的因素

1.1.5如何判断蜘蛛访问网站

有两种方法可以判断蜘蛛是否来到 网站

1.2 过滤器

筛选

1.2.1过滤系统的含义

临时数据库是用来临时存储蜘蛛抓取的网页的地方。对于服务器,这里需要过滤网页。过滤需要解决一些无用的资源,节省空间,减少服务器的工作量。其他明显欺骗用户的页面、死链接、空白内容页面等,这些页面对用户、站长和百度没有足够的价值,所以百度会自动过滤这些内容,避免用户和你。网站 带来了不必要的麻烦。

1.2.2 影响过滤的因素

模板,所谓模板,就是我们所说的网页相似度。如果整个网站的相似度高,页面的质量也低。

识别是内容是否可以被百度直接识别。文字和链接可以直接被百度识别,而图片和视频不能直接被百度识别,而是通过标签alt来识别。其余的js、cs、iframe框架等都不识别。

相关性,所谓相关性是指文章标题和文章内容是否相关,相关性越高越好

1.3收录

经过以上一系列的爬取和过滤,我们就到了收录的阶段。蜘蛛会将符合规则的添加到数据库中。然后百度收录就是内容。

1.3.1收录的内容

收录大概有这些页面标题、页面描述、页面源代码、页面url。

1.3.2查看收录

查看 收录

1.3.3收录 的常见问题

1.4 索引

1.4.1 个索引数量

详情请参考百度官方资料:

1.4.2查看索引数量

site命令的当前值是对索引量的估计,不好。百度官方也提出:建议站长使用百度站长平台查看网站的索引量。

1.4.3页进入优质索引条件

至此,我们基本讲完了搜索引擎是如何开始爬取网页或者后期排名的。最后,进入索引库的页面可以通过归档排序很好的展示给用户。好了,最后,如果大家有什么建议或者意见,可以留言告诉我。需要课件的可以直接给我留言。