scrapy分页抓取网页( Scrapy的安装输入密码安装完成/scrapy.py)

优采云 发布时间: 2022-02-05 06:10scrapy分页抓取网页(

Scrapy的安装输入密码安装完成/scrapy.py)

Scrapy入门教程——爬上iTunes应用列表

什么是刮痧?

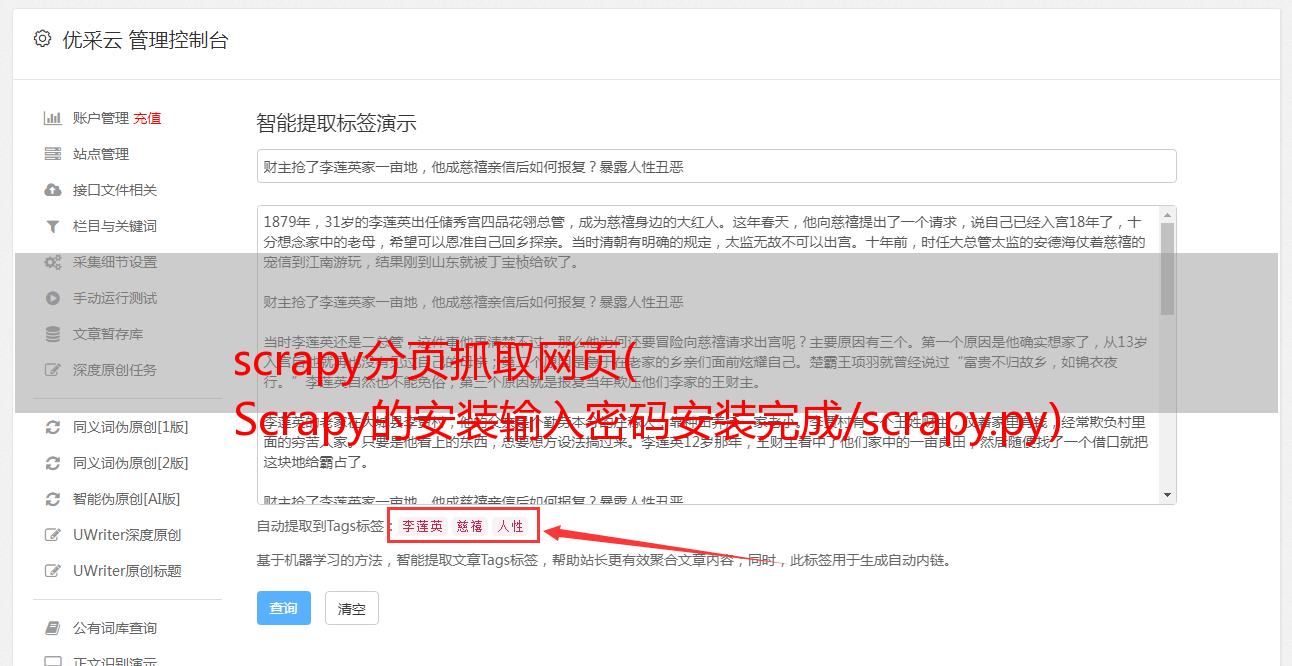

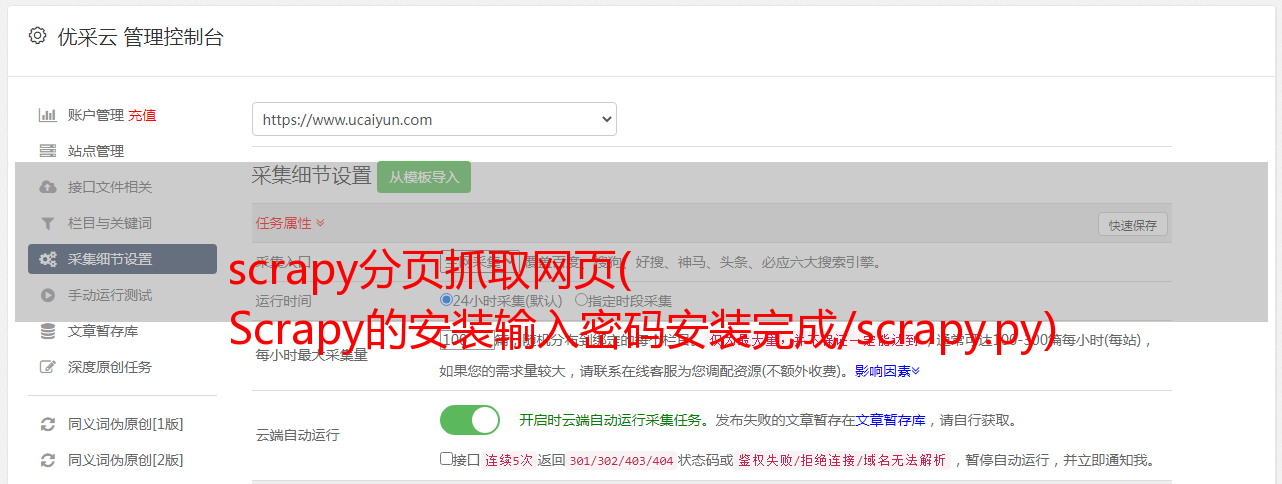

Scrapy 是一个开源的基于 Twisted 的 Python 爬虫框架。我们只需要自定义几个简单的模块即可爬取网络数据。Scrapy的整体架构

简单解释一下上图:

爬虫处理的原材料是一个或多个url。爬取时,Sheduler 会为Downloader 分配一个url 进行网络请求请求。请求完成后,Downloader 会将获取到的响应传给 Spider。如果返回的数据是我们需要的,则将数据处理成对应的Item,交给ItemPipeline进行存储等处理。如果返回的url还是要处理的url,那么就必须交给Scheduler进行另一个处理过程。

3.Scrapy 的安装

sudo pip_install scrapy 或 sudo easy_intall scrapy

输入密码,安装完成。如果你使用scrapy,如果没有找不到命令,就说明安装成功了。

4.创建一个项目

scrapy startproject project_name

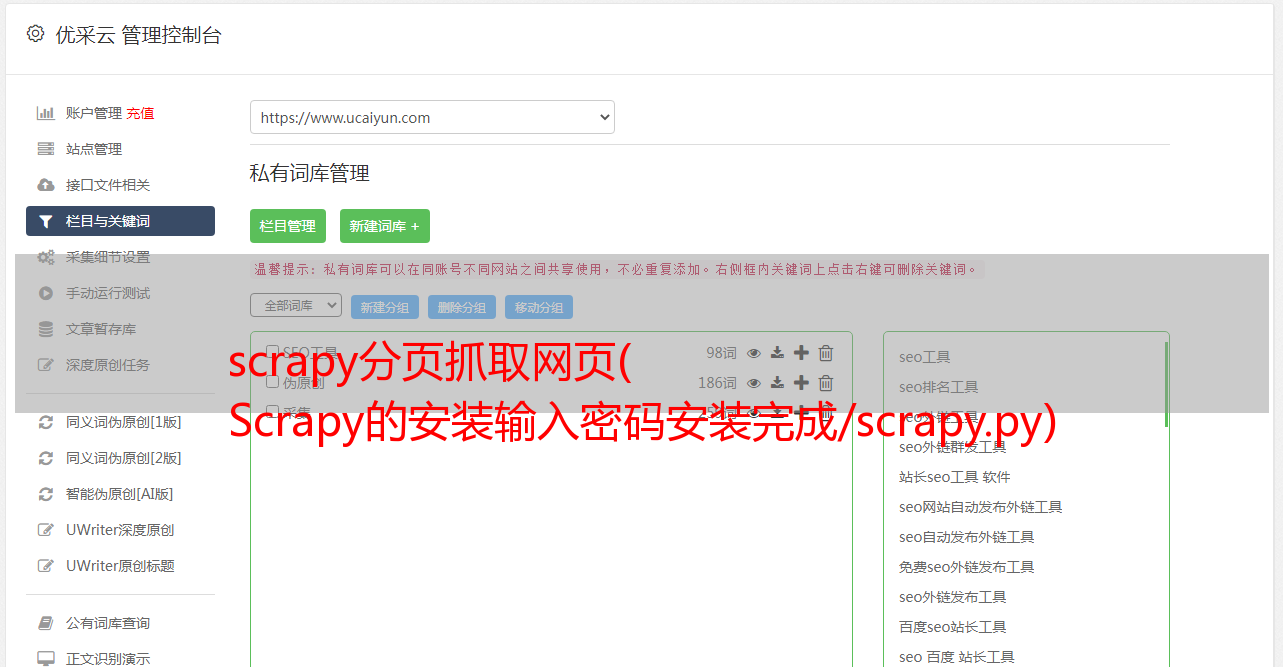

如果看到上面的提示,那么我们的项目就创建成功了。切换到项目目录,我们会看到如下目录结构

应用程序/

整个项目的scrapy.cfg配置信息

所有 python 自定义模块的 appScrapy/ 文件夹

初始化文件

items.py 数据结构保存爬取的数据

pipelines.py 数据流处理文件,对爬取的数据流进行处理

settings.py 设置文件,其中设置了数据库等

spiders/ 存储我们的自定义蜘蛛

初始化文件

…

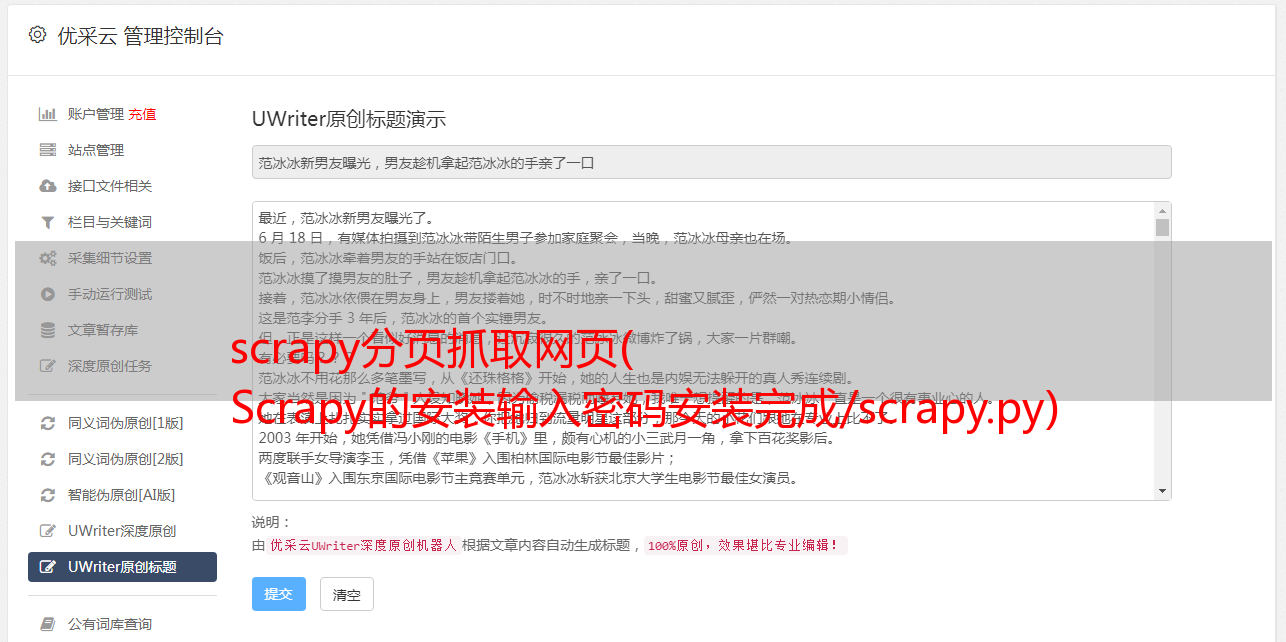

让我们找到完整的目标,appStore的娱乐图表

我们要爬取的数据是列表中应用的名称及其对应的具体信息的url。

首先我们自定义我们用来保存数据类型的items.py,打开items.py,添加代码如下:

import scrapy

class AppscrapyItem(scrapy.Item):

# define the fields for your item here like:

name = scrapy.Field()

url = scrapy.Field()

简单来说,所有item都继承自scrapy.Item,里面的字段是scrapy.Field()类型,scrapy.Field()可以接收任何数据类型。

现在是时候自定义我们的爬虫了。

在 spiders 文件夹中创建一个 AppScrapy.py,然后打开并添加以下代码

from scrapy.spider import BaseSpider

from appScrapy.items import AppscrapyItem

class AppScrapy(BaseSpider):

name = ‘app_scrapy‘

start_urls = ["https://itunes.apple.com/cn/genre/ios-yu-le/id6016?mt=8"]

def parse(self, response):

result = []

lis = response.xpath("//div[@class=‘grid3-column‘]/div")

for li in lis:

array = li.xpath("./ul/li")

for node in array:

item = AppscrapyItem()

item["name"] = node.xpath("./a/text()").extract()

item["url"] = node.xpath("./a/@href").extract()

result.append(item)

return result

所有的爬虫类都需要继承自BaseSpider,并且必须定义一个名字,因为我们需要用这个名字来启动爬虫。一个url数组,爬虫有必要知道它应该去哪里。最后,必须实现 parse 方法。在这里,爬回来的数据真的是经过过滤得到我们想要的。

当我们启动爬虫(scrapy crawl app_scrapy)时,scrapy会从start_urls中取第一个url,用这个url发起请求,并使用parse作为请求的回调函数,回调函数中的response就是request的response请求后收到。

对于内容的选择,我们使用 xpath 方法。xpath 方法需要输入路径并返回选择器数组。

对于路径,我们可以使用Chrome的开发者工具来获取,如上图。当我们要获取内容的时候,只要选择Element选项卡下的内容,然后右键选择copy xPath

lis = response.xpath("//div[@class=‘grid3-column‘]/div")

首先,我们使用xpath获取class = 'grid3-column'的div中的所有div,返回值是一个数组。从上图中我们可以看出,数组中应该有 3 个选择器代表 div。

每个 div 中的内容如上图所示。我们取出每个 div 并解析其内容。

for li in lis:

array = li.xpath("./ul/li")

for node in array:

item = AppscrapyItem()

item["name"] = node.xpath("./a/text()").extract()

item["url"] = node.xpath("./a/@href").extract()

result.append(item)

先用for循环取出每个div,然后获取当前div下所有ul下的所有li,如上图所示,我们会得到一个代表li的选择器数组。再来看看li的结构

中间的文本是通过text()获取的,所以当前li的文本路径是“./a/text()”“.” 表示当前选择器的开始。如果返回,xpath 返回一个选择器。如果我们想得到它的真实值,我们需要调用extract(),它会返回一个真实文字值的数组。

要获取字段的属性值,需要使用@,比如上面的@href,然后将这些值赋给我们写的item。

当然,数据应该保存,并且会继续。下次如何保存到数据库中。

时间:03-08

Scrapy入门教程--爬取iTunes应用列表相关文章Scrapy入门教程

在这个介绍性教程中,我们假设您已经安装了 Scrapy。如果没有,请参阅安装指南。我们将使用 Open Directory Project (dmoz) 作为抓取示例。本介绍性教程将引导您完成以下任务: 创建一个新的 Scrapy 项目以定义提取的项目 编写一个蜘蛛来爬取站点并提取项目 编写一个项目管道来存储提取的项目 Scrapy 是用 Python 编写的。如果您是 Python 新手,您可能希望从了解 Python 开始,以便最好地使用 Scrapy。如果你熟悉其他编程语言,想快速学习

Python的scrapy入门教程

看了这篇文章的同学,我假设大家都学过python(Pyson),那么下面的知识就是python的一个扩展(framework)。在这个介绍性教程中,我们假设您已经安装了 Scrapy。如果您还没有安装它,请参阅安装指南。我们将使用 Open Directory Project (dmoz) 作为抓取示例。本介绍性教程将指导您完成以下任务: 创建一个新的 Scrapy 项目,定义提取的项目 编写一个蜘蛛来抓取站点并提取项目 编写一个项目管道来存储提取的项目 Scrapy 是用 Python 编写的。如果你是皮思

开始使用 Scrapy

Scrapy 是一个用 Python 编写的应用程序框架,用于爬取 网站 数据并提取结构化数据。Scrapy 常用于数据挖掘、信息处理或存储历史数据等一系列程序中。通常我们通过 Scrapy 框架实现爬虫来抓取指定 网站 的内容或图片是非常简单的。Scrapy架构图(绿线为数据流) Scrapy Engine(引擎):负责Spider.ItemPipeline.Downloader.Scheduler中间的通信、信号、数据传输等调度器:负责接收引擎

在 Scrapy 入门教程中写入数据库

那么前面的文章会讲到如何将抓取到的数据写入数据库。1. 爬虫脚本还是以爬虫百科为例,脚本编写保存在Hello/spiders目录下的spider_qiushibaike中。py 文件 # -*- 编码:utf-8 -*- import scrapy from Hello.items import HelloItem class Spider_qiush

Angular2 入门教程-2 实现 TodoList 应用

最近在学习中遇到一些问题(机械工业出版社),没看懂书上说的什么。我在网上找了一些,资源很多,也有很多以前的经验。原文: 原文地址:

Scrapy安装、爬虫入门教程、爬虫示例(豆瓣电影爬虫)

窗口上Scrapy的安装教程见以下链接: Scrapy安装教程 以上安装教程已经实践过,可行。本来打算在ubuntu上安装scrapy,但是ubuntu磁盘空间太小,还没有扩充磁盘空间,暂时不想再安装太多软件了。Scrapy的入门教程见以下链接: 上面的入门教程很基础。先跟随作者,动起来。不要只阅读上面的介绍性教程。这是一个简短的总结。我们来看看Scrapy爬虫流程:1.在Item中定义你要爬取的数据:movie_name就像字典中的“key”,爬取的数量

Scrapy 框架入门

Scrapy 入门教程 在本教程中,我已经安装了 Scrapy。本教程将带您完成以下任务: 创建一个 Scrapy 项目以定义提取的项目 编写一个爬取 网站 的蜘蛛并提取项目 编写一个项目管道来存储提取的项目(即数据) 创建一个项目 之前开始抓取,您必须创建一个新的 Scrapy 项目。转到您打算存储代码的目录并运行以下命令:scrapy startproject tutorial tutorial/ scrapy.cfg tutorial/ __init__

[scrapy] 开始学习Scrapy

Scrapy 简介 Scrapy 是一个用于爬取网站 数据并提取结构化数据的应用程序框架。它可用于数据挖掘、信息处理或历史数据存储等一系列程序中。所谓网络爬虫,就是在互联网上到处或有针对性地爬取数据的程序。当然,这种说法不够专业。更专业的描述是爬取特定网站网页的HTML数据。爬取网页的一般方法是定义一个条目。页面,然后一般一个页面会有其他页面的url,所以这些url是从当前页面获取的,加入爬虫的抓取队列,然后进入新页面,然后递归执行上述操作。实际上,它与深度有关,与遍历或广度遍历相同。屏幕截图

2015最新Android基础入门教程目录(汉化版)

2015最新Android基础入门教程目录(最终版) 标签(空格分隔):Android基础入门教程 前言:关于今天终于结束了,全套教程一共写了148节,附目录,关于教程的由来,作者的情况和自学经验,资源分享以及一些问题可以戳:成品散花~以下是本系列教程的完整目录:第一章:环境搭建与开发( 10月1日完成0)Android Basic入门教程--1.1背景及系统架构