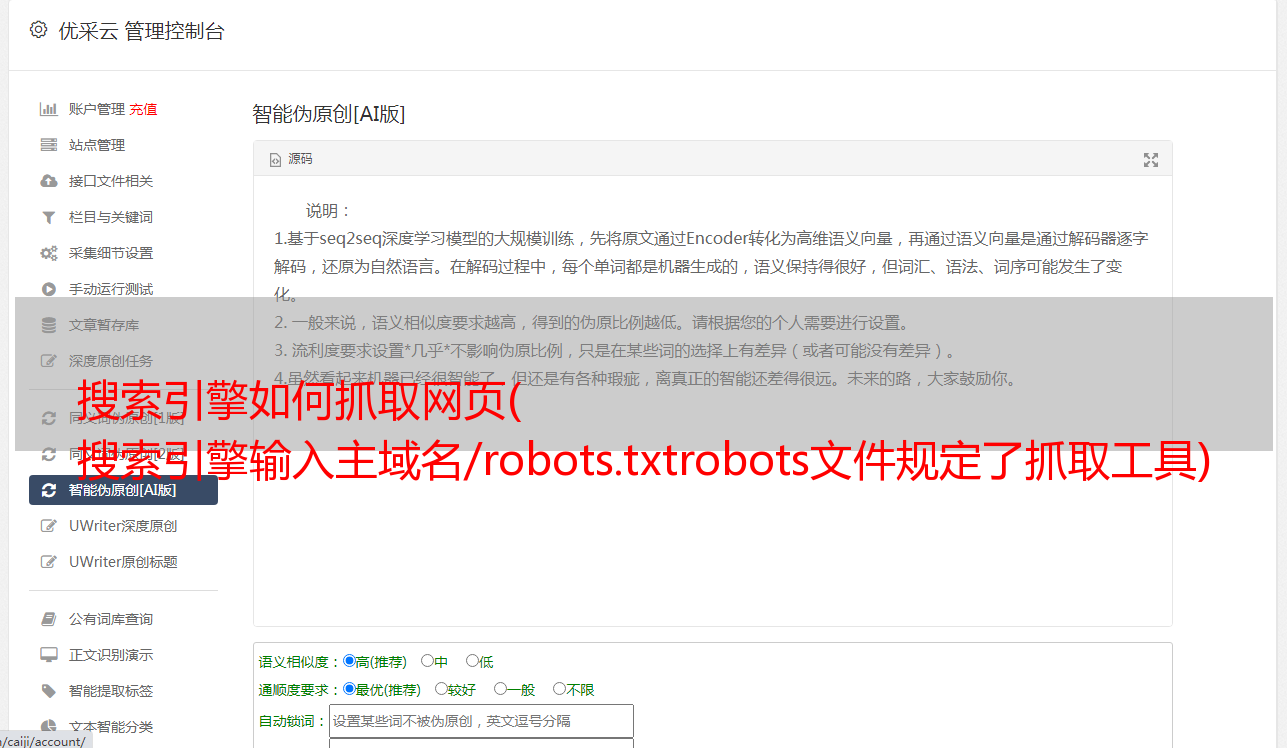

搜索引擎如何抓取网页( 搜索引擎输入主域名/robots.txtrobots文件规定了抓取工具)

优采云 发布时间: 2022-01-18 15:02搜索引擎如何抓取网页(

搜索引擎输入主域名/robots.txtrobots文件规定了抓取工具)

如何查看机器人文件?

浏览器输入主域名/robots.txt

robots.txt的作用

robots.txt 文件定义了 网站 搜索引擎爬虫可以访问的 URL,并且不会阻止搜索引擎将页面编入索引。如果要禁止索引(收录),可以使用noindex,或者设置网页密码才能访问(因为如果其他网页使用描述性文字指向一个网页,谷歌仍然可以访问该网页而不访问它。索引它的 URL/收录这个页面)。

robots.txt 文件主要用于管理到 网站 的爬虫流量,通常是为了防止 Google 访问文件(取决于文件类型)。

如果您使用 robots.txt 文件阻止 Google 抓取网页,有时其网址可能仍会显示在搜索结果中(通过另一个链接找到),但搜索结果不会收录该网页的说明:

如果在加载页面时跳过不重要的图像、脚本或样式文件等资源不会对页面产生太大影响,您可以使用 robots.txt 文件阻止此类资源。但是,如果此类资源的缺乏使 Google 的爬虫更难解释页面,请不要阻止此类资源,否则 Google 将无法有效分析依赖于此类资源的页面。

例如:

robots.txt 指令的一些限制

并非所有搜索引擎都支持 robots.txt 指令。

robots.txt 文件中的命令不会针对 网站 强制执行爬虫行为;是否遵守这些命令由爬虫自行决定。Googlebot 和其他合法网络爬虫遵循 robots.txt 文件中的命令,但其他爬虫不一定。

不同的爬虫以不同的方式解析语法。

虽然普通的网络爬虫遵循 robots.txt 文件中的说明,但每个爬虫可能会以不同的方式解析这些说明。

如果其他 网站 上有链接,则可能仍会索引被 robots.txt 文件阻止的页面

尽管 Google 不会抓取或索引被 robots.txt 文件阻止的内容,但如果网络上其他地方存在指向被阻止 URL 的链接,我们仍可能会找到该 URL 并将其编入索引。

如何创建机器人文件?

使用任何文本编辑器(即编写代码的软件)创建 robots.txt 文件。

格式和位置规则:

robots 文件的编写规则爬虫按从上到下的顺序处理组。一个用户代理只能匹配一个规则集(即匹配相应用户代理的第一个最具体的组)。系统的默认假设是用户代理可以爬取所有未被禁止规则阻止的页面或目录。规则区分大小写。例如, disallow: /file.asp 有效但无效。# 字符表示注释的开始。

举例说明:

# Example 1: Block only Googlebot

User-agent: Googlebot

Disallow: /

# Example 2: Block Googlebot and Adsbot

User-agent: Googlebot

User-agent: AdsBot-Google

Disallow: /

# Example 3: Block all but AdsBot crawlers

User-agent: *

Disallow: /

Sitemap: http://www.example.com/sitemap.xml

上传机器人文件

添加到 网站 的根目录(取决于 网站 和服务器架构)。

测试 robots.txt 标签

要测试新上传的 robots.txt 文件是否可公开访问,请在浏览器中打开一个隐身窗口(或等效窗口)并转到 robots.txt 文件所在的位置。例如:。如果您看到 robots.txt 文件的内容,您就可以测试标记了。

测试工具:

常用机器人规则

# 禁止所有搜索引擎抓取整个网站

User-agent: *

Disallow: /

# 禁止所有搜索引擎抓取某一目录及其内容(禁止抓取的目录字符串可以出现在路径中的任何位置,因此 Disallow: /junk/ 与 https://example.com/junk/ 和 https://example.com/for-sale/other/junk/ 均匹配。)

User-agent: *

Disallow: /calendar/

Disallow: /junk/

Disallow: /books/fiction/contemporary/

# 只有 googlebot-news 可以抓取整个网站。

User-agent: Googlebot-news

Allow: /

User-agent: *

Disallow: /

# Unnecessarybot 不能抓取相应网站,所有其他漫游器都可以。

User-agent: Unnecessarybot

Disallow: /

User-agent: *

Allow: /

# 禁止所有搜索引擎抓取 useless_file.html 网页。

User-agent: *

Disallow: /useless_file.html

# 禁止访问 dogs.jpg 图片。

User-agent: Googlebot-Image

Disallow: /images/dogs.jpg

# 禁止 Google 图片访问您网站上的所有图片(如果无法抓取图片和视频,则 Google 无法将其编入索引。)

User-agent: Googlebot-Image

Disallow: /

# 禁止谷歌抓取所有 .gif 文件。

User-agent: Googlebot

Disallow: /*.gif$

# 禁止抓取整个网站,但允许 Mediapartners-Google 访问内容

User-agent: *

Disallow: /

User-agent: Mediapartners-Google

Allow: /

# 禁止谷歌抓取所有 .xls 文件。

User-agent: Googlebot

Disallow: /*.xls$

如何更新机器人文件?

直接传过去,打开,复制到编辑器,修改,再上传到根目录,用GSC测试后提交。(没有删除原robots文件的步骤)