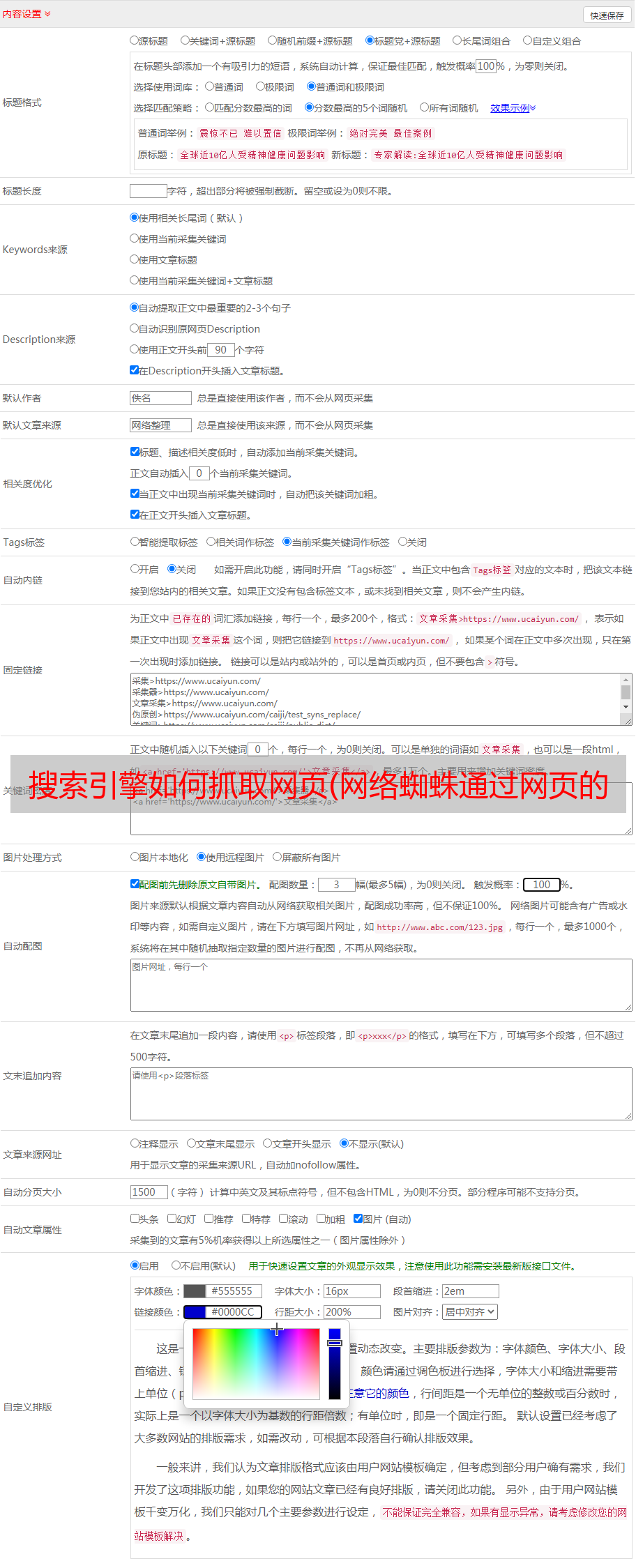

搜索引擎如何抓取网页(网络蜘蛛通过网页的链接地址来寻找网页中的网页)

优采云 发布时间: 2021-12-27 12:04搜索引擎如何抓取网页(网络蜘蛛通过网页的链接地址来寻找网页中的网页)

搜索引擎机器人也叫Web Spider,这是一个很形象的名字。把互联网比作蜘蛛网,那么蜘蛛就是在网上爬来爬去的蜘蛛。网络蜘蛛使用网页的链接地址来查找网页。从网站的某个页面(通常是首页)开始,阅读网页内容,找到网页中的其他链接地址,然后利用这些链接地址找到下一个网页。循环一直持续到该网站的所有页面都已被抓取为止。如果把整个互联网看作一个网站,那么网络蜘蛛就可以利用这个原理来抓取互联网上的所有网页。

在抓取网页时,网络蜘蛛一般有两种策略:广度优先和深度优先(如下图)。

广度优先是指网络蜘蛛会先抓取起始网页中链接的所有网页,然后选择其中一个链接的网页,继续抓取该网页中链接的所有网页。这是最常用的方法,因为这种方法可以让网络蜘蛛并行处理,提高爬行速度。

深度优先是指网络蜘蛛会从起始页开始,逐个跟踪每一个链接,处理完这一行后再转移到下一个起始页,继续跟踪链接。这种方法的优点是更容易设计网络蜘蛛。

由于不可能爬取所有网页,因此一些网络蜘蛛设置了访问一些不太重要的网站的次数。比如上面A是起始网页,属于0层,B、C、D、E、F属于1层,G、H属于2层,I属于3层。 如果访问级别网络蜘蛛设置为2,网页我不会被访问。这也使得某些网站上的部分网页可以在搜索引擎上搜索到,而另一部分则无法搜索到。对于网站设计师来说,扁平化的网站结构设计有助于搜索引擎抓取更多的网页。

网络蜘蛛在访问网页时,经常会遇到加密数据和网络权限的问题。某些网页需要会员权限才能访问。当然,站长可以通过协议来防止网络蜘蛛爬行,但是对于一些卖报告的网站,他们希望搜索引擎可以搜索到他们的报告,但不能让搜索者完全免费查看。提供相应的用户名和密码给网络蜘蛛。网络蜘蛛可以使用给定的权限抓取这些网页以提供搜索。当搜索者点击查看网页时,搜索者还需要提供相应的权限验证。

除特别注明外,均为雷雪博客原创文章,禁止以任何形式转载

这篇文章的链接: