php多线程抓取网页(Python多线程爬虫扫描器介绍)

优采云 发布时间: 2021-12-10 14:05php多线程抓取网页(Python多线程爬虫扫描器介绍)

Python多线程爬虫扫描程序

一、Python多线程扫描程序简介

对于小白来说,这里介绍的扫描仪不是条形码扫描仪

事实上,多线程扫描程序是Python爬虫程序之一。它可以自动检测安全漏洞,如远程服务器和网站、弱密码、扫描IP、文件、端口和目录的python程序。它能快速准确地发现扫描目标的漏洞,为深入入侵安全检测打下基础。

Python多线程爬虫相关知识也是Python黑客学习渗透技术所必需的

例如,python黑客工具具有以下功能:

1.扫描站点漏洞、*敏*感*词*木马和危险程序

2.扫描对比文件的差异,并监控网站文件

3.检测网页状态代码(200、403、404、500==)

4.检查网站是否存在搜索引擎优化欺骗[为用户和搜索引擎返回不同的结果]

5.网站150个虚拟主机空间连接,例如压力测试中的IIS连接

6.模拟搜索引擎蜘蛛抓取美国用户代理用户代理

7.网站程序和版本确认,网站后台扫描

8.扫描端口等,玩蛇网游戏

二、黑客多线程扫描仪的功能

在本次播放snake Python home的图形和视频教程中,Python scanner要实现的简单功能包括:

1.多线程扫描(更快)

2.模拟搜索引擎爬虫(用户代理)

3.使用代理服务器(大量代理IP交换和获取)

4.扫描状态代码、文件目录等

5.过滤不必要的文件或目录等

6.您可以手动更改与扫描匹配的词典

7.它可以制成一个带有图形界面的黑客工具

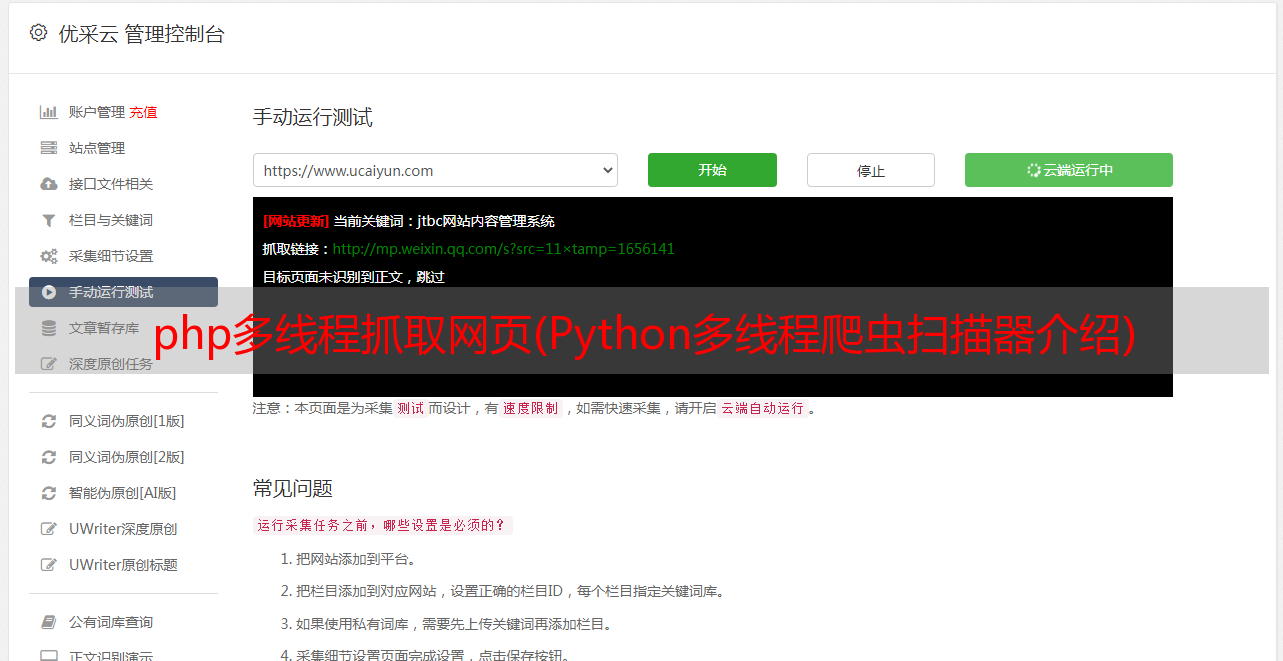

如下图所示:(本教程为终端版本,未来将推出相应的GUI版本)

三、测试多线程爬虫环境的构造

1.linux\Mac OS X\windows

2.编辑器IDE,python2.x/python3.x

3.构建一个开放源代码的web程序或博客程序进行本地测试(play snake教程环境:apache2+PHP5+WordPress)

4.获取匹配列表字典、目录或漏洞文件字典(WordPress、zblog、Dedecms等)

5.确保本地网络和扫描服务器之间的连接和稳定性

6.注意:建议在本地构建测试环境。请勿扫描网络上的其他网站和服务器。这是违法的

声明:本视频教程仅用于Python学习和测试,不应用于非法方式和行为

一切后果自负。玩蛇网与斯巴达无关

四、黑客工具实用代码案例分析

# -*- coding:utf-8 -*-

__author__="iplaypython.com"

import os

import urllib2

import threading

import Queue

import time

import random

q = Queue.Queue() # Queue产生一个队列,有3种类型队列 默认用 FIFO队列

threading_num = 5 # 开启5个线程

# 扫描本地IP或域名

domain_name = "http://127.0.0.1"

# 百度蜘蛛UA

Baidu_spider = "Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html)"

# 不需要的文件过滤列表

exclude_list = ['.jpg', '.gif', '.css', '.png', '.js', '.scss']

proxy_list = [ # 代理服务器,可能已经失效,换为自己的

{'http': '117.28.254.130:8080'},

{'http': '118.144.177.254:3128'},

{'http': '113.118.211.152:9797'},

]

# 打开字典文件,开始过滤不需要的文件路径

with open("/home/leo/app_txt/wordpress.txt" , "r") as lines:

for line in lines:

line = line.rstrip()

if os.path.splitext(line)[1] not in exclude_list:

q.put(line) #将line传入到队列 q 中

# 扫描器方法

def crawler():

while not q.empty(): # 循环

path = q.get() 将line从队列 q 中取出来

url = "%s%s" % (domain_name, path) # 组合url地址,用于下一步提交

random_proxy = random.choice(proxy_list) # 随机使用一个代理服务器

proxy_support = urllib2.ProxyHandler(random_proxy)

opener = urllib2.build_opener(proxy_support)

urllib2.install_opener(opener)

headers = {}

headers['User-Agent'] = Baidu_spider # 蜘蛛的头部信息

# 玩蛇网 www.iplaypy.com

request = urllib2.Request(url, headers=headers)

try:

response = urllib2.urlopen(request)

content = response.read()

if len(content): # 内容不为空的情况下返回状态码、路径

print "Status [%s] - path: %s" % (response.code, path)

response.close()

time.sleep(1) # 休息一会儿,防止速度过快连接数过大被封掉IP

except urllib2.HTTPError as e:

# print e.code, path

pass # 异常处理,先暂时pass掉

if __name__ == '__main__':

# 创建多线程并指明函数的入口为crawler,以后还可以传参进去

for i in range(threading_num):

t = threading.Thread(target=crawler)

t.start()

#在上面的代码中,我们总共导入了6个模块,这些模块都是下一步要使用的功能模块

#操作系统用于过滤我们不需要扫描的后缀文件

#Urlib2负责抓取,线程是我们的Python多线程模块

#这次还需要一个线程安全的队列模块Queue

#另外两个相对简单。一个是随机模块,另一个是时间模块

五、下载与本文相关的资源

黑客工具\uPython多线程爬虫抓取扫描仪Python完整源代码下载:

本地高速下载:爬虫扫描程序rar

源代码大小:1.6KB

Python多线程爬虫抓取扫描程序

这是pyhton多线程扫描仪视频课程的内容页,稍后将更新

提供课程相关资源和python源代码下载,以及详细的图形教程使用

黑客工具,黑客扫描仪,端口扫描,免费网页网站扫描仪

百度在线硬盘下载地址:

由于视频教程持续约50分钟,因此视频分两部分发送

Python多线程爬虫抓取扫描程序-上一节

Python多线程爬虫抓取扫描程序-下一节

任何问题和建议都可以留在评论区供讨论

[视频播放密码]:qqun20419428