搜索引擎如何抓取网页(什么是搜索引擎蜘蛛?蜘蛛如何提升蜘蛛爬取效果?)

优采云 发布时间: 2021-11-24 12:21搜索引擎如何抓取网页(什么是搜索引擎蜘蛛?蜘蛛如何提升蜘蛛爬取效果?)

众所周知,网络推广的最终目的是带来流量、排名和订单。最重要的前提是搜索引擎能做好你的网站和文章.收录。然而,当面对收录的糟糕结果时,很多小伙伴不知道为什么,很大程度上是因为他们不了解一个关键点——搜索引擎蜘蛛。

一、什么是搜索引擎蜘蛛?

搜索引擎如何利用蜘蛛对收录进行排名网站?如何提高蜘蛛爬行效果?

的确,按照白话的理解,互联网可以理解为一个巨大的“蜘蛛网”,搜索引擎蜘蛛类似于真正的“机器人”。

蜘蛛的主要任务是浏览巨大的蜘蛛网(Internet)中的信息,然后抓取信息到搜索引擎的服务器,建立索引数据库。这就像一个机器人浏览我们的网站并将内容保存在自己的电脑上。

每个独立的搜索引擎都会有自己的网络爬虫爬虫。蜘蛛爬虫通过对网页中超链接的分析,不断地访问和抓取更多的网页。抓取到的网页称为网页快照。毫无疑问,搜索引擎蜘蛛以某种模式抓取网页。

如下:

1. 权重优先是指链接的权重,然后综合深度优先和广度优先的策略爬取。比如这个环节的权重好,就采用深度优先;如果权重很低,则采用宽度优先。

2. 蜘蛛深度爬取是指当蜘蛛找到要爬取的链接时,会一直往前爬,直到最深一层不能爬取为止,然后回到原来的爬取页面,再爬取下一个链接。就好像从网站的首页爬到网站的第一版块页面,然后通过版块页面爬取一个内容页面,再跳出首页爬第二个网站@ >.

3. 蜘蛛广度爬取是指当一个蜘蛛爬取一个页面时,有多个链接,而不是深度爬取一个链接。比如蜘蛛进入网站的首页后,就有效的爬取了所有的栏目页面。然后爬取所有栏目页下的二级栏目或内容页,即一一抓取,而不是一一抓取。

4. revisit and fetch 这个可以从字面上理解。因为搜索引擎大多使用单次重访和所有重访的组合。所以,我们在制作网站内容的时候,一定要记得每天定时更新,让更多的蜘蛛可以访问,抓取更多,才能收录快。

**二、搜索引擎蜘蛛是如何爬行的?如何吸引蜘蛛抓取页面

搜索引擎的工作过程大致可以分为三个阶段:**

(1) 爬行爬行:搜索引擎蜘蛛通过跟踪链接发现和访问页面,读取页面的HTML代码,并保存到数据库中。

(2) 预处理:索引程序对抓取的页面数据进行文本提取、中文分词、索引、倒排索引,为排名程序调用做准备。

(3) Ranking:用户输入查询词(关键词)后,排名程序调用索引数据,计算相关性,然后生成一定格式的搜索结果页面。

搜索引擎的工作原理 爬取和爬取是搜索引擎完成数据采集任务的第一步。搜索引擎用来抓取页面的程序称为蜘蛛

一个合格的SEOer,如果想让自己的页面有更多的收录,一定要尽量吸引蜘蛛爬行。

蜘蛛爬取页面有几个因素:

(1)网站和页面权重、质量高、时间长的网站一般被认为具有较高的权重和较高的爬取深度。收录的页面也是会更多。

(2)页面的更新频率,蜘蛛每次爬取都会保存页面数据,如果第二次和第三次爬取和第一次一样,说明没有更新。时间久了,蜘蛛不会频繁抓取你的页面,如果内容更新频繁,蜘蛛会频繁访问页面来抓取新页面。

(3)导入链接,无论是内链还是外链,如果要被蜘蛛抓取,必须要有导入链接才能进入页面,否则蜘蛛会不知道存在这一页。

(4)与首页的点击距离一般是网站上权重最高的首页。外链大部分都会指向首页。那么蜘蛛访问最频繁的页面就是首页。点击距离离首页越近,页面权重越高,被爬取的几率越大。

如何吸引百度蜘蛛来吸引蜘蛛爬取我们的页面?

经常更新网站内容,最好是高质量的原创内容。

主动向搜索引擎提供我们的新页面,让蜘蛛更快找到,如百度链接提交、爬虫诊断等。

建立外链,可以和相关的网站交换友情链接,也可以将高质量的文章发布到自己在其他平台的页面上,内容必须是相关的。

制作网站的地图,每个网站都要有一个sitemap,网站的所有页面都在sitemap中,方便蜘蛛爬取。

**三、搜索引擎蜘蛛SPIDER无法顺利爬行的原因分析

1.服务器连接异常**

服务器连接异常有两种情况:一种是网站不稳定,百度蜘蛛在尝试连接你的网站服务器时暂时无法连接;另一种是百度蜘蛛一直无法连接到你网站服务器。

服务器连接异常的原因通常是你的网站服务器太大,过载。也有可能你的 网站 运行不正常。请检查网站的web服务器(如apache、iis)是否安装运行正常,并使用浏览器查看主页是否可以正常访问。你的网站和主机也可能屏蔽了百度蜘蛛的访问,需要检查网站和主机的防火墙。

2.网络运营商异常

有两种类型的网络运营商:电信和中国联通。百度蜘蛛无法通过电信或网通访问您的网站。如果出现这种情况,您需要联系网络服务运营商,或者购买双线服务的空间或购买CDN服务。

3.DNS 异常

当百度蜘蛛无法解析你的网站 IP时,就会出现DNS异常。可能是你的网站IP地址错误,或者域名服务商封禁了百度蜘蛛。请使用 WHOIS 或主机检查您的 网站 IP 地址是否正确且可解析。如果不正确或无法解决,请联系域名注册商更新您的IP地址。

4.IP禁令

IP禁止是:限制网络的出口IP地址,禁止该IP段的用户访问内容,这里特指禁止百度蜘蛛IP。仅当您的 网站 不希望百度蜘蛛访问时才需要此设置。如果您想让百度蜘蛛访问您的网站,请检查相关设置中是否错误添加了百度蜘蛛IP。也有可能你网站所在的空间服务商被封禁了百度IP,则需要联系服务商更改设置。

5.UA 块

UA是User-Agent,服务器通过UA识别访问者的身份。当网站返回异常页面(如402、500)或跳转到其他页面)访问指定的UA时,即被UA禁止。当你的网站不想百度时,只有蜘蛛访问才需要这个设置。如果想让百度蜘蛛访问你的网站,useragent相关设置中是否有百度蜘蛛UA,及时修改。

6.死链接

页面无效,不能为用户提供任何有价值信息的页面为死链接,包括协议死链接和内容死链接两种形式。协议死链接,死链接由页面的TCP协议状态/HTTP协议状态明确指示,如404、402、502状态等;内容死链接,服务器返回状态正常,但内容已更改为不存在、已删除、或需要权限等与原内容无关的信息页。

对于死链接,我们建议网站使用协议死链接,通过百度站长平台-死链接工具提交给百度,以便百度更快找到死链接,减少死链接对用户和搜索引擎的负面影响。

7. 异常跳转

将网络请求重定向到其他位置是一种跳转,异常跳转是指以下几种情况。

1.当前页面无效(内容被删除、死链接等)。直接跳转到上一个目录或主页。百度建议站长删除无效页面的入口超链接。

2. 跳转到错误或无效的页面。

提示:对于长期重定向到其他域名,如网站更改域名,百度建议使用201重定向协议进行设置。

8.其他例外

1. 针对百度引用的异常:从百度返回引用的网页行为与正常内容不同。

2.百度UA异常:网页返回百度UA的行为与页面原创内容不同。

3.JS跳转异常:网页加载了百度无法识别的JS跳转代码,导致用户通过搜索结果进入页面后跳转。

4. 压力过大误封:百度会根据网站规模、流量等信息自动设置合理的爬取压力。但是,在异常情况下,例如压力控制异常,服务器会根据自身的负载偶尔被禁止进行保护。在这种情况下,请在返回码中返回502(它的意思是“服务不可用”),所以百度蜘蛛会在一段时间后再次尝试抓取这个链接,如果网站空闲,就会成功抓取Pick .

**四、利用蜘蛛池制作新的网站快速收录

根据多年搜索引擎营销推广的工作经验,当一个新网站接入搜索引擎时,就会进入沙盒期。一些新网站可以快速受益于搜索引擎,在短时间内摆脱沙盒期。关键原因是收录以下元素:**

1、技术设备

我们知道,搜索引擎的收录越来越方便快捷。通常,人们必须将 网站 标准化为 SEO。从技术角度来看,您必须:

① 非常重视网页的客户体验,包括网页的视觉效果和加载率。

②制作站点地图,根据网页的优先级合理流转相关网址。

③配备百度熊掌ID,可快速向百度搜索官方网站提交优质网址。

所描述的内容是新站必备的标准化设备。

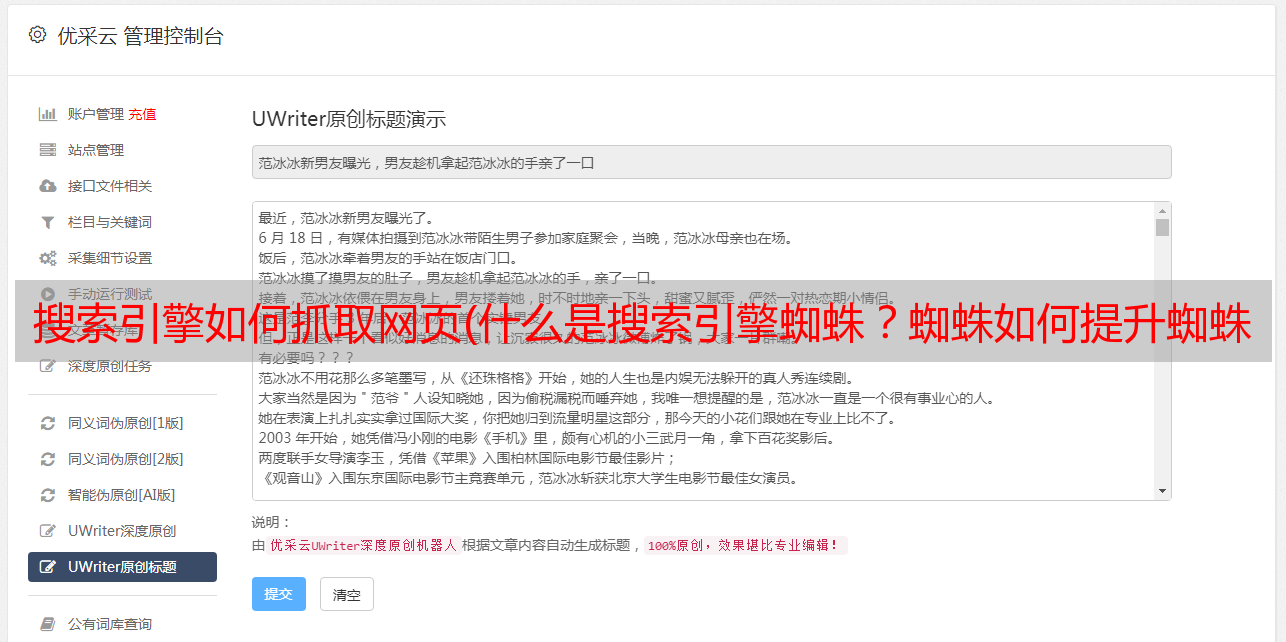

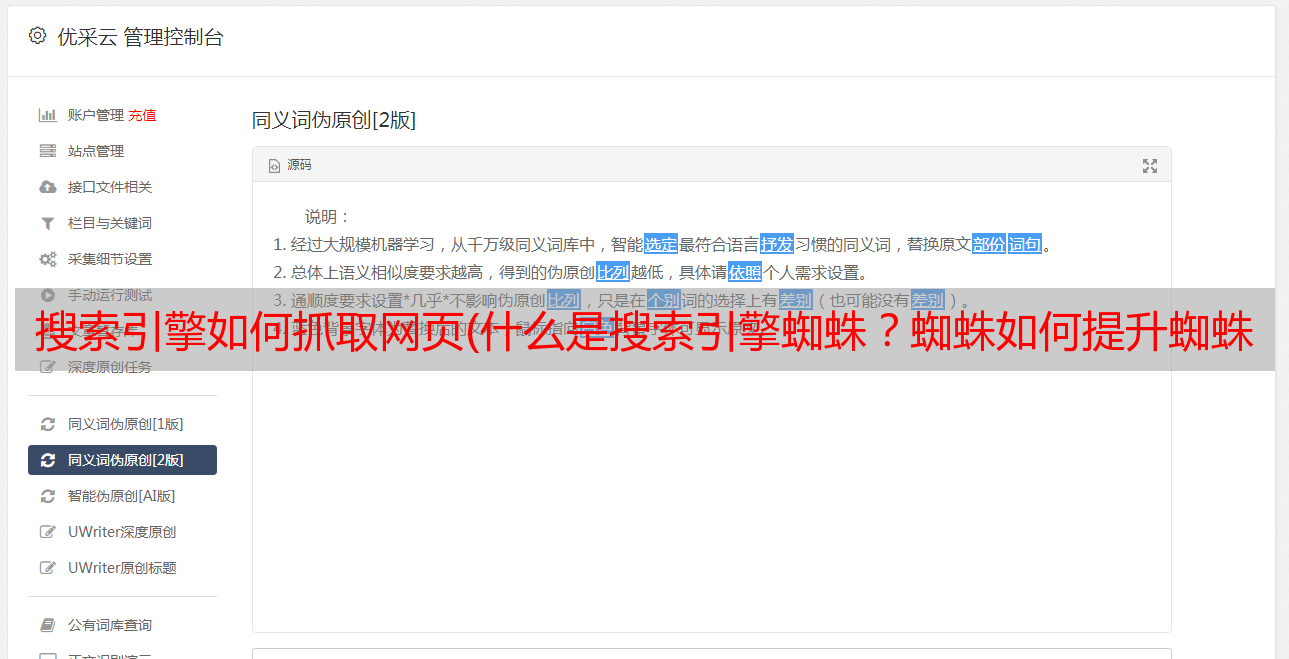

使用蜘蛛池加速新网站收录

2、网页页面质量

对于搜索引擎收录来说,网页质量是首要的评价标准。从理论上讲,它是由几个层次组成的。对于这些新网站,收入相对较快的网站,除了提交百度网址外,还重点关注以下几个方面:

① 时事内容

对于新展来说,如果想让搜索引擎收录越来越快,经过多年的具体测试,人们发现制造业的热点新闻更容易、更快收录。

他及时搜索关键词的量会很高,也可能比较平均,但这不是一个基本要素。

②专题内容

从专业权威的角度,建立一个网站的内部小型研讨会,尽可能与某个制造行业进行讨论。最重要的是相关内容,一般是多层次的有机化学成分。

例如:来自KOL的意见,制造业组织权威专家多年的总结,以及社会发展科研团队相关数据信息的应用。

③内容多元化

对于网页的多样化,通常由多媒体系统元素组成,例如:小视频、数据图表、高清图片等,这些都是视频的介入,显得非常重要。

使用蜘蛛池加速新网站收录

3、外部资源

对于搜索引擎收录,这里人们所指的外部资源一般指的是外部链接。如果你发现一个新网站发布的早,它的收录和排名会迅速上升,甚至是竖线和折线类型的索引值图,那么关键元素就是外部链接。

这不一定基于高质量的外部链接。在某些情况下,它仍然以总数为基础,人们普遍建议选择前者。

4、站群排水方式

站群,即一个人或一个群体实际操作几个网址,目的是根据搜索引擎获取大量的总流量,或者偏向同一网址的链接以提高自然排名。2005-2012年,国内一些SEO工作者明确提出了站群的定义:多个单独的网站域名(包括二级域名)URL具有统一的管理方式和相互关系。2008年初,站群软件开发者开发设计了一种更便捷的网站采集方式,即基于关键词自动采集网站内容。以前的采集方法是 Write 标准方法。

5、蜘蛛池排水方法

Spider Pool是一堆由网站域名组成的站群,在每个网站下转化为大量的网页(抓取一堆文字内容相互形成) ,页面设计和一切普通网页没有太大区别。由于每个网站都有大量的网页,所有站群搜索引擎蜘蛛的总抓取量也非常大。将搜索引擎蜘蛛引入非收录的网页,就是在站群的所有普通网页的模板中独立打开一个DIV。收录的网页没有连接,而且web服务器没有设置缓存文件,搜索引擎蜘蛛每次浏览,DIV中呈现的连接在这方面都是不同的。简而言之,蜘蛛池实际上在短时间内显示了许多不是收录的真实外部链接。如果暴露的频道越多,被爬取的概率就会越高。收录率当然是up了,而且因为是外链,所以在排名上也有一定的前进方向,大大加分。