php抓取网页所有图片(任务解析及提升任务)

优采云 发布时间: 2021-11-23 08:21php抓取网页所有图片(任务解析及提升任务)

这个任务是:

对搜索到的网页进行聚类,并将聚类结果显示给用户。用户可以选择其中一个类别,标记焦点,以该类别的关键词为主体,用户可以跟踪该主题并了解该主题。

截止日期:11.09

任务分析:

基本任务:对网页进行聚类,按类别归档,将图片放入相应的文件夹中,将文本放入相应的文件中。

推广任务:持续跟踪网页,持续下载符合条件的文件。

编译环境总结:

如果想省事,可以直接从睿思下载Anaconda Navigator。安装后直接使用,打包即可。

话不多说,先贴上代码:

#################################################

# 网页爬虫

# Email : jtailong@163.com

#################################################

import re

import time

import urllib.request

import requests

from bs4 import BeautifulSoup

#添加网页

url = \'https://www.douban.com/\'

#将图片抓取,并打包

req = urllib.request.urlopen(url)

data = req.read().decode(\'utf-8\')

match = re.compile("data-origin=\"(.+?\.jpg)")

#j记录图片信息

f = open(\'D:\P\图片下载记录.txt\', \'w+\')

for sj in match.findall(data):

try:

f.write(sj)

except:

print("fail")

f.write(\'\n\')

f.close()

f1 = open(\'D:\P\Pic_information.txt\', \'r+\')

#开始抓取网页图片

x = 0

for lj in f1.readlines():

img = urllib.request.urlretrieve(lj, \'D:/P/%s.jpg\' % x)

x += 1

f1.close()

#将网页上所有的文字信息,记录到TXT文件当中

r = requests.get(url)

soup = BeautifulSoup(r.text, \'html.parser\')

content = soup.text

print (content)

file = open(\'D:\P\网页上所有文字信息.txt\', \'w\', encoding=\'utf-8\')

file.write(content)

file.close()

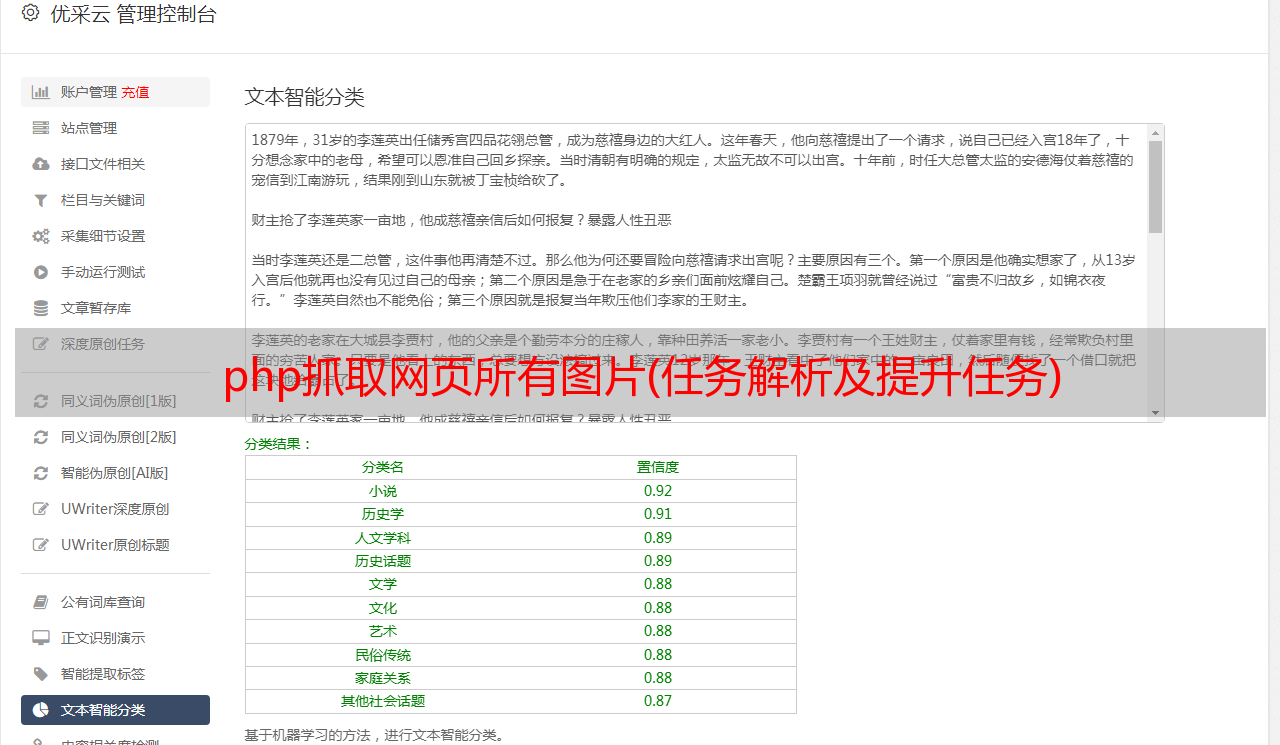

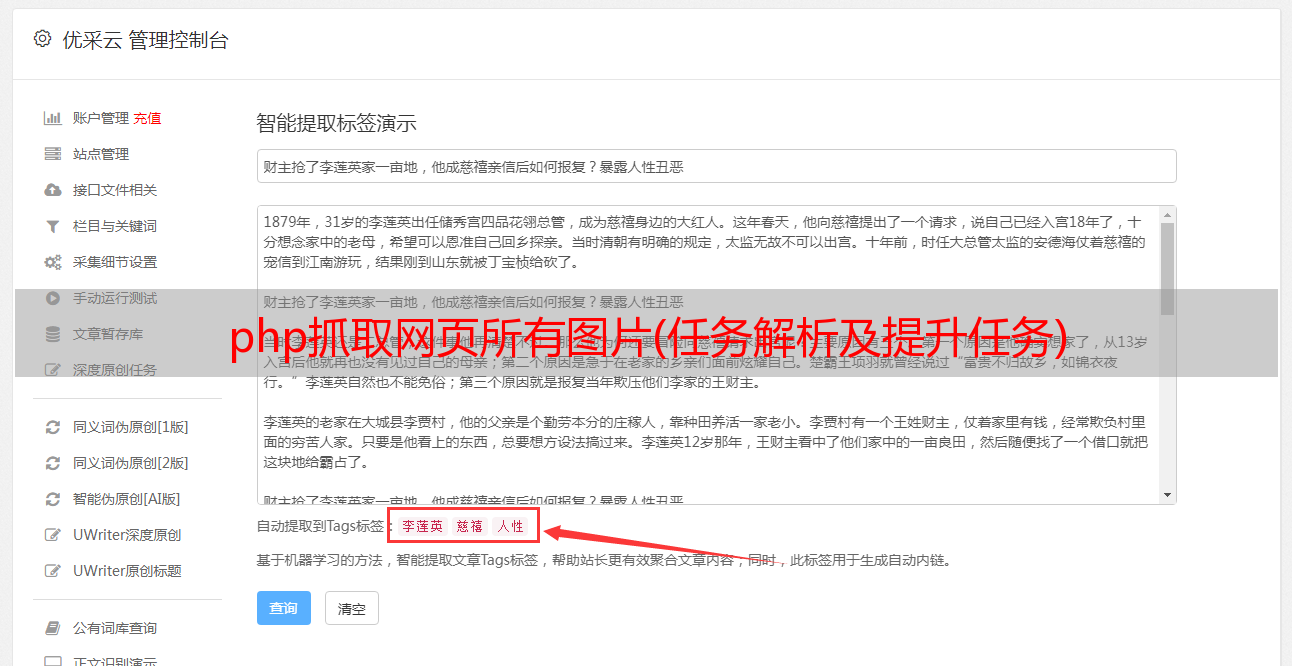

编译效果对比:

上图:原网页;下图:爬取后,可以看到文件夹中的信息。

更新:

通过这个编程,我对爬虫的理解是: