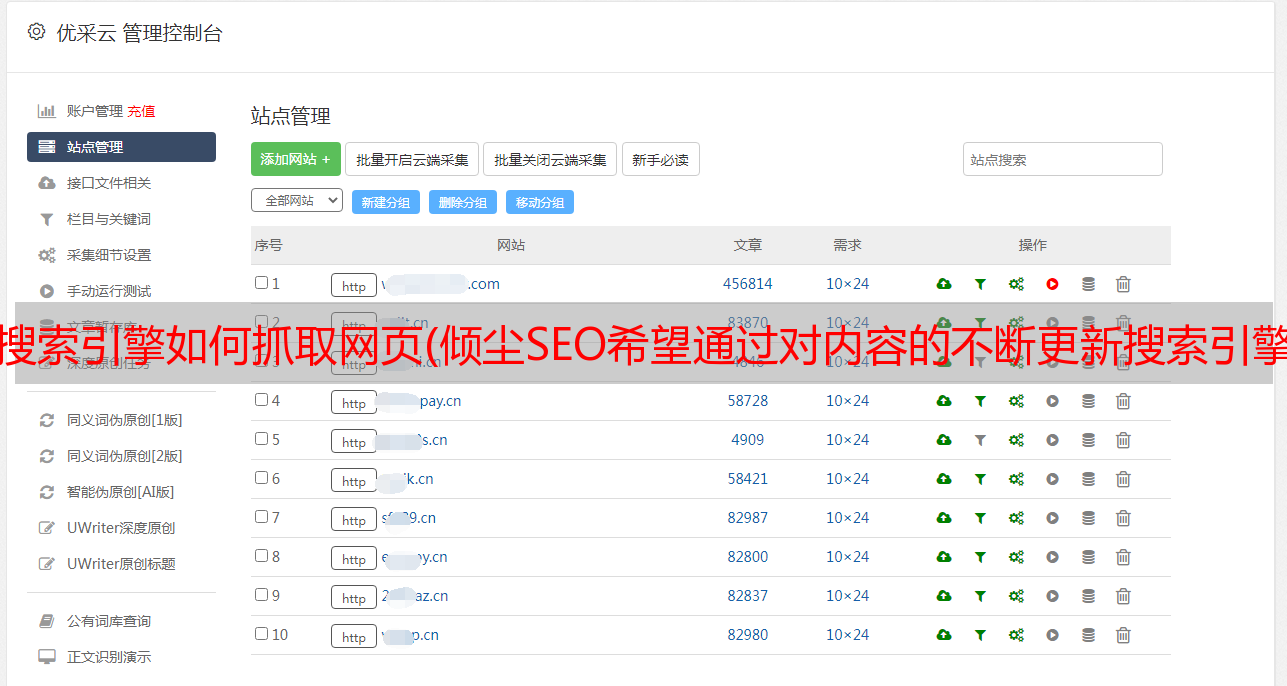

搜索引擎如何抓取网页(倾尘SEO希望通过对内容的不断更新搜索引擎保持同步(图) )

优采云 发布时间: 2021-10-28 11:05搜索引擎如何抓取网页(倾尘SEO希望通过对内容的不断更新搜索引擎保持同步(图)

)

概括

随着科技和互联网的发展进步,各大搜索引擎都在发生着翻天覆地的变化,变化也非常迅速。擎辰SEO希望通过不断更新内容,紧跟各大搜索引擎,把最新的相关新闻带给所有站长。

随着科技和互联网的发展进步,各大搜索引擎都在发生着翻天覆地的变化,变化也非常迅速。擎辰SEO希望通过不断更新内容,紧跟各大搜索引擎,把最新的相关新闻带给所有站长。

一:爬行

作为搜索引擎的上游,数据抓取系统主要用于互联网数据的采集、存储和更新。它们就像在互联网上爬行的蜘蛛。所以不叫“蜘蛛”,最常见的搜索引擎“蜘蛛”有:Googlebot、Baiduspdier、搜狗网蜘蛛、360Spider等。

以百度百科为例

爬行友好

在庞大的互联网数据中,这就要求爬虫系统高效利用带宽,利用有限的硬件和带宽,尽可能多地爬取有价值的资源。如果搜索引擎在爬取过程中消耗的资源过多,会影响爬取网站的正常访问,所以在爬取过程中使用了一定的爬取压力控制来实现不影响正常访问网站 的用户,但可以做到最好。有可能获得宝贵的资源。

对于网站抓取压力的站长,可以使用百度站长工具进行调整。

抓取优先级

对于互联网数据的快速变化,搜索引擎基本上不可能与之完全一致。因此,有必要通过爬虫系统设计一个有效的优先级分配策略。从而达到最好的效果。主要包括:深度优先遍历策略、广度优先遍历策略、pr-first策略、反链策略、社交分享引导策略等。

返回错误代码

在蜘蛛爬取过程中,最常见的返回码有:

(1)Error 404 "NOT FOUND" 表示该网页不存在,如果搜索引擎蜘蛛在短时间内再次找到该网址,则不会被抓取。

(2)返回403“Forbidden”,表示这个网页被禁止访问。如果这个网页的网址是新的,那么搜索引擎蜘蛛暂时不会抓取它。如果这个网页的网址已经被抓取, 搜索引擎不会被直接删除,但会在短时间内多次访问,如果页面可以访问,则正常抓取,如果仍然被禁止访问,则该网址将被视为无效链接并将从搜索引擎中删除。从数据库中删除。

(3) 返回 301 "Moved Permanently",这是因为这个页面的 URL 已经被重定向到了新的 URL。

(4)返回503“Service Unavailable”,表示该页面的URL暂时无法访问。这种情况一般网站关闭或者宽带限制容易出现。这种情况下,搜索引擎不会直接删除,而且会在短时间内多次重复访问,如果页面可以访问,则正常抓取,如果仍然返回503,则认为此URL无效链接并将从搜索引擎的数据库中删除。

URL重定向识别

在互联网中,由于各种原因,总会有一些网页处于URL重定向状态。为了抓取此类资源,搜索引擎蜘蛛需要识别和判断页面 URL 重定向。当然,它还可以防止作弊。页面重定向分为三类:页面301重定向、Mate Refresh重定向和Js重定向。

过滤重复的 URL

在搜索引擎蜘蛛抓取和抓取的过程中,也会判断这个页面之前是否被抓取过。如果页面没有被爬取,则被爬取的页面会被放入爬取URL的集合中。在搜索引擎中判断一个页面是否被重复抓取涉及最核心的快速搜索和比较,也涉及到URL的规范化,对吧?

反作弊

搜索引擎蜘蛛在爬取网站页面的过程中,经常会面临大量地址页面和一些所谓的爬取黑洞的困扰。对于这种干净的搜索引擎,还设计了一套完整的反作弊爬取系统。比如通过页面URL的特征,分析页面大小、页面内容、站点规模进行爬取等。

二:展示

在网站的页面上,搜索引擎对数据库的爬取和建库,排序计算,最后会展现在搜索引擎的用户面前。如下