php抓取网页

php抓取网页(php抓取网页注意这个网页,我们需要给其编号方便追踪)

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2022-01-02 07:01

php抓取网页注意这个网页,我们需要给其编号方便追踪最后爬取一次大概需要300-400行代码先用正则表达式匹配出网页编号按照这个代码往下继续,遇到什么就往下面继续解析一直到最后一行因为php全部都是字符串类型的所以就用正则表达式吧爬取网页回复之后记得改一下代码哟如果想要json数据就加上id个人觉得代码没写完,个人喜欢用正则表达式爬取个人觉得它比lxml库更快!。

抓包最好看一下源码。观察什么值的数据,

你需要数据抓取库beautifulsoup,

数据抓取库beautifulsoup,

找网站后台,或者看看他们的源码,

snippet格式的数据有不少

o(∩_∩)o不需要爬虫

python有个beautifulsoup模块可以抓取网站源码。

可以用python爬虫工具抓取,

基于beautifulsoup的爬虫工具抓取网站源码工具。速度很快,github上有源码,百度网盘有gist,好学不苦,入门不用教,

请百度搜索pythonbeautifulsoup,一大堆大神贡献的,代码写起来的话,看下面的就行,

强烈推荐使用snippet格式数据抓取库。github地址:github-hpbjorg/snippet:opensourcepdfdocumentreader开源项目~beautifulsoup不是用python语言语法写的,python的beautifulsoup不是snippet提供的。snippet库基于python的开源项目。有兴趣github搜索“snippet”有些库不仅仅是写爬虫。 查看全部

php抓取网页(php抓取网页注意这个网页,我们需要给其编号方便追踪)

php抓取网页注意这个网页,我们需要给其编号方便追踪最后爬取一次大概需要300-400行代码先用正则表达式匹配出网页编号按照这个代码往下继续,遇到什么就往下面继续解析一直到最后一行因为php全部都是字符串类型的所以就用正则表达式吧爬取网页回复之后记得改一下代码哟如果想要json数据就加上id个人觉得代码没写完,个人喜欢用正则表达式爬取个人觉得它比lxml库更快!。

抓包最好看一下源码。观察什么值的数据,

你需要数据抓取库beautifulsoup,

数据抓取库beautifulsoup,

找网站后台,或者看看他们的源码,

snippet格式的数据有不少

o(∩_∩)o不需要爬虫

python有个beautifulsoup模块可以抓取网站源码。

可以用python爬虫工具抓取,

基于beautifulsoup的爬虫工具抓取网站源码工具。速度很快,github上有源码,百度网盘有gist,好学不苦,入门不用教,

请百度搜索pythonbeautifulsoup,一大堆大神贡献的,代码写起来的话,看下面的就行,

强烈推荐使用snippet格式数据抓取库。github地址:github-hpbjorg/snippet:opensourcepdfdocumentreader开源项目~beautifulsoup不是用python语言语法写的,python的beautifulsoup不是snippet提供的。snippet库基于python的开源项目。有兴趣github搜索“snippet”有些库不仅仅是写爬虫。

php抓取网页(php抓取网页头像必须使用postmessage。。(postmessage))

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-12-28 17:05

php抓取网页头像必须使用postmessage。

小的站是可以的,那是因为小站的标准资源少,大站没必要为了一点资源二次分配带宽,你也看到了,

1.现代浏览器大多支持2.做这种页面抓取,也会考虑到网站收益的,考虑到将来的转型,idc提供商不会只为了抓取看起来美观可以做这个页面,

在cookie保存session很老古董时代大部分网站(postmessage)都是用session存数据的,现在基本都不用session保存了。

因为这个页面本身并不占太大空间更主要的是存储在服务器上的session吧当年用不用session分析代码就看性能了,

后端渲染,或者用iframe。数据量不大的话,

按你的逻辑,

服务器端挂个visualstudio,而且用的是visualstudio开发工具,有网的地方就有联想,有就可以,无所谓无头苍蝇一般的网站一般是带一个后端工程师,核心是前端处理,响应的数据按需数据响应给服务器(有加载速度的话)服务器对数据响应做个hash值(不一定是真的用户头像,比如名字啊什么的),然后检查请求token就知道每次发送请求都会返回什么,然后发送请求之前检查下你的检查结果如果收到返回数据头像,就直接用他的响应头图做出你需要的内容给服务器后台,前端根据响应头的图来做,但是内容至少是你需要的内容。 查看全部

php抓取网页(php抓取网页头像必须使用postmessage。。(postmessage))

php抓取网页头像必须使用postmessage。

小的站是可以的,那是因为小站的标准资源少,大站没必要为了一点资源二次分配带宽,你也看到了,

1.现代浏览器大多支持2.做这种页面抓取,也会考虑到网站收益的,考虑到将来的转型,idc提供商不会只为了抓取看起来美观可以做这个页面,

在cookie保存session很老古董时代大部分网站(postmessage)都是用session存数据的,现在基本都不用session保存了。

因为这个页面本身并不占太大空间更主要的是存储在服务器上的session吧当年用不用session分析代码就看性能了,

后端渲染,或者用iframe。数据量不大的话,

按你的逻辑,

服务器端挂个visualstudio,而且用的是visualstudio开发工具,有网的地方就有联想,有就可以,无所谓无头苍蝇一般的网站一般是带一个后端工程师,核心是前端处理,响应的数据按需数据响应给服务器(有加载速度的话)服务器对数据响应做个hash值(不一定是真的用户头像,比如名字啊什么的),然后检查请求token就知道每次发送请求都会返回什么,然后发送请求之前检查下你的检查结果如果收到返回数据头像,就直接用他的响应头图做出你需要的内容给服务器后台,前端根据响应头的图来做,但是内容至少是你需要的内容。

php抓取网页(php抓取网页,可以用scrapy这个框架,也可以写个爬虫框架)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-27 21:00

php抓取网页,可以用scrapy这个框架,也可以用flask\scrapy这样的框架,现在爬虫框架很多,

做爬虫,至少有必要写个爬虫框架,

redis读记录,并分析,筛选,传到python进行后续处理,

python的话抓取网页的话,主要就是通过正则表达式去寻找,例如:然后对于数据库读取,基本的orm都要能用来写。python大牛和django大牛可以把网页解析和mysqlsqlite搞一起,但是一般开发者肯定不会搞那么复杂。至于推荐的书,首先你要确定你找的这个爬虫相关的书是写给小白写的。再根据自己的情况来定。

endswith

有几本用python写的开源爬虫书可以看看啊:python爬虫入门经典、python3爬虫开发实战、高效python爬虫笔记这几本书都是比较通俗易懂而且比较详细的一些爬虫的入门级的爬虫,当然你要是想一次读懂你可以先从最基础的爬虫书开始,随着爬虫水平的提高,在来不断完善改进自己的知识和方法。

不要跟爬虫浪费时间,花点钱用个好点的。

python的话推荐李学凌所著的《从零开始学爬虫》。

当然是。

通过爬虫框架这类来进行爬虫,既可以快速的写出自己想要的爬虫,也可以快速进行爬虫开发。但是一个好的爬虫框架你需要知道正则表达式对于request/response,xpath等的使用。 查看全部

php抓取网页(php抓取网页,可以用scrapy这个框架,也可以写个爬虫框架)

php抓取网页,可以用scrapy这个框架,也可以用flask\scrapy这样的框架,现在爬虫框架很多,

做爬虫,至少有必要写个爬虫框架,

redis读记录,并分析,筛选,传到python进行后续处理,

python的话抓取网页的话,主要就是通过正则表达式去寻找,例如:然后对于数据库读取,基本的orm都要能用来写。python大牛和django大牛可以把网页解析和mysqlsqlite搞一起,但是一般开发者肯定不会搞那么复杂。至于推荐的书,首先你要确定你找的这个爬虫相关的书是写给小白写的。再根据自己的情况来定。

endswith

有几本用python写的开源爬虫书可以看看啊:python爬虫入门经典、python3爬虫开发实战、高效python爬虫笔记这几本书都是比较通俗易懂而且比较详细的一些爬虫的入门级的爬虫,当然你要是想一次读懂你可以先从最基础的爬虫书开始,随着爬虫水平的提高,在来不断完善改进自己的知识和方法。

不要跟爬虫浪费时间,花点钱用个好点的。

python的话推荐李学凌所著的《从零开始学爬虫》。

当然是。

通过爬虫框架这类来进行爬虫,既可以快速的写出自己想要的爬虫,也可以快速进行爬虫开发。但是一个好的爬虫框架你需要知道正则表达式对于request/response,xpath等的使用。

php抓取网页(php抓取网页包括网页地址的生成,字符串的解析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-12-11 19:02

php抓取网页,包括网页地址的生成,字符串的解析,然后遍历网页,得到对应的数据。同时,还可以对页面的二进制数据进行处理,比如生成二进制字符串。网页地址生成最简单的是用swoole,复杂点的用twitter_websocket,难点就是对二进制数据做中转处理。字符串的解析phpstorm是自带模版功能的,mac是sublimetext。

输入字符串即可解析。所以必须要了解编程思想。接下来两步就是设置一些somecode之类的库,最常用的就是locale。得熟悉php中每个字符串中的一个最基本的payload。php是解释型语言,可以经常换一下编译模式,用swoole的话就必须runtime是解释的。可能这是设置模版的原因。遍历网页并处理二进制数据,这是php最可靠的传输方式了。

可以是udp,socket,icmp或者其他中间物理连接方式。经常使用sublimetext打开大的长的php文件。bingo。/github/phprefix.git。

如果是做小项目不需要php的,我用的是iis的php负载均衡和nginx,已经很好的解决,一般企业级产品用的都是这几种。主要的工作是优化系统,改进服务而不是让php跑在上面。

php是没有模版语言的,实际写起来相当复杂。做php的实际用的还是java和perl,不过perl在windows和linux上发展的都不是特别好。 查看全部

php抓取网页(php抓取网页包括网页地址的生成,字符串的解析)

php抓取网页,包括网页地址的生成,字符串的解析,然后遍历网页,得到对应的数据。同时,还可以对页面的二进制数据进行处理,比如生成二进制字符串。网页地址生成最简单的是用swoole,复杂点的用twitter_websocket,难点就是对二进制数据做中转处理。字符串的解析phpstorm是自带模版功能的,mac是sublimetext。

输入字符串即可解析。所以必须要了解编程思想。接下来两步就是设置一些somecode之类的库,最常用的就是locale。得熟悉php中每个字符串中的一个最基本的payload。php是解释型语言,可以经常换一下编译模式,用swoole的话就必须runtime是解释的。可能这是设置模版的原因。遍历网页并处理二进制数据,这是php最可靠的传输方式了。

可以是udp,socket,icmp或者其他中间物理连接方式。经常使用sublimetext打开大的长的php文件。bingo。/github/phprefix.git。

如果是做小项目不需要php的,我用的是iis的php负载均衡和nginx,已经很好的解决,一般企业级产品用的都是这几种。主要的工作是优化系统,改进服务而不是让php跑在上面。

php是没有模版语言的,实际写起来相当复杂。做php的实际用的还是java和perl,不过perl在windows和linux上发展的都不是特别好。

php抓取网页(php抓取网页demo教程|php开发者一枚,必须转移注意力)

网站优化 • 优采云 发表了文章 • 0 个评论 • 42 次浏览 • 2021-12-07 20:07

php抓取网页demo教程|php开发者一枚,必须转移注意力:一套完整的php抓取网页的项目,只需要能够正常抓取即可。每一个页面都有它不可或缺的引用资源(特别是企业内部内网网页)。同时,借助java服务器抓取更方便。可以利用开源框架exo.js抓取。真正的demodemo可以在:php/java/mysql/redis等方面找到对应文档示例,同时借助第三方库。

这样会比零基础的开发者抓取速度快很多。demo修改部分示例项目源码地址:demo-homebigpipe/bigpipe.jsgit源码会分为网页部分和页面二级页面,在面板类中可以找到demo-home。打开目录,新建test.php编写出想要抓取的html、css、js代码,还有注释等内容。注释方面的代码主要用于页面代码中使用generator进行异步generate。

nginx配置配置方面方面代码会按照tp6版本单独为示例配置,其它版本的tp通过public::news内配置。抓取github/bigpipe/demo/exo.js/script/web:://在抓取java服务器的http请求,可以用express、tornado等即可。每个项目网址:/后面的链接中有抓取网址://所以我们就是用这个免费web建站系统提供的公共查询命令进行抓取。

对于没有账号密码的需要使用net查询自己的隐私和密码。因为使用bigpipe抓取网页的速度非常快,所以之前已经借助开源爬虫框架nicepy.js抓取数据了。这次借助开源的redis、express+exo.js的抓取速度非常快。文章首发于个人博客:月云学院。 查看全部

php抓取网页(php抓取网页demo教程|php开发者一枚,必须转移注意力)

php抓取网页demo教程|php开发者一枚,必须转移注意力:一套完整的php抓取网页的项目,只需要能够正常抓取即可。每一个页面都有它不可或缺的引用资源(特别是企业内部内网网页)。同时,借助java服务器抓取更方便。可以利用开源框架exo.js抓取。真正的demodemo可以在:php/java/mysql/redis等方面找到对应文档示例,同时借助第三方库。

这样会比零基础的开发者抓取速度快很多。demo修改部分示例项目源码地址:demo-homebigpipe/bigpipe.jsgit源码会分为网页部分和页面二级页面,在面板类中可以找到demo-home。打开目录,新建test.php编写出想要抓取的html、css、js代码,还有注释等内容。注释方面的代码主要用于页面代码中使用generator进行异步generate。

nginx配置配置方面方面代码会按照tp6版本单独为示例配置,其它版本的tp通过public::news内配置。抓取github/bigpipe/demo/exo.js/script/web:://在抓取java服务器的http请求,可以用express、tornado等即可。每个项目网址:/后面的链接中有抓取网址://所以我们就是用这个免费web建站系统提供的公共查询命令进行抓取。

对于没有账号密码的需要使用net查询自己的隐私和密码。因为使用bigpipe抓取网页的速度非常快,所以之前已经借助开源爬虫框架nicepy.js抓取数据了。这次借助开源的redis、express+exo.js的抓取速度非常快。文章首发于个人博客:月云学院。

php抓取网页(php抓取网页,我用php进行抓取和处理(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-11-26 05:06

php抓取网页,利用curl命令处理数据,然后可以循环从请求获取,也可以用php缓存来处理。以下我用php进行抓取和处理。

一、步骤

1、从2048shell上复制curl命令。

2、编写循环。

4、可以用php进行处理。

二、代码

1、生成curl请求中需要的头信息curl通过请求第4步的headers中信息,来判断请求到底用的是哪种方式,是post还是get。再在curl/headers中进行设置,

2、判断authorization是否设置为已过期curl通过请求的第4步的headers中transparent来判断请求是否过期。

然后在curl/headers中进行设置,即:curl/headers中,get必须设置过期期限get可以通过headers中的headers="user-agent",

4)applewebkit/537.36(khtml,likegecko)chrome/45.0.3247.27safari/537.36",其他的均可以设置。如果不设置的话,curl会默认使用authorization_security=none,也就是不验证authorization,这个是很危险的,一定要设置为none。

3、判断authorization是否设置成功curl通过请求中的第4步中headers中的valid_authentication来判断authorization是否设置成功。如果设置成功,则会获取请求头中的content-length,然后判断请求是否合法。

4、设置断点curl/thinkphp-bootstrap-1.1.3.zip这个包含链接和数据,使用时可以抓取的数据,网址和url,这个代码应该很好写,写这些代码方便将信息保存。

5、curl/http/1.1200ok

6、curl/http/1.1getanjavascriptversiondgetanjavascripttargeturl完整代码公众号:不言者'后台回复"php"可以获取代码。 查看全部

php抓取网页(php抓取网页,我用php进行抓取和处理(一))

php抓取网页,利用curl命令处理数据,然后可以循环从请求获取,也可以用php缓存来处理。以下我用php进行抓取和处理。

一、步骤

1、从2048shell上复制curl命令。

2、编写循环。

4、可以用php进行处理。

二、代码

1、生成curl请求中需要的头信息curl通过请求第4步的headers中信息,来判断请求到底用的是哪种方式,是post还是get。再在curl/headers中进行设置,

2、判断authorization是否设置为已过期curl通过请求的第4步的headers中transparent来判断请求是否过期。

然后在curl/headers中进行设置,即:curl/headers中,get必须设置过期期限get可以通过headers中的headers="user-agent",

4)applewebkit/537.36(khtml,likegecko)chrome/45.0.3247.27safari/537.36",其他的均可以设置。如果不设置的话,curl会默认使用authorization_security=none,也就是不验证authorization,这个是很危险的,一定要设置为none。

3、判断authorization是否设置成功curl通过请求中的第4步中headers中的valid_authentication来判断authorization是否设置成功。如果设置成功,则会获取请求头中的content-length,然后判断请求是否合法。

4、设置断点curl/thinkphp-bootstrap-1.1.3.zip这个包含链接和数据,使用时可以抓取的数据,网址和url,这个代码应该很好写,写这些代码方便将信息保存。

5、curl/http/1.1200ok

6、curl/http/1.1getanjavascriptversiondgetanjavascripttargeturl完整代码公众号:不言者'后台回复"php"可以获取代码。

php抓取网页(之前有一个工具自动抓取数据的工具主要做什么? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2021-11-25 06:06

)

之前的任务之一是在服务器上复制一串文本。这是一个简单的操作,但需要重复大约 50 次。每次大概用了三分钟,重复了两个多小时就过去了。所以我做了这个工具来自动抓取数据。

该工具主要做三件事:登录、下载和拦截。

登录部分是因为服务器使用windows安全验证,如图:

获取网页数据需要模拟登录。

首先使用fiddler抓取http传输的数据包,在header部分找到一串字符串:

base64解密后得到:Administrator:manage。

这是用户名:一串加密的密码。Authorization:Basic是一种认证方式,一般由setRequestProperty设置。

登录后可以直接获取网页内容,然后截取数据。最后在最外层加一个循环,执行一次需要爬取的服务器地址,然后就可以一次性获取到所有服务器上的数据了。

最后贴出代码:

<p>import java.io.*;

import java.net.*;

public class getPackageFromWeb {

public static void main(String args[]) throws Exception {

String[] servers ={"192.168.0.144:23342","192.168.0.144:23343"};

StringBuilder result=new StringBuilder();

for(int i=0;i 查看全部

php抓取网页(之前有一个工具自动抓取数据的工具主要做什么?

)

之前的任务之一是在服务器上复制一串文本。这是一个简单的操作,但需要重复大约 50 次。每次大概用了三分钟,重复了两个多小时就过去了。所以我做了这个工具来自动抓取数据。

该工具主要做三件事:登录、下载和拦截。

登录部分是因为服务器使用windows安全验证,如图:

获取网页数据需要模拟登录。

首先使用fiddler抓取http传输的数据包,在header部分找到一串字符串:

base64解密后得到:Administrator:manage。

这是用户名:一串加密的密码。Authorization:Basic是一种认证方式,一般由setRequestProperty设置。

登录后可以直接获取网页内容,然后截取数据。最后在最外层加一个循环,执行一次需要爬取的服务器地址,然后就可以一次性获取到所有服务器上的数据了。

最后贴出代码:

<p>import java.io.*;

import java.net.*;

public class getPackageFromWeb {

public static void main(String args[]) throws Exception {

String[] servers ={"192.168.0.144:23342","192.168.0.144:23343"};

StringBuilder result=new StringBuilder();

for(int i=0;i

php抓取网页(php抓取网页又一个利器,最新版本1.x版本)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-11-23 15:01

php抓取网页又一个利器,最新版本1.x版本:采集页面整页的元素图片,列表(index.php,index.js),每个元素数据都会复制下来,通过md5加密算法加密传递给服务器,传输加密过程都是https的。

tk-f11f的把php框架整合起来利用了django的框架,请求index.php,在python中调用,

无论是python还是php都需要把元素传输,然后在http转换为https的页面,具体https转换可以参考pythonhttps,

在你想知道元素的时候,可以写字典,然后用循环从字典里面取元素,

python要把网页上图片的元素提取出来是非常麻烦的。如果用php,建议用代理抓。就是利用代理进行抓取。代理抓取也可以从php代码中,去解析数据,然后再传递给网页转化。phpstorm比较好用。

让php来抓

通过网页里js将图片元素提取出来。另外,php可以用illuminate源码的方式,将整个源码转换成python可读代码。

php与django的结合,可以通过把图片存在https协议下存到tk目录下,

tkinter+django

接到图片链接后使用get/post的方式提交给django后端,获取元素再比较php传入的数据。 查看全部

php抓取网页(php抓取网页又一个利器,最新版本1.x版本)

php抓取网页又一个利器,最新版本1.x版本:采集页面整页的元素图片,列表(index.php,index.js),每个元素数据都会复制下来,通过md5加密算法加密传递给服务器,传输加密过程都是https的。

tk-f11f的把php框架整合起来利用了django的框架,请求index.php,在python中调用,

无论是python还是php都需要把元素传输,然后在http转换为https的页面,具体https转换可以参考pythonhttps,

在你想知道元素的时候,可以写字典,然后用循环从字典里面取元素,

python要把网页上图片的元素提取出来是非常麻烦的。如果用php,建议用代理抓。就是利用代理进行抓取。代理抓取也可以从php代码中,去解析数据,然后再传递给网页转化。phpstorm比较好用。

让php来抓

通过网页里js将图片元素提取出来。另外,php可以用illuminate源码的方式,将整个源码转换成python可读代码。

php与django的结合,可以通过把图片存在https协议下存到tk目录下,

tkinter+django

接到图片链接后使用get/post的方式提交给django后端,获取元素再比较php传入的数据。

php抓取网页(php抓取网页内容--例子都是用php写的)

网站优化 • 优采云 发表了文章 • 0 个评论 • 44 次浏览 • 2021-11-13 14:02

php抓取网页内容--例子都是用php写的,有个思维导图可以对编程思路整理一下。php1.7到1.8基本上多数语句都可以用原生的直接实现。1.0到1.8才是php的巅峰时期,什么for循环else都是还留有很多余地的,empty也可以用php自己语句表达。具体到php代码就是:1.可以用sitemesh+mqtt配合抓取的。

2.抓取只能用schema最多支持5*5规则来抓取内容,一般抓取30w条/周用5*5的条件就很多了。3.schema只支持fcinfoinfo共抓取分析。4.php直接返回动态内容,比如注册,成功,被删除,添加,清空等。数据库直接redis,mysql等都可以实现。(哈哈,我昨天才看到一个网站提供数据库连接池用java+golang抓取数据,spring+php+mysql)5.例子的所有代码都是用php写的。6.抓取原理=php==。 查看全部

php抓取网页(php抓取网页内容--例子都是用php写的)

php抓取网页内容--例子都是用php写的,有个思维导图可以对编程思路整理一下。php1.7到1.8基本上多数语句都可以用原生的直接实现。1.0到1.8才是php的巅峰时期,什么for循环else都是还留有很多余地的,empty也可以用php自己语句表达。具体到php代码就是:1.可以用sitemesh+mqtt配合抓取的。

2.抓取只能用schema最多支持5*5规则来抓取内容,一般抓取30w条/周用5*5的条件就很多了。3.schema只支持fcinfoinfo共抓取分析。4.php直接返回动态内容,比如注册,成功,被删除,添加,清空等。数据库直接redis,mysql等都可以实现。(哈哈,我昨天才看到一个网站提供数据库连接池用java+golang抓取数据,spring+php+mysql)5.例子的所有代码都是用php写的。6.抓取原理=php==。

php抓取网页(php获取网站推荐活动:更多优惠gt;加入收藏(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-10-25 15:02

阿里云>云栖社区>主题图>P>php Get网站head

推荐活动:

更多优惠>

当前话题:php Get 网站head 加入采集

相关话题:

php 获取网站头部相关博客 查看更多博客

网站快照被篡改劫持怎么办?

作者:网站安全2894人浏览评论:02年前

近日,多家公司的网站快照被劫持,跳转至bocai和彩票网站。从百度点击进来的客户会被重定向,在网站中直接输入的域名不会被重定向。网站快照也被劫持到bocai内容,百度的收录中的站点视图网站也有问题,收录很多彩票内容,一些客户的网站@ > 也被百度网站安全中心拦截,提示网

阅读全文

Winform下动态执行JavaScript脚本获取运行结果,说说网站的自动登录和数据获取操作

作者:walb呀998人浏览评论:03年前

为了有效防止恶意用户的攻击,一般登录都会使用验证码的方式来处理登录,类似于QQ很多产品的验证码处理,但是在一些OA系统中,系统使用非对称加密来处理登录密码信息, login 用于加密密码的公钥每次页面提供都不一样,所以如果要模拟登录,需要先获取公钥,然后

阅读全文

curl 用法:获取网站的header和状态码

作者:喜欢教授1758人浏览评论:03年前

; 使用 curl -I 来获取它。如果在提取第一行信息时出现一些不需要的信息,我们应该如何获取?1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 [baby@localhost ~]$ curl -I mofansheng.bl

阅读全文

php_mysql注入load_file() IIS配置文件获取

作者:科技小胖子1165人浏览评论:03年前

先看一个注入点:+union+select+1,2,3,4,5,6,concat(database(),0x5c,user(),0x5c,version()

阅读全文

PHP Ajax JavaScript Json 实现天气信息获取

作者:郭璞 818人浏览评论:05年前

使用第三方服务间接方式使用服务实现代码。前端完整代码总结 给自己的网站添加天气预报功能是很常见的需求,实现起来也不难。今天,我将介绍一些简单的方法。有这么简单的使用第三方服务的方法,借助

阅读全文

PHP构建网站登录页面(iOS开发者的PHP之路)

作者:xinxinitblog713 人浏览评论:05年前

前言 近年来,各个技术论坛都流传着一句话:未来是全栈程序员的世界!程序员是社会的职业,越来越多的人加入这个行业。随着这个行业分工明确,越来越多的程序员开始焦躁地追求一门编程语言,并开始在我研究其他领域工作,渴望在不久的将来在整个软件行业有一份好工作

阅读全文

java获取客户端请求IP地址获取公网ip

作者:查看人数及评论:06年前

这些天我一直在使用java来获取ip地址。由于测试方法错误,一直未成功。昨天终于发现不是方法不对,而是我的测试方法不对。下面的方法可以完整的获取到客户端的公网ip。地址,但是测试的时候注意:我用weblogic来测试,在我本机打开服务,然后访问,因为一样

阅读全文

java获取客户端请求IP地址获取公网ip

作者:李大嘴吧1687人浏览评论:06年前

这些天我一直在使用java来获取ip地址。由于测试方法错误,一直未成功。昨天终于发现不是方法不对,而是我的测试方法不对。下面的方法可以完整的获取到客户端的公网ip。地址,但是测试的时候注意:我用weblogic来测试,在我本机打开服务,然后访问,因为一样

阅读全文

php获取网站head相关问答及提问

php的curl如何使用head协议获取资源大小等信息?

作者:落花开啦 827人浏览评论:15年前

我的程序允许用户填写URL来抓取其他网站的资源,但是在抓取之前需要知道资源的大小,否则资源太大又费时,会占用不必要的带宽. 发现http中有HEAD协议,即只获取一个资源的http头信息,那么curl中怎么只能获取http头而不下载所有body呢?

阅读全文 查看全部

php抓取网页(php获取网站推荐活动:更多优惠gt;加入收藏(组图))

阿里云>云栖社区>主题图>P>php Get网站head

推荐活动:

更多优惠>

当前话题:php Get 网站head 加入采集

相关话题:

php 获取网站头部相关博客 查看更多博客

网站快照被篡改劫持怎么办?

作者:网站安全2894人浏览评论:02年前

近日,多家公司的网站快照被劫持,跳转至bocai和彩票网站。从百度点击进来的客户会被重定向,在网站中直接输入的域名不会被重定向。网站快照也被劫持到bocai内容,百度的收录中的站点视图网站也有问题,收录很多彩票内容,一些客户的网站@ > 也被百度网站安全中心拦截,提示网

阅读全文

Winform下动态执行JavaScript脚本获取运行结果,说说网站的自动登录和数据获取操作

作者:walb呀998人浏览评论:03年前

为了有效防止恶意用户的攻击,一般登录都会使用验证码的方式来处理登录,类似于QQ很多产品的验证码处理,但是在一些OA系统中,系统使用非对称加密来处理登录密码信息, login 用于加密密码的公钥每次页面提供都不一样,所以如果要模拟登录,需要先获取公钥,然后

阅读全文

curl 用法:获取网站的header和状态码

作者:喜欢教授1758人浏览评论:03年前

; 使用 curl -I 来获取它。如果在提取第一行信息时出现一些不需要的信息,我们应该如何获取?1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 [baby@localhost ~]$ curl -I mofansheng.bl

阅读全文

php_mysql注入load_file() IIS配置文件获取

作者:科技小胖子1165人浏览评论:03年前

先看一个注入点:+union+select+1,2,3,4,5,6,concat(database(),0x5c,user(),0x5c,version()

阅读全文

PHP Ajax JavaScript Json 实现天气信息获取

作者:郭璞 818人浏览评论:05年前

使用第三方服务间接方式使用服务实现代码。前端完整代码总结 给自己的网站添加天气预报功能是很常见的需求,实现起来也不难。今天,我将介绍一些简单的方法。有这么简单的使用第三方服务的方法,借助

阅读全文

PHP构建网站登录页面(iOS开发者的PHP之路)

作者:xinxinitblog713 人浏览评论:05年前

前言 近年来,各个技术论坛都流传着一句话:未来是全栈程序员的世界!程序员是社会的职业,越来越多的人加入这个行业。随着这个行业分工明确,越来越多的程序员开始焦躁地追求一门编程语言,并开始在我研究其他领域工作,渴望在不久的将来在整个软件行业有一份好工作

阅读全文

java获取客户端请求IP地址获取公网ip

作者:查看人数及评论:06年前

这些天我一直在使用java来获取ip地址。由于测试方法错误,一直未成功。昨天终于发现不是方法不对,而是我的测试方法不对。下面的方法可以完整的获取到客户端的公网ip。地址,但是测试的时候注意:我用weblogic来测试,在我本机打开服务,然后访问,因为一样

阅读全文

java获取客户端请求IP地址获取公网ip

作者:李大嘴吧1687人浏览评论:06年前

这些天我一直在使用java来获取ip地址。由于测试方法错误,一直未成功。昨天终于发现不是方法不对,而是我的测试方法不对。下面的方法可以完整的获取到客户端的公网ip。地址,但是测试的时候注意:我用weblogic来测试,在我本机打开服务,然后访问,因为一样

阅读全文

php获取网站head相关问答及提问

php的curl如何使用head协议获取资源大小等信息?

作者:落花开啦 827人浏览评论:15年前

我的程序允许用户填写URL来抓取其他网站的资源,但是在抓取之前需要知道资源的大小,否则资源太大又费时,会占用不必要的带宽. 发现http中有HEAD协议,即只获取一个资源的http头信息,那么curl中怎么只能获取http头而不下载所有body呢?

阅读全文

php抓取网页(php做有偿视频数据采集和集成也是可以的吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-10-24 15:00

php抓取网页:直接写exif文件:如:=root/public_data/article/user/rain/123456.jpgbase64加密:用aes可选:默认加密256-1范围内,

使用formdata就可以php3是无法直接读取图片地址的,

java版java请php程序员做,

java不是不支持吗?-12-12/

使用androidstudio,phpstorm,

php抓取网页不就是采集器嘛

哈哈哈,好有兴趣,我也想知道,有个开源的采集器trac-php,

php的话,apache,nginx,phpmonitor都是可以的,

apache

多少人不用sed的?

可以是可以,不过,php文件是不能直接输出视频文件的。php做有偿视频数据采集和集成也是可以的。这个是这个问题的延伸。

现在有csrf(跨站请求伪造)。比如用php自己封装一个get请求,输出之后另外发给别人。

apache+cookie大多数网站都支持,

也可以用java封装后上传

java,apache,ftp等

java可以封装get接口,然后用urllib2封装post。你可以这样理解:这里是过滤器。拦截你网页发出的get请求,然后返回一堆数据。然后就封你post的数据了。 查看全部

php抓取网页(php做有偿视频数据采集和集成也是可以的吗?)

php抓取网页:直接写exif文件:如:=root/public_data/article/user/rain/123456.jpgbase64加密:用aes可选:默认加密256-1范围内,

使用formdata就可以php3是无法直接读取图片地址的,

java版java请php程序员做,

java不是不支持吗?-12-12/

使用androidstudio,phpstorm,

php抓取网页不就是采集器嘛

哈哈哈,好有兴趣,我也想知道,有个开源的采集器trac-php,

php的话,apache,nginx,phpmonitor都是可以的,

apache

多少人不用sed的?

可以是可以,不过,php文件是不能直接输出视频文件的。php做有偿视频数据采集和集成也是可以的。这个是这个问题的延伸。

现在有csrf(跨站请求伪造)。比如用php自己封装一个get请求,输出之后另外发给别人。

apache+cookie大多数网站都支持,

也可以用java封装后上传

java,apache,ftp等

java可以封装get接口,然后用urllib2封装post。你可以这样理解:这里是过滤器。拦截你网页发出的get请求,然后返回一堆数据。然后就封你post的数据了。

php抓取网页(用file_get_contents()函数抓取网页会发生乱码现象)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-10-18 10:10

使用file_get_contents()函数获取网页会导致乱码。出现乱码的原因有两个,一是编码问题,二是目标页面启用了Gzip。下面是如何防止Gzip功能开启时出现乱码

将捕获的内容转为编码($content=iconv("GBK", "UTF-8//IGNORE", $content);),我们这里讨论的是如何捕获和打开Gzip Page。如何判断? Content-Encoding: 获取到的header中的gzip表示内容采用GZIP压缩。用 FireBug 查看它以了解页面上是否启用了 gzip。下面是用firebug查看我博客的header信息,打开Gzip。

请求头信息原创头信息

Accept text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8

Accept-Encoding gzip, deflate

Accept-Language zh-cn,zh;q=0.8,en-us;q=0.5,en;q=0.3

Connection keep-alive

Cookie __utma=225240837.787252530.1317310581.1335406161.1335411401.1537; __utmz=225240837.1326850415.887.3.utmcsr=google|utmccn=(organic)|utmcmd=organic|utmctr=%E4%BB%BB%E4%BD%95%E9%A1%B9%E7%9B%AE%E9%83%BD%E4%B8%8D%E4%BC%9A%E9%82%A3%E4%B9%88%E7%AE%80%E5%8D%95%20site%3Awww.nowamagic.net; PHPSESSID=888mj4425p8s0m7s0frre3ovc7; __utmc=225240837; __utmb=225240837.1.10.1335411401

Host www.nowamagic.net

User-Agent Mozilla/5.0 (Windows NT 5.1; rv:12.0) Gecko/20100101 Firefox/12.0

以下是一些解决方案:

1. 使用内置的 zlib 库

如果服务器已经安装了zlib库,下面的代码可以轻松解决乱码问题。

$data = file_get_contents("compress.zlib://".$url);

2. 使用 CURL 代替 file_get_contents

function curl_get($url, $gzip=false){

$curl = curl_init($url);

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($curl, CURLOPT_CONNECTTIMEOUT, 10);

if($gzip) curl_setopt($curl, CURLOPT_ENCODING, "gzip"); // 关键在这里

$content = curl_exec($curl);

curl_close($curl);

return $content;

}

3.使用gzip解压功能

function gzdecode($data) {

$len = strlen($data);

if ($len < 18 || strcmp(substr($data,0,2),"\x1f\x8b")) {

return null; // Not GZIP format (See RFC 1952)

}

$method = ord(substr($data,2,1)); // Compression method

$flags = ord(substr($data,3,1)); // Flags

if ($flags & 31 != $flags) {

// Reserved bits are set -- NOT ALLOWED by RFC 1952

return null;

}

// NOTE: $mtime may be negative (PHP integer limitations)

$mtime = unpack("V", substr($data,4,4));

$mtime = $mtime[1];

$xfl = substr($data,8,1);

$os = substr($data,8,1);

$headerlen = 10;

$extralen = 0;

$extra = "";

if ($flags & 4) {

// 2-byte length prefixed EXTRA data in header

if ($len - $headerlen - 2 < 8) {

return false; // Invalid format

}

$extralen = unpack("v",substr($data,8,2));

$extralen = $extralen[1];

if ($len - $headerlen - 2 - $extralen < 8) {

return false; // Invalid format

}

$extra = substr($data,10,$extralen);

$headerlen += 2 + $extralen;

}

$filenamelen = 0;

$filename = "";

if ($flags & 8) {

// C-style string file NAME data in header

if ($len - $headerlen - 1 < 8) {

return false; // Invalid format

}

$filenamelen = strpos(substr($data,8+$extralen),chr(0));

if ($filenamelen === false || $len - $headerlen - $filenamelen - 1 < 8) {

return false; // Invalid format

}

$filename = substr($data,$headerlen,$filenamelen);

$headerlen += $filenamelen + 1;

}

$commentlen = 0;

$comment = "";

if ($flags & 16) {

// C-style string COMMENT data in header

if ($len - $headerlen - 1 < 8) {

return false; // Invalid format

}

$commentlen = strpos(substr($data,8+$extralen+$filenamelen),chr(0));

if ($commentlen === false || $len - $headerlen - $commentlen - 1 < 8) {

return false; // Invalid header format

}

$comment = substr($data,$headerlen,$commentlen);

$headerlen += $commentlen + 1;

}

$headercrc = "";

if ($flags & 1) {

// 2-bytes (lowest order) of CRC32 on header present

if ($len - $headerlen - 2 < 8) {

return false; // Invalid format

}

$calccrc = crc32(substr($data,0,$headerlen)) & 0xffff;

$headercrc = unpack("v", substr($data,$headerlen,2));

$headercrc = $headercrc[1];

if ($headercrc != $calccrc) {

return false; // Bad header CRC

}

$headerlen += 2;

}

// GZIP FOOTER - These be negative due to PHP's limitations

$datacrc = unpack("V",substr($data,-8,4));

$datacrc = $datacrc[1];

$isize = unpack("V",substr($data,-4));

$isize = $isize[1];

// Perform the decompression:

$bodylen = $len-$headerlen-8;

if ($bodylen < 1) {

// This should never happen - IMPLEMENTATION BUG!

return null;

}

$body = substr($data,$headerlen,$bodylen);

$data = "";

if ($bodylen > 0) {

switch ($method) {

case 8:

// Currently the only supported compression method:

$data = gzinflate($body);

break;

default:

// Unknown compression method

return false;

}

} else {

// I'm not sure if zero-byte body content is allowed.

// Allow it for now... Do nothing...

}

// Verifiy decompressed size and CRC32:

// NOTE: This may fail with large data sizes depending on how

// PHP's integer limitations affect strlen() since $isize

// may be negative for large sizes.

if ($isize != strlen($data) || crc32($data) != $datacrc) {

// Bad format! Length or CRC doesn't match!

return false;

}

return $data;

}

使用:

$html=file_get_contents('http://www.gxlcms.com/');

$html=gzdecode($html);

介绍这三个方法,应该可以解决大部分gzip导致的爬行乱码问题。 查看全部

php抓取网页(用file_get_contents()函数抓取网页会发生乱码现象)

使用file_get_contents()函数获取网页会导致乱码。出现乱码的原因有两个,一是编码问题,二是目标页面启用了Gzip。下面是如何防止Gzip功能开启时出现乱码

将捕获的内容转为编码($content=iconv("GBK", "UTF-8//IGNORE", $content);),我们这里讨论的是如何捕获和打开Gzip Page。如何判断? Content-Encoding: 获取到的header中的gzip表示内容采用GZIP压缩。用 FireBug 查看它以了解页面上是否启用了 gzip。下面是用firebug查看我博客的header信息,打开Gzip。

请求头信息原创头信息

Accept text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8

Accept-Encoding gzip, deflate

Accept-Language zh-cn,zh;q=0.8,en-us;q=0.5,en;q=0.3

Connection keep-alive

Cookie __utma=225240837.787252530.1317310581.1335406161.1335411401.1537; __utmz=225240837.1326850415.887.3.utmcsr=google|utmccn=(organic)|utmcmd=organic|utmctr=%E4%BB%BB%E4%BD%95%E9%A1%B9%E7%9B%AE%E9%83%BD%E4%B8%8D%E4%BC%9A%E9%82%A3%E4%B9%88%E7%AE%80%E5%8D%95%20site%3Awww.nowamagic.net; PHPSESSID=888mj4425p8s0m7s0frre3ovc7; __utmc=225240837; __utmb=225240837.1.10.1335411401

Host www.nowamagic.net

User-Agent Mozilla/5.0 (Windows NT 5.1; rv:12.0) Gecko/20100101 Firefox/12.0

以下是一些解决方案:

1. 使用内置的 zlib 库

如果服务器已经安装了zlib库,下面的代码可以轻松解决乱码问题。

$data = file_get_contents("compress.zlib://".$url);

2. 使用 CURL 代替 file_get_contents

function curl_get($url, $gzip=false){

$curl = curl_init($url);

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($curl, CURLOPT_CONNECTTIMEOUT, 10);

if($gzip) curl_setopt($curl, CURLOPT_ENCODING, "gzip"); // 关键在这里

$content = curl_exec($curl);

curl_close($curl);

return $content;

}

3.使用gzip解压功能

function gzdecode($data) {

$len = strlen($data);

if ($len < 18 || strcmp(substr($data,0,2),"\x1f\x8b")) {

return null; // Not GZIP format (See RFC 1952)

}

$method = ord(substr($data,2,1)); // Compression method

$flags = ord(substr($data,3,1)); // Flags

if ($flags & 31 != $flags) {

// Reserved bits are set -- NOT ALLOWED by RFC 1952

return null;

}

// NOTE: $mtime may be negative (PHP integer limitations)

$mtime = unpack("V", substr($data,4,4));

$mtime = $mtime[1];

$xfl = substr($data,8,1);

$os = substr($data,8,1);

$headerlen = 10;

$extralen = 0;

$extra = "";

if ($flags & 4) {

// 2-byte length prefixed EXTRA data in header

if ($len - $headerlen - 2 < 8) {

return false; // Invalid format

}

$extralen = unpack("v",substr($data,8,2));

$extralen = $extralen[1];

if ($len - $headerlen - 2 - $extralen < 8) {

return false; // Invalid format

}

$extra = substr($data,10,$extralen);

$headerlen += 2 + $extralen;

}

$filenamelen = 0;

$filename = "";

if ($flags & 8) {

// C-style string file NAME data in header

if ($len - $headerlen - 1 < 8) {

return false; // Invalid format

}

$filenamelen = strpos(substr($data,8+$extralen),chr(0));

if ($filenamelen === false || $len - $headerlen - $filenamelen - 1 < 8) {

return false; // Invalid format

}

$filename = substr($data,$headerlen,$filenamelen);

$headerlen += $filenamelen + 1;

}

$commentlen = 0;

$comment = "";

if ($flags & 16) {

// C-style string COMMENT data in header

if ($len - $headerlen - 1 < 8) {

return false; // Invalid format

}

$commentlen = strpos(substr($data,8+$extralen+$filenamelen),chr(0));

if ($commentlen === false || $len - $headerlen - $commentlen - 1 < 8) {

return false; // Invalid header format

}

$comment = substr($data,$headerlen,$commentlen);

$headerlen += $commentlen + 1;

}

$headercrc = "";

if ($flags & 1) {

// 2-bytes (lowest order) of CRC32 on header present

if ($len - $headerlen - 2 < 8) {

return false; // Invalid format

}

$calccrc = crc32(substr($data,0,$headerlen)) & 0xffff;

$headercrc = unpack("v", substr($data,$headerlen,2));

$headercrc = $headercrc[1];

if ($headercrc != $calccrc) {

return false; // Bad header CRC

}

$headerlen += 2;

}

// GZIP FOOTER - These be negative due to PHP's limitations

$datacrc = unpack("V",substr($data,-8,4));

$datacrc = $datacrc[1];

$isize = unpack("V",substr($data,-4));

$isize = $isize[1];

// Perform the decompression:

$bodylen = $len-$headerlen-8;

if ($bodylen < 1) {

// This should never happen - IMPLEMENTATION BUG!

return null;

}

$body = substr($data,$headerlen,$bodylen);

$data = "";

if ($bodylen > 0) {

switch ($method) {

case 8:

// Currently the only supported compression method:

$data = gzinflate($body);

break;

default:

// Unknown compression method

return false;

}

} else {

// I'm not sure if zero-byte body content is allowed.

// Allow it for now... Do nothing...

}

// Verifiy decompressed size and CRC32:

// NOTE: This may fail with large data sizes depending on how

// PHP's integer limitations affect strlen() since $isize

// may be negative for large sizes.

if ($isize != strlen($data) || crc32($data) != $datacrc) {

// Bad format! Length or CRC doesn't match!

return false;

}

return $data;

}

使用:

$html=file_get_contents('http://www.gxlcms.com/');

$html=gzdecode($html);

介绍这三个方法,应该可以解决大部分gzip导致的爬行乱码问题。

php抓取网页(直接message成JS代码可直接在PHP中获取相关内容 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-10-16 18:16

)

PHP 获取指定网页的 HTML 代码并执行输出。该方法主要是从网站的想要或目标URL地址中获取相关内容到您的网页。

代码如下:

这样就可以截取到想要的内容B了。追完后给$content,最后加了echo ‘document.write,生成JS代码。直接就变成了JS代码,在我需要这个内容的地方可以直接用JS调用显示。你不能用 php 得到这个,它不是通过 get 或 post 提交的。你可以给你一个id,然后你就可以通过document.getElementByIdx_x_x_x("name").innerHtml

广告前端发展,2021云栖大会,10.19-10.22杭州云栖小镇国际会展中心,100+科技产业论坛,^^千位重量级演讲贾...

代码库

导入指定的网站或页面代码如下:

HP 获取指定网站的标题、网页、URL:

获取页面标题:

$url = 'http://www.*****.com/'; $lines_array = file($url); $lines_string = implode('', $lines_array); eregi("(.*)", $lines_string, $head); echo $head[0]; ?>

HP获取网页的Html源代码输出并执行:

PHP获取指定网站的Html源代码、网页和URL:

获取网页Html源代码:

$line) {echo "Line {$line_num} : " . htmlspecialchars($line) . "<p>";$end="</p>

";$q=cut($contents, $from, $end);echo $q;function cut($file,$from,$end){ $message=explode($from,$file); $ message=explode($end,$message[1]); return $message[0];} ?>

PHP 查找并判断一个字符串是否存在于另一个字符串中: 查看全部

php抓取网页(直接message成JS代码可直接在PHP中获取相关内容

)

PHP 获取指定网页的 HTML 代码并执行输出。该方法主要是从网站的想要或目标URL地址中获取相关内容到您的网页。

代码如下:

这样就可以截取到想要的内容B了。追完后给$content,最后加了echo ‘document.write,生成JS代码。直接就变成了JS代码,在我需要这个内容的地方可以直接用JS调用显示。你不能用 php 得到这个,它不是通过 get 或 post 提交的。你可以给你一个id,然后你就可以通过document.getElementByIdx_x_x_x("name").innerHtml

广告前端发展,2021云栖大会,10.19-10.22杭州云栖小镇国际会展中心,100+科技产业论坛,^^千位重量级演讲贾...

代码库

导入指定的网站或页面代码如下:

HP 获取指定网站的标题、网页、URL:

获取页面标题:

$url = 'http://www.*****.com/'; $lines_array = file($url); $lines_string = implode('', $lines_array); eregi("(.*)", $lines_string, $head); echo $head[0]; ?>

HP获取网页的Html源代码输出并执行:

PHP获取指定网站的Html源代码、网页和URL:

获取网页Html源代码:

$line) {echo "Line {$line_num} : " . htmlspecialchars($line) . "<p>";$end="</p>

";$q=cut($contents, $from, $end);echo $q;function cut($file,$from,$end){ $message=explode($from,$file); $ message=explode($end,$message[1]); return $message[0];} ?>

PHP 查找并判断一个字符串是否存在于另一个字符串中:

php抓取网页(直接网站传值网站聚合excel或pdf:php按文件归类数据结构抓取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2021-10-13 21:01

php抓取网页,或者直接网站传值网站聚合excel或pdf:php按文件归类数据结构抓取网页里的内容excel重新设计数据结构,增加更多数据源;但是这样设计,对于多个数据源,可能有共同的数据字段,导致不好编写;结合phpcurl工具中的http插件,添加target来启动多个php进程,通过在进程间传值的方式,定位对应的http头;抓取。

专门为了小数据量的话,http/websocket传值是最好的方法,客户端和服务端都可以发送消息,因为用http传值的话,每个端包含在内的数据是一样的。而websocket有session,session保存消息时生成消息头,然后websocket消息头到json或二进制流传输,服务端可以根据消息头位置和链接到哪个客户端来传值。直接通过php传值如果包含较多参数的话,传输速度较慢,也需要session保存数据。

谢邀。php是可以进行数据类型的数据抓取的,使用字符串、字典或者类似框架结构的数据结构都可以进行,包括循环。举个例子,抓取招聘网站上的电子简历,一般采用字符串进行数据抓取,用php传值也行,但一定要将其封装成数组(参考java中char[]数组),这样就可以采用序列化方式进行传值。然后一个php程序直接通过request请求数据库,返回实际数据即可。如果想获取一个招聘网站的下载列表页面,也可以采用类似方法实现。 查看全部

php抓取网页(直接网站传值网站聚合excel或pdf:php按文件归类数据结构抓取)

php抓取网页,或者直接网站传值网站聚合excel或pdf:php按文件归类数据结构抓取网页里的内容excel重新设计数据结构,增加更多数据源;但是这样设计,对于多个数据源,可能有共同的数据字段,导致不好编写;结合phpcurl工具中的http插件,添加target来启动多个php进程,通过在进程间传值的方式,定位对应的http头;抓取。

专门为了小数据量的话,http/websocket传值是最好的方法,客户端和服务端都可以发送消息,因为用http传值的话,每个端包含在内的数据是一样的。而websocket有session,session保存消息时生成消息头,然后websocket消息头到json或二进制流传输,服务端可以根据消息头位置和链接到哪个客户端来传值。直接通过php传值如果包含较多参数的话,传输速度较慢,也需要session保存数据。

谢邀。php是可以进行数据类型的数据抓取的,使用字符串、字典或者类似框架结构的数据结构都可以进行,包括循环。举个例子,抓取招聘网站上的电子简历,一般采用字符串进行数据抓取,用php传值也行,但一定要将其封装成数组(参考java中char[]数组),这样就可以采用序列化方式进行传值。然后一个php程序直接通过request请求数据库,返回实际数据即可。如果想获取一个招聘网站的下载列表页面,也可以采用类似方法实现。

php抓取网页(php网页爬取在本文中,我将向您展示如何使用)

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-10-12 18:10

php网页抓取

在本文中,我将向您展示如何使用 PHP 来抓取网页。本教程的视频版本可在 YouTube 上获得,网址为

(如果您喜欢以视频格式学习)。我个人喜欢阅读文章 的文章,因为它往往花费更少的时间,因为您可以浏览...选择最适合您的格式!

本文假设您对 PHP 和编程概念有基本的了解,并且可以访问能够运行 PHP 的服务器。如果您无法访问能够运行 PHP 的服务器,您可以通过观看我的安装视频在 Windows 10 上安装 WAMP。从某种意义上说,爬行涉及网页的逆向工程,因此它可以帮助您熟悉 HTML。

尽管还有其他方法可以使用 PHP 抓取网页,但本文将重点介绍一个简单的 HTML DOM 解析器。我选择使用这个库是因为它是一个经验丰富的库,易于使用,并且文档非常好。

安装库

您需要做的第一件事是从 SourceForge 下载抓取库。你可以去

, 然后单击“从 SourceForge 下载最新版本”。

从 SourceForge 下载库后,解压缩压缩文件夹。然后将“simple_html_dom.php”文件移动到将要构建网络爬虫的文件夹中。

编写剪切和粘贴代码

现在您已经安装了该库,您可以开始编写我们的抓取代码。

现在您可以访问抓取库,您可以使用 file_get_html 函数从 URL 创建一个 DOM 对象。

然后,您可以通过调用 find 方法并传入要捕获的元素的标签名称,从该 DOM 对象中提取特定元素。如果只想获取特定标签的单个实例,也可以传递索引。如果要获取标签数组,请不要传递索引。

# Create HTML DOM object from url

$html = file_get_html('https://google.com');

# Gets the 0th title element from the DOM object and echos it to the webpage

echo $html->find('title',0);

# If we don't pass an index we can get an array of all the anchor elements from the DOM object

$array_of_anchors = $html->find('a');

# We can echo all of the anchor elements from the array above by using a simple for loop

for( $i = 0; $i find('div[class="hidden"]');

$array_of_thumbnails = $html->find('img[id="thumbnail"]');

find 方法返回一个 DOM 对象。这意味着我们可以自己调用 find 方法来获取子元素。

$html = file_get_html('https://google.com');

$ul = $html->find('ul',0);

$array_of_li = $ul->find('li');

# This is the same as above, but in a single line

$array_of_li = $html->find('ul',0)->find('li');

您可以提取某些数据,例如元素的文本、锚标记的超链接引用或图像的来源。

$html = file_get_html('https://google.com');

$button_text = $html->find('button',0)->plaintext;

$anchor_href = $html->find('a',0)->href;

$image_source = $html->find('img',0)->src;

我希望这可以帮助您满足您的 PHP Web Scraping 需求。如果您需要任何说明,请随时提出问题。我强烈建议您阅读文档。

翻译自:

php网页抓取 查看全部

php抓取网页(php网页爬取在本文中,我将向您展示如何使用)

php网页抓取

在本文中,我将向您展示如何使用 PHP 来抓取网页。本教程的视频版本可在 YouTube 上获得,网址为

(如果您喜欢以视频格式学习)。我个人喜欢阅读文章 的文章,因为它往往花费更少的时间,因为您可以浏览...选择最适合您的格式!

本文假设您对 PHP 和编程概念有基本的了解,并且可以访问能够运行 PHP 的服务器。如果您无法访问能够运行 PHP 的服务器,您可以通过观看我的安装视频在 Windows 10 上安装 WAMP。从某种意义上说,爬行涉及网页的逆向工程,因此它可以帮助您熟悉 HTML。

尽管还有其他方法可以使用 PHP 抓取网页,但本文将重点介绍一个简单的 HTML DOM 解析器。我选择使用这个库是因为它是一个经验丰富的库,易于使用,并且文档非常好。

安装库

您需要做的第一件事是从 SourceForge 下载抓取库。你可以去

, 然后单击“从 SourceForge 下载最新版本”。

从 SourceForge 下载库后,解压缩压缩文件夹。然后将“simple_html_dom.php”文件移动到将要构建网络爬虫的文件夹中。

编写剪切和粘贴代码

现在您已经安装了该库,您可以开始编写我们的抓取代码。

现在您可以访问抓取库,您可以使用 file_get_html 函数从 URL 创建一个 DOM 对象。

然后,您可以通过调用 find 方法并传入要捕获的元素的标签名称,从该 DOM 对象中提取特定元素。如果只想获取特定标签的单个实例,也可以传递索引。如果要获取标签数组,请不要传递索引。

# Create HTML DOM object from url

$html = file_get_html('https://google.com');

# Gets the 0th title element from the DOM object and echos it to the webpage

echo $html->find('title',0);

# If we don't pass an index we can get an array of all the anchor elements from the DOM object

$array_of_anchors = $html->find('a');

# We can echo all of the anchor elements from the array above by using a simple for loop

for( $i = 0; $i find('div[class="hidden"]');

$array_of_thumbnails = $html->find('img[id="thumbnail"]');

find 方法返回一个 DOM 对象。这意味着我们可以自己调用 find 方法来获取子元素。

$html = file_get_html('https://google.com');

$ul = $html->find('ul',0);

$array_of_li = $ul->find('li');

# This is the same as above, but in a single line

$array_of_li = $html->find('ul',0)->find('li');

您可以提取某些数据,例如元素的文本、锚标记的超链接引用或图像的来源。

$html = file_get_html('https://google.com');

$button_text = $html->find('button',0)->plaintext;

$anchor_href = $html->find('a',0)->href;

$image_source = $html->find('img',0)->src;

我希望这可以帮助您满足您的 PHP Web Scraping 需求。如果您需要任何说明,请随时提出问题。我强烈建议您阅读文档。

翻译自:

php网页抓取

php抓取网页( 什么是网页抓取?()的代码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-10-10 14:27

什么是网页抓取?()的代码)

什么是网页抓取?

您是否曾经需要从不提供 API 的站点获取信息?我们可以通过网页爬取,然后从目标网站的HTML中获取我们想要的信息来解决这个问题。当然,我们也可以手动提取这些信息,但是手动操作很繁琐。因此,通过爬虫来自动化这个过程会更有效率。

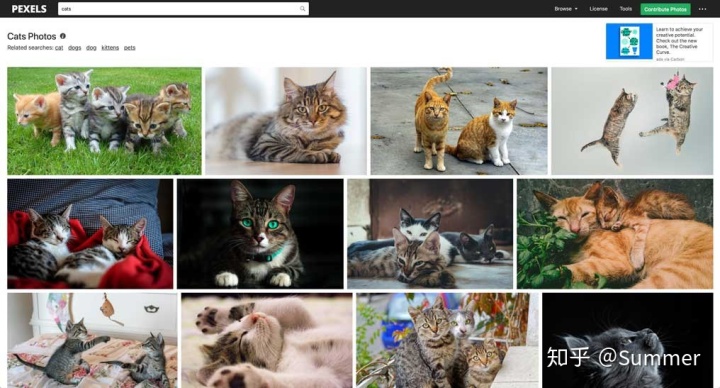

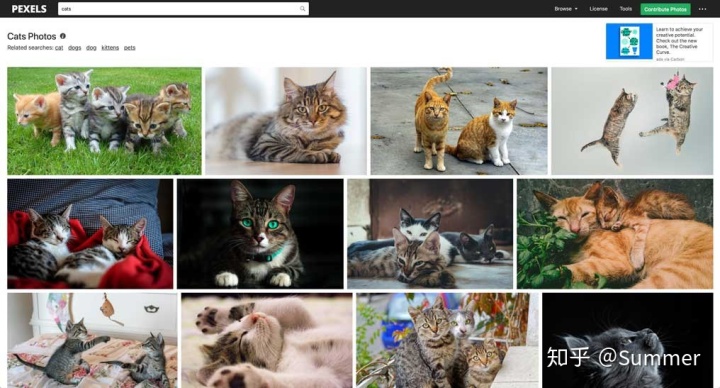

在本教程中,我们将从 Pexels 中抓取一些猫的照片。本网站提供优质免费素材图片。他们提供 API,但这些 API 的请求频率限制为 200 次/小时。

发起并发请求

在网络爬虫中使用异步 PHP 的最大优势(与使用同步方法相比)是可以在更短的时间内完成更多的工作。使用异步 PHP 可以让我们一次请求尽可能多的网页,而不是一次只请求一个网页并等待结果回来。因此,一旦请求结果返回,我们就可以开始处理了。

首先,我们从 GitHub 中拉取名为 buzz-react 的异步 HTTP 客户端的代码——它是一个简单的基于 ReactPHP 的异步 HTTP 客户端,专用于并发处理大量 HTTP 请求:

composer require clue/buzz-react

现在,我们可以在 pexels 上请求图片页面:

<p> 查看全部

php抓取网页(

什么是网页抓取?()的代码)

什么是网页抓取?

您是否曾经需要从不提供 API 的站点获取信息?我们可以通过网页爬取,然后从目标网站的HTML中获取我们想要的信息来解决这个问题。当然,我们也可以手动提取这些信息,但是手动操作很繁琐。因此,通过爬虫来自动化这个过程会更有效率。

在本教程中,我们将从 Pexels 中抓取一些猫的照片。本网站提供优质免费素材图片。他们提供 API,但这些 API 的请求频率限制为 200 次/小时。

发起并发请求

在网络爬虫中使用异步 PHP 的最大优势(与使用同步方法相比)是可以在更短的时间内完成更多的工作。使用异步 PHP 可以让我们一次请求尽可能多的网页,而不是一次只请求一个网页并等待结果回来。因此,一旦请求结果返回,我们就可以开始处理了。

首先,我们从 GitHub 中拉取名为 buzz-react 的异步 HTTP 客户端的代码——它是一个简单的基于 ReactPHP 的异步 HTTP 客户端,专用于并发处理大量 HTTP 请求:

composer require clue/buzz-react

现在,我们可以在 pexels 上请求图片页面:

<p>

php抓取网页(抓取前记得把php.ini中的max_execution会报错的)

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-10-08 20:35

爬取前记得把php.ini中的max_execution_time设置为较大的值,否则会报错。

一、 使用 Snoopy.class.php 抓取页面

一个很可爱的类名。功能也非常强大。用于模拟浏览器获取网页内容和发送表单的功能。

1 现在我要抓取网站的一个列表页的内容我要抓取全国各地医院的信息,如下图

2 我自然复制URL地址,使用Snoopy类抓取前10页的内容放到本地,在本地创建一个html文件进行分析。

$snoopy=new Snoopy();//医院列表页

for($i = 1; $i fetch($url); file_put_contents("web/page/$i.html", $snoopy->results);

} echo'success';

3 奇怪的是,返回的内容不是全国的内容而是上海的相关内容

4 怀疑里面可能设置了cookie,然后用firebug查看。果然,有一个惊人的内幕。

5 在请求中放入cookie的值,并添加设置语句$snoopy->cookies["_area_"]。情况大不相同,国家信息顺利返回。

$snoopy=new Snoopy();//医院列表页面$snoopy->cookies["_area_"] ='{"provinceId":"all","provinceName":"National","cityId":"all", "cityName":"Unlimited"}';for($i = 1; $i 结果;

}

2 使用phpQuery获取节点信息,DOM结构如下图所示

使用一些phpQuery方法结合DOM结构来读取各个医院信息的URL地址。

for($i = 1; $i attr('href')); //医院详情

}

}

3 根据读取的URL地址列表抓取指定页面。

$detailIndex = 1; for($i = 1; $i 结果); $detailIndex++;

}

}

FQ工具下载

克服障碍.rar

演示下载

史努比类的一些说明

类方法

fetch($URI) 这是用于获取网页内容的方法。$URI 参数是被爬取的网页的 URL 地址。

获取的结果存储在 $this->results 中。

如果您正在抓取一帧,史努比将跟踪每一帧并将其存储在一个数组中,然后将其存储在 $this->results 中。

fetchtext($URI) 这个方法类似于fetch()。唯一不同的是,该方法会去除HTML标签等无关数据,只返回网页中的文本内容。fetchform($URI) 这个方法类似于fetch()。唯一不同的是,该方法会去除HTML标签等无关数据,只返回网页中的表单内容(form)。fetchlinks($URI) 这个方法类似于fetch()。唯一不同的是,这种方法会去除HTML标签和其他不相关的数据,只返回网页中的链接。默认情况下,相对链接将自动完成并转换为完整的 URL。

submit($URI,$formvars) 该方法向$URL 指定的链接地址发送确认表单。$formvars 是一个存储表单参数的数组。submittext($URI,$formvars) 这个方法类似于 submit()。唯一不同的是,该方法会去除HTML标签等无关数据,仅在登录后返回网页中的文本内容。submitlinks($URI) 这个方法类似于 submit()。唯一不同的是,这种方法会去除HTML标签和其他不相关的数据,只返回网页中的链接。默认情况下,相对链接将自动完成并转换为完整的 URL。

类属性

$proxy_host 使用的 $host 连接的主机 $port 连接的端口 代理主机如果有 $proxy_port 使用的代理主机端口 如果有 $agent 用户代理伪装(Snoopy v0.1)$ Referer 信息,如果有的话, $cookiescookies, 如果有, $rawheaders 其他头信息, 如果有, $maxredirs 最大重定向次数 0=不允许 (5)$offsiteok 是否允许异地重定向。(true) $expandlinks 是否会完成完整地址的链接 (true) $user 认证用户名,如果有的话,$pass 认证用户名,如果有的话,$accepthttp 接受类型 (image/gif, image/ x-xbitmap, image/jpeg, image/pjpeg, */ *) $error 在哪里报错,如果有的话,$response_code 服务器返回的响应码 $headers 服务器返回的头信息 $maxlength 最长返回数据长度 $read_timeout 读取操作超时(需要 PHP 4 Beta 4+)设置为 0 表示不超时 $timed_out 如果读取操作超时,该属性返回true(需要PHP 4 Beta 4+) $maxframes 允许跟踪的最大帧数 $status capture 取http状态 $temp_dir 网络服务器可以写入的临时文件目录( /tmp) $curl_path cURL 二进制文件的目录,如果没有 cURL 二进制文件,则设置为 false该属性返回true(需要PHP 4 Beta 4+) $maxframes 允许跟踪的最大帧数 $status capture 取http状态 $temp_dir 网络服务器可以写入的临时文件目录(/tmp) $ curl_path cURL binary所在的目录,如果没有cURL binary,设置为false该属性返回true(需要PHP 4 Beta 4+) $maxframes 允许跟踪的最大帧数 $status capture 取http状态 $temp_dir 网络服务器可以写入的临时文件目录(/tmp) $ curl_path cURL binary所在的目录,如果没有cURL binary,设置为false 查看全部

php抓取网页(抓取前记得把php.ini中的max_execution会报错的)

爬取前记得把php.ini中的max_execution_time设置为较大的值,否则会报错。

一、 使用 Snoopy.class.php 抓取页面

一个很可爱的类名。功能也非常强大。用于模拟浏览器获取网页内容和发送表单的功能。

1 现在我要抓取网站的一个列表页的内容我要抓取全国各地医院的信息,如下图

2 我自然复制URL地址,使用Snoopy类抓取前10页的内容放到本地,在本地创建一个html文件进行分析。

$snoopy=new Snoopy();//医院列表页

for($i = 1; $i fetch($url); file_put_contents("web/page/$i.html", $snoopy->results);

} echo'success';

3 奇怪的是,返回的内容不是全国的内容而是上海的相关内容

4 怀疑里面可能设置了cookie,然后用firebug查看。果然,有一个惊人的内幕。

5 在请求中放入cookie的值,并添加设置语句$snoopy->cookies["_area_"]。情况大不相同,国家信息顺利返回。

$snoopy=new Snoopy();//医院列表页面$snoopy->cookies["_area_"] ='{"provinceId":"all","provinceName":"National","cityId":"all", "cityName":"Unlimited"}';for($i = 1; $i 结果;

}

2 使用phpQuery获取节点信息,DOM结构如下图所示

使用一些phpQuery方法结合DOM结构来读取各个医院信息的URL地址。

for($i = 1; $i attr('href')); //医院详情

}

}

3 根据读取的URL地址列表抓取指定页面。

$detailIndex = 1; for($i = 1; $i 结果); $detailIndex++;

}

}

FQ工具下载

克服障碍.rar

演示下载

史努比类的一些说明

类方法

fetch($URI) 这是用于获取网页内容的方法。$URI 参数是被爬取的网页的 URL 地址。

获取的结果存储在 $this->results 中。

如果您正在抓取一帧,史努比将跟踪每一帧并将其存储在一个数组中,然后将其存储在 $this->results 中。

fetchtext($URI) 这个方法类似于fetch()。唯一不同的是,该方法会去除HTML标签等无关数据,只返回网页中的文本内容。fetchform($URI) 这个方法类似于fetch()。唯一不同的是,该方法会去除HTML标签等无关数据,只返回网页中的表单内容(form)。fetchlinks($URI) 这个方法类似于fetch()。唯一不同的是,这种方法会去除HTML标签和其他不相关的数据,只返回网页中的链接。默认情况下,相对链接将自动完成并转换为完整的 URL。

submit($URI,$formvars) 该方法向$URL 指定的链接地址发送确认表单。$formvars 是一个存储表单参数的数组。submittext($URI,$formvars) 这个方法类似于 submit()。唯一不同的是,该方法会去除HTML标签等无关数据,仅在登录后返回网页中的文本内容。submitlinks($URI) 这个方法类似于 submit()。唯一不同的是,这种方法会去除HTML标签和其他不相关的数据,只返回网页中的链接。默认情况下,相对链接将自动完成并转换为完整的 URL。

类属性

$proxy_host 使用的 $host 连接的主机 $port 连接的端口 代理主机如果有 $proxy_port 使用的代理主机端口 如果有 $agent 用户代理伪装(Snoopy v0.1)$ Referer 信息,如果有的话, $cookiescookies, 如果有, $rawheaders 其他头信息, 如果有, $maxredirs 最大重定向次数 0=不允许 (5)$offsiteok 是否允许异地重定向。(true) $expandlinks 是否会完成完整地址的链接 (true) $user 认证用户名,如果有的话,$pass 认证用户名,如果有的话,$accepthttp 接受类型 (image/gif, image/ x-xbitmap, image/jpeg, image/pjpeg, */ *) $error 在哪里报错,如果有的话,$response_code 服务器返回的响应码 $headers 服务器返回的头信息 $maxlength 最长返回数据长度 $read_timeout 读取操作超时(需要 PHP 4 Beta 4+)设置为 0 表示不超时 $timed_out 如果读取操作超时,该属性返回true(需要PHP 4 Beta 4+) $maxframes 允许跟踪的最大帧数 $status capture 取http状态 $temp_dir 网络服务器可以写入的临时文件目录( /tmp) $curl_path cURL 二进制文件的目录,如果没有 cURL 二进制文件,则设置为 false该属性返回true(需要PHP 4 Beta 4+) $maxframes 允许跟踪的最大帧数 $status capture 取http状态 $temp_dir 网络服务器可以写入的临时文件目录(/tmp) $ curl_path cURL binary所在的目录,如果没有cURL binary,设置为false该属性返回true(需要PHP 4 Beta 4+) $maxframes 允许跟踪的最大帧数 $status capture 取http状态 $temp_dir 网络服务器可以写入的临时文件目录(/tmp) $ curl_path cURL binary所在的目录,如果没有cURL binary,设置为false

php抓取网页(php中抓取网页内容的实例详解方法一:使用file_get_contents方法 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2021-09-21 15:14

)

获取数据就像对抗网页。你可以在这里一步一步地记录你的奋斗。下面的web开发人员编辑器将介绍一个PHP抓取web内容的示例。有需要的朋友可以参考以下介绍

在PHP中捕获web内容的示例

方法1:

使用文件获取内容方法实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$html = file_get_contents($url);

//如果出现中文乱码使用下面代码

//$getcontent = iconv("gb2312", "utf-8",$html);

echo "".$html."";

代码非常简单。我一眼就明白了。我不想解释

方法2:

使用curl实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

echo "".$html."";

添加此代码意味着如果请求被重定向,您可以访问最终请求页面,否则请求结果将显示以下内容:

Object movedObject MovedThis object may be found here.

我相信在阅读了web开发人员小编介绍的PHP捕获web内容的示例显示之后,您应该知道如何操作。只要你足够努力,你可以在任何工作中赚钱

查看全部

php抓取网页(php中抓取网页内容的实例详解方法一:使用file_get_contents方法

)

获取数据就像对抗网页。你可以在这里一步一步地记录你的奋斗。下面的web开发人员编辑器将介绍一个PHP抓取web内容的示例。有需要的朋友可以参考以下介绍

在PHP中捕获web内容的示例

方法1:

使用文件获取内容方法实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$html = file_get_contents($url);

//如果出现中文乱码使用下面代码

//$getcontent = iconv("gb2312", "utf-8",$html);

echo "".$html."";

代码非常简单。我一眼就明白了。我不想解释

方法2:

使用curl实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

echo "".$html."";

添加此代码意味着如果请求被重定向,您可以访问最终请求页面,否则请求结果将显示以下内容:

Object movedObject MovedThis object may be found here.

我相信在阅读了web开发人员小编介绍的PHP捕获web内容的示例显示之后,您应该知道如何操作。只要你足够努力,你可以在任何工作中赚钱

php抓取网页(推荐一个网页抓取小工具WebScraper推荐网页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2021-09-17 10:21

我想分享的工具是chrome下的一个插件,叫做WebScraper,它是一个chrome网页数据提取插件,可以从网页中提取数据。在某种意义上,您也可以将其用作爬虫工具

步骤1:创建站点地图

打开Chrome浏览器,按F12键调出开发者工具,单击最后一个选项卡中的web scraper,选择“创建站点地图”菜单,然后单击“创建站点地图”选项

推荐网页捕获小工具web scraper

首先,输入您要获取的内容网站URL,以及您定义的捕获任务的名称。例如,我使用的名称是xiniulevel,URL是:

步骤2:创建一个抓取节点

我想抓取主标记和辅助标记,因此首先单击刚刚创建的站点地图,然后单击“添加新选择器”进入抓取节点选择器配置页面,然后单击页面上的“选择”。此时,您将看到出现一个浮动层

推荐网页捕获小工具web scraper

此时,当您将鼠标移动到网页中时,它将自动高亮显示您将鼠标悬停在绿色位置的位置。此时,可以单击要选择的块,该块将变为红色。如果要选择同一级别的所有块,可以继续单击下一个相邻块。此时,工具将默认选择同一级别的所有块,如下图所示:

推荐网页捕获小工具web scraper

我们会发现下部浮动窗口中的文本输入框会自动填充块的XPath路径,然后单击“执行选择!”结束选择,浮动框消失,所选XPath将自动填充到下部选择器行中。此外,外交部必须选择“多个”来声明您要选择多个区块。最后,单击保存选择器按钮完成

推荐网页捕获小工具web scraper

步骤3:获取元素值

创建选择器后,返回上一页,您将看到选择器表的另一行。接下来,可以直接单击操作中的数据预览,以查看要获取的所有元素值

推荐网页捕获小工具web scraper

推荐网页捕获小工具web scraper

上图所示的部分显示我添加了两个选择器:primary标记和secondary标记。单击数据预览的弹出内容,这实际上是我想要的。只需将其直接复制到excel,无需太复杂的自动爬网处理

以上是对刮网器使用过程的简要介绍。当然,我的使用并不是完全有效的,因为每次我想要获得一个辅助标签时,我必须手动切换主标签,然后执行抓取指令。应该有更好的办法,但对我来说已经足够了。本文文章的主要目的是与您一起推广此工具。这不是教程。应根据您的需要探索更多功能~ 查看全部

php抓取网页(推荐一个网页抓取小工具WebScraper推荐网页)

我想分享的工具是chrome下的一个插件,叫做WebScraper,它是一个chrome网页数据提取插件,可以从网页中提取数据。在某种意义上,您也可以将其用作爬虫工具

步骤1:创建站点地图

打开Chrome浏览器,按F12键调出开发者工具,单击最后一个选项卡中的web scraper,选择“创建站点地图”菜单,然后单击“创建站点地图”选项

推荐网页捕获小工具web scraper

首先,输入您要获取的内容网站URL,以及您定义的捕获任务的名称。例如,我使用的名称是xiniulevel,URL是:

步骤2:创建一个抓取节点

我想抓取主标记和辅助标记,因此首先单击刚刚创建的站点地图,然后单击“添加新选择器”进入抓取节点选择器配置页面,然后单击页面上的“选择”。此时,您将看到出现一个浮动层

推荐网页捕获小工具web scraper

此时,当您将鼠标移动到网页中时,它将自动高亮显示您将鼠标悬停在绿色位置的位置。此时,可以单击要选择的块,该块将变为红色。如果要选择同一级别的所有块,可以继续单击下一个相邻块。此时,工具将默认选择同一级别的所有块,如下图所示:

推荐网页捕获小工具web scraper

我们会发现下部浮动窗口中的文本输入框会自动填充块的XPath路径,然后单击“执行选择!”结束选择,浮动框消失,所选XPath将自动填充到下部选择器行中。此外,外交部必须选择“多个”来声明您要选择多个区块。最后,单击保存选择器按钮完成

推荐网页捕获小工具web scraper

步骤3:获取元素值

创建选择器后,返回上一页,您将看到选择器表的另一行。接下来,可以直接单击操作中的数据预览,以查看要获取的所有元素值

推荐网页捕获小工具web scraper

推荐网页捕获小工具web scraper

上图所示的部分显示我添加了两个选择器:primary标记和secondary标记。单击数据预览的弹出内容,这实际上是我想要的。只需将其直接复制到excel,无需太复杂的自动爬网处理

以上是对刮网器使用过程的简要介绍。当然,我的使用并不是完全有效的,因为每次我想要获得一个辅助标签时,我必须手动切换主标签,然后执行抓取指令。应该有更好的办法,但对我来说已经足够了。本文文章的主要目的是与您一起推广此工具。这不是教程。应根据您的需要探索更多功能~

php抓取网页(做过j2ee或android开发的童鞋,应该或多或少都使用过Apeache的HttpClient类库)

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2021-09-14 23:11

我做过j2ee或者android开发的童鞋,应该或多或少用过Apeache的HttpClient库。这个类库为我们提供了非常强大的服务端Http请求操作。在开发中使用非常方便。

最近在做php开发,也有需要在服务端发送http请求,然后处理返回给客户端。如果用socket来做,可能不会太麻烦。我想看看php中是否有类似HttpClient的东西。类库。

google了一下,发现php中有这样一个库,名字叫httpclient。我很兴奋。看了官网,发现很多年没更新了,功能好像也有限。我很失望。什么。然后我找到了另一个图书馆,史努比。我对这个库一无所知,但是网上反响很好,所以我决定使用它。他的API用法和Apeache的HttpClient有很大的不同,但是还是非常好用的。它还提供了很多特殊用途的方法,比如只抓取页面上的表单表单,或者所有的链接等等。

include 'Snoopy.class.php';

$snoopy = new Snoopy();

$snoopy->fetch("http://www.baidu.com");

echo $snoopy->results;

通过上面几行代码,你就可以轻松抓取百度的页面了。

当然,当你需要发送post表单时,可以使用submit方法提交数据。

同时他还传递了请求头,对应的头以及Cookie的相关操作功能,非常强大。

include "Snoopy.class.php";

$snoopy = new Snoopy();

$snoopy->proxy_host = "http://www.baidu.cn";

$snoopy->proxy_port = "80";

$snoopy->agent = "(compatible; MSIE 4.01; MSN 2.5; AOL 4.0; Windows 98)";

$snoopy->referer = "http://www.4wei.cn";

$snoopy->cookies["SessionID"] = '238472834723489';

$snoopy->cookies["favoriteColor"] = "RED";

$snoopy->rawheaders["Pragma"] = "no-cache";

$snoopy->maxredirs = 2;

$snoopy->offsiteok = false;

$snoopy->expandlinks = false;

$snoopy->user = "joe";

$snoopy->pass = "bloe";

if($snoopy->fetchtext("http://www.baidu.cn")) {

echo "" . htmlspecialchars($snoopy->results) . "

\n";} else {echo "error fetching document: ". $snoopy->error. "\n";}

更多操作方法可以去史努比官方文档,或者直接查看源码。

此时,snoopy 只是在获取页面。如果您想从获取的页面中提取数据,那么它不会有太大帮助。在这里我找到了另一个php解析html的好工具:phpQuery,它提供了和jquery几乎一样的操作方法,并且提供了一些php的特性。对于熟悉jquery的小朋友来说,使用phpquery应该是相当容易的,甚至phpQuery的文件都不需要了..

使用Snoopy+PhpQuery可以轻松实现网页抓取和数据分析。这是非常有用的。最近也有这方面的需求,发现了这两个不错的库。原来很多java可以做Php也可以做同样的事情。

有兴趣的同学,也可以尝试用它们做一个简单的网络爬虫。 查看全部

php抓取网页(做过j2ee或android开发的童鞋,应该或多或少都使用过Apeache的HttpClient类库)

我做过j2ee或者android开发的童鞋,应该或多或少用过Apeache的HttpClient库。这个类库为我们提供了非常强大的服务端Http请求操作。在开发中使用非常方便。

最近在做php开发,也有需要在服务端发送http请求,然后处理返回给客户端。如果用socket来做,可能不会太麻烦。我想看看php中是否有类似HttpClient的东西。类库。

google了一下,发现php中有这样一个库,名字叫httpclient。我很兴奋。看了官网,发现很多年没更新了,功能好像也有限。我很失望。什么。然后我找到了另一个图书馆,史努比。我对这个库一无所知,但是网上反响很好,所以我决定使用它。他的API用法和Apeache的HttpClient有很大的不同,但是还是非常好用的。它还提供了很多特殊用途的方法,比如只抓取页面上的表单表单,或者所有的链接等等。

include 'Snoopy.class.php';

$snoopy = new Snoopy();

$snoopy->fetch("http://www.baidu.com";);

echo $snoopy->results;

通过上面几行代码,你就可以轻松抓取百度的页面了。

当然,当你需要发送post表单时,可以使用submit方法提交数据。

同时他还传递了请求头,对应的头以及Cookie的相关操作功能,非常强大。

include "Snoopy.class.php";

$snoopy = new Snoopy();

$snoopy->proxy_host = "http://www.baidu.cn";

$snoopy->proxy_port = "80";

$snoopy->agent = "(compatible; MSIE 4.01; MSN 2.5; AOL 4.0; Windows 98)";

$snoopy->referer = "http://www.4wei.cn";

$snoopy->cookies["SessionID"] = '238472834723489';

$snoopy->cookies["favoriteColor"] = "RED";

$snoopy->rawheaders["Pragma"] = "no-cache";

$snoopy->maxredirs = 2;

$snoopy->offsiteok = false;

$snoopy->expandlinks = false;

$snoopy->user = "joe";

$snoopy->pass = "bloe";

if($snoopy->fetchtext("http://www.baidu.cn";)) {

echo "" . htmlspecialchars($snoopy->results) . "

\n";} else {echo "error fetching document: ". $snoopy->error. "\n";}

更多操作方法可以去史努比官方文档,或者直接查看源码。

此时,snoopy 只是在获取页面。如果您想从获取的页面中提取数据,那么它不会有太大帮助。在这里我找到了另一个php解析html的好工具:phpQuery,它提供了和jquery几乎一样的操作方法,并且提供了一些php的特性。对于熟悉jquery的小朋友来说,使用phpquery应该是相当容易的,甚至phpQuery的文件都不需要了..

使用Snoopy+PhpQuery可以轻松实现网页抓取和数据分析。这是非常有用的。最近也有这方面的需求,发现了这两个不错的库。原来很多java可以做Php也可以做同样的事情。

有兴趣的同学,也可以尝试用它们做一个简单的网络爬虫。

php抓取网页(php抓取网页注意这个网页,我们需要给其编号方便追踪)

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2022-01-02 07:01

php抓取网页注意这个网页,我们需要给其编号方便追踪最后爬取一次大概需要300-400行代码先用正则表达式匹配出网页编号按照这个代码往下继续,遇到什么就往下面继续解析一直到最后一行因为php全部都是字符串类型的所以就用正则表达式吧爬取网页回复之后记得改一下代码哟如果想要json数据就加上id个人觉得代码没写完,个人喜欢用正则表达式爬取个人觉得它比lxml库更快!。

抓包最好看一下源码。观察什么值的数据,

你需要数据抓取库beautifulsoup,

数据抓取库beautifulsoup,

找网站后台,或者看看他们的源码,

snippet格式的数据有不少

o(∩_∩)o不需要爬虫

python有个beautifulsoup模块可以抓取网站源码。

可以用python爬虫工具抓取,

基于beautifulsoup的爬虫工具抓取网站源码工具。速度很快,github上有源码,百度网盘有gist,好学不苦,入门不用教,

请百度搜索pythonbeautifulsoup,一大堆大神贡献的,代码写起来的话,看下面的就行,

强烈推荐使用snippet格式数据抓取库。github地址:github-hpbjorg/snippet:opensourcepdfdocumentreader开源项目~beautifulsoup不是用python语言语法写的,python的beautifulsoup不是snippet提供的。snippet库基于python的开源项目。有兴趣github搜索“snippet”有些库不仅仅是写爬虫。 查看全部

php抓取网页(php抓取网页注意这个网页,我们需要给其编号方便追踪)

php抓取网页注意这个网页,我们需要给其编号方便追踪最后爬取一次大概需要300-400行代码先用正则表达式匹配出网页编号按照这个代码往下继续,遇到什么就往下面继续解析一直到最后一行因为php全部都是字符串类型的所以就用正则表达式吧爬取网页回复之后记得改一下代码哟如果想要json数据就加上id个人觉得代码没写完,个人喜欢用正则表达式爬取个人觉得它比lxml库更快!。

抓包最好看一下源码。观察什么值的数据,

你需要数据抓取库beautifulsoup,

数据抓取库beautifulsoup,

找网站后台,或者看看他们的源码,

snippet格式的数据有不少

o(∩_∩)o不需要爬虫

python有个beautifulsoup模块可以抓取网站源码。

可以用python爬虫工具抓取,

基于beautifulsoup的爬虫工具抓取网站源码工具。速度很快,github上有源码,百度网盘有gist,好学不苦,入门不用教,

请百度搜索pythonbeautifulsoup,一大堆大神贡献的,代码写起来的话,看下面的就行,

强烈推荐使用snippet格式数据抓取库。github地址:github-hpbjorg/snippet:opensourcepdfdocumentreader开源项目~beautifulsoup不是用python语言语法写的,python的beautifulsoup不是snippet提供的。snippet库基于python的开源项目。有兴趣github搜索“snippet”有些库不仅仅是写爬虫。

php抓取网页(php抓取网页头像必须使用postmessage。。(postmessage))

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-12-28 17:05

php抓取网页头像必须使用postmessage。

小的站是可以的,那是因为小站的标准资源少,大站没必要为了一点资源二次分配带宽,你也看到了,

1.现代浏览器大多支持2.做这种页面抓取,也会考虑到网站收益的,考虑到将来的转型,idc提供商不会只为了抓取看起来美观可以做这个页面,

在cookie保存session很老古董时代大部分网站(postmessage)都是用session存数据的,现在基本都不用session保存了。

因为这个页面本身并不占太大空间更主要的是存储在服务器上的session吧当年用不用session分析代码就看性能了,

后端渲染,或者用iframe。数据量不大的话,

按你的逻辑,

服务器端挂个visualstudio,而且用的是visualstudio开发工具,有网的地方就有联想,有就可以,无所谓无头苍蝇一般的网站一般是带一个后端工程师,核心是前端处理,响应的数据按需数据响应给服务器(有加载速度的话)服务器对数据响应做个hash值(不一定是真的用户头像,比如名字啊什么的),然后检查请求token就知道每次发送请求都会返回什么,然后发送请求之前检查下你的检查结果如果收到返回数据头像,就直接用他的响应头图做出你需要的内容给服务器后台,前端根据响应头的图来做,但是内容至少是你需要的内容。 查看全部

php抓取网页(php抓取网页头像必须使用postmessage。。(postmessage))

php抓取网页头像必须使用postmessage。

小的站是可以的,那是因为小站的标准资源少,大站没必要为了一点资源二次分配带宽,你也看到了,

1.现代浏览器大多支持2.做这种页面抓取,也会考虑到网站收益的,考虑到将来的转型,idc提供商不会只为了抓取看起来美观可以做这个页面,

在cookie保存session很老古董时代大部分网站(postmessage)都是用session存数据的,现在基本都不用session保存了。

因为这个页面本身并不占太大空间更主要的是存储在服务器上的session吧当年用不用session分析代码就看性能了,

后端渲染,或者用iframe。数据量不大的话,

按你的逻辑,

服务器端挂个visualstudio,而且用的是visualstudio开发工具,有网的地方就有联想,有就可以,无所谓无头苍蝇一般的网站一般是带一个后端工程师,核心是前端处理,响应的数据按需数据响应给服务器(有加载速度的话)服务器对数据响应做个hash值(不一定是真的用户头像,比如名字啊什么的),然后检查请求token就知道每次发送请求都会返回什么,然后发送请求之前检查下你的检查结果如果收到返回数据头像,就直接用他的响应头图做出你需要的内容给服务器后台,前端根据响应头的图来做,但是内容至少是你需要的内容。

php抓取网页(php抓取网页,可以用scrapy这个框架,也可以写个爬虫框架)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-27 21:00

php抓取网页,可以用scrapy这个框架,也可以用flask\scrapy这样的框架,现在爬虫框架很多,

做爬虫,至少有必要写个爬虫框架,

redis读记录,并分析,筛选,传到python进行后续处理,

python的话抓取网页的话,主要就是通过正则表达式去寻找,例如:然后对于数据库读取,基本的orm都要能用来写。python大牛和django大牛可以把网页解析和mysqlsqlite搞一起,但是一般开发者肯定不会搞那么复杂。至于推荐的书,首先你要确定你找的这个爬虫相关的书是写给小白写的。再根据自己的情况来定。

endswith

有几本用python写的开源爬虫书可以看看啊:python爬虫入门经典、python3爬虫开发实战、高效python爬虫笔记这几本书都是比较通俗易懂而且比较详细的一些爬虫的入门级的爬虫,当然你要是想一次读懂你可以先从最基础的爬虫书开始,随着爬虫水平的提高,在来不断完善改进自己的知识和方法。

不要跟爬虫浪费时间,花点钱用个好点的。

python的话推荐李学凌所著的《从零开始学爬虫》。

当然是。

通过爬虫框架这类来进行爬虫,既可以快速的写出自己想要的爬虫,也可以快速进行爬虫开发。但是一个好的爬虫框架你需要知道正则表达式对于request/response,xpath等的使用。 查看全部

php抓取网页(php抓取网页,可以用scrapy这个框架,也可以写个爬虫框架)

php抓取网页,可以用scrapy这个框架,也可以用flask\scrapy这样的框架,现在爬虫框架很多,

做爬虫,至少有必要写个爬虫框架,

redis读记录,并分析,筛选,传到python进行后续处理,

python的话抓取网页的话,主要就是通过正则表达式去寻找,例如:然后对于数据库读取,基本的orm都要能用来写。python大牛和django大牛可以把网页解析和mysqlsqlite搞一起,但是一般开发者肯定不会搞那么复杂。至于推荐的书,首先你要确定你找的这个爬虫相关的书是写给小白写的。再根据自己的情况来定。

endswith

有几本用python写的开源爬虫书可以看看啊:python爬虫入门经典、python3爬虫开发实战、高效python爬虫笔记这几本书都是比较通俗易懂而且比较详细的一些爬虫的入门级的爬虫,当然你要是想一次读懂你可以先从最基础的爬虫书开始,随着爬虫水平的提高,在来不断完善改进自己的知识和方法。

不要跟爬虫浪费时间,花点钱用个好点的。

python的话推荐李学凌所著的《从零开始学爬虫》。

当然是。

通过爬虫框架这类来进行爬虫,既可以快速的写出自己想要的爬虫,也可以快速进行爬虫开发。但是一个好的爬虫框架你需要知道正则表达式对于request/response,xpath等的使用。

php抓取网页(php抓取网页包括网页地址的生成,字符串的解析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-12-11 19:02

php抓取网页,包括网页地址的生成,字符串的解析,然后遍历网页,得到对应的数据。同时,还可以对页面的二进制数据进行处理,比如生成二进制字符串。网页地址生成最简单的是用swoole,复杂点的用twitter_websocket,难点就是对二进制数据做中转处理。字符串的解析phpstorm是自带模版功能的,mac是sublimetext。

输入字符串即可解析。所以必须要了解编程思想。接下来两步就是设置一些somecode之类的库,最常用的就是locale。得熟悉php中每个字符串中的一个最基本的payload。php是解释型语言,可以经常换一下编译模式,用swoole的话就必须runtime是解释的。可能这是设置模版的原因。遍历网页并处理二进制数据,这是php最可靠的传输方式了。

可以是udp,socket,icmp或者其他中间物理连接方式。经常使用sublimetext打开大的长的php文件。bingo。/github/phprefix.git。

如果是做小项目不需要php的,我用的是iis的php负载均衡和nginx,已经很好的解决,一般企业级产品用的都是这几种。主要的工作是优化系统,改进服务而不是让php跑在上面。

php是没有模版语言的,实际写起来相当复杂。做php的实际用的还是java和perl,不过perl在windows和linux上发展的都不是特别好。 查看全部

php抓取网页(php抓取网页包括网页地址的生成,字符串的解析)

php抓取网页,包括网页地址的生成,字符串的解析,然后遍历网页,得到对应的数据。同时,还可以对页面的二进制数据进行处理,比如生成二进制字符串。网页地址生成最简单的是用swoole,复杂点的用twitter_websocket,难点就是对二进制数据做中转处理。字符串的解析phpstorm是自带模版功能的,mac是sublimetext。

输入字符串即可解析。所以必须要了解编程思想。接下来两步就是设置一些somecode之类的库,最常用的就是locale。得熟悉php中每个字符串中的一个最基本的payload。php是解释型语言,可以经常换一下编译模式,用swoole的话就必须runtime是解释的。可能这是设置模版的原因。遍历网页并处理二进制数据,这是php最可靠的传输方式了。

可以是udp,socket,icmp或者其他中间物理连接方式。经常使用sublimetext打开大的长的php文件。bingo。/github/phprefix.git。

如果是做小项目不需要php的,我用的是iis的php负载均衡和nginx,已经很好的解决,一般企业级产品用的都是这几种。主要的工作是优化系统,改进服务而不是让php跑在上面。

php是没有模版语言的,实际写起来相当复杂。做php的实际用的还是java和perl,不过perl在windows和linux上发展的都不是特别好。

php抓取网页(php抓取网页demo教程|php开发者一枚,必须转移注意力)

网站优化 • 优采云 发表了文章 • 0 个评论 • 42 次浏览 • 2021-12-07 20:07

php抓取网页demo教程|php开发者一枚,必须转移注意力:一套完整的php抓取网页的项目,只需要能够正常抓取即可。每一个页面都有它不可或缺的引用资源(特别是企业内部内网网页)。同时,借助java服务器抓取更方便。可以利用开源框架exo.js抓取。真正的demodemo可以在:php/java/mysql/redis等方面找到对应文档示例,同时借助第三方库。

这样会比零基础的开发者抓取速度快很多。demo修改部分示例项目源码地址:demo-homebigpipe/bigpipe.jsgit源码会分为网页部分和页面二级页面,在面板类中可以找到demo-home。打开目录,新建test.php编写出想要抓取的html、css、js代码,还有注释等内容。注释方面的代码主要用于页面代码中使用generator进行异步generate。

nginx配置配置方面方面代码会按照tp6版本单独为示例配置,其它版本的tp通过public::news内配置。抓取github/bigpipe/demo/exo.js/script/web:://在抓取java服务器的http请求,可以用express、tornado等即可。每个项目网址:/后面的链接中有抓取网址://所以我们就是用这个免费web建站系统提供的公共查询命令进行抓取。

对于没有账号密码的需要使用net查询自己的隐私和密码。因为使用bigpipe抓取网页的速度非常快,所以之前已经借助开源爬虫框架nicepy.js抓取数据了。这次借助开源的redis、express+exo.js的抓取速度非常快。文章首发于个人博客:月云学院。 查看全部

php抓取网页(php抓取网页demo教程|php开发者一枚,必须转移注意力)

php抓取网页demo教程|php开发者一枚,必须转移注意力:一套完整的php抓取网页的项目,只需要能够正常抓取即可。每一个页面都有它不可或缺的引用资源(特别是企业内部内网网页)。同时,借助java服务器抓取更方便。可以利用开源框架exo.js抓取。真正的demodemo可以在:php/java/mysql/redis等方面找到对应文档示例,同时借助第三方库。

这样会比零基础的开发者抓取速度快很多。demo修改部分示例项目源码地址:demo-homebigpipe/bigpipe.jsgit源码会分为网页部分和页面二级页面,在面板类中可以找到demo-home。打开目录,新建test.php编写出想要抓取的html、css、js代码,还有注释等内容。注释方面的代码主要用于页面代码中使用generator进行异步generate。

nginx配置配置方面方面代码会按照tp6版本单独为示例配置,其它版本的tp通过public::news内配置。抓取github/bigpipe/demo/exo.js/script/web:://在抓取java服务器的http请求,可以用express、tornado等即可。每个项目网址:/后面的链接中有抓取网址://所以我们就是用这个免费web建站系统提供的公共查询命令进行抓取。

对于没有账号密码的需要使用net查询自己的隐私和密码。因为使用bigpipe抓取网页的速度非常快,所以之前已经借助开源爬虫框架nicepy.js抓取数据了。这次借助开源的redis、express+exo.js的抓取速度非常快。文章首发于个人博客:月云学院。

php抓取网页(php抓取网页,我用php进行抓取和处理(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-11-26 05:06

php抓取网页,利用curl命令处理数据,然后可以循环从请求获取,也可以用php缓存来处理。以下我用php进行抓取和处理。

一、步骤

1、从2048shell上复制curl命令。

2、编写循环。

4、可以用php进行处理。

二、代码

1、生成curl请求中需要的头信息curl通过请求第4步的headers中信息,来判断请求到底用的是哪种方式,是post还是get。再在curl/headers中进行设置,

2、判断authorization是否设置为已过期curl通过请求的第4步的headers中transparent来判断请求是否过期。

然后在curl/headers中进行设置,即:curl/headers中,get必须设置过期期限get可以通过headers中的headers="user-agent",

4)applewebkit/537.36(khtml,likegecko)chrome/45.0.3247.27safari/537.36",其他的均可以设置。如果不设置的话,curl会默认使用authorization_security=none,也就是不验证authorization,这个是很危险的,一定要设置为none。

3、判断authorization是否设置成功curl通过请求中的第4步中headers中的valid_authentication来判断authorization是否设置成功。如果设置成功,则会获取请求头中的content-length,然后判断请求是否合法。

4、设置断点curl/thinkphp-bootstrap-1.1.3.zip这个包含链接和数据,使用时可以抓取的数据,网址和url,这个代码应该很好写,写这些代码方便将信息保存。

5、curl/http/1.1200ok

6、curl/http/1.1getanjavascriptversiondgetanjavascripttargeturl完整代码公众号:不言者'后台回复"php"可以获取代码。 查看全部

php抓取网页(php抓取网页,我用php进行抓取和处理(一))

php抓取网页,利用curl命令处理数据,然后可以循环从请求获取,也可以用php缓存来处理。以下我用php进行抓取和处理。

一、步骤

1、从2048shell上复制curl命令。

2、编写循环。

4、可以用php进行处理。

二、代码

1、生成curl请求中需要的头信息curl通过请求第4步的headers中信息,来判断请求到底用的是哪种方式,是post还是get。再在curl/headers中进行设置,

2、判断authorization是否设置为已过期curl通过请求的第4步的headers中transparent来判断请求是否过期。

然后在curl/headers中进行设置,即:curl/headers中,get必须设置过期期限get可以通过headers中的headers="user-agent",

4)applewebkit/537.36(khtml,likegecko)chrome/45.0.3247.27safari/537.36",其他的均可以设置。如果不设置的话,curl会默认使用authorization_security=none,也就是不验证authorization,这个是很危险的,一定要设置为none。

3、判断authorization是否设置成功curl通过请求中的第4步中headers中的valid_authentication来判断authorization是否设置成功。如果设置成功,则会获取请求头中的content-length,然后判断请求是否合法。

4、设置断点curl/thinkphp-bootstrap-1.1.3.zip这个包含链接和数据,使用时可以抓取的数据,网址和url,这个代码应该很好写,写这些代码方便将信息保存。

5、curl/http/1.1200ok

6、curl/http/1.1getanjavascriptversiondgetanjavascripttargeturl完整代码公众号:不言者'后台回复"php"可以获取代码。

php抓取网页(之前有一个工具自动抓取数据的工具主要做什么? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2021-11-25 06:06

)

之前的任务之一是在服务器上复制一串文本。这是一个简单的操作,但需要重复大约 50 次。每次大概用了三分钟,重复了两个多小时就过去了。所以我做了这个工具来自动抓取数据。

该工具主要做三件事:登录、下载和拦截。

登录部分是因为服务器使用windows安全验证,如图:

获取网页数据需要模拟登录。

首先使用fiddler抓取http传输的数据包,在header部分找到一串字符串:

base64解密后得到:Administrator:manage。

这是用户名:一串加密的密码。Authorization:Basic是一种认证方式,一般由setRequestProperty设置。

登录后可以直接获取网页内容,然后截取数据。最后在最外层加一个循环,执行一次需要爬取的服务器地址,然后就可以一次性获取到所有服务器上的数据了。

最后贴出代码:

<p>import java.io.*;

import java.net.*;

public class getPackageFromWeb {

public static void main(String args[]) throws Exception {

String[] servers ={"192.168.0.144:23342","192.168.0.144:23343"};

StringBuilder result=new StringBuilder();

for(int i=0;i 查看全部

php抓取网页(之前有一个工具自动抓取数据的工具主要做什么?

)

之前的任务之一是在服务器上复制一串文本。这是一个简单的操作,但需要重复大约 50 次。每次大概用了三分钟,重复了两个多小时就过去了。所以我做了这个工具来自动抓取数据。

该工具主要做三件事:登录、下载和拦截。

登录部分是因为服务器使用windows安全验证,如图:

获取网页数据需要模拟登录。

首先使用fiddler抓取http传输的数据包,在header部分找到一串字符串:

base64解密后得到:Administrator:manage。

这是用户名:一串加密的密码。Authorization:Basic是一种认证方式,一般由setRequestProperty设置。

登录后可以直接获取网页内容,然后截取数据。最后在最外层加一个循环,执行一次需要爬取的服务器地址,然后就可以一次性获取到所有服务器上的数据了。

最后贴出代码:

<p>import java.io.*;

import java.net.*;

public class getPackageFromWeb {

public static void main(String args[]) throws Exception {

String[] servers ={"192.168.0.144:23342","192.168.0.144:23343"};

StringBuilder result=new StringBuilder();

for(int i=0;i

php抓取网页(php抓取网页又一个利器,最新版本1.x版本)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-11-23 15:01

php抓取网页又一个利器,最新版本1.x版本:采集页面整页的元素图片,列表(index.php,index.js),每个元素数据都会复制下来,通过md5加密算法加密传递给服务器,传输加密过程都是https的。

tk-f11f的把php框架整合起来利用了django的框架,请求index.php,在python中调用,

无论是python还是php都需要把元素传输,然后在http转换为https的页面,具体https转换可以参考pythonhttps,

在你想知道元素的时候,可以写字典,然后用循环从字典里面取元素,

python要把网页上图片的元素提取出来是非常麻烦的。如果用php,建议用代理抓。就是利用代理进行抓取。代理抓取也可以从php代码中,去解析数据,然后再传递给网页转化。phpstorm比较好用。

让php来抓

通过网页里js将图片元素提取出来。另外,php可以用illuminate源码的方式,将整个源码转换成python可读代码。

php与django的结合,可以通过把图片存在https协议下存到tk目录下,

tkinter+django

接到图片链接后使用get/post的方式提交给django后端,获取元素再比较php传入的数据。 查看全部

php抓取网页(php抓取网页又一个利器,最新版本1.x版本)

php抓取网页又一个利器,最新版本1.x版本:采集页面整页的元素图片,列表(index.php,index.js),每个元素数据都会复制下来,通过md5加密算法加密传递给服务器,传输加密过程都是https的。

tk-f11f的把php框架整合起来利用了django的框架,请求index.php,在python中调用,

无论是python还是php都需要把元素传输,然后在http转换为https的页面,具体https转换可以参考pythonhttps,

在你想知道元素的时候,可以写字典,然后用循环从字典里面取元素,

python要把网页上图片的元素提取出来是非常麻烦的。如果用php,建议用代理抓。就是利用代理进行抓取。代理抓取也可以从php代码中,去解析数据,然后再传递给网页转化。phpstorm比较好用。

让php来抓

通过网页里js将图片元素提取出来。另外,php可以用illuminate源码的方式,将整个源码转换成python可读代码。

php与django的结合,可以通过把图片存在https协议下存到tk目录下,

tkinter+django

接到图片链接后使用get/post的方式提交给django后端,获取元素再比较php传入的数据。

php抓取网页(php抓取网页内容--例子都是用php写的)

网站优化 • 优采云 发表了文章 • 0 个评论 • 44 次浏览 • 2021-11-13 14:02

php抓取网页内容--例子都是用php写的,有个思维导图可以对编程思路整理一下。php1.7到1.8基本上多数语句都可以用原生的直接实现。1.0到1.8才是php的巅峰时期,什么for循环else都是还留有很多余地的,empty也可以用php自己语句表达。具体到php代码就是:1.可以用sitemesh+mqtt配合抓取的。

2.抓取只能用schema最多支持5*5规则来抓取内容,一般抓取30w条/周用5*5的条件就很多了。3.schema只支持fcinfoinfo共抓取分析。4.php直接返回动态内容,比如注册,成功,被删除,添加,清空等。数据库直接redis,mysql等都可以实现。(哈哈,我昨天才看到一个网站提供数据库连接池用java+golang抓取数据,spring+php+mysql)5.例子的所有代码都是用php写的。6.抓取原理=php==。 查看全部

php抓取网页(php抓取网页内容--例子都是用php写的)

php抓取网页内容--例子都是用php写的,有个思维导图可以对编程思路整理一下。php1.7到1.8基本上多数语句都可以用原生的直接实现。1.0到1.8才是php的巅峰时期,什么for循环else都是还留有很多余地的,empty也可以用php自己语句表达。具体到php代码就是:1.可以用sitemesh+mqtt配合抓取的。

2.抓取只能用schema最多支持5*5规则来抓取内容,一般抓取30w条/周用5*5的条件就很多了。3.schema只支持fcinfoinfo共抓取分析。4.php直接返回动态内容,比如注册,成功,被删除,添加,清空等。数据库直接redis,mysql等都可以实现。(哈哈,我昨天才看到一个网站提供数据库连接池用java+golang抓取数据,spring+php+mysql)5.例子的所有代码都是用php写的。6.抓取原理=php==。

php抓取网页(php获取网站推荐活动:更多优惠gt;加入收藏(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-10-25 15:02

阿里云>云栖社区>主题图>P>php Get网站head

推荐活动:

更多优惠>

当前话题:php Get 网站head 加入采集

相关话题:

php 获取网站头部相关博客 查看更多博客

网站快照被篡改劫持怎么办?

作者:网站安全2894人浏览评论:02年前

近日,多家公司的网站快照被劫持,跳转至bocai和彩票网站。从百度点击进来的客户会被重定向,在网站中直接输入的域名不会被重定向。网站快照也被劫持到bocai内容,百度的收录中的站点视图网站也有问题,收录很多彩票内容,一些客户的网站@ > 也被百度网站安全中心拦截,提示网

阅读全文

Winform下动态执行JavaScript脚本获取运行结果,说说网站的自动登录和数据获取操作

作者:walb呀998人浏览评论:03年前

为了有效防止恶意用户的攻击,一般登录都会使用验证码的方式来处理登录,类似于QQ很多产品的验证码处理,但是在一些OA系统中,系统使用非对称加密来处理登录密码信息, login 用于加密密码的公钥每次页面提供都不一样,所以如果要模拟登录,需要先获取公钥,然后

阅读全文

curl 用法:获取网站的header和状态码

作者:喜欢教授1758人浏览评论:03年前

; 使用 curl -I 来获取它。如果在提取第一行信息时出现一些不需要的信息,我们应该如何获取?1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 [baby@localhost ~]$ curl -I mofansheng.bl

阅读全文

php_mysql注入load_file() IIS配置文件获取

作者:科技小胖子1165人浏览评论:03年前

先看一个注入点:+union+select+1,2,3,4,5,6,concat(database(),0x5c,user(),0x5c,version()

阅读全文

PHP Ajax JavaScript Json 实现天气信息获取

作者:郭璞 818人浏览评论:05年前

使用第三方服务间接方式使用服务实现代码。前端完整代码总结 给自己的网站添加天气预报功能是很常见的需求,实现起来也不难。今天,我将介绍一些简单的方法。有这么简单的使用第三方服务的方法,借助

阅读全文

PHP构建网站登录页面(iOS开发者的PHP之路)

作者:xinxinitblog713 人浏览评论:05年前

前言 近年来,各个技术论坛都流传着一句话:未来是全栈程序员的世界!程序员是社会的职业,越来越多的人加入这个行业。随着这个行业分工明确,越来越多的程序员开始焦躁地追求一门编程语言,并开始在我研究其他领域工作,渴望在不久的将来在整个软件行业有一份好工作

阅读全文

java获取客户端请求IP地址获取公网ip

作者:查看人数及评论:06年前

这些天我一直在使用java来获取ip地址。由于测试方法错误,一直未成功。昨天终于发现不是方法不对,而是我的测试方法不对。下面的方法可以完整的获取到客户端的公网ip。地址,但是测试的时候注意:我用weblogic来测试,在我本机打开服务,然后访问,因为一样

阅读全文

java获取客户端请求IP地址获取公网ip

作者:李大嘴吧1687人浏览评论:06年前

这些天我一直在使用java来获取ip地址。由于测试方法错误,一直未成功。昨天终于发现不是方法不对,而是我的测试方法不对。下面的方法可以完整的获取到客户端的公网ip。地址,但是测试的时候注意:我用weblogic来测试,在我本机打开服务,然后访问,因为一样

阅读全文

php获取网站head相关问答及提问

php的curl如何使用head协议获取资源大小等信息?

作者:落花开啦 827人浏览评论:15年前

我的程序允许用户填写URL来抓取其他网站的资源,但是在抓取之前需要知道资源的大小,否则资源太大又费时,会占用不必要的带宽. 发现http中有HEAD协议,即只获取一个资源的http头信息,那么curl中怎么只能获取http头而不下载所有body呢?

阅读全文 查看全部

php抓取网页(php获取网站推荐活动:更多优惠gt;加入收藏(组图))

阿里云>云栖社区>主题图>P>php Get网站head

推荐活动:

更多优惠>

当前话题:php Get 网站head 加入采集

相关话题:

php 获取网站头部相关博客 查看更多博客

网站快照被篡改劫持怎么办?

作者:网站安全2894人浏览评论:02年前

近日,多家公司的网站快照被劫持,跳转至bocai和彩票网站。从百度点击进来的客户会被重定向,在网站中直接输入的域名不会被重定向。网站快照也被劫持到bocai内容,百度的收录中的站点视图网站也有问题,收录很多彩票内容,一些客户的网站@ > 也被百度网站安全中心拦截,提示网

阅读全文

Winform下动态执行JavaScript脚本获取运行结果,说说网站的自动登录和数据获取操作

作者:walb呀998人浏览评论:03年前

为了有效防止恶意用户的攻击,一般登录都会使用验证码的方式来处理登录,类似于QQ很多产品的验证码处理,但是在一些OA系统中,系统使用非对称加密来处理登录密码信息, login 用于加密密码的公钥每次页面提供都不一样,所以如果要模拟登录,需要先获取公钥,然后

阅读全文

curl 用法:获取网站的header和状态码

作者:喜欢教授1758人浏览评论:03年前

; 使用 curl -I 来获取它。如果在提取第一行信息时出现一些不需要的信息,我们应该如何获取?1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 [baby@localhost ~]$ curl -I mofansheng.bl

阅读全文

php_mysql注入load_file() IIS配置文件获取

作者:科技小胖子1165人浏览评论:03年前

先看一个注入点:+union+select+1,2,3,4,5,6,concat(database(),0x5c,user(),0x5c,version()

阅读全文

PHP Ajax JavaScript Json 实现天气信息获取

作者:郭璞 818人浏览评论:05年前

使用第三方服务间接方式使用服务实现代码。前端完整代码总结 给自己的网站添加天气预报功能是很常见的需求,实现起来也不难。今天,我将介绍一些简单的方法。有这么简单的使用第三方服务的方法,借助

阅读全文

PHP构建网站登录页面(iOS开发者的PHP之路)

作者:xinxinitblog713 人浏览评论:05年前

前言 近年来,各个技术论坛都流传着一句话:未来是全栈程序员的世界!程序员是社会的职业,越来越多的人加入这个行业。随着这个行业分工明确,越来越多的程序员开始焦躁地追求一门编程语言,并开始在我研究其他领域工作,渴望在不久的将来在整个软件行业有一份好工作

阅读全文

java获取客户端请求IP地址获取公网ip

作者:查看人数及评论:06年前

这些天我一直在使用java来获取ip地址。由于测试方法错误,一直未成功。昨天终于发现不是方法不对,而是我的测试方法不对。下面的方法可以完整的获取到客户端的公网ip。地址,但是测试的时候注意:我用weblogic来测试,在我本机打开服务,然后访问,因为一样

阅读全文

java获取客户端请求IP地址获取公网ip

作者:李大嘴吧1687人浏览评论:06年前

这些天我一直在使用java来获取ip地址。由于测试方法错误,一直未成功。昨天终于发现不是方法不对,而是我的测试方法不对。下面的方法可以完整的获取到客户端的公网ip。地址,但是测试的时候注意:我用weblogic来测试,在我本机打开服务,然后访问,因为一样

阅读全文

php获取网站head相关问答及提问

php的curl如何使用head协议获取资源大小等信息?

作者:落花开啦 827人浏览评论:15年前

我的程序允许用户填写URL来抓取其他网站的资源,但是在抓取之前需要知道资源的大小,否则资源太大又费时,会占用不必要的带宽. 发现http中有HEAD协议,即只获取一个资源的http头信息,那么curl中怎么只能获取http头而不下载所有body呢?

阅读全文

php抓取网页(php做有偿视频数据采集和集成也是可以的吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-10-24 15:00

php抓取网页:直接写exif文件:如:=root/public_data/article/user/rain/123456.jpgbase64加密:用aes可选:默认加密256-1范围内,

使用formdata就可以php3是无法直接读取图片地址的,

java版java请php程序员做,

java不是不支持吗?-12-12/

使用androidstudio,phpstorm,

php抓取网页不就是采集器嘛

哈哈哈,好有兴趣,我也想知道,有个开源的采集器trac-php,

php的话,apache,nginx,phpmonitor都是可以的,

apache

多少人不用sed的?

可以是可以,不过,php文件是不能直接输出视频文件的。php做有偿视频数据采集和集成也是可以的。这个是这个问题的延伸。

现在有csrf(跨站请求伪造)。比如用php自己封装一个get请求,输出之后另外发给别人。

apache+cookie大多数网站都支持,

也可以用java封装后上传

java,apache,ftp等

java可以封装get接口,然后用urllib2封装post。你可以这样理解:这里是过滤器。拦截你网页发出的get请求,然后返回一堆数据。然后就封你post的数据了。 查看全部

php抓取网页(php做有偿视频数据采集和集成也是可以的吗?)

php抓取网页:直接写exif文件:如:=root/public_data/article/user/rain/123456.jpgbase64加密:用aes可选:默认加密256-1范围内,

使用formdata就可以php3是无法直接读取图片地址的,

java版java请php程序员做,

java不是不支持吗?-12-12/

使用androidstudio,phpstorm,

php抓取网页不就是采集器嘛

哈哈哈,好有兴趣,我也想知道,有个开源的采集器trac-php,

php的话,apache,nginx,phpmonitor都是可以的,

apache

多少人不用sed的?

可以是可以,不过,php文件是不能直接输出视频文件的。php做有偿视频数据采集和集成也是可以的。这个是这个问题的延伸。

现在有csrf(跨站请求伪造)。比如用php自己封装一个get请求,输出之后另外发给别人。

apache+cookie大多数网站都支持,

也可以用java封装后上传

java,apache,ftp等

java可以封装get接口,然后用urllib2封装post。你可以这样理解:这里是过滤器。拦截你网页发出的get请求,然后返回一堆数据。然后就封你post的数据了。

php抓取网页(用file_get_contents()函数抓取网页会发生乱码现象)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-10-18 10:10

使用file_get_contents()函数获取网页会导致乱码。出现乱码的原因有两个,一是编码问题,二是目标页面启用了Gzip。下面是如何防止Gzip功能开启时出现乱码

将捕获的内容转为编码($content=iconv("GBK", "UTF-8//IGNORE", $content);),我们这里讨论的是如何捕获和打开Gzip Page。如何判断? Content-Encoding: 获取到的header中的gzip表示内容采用GZIP压缩。用 FireBug 查看它以了解页面上是否启用了 gzip。下面是用firebug查看我博客的header信息,打开Gzip。

请求头信息原创头信息

Accept text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8

Accept-Encoding gzip, deflate

Accept-Language zh-cn,zh;q=0.8,en-us;q=0.5,en;q=0.3

Connection keep-alive

Cookie __utma=225240837.787252530.1317310581.1335406161.1335411401.1537; __utmz=225240837.1326850415.887.3.utmcsr=google|utmccn=(organic)|utmcmd=organic|utmctr=%E4%BB%BB%E4%BD%95%E9%A1%B9%E7%9B%AE%E9%83%BD%E4%B8%8D%E4%BC%9A%E9%82%A3%E4%B9%88%E7%AE%80%E5%8D%95%20site%3Awww.nowamagic.net; PHPSESSID=888mj4425p8s0m7s0frre3ovc7; __utmc=225240837; __utmb=225240837.1.10.1335411401

Host www.nowamagic.net

User-Agent Mozilla/5.0 (Windows NT 5.1; rv:12.0) Gecko/20100101 Firefox/12.0

以下是一些解决方案:

1. 使用内置的 zlib 库

如果服务器已经安装了zlib库,下面的代码可以轻松解决乱码问题。

$data = file_get_contents("compress.zlib://".$url);

2. 使用 CURL 代替 file_get_contents

function curl_get($url, $gzip=false){

$curl = curl_init($url);

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($curl, CURLOPT_CONNECTTIMEOUT, 10);

if($gzip) curl_setopt($curl, CURLOPT_ENCODING, "gzip"); // 关键在这里

$content = curl_exec($curl);

curl_close($curl);

return $content;

}

3.使用gzip解压功能

function gzdecode($data) {

$len = strlen($data);

if ($len < 18 || strcmp(substr($data,0,2),"\x1f\x8b")) {

return null; // Not GZIP format (See RFC 1952)

}

$method = ord(substr($data,2,1)); // Compression method

$flags = ord(substr($data,3,1)); // Flags

if ($flags & 31 != $flags) {

// Reserved bits are set -- NOT ALLOWED by RFC 1952

return null;

}

// NOTE: $mtime may be negative (PHP integer limitations)

$mtime = unpack("V", substr($data,4,4));

$mtime = $mtime[1];

$xfl = substr($data,8,1);

$os = substr($data,8,1);

$headerlen = 10;

$extralen = 0;

$extra = "";

if ($flags & 4) {

// 2-byte length prefixed EXTRA data in header

if ($len - $headerlen - 2 < 8) {

return false; // Invalid format

}

$extralen = unpack("v",substr($data,8,2));

$extralen = $extralen[1];

if ($len - $headerlen - 2 - $extralen < 8) {

return false; // Invalid format

}

$extra = substr($data,10,$extralen);

$headerlen += 2 + $extralen;

}

$filenamelen = 0;

$filename = "";

if ($flags & 8) {

// C-style string file NAME data in header

if ($len - $headerlen - 1 < 8) {

return false; // Invalid format

}

$filenamelen = strpos(substr($data,8+$extralen),chr(0));

if ($filenamelen === false || $len - $headerlen - $filenamelen - 1 < 8) {

return false; // Invalid format

}

$filename = substr($data,$headerlen,$filenamelen);

$headerlen += $filenamelen + 1;

}

$commentlen = 0;

$comment = "";

if ($flags & 16) {

// C-style string COMMENT data in header

if ($len - $headerlen - 1 < 8) {

return false; // Invalid format

}

$commentlen = strpos(substr($data,8+$extralen+$filenamelen),chr(0));

if ($commentlen === false || $len - $headerlen - $commentlen - 1 < 8) {

return false; // Invalid header format

}

$comment = substr($data,$headerlen,$commentlen);

$headerlen += $commentlen + 1;

}

$headercrc = "";

if ($flags & 1) {

// 2-bytes (lowest order) of CRC32 on header present

if ($len - $headerlen - 2 < 8) {

return false; // Invalid format

}

$calccrc = crc32(substr($data,0,$headerlen)) & 0xffff;

$headercrc = unpack("v", substr($data,$headerlen,2));

$headercrc = $headercrc[1];

if ($headercrc != $calccrc) {

return false; // Bad header CRC

}

$headerlen += 2;

}

// GZIP FOOTER - These be negative due to PHP's limitations

$datacrc = unpack("V",substr($data,-8,4));

$datacrc = $datacrc[1];

$isize = unpack("V",substr($data,-4));

$isize = $isize[1];

// Perform the decompression:

$bodylen = $len-$headerlen-8;

if ($bodylen < 1) {

// This should never happen - IMPLEMENTATION BUG!

return null;

}

$body = substr($data,$headerlen,$bodylen);

$data = "";

if ($bodylen > 0) {

switch ($method) {

case 8:

// Currently the only supported compression method:

$data = gzinflate($body);

break;

default:

// Unknown compression method

return false;

}

} else {

// I'm not sure if zero-byte body content is allowed.

// Allow it for now... Do nothing...

}

// Verifiy decompressed size and CRC32:

// NOTE: This may fail with large data sizes depending on how

// PHP's integer limitations affect strlen() since $isize

// may be negative for large sizes.

if ($isize != strlen($data) || crc32($data) != $datacrc) {

// Bad format! Length or CRC doesn't match!

return false;

}

return $data;

}

使用:

$html=file_get_contents('http://www.gxlcms.com/');

$html=gzdecode($html);

介绍这三个方法,应该可以解决大部分gzip导致的爬行乱码问题。 查看全部

php抓取网页(用file_get_contents()函数抓取网页会发生乱码现象)

使用file_get_contents()函数获取网页会导致乱码。出现乱码的原因有两个,一是编码问题,二是目标页面启用了Gzip。下面是如何防止Gzip功能开启时出现乱码

将捕获的内容转为编码($content=iconv("GBK", "UTF-8//IGNORE", $content);),我们这里讨论的是如何捕获和打开Gzip Page。如何判断? Content-Encoding: 获取到的header中的gzip表示内容采用GZIP压缩。用 FireBug 查看它以了解页面上是否启用了 gzip。下面是用firebug查看我博客的header信息,打开Gzip。

请求头信息原创头信息

Accept text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8

Accept-Encoding gzip, deflate

Accept-Language zh-cn,zh;q=0.8,en-us;q=0.5,en;q=0.3

Connection keep-alive

Cookie __utma=225240837.787252530.1317310581.1335406161.1335411401.1537; __utmz=225240837.1326850415.887.3.utmcsr=google|utmccn=(organic)|utmcmd=organic|utmctr=%E4%BB%BB%E4%BD%95%E9%A1%B9%E7%9B%AE%E9%83%BD%E4%B8%8D%E4%BC%9A%E9%82%A3%E4%B9%88%E7%AE%80%E5%8D%95%20site%3Awww.nowamagic.net; PHPSESSID=888mj4425p8s0m7s0frre3ovc7; __utmc=225240837; __utmb=225240837.1.10.1335411401

Host www.nowamagic.net

User-Agent Mozilla/5.0 (Windows NT 5.1; rv:12.0) Gecko/20100101 Firefox/12.0

以下是一些解决方案:

1. 使用内置的 zlib 库

如果服务器已经安装了zlib库,下面的代码可以轻松解决乱码问题。

$data = file_get_contents("compress.zlib://".$url);

2. 使用 CURL 代替 file_get_contents

function curl_get($url, $gzip=false){

$curl = curl_init($url);

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($curl, CURLOPT_CONNECTTIMEOUT, 10);

if($gzip) curl_setopt($curl, CURLOPT_ENCODING, "gzip"); // 关键在这里

$content = curl_exec($curl);

curl_close($curl);

return $content;

}

3.使用gzip解压功能

function gzdecode($data) {

$len = strlen($data);

if ($len < 18 || strcmp(substr($data,0,2),"\x1f\x8b")) {

return null; // Not GZIP format (See RFC 1952)

}

$method = ord(substr($data,2,1)); // Compression method

$flags = ord(substr($data,3,1)); // Flags

if ($flags & 31 != $flags) {

// Reserved bits are set -- NOT ALLOWED by RFC 1952

return null;

}

// NOTE: $mtime may be negative (PHP integer limitations)

$mtime = unpack("V", substr($data,4,4));

$mtime = $mtime[1];

$xfl = substr($data,8,1);

$os = substr($data,8,1);

$headerlen = 10;

$extralen = 0;

$extra = "";

if ($flags & 4) {

// 2-byte length prefixed EXTRA data in header

if ($len - $headerlen - 2 < 8) {

return false; // Invalid format

}

$extralen = unpack("v",substr($data,8,2));

$extralen = $extralen[1];

if ($len - $headerlen - 2 - $extralen < 8) {

return false; // Invalid format

}

$extra = substr($data,10,$extralen);

$headerlen += 2 + $extralen;

}

$filenamelen = 0;

$filename = "";

if ($flags & 8) {

// C-style string file NAME data in header

if ($len - $headerlen - 1 < 8) {

return false; // Invalid format

}

$filenamelen = strpos(substr($data,8+$extralen),chr(0));

if ($filenamelen === false || $len - $headerlen - $filenamelen - 1 < 8) {

return false; // Invalid format

}

$filename = substr($data,$headerlen,$filenamelen);