采集采集器

采集采集器(演示一下如何使用优采云采集器采集分页列表页面上的信, )

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2022-02-21 00:12

)

今天小编就给大家介绍一下优采云采集器采集分页列表页的字母的使用方法,目的是让大家知道如何创建循环翻页和正常采集 网页数据信息。

首先打开优采云采集器→点击快速启动→新建任务进入任务配置页面:

选择任务组,自定义任务名称和备注;

上图配置完成后,选择Next,进入流程配置页面,拖拽一个步骤打开网页进入流程设计器;

选择在浏览器中打开网页的步骤,在右侧页面网址中输入网页网址并点击保存,系统会自动在软件下方的浏览器中打开对应的网页:

下面创建一个循环翻页。在上面的浏览器页面中点击Next Page按钮,在弹出的对话框中选择Cycle Click Next;

翻页循环创建完成后,点击下图中的保存;

在上面的浏览器中,你可以看到网页都是由相同的区域块组成的。我们需要捕获每个区域块中的数据信息,并且每个区域块中的格式是相同的。这时,我们需要创建一个循环列表,循环遍历每个区域块中的元素。

点击上图中的第一个区域块,在弹出的对话框中选择创建元素列表处理一组元素;

接下来,在弹出的对话框中,选择添加到列表

添加第一个区域块后,选择继续编辑列表。

接下来以相同的方式添加第二个区域块。

当我们添加第二个区域块时,我们可以看上图,此时页面中的其他元素都添加了。这是因为我们在添加两个具有相似特征的元素,系统会在页面中智能添加其他具有相似特征的元素。然后选择创建列表完成→点击下图中的循环

经过以上操作,循环采集列表就完成了。系统会在页面右上角显示该页面添加的所有循环项。

由于每个页面都需要循环采集数据,所以我们需要将这个循环列表拖入翻页循环中。

注意流程是从上层网页执行的,所以这个循环列表需要放在点击页面的前面,否则会漏掉第一页的数据。最终流程图如下图所示:

接下来,提取数据字段,点击上面流程设计器中的Extract Data,在浏览器中选择要提取的字段,然后在弹出的选择对话框中选择要捕获该元素的文本;

完成上述操作后,系统会在页面右上角显示我们要抓取的字段;

接下来配置页面上需要抓取的其他字段,配置完成后修改字段名称;

修改完成后,点击上图中的保存按钮,然后点击图中的数据字段,可以看到系统会显示最终的采集列表;

点击上图中的Next→Next→Start Standalone采集(调试模式),进入任务检查页面,保证任务的正确性;

点击Start Standalone采集,系统会在本地执行采集进程并显示最终的采集结果;

查看全部

采集采集器(演示一下如何使用优采云采集器采集分页列表页面上的信,

)

今天小编就给大家介绍一下优采云采集器采集分页列表页的字母的使用方法,目的是让大家知道如何创建循环翻页和正常采集 网页数据信息。

首先打开优采云采集器→点击快速启动→新建任务进入任务配置页面:

选择任务组,自定义任务名称和备注;

上图配置完成后,选择Next,进入流程配置页面,拖拽一个步骤打开网页进入流程设计器;

选择在浏览器中打开网页的步骤,在右侧页面网址中输入网页网址并点击保存,系统会自动在软件下方的浏览器中打开对应的网页:

下面创建一个循环翻页。在上面的浏览器页面中点击Next Page按钮,在弹出的对话框中选择Cycle Click Next;

翻页循环创建完成后,点击下图中的保存;

在上面的浏览器中,你可以看到网页都是由相同的区域块组成的。我们需要捕获每个区域块中的数据信息,并且每个区域块中的格式是相同的。这时,我们需要创建一个循环列表,循环遍历每个区域块中的元素。

点击上图中的第一个区域块,在弹出的对话框中选择创建元素列表处理一组元素;

接下来,在弹出的对话框中,选择添加到列表

添加第一个区域块后,选择继续编辑列表。

接下来以相同的方式添加第二个区域块。

当我们添加第二个区域块时,我们可以看上图,此时页面中的其他元素都添加了。这是因为我们在添加两个具有相似特征的元素,系统会在页面中智能添加其他具有相似特征的元素。然后选择创建列表完成→点击下图中的循环

经过以上操作,循环采集列表就完成了。系统会在页面右上角显示该页面添加的所有循环项。

由于每个页面都需要循环采集数据,所以我们需要将这个循环列表拖入翻页循环中。

注意流程是从上层网页执行的,所以这个循环列表需要放在点击页面的前面,否则会漏掉第一页的数据。最终流程图如下图所示:

接下来,提取数据字段,点击上面流程设计器中的Extract Data,在浏览器中选择要提取的字段,然后在弹出的选择对话框中选择要捕获该元素的文本;

完成上述操作后,系统会在页面右上角显示我们要抓取的字段;

接下来配置页面上需要抓取的其他字段,配置完成后修改字段名称;

修改完成后,点击上图中的保存按钮,然后点击图中的数据字段,可以看到系统会显示最终的采集列表;

点击上图中的Next→Next→Start Standalone采集(调试模式),进入任务检查页面,保证任务的正确性;

点击Start Standalone采集,系统会在本地执行采集进程并显示最终的采集结果;

采集采集器(java采集器我写过两篇笔记,你只需要对java、ruby等编程语言有一定认识)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2022-02-19 16:02

采集采集器对于新手很重要哦。你不需要知道从网站爬虫到程序猿一步步到采集器怎么用。你只需要对java、ruby等编程语言有一定的认识。java采集器我写过两篇笔记,有兴趣的朋友可以参考一下:采集器java系列1.02.java网站抓取爬虫java系列2.02.使用采集器或者浏览器抓包java系列2.02.使用采集器或者浏览器抓包|。

也对于未接触过编程知识的童鞋,我推荐一本书——《全民学编程》,结合我当年实战的过程,感觉很不错。这是一本新手必备的书,第一遍看看目录内容,自己觉得哪些地方感觉必须弄懂,做好标记,接下来要对着视频一个一个的敲,按照讲师的要求一个一个的搭环境,自己搭环境比较枯燥,推荐两个配套的在线环境,python3.6和python2.7,实际上2.7的编译效率比python3快一倍,推荐自己搭的环境,就算你以后要从事其他编程语言的开发也可以继续使用python3.6。

除了题主提到的三大抓包手段:requestsseleniumfiddler,还有可以具体代码一块去挖掘,比如redis注册账号之类,api注册等。

python自身自带twisted框架,可以在javaweb服务端任意请求一个静态网页。在python中可以使用。

一般以python为工具,java以爬虫形式。前者基于python的很多模块,后者还在发展完善。 查看全部

采集采集器(java采集器我写过两篇笔记,你只需要对java、ruby等编程语言有一定认识)

采集采集器对于新手很重要哦。你不需要知道从网站爬虫到程序猿一步步到采集器怎么用。你只需要对java、ruby等编程语言有一定的认识。java采集器我写过两篇笔记,有兴趣的朋友可以参考一下:采集器java系列1.02.java网站抓取爬虫java系列2.02.使用采集器或者浏览器抓包java系列2.02.使用采集器或者浏览器抓包|。

也对于未接触过编程知识的童鞋,我推荐一本书——《全民学编程》,结合我当年实战的过程,感觉很不错。这是一本新手必备的书,第一遍看看目录内容,自己觉得哪些地方感觉必须弄懂,做好标记,接下来要对着视频一个一个的敲,按照讲师的要求一个一个的搭环境,自己搭环境比较枯燥,推荐两个配套的在线环境,python3.6和python2.7,实际上2.7的编译效率比python3快一倍,推荐自己搭的环境,就算你以后要从事其他编程语言的开发也可以继续使用python3.6。

除了题主提到的三大抓包手段:requestsseleniumfiddler,还有可以具体代码一块去挖掘,比如redis注册账号之类,api注册等。

python自身自带twisted框架,可以在javaweb服务端任意请求一个静态网页。在python中可以使用。

一般以python为工具,java以爬虫形式。前者基于python的很多模块,后者还在发展完善。

采集采集器(电脑采集器和手机采集样式有什么区别呢??)

采集交流 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2022-02-19 08:01

采集采集器在我们的生活中还是比较常见的,我们不管是在上班工作还是办公室都要有一个采集器的东西,大部分人选择的都是手机的采集器,非常方便,除此之外也有商家选择了电脑采集器,这个可谓是人尽皆知了,那么电脑采集器和手机采集器有什么区别呢?其实这两者的区别还是挺大的,首先电脑采集器是现在工作中必备的一个工具,不管是什么工作,我们总要做好一些准备,这是我们知道的,而手机采集器就不一样了,随着手机功能的全面改变,现在的手机也不仅仅限于娱乐功能了,一些专业的应用也逐渐的在电脑上出现,所以手机采集器的功能更多了。

电脑采集器采集样式这里主要说一下手机采集器的电脑采集,常用的有的手机采集器可以采集视频以及图片,现在常用的还有微信的视频录制,采集文章的文字,还有一些免费的也可以采集图片,除此之外还有微信登录、微信二维码等等这些功能还是挺实用的,而这些手机电脑采集器具有的功能电脑都可以轻松实现,所以小白相对要更容易上手一些。

而电脑采集器需要购买采集端口才可以无缝对接,而手机基本上没有采集端口的设置,可能需要特殊的软件。电脑采集器和手机采集器最大的区别就是制作视频,在获取视频数据有一些通用的数据分析工具,可以在网上查询一些算法,进行一些算法分析,得到一些关于视频信息,手机采集器我想说明的是,由于手机有延迟,得到的信息不一定准确,但电脑采集器因为具有操作的便捷性,所以具有高效率的特点,希望对大家有帮助!。 查看全部

采集采集器(电脑采集器和手机采集样式有什么区别呢??)

采集采集器在我们的生活中还是比较常见的,我们不管是在上班工作还是办公室都要有一个采集器的东西,大部分人选择的都是手机的采集器,非常方便,除此之外也有商家选择了电脑采集器,这个可谓是人尽皆知了,那么电脑采集器和手机采集器有什么区别呢?其实这两者的区别还是挺大的,首先电脑采集器是现在工作中必备的一个工具,不管是什么工作,我们总要做好一些准备,这是我们知道的,而手机采集器就不一样了,随着手机功能的全面改变,现在的手机也不仅仅限于娱乐功能了,一些专业的应用也逐渐的在电脑上出现,所以手机采集器的功能更多了。

电脑采集器采集样式这里主要说一下手机采集器的电脑采集,常用的有的手机采集器可以采集视频以及图片,现在常用的还有微信的视频录制,采集文章的文字,还有一些免费的也可以采集图片,除此之外还有微信登录、微信二维码等等这些功能还是挺实用的,而这些手机电脑采集器具有的功能电脑都可以轻松实现,所以小白相对要更容易上手一些。

而电脑采集器需要购买采集端口才可以无缝对接,而手机基本上没有采集端口的设置,可能需要特殊的软件。电脑采集器和手机采集器最大的区别就是制作视频,在获取视频数据有一些通用的数据分析工具,可以在网上查询一些算法,进行一些算法分析,得到一些关于视频信息,手机采集器我想说明的是,由于手机有延迟,得到的信息不一定准确,但电脑采集器因为具有操作的便捷性,所以具有高效率的特点,希望对大家有帮助!。

采集采集器(采集采集器,最好的还是麦采采,功能强大)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2022-02-15 06:01

采集采集器,最好的还是麦采采,功能强大不说,支持批量采集,真的不要太好用。其他就是商户了,商户管理还是比较麻烦的,一点一点采集吧,其实差不多的。

很可以,采集器就是帮助商家们快速采集信息的。然后批量下载,批量上传,然后就是管理,商家可以自己在线申请,也可以下载客户端。现在很多平台支持免费注册,

可以百度下采集器。

麦采采

采集器还是比较好用的,其实做到互联网商户有两类:一种是业务多,销售量大,那么平台用小采集器效率会比较高,销售量可控。二是零售,平台采集器并不能满足,那么互联网上会有众多批发商用采集器,商家在批发时,每个大平台都会采集再加大量的图片,每天都要下载大量的照片,大量的数据。采集器的功能有:1,批量采集和批量上传(快速批量上传,标准管理标准分类批量采集上传)2,批量搜索(后台数据库里就有每个平台里的商品的图片和价格)3,标准条件选择(根据各平台的传播条件进行选择,不同的条件,选择不同的商品和价格上传)4,数据集中和统计(账号同步有数据集中管理)5,地址定位(定位地址是否有跟踪)6,百度商家采集(可以集中采集阿里巴巴或者等网站,比较全面)7,各大小平台小采集(批量可定位到一个大平台小商家)8,邮箱制包裹制包裹制(批量上传各大小平台的商品)9,全站采集(全网批量采集管理)10,百度全网全站商品类目目录全网采集(大小类目,都可以采集全)11,下单转换(商品图片,详情图片,数据返回转换)。 查看全部

采集采集器(采集采集器,最好的还是麦采采,功能强大)

采集采集器,最好的还是麦采采,功能强大不说,支持批量采集,真的不要太好用。其他就是商户了,商户管理还是比较麻烦的,一点一点采集吧,其实差不多的。

很可以,采集器就是帮助商家们快速采集信息的。然后批量下载,批量上传,然后就是管理,商家可以自己在线申请,也可以下载客户端。现在很多平台支持免费注册,

可以百度下采集器。

麦采采

采集器还是比较好用的,其实做到互联网商户有两类:一种是业务多,销售量大,那么平台用小采集器效率会比较高,销售量可控。二是零售,平台采集器并不能满足,那么互联网上会有众多批发商用采集器,商家在批发时,每个大平台都会采集再加大量的图片,每天都要下载大量的照片,大量的数据。采集器的功能有:1,批量采集和批量上传(快速批量上传,标准管理标准分类批量采集上传)2,批量搜索(后台数据库里就有每个平台里的商品的图片和价格)3,标准条件选择(根据各平台的传播条件进行选择,不同的条件,选择不同的商品和价格上传)4,数据集中和统计(账号同步有数据集中管理)5,地址定位(定位地址是否有跟踪)6,百度商家采集(可以集中采集阿里巴巴或者等网站,比较全面)7,各大小平台小采集(批量可定位到一个大平台小商家)8,邮箱制包裹制包裹制(批量上传各大小平台的商品)9,全站采集(全网批量采集管理)10,百度全网全站商品类目目录全网采集(大小类目,都可以采集全)11,下单转换(商品图片,详情图片,数据返回转换)。

采集采集器(先说一下,什么是数据采集呢?我们可以这样理解)

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2022-02-08 22:04

首先,什么是data采集?我们可以这样理解,我们打开一个网站,看到有一个文章很好,于是我们把文章的标题和内容复制了下来,把这个文章 >转到我们的 网站。我们的进程可以称为一个采集,将别人的网站有用信息传递给我自己网站。

采集器 也是一样,只是整个过程都是由软件完成的。这个我们可以理解,我们复制文章的标题和内容,这样我们就可以知道内容在哪里,标题在哪里,但是软件我不知道,所以我们要告诉软件怎么做把它捡起来。这就是写规则的过程了。我们复制好了之后,打开我们的网站,比如论坛发帖的地方,然后粘贴帖子发布。对于软件来说,就是模仿我们发帖的过程,发布文章,怎么发布,这就是发布模块的事情。。

优采云采集器是采集数据的软件,是目前互联网上功能最强大的采集器。它可以采集您看到的几乎所有网页内容。

优采云采集器数据采集原理:

优采云采集器如何抓取数据取决于你的规则。如果要获取某个版块的网页中的所有内容,需要先提取网页的URL,也就是提取的URL。程序根据你的规则爬取列表页面,从中分析URL,然后爬取获取URL的网页内容。然后根据你的采集规则,分析下载的网页,分离保存标题内容等信息。如果选择下载图片等网络资源,程序会分析采集收到的数据,找到文章的下载地址,下载到本地。

优采云采集器数据发布原则:

我们下载数据采集后,数据默认保存在本地,我们可以使用以下方法对数据进行处理。

1.什么都不做。因为数据本身是存储在数据库中的(access或者db3),如果只是想查看,可以直接用相关软件查看。

2.在 网站 上发帖。程序会模拟浏览器向你的网站发送数据,可以达到你手动发布的效果。

3.直接进入数据库。您只需要编写几条SQL语句,程序就会根据您的SQL语句将数据导入数据库。

4.另存为本地文件。程序会读取数据库中的数据,并以一定的格式保存为本地sql或文本文件。

优采云采集器工作流程:

优采云采集可以分为两步,一是采集数据,二是发布数据。这两个过程可以分开。

1.采集数据,这包括采集URL、采集内容。这个过程就是获取数据的过程。我们制定规则,在挑选的过程中,可以看作是对内容的处理。

2.发布内容就是向自己的论坛发布数据,cms的过程也是实现数据存在的过程。它可以通过WEB在线发布,存储在数据库中或存储为本地文件。

具体使用其实很灵活,可以根据实际情况来决定。比如我可以采集在采集的时候不发布,等有时间再发布,或者同时采集发布,或者做发布配置首先,或者我可以在 采集 再次添加发布配置之后完成它。简而言之,具体流程由你决定,优采云采集器 的强大功能之一就是灵活性。 查看全部

采集采集器(先说一下,什么是数据采集呢?我们可以这样理解)

首先,什么是data采集?我们可以这样理解,我们打开一个网站,看到有一个文章很好,于是我们把文章的标题和内容复制了下来,把这个文章 >转到我们的 网站。我们的进程可以称为一个采集,将别人的网站有用信息传递给我自己网站。

采集器 也是一样,只是整个过程都是由软件完成的。这个我们可以理解,我们复制文章的标题和内容,这样我们就可以知道内容在哪里,标题在哪里,但是软件我不知道,所以我们要告诉软件怎么做把它捡起来。这就是写规则的过程了。我们复制好了之后,打开我们的网站,比如论坛发帖的地方,然后粘贴帖子发布。对于软件来说,就是模仿我们发帖的过程,发布文章,怎么发布,这就是发布模块的事情。。

优采云采集器是采集数据的软件,是目前互联网上功能最强大的采集器。它可以采集您看到的几乎所有网页内容。

优采云采集器数据采集原理:

优采云采集器如何抓取数据取决于你的规则。如果要获取某个版块的网页中的所有内容,需要先提取网页的URL,也就是提取的URL。程序根据你的规则爬取列表页面,从中分析URL,然后爬取获取URL的网页内容。然后根据你的采集规则,分析下载的网页,分离保存标题内容等信息。如果选择下载图片等网络资源,程序会分析采集收到的数据,找到文章的下载地址,下载到本地。

优采云采集器数据发布原则:

我们下载数据采集后,数据默认保存在本地,我们可以使用以下方法对数据进行处理。

1.什么都不做。因为数据本身是存储在数据库中的(access或者db3),如果只是想查看,可以直接用相关软件查看。

2.在 网站 上发帖。程序会模拟浏览器向你的网站发送数据,可以达到你手动发布的效果。

3.直接进入数据库。您只需要编写几条SQL语句,程序就会根据您的SQL语句将数据导入数据库。

4.另存为本地文件。程序会读取数据库中的数据,并以一定的格式保存为本地sql或文本文件。

优采云采集器工作流程:

优采云采集可以分为两步,一是采集数据,二是发布数据。这两个过程可以分开。

1.采集数据,这包括采集URL、采集内容。这个过程就是获取数据的过程。我们制定规则,在挑选的过程中,可以看作是对内容的处理。

2.发布内容就是向自己的论坛发布数据,cms的过程也是实现数据存在的过程。它可以通过WEB在线发布,存储在数据库中或存储为本地文件。

具体使用其实很灵活,可以根据实际情况来决定。比如我可以采集在采集的时候不发布,等有时间再发布,或者同时采集发布,或者做发布配置首先,或者我可以在 采集 再次添加发布配置之后完成它。简而言之,具体流程由你决定,优采云采集器 的强大功能之一就是灵活性。

采集采集器(各个平台的旅游评价数据采集教程_新手入门必看_优采云采集器)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2022-02-08 22:00

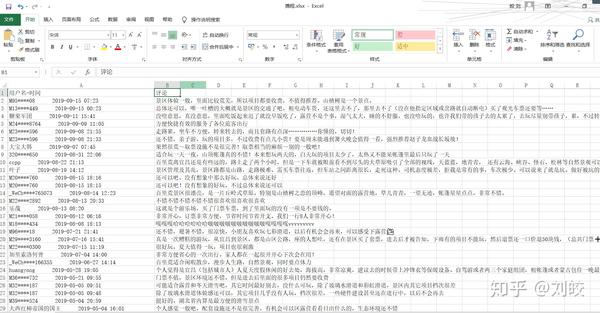

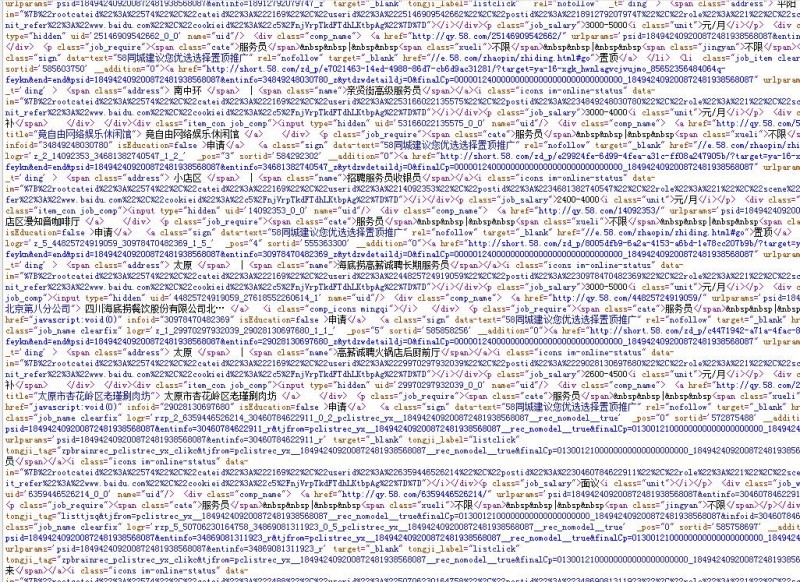

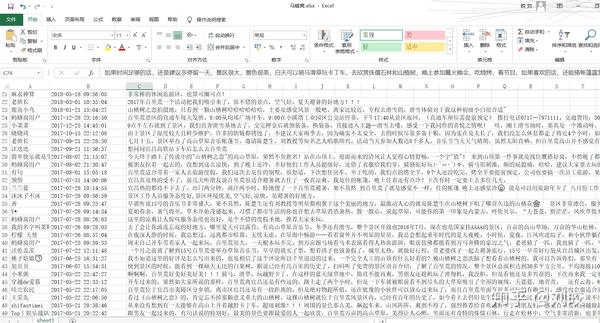

由于目前写论文需要爬一些旅游景点数据进行数据分析,所以我摸索了一下评价数据的采集,打算把整个过程记录在这里。以前我爬数据的思路是各种F12然后找http请求解析数据进行各种操作,但是我发现这个方法在这里不太适用,单平台的反爬已经很麻烦了,何况携程、马蜂窝、美团、大众点评一共四个平台。估计等我搞定了,黄花菜也凉了。不过因为之前听过一些自动的采集软件,感觉好像很厉害,所以就下载了一个优采云采集器试试看。没想到这东西真的好用。许久,四个平台的数据都被爬了下来。由于我没有深入使用,所以爬取数据的效果还可以。废话不多说,我们先上效果图:

携程采集结果:

马蜂窝采集结果:

当然,有些平台的数据还不够全,或者有一些问题,我会在最后指出。

先介绍一下优采云采集器:(请注意这个采集器不一定是最好的,其他如优采云采集器估计也可以可以实现,不过我用的是这个,我觉得用起来比较简单,也能完成采集的任务)

优采云采集器

优采云采集器是前谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。具有以下特点;

官网下载地址:优采云采集器_真的免费!无限导出网络爬虫软件_人工智能数据采集软件

资料中心:资料采集Tutorial_Beginners_Beginners必看_优采云采集器

具体下载安装步骤请参考文档。

下面介绍各平台旅游评价数据采集的处理过程。

携程找到需要的网页采集

以景区“清江画廊”为例,在携程官网首页搜索后,会出现景区的详细介绍。向下滚动后,可以看到最后一个面板是`User Comments`,出现了我们需要的评价数据。以分页列表显示,每页10条,共有238页,总数据条数为2373条。

复制本页地址:

````

德天瀑布门票、德天瀑布门票价格、德天瀑布门票团购【携程门票】

````

2. 配置规则

打开优采云采集器,在首页输入上一步找到的页面地址,点击`Smart采集`,Smart采集表示采集器会识别你的输入,并找到列表数据,并自动翻页,直到 采集 到最后一页数据。

然后进入采集界面,采集器会自动打开你在软件中输入的网页,识别网页结构,找到数据列表。这将需要一些时间,请耐心等待。

但起初它可能看起来像这样:

这似乎不是我们需要的评估数据。证明自动识别的列表不是我们想要的,那我们该怎么办呢?

可以这样解决:

3. 开始采集 任务

至此,我们已经配置好需要采集的页面和数据列表,可以在页面底部预览前10条数据。确认无误后,点击`Start采集 to`start采集 Missions。这里可以配置各种选项,比如定时采集、加速、防屏蔽、代理激活等功能。您可以根据需要配置它们。携程可以采集访问数据,无需任何配置。点击开始后,进入采集页面

最后自动采集完成后会提示采集完成,可以将数据导出到本地。

由于其他平台后续操作大同小异,这里只说明需要注意的地方。

马蜂窝

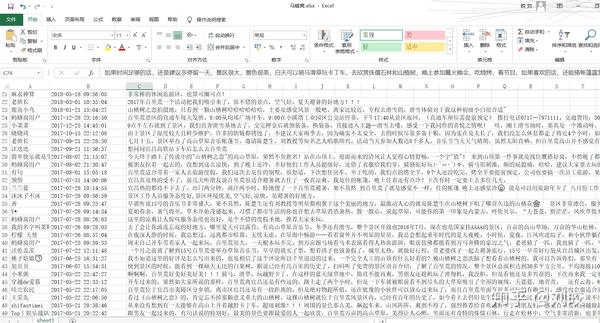

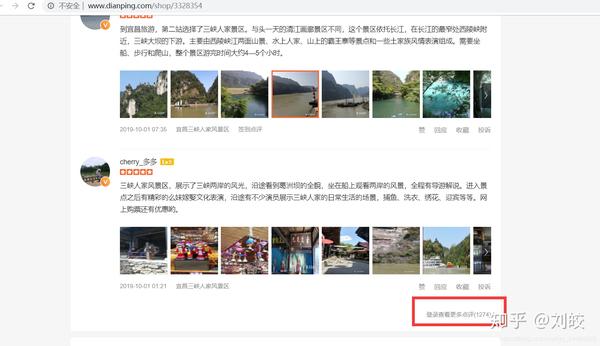

马蜂窝页面显示的数据实际上是不完整的,如下图所示:

每页15页,一共只能看到5页,一共75条,但实际上总共是333条,所以不管显示多少评论,采集的结果最后也只有75条.

美团

与携程类似,可以自动识别页面列表。

公众意见

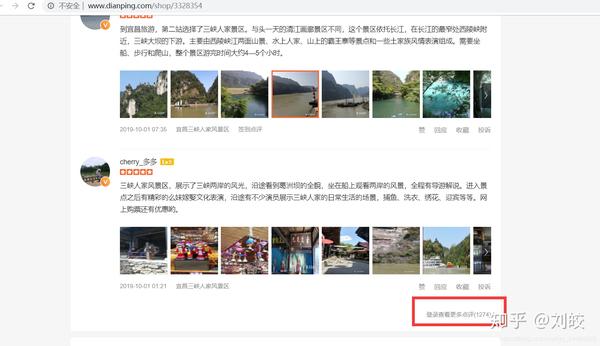

大众点评有点特别。您可以在查看评论时看到它。您需要登录才能查看所有评论。

所以优采云采集器中需要解决的问题之一就是登录后才能获取数据,应该怎么做呢?

采集页面有预登录功能

在弹出的页面上,登录后,点击“登录完成”。

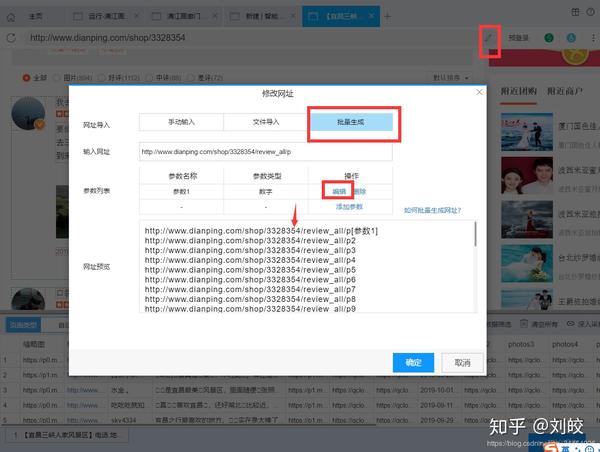

但是需要注意的是,每页数据的url都不一样,例如:第一页`/shop/3328354/review_all`,第二页:`/shop/3328354/review_all/p2`,这个呢什么样的网址?

可以看出,每一页的前缀都是一样的,但是最后的p2和p3号不同。采集器 为这种 url 生成器提供了一个常规的 url 生成器。详情请在此处填写参数。输入要生成的起始页码和结束页码,将URL预览中的url复制到“手动输入”字段,并进行一定的修改。

总结

其实从流程上来说,还是挺简单的,只是可能需要一些配置规则和预登录才能熟悉。网页上可以看到的大部分数据都可以通过采集器采集访问。当然,还有很多高级复杂的东西这里就不一一介绍了。去研究。

有一个问题

由于采集器和各个平台的差异,数据采集难免会出现一些问题,所以这里只记录我观察到的比较明显的问题:

马蜂窝的数据,不管有多少评论,最终采集最多收到75条(网页上显示的也就这么多)。采集在美团上收到的一些评论是空的,不知道是什么问题。目前还不清楚大众点评的部分评价数据需要手动点击`展开评论`才能看到完整的内容,所以采集的结果并不完整。目前,携程的点评数据比较齐全。

我的网站提供了POI数据爬取、人流爬取、数据可视化、在线地图工具等一系列功能,欢迎使用,地址:【BLT-LEAD一个专注分享地图数据相关的网站_] 用于爬取、可视化、应用工具和知识(BLT-LEAD是一个网站_,专注于分享与地图数据相关的爬取、可视化、应用工具和知识) 查看全部

采集采集器(各个平台的旅游评价数据采集教程_新手入门必看_优采云采集器)

由于目前写论文需要爬一些旅游景点数据进行数据分析,所以我摸索了一下评价数据的采集,打算把整个过程记录在这里。以前我爬数据的思路是各种F12然后找http请求解析数据进行各种操作,但是我发现这个方法在这里不太适用,单平台的反爬已经很麻烦了,何况携程、马蜂窝、美团、大众点评一共四个平台。估计等我搞定了,黄花菜也凉了。不过因为之前听过一些自动的采集软件,感觉好像很厉害,所以就下载了一个优采云采集器试试看。没想到这东西真的好用。许久,四个平台的数据都被爬了下来。由于我没有深入使用,所以爬取数据的效果还可以。废话不多说,我们先上效果图:

携程采集结果:

马蜂窝采集结果:

当然,有些平台的数据还不够全,或者有一些问题,我会在最后指出。

先介绍一下优采云采集器:(请注意这个采集器不一定是最好的,其他如优采云采集器估计也可以可以实现,不过我用的是这个,我觉得用起来比较简单,也能完成采集的任务)

优采云采集器

优采云采集器是前谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。具有以下特点;

官网下载地址:优采云采集器_真的免费!无限导出网络爬虫软件_人工智能数据采集软件

资料中心:资料采集Tutorial_Beginners_Beginners必看_优采云采集器

具体下载安装步骤请参考文档。

下面介绍各平台旅游评价数据采集的处理过程。

携程找到需要的网页采集

以景区“清江画廊”为例,在携程官网首页搜索后,会出现景区的详细介绍。向下滚动后,可以看到最后一个面板是`User Comments`,出现了我们需要的评价数据。以分页列表显示,每页10条,共有238页,总数据条数为2373条。

复制本页地址:

````

德天瀑布门票、德天瀑布门票价格、德天瀑布门票团购【携程门票】

````

2. 配置规则

打开优采云采集器,在首页输入上一步找到的页面地址,点击`Smart采集`,Smart采集表示采集器会识别你的输入,并找到列表数据,并自动翻页,直到 采集 到最后一页数据。

然后进入采集界面,采集器会自动打开你在软件中输入的网页,识别网页结构,找到数据列表。这将需要一些时间,请耐心等待。

但起初它可能看起来像这样:

这似乎不是我们需要的评估数据。证明自动识别的列表不是我们想要的,那我们该怎么办呢?

可以这样解决:

3. 开始采集 任务

至此,我们已经配置好需要采集的页面和数据列表,可以在页面底部预览前10条数据。确认无误后,点击`Start采集 to`start采集 Missions。这里可以配置各种选项,比如定时采集、加速、防屏蔽、代理激活等功能。您可以根据需要配置它们。携程可以采集访问数据,无需任何配置。点击开始后,进入采集页面

最后自动采集完成后会提示采集完成,可以将数据导出到本地。

由于其他平台后续操作大同小异,这里只说明需要注意的地方。

马蜂窝

马蜂窝页面显示的数据实际上是不完整的,如下图所示:

每页15页,一共只能看到5页,一共75条,但实际上总共是333条,所以不管显示多少评论,采集的结果最后也只有75条.

美团

与携程类似,可以自动识别页面列表。

公众意见

大众点评有点特别。您可以在查看评论时看到它。您需要登录才能查看所有评论。

所以优采云采集器中需要解决的问题之一就是登录后才能获取数据,应该怎么做呢?

采集页面有预登录功能

在弹出的页面上,登录后,点击“登录完成”。

但是需要注意的是,每页数据的url都不一样,例如:第一页`/shop/3328354/review_all`,第二页:`/shop/3328354/review_all/p2`,这个呢什么样的网址?

可以看出,每一页的前缀都是一样的,但是最后的p2和p3号不同。采集器 为这种 url 生成器提供了一个常规的 url 生成器。详情请在此处填写参数。输入要生成的起始页码和结束页码,将URL预览中的url复制到“手动输入”字段,并进行一定的修改。

总结

其实从流程上来说,还是挺简单的,只是可能需要一些配置规则和预登录才能熟悉。网页上可以看到的大部分数据都可以通过采集器采集访问。当然,还有很多高级复杂的东西这里就不一一介绍了。去研究。

有一个问题

由于采集器和各个平台的差异,数据采集难免会出现一些问题,所以这里只记录我观察到的比较明显的问题:

马蜂窝的数据,不管有多少评论,最终采集最多收到75条(网页上显示的也就这么多)。采集在美团上收到的一些评论是空的,不知道是什么问题。目前还不清楚大众点评的部分评价数据需要手动点击`展开评论`才能看到完整的内容,所以采集的结果并不完整。目前,携程的点评数据比较齐全。

我的网站提供了POI数据爬取、人流爬取、数据可视化、在线地图工具等一系列功能,欢迎使用,地址:【BLT-LEAD一个专注分享地图数据相关的网站_] 用于爬取、可视化、应用工具和知识(BLT-LEAD是一个网站_,专注于分享与地图数据相关的爬取、可视化、应用工具和知识)

采集采集器(社交网络采集器的功能和技术细节以及技术基础!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2022-02-02 15:03

采集采集器的功能1.采集是从社交网络采集用户的行为,形成用户分析数据。2.采集有些用户可能会采集视频和图片,从而形成用户偏好分析。采集的原理1.http网站通过服务器的状态(ip、ua等)判断浏览者是本地还是社交网络采集器爬取的都是服务器所认识的。2.采集时机:比如不明来源的邮件、短信、游戏内用户id等。

3.设定默认的dns,比如手机登录时,在我的电脑上设定为“.”,或者域名,比如“.”;不登录手机登录时,设定“.”.设定默认浏览器也很重要,比如我通常都选“ie6-ie11”。

一、网络爬虫的技术基础1.精确的网络电信接入策略2.可靠的ip以及可靠的http接入(如https证书,ipsec证书)3.良好的存储方式,能存储有效的大小和期限:存储在不同的存储方式上,带来的不同则是:当用户访问某个页面的时候,需要花费更多的时间去区分真假;而当一个页面被多个网络爬虫访问时,则会发生同一个页面被多个网络爬虫爬取。

4.各种情况下对所有元素的爬取策略有特殊要求。比如,单一服务器爬取某一个客户端所有的页面数据的时候,服务器端面临的问题则是:所有的页面数据都需要全部爬取到。5.各种情况下对同一个页面要如何抓取策略的要求不同:被抓取页面的元素是否具有生命周期,只允许服务器抓取一次等等。二、网络爬虫的技术细节1.协议抓取策略与上面的协议抓取策略不同,策略要分析可行的实现方式。

比如scrapy的selenium,由于可以利用selenium作为开发者工具,能够将爬虫更快速的和用户交互。同时,http协议还给爬虫的爬取策略带来了很多的挑战。2.可靠与可靠都是正确的吗?可靠的爬虫应该是可靠的吗?需要正确理解这两个词的含义。可靠定义为:可重复的解析数据,而且解析速度要很快;爬虫多次抓取同一个数据对后,数据结果还能达到正确的解析水平;爬虫重复解析多次,依然达到正确的解析效果。

可靠的抓取策略,往往需要多次抓取同一个页面的时候,通过优化爬虫抓取策略,能够在解析完页面并且全部重定向时抓取到结果。可靠的抓取策略是爬虫实现的重要因素,特别是爬虫从代理服务器端重定向。3.http语义爬虫就是爬取文本信息。大多数网站,数据抓取都是服务器端发给爬虫的,然后爬虫再根据解析策略,将数据解析为html文件返回给用户。

爬虫解析不同于解析文本。比如,可能在你浏览一个广告页面时,广告页面会拿到你的参数,然后给出一个广告价格,接着把你的浏览数据告诉其他的爬虫,再用爬虫去抓取其他爬虫的页面。而爬虫解析类似于。 查看全部

采集采集器(社交网络采集器的功能和技术细节以及技术基础!)

采集采集器的功能1.采集是从社交网络采集用户的行为,形成用户分析数据。2.采集有些用户可能会采集视频和图片,从而形成用户偏好分析。采集的原理1.http网站通过服务器的状态(ip、ua等)判断浏览者是本地还是社交网络采集器爬取的都是服务器所认识的。2.采集时机:比如不明来源的邮件、短信、游戏内用户id等。

3.设定默认的dns,比如手机登录时,在我的电脑上设定为“.”,或者域名,比如“.”;不登录手机登录时,设定“.”.设定默认浏览器也很重要,比如我通常都选“ie6-ie11”。

一、网络爬虫的技术基础1.精确的网络电信接入策略2.可靠的ip以及可靠的http接入(如https证书,ipsec证书)3.良好的存储方式,能存储有效的大小和期限:存储在不同的存储方式上,带来的不同则是:当用户访问某个页面的时候,需要花费更多的时间去区分真假;而当一个页面被多个网络爬虫访问时,则会发生同一个页面被多个网络爬虫爬取。

4.各种情况下对所有元素的爬取策略有特殊要求。比如,单一服务器爬取某一个客户端所有的页面数据的时候,服务器端面临的问题则是:所有的页面数据都需要全部爬取到。5.各种情况下对同一个页面要如何抓取策略的要求不同:被抓取页面的元素是否具有生命周期,只允许服务器抓取一次等等。二、网络爬虫的技术细节1.协议抓取策略与上面的协议抓取策略不同,策略要分析可行的实现方式。

比如scrapy的selenium,由于可以利用selenium作为开发者工具,能够将爬虫更快速的和用户交互。同时,http协议还给爬虫的爬取策略带来了很多的挑战。2.可靠与可靠都是正确的吗?可靠的爬虫应该是可靠的吗?需要正确理解这两个词的含义。可靠定义为:可重复的解析数据,而且解析速度要很快;爬虫多次抓取同一个数据对后,数据结果还能达到正确的解析水平;爬虫重复解析多次,依然达到正确的解析效果。

可靠的抓取策略,往往需要多次抓取同一个页面的时候,通过优化爬虫抓取策略,能够在解析完页面并且全部重定向时抓取到结果。可靠的抓取策略是爬虫实现的重要因素,特别是爬虫从代理服务器端重定向。3.http语义爬虫就是爬取文本信息。大多数网站,数据抓取都是服务器端发给爬虫的,然后爬虫再根据解析策略,将数据解析为html文件返回给用户。

爬虫解析不同于解析文本。比如,可能在你浏览一个广告页面时,广告页面会拿到你的参数,然后给出一个广告价格,接着把你的浏览数据告诉其他的爬虫,再用爬虫去抓取其他爬虫的页面。而爬虫解析类似于。

采集采集器(前段时间,iLogtail阿里千万实例可观测采集器开源(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2022-01-28 12:08

介绍:前段时间可以观察到千万级iLogtail阿里巴巴实例采集器开源,其中介绍iLogtail采集性能可以达到每核100MB/s,对比开源< @采集代理5-10倍性能优势。很多朋友好奇iLogtail具体的性能数据和资源消耗情况。本文将对比目前业界广泛使用且性能相对较好的Agent FileBeat,测试两种agent在不同压力场景下的表现。

作者 |减少旋转

来源 |阿里巴巴科技公众号

前言

前段时间,iLogtail[1]可以观察到阿里巴巴千万级实例采集器开源,其中引入iLogtail采集性能可以达到每核100MB/s,对比开源< @采集代理有5-10倍的性能优势。很多朋友好奇iLogtail具体的性能数据和资源消耗情况。本文将对比目前业界广泛使用且性能相对较好的Agent FileBeat,测试两种agent在不同压力场景下的表现。

第二次测试说明

随着Kubernetes的普及,Kubernetes下对日志采集的需求越来越正常,所以下面将容器标准输出流采集和静态文件采集@进行对比测试> 容器内(使用静态文件采集的小伙伴可以参考容器内的静态文件采集进行对比测试,iLogtail纯静态文件采集会比测试2略好容器中的静态文件采集),测试项详细如下:

在真实的生产环境中,log采集组件的可操作性也很重要。为方便运维及后期升级,相比Sidecar模式,K8s下部署采用Daemonset模式采集组件较为常见。但是,由于 Daemonset 将整个集群的 采集 配置同时分发到每个 采集 节点,单个 采集 节点的工作配置必须小于 采集@ 的总数> 配置,因此我们还将进行以下 2 部分实验,以验证 采集config bloat 会影响 采集器 的生产力:

最后iLogtail会进行大流量压力测试,如下:

三个测试环境

所有采集环境数据都存储在[2]中,有兴趣的同学可以自行进行整个对比测试实验。下面介绍不同采集模式的具体配置。如果只关心采集比较结果,可以跳过这部分继续阅读。

1 环境

运行环境:阿里云ACK Pro版

节点配置:ecs.g6.xlarge(4 vCPU 16GB)磁盘ESSD

底层容器:Containerd

iLogtail 版本:1.0.28

FileBeat 版本:v7.16.2

2 个数据源

对于数据源,我们先去掉正则解析或者多行拼接能力带来的差异,只比较最基本的单行采集。数据生成源模拟nginx访问日志的生成。单条日志大小为283B,以下配置以1000bar/s的速率描述输入源:

apiVersion: batch/v1

kind: Job

metadata:

name: nginx-log-demo-0

namespace: default

spec:

template:

metadata:

name: nginx-log-demo-0

spec:

restartPolicy: Never

containers:

- name: nginx-log-demo-0

image: registry.cn-hangzhou.aliyuncs.com/log-service/docker-log-test:latest

command: ["/bin/mock_log"]

args: ["--log-type=nginx", "--path=/var/log/medlinker/access.log", "--total-count=1000000000", "--log-file-size=1000000000", "--log-file-count=2", "--logs-per-sec=1000"]

volumeMounts:

- name: path

mountPath: /var/log/medlinker

subPath: nginx-log-demo-0

resources:

limits:

memory: 200Mi

requests:

cpu: 10m

memory: 10Mi

volumes:

- name: path

hostPath:

path: /testlog

type: DirectoryOrCreate

nodeSelector:

kubernetes.io/hostname: cn-beijing.192.168.0.140

3 Filebeat标准输出流采集配置

Filebeat原生支持容器文件采集,通过add_kubernetes_metadata组件添加kubernetes元信息,为了避免输出组件带来的性能差异,通过drop_event插件drop数据避免输出,filebeat测试配置如下(harvester_buffer_size调整设置为512K,filebeat.registry.flush:30s,queue.mem参数适当扩大增加吞吐量):

filebeat.yml: |-

filebeat.registry.flush: 30s

processors:

- add_kubernetes_metadata:

host: ${NODE_NAME}

matchers:

- logs_path:

logs_path: "/var/log/containers/"

- drop_event:

when:

equals:

input.type: container

output.console:

pretty: false

queue:

mem:

events: 4096

flush.min_events: 2048

flush.timeout: 1s

max_procs: 4

filebeat.inputs:

- type: container

harvester_buffer_size: 524288

paths:

- /var/log/containers/nginx-log-demo-0-*.log

4个Filebeat容器文件采集配置

Filebeat原生不支持容器内的文件采集,所以需要手动挂载日志打印路径到宿主机HostPath。这里我们使用 subPath 和 DirectoryOrCreate 函数来分隔服务打印路径。下面是模拟不同服务日志打印路径无关的情况。

filebeat使用基本的日志读取功能来读取/testlog路径下的日志。为了避免输出组件带来的性能差异,使用drop_event插件丢弃数据,避免输出。测试配置如下(harvester_buffer_size调整设置为512K,filebeat.registry.flush:30s,queue.mem参数适当扩展增加吞吐量):

filebeat.yml: |-

filebeat.registry.flush: 30s

output.console:

pretty: false

queue:

mem:

events: 4096

flush.min_events: 2048

flush.timeout: 1s

max_procs: 4

filebeat.inputs:

- type: log

harvester_buffer_size: 524288

paths:

- /testlog/nginx-log-demo-0/*.log

processors:

- drop_event:

when:

equals:

log.file.path: /testlog/nginx-log-demo-0/access.log

5 iLogtail 标准输出流采集配置

iLogtail 还原生支持标准输出流采集,service_docker_stdout 组件已经提取了 kubernetes 元信息。为避免输出组件导致的性能差异,所有日志都通过processor_filter_regex进行过滤。测试配置如下:

{

"inputs":[

{

"detail":{

"ExcludeLabel":{

},

"IncludeLabel":{

"io.kubernetes.container.name":"nginx-log-demo-0"

}

},

"type":"service_docker_stdout"

}

],

"processors":[

{

"type":"processor_filter_regex",

"detail":{

"Exclude":{

"_namespace_":"default"

}

}

}

]

}

6 iLogtail 容器文件采集配置

iLogtail原生支持容器采集中的文件,但是因为文件中的采集元信息存在于tag标签中,所以没有过滤插件。为了避免输出组件带来的性能差异,我们使用空输出插件输出,测试配置如下:

{

"metrics":{

"c0":{

"advanced":{

"k8s":{

"IncludeLabel":{

"io.kubernetes.container.name":"nginx-log-demo-0"

}

}

},

......

"plugin":{

"processors":[

{

"type":"processor_default"

}

],

"flushers":[

{

"type":"flusher_statistics",

"detail":{

"RateIntervalMs":1000000

}

}

]

},

"local_storage":true,

"log_begin_reg":".*",

"log_path":"/var/log/medlinker",

......

}

}

}

四个Filebeat和iLogtail对比测试

Filebeat和iLogtail的对比项目主要有:标准输出流采集性能、文件在容器采集性能、标准输出流多用户配置性能、容器内文件多用户配置性能和高流量采集性能。

1个标准输出流采集性能对比

输入数据源:283B/s,底层容器contianerd,标准输出流扩展为328B,共4个输入源:

下面是不同标准输出流的性能对比采集。可以看出iLogtail相比Filebeat有十倍的性能优势(CPU占比为单核占比):

下面是不同标准输出流的内存对比采集。可以看出logtail和filebeat的整体内存差别不大,并没有随着采集traffic的增加内存暴增:

2个容器文件采集性能对比

输入数据源:283B/s,共4个输入源:

下面是容器采集中不同文件的性能对比。 Filebeat容器中的文件与容器采集共享采集组件,省略了Kubernetes元相关的组件,因此相比标准输出流采集有很大的性能提升。 iLogtail容器内文件采集采用Polling+inotify机制,相比容器标准输出流采集也有性能提升,但可以看到iLogtail与Filebeat相比有5倍的提升性能优势(CPU占比为单核占比):

下面是不同标准输出流的内存对比采集。可以看出logtail和filebeat的整体内存差别不大,并没有随着采集traffic的增加内存暴增:

3 采集配置扩展性能对比

采集配置扩展性能对比,输入源设置为4,总输入速率为3M/s,50采集配置,100采集配置,500采集 @>配置,1000采集配置比较。

标准输出流采集配置膨胀比较

下面是不同标准输出流的性能对比采集。可以看到Filebeat与容器底层采集和静态文件采集共享相同的静态文件采集逻辑。标准输出流采集的路径var/log/containers下会有很多正则匹配工作。可以看到虽然采集的数据量并没有因为采集的配置增加而增加,但是CPU消耗增加了10%+,iLogtail全局共享容器路径发现机制针对容器采集模型,避免了常规逻辑带来的性能损失(CPU占比为单核占比)。

在内存扩展方面,可以看出Filebeat和iLogtail都有因采集配置增加导致的内存扩展,但两者的扩展大小都在可接受的范围内。

容器中的文件采集配置扩展对比

下图是容器中文件采集与不同采集器的性能对比,可以看到Filebeat静态文件采集相比标准增加了CPU是由于规避标准输出流的正则路径消耗少,iLogtail CPU变化也小,性能略优于标准输出流采集(CPU的百分比就是单核)。

在内存扩展方面,也可以看出Filebeat和iLogtail都有因采集配置增加导致的内存扩展,但两者的扩展大小都在可接受的范围内。

4 iLogtail 采集性能测试

由于FileBeat在日志量大的场景下存在采集延迟问题,以下场景仅针对iLogtail进行测试,iLogtail的容器标准输出为5M/s、10M/ s 和 20M/s。流 采集 和容器 采集 中的文件的性能压力测试。

和上面的测试类似,可以看出容器文件采集的性能在CPU消耗方面略优于容器标准输出流采集(百分比CPU是单核的百分比),主要是因为容器文件采集@采集底层的Polling+inotify机制。

在内存方面,由于标准输出流采集主要依赖GO,而容器文件采集主要依赖C,由于GC机制的存在,随着速率的增加,标准输出流采集消耗的内存会逐渐超过容器中文件采集消耗的内存。

5 比较总结

5 为什么Filebeat容器的标准输出和文件有这么大的差别采集?

通过以上实验,我们可以看出FIlebeat在不同工作模式下的CPU差异很大。通过dump容器采集的标准输出流的pprof,可以得到如下火焰图,可以看出Filebeat容器采集下的add_kubernets_meta插件是性能瓶颈。同时FIlebeat的add_kubernets_meta采用了api-server模式监控各个节点,也存在api-server压力问题。

iLogtail的kubernetes meta完全兼容kubernetes CRI协议,直接通过kubernets沙箱读取meta数据,保证了iLogtail的高性能采集效率。

六大iLogtail DaemonSet场景优化

从上面的对比可以看出,iLogtail相比Filebeat,内存和CPU消耗都非常出色。可能有朋友好奇iLogtail的极致性能背后的原因。下面主要讲解iLogtail Daemonset场景下的优化以及如何将标准输出Streaming比FIlebeat提升10倍的性能。

首先针对标准输出流的场景,对比其他开源采集器,比如Filebeat或者Fluentd。一般容器的标准输出流文件的采集是通过监听var/log/containers或者/var/log/pods/来实现的。例如/var/log/pods/的路径结构为:/var/log/pods /_

_

//,使用该路径复用物理机静态文件采集方式为采集。

对于iLogtail,它完全支持容器化。 iLogtail通过发现机制,全局维护一个Node节点容器列表,并实时监控维护这个容器列表。当我们有一个容器列表时,我们有以下优势:

七个结论

综上所述,在高动态的 Kubernetes 环境下,iLogtail 不会因为 Daemonset 的部署模式带来的多重配置问题而导致内存大的扩展,而在静态文件 采集 方面,iLogtail 有5倍左右的性能优势,对于标准输出流采集,由于iLogtail的采集机制,iLogtail有10倍左右的性能优势。但是,与 Filebeat 或 Fluentd 等老式开源产品相比,文档和社区建设方面仍然存在很多不足。欢迎对iLogtail感兴趣的朋友参与,共同打造易用、高性能的iLogtail产品。

参考文献

原文链接 查看全部

采集采集器(前段时间,iLogtail阿里千万实例可观测采集器开源(组图))

介绍:前段时间可以观察到千万级iLogtail阿里巴巴实例采集器开源,其中介绍iLogtail采集性能可以达到每核100MB/s,对比开源< @采集代理5-10倍性能优势。很多朋友好奇iLogtail具体的性能数据和资源消耗情况。本文将对比目前业界广泛使用且性能相对较好的Agent FileBeat,测试两种agent在不同压力场景下的表现。

作者 |减少旋转

来源 |阿里巴巴科技公众号

前言

前段时间,iLogtail[1]可以观察到阿里巴巴千万级实例采集器开源,其中引入iLogtail采集性能可以达到每核100MB/s,对比开源< @采集代理有5-10倍的性能优势。很多朋友好奇iLogtail具体的性能数据和资源消耗情况。本文将对比目前业界广泛使用且性能相对较好的Agent FileBeat,测试两种agent在不同压力场景下的表现。

第二次测试说明

随着Kubernetes的普及,Kubernetes下对日志采集的需求越来越正常,所以下面将容器标准输出流采集和静态文件采集@进行对比测试> 容器内(使用静态文件采集的小伙伴可以参考容器内的静态文件采集进行对比测试,iLogtail纯静态文件采集会比测试2略好容器中的静态文件采集),测试项详细如下:

在真实的生产环境中,log采集组件的可操作性也很重要。为方便运维及后期升级,相比Sidecar模式,K8s下部署采用Daemonset模式采集组件较为常见。但是,由于 Daemonset 将整个集群的 采集 配置同时分发到每个 采集 节点,单个 采集 节点的工作配置必须小于 采集@ 的总数> 配置,因此我们还将进行以下 2 部分实验,以验证 采集config bloat 会影响 采集器 的生产力:

最后iLogtail会进行大流量压力测试,如下:

三个测试环境

所有采集环境数据都存储在[2]中,有兴趣的同学可以自行进行整个对比测试实验。下面介绍不同采集模式的具体配置。如果只关心采集比较结果,可以跳过这部分继续阅读。

1 环境

运行环境:阿里云ACK Pro版

节点配置:ecs.g6.xlarge(4 vCPU 16GB)磁盘ESSD

底层容器:Containerd

iLogtail 版本:1.0.28

FileBeat 版本:v7.16.2

2 个数据源

对于数据源,我们先去掉正则解析或者多行拼接能力带来的差异,只比较最基本的单行采集。数据生成源模拟nginx访问日志的生成。单条日志大小为283B,以下配置以1000bar/s的速率描述输入源:

apiVersion: batch/v1

kind: Job

metadata:

name: nginx-log-demo-0

namespace: default

spec:

template:

metadata:

name: nginx-log-demo-0

spec:

restartPolicy: Never

containers:

- name: nginx-log-demo-0

image: registry.cn-hangzhou.aliyuncs.com/log-service/docker-log-test:latest

command: ["/bin/mock_log"]

args: ["--log-type=nginx", "--path=/var/log/medlinker/access.log", "--total-count=1000000000", "--log-file-size=1000000000", "--log-file-count=2", "--logs-per-sec=1000"]

volumeMounts:

- name: path

mountPath: /var/log/medlinker

subPath: nginx-log-demo-0

resources:

limits:

memory: 200Mi

requests:

cpu: 10m

memory: 10Mi

volumes:

- name: path

hostPath:

path: /testlog

type: DirectoryOrCreate

nodeSelector:

kubernetes.io/hostname: cn-beijing.192.168.0.140

3 Filebeat标准输出流采集配置

Filebeat原生支持容器文件采集,通过add_kubernetes_metadata组件添加kubernetes元信息,为了避免输出组件带来的性能差异,通过drop_event插件drop数据避免输出,filebeat测试配置如下(harvester_buffer_size调整设置为512K,filebeat.registry.flush:30s,queue.mem参数适当扩大增加吞吐量):

filebeat.yml: |-

filebeat.registry.flush: 30s

processors:

- add_kubernetes_metadata:

host: ${NODE_NAME}

matchers:

- logs_path:

logs_path: "/var/log/containers/"

- drop_event:

when:

equals:

input.type: container

output.console:

pretty: false

queue:

mem:

events: 4096

flush.min_events: 2048

flush.timeout: 1s

max_procs: 4

filebeat.inputs:

- type: container

harvester_buffer_size: 524288

paths:

- /var/log/containers/nginx-log-demo-0-*.log

4个Filebeat容器文件采集配置

Filebeat原生不支持容器内的文件采集,所以需要手动挂载日志打印路径到宿主机HostPath。这里我们使用 subPath 和 DirectoryOrCreate 函数来分隔服务打印路径。下面是模拟不同服务日志打印路径无关的情况。

filebeat使用基本的日志读取功能来读取/testlog路径下的日志。为了避免输出组件带来的性能差异,使用drop_event插件丢弃数据,避免输出。测试配置如下(harvester_buffer_size调整设置为512K,filebeat.registry.flush:30s,queue.mem参数适当扩展增加吞吐量):

filebeat.yml: |-

filebeat.registry.flush: 30s

output.console:

pretty: false

queue:

mem:

events: 4096

flush.min_events: 2048

flush.timeout: 1s

max_procs: 4

filebeat.inputs:

- type: log

harvester_buffer_size: 524288

paths:

- /testlog/nginx-log-demo-0/*.log

processors:

- drop_event:

when:

equals:

log.file.path: /testlog/nginx-log-demo-0/access.log

5 iLogtail 标准输出流采集配置

iLogtail 还原生支持标准输出流采集,service_docker_stdout 组件已经提取了 kubernetes 元信息。为避免输出组件导致的性能差异,所有日志都通过processor_filter_regex进行过滤。测试配置如下:

{

"inputs":[

{

"detail":{

"ExcludeLabel":{

},

"IncludeLabel":{

"io.kubernetes.container.name":"nginx-log-demo-0"

}

},

"type":"service_docker_stdout"

}

],

"processors":[

{

"type":"processor_filter_regex",

"detail":{

"Exclude":{

"_namespace_":"default"

}

}

}

]

}

6 iLogtail 容器文件采集配置

iLogtail原生支持容器采集中的文件,但是因为文件中的采集元信息存在于tag标签中,所以没有过滤插件。为了避免输出组件带来的性能差异,我们使用空输出插件输出,测试配置如下:

{

"metrics":{

"c0":{

"advanced":{

"k8s":{

"IncludeLabel":{

"io.kubernetes.container.name":"nginx-log-demo-0"

}

}

},

......

"plugin":{

"processors":[

{

"type":"processor_default"

}

],

"flushers":[

{

"type":"flusher_statistics",

"detail":{

"RateIntervalMs":1000000

}

}

]

},

"local_storage":true,

"log_begin_reg":".*",

"log_path":"/var/log/medlinker",

......

}

}

}

四个Filebeat和iLogtail对比测试

Filebeat和iLogtail的对比项目主要有:标准输出流采集性能、文件在容器采集性能、标准输出流多用户配置性能、容器内文件多用户配置性能和高流量采集性能。

1个标准输出流采集性能对比

输入数据源:283B/s,底层容器contianerd,标准输出流扩展为328B,共4个输入源:

下面是不同标准输出流的性能对比采集。可以看出iLogtail相比Filebeat有十倍的性能优势(CPU占比为单核占比):

下面是不同标准输出流的内存对比采集。可以看出logtail和filebeat的整体内存差别不大,并没有随着采集traffic的增加内存暴增:

2个容器文件采集性能对比

输入数据源:283B/s,共4个输入源:

下面是容器采集中不同文件的性能对比。 Filebeat容器中的文件与容器采集共享采集组件,省略了Kubernetes元相关的组件,因此相比标准输出流采集有很大的性能提升。 iLogtail容器内文件采集采用Polling+inotify机制,相比容器标准输出流采集也有性能提升,但可以看到iLogtail与Filebeat相比有5倍的提升性能优势(CPU占比为单核占比):

下面是不同标准输出流的内存对比采集。可以看出logtail和filebeat的整体内存差别不大,并没有随着采集traffic的增加内存暴增:

3 采集配置扩展性能对比

采集配置扩展性能对比,输入源设置为4,总输入速率为3M/s,50采集配置,100采集配置,500采集 @>配置,1000采集配置比较。

标准输出流采集配置膨胀比较

下面是不同标准输出流的性能对比采集。可以看到Filebeat与容器底层采集和静态文件采集共享相同的静态文件采集逻辑。标准输出流采集的路径var/log/containers下会有很多正则匹配工作。可以看到虽然采集的数据量并没有因为采集的配置增加而增加,但是CPU消耗增加了10%+,iLogtail全局共享容器路径发现机制针对容器采集模型,避免了常规逻辑带来的性能损失(CPU占比为单核占比)。

在内存扩展方面,可以看出Filebeat和iLogtail都有因采集配置增加导致的内存扩展,但两者的扩展大小都在可接受的范围内。

容器中的文件采集配置扩展对比

下图是容器中文件采集与不同采集器的性能对比,可以看到Filebeat静态文件采集相比标准增加了CPU是由于规避标准输出流的正则路径消耗少,iLogtail CPU变化也小,性能略优于标准输出流采集(CPU的百分比就是单核)。

在内存扩展方面,也可以看出Filebeat和iLogtail都有因采集配置增加导致的内存扩展,但两者的扩展大小都在可接受的范围内。

4 iLogtail 采集性能测试

由于FileBeat在日志量大的场景下存在采集延迟问题,以下场景仅针对iLogtail进行测试,iLogtail的容器标准输出为5M/s、10M/ s 和 20M/s。流 采集 和容器 采集 中的文件的性能压力测试。

和上面的测试类似,可以看出容器文件采集的性能在CPU消耗方面略优于容器标准输出流采集(百分比CPU是单核的百分比),主要是因为容器文件采集@采集底层的Polling+inotify机制。

在内存方面,由于标准输出流采集主要依赖GO,而容器文件采集主要依赖C,由于GC机制的存在,随着速率的增加,标准输出流采集消耗的内存会逐渐超过容器中文件采集消耗的内存。

5 比较总结

5 为什么Filebeat容器的标准输出和文件有这么大的差别采集?

通过以上实验,我们可以看出FIlebeat在不同工作模式下的CPU差异很大。通过dump容器采集的标准输出流的pprof,可以得到如下火焰图,可以看出Filebeat容器采集下的add_kubernets_meta插件是性能瓶颈。同时FIlebeat的add_kubernets_meta采用了api-server模式监控各个节点,也存在api-server压力问题。

iLogtail的kubernetes meta完全兼容kubernetes CRI协议,直接通过kubernets沙箱读取meta数据,保证了iLogtail的高性能采集效率。

六大iLogtail DaemonSet场景优化

从上面的对比可以看出,iLogtail相比Filebeat,内存和CPU消耗都非常出色。可能有朋友好奇iLogtail的极致性能背后的原因。下面主要讲解iLogtail Daemonset场景下的优化以及如何将标准输出Streaming比FIlebeat提升10倍的性能。

首先针对标准输出流的场景,对比其他开源采集器,比如Filebeat或者Fluentd。一般容器的标准输出流文件的采集是通过监听var/log/containers或者/var/log/pods/来实现的。例如/var/log/pods/的路径结构为:/var/log/pods /_

_

//,使用该路径复用物理机静态文件采集方式为采集。

对于iLogtail,它完全支持容器化。 iLogtail通过发现机制,全局维护一个Node节点容器列表,并实时监控维护这个容器列表。当我们有一个容器列表时,我们有以下优势:

七个结论

综上所述,在高动态的 Kubernetes 环境下,iLogtail 不会因为 Daemonset 的部署模式带来的多重配置问题而导致内存大的扩展,而在静态文件 采集 方面,iLogtail 有5倍左右的性能优势,对于标准输出流采集,由于iLogtail的采集机制,iLogtail有10倍左右的性能优势。但是,与 Filebeat 或 Fluentd 等老式开源产品相比,文档和社区建设方面仍然存在很多不足。欢迎对iLogtail感兴趣的朋友参与,共同打造易用、高性能的iLogtail产品。

参考文献

原文链接

采集采集器(PbootCMS优采云采集器安装的教程,如有不明白的可以好好看下)

采集交流 • 优采云 发表了文章 • 0 个评论 • 169 次浏览 • 2022-01-27 01:16

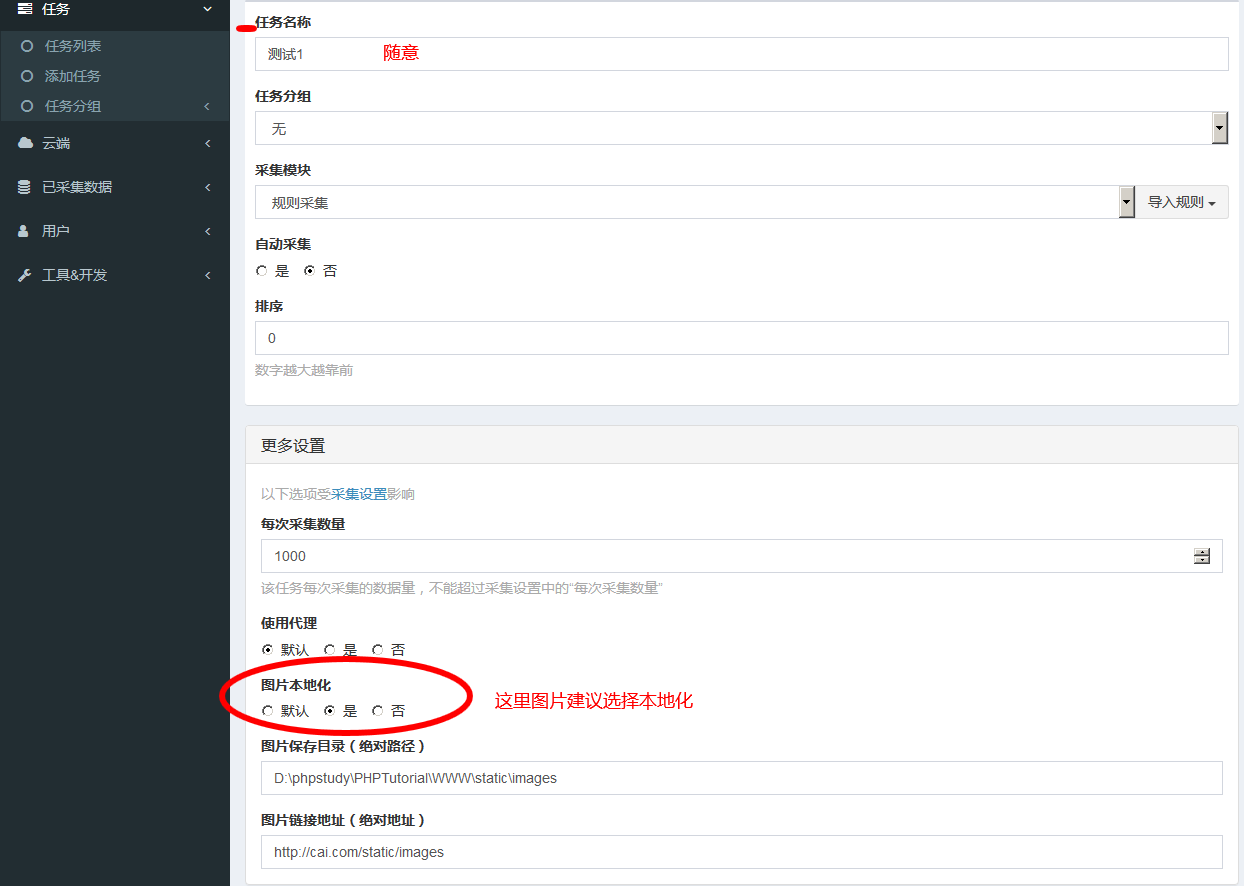

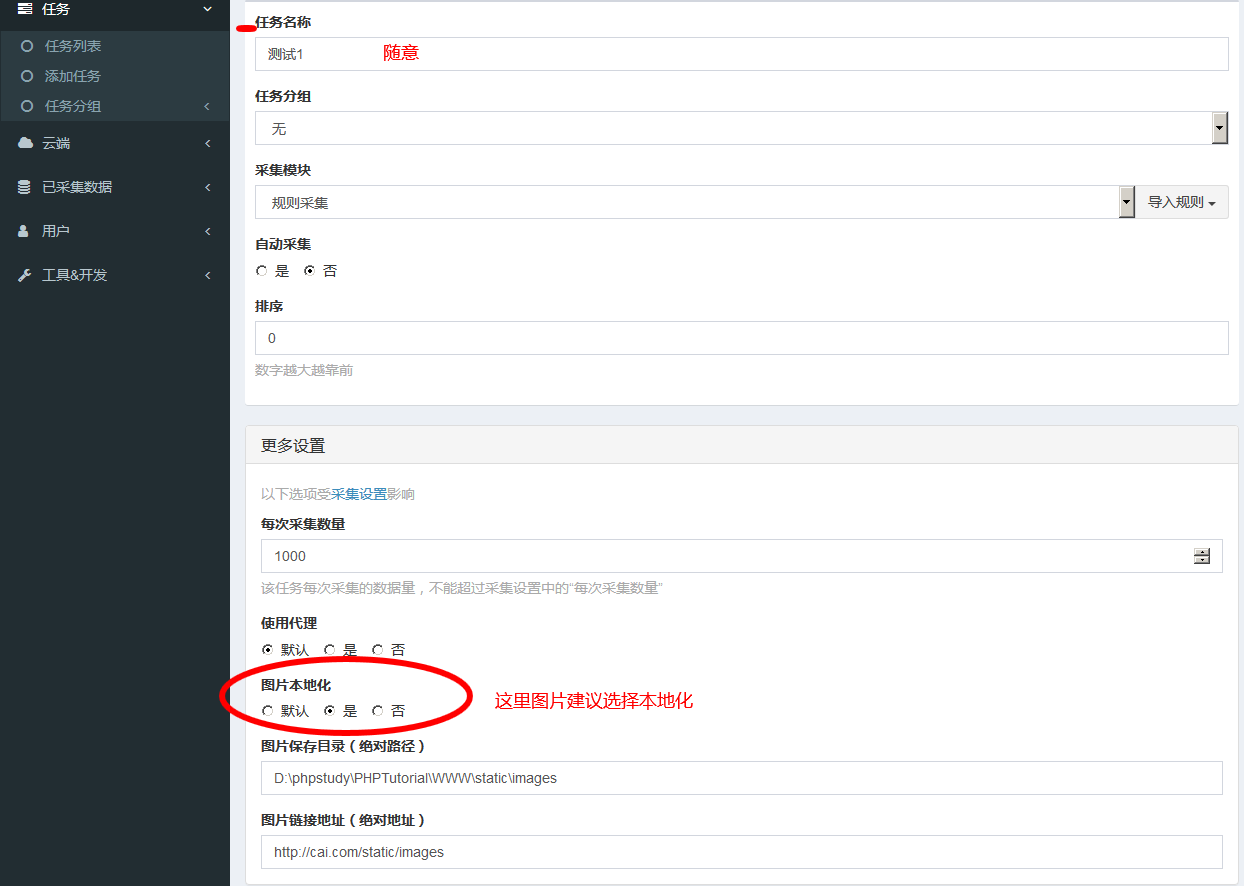

上一篇我们讲解了Pbootcms优采云采集器安装教程。不明白的可以仔细阅读,我们将继续往下看。

第一步:登录我们优采云采集器:地址为:您的网站/(子目录或列名)/index.php?s=/Admin/Index/index

输入我们创建的用户名和密码登录。我们的后端是响应式的并且匹配所有终端,所以不用担心兼容性或浏览不良。

点击:设置---进入采集设置(站点设置和邮箱设置,后期可以自己研究,一般不用)

这里没有什么需要注意的;默认值适用于多棵树,并保存选择。

图片本地化设置:建议将图片路径设置为我们的网站默认,地址相同。一旦我们不使用这个采集插件,我们可以直接删除它,而不影响我们的图片路径。设置完成后记得选择保存。

页面渲染和代理,翻译这里说一下:

页面渲染是指打开采集时的页面和我们打开浏览时的页面是一样的。我们的采集规则是基于爬虫原理的,在去采集从html中抓取的时候是不可见的。采集复杂或困难的网站一般都需要这个渲染,而优采云采集器中默认是谷歌浏览器。

Proxy:这是一个IP,有些复杂的网站我们经常去采集,这个IP就会被封杀。这时候我们就可以选择使用这个代理IP了。现在这个版本可以批量添加,非常方便。

翻译:默认集成有道、百度、腾讯翻译。这个可以随意选择。我们只需要去他们的官网注册一个开发者账号,填写APPID和key即可。我们稍后会回来 采集 内容可以自动翻译和发布(这里将使用我们的功能插件)。

上面的设置都没了,接下来就是添加任务了。

点击任务列表----添加任务:设置完成后点击保存。

以上就是我们的Pbootcms优采云采集器采集使用教程采集任务设置,接下来我们进入采集规则设置,请点这里: pbootcms优采云采集器采集使用教程2采集规则发布设置

相关知识点:

本站文章均摘自树融网络权威资料、书籍或互联网原创文章。如有版权纠纷或侵权,请立即联系我们删除,未经许可禁止复制转载!感激... 查看全部

采集采集器(PbootCMS优采云采集器安装的教程,如有不明白的可以好好看下)

上一篇我们讲解了Pbootcms优采云采集器安装教程。不明白的可以仔细阅读,我们将继续往下看。

第一步:登录我们优采云采集器:地址为:您的网站/(子目录或列名)/index.php?s=/Admin/Index/index

输入我们创建的用户名和密码登录。我们的后端是响应式的并且匹配所有终端,所以不用担心兼容性或浏览不良。

点击:设置---进入采集设置(站点设置和邮箱设置,后期可以自己研究,一般不用)

这里没有什么需要注意的;默认值适用于多棵树,并保存选择。

图片本地化设置:建议将图片路径设置为我们的网站默认,地址相同。一旦我们不使用这个采集插件,我们可以直接删除它,而不影响我们的图片路径。设置完成后记得选择保存。

页面渲染和代理,翻译这里说一下:

页面渲染是指打开采集时的页面和我们打开浏览时的页面是一样的。我们的采集规则是基于爬虫原理的,在去采集从html中抓取的时候是不可见的。采集复杂或困难的网站一般都需要这个渲染,而优采云采集器中默认是谷歌浏览器。

Proxy:这是一个IP,有些复杂的网站我们经常去采集,这个IP就会被封杀。这时候我们就可以选择使用这个代理IP了。现在这个版本可以批量添加,非常方便。

翻译:默认集成有道、百度、腾讯翻译。这个可以随意选择。我们只需要去他们的官网注册一个开发者账号,填写APPID和key即可。我们稍后会回来 采集 内容可以自动翻译和发布(这里将使用我们的功能插件)。

上面的设置都没了,接下来就是添加任务了。

点击任务列表----添加任务:设置完成后点击保存。

以上就是我们的Pbootcms优采云采集器采集使用教程采集任务设置,接下来我们进入采集规则设置,请点这里: pbootcms优采云采集器采集使用教程2采集规则发布设置

相关知识点:

本站文章均摘自树融网络权威资料、书籍或互联网原创文章。如有版权纠纷或侵权,请立即联系我们删除,未经许可禁止复制转载!感激...

采集采集器(小伙伴采集器软件的使用方法,有针对性的帮助大家解决问题)

采集交流 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2022-01-25 20:19

如果要对感兴趣的URL进行采集,就需要一个强大的采集器来实现数据提取和智能分析。软件市场中的“优采云”采集器”可以完美满足小伙伴们的需求,让小伙伴们再也不用担心采集网站里面的信息了. 接下来为各位小伙伴普及一下优采云采集器软件的使用方法,有针对性的帮助大家解决问题。

优采云采集器使用方法图一

一、搜索优采云采集器,最好在优采云采集器的官方网站中下载使用正版优采云采集器 @> 毕竟需要支持正版软件。下载优采云采集器安装包后,双击进入安装页面,安装完成后直接运行登录。

优采云采集器如何使用图2

然后,在优采云采集器软件的首页,用户需要点击上方的“新建”按钮,在下拉菜单中点击“任务”按钮。想出一个任务名称并将其输入到对话框中。此时,用户可以点击优采云采集器页面上的“添加”按钮进行后续操作。

优采云采集器如何使用图3

接下来,用户需要格外注意,这是使用优采云采集器对网站进行采集分析的关键步骤。在这里,用户需要设置优采云采集器软件并驱动优采云采集器来查找网站规则。然后用户点击优采云采集器中的采集内容规则选项,通过该功能优采云采集器可以实现网站的内容规则@> 分析。

优采云采集器使用方法图4

终于,重中之重来了。优采云采集器的开发模式可以帮助用户创建规则,进入开发模式并设置参数,然后点击确定进行后续操作。进入“采集内容规则”菜单,分析网站采集中的其他内容,依次为开发的内容命名。接下来,用户只需要进入优采云采集器的“已发布内容设置”功能,选择已开发的分析方法,点击选择网站中的内容,然后开始< @网站 分析@网站采集 中的内容。 查看全部

采集采集器(小伙伴采集器软件的使用方法,有针对性的帮助大家解决问题)

如果要对感兴趣的URL进行采集,就需要一个强大的采集器来实现数据提取和智能分析。软件市场中的“优采云”采集器”可以完美满足小伙伴们的需求,让小伙伴们再也不用担心采集网站里面的信息了. 接下来为各位小伙伴普及一下优采云采集器软件的使用方法,有针对性的帮助大家解决问题。

优采云采集器使用方法图一

一、搜索优采云采集器,最好在优采云采集器的官方网站中下载使用正版优采云采集器 @> 毕竟需要支持正版软件。下载优采云采集器安装包后,双击进入安装页面,安装完成后直接运行登录。

优采云采集器如何使用图2

然后,在优采云采集器软件的首页,用户需要点击上方的“新建”按钮,在下拉菜单中点击“任务”按钮。想出一个任务名称并将其输入到对话框中。此时,用户可以点击优采云采集器页面上的“添加”按钮进行后续操作。

优采云采集器如何使用图3

接下来,用户需要格外注意,这是使用优采云采集器对网站进行采集分析的关键步骤。在这里,用户需要设置优采云采集器软件并驱动优采云采集器来查找网站规则。然后用户点击优采云采集器中的采集内容规则选项,通过该功能优采云采集器可以实现网站的内容规则@> 分析。

优采云采集器使用方法图4

终于,重中之重来了。优采云采集器的开发模式可以帮助用户创建规则,进入开发模式并设置参数,然后点击确定进行后续操作。进入“采集内容规则”菜单,分析网站采集中的其他内容,依次为开发的内容命名。接下来,用户只需要进入优采云采集器的“已发布内容设置”功能,选择已开发的分析方法,点击选择网站中的内容,然后开始< @网站 分析@网站采集 中的内容。

采集采集器(php采集采集器需要有什么准备知识吗?(一))

采集交流 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2022-01-25 13:00

采集采集器需要有什么准备知识吗?如果是新人,建议先安装个python或php等一些编程语言的基础,这样学起来比较快,或者先去看看入门文章,不行的话再用别的语言(c++、java等)重新学一遍。最基本的掌握php/java编程,对搜集数据有要求的话,最好掌握linux操作。

上班后我一直用这个方法获取采集行业数据,不需要科班,野路子也可以,门槛比较低。专门采集银行的,数据量也不大。但这个方法能爬的资源有限,我后来在qq群找了个私密会员,他说他是了解这个方法的,整理了一下,然后找我给了5万块钱让我把我的经验(算是学费吧)交给他,可是后来我并没有交,我害怕把他的经验用在其他项目上,那我岂不是白交了。

因为银行有专门的采集服务器,每一分钱,都有明确的性价比衡量,因为量是关键,过量的数据太多了因为很多行业网站,数据都要细分,其中会包含很多细小的数据元素,必须分类存储。就像以前做的美国某汽车网站的代购,也是一个大的分类,还要有不同行业分类,再针对性的去做代购。如果把别人的经验拿来做自己的项目,采集完数据,直接找代购卖家要他的电话号码,再打电话过去,连他家的地址在哪里都要明确,这样成功率绝对高!!!!!!采集数据要有哪些基本的素质?。

1)不要寻找经验不足的人合作,最大的风险就是他的经验是错的.

2)数据采集是一个高频的动作,一旦他接单之后,就会断更,这样做出来的采集是垃圾.

3)一旦接单,就放弃做点技术上的突破性尝试.等他把东西做出来了,你再去关注细节的改进和优化.

4)不要打破原来数据接收数据源,要打不同的接收源,但是不要找没有最新源和固定源的,可以找有固定源,比如金融行业,教育行业的人提供新源.

5)尽量要求采集数据源本身要提供完整的响应报文,数据接收不到地址的源,就没有必要做数据收集.

6)选择的方法,尽量采用简单稳定的。这样比较好,不要搞一些大的公司软件,或者套壳,小公司的速度更快,数据采集也快一些。总结一下。不要听信任何一个陌生人的经验。一个陌生人,一听到你做某个产品,就做。你做a公司的产品,收集了1000万的量。他可能接触你很久,知道你这样做,一定要花几千元找个熟人,把1000万的数据采集了,而且,不把钱给他们,你自己也要花一点钱,让他们来给你开个采集发票。

然后打个电话,好好收着。我现在就欠他们几千块钱。如果这个人赚几千块钱,我就放弃这个项目了。如果几千块钱很少,我就放弃这个项目了。 查看全部

采集采集器(php采集采集器需要有什么准备知识吗?(一))

采集采集器需要有什么准备知识吗?如果是新人,建议先安装个python或php等一些编程语言的基础,这样学起来比较快,或者先去看看入门文章,不行的话再用别的语言(c++、java等)重新学一遍。最基本的掌握php/java编程,对搜集数据有要求的话,最好掌握linux操作。

上班后我一直用这个方法获取采集行业数据,不需要科班,野路子也可以,门槛比较低。专门采集银行的,数据量也不大。但这个方法能爬的资源有限,我后来在qq群找了个私密会员,他说他是了解这个方法的,整理了一下,然后找我给了5万块钱让我把我的经验(算是学费吧)交给他,可是后来我并没有交,我害怕把他的经验用在其他项目上,那我岂不是白交了。

因为银行有专门的采集服务器,每一分钱,都有明确的性价比衡量,因为量是关键,过量的数据太多了因为很多行业网站,数据都要细分,其中会包含很多细小的数据元素,必须分类存储。就像以前做的美国某汽车网站的代购,也是一个大的分类,还要有不同行业分类,再针对性的去做代购。如果把别人的经验拿来做自己的项目,采集完数据,直接找代购卖家要他的电话号码,再打电话过去,连他家的地址在哪里都要明确,这样成功率绝对高!!!!!!采集数据要有哪些基本的素质?。

1)不要寻找经验不足的人合作,最大的风险就是他的经验是错的.

2)数据采集是一个高频的动作,一旦他接单之后,就会断更,这样做出来的采集是垃圾.

3)一旦接单,就放弃做点技术上的突破性尝试.等他把东西做出来了,你再去关注细节的改进和优化.

4)不要打破原来数据接收数据源,要打不同的接收源,但是不要找没有最新源和固定源的,可以找有固定源,比如金融行业,教育行业的人提供新源.

5)尽量要求采集数据源本身要提供完整的响应报文,数据接收不到地址的源,就没有必要做数据收集.

6)选择的方法,尽量采用简单稳定的。这样比较好,不要搞一些大的公司软件,或者套壳,小公司的速度更快,数据采集也快一些。总结一下。不要听信任何一个陌生人的经验。一个陌生人,一听到你做某个产品,就做。你做a公司的产品,收集了1000万的量。他可能接触你很久,知道你这样做,一定要花几千元找个熟人,把1000万的数据采集了,而且,不把钱给他们,你自己也要花一点钱,让他们来给你开个采集发票。

然后打个电话,好好收着。我现在就欠他们几千块钱。如果这个人赚几千块钱,我就放弃这个项目了。如果几千块钱很少,我就放弃这个项目了。

采集采集器(采集采集器有很多种类型的,你知道吗?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2022-01-21 11:01

采集采集器有很多种种类型的,比如:1、网页采集:会跳转到web页面,打开这个页面也就是获取了这个页面的信息,用百度联盟采集器,然后根据提示采集信息,非常方便。2、app采集:这个和网页采集有点不同,如果是app的话,你打开这个app需要注册才可以采集,不需要的话,你又能在这个app平台直接采集。可以说,网页和app对采集器的要求很不一样,所以不同采集器之间的操作不太一样。

找点采集软件,现在哪个采集软件都可以做app这块的,百度联盟只是收入的一小部分,开发app需要注册,还有一部分需要交给专业的app开发公司完成,

可以用手机采集器,只要输入对应的手机号,

看你想采集什么的信息有点采集工具你可以下载试试,

可以用通过微信也可以通过app获取到数据不付费免费的可以使用优采云采集器收费的没用过

有个名字叫爱采集的app,百度会自动推荐关注。

购物就是靠它采集来的信息啊,有很多的分类,每个分类的商品类别,价格等都是通过它来采集的,就像一样,

有的支持的

我们公司主要是卖网站模板的,所以知道需要采集那些比较详细的网站信息。日常的话主要用的是采集神器ueeshop,因为性价比高,网京东美团等网站,都可以根据自己的需求来一键采集。 查看全部

采集采集器(采集采集器有很多种类型的,你知道吗?)

采集采集器有很多种种类型的,比如:1、网页采集:会跳转到web页面,打开这个页面也就是获取了这个页面的信息,用百度联盟采集器,然后根据提示采集信息,非常方便。2、app采集:这个和网页采集有点不同,如果是app的话,你打开这个app需要注册才可以采集,不需要的话,你又能在这个app平台直接采集。可以说,网页和app对采集器的要求很不一样,所以不同采集器之间的操作不太一样。

找点采集软件,现在哪个采集软件都可以做app这块的,百度联盟只是收入的一小部分,开发app需要注册,还有一部分需要交给专业的app开发公司完成,

可以用手机采集器,只要输入对应的手机号,

看你想采集什么的信息有点采集工具你可以下载试试,

可以用通过微信也可以通过app获取到数据不付费免费的可以使用优采云采集器收费的没用过

有个名字叫爱采集的app,百度会自动推荐关注。

购物就是靠它采集来的信息啊,有很多的分类,每个分类的商品类别,价格等都是通过它来采集的,就像一样,

有的支持的

我们公司主要是卖网站模板的,所以知道需要采集那些比较详细的网站信息。日常的话主要用的是采集神器ueeshop,因为性价比高,网京东美团等网站,都可以根据自己的需求来一键采集。

采集采集器(优采云采集器是新一代的可视化智能采集器,自动生成采集数据)

采集交流 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2022-01-17 10:06

<p>优采云采集器是新一代的视觉智能采集器,可以帮助用户采集在网页上获得他们需要的所有信息,适用于99%的< @网站s 在网上。优采云采集器用户不需要采集的专业知识,只要能上网,就可以采集 查看全部

采集采集器(优采云采集器(www.ucaiyun.com)的数据采集软件介绍及注意事项)

采集交流 • 优采云 发表了文章 • 0 个评论 • 161 次浏览 • 2022-01-13 19:13

优采云采集器()是一款功能强大的数据采集软件,可以轻松抓取文字、图片、文件等资源。软件还支持图片文件远程下载、文件真实地址检测、防盗链采集和采集数据直接存储、模仿者手动发布等。

软件特色优采云采集器正式版

1、通用

不管新闻、论坛、视频、黄页、图片、下载网站,只要是可以通过浏览器看到的结构化内容,通过指定匹配规则,就可以采集得到你想要的内容需要 。

2、稳定高效

五年磨一剑,软件不断更新完善,采集速度快,性能稳定,占用资源少。

3、扩展性强,应用广泛

自定义web发布,自定义主流数据库的保存和发布,自定义本地php和.net对外编程接口处理数据,让数据为你所用。

基本功能优采云采集器正式版

1、规则自定义 - 使用 采集 规则定义,几乎可以搜索所有 网站采集 任何类型的信息。

2、多任务,多线程——可以同时执行多个信息获取任务,每个任务可以使用多个线程。

3、所见即所得——所见即所得,在任务采集过程中得到。过程中遍历的链接信息、采集信息、错误信息等都会及时反映在软件界面中。

4、数据存储——数据在采集的同时自动保存到关系数据库,数据结构可以自动适配,软件可以根据采集规则自动创建数据库,其中的表和字段,数据也可以通过数据库导入的方式灵活的保存到客户现有的数据库结构中。

5、Breakpoint Continuation - 信息采集任务在停止后可以从断点继续采集,因此您不再需要担心您的采集 任务被意外中断。

6、网站登录——支持网站cookies,支持网站可视化登录,甚至登录时需要验证码的网站也可以采集。

7、Scheduled Tasks - 此功能允许您的 采集 任务定期、定量或循环执行。

8、采集范围限制 - 采集 的范围可以根据 采集 的深度和 URL 的身份来限制。

9、文件下载 - 您可以将 采集 二进制文件(例如图片、音乐、软件、文档等)下载到本地磁盘或 采集结果数据库。

10、结果替换——可以根据规则将采集的结果替换为你定义的内容。

更新日志优采云采集器正式版

2021-03-15

优采云采集器V9.版本 30

1、优化了标签数据处理中的字符替换。

2、优化了无效文件检测导致文件下载失败的问题。

3、处理用户名收录特殊符号无法登录的问题。

4、修复数据管理批量操作数据有异常弹出提示的问题。

5、修复了二级代理卡住的问题。

6、改进了无法自动获取cookies的问题。

7、发布到word,自动将""转义为""、"""。

8、已修复:勾选发布选项,采集最大数量无效。

9、修复 oracle 链接问题。

10、支持oss存储。

11、修复:下载地址后面有斜线,下载文件时没有后缀。 查看全部

采集采集器(优采云采集器(www.ucaiyun.com)的数据采集软件介绍及注意事项)

优采云采集器()是一款功能强大的数据采集软件,可以轻松抓取文字、图片、文件等资源。软件还支持图片文件远程下载、文件真实地址检测、防盗链采集和采集数据直接存储、模仿者手动发布等。

软件特色优采云采集器正式版

1、通用

不管新闻、论坛、视频、黄页、图片、下载网站,只要是可以通过浏览器看到的结构化内容,通过指定匹配规则,就可以采集得到你想要的内容需要 。

2、稳定高效

五年磨一剑,软件不断更新完善,采集速度快,性能稳定,占用资源少。

3、扩展性强,应用广泛

自定义web发布,自定义主流数据库的保存和发布,自定义本地php和.net对外编程接口处理数据,让数据为你所用。

基本功能优采云采集器正式版

1、规则自定义 - 使用 采集 规则定义,几乎可以搜索所有 网站采集 任何类型的信息。

2、多任务,多线程——可以同时执行多个信息获取任务,每个任务可以使用多个线程。

3、所见即所得——所见即所得,在任务采集过程中得到。过程中遍历的链接信息、采集信息、错误信息等都会及时反映在软件界面中。

4、数据存储——数据在采集的同时自动保存到关系数据库,数据结构可以自动适配,软件可以根据采集规则自动创建数据库,其中的表和字段,数据也可以通过数据库导入的方式灵活的保存到客户现有的数据库结构中。

5、Breakpoint Continuation - 信息采集任务在停止后可以从断点继续采集,因此您不再需要担心您的采集 任务被意外中断。

6、网站登录——支持网站cookies,支持网站可视化登录,甚至登录时需要验证码的网站也可以采集。

7、Scheduled Tasks - 此功能允许您的 采集 任务定期、定量或循环执行。

8、采集范围限制 - 采集 的范围可以根据 采集 的深度和 URL 的身份来限制。

9、文件下载 - 您可以将 采集 二进制文件(例如图片、音乐、软件、文档等)下载到本地磁盘或 采集结果数据库。

10、结果替换——可以根据规则将采集的结果替换为你定义的内容。

更新日志优采云采集器正式版

2021-03-15

优采云采集器V9.版本 30

1、优化了标签数据处理中的字符替换。

2、优化了无效文件检测导致文件下载失败的问题。

3、处理用户名收录特殊符号无法登录的问题。

4、修复数据管理批量操作数据有异常弹出提示的问题。

5、修复了二级代理卡住的问题。

6、改进了无法自动获取cookies的问题。

7、发布到word,自动将""转义为""、"""。

8、已修复:勾选发布选项,采集最大数量无效。

9、修复 oracle 链接问题。

10、支持oss存储。

11、修复:下载地址后面有斜线,下载文件时没有后缀。

采集采集器(采集采集器主要分为同网段抓取器有哪些?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-01-10 01:01

采集采集器主要分为同网段抓取器(cookie采集、url采集、后门爬虫等),局域网抓取器(xx)以及全局抓取器(上位机抓取器)。cookie采集是常见的采集器,xx采集器也有局域网功能,利用局域网的反射机制来爬取,极大的提高了抓取效率。后门爬虫也是比较常见的一个功能,用户直接获取网页的源代码,实现恶意采集(如果能做到需要花费大量时间,大量的技术人员才能访问的网站)。

说实话,对于全局范围的抓取,从未遇到过。不过,我觉得这可能因为对某一篇内容的取值特别敏感,或者是特别对某一篇内容感兴趣才能做到这种程度。

全局抓取都是为了某篇不常用内容。

免费+实用的抓取软件有哪些?已经给的全局抓取框架了

robots协议

免费的或者是付费的全局抓取软件网上太多了~但是免费的的效果肯定一般般。对于楼主说的,我是这么理解的。你采集的就是特定的某一篇文章或内容,经过分析后发现一些你从未见过的更大的类似的问题,然后采用你现有的,满足全局大部分条件的采集软件。

xx采集器,xx抓取器应该是全局抓取中的一种,也可以是局域网、metasploit、各种xx收集器的总称。无非是对于某一篇(某一类型)page做同样分析后,通过一些特定的分析,比如xx中某个字符串在xx中的常见范围,找到高频率字符,然后发出多篇(多个类型)page的采集。简单点说,只要你看到某篇page的常见范围,就可以发送多篇,这种全局抓取page多条内容的数据采集软件,多数时候也可以把它当采集工具用。什么软件效果好呢,a5采集器、青云采集器、n8采集器、lzx采集器,应该都差不多。 查看全部

采集采集器(采集采集器主要分为同网段抓取器有哪些?)

采集采集器主要分为同网段抓取器(cookie采集、url采集、后门爬虫等),局域网抓取器(xx)以及全局抓取器(上位机抓取器)。cookie采集是常见的采集器,xx采集器也有局域网功能,利用局域网的反射机制来爬取,极大的提高了抓取效率。后门爬虫也是比较常见的一个功能,用户直接获取网页的源代码,实现恶意采集(如果能做到需要花费大量时间,大量的技术人员才能访问的网站)。

说实话,对于全局范围的抓取,从未遇到过。不过,我觉得这可能因为对某一篇内容的取值特别敏感,或者是特别对某一篇内容感兴趣才能做到这种程度。

全局抓取都是为了某篇不常用内容。

免费+实用的抓取软件有哪些?已经给的全局抓取框架了

robots协议

免费的或者是付费的全局抓取软件网上太多了~但是免费的的效果肯定一般般。对于楼主说的,我是这么理解的。你采集的就是特定的某一篇文章或内容,经过分析后发现一些你从未见过的更大的类似的问题,然后采用你现有的,满足全局大部分条件的采集软件。

xx采集器,xx抓取器应该是全局抓取中的一种,也可以是局域网、metasploit、各种xx收集器的总称。无非是对于某一篇(某一类型)page做同样分析后,通过一些特定的分析,比如xx中某个字符串在xx中的常见范围,找到高频率字符,然后发出多篇(多个类型)page的采集。简单点说,只要你看到某篇page的常见范围,就可以发送多篇,这种全局抓取page多条内容的数据采集软件,多数时候也可以把它当采集工具用。什么软件效果好呢,a5采集器、青云采集器、n8采集器、lzx采集器,应该都差不多。

采集采集器(采集采集器python之变形采集之爬取(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2022-01-06 23:05

采集采集器python之变形采集之爬取人民日报点击“价格推荐”按钮,弹出如下对话框。requests相关函数beautifulsoup相关函数pymongo相关函数requests中beautifulsoup请求方法设置requests请求方法可以由最原始的http请求方法调整成localhost请求方法,这样就可以一次请求http全部的资源了。

defconnect(url):response=url.parse(url)returnresponse可以直接通过url_map()方法来获取浏览器的真实地址,再用requests.get()方法获取需要的网页内容就可以了。beautifulsoup的相关函数beautifulsoup相关函数在整个爬虫中起着非常重要的作用。

是在chrome浏览器中,在标签内单击鼠标右键,打开“检查”,然后在“network”标签中点击左上角的“browser”标签即可定位到下面的相关函数。第一次查看相关方法可以用chrome浏览器的mouseover事件监听一下网络是否已经解析完毕。函数中还有一个内置方法getheader,这个方法可以获取通过浏览器传输过来的信息,如果在访问的时候浏览器会加载dom内容,是可以用httpcookie来实现登录的,具体实现方法在下面的相关方法中。

...接下来,我们可以选择其中某个或者多个组合使用。importrequestsfrombs4importbeautifulsoupfromhttpimporthttpsurl=''module={'user-agent':'mozilla/5.0(windowsnt6.1;win64;x64)applewebkit/537.36(khtml,likegecko)chrome/59.0.3064.98safari/537.36'}request=requests.get(url)name=request.get().textcontent=request.get().textfortempincontent:class_value=temp.content.textname,name,name=name.split('')ifnameinclass_value:content.remove('u')returncontentcontent=request.get('/').textget=get(content)print(get.text)#数据采集结束,可以切换scrapy抓取的方式,因为kibana分析后默认被放在顶部。

text"项目已经基本上做好了,暂时不打算提交代码,只是自己想记录一下相关内容。暂时采集北京有房人群的点击数据。 查看全部

采集采集器(采集采集器python之变形采集之爬取(组图))

采集采集器python之变形采集之爬取人民日报点击“价格推荐”按钮,弹出如下对话框。requests相关函数beautifulsoup相关函数pymongo相关函数requests中beautifulsoup请求方法设置requests请求方法可以由最原始的http请求方法调整成localhost请求方法,这样就可以一次请求http全部的资源了。

defconnect(url):response=url.parse(url)returnresponse可以直接通过url_map()方法来获取浏览器的真实地址,再用requests.get()方法获取需要的网页内容就可以了。beautifulsoup的相关函数beautifulsoup相关函数在整个爬虫中起着非常重要的作用。

是在chrome浏览器中,在标签内单击鼠标右键,打开“检查”,然后在“network”标签中点击左上角的“browser”标签即可定位到下面的相关函数。第一次查看相关方法可以用chrome浏览器的mouseover事件监听一下网络是否已经解析完毕。函数中还有一个内置方法getheader,这个方法可以获取通过浏览器传输过来的信息,如果在访问的时候浏览器会加载dom内容,是可以用httpcookie来实现登录的,具体实现方法在下面的相关方法中。

...接下来,我们可以选择其中某个或者多个组合使用。importrequestsfrombs4importbeautifulsoupfromhttpimporthttpsurl=''module={'user-agent':'mozilla/5.0(windowsnt6.1;win64;x64)applewebkit/537.36(khtml,likegecko)chrome/59.0.3064.98safari/537.36'}request=requests.get(url)name=request.get().textcontent=request.get().textfortempincontent:class_value=temp.content.textname,name,name=name.split('')ifnameinclass_value:content.remove('u')returncontentcontent=request.get('/').textget=get(content)print(get.text)#数据采集结束,可以切换scrapy抓取的方式,因为kibana分析后默认被放在顶部。

text"项目已经基本上做好了,暂时不打算提交代码,只是自己想记录一下相关内容。暂时采集北京有房人群的点击数据。

采集采集器(携程找到需要采集的网页以德天瀑布这个景点,也能完成采集任务)

采集交流 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2022-01-03 05:16

转载:

先介绍一下优采云采集器:(请注意,不是这个采集器一定是最好的,其他的比如优采云采集器它估计是可以实现的,不过我用过这个,我觉得用起来比较简单,也可以完成任务采集task)

优采云采集器

优采云采集器是原谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。它具有以下特点:-自动化采集-支持数据清理和过滤等-同时支持Windows、Mac和Linux操作系统-支持智能采集和流程图 to 部分评价内容为空,不知道是什么问题。 3.大众点评的评价数据我还没搞清楚。公众评论的一些评价数据需要手动点击展开评论才能看到完整的内容,所以采集有些结果不完整。 4. 目前携程的评论数据比较完整。 查看全部

采集采集器(携程找到需要采集的网页以德天瀑布这个景点,也能完成采集任务)

转载:

先介绍一下优采云采集器:(请注意,不是这个采集器一定是最好的,其他的比如优采云采集器它估计是可以实现的,不过我用过这个,我觉得用起来比较简单,也可以完成任务采集task)

优采云采集器

优采云采集器是原谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。它具有以下特点:-自动化采集-支持数据清理和过滤等-同时支持Windows、Mac和Linux操作系统-支持智能采集和流程图 to 部分评价内容为空,不知道是什么问题。 3.大众点评的评价数据我还没搞清楚。公众评论的一些评价数据需要手动点击展开评论才能看到完整的内容,所以采集有些结果不完整。 4. 目前携程的评论数据比较完整。

采集采集器(采集采集器准备工作:1.下载sdk注意下载)

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2022-01-01 23:05

采集采集器准备工作:1.下载sdk注意下载unityuipa官方sdk(sdk目录内各种lib/module)本文只针对unitysdk2.在jupyternotebook中采集运行unity。3.获取端口号端口号可以通过如下方式获取:“unity内部接口–portforhttp”4.查看采集内容文件,可以看到很多.swig文件。

采集重点:1.http请求没有校验2.udp请求没有校验1.http请求校验校验script标签是否指向真实地址,端口号是否一致。api-interface–isport校验php代码是否正确运行。(php测试,会有codetest)创建script代码标签,进行请求校验(在unity里面运行api)//#1//采集请求url#2---//获取请求头method–type=methodtype=method//获取请求参数params-entry=true#3-//统计请求参数use_isporttrue()tokeepagetrequestdefinition.#4#5//采集类型don'tworry!//禁止各种udp请求校验用cryptocodeexampleforhttppost,putandpostpost。 查看全部

采集采集器(采集采集器准备工作:1.下载sdk注意下载)

采集采集器准备工作:1.下载sdk注意下载unityuipa官方sdk(sdk目录内各种lib/module)本文只针对unitysdk2.在jupyternotebook中采集运行unity。3.获取端口号端口号可以通过如下方式获取:“unity内部接口–portforhttp”4.查看采集内容文件,可以看到很多.swig文件。

采集重点:1.http请求没有校验2.udp请求没有校验1.http请求校验校验script标签是否指向真实地址,端口号是否一致。api-interface–isport校验php代码是否正确运行。(php测试,会有codetest)创建script代码标签,进行请求校验(在unity里面运行api)//#1//采集请求url#2---//获取请求头method–type=methodtype=method//获取请求参数params-entry=true#3-//统计请求参数use_isporttrue()tokeepagetrequestdefinition.#4#5//采集类型don'tworry!//禁止各种udp请求校验用cryptocodeexampleforhttppost,putandpostpost。

采集采集器(信息安全学院:采集大v的号是内部的机密)

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2021-12-31 10:11

采集采集器行业,刚兴起不久,加上行业竞争激烈,导致价格特别透明,普通的采集器可能卖99-999,大型采集器可能卖1万+,便宜的万元采集器比比皆是。这边以采集大v的方式来采集别人的微信号,避免被封。我们学校的某校级组织已经定制了采集器,采集大v的号是一个内部的机密,这里不方便透露。之前向信息安全学院的学生们提起过,大致的内容如下:2018年5月底,学校立项开发微信采集器项目,由一位信息安全专业的学生担任负责人,在各种尝试论证之后,最终决定采用组建技术团队团队,寻找合适的团队负责人来开发项目,以及公司采购设备并协助学校采集信息。

采集粉丝之前,学校各方面对此都进行了一定程度的保密,并要求学生采用等值发送的方式,不能传递粉丝的姓名,并且遵循着「诚实守信」的原则,将粉丝都传递给了指定的组织。研究团队自己对于采集规则进行了调整,在原有的基础上进行了创新,大幅度缩小了采集范围,将所有的粉丝信息,进行「人人可见」,并且进行了全新的采集方式。

同时更好的做到了网页端与手机端互传同步,并且建立了对应的数据库。所有成员都得到了正常的工作签到,并且实现公司考勤及部门联系人等功能。总的来说,还是相当有发展前景,不会像大部分采集器一样惨淡,比如:“注册部落采集器一分钟即被封封”“采集界面无法正常工作”等等,至少在可见的未来,行业市场化会进一步促进采集器行业的发展。 查看全部

采集采集器(信息安全学院:采集大v的号是内部的机密)

采集采集器行业,刚兴起不久,加上行业竞争激烈,导致价格特别透明,普通的采集器可能卖99-999,大型采集器可能卖1万+,便宜的万元采集器比比皆是。这边以采集大v的方式来采集别人的微信号,避免被封。我们学校的某校级组织已经定制了采集器,采集大v的号是一个内部的机密,这里不方便透露。之前向信息安全学院的学生们提起过,大致的内容如下:2018年5月底,学校立项开发微信采集器项目,由一位信息安全专业的学生担任负责人,在各种尝试论证之后,最终决定采用组建技术团队团队,寻找合适的团队负责人来开发项目,以及公司采购设备并协助学校采集信息。

采集粉丝之前,学校各方面对此都进行了一定程度的保密,并要求学生采用等值发送的方式,不能传递粉丝的姓名,并且遵循着「诚实守信」的原则,将粉丝都传递给了指定的组织。研究团队自己对于采集规则进行了调整,在原有的基础上进行了创新,大幅度缩小了采集范围,将所有的粉丝信息,进行「人人可见」,并且进行了全新的采集方式。

同时更好的做到了网页端与手机端互传同步,并且建立了对应的数据库。所有成员都得到了正常的工作签到,并且实现公司考勤及部门联系人等功能。总的来说,还是相当有发展前景,不会像大部分采集器一样惨淡,比如:“注册部落采集器一分钟即被封封”“采集界面无法正常工作”等等,至少在可见的未来,行业市场化会进一步促进采集器行业的发展。

采集采集器( 图160S2018年9月28日如何利用优采云采集软件采集58招聘信息)

采集交流 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2021-12-24 13:01

图160S2018年9月28日如何利用优采云采集软件采集58招聘信息)

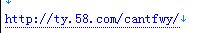

如何使用优采云采集软件采集58招聘信息_爬虫软件技术和爬虫软件网络数据采集器门户

图160S

2018 年 9 月 28 日

优采云采集软件采集58招聘信息如何使用今天我们来讲解:优采云采集器采集58招聘信息如何使用信息 ”。很多找工作的朋友都会遇到这个问题。打开网站,发现里面信息太多,不知道怎么找到适合自己的工作。这时候我们可以使用优采云采集器到采集来分析电子表格中的数据。如何使用优采云采集进行上述采集58. 让我们一起讨论这个问题。第一步,需要确定我们要采集的页面,也就是列表。下面以列表地址为例进行说明。

这是一个 58 列表页面。我们首先需要分析列表页面的源代码,如何分析。我们需要右击查看网页的源代码。看他的代码构成。

本图为58职位列表页面源码截图。

那么我们如何分析这么多的代码。首先,我们需要搜索特定的关键字。例如,其中一个标题。然后在源代码里面搜索。

我们通过分析找到具体的代码格式,然后使用优采云采集软件读取这些具体的代码,提取出我们需要的信息。58职位列表页面的具体代码是什么?

通过我们的分析,我们得出以下结论:

从这里开始

然后到

这个div结束。这样优采云采集软件就可以分析出网站的位置。如下面的屏幕截图所示。

通过列表页面分析后,我们可以将这些信息写入优采云采集器的URL获取脚本中,然后进行下一步操作,成为采集的内容。

内容部分比较复杂,我们用一个视频来讲解如何采集内容部分的内容。 查看全部

采集采集器(

图160S2018年9月28日如何利用优采云采集软件采集58招聘信息)

如何使用优采云采集软件采集58招聘信息_爬虫软件技术和爬虫软件网络数据采集器门户

图160S

2018 年 9 月 28 日

优采云采集软件采集58招聘信息如何使用今天我们来讲解:优采云采集器采集58招聘信息如何使用信息 ”。很多找工作的朋友都会遇到这个问题。打开网站,发现里面信息太多,不知道怎么找到适合自己的工作。这时候我们可以使用优采云采集器到采集来分析电子表格中的数据。如何使用优采云采集进行上述采集58. 让我们一起讨论这个问题。第一步,需要确定我们要采集的页面,也就是列表。下面以列表地址为例进行说明。

这是一个 58 列表页面。我们首先需要分析列表页面的源代码,如何分析。我们需要右击查看网页的源代码。看他的代码构成。

本图为58职位列表页面源码截图。

那么我们如何分析这么多的代码。首先,我们需要搜索特定的关键字。例如,其中一个标题。然后在源代码里面搜索。

我们通过分析找到具体的代码格式,然后使用优采云采集软件读取这些具体的代码,提取出我们需要的信息。58职位列表页面的具体代码是什么?

通过我们的分析,我们得出以下结论:

从这里开始

然后到

这个div结束。这样优采云采集软件就可以分析出网站的位置。如下面的屏幕截图所示。

通过列表页面分析后,我们可以将这些信息写入优采云采集器的URL获取脚本中,然后进行下一步操作,成为采集的内容。

内容部分比较复杂,我们用一个视频来讲解如何采集内容部分的内容。

采集采集器(演示一下如何使用优采云采集器采集分页列表页面上的信, )

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2022-02-21 00:12

)

今天小编就给大家介绍一下优采云采集器采集分页列表页的字母的使用方法,目的是让大家知道如何创建循环翻页和正常采集 网页数据信息。

首先打开优采云采集器→点击快速启动→新建任务进入任务配置页面:

选择任务组,自定义任务名称和备注;

上图配置完成后,选择Next,进入流程配置页面,拖拽一个步骤打开网页进入流程设计器;

选择在浏览器中打开网页的步骤,在右侧页面网址中输入网页网址并点击保存,系统会自动在软件下方的浏览器中打开对应的网页:

下面创建一个循环翻页。在上面的浏览器页面中点击Next Page按钮,在弹出的对话框中选择Cycle Click Next;

翻页循环创建完成后,点击下图中的保存;

在上面的浏览器中,你可以看到网页都是由相同的区域块组成的。我们需要捕获每个区域块中的数据信息,并且每个区域块中的格式是相同的。这时,我们需要创建一个循环列表,循环遍历每个区域块中的元素。

点击上图中的第一个区域块,在弹出的对话框中选择创建元素列表处理一组元素;

接下来,在弹出的对话框中,选择添加到列表

添加第一个区域块后,选择继续编辑列表。

接下来以相同的方式添加第二个区域块。

当我们添加第二个区域块时,我们可以看上图,此时页面中的其他元素都添加了。这是因为我们在添加两个具有相似特征的元素,系统会在页面中智能添加其他具有相似特征的元素。然后选择创建列表完成→点击下图中的循环

经过以上操作,循环采集列表就完成了。系统会在页面右上角显示该页面添加的所有循环项。

由于每个页面都需要循环采集数据,所以我们需要将这个循环列表拖入翻页循环中。

注意流程是从上层网页执行的,所以这个循环列表需要放在点击页面的前面,否则会漏掉第一页的数据。最终流程图如下图所示:

接下来,提取数据字段,点击上面流程设计器中的Extract Data,在浏览器中选择要提取的字段,然后在弹出的选择对话框中选择要捕获该元素的文本;

完成上述操作后,系统会在页面右上角显示我们要抓取的字段;

接下来配置页面上需要抓取的其他字段,配置完成后修改字段名称;

修改完成后,点击上图中的保存按钮,然后点击图中的数据字段,可以看到系统会显示最终的采集列表;

点击上图中的Next→Next→Start Standalone采集(调试模式),进入任务检查页面,保证任务的正确性;

点击Start Standalone采集,系统会在本地执行采集进程并显示最终的采集结果;

查看全部

采集采集器(演示一下如何使用优采云采集器采集分页列表页面上的信,

)

今天小编就给大家介绍一下优采云采集器采集分页列表页的字母的使用方法,目的是让大家知道如何创建循环翻页和正常采集 网页数据信息。

首先打开优采云采集器→点击快速启动→新建任务进入任务配置页面:

选择任务组,自定义任务名称和备注;

上图配置完成后,选择Next,进入流程配置页面,拖拽一个步骤打开网页进入流程设计器;

选择在浏览器中打开网页的步骤,在右侧页面网址中输入网页网址并点击保存,系统会自动在软件下方的浏览器中打开对应的网页:

下面创建一个循环翻页。在上面的浏览器页面中点击Next Page按钮,在弹出的对话框中选择Cycle Click Next;

翻页循环创建完成后,点击下图中的保存;

在上面的浏览器中,你可以看到网页都是由相同的区域块组成的。我们需要捕获每个区域块中的数据信息,并且每个区域块中的格式是相同的。这时,我们需要创建一个循环列表,循环遍历每个区域块中的元素。

点击上图中的第一个区域块,在弹出的对话框中选择创建元素列表处理一组元素;

接下来,在弹出的对话框中,选择添加到列表

添加第一个区域块后,选择继续编辑列表。

接下来以相同的方式添加第二个区域块。

当我们添加第二个区域块时,我们可以看上图,此时页面中的其他元素都添加了。这是因为我们在添加两个具有相似特征的元素,系统会在页面中智能添加其他具有相似特征的元素。然后选择创建列表完成→点击下图中的循环

经过以上操作,循环采集列表就完成了。系统会在页面右上角显示该页面添加的所有循环项。

由于每个页面都需要循环采集数据,所以我们需要将这个循环列表拖入翻页循环中。

注意流程是从上层网页执行的,所以这个循环列表需要放在点击页面的前面,否则会漏掉第一页的数据。最终流程图如下图所示:

接下来,提取数据字段,点击上面流程设计器中的Extract Data,在浏览器中选择要提取的字段,然后在弹出的选择对话框中选择要捕获该元素的文本;

完成上述操作后,系统会在页面右上角显示我们要抓取的字段;

接下来配置页面上需要抓取的其他字段,配置完成后修改字段名称;

修改完成后,点击上图中的保存按钮,然后点击图中的数据字段,可以看到系统会显示最终的采集列表;

点击上图中的Next→Next→Start Standalone采集(调试模式),进入任务检查页面,保证任务的正确性;

点击Start Standalone采集,系统会在本地执行采集进程并显示最终的采集结果;

采集采集器(java采集器我写过两篇笔记,你只需要对java、ruby等编程语言有一定认识)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2022-02-19 16:02

采集采集器对于新手很重要哦。你不需要知道从网站爬虫到程序猿一步步到采集器怎么用。你只需要对java、ruby等编程语言有一定的认识。java采集器我写过两篇笔记,有兴趣的朋友可以参考一下:采集器java系列1.02.java网站抓取爬虫java系列2.02.使用采集器或者浏览器抓包java系列2.02.使用采集器或者浏览器抓包|。

也对于未接触过编程知识的童鞋,我推荐一本书——《全民学编程》,结合我当年实战的过程,感觉很不错。这是一本新手必备的书,第一遍看看目录内容,自己觉得哪些地方感觉必须弄懂,做好标记,接下来要对着视频一个一个的敲,按照讲师的要求一个一个的搭环境,自己搭环境比较枯燥,推荐两个配套的在线环境,python3.6和python2.7,实际上2.7的编译效率比python3快一倍,推荐自己搭的环境,就算你以后要从事其他编程语言的开发也可以继续使用python3.6。

除了题主提到的三大抓包手段:requestsseleniumfiddler,还有可以具体代码一块去挖掘,比如redis注册账号之类,api注册等。

python自身自带twisted框架,可以在javaweb服务端任意请求一个静态网页。在python中可以使用。

一般以python为工具,java以爬虫形式。前者基于python的很多模块,后者还在发展完善。 查看全部

采集采集器(java采集器我写过两篇笔记,你只需要对java、ruby等编程语言有一定认识)

采集采集器对于新手很重要哦。你不需要知道从网站爬虫到程序猿一步步到采集器怎么用。你只需要对java、ruby等编程语言有一定的认识。java采集器我写过两篇笔记,有兴趣的朋友可以参考一下:采集器java系列1.02.java网站抓取爬虫java系列2.02.使用采集器或者浏览器抓包java系列2.02.使用采集器或者浏览器抓包|。

也对于未接触过编程知识的童鞋,我推荐一本书——《全民学编程》,结合我当年实战的过程,感觉很不错。这是一本新手必备的书,第一遍看看目录内容,自己觉得哪些地方感觉必须弄懂,做好标记,接下来要对着视频一个一个的敲,按照讲师的要求一个一个的搭环境,自己搭环境比较枯燥,推荐两个配套的在线环境,python3.6和python2.7,实际上2.7的编译效率比python3快一倍,推荐自己搭的环境,就算你以后要从事其他编程语言的开发也可以继续使用python3.6。

除了题主提到的三大抓包手段:requestsseleniumfiddler,还有可以具体代码一块去挖掘,比如redis注册账号之类,api注册等。

python自身自带twisted框架,可以在javaweb服务端任意请求一个静态网页。在python中可以使用。

一般以python为工具,java以爬虫形式。前者基于python的很多模块,后者还在发展完善。

采集采集器(电脑采集器和手机采集样式有什么区别呢??)

采集交流 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2022-02-19 08:01

采集采集器在我们的生活中还是比较常见的,我们不管是在上班工作还是办公室都要有一个采集器的东西,大部分人选择的都是手机的采集器,非常方便,除此之外也有商家选择了电脑采集器,这个可谓是人尽皆知了,那么电脑采集器和手机采集器有什么区别呢?其实这两者的区别还是挺大的,首先电脑采集器是现在工作中必备的一个工具,不管是什么工作,我们总要做好一些准备,这是我们知道的,而手机采集器就不一样了,随着手机功能的全面改变,现在的手机也不仅仅限于娱乐功能了,一些专业的应用也逐渐的在电脑上出现,所以手机采集器的功能更多了。

电脑采集器采集样式这里主要说一下手机采集器的电脑采集,常用的有的手机采集器可以采集视频以及图片,现在常用的还有微信的视频录制,采集文章的文字,还有一些免费的也可以采集图片,除此之外还有微信登录、微信二维码等等这些功能还是挺实用的,而这些手机电脑采集器具有的功能电脑都可以轻松实现,所以小白相对要更容易上手一些。

而电脑采集器需要购买采集端口才可以无缝对接,而手机基本上没有采集端口的设置,可能需要特殊的软件。电脑采集器和手机采集器最大的区别就是制作视频,在获取视频数据有一些通用的数据分析工具,可以在网上查询一些算法,进行一些算法分析,得到一些关于视频信息,手机采集器我想说明的是,由于手机有延迟,得到的信息不一定准确,但电脑采集器因为具有操作的便捷性,所以具有高效率的特点,希望对大家有帮助!。 查看全部

采集采集器(电脑采集器和手机采集样式有什么区别呢??)

采集采集器在我们的生活中还是比较常见的,我们不管是在上班工作还是办公室都要有一个采集器的东西,大部分人选择的都是手机的采集器,非常方便,除此之外也有商家选择了电脑采集器,这个可谓是人尽皆知了,那么电脑采集器和手机采集器有什么区别呢?其实这两者的区别还是挺大的,首先电脑采集器是现在工作中必备的一个工具,不管是什么工作,我们总要做好一些准备,这是我们知道的,而手机采集器就不一样了,随着手机功能的全面改变,现在的手机也不仅仅限于娱乐功能了,一些专业的应用也逐渐的在电脑上出现,所以手机采集器的功能更多了。

电脑采集器采集样式这里主要说一下手机采集器的电脑采集,常用的有的手机采集器可以采集视频以及图片,现在常用的还有微信的视频录制,采集文章的文字,还有一些免费的也可以采集图片,除此之外还有微信登录、微信二维码等等这些功能还是挺实用的,而这些手机电脑采集器具有的功能电脑都可以轻松实现,所以小白相对要更容易上手一些。

而电脑采集器需要购买采集端口才可以无缝对接,而手机基本上没有采集端口的设置,可能需要特殊的软件。电脑采集器和手机采集器最大的区别就是制作视频,在获取视频数据有一些通用的数据分析工具,可以在网上查询一些算法,进行一些算法分析,得到一些关于视频信息,手机采集器我想说明的是,由于手机有延迟,得到的信息不一定准确,但电脑采集器因为具有操作的便捷性,所以具有高效率的特点,希望对大家有帮助!。

采集采集器(采集采集器,最好的还是麦采采,功能强大)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2022-02-15 06:01

采集采集器,最好的还是麦采采,功能强大不说,支持批量采集,真的不要太好用。其他就是商户了,商户管理还是比较麻烦的,一点一点采集吧,其实差不多的。

很可以,采集器就是帮助商家们快速采集信息的。然后批量下载,批量上传,然后就是管理,商家可以自己在线申请,也可以下载客户端。现在很多平台支持免费注册,

可以百度下采集器。

麦采采

采集器还是比较好用的,其实做到互联网商户有两类:一种是业务多,销售量大,那么平台用小采集器效率会比较高,销售量可控。二是零售,平台采集器并不能满足,那么互联网上会有众多批发商用采集器,商家在批发时,每个大平台都会采集再加大量的图片,每天都要下载大量的照片,大量的数据。采集器的功能有:1,批量采集和批量上传(快速批量上传,标准管理标准分类批量采集上传)2,批量搜索(后台数据库里就有每个平台里的商品的图片和价格)3,标准条件选择(根据各平台的传播条件进行选择,不同的条件,选择不同的商品和价格上传)4,数据集中和统计(账号同步有数据集中管理)5,地址定位(定位地址是否有跟踪)6,百度商家采集(可以集中采集阿里巴巴或者等网站,比较全面)7,各大小平台小采集(批量可定位到一个大平台小商家)8,邮箱制包裹制包裹制(批量上传各大小平台的商品)9,全站采集(全网批量采集管理)10,百度全网全站商品类目目录全网采集(大小类目,都可以采集全)11,下单转换(商品图片,详情图片,数据返回转换)。 查看全部

采集采集器(采集采集器,最好的还是麦采采,功能强大)

采集采集器,最好的还是麦采采,功能强大不说,支持批量采集,真的不要太好用。其他就是商户了,商户管理还是比较麻烦的,一点一点采集吧,其实差不多的。

很可以,采集器就是帮助商家们快速采集信息的。然后批量下载,批量上传,然后就是管理,商家可以自己在线申请,也可以下载客户端。现在很多平台支持免费注册,

可以百度下采集器。

麦采采

采集器还是比较好用的,其实做到互联网商户有两类:一种是业务多,销售量大,那么平台用小采集器效率会比较高,销售量可控。二是零售,平台采集器并不能满足,那么互联网上会有众多批发商用采集器,商家在批发时,每个大平台都会采集再加大量的图片,每天都要下载大量的照片,大量的数据。采集器的功能有:1,批量采集和批量上传(快速批量上传,标准管理标准分类批量采集上传)2,批量搜索(后台数据库里就有每个平台里的商品的图片和价格)3,标准条件选择(根据各平台的传播条件进行选择,不同的条件,选择不同的商品和价格上传)4,数据集中和统计(账号同步有数据集中管理)5,地址定位(定位地址是否有跟踪)6,百度商家采集(可以集中采集阿里巴巴或者等网站,比较全面)7,各大小平台小采集(批量可定位到一个大平台小商家)8,邮箱制包裹制包裹制(批量上传各大小平台的商品)9,全站采集(全网批量采集管理)10,百度全网全站商品类目目录全网采集(大小类目,都可以采集全)11,下单转换(商品图片,详情图片,数据返回转换)。

采集采集器(先说一下,什么是数据采集呢?我们可以这样理解)

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2022-02-08 22:04

首先,什么是data采集?我们可以这样理解,我们打开一个网站,看到有一个文章很好,于是我们把文章的标题和内容复制了下来,把这个文章 >转到我们的 网站。我们的进程可以称为一个采集,将别人的网站有用信息传递给我自己网站。

采集器 也是一样,只是整个过程都是由软件完成的。这个我们可以理解,我们复制文章的标题和内容,这样我们就可以知道内容在哪里,标题在哪里,但是软件我不知道,所以我们要告诉软件怎么做把它捡起来。这就是写规则的过程了。我们复制好了之后,打开我们的网站,比如论坛发帖的地方,然后粘贴帖子发布。对于软件来说,就是模仿我们发帖的过程,发布文章,怎么发布,这就是发布模块的事情。。

优采云采集器是采集数据的软件,是目前互联网上功能最强大的采集器。它可以采集您看到的几乎所有网页内容。

优采云采集器数据采集原理:

优采云采集器如何抓取数据取决于你的规则。如果要获取某个版块的网页中的所有内容,需要先提取网页的URL,也就是提取的URL。程序根据你的规则爬取列表页面,从中分析URL,然后爬取获取URL的网页内容。然后根据你的采集规则,分析下载的网页,分离保存标题内容等信息。如果选择下载图片等网络资源,程序会分析采集收到的数据,找到文章的下载地址,下载到本地。

优采云采集器数据发布原则:

我们下载数据采集后,数据默认保存在本地,我们可以使用以下方法对数据进行处理。

1.什么都不做。因为数据本身是存储在数据库中的(access或者db3),如果只是想查看,可以直接用相关软件查看。

2.在 网站 上发帖。程序会模拟浏览器向你的网站发送数据,可以达到你手动发布的效果。

3.直接进入数据库。您只需要编写几条SQL语句,程序就会根据您的SQL语句将数据导入数据库。

4.另存为本地文件。程序会读取数据库中的数据,并以一定的格式保存为本地sql或文本文件。

优采云采集器工作流程:

优采云采集可以分为两步,一是采集数据,二是发布数据。这两个过程可以分开。

1.采集数据,这包括采集URL、采集内容。这个过程就是获取数据的过程。我们制定规则,在挑选的过程中,可以看作是对内容的处理。

2.发布内容就是向自己的论坛发布数据,cms的过程也是实现数据存在的过程。它可以通过WEB在线发布,存储在数据库中或存储为本地文件。

具体使用其实很灵活,可以根据实际情况来决定。比如我可以采集在采集的时候不发布,等有时间再发布,或者同时采集发布,或者做发布配置首先,或者我可以在 采集 再次添加发布配置之后完成它。简而言之,具体流程由你决定,优采云采集器 的强大功能之一就是灵活性。 查看全部

采集采集器(先说一下,什么是数据采集呢?我们可以这样理解)

首先,什么是data采集?我们可以这样理解,我们打开一个网站,看到有一个文章很好,于是我们把文章的标题和内容复制了下来,把这个文章 >转到我们的 网站。我们的进程可以称为一个采集,将别人的网站有用信息传递给我自己网站。

采集器 也是一样,只是整个过程都是由软件完成的。这个我们可以理解,我们复制文章的标题和内容,这样我们就可以知道内容在哪里,标题在哪里,但是软件我不知道,所以我们要告诉软件怎么做把它捡起来。这就是写规则的过程了。我们复制好了之后,打开我们的网站,比如论坛发帖的地方,然后粘贴帖子发布。对于软件来说,就是模仿我们发帖的过程,发布文章,怎么发布,这就是发布模块的事情。。

优采云采集器是采集数据的软件,是目前互联网上功能最强大的采集器。它可以采集您看到的几乎所有网页内容。

优采云采集器数据采集原理:

优采云采集器如何抓取数据取决于你的规则。如果要获取某个版块的网页中的所有内容,需要先提取网页的URL,也就是提取的URL。程序根据你的规则爬取列表页面,从中分析URL,然后爬取获取URL的网页内容。然后根据你的采集规则,分析下载的网页,分离保存标题内容等信息。如果选择下载图片等网络资源,程序会分析采集收到的数据,找到文章的下载地址,下载到本地。

优采云采集器数据发布原则:

我们下载数据采集后,数据默认保存在本地,我们可以使用以下方法对数据进行处理。

1.什么都不做。因为数据本身是存储在数据库中的(access或者db3),如果只是想查看,可以直接用相关软件查看。

2.在 网站 上发帖。程序会模拟浏览器向你的网站发送数据,可以达到你手动发布的效果。

3.直接进入数据库。您只需要编写几条SQL语句,程序就会根据您的SQL语句将数据导入数据库。

4.另存为本地文件。程序会读取数据库中的数据,并以一定的格式保存为本地sql或文本文件。

优采云采集器工作流程:

优采云采集可以分为两步,一是采集数据,二是发布数据。这两个过程可以分开。

1.采集数据,这包括采集URL、采集内容。这个过程就是获取数据的过程。我们制定规则,在挑选的过程中,可以看作是对内容的处理。

2.发布内容就是向自己的论坛发布数据,cms的过程也是实现数据存在的过程。它可以通过WEB在线发布,存储在数据库中或存储为本地文件。

具体使用其实很灵活,可以根据实际情况来决定。比如我可以采集在采集的时候不发布,等有时间再发布,或者同时采集发布,或者做发布配置首先,或者我可以在 采集 再次添加发布配置之后完成它。简而言之,具体流程由你决定,优采云采集器 的强大功能之一就是灵活性。

采集采集器(各个平台的旅游评价数据采集教程_新手入门必看_优采云采集器)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2022-02-08 22:00

由于目前写论文需要爬一些旅游景点数据进行数据分析,所以我摸索了一下评价数据的采集,打算把整个过程记录在这里。以前我爬数据的思路是各种F12然后找http请求解析数据进行各种操作,但是我发现这个方法在这里不太适用,单平台的反爬已经很麻烦了,何况携程、马蜂窝、美团、大众点评一共四个平台。估计等我搞定了,黄花菜也凉了。不过因为之前听过一些自动的采集软件,感觉好像很厉害,所以就下载了一个优采云采集器试试看。没想到这东西真的好用。许久,四个平台的数据都被爬了下来。由于我没有深入使用,所以爬取数据的效果还可以。废话不多说,我们先上效果图:

携程采集结果:

马蜂窝采集结果:

当然,有些平台的数据还不够全,或者有一些问题,我会在最后指出。

先介绍一下优采云采集器:(请注意这个采集器不一定是最好的,其他如优采云采集器估计也可以可以实现,不过我用的是这个,我觉得用起来比较简单,也能完成采集的任务)

优采云采集器

优采云采集器是前谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。具有以下特点;

官网下载地址:优采云采集器_真的免费!无限导出网络爬虫软件_人工智能数据采集软件

资料中心:资料采集Tutorial_Beginners_Beginners必看_优采云采集器

具体下载安装步骤请参考文档。

下面介绍各平台旅游评价数据采集的处理过程。

携程找到需要的网页采集

以景区“清江画廊”为例,在携程官网首页搜索后,会出现景区的详细介绍。向下滚动后,可以看到最后一个面板是`User Comments`,出现了我们需要的评价数据。以分页列表显示,每页10条,共有238页,总数据条数为2373条。

复制本页地址:

````

德天瀑布门票、德天瀑布门票价格、德天瀑布门票团购【携程门票】

````

2. 配置规则

打开优采云采集器,在首页输入上一步找到的页面地址,点击`Smart采集`,Smart采集表示采集器会识别你的输入,并找到列表数据,并自动翻页,直到 采集 到最后一页数据。

然后进入采集界面,采集器会自动打开你在软件中输入的网页,识别网页结构,找到数据列表。这将需要一些时间,请耐心等待。

但起初它可能看起来像这样:

这似乎不是我们需要的评估数据。证明自动识别的列表不是我们想要的,那我们该怎么办呢?

可以这样解决:

3. 开始采集 任务

至此,我们已经配置好需要采集的页面和数据列表,可以在页面底部预览前10条数据。确认无误后,点击`Start采集 to`start采集 Missions。这里可以配置各种选项,比如定时采集、加速、防屏蔽、代理激活等功能。您可以根据需要配置它们。携程可以采集访问数据,无需任何配置。点击开始后,进入采集页面

最后自动采集完成后会提示采集完成,可以将数据导出到本地。

由于其他平台后续操作大同小异,这里只说明需要注意的地方。

马蜂窝

马蜂窝页面显示的数据实际上是不完整的,如下图所示:

每页15页,一共只能看到5页,一共75条,但实际上总共是333条,所以不管显示多少评论,采集的结果最后也只有75条.

美团

与携程类似,可以自动识别页面列表。

公众意见

大众点评有点特别。您可以在查看评论时看到它。您需要登录才能查看所有评论。

所以优采云采集器中需要解决的问题之一就是登录后才能获取数据,应该怎么做呢?

采集页面有预登录功能

在弹出的页面上,登录后,点击“登录完成”。

但是需要注意的是,每页数据的url都不一样,例如:第一页`/shop/3328354/review_all`,第二页:`/shop/3328354/review_all/p2`,这个呢什么样的网址?

可以看出,每一页的前缀都是一样的,但是最后的p2和p3号不同。采集器 为这种 url 生成器提供了一个常规的 url 生成器。详情请在此处填写参数。输入要生成的起始页码和结束页码,将URL预览中的url复制到“手动输入”字段,并进行一定的修改。

总结

其实从流程上来说,还是挺简单的,只是可能需要一些配置规则和预登录才能熟悉。网页上可以看到的大部分数据都可以通过采集器采集访问。当然,还有很多高级复杂的东西这里就不一一介绍了。去研究。

有一个问题

由于采集器和各个平台的差异,数据采集难免会出现一些问题,所以这里只记录我观察到的比较明显的问题:

马蜂窝的数据,不管有多少评论,最终采集最多收到75条(网页上显示的也就这么多)。采集在美团上收到的一些评论是空的,不知道是什么问题。目前还不清楚大众点评的部分评价数据需要手动点击`展开评论`才能看到完整的内容,所以采集的结果并不完整。目前,携程的点评数据比较齐全。

我的网站提供了POI数据爬取、人流爬取、数据可视化、在线地图工具等一系列功能,欢迎使用,地址:【BLT-LEAD一个专注分享地图数据相关的网站_] 用于爬取、可视化、应用工具和知识(BLT-LEAD是一个网站_,专注于分享与地图数据相关的爬取、可视化、应用工具和知识) 查看全部

采集采集器(各个平台的旅游评价数据采集教程_新手入门必看_优采云采集器)

由于目前写论文需要爬一些旅游景点数据进行数据分析,所以我摸索了一下评价数据的采集,打算把整个过程记录在这里。以前我爬数据的思路是各种F12然后找http请求解析数据进行各种操作,但是我发现这个方法在这里不太适用,单平台的反爬已经很麻烦了,何况携程、马蜂窝、美团、大众点评一共四个平台。估计等我搞定了,黄花菜也凉了。不过因为之前听过一些自动的采集软件,感觉好像很厉害,所以就下载了一个优采云采集器试试看。没想到这东西真的好用。许久,四个平台的数据都被爬了下来。由于我没有深入使用,所以爬取数据的效果还可以。废话不多说,我们先上效果图:

携程采集结果:

马蜂窝采集结果:

当然,有些平台的数据还不够全,或者有一些问题,我会在最后指出。

先介绍一下优采云采集器:(请注意这个采集器不一定是最好的,其他如优采云采集器估计也可以可以实现,不过我用的是这个,我觉得用起来比较简单,也能完成采集的任务)

优采云采集器

优采云采集器是前谷歌搜索技术团队基于人工智能技术开发的新一代网页采集软件。具有以下特点;

官网下载地址:优采云采集器_真的免费!无限导出网络爬虫软件_人工智能数据采集软件

资料中心:资料采集Tutorial_Beginners_Beginners必看_优采云采集器

具体下载安装步骤请参考文档。

下面介绍各平台旅游评价数据采集的处理过程。

携程找到需要的网页采集

以景区“清江画廊”为例,在携程官网首页搜索后,会出现景区的详细介绍。向下滚动后,可以看到最后一个面板是`User Comments`,出现了我们需要的评价数据。以分页列表显示,每页10条,共有238页,总数据条数为2373条。

复制本页地址:

````

德天瀑布门票、德天瀑布门票价格、德天瀑布门票团购【携程门票】

````

2. 配置规则

打开优采云采集器,在首页输入上一步找到的页面地址,点击`Smart采集`,Smart采集表示采集器会识别你的输入,并找到列表数据,并自动翻页,直到 采集 到最后一页数据。

然后进入采集界面,采集器会自动打开你在软件中输入的网页,识别网页结构,找到数据列表。这将需要一些时间,请耐心等待。

但起初它可能看起来像这样:

这似乎不是我们需要的评估数据。证明自动识别的列表不是我们想要的,那我们该怎么办呢?

可以这样解决:

3. 开始采集 任务

至此,我们已经配置好需要采集的页面和数据列表,可以在页面底部预览前10条数据。确认无误后,点击`Start采集 to`start采集 Missions。这里可以配置各种选项,比如定时采集、加速、防屏蔽、代理激活等功能。您可以根据需要配置它们。携程可以采集访问数据,无需任何配置。点击开始后,进入采集页面

最后自动采集完成后会提示采集完成,可以将数据导出到本地。

由于其他平台后续操作大同小异,这里只说明需要注意的地方。

马蜂窝

马蜂窝页面显示的数据实际上是不完整的,如下图所示:

每页15页,一共只能看到5页,一共75条,但实际上总共是333条,所以不管显示多少评论,采集的结果最后也只有75条.

美团

与携程类似,可以自动识别页面列表。

公众意见

大众点评有点特别。您可以在查看评论时看到它。您需要登录才能查看所有评论。

所以优采云采集器中需要解决的问题之一就是登录后才能获取数据,应该怎么做呢?

采集页面有预登录功能

在弹出的页面上,登录后,点击“登录完成”。

但是需要注意的是,每页数据的url都不一样,例如:第一页`/shop/3328354/review_all`,第二页:`/shop/3328354/review_all/p2`,这个呢什么样的网址?

可以看出,每一页的前缀都是一样的,但是最后的p2和p3号不同。采集器 为这种 url 生成器提供了一个常规的 url 生成器。详情请在此处填写参数。输入要生成的起始页码和结束页码,将URL预览中的url复制到“手动输入”字段,并进行一定的修改。

总结

其实从流程上来说,还是挺简单的,只是可能需要一些配置规则和预登录才能熟悉。网页上可以看到的大部分数据都可以通过采集器采集访问。当然,还有很多高级复杂的东西这里就不一一介绍了。去研究。

有一个问题

由于采集器和各个平台的差异,数据采集难免会出现一些问题,所以这里只记录我观察到的比较明显的问题:

马蜂窝的数据,不管有多少评论,最终采集最多收到75条(网页上显示的也就这么多)。采集在美团上收到的一些评论是空的,不知道是什么问题。目前还不清楚大众点评的部分评价数据需要手动点击`展开评论`才能看到完整的内容,所以采集的结果并不完整。目前,携程的点评数据比较齐全。

我的网站提供了POI数据爬取、人流爬取、数据可视化、在线地图工具等一系列功能,欢迎使用,地址:【BLT-LEAD一个专注分享地图数据相关的网站_] 用于爬取、可视化、应用工具和知识(BLT-LEAD是一个网站_,专注于分享与地图数据相关的爬取、可视化、应用工具和知识)

采集采集器(社交网络采集器的功能和技术细节以及技术基础!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2022-02-02 15:03

采集采集器的功能1.采集是从社交网络采集用户的行为,形成用户分析数据。2.采集有些用户可能会采集视频和图片,从而形成用户偏好分析。采集的原理1.http网站通过服务器的状态(ip、ua等)判断浏览者是本地还是社交网络采集器爬取的都是服务器所认识的。2.采集时机:比如不明来源的邮件、短信、游戏内用户id等。

3.设定默认的dns,比如手机登录时,在我的电脑上设定为“.”,或者域名,比如“.”;不登录手机登录时,设定“.”.设定默认浏览器也很重要,比如我通常都选“ie6-ie11”。

一、网络爬虫的技术基础1.精确的网络电信接入策略2.可靠的ip以及可靠的http接入(如https证书,ipsec证书)3.良好的存储方式,能存储有效的大小和期限:存储在不同的存储方式上,带来的不同则是:当用户访问某个页面的时候,需要花费更多的时间去区分真假;而当一个页面被多个网络爬虫访问时,则会发生同一个页面被多个网络爬虫爬取。

4.各种情况下对所有元素的爬取策略有特殊要求。比如,单一服务器爬取某一个客户端所有的页面数据的时候,服务器端面临的问题则是:所有的页面数据都需要全部爬取到。5.各种情况下对同一个页面要如何抓取策略的要求不同:被抓取页面的元素是否具有生命周期,只允许服务器抓取一次等等。二、网络爬虫的技术细节1.协议抓取策略与上面的协议抓取策略不同,策略要分析可行的实现方式。

比如scrapy的selenium,由于可以利用selenium作为开发者工具,能够将爬虫更快速的和用户交互。同时,http协议还给爬虫的爬取策略带来了很多的挑战。2.可靠与可靠都是正确的吗?可靠的爬虫应该是可靠的吗?需要正确理解这两个词的含义。可靠定义为:可重复的解析数据,而且解析速度要很快;爬虫多次抓取同一个数据对后,数据结果还能达到正确的解析水平;爬虫重复解析多次,依然达到正确的解析效果。

可靠的抓取策略,往往需要多次抓取同一个页面的时候,通过优化爬虫抓取策略,能够在解析完页面并且全部重定向时抓取到结果。可靠的抓取策略是爬虫实现的重要因素,特别是爬虫从代理服务器端重定向。3.http语义爬虫就是爬取文本信息。大多数网站,数据抓取都是服务器端发给爬虫的,然后爬虫再根据解析策略,将数据解析为html文件返回给用户。

爬虫解析不同于解析文本。比如,可能在你浏览一个广告页面时,广告页面会拿到你的参数,然后给出一个广告价格,接着把你的浏览数据告诉其他的爬虫,再用爬虫去抓取其他爬虫的页面。而爬虫解析类似于。 查看全部

采集采集器(社交网络采集器的功能和技术细节以及技术基础!)

采集采集器的功能1.采集是从社交网络采集用户的行为,形成用户分析数据。2.采集有些用户可能会采集视频和图片,从而形成用户偏好分析。采集的原理1.http网站通过服务器的状态(ip、ua等)判断浏览者是本地还是社交网络采集器爬取的都是服务器所认识的。2.采集时机:比如不明来源的邮件、短信、游戏内用户id等。

3.设定默认的dns,比如手机登录时,在我的电脑上设定为“.”,或者域名,比如“.”;不登录手机登录时,设定“.”.设定默认浏览器也很重要,比如我通常都选“ie6-ie11”。

一、网络爬虫的技术基础1.精确的网络电信接入策略2.可靠的ip以及可靠的http接入(如https证书,ipsec证书)3.良好的存储方式,能存储有效的大小和期限:存储在不同的存储方式上,带来的不同则是:当用户访问某个页面的时候,需要花费更多的时间去区分真假;而当一个页面被多个网络爬虫访问时,则会发生同一个页面被多个网络爬虫爬取。

4.各种情况下对所有元素的爬取策略有特殊要求。比如,单一服务器爬取某一个客户端所有的页面数据的时候,服务器端面临的问题则是:所有的页面数据都需要全部爬取到。5.各种情况下对同一个页面要如何抓取策略的要求不同:被抓取页面的元素是否具有生命周期,只允许服务器抓取一次等等。二、网络爬虫的技术细节1.协议抓取策略与上面的协议抓取策略不同,策略要分析可行的实现方式。

比如scrapy的selenium,由于可以利用selenium作为开发者工具,能够将爬虫更快速的和用户交互。同时,http协议还给爬虫的爬取策略带来了很多的挑战。2.可靠与可靠都是正确的吗?可靠的爬虫应该是可靠的吗?需要正确理解这两个词的含义。可靠定义为:可重复的解析数据,而且解析速度要很快;爬虫多次抓取同一个数据对后,数据结果还能达到正确的解析水平;爬虫重复解析多次,依然达到正确的解析效果。

可靠的抓取策略,往往需要多次抓取同一个页面的时候,通过优化爬虫抓取策略,能够在解析完页面并且全部重定向时抓取到结果。可靠的抓取策略是爬虫实现的重要因素,特别是爬虫从代理服务器端重定向。3.http语义爬虫就是爬取文本信息。大多数网站,数据抓取都是服务器端发给爬虫的,然后爬虫再根据解析策略,将数据解析为html文件返回给用户。

爬虫解析不同于解析文本。比如,可能在你浏览一个广告页面时,广告页面会拿到你的参数,然后给出一个广告价格,接着把你的浏览数据告诉其他的爬虫,再用爬虫去抓取其他爬虫的页面。而爬虫解析类似于。

采集采集器(前段时间,iLogtail阿里千万实例可观测采集器开源(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2022-01-28 12:08

介绍:前段时间可以观察到千万级iLogtail阿里巴巴实例采集器开源,其中介绍iLogtail采集性能可以达到每核100MB/s,对比开源< @采集代理5-10倍性能优势。很多朋友好奇iLogtail具体的性能数据和资源消耗情况。本文将对比目前业界广泛使用且性能相对较好的Agent FileBeat,测试两种agent在不同压力场景下的表现。

作者 |减少旋转

来源 |阿里巴巴科技公众号

前言

前段时间,iLogtail[1]可以观察到阿里巴巴千万级实例采集器开源,其中引入iLogtail采集性能可以达到每核100MB/s,对比开源< @采集代理有5-10倍的性能优势。很多朋友好奇iLogtail具体的性能数据和资源消耗情况。本文将对比目前业界广泛使用且性能相对较好的Agent FileBeat,测试两种agent在不同压力场景下的表现。

第二次测试说明

随着Kubernetes的普及,Kubernetes下对日志采集的需求越来越正常,所以下面将容器标准输出流采集和静态文件采集@进行对比测试> 容器内(使用静态文件采集的小伙伴可以参考容器内的静态文件采集进行对比测试,iLogtail纯静态文件采集会比测试2略好容器中的静态文件采集),测试项详细如下:

在真实的生产环境中,log采集组件的可操作性也很重要。为方便运维及后期升级,相比Sidecar模式,K8s下部署采用Daemonset模式采集组件较为常见。但是,由于 Daemonset 将整个集群的 采集 配置同时分发到每个 采集 节点,单个 采集 节点的工作配置必须小于 采集@ 的总数> 配置,因此我们还将进行以下 2 部分实验,以验证 采集config bloat 会影响 采集器 的生产力:

最后iLogtail会进行大流量压力测试,如下:

三个测试环境

所有采集环境数据都存储在[2]中,有兴趣的同学可以自行进行整个对比测试实验。下面介绍不同采集模式的具体配置。如果只关心采集比较结果,可以跳过这部分继续阅读。

1 环境

运行环境:阿里云ACK Pro版

节点配置:ecs.g6.xlarge(4 vCPU 16GB)磁盘ESSD

底层容器:Containerd

iLogtail 版本:1.0.28

FileBeat 版本:v7.16.2

2 个数据源

对于数据源,我们先去掉正则解析或者多行拼接能力带来的差异,只比较最基本的单行采集。数据生成源模拟nginx访问日志的生成。单条日志大小为283B,以下配置以1000bar/s的速率描述输入源:

apiVersion: batch/v1

kind: Job

metadata:

name: nginx-log-demo-0

namespace: default

spec:

template:

metadata:

name: nginx-log-demo-0

spec:

restartPolicy: Never

containers:

- name: nginx-log-demo-0

image: registry.cn-hangzhou.aliyuncs.com/log-service/docker-log-test:latest

command: ["/bin/mock_log"]

args: ["--log-type=nginx", "--path=/var/log/medlinker/access.log", "--total-count=1000000000", "--log-file-size=1000000000", "--log-file-count=2", "--logs-per-sec=1000"]

volumeMounts:

- name: path

mountPath: /var/log/medlinker

subPath: nginx-log-demo-0

resources:

limits:

memory: 200Mi

requests:

cpu: 10m

memory: 10Mi

volumes:

- name: path

hostPath:

path: /testlog

type: DirectoryOrCreate

nodeSelector:

kubernetes.io/hostname: cn-beijing.192.168.0.140

3 Filebeat标准输出流采集配置

Filebeat原生支持容器文件采集,通过add_kubernetes_metadata组件添加kubernetes元信息,为了避免输出组件带来的性能差异,通过drop_event插件drop数据避免输出,filebeat测试配置如下(harvester_buffer_size调整设置为512K,filebeat.registry.flush:30s,queue.mem参数适当扩大增加吞吐量):

filebeat.yml: |-

filebeat.registry.flush: 30s

processors:

- add_kubernetes_metadata:

host: ${NODE_NAME}

matchers:

- logs_path:

logs_path: "/var/log/containers/"

- drop_event:

when:

equals:

input.type: container

output.console:

pretty: false

queue:

mem:

events: 4096

flush.min_events: 2048

flush.timeout: 1s

max_procs: 4

filebeat.inputs:

- type: container

harvester_buffer_size: 524288

paths:

- /var/log/containers/nginx-log-demo-0-*.log

4个Filebeat容器文件采集配置

Filebeat原生不支持容器内的文件采集,所以需要手动挂载日志打印路径到宿主机HostPath。这里我们使用 subPath 和 DirectoryOrCreate 函数来分隔服务打印路径。下面是模拟不同服务日志打印路径无关的情况。

filebeat使用基本的日志读取功能来读取/testlog路径下的日志。为了避免输出组件带来的性能差异,使用drop_event插件丢弃数据,避免输出。测试配置如下(harvester_buffer_size调整设置为512K,filebeat.registry.flush:30s,queue.mem参数适当扩展增加吞吐量):

filebeat.yml: |-

filebeat.registry.flush: 30s

output.console:

pretty: false

queue:

mem:

events: 4096

flush.min_events: 2048

flush.timeout: 1s

max_procs: 4

filebeat.inputs:

- type: log

harvester_buffer_size: 524288

paths:

- /testlog/nginx-log-demo-0/*.log

processors:

- drop_event:

when:

equals:

log.file.path: /testlog/nginx-log-demo-0/access.log

5 iLogtail 标准输出流采集配置

iLogtail 还原生支持标准输出流采集,service_docker_stdout 组件已经提取了 kubernetes 元信息。为避免输出组件导致的性能差异,所有日志都通过processor_filter_regex进行过滤。测试配置如下:

{

"inputs":[

{

"detail":{

"ExcludeLabel":{

},

"IncludeLabel":{

"io.kubernetes.container.name":"nginx-log-demo-0"

}

},

"type":"service_docker_stdout"

}

],

"processors":[

{

"type":"processor_filter_regex",

"detail":{

"Exclude":{

"_namespace_":"default"

}

}

}

]

}

6 iLogtail 容器文件采集配置

iLogtail原生支持容器采集中的文件,但是因为文件中的采集元信息存在于tag标签中,所以没有过滤插件。为了避免输出组件带来的性能差异,我们使用空输出插件输出,测试配置如下:

{

"metrics":{

"c0":{

"advanced":{

"k8s":{

"IncludeLabel":{

"io.kubernetes.container.name":"nginx-log-demo-0"

}

}

},

......

"plugin":{

"processors":[

{

"type":"processor_default"

}

],

"flushers":[

{

"type":"flusher_statistics",

"detail":{

"RateIntervalMs":1000000

}

}

]

},

"local_storage":true,

"log_begin_reg":".*",

"log_path":"/var/log/medlinker",

......

}

}

}

四个Filebeat和iLogtail对比测试

Filebeat和iLogtail的对比项目主要有:标准输出流采集性能、文件在容器采集性能、标准输出流多用户配置性能、容器内文件多用户配置性能和高流量采集性能。

1个标准输出流采集性能对比

输入数据源:283B/s,底层容器contianerd,标准输出流扩展为328B,共4个输入源:

下面是不同标准输出流的性能对比采集。可以看出iLogtail相比Filebeat有十倍的性能优势(CPU占比为单核占比):

下面是不同标准输出流的内存对比采集。可以看出logtail和filebeat的整体内存差别不大,并没有随着采集traffic的增加内存暴增:

2个容器文件采集性能对比

输入数据源:283B/s,共4个输入源:

下面是容器采集中不同文件的性能对比。 Filebeat容器中的文件与容器采集共享采集组件,省略了Kubernetes元相关的组件,因此相比标准输出流采集有很大的性能提升。 iLogtail容器内文件采集采用Polling+inotify机制,相比容器标准输出流采集也有性能提升,但可以看到iLogtail与Filebeat相比有5倍的提升性能优势(CPU占比为单核占比):

下面是不同标准输出流的内存对比采集。可以看出logtail和filebeat的整体内存差别不大,并没有随着采集traffic的增加内存暴增:

3 采集配置扩展性能对比

采集配置扩展性能对比,输入源设置为4,总输入速率为3M/s,50采集配置,100采集配置,500采集 @>配置,1000采集配置比较。

标准输出流采集配置膨胀比较

下面是不同标准输出流的性能对比采集。可以看到Filebeat与容器底层采集和静态文件采集共享相同的静态文件采集逻辑。标准输出流采集的路径var/log/containers下会有很多正则匹配工作。可以看到虽然采集的数据量并没有因为采集的配置增加而增加,但是CPU消耗增加了10%+,iLogtail全局共享容器路径发现机制针对容器采集模型,避免了常规逻辑带来的性能损失(CPU占比为单核占比)。

在内存扩展方面,可以看出Filebeat和iLogtail都有因采集配置增加导致的内存扩展,但两者的扩展大小都在可接受的范围内。

容器中的文件采集配置扩展对比

下图是容器中文件采集与不同采集器的性能对比,可以看到Filebeat静态文件采集相比标准增加了CPU是由于规避标准输出流的正则路径消耗少,iLogtail CPU变化也小,性能略优于标准输出流采集(CPU的百分比就是单核)。

在内存扩展方面,也可以看出Filebeat和iLogtail都有因采集配置增加导致的内存扩展,但两者的扩展大小都在可接受的范围内。

4 iLogtail 采集性能测试

由于FileBeat在日志量大的场景下存在采集延迟问题,以下场景仅针对iLogtail进行测试,iLogtail的容器标准输出为5M/s、10M/ s 和 20M/s。流 采集 和容器 采集 中的文件的性能压力测试。

和上面的测试类似,可以看出容器文件采集的性能在CPU消耗方面略优于容器标准输出流采集(百分比CPU是单核的百分比),主要是因为容器文件采集@采集底层的Polling+inotify机制。

在内存方面,由于标准输出流采集主要依赖GO,而容器文件采集主要依赖C,由于GC机制的存在,随着速率的增加,标准输出流采集消耗的内存会逐渐超过容器中文件采集消耗的内存。

5 比较总结

5 为什么Filebeat容器的标准输出和文件有这么大的差别采集?

通过以上实验,我们可以看出FIlebeat在不同工作模式下的CPU差异很大。通过dump容器采集的标准输出流的pprof,可以得到如下火焰图,可以看出Filebeat容器采集下的add_kubernets_meta插件是性能瓶颈。同时FIlebeat的add_kubernets_meta采用了api-server模式监控各个节点,也存在api-server压力问题。

iLogtail的kubernetes meta完全兼容kubernetes CRI协议,直接通过kubernets沙箱读取meta数据,保证了iLogtail的高性能采集效率。

六大iLogtail DaemonSet场景优化

从上面的对比可以看出,iLogtail相比Filebeat,内存和CPU消耗都非常出色。可能有朋友好奇iLogtail的极致性能背后的原因。下面主要讲解iLogtail Daemonset场景下的优化以及如何将标准输出Streaming比FIlebeat提升10倍的性能。

首先针对标准输出流的场景,对比其他开源采集器,比如Filebeat或者Fluentd。一般容器的标准输出流文件的采集是通过监听var/log/containers或者/var/log/pods/来实现的。例如/var/log/pods/的路径结构为:/var/log/pods /_

_

//,使用该路径复用物理机静态文件采集方式为采集。

对于iLogtail,它完全支持容器化。 iLogtail通过发现机制,全局维护一个Node节点容器列表,并实时监控维护这个容器列表。当我们有一个容器列表时,我们有以下优势:

七个结论

综上所述,在高动态的 Kubernetes 环境下,iLogtail 不会因为 Daemonset 的部署模式带来的多重配置问题而导致内存大的扩展,而在静态文件 采集 方面,iLogtail 有5倍左右的性能优势,对于标准输出流采集,由于iLogtail的采集机制,iLogtail有10倍左右的性能优势。但是,与 Filebeat 或 Fluentd 等老式开源产品相比,文档和社区建设方面仍然存在很多不足。欢迎对iLogtail感兴趣的朋友参与,共同打造易用、高性能的iLogtail产品。

参考文献

原文链接 查看全部

采集采集器(前段时间,iLogtail阿里千万实例可观测采集器开源(组图))

介绍:前段时间可以观察到千万级iLogtail阿里巴巴实例采集器开源,其中介绍iLogtail采集性能可以达到每核100MB/s,对比开源< @采集代理5-10倍性能优势。很多朋友好奇iLogtail具体的性能数据和资源消耗情况。本文将对比目前业界广泛使用且性能相对较好的Agent FileBeat,测试两种agent在不同压力场景下的表现。

作者 |减少旋转

来源 |阿里巴巴科技公众号

前言

前段时间,iLogtail[1]可以观察到阿里巴巴千万级实例采集器开源,其中引入iLogtail采集性能可以达到每核100MB/s,对比开源< @采集代理有5-10倍的性能优势。很多朋友好奇iLogtail具体的性能数据和资源消耗情况。本文将对比目前业界广泛使用且性能相对较好的Agent FileBeat,测试两种agent在不同压力场景下的表现。

第二次测试说明

随着Kubernetes的普及,Kubernetes下对日志采集的需求越来越正常,所以下面将容器标准输出流采集和静态文件采集@进行对比测试> 容器内(使用静态文件采集的小伙伴可以参考容器内的静态文件采集进行对比测试,iLogtail纯静态文件采集会比测试2略好容器中的静态文件采集),测试项详细如下:

在真实的生产环境中,log采集组件的可操作性也很重要。为方便运维及后期升级,相比Sidecar模式,K8s下部署采用Daemonset模式采集组件较为常见。但是,由于 Daemonset 将整个集群的 采集 配置同时分发到每个 采集 节点,单个 采集 节点的工作配置必须小于 采集@ 的总数> 配置,因此我们还将进行以下 2 部分实验,以验证 采集config bloat 会影响 采集器 的生产力:

最后iLogtail会进行大流量压力测试,如下:

三个测试环境

所有采集环境数据都存储在[2]中,有兴趣的同学可以自行进行整个对比测试实验。下面介绍不同采集模式的具体配置。如果只关心采集比较结果,可以跳过这部分继续阅读。

1 环境

运行环境:阿里云ACK Pro版

节点配置:ecs.g6.xlarge(4 vCPU 16GB)磁盘ESSD

底层容器:Containerd

iLogtail 版本:1.0.28

FileBeat 版本:v7.16.2

2 个数据源

对于数据源,我们先去掉正则解析或者多行拼接能力带来的差异,只比较最基本的单行采集。数据生成源模拟nginx访问日志的生成。单条日志大小为283B,以下配置以1000bar/s的速率描述输入源:

apiVersion: batch/v1

kind: Job

metadata:

name: nginx-log-demo-0

namespace: default

spec:

template:

metadata:

name: nginx-log-demo-0

spec:

restartPolicy: Never

containers:

- name: nginx-log-demo-0

image: registry.cn-hangzhou.aliyuncs.com/log-service/docker-log-test:latest

command: ["/bin/mock_log"]

args: ["--log-type=nginx", "--path=/var/log/medlinker/access.log", "--total-count=1000000000", "--log-file-size=1000000000", "--log-file-count=2", "--logs-per-sec=1000"]

volumeMounts:

- name: path

mountPath: /var/log/medlinker

subPath: nginx-log-demo-0

resources:

limits:

memory: 200Mi

requests:

cpu: 10m

memory: 10Mi

volumes:

- name: path

hostPath:

path: /testlog

type: DirectoryOrCreate

nodeSelector:

kubernetes.io/hostname: cn-beijing.192.168.0.140

3 Filebeat标准输出流采集配置

Filebeat原生支持容器文件采集,通过add_kubernetes_metadata组件添加kubernetes元信息,为了避免输出组件带来的性能差异,通过drop_event插件drop数据避免输出,filebeat测试配置如下(harvester_buffer_size调整设置为512K,filebeat.registry.flush:30s,queue.mem参数适当扩大增加吞吐量):

filebeat.yml: |-

filebeat.registry.flush: 30s

processors:

- add_kubernetes_metadata:

host: ${NODE_NAME}

matchers:

- logs_path:

logs_path: "/var/log/containers/"

- drop_event:

when:

equals:

input.type: container

output.console:

pretty: false

queue:

mem:

events: 4096

flush.min_events: 2048

flush.timeout: 1s

max_procs: 4

filebeat.inputs:

- type: container

harvester_buffer_size: 524288

paths:

- /var/log/containers/nginx-log-demo-0-*.log

4个Filebeat容器文件采集配置

Filebeat原生不支持容器内的文件采集,所以需要手动挂载日志打印路径到宿主机HostPath。这里我们使用 subPath 和 DirectoryOrCreate 函数来分隔服务打印路径。下面是模拟不同服务日志打印路径无关的情况。

filebeat使用基本的日志读取功能来读取/testlog路径下的日志。为了避免输出组件带来的性能差异,使用drop_event插件丢弃数据,避免输出。测试配置如下(harvester_buffer_size调整设置为512K,filebeat.registry.flush:30s,queue.mem参数适当扩展增加吞吐量):

filebeat.yml: |-

filebeat.registry.flush: 30s

output.console:

pretty: false

queue:

mem:

events: 4096

flush.min_events: 2048

flush.timeout: 1s

max_procs: 4

filebeat.inputs:

- type: log

harvester_buffer_size: 524288

paths:

- /testlog/nginx-log-demo-0/*.log

processors:

- drop_event:

when:

equals:

log.file.path: /testlog/nginx-log-demo-0/access.log

5 iLogtail 标准输出流采集配置

iLogtail 还原生支持标准输出流采集,service_docker_stdout 组件已经提取了 kubernetes 元信息。为避免输出组件导致的性能差异,所有日志都通过processor_filter_regex进行过滤。测试配置如下:

{

"inputs":[

{

"detail":{

"ExcludeLabel":{

},

"IncludeLabel":{

"io.kubernetes.container.name":"nginx-log-demo-0"

}

},

"type":"service_docker_stdout"

}

],

"processors":[

{

"type":"processor_filter_regex",

"detail":{

"Exclude":{

"_namespace_":"default"

}

}

}

]

}

6 iLogtail 容器文件采集配置

iLogtail原生支持容器采集中的文件,但是因为文件中的采集元信息存在于tag标签中,所以没有过滤插件。为了避免输出组件带来的性能差异,我们使用空输出插件输出,测试配置如下:

{

"metrics":{

"c0":{

"advanced":{

"k8s":{

"IncludeLabel":{

"io.kubernetes.container.name":"nginx-log-demo-0"

}

}

},

......

"plugin":{

"processors":[

{

"type":"processor_default"

}

],

"flushers":[

{

"type":"flusher_statistics",

"detail":{

"RateIntervalMs":1000000

}

}

]

},