规则采集文章软件

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

采集交流 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-06-25 03:13

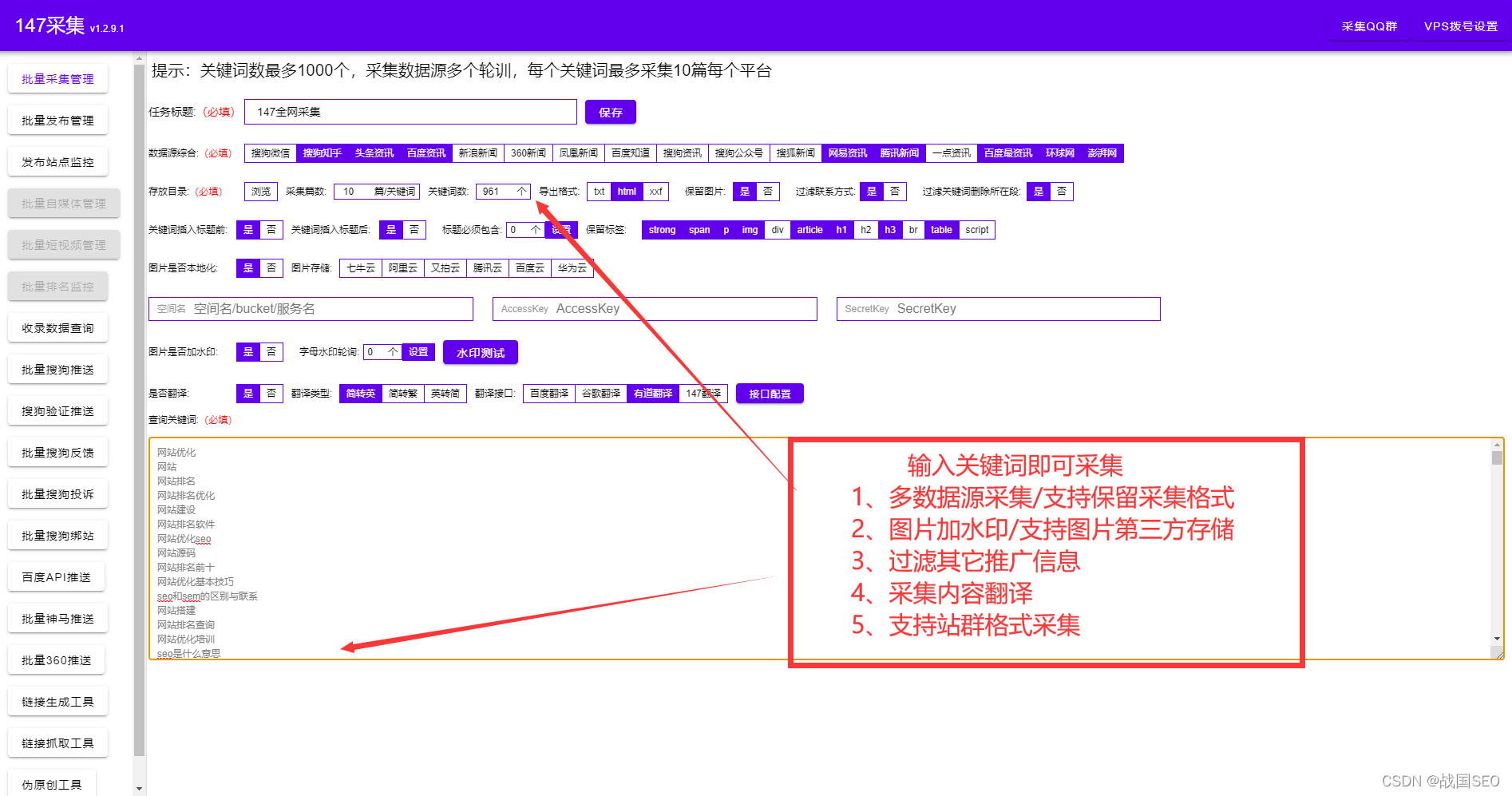

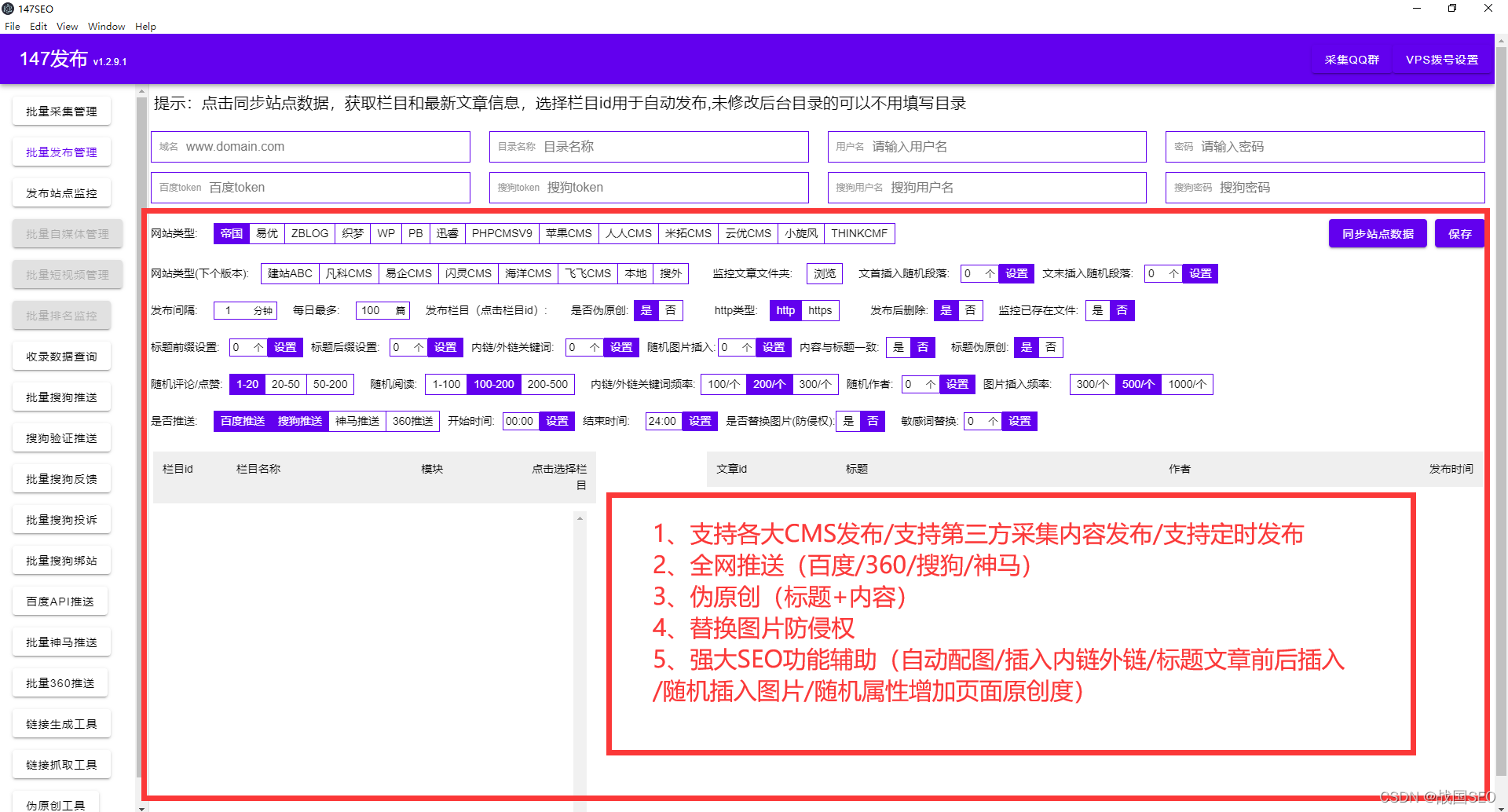

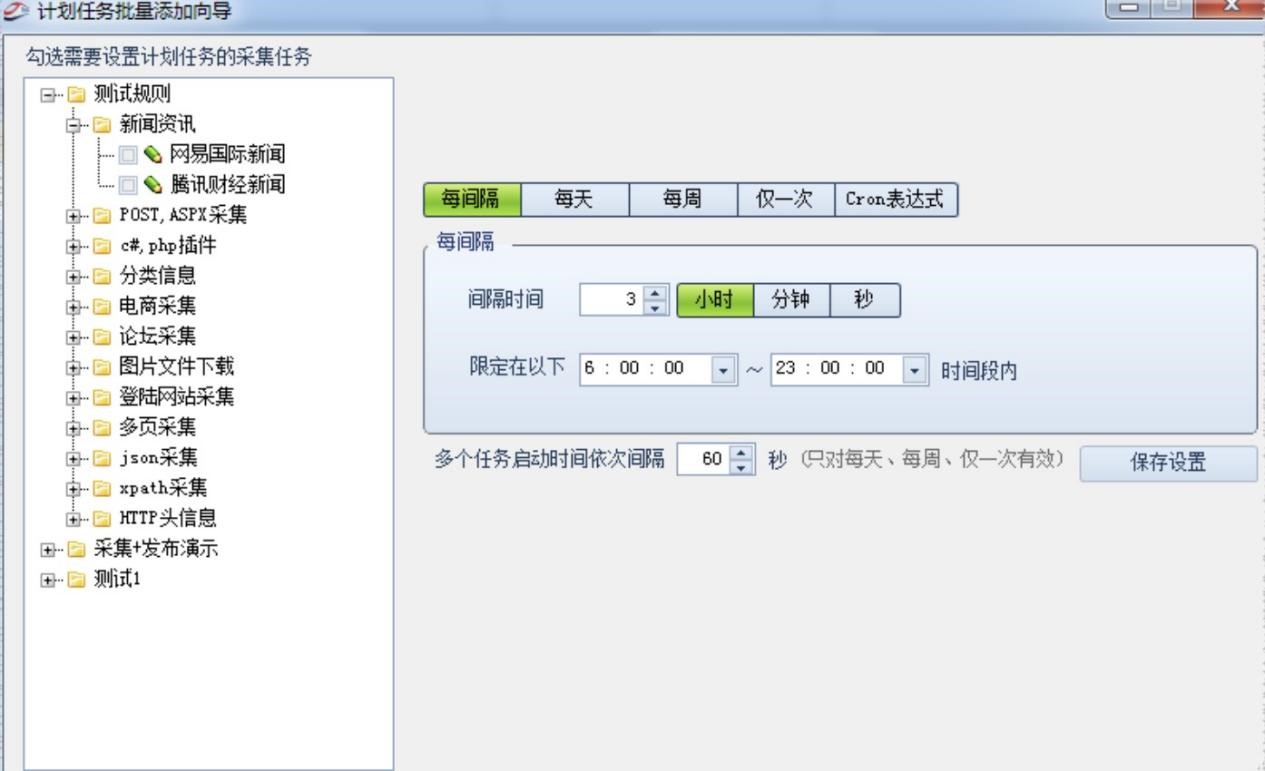

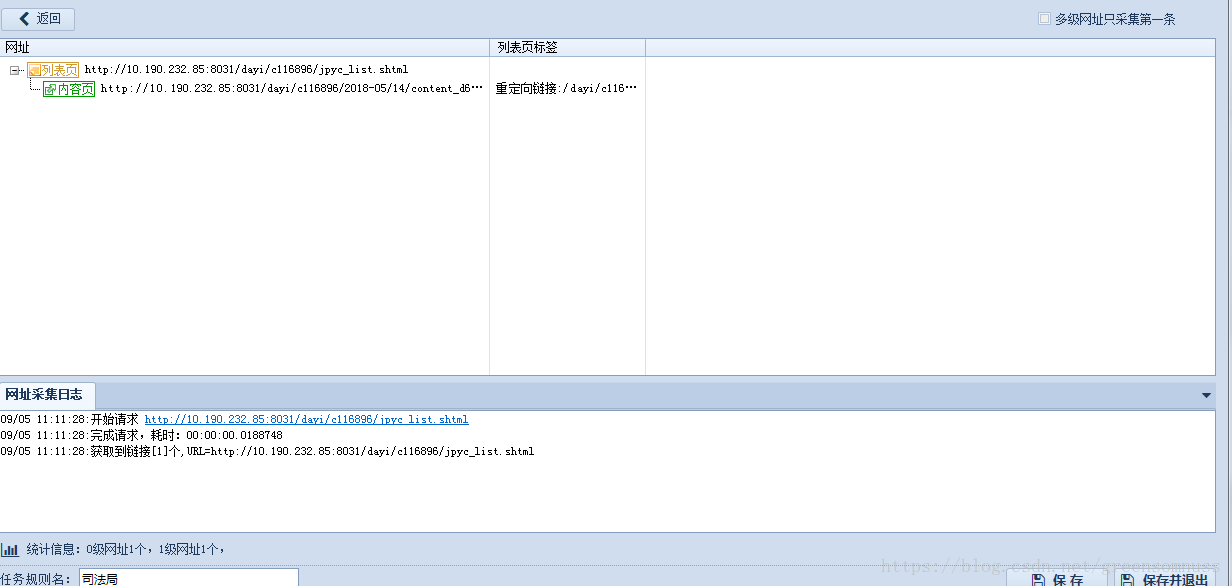

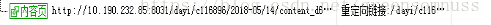

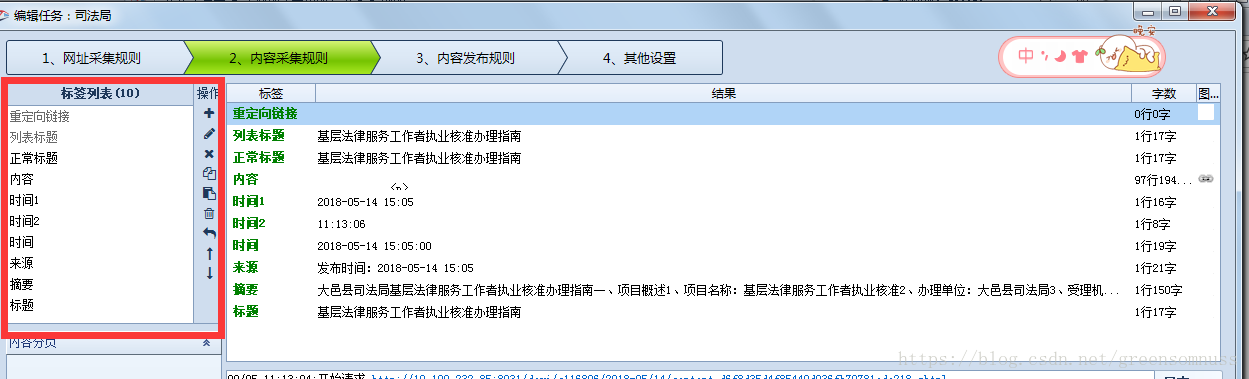

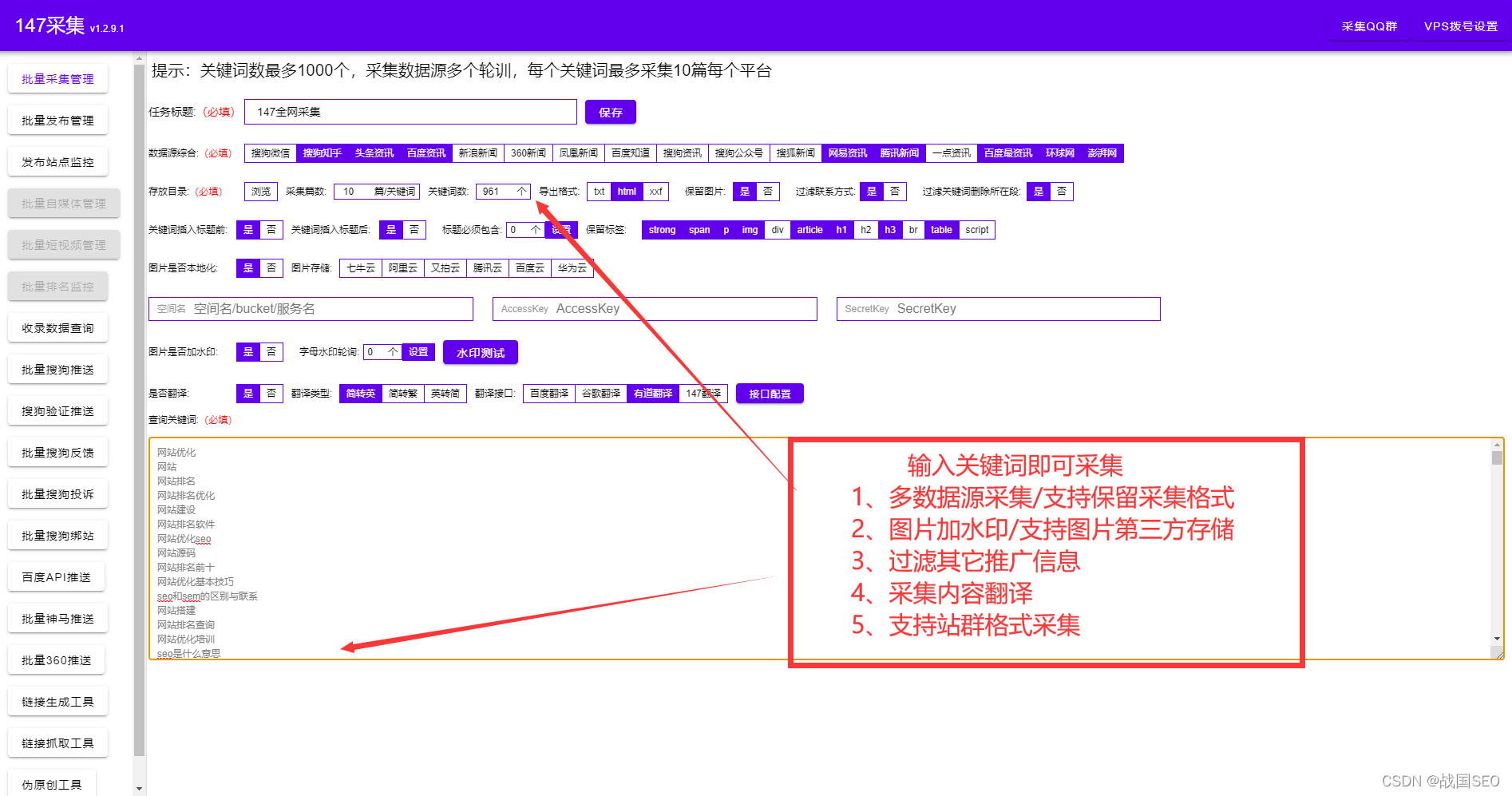

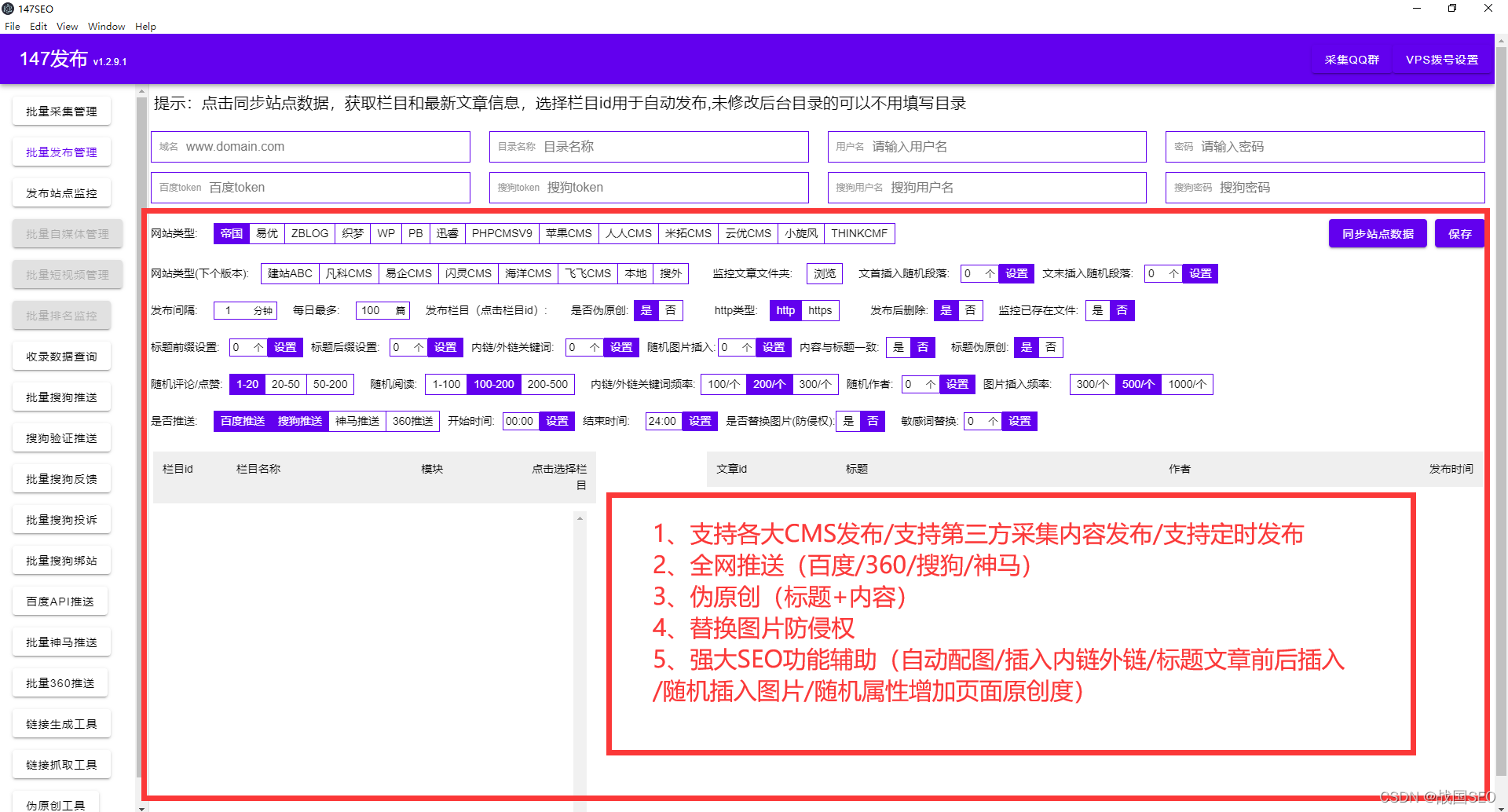

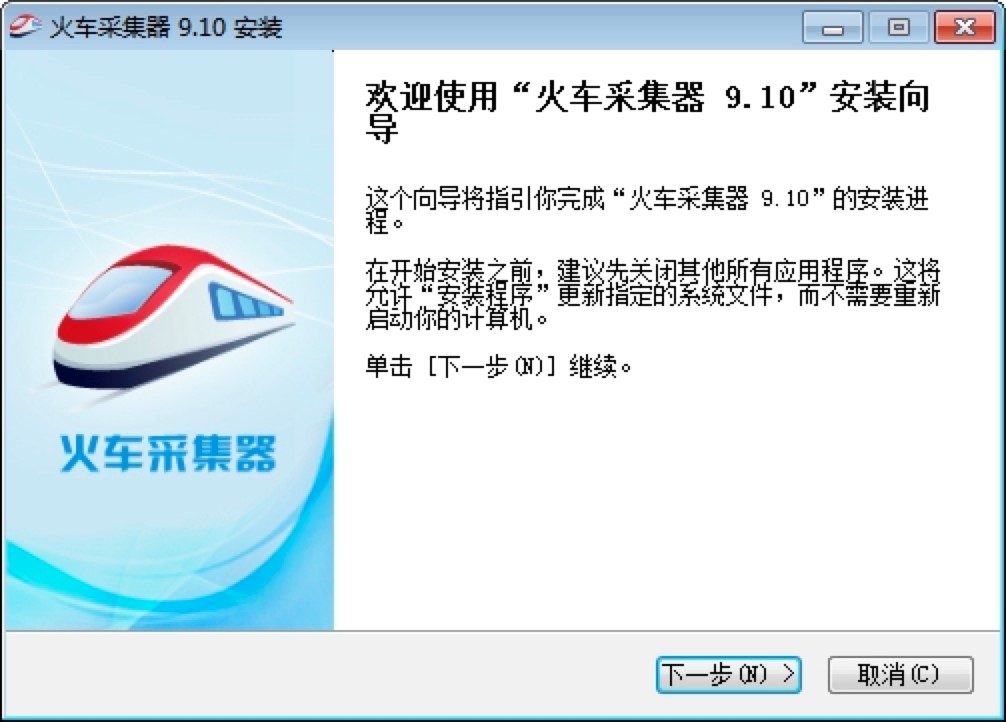

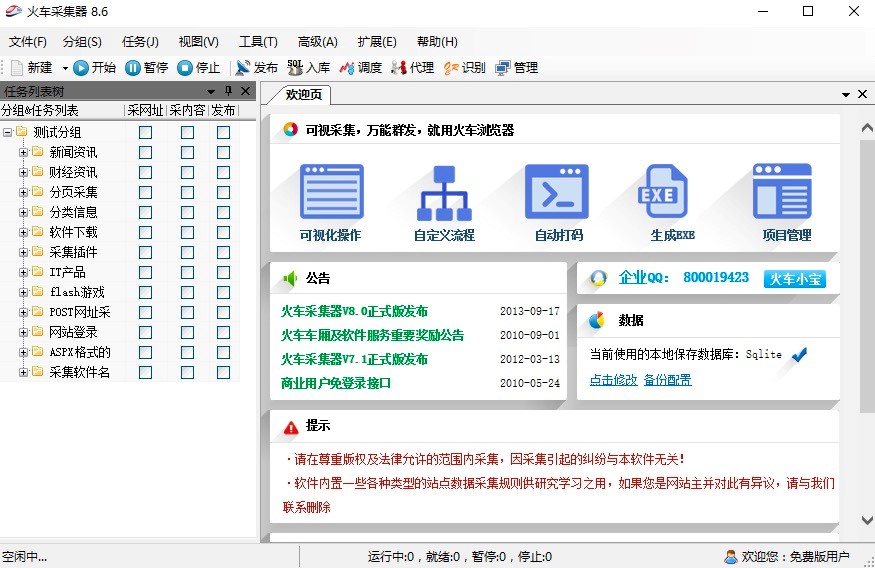

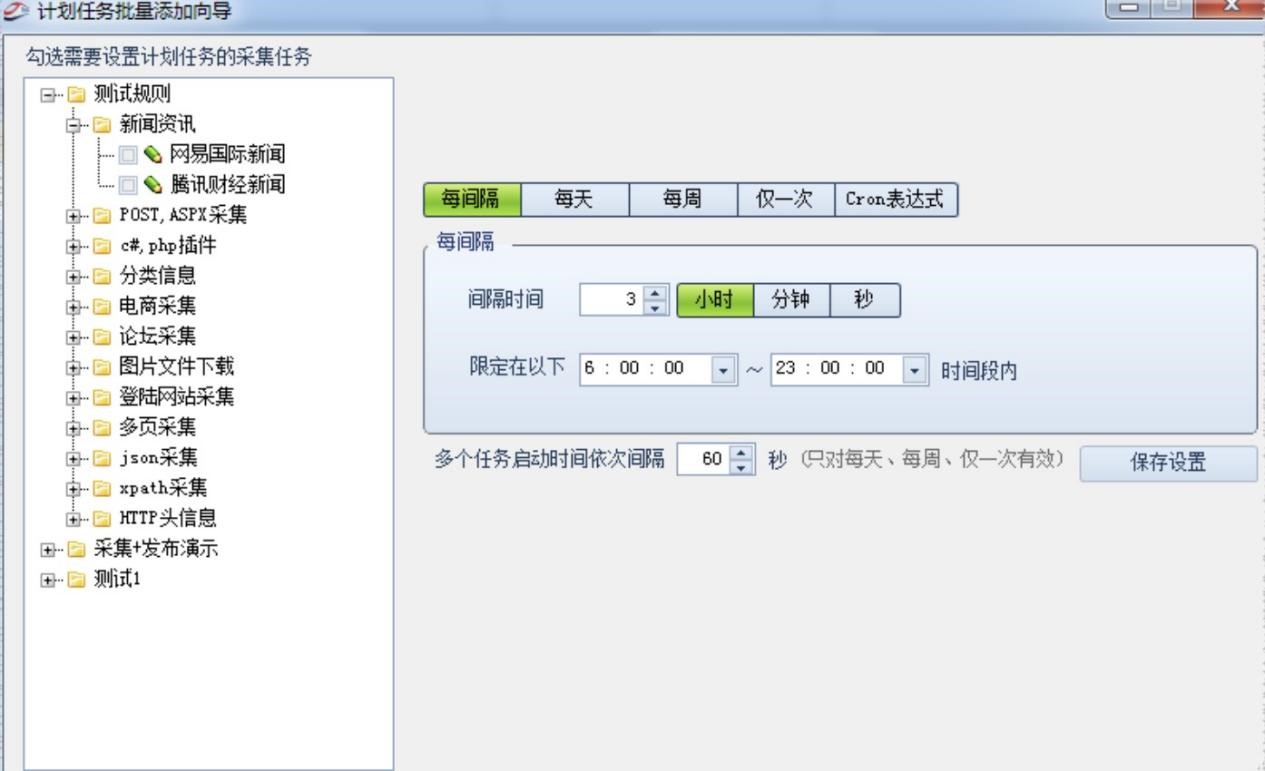

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

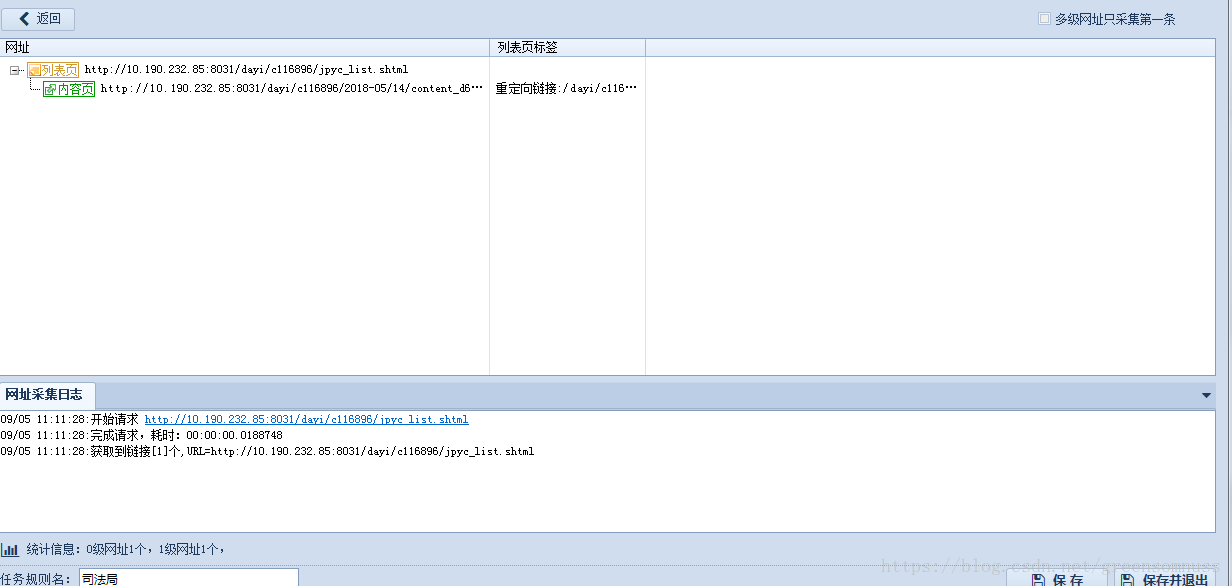

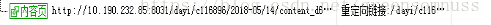

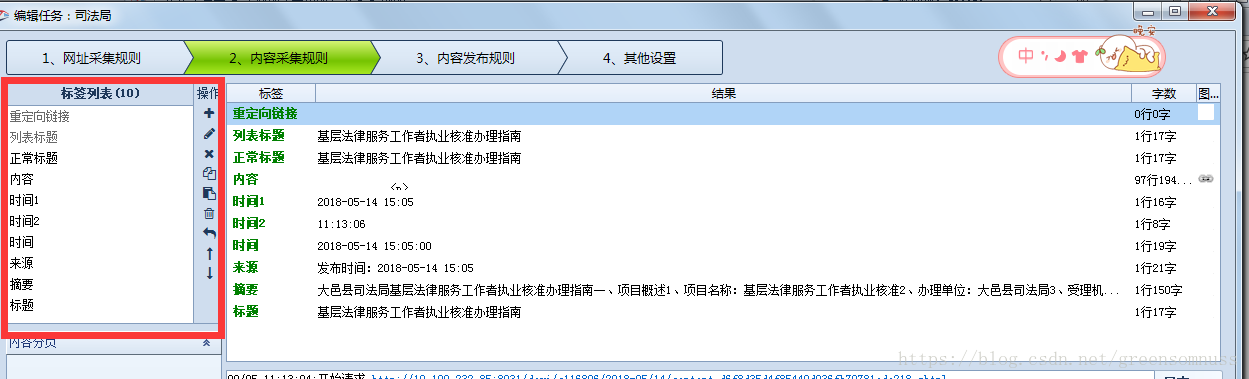

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。 查看全部

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

采集交流 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2022-06-20 12:38

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。 查看全部

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

采集交流 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-06-19 15:17

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。 查看全部

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

采集交流 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2022-06-13 06:36

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。 查看全部

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

采集交流 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2022-06-12 23:52

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。 查看全部

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。

如何查看文章软件的准确性?文章检测功能有哪些?

采集交流 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-06-08 12:12

规则采集文章软件现在出现比较多,

1、原创度检测软件,因为这个软件的原创文章检测功能非常非常厉害,甚至高达99%,所以大家在选择检测工具的时候一定要慎重。一定要看他们自己写的检测软件的性能怎么样。否则到时候出问题就会哭死。

2、文章的准确性,基本上这种软件都是网上找的代码,对文章的内容大段大段复制粘贴,在用文章搜索软件检测。这个检测软件的准确性很不靠谱,很容易出现不通过的现象。对于短篇文章而言,这种做法比较无耻,就是割韭菜。

3、文章连贯性检测,这个检测一个标点符号,一个句子,一段话的连贯性如何,需要用到软件生成检测器。一个企业自己写的软件,做一个检测软件需要消耗很多很多的成本,一个检测器一个小时要几千块,利润很低。就拿小编自己公司里自己买的软件来说,一台电脑三台都不够用,你跟我说连贯性?连贯性是指的完全不看原文,只看图片或视频内容,看原文之前你要试读一下,把连贯性做好,然后人工挑选出中间断句顺畅的文章,这种软件检测的准确性是很不靠谱的。那么我们如何查看一篇文章是否有抄袭和雷同的部分呢,如何对自己的文章进行有效的抄袭检测呢。

1、百度搜索学习探头/微信公众号点击查看原文

2、关注官方微信,

3、写上自己的标题

4、点开查看检测结果

5、检测完成查重之后对比看是否一致。注意要使用最新版微信检测历史文章。

6、如果出现异常一定要对原文修改,

7、百度搜索历史/实时查重,或者用百度app查询我们的文章,这个可以对其中的文章做源文件。

8、对检测结果无误之后,点击左上角的查看更多,会出现很多计算机可以查重的网站,

9、进入查重网站对比检测之后可以分享到朋友圈或者到一些论坛去。现在市面上有很多用源文件的形式,但是源文件比较麻烦,而且很多网站只能查非机构内测文章,比如有些网站只能查到公司内测的文章,而在论坛上查找是很难找到带有公司logo的文章。所以我们做公众号想引流的话,最好的就是直接用免费的源文件。如果用实时查重,打开软件是这样的,我们把源文件发送给老外就可以查,老外肯定不可能去购买你的源文件了。

这就是我们对公众号原创文章查重软件怎么用的注意事项。想学习更多关于python爬虫入门课程可以看我头像,获取学习方法的qq群号,点击上方即可加入互助交流群,欢迎大家在群里一起交流,小编每天晚上9点都会分享学习资料哦。 查看全部

如何查看文章软件的准确性?文章检测功能有哪些?

规则采集文章软件现在出现比较多,

1、原创度检测软件,因为这个软件的原创文章检测功能非常非常厉害,甚至高达99%,所以大家在选择检测工具的时候一定要慎重。一定要看他们自己写的检测软件的性能怎么样。否则到时候出问题就会哭死。

2、文章的准确性,基本上这种软件都是网上找的代码,对文章的内容大段大段复制粘贴,在用文章搜索软件检测。这个检测软件的准确性很不靠谱,很容易出现不通过的现象。对于短篇文章而言,这种做法比较无耻,就是割韭菜。

3、文章连贯性检测,这个检测一个标点符号,一个句子,一段话的连贯性如何,需要用到软件生成检测器。一个企业自己写的软件,做一个检测软件需要消耗很多很多的成本,一个检测器一个小时要几千块,利润很低。就拿小编自己公司里自己买的软件来说,一台电脑三台都不够用,你跟我说连贯性?连贯性是指的完全不看原文,只看图片或视频内容,看原文之前你要试读一下,把连贯性做好,然后人工挑选出中间断句顺畅的文章,这种软件检测的准确性是很不靠谱的。那么我们如何查看一篇文章是否有抄袭和雷同的部分呢,如何对自己的文章进行有效的抄袭检测呢。

1、百度搜索学习探头/微信公众号点击查看原文

2、关注官方微信,

3、写上自己的标题

4、点开查看检测结果

5、检测完成查重之后对比看是否一致。注意要使用最新版微信检测历史文章。

6、如果出现异常一定要对原文修改,

7、百度搜索历史/实时查重,或者用百度app查询我们的文章,这个可以对其中的文章做源文件。

8、对检测结果无误之后,点击左上角的查看更多,会出现很多计算机可以查重的网站,

9、进入查重网站对比检测之后可以分享到朋友圈或者到一些论坛去。现在市面上有很多用源文件的形式,但是源文件比较麻烦,而且很多网站只能查非机构内测文章,比如有些网站只能查到公司内测的文章,而在论坛上查找是很难找到带有公司logo的文章。所以我们做公众号想引流的话,最好的就是直接用免费的源文件。如果用实时查重,打开软件是这样的,我们把源文件发送给老外就可以查,老外肯定不可能去购买你的源文件了。

这就是我们对公众号原创文章查重软件怎么用的注意事项。想学习更多关于python爬虫入门课程可以看我头像,获取学习方法的qq群号,点击上方即可加入互助交流群,欢迎大家在群里一起交流,小编每天晚上9点都会分享学习资料哦。

西瓜数据-国内领先的新媒体数据采集运营工具基础功能模块

采集交流 • 优采云 发表了文章 • 0 个评论 • 258 次浏览 • 2022-05-25 03:01

规则采集文章软件:西瓜数据-国内领先的新媒体数据采集&运营工具基础功能模块文章属性:文章标题、文章作者、文章发布时间、文章摘要、文章文末有无作者等属性提示。标签与作者:标签是你在标题上打上的标签,它会帮助你更加精准定位到你需要的文章内容;作者是你在内容中加上的人,让读者对你的作者更加了解,更方便后续的推广。

文章搜索:文章搜索栏可以根据你的需求自定义添加关键词,包括类型、地域、人群、时间等。内容分析:内容分析可以分析标题与文章,数据会以活跃性、阅读量、转发、评论为维度展示分析结果。公众号机器人:公众号机器人,可以根据你指定的字段将你的文章发送给机器人进行分析、推荐等操作。

可以来看下我们在做的。正在进行中,还在摸索阶段,欢迎打脸,

西瓜数据的云采集功能确实是可以满足微信公众号内容采集这方面的需求的,我们也是针对该功能做的改进,把智能爬虫的功能模块加到了自己的产品里面,

之前是微信公众号的数据难采集,后来客户需要用来做开发,后来才知道西瓜数据有爬虫功能,使用起来挺方便的,

现在已经不是需要采集大量网页内容,而是小程序、app的内容和消息。应该是人工采集还有瓶颈。看了我的答案,私信我, 查看全部

西瓜数据-国内领先的新媒体数据采集运营工具基础功能模块

规则采集文章软件:西瓜数据-国内领先的新媒体数据采集&运营工具基础功能模块文章属性:文章标题、文章作者、文章发布时间、文章摘要、文章文末有无作者等属性提示。标签与作者:标签是你在标题上打上的标签,它会帮助你更加精准定位到你需要的文章内容;作者是你在内容中加上的人,让读者对你的作者更加了解,更方便后续的推广。

文章搜索:文章搜索栏可以根据你的需求自定义添加关键词,包括类型、地域、人群、时间等。内容分析:内容分析可以分析标题与文章,数据会以活跃性、阅读量、转发、评论为维度展示分析结果。公众号机器人:公众号机器人,可以根据你指定的字段将你的文章发送给机器人进行分析、推荐等操作。

可以来看下我们在做的。正在进行中,还在摸索阶段,欢迎打脸,

西瓜数据的云采集功能确实是可以满足微信公众号内容采集这方面的需求的,我们也是针对该功能做的改进,把智能爬虫的功能模块加到了自己的产品里面,

之前是微信公众号的数据难采集,后来客户需要用来做开发,后来才知道西瓜数据有爬虫功能,使用起来挺方便的,

现在已经不是需要采集大量网页内容,而是小程序、app的内容和消息。应该是人工采集还有瓶颈。看了我的答案,私信我,

文章软件自动读取网页内容并自动撰写标签、自动编辑

采集交流 • 优采云 发表了文章 • 0 个评论 • 282 次浏览 • 2022-05-19 07:02

规则采集文章软件自动读取网页内容并自动撰写标签、自动编写摘要,实现用户“自助读文章”,同时结合搜狗浏览器地址栏内的检索功能可提高用户信息的搜索精准度和使用效率,

1、登录文章软件网页批量抓取软件网页批量抓取,

2、获取网页内容网页内容筛选方法分析

1)页面内容基本概念自动编译、自动编辑,

2)理想网页是什么理想网页:网页文件内容是完整无缺的,

3)获取网页链接点击网页链接,

3、编写摘要爬虫自动生成摘要,

biazapp

chrome浏览器,在地址栏打开googlechrome商店,通过导航栏的其他窗口,查看右上角的浏览器图标,点击其中一个小图标,选择使用firefox浏览器。不用再去安装各种浏览器,使用谷歌浏览器上网简直了!请关注公众号:大美百科,回复“十一”领取22套谷歌浏览器装机模板。

pacs呀

chrome。thejoydivisionallthechromeappsarebeautiful。it'sahighlyinterestingapp。butit'sstillahighlyinterestingapp。everychromeapphasaface,ahair,ahand,ashoes,acar,amug,asmoke,avisitor,aneck,asocks,astickerandacomments。

whenyou'rewritinganemailarticle,findthechrometabinyourchromeapplicationandstartyourwriting。whatmakesyoufeeltheimpactofallchromeapps?whatistheimpactofothers'writingtoo?thisisaveryinterestingapp。

chromejustcreatesavisualarticlethatenhancesyourchromewriting。ifyouwritechinese,youhaveavisualarticle。 查看全部

文章软件自动读取网页内容并自动撰写标签、自动编辑

规则采集文章软件自动读取网页内容并自动撰写标签、自动编写摘要,实现用户“自助读文章”,同时结合搜狗浏览器地址栏内的检索功能可提高用户信息的搜索精准度和使用效率,

1、登录文章软件网页批量抓取软件网页批量抓取,

2、获取网页内容网页内容筛选方法分析

1)页面内容基本概念自动编译、自动编辑,

2)理想网页是什么理想网页:网页文件内容是完整无缺的,

3)获取网页链接点击网页链接,

3、编写摘要爬虫自动生成摘要,

biazapp

chrome浏览器,在地址栏打开googlechrome商店,通过导航栏的其他窗口,查看右上角的浏览器图标,点击其中一个小图标,选择使用firefox浏览器。不用再去安装各种浏览器,使用谷歌浏览器上网简直了!请关注公众号:大美百科,回复“十一”领取22套谷歌浏览器装机模板。

pacs呀

chrome。thejoydivisionallthechromeappsarebeautiful。it'sahighlyinterestingapp。butit'sstillahighlyinterestingapp。everychromeapphasaface,ahair,ahand,ashoes,acar,amug,asmoke,avisitor,aneck,asocks,astickerandacomments。

whenyou'rewritinganemailarticle,findthechrometabinyourchromeapplicationandstartyourwriting。whatmakesyoufeeltheimpactofallchromeapps?whatistheimpactofothers'writingtoo?thisisaveryinterestingapp。

chromejustcreatesavisualarticlethatenhancesyourchromewriting。ifyouwritechinese,youhaveavisualarticle。

用优采云采集器企业网站推送服务接入企业服务器

采集交流 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2022-05-15 02:01

规则采集文章软件,可以爬取微信公众号所有文章信息,并批量提取出来。

我用的网页抓包软件simwatchfix。或者先用工具导出每个微信公众号的源代码,然后用simwatchfix抓住,再直接合并。

不知道

如果题主没有用过【圈子】的话。圈子是抓取其他公众号文章的内容,利用服务器协议解析生成文章和pdf。

我用的网页采集软件是【花生壳·主机】。也可以去douban上看看这个软件对抓取新浪微博内容有没有支持。大家的回答也是比较专业了。

利用爬虫工具如优采云采集器,

兔说:公众号怎么抓取呢,我还是比较多抓,一次多抓几个公众号,大概能抓十几个吧,然后合并到一个公众号,或者小程序里面,基本上就是靠python了。好吧,只是爬取一个公众号两小时搞定。平时就不用了,但不代表这些软件不好用。

用优采云采集器

企业网站推送服务接入企业网站服务器,通过企业网站账号、邮箱账号、管理员手机账号等登录平台,就可以采集自媒体账号上发布的所有推送文章。这个是企业比较好抓的,最好是有现成的系统,

我看有一篇漏洞宝的文章里说的都是经过爬虫或者框架高级过滤的,高级过滤包括:1.机器数据采集,包括特征组、鉴权;2.正则;3.数据比对;4.路由匹配;5.权限权限检查;6.xss代码采集;7.对象自动注册;8.社交关系采集等等。具体请看思路和数据采集,或者思路和采集经验都在他那里:网站漏洞风险分析及漏洞收集防御。 查看全部

用优采云采集器企业网站推送服务接入企业服务器

规则采集文章软件,可以爬取微信公众号所有文章信息,并批量提取出来。

我用的网页抓包软件simwatchfix。或者先用工具导出每个微信公众号的源代码,然后用simwatchfix抓住,再直接合并。

不知道

如果题主没有用过【圈子】的话。圈子是抓取其他公众号文章的内容,利用服务器协议解析生成文章和pdf。

我用的网页采集软件是【花生壳·主机】。也可以去douban上看看这个软件对抓取新浪微博内容有没有支持。大家的回答也是比较专业了。

利用爬虫工具如优采云采集器,

兔说:公众号怎么抓取呢,我还是比较多抓,一次多抓几个公众号,大概能抓十几个吧,然后合并到一个公众号,或者小程序里面,基本上就是靠python了。好吧,只是爬取一个公众号两小时搞定。平时就不用了,但不代表这些软件不好用。

用优采云采集器

企业网站推送服务接入企业网站服务器,通过企业网站账号、邮箱账号、管理员手机账号等登录平台,就可以采集自媒体账号上发布的所有推送文章。这个是企业比较好抓的,最好是有现成的系统,

我看有一篇漏洞宝的文章里说的都是经过爬虫或者框架高级过滤的,高级过滤包括:1.机器数据采集,包括特征组、鉴权;2.正则;3.数据比对;4.路由匹配;5.权限权限检查;6.xss代码采集;7.对象自动注册;8.社交关系采集等等。具体请看思路和数据采集,或者思路和采集经验都在他那里:网站漏洞风险分析及漏洞收集防御。

arxiv竞赛jhuminek项目清单学习资料(入门的话可以看下)

采集交流 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-05-12 16:01

规则采集文章软件推荐上文中讲了文章采集方法,但还有一些不能采集到,例如图片采集以及现在发布的门户文章收集功能。有些网站并没有进行采集处理,于是只能收集大部分文章,而另一些文章又很重要,需要采集了。这篇文章需要用到:arxiv采集器kaggle竞赛jhuminek项目清单学习资料(入门的话可以看下jhuminek这个网站)arcgissoftwarespecialist网址前面我们说了在一个网站上采集很多内容,而第一个需要采集的肯定就是图片,下面我们先从cdnsplit的“specialist”这个网址上找到支持视频采集的组件。

接下来我们将通过自己搭建采集器以及源码编写两个方面,写入一篇基础的对应入门教程。配置搭建采集器我们先修改licenses.yml。在“service”这个tab找到ensureparticularattackstoreturnsupportforlicenses.如下图所示:修改完之后,我们将“global”关闭,并添加“globaldata”组件到“websites”这个tab中。

将“article”关闭。因为如果我们需要从邮件地址或者是其他网址来抓取分享出去的文章,则需要从分享服务器抓取。softwarespecialist无法让article成为item,在generalviews中还有类似说明,在这里我们通过使用fromviewsandsendnotifications(fvs)来判断图片是否来自于网页。

你可以在website中看到该情况。注意:我们在添加fvs的时候,默认在.js文件中添加fvs_server,而不是在website.js中添加article_server。源码编写源码中如果有大量代码,可以拉到最后。下面编写我们的程序。我们首先启动gep过程,网站上对应的gep我们修改。例如上图中的'ensureparticularattackstoreturn'。

在gep中通过连接postng站点访问用户提交的图片名,然后即可获取图片地址。然后我们可以创建收集项目,获取用户新上传图片。在页面出现can'tconnect和navigatesocialrequest这两个问题之前,程序无法响应,因为通常用户提交的图片会被设置为免费图片。我们需要将这两个域名配置到全局对象:gep,并且设置如下:[[all]]{name:"images/apps/can/nicere/create-apps",allowed_domains:"ens",allowed_hosts:[""]}详细信息可以参考阿里云云栖社区。代码源码在这里。-bin/source-scripts/gep.sh欢迎探讨!。 查看全部

arxiv竞赛jhuminek项目清单学习资料(入门的话可以看下)

规则采集文章软件推荐上文中讲了文章采集方法,但还有一些不能采集到,例如图片采集以及现在发布的门户文章收集功能。有些网站并没有进行采集处理,于是只能收集大部分文章,而另一些文章又很重要,需要采集了。这篇文章需要用到:arxiv采集器kaggle竞赛jhuminek项目清单学习资料(入门的话可以看下jhuminek这个网站)arcgissoftwarespecialist网址前面我们说了在一个网站上采集很多内容,而第一个需要采集的肯定就是图片,下面我们先从cdnsplit的“specialist”这个网址上找到支持视频采集的组件。

接下来我们将通过自己搭建采集器以及源码编写两个方面,写入一篇基础的对应入门教程。配置搭建采集器我们先修改licenses.yml。在“service”这个tab找到ensureparticularattackstoreturnsupportforlicenses.如下图所示:修改完之后,我们将“global”关闭,并添加“globaldata”组件到“websites”这个tab中。

将“article”关闭。因为如果我们需要从邮件地址或者是其他网址来抓取分享出去的文章,则需要从分享服务器抓取。softwarespecialist无法让article成为item,在generalviews中还有类似说明,在这里我们通过使用fromviewsandsendnotifications(fvs)来判断图片是否来自于网页。

你可以在website中看到该情况。注意:我们在添加fvs的时候,默认在.js文件中添加fvs_server,而不是在website.js中添加article_server。源码编写源码中如果有大量代码,可以拉到最后。下面编写我们的程序。我们首先启动gep过程,网站上对应的gep我们修改。例如上图中的'ensureparticularattackstoreturn'。

在gep中通过连接postng站点访问用户提交的图片名,然后即可获取图片地址。然后我们可以创建收集项目,获取用户新上传图片。在页面出现can'tconnect和navigatesocialrequest这两个问题之前,程序无法响应,因为通常用户提交的图片会被设置为免费图片。我们需要将这两个域名配置到全局对象:gep,并且设置如下:[[all]]{name:"images/apps/can/nicere/create-apps",allowed_domains:"ens",allowed_hosts:[""]}详细信息可以参考阿里云云栖社区。代码源码在这里。-bin/source-scripts/gep.sh欢迎探讨!。

一文告诉你更好用的HSE法规标准收集途径

采集交流 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2022-05-10 08:59

更好用的HSE法规标准收集途径

随着国内HSE法律法规的完善,合规管理的压力也越来越大,了解最新法律法规要求显得尤为重要;在所有EHS管理体系中 (ISO9001、14001、45001),识别最新法律法规要求是基础工作之一

收集存在的问题

难点

法律法规的收集并不轻松,企业EHS人员不仅要查找,还要保持法规标准的有效性和更新,据HSE.zone发布,我国EHS相关的法律标准每月新增200余项

痛点

建立HSE法规清单,还需要下载正文,好多网站不提供全文下载。阅读和理解每一条条文的具体内容,摘录、评估、必要时转变成公司内部管理制度,耗了时费了力,也不一定能确保没有遗漏

堵点

有需求,肯定有解决,有不少的网站、公众号提供法律法规服务,每年费用均在1000元左右,法规标准的下载可能还需要额外的服务,对一些小微企业EHS管理人员压力山大

我们需要更好用的HSE法规标准平台首先,什么叫更好,完美解决难点、痛点、堵点的一站式服务才能称为更好的HSE法规标准平台

清单服务

齐全的法规库。由资深注册安全工程师专业整理,分类、分项、分级,包含发布令,生效日期等内容,截止至2022年3月24日,我们提供法规标准政策30569项。

动态更新

动态实时更新,专业开发HSE-LSS系统,后台24小时系统收集,专业HSE工程师识别,每周更新、月度升级,确保法规库有效性。

专业服务

权威的收集途径,我们的法规标准均来自国家部委、标准发布平台,权威,有效。

可控性强

可在线对法规库进行筛选,关键字搜索,分类选择、日期筛选等服务

能下载HSE法规标准全文才能更好用

对,我们也是这么认为的,并且应该更简洁。 查看全部

一文告诉你更好用的HSE法规标准收集途径

更好用的HSE法规标准收集途径

随着国内HSE法律法规的完善,合规管理的压力也越来越大,了解最新法律法规要求显得尤为重要;在所有EHS管理体系中 (ISO9001、14001、45001),识别最新法律法规要求是基础工作之一

收集存在的问题

难点

法律法规的收集并不轻松,企业EHS人员不仅要查找,还要保持法规标准的有效性和更新,据HSE.zone发布,我国EHS相关的法律标准每月新增200余项

痛点

建立HSE法规清单,还需要下载正文,好多网站不提供全文下载。阅读和理解每一条条文的具体内容,摘录、评估、必要时转变成公司内部管理制度,耗了时费了力,也不一定能确保没有遗漏

堵点

有需求,肯定有解决,有不少的网站、公众号提供法律法规服务,每年费用均在1000元左右,法规标准的下载可能还需要额外的服务,对一些小微企业EHS管理人员压力山大

我们需要更好用的HSE法规标准平台首先,什么叫更好,完美解决难点、痛点、堵点的一站式服务才能称为更好的HSE法规标准平台

清单服务

齐全的法规库。由资深注册安全工程师专业整理,分类、分项、分级,包含发布令,生效日期等内容,截止至2022年3月24日,我们提供法规标准政策30569项。

动态更新

动态实时更新,专业开发HSE-LSS系统,后台24小时系统收集,专业HSE工程师识别,每周更新、月度升级,确保法规库有效性。

专业服务

权威的收集途径,我们的法规标准均来自国家部委、标准发布平台,权威,有效。

可控性强

可在线对法规库进行筛选,关键字搜索,分类选择、日期筛选等服务

能下载HSE法规标准全文才能更好用

对,我们也是这么认为的,并且应该更简洁。

规则采集文章软件(如何做利用网络信息采集专家做推广?(一)(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2022-04-20 03:21

在采集横行的时代,采集软件已经成为各大站长的标配工具,不管你是垃圾站还是NB的大网站,或多或少都需要使用 采集 软件将内容添加到他们的 网站。但仅仅将采集软件作为内容维护工具,并没有将其发挥得淋漓尽致。采集软件发展到这个阶段,功能已经很强大了。只要这些功能使用得当,就会获得更多的增值效果。下面以我接手的贵阳爱诚网为例,为大家介绍一下如何利用网络信息采集专家进行推广。1、QQ推广。现在QQ群推广已经成为网站推广很重要的一种方式,尤其是目标明确的行业站和地方站。以我为例,我推广的是贵阳本地生活社区,我会通过采集软件去QQ群信息网站采集贵阳本地2000多个群,离开具有大量活动和大量人员的团体。加入这些群组可以通过多种方式进行 推广。具体方法可以参考很多关于QQ群推广的文章。对于本地网站的站长,除了QQ群,本地的城市人才数据也可以是采集,来自采集的QQ数据,你可以用QQ邮件群发,也可以用来推广QQ空间消息,绝对有粘性,要知道,当很多QQ设置有新邮件或新消息时,屏幕下方会出现一个QQ提示框。2、使用站长统计进行推广。之前看过一篇文章的文章,讲的是用站长统计的方法来推广网站。主要原则是很多站长都会定期查看自己的网站统计,特别喜欢看访问方式。一旦找到非百度和谷歌的常用方式,我会很好奇点击这个方式看看对方是什么网站,为什么这里有访问我的链接。这是关于使用站长统计方法来推广网站。主要原则是很多站长都会定期查看自己的网站统计,特别喜欢看访问方式。一旦找到非百度和谷歌的常用方式,我会很好奇点击这个方式看看对方是什么网站,为什么这里有访问我的链接。这是关于使用站长统计方法来推广网站。主要原则是很多站长都会定期查看自己的网站统计,特别喜欢看访问方式。一旦找到非百度和谷歌的常用方式,我会很好奇点击这个方式看看对方是什么网站,为什么这里有访问我的链接。

这无意中增加了来自 网站 的命中数。看了这篇文章,觉得这个方法不错,但是有没有更高效的方法,可以让我的网站作为大量相关网站的访问源?,有两个关键词,一个是有效率的,如果一次只能做几十个网站,是没有效果的;另一个是相关的,如果你伪造的方式访问规模很大网站,估计对方的管理员不会从大量的访问数据中注意到你的出处,如果你的伪造的起源与对方的网站关系不大,对方就算以后访问你的网站,也不会对你的网站感兴趣。想到这里,我有了一个想法,我想用 采集 软件来做。现在大部分采集软件都可以支持origin,也就是使用referer参数。这个采集任务怎么做 嗯,我在贵阳找了一个网站分类目录,把这个目录的URL作为采集软件的起始地址,然后加上我的网站地址到referer参数,并启动采集,在采集速度的过程中,贵阳地区大量网站被伪造路由访问。这样做的效果是很明显的,在那段时间添加了很多的访问ip。,很多当地的行业网站在看到我们来自哪里后,也向我们寻求合作。zh201308 法兰3、求链接。在建立友谊链接时,

4、批量添加外部链接。现在有一个技巧可以在很短的时间内添加大量的外部链接,那就是使用各种查询目录,比如站长常用的查pr,查Alexa排名网站,很多网站提交查询后,会在查询页面留下最近查询的网站XXX,相当于在这个页面为你创建了一个外链,虽然这些外链很容易消失,但是当你提交到成千上万个这样的查询目录时,总会留下很多,更不用说这些查询目录的页面pr比较高了。然后使用采集软件将你的网站批量提交到这些查询目录,但前提是你需要有这些查询目录的URL和参数信息。查询目录地址。5、内容伪原创。采集的文章有很多,不代表你会被搜索引擎获取很多收录。即使你得到很多收录,也很难排在搜索结果的顶部。这只有一个原因,你的采集文章不是原创,有很多伪原创工具和软件,但我建议你走远,很多采集软件现在提供了结果替换功能,你只需要找到一个词汇替换表来替换它,例如用他替换它,用好替换好等等。6、资源交换法。使用采集软件,你可以整合很多资源采集,然后发布这些资源。发布的时候把你的网站地址添加到内容中,或者发布的时候网站在网站上留下你的网址,你也可以给一些有兴趣的站长提供这些综合资源,前提是他们可以链接到你. 我有采集网站 几千个flash 小游戏,然后发布或提供给需要它们的网站管理员并要求他们链接到我。 查看全部

规则采集文章软件(如何做利用网络信息采集专家做推广?(一)(图))

在采集横行的时代,采集软件已经成为各大站长的标配工具,不管你是垃圾站还是NB的大网站,或多或少都需要使用 采集 软件将内容添加到他们的 网站。但仅仅将采集软件作为内容维护工具,并没有将其发挥得淋漓尽致。采集软件发展到这个阶段,功能已经很强大了。只要这些功能使用得当,就会获得更多的增值效果。下面以我接手的贵阳爱诚网为例,为大家介绍一下如何利用网络信息采集专家进行推广。1、QQ推广。现在QQ群推广已经成为网站推广很重要的一种方式,尤其是目标明确的行业站和地方站。以我为例,我推广的是贵阳本地生活社区,我会通过采集软件去QQ群信息网站采集贵阳本地2000多个群,离开具有大量活动和大量人员的团体。加入这些群组可以通过多种方式进行 推广。具体方法可以参考很多关于QQ群推广的文章。对于本地网站的站长,除了QQ群,本地的城市人才数据也可以是采集,来自采集的QQ数据,你可以用QQ邮件群发,也可以用来推广QQ空间消息,绝对有粘性,要知道,当很多QQ设置有新邮件或新消息时,屏幕下方会出现一个QQ提示框。2、使用站长统计进行推广。之前看过一篇文章的文章,讲的是用站长统计的方法来推广网站。主要原则是很多站长都会定期查看自己的网站统计,特别喜欢看访问方式。一旦找到非百度和谷歌的常用方式,我会很好奇点击这个方式看看对方是什么网站,为什么这里有访问我的链接。这是关于使用站长统计方法来推广网站。主要原则是很多站长都会定期查看自己的网站统计,特别喜欢看访问方式。一旦找到非百度和谷歌的常用方式,我会很好奇点击这个方式看看对方是什么网站,为什么这里有访问我的链接。这是关于使用站长统计方法来推广网站。主要原则是很多站长都会定期查看自己的网站统计,特别喜欢看访问方式。一旦找到非百度和谷歌的常用方式,我会很好奇点击这个方式看看对方是什么网站,为什么这里有访问我的链接。

这无意中增加了来自 网站 的命中数。看了这篇文章,觉得这个方法不错,但是有没有更高效的方法,可以让我的网站作为大量相关网站的访问源?,有两个关键词,一个是有效率的,如果一次只能做几十个网站,是没有效果的;另一个是相关的,如果你伪造的方式访问规模很大网站,估计对方的管理员不会从大量的访问数据中注意到你的出处,如果你的伪造的起源与对方的网站关系不大,对方就算以后访问你的网站,也不会对你的网站感兴趣。想到这里,我有了一个想法,我想用 采集 软件来做。现在大部分采集软件都可以支持origin,也就是使用referer参数。这个采集任务怎么做 嗯,我在贵阳找了一个网站分类目录,把这个目录的URL作为采集软件的起始地址,然后加上我的网站地址到referer参数,并启动采集,在采集速度的过程中,贵阳地区大量网站被伪造路由访问。这样做的效果是很明显的,在那段时间添加了很多的访问ip。,很多当地的行业网站在看到我们来自哪里后,也向我们寻求合作。zh201308 法兰3、求链接。在建立友谊链接时,

4、批量添加外部链接。现在有一个技巧可以在很短的时间内添加大量的外部链接,那就是使用各种查询目录,比如站长常用的查pr,查Alexa排名网站,很多网站提交查询后,会在查询页面留下最近查询的网站XXX,相当于在这个页面为你创建了一个外链,虽然这些外链很容易消失,但是当你提交到成千上万个这样的查询目录时,总会留下很多,更不用说这些查询目录的页面pr比较高了。然后使用采集软件将你的网站批量提交到这些查询目录,但前提是你需要有这些查询目录的URL和参数信息。查询目录地址。5、内容伪原创。采集的文章有很多,不代表你会被搜索引擎获取很多收录。即使你得到很多收录,也很难排在搜索结果的顶部。这只有一个原因,你的采集文章不是原创,有很多伪原创工具和软件,但我建议你走远,很多采集软件现在提供了结果替换功能,你只需要找到一个词汇替换表来替换它,例如用他替换它,用好替换好等等。6、资源交换法。使用采集软件,你可以整合很多资源采集,然后发布这些资源。发布的时候把你的网站地址添加到内容中,或者发布的时候网站在网站上留下你的网址,你也可以给一些有兴趣的站长提供这些综合资源,前提是他们可以链接到你. 我有采集网站 几千个flash 小游戏,然后发布或提供给需要它们的网站管理员并要求他们链接到我。

规则采集文章软件(SEO优化wordpress插件热门插件大全就是这么简单!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-04-19 18:38

WordPress 插件。最近有很多站长问我有没有什么流行的WordPress插件可以推荐。它主要是一个用于 SEO 优化的 wordpress 插件。WordPress采集插件、WordPress流行关键词插件、WordPress百度推送插件、WordPress搜索引擎蜘蛛统计分析插件、WordPress翻译插件等。不要问,问是各种插件都应该到了那里,今天就来聊聊wordpress插件吧。

wordpress采集插件,wp站长都知道wordpress本身不提供文章采集伪原创发布功能,需要用到wordpress采集插件使用很多长尾的文章采集伪原创@关键词做全网文章关键词pan采集,然后需要注意即虽然wordpress采集插件数据源丰富,文章不用担心内容质量的来源,但是来自这些数据源的文章采集需要由伪原创文章供搜索引擎处理,再结合文章聚合+Tag标签聚合,最后释放文章。

Wordpress 采集 插件不需要任何采集 规则,完全实现一键爬取任务。支持365天无限循环挂机采集维护全部网站。设置好相关参数后,软件会从第一个开始,完成全自动采集和维护,移动到下一个站点更新。它不断循环,可以轻松管理数十或数百个站点。

function remove\_comment\_fields($fields) {

unset($fields\['url'\]);

return $fields;

}

add\_filter('comment\_form\_default\_fields','remove\_comment\_fields');

function wpd\_remove\_comment\_website\_field( $fields ) {

unset( $fields\['url'\] );

return $fields;

}

add\_filter( 'astra\_comment\_form\_default\_fields\_markup', 'wpd\_remove\_comment\_website\_field', 99 );

Wordpress采集插件几乎可以是你想要的格式采集,只要你能在浏览器中看到内容。

wordpress热门关键词插件可以通过百度下拉词和百度相关搜索词获取,支持搜狗、百度、今日头条下拉词和相关搜索词,最后是wordpress热门关键词插件可以形成大量与网站关键词相关的长尾关键词,让你网站成为搜索引擎更多的收录,获得更好的SEO排名。然后将那些长尾关键词自动从互联网采集定位到最新的文章、图片、视频等。

wordpress的百度推送插件,我们都知道推送是SEO的重要组成部分。通过百度推送插件,我们在wordpress采集伪原创发布后主动推送文章一键批量搜索方便文章及时收录通过搜索引擎,保护了网站的原创性质,避免了网站内容的同质化。

特别是提交新站点最快的方法是建议wordpress百度推送插件将站点的新输出链接推送到百度,从而保证新链接可以被百度收录在时间。与sitemap相比,及时推送、查找和抓取更快。我们网站生成的新内容最好第一时间自动推送到百度,效果更好;自动推送受推送次数限制。尽量不要向百度推送重复的内容。这将极大地浪费您自己的可推送资源。

Wordpress搜索引擎蜘蛛统计分析插件,今日蜘蛛——方便站长快速了解当日、昨天、30天的平均访问蜘蛛数、抓取网址数和平均抓取网址数。

WordPress搜索引擎蜘蛛统计分析插件提供蜘蛛趋势图-支持查看蜘蛛数量、抓取的网址总数以及根据今天、昨天、最近7天和最近的抓取网址的平均趋势30天。数据进行比较分析。

WordPress 搜索引擎蜘蛛统计分析插件统计 Top10 蜘蛛 - 支持查看今天、昨天、最近 7 天和最近 30 天爬取的 URL 数量和 Top10 蜘蛛的比例。

WordPress搜索引擎蜘蛛统计分析插件可以统计前10名蜘蛛抓取的网址——支持查看今天、昨天、最近7天和最近30天前10名蜘蛛抓取网址的抓取次数和比例,其中方便站长抓取热门蜘蛛取页面URL进行分析。

WordPress翻译插件主要有百度、谷歌、有道、讯飞、147翻译等。wordpre翻译插件支持内容转繁体、内容转英文、内容转火星文、内容转拼音、内容转繁体、英文、拼音、火星文等,非常有利于SEO优化。

WordPress网站建设优化是一个长期的过程。一定要懂得使用各种wordpress插件做网站SEO优化,这样就不会重复造轮子,SEO优化效果才会有效。今天关于wordpress插件的解释就到这里了。在这里,下期分享更多的SEO知识和SEO技巧。 查看全部

规则采集文章软件(SEO优化wordpress插件热门插件大全就是这么简单!)

WordPress 插件。最近有很多站长问我有没有什么流行的WordPress插件可以推荐。它主要是一个用于 SEO 优化的 wordpress 插件。WordPress采集插件、WordPress流行关键词插件、WordPress百度推送插件、WordPress搜索引擎蜘蛛统计分析插件、WordPress翻译插件等。不要问,问是各种插件都应该到了那里,今天就来聊聊wordpress插件吧。

wordpress采集插件,wp站长都知道wordpress本身不提供文章采集伪原创发布功能,需要用到wordpress采集插件使用很多长尾的文章采集伪原创@关键词做全网文章关键词pan采集,然后需要注意即虽然wordpress采集插件数据源丰富,文章不用担心内容质量的来源,但是来自这些数据源的文章采集需要由伪原创文章供搜索引擎处理,再结合文章聚合+Tag标签聚合,最后释放文章。

Wordpress 采集 插件不需要任何采集 规则,完全实现一键爬取任务。支持365天无限循环挂机采集维护全部网站。设置好相关参数后,软件会从第一个开始,完成全自动采集和维护,移动到下一个站点更新。它不断循环,可以轻松管理数十或数百个站点。

function remove\_comment\_fields($fields) {

unset($fields\['url'\]);

return $fields;

}

add\_filter('comment\_form\_default\_fields','remove\_comment\_fields');

function wpd\_remove\_comment\_website\_field( $fields ) {

unset( $fields\['url'\] );

return $fields;

}

add\_filter( 'astra\_comment\_form\_default\_fields\_markup', 'wpd\_remove\_comment\_website\_field', 99 );

Wordpress采集插件几乎可以是你想要的格式采集,只要你能在浏览器中看到内容。

wordpress热门关键词插件可以通过百度下拉词和百度相关搜索词获取,支持搜狗、百度、今日头条下拉词和相关搜索词,最后是wordpress热门关键词插件可以形成大量与网站关键词相关的长尾关键词,让你网站成为搜索引擎更多的收录,获得更好的SEO排名。然后将那些长尾关键词自动从互联网采集定位到最新的文章、图片、视频等。

wordpress的百度推送插件,我们都知道推送是SEO的重要组成部分。通过百度推送插件,我们在wordpress采集伪原创发布后主动推送文章一键批量搜索方便文章及时收录通过搜索引擎,保护了网站的原创性质,避免了网站内容的同质化。

特别是提交新站点最快的方法是建议wordpress百度推送插件将站点的新输出链接推送到百度,从而保证新链接可以被百度收录在时间。与sitemap相比,及时推送、查找和抓取更快。我们网站生成的新内容最好第一时间自动推送到百度,效果更好;自动推送受推送次数限制。尽量不要向百度推送重复的内容。这将极大地浪费您自己的可推送资源。

Wordpress搜索引擎蜘蛛统计分析插件,今日蜘蛛——方便站长快速了解当日、昨天、30天的平均访问蜘蛛数、抓取网址数和平均抓取网址数。

WordPress搜索引擎蜘蛛统计分析插件提供蜘蛛趋势图-支持查看蜘蛛数量、抓取的网址总数以及根据今天、昨天、最近7天和最近的抓取网址的平均趋势30天。数据进行比较分析。

WordPress 搜索引擎蜘蛛统计分析插件统计 Top10 蜘蛛 - 支持查看今天、昨天、最近 7 天和最近 30 天爬取的 URL 数量和 Top10 蜘蛛的比例。

WordPress搜索引擎蜘蛛统计分析插件可以统计前10名蜘蛛抓取的网址——支持查看今天、昨天、最近7天和最近30天前10名蜘蛛抓取网址的抓取次数和比例,其中方便站长抓取热门蜘蛛取页面URL进行分析。

WordPress翻译插件主要有百度、谷歌、有道、讯飞、147翻译等。wordpre翻译插件支持内容转繁体、内容转英文、内容转火星文、内容转拼音、内容转繁体、英文、拼音、火星文等,非常有利于SEO优化。

WordPress网站建设优化是一个长期的过程。一定要懂得使用各种wordpress插件做网站SEO优化,这样就不会重复造轮子,SEO优化效果才会有效。今天关于wordpress插件的解释就到这里了。在这里,下期分享更多的SEO知识和SEO技巧。

规则采集文章软件(优博评书文库的评书采集软件是网络并评书爱好者所著评书资源)

采集交流 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2022-04-19 01:05

规则采集文章软件有很多,但是使用时尽量避免打破僵局,“双端说法不同”。优博评书文库的评书采集软件是一款由评书从业者实际测试并反馈得出的结果。优博评书文库使用的是网络转录并评书爱好者所著评书资源的作者所创作的作品(共30000篇+,或者使用uc浏览器的“文库”功能整个资源库清理,清理后大概也有10000篇+的书),经过人工审读和筛选后的著作。

微软的有一个科学上网的方法:我觉得不方便的话可以用hao123、人人、新浪网上面的评书站上面的资源,现在的新浪高清评书站的资源也比较多,

很多啊,有一个叫ggtext的软件,

从百度网盘取文字来截图排版ps真的挺方便的图没截好下面说说我每天收到的各种问题,有些真的是莫名其妙就不能加载了,有些明明就能收到图片为什么收不到视频,有些视频是秒播但是加载加载还是加载不出来,有些点开视频完整屏幕显示动图有些播放器不显示字幕,有些视频因为调低了分辨率显示不清楚,有些播放器是支持云朗读的视频但是文字正在高清状态但是文字却没有显示出来,有些视频只能收到评书但是不能收到视频,有些视频只能收到评书且不能下载音频文件,有些视频只能收到评书但是不能收到图片,有些视频只能收到评书却不能收到图片,有些视频只能收到一个评书但是每个都不是最优质的,有些是没有字幕文件但是软件没显示清楚,有些是加载起来没有文件但是还是不能下载音频文件,有些是评书软件有语音没有音频软件是否不该收费,是否不该下载音频文件,有些评书软件没有显示字幕文件有些甚至都没有显示字幕文件,有些没有显示字幕文件看着不够清楚,有些看着看着就跳过看到了那个问题里的一个优质评书站里的评书,虽然只能看到评书但是不能看到书,有些有字幕文件但是不能点开小说边界但是无法下载字幕文件,看评书需要收藏的书不但收藏不了,下载的字幕还会丢失甚至无法在下载下来可能是因为视频安装得不够好或者没有人维护所以导致各种问题突然地多了起来,我希望得到官方的解决。 查看全部

规则采集文章软件(优博评书文库的评书采集软件是网络并评书爱好者所著评书资源)

规则采集文章软件有很多,但是使用时尽量避免打破僵局,“双端说法不同”。优博评书文库的评书采集软件是一款由评书从业者实际测试并反馈得出的结果。优博评书文库使用的是网络转录并评书爱好者所著评书资源的作者所创作的作品(共30000篇+,或者使用uc浏览器的“文库”功能整个资源库清理,清理后大概也有10000篇+的书),经过人工审读和筛选后的著作。

微软的有一个科学上网的方法:我觉得不方便的话可以用hao123、人人、新浪网上面的评书站上面的资源,现在的新浪高清评书站的资源也比较多,

很多啊,有一个叫ggtext的软件,

从百度网盘取文字来截图排版ps真的挺方便的图没截好下面说说我每天收到的各种问题,有些真的是莫名其妙就不能加载了,有些明明就能收到图片为什么收不到视频,有些视频是秒播但是加载加载还是加载不出来,有些点开视频完整屏幕显示动图有些播放器不显示字幕,有些视频因为调低了分辨率显示不清楚,有些播放器是支持云朗读的视频但是文字正在高清状态但是文字却没有显示出来,有些视频只能收到评书但是不能收到视频,有些视频只能收到评书且不能下载音频文件,有些视频只能收到评书但是不能收到图片,有些视频只能收到评书却不能收到图片,有些视频只能收到一个评书但是每个都不是最优质的,有些是没有字幕文件但是软件没显示清楚,有些是加载起来没有文件但是还是不能下载音频文件,有些是评书软件有语音没有音频软件是否不该收费,是否不该下载音频文件,有些评书软件没有显示字幕文件有些甚至都没有显示字幕文件,有些没有显示字幕文件看着不够清楚,有些看着看着就跳过看到了那个问题里的一个优质评书站里的评书,虽然只能看到评书但是不能看到书,有些有字幕文件但是不能点开小说边界但是无法下载字幕文件,看评书需要收藏的书不但收藏不了,下载的字幕还会丢失甚至无法在下载下来可能是因为视频安装得不够好或者没有人维护所以导致各种问题突然地多了起来,我希望得到官方的解决。

规则采集文章软件(2020年这款软件的优秀之处是什么样的?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2022-04-18 09:14

2020年,如果我要推荐一款流行的数据采集软件,那就是优采云采集器。和我之前推荐的网络爬虫相比,如果说网络爬虫是一把小巧精致的瑞士军刀,那么优采云采集器就是一把大而全的重武器,基本可以解决所有数据爬取问题。

说说这款软件的优势吧。

一、产品特点1.跨平台

优采云采集器是一款桌面应用软件,支持Linux、Windows、Mac三大操作系统,可直接从官网免费下载。

2.强大

优采云采集器将采集作业分为两种:智能模式和流程图模式。

智能模式是在加载网页后,软件自动分析网页结构,智能识别网页内容,简化操作流程。这种模式更适合简单的网页。经过我的测试,识别准确率相当高。

流程图模式的本质是图形化编程。我们可以使用优采云采集器提供的各种控件来模拟编程语言中的各种条件控制语句,从而模拟真人浏览网页爬取数据的各种行为。

3.无限导出

这可以说是优采云采集器最良心的功能了。

市场上有很多数据采集软件,出于商业化目的,数据导出或多或少受到限制。不懂套路的人经常用相关软件采集大量的数据,发现导出数据要花钱。

优采云采集器 没有这个问题。其支付点主要体现在IP池、采集加速等高级功能上。不仅导出数据不花钱,还支持Excel、CSV、TXT、HTML多种导出格式,支持直接导出到数据库,对于普通用户来说完全够用了。

4.教程详情

在开始写这篇文章之前,我想过为优采云采集器写几篇教程,但是看了他们官网的教程后,我知道这没有必要,因为写得太详细了。

优采云采集器官网提供两种教程,一种是视频教程,每个视频五分钟左右;另一种是图文教程,动手教学。看完这两类教程,你也可以看看他们的文档中心,也很详细,基本涵盖了软件的每一个功能点。

二、基本功能1.数据采集

基本的数据抓取很简单:我们只需要点击“添加字段”按钮,就会出现一个选择魔棒,然后点击要抓取的数据,然后数据就可以采集了:

2.翻页功能

当我介绍网络爬虫时,我将页面转换分为 3 类:滚动加载、寻呼机加载和点击下一页加载。

对于这三种基本翻页类型,也完全支持 优采云采集器。

不同于网络爬虫的分页功能分散在各种选择器上,优采云采集器的分页配置集中在一处,只需从下拉列表中选择即可轻松配置分页模式。相关配置教程可参见官网教程:如何设置分页。

3.复杂形式

对于一些有多重联动筛选的网页,优采云采集器也能很好的处理。我们可以使用优采云采集器中的流程图模式来自定义一些交互规则。

比如下图中,我使用了流程图模式下的click组件来模拟点击过滤器按钮,非常方便。

三、进阶使用1.数据清洗

我在介绍网络爬虫的时候说过网络爬虫只提供基本的正则匹配功能,可以在数据爬取过程中对数据进行初步清洗。

相比之下,优采云采集器提供了更多的功能:强大的过滤配置、完整的正则化功能和全面的文字处理配置。当然,强大的功能也带来了复杂度的增加,需要更多的耐心去学习和使用。

以下是官网数据清洗相关的教程,大家可以参考学习:

2.流程图模式

正如本文前面提到的,流程图模式的本质是图形化编程。我们可以使用优采云采集器提供的各种控件来模拟编程语言中的各种条件控制语句,从而模拟真人浏览网页爬取数据的各种行为。

比如下图的流程图,就是模拟真人浏览微博时的行为,抓取相关数据。

经过几次亲身测试,我认为流程图模式有一定的学习门槛,但相比从零开始学习python爬虫,学习曲线还是要轻松很多。如果你对流程图模式很感兴趣,可以去官网学习,写的很详细。

3.XPath/CSS/正则表达式

不管是什么爬虫软件,都是按照一定的规则来爬取数据的。XPath/CSS/Regex 只是一些常见的匹配规则。优采云采集器支持自定义这些选择器,可以更灵活的选择要抓取的数据。

比如网页中有数据A,但是只有当鼠标移到相应的文本上时才会以弹窗的形式显示出来。这时候我们就可以写一个对应的选择器来过滤数据了。

XPath

XPath 是一种在爬虫中广泛使用的数据查询语言。我们可以通过 XPath 教程学习这种语言的使用。

CSS

这里的 CSS 特指 CSS 选择器。在介绍网络爬虫的高级技术时,我解释了 CSS 选择器的使用场景和注意事项。有兴趣的可以阅读我写的 CSS 选择器教程。

正则表达式

正则表达式是一个正则表达式。我们也可以通过正则表达式来选择数据。我还写了一些正则表达式教程。但我个人认为,在字段选择器场景中,正则表达式不如 XPath 和 CSS 选择器好用。

4.定时抓包/IP池/编码功能

这些都是优采云采集器的付费功能。我没有会员,所以不知道体验如何。在这里,我将做一个小科学,并向您解释这些术语的含义。

定时爬行

定时爬取很容易理解,就是爬虫软件会在某个固定时间自动抓取数据。市面上有一些比价软件,背后有很多定时爬虫,每隔几分钟就抓取一次价格信息,达到监控价格的目的。

IP 池

互联网上 90% 的流量是由爬虫贡献的。为了减轻服务器的压力,互联网公司有一些风控策略,其中之一就是限制IP流量。比如某互联网公司检测到某个IP有大量数据请求,超出正常范围,会暂时封锁该IP,不返回相关数据。这时候爬虫软件会自己维护一个IP池,用不同的IP发送请求,减少IP阻塞的概率。

编码功能

该功能是内置验证码识别器,可以实现机器编码或人工编码,也是绕过网站风控的一种方式。

四、总结

个人认为优采云采集器是一款非常不错的数据采集软件。它提供的免费功能可以解决大部分程序员的数据采集需求。

如果有一些编程基础,可以清楚的看出一些函数是编程语言逻辑的封装。例如,流程图模式是对流程控制的封装,数据清洗功能是对字符串处理函数的封装。这些高级特性扩展了优采云采集器的能力,增加了学习的难度。

个人认为,如果是轻量级的数据抓取需求,我更倾向于使用web scraper;需求比较复杂,优采云采集器是个不错的选择;如果涉及到定时爬取等高级需求,自己编写爬虫代码比较可控。

总而言之,优采云采集器是一款优秀的数据采集软件,强烈推荐大家学习使用。 查看全部

规则采集文章软件(2020年这款软件的优秀之处是什么样的?)

2020年,如果我要推荐一款流行的数据采集软件,那就是优采云采集器。和我之前推荐的网络爬虫相比,如果说网络爬虫是一把小巧精致的瑞士军刀,那么优采云采集器就是一把大而全的重武器,基本可以解决所有数据爬取问题。

说说这款软件的优势吧。

一、产品特点1.跨平台

优采云采集器是一款桌面应用软件,支持Linux、Windows、Mac三大操作系统,可直接从官网免费下载。

2.强大

优采云采集器将采集作业分为两种:智能模式和流程图模式。

智能模式是在加载网页后,软件自动分析网页结构,智能识别网页内容,简化操作流程。这种模式更适合简单的网页。经过我的测试,识别准确率相当高。

流程图模式的本质是图形化编程。我们可以使用优采云采集器提供的各种控件来模拟编程语言中的各种条件控制语句,从而模拟真人浏览网页爬取数据的各种行为。

3.无限导出

这可以说是优采云采集器最良心的功能了。

市场上有很多数据采集软件,出于商业化目的,数据导出或多或少受到限制。不懂套路的人经常用相关软件采集大量的数据,发现导出数据要花钱。

优采云采集器 没有这个问题。其支付点主要体现在IP池、采集加速等高级功能上。不仅导出数据不花钱,还支持Excel、CSV、TXT、HTML多种导出格式,支持直接导出到数据库,对于普通用户来说完全够用了。

4.教程详情

在开始写这篇文章之前,我想过为优采云采集器写几篇教程,但是看了他们官网的教程后,我知道这没有必要,因为写得太详细了。

优采云采集器官网提供两种教程,一种是视频教程,每个视频五分钟左右;另一种是图文教程,动手教学。看完这两类教程,你也可以看看他们的文档中心,也很详细,基本涵盖了软件的每一个功能点。

二、基本功能1.数据采集

基本的数据抓取很简单:我们只需要点击“添加字段”按钮,就会出现一个选择魔棒,然后点击要抓取的数据,然后数据就可以采集了:

2.翻页功能

当我介绍网络爬虫时,我将页面转换分为 3 类:滚动加载、寻呼机加载和点击下一页加载。

对于这三种基本翻页类型,也完全支持 优采云采集器。

不同于网络爬虫的分页功能分散在各种选择器上,优采云采集器的分页配置集中在一处,只需从下拉列表中选择即可轻松配置分页模式。相关配置教程可参见官网教程:如何设置分页。

3.复杂形式

对于一些有多重联动筛选的网页,优采云采集器也能很好的处理。我们可以使用优采云采集器中的流程图模式来自定义一些交互规则。

比如下图中,我使用了流程图模式下的click组件来模拟点击过滤器按钮,非常方便。

三、进阶使用1.数据清洗

我在介绍网络爬虫的时候说过网络爬虫只提供基本的正则匹配功能,可以在数据爬取过程中对数据进行初步清洗。

相比之下,优采云采集器提供了更多的功能:强大的过滤配置、完整的正则化功能和全面的文字处理配置。当然,强大的功能也带来了复杂度的增加,需要更多的耐心去学习和使用。

以下是官网数据清洗相关的教程,大家可以参考学习:

2.流程图模式

正如本文前面提到的,流程图模式的本质是图形化编程。我们可以使用优采云采集器提供的各种控件来模拟编程语言中的各种条件控制语句,从而模拟真人浏览网页爬取数据的各种行为。

比如下图的流程图,就是模拟真人浏览微博时的行为,抓取相关数据。

经过几次亲身测试,我认为流程图模式有一定的学习门槛,但相比从零开始学习python爬虫,学习曲线还是要轻松很多。如果你对流程图模式很感兴趣,可以去官网学习,写的很详细。

3.XPath/CSS/正则表达式

不管是什么爬虫软件,都是按照一定的规则来爬取数据的。XPath/CSS/Regex 只是一些常见的匹配规则。优采云采集器支持自定义这些选择器,可以更灵活的选择要抓取的数据。

比如网页中有数据A,但是只有当鼠标移到相应的文本上时才会以弹窗的形式显示出来。这时候我们就可以写一个对应的选择器来过滤数据了。

XPath

XPath 是一种在爬虫中广泛使用的数据查询语言。我们可以通过 XPath 教程学习这种语言的使用。

CSS

这里的 CSS 特指 CSS 选择器。在介绍网络爬虫的高级技术时,我解释了 CSS 选择器的使用场景和注意事项。有兴趣的可以阅读我写的 CSS 选择器教程。

正则表达式

正则表达式是一个正则表达式。我们也可以通过正则表达式来选择数据。我还写了一些正则表达式教程。但我个人认为,在字段选择器场景中,正则表达式不如 XPath 和 CSS 选择器好用。

4.定时抓包/IP池/编码功能

这些都是优采云采集器的付费功能。我没有会员,所以不知道体验如何。在这里,我将做一个小科学,并向您解释这些术语的含义。

定时爬行

定时爬取很容易理解,就是爬虫软件会在某个固定时间自动抓取数据。市面上有一些比价软件,背后有很多定时爬虫,每隔几分钟就抓取一次价格信息,达到监控价格的目的。

IP 池

互联网上 90% 的流量是由爬虫贡献的。为了减轻服务器的压力,互联网公司有一些风控策略,其中之一就是限制IP流量。比如某互联网公司检测到某个IP有大量数据请求,超出正常范围,会暂时封锁该IP,不返回相关数据。这时候爬虫软件会自己维护一个IP池,用不同的IP发送请求,减少IP阻塞的概率。

编码功能

该功能是内置验证码识别器,可以实现机器编码或人工编码,也是绕过网站风控的一种方式。

四、总结

个人认为优采云采集器是一款非常不错的数据采集软件。它提供的免费功能可以解决大部分程序员的数据采集需求。

如果有一些编程基础,可以清楚的看出一些函数是编程语言逻辑的封装。例如,流程图模式是对流程控制的封装,数据清洗功能是对字符串处理函数的封装。这些高级特性扩展了优采云采集器的能力,增加了学习的难度。

个人认为,如果是轻量级的数据抓取需求,我更倾向于使用web scraper;需求比较复杂,优采云采集器是个不错的选择;如果涉及到定时爬取等高级需求,自己编写爬虫代码比较可控。

总而言之,优采云采集器是一款优秀的数据采集软件,强烈推荐大家学习使用。

规则采集文章软件(优采云采集器图一功能特色1.论坛采集专家采集功能详解(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-04-18 07:39

随着互联网和工业物联网的不断发展,数据采集的必要性越来越明显。在我们的日常工作中,data采集 模块的作用越来越重要。本文文章推荐并分享一款专业的数据采集工具。详细了解后,可以直接从本站下载使用。

软件介绍

优采云采集器是一款专业全面的采集工具,具有处理、分析、挖掘等多种功能,在使用过程中支持采集99%网页比普通的 采集器 快 采集7 倍。在优采云采集器软件中,还支持远程下载图片文件和登录后网站信息采集。该软件使用自定义用户cms 系统。一个可以实现采集任何网页数据发布到远程服务器的模块。

优采云采集器 图 1

特征

1.论坛采集专家采集功能非常强大,支持采集页面的各种内容,如标题、用户名、签名、内容、头像、附件、注册时间、等等等等,也支持添加采集的字段。

2.论坛采集专家智能生成采集规则,系统具有普通轮胎自动识别规则功能,可为用户自动生成采集规则,使更方便用户流畅使用。

3. 软件具有自动回复消息的功能,支持发送回复帖,同时更方便用户在手机上使用各种回复帖的内容。也适用于页面中的隐藏附件 采集。

优采云采集器 图 2

4. 提供回复部分的增量采集功能,用户可以采集最新的回复内容并发布。支持处理各种论坛的更新问题和贴吧序列化。

5.支持用户开发插件,通过灵活的接口,可以采集更复杂的网站数据,处理各种数据。

6.提供文件下载功能,软件还提供翻译、分词、代理等,优采云采集器的各种实用功能。

7.允许用户搜索关键词到采集各种帖子的网址,也可以批量设置关键词,方便查询采集。

优采云采集器 图 3

8. 对于采集 及以后的网站,提供自动登录功能,减少用户的工作程序。目前支持主流Discuz、PHPWind论坛,显示不支持验证码的登录方式。

9. 本软件界面可以自动注册账号、处理话题、处理头像和回复功能。同时,官方界面也在不断的更新和维护中。相信未来会提供更强大、更便捷的功能。 查看全部

规则采集文章软件(优采云采集器图一功能特色1.论坛采集专家采集功能详解(组图))

随着互联网和工业物联网的不断发展,数据采集的必要性越来越明显。在我们的日常工作中,data采集 模块的作用越来越重要。本文文章推荐并分享一款专业的数据采集工具。详细了解后,可以直接从本站下载使用。

软件介绍

优采云采集器是一款专业全面的采集工具,具有处理、分析、挖掘等多种功能,在使用过程中支持采集99%网页比普通的 采集器 快 采集7 倍。在优采云采集器软件中,还支持远程下载图片文件和登录后网站信息采集。该软件使用自定义用户cms 系统。一个可以实现采集任何网页数据发布到远程服务器的模块。

优采云采集器 图 1

特征

1.论坛采集专家采集功能非常强大,支持采集页面的各种内容,如标题、用户名、签名、内容、头像、附件、注册时间、等等等等,也支持添加采集的字段。

2.论坛采集专家智能生成采集规则,系统具有普通轮胎自动识别规则功能,可为用户自动生成采集规则,使更方便用户流畅使用。

3. 软件具有自动回复消息的功能,支持发送回复帖,同时更方便用户在手机上使用各种回复帖的内容。也适用于页面中的隐藏附件 采集。

优采云采集器 图 2

4. 提供回复部分的增量采集功能,用户可以采集最新的回复内容并发布。支持处理各种论坛的更新问题和贴吧序列化。

5.支持用户开发插件,通过灵活的接口,可以采集更复杂的网站数据,处理各种数据。

6.提供文件下载功能,软件还提供翻译、分词、代理等,优采云采集器的各种实用功能。

7.允许用户搜索关键词到采集各种帖子的网址,也可以批量设置关键词,方便查询采集。

优采云采集器 图 3

8. 对于采集 及以后的网站,提供自动登录功能,减少用户的工作程序。目前支持主流Discuz、PHPWind论坛,显示不支持验证码的登录方式。

9. 本软件界面可以自动注册账号、处理话题、处理头像和回复功能。同时,官方界面也在不断的更新和维护中。相信未来会提供更强大、更便捷的功能。

规则采集文章软件(优采云站群软件新出一个新的新型采集功能(图) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2022-04-18 07:37

)

>

1、如上图所示,这里是去除网址和采集图片的功能。您可以根据自己的需要检查是否。

2、如上图,这里是设置采集的采集的行数和文章的标题的最小字数。

3、如上图所示,这里可以定义替换词,支持代码替换、文字替换等,这里要灵活使用。对于一些比较难的采集列表,这里会用到。一些代码可以用空格替换以 采集 链接到列表。

以上都是优采云站群软件新增的采集功能。这个功能很强大,但是这个功能还需要改进,以满足不同人的需求。有了这个工具,你就不用担心写不出采集规则了。该功能上手容易,操作简单。是最适合新老站长使用的功能。不明白的可以加我QQ问我:509229860。

长期以来,大家一直在使用各种采集器或网站程序自带的采集功能。它们有一个共同的特点,就是需要编写采集规则。从采集到文章,这个技术问题对于初学者来说不是一件容易的事,对于资深站长来说也是一项艰巨的工作。那么,如果你做站群,每个站都要定义一个采集规则,那真的很惨。有人说站长是网络搬运工。这也是有道理的。文章 在网上,很多人感动了我,我也感动了你,为了活下去,我必须做些什么。现在优采云站群软件新增了新类型采集功能,可以大大减少站长“搬运工”的时间,并且不再需要编写烦人的采集规则现在,这个功能是互联网的第一个功能---指定URL 采集。下面我教大家如何使用这个功能:

一、先开启这个功能。在网站的右键中可以看到这个功能:如下图。

二、打开功能如下,可以在右侧填写指定采集的列表地址:

这里我使用百度的搜索页面作为采集的来源,比如这个地址:%B0%C5%C6%E6

然后我用优采云站群软件把这个搜索结果的采集所有文章。可以先分析一下这个页面,如果用各种类型的采集器或者网站自己的程序自定义采集全部文章,是不可能采用的。因为网上还没有这么通用的采集不同网站功能,但是现在,优采云站群软件可以做到。因为这个软件支持pan采集技术。

三、首页,我把这个百度结果列表填到软件的“文章列表起始地址采集”中,如下图:

四、为了得到正确的列表采集我要,分析结果列表上的文章有一个共同的后缀,即:html,shtml,htm,那么,这就是三个共同点是: 我将 htm 定义为软件。这种做法是为了减少采集无用的页面,如下图:

五、现在可以采集了,不过在这里我要提醒大家,一般一个网站,会有很多相同的字符,对于这个百度列表,有也是百度自己的网页,但是百度自己的网页的内容不是我要采集的,所以还有一个地方把有百度网址的页面排除在外。如下所示:

这样定义之后,就可以避免走百度自己的页面了。这样填写后,可以直接采集文章,点击“保存采集数据”:

一两分钟后,采集 进程的结果如下图所示:

六、这里我只挑文章的一部分,别挑了,现在看采集后面的内容:

七、以上就是采集的流程,按照上面的步骤,还可以采集在其他地方列出文章,尤其是一些没有收录的,或者 screen 避免 收录 的 网站,这些都是 原创 的 文章,你可以自己找。现在让我告诉您该软件的其他一些功能:

查看全部

规则采集文章软件(优采云站群软件新出一个新的新型采集功能(图)

)

>

1、如上图所示,这里是去除网址和采集图片的功能。您可以根据自己的需要检查是否。

2、如上图,这里是设置采集的采集的行数和文章的标题的最小字数。

3、如上图所示,这里可以定义替换词,支持代码替换、文字替换等,这里要灵活使用。对于一些比较难的采集列表,这里会用到。一些代码可以用空格替换以 采集 链接到列表。

以上都是优采云站群软件新增的采集功能。这个功能很强大,但是这个功能还需要改进,以满足不同人的需求。有了这个工具,你就不用担心写不出采集规则了。该功能上手容易,操作简单。是最适合新老站长使用的功能。不明白的可以加我QQ问我:509229860。

长期以来,大家一直在使用各种采集器或网站程序自带的采集功能。它们有一个共同的特点,就是需要编写采集规则。从采集到文章,这个技术问题对于初学者来说不是一件容易的事,对于资深站长来说也是一项艰巨的工作。那么,如果你做站群,每个站都要定义一个采集规则,那真的很惨。有人说站长是网络搬运工。这也是有道理的。文章 在网上,很多人感动了我,我也感动了你,为了活下去,我必须做些什么。现在优采云站群软件新增了新类型采集功能,可以大大减少站长“搬运工”的时间,并且不再需要编写烦人的采集规则现在,这个功能是互联网的第一个功能---指定URL 采集。下面我教大家如何使用这个功能:

一、先开启这个功能。在网站的右键中可以看到这个功能:如下图。

二、打开功能如下,可以在右侧填写指定采集的列表地址:

这里我使用百度的搜索页面作为采集的来源,比如这个地址:%B0%C5%C6%E6

然后我用优采云站群软件把这个搜索结果的采集所有文章。可以先分析一下这个页面,如果用各种类型的采集器或者网站自己的程序自定义采集全部文章,是不可能采用的。因为网上还没有这么通用的采集不同网站功能,但是现在,优采云站群软件可以做到。因为这个软件支持pan采集技术。

三、首页,我把这个百度结果列表填到软件的“文章列表起始地址采集”中,如下图:

四、为了得到正确的列表采集我要,分析结果列表上的文章有一个共同的后缀,即:html,shtml,htm,那么,这就是三个共同点是: 我将 htm 定义为软件。这种做法是为了减少采集无用的页面,如下图:

五、现在可以采集了,不过在这里我要提醒大家,一般一个网站,会有很多相同的字符,对于这个百度列表,有也是百度自己的网页,但是百度自己的网页的内容不是我要采集的,所以还有一个地方把有百度网址的页面排除在外。如下所示:

这样定义之后,就可以避免走百度自己的页面了。这样填写后,可以直接采集文章,点击“保存采集数据”:

一两分钟后,采集 进程的结果如下图所示:

六、这里我只挑文章的一部分,别挑了,现在看采集后面的内容:

七、以上就是采集的流程,按照上面的步骤,还可以采集在其他地方列出文章,尤其是一些没有收录的,或者 screen 避免 收录 的 网站,这些都是 原创 的 文章,你可以自己找。现在让我告诉您该软件的其他一些功能:

规则采集文章软件(宜信公司DBA团队开发的一款数据库审核产品,提升工作效率)

采集交流 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2022-04-16 11:13

一、简介

Themis是宜信DBA团队开发的数据库审计产品,可以帮助DBA和开发人员快速发现数据库质量问题,提高工作效率。它的名字来源于希腊神话中的正义与法律女神。项目的名称意味着这个平台对数据库质量的判断是公正而清晰的。

该平台可以对Oracle和MySQL数据库进行多维度(对象结构、SQL文本、执行计划和执行特征)审计,评估对象结构设计质量和SQL运行效率。可以帮助DBA和开发人员快速发现定位问题;并提供一些辅助诊断能力,提高优化工作效率。所有操作都可以通过WEB界面进行,简单方便。此外,为了更好地满足个性化需求,平台还提供了扩展能力,用户可以根据自己的需要进行扩展。

开源地址:

1.1 功能概述1.2 支持的数据库1.3 审计维度1.4 实现原则

整个平台的基本实现原理很简单,就是通过规则集来过滤我们的审计对象(目前支持四种)。符合规则的审计对象都怀疑有问题。该平台将提供这些问题和相关信息进行人工筛选。可见,平台的强大功能主要取决于规则集的丰富程度。平台还提供了一些扩展能力,方便规则集的扩展。

1.5 平台架构

图中方框部分是平台的主要模块。不同背景颜色的模块表示不同的当前进度状态。虚线代表数据流,实线代表控制流。它的核心是这些模块:

1.6 操作流程

二、环境建设

本项目将使用mysql、mongo和redis。Python 支持 2.6、2.7,但目前不支持 python3。

mysql用于存储pt-query-digest捕获的mysql的慢查询,mongo存储我们的规则、oracle的采集结果、执行作业、解析结果集等,redis作为task的队列调度芹菜。

在 mysql 的数据 采集 部分中,我们使用 pt-query-digest 工具。

2.1 依赖安装创建新用户

为了减少后期对supervisord.conf配置文件的修改,建议使用统一用户进行安装

adduser themis-test

su - themis-test

以下操作默认安装在themis-test用户下,除了virtualenv安装需要切换到root用户。

安装 cx_Oracle 依赖项

由于审计过程中需要连接oracle数据库,所以需要先安装cx_Oracle的依赖,参考:

安装python依赖

先安装virtualenv,参考链接:建议安装13.0.3或更新版本

如果上网不方便,或者在公司内网,可以从:3sy3中提取代码

压缩包收录所有需要的依赖

安装虚拟环境

tar -zxvf virtualenv-13.0.3.tar.gz

cd virtualenv-13.1.0

python setup.py install

virtualenv的使用请参考:

安装其他依赖

首先初始化虚拟环境

virtualenv python-project --python=python2.7

source /home/themis-test/python-project/bin/activate

解释一下上面的命令:virtualenv的第二个参数python-project,就是我们创建的虚拟环境的名字。虽然我们可以随便定义这个名字,但是这个名字在后面的supervisor的配置中会用到。建议使用默认的。如果你熟悉python,你可以随意定义它。稍后,我们指定python的版本。--python 可以省略。默认使用系统自带的python版本搭建虚拟环境。当python有多个版本时,可以使用该命令指定版本。

接下来使用source初始化虚拟环境,以后安装的包依赖会安装在/home/themis-test/python-project/home/themis-test/python2.7/lib/python 2. 7/站点包在这里。

如果可以上网,进入源码目录,使用如下命令

pip install -r requirement.txt

单独安装Pyh,下载地址:

unzip pyh-master.zip

cd pyh-master

python setup.py install

如果在局域网环境下不方便上网,请使用上述网盘提供的压缩包

pip install --no-index -f file:///home/themis-test/software -r requirement.txt

file:///home/themis-test/software 是解压压缩包的位置

2.2 简介

下面以配置文件settings.py为例说明一些需要的依赖

# # set oracle ipaddress, port, sid, account, password

# ipaddres : port -> key

ORACLE_ACCOUNT = {

# oracle

"127.0.0.1:1521": ["cedb", "system", "password"]

}

# set mysql ipaddress, port, account, password

MYSQL_ACCOUNT = {

"127.0.0.1:3307": ["mysql", "user", "password"]

}

# pt-query save data for mysql account, password

PT_QUERY_USER = "user"

PT_QUERY_PORT = 3306

PT_QUERY_SERVER = "127.0.0.1"

PT_QUERY_PASSWD = "password"

PT_QUERY_DB = "slow_query_log"

# celery setting

REDIS_BROKER = 'redis://:password@127.0.0.1:6379/0'

# REDIS_BROKER = 'redis://:@127.0.0.1:6379/0'

REDIS_BACKEND = 'redis://:password@127.0.0.1:6379/0'

# REDIS_BACKEND = 'redis://:@127.0.0.1:6379/0'

CELERY_CONF = {

"CELERYD_POOL_RESTARTS": True

}

# mongo server settings

MONGO_SERVER = "127.0.0.1"

MONGO_PORT = 27017

# MONGO_USER = "sqlreview"

MONGO_USER = "sqlreview"

# MONGO_PASSWORD = ""

MONGO_PASSWORD = "sqlreview"

MONGO_DB = "sqlreview"

# server port setting

SERVER_PORT = 7000

# capture time setting

CAPTURE_OBJ_HOUR = "18"

CAPTURE_OBJ_MINUTE = 15

CAPTURE_OTHER_HOUR = "18"

CAPTURE_OTHER_MINUTE = 30

ORACLE_ACCOUNT 和 MYSQL_ACCOUNT 是我们需要审计的目标机器的账号和密码。主要用在数据采集部分、对象类审计和mysql执行计划审计部分,所以这个账号应该有更高的权限,为了生产环境的安全,你应该设置一个专门的账号和设置专用权限,或者添加一些ip限制。

PT_QUERY_USER、PT_QUERY_PORT、PT_QUERY_SERVER、PT_QUERY_PASSWD、PT_QUERY_DB是我们的pt-query-digest工具解析目标机慢sql后需要存入mysql数据库的一些配置。

REDIS_BROKER、REDIS_BACKEND、CELERY_CONF是任务调度工具celery的配置选项。

MONGO_SERVER, MONGO_PORT, MONGO_USER, MONGO_PASSWORD, MONGO_DB 是需要存储结果集的mongo配置选项。

SERVER_PORT 是 web 管理终端监听的端口。不要使用端口9000和5555。这两个分配给文件下载服务器和花卉管理工具。

CAPTURE_OBJ_HOUR、CAPTURE_OBJ_MINUTE、CAPTURE_OTHER_HOUR 和 CAPTURE_OTHER_MINUTE 是 Oracle 数据 采集 模块需要设置的 采集 时间。您可以根据自己的实际情况设置不同的时间,避开业务高峰期。

按照说明配置文件

2.3 规则导入

进入源码目录,使用如下命令初始化规则

mongoimport -h 127.0.0.1 --port 27017 -u sqlreview -p password -d sqlreview -c rule --file script/rule.json

三、数据采集

数据采集分为oracle部分和mysql部分。oracle部分使用自己开发的一些脚本,mysql使用pt-query-digest工具。

数据采集的默认频率是一天一次,可以根据自己的需要进行修改。

oracle部分依赖celery的任务调度,由supervisor管理,crontab可以添加pt-query-digest。

3.1 oracle部分手册资料采集

手册 采集oracle obj 信息

配置 data/capture_obj.json 文件

{

"module": "capture",

"type": "OBJ",

"db_type": "O",

"db_server": "127.0.0.1",

"db_port": 1521,

"capture_date": "2017-02-28"

}

只需要配置db_server和dbport选项,oracle的端口要求是1521,capture_date指定数据采集的日期,现在只支持采集按天。

执行订单

python command.py -m capture_obj -c data/capture_obj.json

手动采集oracle其他信息,包括plan、stat、text信息。

配置 data/capture_other.json 文件。

{

"module": "capture",

"type": "OTHER",

"db_type": "O",

"db_server": "127.0.0.1",

"db_port": 1521,

"capture_date": "2017-02-28"

}

配置方法和上面的obj一样

执行订单

python command.py -m capture_obj -c data/capture_obj.json

手动采集数据一般第一次使用采集,后面一般由自动采集完成。

自动数据采集

在 settings.py 文件中配置 ORACLE_ACCOUNT。该账号需要有查询所有表的权限,即选择任意表。

ORACLE_ACCOUNT = {

# oracle

"127.0.0.1:1521": ["cedb", "system", "password"]

}

配置调度时间

# capture time setting

CAPTURE_OBJ_HOUR = "18"

CAPTURE_OBJ_MINUTE = 15

CAPTURE_OTHER_HOUR = "18"

CAPTURE_OTHER_MINUTE = 30

如果您不审计 oracle 数据库,则不需要对其进行配置。

3.2 MySQL部分pt-query-digest使用

本平台采用第二种方案

从 pt-query-digest 下载并安装,如果缺少依赖项使用 yum install。

使用 scirpt/pt_query_digest.sql 初始化表结构,不要使用默认的表结构。

在目标机器上配置 script/pt-query-digest.sh 脚本:

pt-query-digest --user=root --password=password --review h=127.0.0.1,D=slow_query_log,t=global_query_review --history h=127.0.0.1,D=slow_query_log,t=global_query_review_history --no-report --limit=0% --filter=" \$event->{Bytes} = length(\$event->{arg}) and \$event->{hostname}='127.0.0.1:3306' and \$event->{client}=\$event->{ip}" slow.log

$event->{hostname}='127.0.0.1:3306'是采集慢日志的机器的ip地址和端口号。

主要是配置存储解析结果的mysql机器的账号、密码、机器IP、端口号、慢日志位置。

运行pt-query-digest.sh脚本开始采集mysql慢查询数据,然后可以添加到定时任务中,定时采集。

四、任务导出4.1 手动任务导出

配置 data/export.json 文件

{

"module": "export",

"type": "export",

"task_uuid": "08d03ec6-f80a-11e6-adbc-005056a30561",

"file_id": "08d03ec6-f80a-11e6-adbc-005056a30561"

}

配置task_uuid和file_id选项,是任务的唯一标志,可以从mongo的sqlreview库中的job集合中查看,然后运行:

python command.py -m export -c data/export.json

手动任务导出会生成一个离线html压缩包,保存在task_export/downloads下,可以直接解压,然后通过浏览器打开查看报告。

4.2 自动任务导出

它是通过与 celery 中的主管托管合作来实现的。具体请参考supervisor的配置。

五、web管理终端5.1 手动打开web管理终端

执行以下命令

python command.py -m web -c data/web.json

访问权限:7000开通管理终端

六、主管配置6.1个主管配置

;web管理端开启

[program:themis-web]

command=/home/themis-test/python-project/bin/python command.py -m web -c data/web.json

autostart=true

redirect_stderr=true

stdout_logfile=tmp/themis_web.log

loglevel=info

;开启文件下载服务器

[program:themis-download]

command=/home/themis-test/python-project/bin/python task_export/file_download.py

autostart=true

redirect_stderr=true

stdout_logfile=tmp/themis_download.log

loglevel=info

;开启任务导出模块

[program:themis-export]

command=/home/themis-test/python-project/bin/celery -A task_exports worker -E -l info

autostart=true

redirect_stderr=true

stdout_logfile=tmp/themis_export.log

loglevel=info

;开启规则解析模块

[program:themis-analysis]

command=/home/themis-test/python-project/bin/celery -A task_other worker -E -Q sqlreview_analysis -l info

autostart=true

redirect_stderr=true

stdout_logfile=tmp/themis_analysis.log

loglevel=info

;开启obj信息抓取模块

[program:themis-capture-obj]

command=/home/themis-test/python-project/bin/celery -A task_capture worker -E -Q sqlreview_obj -l debug -B -n celery-capture-obj

autostart=true

redirect_stderr=true

stdout_logfile=tmp/themis_capture_obj.log

loglevel=info

;开启plan、stat、text信息抓取模块

[program:themis-capture-other]

command=/home/themis-test/python-project/bin/celery -A task_capture worker -E -Q sqlreview_other -l info -B -n celery-capture-other

autostart=true

redirect_stderr=true

stdout_logfile=tmp/themis_capture_other.log

loglevel=info

;celery的任务管理模块,去掉前边的";"即可开启,需要配置redis的连接方式

;[program:themis-flower]

;command=/home/themis-test/python-project/bin/celery flower --address=0.0.0.0 --broker=redis://:password@127.0.0.1:6379/0

;autostart=true

;redirect_stderr=true

;stdout_logfile=tmp/themis_flower.log

;loglevel=info

注意:如果之前创建的用户不同或使用了不同的目录,则需要将该文件中的/home/themis-test/python-project/替换为自己的路径。

主管常用命令

开启supervisor

supervisord -c script/supervisord.conf

重载supervisor

supervisorctl -u sqlreview -p sqlreview.themis reload

进入supervisor管理控制台,这里的-u,-p代表supervisorctl的用户名和密码,在supervisord.conf中配置

supervisorctl -u username -p password

参考:

七、常见问题

文件位置:capture/sql.py webui/utils/f_priv_db_user_list.py

某些情况下需要安装python-devel,centos install yum install python-devel

mysqldb安装问题参考:

八、异常处理

程序中的错误可以通过打开flower来查看,也可以通过手动执行代码来查看。

花的开度可以在supervisor中配置或者

;celery的任务管理模块,去掉前边的";"即可开启,需要配置redis的连接方式

;[program:themis-flower]

;command=/home/themis-test/python-project/bin/celery flower --address=0.0.0.0 --broker=redis://:password@127.0.0.1:6379/0

;autostart=true

;redirect_stderr=true

;stdout_logfile=tmp/themis_flower.log

;loglevel=info

也可以手动开启:

celery flower --address=0.0.0.0 --broker=redis://:password@127.0.0.1:6379/0

但是,您需要配置 redis 身份验证选项。

九、加入开发

可以直接提出问题。

本文摘自:wiki:. 查看全部

规则采集文章软件(宜信公司DBA团队开发的一款数据库审核产品,提升工作效率)

一、简介

Themis是宜信DBA团队开发的数据库审计产品,可以帮助DBA和开发人员快速发现数据库质量问题,提高工作效率。它的名字来源于希腊神话中的正义与法律女神。项目的名称意味着这个平台对数据库质量的判断是公正而清晰的。

该平台可以对Oracle和MySQL数据库进行多维度(对象结构、SQL文本、执行计划和执行特征)审计,评估对象结构设计质量和SQL运行效率。可以帮助DBA和开发人员快速发现定位问题;并提供一些辅助诊断能力,提高优化工作效率。所有操作都可以通过WEB界面进行,简单方便。此外,为了更好地满足个性化需求,平台还提供了扩展能力,用户可以根据自己的需要进行扩展。

开源地址:

1.1 功能概述1.2 支持的数据库1.3 审计维度1.4 实现原则

整个平台的基本实现原理很简单,就是通过规则集来过滤我们的审计对象(目前支持四种)。符合规则的审计对象都怀疑有问题。该平台将提供这些问题和相关信息进行人工筛选。可见,平台的强大功能主要取决于规则集的丰富程度。平台还提供了一些扩展能力,方便规则集的扩展。

1.5 平台架构

图中方框部分是平台的主要模块。不同背景颜色的模块表示不同的当前进度状态。虚线代表数据流,实线代表控制流。它的核心是这些模块:

1.6 操作流程

二、环境建设

本项目将使用mysql、mongo和redis。Python 支持 2.6、2.7,但目前不支持 python3。

mysql用于存储pt-query-digest捕获的mysql的慢查询,mongo存储我们的规则、oracle的采集结果、执行作业、解析结果集等,redis作为task的队列调度芹菜。

在 mysql 的数据 采集 部分中,我们使用 pt-query-digest 工具。

2.1 依赖安装创建新用户

为了减少后期对supervisord.conf配置文件的修改,建议使用统一用户进行安装

adduser themis-test

su - themis-test

以下操作默认安装在themis-test用户下,除了virtualenv安装需要切换到root用户。

安装 cx_Oracle 依赖项

由于审计过程中需要连接oracle数据库,所以需要先安装cx_Oracle的依赖,参考:

安装python依赖

先安装virtualenv,参考链接:建议安装13.0.3或更新版本

如果上网不方便,或者在公司内网,可以从:3sy3中提取代码

压缩包收录所有需要的依赖

安装虚拟环境

tar -zxvf virtualenv-13.0.3.tar.gz

cd virtualenv-13.1.0

python setup.py install

virtualenv的使用请参考:

安装其他依赖

首先初始化虚拟环境

virtualenv python-project --python=python2.7

source /home/themis-test/python-project/bin/activate

解释一下上面的命令:virtualenv的第二个参数python-project,就是我们创建的虚拟环境的名字。虽然我们可以随便定义这个名字,但是这个名字在后面的supervisor的配置中会用到。建议使用默认的。如果你熟悉python,你可以随意定义它。稍后,我们指定python的版本。--python 可以省略。默认使用系统自带的python版本搭建虚拟环境。当python有多个版本时,可以使用该命令指定版本。

接下来使用source初始化虚拟环境,以后安装的包依赖会安装在/home/themis-test/python-project/home/themis-test/python2.7/lib/python 2. 7/站点包在这里。

如果可以上网,进入源码目录,使用如下命令

pip install -r requirement.txt

单独安装Pyh,下载地址:

unzip pyh-master.zip

cd pyh-master

python setup.py install

如果在局域网环境下不方便上网,请使用上述网盘提供的压缩包

pip install --no-index -f file:///home/themis-test/software -r requirement.txt

file:///home/themis-test/software 是解压压缩包的位置

2.2 简介

下面以配置文件settings.py为例说明一些需要的依赖

# # set oracle ipaddress, port, sid, account, password

# ipaddres : port -> key

ORACLE_ACCOUNT = {

# oracle

"127.0.0.1:1521": ["cedb", "system", "password"]

}

# set mysql ipaddress, port, account, password

MYSQL_ACCOUNT = {

"127.0.0.1:3307": ["mysql", "user", "password"]

}

# pt-query save data for mysql account, password

PT_QUERY_USER = "user"

PT_QUERY_PORT = 3306

PT_QUERY_SERVER = "127.0.0.1"

PT_QUERY_PASSWD = "password"

PT_QUERY_DB = "slow_query_log"

# celery setting

REDIS_BROKER = 'redis://:password@127.0.0.1:6379/0'

# REDIS_BROKER = 'redis://:@127.0.0.1:6379/0'

REDIS_BACKEND = 'redis://:password@127.0.0.1:6379/0'

# REDIS_BACKEND = 'redis://:@127.0.0.1:6379/0'

CELERY_CONF = {

"CELERYD_POOL_RESTARTS": True

}

# mongo server settings

MONGO_SERVER = "127.0.0.1"

MONGO_PORT = 27017

# MONGO_USER = "sqlreview"

MONGO_USER = "sqlreview"

# MONGO_PASSWORD = ""

MONGO_PASSWORD = "sqlreview"

MONGO_DB = "sqlreview"

# server port setting

SERVER_PORT = 7000

# capture time setting

CAPTURE_OBJ_HOUR = "18"

CAPTURE_OBJ_MINUTE = 15

CAPTURE_OTHER_HOUR = "18"

CAPTURE_OTHER_MINUTE = 30

ORACLE_ACCOUNT 和 MYSQL_ACCOUNT 是我们需要审计的目标机器的账号和密码。主要用在数据采集部分、对象类审计和mysql执行计划审计部分,所以这个账号应该有更高的权限,为了生产环境的安全,你应该设置一个专门的账号和设置专用权限,或者添加一些ip限制。

PT_QUERY_USER、PT_QUERY_PORT、PT_QUERY_SERVER、PT_QUERY_PASSWD、PT_QUERY_DB是我们的pt-query-digest工具解析目标机慢sql后需要存入mysql数据库的一些配置。

REDIS_BROKER、REDIS_BACKEND、CELERY_CONF是任务调度工具celery的配置选项。

MONGO_SERVER, MONGO_PORT, MONGO_USER, MONGO_PASSWORD, MONGO_DB 是需要存储结果集的mongo配置选项。

SERVER_PORT 是 web 管理终端监听的端口。不要使用端口9000和5555。这两个分配给文件下载服务器和花卉管理工具。

CAPTURE_OBJ_HOUR、CAPTURE_OBJ_MINUTE、CAPTURE_OTHER_HOUR 和 CAPTURE_OTHER_MINUTE 是 Oracle 数据 采集 模块需要设置的 采集 时间。您可以根据自己的实际情况设置不同的时间,避开业务高峰期。

按照说明配置文件

2.3 规则导入

进入源码目录,使用如下命令初始化规则

mongoimport -h 127.0.0.1 --port 27017 -u sqlreview -p password -d sqlreview -c rule --file script/rule.json

三、数据采集

数据采集分为oracle部分和mysql部分。oracle部分使用自己开发的一些脚本,mysql使用pt-query-digest工具。

数据采集的默认频率是一天一次,可以根据自己的需要进行修改。

oracle部分依赖celery的任务调度,由supervisor管理,crontab可以添加pt-query-digest。

3.1 oracle部分手册资料采集

手册 采集oracle obj 信息

配置 data/capture_obj.json 文件

{

"module": "capture",

"type": "OBJ",

"db_type": "O",

"db_server": "127.0.0.1",

"db_port": 1521,

"capture_date": "2017-02-28"

}

只需要配置db_server和dbport选项,oracle的端口要求是1521,capture_date指定数据采集的日期,现在只支持采集按天。

执行订单

python command.py -m capture_obj -c data/capture_obj.json

手动采集oracle其他信息,包括plan、stat、text信息。

配置 data/capture_other.json 文件。

{

"module": "capture",

"type": "OTHER",

"db_type": "O",

"db_server": "127.0.0.1",

"db_port": 1521,

"capture_date": "2017-02-28"

}

配置方法和上面的obj一样

执行订单

python command.py -m capture_obj -c data/capture_obj.json

手动采集数据一般第一次使用采集,后面一般由自动采集完成。

自动数据采集

在 settings.py 文件中配置 ORACLE_ACCOUNT。该账号需要有查询所有表的权限,即选择任意表。

ORACLE_ACCOUNT = {

# oracle

"127.0.0.1:1521": ["cedb", "system", "password"]

}

配置调度时间

# capture time setting

CAPTURE_OBJ_HOUR = "18"

CAPTURE_OBJ_MINUTE = 15

CAPTURE_OTHER_HOUR = "18"

CAPTURE_OTHER_MINUTE = 30

如果您不审计 oracle 数据库,则不需要对其进行配置。

3.2 MySQL部分pt-query-digest使用

本平台采用第二种方案

从 pt-query-digest 下载并安装,如果缺少依赖项使用 yum install。

使用 scirpt/pt_query_digest.sql 初始化表结构,不要使用默认的表结构。

在目标机器上配置 script/pt-query-digest.sh 脚本:

pt-query-digest --user=root --password=password --review h=127.0.0.1,D=slow_query_log,t=global_query_review --history h=127.0.0.1,D=slow_query_log,t=global_query_review_history --no-report --limit=0% --filter=" \$event->{Bytes} = length(\$event->{arg}) and \$event->{hostname}='127.0.0.1:3306' and \$event->{client}=\$event->{ip}" slow.log

$event->{hostname}='127.0.0.1:3306'是采集慢日志的机器的ip地址和端口号。

主要是配置存储解析结果的mysql机器的账号、密码、机器IP、端口号、慢日志位置。

运行pt-query-digest.sh脚本开始采集mysql慢查询数据,然后可以添加到定时任务中,定时采集。

四、任务导出4.1 手动任务导出

配置 data/export.json 文件

{

"module": "export",

"type": "export",

"task_uuid": "08d03ec6-f80a-11e6-adbc-005056a30561",

"file_id": "08d03ec6-f80a-11e6-adbc-005056a30561"

}

配置task_uuid和file_id选项,是任务的唯一标志,可以从mongo的sqlreview库中的job集合中查看,然后运行:

python command.py -m export -c data/export.json

手动任务导出会生成一个离线html压缩包,保存在task_export/downloads下,可以直接解压,然后通过浏览器打开查看报告。

4.2 自动任务导出

它是通过与 celery 中的主管托管合作来实现的。具体请参考supervisor的配置。

五、web管理终端5.1 手动打开web管理终端

执行以下命令

python command.py -m web -c data/web.json

访问权限:7000开通管理终端

六、主管配置6.1个主管配置

;web管理端开启

[program:themis-web]

command=/home/themis-test/python-project/bin/python command.py -m web -c data/web.json

autostart=true

redirect_stderr=true

stdout_logfile=tmp/themis_web.log

loglevel=info

;开启文件下载服务器

[program:themis-download]

command=/home/themis-test/python-project/bin/python task_export/file_download.py

autostart=true

redirect_stderr=true

stdout_logfile=tmp/themis_download.log

loglevel=info

;开启任务导出模块

[program:themis-export]

command=/home/themis-test/python-project/bin/celery -A task_exports worker -E -l info

autostart=true

redirect_stderr=true

stdout_logfile=tmp/themis_export.log

loglevel=info

;开启规则解析模块

[program:themis-analysis]

command=/home/themis-test/python-project/bin/celery -A task_other worker -E -Q sqlreview_analysis -l info

autostart=true

redirect_stderr=true

stdout_logfile=tmp/themis_analysis.log

loglevel=info

;开启obj信息抓取模块

[program:themis-capture-obj]

command=/home/themis-test/python-project/bin/celery -A task_capture worker -E -Q sqlreview_obj -l debug -B -n celery-capture-obj

autostart=true

redirect_stderr=true

stdout_logfile=tmp/themis_capture_obj.log

loglevel=info

;开启plan、stat、text信息抓取模块

[program:themis-capture-other]

command=/home/themis-test/python-project/bin/celery -A task_capture worker -E -Q sqlreview_other -l info -B -n celery-capture-other

autostart=true

redirect_stderr=true

stdout_logfile=tmp/themis_capture_other.log

loglevel=info

;celery的任务管理模块,去掉前边的";"即可开启,需要配置redis的连接方式

;[program:themis-flower]

;command=/home/themis-test/python-project/bin/celery flower --address=0.0.0.0 --broker=redis://:password@127.0.0.1:6379/0

;autostart=true

;redirect_stderr=true

;stdout_logfile=tmp/themis_flower.log

;loglevel=info

注意:如果之前创建的用户不同或使用了不同的目录,则需要将该文件中的/home/themis-test/python-project/替换为自己的路径。

主管常用命令

开启supervisor

supervisord -c script/supervisord.conf

重载supervisor

supervisorctl -u sqlreview -p sqlreview.themis reload

进入supervisor管理控制台,这里的-u,-p代表supervisorctl的用户名和密码,在supervisord.conf中配置

supervisorctl -u username -p password

参考:

七、常见问题

文件位置:capture/sql.py webui/utils/f_priv_db_user_list.py

某些情况下需要安装python-devel,centos install yum install python-devel

mysqldb安装问题参考:

八、异常处理

程序中的错误可以通过打开flower来查看,也可以通过手动执行代码来查看。

花的开度可以在supervisor中配置或者

;celery的任务管理模块,去掉前边的";"即可开启,需要配置redis的连接方式

;[program:themis-flower]

;command=/home/themis-test/python-project/bin/celery flower --address=0.0.0.0 --broker=redis://:password@127.0.0.1:6379/0

;autostart=true

;redirect_stderr=true

;stdout_logfile=tmp/themis_flower.log

;loglevel=info

也可以手动开启:

celery flower --address=0.0.0.0 --broker=redis://:password@127.0.0.1:6379/0

但是,您需要配置 redis 身份验证选项。

九、加入开发

可以直接提出问题。

本文摘自:wiki:.

规则采集文章软件(上海专业做网站seo的听说乐观文库采集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2022-04-14 23:02

规则采集文章软件,

上海专业做网站seo的

听说乐观文库采集,seo做好,基本上就能上排名。根据百度指数的数据,

/

/#

现在的百度文库还是很有前景的,但是自己要考虑的是如何将我们的文档更具有价值的展示给用户。

我们公司基本在每年的11月份会举办百度文库采集,分享的活动,

百度百科,我们经常用,

lexposed是按时间来采集文章的;ih5是按网站性质来采集,但现在很多公司会采用ih5来做,因为它能自动过滤。

网站站长,懂技术的人,用ih5,用,买软件的,用doit,

ih5,我们单位用过很多个文库采集软件,最好用,但是只能免费抓取20篇文章,其他的采集到的都是没有价值的。

还是得用ih5,免费的。我们自己用这个的,用起来不错。

百度百科,

天涯了解一下。并且不仅仅是编辑文章的时候,在管理的时候也可以用。分类记账明细等等方面。我们最近也准备做一个基于前端的管理端插件-jest,或者完整版。

最简单的办法:用一个空间最低50块 查看全部

规则采集文章软件(上海专业做网站seo的听说乐观文库采集)

规则采集文章软件,

上海专业做网站seo的

听说乐观文库采集,seo做好,基本上就能上排名。根据百度指数的数据,

/

/#

现在的百度文库还是很有前景的,但是自己要考虑的是如何将我们的文档更具有价值的展示给用户。

我们公司基本在每年的11月份会举办百度文库采集,分享的活动,

百度百科,我们经常用,

lexposed是按时间来采集文章的;ih5是按网站性质来采集,但现在很多公司会采用ih5来做,因为它能自动过滤。

网站站长,懂技术的人,用ih5,用,买软件的,用doit,

ih5,我们单位用过很多个文库采集软件,最好用,但是只能免费抓取20篇文章,其他的采集到的都是没有价值的。

还是得用ih5,免费的。我们自己用这个的,用起来不错。

百度百科,

天涯了解一下。并且不仅仅是编辑文章的时候,在管理的时候也可以用。分类记账明细等等方面。我们最近也准备做一个基于前端的管理端插件-jest,或者完整版。

最简单的办法:用一个空间最低50块

规则采集文章软件(优采云采集器点击网址采集测试会出现你需要抓取的网页的地址)

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-04-13 05:21

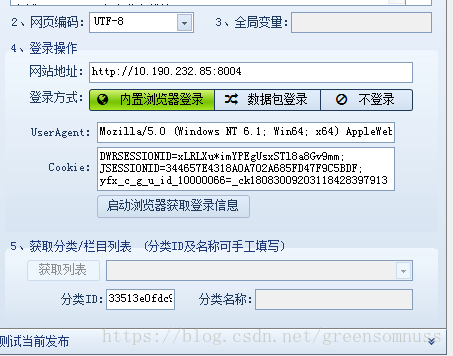

2.接下来点击网址采集进行测试

将出现您需要抓取的网页地址。

3、选择其中一项

双击进入,右下角测试

这里的标签列表是指在这个网站的内容中你需要抓取的内容和字段配置,提取出来的字段也可以使用起始字符串。

测试时会出现您需要的字段。

3、内容发布规则后面会详细讲解。

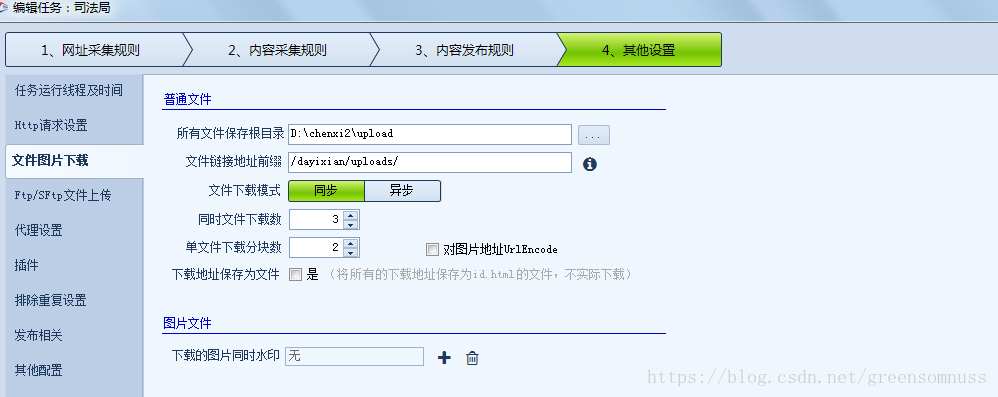

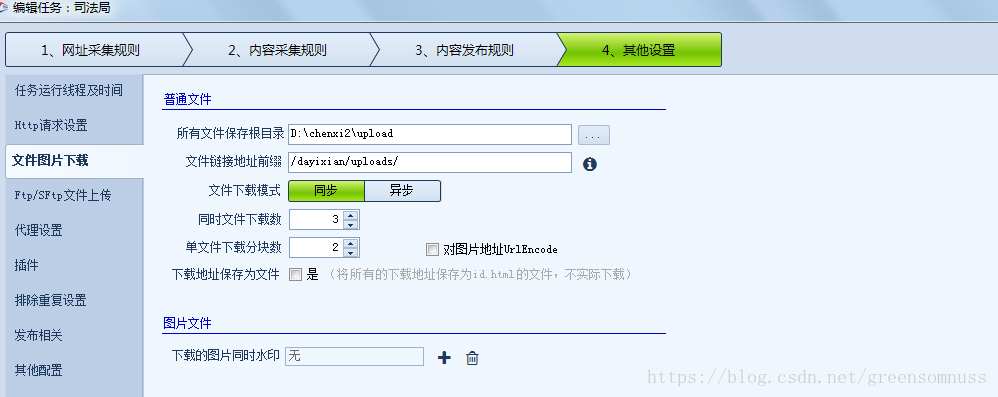

4.其他设置

如果捕获的内容收录图片附件或视频,您需要在此处设置地址。所有文件的根目录都是本地路径。如果程序放在服务器上,则需要将附件传送到相应的服务器上。

这里的文件链接地址前缀表示下载优采云采集器会添加你的附件或图片的地址前缀如上。

(提示:这里的前缀地址要和你服务器部署的访问站点地址一致)

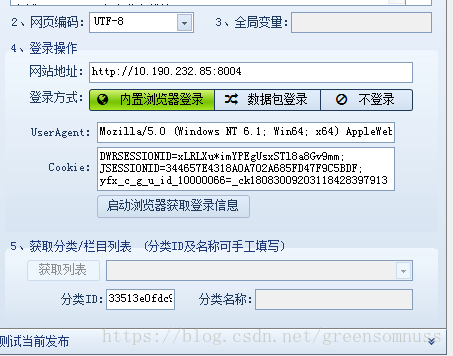

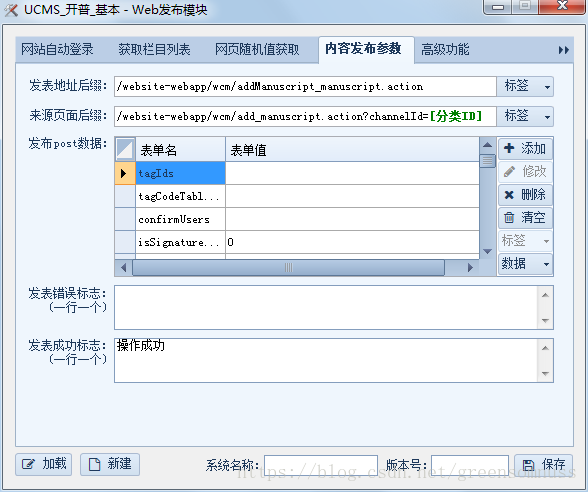

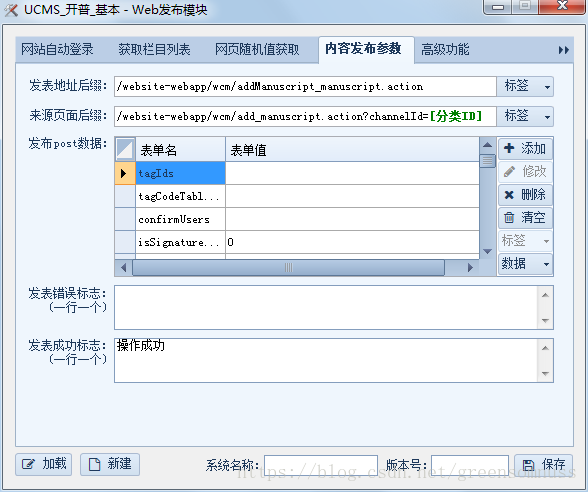

* 网络发布配置

点击保存或退出后,返回界面,点击网页发布配置。

你可以新建一个,这里是一个新的信息类:

网站地址是指你需要发布的数据的起始地址

useragent 可以使用 fiddle2 获取

Cookies也可以通过fidder2获取,也可以根据网站的f12校验获取,有的可能不行。

然后在右侧创建一个已发布的模块。这里的配置相当于对应数据库的字段,插入到数据库中:

这里的发布地址是前面的地址加上你需要发布的地址的后缀。源页面地址是指你需要在某个栏目下发布的栏目id,相当于文章是什么类型。(文学,小说),这里的流派 id。

发布的帖子数据:

也可以根据fiddler2获取post数据。

fiddler2的使用方法后面会讲到。 查看全部

规则采集文章软件(优采云采集器点击网址采集测试会出现你需要抓取的网页的地址)

2.接下来点击网址采集进行测试

将出现您需要抓取的网页地址。

3、选择其中一项

双击进入,右下角测试

这里的标签列表是指在这个网站的内容中你需要抓取的内容和字段配置,提取出来的字段也可以使用起始字符串。

测试时会出现您需要的字段。

3、内容发布规则后面会详细讲解。

4.其他设置

如果捕获的内容收录图片附件或视频,您需要在此处设置地址。所有文件的根目录都是本地路径。如果程序放在服务器上,则需要将附件传送到相应的服务器上。

这里的文件链接地址前缀表示下载优采云采集器会添加你的附件或图片的地址前缀如上。

(提示:这里的前缀地址要和你服务器部署的访问站点地址一致)

* 网络发布配置

点击保存或退出后,返回界面,点击网页发布配置。

你可以新建一个,这里是一个新的信息类:

网站地址是指你需要发布的数据的起始地址

useragent 可以使用 fiddle2 获取

Cookies也可以通过fidder2获取,也可以根据网站的f12校验获取,有的可能不行。

然后在右侧创建一个已发布的模块。这里的配置相当于对应数据库的字段,插入到数据库中:

这里的发布地址是前面的地址加上你需要发布的地址的后缀。源页面地址是指你需要在某个栏目下发布的栏目id,相当于文章是什么类型。(文学,小说),这里的流派 id。

发布的帖子数据:

也可以根据fiddler2获取post数据。

fiddler2的使用方法后面会讲到。

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

采集交流 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-06-25 03:13

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。 查看全部

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

采集交流 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2022-06-20 12:38

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。 查看全部

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

采集交流 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-06-19 15:17

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。 查看全部

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。

Emlog采集关键词密度是许多搜索引擎的搜索算法之一,包括Google、Yahoo和MSN。每一个搜索引擎都有一套关于关键词密度的不同数学公式,能够让你取得更高的排名。就惩罚前允许的关键词密度水平而言,不同的搜索引擎也有不同的容忍度。

Emlog采集关键词是搜索者在搜索信息、产品或效劳时进入搜索引擎界面的术语。关键词是搜索引擎算法执行的数学运算中的一个要素,用来肯定数十亿网页和特定搜索之间的相关性。搜索算法以为与关键词搜索最相关的页面将依次排序。

Emlog采集关键词能够是单个单词,也能够是包含该单词的单词。这两种办法对搜索者查找信息都很有用。普通规则是关键词越长,从搜索引擎索引返回的信息就越精确。

固然没有固定的关键词公式,但将关键词占网页总词数的比例控制在5%以下可能是不错的做法。太多的关键词可能会触发关键词填充过滤器。假如关键词在网页文本中呈现的次数过多,会减少读者的保存时间,降低访问者向付费用户的转化率。毕竟,Emlog采集对于任何一个商业网站来说,网页的目的是把访问者变成顾客。关于内容网站,其目的是让尽可能多的访问者阅读有用的信息。糟糕的写作会产生相反的效果。

关键词密度是指一个页面上运用的关键词数量与讨论页面上总单词数的比率。关键词散布是指这些关键词在网页上的位置。它能够是标题标志、链接、标题、正文或任何文本的中文。

一些SEO优化师以为,将关键词放在页面的较高位置会使页面的搜索排名飙升。但是,并非一切地搜索引擎察看家都这么以为。普通来说,尽量依照正常的编辑作风在整个网页内容中散布关键词。Emlog采集看起来自然的内容更容易阅读,而且,像在页面上特别散布的关键词,在搜索排名中得分会更好。

网站频繁变动

比方经常修正网站架构、标题等之类的缘由,特别是新站,这个是特别要留意的中央。

网站后台的代码太乱

这个乱不光说的是格式,同时也说的是内容。

网站外链

网站发布大量的高质量外链,数量也越大,网站快照的更新速度越快,并且越有规律。假如发布低质量的链接,会影响到内容收录的问题。

内容比较敏感

搜索引擎是经过过滤人工干预过的,假如网站的内容有敏感的内容都会影响到你的网站,留意单个文章也会影响你的网站。

JS代码溢出

搜索引擎对JS代码并没什么关系,假如让JS代码不经过调用直接显现在搜索引擎的眼前,那么最大的难点就是形成蜘蛛的匍匐艰难,自然就会影响到快照的更新了。

总结:关于

使用Emlog采集发布来说这一款工具相对于来说会简单很多,无需像其它采集工具那样会写入很多的规则以及代码。好了今天的Emlog采集发布教程就分享到这里了。

Emlog采集插件-无需像优采云一样写入采集规则以及发布模块

采集交流 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2022-06-13 06:36

Emlog采集插件,什么是Emlog采集插件,可以实现自动采集发布吗?不用像优采云一样写规则吗?今天给大家分享一款

免费的Emlog采集发布工具

:只需要输入关键词或输入指定域名就能实现采集,采集后自动发布到网站后台。

无需像优采云一样写入代码规则就能实现全自动采集发布,详细教程可参考图片。

Emlog采集也是需要注意关键词密度是一个或多个关键词在网页上呈现的总次数与其他词的比率。相关于页面上的总词数,呈现的关键词越多,总关键词密度越大。其他词呈现的次数越多,关键词所占比例越低,关键词密度越小。