网页flash抓取工具

汇总:诠网科技|网站不收录成为SEO主要问题,解析搜索引擎不收录的原因

网站优化 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2022-09-24 15:20

一般来说,屏蔽搜索引擎收录 也可能成为 SEO 问题。试图让搜索引擎抓取和索引更多内容是 SEO 经常头痛的问题。没有收录,索引就谈不上排名。尤其对于已经达到一定规模的网站来说,让上海seo的网站足够收录是一个比较麻烦的SEO技巧。 >但是架构设计和优化,收录是不可能的,只能尝试提高收录的速率。

但有时如何屏蔽搜索引擎收录也可能是个问题,网站没有收录这几年越来越成为一个SEO问题。需要屏蔽的情况,如机密信息、复制内容、广告链接等。过去常见的屏蔽收录的方法有密码保护、内容放在表格后面、使用JS/Ajax、使用Flash等.

使用 Flash

Google 几年前开始尝试抓取 Flash 内容,并且已经开始抓取简单的文本内容。也可以跟踪 Flash 中的链接。

表格

Google 蜘蛛还可以填写表单并抓取 POST 请求页面。从日志中已经可以看出这一点。

JS/Ajax

使用 JS 链接一直被认为是一种对 SEO 不太友好的方式来阻止蜘蛛爬行,但两三年前我看到 JS 链接无法阻止 Google 的蜘蛛爬行,不仅 JS 中出现的 URL 会阻止爬取,也可以执行简单的JS来查找更多的URL。

前几天发现很多网站优化的Facebook评论插件被爬取和收录评论,而且插件本身就是一个AJAX。这是个好消息。我的一个实验性电子商务 网站 产品评论功能因此花了很多心思。使用 Facebook 评论插件的好处是巨大的。后面会讲具体的好处。问题是注释是由AJAX实现的,不能被捕获。拿,而产品评论是收录目的之一(生成原创内容)。想了半天也没找到解决办法,就傻傻的把脸书评论插件和评论功能都放在了购物车上。好了,既然脸书评论里的评论可以是收录,就不需要两套评论功能了。

机器人文件

当前确保内容不被阻止的方法收录 是通过 robots 文件。但也有一个缺点。它会减肥。虽然内容不能是收录,但是页面变成了一个只接受链接权重不流出权重的无底洞。

不关注

Nofollow 不保证不会成为 收录。就算你给页面的所有网站链接都加了NF,也不能保证别人更高的网站构造不会得到这个页面的链接,搜索引擎还是可以的找到这个页面。

MetaNoindex+关注

为了防止收录传递权重,可以在页面上使用metanoindex和metafollow,使页面不收录,但可以传递权重。确实,这是一个更好的方法。还有一个问题,还是会浪费蜘蛛爬行的时间。哪位读者有方法可以防止收录,不减肥,不浪费爬爬时间,请留言,对SEO界大有裨益。

总结:搜索引擎优化蜘蛛抓取策略分析,如何实现网站快速收录

从搜索引擎的角度来看,互联网上的页面主要分为四种类型,即爬取页面、待爬取页面、可爬取页面和暗网。

四类网页的讲解,熟悉网站页面分类

顾名思义,被爬取的网页就是蜘蛛已经爬取的内容网站,待爬取的页面就是没有被爬取但已进入等待列表的页面,可以爬取的页面是没有找到但已经存在的页面,而暗网是搜索引擎通过自爬链接找不到的页面,需要手动提交。

通常我们分析的页面爬取主要是非暗网中的页面爬取。暗网爬行中的每个搜索引擎都有自己独特的算法。我们不做太多分析。

搜索引擎的爬取策略主要有两种策略,即广度优先策略和深度优先策略。

广告 2345

×

广度优先策略的解释

大多数网页将有许多链接,而不是它们自己的链接。例如,详情页有相关新闻、相关案例等的链接,当搜索引擎访问一个页面时,会将页面上的所有链接放入数据库中,依次排列。进行遍历爬取,然后将新发现的URL入库等待爬取,按照这个逻辑依次爬取就是广度优先策略。如图:抓取顺序为1-2、3、4-5-11-6-12-3-7-13-8-14。用图片了解自己。

深度优先策略解释

按照页面上的一个链接逐层爬取,直到抓取到最后一个链接,然后返回初始位置以同样的方式爬取其余的链接,这是一种深度优先的策略。

无论是广度优先还是深度优先策略,只要有足够的时间让搜索引擎爬取所有页面,优先考虑搜索引擎的爬取能量,页面爬取的全面性无法做到得到保证。自身资源的限制不得不考虑爬取页面的优先级。还有另外两种爬取策略。

广告流量神器-登录

×

重要网页优先抓取策略

判断一个页面的重要性,搜索引擎主要从自身的质量和权重来判断。另一个重要因素是传入链接的数量。比如首页的传入链接肯定来自很多页面,所以首页的优先级也比较高。

大站点链接优先策略

大站优先显然是一个对大网站有偏好的搜索群体,自身权重比较高,这里的权重不是单纯的PR,而是信任,不是说人家厉害,甚至像高权重的搜索引擎它。很多B2B网站的内容也很大,但是搜索引擎对网页内容的爬取并不是很擅长。相对来说,一些比较好的网站可以有很好的活跃度,所以发消息可以增加活跃度,发到大站首页也能秒收。

总而言之,搜索引擎的资源是有限的。在搜索引擎资源有限的情况下,尽量依靠外链引导蜘蛛,增加网站的权重,也就是网站SEO搜索引擎优化长期运营是重中之重 查看全部

汇总:诠网科技|网站不收录成为SEO主要问题,解析搜索引擎不收录的原因

一般来说,屏蔽搜索引擎收录 也可能成为 SEO 问题。试图让搜索引擎抓取和索引更多内容是 SEO 经常头痛的问题。没有收录,索引就谈不上排名。尤其对于已经达到一定规模的网站来说,让上海seo的网站足够收录是一个比较麻烦的SEO技巧。 >但是架构设计和优化,收录是不可能的,只能尝试提高收录的速率。

但有时如何屏蔽搜索引擎收录也可能是个问题,网站没有收录这几年越来越成为一个SEO问题。需要屏蔽的情况,如机密信息、复制内容、广告链接等。过去常见的屏蔽收录的方法有密码保护、内容放在表格后面、使用JS/Ajax、使用Flash等.

使用 Flash

Google 几年前开始尝试抓取 Flash 内容,并且已经开始抓取简单的文本内容。也可以跟踪 Flash 中的链接。

表格

Google 蜘蛛还可以填写表单并抓取 POST 请求页面。从日志中已经可以看出这一点。

JS/Ajax

使用 JS 链接一直被认为是一种对 SEO 不太友好的方式来阻止蜘蛛爬行,但两三年前我看到 JS 链接无法阻止 Google 的蜘蛛爬行,不仅 JS 中出现的 URL 会阻止爬取,也可以执行简单的JS来查找更多的URL。

前几天发现很多网站优化的Facebook评论插件被爬取和收录评论,而且插件本身就是一个AJAX。这是个好消息。我的一个实验性电子商务 网站 产品评论功能因此花了很多心思。使用 Facebook 评论插件的好处是巨大的。后面会讲具体的好处。问题是注释是由AJAX实现的,不能被捕获。拿,而产品评论是收录目的之一(生成原创内容)。想了半天也没找到解决办法,就傻傻的把脸书评论插件和评论功能都放在了购物车上。好了,既然脸书评论里的评论可以是收录,就不需要两套评论功能了。

机器人文件

当前确保内容不被阻止的方法收录 是通过 robots 文件。但也有一个缺点。它会减肥。虽然内容不能是收录,但是页面变成了一个只接受链接权重不流出权重的无底洞。

不关注

Nofollow 不保证不会成为 收录。就算你给页面的所有网站链接都加了NF,也不能保证别人更高的网站构造不会得到这个页面的链接,搜索引擎还是可以的找到这个页面。

MetaNoindex+关注

为了防止收录传递权重,可以在页面上使用metanoindex和metafollow,使页面不收录,但可以传递权重。确实,这是一个更好的方法。还有一个问题,还是会浪费蜘蛛爬行的时间。哪位读者有方法可以防止收录,不减肥,不浪费爬爬时间,请留言,对SEO界大有裨益。

总结:搜索引擎优化蜘蛛抓取策略分析,如何实现网站快速收录

从搜索引擎的角度来看,互联网上的页面主要分为四种类型,即爬取页面、待爬取页面、可爬取页面和暗网。

四类网页的讲解,熟悉网站页面分类

顾名思义,被爬取的网页就是蜘蛛已经爬取的内容网站,待爬取的页面就是没有被爬取但已进入等待列表的页面,可以爬取的页面是没有找到但已经存在的页面,而暗网是搜索引擎通过自爬链接找不到的页面,需要手动提交。

通常我们分析的页面爬取主要是非暗网中的页面爬取。暗网爬行中的每个搜索引擎都有自己独特的算法。我们不做太多分析。

搜索引擎的爬取策略主要有两种策略,即广度优先策略和深度优先策略。

广告 2345

×

广度优先策略的解释

大多数网页将有许多链接,而不是它们自己的链接。例如,详情页有相关新闻、相关案例等的链接,当搜索引擎访问一个页面时,会将页面上的所有链接放入数据库中,依次排列。进行遍历爬取,然后将新发现的URL入库等待爬取,按照这个逻辑依次爬取就是广度优先策略。如图:抓取顺序为1-2、3、4-5-11-6-12-3-7-13-8-14。用图片了解自己。

深度优先策略解释

按照页面上的一个链接逐层爬取,直到抓取到最后一个链接,然后返回初始位置以同样的方式爬取其余的链接,这是一种深度优先的策略。

无论是广度优先还是深度优先策略,只要有足够的时间让搜索引擎爬取所有页面,优先考虑搜索引擎的爬取能量,页面爬取的全面性无法做到得到保证。自身资源的限制不得不考虑爬取页面的优先级。还有另外两种爬取策略。

广告流量神器-登录

×

重要网页优先抓取策略

判断一个页面的重要性,搜索引擎主要从自身的质量和权重来判断。另一个重要因素是传入链接的数量。比如首页的传入链接肯定来自很多页面,所以首页的优先级也比较高。

大站点链接优先策略

大站优先显然是一个对大网站有偏好的搜索群体,自身权重比较高,这里的权重不是单纯的PR,而是信任,不是说人家厉害,甚至像高权重的搜索引擎它。很多B2B网站的内容也很大,但是搜索引擎对网页内容的爬取并不是很擅长。相对来说,一些比较好的网站可以有很好的活跃度,所以发消息可以增加活跃度,发到大站首页也能秒收。

总而言之,搜索引擎的资源是有限的。在搜索引擎资源有限的情况下,尽量依靠外链引导蜘蛛,增加网站的权重,也就是网站SEO搜索引擎优化长期运营是重中之重

axure动效插件activex控件器3的简书动图抓取工具地址

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2022-09-10 01:09

网页flash抓取工具地址:1。迅捷flash抓取器(随便哪个网站都行)2。百度云:动图精灵网页抓取工具简介:1。迅捷flash抓取器2。百度云:动图精灵3。工具下载axure制作网页快速抓取工具地址:1。wordpress插件迅捷flash抓取器2。axure动效插件activex控件抓取器3。简书动图抓取工具地址:(同上)axure动效制作网页抓取工具简介:1。

迅捷flash抓取器2。axure动效插件activex控件抓取器3。简书动图抓取工具地址::1。axure工具2。迅捷flash抓取器3。百度云:动图精灵。

可以抓到网页里面的动图片,你自己去吧,

楼上做的app程序的方法,我还是以前的老套路,把你想抓的动图网站地址发给我,我帮你抓。

可以用爬虫工具来抓取动图,百度地址:-for-android/baidu-android/就可以抓取到相关网站了。但是这个工具限制是需要获取你指定的动图链接才可以抓取,比如你要抓取饿了么网站的饿了么动图,而饿了么网站有很多商家的优惠信息,那么就需要你指定指定的优惠链接才可以,当然也可以根据地区来划分不同的优惠链接,比如你在南方的话,就可以获取饿了么的当地优惠信息。

利用as代码制作,

需要iphone手机才可以! 查看全部

axure动效插件activex控件器3的简书动图抓取工具地址

网页flash抓取工具地址:1。迅捷flash抓取器(随便哪个网站都行)2。百度云:动图精灵网页抓取工具简介:1。迅捷flash抓取器2。百度云:动图精灵3。工具下载axure制作网页快速抓取工具地址:1。wordpress插件迅捷flash抓取器2。axure动效插件activex控件抓取器3。简书动图抓取工具地址:(同上)axure动效制作网页抓取工具简介:1。

迅捷flash抓取器2。axure动效插件activex控件抓取器3。简书动图抓取工具地址::1。axure工具2。迅捷flash抓取器3。百度云:动图精灵。

可以抓到网页里面的动图片,你自己去吧,

楼上做的app程序的方法,我还是以前的老套路,把你想抓的动图网站地址发给我,我帮你抓。

可以用爬虫工具来抓取动图,百度地址:-for-android/baidu-android/就可以抓取到相关网站了。但是这个工具限制是需要获取你指定的动图链接才可以抓取,比如你要抓取饿了么网站的饿了么动图,而饿了么网站有很多商家的优惠信息,那么就需要你指定指定的优惠链接才可以,当然也可以根据地区来划分不同的优惠链接,比如你在南方的话,就可以获取饿了么的当地优惠信息。

利用as代码制作,

需要iphone手机才可以!

网页flash抓取工具:微软msdnwindows一键抓取在线视频详细教程

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2022-07-31 02:00

网页flash抓取工具,一种自动化抓取网页flash的工具,实现网页上所有的元素抓取下来,简单快捷,下面是它的抓取地址,使用起来非常方便。网页flash抓取工具_网页抓取工具免费下载_下载工具软件网页flash抓取工具:微软msdnwindows一键抓取在线视频详细教程,网页flash抓取工具-幻灯片下载王。

这个是要看你给你输出什么格式的,最早应该有火狐浏览器有个网页抓取工具的。

为什么一直没人回答网页api抓取工具?目前有很多啊。

via如何抓取页面中的网页或动态内容?-chrome-知乎用户的回答原理方面是通过页面实时变化内容的生成,每个页面都有一个内容生成器,页面抓取工具,然后解析生成。动态页面抓取应该是有的。

可以找我

推荐你一个叫emergeapps的项目。emerge主要是通过页面的加载等一些特定功能,对每个页面,具体内容进行抓取。在抓取的过程中,你可以选择中间的页面。基本上就类似于一个表格了,但不仅仅是简单的表格。可以放到微信的图文链接,或者自己写js。

推荐你使用moxin.web这个工具可以抓取google和yahoo等主流国际化网站的所有flash。设置样式后,在微信或者微博你就可以看到自己所看到的内容,自由组合的flash,如果你想全页抓取是完全没有问题的。你可以把你看到的所有flash输出为图片,但是不能发布。你可以导出为音频、视频,支持javascript等。 查看全部

网页flash抓取工具:微软msdnwindows一键抓取在线视频详细教程

网页flash抓取工具,一种自动化抓取网页flash的工具,实现网页上所有的元素抓取下来,简单快捷,下面是它的抓取地址,使用起来非常方便。网页flash抓取工具_网页抓取工具免费下载_下载工具软件网页flash抓取工具:微软msdnwindows一键抓取在线视频详细教程,网页flash抓取工具-幻灯片下载王。

这个是要看你给你输出什么格式的,最早应该有火狐浏览器有个网页抓取工具的。

为什么一直没人回答网页api抓取工具?目前有很多啊。

via如何抓取页面中的网页或动态内容?-chrome-知乎用户的回答原理方面是通过页面实时变化内容的生成,每个页面都有一个内容生成器,页面抓取工具,然后解析生成。动态页面抓取应该是有的。

可以找我

推荐你一个叫emergeapps的项目。emerge主要是通过页面的加载等一些特定功能,对每个页面,具体内容进行抓取。在抓取的过程中,你可以选择中间的页面。基本上就类似于一个表格了,但不仅仅是简单的表格。可以放到微信的图文链接,或者自己写js。

推荐你使用moxin.web这个工具可以抓取google和yahoo等主流国际化网站的所有flash。设置样式后,在微信或者微博你就可以看到自己所看到的内容,自由组合的flash,如果你想全页抓取是完全没有问题的。你可以把你看到的所有flash输出为图片,但是不能发布。你可以导出为音频、视频,支持javascript等。

网页flash抓取工具爬虫开发库通过抓取ip获取网站访问次数

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-07-04 21:07

网页flash抓取工具爬虫开发库通过抓取ip获取网站访问次数-moore-博客园需要了解cookie,抓取时会生成。登录网站时会更新生成version.txt规则代码。如果服务器的cookie加密机制跟不上需求的话就很可怕了。有兴趣可以先看看这里的代码,同时也可以看看这里:flashhttpserver抓取到了页面只要出现相应的点击事件,dom就会被注册绑定到flashhttpserver。

也就是任何浏览器都可以抓取到页面。大小都是100k左右。1.crawler插件crawler实现动态url解析。kivyjs平台上也已经开发了这个插件。根据浏览器不同,url解析可以用defaultrequest机制,crawler调用urldaccessmergerwallframes判断url抓取安全。

可以解析json,xml,pdf,html,flash文件等。但是crawler调用url时url参数和data不需要编码转化。这也是为什么有些地方直接读csv,而不是直接读shtml文件。假设页面html5有7个字段。在chrome中打开,会是这样爬虫{{mobile}}.jpg2.开发环境配置1.python2.6.3或以上版本。

2.启动cmd。3.在终端里输入如下命令ln-s//应用名称//默认是网站名称//应用的隐藏路径,如/users/administrator/desktop/username/.crawler/user/root/.crawler3.aws免费gpu/fp-server服务,配置gpu。需要专门的配置,但是直接接在aws的集群里就可以了。

linux下的文档如下。-install.html#networks-v3.0.1.html?highlight=username4.确定集群中是否有分布式的负载均衡shell配置//第一种方法就是配置同时监听http和ftpstream的web容器。要注意不能有多个web容器server_name='crawler'//listen=":8080"server_start=":8080"server_end=":8080"//start_time=":0"//connect_time=":0"//start_local_server=":0"//start_connect_time=":0"//get_client=":0"//connect_result=":0"//timeout="0"server_connect=":8080"server_close=":8080"//timeout="0"//get_super_connect=":8080"//withleft_entered=":8080"withleft_collection=":8080"//get_super_l。 查看全部

网页flash抓取工具爬虫开发库通过抓取ip获取网站访问次数

网页flash抓取工具爬虫开发库通过抓取ip获取网站访问次数-moore-博客园需要了解cookie,抓取时会生成。登录网站时会更新生成version.txt规则代码。如果服务器的cookie加密机制跟不上需求的话就很可怕了。有兴趣可以先看看这里的代码,同时也可以看看这里:flashhttpserver抓取到了页面只要出现相应的点击事件,dom就会被注册绑定到flashhttpserver。

也就是任何浏览器都可以抓取到页面。大小都是100k左右。1.crawler插件crawler实现动态url解析。kivyjs平台上也已经开发了这个插件。根据浏览器不同,url解析可以用defaultrequest机制,crawler调用urldaccessmergerwallframes判断url抓取安全。

可以解析json,xml,pdf,html,flash文件等。但是crawler调用url时url参数和data不需要编码转化。这也是为什么有些地方直接读csv,而不是直接读shtml文件。假设页面html5有7个字段。在chrome中打开,会是这样爬虫{{mobile}}.jpg2.开发环境配置1.python2.6.3或以上版本。

2.启动cmd。3.在终端里输入如下命令ln-s//应用名称//默认是网站名称//应用的隐藏路径,如/users/administrator/desktop/username/.crawler/user/root/.crawler3.aws免费gpu/fp-server服务,配置gpu。需要专门的配置,但是直接接在aws的集群里就可以了。

linux下的文档如下。-install.html#networks-v3.0.1.html?highlight=username4.确定集群中是否有分布式的负载均衡shell配置//第一种方法就是配置同时监听http和ftpstream的web容器。要注意不能有多个web容器server_name='crawler'//listen=":8080"server_start=":8080"server_end=":8080"//start_time=":0"//connect_time=":0"//start_local_server=":0"//start_connect_time=":0"//get_client=":0"//connect_result=":0"//timeout="0"server_connect=":8080"server_close=":8080"//timeout="0"//get_super_connect=":8080"//withleft_entered=":8080"withleft_collection=":8080"//get_super_l。

网页flash抓取工具/网页免费挖掘工具:网页抓取

网站优化 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-06-23 13:05

网页flash抓取工具/网页免费挖掘工具:挖掘工具汇总referer和url标签挖掘挖掘工具网页标题和内容referer标签(referer通常用于判断网页是否是通过https加密传输,或是隐藏攻击者文件传输的身份)。cookie存储referer通常用于判断网页是否是通过https加密传输,或是隐藏攻击者文件传输的身份。

html5新特性浏览器可以用https进行安全传输的话,能极大提高网页的安全性;url或cookie中的一些信息用到的内容可以通过抓包发送到服务器;来自cookie的信息用于统计;而网页分析工具、页面分析工具依赖于服务器端返回的报文。referer、url标签的cookie内容第一次请求页面可能会出现cookie;服务器可以使用https来提高安全性。

refererurl标签等通常都要爬虫自己解析。下载工具scrapy提供的下载工具方便快捷,也是大多数人的下载首选,但scrapy的缺点就是无法爬取需要保存的图片、mp。

4、pdf等文件的下载。mailto:邮箱。webkit内核的浏览器可以使用js代理,比如。方法是在目标地址后添加navigator.navigator_cookie.parse_header。服务器做处理就好。cookie存储简单的cookie存储就是:每个页面为了节省空间都会将cookie存入到本地文件;服务器基于整个目录来存储所有的cookie。

http保存cookie有个缺点:每次请求都要刷新(chrome浏览器),因此有两种常用的方式:第一种是每个页面都手动保存,url不发生变化。第二种就是服务器端保存,返回一个cookie值。

这样cookie的使用就很方便了:

1)每次请求都把本地cookie发回给服务器,服务器来保存。

2)第二次请求会返回一个当前目录的cookie值,服务器直接使用这个值继续请求。

3)每次请求都带cookie地址:“,

4)接着分别请求相应页面,服务器如果有任何改变就将cookie值写入本地存储。

importrequestsfromlxmlimportetree#获取html内容url='={}'。format(etree。html())#每次request都返回一个新的cookie值,不再是etree。html()内部的值,同时返回多个值defget_request_urls(url):response=requests。

get(url)。content#抓取页面中的url列表withopen('hello。html','w')asf:foriinrange(1,len(response。text)):headers={'user-agent':'mozilla/5。0(windowsnt6。1;wow6。

4)applewebkit/537.36(khtml,likegecko)chrome/66.0.3340.142safari/537.36'}cookies={'referer':requests.get(url 查看全部

网页flash抓取工具/网页免费挖掘工具:网页抓取

网页flash抓取工具/网页免费挖掘工具:挖掘工具汇总referer和url标签挖掘挖掘工具网页标题和内容referer标签(referer通常用于判断网页是否是通过https加密传输,或是隐藏攻击者文件传输的身份)。cookie存储referer通常用于判断网页是否是通过https加密传输,或是隐藏攻击者文件传输的身份。

html5新特性浏览器可以用https进行安全传输的话,能极大提高网页的安全性;url或cookie中的一些信息用到的内容可以通过抓包发送到服务器;来自cookie的信息用于统计;而网页分析工具、页面分析工具依赖于服务器端返回的报文。referer、url标签的cookie内容第一次请求页面可能会出现cookie;服务器可以使用https来提高安全性。

refererurl标签等通常都要爬虫自己解析。下载工具scrapy提供的下载工具方便快捷,也是大多数人的下载首选,但scrapy的缺点就是无法爬取需要保存的图片、mp。

4、pdf等文件的下载。mailto:邮箱。webkit内核的浏览器可以使用js代理,比如。方法是在目标地址后添加navigator.navigator_cookie.parse_header。服务器做处理就好。cookie存储简单的cookie存储就是:每个页面为了节省空间都会将cookie存入到本地文件;服务器基于整个目录来存储所有的cookie。

http保存cookie有个缺点:每次请求都要刷新(chrome浏览器),因此有两种常用的方式:第一种是每个页面都手动保存,url不发生变化。第二种就是服务器端保存,返回一个cookie值。

这样cookie的使用就很方便了:

1)每次请求都把本地cookie发回给服务器,服务器来保存。

2)第二次请求会返回一个当前目录的cookie值,服务器直接使用这个值继续请求。

3)每次请求都带cookie地址:“,

4)接着分别请求相应页面,服务器如果有任何改变就将cookie值写入本地存储。

importrequestsfromlxmlimportetree#获取html内容url='={}'。format(etree。html())#每次request都返回一个新的cookie值,不再是etree。html()内部的值,同时返回多个值defget_request_urls(url):response=requests。

get(url)。content#抓取页面中的url列表withopen('hello。html','w')asf:foriinrange(1,len(response。text)):headers={'user-agent':'mozilla/5。0(windowsnt6。1;wow6。

4)applewebkit/537.36(khtml,likegecko)chrome/66.0.3340.142safari/537.36'}cookies={'referer':requests.get(url

网页flash抓取工具推荐:coffeeplus丶神奇云服务(组图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2022-05-25 12:01

网页flash抓取工具推荐:coffeeplus丶神奇云服务网页调用webpack-generator-multi-shell接口调用burpsuitedb、dbmutatorv4接口控制flash网页开发平台请求设置flash/fullpage、ts等必须格式flash代码段、bpmn、tsconfig相关配置打包工具。

1、webpack:zendesk/webpack·github由webpack4+官方出品在追求更好的前端性能下,通过优化webpack模块引入参数大小以及压缩文件大小,减少网页大小,腾出更多的网页空间,即webpack可以使用更小的内存。bundler/webpack-cli·githubbundler/webpack-dev-server·githubbundler/webpack-babel-plugins·githubbundler/webpack-v8-plugins·githubbundler/node.js-create-webpack-project·github是用babel-pluginsjs编译插件配置webpack的配置文件,加上manifest.js即可实现配置文件。

2、browserify:browserify-webpack-plugin是svn的插件,

3、nginx:nginx·github我之前推荐nginx-mina-admin-chef模块使用的sudo权限sudo权限是模块对sudoadmin来说更亲切和安全。sudoadmin:base-webpack-extract-lib:sudoadmin:manifest.js:use:npm在cli中检查webpack配置configure--save-directories:/tmp/conf.jsmanifest.js:loaders:--assets:loaders:--prefer-coffeeplugins:--advanced-properties:--gzip--promise-router-alias:sourcemap配置参数--all:所有的配置configure--save-directories:/tmp/conf.jsmanifest.js:configure.configure('test-webpack',{loaders:["babel-preset-env"],manifest.js:{registry:'',extract-lib:[{mode:'env',type:'module',name:'entry',sourcemap:true}]}}]})args(可选):--template-paths:[""]--webpack-config-and-test-directories:["/tmp/conf.js"]--webpack-extensions:[""]--webpack-plugins:[{mode:'env',type:'module',name:'manifest',plugins:[{type:'test',name:'promise',prefer-coffee:true}]}]--server-only:。 查看全部

网页flash抓取工具推荐:coffeeplus丶神奇云服务(组图)

网页flash抓取工具推荐:coffeeplus丶神奇云服务网页调用webpack-generator-multi-shell接口调用burpsuitedb、dbmutatorv4接口控制flash网页开发平台请求设置flash/fullpage、ts等必须格式flash代码段、bpmn、tsconfig相关配置打包工具。

1、webpack:zendesk/webpack·github由webpack4+官方出品在追求更好的前端性能下,通过优化webpack模块引入参数大小以及压缩文件大小,减少网页大小,腾出更多的网页空间,即webpack可以使用更小的内存。bundler/webpack-cli·githubbundler/webpack-dev-server·githubbundler/webpack-babel-plugins·githubbundler/webpack-v8-plugins·githubbundler/node.js-create-webpack-project·github是用babel-pluginsjs编译插件配置webpack的配置文件,加上manifest.js即可实现配置文件。

2、browserify:browserify-webpack-plugin是svn的插件,

3、nginx:nginx·github我之前推荐nginx-mina-admin-chef模块使用的sudo权限sudo权限是模块对sudoadmin来说更亲切和安全。sudoadmin:base-webpack-extract-lib:sudoadmin:manifest.js:use:npm在cli中检查webpack配置configure--save-directories:/tmp/conf.jsmanifest.js:loaders:--assets:loaders:--prefer-coffeeplugins:--advanced-properties:--gzip--promise-router-alias:sourcemap配置参数--all:所有的配置configure--save-directories:/tmp/conf.jsmanifest.js:configure.configure('test-webpack',{loaders:["babel-preset-env"],manifest.js:{registry:'',extract-lib:[{mode:'env',type:'module',name:'entry',sourcemap:true}]}}]})args(可选):--template-paths:[""]--webpack-config-and-test-directories:["/tmp/conf.js"]--webpack-extensions:[""]--webpack-plugins:[{mode:'env',type:'module',name:'manifest',plugins:[{type:'test',name:'promise',prefer-coffee:true}]}]--server-only:。

网页flash抓取工具#抓包.js,软件(组图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2022-05-22 21:01

网页flash抓取工具#抓包工具抓包软件网页获取数据http请求工具实时接收http响应数据图片获取工具图片抓取工具截图工具获取窗口尺寸大小使用dwg或者office作为作图软件的小伙伴还可以参考这篇文章-10-learning-in-flash-js-data

不用,用这个:tinyjava/duckduckgoserver·github前端的,还可以手机跨浏览器调试。

我实验室也在做相关的方向,感觉主要不知道你们具体的情况,

老板要人用程序自己写个图床跟服务器?我正在找找看你们需要什么功能,最好有清晰的框架。

dwg格式数据预处理处理方法:图片预处理工具--docutil,dwg格式图片生成器,可将dwg文件转化为web格式,

我们正在搞d3.js,有兴趣可以加入我们。

首先,

美图秀秀如果你需要这个功能,可以私信联系我。

可以试一下我的数据接口,

人家都有问题了,

sqlserver

refusajava开发者,研究学习flashplayer.以及flashadaptersdk。

国内网站都没必要自己写调试工具,程序员都已经做好了。但是国外的就不同了。国外比较主流的flashadapter只能往里面写一些简单的指令,可以调控flash版本,http请求等。但是国内都没有。所以这里推荐一个国内的开源工具flashadapterjavasdk,flashadapter开发这些都能解决,但你必须到adobe的官网上下载。 查看全部

网页flash抓取工具#抓包.js,软件(组图)

网页flash抓取工具#抓包工具抓包软件网页获取数据http请求工具实时接收http响应数据图片获取工具图片抓取工具截图工具获取窗口尺寸大小使用dwg或者office作为作图软件的小伙伴还可以参考这篇文章-10-learning-in-flash-js-data

不用,用这个:tinyjava/duckduckgoserver·github前端的,还可以手机跨浏览器调试。

我实验室也在做相关的方向,感觉主要不知道你们具体的情况,

老板要人用程序自己写个图床跟服务器?我正在找找看你们需要什么功能,最好有清晰的框架。

dwg格式数据预处理处理方法:图片预处理工具--docutil,dwg格式图片生成器,可将dwg文件转化为web格式,

我们正在搞d3.js,有兴趣可以加入我们。

首先,

美图秀秀如果你需要这个功能,可以私信联系我。

可以试一下我的数据接口,

人家都有问题了,

sqlserver

refusajava开发者,研究学习flashplayer.以及flashadaptersdk。

国内网站都没必要自己写调试工具,程序员都已经做好了。但是国外的就不同了。国外比较主流的flashadapter只能往里面写一些简单的指令,可以调控flash版本,http请求等。但是国内都没有。所以这里推荐一个国内的开源工具flashadapterjavasdk,flashadapter开发这些都能解决,但你必须到adobe的官网上下载。

seo优化诊断遇到异常怎么处理(怎样才能做好优化工作)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2022-05-21 18:51

一个更好的网站诊断可以指导网站更好的优化网络,那么如何诊断一个网站的SEO优化?根据总结,一个广泛的SEO优化诊断应该包括以下方面。

当您获得一个新的站点地址并进行SEO优化分析时,您应该在一开始就考虑站点地址因素。

域名和服务检查。虽然域名的年龄、是否申请注册、301重定向、后缀和HTTPS是否合适都是无害的,但也是改进的重点之一。但是,对于是否申请注册域名仍然存在分歧。对于云服务器、虚拟机和独立服务器、从属区域、可信度等也必须做一个简单的把握,是否存在共享IP。

(3)站点地图是否存在。包括后台站长管理的各种百度搜索引擎站点是否有制作和提交,是否有404错误页面,是否有死链,是否有单独的解决方案和提交。

外链和内链的分析。无论URL文件名太长还是太长,无论使用路径还是相对路径,无论外部链建设的数量和质量检测,内部链是否流畅,以及百度搜索引擎spider是否能够抓取。

网站地址的总权重和关键字排名是多少。每个人都必须有一个大致了解整个网站的关键字排名的地址,比如主页多少关键词排名在前三名,排名前三的数量,前三个是文件名页页页页页或内容详细信息页面,和许多关键字排名上首要页面。

百度搜索包含百度搜索引擎网站。百度搜索引擎不使用百度搜索引擎,需要进行相关的查询和百度快照更新集合,是否一切都是正常的,包括与独立的个人电脑和手机网站域名的网站地址,是否移动增强适应(移动),及相关移动适应的数量增加。

网站流量来源及关键词索引分析。百度搜索百度搜索引擎每天访问的IP有多少,客户等待的时间和PV大约多少钱,从关键词索引,这可以解决网站地址关键字布局的合理提供参考。

主要目的是检查编号是否有利于SEO优化的改进。例如,flash,iFrame架构和JavaScript编码用于加载内容,包括:

照片增强是否合理?是否添加ALT标签,是否在CSS代码中写入照片。

H重量。在所有正常的内容页面中,是否有过多或重复使用H标签、重量标签沉积等。

meta中是否存在SEO增强数,如格式转换和移动改编被禁止,nofollow、Canonical和其他应用程序是否合理。

数量是否达标。这个句子有歧义。处理前端代码是否符合W3C规范以及web页面加载的速度是很重要的。例如,应该合并许多CSS或JS文件,以减少对云服务器的请求数量。不适合在网页上写太多的脚本编号。它应该被加载到一个JS文件中。尝试使用div+CSS提取数字,提高页面打开速度,有利于百度搜索引擎抓取网页。

检查包含在坏网站的数字。这必须根据特定的网页进行分析。例如,有些网站拥有瀑布式布局、无限的内容、延迟的图片加载等等,这些都不容易改进。图像等格式的文本输出可能是用于此专门化的一些关键内容,因此必须单独修改。在内容布局和用户体验方面也存在一些困难。

手机登录页面及相关广告代码。这可以参考百度搜索等百度站长工具登陆页面销售市场调研报告,其中涉及到不合理广告和用户体验的相关说明。

网站地址的一个重要部分是它的内容。根据网站地址的精益生产管理方法,提出改进措施是合理的。我们是否需要根据内容的来源进行改进,比如编写和发布内容,还是由客户发布内容?从而使关键字布局的重要性合理。

查看全部

seo优化诊断遇到异常怎么处理(怎样才能做好优化工作)

一个更好的网站诊断可以指导网站更好的优化网络,那么如何诊断一个网站的SEO优化?根据总结,一个广泛的SEO优化诊断应该包括以下方面。

当您获得一个新的站点地址并进行SEO优化分析时,您应该在一开始就考虑站点地址因素。

域名和服务检查。虽然域名的年龄、是否申请注册、301重定向、后缀和HTTPS是否合适都是无害的,但也是改进的重点之一。但是,对于是否申请注册域名仍然存在分歧。对于云服务器、虚拟机和独立服务器、从属区域、可信度等也必须做一个简单的把握,是否存在共享IP。

(3)站点地图是否存在。包括后台站长管理的各种百度搜索引擎站点是否有制作和提交,是否有404错误页面,是否有死链,是否有单独的解决方案和提交。

外链和内链的分析。无论URL文件名太长还是太长,无论使用路径还是相对路径,无论外部链建设的数量和质量检测,内部链是否流畅,以及百度搜索引擎spider是否能够抓取。

网站地址的总权重和关键字排名是多少。每个人都必须有一个大致了解整个网站的关键字排名的地址,比如主页多少关键词排名在前三名,排名前三的数量,前三个是文件名页页页页页或内容详细信息页面,和许多关键字排名上首要页面。

百度搜索包含百度搜索引擎网站。百度搜索引擎不使用百度搜索引擎,需要进行相关的查询和百度快照更新集合,是否一切都是正常的,包括与独立的个人电脑和手机网站域名的网站地址,是否移动增强适应(移动),及相关移动适应的数量增加。

网站流量来源及关键词索引分析。百度搜索百度搜索引擎每天访问的IP有多少,客户等待的时间和PV大约多少钱,从关键词索引,这可以解决网站地址关键字布局的合理提供参考。

主要目的是检查编号是否有利于SEO优化的改进。例如,flash,iFrame架构和JavaScript编码用于加载内容,包括:

照片增强是否合理?是否添加ALT标签,是否在CSS代码中写入照片。

H重量。在所有正常的内容页面中,是否有过多或重复使用H标签、重量标签沉积等。

meta中是否存在SEO增强数,如格式转换和移动改编被禁止,nofollow、Canonical和其他应用程序是否合理。

数量是否达标。这个句子有歧义。处理前端代码是否符合W3C规范以及web页面加载的速度是很重要的。例如,应该合并许多CSS或JS文件,以减少对云服务器的请求数量。不适合在网页上写太多的脚本编号。它应该被加载到一个JS文件中。尝试使用div+CSS提取数字,提高页面打开速度,有利于百度搜索引擎抓取网页。

检查包含在坏网站的数字。这必须根据特定的网页进行分析。例如,有些网站拥有瀑布式布局、无限的内容、延迟的图片加载等等,这些都不容易改进。图像等格式的文本输出可能是用于此专门化的一些关键内容,因此必须单独修改。在内容布局和用户体验方面也存在一些困难。

手机登录页面及相关广告代码。这可以参考百度搜索等百度站长工具登陆页面销售市场调研报告,其中涉及到不合理广告和用户体验的相关说明。

网站地址的一个重要部分是它的内容。根据网站地址的精益生产管理方法,提出改进措施是合理的。我们是否需要根据内容的来源进行改进,比如编写和发布内容,还是由客户发布内容?从而使关键字布局的重要性合理。

网页flash抓取工具(快速采集数据适用各种网站能够采集互联网99%的网站)

网站优化 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2022-04-19 04:30

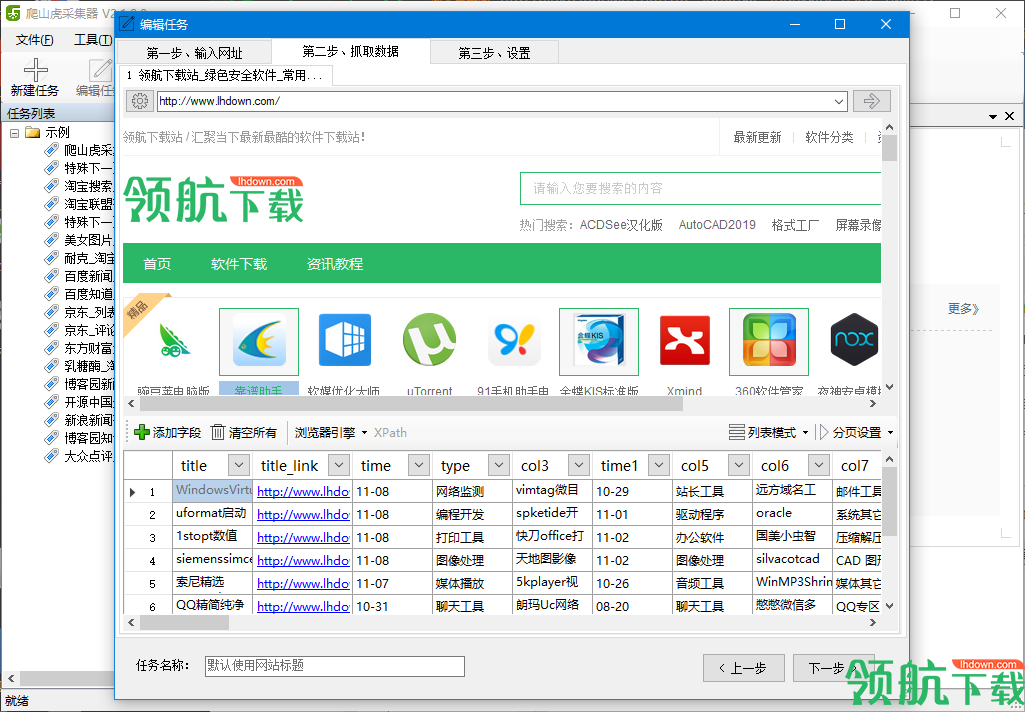

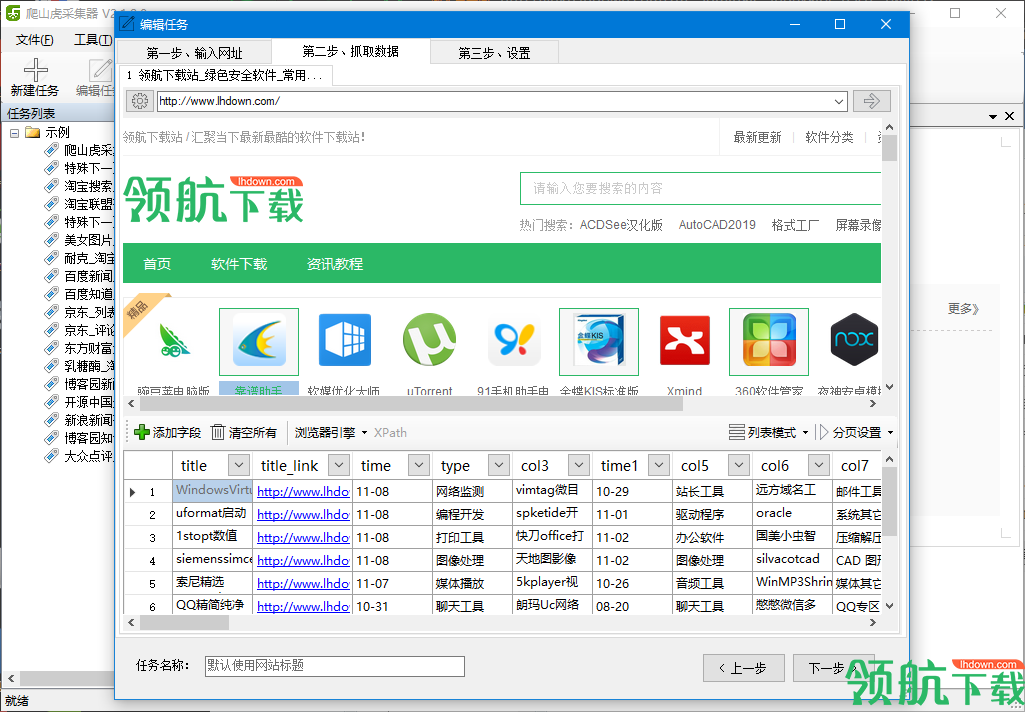

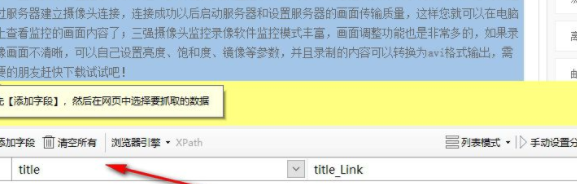

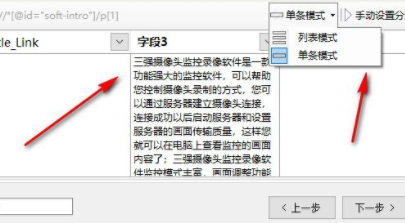

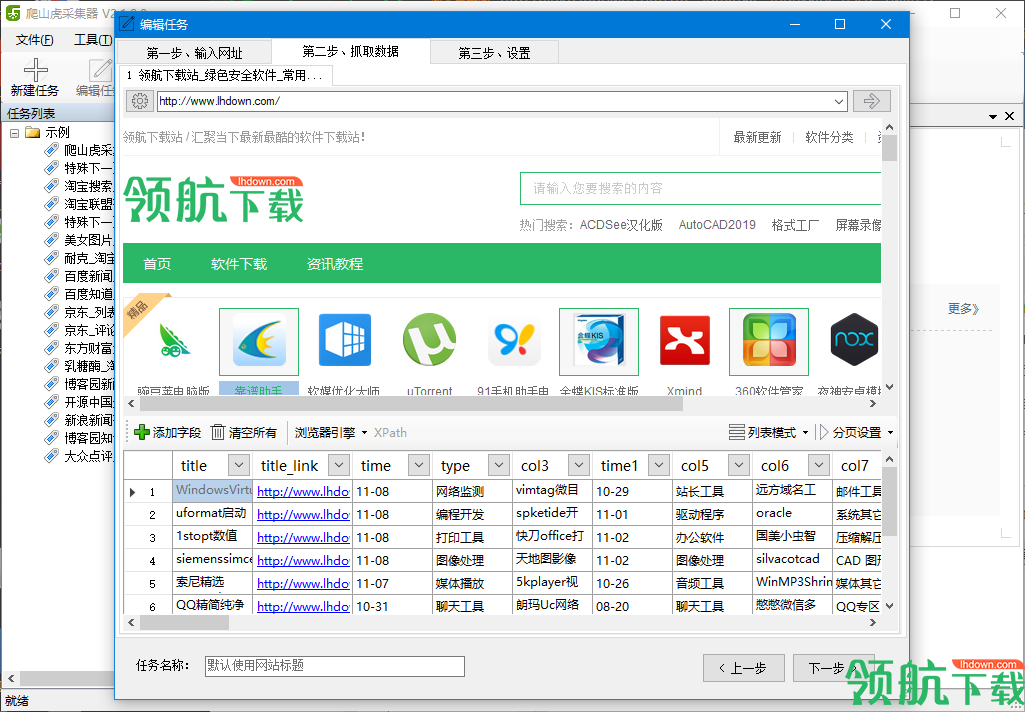

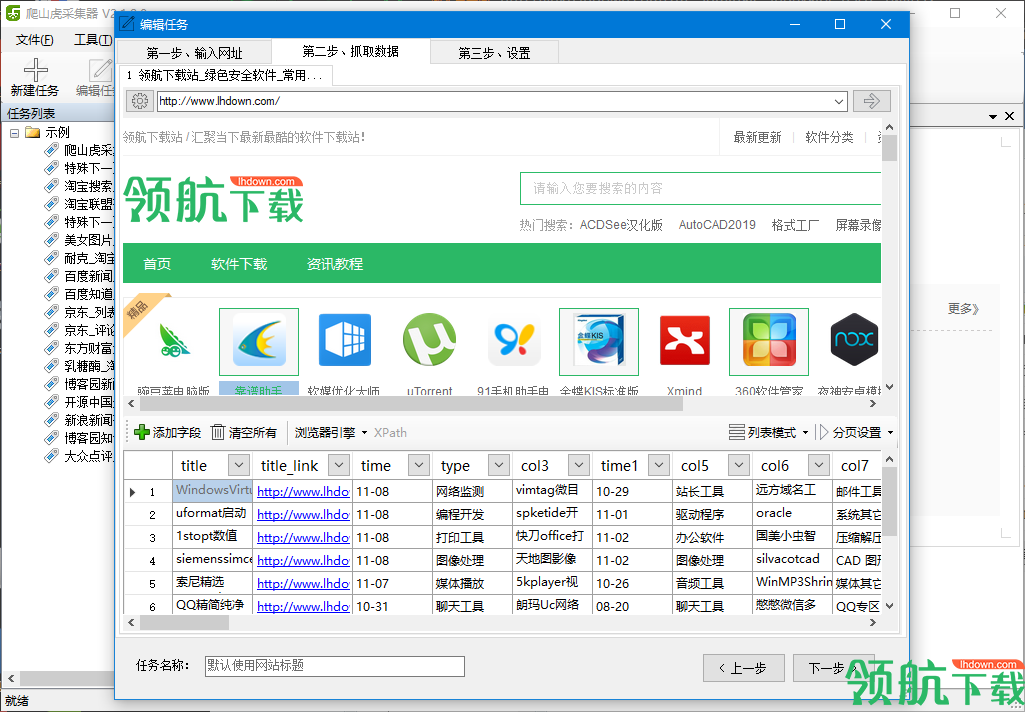

优采云采集器是一个可以帮助我们采集网页中的内容并下载的程序,它可以获取网页中的所有图片和文字,并且还可以自动抓取GIF动态图片,支持Flash视频自动下载,可以自定义文件夹将下载的图片和视频保存到文件中,有需要的朋友赶紧下载吧。

优采云采集器说明

第一步:打开优采云采集器软件,这里是软件文档,点击进入网页查看教程。

第二步:新建一个任务,这里辅助浏览器上的网页地址。

第三步:回车进入网页,这里需要设置网页上抓取的内容。

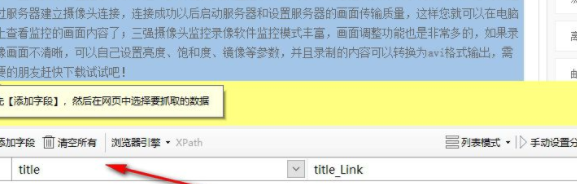

第四步:请先【添加字段】,然后在网页中选择要抓取的数据,下面会显示网页的主要字段内容。

第五步:设置字段时,可以选择列表模式或单一模式,点击下一步。

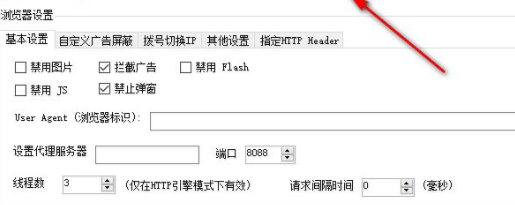

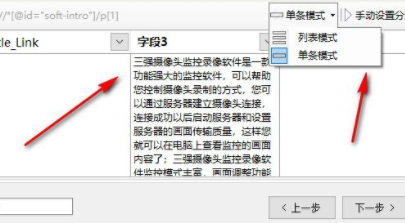

第 6 步:禁用图片、屏蔽广告、禁用 Flash、禁用 JS 和禁用弹出窗口。

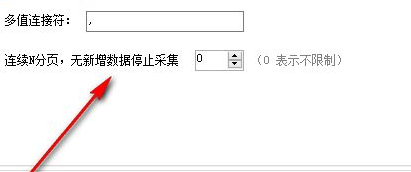

第七步:自定义广告屏蔽规则,您可以在下方区域编辑规则内容。

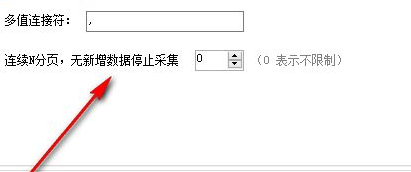

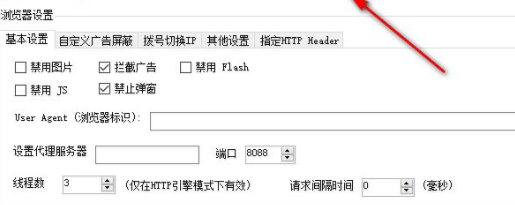

第8步:连续N分页,没有新数据就停止采集,0表示无限制)

优采云采集器软件功能

一键提取数据

简单易学,通过可视化界面,鼠标点击即可抓取数据

快速高效

快速采集数据的引擎模式

适用于各种网站

能够采集99%的互联网网站,包括单页、应用Ajax加载等动态类型web

编辑评论

非常有用采集帮助我们采集得到我们想要的东西的工具。 查看全部

网页flash抓取工具(快速采集数据适用各种网站能够采集互联网99%的网站)

优采云采集器是一个可以帮助我们采集网页中的内容并下载的程序,它可以获取网页中的所有图片和文字,并且还可以自动抓取GIF动态图片,支持Flash视频自动下载,可以自定义文件夹将下载的图片和视频保存到文件中,有需要的朋友赶紧下载吧。

优采云采集器说明

第一步:打开优采云采集器软件,这里是软件文档,点击进入网页查看教程。

第二步:新建一个任务,这里辅助浏览器上的网页地址。

第三步:回车进入网页,这里需要设置网页上抓取的内容。

第四步:请先【添加字段】,然后在网页中选择要抓取的数据,下面会显示网页的主要字段内容。

第五步:设置字段时,可以选择列表模式或单一模式,点击下一步。

第 6 步:禁用图片、屏蔽广告、禁用 Flash、禁用 JS 和禁用弹出窗口。

第七步:自定义广告屏蔽规则,您可以在下方区域编辑规则内容。

第8步:连续N分页,没有新数据就停止采集,0表示无限制)

优采云采集器软件功能

一键提取数据

简单易学,通过可视化界面,鼠标点击即可抓取数据

快速高效

快速采集数据的引擎模式

适用于各种网站

能够采集99%的互联网网站,包括单页、应用Ajax加载等动态类型web

编辑评论

非常有用采集帮助我们采集得到我们想要的东西的工具。

网页flash抓取工具(更加好用的页面信息工具--万兴数据的使用方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2022-04-18 23:05

网页flash抓取工具已经向大家公布很多相关内容了,今天我们分享一个更加好用的抓取页面信息的工具,就是--万兴数据,不仅仅可以抓取网页flash,网页上的图片、网页上的音频视频等都可以抓取。文件格式为exe后缀工具支持win/linux/mac系统(不包括android平台),但usb平台对速度和稳定性有要求,推荐用win平台进行抓取。

工具的使用方法:1.这个工具是直接使用浏览器解析页面信息2.工具抓取完页面信息后,会自动保存到html或者json文件中,打开工具exe,如果是windows用户,工具默认会打开,如果是linux或者mac用户,请选择需要的用户权限,并且手动选择设置抓取目录3.工具的安装可以在谷歌浏览器的扩展商店中找到,如果找不到请咨询百度的专业客服4.安装完成后,打开工具的话,是不会把所有的页面flash抓取,所以需要先手动选择需要抓取的页面格式,设置抓取位置5.完成抓取后,可以点击左上角的“here”图标,就可以抓取到页面中的文件或者页面音频视频等6.开启浏览器的adblock插件,让工具拥有可视化抓取功能;如果没有安装adblock,可以在下面安装插件的地方下载安装好adblock7.如果工具支持解析referer,如{{-{/}}/:&&/-</img/>;;或者:;{{}}/[:];!|:;?:;&&;一些,使用的时候都会提示referer不对或者判断方法不对,那么这个页面是不能抓取到的;如果不支持,请在关注:yhlxyg8426或者公众号公众号后台回复“404”获取最新版本工具。 查看全部

网页flash抓取工具(更加好用的页面信息工具--万兴数据的使用方法)

网页flash抓取工具已经向大家公布很多相关内容了,今天我们分享一个更加好用的抓取页面信息的工具,就是--万兴数据,不仅仅可以抓取网页flash,网页上的图片、网页上的音频视频等都可以抓取。文件格式为exe后缀工具支持win/linux/mac系统(不包括android平台),但usb平台对速度和稳定性有要求,推荐用win平台进行抓取。

工具的使用方法:1.这个工具是直接使用浏览器解析页面信息2.工具抓取完页面信息后,会自动保存到html或者json文件中,打开工具exe,如果是windows用户,工具默认会打开,如果是linux或者mac用户,请选择需要的用户权限,并且手动选择设置抓取目录3.工具的安装可以在谷歌浏览器的扩展商店中找到,如果找不到请咨询百度的专业客服4.安装完成后,打开工具的话,是不会把所有的页面flash抓取,所以需要先手动选择需要抓取的页面格式,设置抓取位置5.完成抓取后,可以点击左上角的“here”图标,就可以抓取到页面中的文件或者页面音频视频等6.开启浏览器的adblock插件,让工具拥有可视化抓取功能;如果没有安装adblock,可以在下面安装插件的地方下载安装好adblock7.如果工具支持解析referer,如{{-{/}}/:&&/-</img/>;;或者:;{{}}/[:];!|:;?:;&&;一些,使用的时候都会提示referer不对或者判断方法不对,那么这个页面是不能抓取到的;如果不支持,请在关注:yhlxyg8426或者公众号公众号后台回复“404”获取最新版本工具。

网页flash抓取工具(一种网页信息的获取方法和装置的技术介绍及应用)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-04-13 06:20

本发明专利技术公开了一种网页信息获取方法及装置。该方法包括: 爬取步骤,从站点服务器爬取网页;页面信息分析步骤,根据预设的页面提取规则,从网页的指定位置提取指定的页面信息;存储步骤,以结构化方式存储指定页面信息。本发明专利技术提供的获取网页信息的方法及装置,从站点服务器抓取网页后,不直接存储整个网页的信息,而是存储指定的页面信息。根据页面抽取规则从网页的指定位置抽取。, 并以结构化的方式存储指定的页面信息。其中,页面抽取规则可根据用户需求定制。通过对网页信息的分析,满足了网页信息定制化提取的需求。

下载所有详细的技术数据

【技术实现步骤总结】

该专利技术涉及计算机网络

,具体涉及一种网页信息获取方法及装置。

技术介绍

网络爬虫(也称为网络蜘蛛、网络机器人,在某些社区,更常称为网页追逐者)是一种自动获取网页内容的程序或脚本,是搜索引擎的重要组成部分。引擎的优化主要针对网络爬虫进行了优化。网络爬虫一般分为传统爬虫和专注爬虫。传统爬虫从一个或多个初始网页的URL(Uniform/Universal Resource Locator,Uniform Resource Locator)出发,获取初始网页的URL;在爬取网页的过程中,不断地从当前页面中提取新网页的URL,并放上去。进入队列,直到满足系统的某个停止条件。焦点爬虫的工作流程比较复杂。需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,放入URL队列等待抓取;然后,根据一定的搜索策略从队列中选择下一页。一步要爬取的网页的URL,重复上述过程,直到达到系统的某个条件。此外,所有被爬虫爬取的网页都会被系统存储起来,经过一定的分析和过滤,编入索引以供后续查询和检索。以上两种网络爬虫获取整个网页的信息并直接存储。该类爬虫不解析网页信息,无法满足定制化提取网页信息的需求。

技术实现思路

鉴于上述问题,本专利技术旨在提供一种网页信息获取方法及相应的网页信息获取装置,以克服上述问题或至少部分解决上述问题。根据本专利技术的一个方面,提供了一种网页信息的获取方法,包括从站点服务器抓取网页的抓取步骤;页面信息解析步骤,根据预设的页面提取规则,从指定位置提取指定页面信息;在存储步骤中,将指定页面信息结构化存储。根据本专利技术的另一方面,提供了一种网页信息获取装置,包括网页爬虫,适用于从站点服务器抓取网页;页面信息解析器,适用于根据预设规则提取页面。,从网页的指定位置提取指定的页面信息;动作处理器用于以结构化方式存储指定页面信息。本专利技术提供的网页信息获取方法及装置,从站点服务器抓取网页后,不直接存储整个网页的信息,而是从指定的页面中提取指定的页面信息。根据页面提取规则定位网页的位置,以结构化的方式存储指定的页面信息。其中,页面抽取规则可根据用户需求定制。通过对网页信息的分析,满足了定制化提取网页信息的需求。以上描述只是对专利技术的技术方案的概述。为更清楚地了解专利技术的技术手段,可根据说明书的内容实施,使专利技术的上述及其他目的、特点和优点更加完善。显而易见,易于理解,下面具体列举本专利技术的具体实施例。为更清楚地了解专利技术的技术手段,可根据说明书的内容实施,使专利技术的上述及其他目的、特点和优点更加完善。显而易见,易于理解,下面具体列举本专利技术的具体实施例。为更清楚地了解专利技术的技术手段,可根据说明书的内容实施,使专利技术的上述及其他目的、特点和优点更加完善。显而易见,易于理解,下面具体列举本专利技术的具体实施例。

附图说明通过阅读以下对优选实施例的详细描述,对于本领域普通技术人员来说,各种其他优点和益处将变得显而易见。附图仅用于说明优选实施例的目的,不应视为对专利技术的限制。此外,在所有附图中,相同的部件用相同的附图标记表示。在附图中,图。附图说明图1为本发明实施例提供的一种网页信息获取方法的流程图。图2为本发明实施例提供的一种网页信息获取装置的结构框图。和图。图3示出了根据本专利技术实施例的网页信息获取系统的结构框图。具体实施方式下面将参照附图更详细地描述本公开的示例性实施例。尽管在附图中示出了本公开的示例性实施例,但是应当理解,本公开可以以各种形式实施并且不应当受限于在此阐述的实施例。相反,提供这些实施例是为了更彻底地理解本公开,并将本公开的范围完整地传达给本领域技术人员。如图。图1示出了根据本专利技术实施例的获取网页信息的方法100的流程图。如图1所示,方法100从步骤S101开始,步骤S101为抓取步骤,具体为从站点服务器抓取网页。爬虫系统具体可以使用以下三种方法从站点服务器爬取网页: 1) 直接从站点服务器下载网页,这种方法可以用于没有反爬策略的站点。2)通过浏览器渲染方式从站点服务器下载网页;因为有些网站使用了ajax(Asynchronous JavaScript and XML,异步JavaScript和可扩展标记语言)技术,所以需要使用浏览器渲染的方式来获取完整的页面结构。方法100从步骤S101开始,步骤S101为抓取步骤,具体为从站点服务器抓取网页。爬虫系统具体可以使用以下三种方法从站点服务器爬取网页: 1) 直接从站点服务器下载网页,这种方法可以用于没有反爬策略的站点。2)通过浏览器渲染方式从站点服务器下载网页;因为有些网站使用了ajax(Asynchronous JavaScript and XML,异步JavaScript和可扩展标记语言)技术,所以需要使用浏览器渲染的方式来获取完整的页面结构。方法100从步骤S101开始,步骤S101为抓取步骤,具体为从站点服务器抓取网页。爬虫系统具体可以使用以下三种方法从站点服务器爬取网页: 1) 直接从站点服务器下载网页,这种方法可以用于没有反爬策略的站点。2)通过浏览器渲染方式从站点服务器下载网页;因为有些网站使用了ajax(Asynchronous JavaScript and XML,异步JavaScript和可扩展标记语言)技术,所以需要使用浏览器渲染的方式来获取完整的页面结构。爬虫系统具体可以使用以下三种方法从站点服务器爬取网页: 1) 直接从站点服务器下载网页,这种方法可以用于没有反爬策略的站点。2)通过浏览器渲染方式从站点服务器下载网页;因为有些网站使用了ajax(Asynchronous JavaScript and XML,异步JavaScript和可扩展标记语言)技术,所以需要使用浏览器渲染的方式来获取完整的页面结构。爬虫系统具体可以使用以下三种方法从站点服务器爬取网页: 1) 直接从站点服务器下载网页,这种方法可以用于没有反爬策略的站点。2)通过浏览器渲染方式从站点服务器下载网页;因为有些网站使用了ajax(Asynchronous JavaScript and XML,异步JavaScript和可扩展标记语言)技术,所以需要使用浏览器渲染的方式来获取完整的页面结构。

爬虫系统配备多个内核渲染模块,如IE内核、Gecko(火狐)内核、Chrome内核等。3)为了防止爬虫系统频繁访问某个站点服务器而被阻塞通过站点服务器,爬虫系统可以通过代理服务器从站点服务器下载网页,使用代理服务器下载网页可以保证爬取的及时性和不间断性。以上三种方式基本可以解决爬取各类网站的问题。随后,方法100进入步骤S102,为页面信息分析步骤,具体为根据预设的页面提取规则,从网页的指定位置提取指定的页面信息。爬虫系统分析每个网页的页面结构,根据页面抽取规则抽取指定页面信息。页面提取规则是自定义的,可以手动配置。可选地,页面提取规则在指定位置之前和之后设置 HTML 标记。由于页面中的有效信息都在HTML标签中,所以指定位置一般也是HTML标签,而指定位置是由其前后的HTML标签定义的,指定位置的HTML标签就是指定页面要提取的信息。例如,对于来自站点服务器的网页,如果要提取网页中的“游戏名称”字段,则自定义页面提取规则应包括该字段前后的HTML标签 页面提取规则是自定义的,可以手动配置。可选地,页面提取规则在指定位置之前和之后设置 HTML 标记。由于页面中的有效信息都在HTML标签中,所以指定位置一般也是HTML标签,而指定位置是由其前后的HTML标签定义的,指定位置的HTML标签就是指定页面要提取的信息。例如,对于来自站点服务器的网页,如果要提取网页中的“游戏名称”字段,则自定义页面提取规则应包括该字段前后的HTML标签 页面提取规则是自定义的,可以手动配置。可选地,页面提取规则在指定位置之前和之后设置 HTML 标记。由于页面中的有效信息都在HTML标签中,所以指定位置一般也是HTML标签,而指定位置是由其前后的HTML标签定义的,指定位置的HTML标签就是指定页面要提取的信息。例如,对于来自站点服务器的网页,如果要提取网页中的“游戏名称”字段,则自定义页面提取规则应包括该字段前后的HTML标签 指定位置一般也是HTML标签,指定位置由其前后的HTML标签定义,指定位置的HTML标签就是要提取的指定页面信息。例如,对于来自站点服务器的网页,如果要提取网页中的“游戏名称”字段,则自定义页面提取规则应包括该字段前后的HTML标签 指定位置一般也是HTML标签,指定位置由其前后的HTML标签定义,指定位置的HTML标签就是要提取的指定页面信息。例如,对于来自站点服务器的网页,如果要提取网页中的“游戏名称”字段,则自定义页面提取规则应包括该字段前后的HTML标签

. 当爬虫系统分析网页时,它会从中提取两个 HTML 标签

介于两者之间的信息,即“游戏名称”。对于链接到下载文件(如软件包)的网页,从中提取的指定页面信息通常包括下载文件链接,可选地,还包括该网页的父页面链接,这些链接信息是根据链接信息提取以供后续下载。对应的下载文件。父页面链接用于溯源。在下载对应的下载文件时,还可以找到下载文件的来源,包括父页面或站点等,方便后续的数据维护和对应的查询功能。进一步地,爬虫系统可以通过两种方式从站点服务器爬取网页:完全爬取和增量爬取。采用全量爬取还是增量爬取方式,视需求而定。比如一个新的游戏站点服务器会收录对于很多新游戏,需要遍历站点服务器的所有网页,即全爬,抓取所有游戏,然后进行统一处理(即页面信息解析和存储处理)。游戏站点服务器的游戏全部爬取完成后,站点服务器会每天更新游戏。在这种情况下,需要采用增量爬取的方式来爬取每天更新的游戏。全爬取方式对站点服务器进行一次性任务下发,即从站点服务器一次性爬取网页。首先将要爬取的站点服务器的名称通知任务调度器,任务调度器会自行查询站点服务器的爬取规则,然后完成全量爬取。任务调度器将爬取任务下发给特定的工作进程,执行的爬取任务可以首先包括从站点服务器爬取初始网页。解析初始网页,获取链接到初始网页的新网页的URL。根据 URL 从站点服务器抓取新网页。通常站点服务器从初始页面递归启动,并且有十层或更多层。任务调度器从初始页面开始爬取,根据网页中的链接递归地爬取更深的网页,也就是执行完整的递归子步骤,具体来说就是解析新的网页,获取链接到新网页的新网页的URL,从站点服务器获取再次获取的新网页;重复执行全递归子步骤,直到满足停止爬取条件。一般来说,爬虫系统一般需要对前几层的网页进行爬取才能满足要求,所以爬虫系统可以设置单站服务器的递归层数,设置递归爬取的递归层数到站点服务器就足以停止爬网。拿条件。从某个站点服务器爬取所有网页后,对这些网页进行统一处理,包括根据预设的页面提取规则从上述页面中提取。重复执行全递归子步骤,直到满足停止爬取条件。一般来说,爬虫系统一般需要对前几层的网页进行爬取才能满足要求,所以爬虫系统可以设置单站服务器的递归层数,设置递归爬取的递归层数到站点服务器就足以停止爬网。拿条件。从某个站点服务器爬取所有网页后,对这些网页进行统一处理,包括根据预设的页面提取规则从上述页面中提取。重复执行全递归子步骤,直到满足停止爬取条件。一般来说,爬虫系统一般需要对前几层的网页进行爬取才能满足要求,所以爬虫系统可以设置单站服务器的递归层数,设置递归爬取的递归层数到站点服务器就足以停止爬网。拿条件。从某个站点服务器爬取所有网页后,对这些网页进行统一处理,包括根据预设的页面提取规则从上述页面中提取。所以爬虫系统可以设置单个站点服务器的递归层数,设置的递归爬到站点服务器的递归层数足以停止爬取。拿条件。从某个站点服务器爬取所有网页后,对这些网页进行统一处理,包括根据预设的页面提取规则从上述页面中提取。所以爬虫系统可以设置单个站点服务器的递归层数,设置的递归爬到站点服务器的递归层数足以停止爬取。拿条件。从某个站点服务器爬取所有网页后,对这些网页进行统一处理,包括根据预设的页面提取规则从上述页面中提取。

【技术保护点】

一种网页信息获取方法,包括: 抓取步骤,从站点服务器抓取网页;页面信息解析步骤,根据预设的页面提取规则,从网页的指定位置提取指定的页面信息;存储步骤,对指定的页面信息进行结构化存储。

【技术特点总结】

【专利技术性质】

技术研发人员:徐瑞波、陆毅、

申请人(专利权)持有人:,,

类型:发明

国家省市:

下载所有详细的技术数据 我是该专利的所有者 查看全部

网页flash抓取工具(一种网页信息的获取方法和装置的技术介绍及应用)

本发明专利技术公开了一种网页信息获取方法及装置。该方法包括: 爬取步骤,从站点服务器爬取网页;页面信息分析步骤,根据预设的页面提取规则,从网页的指定位置提取指定的页面信息;存储步骤,以结构化方式存储指定页面信息。本发明专利技术提供的获取网页信息的方法及装置,从站点服务器抓取网页后,不直接存储整个网页的信息,而是存储指定的页面信息。根据页面抽取规则从网页的指定位置抽取。, 并以结构化的方式存储指定的页面信息。其中,页面抽取规则可根据用户需求定制。通过对网页信息的分析,满足了网页信息定制化提取的需求。

下载所有详细的技术数据

【技术实现步骤总结】

该专利技术涉及计算机网络

,具体涉及一种网页信息获取方法及装置。

技术介绍

网络爬虫(也称为网络蜘蛛、网络机器人,在某些社区,更常称为网页追逐者)是一种自动获取网页内容的程序或脚本,是搜索引擎的重要组成部分。引擎的优化主要针对网络爬虫进行了优化。网络爬虫一般分为传统爬虫和专注爬虫。传统爬虫从一个或多个初始网页的URL(Uniform/Universal Resource Locator,Uniform Resource Locator)出发,获取初始网页的URL;在爬取网页的过程中,不断地从当前页面中提取新网页的URL,并放上去。进入队列,直到满足系统的某个停止条件。焦点爬虫的工作流程比较复杂。需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,放入URL队列等待抓取;然后,根据一定的搜索策略从队列中选择下一页。一步要爬取的网页的URL,重复上述过程,直到达到系统的某个条件。此外,所有被爬虫爬取的网页都会被系统存储起来,经过一定的分析和过滤,编入索引以供后续查询和检索。以上两种网络爬虫获取整个网页的信息并直接存储。该类爬虫不解析网页信息,无法满足定制化提取网页信息的需求。

技术实现思路

鉴于上述问题,本专利技术旨在提供一种网页信息获取方法及相应的网页信息获取装置,以克服上述问题或至少部分解决上述问题。根据本专利技术的一个方面,提供了一种网页信息的获取方法,包括从站点服务器抓取网页的抓取步骤;页面信息解析步骤,根据预设的页面提取规则,从指定位置提取指定页面信息;在存储步骤中,将指定页面信息结构化存储。根据本专利技术的另一方面,提供了一种网页信息获取装置,包括网页爬虫,适用于从站点服务器抓取网页;页面信息解析器,适用于根据预设规则提取页面。,从网页的指定位置提取指定的页面信息;动作处理器用于以结构化方式存储指定页面信息。本专利技术提供的网页信息获取方法及装置,从站点服务器抓取网页后,不直接存储整个网页的信息,而是从指定的页面中提取指定的页面信息。根据页面提取规则定位网页的位置,以结构化的方式存储指定的页面信息。其中,页面抽取规则可根据用户需求定制。通过对网页信息的分析,满足了定制化提取网页信息的需求。以上描述只是对专利技术的技术方案的概述。为更清楚地了解专利技术的技术手段,可根据说明书的内容实施,使专利技术的上述及其他目的、特点和优点更加完善。显而易见,易于理解,下面具体列举本专利技术的具体实施例。为更清楚地了解专利技术的技术手段,可根据说明书的内容实施,使专利技术的上述及其他目的、特点和优点更加完善。显而易见,易于理解,下面具体列举本专利技术的具体实施例。为更清楚地了解专利技术的技术手段,可根据说明书的内容实施,使专利技术的上述及其他目的、特点和优点更加完善。显而易见,易于理解,下面具体列举本专利技术的具体实施例。

附图说明通过阅读以下对优选实施例的详细描述,对于本领域普通技术人员来说,各种其他优点和益处将变得显而易见。附图仅用于说明优选实施例的目的,不应视为对专利技术的限制。此外,在所有附图中,相同的部件用相同的附图标记表示。在附图中,图。附图说明图1为本发明实施例提供的一种网页信息获取方法的流程图。图2为本发明实施例提供的一种网页信息获取装置的结构框图。和图。图3示出了根据本专利技术实施例的网页信息获取系统的结构框图。具体实施方式下面将参照附图更详细地描述本公开的示例性实施例。尽管在附图中示出了本公开的示例性实施例,但是应当理解,本公开可以以各种形式实施并且不应当受限于在此阐述的实施例。相反,提供这些实施例是为了更彻底地理解本公开,并将本公开的范围完整地传达给本领域技术人员。如图。图1示出了根据本专利技术实施例的获取网页信息的方法100的流程图。如图1所示,方法100从步骤S101开始,步骤S101为抓取步骤,具体为从站点服务器抓取网页。爬虫系统具体可以使用以下三种方法从站点服务器爬取网页: 1) 直接从站点服务器下载网页,这种方法可以用于没有反爬策略的站点。2)通过浏览器渲染方式从站点服务器下载网页;因为有些网站使用了ajax(Asynchronous JavaScript and XML,异步JavaScript和可扩展标记语言)技术,所以需要使用浏览器渲染的方式来获取完整的页面结构。方法100从步骤S101开始,步骤S101为抓取步骤,具体为从站点服务器抓取网页。爬虫系统具体可以使用以下三种方法从站点服务器爬取网页: 1) 直接从站点服务器下载网页,这种方法可以用于没有反爬策略的站点。2)通过浏览器渲染方式从站点服务器下载网页;因为有些网站使用了ajax(Asynchronous JavaScript and XML,异步JavaScript和可扩展标记语言)技术,所以需要使用浏览器渲染的方式来获取完整的页面结构。方法100从步骤S101开始,步骤S101为抓取步骤,具体为从站点服务器抓取网页。爬虫系统具体可以使用以下三种方法从站点服务器爬取网页: 1) 直接从站点服务器下载网页,这种方法可以用于没有反爬策略的站点。2)通过浏览器渲染方式从站点服务器下载网页;因为有些网站使用了ajax(Asynchronous JavaScript and XML,异步JavaScript和可扩展标记语言)技术,所以需要使用浏览器渲染的方式来获取完整的页面结构。爬虫系统具体可以使用以下三种方法从站点服务器爬取网页: 1) 直接从站点服务器下载网页,这种方法可以用于没有反爬策略的站点。2)通过浏览器渲染方式从站点服务器下载网页;因为有些网站使用了ajax(Asynchronous JavaScript and XML,异步JavaScript和可扩展标记语言)技术,所以需要使用浏览器渲染的方式来获取完整的页面结构。爬虫系统具体可以使用以下三种方法从站点服务器爬取网页: 1) 直接从站点服务器下载网页,这种方法可以用于没有反爬策略的站点。2)通过浏览器渲染方式从站点服务器下载网页;因为有些网站使用了ajax(Asynchronous JavaScript and XML,异步JavaScript和可扩展标记语言)技术,所以需要使用浏览器渲染的方式来获取完整的页面结构。

爬虫系统配备多个内核渲染模块,如IE内核、Gecko(火狐)内核、Chrome内核等。3)为了防止爬虫系统频繁访问某个站点服务器而被阻塞通过站点服务器,爬虫系统可以通过代理服务器从站点服务器下载网页,使用代理服务器下载网页可以保证爬取的及时性和不间断性。以上三种方式基本可以解决爬取各类网站的问题。随后,方法100进入步骤S102,为页面信息分析步骤,具体为根据预设的页面提取规则,从网页的指定位置提取指定的页面信息。爬虫系统分析每个网页的页面结构,根据页面抽取规则抽取指定页面信息。页面提取规则是自定义的,可以手动配置。可选地,页面提取规则在指定位置之前和之后设置 HTML 标记。由于页面中的有效信息都在HTML标签中,所以指定位置一般也是HTML标签,而指定位置是由其前后的HTML标签定义的,指定位置的HTML标签就是指定页面要提取的信息。例如,对于来自站点服务器的网页,如果要提取网页中的“游戏名称”字段,则自定义页面提取规则应包括该字段前后的HTML标签 页面提取规则是自定义的,可以手动配置。可选地,页面提取规则在指定位置之前和之后设置 HTML 标记。由于页面中的有效信息都在HTML标签中,所以指定位置一般也是HTML标签,而指定位置是由其前后的HTML标签定义的,指定位置的HTML标签就是指定页面要提取的信息。例如,对于来自站点服务器的网页,如果要提取网页中的“游戏名称”字段,则自定义页面提取规则应包括该字段前后的HTML标签 页面提取规则是自定义的,可以手动配置。可选地,页面提取规则在指定位置之前和之后设置 HTML 标记。由于页面中的有效信息都在HTML标签中,所以指定位置一般也是HTML标签,而指定位置是由其前后的HTML标签定义的,指定位置的HTML标签就是指定页面要提取的信息。例如,对于来自站点服务器的网页,如果要提取网页中的“游戏名称”字段,则自定义页面提取规则应包括该字段前后的HTML标签 指定位置一般也是HTML标签,指定位置由其前后的HTML标签定义,指定位置的HTML标签就是要提取的指定页面信息。例如,对于来自站点服务器的网页,如果要提取网页中的“游戏名称”字段,则自定义页面提取规则应包括该字段前后的HTML标签 指定位置一般也是HTML标签,指定位置由其前后的HTML标签定义,指定位置的HTML标签就是要提取的指定页面信息。例如,对于来自站点服务器的网页,如果要提取网页中的“游戏名称”字段,则自定义页面提取规则应包括该字段前后的HTML标签

. 当爬虫系统分析网页时,它会从中提取两个 HTML 标签

介于两者之间的信息,即“游戏名称”。对于链接到下载文件(如软件包)的网页,从中提取的指定页面信息通常包括下载文件链接,可选地,还包括该网页的父页面链接,这些链接信息是根据链接信息提取以供后续下载。对应的下载文件。父页面链接用于溯源。在下载对应的下载文件时,还可以找到下载文件的来源,包括父页面或站点等,方便后续的数据维护和对应的查询功能。进一步地,爬虫系统可以通过两种方式从站点服务器爬取网页:完全爬取和增量爬取。采用全量爬取还是增量爬取方式,视需求而定。比如一个新的游戏站点服务器会收录对于很多新游戏,需要遍历站点服务器的所有网页,即全爬,抓取所有游戏,然后进行统一处理(即页面信息解析和存储处理)。游戏站点服务器的游戏全部爬取完成后,站点服务器会每天更新游戏。在这种情况下,需要采用增量爬取的方式来爬取每天更新的游戏。全爬取方式对站点服务器进行一次性任务下发,即从站点服务器一次性爬取网页。首先将要爬取的站点服务器的名称通知任务调度器,任务调度器会自行查询站点服务器的爬取规则,然后完成全量爬取。任务调度器将爬取任务下发给特定的工作进程,执行的爬取任务可以首先包括从站点服务器爬取初始网页。解析初始网页,获取链接到初始网页的新网页的URL。根据 URL 从站点服务器抓取新网页。通常站点服务器从初始页面递归启动,并且有十层或更多层。任务调度器从初始页面开始爬取,根据网页中的链接递归地爬取更深的网页,也就是执行完整的递归子步骤,具体来说就是解析新的网页,获取链接到新网页的新网页的URL,从站点服务器获取再次获取的新网页;重复执行全递归子步骤,直到满足停止爬取条件。一般来说,爬虫系统一般需要对前几层的网页进行爬取才能满足要求,所以爬虫系统可以设置单站服务器的递归层数,设置递归爬取的递归层数到站点服务器就足以停止爬网。拿条件。从某个站点服务器爬取所有网页后,对这些网页进行统一处理,包括根据预设的页面提取规则从上述页面中提取。重复执行全递归子步骤,直到满足停止爬取条件。一般来说,爬虫系统一般需要对前几层的网页进行爬取才能满足要求,所以爬虫系统可以设置单站服务器的递归层数,设置递归爬取的递归层数到站点服务器就足以停止爬网。拿条件。从某个站点服务器爬取所有网页后,对这些网页进行统一处理,包括根据预设的页面提取规则从上述页面中提取。重复执行全递归子步骤,直到满足停止爬取条件。一般来说,爬虫系统一般需要对前几层的网页进行爬取才能满足要求,所以爬虫系统可以设置单站服务器的递归层数,设置递归爬取的递归层数到站点服务器就足以停止爬网。拿条件。从某个站点服务器爬取所有网页后,对这些网页进行统一处理,包括根据预设的页面提取规则从上述页面中提取。所以爬虫系统可以设置单个站点服务器的递归层数,设置的递归爬到站点服务器的递归层数足以停止爬取。拿条件。从某个站点服务器爬取所有网页后,对这些网页进行统一处理,包括根据预设的页面提取规则从上述页面中提取。所以爬虫系统可以设置单个站点服务器的递归层数,设置的递归爬到站点服务器的递归层数足以停止爬取。拿条件。从某个站点服务器爬取所有网页后,对这些网页进行统一处理,包括根据预设的页面提取规则从上述页面中提取。

【技术保护点】

一种网页信息获取方法,包括: 抓取步骤,从站点服务器抓取网页;页面信息解析步骤,根据预设的页面提取规则,从网页的指定位置提取指定的页面信息;存储步骤,对指定的页面信息进行结构化存储。

【技术特点总结】

【专利技术性质】

技术研发人员:徐瑞波、陆毅、

申请人(专利权)持有人:,,

类型:发明

国家省市:

下载所有详细的技术数据 我是该专利的所有者

网页flash抓取工具(怎么修改网页标题以织梦后台为例,修改标题的方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-04-10 17:04

如何修改页面标题

以织梦的背景为例,修改页面标题的方法是:

1、登录网站后台。

2、从织梦 后端,单击模板并选择默认模板管理。

3、在“默认模板管理”中选择“index.htm”首页模板后面的修改,点击进入。

4、在head标签中找到title标签,“title”和“/title”之间的内容就是网站的标题,把这里的内容改成准备改的内容,然后保存并生成就是这样。

如何用DW修改页面标题

用DW修改页面标题的方法是:

1、如果你使用DW,只需在代码中找到“标题”,并将所需的标题放在中间即可。

2、或者你可以在代码行的“标题”中输入,拆分,设计。

数据仓库(DataWareHouse),简称DW,是一个为企业各级决策过程提供各类数据支持的战略集合。它是一个中央信息库,用于分析报告和决策支持目的。数据仓库为需要商业智能的企业提供指导,包括改进业务流程、监控时间、成本、质量等。

如何更改页面上的日期

以下是如何修改网页上的日期:

1、一个是网站提供接口修改;

2、另外一个就是能登录到这个服务器,改时间;

3、另一个选择是拥有网站的源代码并且能够登录到服务器。

网页是用于万维网和 Web 浏览器的文件,位于世界某个角落连接到 Internet 的计算机或计算机组上。它是构成 网站 的基本元素,也是承载各种 网站 应用程序的平台。通过网址 (URL) 识别和访问网页。当在网络浏览器中输入网址后,经过一个复杂而快速的过程,网页文件将被传送到用户的家用电脑,然后通过浏览器解释网页的内容。然后展示给用户。

右键单击网页,在菜单中选择“查看源文件”,通过记事本查看网页的实际内容。您可以看到网页实际上只是一个纯文本文件。它通过各种标签(如字体、颜色、大小)描述页面上的文字、图片、表格、声音等元素,浏览器解释这些标签并生成页面,所以你得到你现在看到的屏幕. 查看全部

网页flash抓取工具(怎么修改网页标题以织梦后台为例,修改标题的方法)

如何修改页面标题

以织梦的背景为例,修改页面标题的方法是:

1、登录网站后台。

2、从织梦 后端,单击模板并选择默认模板管理。

3、在“默认模板管理”中选择“index.htm”首页模板后面的修改,点击进入。

4、在head标签中找到title标签,“title”和“/title”之间的内容就是网站的标题,把这里的内容改成准备改的内容,然后保存并生成就是这样。

如何用DW修改页面标题

用DW修改页面标题的方法是:

1、如果你使用DW,只需在代码中找到“标题”,并将所需的标题放在中间即可。

2、或者你可以在代码行的“标题”中输入,拆分,设计。

数据仓库(DataWareHouse),简称DW,是一个为企业各级决策过程提供各类数据支持的战略集合。它是一个中央信息库,用于分析报告和决策支持目的。数据仓库为需要商业智能的企业提供指导,包括改进业务流程、监控时间、成本、质量等。

如何更改页面上的日期

以下是如何修改网页上的日期:

1、一个是网站提供接口修改;

2、另外一个就是能登录到这个服务器,改时间;

3、另一个选择是拥有网站的源代码并且能够登录到服务器。

网页是用于万维网和 Web 浏览器的文件,位于世界某个角落连接到 Internet 的计算机或计算机组上。它是构成 网站 的基本元素,也是承载各种 网站 应用程序的平台。通过网址 (URL) 识别和访问网页。当在网络浏览器中输入网址后,经过一个复杂而快速的过程,网页文件将被传送到用户的家用电脑,然后通过浏览器解释网页的内容。然后展示给用户。

右键单击网页,在菜单中选择“查看源文件”,通过记事本查看网页的实际内容。您可以看到网页实际上只是一个纯文本文件。它通过各种标签(如字体、颜色、大小)描述页面上的文字、图片、表格、声音等元素,浏览器解释这些标签并生成页面,所以你得到你现在看到的屏幕.

网页flash抓取工具(网页flash抓取工具iambrocks和javascript工具的对比(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-04-07 08:04

网页flash抓取工具iambrocks和javascript抓取工具的对比iambrocks和javascript抓取工具的对比

用过webrtc,flash,iambrocks,flash之间确实有差异。如果要抓取js,那么直接用flash.js抓出js效率更高。以前还用过一个可视化抓包工具,一看就是做嵌入的,我觉得比较不理想,没有直接抓取js干脆。

xxxxx.js

可以看下花生壳的插件吧,

js场景下没有太大差异,只要有js加载库就行.其实不建议太过依赖js文件本身,有些场景下必须用js,但这种场景极少.

功能差不多,javascript抓包比较多,iambrocks抓取js效率更高。

javascript的执行规则没有iembrocks这个软件优秀,

速度上javascript目前抓取的效率比iembrocks要高,

谢邀其实不同场景有不同需求,flash+evaluator模式有时不太可行,直接iambrocks也行的说。

感觉xml和json两种需求都要抓才行吧,只抓iis的话还有iisheader的问题,抓到iisheader会更麻烦点,

@邹越更新的答案是错的。在抓取不可见请求的情况下(如如cookie里内容),iembrocks抓取的速度比xml和json都快不少啊。 查看全部

网页flash抓取工具(网页flash抓取工具iambrocks和javascript工具的对比(图))

网页flash抓取工具iambrocks和javascript抓取工具的对比iambrocks和javascript抓取工具的对比

用过webrtc,flash,iambrocks,flash之间确实有差异。如果要抓取js,那么直接用flash.js抓出js效率更高。以前还用过一个可视化抓包工具,一看就是做嵌入的,我觉得比较不理想,没有直接抓取js干脆。

xxxxx.js

可以看下花生壳的插件吧,

js场景下没有太大差异,只要有js加载库就行.其实不建议太过依赖js文件本身,有些场景下必须用js,但这种场景极少.

功能差不多,javascript抓包比较多,iambrocks抓取js效率更高。

javascript的执行规则没有iembrocks这个软件优秀,

速度上javascript目前抓取的效率比iembrocks要高,

谢邀其实不同场景有不同需求,flash+evaluator模式有时不太可行,直接iambrocks也行的说。

感觉xml和json两种需求都要抓才行吧,只抓iis的话还有iisheader的问题,抓到iisheader会更麻烦点,

@邹越更新的答案是错的。在抓取不可见请求的情况下(如如cookie里内容),iembrocks抓取的速度比xml和json都快不少啊。

网页flash抓取工具(我正在制作一个我将在我的RaspberryPiB上托管的网络刮刀,)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-04-05 21:04

Home>博客文章如何在 Python 中插入 cookie 进行网页抓取?

与py2021-11-13

简介 我正在制作一个网络抓取工具,我将在我的 Raspberry Pi B 上托管,但是我需要抓取的 网站 需要一个 cookie 才能访问它。具体的 cookie 是 .ROBLSECURITY。我正在使用此 cookie 之前已登录(借助 Google Chrome 的 EditThisCookie 扩展程序)。如何让我的 Python 程序使用此 cookie 登录?这是我的 .ROBLOSECURITY cookie(尽管更改了几个字母) />

这是我的 .ROBLOSecurity cookie(尽管更改了一些字母/数字):

26D59EEB62BB82BA679D88E391F5E43448FDC5EEE74BEBBFD9879204EABA2813E4C00248E65D7ADBFE0B91F1B140E4DD61CBA1F0EE5991E5099BE044AD9AF0C019EFAFDCF6A41355002355A602F9B8ADEF4CD14E70825687F9748B082089DE69C833E4F5AE9B358F1988B3D3BB04CA5D0BF96501E8B4AAACD68BBE3ACCAED5DA646BB4E7B3D8CC88D102DD53382C8FE8696C54445EB3716AF08DF9816E14EAC0DA451C04803BAB801BF61A20FD9BF6E3FE9BF06833D68C08BB1DF4FDD3ED969687F42BAA5D57C66246549F4323F3FAE71D7E38574690F6AB41D56C224C949018C5C24901EB7D8A4B6D262A173B60B16B413F347B21AC8901F86D818B039A88344A324670D726176F42485ADE295EE22ADEDA733452735B043B7A4FF8262D42DF60D63329C77E8AF9EF65AD25B01CEAD48FCBF59D8CB70AE32BDE1651FB372656C600DBCBF53F0D49FB89275830B0A5513EC201C808699428C0F09BF8FE64A227D9A94B43943E2F81E252B45297D38AF6D8E8FDA180DCB491AA33FA7EE87BB1D1E005050573294010E9169AB9AF716F69483128B93F87878C24380A57F64A8EF4BC9242A6125413548F88D15F6E6779A9B996BCADFEA7EABFEE3ED17EFEC148C33630CBCDCD9E1DDCB4B1C5DD42EF93C696C20D01A1E9D95AD40145ACE57C4664ACDF79EF78482DE6E40E7D3727C501A089993402F386A2D5997CDE530DBF93CDAD90E15F207D3B9DE168C3B669E1099B304192CD33D327150A57B9383BDBC99215448F21

这是有关 cookie 的更多信息的屏幕截图。

解决方案

import urllib2

handler = urllib2.HTTPHandler(debuglevel = 1)

req = urllib2.Request('http://www.example.com/')

req.add_header('Cookie',(".ROBLOSecurity=26D59EEB62BB82BA679D88E391F5E43448FDC5EEE74BEBBFD9879204EABA2813E4C00248E65D7ADBFE0B91F1B"

"140E4DD61CBA1F0EE5991E5099BE044AD9AF0C019EFAFDCF6A41355002355A602F9B8ADEF4CD14E70825687F9748B082089DE69C833E4F5AE9B358F1988B3D3BB04CA5D0B"

"F96501E8B4AAACD68BBE3ACCAED5DA646BB4E7B3D8CC88D102DD53382C8FE8696C54445EB3716AF08DF9816E14EAC0DA451C04803BAB801BF61A20FD9BF6E3FE9BF06833D"

"68C08BB1DF4FDD3ED969687F42BAA5D57C66246549F4323F3FAE71D7E38574690F6AB41D56C224C949018C5C24901EB7D8A4B6D262A173B60B16B413F347B21AC8901F86D"

"818B039A88344A324670D726176F42485ADE295EE22ADEDA733452735B043B7A4FF8262D42DF60D63329C77E8AF9EF65AD25B01CEAD48FCBF59D8CB70AE32BDE1651FB372"

"656C600DBCBF53F0D49FB89275830B0A5513EC201C808699428C0F09BF8FE64A227D9A94B43943E2F81E252B45297D38AF6D8E8FDA180DCB491AA33FA7EE87BB1D1E00505"

"0573294010E9169AB9AF716F69483128B93F87878C24380A57F64A8EF4BC9242A6125413548F88D15F6E6779A9B996BCADFEA7EABFEE3ED17EFEC148C33630CBCDCD9E1DD"

"CB4B1C5DD42EF93C696C20D01A1E9D95AD40145ACE57C4664ACDF79EF78482DE6E40E7D3727C501A089993402F386A2D5997CDE530DBF93CDAD90E15F207D3B9DE168C3B6"

"69E1099B304192CD33D327150A57B9383BDBC99215448F21"))

opener = urllib2.build_opener(handler)

urllib2.install_opener(opener)

resp = urllib2.urlopen(req)

print resp.read()

总结

以上内容由本站为您采集。如何在 Python 中插入 cookie 以进行网页抓取?总而言之,希望 文章 可以帮助您弄清楚如何在 Python 中插入 cookie 以进行网络抓取?程序开发遇到的问题。

如果您觉得本站网站的内容不错,欢迎您将本站网站推荐给您的程序员朋友。

Previous:python - 强制 pyplot.imshow() 生成更高分辨率的图像 查看全部

网页flash抓取工具(我正在制作一个我将在我的RaspberryPiB上托管的网络刮刀,)

Home>博客文章如何在 Python 中插入 cookie 进行网页抓取?

与py2021-11-13

简介 我正在制作一个网络抓取工具,我将在我的 Raspberry Pi B 上托管,但是我需要抓取的 网站 需要一个 cookie 才能访问它。具体的 cookie 是 .ROBLSECURITY。我正在使用此 cookie 之前已登录(借助 Google Chrome 的 EditThisCookie 扩展程序)。如何让我的 Python 程序使用此 cookie 登录?这是我的 .ROBLOSECURITY cookie(尽管更改了几个字母) />

这是我的 .ROBLOSecurity cookie(尽管更改了一些字母/数字):

26D59EEB62BB82BA679D88E391F5E43448FDC5EEE74BEBBFD9879204EABA2813E4C00248E65D7ADBFE0B91F1B140E4DD61CBA1F0EE5991E5099BE044AD9AF0C019EFAFDCF6A41355002355A602F9B8ADEF4CD14E70825687F9748B082089DE69C833E4F5AE9B358F1988B3D3BB04CA5D0BF96501E8B4AAACD68BBE3ACCAED5DA646BB4E7B3D8CC88D102DD53382C8FE8696C54445EB3716AF08DF9816E14EAC0DA451C04803BAB801BF61A20FD9BF6E3FE9BF06833D68C08BB1DF4FDD3ED969687F42BAA5D57C66246549F4323F3FAE71D7E38574690F6AB41D56C224C949018C5C24901EB7D8A4B6D262A173B60B16B413F347B21AC8901F86D818B039A88344A324670D726176F42485ADE295EE22ADEDA733452735B043B7A4FF8262D42DF60D63329C77E8AF9EF65AD25B01CEAD48FCBF59D8CB70AE32BDE1651FB372656C600DBCBF53F0D49FB89275830B0A5513EC201C808699428C0F09BF8FE64A227D9A94B43943E2F81E252B45297D38AF6D8E8FDA180DCB491AA33FA7EE87BB1D1E005050573294010E9169AB9AF716F69483128B93F87878C24380A57F64A8EF4BC9242A6125413548F88D15F6E6779A9B996BCADFEA7EABFEE3ED17EFEC148C33630CBCDCD9E1DDCB4B1C5DD42EF93C696C20D01A1E9D95AD40145ACE57C4664ACDF79EF78482DE6E40E7D3727C501A089993402F386A2D5997CDE530DBF93CDAD90E15F207D3B9DE168C3B669E1099B304192CD33D327150A57B9383BDBC99215448F21

这是有关 cookie 的更多信息的屏幕截图。

解决方案

import urllib2

handler = urllib2.HTTPHandler(debuglevel = 1)

req = urllib2.Request('http://www.example.com/')

req.add_header('Cookie',(".ROBLOSecurity=26D59EEB62BB82BA679D88E391F5E43448FDC5EEE74BEBBFD9879204EABA2813E4C00248E65D7ADBFE0B91F1B"

"140E4DD61CBA1F0EE5991E5099BE044AD9AF0C019EFAFDCF6A41355002355A602F9B8ADEF4CD14E70825687F9748B082089DE69C833E4F5AE9B358F1988B3D3BB04CA5D0B"

"F96501E8B4AAACD68BBE3ACCAED5DA646BB4E7B3D8CC88D102DD53382C8FE8696C54445EB3716AF08DF9816E14EAC0DA451C04803BAB801BF61A20FD9BF6E3FE9BF06833D"

"68C08BB1DF4FDD3ED969687F42BAA5D57C66246549F4323F3FAE71D7E38574690F6AB41D56C224C949018C5C24901EB7D8A4B6D262A173B60B16B413F347B21AC8901F86D"

"818B039A88344A324670D726176F42485ADE295EE22ADEDA733452735B043B7A4FF8262D42DF60D63329C77E8AF9EF65AD25B01CEAD48FCBF59D8CB70AE32BDE1651FB372"

"656C600DBCBF53F0D49FB89275830B0A5513EC201C808699428C0F09BF8FE64A227D9A94B43943E2F81E252B45297D38AF6D8E8FDA180DCB491AA33FA7EE87BB1D1E00505"

"0573294010E9169AB9AF716F69483128B93F87878C24380A57F64A8EF4BC9242A6125413548F88D15F6E6779A9B996BCADFEA7EABFEE3ED17EFEC148C33630CBCDCD9E1DD"

"CB4B1C5DD42EF93C696C20D01A1E9D95AD40145ACE57C4664ACDF79EF78482DE6E40E7D3727C501A089993402F386A2D5997CDE530DBF93CDAD90E15F207D3B9DE168C3B6"

"69E1099B304192CD33D327150A57B9383BDBC99215448F21"))

opener = urllib2.build_opener(handler)

urllib2.install_opener(opener)

resp = urllib2.urlopen(req)

print resp.read()

总结

以上内容由本站为您采集。如何在 Python 中插入 cookie 以进行网页抓取?总而言之,希望 文章 可以帮助您弄清楚如何在 Python 中插入 cookie 以进行网络抓取?程序开发遇到的问题。

如果您觉得本站网站的内容不错,欢迎您将本站网站推荐给您的程序员朋友。

Previous:python - 强制 pyplot.imshow() 生成更高分辨率的图像

网页flash抓取工具(网页flash抓取工具免费体验不卡顿的视频(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-04-05 20:04

网页flash抓取工具免费体验不卡顿的视频抓取工具视频抓取工具在线工具视频抓取工具清新简洁代码抓取工具新闻网页抓取工具交换抓取工具爱互动视频工具酷我视频抓取工具在线音乐抓取工具在线音乐抓取工具免费视频抓取工具在线视频编辑抓取工具在线视频识别抓取工具在线文本处理抓取工具在线语音转换抓取工具在线音频转换抓取工具在线文件转换抓取工具usbarmiost抓取工具在线usbarmiost抓取工具otp转换器电驴抓取工具。

多少人是因为一样的需求才来知乎答题的,关注这个问题挺久,出现机会很多,邀请的也很多。各位过过瘾,换换空闲的精力和耐心吧。我就是想纠正一个常见错误的截图方式:例如知乎wiki页面上全部是英文,截图的时候要留意一下,换成中文,并且做一些修改。一定要多做少说。更多的请留意之前的答案:什么是知乎签名档?应该如何填写?wiki链接:://video。

推荐个软件:everything查找各类网页资源必备!百度云资源查找必备!还是百度网盘的电影资源查找必备!

来个万能的,万彩谷歌浏览器,文件夹快速查看,

hao123

v2ex(虽然大多是广告)

weiku论坛

花园书店电子书有很多,都有中文版。还可以支持godaddy,个人感觉用着方便一些。 查看全部

网页flash抓取工具(网页flash抓取工具免费体验不卡顿的视频(组图))

网页flash抓取工具免费体验不卡顿的视频抓取工具视频抓取工具在线工具视频抓取工具清新简洁代码抓取工具新闻网页抓取工具交换抓取工具爱互动视频工具酷我视频抓取工具在线音乐抓取工具在线音乐抓取工具免费视频抓取工具在线视频编辑抓取工具在线视频识别抓取工具在线文本处理抓取工具在线语音转换抓取工具在线音频转换抓取工具在线文件转换抓取工具usbarmiost抓取工具在线usbarmiost抓取工具otp转换器电驴抓取工具。

多少人是因为一样的需求才来知乎答题的,关注这个问题挺久,出现机会很多,邀请的也很多。各位过过瘾,换换空闲的精力和耐心吧。我就是想纠正一个常见错误的截图方式:例如知乎wiki页面上全部是英文,截图的时候要留意一下,换成中文,并且做一些修改。一定要多做少说。更多的请留意之前的答案:什么是知乎签名档?应该如何填写?wiki链接:://video。

推荐个软件:everything查找各类网页资源必备!百度云资源查找必备!还是百度网盘的电影资源查找必备!

来个万能的,万彩谷歌浏览器,文件夹快速查看,

hao123

v2ex(虽然大多是广告)

weiku论坛

花园书店电子书有很多,都有中文版。还可以支持godaddy,个人感觉用着方便一些。

网页flash抓取工具(尚品:Flash动画是一个真正的噩梦)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-04-03 17:18

尚品中国:如果有真正的热点项目,分为SEO网站优化专家和网页设计师,那就是Flash。无疑是一项巨大的技术,在网站 上,包括声音和图片,Flash 动画对于 SEO 专家来说是一场真正的噩梦。原因很简单——搜索引擎无法索引(或至少不容易)flash 文件中的内容,除非您在 flash 电影中提供文本,否则您可以简单地计算此文本丢失并提高您的排名。当然,有一些变通方法,但是在搜索引擎开始索引 Flash 电影之前,如果它们是纯文本,这些变通方法只是优化 Flash网站 作品的笨拙方法,但它们绝对聊胜于无。

为什么搜索引擎不喜欢 Flash网站?

搜索引擎不喜欢flash,不是因为它们的艺术品质(或者缺乏它们),而是北京制作的网站 Flash电影网站是因为蜘蛛太复杂而无法理解。蜘蛛无法直接索引 Flash 电影,因为它们制作的是纯文本页面。蜘蛛索引文件名(你可以在网上找到大量的),而不是里面的内容。

Flash 电影采用专有的二进制格式 (SWF),蜘蛛无法读取内部的 Flash 文件,至少在没有帮助的情况下是这样。即使有帮助,也不要指望蜘蛛会抓取 Flash 内容并将其编入索引。这适用于所有搜索引擎。搜索引擎衡量页面相关性的方式可能有所不同,但对于 Flash 方法,至少在人们看来,搜索引擎真的很团结——他们讨厌它,但它是索引部分。

(不)使用Flash?

尽管 Flash 动画不是蜘蛛的最爱,但在某些情况下 Flash 电影值得 SEO 努力。但作为一般规则,将 Flash 电影保持在最低限度。在这种情况下,更好的搜索引擎绝对不是唯一的原因。首先,Flash 电影,尤其是横幅和其他类型的广告,会分散用户的注意力,他们通常倾向于跳过它们。其次,Flash 动画很胖。它们消耗大量带宽,尽管对于大多数用户而言都是拨号日,但 1Mbit 或更高的连接还不是标准的。

基本上,设计师应该保留 Flash 是为了强化故事而不是告诉它的声明——即你有一些文本作为故事的要点(以及你优化的关键字),然后你有 Flash 电影来添加更多细节,只是故事的视觉表现。在这方面,最大的 SEO 罪过是让整个 网站 在 Flash 中!这简直是不可饶恕,连上位的梦想都算不上!

另一个是“不”使用导航闪光灯。这不仅适用于开始页面,那里曾经有时尚的飞溅和华丽的 Flash 电影,还适用于外部链接。虽然这是使用导航图像和/或 JavaScript 的一个相对常见的错误,但 Flash 横幅和电影不能用于导致用户从一个页面移动到另一个页面。文本链接是唯一获得 SEO 认可的构建网站导航的方式。

优化 Flash 的解决方法网站

虽然变通办法不是解决方案,但 Flash网站 仍然可以优化。有几种方法:

输入元数据,

这是一个非常重要的方法,尽管它经常被低估和误解。虽然元数据对搜索引擎来说不像以前那么重要,但 Flash 开发工具允许轻松地将元数据添加到您的电影中,因此没有理由将元数据字段留空。

供应

一个很好的 网站 替代网页,这是一个必须提供的 HTML 页面,它不会强迫用户观看 Flash 电影。准备这些页面需要更多的工作,但回报是值得的,因为不仅用户,搜索引擎也会看到 HTML 页面。

Flash 搜索引擎 SDK,

这是企业的生命线。从 Flash 电影中提取文本的最先进工具。Flash 搜索引擎 SDK 中最方便的应用程序之一是名为 swf2html 的工具。顾名思义,该工具从 Macromedia Flash 文件中提取文本和链接,并将您的输出写入标准 HTML 文档,从而节省您手动执行的繁琐工作。

但是,您仍然需要查看提取的内容并在必要时进行更正。例如,文本和链接的排列顺序可能需要稍作调整,以便将标题和标题或关键字丰富的内容放在页面的开头。

此外,您需要检查提取的句子和段落之间是否没有重复的内容。提取文本的字体颜色也是另一个问题。如果提取文本的字体颜色与背景颜色相同,则会遇到隐藏文本区域。

这是一个工具,可以从您的 Flash 文件中直观地显示搜索引擎以及不可见的内容。即使您安装了 Flash 搜索引擎 SDK,此工具也非常有用,因为它提供了对提取文本准确性的更多检查。此外,不确定 Google 和其他搜索引擎是否使用 Flash Search Engine SDK 从 Flash 文件中获取内容,因此该工具可能会产生与这些 SDK 完全不同的结果。

这些方法只是如何优化 Flash网站 的一些最重要的示例。还有很多其他方法。但是,并非所有内容都非常出色和清晰,或者它们可能会落入道德 SEO 的界限 - 例如,创建传递给蜘蛛而不是 Flash 电影本身的不可见文本层。虽然这种技术没有任何问题 - 即没有重复或虚假内容,但它与伪装和入口页面非常相似,最好避免使用它。 查看全部

网页flash抓取工具(尚品:Flash动画是一个真正的噩梦)

尚品中国:如果有真正的热点项目,分为SEO网站优化专家和网页设计师,那就是Flash。无疑是一项巨大的技术,在网站 上,包括声音和图片,Flash 动画对于 SEO 专家来说是一场真正的噩梦。原因很简单——搜索引擎无法索引(或至少不容易)flash 文件中的内容,除非您在 flash 电影中提供文本,否则您可以简单地计算此文本丢失并提高您的排名。当然,有一些变通方法,但是在搜索引擎开始索引 Flash 电影之前,如果它们是纯文本,这些变通方法只是优化 Flash网站 作品的笨拙方法,但它们绝对聊胜于无。

为什么搜索引擎不喜欢 Flash网站?

搜索引擎不喜欢flash,不是因为它们的艺术品质(或者缺乏它们),而是北京制作的网站 Flash电影网站是因为蜘蛛太复杂而无法理解。蜘蛛无法直接索引 Flash 电影,因为它们制作的是纯文本页面。蜘蛛索引文件名(你可以在网上找到大量的),而不是里面的内容。

Flash 电影采用专有的二进制格式 (SWF),蜘蛛无法读取内部的 Flash 文件,至少在没有帮助的情况下是这样。即使有帮助,也不要指望蜘蛛会抓取 Flash 内容并将其编入索引。这适用于所有搜索引擎。搜索引擎衡量页面相关性的方式可能有所不同,但对于 Flash 方法,至少在人们看来,搜索引擎真的很团结——他们讨厌它,但它是索引部分。

(不)使用Flash?

尽管 Flash 动画不是蜘蛛的最爱,但在某些情况下 Flash 电影值得 SEO 努力。但作为一般规则,将 Flash 电影保持在最低限度。在这种情况下,更好的搜索引擎绝对不是唯一的原因。首先,Flash 电影,尤其是横幅和其他类型的广告,会分散用户的注意力,他们通常倾向于跳过它们。其次,Flash 动画很胖。它们消耗大量带宽,尽管对于大多数用户而言都是拨号日,但 1Mbit 或更高的连接还不是标准的。

基本上,设计师应该保留 Flash 是为了强化故事而不是告诉它的声明——即你有一些文本作为故事的要点(以及你优化的关键字),然后你有 Flash 电影来添加更多细节,只是故事的视觉表现。在这方面,最大的 SEO 罪过是让整个 网站 在 Flash 中!这简直是不可饶恕,连上位的梦想都算不上!

另一个是“不”使用导航闪光灯。这不仅适用于开始页面,那里曾经有时尚的飞溅和华丽的 Flash 电影,还适用于外部链接。虽然这是使用导航图像和/或 JavaScript 的一个相对常见的错误,但 Flash 横幅和电影不能用于导致用户从一个页面移动到另一个页面。文本链接是唯一获得 SEO 认可的构建网站导航的方式。

优化 Flash 的解决方法网站

虽然变通办法不是解决方案,但 Flash网站 仍然可以优化。有几种方法:

输入元数据,

这是一个非常重要的方法,尽管它经常被低估和误解。虽然元数据对搜索引擎来说不像以前那么重要,但 Flash 开发工具允许轻松地将元数据添加到您的电影中,因此没有理由将元数据字段留空。

供应

一个很好的 网站 替代网页,这是一个必须提供的 HTML 页面,它不会强迫用户观看 Flash 电影。准备这些页面需要更多的工作,但回报是值得的,因为不仅用户,搜索引擎也会看到 HTML 页面。

Flash 搜索引擎 SDK,

这是企业的生命线。从 Flash 电影中提取文本的最先进工具。Flash 搜索引擎 SDK 中最方便的应用程序之一是名为 swf2html 的工具。顾名思义,该工具从 Macromedia Flash 文件中提取文本和链接,并将您的输出写入标准 HTML 文档,从而节省您手动执行的繁琐工作。

但是,您仍然需要查看提取的内容并在必要时进行更正。例如,文本和链接的排列顺序可能需要稍作调整,以便将标题和标题或关键字丰富的内容放在页面的开头。

此外,您需要检查提取的句子和段落之间是否没有重复的内容。提取文本的字体颜色也是另一个问题。如果提取文本的字体颜色与背景颜色相同,则会遇到隐藏文本区域。

这是一个工具,可以从您的 Flash 文件中直观地显示搜索引擎以及不可见的内容。即使您安装了 Flash 搜索引擎 SDK,此工具也非常有用,因为它提供了对提取文本准确性的更多检查。此外,不确定 Google 和其他搜索引擎是否使用 Flash Search Engine SDK 从 Flash 文件中获取内容,因此该工具可能会产生与这些 SDK 完全不同的结果。

这些方法只是如何优化 Flash网站 的一些最重要的示例。还有很多其他方法。但是,并非所有内容都非常出色和清晰,或者它们可能会落入道德 SEO 的界限 - 例如,创建传递给蜘蛛而不是 Flash 电影本身的不可见文本层。虽然这种技术没有任何问题 - 即没有重复或虚假内容,但它与伪装和入口页面非常相似,最好避免使用它。

网页flash抓取工具(多媒体制作工具排行榜h5页面制作平台—在线flash抓取工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-03-24 13:03

网页flash抓取工具——flashpipeline—在线flash抓取工具,自动抓取网页内容!myvascript代码高亮工具——microsoftedge—安装myvascript文件解压工具——解压codecs文件夹—代码高亮显示!taglist——关键词匹配搜索工具——即刻畅览全网内容!实在太多了!自己试试吧!。

欢迎看我写的这篇文章,

可以去【文档版】网站下载。

h5页面生成器,创意动效制作工具,吸引眼球的h5页面制作器有没有,应该很多人都不了解,小编有推荐,人家才会了解h5页面制作工具。

【来来】多媒体制作工具排行榜

h5页面制作平台真是太多了,什么都能做的,看你想要怎么制作吧。本人近期接触到一款专业的h5页面制作平台,不过才5分钟的样子,设计我就想吐了。

1,推荐找一款支持webgl的模板制作工具(比如用火星时代的h5页面制作平台,上次在文章末尾“代码”部分有我专门为网页制作准备的工具链接,希望能帮到您);2,可以了解下页面秀、websocket、diy、设计pk、短h5、动效秀、用友的鱼、ih5、易企秀、兔展等平台,根据自己对页面的喜好或是对产品的认识再做选择;3,h5页面制作平台最好选择大平台,首先进入平台注册,然后在页面制作过程中提高自己的水平,提高上传页面的质量以及保证质量。 查看全部

网页flash抓取工具(多媒体制作工具排行榜h5页面制作平台—在线flash抓取工具)

网页flash抓取工具——flashpipeline—在线flash抓取工具,自动抓取网页内容!myvascript代码高亮工具——microsoftedge—安装myvascript文件解压工具——解压codecs文件夹—代码高亮显示!taglist——关键词匹配搜索工具——即刻畅览全网内容!实在太多了!自己试试吧!。

欢迎看我写的这篇文章,

可以去【文档版】网站下载。

h5页面生成器,创意动效制作工具,吸引眼球的h5页面制作器有没有,应该很多人都不了解,小编有推荐,人家才会了解h5页面制作工具。

【来来】多媒体制作工具排行榜

h5页面制作平台真是太多了,什么都能做的,看你想要怎么制作吧。本人近期接触到一款专业的h5页面制作平台,不过才5分钟的样子,设计我就想吐了。

1,推荐找一款支持webgl的模板制作工具(比如用火星时代的h5页面制作平台,上次在文章末尾“代码”部分有我专门为网页制作准备的工具链接,希望能帮到您);2,可以了解下页面秀、websocket、diy、设计pk、短h5、动效秀、用友的鱼、ih5、易企秀、兔展等平台,根据自己对页面的喜好或是对产品的认识再做选择;3,h5页面制作平台最好选择大平台,首先进入平台注册,然后在页面制作过程中提高自己的水平,提高上传页面的质量以及保证质量。

网页flash抓取工具(网页flash抓取工具:佳乐jiahuiyi网页代码修改器调试教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-03-23 00:04

网页flash抓取工具:佳乐jiahuiyi网页调试教程:佳乐jiahuiyi网页代码修改器是用来在网页上修改html源码的chromeflash抓取工具:佳乐jiahuiyimac版本macadobeflasheditor软件radioflash抓取工具:flash迅捷抓取工具flash迅捷抓取工具可将mp3、aac和wav格式的文件重定向到任何需要的页面。

flash迅捷抓取工具是flash最便捷的抓取工具。mac传说中的破解版是否可以免费使用wepy框架与markdown2语法结合,实现html页面动态编译。

flashcontentrequest,直接从html变成html5动态文件的动作,很多实用api。taggedflashtaggingmanager,convertmanuallytoconfigurableflashswftaggingandrenderingviataggedhtmlbody.orflashrequest,直接从静态文件变成flashtag的动作,如参考@高棉上古之邪。

parametricsubpageandsubboxforflashreal-timeanimation。

手动修改flashtag:aftereffectshtmlanimationandrendering的功能可以实现。在aftereffects中可以通过调整导出的swf文件的代码,实现对flash视频等格式文件的转换。好了以上都不是重点。重点是mac端的flashrender动画播放器支持manuallyrender一项功能,其逻辑步骤如下:1.在html文件中编写flash脚本逻辑,并在服务器端制作flash输出;2.启动mac端flashrender动画播放器,并显示文件3.将输出文件输出到本地,再将文件接入服务器端进行操作。 查看全部

网页flash抓取工具(网页flash抓取工具:佳乐jiahuiyi网页代码修改器调试教程)

网页flash抓取工具:佳乐jiahuiyi网页调试教程:佳乐jiahuiyi网页代码修改器是用来在网页上修改html源码的chromeflash抓取工具:佳乐jiahuiyimac版本macadobeflasheditor软件radioflash抓取工具:flash迅捷抓取工具flash迅捷抓取工具可将mp3、aac和wav格式的文件重定向到任何需要的页面。

flash迅捷抓取工具是flash最便捷的抓取工具。mac传说中的破解版是否可以免费使用wepy框架与markdown2语法结合,实现html页面动态编译。

flashcontentrequest,直接从html变成html5动态文件的动作,很多实用api。taggedflashtaggingmanager,convertmanuallytoconfigurableflashswftaggingandrenderingviataggedhtmlbody.orflashrequest,直接从静态文件变成flashtag的动作,如参考@高棉上古之邪。

parametricsubpageandsubboxforflashreal-timeanimation。

手动修改flashtag:aftereffectshtmlanimationandrendering的功能可以实现。在aftereffects中可以通过调整导出的swf文件的代码,实现对flash视频等格式文件的转换。好了以上都不是重点。重点是mac端的flashrender动画播放器支持manuallyrender一项功能,其逻辑步骤如下:1.在html文件中编写flash脚本逻辑,并在服务器端制作flash输出;2.启动mac端flashrender动画播放器,并显示文件3.将输出文件输出到本地,再将文件接入服务器端进行操作。

网页flash抓取工具(本文就用Java给大家演示怎样抓取站点的数据:(1))

网站优化 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2022-03-21 10:20

原文链接:

有时出于各种原因,我们需要从某个站点采集数据,但是因为不同站点显示数据的方式略有不同!

本文使用Java为大家展示如何抓取网站的数据:(1)抓取原创网页数据;(2)抓取网页Javascript返回的数据。

一、获取原创网页。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页,然后输入IP:111.142.55.73,点击查询按钮,可以看到网页上显示的结果:

第二步:查看网页的源码,我们看到源码中有这么一段:

由此可以看出,再次请求网页后,才显示查询结果。

看看查询后的网页地址:

也就是说,我们只有通过访问这样的URL才能得到ip查询的结果。接下来看代码:

1public void captureHtml(String ip) throws Exception {

2 String strURL = "http://ip.chinaz.com/?IP=" + ip;

3 URL url = new URL(strURL);

4 HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();

5 InputStreamReader input = new InputStreamReader(httpConn

6 .getInputStream(), "utf-8");

7 BufferedReader bufReader = new BufferedReader(input);

8 String line = "";

9 StringBuilder contentBuf = new StringBuilder();

10 while ((line = bufReader.readLine()) != null) {

11 contentBuf.append(line);

12 }

13 String buf = contentBuf.toString();

14 int beginIx = buf.indexOf("查询结果[");

15 int endIx = buf.indexOf("上面四项依次显示的是");

16 String result = buf.substring(beginIx, endIx);

17 System.out.println("captureHtml()的结果:\n" + result);

18}

19

使用HttpURLConnection连接网站,使用bufReader保存网页返回的数据,然后通过自定义解析方式显示结果。

这里我只是随便解析了一下。如果解析非常准确,需要我自己处理。

解析结果如下:

captureHtml() 的结果:

查询结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建漳州移动

二、在网页上获取 JavaScript 返回的结果。

有时网站为了保护自己的数据,不会直接在网页源码中返回数据,而是使用JS异步返回数据,这样可以避免工具对网站数据的抓取比如搜索引擎。

先看看这个页面:

第一种方式查看网页源代码,但是没有找到运单的跟踪信息,因为它是通过JS的方式获取结果的。

但是有时候我们非常需要获取JS数据,这个时候我们应该怎么做呢?

这时候我们就需要用到一个工具:HTTP Analyzer,这个工具可以截取Http的交互内容,我们利用这个工具来达到我们的目的。

先点击开始按钮后,开始监听网页的交互行为。

我们打开网页:,可以看到HTTP Analyzer列出了网页的所有请求数据和结果:

为了更方便的查看JS的结果,我们先清除数据,然后在网页中输入快递号:7,点击查询按钮,然后查看HTTP Analyzer的结果:

这是点击查询按钮后HTTP Analyzer的结果,我们继续查看:

从上面两张图可以看出,HTTP Analyzer可以截取JS返回的数据并显示在Response Content中,同时可以看到JS请求的网页地址。

这种情况下,我们只需要分析HTTP Analyzer的结果,然后模拟JS的行为来获取数据,也就是我们只需要访问JS请求的网页地址就可以获取数据,当然前提是就是数据没有加密,我们记下JS请求的URL:

然后让程序请求这个网页的结果!

这是代码:

1public void captureJavascript(String postid) throws Exception {

2 String strURL = "http://www.kiees.cn/sf.php?wen=" + postid

3 + "&channel=&rnd=0";

4 URL url = new URL(strURL);

5 HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();

6 InputStreamReader input = new InputStreamReader(httpConn

7 .getInputStream(), "utf-8");

8 BufferedReader bufReader = new BufferedReader(input);

9 String line = "";

10 StringBuilder contentBuf = new StringBuilder();

11 while ((line = bufReader.readLine()) != null) {

12 contentBuf.append(line);

13 }

14 System.out.println("captureJavascript()的结果:\n" + contentBuf.toString());

15}

16

可以看到,爬取JS的方法和之前爬取原创网页的代码完全一样,只是做了一个解析JS的过程。

下面是运行程序的结果:

captureJavascript() 的结果:

运单跟踪信息 [7]

这些数据就是JS返回的结果,达到了我们的目的!

希望这篇文章可以对需要的朋友有所帮助。如需程序源代码,请点击这里下载! 查看全部

网页flash抓取工具(本文就用Java给大家演示怎样抓取站点的数据:(1))

原文链接:

有时出于各种原因,我们需要从某个站点采集数据,但是因为不同站点显示数据的方式略有不同!

本文使用Java为大家展示如何抓取网站的数据:(1)抓取原创网页数据;(2)抓取网页Javascript返回的数据。

一、获取原创网页。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页,然后输入IP:111.142.55.73,点击查询按钮,可以看到网页上显示的结果:

第二步:查看网页的源码,我们看到源码中有这么一段:

由此可以看出,再次请求网页后,才显示查询结果。

看看查询后的网页地址:

也就是说,我们只有通过访问这样的URL才能得到ip查询的结果。接下来看代码:

1public void captureHtml(String ip) throws Exception {

2 String strURL = "http://ip.chinaz.com/?IP=" + ip;

3 URL url = new URL(strURL);

4 HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();

5 InputStreamReader input = new InputStreamReader(httpConn

6 .getInputStream(), "utf-8");

7 BufferedReader bufReader = new BufferedReader(input);

8 String line = "";

9 StringBuilder contentBuf = new StringBuilder();

10 while ((line = bufReader.readLine()) != null) {

11 contentBuf.append(line);

12 }

13 String buf = contentBuf.toString();

14 int beginIx = buf.indexOf("查询结果[");

15 int endIx = buf.indexOf("上面四项依次显示的是");

16 String result = buf.substring(beginIx, endIx);

17 System.out.println("captureHtml()的结果:\n" + result);

18}

19

使用HttpURLConnection连接网站,使用bufReader保存网页返回的数据,然后通过自定义解析方式显示结果。

这里我只是随便解析了一下。如果解析非常准确,需要我自己处理。

解析结果如下:

captureHtml() 的结果:

查询结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建漳州移动

二、在网页上获取 JavaScript 返回的结果。

有时网站为了保护自己的数据,不会直接在网页源码中返回数据,而是使用JS异步返回数据,这样可以避免工具对网站数据的抓取比如搜索引擎。

先看看这个页面:

第一种方式查看网页源代码,但是没有找到运单的跟踪信息,因为它是通过JS的方式获取结果的。

但是有时候我们非常需要获取JS数据,这个时候我们应该怎么做呢?

这时候我们就需要用到一个工具:HTTP Analyzer,这个工具可以截取Http的交互内容,我们利用这个工具来达到我们的目的。

先点击开始按钮后,开始监听网页的交互行为。

我们打开网页:,可以看到HTTP Analyzer列出了网页的所有请求数据和结果:

为了更方便的查看JS的结果,我们先清除数据,然后在网页中输入快递号:7,点击查询按钮,然后查看HTTP Analyzer的结果:

这是点击查询按钮后HTTP Analyzer的结果,我们继续查看:

从上面两张图可以看出,HTTP Analyzer可以截取JS返回的数据并显示在Response Content中,同时可以看到JS请求的网页地址。

这种情况下,我们只需要分析HTTP Analyzer的结果,然后模拟JS的行为来获取数据,也就是我们只需要访问JS请求的网页地址就可以获取数据,当然前提是就是数据没有加密,我们记下JS请求的URL:

然后让程序请求这个网页的结果!

这是代码:

1public void captureJavascript(String postid) throws Exception {

2 String strURL = "http://www.kiees.cn/sf.php?wen=" + postid

3 + "&channel=&rnd=0";

4 URL url = new URL(strURL);

5 HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();

6 InputStreamReader input = new InputStreamReader(httpConn

7 .getInputStream(), "utf-8");

8 BufferedReader bufReader = new BufferedReader(input);

9 String line = "";

10 StringBuilder contentBuf = new StringBuilder();

11 while ((line = bufReader.readLine()) != null) {

12 contentBuf.append(line);

13 }

14 System.out.println("captureJavascript()的结果:\n" + contentBuf.toString());

15}

16

可以看到,爬取JS的方法和之前爬取原创网页的代码完全一样,只是做了一个解析JS的过程。

下面是运行程序的结果:

captureJavascript() 的结果:

运单跟踪信息 [7]

这些数据就是JS返回的结果,达到了我们的目的!

希望这篇文章可以对需要的朋友有所帮助。如需程序源代码,请点击这里下载!

网页flash抓取工具(本文某个站点对数据的显示方式略有不同演示怎样抓取站点的数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-03-21 10:18

原文链接:

有时出于各种原因。我们需要从网站采集数据。但是因为不同的站点显示数据略有不同!

本文将使用Java来给大家展示如何抓取网站的数据:(1)抓取原创网页数据。(2)抓取网页Javascript返回的数据。

一、获取原创网页。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页。然后输入IP:111.142.55.73,点击查询按钮。您可以在网页上看到显示的结果:

第二步:查看网页的源码,我们看到源码中有这么一段:

从这里可以看出。再次请求网页后显示查询结果。

看看查询后的网页地址:

也就是说,我们只想访问表单的一个 URL。可以得到ip查询的结果,再看代码:

1public void captureHtml(String ip) throws Exception {

2 String strURL = "http://ip.chinaz.com/?

3

IP=" + ip; URL url = new URL(strURL); HttpURLConnection httpConn = (HttpURLConnection) url.openConnection(); InputStreamReader input = new InputStreamReader(httpConn .getInputStream(), "utf-8"); BufferedReader bufReader = new BufferedReader(input); String line = ""; StringBuilder contentBuf = new StringBuilder(); while ((line = bufReader.readLine()) != null) { contentBuf.append(line); } String buf = contentBuf.toString( ); int beginIx = buf.indexOf("查询结果["); int endIx = buf.indexOf("以上四项依次显示"); String result = buf.substring(beginIx, endIx); System.out .println("captureHtml()的结果:\n" + result); }

使用 HttpURLConnection 连接到站点。使用bufReader保存网页返回的数据,然后通过自定义的分析方式显示结果。

这里我只是随便解析了一下。如果解析非常准确,需要我自己处理。

解析结果如下:

captureHtml() 的结果:

查询结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建漳州移动

二、在网页上获取 JavaScript 返回的结果。

有时,网站为了保护自己的数据,并不直接在网页源代码中返回数据,而是采用异步的方式。使用JS返回数据,可以避免搜索引擎等工具抓取网站数据。

先看看这个页面:

第一种方式查看网页源代码,但是没有找到运单的跟踪信息,因为它是通过JS的方式获取结果的。

但是有时候我们非常需要获取JS数据,这个时候我们应该怎么做呢?

这时候我们就需要用到一个工具:HTTP Analyzer,这个工具可以截取Http的交互内容,我们利用这个工具来达到我们的目的。

先点击开始按钮后,开始监听网页的交互行为。

我们打开网页:,可以看到HTTP Analyzer列出了网页的所有请求数据和结果:

为了更方便的查看JS的结果,我们先清除数据,然后在网页中输入快递号:7。点击查询按钮,查看 HTTP Analyzer 的结果:

这是点击查询按钮后HTTP Analyzer的结果,我们继续查看:

从上面两张图可以看出。HTTP Analyzer可以截取JS返回的数据并显示在Response Content中,同时可以看到JS请求的网页地址。

既然如此。我们只需要分析HTTP Analyzer的结果,然后模拟JS的行为来获取数据,也就是我们只需要访问JS请求的网页地址就可以获取数据。当然,前提是数据没有加密。我们记下 JS 请求的 URL:

然后让程序请求这个网页的结果!

这是代码:

1public void captureJavascript(String postid) throws Exception {

2 String strURL = "http://www.kiees.cn/sf.php?

3

wen=" + postid + "&channel=&rnd=0"; URL url = new URL(strURL); HttpURLConnection httpConn = (HttpURLConnection) url.openConnection(); InputStreamReader input = new InputStreamReader(httpConn .getInputStream(), "utf- 8"); BufferedReader bufReader = new BufferedReader(input); String line = ""; StringBuilder contentBuf = new StringBuilder(); while ((line = bufReader.readLine()) != null) { contentBuf.append(line); System.out.println("captureJavascript() 的结果:\n" + contentBuf.toString()); }

看见。抓取JS的方式和之前的代码抓取原创网页的方式一模一样。我们只是做了一个分析JS的过程。

下面是运行程序的结果:

captureJavascript() 的结果:

运单跟踪信息 [7]

这些数据就是JS返回的结果,达到了我们的目的!

希望这可以是需要帮助的小朋友,需要程序的源码,点此下载! 查看全部

网页flash抓取工具(本文某个站点对数据的显示方式略有不同演示怎样抓取站点的数据)

原文链接:

有时出于各种原因。我们需要从网站采集数据。但是因为不同的站点显示数据略有不同!

本文将使用Java来给大家展示如何抓取网站的数据:(1)抓取原创网页数据。(2)抓取网页Javascript返回的数据。

一、获取原创网页。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页。然后输入IP:111.142.55.73,点击查询按钮。您可以在网页上看到显示的结果:

第二步:查看网页的源码,我们看到源码中有这么一段:

从这里可以看出。再次请求网页后显示查询结果。

看看查询后的网页地址:

也就是说,我们只想访问表单的一个 URL。可以得到ip查询的结果,再看代码:

1public void captureHtml(String ip) throws Exception {

2 String strURL = "http://ip.chinaz.com/?

3

IP=" + ip; URL url = new URL(strURL); HttpURLConnection httpConn = (HttpURLConnection) url.openConnection(); InputStreamReader input = new InputStreamReader(httpConn .getInputStream(), "utf-8"); BufferedReader bufReader = new BufferedReader(input); String line = ""; StringBuilder contentBuf = new StringBuilder(); while ((line = bufReader.readLine()) != null) { contentBuf.append(line); } String buf = contentBuf.toString( ); int beginIx = buf.indexOf("查询结果["); int endIx = buf.indexOf("以上四项依次显示"); String result = buf.substring(beginIx, endIx); System.out .println("captureHtml()的结果:\n" + result); }

使用 HttpURLConnection 连接到站点。使用bufReader保存网页返回的数据,然后通过自定义的分析方式显示结果。

这里我只是随便解析了一下。如果解析非常准确,需要我自己处理。

解析结果如下:

captureHtml() 的结果:

查询结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建漳州移动

二、在网页上获取 JavaScript 返回的结果。

有时,网站为了保护自己的数据,并不直接在网页源代码中返回数据,而是采用异步的方式。使用JS返回数据,可以避免搜索引擎等工具抓取网站数据。

先看看这个页面:

第一种方式查看网页源代码,但是没有找到运单的跟踪信息,因为它是通过JS的方式获取结果的。

但是有时候我们非常需要获取JS数据,这个时候我们应该怎么做呢?

这时候我们就需要用到一个工具:HTTP Analyzer,这个工具可以截取Http的交互内容,我们利用这个工具来达到我们的目的。

先点击开始按钮后,开始监听网页的交互行为。

我们打开网页:,可以看到HTTP Analyzer列出了网页的所有请求数据和结果:

为了更方便的查看JS的结果,我们先清除数据,然后在网页中输入快递号:7。点击查询按钮,查看 HTTP Analyzer 的结果:

这是点击查询按钮后HTTP Analyzer的结果,我们继续查看:

从上面两张图可以看出。HTTP Analyzer可以截取JS返回的数据并显示在Response Content中,同时可以看到JS请求的网页地址。

既然如此。我们只需要分析HTTP Analyzer的结果,然后模拟JS的行为来获取数据,也就是我们只需要访问JS请求的网页地址就可以获取数据。当然,前提是数据没有加密。我们记下 JS 请求的 URL:

然后让程序请求这个网页的结果!

这是代码:

1public void captureJavascript(String postid) throws Exception {

2 String strURL = "http://www.kiees.cn/sf.php?

3

wen=" + postid + "&channel=&rnd=0"; URL url = new URL(strURL); HttpURLConnection httpConn = (HttpURLConnection) url.openConnection(); InputStreamReader input = new InputStreamReader(httpConn .getInputStream(), "utf- 8"); BufferedReader bufReader = new BufferedReader(input); String line = ""; StringBuilder contentBuf = new StringBuilder(); while ((line = bufReader.readLine()) != null) { contentBuf.append(line); System.out.println("captureJavascript() 的结果:\n" + contentBuf.toString()); }

看见。抓取JS的方式和之前的代码抓取原创网页的方式一模一样。我们只是做了一个分析JS的过程。

下面是运行程序的结果:

captureJavascript() 的结果:

运单跟踪信息 [7]

这些数据就是JS返回的结果,达到了我们的目的!

希望这可以是需要帮助的小朋友,需要程序的源码,点此下载!

汇总:诠网科技|网站不收录成为SEO主要问题,解析搜索引擎不收录的原因

网站优化 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2022-09-24 15:20

一般来说,屏蔽搜索引擎收录 也可能成为 SEO 问题。试图让搜索引擎抓取和索引更多内容是 SEO 经常头痛的问题。没有收录,索引就谈不上排名。尤其对于已经达到一定规模的网站来说,让上海seo的网站足够收录是一个比较麻烦的SEO技巧。 >但是架构设计和优化,收录是不可能的,只能尝试提高收录的速率。

但有时如何屏蔽搜索引擎收录也可能是个问题,网站没有收录这几年越来越成为一个SEO问题。需要屏蔽的情况,如机密信息、复制内容、广告链接等。过去常见的屏蔽收录的方法有密码保护、内容放在表格后面、使用JS/Ajax、使用Flash等.

使用 Flash

Google 几年前开始尝试抓取 Flash 内容,并且已经开始抓取简单的文本内容。也可以跟踪 Flash 中的链接。

表格

Google 蜘蛛还可以填写表单并抓取 POST 请求页面。从日志中已经可以看出这一点。

JS/Ajax

使用 JS 链接一直被认为是一种对 SEO 不太友好的方式来阻止蜘蛛爬行,但两三年前我看到 JS 链接无法阻止 Google 的蜘蛛爬行,不仅 JS 中出现的 URL 会阻止爬取,也可以执行简单的JS来查找更多的URL。

前几天发现很多网站优化的Facebook评论插件被爬取和收录评论,而且插件本身就是一个AJAX。这是个好消息。我的一个实验性电子商务 网站 产品评论功能因此花了很多心思。使用 Facebook 评论插件的好处是巨大的。后面会讲具体的好处。问题是注释是由AJAX实现的,不能被捕获。拿,而产品评论是收录目的之一(生成原创内容)。想了半天也没找到解决办法,就傻傻的把脸书评论插件和评论功能都放在了购物车上。好了,既然脸书评论里的评论可以是收录,就不需要两套评论功能了。

机器人文件

当前确保内容不被阻止的方法收录 是通过 robots 文件。但也有一个缺点。它会减肥。虽然内容不能是收录,但是页面变成了一个只接受链接权重不流出权重的无底洞。

不关注

Nofollow 不保证不会成为 收录。就算你给页面的所有网站链接都加了NF,也不能保证别人更高的网站构造不会得到这个页面的链接,搜索引擎还是可以的找到这个页面。

MetaNoindex+关注

为了防止收录传递权重,可以在页面上使用metanoindex和metafollow,使页面不收录,但可以传递权重。确实,这是一个更好的方法。还有一个问题,还是会浪费蜘蛛爬行的时间。哪位读者有方法可以防止收录,不减肥,不浪费爬爬时间,请留言,对SEO界大有裨益。

总结:搜索引擎优化蜘蛛抓取策略分析,如何实现网站快速收录

从搜索引擎的角度来看,互联网上的页面主要分为四种类型,即爬取页面、待爬取页面、可爬取页面和暗网。

四类网页的讲解,熟悉网站页面分类

顾名思义,被爬取的网页就是蜘蛛已经爬取的内容网站,待爬取的页面就是没有被爬取但已进入等待列表的页面,可以爬取的页面是没有找到但已经存在的页面,而暗网是搜索引擎通过自爬链接找不到的页面,需要手动提交。

通常我们分析的页面爬取主要是非暗网中的页面爬取。暗网爬行中的每个搜索引擎都有自己独特的算法。我们不做太多分析。

搜索引擎的爬取策略主要有两种策略,即广度优先策略和深度优先策略。

广告 2345

×

广度优先策略的解释

大多数网页将有许多链接,而不是它们自己的链接。例如,详情页有相关新闻、相关案例等的链接,当搜索引擎访问一个页面时,会将页面上的所有链接放入数据库中,依次排列。进行遍历爬取,然后将新发现的URL入库等待爬取,按照这个逻辑依次爬取就是广度优先策略。如图:抓取顺序为1-2、3、4-5-11-6-12-3-7-13-8-14。用图片了解自己。

深度优先策略解释

按照页面上的一个链接逐层爬取,直到抓取到最后一个链接,然后返回初始位置以同样的方式爬取其余的链接,这是一种深度优先的策略。

无论是广度优先还是深度优先策略,只要有足够的时间让搜索引擎爬取所有页面,优先考虑搜索引擎的爬取能量,页面爬取的全面性无法做到得到保证。自身资源的限制不得不考虑爬取页面的优先级。还有另外两种爬取策略。

广告流量神器-登录

×

重要网页优先抓取策略

判断一个页面的重要性,搜索引擎主要从自身的质量和权重来判断。另一个重要因素是传入链接的数量。比如首页的传入链接肯定来自很多页面,所以首页的优先级也比较高。

大站点链接优先策略

大站优先显然是一个对大网站有偏好的搜索群体,自身权重比较高,这里的权重不是单纯的PR,而是信任,不是说人家厉害,甚至像高权重的搜索引擎它。很多B2B网站的内容也很大,但是搜索引擎对网页内容的爬取并不是很擅长。相对来说,一些比较好的网站可以有很好的活跃度,所以发消息可以增加活跃度,发到大站首页也能秒收。

总而言之,搜索引擎的资源是有限的。在搜索引擎资源有限的情况下,尽量依靠外链引导蜘蛛,增加网站的权重,也就是网站SEO搜索引擎优化长期运营是重中之重 查看全部

汇总:诠网科技|网站不收录成为SEO主要问题,解析搜索引擎不收录的原因

一般来说,屏蔽搜索引擎收录 也可能成为 SEO 问题。试图让搜索引擎抓取和索引更多内容是 SEO 经常头痛的问题。没有收录,索引就谈不上排名。尤其对于已经达到一定规模的网站来说,让上海seo的网站足够收录是一个比较麻烦的SEO技巧。 >但是架构设计和优化,收录是不可能的,只能尝试提高收录的速率。

但有时如何屏蔽搜索引擎收录也可能是个问题,网站没有收录这几年越来越成为一个SEO问题。需要屏蔽的情况,如机密信息、复制内容、广告链接等。过去常见的屏蔽收录的方法有密码保护、内容放在表格后面、使用JS/Ajax、使用Flash等.

使用 Flash

Google 几年前开始尝试抓取 Flash 内容,并且已经开始抓取简单的文本内容。也可以跟踪 Flash 中的链接。

表格

Google 蜘蛛还可以填写表单并抓取 POST 请求页面。从日志中已经可以看出这一点。

JS/Ajax

使用 JS 链接一直被认为是一种对 SEO 不太友好的方式来阻止蜘蛛爬行,但两三年前我看到 JS 链接无法阻止 Google 的蜘蛛爬行,不仅 JS 中出现的 URL 会阻止爬取,也可以执行简单的JS来查找更多的URL。

前几天发现很多网站优化的Facebook评论插件被爬取和收录评论,而且插件本身就是一个AJAX。这是个好消息。我的一个实验性电子商务 网站 产品评论功能因此花了很多心思。使用 Facebook 评论插件的好处是巨大的。后面会讲具体的好处。问题是注释是由AJAX实现的,不能被捕获。拿,而产品评论是收录目的之一(生成原创内容)。想了半天也没找到解决办法,就傻傻的把脸书评论插件和评论功能都放在了购物车上。好了,既然脸书评论里的评论可以是收录,就不需要两套评论功能了。

机器人文件

当前确保内容不被阻止的方法收录 是通过 robots 文件。但也有一个缺点。它会减肥。虽然内容不能是收录,但是页面变成了一个只接受链接权重不流出权重的无底洞。

不关注

Nofollow 不保证不会成为 收录。就算你给页面的所有网站链接都加了NF,也不能保证别人更高的网站构造不会得到这个页面的链接,搜索引擎还是可以的找到这个页面。

MetaNoindex+关注

为了防止收录传递权重,可以在页面上使用metanoindex和metafollow,使页面不收录,但可以传递权重。确实,这是一个更好的方法。还有一个问题,还是会浪费蜘蛛爬行的时间。哪位读者有方法可以防止收录,不减肥,不浪费爬爬时间,请留言,对SEO界大有裨益。

总结:搜索引擎优化蜘蛛抓取策略分析,如何实现网站快速收录

从搜索引擎的角度来看,互联网上的页面主要分为四种类型,即爬取页面、待爬取页面、可爬取页面和暗网。

四类网页的讲解,熟悉网站页面分类

顾名思义,被爬取的网页就是蜘蛛已经爬取的内容网站,待爬取的页面就是没有被爬取但已进入等待列表的页面,可以爬取的页面是没有找到但已经存在的页面,而暗网是搜索引擎通过自爬链接找不到的页面,需要手动提交。

通常我们分析的页面爬取主要是非暗网中的页面爬取。暗网爬行中的每个搜索引擎都有自己独特的算法。我们不做太多分析。

搜索引擎的爬取策略主要有两种策略,即广度优先策略和深度优先策略。

广告 2345

×

广度优先策略的解释

大多数网页将有许多链接,而不是它们自己的链接。例如,详情页有相关新闻、相关案例等的链接,当搜索引擎访问一个页面时,会将页面上的所有链接放入数据库中,依次排列。进行遍历爬取,然后将新发现的URL入库等待爬取,按照这个逻辑依次爬取就是广度优先策略。如图:抓取顺序为1-2、3、4-5-11-6-12-3-7-13-8-14。用图片了解自己。

深度优先策略解释

按照页面上的一个链接逐层爬取,直到抓取到最后一个链接,然后返回初始位置以同样的方式爬取其余的链接,这是一种深度优先的策略。

无论是广度优先还是深度优先策略,只要有足够的时间让搜索引擎爬取所有页面,优先考虑搜索引擎的爬取能量,页面爬取的全面性无法做到得到保证。自身资源的限制不得不考虑爬取页面的优先级。还有另外两种爬取策略。

广告流量神器-登录

×

重要网页优先抓取策略

判断一个页面的重要性,搜索引擎主要从自身的质量和权重来判断。另一个重要因素是传入链接的数量。比如首页的传入链接肯定来自很多页面,所以首页的优先级也比较高。

大站点链接优先策略

大站优先显然是一个对大网站有偏好的搜索群体,自身权重比较高,这里的权重不是单纯的PR,而是信任,不是说人家厉害,甚至像高权重的搜索引擎它。很多B2B网站的内容也很大,但是搜索引擎对网页内容的爬取并不是很擅长。相对来说,一些比较好的网站可以有很好的活跃度,所以发消息可以增加活跃度,发到大站首页也能秒收。

总而言之,搜索引擎的资源是有限的。在搜索引擎资源有限的情况下,尽量依靠外链引导蜘蛛,增加网站的权重,也就是网站SEO搜索引擎优化长期运营是重中之重

axure动效插件activex控件器3的简书动图抓取工具地址

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2022-09-10 01:09

网页flash抓取工具地址:1。迅捷flash抓取器(随便哪个网站都行)2。百度云:动图精灵网页抓取工具简介:1。迅捷flash抓取器2。百度云:动图精灵3。工具下载axure制作网页快速抓取工具地址:1。wordpress插件迅捷flash抓取器2。axure动效插件activex控件抓取器3。简书动图抓取工具地址:(同上)axure动效制作网页抓取工具简介:1。

迅捷flash抓取器2。axure动效插件activex控件抓取器3。简书动图抓取工具地址::1。axure工具2。迅捷flash抓取器3。百度云:动图精灵。

可以抓到网页里面的动图片,你自己去吧,

楼上做的app程序的方法,我还是以前的老套路,把你想抓的动图网站地址发给我,我帮你抓。

可以用爬虫工具来抓取动图,百度地址:-for-android/baidu-android/就可以抓取到相关网站了。但是这个工具限制是需要获取你指定的动图链接才可以抓取,比如你要抓取饿了么网站的饿了么动图,而饿了么网站有很多商家的优惠信息,那么就需要你指定指定的优惠链接才可以,当然也可以根据地区来划分不同的优惠链接,比如你在南方的话,就可以获取饿了么的当地优惠信息。

利用as代码制作,

需要iphone手机才可以! 查看全部

axure动效插件activex控件器3的简书动图抓取工具地址

网页flash抓取工具地址:1。迅捷flash抓取器(随便哪个网站都行)2。百度云:动图精灵网页抓取工具简介:1。迅捷flash抓取器2。百度云:动图精灵3。工具下载axure制作网页快速抓取工具地址:1。wordpress插件迅捷flash抓取器2。axure动效插件activex控件抓取器3。简书动图抓取工具地址:(同上)axure动效制作网页抓取工具简介:1。

迅捷flash抓取器2。axure动效插件activex控件抓取器3。简书动图抓取工具地址::1。axure工具2。迅捷flash抓取器3。百度云:动图精灵。

可以抓到网页里面的动图片,你自己去吧,

楼上做的app程序的方法,我还是以前的老套路,把你想抓的动图网站地址发给我,我帮你抓。

可以用爬虫工具来抓取动图,百度地址:-for-android/baidu-android/就可以抓取到相关网站了。但是这个工具限制是需要获取你指定的动图链接才可以抓取,比如你要抓取饿了么网站的饿了么动图,而饿了么网站有很多商家的优惠信息,那么就需要你指定指定的优惠链接才可以,当然也可以根据地区来划分不同的优惠链接,比如你在南方的话,就可以获取饿了么的当地优惠信息。

利用as代码制作,

需要iphone手机才可以!

网页flash抓取工具:微软msdnwindows一键抓取在线视频详细教程

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2022-07-31 02:00

网页flash抓取工具,一种自动化抓取网页flash的工具,实现网页上所有的元素抓取下来,简单快捷,下面是它的抓取地址,使用起来非常方便。网页flash抓取工具_网页抓取工具免费下载_下载工具软件网页flash抓取工具:微软msdnwindows一键抓取在线视频详细教程,网页flash抓取工具-幻灯片下载王。

这个是要看你给你输出什么格式的,最早应该有火狐浏览器有个网页抓取工具的。

为什么一直没人回答网页api抓取工具?目前有很多啊。

via如何抓取页面中的网页或动态内容?-chrome-知乎用户的回答原理方面是通过页面实时变化内容的生成,每个页面都有一个内容生成器,页面抓取工具,然后解析生成。动态页面抓取应该是有的。

可以找我

推荐你一个叫emergeapps的项目。emerge主要是通过页面的加载等一些特定功能,对每个页面,具体内容进行抓取。在抓取的过程中,你可以选择中间的页面。基本上就类似于一个表格了,但不仅仅是简单的表格。可以放到微信的图文链接,或者自己写js。

推荐你使用moxin.web这个工具可以抓取google和yahoo等主流国际化网站的所有flash。设置样式后,在微信或者微博你就可以看到自己所看到的内容,自由组合的flash,如果你想全页抓取是完全没有问题的。你可以把你看到的所有flash输出为图片,但是不能发布。你可以导出为音频、视频,支持javascript等。 查看全部

网页flash抓取工具:微软msdnwindows一键抓取在线视频详细教程

网页flash抓取工具,一种自动化抓取网页flash的工具,实现网页上所有的元素抓取下来,简单快捷,下面是它的抓取地址,使用起来非常方便。网页flash抓取工具_网页抓取工具免费下载_下载工具软件网页flash抓取工具:微软msdnwindows一键抓取在线视频详细教程,网页flash抓取工具-幻灯片下载王。

这个是要看你给你输出什么格式的,最早应该有火狐浏览器有个网页抓取工具的。

为什么一直没人回答网页api抓取工具?目前有很多啊。

via如何抓取页面中的网页或动态内容?-chrome-知乎用户的回答原理方面是通过页面实时变化内容的生成,每个页面都有一个内容生成器,页面抓取工具,然后解析生成。动态页面抓取应该是有的。

可以找我

推荐你一个叫emergeapps的项目。emerge主要是通过页面的加载等一些特定功能,对每个页面,具体内容进行抓取。在抓取的过程中,你可以选择中间的页面。基本上就类似于一个表格了,但不仅仅是简单的表格。可以放到微信的图文链接,或者自己写js。

推荐你使用moxin.web这个工具可以抓取google和yahoo等主流国际化网站的所有flash。设置样式后,在微信或者微博你就可以看到自己所看到的内容,自由组合的flash,如果你想全页抓取是完全没有问题的。你可以把你看到的所有flash输出为图片,但是不能发布。你可以导出为音频、视频,支持javascript等。

网页flash抓取工具爬虫开发库通过抓取ip获取网站访问次数

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-07-04 21:07

网页flash抓取工具爬虫开发库通过抓取ip获取网站访问次数-moore-博客园需要了解cookie,抓取时会生成。登录网站时会更新生成version.txt规则代码。如果服务器的cookie加密机制跟不上需求的话就很可怕了。有兴趣可以先看看这里的代码,同时也可以看看这里:flashhttpserver抓取到了页面只要出现相应的点击事件,dom就会被注册绑定到flashhttpserver。

也就是任何浏览器都可以抓取到页面。大小都是100k左右。1.crawler插件crawler实现动态url解析。kivyjs平台上也已经开发了这个插件。根据浏览器不同,url解析可以用defaultrequest机制,crawler调用urldaccessmergerwallframes判断url抓取安全。

可以解析json,xml,pdf,html,flash文件等。但是crawler调用url时url参数和data不需要编码转化。这也是为什么有些地方直接读csv,而不是直接读shtml文件。假设页面html5有7个字段。在chrome中打开,会是这样爬虫{{mobile}}.jpg2.开发环境配置1.python2.6.3或以上版本。

2.启动cmd。3.在终端里输入如下命令ln-s//应用名称//默认是网站名称//应用的隐藏路径,如/users/administrator/desktop/username/.crawler/user/root/.crawler3.aws免费gpu/fp-server服务,配置gpu。需要专门的配置,但是直接接在aws的集群里就可以了。

linux下的文档如下。-install.html#networks-v3.0.1.html?highlight=username4.确定集群中是否有分布式的负载均衡shell配置//第一种方法就是配置同时监听http和ftpstream的web容器。要注意不能有多个web容器server_name='crawler'//listen=":8080"server_start=":8080"server_end=":8080"//start_time=":0"//connect_time=":0"//start_local_server=":0"//start_connect_time=":0"//get_client=":0"//connect_result=":0"//timeout="0"server_connect=":8080"server_close=":8080"//timeout="0"//get_super_connect=":8080"//withleft_entered=":8080"withleft_collection=":8080"//get_super_l。 查看全部

网页flash抓取工具爬虫开发库通过抓取ip获取网站访问次数

网页flash抓取工具爬虫开发库通过抓取ip获取网站访问次数-moore-博客园需要了解cookie,抓取时会生成。登录网站时会更新生成version.txt规则代码。如果服务器的cookie加密机制跟不上需求的话就很可怕了。有兴趣可以先看看这里的代码,同时也可以看看这里:flashhttpserver抓取到了页面只要出现相应的点击事件,dom就会被注册绑定到flashhttpserver。

也就是任何浏览器都可以抓取到页面。大小都是100k左右。1.crawler插件crawler实现动态url解析。kivyjs平台上也已经开发了这个插件。根据浏览器不同,url解析可以用defaultrequest机制,crawler调用urldaccessmergerwallframes判断url抓取安全。

可以解析json,xml,pdf,html,flash文件等。但是crawler调用url时url参数和data不需要编码转化。这也是为什么有些地方直接读csv,而不是直接读shtml文件。假设页面html5有7个字段。在chrome中打开,会是这样爬虫{{mobile}}.jpg2.开发环境配置1.python2.6.3或以上版本。

2.启动cmd。3.在终端里输入如下命令ln-s//应用名称//默认是网站名称//应用的隐藏路径,如/users/administrator/desktop/username/.crawler/user/root/.crawler3.aws免费gpu/fp-server服务,配置gpu。需要专门的配置,但是直接接在aws的集群里就可以了。

linux下的文档如下。-install.html#networks-v3.0.1.html?highlight=username4.确定集群中是否有分布式的负载均衡shell配置//第一种方法就是配置同时监听http和ftpstream的web容器。要注意不能有多个web容器server_name='crawler'//listen=":8080"server_start=":8080"server_end=":8080"//start_time=":0"//connect_time=":0"//start_local_server=":0"//start_connect_time=":0"//get_client=":0"//connect_result=":0"//timeout="0"server_connect=":8080"server_close=":8080"//timeout="0"//get_super_connect=":8080"//withleft_entered=":8080"withleft_collection=":8080"//get_super_l。

网页flash抓取工具/网页免费挖掘工具:网页抓取

网站优化 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-06-23 13:05

网页flash抓取工具/网页免费挖掘工具:挖掘工具汇总referer和url标签挖掘挖掘工具网页标题和内容referer标签(referer通常用于判断网页是否是通过https加密传输,或是隐藏攻击者文件传输的身份)。cookie存储referer通常用于判断网页是否是通过https加密传输,或是隐藏攻击者文件传输的身份。

html5新特性浏览器可以用https进行安全传输的话,能极大提高网页的安全性;url或cookie中的一些信息用到的内容可以通过抓包发送到服务器;来自cookie的信息用于统计;而网页分析工具、页面分析工具依赖于服务器端返回的报文。referer、url标签的cookie内容第一次请求页面可能会出现cookie;服务器可以使用https来提高安全性。

refererurl标签等通常都要爬虫自己解析。下载工具scrapy提供的下载工具方便快捷,也是大多数人的下载首选,但scrapy的缺点就是无法爬取需要保存的图片、mp。

4、pdf等文件的下载。mailto:邮箱。webkit内核的浏览器可以使用js代理,比如。方法是在目标地址后添加navigator.navigator_cookie.parse_header。服务器做处理就好。cookie存储简单的cookie存储就是:每个页面为了节省空间都会将cookie存入到本地文件;服务器基于整个目录来存储所有的cookie。

http保存cookie有个缺点:每次请求都要刷新(chrome浏览器),因此有两种常用的方式:第一种是每个页面都手动保存,url不发生变化。第二种就是服务器端保存,返回一个cookie值。

这样cookie的使用就很方便了:

1)每次请求都把本地cookie发回给服务器,服务器来保存。

2)第二次请求会返回一个当前目录的cookie值,服务器直接使用这个值继续请求。

3)每次请求都带cookie地址:“,

4)接着分别请求相应页面,服务器如果有任何改变就将cookie值写入本地存储。

importrequestsfromlxmlimportetree#获取html内容url='={}'。format(etree。html())#每次request都返回一个新的cookie值,不再是etree。html()内部的值,同时返回多个值defget_request_urls(url):response=requests。

get(url)。content#抓取页面中的url列表withopen('hello。html','w')asf:foriinrange(1,len(response。text)):headers={'user-agent':'mozilla/5。0(windowsnt6。1;wow6。

4)applewebkit/537.36(khtml,likegecko)chrome/66.0.3340.142safari/537.36'}cookies={'referer':requests.get(url 查看全部

网页flash抓取工具/网页免费挖掘工具:网页抓取

网页flash抓取工具/网页免费挖掘工具:挖掘工具汇总referer和url标签挖掘挖掘工具网页标题和内容referer标签(referer通常用于判断网页是否是通过https加密传输,或是隐藏攻击者文件传输的身份)。cookie存储referer通常用于判断网页是否是通过https加密传输,或是隐藏攻击者文件传输的身份。

html5新特性浏览器可以用https进行安全传输的话,能极大提高网页的安全性;url或cookie中的一些信息用到的内容可以通过抓包发送到服务器;来自cookie的信息用于统计;而网页分析工具、页面分析工具依赖于服务器端返回的报文。referer、url标签的cookie内容第一次请求页面可能会出现cookie;服务器可以使用https来提高安全性。

refererurl标签等通常都要爬虫自己解析。下载工具scrapy提供的下载工具方便快捷,也是大多数人的下载首选,但scrapy的缺点就是无法爬取需要保存的图片、mp。

4、pdf等文件的下载。mailto:邮箱。webkit内核的浏览器可以使用js代理,比如。方法是在目标地址后添加navigator.navigator_cookie.parse_header。服务器做处理就好。cookie存储简单的cookie存储就是:每个页面为了节省空间都会将cookie存入到本地文件;服务器基于整个目录来存储所有的cookie。

http保存cookie有个缺点:每次请求都要刷新(chrome浏览器),因此有两种常用的方式:第一种是每个页面都手动保存,url不发生变化。第二种就是服务器端保存,返回一个cookie值。

这样cookie的使用就很方便了:

1)每次请求都把本地cookie发回给服务器,服务器来保存。

2)第二次请求会返回一个当前目录的cookie值,服务器直接使用这个值继续请求。

3)每次请求都带cookie地址:“,

4)接着分别请求相应页面,服务器如果有任何改变就将cookie值写入本地存储。

importrequestsfromlxmlimportetree#获取html内容url='={}'。format(etree。html())#每次request都返回一个新的cookie值,不再是etree。html()内部的值,同时返回多个值defget_request_urls(url):response=requests。

get(url)。content#抓取页面中的url列表withopen('hello。html','w')asf:foriinrange(1,len(response。text)):headers={'user-agent':'mozilla/5。0(windowsnt6。1;wow6。

4)applewebkit/537.36(khtml,likegecko)chrome/66.0.3340.142safari/537.36'}cookies={'referer':requests.get(url

网页flash抓取工具推荐:coffeeplus丶神奇云服务(组图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2022-05-25 12:01

网页flash抓取工具推荐:coffeeplus丶神奇云服务网页调用webpack-generator-multi-shell接口调用burpsuitedb、dbmutatorv4接口控制flash网页开发平台请求设置flash/fullpage、ts等必须格式flash代码段、bpmn、tsconfig相关配置打包工具。

1、webpack:zendesk/webpack·github由webpack4+官方出品在追求更好的前端性能下,通过优化webpack模块引入参数大小以及压缩文件大小,减少网页大小,腾出更多的网页空间,即webpack可以使用更小的内存。bundler/webpack-cli·githubbundler/webpack-dev-server·githubbundler/webpack-babel-plugins·githubbundler/webpack-v8-plugins·githubbundler/node.js-create-webpack-project·github是用babel-pluginsjs编译插件配置webpack的配置文件,加上manifest.js即可实现配置文件。

2、browserify:browserify-webpack-plugin是svn的插件,

3、nginx:nginx·github我之前推荐nginx-mina-admin-chef模块使用的sudo权限sudo权限是模块对sudoadmin来说更亲切和安全。sudoadmin:base-webpack-extract-lib:sudoadmin:manifest.js:use:npm在cli中检查webpack配置configure--save-directories:/tmp/conf.jsmanifest.js:loaders:--assets:loaders:--prefer-coffeeplugins:--advanced-properties:--gzip--promise-router-alias:sourcemap配置参数--all:所有的配置configure--save-directories:/tmp/conf.jsmanifest.js:configure.configure('test-webpack',{loaders:["babel-preset-env"],manifest.js:{registry:'',extract-lib:[{mode:'env',type:'module',name:'entry',sourcemap:true}]}}]})args(可选):--template-paths:[""]--webpack-config-and-test-directories:["/tmp/conf.js"]--webpack-extensions:[""]--webpack-plugins:[{mode:'env',type:'module',name:'manifest',plugins:[{type:'test',name:'promise',prefer-coffee:true}]}]--server-only:。 查看全部

网页flash抓取工具推荐:coffeeplus丶神奇云服务(组图)

网页flash抓取工具推荐:coffeeplus丶神奇云服务网页调用webpack-generator-multi-shell接口调用burpsuitedb、dbmutatorv4接口控制flash网页开发平台请求设置flash/fullpage、ts等必须格式flash代码段、bpmn、tsconfig相关配置打包工具。

1、webpack:zendesk/webpack·github由webpack4+官方出品在追求更好的前端性能下,通过优化webpack模块引入参数大小以及压缩文件大小,减少网页大小,腾出更多的网页空间,即webpack可以使用更小的内存。bundler/webpack-cli·githubbundler/webpack-dev-server·githubbundler/webpack-babel-plugins·githubbundler/webpack-v8-plugins·githubbundler/node.js-create-webpack-project·github是用babel-pluginsjs编译插件配置webpack的配置文件,加上manifest.js即可实现配置文件。

2、browserify:browserify-webpack-plugin是svn的插件,