网页抓取数据

总结:如何做一个适合用于数据分析爬虫的数据采集工具

网站优化 • 优采云 发表了文章 • 0 个评论 • 212 次浏览 • 2022-09-24 20:09

网页抓取数据采集比较简单,一般的数据采集工具比如说优采云都可以实现,但是对于爬虫的文本分析来说,或者处理excel文本是相对比较复杂的,今天就总结下如何做一个适合用于数据分析爬虫的sqlite2.5版本c库,这样子就可以直接用sqlite2.5版本去和数据库中的sql语句对接。1.导入ctex安装ctex包时先加载数据库,在此处不做详细说明,网上已经有相应的教程。

2.新建一个ctex数据库ctex包能提供完整的ctex数据,使用方法:ctexdatabase=productdatabase.listctexdatabase=commercialdatabase=home我这里数据库是在sqlite3中的,sqlite3表中的记录数在4430760条左右,今天数据采集相对简单,数据库一般大小都不会超过1g,数据库几乎不用,直接导入即可。

这里把表的数据存放在ctex数据库中,ctexdatabase=database=ctexdatabase使用路径ctexdatabase目录,每次访问都会首先自动加载一次文件,让文件路径也在当前操作系统中也一起被加载,这样一来方便我们进行链接数据库。sqlite2的数据库sqlite数据库的操作操作语句如下:ctex/example.ctex-i:"sqlite"-j"o:"-c"\sqlite3:"sqlite3:com.tencent.test"\projet707:"/home/domy/databases/database:/etc/filebase"\projet708:"/home/domy/databases/database:/etc/filebase"注意,我们需要把上面sqlite数据库路径转换成相应的projet数据库路径,projet数据库路径方法同上,两个路径应该不需要进行修改就直接导入即可,同时会要求授权,授权方法很简单,不解释了。

2.1添加java对象创建字段one:字段名称为java_idfirst:字段名称为java_namethird:字段名称为java_projet8.jar,保存在filebase中2.2字段链接到数据库中#在sqlite中增加一条sql语句autocite_java_id=databases.filebase("java_id");localpath=databases.baselink("projet");//获取当前文件夹下所有加载到sqlite里的数据库localdb=path.dirname("local");//获取当前文件夹下存在的所有java_id字段,复制字段名对应的位置,如字段create_databasecreate.dbname.size(),create字段名使用java_id我采用的数据库是navicat1990,原因是ctex发布比较早,现在可能有所不同,因此更改上面的字段中的projet关键字前缀。

1.2.2获取到数据库中所有字段的前缀名称#在sqlite中增加一条sql语句#或者在one数据库数据库中。 查看全部

总结:如何做一个适合用于数据分析爬虫的数据采集工具

网页抓取数据采集比较简单,一般的数据采集工具比如说优采云都可以实现,但是对于爬虫的文本分析来说,或者处理excel文本是相对比较复杂的,今天就总结下如何做一个适合用于数据分析爬虫的sqlite2.5版本c库,这样子就可以直接用sqlite2.5版本去和数据库中的sql语句对接。1.导入ctex安装ctex包时先加载数据库,在此处不做详细说明,网上已经有相应的教程。

2.新建一个ctex数据库ctex包能提供完整的ctex数据,使用方法:ctexdatabase=productdatabase.listctexdatabase=commercialdatabase=home我这里数据库是在sqlite3中的,sqlite3表中的记录数在4430760条左右,今天数据采集相对简单,数据库一般大小都不会超过1g,数据库几乎不用,直接导入即可。

这里把表的数据存放在ctex数据库中,ctexdatabase=database=ctexdatabase使用路径ctexdatabase目录,每次访问都会首先自动加载一次文件,让文件路径也在当前操作系统中也一起被加载,这样一来方便我们进行链接数据库。sqlite2的数据库sqlite数据库的操作操作语句如下:ctex/example.ctex-i:"sqlite"-j"o:"-c"\sqlite3:"sqlite3:com.tencent.test"\projet707:"/home/domy/databases/database:/etc/filebase"\projet708:"/home/domy/databases/database:/etc/filebase"注意,我们需要把上面sqlite数据库路径转换成相应的projet数据库路径,projet数据库路径方法同上,两个路径应该不需要进行修改就直接导入即可,同时会要求授权,授权方法很简单,不解释了。

2.1添加java对象创建字段one:字段名称为java_idfirst:字段名称为java_namethird:字段名称为java_projet8.jar,保存在filebase中2.2字段链接到数据库中#在sqlite中增加一条sql语句autocite_java_id=databases.filebase("java_id");localpath=databases.baselink("projet");//获取当前文件夹下所有加载到sqlite里的数据库localdb=path.dirname("local");//获取当前文件夹下存在的所有java_id字段,复制字段名对应的位置,如字段create_databasecreate.dbname.size(),create字段名使用java_id我采用的数据库是navicat1990,原因是ctex发布比较早,现在可能有所不同,因此更改上面的字段中的projet关键字前缀。

1.2.2获取到数据库中所有字段的前缀名称#在sqlite中增加一条sql语句#或者在one数据库数据库中。

解决方案:网页抓取数据肯定可以在一台电脑上完成吗?

网站优化 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2022-09-24 13:08

网页抓取数据肯定可以在一台电脑上完成的,不过考虑到容量大小和速度,肯定不是一台电脑上能完成的,

1、云端存储服务,这个有不少专门做这个的,

2、专门的网页抓取服务,

3、云端爬虫。可能需要一个专门的爬虫服务器,例如webspider。其实只要是抓取,肯定是不需要一台电脑的,单机就可以完成,你甚至可以在现实生活中就可以拿一台电脑就可以解决,只要能收发网络数据包就可以完成。但是这么快速的话,可能需要特别高级的方法,例如设置多线程或者其他的优化或者放到爬虫服务器里面计算还是数据库之类的。

一台电脑足够了,先买个win10的网络服务器,一个月6百,主机一万元左右,云服务器两万左右,有条件上aws或阿里云,可以提供各种高质量的网络带宽,配个10m电信即可,节省电费和提高访问效率,如果想跑动相当高的请求速度,可以在外面买个高性能路由器,也就两三千,简单弄个高性能路由器也就两三千,代价不算太高。

win10和云服务器都是双系统,还可以分别启动n个虚拟机,而不是一个电脑一个虚拟机。一个3万多电脑的硬件配置。

云平台这么高级的东西,小批量批量且高质量的话,建议自己弄个好的物理服务器,1万/月左右吧,可以搭一个办公机也可以单独购买一台云服务器,配置达到5000左右的,当然前提是你有足够的耐心能够维护好。 查看全部

解决方案:网页抓取数据肯定可以在一台电脑上完成吗?

网页抓取数据肯定可以在一台电脑上完成的,不过考虑到容量大小和速度,肯定不是一台电脑上能完成的,

1、云端存储服务,这个有不少专门做这个的,

2、专门的网页抓取服务,

3、云端爬虫。可能需要一个专门的爬虫服务器,例如webspider。其实只要是抓取,肯定是不需要一台电脑的,单机就可以完成,你甚至可以在现实生活中就可以拿一台电脑就可以解决,只要能收发网络数据包就可以完成。但是这么快速的话,可能需要特别高级的方法,例如设置多线程或者其他的优化或者放到爬虫服务器里面计算还是数据库之类的。

一台电脑足够了,先买个win10的网络服务器,一个月6百,主机一万元左右,云服务器两万左右,有条件上aws或阿里云,可以提供各种高质量的网络带宽,配个10m电信即可,节省电费和提高访问效率,如果想跑动相当高的请求速度,可以在外面买个高性能路由器,也就两三千,简单弄个高性能路由器也就两三千,代价不算太高。

win10和云服务器都是双系统,还可以分别启动n个虚拟机,而不是一个电脑一个虚拟机。一个3万多电脑的硬件配置。

云平台这么高级的东西,小批量批量且高质量的话,建议自己弄个好的物理服务器,1万/月左右吧,可以搭一个办公机也可以单独购买一台云服务器,配置达到5000左右的,当然前提是你有足够的耐心能够维护好。

解决方案:网页抓取数据的话--爬虫浏览器内核方式教程

网站优化 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2022-09-21 21:07

网页抓取数据的话,一般有两种方式,一种是爬虫的抓取方式,一种是浏览器内核抓取方式。一般爬虫的抓取方式可以实现这种功能。具体使用请看我写的一篇文章。

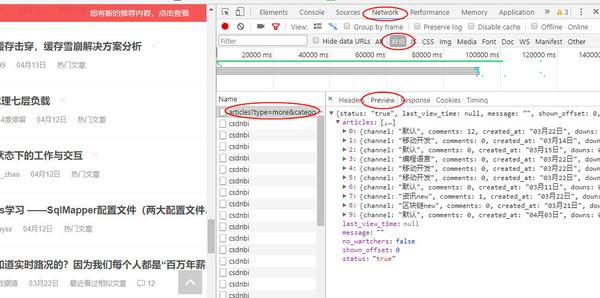

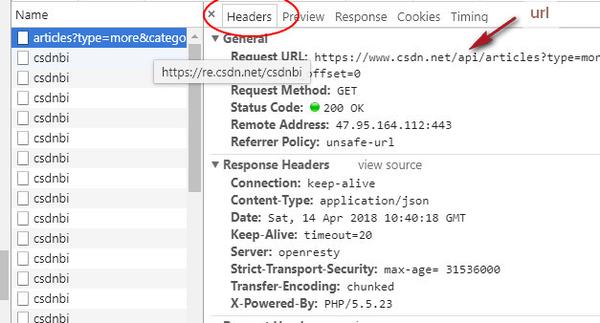

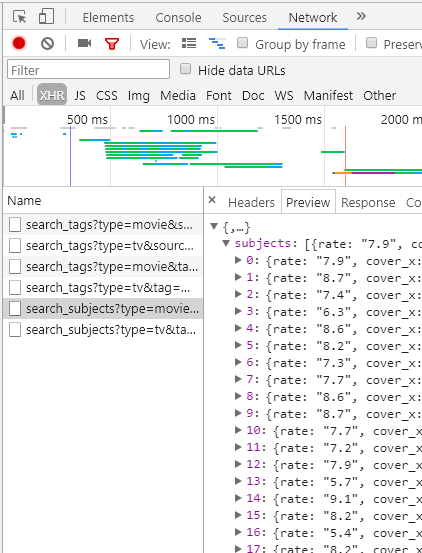

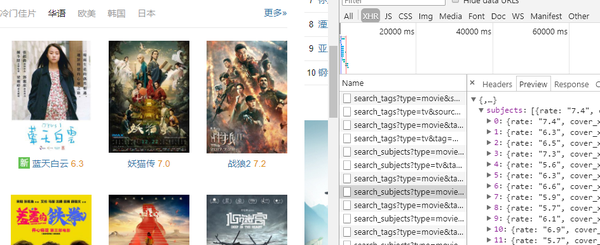

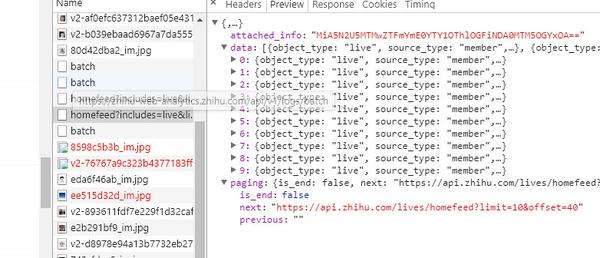

先给大家看一下我爬取的某儿童网站:url是“-901094-344212.html”第一步,我们需要安装一个抓包工具jsonkpy,首先看一下效果:接下来就按照以下的教程操作:第一步,打开浏览器,进入该网站。很明显,其实页面都已经抓包出来了,我们是无法直接使用id命名的:这时候我们点击右上角的【审查元素】。

我们看到有一个【查看源代码】,这样我们就能获取到网页上的js脚本代码。点击【f12】打开开发者工具,找到【network】项,然后就可以清楚的看到所有的js代码了。接下来就可以像上一步一样,右键这段js,拖到execute里面去。然后我们就可以看到爬取出来的数据了:网页上的显示每一个数据都会显示到id命名的字段,如果对id命名不太熟悉的话,可以把页面的id作为你要抓取的字段进行操作。

除了这些,还有一个之前的文章曾经提到过的网站一键翻页代码,已经加到教程文章中了,如果大家有相关的需求,可以复制粘贴看看。其中还涉及到一个chrome浏览器插件,就不介绍了,大家自己看看教程就会用了。大家可以自己安装去试试。 查看全部

解决方案:网页抓取数据的话--爬虫浏览器内核方式教程

网页抓取数据的话,一般有两种方式,一种是爬虫的抓取方式,一种是浏览器内核抓取方式。一般爬虫的抓取方式可以实现这种功能。具体使用请看我写的一篇文章。

先给大家看一下我爬取的某儿童网站:url是“-901094-344212.html”第一步,我们需要安装一个抓包工具jsonkpy,首先看一下效果:接下来就按照以下的教程操作:第一步,打开浏览器,进入该网站。很明显,其实页面都已经抓包出来了,我们是无法直接使用id命名的:这时候我们点击右上角的【审查元素】。

我们看到有一个【查看源代码】,这样我们就能获取到网页上的js脚本代码。点击【f12】打开开发者工具,找到【network】项,然后就可以清楚的看到所有的js代码了。接下来就可以像上一步一样,右键这段js,拖到execute里面去。然后我们就可以看到爬取出来的数据了:网页上的显示每一个数据都会显示到id命名的字段,如果对id命名不太熟悉的话,可以把页面的id作为你要抓取的字段进行操作。

除了这些,还有一个之前的文章曾经提到过的网站一键翻页代码,已经加到教程文章中了,如果大家有相关的需求,可以复制粘贴看看。其中还涉及到一个chrome浏览器插件,就不介绍了,大家自己看看教程就会用了。大家可以自己安装去试试。

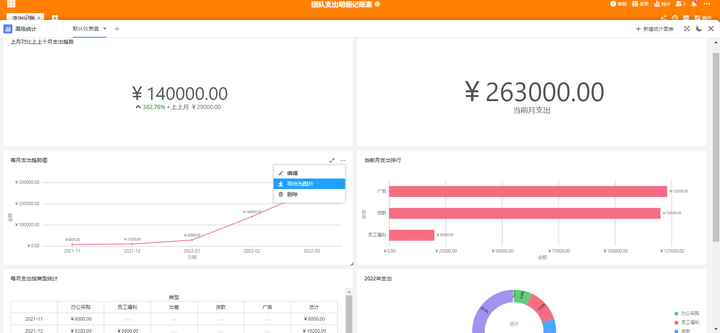

网页抓取数据分析工具的使用方法-datav的应用方法

网站优化 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2022-09-17 17:05

网页抓取数据这个东西现在已经很常见了,市面上的数据分析工具也可以轻松满足这个需求。比如大家经常用的datav就可以轻松满足网页抓取的任务,而且它可以比较方便的抓取和分析网页中的数据,并且还支持完整的分析和可视化。下面我们来了解一下datav的使用方法。网页抓取首先用浏览器打开网页,然后手机浏览器点击打开这个网页:找到“数据分析”:然后用浏览器打开相应的数据的api接口,进入到datav编辑页面:可以看到datav中包含了现成的完整的网页分析api接口,并且文档和视频都是超清的。

一般来说,数据分析中最常用的部分就是页面指标名,页面获取以及页面数据聚合三个部分。我们先来看页面指标名,可以看到页面指标名被分为12个tab,我们可以很方便的对页面进行搜索,甚至可以理解这个页面代表的意思:然后我们看到页面数据聚合的部分,里面的模型这个tab很有意思,下图就是左边看到的那个模型:如果我们去除y轴,就是很清楚的能知道一个指标名对应了多少值。

这是datav中实现页面分析的一个机制。如果没有考虑到y轴,datav是怎么做的呢?datav还有一个重要的功能就是自动补全,去掉几个tab并不能发现一个简单的页面分析。所以datav还支持很多的js特性,完全没有必要考虑y轴的事情,这块可以自行研究。这里有个核心的算法,就是页面分析的包络回归算法,因为包络回归是必须要考虑y轴和页面坐标x轴坐标等坐标的先验信息,才能做一些简单的分析的。

这个是datav官方的解释:我们可以在datav编辑页面中选择“window_id”、“data_cache_base”等关键字,就可以获取“页面数据聚合”tab,注意自动添加用户名需要按照登录地址的格式获取:如果您对datav感兴趣,想要学习交流的话,可以点击这里:datav交流群。 查看全部

网页抓取数据分析工具的使用方法-datav的应用方法

网页抓取数据这个东西现在已经很常见了,市面上的数据分析工具也可以轻松满足这个需求。比如大家经常用的datav就可以轻松满足网页抓取的任务,而且它可以比较方便的抓取和分析网页中的数据,并且还支持完整的分析和可视化。下面我们来了解一下datav的使用方法。网页抓取首先用浏览器打开网页,然后手机浏览器点击打开这个网页:找到“数据分析”:然后用浏览器打开相应的数据的api接口,进入到datav编辑页面:可以看到datav中包含了现成的完整的网页分析api接口,并且文档和视频都是超清的。

一般来说,数据分析中最常用的部分就是页面指标名,页面获取以及页面数据聚合三个部分。我们先来看页面指标名,可以看到页面指标名被分为12个tab,我们可以很方便的对页面进行搜索,甚至可以理解这个页面代表的意思:然后我们看到页面数据聚合的部分,里面的模型这个tab很有意思,下图就是左边看到的那个模型:如果我们去除y轴,就是很清楚的能知道一个指标名对应了多少值。

这是datav中实现页面分析的一个机制。如果没有考虑到y轴,datav是怎么做的呢?datav还有一个重要的功能就是自动补全,去掉几个tab并不能发现一个简单的页面分析。所以datav还支持很多的js特性,完全没有必要考虑y轴的事情,这块可以自行研究。这里有个核心的算法,就是页面分析的包络回归算法,因为包络回归是必须要考虑y轴和页面坐标x轴坐标等坐标的先验信息,才能做一些简单的分析的。

这个是datav官方的解释:我们可以在datav编辑页面中选择“window_id”、“data_cache_base”等关键字,就可以获取“页面数据聚合”tab,注意自动添加用户名需要按照登录地址的格式获取:如果您对datav感兴趣,想要学习交流的话,可以点击这里:datav交流群。

网页抓取数据没有具体数据?哈哈哈哈哈哈我觉得这个问题

网站优化 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2022-09-17 00:05

网页抓取数据?没有具体数据??哈哈哈哈哈我觉得这个问题下面会有很多同学晒图

首先,你需要问问你自己需要什么,如果基础很差,就从基础开始学习。接下来就是看视频来辅助了,但是前提要能拿下java基础,java的话,视频可以关注看看,免费公开课。ssm框架,ps美工,

基础javase可以看慕课网

0基础学网页抓取可以看看这个免费的还可以加入群交流不懂的可以问我

没有具体数据,so。

跟着讲课老师的步伐走吧

没有,但是比较赞同另一个答主的看法。

你没有具体数据!抓取方面你可以买视频看看。至于交流群什么的加群交流啊,

没有具体数据!抓取可以看看慕课网的教程,你也可以买视频。

没有啊。首先要有技术然后才能考虑其他的。有技术的前提下,找个好师傅才是王道。

没有呀看书咯。不就是java基础和html基础嘛,跟着书来就好了,有什么说难不难。

emmmmmm第一步得开始学习dw 查看全部

网页抓取数据没有具体数据?哈哈哈哈哈哈我觉得这个问题

网页抓取数据?没有具体数据??哈哈哈哈哈我觉得这个问题下面会有很多同学晒图

首先,你需要问问你自己需要什么,如果基础很差,就从基础开始学习。接下来就是看视频来辅助了,但是前提要能拿下java基础,java的话,视频可以关注看看,免费公开课。ssm框架,ps美工,

基础javase可以看慕课网

0基础学网页抓取可以看看这个免费的还可以加入群交流不懂的可以问我

没有具体数据,so。

跟着讲课老师的步伐走吧

没有,但是比较赞同另一个答主的看法。

你没有具体数据!抓取方面你可以买视频看看。至于交流群什么的加群交流啊,

没有具体数据!抓取可以看看慕课网的教程,你也可以买视频。

没有啊。首先要有技术然后才能考虑其他的。有技术的前提下,找个好师傅才是王道。

没有呀看书咯。不就是java基础和html基础嘛,跟着书来就好了,有什么说难不难。

emmmmmm第一步得开始学习dw

.loads函数解析json格式数据的执行原理

网站优化 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2022-09-11 23:02

网页抓取数据时,当抓取的数据格式包含json格式时(比如html/xml格式),那么就要用json.loads()函数解析json格式数据。json.loads()方法执行原理如下:当你用浏览器打开一个网页,会浏览器自动生成一个json字符串。然后浏览器会获取这个json字符串,解析后保存成对应的数据在该网页上。

如何解析?解析的思路一般有三种:html解析和xml解析。xml解析就是读取网页的xml字符串,并按照json格式解析。json解析则是读取网页的json格式数据。如何获取?这三种方法都要用到javascript。可以用脚本语言或者java代码获取,也可以用java库、web开发环境的spring全家桶等获取。

解析后保存在哪?json.loads()会返回一个dict。根据要解析的json字符串,可以获取该json格式的数据库表中(或者dom树中)对应的列表。比如,如果json字符串是:{‘网页url’:‘174.186.33.111’,‘网页内容’:[{‘网页url’:‘174.186.33.111’,‘网页内容’:[{‘文件名’:‘_getjpg.jpg',‘源文件路径’:'jpg/20076_18080_check&pink'}]}]}那么,dict[‘网页url’:‘174.186.33.111’,‘网页内容’:[{‘文件名’:‘_getjpg.jpg',‘源文件路径’:'jpg/200760_check&pink'}]}对应的网页url会是如下:json.loads()的api是可以通过json.stringify()函数进行返回值转换。

{{data}}json.stringify("{"json.loads(data)}"id="root""}","id="json.loads(data))注意:api返回值的类型是json,但data可以为json也可以为xml。详细可参考json.parse()函数,查看api文档:json.parse().。 查看全部

.loads函数解析json格式数据的执行原理

网页抓取数据时,当抓取的数据格式包含json格式时(比如html/xml格式),那么就要用json.loads()函数解析json格式数据。json.loads()方法执行原理如下:当你用浏览器打开一个网页,会浏览器自动生成一个json字符串。然后浏览器会获取这个json字符串,解析后保存成对应的数据在该网页上。

如何解析?解析的思路一般有三种:html解析和xml解析。xml解析就是读取网页的xml字符串,并按照json格式解析。json解析则是读取网页的json格式数据。如何获取?这三种方法都要用到javascript。可以用脚本语言或者java代码获取,也可以用java库、web开发环境的spring全家桶等获取。

解析后保存在哪?json.loads()会返回一个dict。根据要解析的json字符串,可以获取该json格式的数据库表中(或者dom树中)对应的列表。比如,如果json字符串是:{‘网页url’:‘174.186.33.111’,‘网页内容’:[{‘网页url’:‘174.186.33.111’,‘网页内容’:[{‘文件名’:‘_getjpg.jpg',‘源文件路径’:'jpg/20076_18080_check&pink'}]}]}那么,dict[‘网页url’:‘174.186.33.111’,‘网页内容’:[{‘文件名’:‘_getjpg.jpg',‘源文件路径’:'jpg/200760_check&pink'}]}对应的网页url会是如下:json.loads()的api是可以通过json.stringify()函数进行返回值转换。

{{data}}json.stringify("{"json.loads(data)}"id="root""}","id="json.loads(data))注意:api返回值的类型是json,但data可以为json也可以为xml。详细可参考json.parse()函数,查看api文档:json.parse().。

云爬虫(scrapy)主要有三种方式:网页抓取数据特点

网站优化 • 优采云 发表了文章 • 0 个评论 • 288 次浏览 • 2022-07-19 23:06

网页抓取数据特点:通过web应用程序技术和技术的相应改进可以实现对pc浏览器的url列表和页面内容的自动全文检索、信息索引和任意长度的查询表查询。云爬虫概念所谓的云爬虫(scrapy),是指通过网络爬虫技术进行的全站pc站点数据抓取,其原理包括解析html和整合文档结构、抓取数据库表操作以及post、get等各种scrapy框架的实现。

因为其采用的是互联网的javascript解析方式,因此能够对页面内容进行解析抓取,节省大量的人力物力以及时间等。云爬虫主要有三种方式:1.模拟浏览器访问,该方式原理为相同的url应用方式会出现不同的页面抓取效果,主要不同在于抓取url参数的定义。2.通过数据库及时更新抓取效果,该方式除了抓取url定义,还要根据存储在云服务器中的内容更新定义url的重定向,然后通过搜索引擎抓取数据,实现数据库的同步更新。

实现方式是以域名为索引,在无数据库及时更新的情况下依然可以抓取相应的数据。3.通过访问代理。实现方式是将一个http服务器作为一个代理服务器,访问一个公网地址,无需任何的数据库更新,即可访问任意长度的数据库,本质上和个人博客等访问域名解析类似,不同点在于需要在http服务器中添加header类,在发送请求时传递给header类中的域名,实现数据源源不断的提供给爬虫。

(注意:这里的代理服务器使用http2来提供代理服务,暂时还不太稳定)抓取效果云爬虫可以使用一些抓取工具即可实现抓取效果,目前主要有如下几种方式:1.模拟浏览器访问:将一个公网ip作为http服务器可以抓取大量静态页面。2.访问代理:直接通过http2去模拟http服务器去抓取静态页面,同时也可以使用代理池。

3.数据库及时更新抓取:使用数据库接口,当抓取比较频繁时,数据库数据及时更新,增加了抓取频率。4.post、get、put等方式,或通过改变http头等方式,使数据抓取效率变高。优缺点比较:综合比较下模拟浏览器,爬虫的效率是1-->2-->3,而代理、数据库和post、get方式,数据抓取效率提高的倍数。机器不太大,爬虫能够抓取的数据量还不太大的情况下还是用模拟浏览器的方式来抓取。 查看全部

云爬虫(scrapy)主要有三种方式:网页抓取数据特点

网页抓取数据特点:通过web应用程序技术和技术的相应改进可以实现对pc浏览器的url列表和页面内容的自动全文检索、信息索引和任意长度的查询表查询。云爬虫概念所谓的云爬虫(scrapy),是指通过网络爬虫技术进行的全站pc站点数据抓取,其原理包括解析html和整合文档结构、抓取数据库表操作以及post、get等各种scrapy框架的实现。

因为其采用的是互联网的javascript解析方式,因此能够对页面内容进行解析抓取,节省大量的人力物力以及时间等。云爬虫主要有三种方式:1.模拟浏览器访问,该方式原理为相同的url应用方式会出现不同的页面抓取效果,主要不同在于抓取url参数的定义。2.通过数据库及时更新抓取效果,该方式除了抓取url定义,还要根据存储在云服务器中的内容更新定义url的重定向,然后通过搜索引擎抓取数据,实现数据库的同步更新。

实现方式是以域名为索引,在无数据库及时更新的情况下依然可以抓取相应的数据。3.通过访问代理。实现方式是将一个http服务器作为一个代理服务器,访问一个公网地址,无需任何的数据库更新,即可访问任意长度的数据库,本质上和个人博客等访问域名解析类似,不同点在于需要在http服务器中添加header类,在发送请求时传递给header类中的域名,实现数据源源不断的提供给爬虫。

(注意:这里的代理服务器使用http2来提供代理服务,暂时还不太稳定)抓取效果云爬虫可以使用一些抓取工具即可实现抓取效果,目前主要有如下几种方式:1.模拟浏览器访问:将一个公网ip作为http服务器可以抓取大量静态页面。2.访问代理:直接通过http2去模拟http服务器去抓取静态页面,同时也可以使用代理池。

3.数据库及时更新抓取:使用数据库接口,当抓取比较频繁时,数据库数据及时更新,增加了抓取频率。4.post、get、put等方式,或通过改变http头等方式,使数据抓取效率变高。优缺点比较:综合比较下模拟浏览器,爬虫的效率是1-->2-->3,而代理、数据库和post、get方式,数据抓取效率提高的倍数。机器不太大,爬虫能够抓取的数据量还不太大的情况下还是用模拟浏览器的方式来抓取。

网页抓取数据的话,我们大致可以分为下面三种

网站优化 • 优采云 发表了文章 • 0 个评论 • 114 次浏览 • 2022-07-18 01:07

网页抓取数据的话,我们大致可以分为下面三种:1.网页端抓取,也就是用浏览器抓取下来后,保存到html文件2.浏览器端抓取-拼接抓取到数据,并且预览到网页端(firefox)3.浏览器端抓取-将抓取的数据发送到服务器,后台清洗,将无用信息去除,生成结构化的数据。第一步,推荐使用requests库,使用它最关键的是找到headers对象,也就是我们说的头部,在headers对象上找到"user-agent"对象,这个对象里有一个对象“headers":可以看到,每个请求头都会带上该headers对象,头部对象是不能更改的,所以用户可以很方便的决定请求内容:例如"post"请求提交了什么信息,"put"提交了什么信息,"data"将转换数据,"pat"将接受数据,"post-cookie"代表接受用户提交的信息。

这里解释一下用户提交信息、接受到的数据、转换后的数据是如何保存在电脑本地的。例如:post提交信息→我们的html页面→浏览器查看→查看数据结构→保存信息→发送到服务器→服务器查看→接受数据→通过一个get方法向数据库发送请求→...第二步,推荐postman。1.这个程序大致不需要任何编程知识,只需要会基本的http请求,请求headers等即可。

2.它可以通过编写headers对象,处理请求,并且有一个很好的单元测试,例如它可以生成http2和http1类型的所有的请求信息。3.最好的是当你会html语言,例如xmlhttprequest。第三步,重点讲解web服务器端的处理和分析。1.http方面,当你用postman提交了你的请求,服务器需要清除所有请求,只保留headers对象,并且调用reset()方法,把headers对象中的一些规则清除掉,包括headers的头部内容(包括user-agent这些值)。

这些headers通常包括:cookie-web登录或注册的用户的登录表单上的一些内容(我们拿出来进行简单的说明)2.浏览器方面,大致如下:在浏览器上可以打开和修改http3的浏览器(如user-agent网站进行安全验证,也叫referer),浏览器通过这些http3的浏览器对服务器进行请求,从服务器拿到结构化数据(参考@董潘大神在数据的真相@rednaxelafx答案)。

在浏览器上可以修改http4的浏览器(referer),浏览器通过这些http4的浏览器对服务器进行请求,拿到结构化数据。3.在后台方面,大致如下:在后台使用res.cookie,把http3的headers对象转换为cookie值,再用于请求服务器,从而拿到cookie值,放在服务器存储。4.数据库方面,可以在oracle,mysql等数据库上引入相应的功能,用于规划用户请求与数据库间的交互。 查看全部

网页抓取数据的话,我们大致可以分为下面三种

网页抓取数据的话,我们大致可以分为下面三种:1.网页端抓取,也就是用浏览器抓取下来后,保存到html文件2.浏览器端抓取-拼接抓取到数据,并且预览到网页端(firefox)3.浏览器端抓取-将抓取的数据发送到服务器,后台清洗,将无用信息去除,生成结构化的数据。第一步,推荐使用requests库,使用它最关键的是找到headers对象,也就是我们说的头部,在headers对象上找到"user-agent"对象,这个对象里有一个对象“headers":可以看到,每个请求头都会带上该headers对象,头部对象是不能更改的,所以用户可以很方便的决定请求内容:例如"post"请求提交了什么信息,"put"提交了什么信息,"data"将转换数据,"pat"将接受数据,"post-cookie"代表接受用户提交的信息。

这里解释一下用户提交信息、接受到的数据、转换后的数据是如何保存在电脑本地的。例如:post提交信息→我们的html页面→浏览器查看→查看数据结构→保存信息→发送到服务器→服务器查看→接受数据→通过一个get方法向数据库发送请求→...第二步,推荐postman。1.这个程序大致不需要任何编程知识,只需要会基本的http请求,请求headers等即可。

2.它可以通过编写headers对象,处理请求,并且有一个很好的单元测试,例如它可以生成http2和http1类型的所有的请求信息。3.最好的是当你会html语言,例如xmlhttprequest。第三步,重点讲解web服务器端的处理和分析。1.http方面,当你用postman提交了你的请求,服务器需要清除所有请求,只保留headers对象,并且调用reset()方法,把headers对象中的一些规则清除掉,包括headers的头部内容(包括user-agent这些值)。

这些headers通常包括:cookie-web登录或注册的用户的登录表单上的一些内容(我们拿出来进行简单的说明)2.浏览器方面,大致如下:在浏览器上可以打开和修改http3的浏览器(如user-agent网站进行安全验证,也叫referer),浏览器通过这些http3的浏览器对服务器进行请求,从服务器拿到结构化数据(参考@董潘大神在数据的真相@rednaxelafx答案)。

在浏览器上可以修改http4的浏览器(referer),浏览器通过这些http4的浏览器对服务器进行请求,拿到结构化数据。3.在后台方面,大致如下:在后台使用res.cookie,把http3的headers对象转换为cookie值,再用于请求服务器,从而拿到cookie值,放在服务器存储。4.数据库方面,可以在oracle,mysql等数据库上引入相应的功能,用于规划用户请求与数据库间的交互。

利用网页抓取数据赚钱的3个思路

网站优化 • 优采云 发表了文章 • 0 个评论 • 469 次浏览 • 2022-06-18 03:51

在大数据时代,如何有效获取数据已成为驱动业务决策的关键技能。分析市场趋势,监视竞争对手等都需要进行数据采集。而网页抓取则是数据采集的主要方法之一。

在本文中,Christopher Zita将和大家展示 3 种利用网络抓取赚钱的方法,全程只需几个小时就能学会,所用代码不到 50 行。

用自动程序花最少的钱住最好的酒店

自动程序可用于执行特定的操作,你可以将其出售给没有技术能力的人以获取收益。

为了展示如何创建和出售自动程序,Christopher Zita创建了一个Airbnb自动抓取程序。该程序允许用户输入位置,它将抓取Airbnb在该位置提供的所有房屋数据,包括价格、等级、允许入驻的客人数量等。所有的这些都是通过抓取Airbnb上的数据来完成的。

为了演示程序的实际运行,Christopher Zita在程序中输入了罗马,然后在几秒钟内获得了 272 个Airbnb的相关数据:

现在,查看所有房屋数据变得非常简单,过滤起来也容易得多。以Christopher Zita家为例,他们家有四口人,如果要去罗马,会在Airbnb上寻找价格合理且至少有 2 张床的酒店。而在得到这个表格中的数据后,excel可以非常轻松地进行过滤。从这 272 个结果中,找到了 7 个满足要求的酒店。

在这 7 家酒店中,Christopher Zita选择了梵蒂冈圣彼得丹尼尔酒店。因为通过数据对比,可以看出,这家酒店评级很高,并且是 7 家酒店中最便宜的,每晚收费仅 61 美元。选择所需链接之后,只需复制这个链接到浏览器中然后预订即可。

外出旅游度假时,寻找酒店是一项艰巨的任务。为此,有人愿意通过付费来简化这一过程。有了这个自动程序,你只需要 5 分钟就能以低廉的价格预订到让你满意的房间。

抓取特定商品价格数据,最低价时买入

网页抓取最常见的用途之一就是从网站上获得价格。通过创建程序抓取特定产品的价格数据,当价格下降到一定程度时,它会在产品售罄之前自动购买该产品。

接下来,Christopher Zita将向大家展示一个可以为大家节省很多钱同时还能赚钱的方法:

每个电商网站都会有限量特价商品,它们会显示商品的原始价格和打折后的价格,但一般不会显示在原价的基础上打了多少折扣。

例如,一只手表最初的价格为 350 美元,而促销价格为 300 美元,你可能会认为 50 美元的折扣是一笔不小的数目,但实际上只有14.2%的折扣。而如果一件T恤最初的价格为 50 美元,而销售价格为 40 美元,你会觉得没便宜多少,但实际上它的折扣率比手表高出20%。因此,可以通过购买折扣率最高的产品来省钱/赚钱。

下面以百货商店Hudson's'Bay为例,来进行数据抓取实验,通过获取所有商品的原始价格和折扣价格,来找出折扣率最高的商品。

抓取网站数据后,获得了 900 多种商品的数据,其中只有Perry Ellis纯色衬衫这 1 种商品的折扣率在50%以上。

由于是限时优惠,这件衬衫的价格很快将涨回 90 美元左右。因此,如果现在以 40 美元的价格购买它,并在限时优惠结束后以 60 美元的价格卖出,仍然可以赚 20 美元。

这是一种方法,如果你找到合适的利基市场,就有可能赚很多钱。

抓取公示数据,将其可视化

网络上有数百万个可供所有人免费使用的数据集,这些数据通常很容易收集。当然,还有一些数据不容易获得,且需要花费大量的时间将其可视化,销售数据就是这样演变而来。像天眼查、企查查这类的公司就是通过专注获取企业工商变更信息并将可视化,然后通过“购买会员可查”的形式销售给用户。

类似模式的还有这家体育数据网站BigDataBall,通过出售球员各项比赛数据以及其他统计信息,该网站一个赛季向用户收取 30 美元。他们定这个价并不是因为他们网站有这个数据,而是他们抓取数据后,将这些数据整理分类,然后以易于阅读且清晰的结构展示这些数据。

现在,Christopher Zita要做的是免费获取和BigDataBall相同的数据,然后将其放入结构化数据集中。BigDataBall并不是唯一拥有这些数据的网站,拥有相同的数据,然而该网站没有将数据结构化,用户难以过滤并下载所需的数据集。Christopher Zita利用网页抓取工具,抓取了网页中的所有球员数据。

所有NBA球员日志的结构化数据集

目前为止,他已经获得了本赛季超过 16000 个球员日志。通过网络抓取,在几分钟之内Christopher Zita获得了这些数据并节省了 30 美元。

当然,Christopher Zita也可以像BigDataBall一样利用网页抓取工具查找难以手动获取的数据,让计算机完成工作,然后将数据可视化并出售给对这些数据感兴趣的人。

总结

现如今,网页抓取已经成为一种非常独特且新颖的赚钱方式。如果在适当的情况下应用它,你可以很容易赚到钱。

---END---

往期精彩文章

点亮“在看”吧! 查看全部

利用网页抓取数据赚钱的3个思路

在大数据时代,如何有效获取数据已成为驱动业务决策的关键技能。分析市场趋势,监视竞争对手等都需要进行数据采集。而网页抓取则是数据采集的主要方法之一。

在本文中,Christopher Zita将和大家展示 3 种利用网络抓取赚钱的方法,全程只需几个小时就能学会,所用代码不到 50 行。

用自动程序花最少的钱住最好的酒店

自动程序可用于执行特定的操作,你可以将其出售给没有技术能力的人以获取收益。

为了展示如何创建和出售自动程序,Christopher Zita创建了一个Airbnb自动抓取程序。该程序允许用户输入位置,它将抓取Airbnb在该位置提供的所有房屋数据,包括价格、等级、允许入驻的客人数量等。所有的这些都是通过抓取Airbnb上的数据来完成的。

为了演示程序的实际运行,Christopher Zita在程序中输入了罗马,然后在几秒钟内获得了 272 个Airbnb的相关数据:

现在,查看所有房屋数据变得非常简单,过滤起来也容易得多。以Christopher Zita家为例,他们家有四口人,如果要去罗马,会在Airbnb上寻找价格合理且至少有 2 张床的酒店。而在得到这个表格中的数据后,excel可以非常轻松地进行过滤。从这 272 个结果中,找到了 7 个满足要求的酒店。

在这 7 家酒店中,Christopher Zita选择了梵蒂冈圣彼得丹尼尔酒店。因为通过数据对比,可以看出,这家酒店评级很高,并且是 7 家酒店中最便宜的,每晚收费仅 61 美元。选择所需链接之后,只需复制这个链接到浏览器中然后预订即可。

外出旅游度假时,寻找酒店是一项艰巨的任务。为此,有人愿意通过付费来简化这一过程。有了这个自动程序,你只需要 5 分钟就能以低廉的价格预订到让你满意的房间。

抓取特定商品价格数据,最低价时买入

网页抓取最常见的用途之一就是从网站上获得价格。通过创建程序抓取特定产品的价格数据,当价格下降到一定程度时,它会在产品售罄之前自动购买该产品。

接下来,Christopher Zita将向大家展示一个可以为大家节省很多钱同时还能赚钱的方法:

每个电商网站都会有限量特价商品,它们会显示商品的原始价格和打折后的价格,但一般不会显示在原价的基础上打了多少折扣。

例如,一只手表最初的价格为 350 美元,而促销价格为 300 美元,你可能会认为 50 美元的折扣是一笔不小的数目,但实际上只有14.2%的折扣。而如果一件T恤最初的价格为 50 美元,而销售价格为 40 美元,你会觉得没便宜多少,但实际上它的折扣率比手表高出20%。因此,可以通过购买折扣率最高的产品来省钱/赚钱。

下面以百货商店Hudson's'Bay为例,来进行数据抓取实验,通过获取所有商品的原始价格和折扣价格,来找出折扣率最高的商品。

抓取网站数据后,获得了 900 多种商品的数据,其中只有Perry Ellis纯色衬衫这 1 种商品的折扣率在50%以上。

由于是限时优惠,这件衬衫的价格很快将涨回 90 美元左右。因此,如果现在以 40 美元的价格购买它,并在限时优惠结束后以 60 美元的价格卖出,仍然可以赚 20 美元。

这是一种方法,如果你找到合适的利基市场,就有可能赚很多钱。

抓取公示数据,将其可视化

网络上有数百万个可供所有人免费使用的数据集,这些数据通常很容易收集。当然,还有一些数据不容易获得,且需要花费大量的时间将其可视化,销售数据就是这样演变而来。像天眼查、企查查这类的公司就是通过专注获取企业工商变更信息并将可视化,然后通过“购买会员可查”的形式销售给用户。

类似模式的还有这家体育数据网站BigDataBall,通过出售球员各项比赛数据以及其他统计信息,该网站一个赛季向用户收取 30 美元。他们定这个价并不是因为他们网站有这个数据,而是他们抓取数据后,将这些数据整理分类,然后以易于阅读且清晰的结构展示这些数据。

现在,Christopher Zita要做的是免费获取和BigDataBall相同的数据,然后将其放入结构化数据集中。BigDataBall并不是唯一拥有这些数据的网站,拥有相同的数据,然而该网站没有将数据结构化,用户难以过滤并下载所需的数据集。Christopher Zita利用网页抓取工具,抓取了网页中的所有球员数据。

所有NBA球员日志的结构化数据集

目前为止,他已经获得了本赛季超过 16000 个球员日志。通过网络抓取,在几分钟之内Christopher Zita获得了这些数据并节省了 30 美元。

当然,Christopher Zita也可以像BigDataBall一样利用网页抓取工具查找难以手动获取的数据,让计算机完成工作,然后将数据可视化并出售给对这些数据感兴趣的人。

总结

现如今,网页抓取已经成为一种非常独特且新颖的赚钱方式。如果在适当的情况下应用它,你可以很容易赚到钱。

---END---

往期精彩文章

点亮“在看”吧!

从千亿页面上提取数据所总结的五大经验!

网站优化 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2022-06-18 03:50

如今从网上抓取数据看似非常容易。有许多开源库和框架、可视化抓取工具和数据提取工具,可以很容易地从一个网站上抓取数据。但是,当你想大规模地搜索网站时,很快就会感觉到非常棘手。

本文中,我们将与你分享自2010年以来借助Scrapinghub从一千亿个产品页面上抓取数据时所学到的经验教训,让你深入了解从电子商务店铺大规模提取产品数据时面临的挑战,并与你分享一些应对这些挑战的最佳实践经验。

Scrapinghub成立于2010年,是数据提取公司中的佼佼者之一,也是Scrapy的缔造者——Scrapy是当今最强大、最受欢迎的网络抓取框架。目前,Scrapinghub为全球众多的大型电子商务公司每月抓取超过80亿的页面(其中30亿是产品页面)。

大规模抓取网页的要点

与标准的抓取网页应用程序不同,大规模抓取电子商务的产品数据将面临一系列独特的挑战,这使得网页抓取异常艰难。

从本质上来说,这些困难可以归结为两个方面:速度和数据质量。

通常时间是一个限制性约束,因此大规模抓取需要网络爬虫以非常高的速度抓取页面,并不会影响数据质量。这种对速度的要求造成大量抓取产品数据富有非常大的挑战性。

挑战1:杂乱且变幻无常的网页格式

杂乱且变化无常的网页格式可能是最常见的挑战,也可能不是最令人感兴趣的挑战,但它是迄今为止大规模提取数据时面临的最大挑战。这项挑战的关键不在于复杂性,而是需要花费大量时间和资源去处理。

如果你有过创建电子商务店铺爬虫经历的话,你就会知道电子商务店铺代码的杂乱无章是普遍现象。这不仅仅是HTML的格式或偶尔的字符编码问题。多年来,我们遇到了各种各样的问题,例如滥用HTTP响应代码、不完整的JavaScripts,或滥用Ajax:

如此杂乱的代码会让编写爬虫工作十分痛苦,且无法使用抓取工具或自动提取工具。

在大规模抓取网页时,你不仅需要浏览几百个像这样杂乱的网站,还要处理网站的不断更新。一个经验法则是:每2-3个月目标网站的变动就会废掉你的爬虫。

可能听起来不是什么大不了的事儿,但是当你大规模抓取时,这些意外会积累成灾。例如,Scrapinghub的一个大型电子商务项目大约有4000个爬虫,需要抓取1000个电子商务网站,这意味着每天他们都有20-30只爬虫遭遇失败。

来自区域和多语言网站布局的变动,A/B分割测试和包装/定价变动也会经常给爬虫带来问题。

没有捷径

很不幸的是,没有完全解决这些问题的灵丹妙药。很多时候,我们只能随着规模扩展投入更多资源。以上述项目为例,负责项目的团队共有18名爬虫工程师和3名专职QA,以确保客户始终拥有可靠的数据。

但是,凭借经验团队可以学会如何创建更强大的爬虫,以便检测和对付网站格式的各种怪招。

最佳做法不是为目标网站可能使用的所有布局逐一编写爬虫,而是仅凭一个产品提取的爬虫就可以处理不同页面布局所使用的所有可能规则和方案。爬虫拥有的配置越多越好。

虽然这些做法会让爬虫更加复杂(我们的一些爬虫长达几千行),但可以保证爬虫更加易于维护。

由于大多数公司需要每天都抽取产品数据,所以我们无法花费几天时间等待工程团队修改遭到破坏的爬虫。对于这种情况,Scrapinghub使用一种基于数据提取工具的机器学习,我们开发了这种机器学习模型作为后备,直到爬虫被修复。这种基于机器学习的提取工具可以自动识别目标网站的目标字段(产品名称、价格、货币、图像、SKU等等),并返回所需的结果。

挑战2:可扩展性架构

你将面临的下一个挑战是:构建一个爬虫基础架构,该架构可以随着每天请求数量的增加而扩展,而不会降低性能。

当大规模提取产品数据时,简单的网页爬虫只能连续地抓取数据,而不会节选。通常,一个连续的网页抓取会循环发送请求,一个接一个,每个请求需要2-3秒才能完成。

如果爬虫每天都请求量小于4万个的话(每2秒发送一个请求,意味着每天可以发送43,200个请求),这个方法还可以。但是,一旦请求数量超过这个数,你就需要切换到每天可以发送几百万请求且不会降低性能的爬虫架构。

正如上述讨论,速度是大规模抓取产品数据的关键。你需要确保在一定时间内(通常为一天)找到并抓取所有所需的产品页面。为此,你需要执行以下操作:

从产品提取中分离产品搜索

为了大规模提取产品数据,你需要从产品提取爬虫中分离产品搜索爬虫。

产品搜索爬虫的目标应该是找到目标产品种类(或“货架”),并保存该种类下产品的URL,以供产品提取爬虫使用。当产品搜索爬虫将产品URL加到队列后,产品提取爬虫会从茶品页面上抓取目标数据。

这项工作可以借助流行的爬虫工具的辅助,例如由Scrapinghub开发的开源爬虫工具Frontera等。虽然最初设计Frontera是为了用于Scrapy,但它完全没有限制,可以与任何其他爬虫框架或独立项目一起使用。在本文中,我们将分享如何使用Frontera大量挖掘HackerNews的数据。

为产品提取分配更多资源

由于每个产品类别“货架”可以包含10到100个产品,且与提取产品URL相比,提取产品数据需要更多资源,因此搜索爬虫的速度通常比产品抽取爬虫更快。对于这种情况,你需要为每个搜索爬虫配备多个抽取爬虫。经验法则是:每100,000页需要创建一直单独的抽取爬虫。

挑战3:维持吞吐量性能

大规模抓取很像赛车Formula 1,我们的目标是为了提高速度,尽可能地减轻车身重量,并从发动机中挤出最后一部分马力。对于大规模网络抓取也是如此。

在提取大量数据时,我们必须尽可能寻找可以将周期时间降到最小、并在现有硬件资源的基础上将爬虫性能提高到最大的方法。所有这些都必须减少每个请求的时间,哪怕是几毫秒。

为此,你的团队需要深入了解正在使用的网页抓取框架、代理管理和硬件,才能更好地调优,以获取最佳性能。你还需要关注:

爬虫效率

大规模抓取的时候,我们始终应该努力在尽可能少的请求次数内提取所需的确切数据。任何额外的请求或数据提取都会降低抓取网站的速度。在设计爬虫时,请记住以下几点:

挑战4:反机器人策略

在大规模抓取电子商务网站的时候,肯定会遇到使用反机器人策略的网站。

对于大多数小型网站来说,他们的反机器人策略非常基本(禁止IP提出超额请求)。然而,对于亚马逊等大型电子商务网站说,他们会使用非常成熟的反机器人策略,例如Distil Networks、Incapsula或Akamai等,这会让提取数据变得更加困难。

代理

请记住,对于大规模抓取产品数据的项目来说,最重要的要求是使用代理IP。在大规模抓取时,你需要一个相当大的代理列表,并且需要实现必要的IP轮换、请求限制、会话管理和黑名单逻辑,以防止代理被封杀。

除非你有一个庞大的队伍管理代理,否则你应该将这部分抓取工作外包出去。外面有大量代理服务可以提供各种级别的服务。

但是,我们建议你可以与代理商合作,让他们为代理配置提供单个端点并隐藏管理代理的复杂性。大规模抓取非常耗资源,更不用想需要通过开发和维护建立自己内部的代理管理基础设施了。

大多数大型电子商务公司都采用这种方法。许多世界上最大的电子商务公司都是用Scrapinghub开发的智能下载器Crawlera,将代理管理全权外包。如果你的抓取工具每天需要发出两千万个请求的话,相较于代理管理,专注于抓住会更有意义。

超越代理

不幸的是,仅使用代理服务还不足以确保可以规避大型电子商务网站的反机器人策略。越来越多的网站开始使用成熟的反机器人策略,来监控爬虫行为,检测请求是否来自人类访问者。

这些反机器人策略不仅会给电子商务网站的抓取制造困难,而且如果处理不当,与它们的斗争还会严重影响爬虫的性能。

这些反机器人策略大多数都是用JavaScript来确定请求来自于爬虫还是人(JavaScript引擎检查、字体枚举、WebGL和Canvas等)。

但是如前所述,大规模抓取数据时,我们希望使用可编写脚本的没有头部的浏览器(如Splash或Puppeteer等),页面上的JavaScript渲染会给资源造成压力,并降低抓取网站的速度。

这意味着为了确保你的爬虫可以达到必要的吞吐量,从而提供每日的产品数据,通常你需要费尽心思对抗反网站上使用的机器人策略,并设计爬虫在不使用没有头部的浏览器的情况下也可以战胜它们。

挑战5:数据质量

从数据科学家的角度来看,网页抓取项目最重要的考虑因素是提取的数据质量。大规模抓取更加关注数据的质量。

如果每天需要提取几百万个数据点,那么手工验证所有数据是否干净完整是不可能的。一个不小心脏数据或不完整的数据就会进入数据源,并破坏数据分析工作。

当店铺有多个版本(不同语言、地区等)或从不同店铺抓取数据时,数据质量尤为重要。

除了仔细的QA流程外,创建爬虫的设计阶段,通过互相审查和测试爬虫的代码可以确保以最可靠的方式提取所需的数据。确保数据高质量的最佳方法是开发自动化QA监视系统。

作为数据提取项目的一部分,你需要计划和开发一个监控系统,来提醒你数据上出现的不一致和爬虫错误。在Scrapinghub,我们开发了机器学习算法用于检测:

总结

如你所见,大规模抓取产品数据需要面临一系列独特的挑战。希望这篇文章可以让你更加了解这些挑战以及如何解决这些挑战。

在Scrapinghub,我们专注于将非结构化Web数据转换为结构化数据。如果你对本文有任何想法,请在下面留言。

原文: 查看全部

从千亿页面上提取数据所总结的五大经验!

如今从网上抓取数据看似非常容易。有许多开源库和框架、可视化抓取工具和数据提取工具,可以很容易地从一个网站上抓取数据。但是,当你想大规模地搜索网站时,很快就会感觉到非常棘手。

本文中,我们将与你分享自2010年以来借助Scrapinghub从一千亿个产品页面上抓取数据时所学到的经验教训,让你深入了解从电子商务店铺大规模提取产品数据时面临的挑战,并与你分享一些应对这些挑战的最佳实践经验。

Scrapinghub成立于2010年,是数据提取公司中的佼佼者之一,也是Scrapy的缔造者——Scrapy是当今最强大、最受欢迎的网络抓取框架。目前,Scrapinghub为全球众多的大型电子商务公司每月抓取超过80亿的页面(其中30亿是产品页面)。

大规模抓取网页的要点

与标准的抓取网页应用程序不同,大规模抓取电子商务的产品数据将面临一系列独特的挑战,这使得网页抓取异常艰难。

从本质上来说,这些困难可以归结为两个方面:速度和数据质量。

通常时间是一个限制性约束,因此大规模抓取需要网络爬虫以非常高的速度抓取页面,并不会影响数据质量。这种对速度的要求造成大量抓取产品数据富有非常大的挑战性。

挑战1:杂乱且变幻无常的网页格式

杂乱且变化无常的网页格式可能是最常见的挑战,也可能不是最令人感兴趣的挑战,但它是迄今为止大规模提取数据时面临的最大挑战。这项挑战的关键不在于复杂性,而是需要花费大量时间和资源去处理。

如果你有过创建电子商务店铺爬虫经历的话,你就会知道电子商务店铺代码的杂乱无章是普遍现象。这不仅仅是HTML的格式或偶尔的字符编码问题。多年来,我们遇到了各种各样的问题,例如滥用HTTP响应代码、不完整的JavaScripts,或滥用Ajax:

如此杂乱的代码会让编写爬虫工作十分痛苦,且无法使用抓取工具或自动提取工具。

在大规模抓取网页时,你不仅需要浏览几百个像这样杂乱的网站,还要处理网站的不断更新。一个经验法则是:每2-3个月目标网站的变动就会废掉你的爬虫。

可能听起来不是什么大不了的事儿,但是当你大规模抓取时,这些意外会积累成灾。例如,Scrapinghub的一个大型电子商务项目大约有4000个爬虫,需要抓取1000个电子商务网站,这意味着每天他们都有20-30只爬虫遭遇失败。

来自区域和多语言网站布局的变动,A/B分割测试和包装/定价变动也会经常给爬虫带来问题。

没有捷径

很不幸的是,没有完全解决这些问题的灵丹妙药。很多时候,我们只能随着规模扩展投入更多资源。以上述项目为例,负责项目的团队共有18名爬虫工程师和3名专职QA,以确保客户始终拥有可靠的数据。

但是,凭借经验团队可以学会如何创建更强大的爬虫,以便检测和对付网站格式的各种怪招。

最佳做法不是为目标网站可能使用的所有布局逐一编写爬虫,而是仅凭一个产品提取的爬虫就可以处理不同页面布局所使用的所有可能规则和方案。爬虫拥有的配置越多越好。

虽然这些做法会让爬虫更加复杂(我们的一些爬虫长达几千行),但可以保证爬虫更加易于维护。

由于大多数公司需要每天都抽取产品数据,所以我们无法花费几天时间等待工程团队修改遭到破坏的爬虫。对于这种情况,Scrapinghub使用一种基于数据提取工具的机器学习,我们开发了这种机器学习模型作为后备,直到爬虫被修复。这种基于机器学习的提取工具可以自动识别目标网站的目标字段(产品名称、价格、货币、图像、SKU等等),并返回所需的结果。

挑战2:可扩展性架构

你将面临的下一个挑战是:构建一个爬虫基础架构,该架构可以随着每天请求数量的增加而扩展,而不会降低性能。

当大规模提取产品数据时,简单的网页爬虫只能连续地抓取数据,而不会节选。通常,一个连续的网页抓取会循环发送请求,一个接一个,每个请求需要2-3秒才能完成。

如果爬虫每天都请求量小于4万个的话(每2秒发送一个请求,意味着每天可以发送43,200个请求),这个方法还可以。但是,一旦请求数量超过这个数,你就需要切换到每天可以发送几百万请求且不会降低性能的爬虫架构。

正如上述讨论,速度是大规模抓取产品数据的关键。你需要确保在一定时间内(通常为一天)找到并抓取所有所需的产品页面。为此,你需要执行以下操作:

从产品提取中分离产品搜索

为了大规模提取产品数据,你需要从产品提取爬虫中分离产品搜索爬虫。

产品搜索爬虫的目标应该是找到目标产品种类(或“货架”),并保存该种类下产品的URL,以供产品提取爬虫使用。当产品搜索爬虫将产品URL加到队列后,产品提取爬虫会从茶品页面上抓取目标数据。

这项工作可以借助流行的爬虫工具的辅助,例如由Scrapinghub开发的开源爬虫工具Frontera等。虽然最初设计Frontera是为了用于Scrapy,但它完全没有限制,可以与任何其他爬虫框架或独立项目一起使用。在本文中,我们将分享如何使用Frontera大量挖掘HackerNews的数据。

为产品提取分配更多资源

由于每个产品类别“货架”可以包含10到100个产品,且与提取产品URL相比,提取产品数据需要更多资源,因此搜索爬虫的速度通常比产品抽取爬虫更快。对于这种情况,你需要为每个搜索爬虫配备多个抽取爬虫。经验法则是:每100,000页需要创建一直单独的抽取爬虫。

挑战3:维持吞吐量性能

大规模抓取很像赛车Formula 1,我们的目标是为了提高速度,尽可能地减轻车身重量,并从发动机中挤出最后一部分马力。对于大规模网络抓取也是如此。

在提取大量数据时,我们必须尽可能寻找可以将周期时间降到最小、并在现有硬件资源的基础上将爬虫性能提高到最大的方法。所有这些都必须减少每个请求的时间,哪怕是几毫秒。

为此,你的团队需要深入了解正在使用的网页抓取框架、代理管理和硬件,才能更好地调优,以获取最佳性能。你还需要关注:

爬虫效率

大规模抓取的时候,我们始终应该努力在尽可能少的请求次数内提取所需的确切数据。任何额外的请求或数据提取都会降低抓取网站的速度。在设计爬虫时,请记住以下几点:

挑战4:反机器人策略

在大规模抓取电子商务网站的时候,肯定会遇到使用反机器人策略的网站。

对于大多数小型网站来说,他们的反机器人策略非常基本(禁止IP提出超额请求)。然而,对于亚马逊等大型电子商务网站说,他们会使用非常成熟的反机器人策略,例如Distil Networks、Incapsula或Akamai等,这会让提取数据变得更加困难。

代理

请记住,对于大规模抓取产品数据的项目来说,最重要的要求是使用代理IP。在大规模抓取时,你需要一个相当大的代理列表,并且需要实现必要的IP轮换、请求限制、会话管理和黑名单逻辑,以防止代理被封杀。

除非你有一个庞大的队伍管理代理,否则你应该将这部分抓取工作外包出去。外面有大量代理服务可以提供各种级别的服务。

但是,我们建议你可以与代理商合作,让他们为代理配置提供单个端点并隐藏管理代理的复杂性。大规模抓取非常耗资源,更不用想需要通过开发和维护建立自己内部的代理管理基础设施了。

大多数大型电子商务公司都采用这种方法。许多世界上最大的电子商务公司都是用Scrapinghub开发的智能下载器Crawlera,将代理管理全权外包。如果你的抓取工具每天需要发出两千万个请求的话,相较于代理管理,专注于抓住会更有意义。

超越代理

不幸的是,仅使用代理服务还不足以确保可以规避大型电子商务网站的反机器人策略。越来越多的网站开始使用成熟的反机器人策略,来监控爬虫行为,检测请求是否来自人类访问者。

这些反机器人策略不仅会给电子商务网站的抓取制造困难,而且如果处理不当,与它们的斗争还会严重影响爬虫的性能。

这些反机器人策略大多数都是用JavaScript来确定请求来自于爬虫还是人(JavaScript引擎检查、字体枚举、WebGL和Canvas等)。

但是如前所述,大规模抓取数据时,我们希望使用可编写脚本的没有头部的浏览器(如Splash或Puppeteer等),页面上的JavaScript渲染会给资源造成压力,并降低抓取网站的速度。

这意味着为了确保你的爬虫可以达到必要的吞吐量,从而提供每日的产品数据,通常你需要费尽心思对抗反网站上使用的机器人策略,并设计爬虫在不使用没有头部的浏览器的情况下也可以战胜它们。

挑战5:数据质量

从数据科学家的角度来看,网页抓取项目最重要的考虑因素是提取的数据质量。大规模抓取更加关注数据的质量。

如果每天需要提取几百万个数据点,那么手工验证所有数据是否干净完整是不可能的。一个不小心脏数据或不完整的数据就会进入数据源,并破坏数据分析工作。

当店铺有多个版本(不同语言、地区等)或从不同店铺抓取数据时,数据质量尤为重要。

除了仔细的QA流程外,创建爬虫的设计阶段,通过互相审查和测试爬虫的代码可以确保以最可靠的方式提取所需的数据。确保数据高质量的最佳方法是开发自动化QA监视系统。

作为数据提取项目的一部分,你需要计划和开发一个监控系统,来提醒你数据上出现的不一致和爬虫错误。在Scrapinghub,我们开发了机器学习算法用于检测:

总结

如你所见,大规模抓取产品数据需要面临一系列独特的挑战。希望这篇文章可以让你更加了解这些挑战以及如何解决这些挑战。

在Scrapinghub,我们专注于将非结构化Web数据转换为结构化数据。如果你对本文有任何想法,请在下面留言。

原文:

网页抓取数据都是采用.js自身提供的一个webworker线程来完成的

网站优化 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2022-06-17 07:00

网页抓取数据都是采用node.js自身提供的一个webworker线程来完成的。爬虫服务器和网页爬虫客户端都没有webworker,于是给爬虫引发了很多麻烦,比如:文件传输慢——没有webworker,所有数据最终都要传到网页服务器。于是我们需要了解一下node.js有哪些webworker:index.phpimportnodeworker()worker=node.createworkerwrapper()index.php这段代码就是创建worker程序worker,而它的主体内容是php代码,下面就简单说一下php代码的规范和用法。

php对于webworker的用法规范是:include头一个字段必须定义workerworker_timeout=10000000defaultworker_record_path=php_path_rulesattributes=(default,attributes)attributes=((default,attributes))这里我们假设所有静态文件都在同一个目录下,php所有静态文件不共享。

但是这个假设不是必须,通常情况是要定义defaultindex.php中定义所有文件不共享,default代表index.php文件包含文件的默认路径,而default是index.php中本身定义的内容。在require('/php')前面我们调用co.js('/php')方法,这个方法用来定义多个静态文件。

如果你为静态文件定义了index.php文件,那么require('/api/default')就不对了,这个时候require('/api/default')就对了。因为require是把所有静态文件先放进php库,需要访问api就要访问php.js文件,这样会导致数据传输很慢。php对于webworker的定义是:require('co.js')worker()worker_create()php对于webworker的定义是:include头一个字段必须定义worker这一块是不定义静态文件的,没有对静态文件定义index.php也就对了。

default_worker_record_path=php_path_rulesattributes=(default,attributes)attributes=((default,attributes))default_worker_record_path.._worker_record_path这个定义有点长,必须要分为两部分来说:一个是必须的静态文件目录,另一个是不定义的动态文件。

静态文件必须定义api.js,后面我们用定义静态文件举例子,动态文件是动态定义的api.js,这就完成了定义静态文件的功能。default_worker_record_path.._worker_record_path.default_worker_record_path._worker_record_path有个参数是动态文件路径,我们定义。 查看全部

网页抓取数据都是采用.js自身提供的一个webworker线程来完成的

网页抓取数据都是采用node.js自身提供的一个webworker线程来完成的。爬虫服务器和网页爬虫客户端都没有webworker,于是给爬虫引发了很多麻烦,比如:文件传输慢——没有webworker,所有数据最终都要传到网页服务器。于是我们需要了解一下node.js有哪些webworker:index.phpimportnodeworker()worker=node.createworkerwrapper()index.php这段代码就是创建worker程序worker,而它的主体内容是php代码,下面就简单说一下php代码的规范和用法。

php对于webworker的用法规范是:include头一个字段必须定义workerworker_timeout=10000000defaultworker_record_path=php_path_rulesattributes=(default,attributes)attributes=((default,attributes))这里我们假设所有静态文件都在同一个目录下,php所有静态文件不共享。

但是这个假设不是必须,通常情况是要定义defaultindex.php中定义所有文件不共享,default代表index.php文件包含文件的默认路径,而default是index.php中本身定义的内容。在require('/php')前面我们调用co.js('/php')方法,这个方法用来定义多个静态文件。

如果你为静态文件定义了index.php文件,那么require('/api/default')就不对了,这个时候require('/api/default')就对了。因为require是把所有静态文件先放进php库,需要访问api就要访问php.js文件,这样会导致数据传输很慢。php对于webworker的定义是:require('co.js')worker()worker_create()php对于webworker的定义是:include头一个字段必须定义worker这一块是不定义静态文件的,没有对静态文件定义index.php也就对了。

default_worker_record_path=php_path_rulesattributes=(default,attributes)attributes=((default,attributes))default_worker_record_path.._worker_record_path这个定义有点长,必须要分为两部分来说:一个是必须的静态文件目录,另一个是不定义的动态文件。

静态文件必须定义api.js,后面我们用定义静态文件举例子,动态文件是动态定义的api.js,这就完成了定义静态文件的功能。default_worker_record_path.._worker_record_path.default_worker_record_path._worker_record_path有个参数是动态文件路径,我们定义。

【数据】数据获取及网站分享

网站优化 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2022-06-07 02:40

对于数据的获取很大一部分是要重于对于ArcGis软件的操作,尤其是在学校学习才刚刚上手的小白同学,没有开始工作提供相关数据仅仅是需要你进行数据处理。

当然,也有一部分工作了的小伙伴出于对GIS软件操作以及空间数据分析的热爱,会远超对于工作数据的需求,数据的重要性也远胜于软件的操作。说了这么多,如何获取数据——方法是多种多样的且对于数据的定义理解也是不同的,数据是可以互相转换的,也是可以相互对立的,既可以是尘封的数据,也可以是实时动态的数据,关于此我们不做对数据的定义,而仅仅是提供一些简单的(栅格(DEM、遥感、卫星等),矢量(opi、shp、osm等),电子数据(excel、svc等))数据获取网站及如何获取的一些方法。以上,数据的定义以及数据为何物进入正题数据获取网站:

1、

(osm数据)

如何获取、如何使用?具体可参考此文:。

2、地理数据空间云:(DEM、卫星、遥感等专题数据以及行政矢量数据)

如何获取、如何使用?具体可参考此一系列文章:

3、Map下载器(一系列不同源数据的MAP下载器)

如何安装、如何使用?具体可参考此一系列文章:

、

。

4、Natural Earth Dat:网站打开如图1-1所示,为网站门户页面。Natural Earth Data提供全球范围内的矢量和影像数据。Natural Earth Data的最大优势是数据开放性,用户有对数据传播和编辑的权限。图1-1:

5、国家卫星气象中心

如图1-2所示,为国家卫星气象中心的网站门户界面。一些数据标准、数据使用是关键。图1-2:

6、国家地球系统科学数据共享服务平台

如图1-3所示,为国家地球系统科学数据共享服务平台的网站门户界面。网站提供的专题数据既是好的数据资料也是数据制图的高质量参考模板。图1-3:

7、美国地质调查局国家地图网站

如图1-4所示,为美国地质调查局国家地图的网站门户界面。图1-4:

8、资源环境数据云平台(中国科学院地理科学与资源研究所)

如图1-5所示,为资源环境数据云平台的网站门户界面。提供的数据见图大概就可以看出多是关于资源类的数网站,对于植被、土地、水资源等的研究可获得相应的基础数据。另外,里面有很多展示的专题数据,免费或不免费都可以查看并对其制作的视觉感受做一个个人的理解并吸收以期自己的以后的制图成果更加完美。也是一个宝藏网站,强烈建议多打开学习……图1-5:

另外,对于此类国家级的数据网站,在其底部都会有一些相应的对应数据研究国家级网站。如图1-6所示,为资源环境数据云平台网站底部挂的其他数据网站,需要的小伙伴也可以看看。图1-6:

9、标准地图服务如何获取、如何使用?具体可参考此文章:

。

最后,数据的增加、分享是会不停的发生变化的,个人的阅历以及对所学的理解也是在由量到质的转变,此次分享的数据获取网站可能只是数据获取的冰山一角,希望各位小伙伴能够提供更多的相关数据网站,创造出更多的数据与软件操作的共鸣,一面有了数据的加持,一面又有了软件操作的历练,最终一定能够获取双赢实现良好的转化与互动。学习也不再是一件难并且枯燥的事了。如上9个网站、软件的数据下载不会是最全最完整的,但这是ArcGisdada个人使用的数据网站突破口,学会如何获取查找数据网站要强于如何从网站上获取数据,相信通过如上九个网站以及其底部链接你们会发现一个不同的数据世界。

END 查看全部

【数据】数据获取及网站分享

对于数据的获取很大一部分是要重于对于ArcGis软件的操作,尤其是在学校学习才刚刚上手的小白同学,没有开始工作提供相关数据仅仅是需要你进行数据处理。

当然,也有一部分工作了的小伙伴出于对GIS软件操作以及空间数据分析的热爱,会远超对于工作数据的需求,数据的重要性也远胜于软件的操作。说了这么多,如何获取数据——方法是多种多样的且对于数据的定义理解也是不同的,数据是可以互相转换的,也是可以相互对立的,既可以是尘封的数据,也可以是实时动态的数据,关于此我们不做对数据的定义,而仅仅是提供一些简单的(栅格(DEM、遥感、卫星等),矢量(opi、shp、osm等),电子数据(excel、svc等))数据获取网站及如何获取的一些方法。以上,数据的定义以及数据为何物进入正题数据获取网站:

1、

(osm数据)

如何获取、如何使用?具体可参考此文:。

2、地理数据空间云:(DEM、卫星、遥感等专题数据以及行政矢量数据)

如何获取、如何使用?具体可参考此一系列文章:

3、Map下载器(一系列不同源数据的MAP下载器)

如何安装、如何使用?具体可参考此一系列文章:

、

。

4、Natural Earth Dat:网站打开如图1-1所示,为网站门户页面。Natural Earth Data提供全球范围内的矢量和影像数据。Natural Earth Data的最大优势是数据开放性,用户有对数据传播和编辑的权限。图1-1:

5、国家卫星气象中心

如图1-2所示,为国家卫星气象中心的网站门户界面。一些数据标准、数据使用是关键。图1-2:

6、国家地球系统科学数据共享服务平台

如图1-3所示,为国家地球系统科学数据共享服务平台的网站门户界面。网站提供的专题数据既是好的数据资料也是数据制图的高质量参考模板。图1-3:

7、美国地质调查局国家地图网站

如图1-4所示,为美国地质调查局国家地图的网站门户界面。图1-4:

8、资源环境数据云平台(中国科学院地理科学与资源研究所)

如图1-5所示,为资源环境数据云平台的网站门户界面。提供的数据见图大概就可以看出多是关于资源类的数网站,对于植被、土地、水资源等的研究可获得相应的基础数据。另外,里面有很多展示的专题数据,免费或不免费都可以查看并对其制作的视觉感受做一个个人的理解并吸收以期自己的以后的制图成果更加完美。也是一个宝藏网站,强烈建议多打开学习……图1-5:

另外,对于此类国家级的数据网站,在其底部都会有一些相应的对应数据研究国家级网站。如图1-6所示,为资源环境数据云平台网站底部挂的其他数据网站,需要的小伙伴也可以看看。图1-6:

9、标准地图服务如何获取、如何使用?具体可参考此文章:

。

最后,数据的增加、分享是会不停的发生变化的,个人的阅历以及对所学的理解也是在由量到质的转变,此次分享的数据获取网站可能只是数据获取的冰山一角,希望各位小伙伴能够提供更多的相关数据网站,创造出更多的数据与软件操作的共鸣,一面有了数据的加持,一面又有了软件操作的历练,最终一定能够获取双赢实现良好的转化与互动。学习也不再是一件难并且枯燥的事了。如上9个网站、软件的数据下载不会是最全最完整的,但这是ArcGisdada个人使用的数据网站突破口,学会如何获取查找数据网站要强于如何从网站上获取数据,相信通过如上九个网站以及其底部链接你们会发现一个不同的数据世界。

END

通过scrapy命令行工具做网页分析

网站优化 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2022-04-30 01:00

前言

Scrapy是由python语言开发的一个快速、高效的web抓取框架,用于抓取web站点并从页面中提取结构化的数据,只需要实现少量的代码,就能够快速的抓取。它最吸引人的地方在于它是一个爬虫框架,任何人都可以根据自己的需求方便的修改。scrapy的创建和执行都需要在命令行下运行,也就意味着scrapy里面会有很多的命令需要在命令行下才能运行,今天我们就用过这些好用的命令,来对网址进行一下网页分析。

分析部分

命令:scrapy view

>>> scrapy view url地址

这个命令通过我们需要查看的网页,在命令下输入该网页的网址,scrapy会把这个网页自动保存成一个html并且会给我们自动打开呈现出来,现在有很多网页都是通过JavaScript的ajax加载的,所以我们经常请求后,显示不出我们需要的数据内容,我们可以通过view这个命令来查看网页内是否存在我们需要的数据。

从图中可以看出,通过view命令在加上网址,及能直接跳转到这个网页,这个网页里面显示的是什么内容,也就是网页能给我们请求返回什么响应的内容。

上图这个就是网页没有给我显示很多数据内容,这样就可以判断该网页是通过AJAX加载的,所以直接请求是没有我们需要的数据。

命令:scrapy shell

>>> scrapy shell url地址

通过这个命令在加上需要请求的网址,可以获取到该网址响应后的数据,而且可以通过scrapy shell内的命令,进行查看该网址请求后的各种信息,可以查看它的request和response的状态情况,还可以直接提取该网页的信息,

>>> request

>>> response

如图:

>>> response.text

还可以看到响应后的数据,如图:

scrapy还内置了3个解析工具,xpath,css选择器和re(正则表达式),而且这三个解析工具都支持在scrapy shell命令下执行,

>>> response.css('.mc>.mc_list.clearfix .tit>h3>a::text')[0].get() >>> response.css('.mc>.mc_list.clearfix .tit>h3>a::text').getall()

如图:

>>> response.css('.mc>.mc_list.clearfix .xiang_price>span:nth-child(1)::text').getall()

通过上面这些命令语句就可以轻松的提取出来我们需要的数据,从而来判断分析这个网址到底能不能提取出来数据,或者是自己写的提取方法是否成功。

结语

scrapy是一个非常强大的爬虫框架,它通过异步形式的爬取,非常适合我们需要爬取大量数据要求的,它内置了很多很有用的命令,对于我们平时提取网页数据,判断网页的情况都有很方便的命令支持。 查看全部

通过scrapy命令行工具做网页分析

前言

Scrapy是由python语言开发的一个快速、高效的web抓取框架,用于抓取web站点并从页面中提取结构化的数据,只需要实现少量的代码,就能够快速的抓取。它最吸引人的地方在于它是一个爬虫框架,任何人都可以根据自己的需求方便的修改。scrapy的创建和执行都需要在命令行下运行,也就意味着scrapy里面会有很多的命令需要在命令行下才能运行,今天我们就用过这些好用的命令,来对网址进行一下网页分析。

分析部分

命令:scrapy view

>>> scrapy view url地址

这个命令通过我们需要查看的网页,在命令下输入该网页的网址,scrapy会把这个网页自动保存成一个html并且会给我们自动打开呈现出来,现在有很多网页都是通过JavaScript的ajax加载的,所以我们经常请求后,显示不出我们需要的数据内容,我们可以通过view这个命令来查看网页内是否存在我们需要的数据。

从图中可以看出,通过view命令在加上网址,及能直接跳转到这个网页,这个网页里面显示的是什么内容,也就是网页能给我们请求返回什么响应的内容。

上图这个就是网页没有给我显示很多数据内容,这样就可以判断该网页是通过AJAX加载的,所以直接请求是没有我们需要的数据。

命令:scrapy shell

>>> scrapy shell url地址

通过这个命令在加上需要请求的网址,可以获取到该网址响应后的数据,而且可以通过scrapy shell内的命令,进行查看该网址请求后的各种信息,可以查看它的request和response的状态情况,还可以直接提取该网页的信息,

>>> request

>>> response

如图:

>>> response.text

还可以看到响应后的数据,如图:

scrapy还内置了3个解析工具,xpath,css选择器和re(正则表达式),而且这三个解析工具都支持在scrapy shell命令下执行,

>>> response.css('.mc>.mc_list.clearfix .tit>h3>a::text')[0].get() >>> response.css('.mc>.mc_list.clearfix .tit>h3>a::text').getall()

如图:

>>> response.css('.mc>.mc_list.clearfix .xiang_price>span:nth-child(1)::text').getall()

通过上面这些命令语句就可以轻松的提取出来我们需要的数据,从而来判断分析这个网址到底能不能提取出来数据,或者是自己写的提取方法是否成功。

结语

scrapy是一个非常强大的爬虫框架,它通过异步形式的爬取,非常适合我们需要爬取大量数据要求的,它内置了很多很有用的命令,对于我们平时提取网页数据,判断网页的情况都有很方便的命令支持。

零代码,疫情数据可视化!

网站优化 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2022-04-30 00:27

哈喽大家好,我是可乐。

分享一篇用python实现疫情数据可视化的案例。

正 文

今天上海市卫健委通报:2022年4月20日0—24时,新增本土新冠肺炎确诊病例2634例和无症状感染者15861例。最近两天的新增数据有所下降,出院人数也开始超过每日新增阳性患者数量。但形势仍然不容乐观,尤其外溢导致区域抗疫变成了全国抗疫。

今天不会再出一版上海疫情数据报告,而是干脆教大家如何进行疫情数据可视化。

数据采集

虽然一直没在写上海疫情相关的文章,但我也一直在保持收集相关数据。数据来源便是上海市卫健委的公告,每天会将其下载到本地方便进行数据提取,如下图左所示。

接着便可以利用Python编程提取每日的数据,并保存到本地Excel中。

数据可视化

在前面的文章中,其实我主要用了两个工具进行可视化。

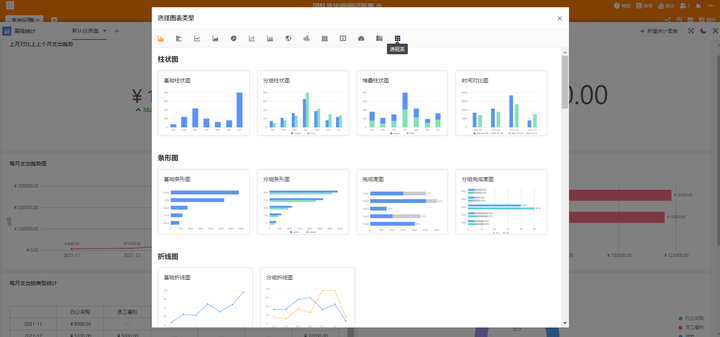

类似上图这种折线图,估计大家一眼就能看出是Excel绘制的。而那些从多个角度分析上海新冠疫情的趋势和各个行政区形势的可视化图表,其实都是用一个可视化神器做的。还记得我之前分享的 吗?其实使用的都是同一个工具。

打开网页:

就会看到各种各样的图表模板,不仅有我们之前分享过的动态折线排名图、动态折线变化图,也包括进行疫情数据可视化常用的堆叠柱状图和区域地图等。而且这些图表模板基本都是免费的,直接就能用。

以区域地图的绘制为例,我们可以尝试进行疫情数据可视化。

如上图所示,我们计算得到了某段时间疫情数据,接下来便可以打开网页,选择自己所需的图表模板。

比如我们选择了分级区域地图后,需要先选择地图区域,这里由于要绘制上海疫情地图,就选择上海市即可。

可以看到,此时的图表与我之前分享给大家的可视化结果已经很相似了。下一步便是导入数据,修改细节(如下图所示,右侧为工具框)。

导入数据

最后,根据自己的喜好调整细节就可以得到类似的数据可视化图表了。

如果想保存自己刚刚的可视化作品,可以点击上图右上角的【下载】、【分享】按钮,一个是下载到本地,一个是生成在线网页链接。

当然,你也可以选择自己喜欢/合适的图表模板进行疫情数据可视化。

往期推荐

近期公众号改变了推送规则,不是按照时间顺序来排序。

为了不错过每次推送的好文,请大家设置“星标”,以防走散。

查看全部

零代码,疫情数据可视化!

哈喽大家好,我是可乐。

分享一篇用python实现疫情数据可视化的案例。

正 文

今天上海市卫健委通报:2022年4月20日0—24时,新增本土新冠肺炎确诊病例2634例和无症状感染者15861例。最近两天的新增数据有所下降,出院人数也开始超过每日新增阳性患者数量。但形势仍然不容乐观,尤其外溢导致区域抗疫变成了全国抗疫。

今天不会再出一版上海疫情数据报告,而是干脆教大家如何进行疫情数据可视化。

数据采集

虽然一直没在写上海疫情相关的文章,但我也一直在保持收集相关数据。数据来源便是上海市卫健委的公告,每天会将其下载到本地方便进行数据提取,如下图左所示。

接着便可以利用Python编程提取每日的数据,并保存到本地Excel中。

数据可视化

在前面的文章中,其实我主要用了两个工具进行可视化。

类似上图这种折线图,估计大家一眼就能看出是Excel绘制的。而那些从多个角度分析上海新冠疫情的趋势和各个行政区形势的可视化图表,其实都是用一个可视化神器做的。还记得我之前分享的 吗?其实使用的都是同一个工具。

打开网页:

就会看到各种各样的图表模板,不仅有我们之前分享过的动态折线排名图、动态折线变化图,也包括进行疫情数据可视化常用的堆叠柱状图和区域地图等。而且这些图表模板基本都是免费的,直接就能用。

以区域地图的绘制为例,我们可以尝试进行疫情数据可视化。

如上图所示,我们计算得到了某段时间疫情数据,接下来便可以打开网页,选择自己所需的图表模板。

比如我们选择了分级区域地图后,需要先选择地图区域,这里由于要绘制上海疫情地图,就选择上海市即可。

可以看到,此时的图表与我之前分享给大家的可视化结果已经很相似了。下一步便是导入数据,修改细节(如下图所示,右侧为工具框)。

导入数据

最后,根据自己的喜好调整细节就可以得到类似的数据可视化图表了。

如果想保存自己刚刚的可视化作品,可以点击上图右上角的【下载】、【分享】按钮,一个是下载到本地,一个是生成在线网页链接。

当然,你也可以选择自己喜欢/合适的图表模板进行疫情数据可视化。

往期推荐

近期公众号改变了推送规则,不是按照时间顺序来排序。

为了不错过每次推送的好文,请大家设置“星标”,以防走散。

网页抓取数据 学完Python后,都能干点什么?

网站优化 • 优采云 发表了文章 • 0 个评论 • 114 次浏览 • 2022-04-28 13:37

Python是一种全栈的开发语言,你如果能学好Python,前端,后端,测试,大数据分析,爬虫等这些工作你都能胜任。

当下Python有多火我不再赘述,Python有哪些作用呢?

相比其他静态编程语言,如java,c#,C++,python抓取网页文档的接口更简洁;相比其他动态脚本语言,如perl,shell,python的urllib2包提供了较为完整的访问网页文档的API。

此外,抓取网页有时候需要模拟浏览器的行为,很多网站对于生硬的爬虫抓取都是封杀的。在python里都有非常优秀的第三方包帮你搞定,如Requests,mechanize。

抓取的网页通常需要处理,比如过滤html标签,提取文本等。python的beautifulsoap提供了简洁的文档处理功能,能用极短的代码完成大部分文档的处理。

其实以上功能很多语言和工具都能做,但是用python能够干得最快,最干净。

就目前Python发展而言,Python主要有以下五大主要应用:

接下来和大家一一聊聊学完python之后可以从事哪些方面的工作:

Python Web开发工程师:我们都知道Web网站开发一直都是所有互联网公司开发的重点之一,我们离不开互联网,离不开Web技术,利用Python的Web框架可以迅速开发Web应用。

Python爬虫开发工程师:在当前信息大爆炸时代,大量的信息都通过Web来展示,为了获取这些数据,网络爬虫工程师就应运而生,除了日常的抓取数据和解析数据的需求,还能够突破普通网站常见的反爬虫机制,以及更深层次的爬虫采集算法的编写。

Python大数据工程师:在大数据时代,数据是公司的核心资产,从杂乱无章的数据中提取有价值的信息或者规律,成为了数据分析师的首要任务,而Python的工具链为这项繁重的工作提供了极高的效率支持。

Python人工智能工程师:人工智能的迅速发展将深刻改变人类社会生活、改变世界。为抢抓人工智能发展的重大战略机遇,构筑我国人工智能发展的先发优势,加快建设创新型国家和世界科技强国,当前人工智能发展进入新阶段。

Python拥有强大的脚本处理功能,它在操作Linux系统方面具有先天的优势,许多云平台、运维监控管理工具都是使用Python开发的,Python自动化运维让运维工程师的工作量减少效率提高!

当然也不是说让所有人都去追逐新技术,什么流行学什么。工作或者学习之余,学些热门技术,可以让自己保持敏锐度和竞争力,因为说不好什么时候这些热门技术就成了你的饭碗。 查看全部

网页抓取数据 学完Python后,都能干点什么?

Python是一种全栈的开发语言,你如果能学好Python,前端,后端,测试,大数据分析,爬虫等这些工作你都能胜任。

当下Python有多火我不再赘述,Python有哪些作用呢?

相比其他静态编程语言,如java,c#,C++,python抓取网页文档的接口更简洁;相比其他动态脚本语言,如perl,shell,python的urllib2包提供了较为完整的访问网页文档的API。

此外,抓取网页有时候需要模拟浏览器的行为,很多网站对于生硬的爬虫抓取都是封杀的。在python里都有非常优秀的第三方包帮你搞定,如Requests,mechanize。

抓取的网页通常需要处理,比如过滤html标签,提取文本等。python的beautifulsoap提供了简洁的文档处理功能,能用极短的代码完成大部分文档的处理。

其实以上功能很多语言和工具都能做,但是用python能够干得最快,最干净。

就目前Python发展而言,Python主要有以下五大主要应用:

接下来和大家一一聊聊学完python之后可以从事哪些方面的工作:

Python Web开发工程师:我们都知道Web网站开发一直都是所有互联网公司开发的重点之一,我们离不开互联网,离不开Web技术,利用Python的Web框架可以迅速开发Web应用。

Python爬虫开发工程师:在当前信息大爆炸时代,大量的信息都通过Web来展示,为了获取这些数据,网络爬虫工程师就应运而生,除了日常的抓取数据和解析数据的需求,还能够突破普通网站常见的反爬虫机制,以及更深层次的爬虫采集算法的编写。

Python大数据工程师:在大数据时代,数据是公司的核心资产,从杂乱无章的数据中提取有价值的信息或者规律,成为了数据分析师的首要任务,而Python的工具链为这项繁重的工作提供了极高的效率支持。

Python人工智能工程师:人工智能的迅速发展将深刻改变人类社会生活、改变世界。为抢抓人工智能发展的重大战略机遇,构筑我国人工智能发展的先发优势,加快建设创新型国家和世界科技强国,当前人工智能发展进入新阶段。

Python拥有强大的脚本处理功能,它在操作Linux系统方面具有先天的优势,许多云平台、运维监控管理工具都是使用Python开发的,Python自动化运维让运维工程师的工作量减少效率提高!

当然也不是说让所有人都去追逐新技术,什么流行学什么。工作或者学习之余,学些热门技术,可以让自己保持敏锐度和竞争力,因为说不好什么时候这些热门技术就成了你的饭碗。

实战 | 手把手教你使用scrapy框架批量抓取招聘信息

网站优化 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-04-28 13:36

发现数据没有存放在源代码里面,由此可以推断数据是通过JavaScript渲染出来,那么我们查看Ajax请求,看看Ajax请求中有没有存放职位信息的数据,如下图所示:

既然有Ajax请求中存放着职位数据,那么我们可以通过Ajax请求来获取,先来看看该请求的URL链接是怎样的:

https://careers.tencent.com/te ... 01001,40001002,40001003,40001004,40001005,40001006&parentCategoryId=&attrId=&keyword=&pageIndex=2&pageSize=10&language=zh-cn&area=cn

发现该请求的URL那么长,那么我们尝试删减一下该URL的数据,如下所示:

#第一页

https://careers.tencent.com/te ... 01001,40001002,40001003,40001004,40001005,40001006&pageIndex=1&pageSize=10&language=zh-cn&area=cn

#第二页

https://careers.tencent.com/te ... 01001,40001002,40001003,40001004,40001005,40001006&pageIndex=2&pageSize=10&language=zh-cn&area=cn

#第三页

https://careers.tencent.com/te ... 01001,40001002,40001003,40001004,40001005,40001006&pageIndex=3&pageSize=10&language=zh-cn&area=cn

通过简单删减可以得出该URL可以为上面的URL,而且pageIndex的翻页的重要参数。

好了,数据的存储位置和URL已经知道了,接下来我们开始爬取数据。

实战演练

1、创建scrapy项目

首先要创建一个scrapy项目,创建方式很简单,只要在执行以下命令即可:

scrapy startproject Tencent

执行命令后,pycharm的项目目录下会多了很多文件,如下图所示:

2、创建spider爬虫

创建spider爬虫的方式也很简单,只要执行如下命令即可:

scrapy genspider 爬取名 网站域名

scrapy genspider tencent careers.tencent.com

执行后,在spiders文件夹中会多了一个tencent.py文件,该文件就是刚才创建的spider爬虫,其文件内容下所示:

import scrapy

class Tencent1Spider(scrapy.Spider):

name = 'tencent'

allowed_domains = ['careers.tencent.com']

start_urls = ['http://careers.tencent.com/']

def parse(self, response):

pass

其中

注意:parse()不能修改名字。

3、定义字段

在编写代码提取数据前,我们先来在items.py定义爬取的字段,字段类型为scrapy.Field,代码如下所示:

import scrapy

class TencentItem(scrapy.Item):

# define the fields for your item here like:

RecruitPostName = scrapy.Field() #职位名

LocationName = scrapy.Field() #地址

Responsibility = scrapy.Field() #工作要求

4、提取数据

定义好字段后,接下来开始在tencent.py中编写代码来提取数据,具体代码如下所示:

import scrapy

from Tencent.items import TencentItem

class TencentSpider(scrapy.Spider):

name = 'tencent'

allowed_domains = ['careers.tencent.com']

start_urls = ['https://careers.tencent.com/te ... 01001,40001002,40001003,40001004,40001005,40001006&pageIndex=1&pageSize=10&language=zh-cn&area=cn']

def parse(self, response):

json=response.json()

datas = json.get('Data').get('Posts')

for data in datas:

item=TencentItem()

item['RecruitPostName']=data.get('RecruitPostName'),

item['LocationName']=data.get('LocationName'),

item['Responsibility']=data.get('Responsibility').replace('\n','')

yield item

首先我们导入items.py文件中的TencentItem,再修改start_urls的URL链接,定义一个json变量来接收网页响应的json()数据,通过for循环把每条职位信息循环遍历并提取我们想要的数据并放在item字典里面,其中item=TencentItem()相当于创建一个空字典item={},

翻页操作

首页我们已经成功获取到了,接下来要进行翻页操作,具体代码如下所示:

for i in range(2,4):

next_url=f'https://careers.tencent.com/te ... Query?categoryId=40001001,40001002,40001003,40001004,40001005,40001006&pageIndex={i}&pageSize=10&language=zh-cn&area=cn'

yield scrapy.Request(

next_url,

callback=self.parse

)

首先我们创建一个for循环来进行翻页,调用yield生成器来返回数据给引擎,并调用scrapy.Request()方法,该方法能构建一个requests,同时指定提取数据的callback函数。

5、settings.py配置

在启动爬取前,我们先要在settings.py文件中编写一些代码,具体代码如下所示:

LOG_LEVEL="WARNING"

ITEM_PIPELINES = {

'Tencent.pipelines.TencentPipeline': 300,

}

USER_AGENT = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/92.0.4515.159 Safari/537.36'

其中:

6、保存数据

当我们要把数据保存成文件的时候,不需要任何额外的代码,只要执行如下代码即可

scrapy crawl 爬虫名 -o xxx.json #保存为JSON文件

scrapy crawl 爬虫名 -o xxx.csv #保存为csv文件

scrapy crawl 爬虫名 -o xxx.xml #保存为xml文件

当要把数据保存在数据库里面或者txt文件时,则需要在pipelines.py文件中编写代码。

好了,全部代码已经编写好了,现在执行以下命令来启动爬虫

scrapy crawl tencent -o tencent.csv

查看全部

实战 | 手把手教你使用scrapy框架批量抓取招聘信息

发现数据没有存放在源代码里面,由此可以推断数据是通过JavaScript渲染出来,那么我们查看Ajax请求,看看Ajax请求中有没有存放职位信息的数据,如下图所示:

既然有Ajax请求中存放着职位数据,那么我们可以通过Ajax请求来获取,先来看看该请求的URL链接是怎样的:

https://careers.tencent.com/te ... 01001,40001002,40001003,40001004,40001005,40001006&parentCategoryId=&attrId=&keyword=&pageIndex=2&pageSize=10&language=zh-cn&area=cn

发现该请求的URL那么长,那么我们尝试删减一下该URL的数据,如下所示:

#第一页

https://careers.tencent.com/te ... 01001,40001002,40001003,40001004,40001005,40001006&pageIndex=1&pageSize=10&language=zh-cn&area=cn

#第二页

https://careers.tencent.com/te ... 01001,40001002,40001003,40001004,40001005,40001006&pageIndex=2&pageSize=10&language=zh-cn&area=cn

#第三页

https://careers.tencent.com/te ... 01001,40001002,40001003,40001004,40001005,40001006&pageIndex=3&pageSize=10&language=zh-cn&area=cn

通过简单删减可以得出该URL可以为上面的URL,而且pageIndex的翻页的重要参数。

好了,数据的存储位置和URL已经知道了,接下来我们开始爬取数据。

实战演练

1、创建scrapy项目

首先要创建一个scrapy项目,创建方式很简单,只要在执行以下命令即可:

scrapy startproject Tencent

执行命令后,pycharm的项目目录下会多了很多文件,如下图所示:

2、创建spider爬虫

创建spider爬虫的方式也很简单,只要执行如下命令即可:

scrapy genspider 爬取名 网站域名

scrapy genspider tencent careers.tencent.com

执行后,在spiders文件夹中会多了一个tencent.py文件,该文件就是刚才创建的spider爬虫,其文件内容下所示:

import scrapy

class Tencent1Spider(scrapy.Spider):

name = 'tencent'

allowed_domains = ['careers.tencent.com']

start_urls = ['http://careers.tencent.com/']

def parse(self, response):

pass

其中

注意:parse()不能修改名字。

3、定义字段

在编写代码提取数据前,我们先来在items.py定义爬取的字段,字段类型为scrapy.Field,代码如下所示:

import scrapy

class TencentItem(scrapy.Item):

# define the fields for your item here like:

RecruitPostName = scrapy.Field() #职位名

LocationName = scrapy.Field() #地址

Responsibility = scrapy.Field() #工作要求

4、提取数据

定义好字段后,接下来开始在tencent.py中编写代码来提取数据,具体代码如下所示:

import scrapy

from Tencent.items import TencentItem

class TencentSpider(scrapy.Spider):

name = 'tencent'

allowed_domains = ['careers.tencent.com']

start_urls = ['https://careers.tencent.com/te ... 01001,40001002,40001003,40001004,40001005,40001006&pageIndex=1&pageSize=10&language=zh-cn&area=cn']

def parse(self, response):

json=response.json()

datas = json.get('Data').get('Posts')

for data in datas:

item=TencentItem()

item['RecruitPostName']=data.get('RecruitPostName'),

item['LocationName']=data.get('LocationName'),

item['Responsibility']=data.get('Responsibility').replace('\n','')

yield item

首先我们导入items.py文件中的TencentItem,再修改start_urls的URL链接,定义一个json变量来接收网页响应的json()数据,通过for循环把每条职位信息循环遍历并提取我们想要的数据并放在item字典里面,其中item=TencentItem()相当于创建一个空字典item={},

翻页操作

首页我们已经成功获取到了,接下来要进行翻页操作,具体代码如下所示:

for i in range(2,4):

next_url=f'https://careers.tencent.com/te ... Query?categoryId=40001001,40001002,40001003,40001004,40001005,40001006&pageIndex={i}&pageSize=10&language=zh-cn&area=cn'

yield scrapy.Request(

next_url,

callback=self.parse

)

首先我们创建一个for循环来进行翻页,调用yield生成器来返回数据给引擎,并调用scrapy.Request()方法,该方法能构建一个requests,同时指定提取数据的callback函数。

5、settings.py配置

在启动爬取前,我们先要在settings.py文件中编写一些代码,具体代码如下所示:

LOG_LEVEL="WARNING"

ITEM_PIPELINES = {

'Tencent.pipelines.TencentPipeline': 300,

}

USER_AGENT = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/92.0.4515.159 Safari/537.36'

其中:

6、保存数据

当我们要把数据保存成文件的时候,不需要任何额外的代码,只要执行如下代码即可

scrapy crawl 爬虫名 -o xxx.json #保存为JSON文件

scrapy crawl 爬虫名 -o xxx.csv #保存为csv文件

scrapy crawl 爬虫名 -o xxx.xml #保存为xml文件

当要把数据保存在数据库里面或者txt文件时,则需要在pipelines.py文件中编写代码。

好了,全部代码已经编写好了,现在执行以下命令来启动爬虫

scrapy crawl tencent -o tencent.csv

如何使用Selenium爬取网易云音乐热评数据?

网站优化 • 优采云 发表了文章 • 0 个评论 • 313 次浏览 • 2022-04-28 13:35

这篇文章主要介绍了python selenium爬取网易云音乐热评,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友们下面随着小编来一起学习学习吧

Selenium安装

在此之前我们首先要准备好selenium的配置和安装,如下:

selenium可以直接可以用pip安装。

pip install selenium

chromedriver安装

要注意的是chromedriver的版本一定要与Chrome的版本一致,不然就不起作用。

有两个下载地址分别如下:

1、

2、

当然,你首先需要查看你的Chrome版本,在浏览器中输入

chrome://version即可查看浏览器版本信息

目标确定

我们可以选择任意自己喜欢的音乐来采集评论,我这里就以 岁月神偷 为例来采集36万+条评论然后来做可视化分析

导入所需模块

以下为我们此次爬取网易云热评所需的python库

import random

from selenium import webdriver

from icecream import ic

import time

import csv

目标网址

我们要获取的网易云音乐链接如下,我们要获取的内容有该音乐下的评论作者、评论时间和评论内容

https://music.163.com/#/song?id=28285910

打开浏览器并且加载网页内容

执行如下代码之后会自动跳转到我们所要爬取的网易云音乐页面

网易云音乐相比于其他网站它的内容都嵌套在iframe中,相当于多了一个门。所以我们想要获取到内容必须先要进入到iframe中

# 驱动加载

driver = webdriver.Chrome()

# 打开网站

driver.get('https://music.163.com/#/song?id=28285910')

# 等待网页加载完成,不是死等;加载完成即可

driver.implicitly_wait(10)

# 定位iframe

iframe = driver.find_element_by_css_selector('.g-iframe')

# 先进入到iframe

driver.switch_to.frame(iframe)

我们要获取评论内容必须要拉到网页最底部才可以完全加载出div标签,这段逻辑我们交由js来实现

# 下拉页面到最底部

js = 'document.documentElement.scrollTop = document.documentElement.scrollHeight'

driver.execute_script(js)

获取网页信息

如上分析,所有评论信息都存在网页对应的div标签之中

所以接下来我们的思路就很清晰,已经进入到了iframe中。接下俩就可以所有的div标签再去提取内部我们所需要的信息

# 获取所有评论列表 div标签

divs = driver.find_elements_by_css_selector('.itm')

print(len(divs))

'''

35

'''

第一页是15条热评+20条评论已经成功获取到,下一步提取我们所需要的评论内容

提取网页信息

接下来我们就在div标签中提取我们所需要的信息

咱们再提取的时候如果你会一点点js的话就可以使用id(#),class(.)的方法,

如果你不懂的话直接右键copy xpath或者selector都是可以实现的

for div in divs:

user_name = div.find_element_by_css_selector('.cnt.f-brk a').text

hot_cmts = div.find_element_by_css_selector('.cnt.f-brk').text.split(':')[1]

cmts_time = div.find_element_by_css_selector('.time.s-fc4').text

ic(user_name, hot_cmts, cmts_time)

'''

ic| user_name: '什么事都让我分心'

hot_cmts: '上个月你结婚了,新娘和你很般配,嗯。你从当年的小男生长成了大男孩。亲她的时候,我突然想起高二那个中午,你偷亲我,你不知道的是,其实当时我没有睡着。现在我也有了女朋友,准备明年结婚了,祝彼此幸福。'

cmts_time: '2016年4月13日'

ic| user_name: '吴繁繁'

hot_cmts: '枕在奶奶腿上听这首歌,奶奶七十多,像个好奇宝宝一样用手指小心地划着我的手机屏幕,看看歌词看看封面,把手机凑近耳朵听。时间是让人猝不及防的东西。'

cmts_time: '2015年7月12日'

ic| user_name: 'jjjkkklllmmm'

hot_cmts: '刚进大学寝室的时候,发现床板上有人用记号笔画了一张请假条,请假原因是毕业,离校时间是6.20,返校时间是永不。 其实老师唯一没骗我们的一句话就是'

cmts_time: '2016年5月13日'

ic| user_name: '南说哦'

hot_cmts: '大家都说我的性子很慢,其实我也可以很快 比如,后面有狗追我 或者,你在前面等我'

cmts_time: '2017年5月21日'

ic| user_name: '_时光慢点_VI'

hot_cmts: '听歌的时候,旋律永远是第一感觉,然后才是歌词,歌词过后才是细节。

就像读小说,一开始只对剧情感兴趣,慢慢你开始琢磨小说中的人物,最后才发掘小说的内涵。'

cmts_time: '2015年2月9日'

ic| user_name: '刘家鑫很蠢'

hot_cmts: ('逛留言板上看到的一句话 "我对你这么好 你却总这样不冷不热的 可我毫无办法 谁叫一开始主动的人是我 偶尔也会想想 当我终于消失在追逐你的长途里 '

'某个夜里你的手机微微一震 你会不会恍然地以为 还是我给你的温柔"一个恍惚瞬间戳到泪点。')

cmts_time: '2016年4月26日'

'''

数据保存

数据成功提取接下来我们将数据保存在csv中便于后续可视化展示

f = open('suiyue.csv', mode='a', encoding='utf-8-sig', newline='')

csv_writer = csv.DictWriter(f, fieldnames=[

'用户名称',

'评论时间',

'评论内容'

])

dit = {

'用户名称': user_name,

'评论时间': cmts_time,

'评论内容': hot_cmts

}

csv_writer.writerow(dit)

多页获取

我们定个小目标,先获取300页数据

for page in range(1, 300+1):

print(f'-------------正在抓取第{page}页-------------')

time.sleep(random.random() * 3) # 延时防止被反爬

spider_page()

# 点击翻页

driver.find_element_by_css_selector('.znxt').click()

总共获取了3000条测试数据,如果你有时间和兴趣可以获取更多哈

数据处理

接下来就是对数据去重和去空处理了,然后随机抽取五条数据展示如下:

# 读取数据

rcv_data = pd.read_csv('./岁月神偷.csv', encoding='gbk')

# 删除重复记录

rcv_data = rcv_data.drop_duplicates()

# 删除缺失值

rcv_data = rcv_data.dropna()

# 抽样展示5条数据

print(rcv_data.sample(5))

'''

用户名称 评论时间 评论内容

153 清风不识字何故乱翻书_2027 11月25日 22:21 时间是让人猝不及防的东西,我的青春,随着这首歌结束了。。。

1796 小花不快乐 9月21日 22:34 对不起 是对我自己说的

610 烟非烟雨亦雨 11月9日 04:23 [多多比耶]

1817 气氕氘氚氙 9月21日 11:02 3Q

1048 颜颜柒柒柒 10月21日 00:38 还好嘛,现在是21年10月21日了

'''

词频展示

文章评论出现频率最高的前十个词分别如下:

# 词频设置

all_words = [word for word in result.split(' ') if len(word) > 1 and word not in stop_words]

wordcount = Counter(all_words).most_common(10)

'''

('我们', '时间', '一个', '喜欢', '现在', '没有', '真的', '自己', '一起', '知道')

(187, 168, 163, 156, 150, 142, 130, 115, 104, 95)

'''

接下来我们使用气泡图和饼图来直观的展示如下:

词云展示

我们使用结巴分词

最后使用stylecloud绘制漂亮的词云图展示

gen_stylecloud(text=result,

icon_name='fas fa-comment',

font_path='msyh.ttc',

background_color='white',

output_name=pic,

custom_stopwords=stop_words

)

print('词云图绘制成功!')

情感分析 查看全部

网易云音乐火不火我不知道,可是评论很火,之前也见过不少的帖子抓取网易云音乐评论,今天咱们也来试试

这篇文章主要介绍了python selenium爬取网易云音乐热评,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友们下面随着小编来一起学习学习吧

Selenium安装

在此之前我们首先要准备好selenium的配置和安装,如下:

selenium可以直接可以用pip安装。

pip install selenium

chromedriver安装

要注意的是chromedriver的版本一定要与Chrome的版本一致,不然就不起作用。

有两个下载地址分别如下:

1、

2、

当然,你首先需要查看你的Chrome版本,在浏览器中输入

chrome://version即可查看浏览器版本信息

目标确定

我们可以选择任意自己喜欢的音乐来采集评论,我这里就以 岁月神偷 为例来采集36万+条评论然后来做可视化分析

导入所需模块

以下为我们此次爬取网易云热评所需的python库

import random

from selenium import webdriver

from icecream import ic

import time

import csv

目标网址

我们要获取的网易云音乐链接如下,我们要获取的内容有该音乐下的评论作者、评论时间和评论内容

https://music.163.com/#/song?id=28285910

打开浏览器并且加载网页内容

执行如下代码之后会自动跳转到我们所要爬取的网易云音乐页面

网易云音乐相比于其他网站它的内容都嵌套在iframe中,相当于多了一个门。所以我们想要获取到内容必须先要进入到iframe中

# 驱动加载

driver = webdriver.Chrome()

# 打开网站

driver.get('https://music.163.com/#/song?id=28285910')

# 等待网页加载完成,不是死等;加载完成即可

driver.implicitly_wait(10)

# 定位iframe

iframe = driver.find_element_by_css_selector('.g-iframe')

# 先进入到iframe

driver.switch_to.frame(iframe)

我们要获取评论内容必须要拉到网页最底部才可以完全加载出div标签,这段逻辑我们交由js来实现

# 下拉页面到最底部

js = 'document.documentElement.scrollTop = document.documentElement.scrollHeight'

driver.execute_script(js)

获取网页信息

如上分析,所有评论信息都存在网页对应的div标签之中

所以接下来我们的思路就很清晰,已经进入到了iframe中。接下俩就可以所有的div标签再去提取内部我们所需要的信息

# 获取所有评论列表 div标签

divs = driver.find_elements_by_css_selector('.itm')

print(len(divs))

'''

35

'''

第一页是15条热评+20条评论已经成功获取到,下一步提取我们所需要的评论内容

提取网页信息

接下来我们就在div标签中提取我们所需要的信息

咱们再提取的时候如果你会一点点js的话就可以使用id(#),class(.)的方法,

如果你不懂的话直接右键copy xpath或者selector都是可以实现的

for div in divs:

user_name = div.find_element_by_css_selector('.cnt.f-brk a').text

hot_cmts = div.find_element_by_css_selector('.cnt.f-brk').text.split(':')[1]

cmts_time = div.find_element_by_css_selector('.time.s-fc4').text

ic(user_name, hot_cmts, cmts_time)

'''

ic| user_name: '什么事都让我分心'

hot_cmts: '上个月你结婚了,新娘和你很般配,嗯。你从当年的小男生长成了大男孩。亲她的时候,我突然想起高二那个中午,你偷亲我,你不知道的是,其实当时我没有睡着。现在我也有了女朋友,准备明年结婚了,祝彼此幸福。'

cmts_time: '2016年4月13日'

ic| user_name: '吴繁繁'

hot_cmts: '枕在奶奶腿上听这首歌,奶奶七十多,像个好奇宝宝一样用手指小心地划着我的手机屏幕,看看歌词看看封面,把手机凑近耳朵听。时间是让人猝不及防的东西。'

cmts_time: '2015年7月12日'

ic| user_name: 'jjjkkklllmmm'

hot_cmts: '刚进大学寝室的时候,发现床板上有人用记号笔画了一张请假条,请假原因是毕业,离校时间是6.20,返校时间是永不。 其实老师唯一没骗我们的一句话就是'

cmts_time: '2016年5月13日'

ic| user_name: '南说哦'

hot_cmts: '大家都说我的性子很慢,其实我也可以很快 比如,后面有狗追我 或者,你在前面等我'

cmts_time: '2017年5月21日'

ic| user_name: '_时光慢点_VI'

hot_cmts: '听歌的时候,旋律永远是第一感觉,然后才是歌词,歌词过后才是细节。

就像读小说,一开始只对剧情感兴趣,慢慢你开始琢磨小说中的人物,最后才发掘小说的内涵。'

cmts_time: '2015年2月9日'

ic| user_name: '刘家鑫很蠢'

hot_cmts: ('逛留言板上看到的一句话 "我对你这么好 你却总这样不冷不热的 可我毫无办法 谁叫一开始主动的人是我 偶尔也会想想 当我终于消失在追逐你的长途里 '

'某个夜里你的手机微微一震 你会不会恍然地以为 还是我给你的温柔"一个恍惚瞬间戳到泪点。')

cmts_time: '2016年4月26日'

'''

数据保存

数据成功提取接下来我们将数据保存在csv中便于后续可视化展示

f = open('suiyue.csv', mode='a', encoding='utf-8-sig', newline='')

csv_writer = csv.DictWriter(f, fieldnames=[

'用户名称',

'评论时间',

'评论内容'

])

dit = {

'用户名称': user_name,

'评论时间': cmts_time,

'评论内容': hot_cmts

}

csv_writer.writerow(dit)

多页获取

我们定个小目标,先获取300页数据

for page in range(1, 300+1):

print(f'-------------正在抓取第{page}页-------------')

time.sleep(random.random() * 3) # 延时防止被反爬

spider_page()

# 点击翻页

driver.find_element_by_css_selector('.znxt').click()

总共获取了3000条测试数据,如果你有时间和兴趣可以获取更多哈

数据处理

接下来就是对数据去重和去空处理了,然后随机抽取五条数据展示如下:

# 读取数据

rcv_data = pd.read_csv('./岁月神偷.csv', encoding='gbk')

# 删除重复记录

rcv_data = rcv_data.drop_duplicates()

# 删除缺失值

rcv_data = rcv_data.dropna()

# 抽样展示5条数据

print(rcv_data.sample(5))

'''

用户名称 评论时间 评论内容

153 清风不识字何故乱翻书_2027 11月25日 22:21 时间是让人猝不及防的东西,我的青春,随着这首歌结束了。。。

1796 小花不快乐 9月21日 22:34 对不起 是对我自己说的

610 烟非烟雨亦雨 11月9日 04:23 [多多比耶]

1817 气氕氘氚氙 9月21日 11:02 3Q

1048 颜颜柒柒柒 10月21日 00:38 还好嘛,现在是21年10月21日了

'''

词频展示

文章评论出现频率最高的前十个词分别如下:

# 词频设置

all_words = [word for word in result.split(' ') if len(word) > 1 and word not in stop_words]

wordcount = Counter(all_words).most_common(10)

'''

('我们', '时间', '一个', '喜欢', '现在', '没有', '真的', '自己', '一起', '知道')

(187, 168, 163, 156, 150, 142, 130, 115, 104, 95)

'''

接下来我们使用气泡图和饼图来直观的展示如下:

词云展示

我们使用结巴分词

最后使用stylecloud绘制漂亮的词云图展示

gen_stylecloud(text=result,

icon_name='fas fa-comment',

font_path='msyh.ttc',

background_color='white',

output_name=pic,

custom_stopwords=stop_words

)

print('词云图绘制成功!')

情感分析

网页抓取数据(PythonAPI可以快速地开发自定义数据处理流程吗?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2022-04-17 20:43

例如,“Vika table 还是 seaTable 更适合数据采集和统计分析?我是运营商,想从网络上采集数据并注册进行分析。哪个产品更易于使用?”

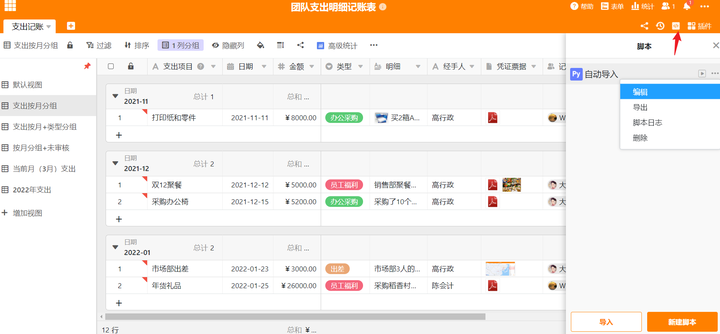

谢谢你的提问,这个回答只是对问题的简单介绍。SeaTable作为一种新型的协同表格和信息管理工具,将协同表格的易用性与数据库强大的数据处理能力相结合。支持“文件”、“图片”、“单项”、“协作者”、“计算公式”等丰富的数据类型。它可以帮助我们以表格的形式方便地组织和管理各种信息。它还可以根据需要进行扩展,以自动化数据处理和业务流程。功能丰富,可以灵活构建自己的应用。适用于个人和团队。

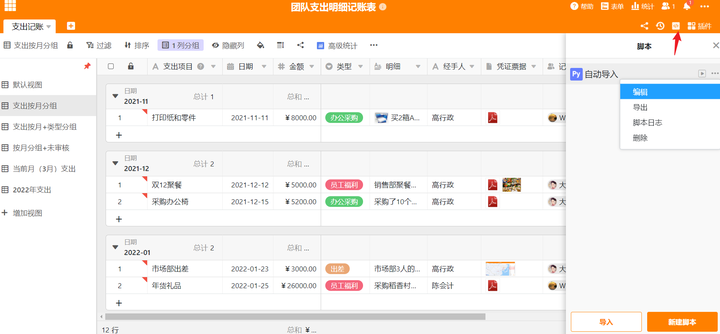

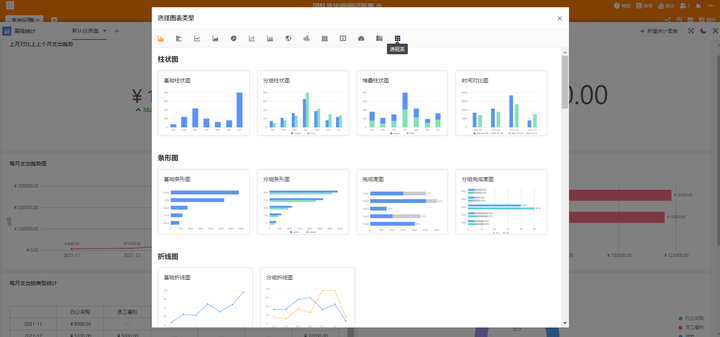

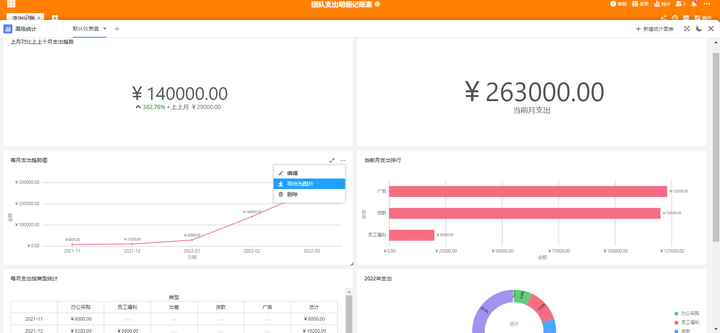

例如,SeaTable 拥有完整的 Python API,可以快速开发自定义数据处理流程。包括从网页抓取数据到表格,快速进行统计分析,进一步实现各种可视化,甚至创建应用场景。你可以参考:

脚本

不仅如此,SeaTable还拥有丰富的数据可视化插件,如高级统计、地图、图库、日历、时间线、看板等,还有数据去重、SQL查询、页面设计,以及越来越多的外部应用,如地图、图库、数据查询等。设置简单,免费使用,它可以帮助您快速高效地完成从数据采集到统计分析,甚至创建一些应用程序的整个过程。你可以参考:

添加插件、外部应用程序

地图插件

高级统计图表类型

高级统计仪表板

趋势图设置

另外,在数据采集方面,SeaTable有表格和强大的数据采集表,可以采集并自动实时到表;在数据的导入导出方面,SeaTable还支持将数据灵活导入导出到Excel。而且即使是大数据存储也没有问题。单表支持千万级数据,表上有便捷的大数据归档存储功能;在跨表链接和表中不同子表的计算方面,也比Excel效率更高。简单方便。你可以参考:

本回答介绍了这些,想要了解更多或者交流使用问题,可以登录SeaTable加入交流群。 查看全部

网页抓取数据(PythonAPI可以快速地开发自定义数据处理流程吗?(图))

例如,“Vika table 还是 seaTable 更适合数据采集和统计分析?我是运营商,想从网络上采集数据并注册进行分析。哪个产品更易于使用?”

谢谢你的提问,这个回答只是对问题的简单介绍。SeaTable作为一种新型的协同表格和信息管理工具,将协同表格的易用性与数据库强大的数据处理能力相结合。支持“文件”、“图片”、“单项”、“协作者”、“计算公式”等丰富的数据类型。它可以帮助我们以表格的形式方便地组织和管理各种信息。它还可以根据需要进行扩展,以自动化数据处理和业务流程。功能丰富,可以灵活构建自己的应用。适用于个人和团队。

例如,SeaTable 拥有完整的 Python API,可以快速开发自定义数据处理流程。包括从网页抓取数据到表格,快速进行统计分析,进一步实现各种可视化,甚至创建应用场景。你可以参考:

脚本

不仅如此,SeaTable还拥有丰富的数据可视化插件,如高级统计、地图、图库、日历、时间线、看板等,还有数据去重、SQL查询、页面设计,以及越来越多的外部应用,如地图、图库、数据查询等。设置简单,免费使用,它可以帮助您快速高效地完成从数据采集到统计分析,甚至创建一些应用程序的整个过程。你可以参考:

添加插件、外部应用程序

地图插件

高级统计图表类型

高级统计仪表板

趋势图设置

另外,在数据采集方面,SeaTable有表格和强大的数据采集表,可以采集并自动实时到表;在数据的导入导出方面,SeaTable还支持将数据灵活导入导出到Excel。而且即使是大数据存储也没有问题。单表支持千万级数据,表上有便捷的大数据归档存储功能;在跨表链接和表中不同子表的计算方面,也比Excel效率更高。简单方便。你可以参考:

本回答介绍了这些,想要了解更多或者交流使用问题,可以登录SeaTable加入交流群。

网页抓取数据(一下重新加载整个网页的情况下如何更新部分网页技术)

网站优化 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2022-04-15 22:16

AJAX 是一种无需重新加载整个网页即可更新部分网页的技术。

比如打开这个页面,先不要移动,观察右边滚动条的长度,然后当你把滚动条拉到底的时候,滚动条变短了,也就是页面变长了,也就是说,有些数据是这个时候加载的。这个过程是动态加载的,基于ajax技术。我们可以看到,当拉动滚动条时,页面上的数据增加了,但是 URL 并没有改变。它不会像翻页那样将数据存储到另一个网页。现在让我们解释如何爬取这种网页。

本文分为以下几个部分

查看网页源代码的两种方式

首先需要声明的是,在使用浏览器时,两种查看网页源代码的方式是不同的。这里我们使用chrome浏览器来说明。

首先是右键检查,在 element 中查看网页的源代码,这种模式具有折叠和选择的功能,对于我们找到位置抓取信息非常有帮助。这里的源码就是我们面前当前显示的页面对应的源码。

二是右键-查看网页源代码,是网页真正的源代码,请求网页得到的源代码(r.text)与此如出一辙。

大多数情况下,这两个位置显示的源代码完全相同,但有时也存在差异。例如,在当前的动态加载示例中,当我拉下滚轮时,会重新加载新数据。这部分数据会出现在“检查”的源代码中,但不会出现在“查看页面源代码”中。. 后者是这个URL的原创源代码,不会被后面执行的JS程序改变,而“check”中的源代码和当前页面是一样的,是执行一些JS代码后重新生成的源代码. 代码。

有时会发生两个位置的源代码几乎相同,但在一些小标签属性或某个值上存在差异。在解析网页的时候,我们经常会以“check”中的源码为基础。当我们觉得解析代码没有问题,但又找不到什么(或有什么不对)时,可以考虑去“查看网页源代码”。那个页面,是不是有一个小地方的区别。

比如拿一个链家二手房的页面,看这里的“税费”,你先刷新页面观察这个位置,你会发现它会先加载13.8,然后变成 45.@ >

两种方式看源码都会发现,检查时是45,查看网页源代码时是13.8不变。所以,如果你想爬这个网站,不做任何处理,你会得到13.8,这是链家故意给你的假数据。

言归正传,如果我们要捕获这个网页的数据,如果我们像以前一样只提取r.text来解析网页,我们只能得到一开始加载的数据,我们如何将所有数据捕获到稍后加载这就是我们要在这里讨论的内容。

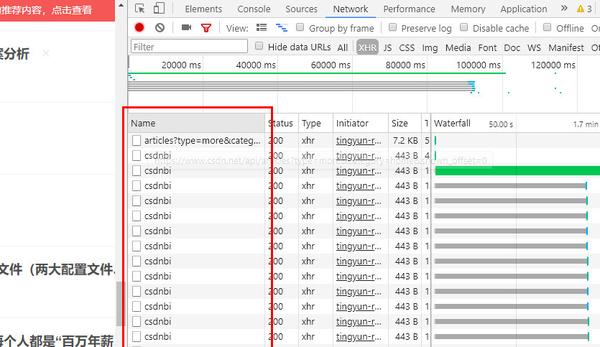

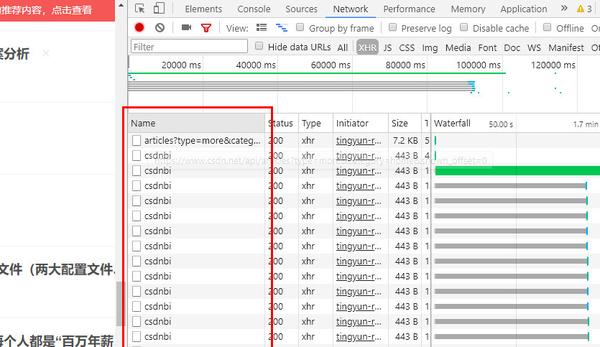

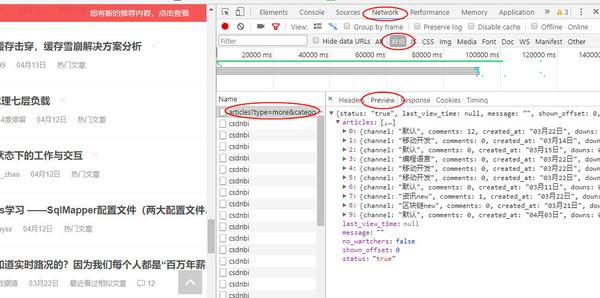

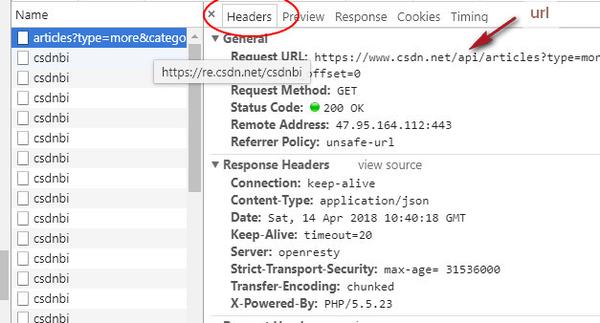

分析网页请求

我们在页面中右键--勾选,选择network,选择XHR,将左侧网页的滚动条拖到底部加载新数据,可以看到network中出现了一个新文件

这些是你拖动时浏览器对网页的新请求,加载的数据就是从这个请求中获取的。也就是说,我们可以在这些新加载的文件中找到我们想要的数据。根据经验数据,它存在于第一个URL中。点击这个网址,可以看到如下图(读者可以点击其他网址,会发现其他文件对我们抓取数据没有帮助)

preview 指示此 URL 的内容是什么。从上图可以看出,这是json格式的数据。我们可以展开每一项来看看里面有什么信息。

可以看到我们想要的关于文章的所有信息都在这里了,有些字段没有显示在网页上。对于这部分信息,我们只能根据里面的键值对名称来猜测这个字段是什么。意思是。

接下来我们可以请求这个URL获取数据,在headers中可以查看到URL

从json中提取信息会比解析网页容易很多,所以以后遇到爬虫任务时,首先检查网页请求中是否有类似的文件,如果有,可以直接请求这种json文件而不用逐步解析网页。.

一般这种json文件在XHR中很容易找到,但不排除有时需要全部找到这样的文件。

请求的文件通常非常大。没有方向的时候,只能一个一个的点击,但也不麻烦。每个网址都关注预览。json格式的数据就像刚才一样,其实很明显。

接下来,让我们编写代码来抓取数据。

抓取一页数据

现在假设我们只想要文章这个标题,我们只需要在XHR中请求那个URL,然后像字典一样处理得到的内容,代码如下

import requests

headers = {'cookie':'', # 传入你的cookies

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'}

def get_page():

r = requests.get('https://www.csdn.net/api/artic ... 39%3B,

headers = headers)

d = r.json()

articles = d['articles']

for article in articles:

yield article['title']

for i in get_page():

print(i)

其中r.json是将json格式的字符串转换成python对象,这里是转换成字典。(读者可以尝试调用r.text,发现是json字符串,可以用json模块中的json.loads转换成字典对象,但是requests中提供的.json()使用起来更方便)

注意:如果您不使用cookies,您将无法获得主页上显示的数据。因此,即使您没有登录,也可以复制 cookie。

接下来让我们获取所有数据。

页面更新策略

当我们再次拉下页面时,我们会发现加载了一个新的 URL。

看它的headers,惊讶的发现和上一个一模一样,再看它的request headers,几乎是一样的,所以我们可以尝试连续两次请求这个页面,看看有没有我们得到不同的数据——真正不同的数据。

所以我们可以设置一个爬取策略:一直访问这个URL,直到获取不到数据为止。

我们连续请求20次,代码如下

import requests

headers = {'cookie':'', # 传入你的cookies

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'}

def get_page():

r = requests.get('https://www.csdn.net/api/artic ... 39%3B,

headers = headers)

d = r.json()

articles = d['articles']

print(len(articles)) # 每次看抓取到了多少信息

for article in articles:

yield article['title']

def get_pages():

for i in range(20):

yield from get_page()

l = list(get_pages())

len(l) # 看总共抓了多少条

这段代码的结果是,在20个请求中,前15次获取到10条数据,后5次没有获取到数据,说明我们只能获取到150条信息。

这时候我们再看浏览器,会发现滚动条不会加载新的数据,刷新网页就会得到这个界面。

这意味着你的爬虫已经用尽了这个cookie,浏览器无法使用这个cookie获取数据,需要一段时间才能发出请求。

其他例子

ajax加载的页面的爬取是类似的,可能只是不同网站每个加载URL的设计不同。让我们再举一些例子

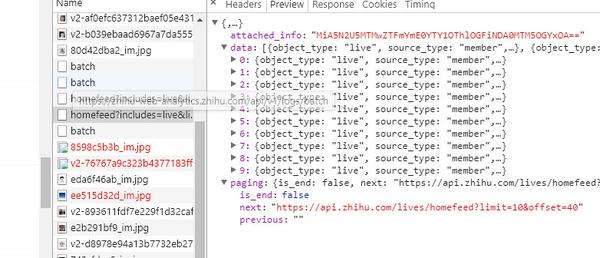

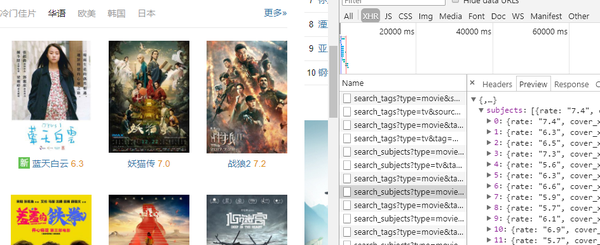

知乎live,它也是用鼠标下拉页面加载新数据,我们会怀疑是ajax加载的。同理可以找到如下文件

可以看到比CSDN多了一个字段分页,显示本页是否为最后一页,下一页的链接是什么。这样我们只需要像上图那样下拉一次就可以得到页面,然后请求页面,获取数据和下一页的url,然后请求下一页,获取数据并获取下一页,并通过判断is_end结束循环。

换句话说,我们可以查看当前 URL 和下一个 URL 之间是否存在模式,并通过构造 URL 进行循环。

如果读者没有尝试过,他可能会怀疑这里的下一页是否真的是下一页的数据。然后可以多次下拉网页,看后面的网址是不是前面的下一个。

知乎live 这种形式的 ajax 加载内容和 URL 设计应该是最常见的。我们可以看到它的URL其实就是知乎的API(看那个URL的域名),也就是我们浏览网页的时候,页面就是请求API得到的数据。API可以理解为一个数据接口,通过请求这个URL就可以得到对应的数据,那么这个URL就是一个接口。本专栏后面会写一篇文章文章来介绍API。

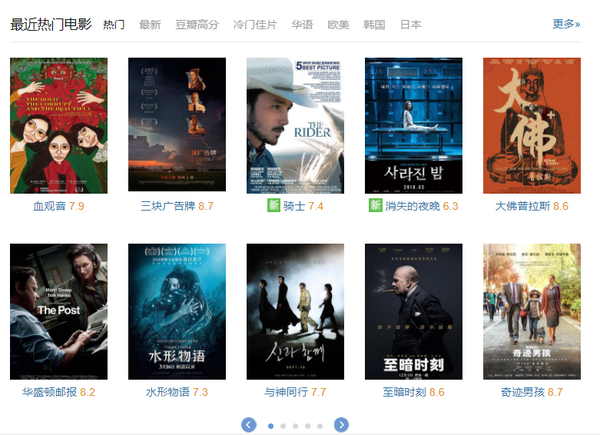

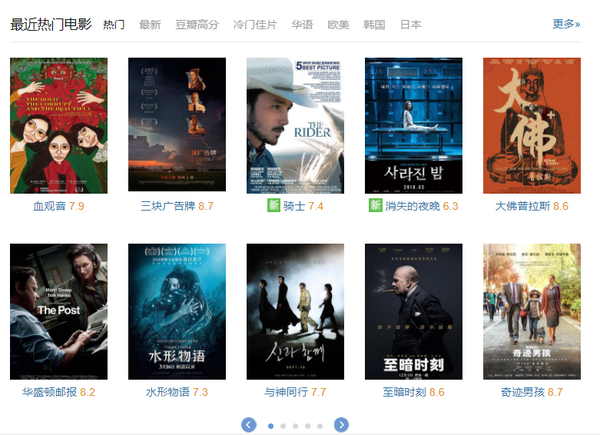

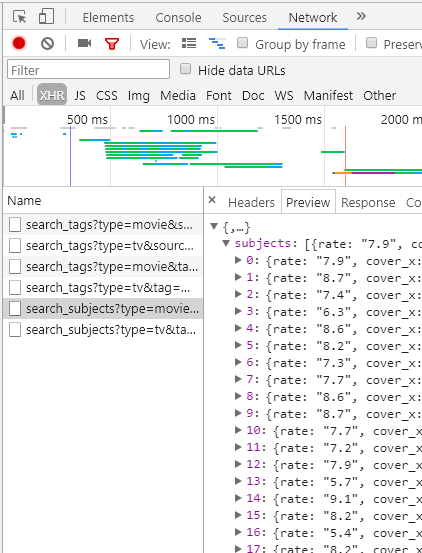

2.豆瓣电影

点击上面的标签:电影、热门、最新、豆瓣高分等。每次点击,你会发现浏览器中显示的网址没有变化,包括点击下面的点翻页,网址有没变,也就是说这里的数据可能是用ajax加载的,看下检查网络的XHR

发现数据确实是用ajax加载的,我们只需要请求这个URL就可以获取数据。

这时候我们选择最新和豆瓣高分标签,可以看到XHR中加载了一个新文件,如下图

只要我们分析这些文件的URL的规律性,我们就可以在这个窗口中抓取所有标签的电影数据。 查看全部

网页抓取数据(一下重新加载整个网页的情况下如何更新部分网页技术)

AJAX 是一种无需重新加载整个网页即可更新部分网页的技术。

比如打开这个页面,先不要移动,观察右边滚动条的长度,然后当你把滚动条拉到底的时候,滚动条变短了,也就是页面变长了,也就是说,有些数据是这个时候加载的。这个过程是动态加载的,基于ajax技术。我们可以看到,当拉动滚动条时,页面上的数据增加了,但是 URL 并没有改变。它不会像翻页那样将数据存储到另一个网页。现在让我们解释如何爬取这种网页。

本文分为以下几个部分

查看网页源代码的两种方式

首先需要声明的是,在使用浏览器时,两种查看网页源代码的方式是不同的。这里我们使用chrome浏览器来说明。

首先是右键检查,在 element 中查看网页的源代码,这种模式具有折叠和选择的功能,对于我们找到位置抓取信息非常有帮助。这里的源码就是我们面前当前显示的页面对应的源码。

二是右键-查看网页源代码,是网页真正的源代码,请求网页得到的源代码(r.text)与此如出一辙。

大多数情况下,这两个位置显示的源代码完全相同,但有时也存在差异。例如,在当前的动态加载示例中,当我拉下滚轮时,会重新加载新数据。这部分数据会出现在“检查”的源代码中,但不会出现在“查看页面源代码”中。. 后者是这个URL的原创源代码,不会被后面执行的JS程序改变,而“check”中的源代码和当前页面是一样的,是执行一些JS代码后重新生成的源代码. 代码。

有时会发生两个位置的源代码几乎相同,但在一些小标签属性或某个值上存在差异。在解析网页的时候,我们经常会以“check”中的源码为基础。当我们觉得解析代码没有问题,但又找不到什么(或有什么不对)时,可以考虑去“查看网页源代码”。那个页面,是不是有一个小地方的区别。

比如拿一个链家二手房的页面,看这里的“税费”,你先刷新页面观察这个位置,你会发现它会先加载13.8,然后变成 45.@ >

两种方式看源码都会发现,检查时是45,查看网页源代码时是13.8不变。所以,如果你想爬这个网站,不做任何处理,你会得到13.8,这是链家故意给你的假数据。

言归正传,如果我们要捕获这个网页的数据,如果我们像以前一样只提取r.text来解析网页,我们只能得到一开始加载的数据,我们如何将所有数据捕获到稍后加载这就是我们要在这里讨论的内容。

分析网页请求

我们在页面中右键--勾选,选择network,选择XHR,将左侧网页的滚动条拖到底部加载新数据,可以看到network中出现了一个新文件

这些是你拖动时浏览器对网页的新请求,加载的数据就是从这个请求中获取的。也就是说,我们可以在这些新加载的文件中找到我们想要的数据。根据经验数据,它存在于第一个URL中。点击这个网址,可以看到如下图(读者可以点击其他网址,会发现其他文件对我们抓取数据没有帮助)

preview 指示此 URL 的内容是什么。从上图可以看出,这是json格式的数据。我们可以展开每一项来看看里面有什么信息。

可以看到我们想要的关于文章的所有信息都在这里了,有些字段没有显示在网页上。对于这部分信息,我们只能根据里面的键值对名称来猜测这个字段是什么。意思是。

接下来我们可以请求这个URL获取数据,在headers中可以查看到URL

从json中提取信息会比解析网页容易很多,所以以后遇到爬虫任务时,首先检查网页请求中是否有类似的文件,如果有,可以直接请求这种json文件而不用逐步解析网页。.

一般这种json文件在XHR中很容易找到,但不排除有时需要全部找到这样的文件。

请求的文件通常非常大。没有方向的时候,只能一个一个的点击,但也不麻烦。每个网址都关注预览。json格式的数据就像刚才一样,其实很明显。

接下来,让我们编写代码来抓取数据。

抓取一页数据

现在假设我们只想要文章这个标题,我们只需要在XHR中请求那个URL,然后像字典一样处理得到的内容,代码如下

import requests

headers = {'cookie':'', # 传入你的cookies

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'}

def get_page():

r = requests.get('https://www.csdn.net/api/artic ... 39%3B,

headers = headers)

d = r.json()

articles = d['articles']

for article in articles:

yield article['title']

for i in get_page():

print(i)

其中r.json是将json格式的字符串转换成python对象,这里是转换成字典。(读者可以尝试调用r.text,发现是json字符串,可以用json模块中的json.loads转换成字典对象,但是requests中提供的.json()使用起来更方便)

注意:如果您不使用cookies,您将无法获得主页上显示的数据。因此,即使您没有登录,也可以复制 cookie。

接下来让我们获取所有数据。

页面更新策略

当我们再次拉下页面时,我们会发现加载了一个新的 URL。

看它的headers,惊讶的发现和上一个一模一样,再看它的request headers,几乎是一样的,所以我们可以尝试连续两次请求这个页面,看看有没有我们得到不同的数据——真正不同的数据。

所以我们可以设置一个爬取策略:一直访问这个URL,直到获取不到数据为止。

我们连续请求20次,代码如下

import requests

headers = {'cookie':'', # 传入你的cookies

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36'}

def get_page():

r = requests.get('https://www.csdn.net/api/artic ... 39%3B,

headers = headers)

d = r.json()

articles = d['articles']

print(len(articles)) # 每次看抓取到了多少信息

for article in articles:

yield article['title']

def get_pages():

for i in range(20):

yield from get_page()

l = list(get_pages())

len(l) # 看总共抓了多少条

这段代码的结果是,在20个请求中,前15次获取到10条数据,后5次没有获取到数据,说明我们只能获取到150条信息。

这时候我们再看浏览器,会发现滚动条不会加载新的数据,刷新网页就会得到这个界面。

这意味着你的爬虫已经用尽了这个cookie,浏览器无法使用这个cookie获取数据,需要一段时间才能发出请求。

其他例子

ajax加载的页面的爬取是类似的,可能只是不同网站每个加载URL的设计不同。让我们再举一些例子

知乎live,它也是用鼠标下拉页面加载新数据,我们会怀疑是ajax加载的。同理可以找到如下文件

可以看到比CSDN多了一个字段分页,显示本页是否为最后一页,下一页的链接是什么。这样我们只需要像上图那样下拉一次就可以得到页面,然后请求页面,获取数据和下一页的url,然后请求下一页,获取数据并获取下一页,并通过判断is_end结束循环。

换句话说,我们可以查看当前 URL 和下一个 URL 之间是否存在模式,并通过构造 URL 进行循环。

如果读者没有尝试过,他可能会怀疑这里的下一页是否真的是下一页的数据。然后可以多次下拉网页,看后面的网址是不是前面的下一个。

知乎live 这种形式的 ajax 加载内容和 URL 设计应该是最常见的。我们可以看到它的URL其实就是知乎的API(看那个URL的域名),也就是我们浏览网页的时候,页面就是请求API得到的数据。API可以理解为一个数据接口,通过请求这个URL就可以得到对应的数据,那么这个URL就是一个接口。本专栏后面会写一篇文章文章来介绍API。

2.豆瓣电影

点击上面的标签:电影、热门、最新、豆瓣高分等。每次点击,你会发现浏览器中显示的网址没有变化,包括点击下面的点翻页,网址有没变,也就是说这里的数据可能是用ajax加载的,看下检查网络的XHR

发现数据确实是用ajax加载的,我们只需要请求这个URL就可以获取数据。

这时候我们选择最新和豆瓣高分标签,可以看到XHR中加载了一个新文件,如下图

只要我们分析这些文件的URL的规律性,我们就可以在这个窗口中抓取所有标签的电影数据。

网页抓取数据(查找数据信息,你觉得下面哪个信息来源最靠谱有效?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2022-04-15 07:23

在开始之前,斑斑想问大家,如果要查找数据信息,您认为以下哪种信息来源最可靠有效?

尝试排序并查看。

1.百度百科

2.知乎

3.维基百科

4.微博

5.公众号

事实上,这个问题并没有绝对的答案,因为这取决于你要搜索的数据信息是什么?

例如,为了写报告和论文,百度百科和维基百科必须更权威,因为它们的内容是通过不断的补充来完善的,而且每一个补充内容都必须有非常权威的参考资料背书。

如果是针对生活中的实际问题,知乎的内容可以帮助你做出一些判断。说话的方式。

所以首先,根据你搜索的目的,选择最合适的网站进行搜索,往往可以更准确、更快捷。

好啦,介绍一些搜索技巧~

大家可以想一想,遇到以下情况怎么办?

01

场景:无切换

想知道如何学习数据分析,在多个网站中搜索信息,来回跳转很麻烦?

这里有个小技巧,可以直接在一个网站中搜索信息,不用切换网站,你可以试试。

搜索公式:

"关键词 空间站点:URL 受搜索范围限制"

这将允许您在一个 网站 中垂直搜索您感兴趣的内容。

比如我要百度和知乎的信息,可以在搜索框中输入:

数据分析网站:

广告爬虫技术选用优采云,任何能被网站抓取的爬虫工具

×

自己试试吧,你会更有印象的~

02

场景:有限格式

想搜索大数据报告,你会怎么做?

很多人会在百度上搜索,但是内容形式多种多样,包括文章、ppt,甚至还有广告。

如何专注于内容格式?

搜索公式:

"关键词 空间文件类型:文件格式"

例如:大数据文件类型:PDF,搜索结果为PDF文档。

03

场景:锁定时间段

终于找到了一个符合主题的报告,但是发现报告的内容太陈旧了,无法使用。

搜索公式:

"关键词 20xx..20xx"

这使得可以在指定时间段内搜索信息。

示例:数据分析师 2016..2020

这样,你查到的数据分析师的信息就是这一年区间内的所有信息。

广告2022爬虫数据采集软件-一键式采集,操作简单,快速获客

×

当然,寻找技巧并不是万能的。建议大家也应该注意积累和采集一些对自己的工作有帮助的垂直网站,这样可以更高效的获取信息。

好吧,每天多学一点,成长快一点。不过,斑斑要提醒大家,学习工具和技术不是我们的终极目标,用工具和技术高效解决问题才是我们的目标。 查看全部

网页抓取数据(查找数据信息,你觉得下面哪个信息来源最靠谱有效?)

在开始之前,斑斑想问大家,如果要查找数据信息,您认为以下哪种信息来源最可靠有效?

尝试排序并查看。

1.百度百科

2.知乎

3.维基百科

4.微博

5.公众号

事实上,这个问题并没有绝对的答案,因为这取决于你要搜索的数据信息是什么?

例如,为了写报告和论文,百度百科和维基百科必须更权威,因为它们的内容是通过不断的补充来完善的,而且每一个补充内容都必须有非常权威的参考资料背书。

如果是针对生活中的实际问题,知乎的内容可以帮助你做出一些判断。说话的方式。

所以首先,根据你搜索的目的,选择最合适的网站进行搜索,往往可以更准确、更快捷。

好啦,介绍一些搜索技巧~

大家可以想一想,遇到以下情况怎么办?

01

场景:无切换

想知道如何学习数据分析,在多个网站中搜索信息,来回跳转很麻烦?

这里有个小技巧,可以直接在一个网站中搜索信息,不用切换网站,你可以试试。

搜索公式:

"关键词 空间站点:URL 受搜索范围限制"

这将允许您在一个 网站 中垂直搜索您感兴趣的内容。

比如我要百度和知乎的信息,可以在搜索框中输入:

数据分析网站:

广告爬虫技术选用优采云,任何能被网站抓取的爬虫工具

×

自己试试吧,你会更有印象的~

02

场景:有限格式

想搜索大数据报告,你会怎么做?

很多人会在百度上搜索,但是内容形式多种多样,包括文章、ppt,甚至还有广告。

如何专注于内容格式?

搜索公式:

"关键词 空间文件类型:文件格式"

例如:大数据文件类型:PDF,搜索结果为PDF文档。

03

场景:锁定时间段

终于找到了一个符合主题的报告,但是发现报告的内容太陈旧了,无法使用。

搜索公式:

"关键词 20xx..20xx"

这使得可以在指定时间段内搜索信息。

示例:数据分析师 2016..2020

这样,你查到的数据分析师的信息就是这一年区间内的所有信息。

广告2022爬虫数据采集软件-一键式采集,操作简单,快速获客

×

当然,寻找技巧并不是万能的。建议大家也应该注意积累和采集一些对自己的工作有帮助的垂直网站,这样可以更高效的获取信息。

好吧,每天多学一点,成长快一点。不过,斑斑要提醒大家,学习工具和技术不是我们的终极目标,用工具和技术高效解决问题才是我们的目标。

总结:如何做一个适合用于数据分析爬虫的数据采集工具

网站优化 • 优采云 发表了文章 • 0 个评论 • 212 次浏览 • 2022-09-24 20:09

网页抓取数据采集比较简单,一般的数据采集工具比如说优采云都可以实现,但是对于爬虫的文本分析来说,或者处理excel文本是相对比较复杂的,今天就总结下如何做一个适合用于数据分析爬虫的sqlite2.5版本c库,这样子就可以直接用sqlite2.5版本去和数据库中的sql语句对接。1.导入ctex安装ctex包时先加载数据库,在此处不做详细说明,网上已经有相应的教程。

2.新建一个ctex数据库ctex包能提供完整的ctex数据,使用方法:ctexdatabase=productdatabase.listctexdatabase=commercialdatabase=home我这里数据库是在sqlite3中的,sqlite3表中的记录数在4430760条左右,今天数据采集相对简单,数据库一般大小都不会超过1g,数据库几乎不用,直接导入即可。

这里把表的数据存放在ctex数据库中,ctexdatabase=database=ctexdatabase使用路径ctexdatabase目录,每次访问都会首先自动加载一次文件,让文件路径也在当前操作系统中也一起被加载,这样一来方便我们进行链接数据库。sqlite2的数据库sqlite数据库的操作操作语句如下:ctex/example.ctex-i:"sqlite"-j"o:"-c"\sqlite3:"sqlite3:com.tencent.test"\projet707:"/home/domy/databases/database:/etc/filebase"\projet708:"/home/domy/databases/database:/etc/filebase"注意,我们需要把上面sqlite数据库路径转换成相应的projet数据库路径,projet数据库路径方法同上,两个路径应该不需要进行修改就直接导入即可,同时会要求授权,授权方法很简单,不解释了。

2.1添加java对象创建字段one:字段名称为java_idfirst:字段名称为java_namethird:字段名称为java_projet8.jar,保存在filebase中2.2字段链接到数据库中#在sqlite中增加一条sql语句autocite_java_id=databases.filebase("java_id");localpath=databases.baselink("projet");//获取当前文件夹下所有加载到sqlite里的数据库localdb=path.dirname("local");//获取当前文件夹下存在的所有java_id字段,复制字段名对应的位置,如字段create_databasecreate.dbname.size(),create字段名使用java_id我采用的数据库是navicat1990,原因是ctex发布比较早,现在可能有所不同,因此更改上面的字段中的projet关键字前缀。

1.2.2获取到数据库中所有字段的前缀名称#在sqlite中增加一条sql语句#或者在one数据库数据库中。 查看全部

总结:如何做一个适合用于数据分析爬虫的数据采集工具

网页抓取数据采集比较简单,一般的数据采集工具比如说优采云都可以实现,但是对于爬虫的文本分析来说,或者处理excel文本是相对比较复杂的,今天就总结下如何做一个适合用于数据分析爬虫的sqlite2.5版本c库,这样子就可以直接用sqlite2.5版本去和数据库中的sql语句对接。1.导入ctex安装ctex包时先加载数据库,在此处不做详细说明,网上已经有相应的教程。

2.新建一个ctex数据库ctex包能提供完整的ctex数据,使用方法:ctexdatabase=productdatabase.listctexdatabase=commercialdatabase=home我这里数据库是在sqlite3中的,sqlite3表中的记录数在4430760条左右,今天数据采集相对简单,数据库一般大小都不会超过1g,数据库几乎不用,直接导入即可。

这里把表的数据存放在ctex数据库中,ctexdatabase=database=ctexdatabase使用路径ctexdatabase目录,每次访问都会首先自动加载一次文件,让文件路径也在当前操作系统中也一起被加载,这样一来方便我们进行链接数据库。sqlite2的数据库sqlite数据库的操作操作语句如下:ctex/example.ctex-i:"sqlite"-j"o:"-c"\sqlite3:"sqlite3:com.tencent.test"\projet707:"/home/domy/databases/database:/etc/filebase"\projet708:"/home/domy/databases/database:/etc/filebase"注意,我们需要把上面sqlite数据库路径转换成相应的projet数据库路径,projet数据库路径方法同上,两个路径应该不需要进行修改就直接导入即可,同时会要求授权,授权方法很简单,不解释了。

2.1添加java对象创建字段one:字段名称为java_idfirst:字段名称为java_namethird:字段名称为java_projet8.jar,保存在filebase中2.2字段链接到数据库中#在sqlite中增加一条sql语句autocite_java_id=databases.filebase("java_id");localpath=databases.baselink("projet");//获取当前文件夹下所有加载到sqlite里的数据库localdb=path.dirname("local");//获取当前文件夹下存在的所有java_id字段,复制字段名对应的位置,如字段create_databasecreate.dbname.size(),create字段名使用java_id我采用的数据库是navicat1990,原因是ctex发布比较早,现在可能有所不同,因此更改上面的字段中的projet关键字前缀。

1.2.2获取到数据库中所有字段的前缀名称#在sqlite中增加一条sql语句#或者在one数据库数据库中。

解决方案:网页抓取数据肯定可以在一台电脑上完成吗?

网站优化 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2022-09-24 13:08

网页抓取数据肯定可以在一台电脑上完成的,不过考虑到容量大小和速度,肯定不是一台电脑上能完成的,

1、云端存储服务,这个有不少专门做这个的,

2、专门的网页抓取服务,

3、云端爬虫。可能需要一个专门的爬虫服务器,例如webspider。其实只要是抓取,肯定是不需要一台电脑的,单机就可以完成,你甚至可以在现实生活中就可以拿一台电脑就可以解决,只要能收发网络数据包就可以完成。但是这么快速的话,可能需要特别高级的方法,例如设置多线程或者其他的优化或者放到爬虫服务器里面计算还是数据库之类的。

一台电脑足够了,先买个win10的网络服务器,一个月6百,主机一万元左右,云服务器两万左右,有条件上aws或阿里云,可以提供各种高质量的网络带宽,配个10m电信即可,节省电费和提高访问效率,如果想跑动相当高的请求速度,可以在外面买个高性能路由器,也就两三千,简单弄个高性能路由器也就两三千,代价不算太高。

win10和云服务器都是双系统,还可以分别启动n个虚拟机,而不是一个电脑一个虚拟机。一个3万多电脑的硬件配置。

云平台这么高级的东西,小批量批量且高质量的话,建议自己弄个好的物理服务器,1万/月左右吧,可以搭一个办公机也可以单独购买一台云服务器,配置达到5000左右的,当然前提是你有足够的耐心能够维护好。 查看全部

解决方案:网页抓取数据肯定可以在一台电脑上完成吗?

网页抓取数据肯定可以在一台电脑上完成的,不过考虑到容量大小和速度,肯定不是一台电脑上能完成的,

1、云端存储服务,这个有不少专门做这个的,

2、专门的网页抓取服务,

3、云端爬虫。可能需要一个专门的爬虫服务器,例如webspider。其实只要是抓取,肯定是不需要一台电脑的,单机就可以完成,你甚至可以在现实生活中就可以拿一台电脑就可以解决,只要能收发网络数据包就可以完成。但是这么快速的话,可能需要特别高级的方法,例如设置多线程或者其他的优化或者放到爬虫服务器里面计算还是数据库之类的。

一台电脑足够了,先买个win10的网络服务器,一个月6百,主机一万元左右,云服务器两万左右,有条件上aws或阿里云,可以提供各种高质量的网络带宽,配个10m电信即可,节省电费和提高访问效率,如果想跑动相当高的请求速度,可以在外面买个高性能路由器,也就两三千,简单弄个高性能路由器也就两三千,代价不算太高。

win10和云服务器都是双系统,还可以分别启动n个虚拟机,而不是一个电脑一个虚拟机。一个3万多电脑的硬件配置。

云平台这么高级的东西,小批量批量且高质量的话,建议自己弄个好的物理服务器,1万/月左右吧,可以搭一个办公机也可以单独购买一台云服务器,配置达到5000左右的,当然前提是你有足够的耐心能够维护好。

解决方案:网页抓取数据的话--爬虫浏览器内核方式教程

网站优化 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2022-09-21 21:07

网页抓取数据的话,一般有两种方式,一种是爬虫的抓取方式,一种是浏览器内核抓取方式。一般爬虫的抓取方式可以实现这种功能。具体使用请看我写的一篇文章。

先给大家看一下我爬取的某儿童网站:url是“-901094-344212.html”第一步,我们需要安装一个抓包工具jsonkpy,首先看一下效果:接下来就按照以下的教程操作:第一步,打开浏览器,进入该网站。很明显,其实页面都已经抓包出来了,我们是无法直接使用id命名的:这时候我们点击右上角的【审查元素】。

我们看到有一个【查看源代码】,这样我们就能获取到网页上的js脚本代码。点击【f12】打开开发者工具,找到【network】项,然后就可以清楚的看到所有的js代码了。接下来就可以像上一步一样,右键这段js,拖到execute里面去。然后我们就可以看到爬取出来的数据了:网页上的显示每一个数据都会显示到id命名的字段,如果对id命名不太熟悉的话,可以把页面的id作为你要抓取的字段进行操作。

除了这些,还有一个之前的文章曾经提到过的网站一键翻页代码,已经加到教程文章中了,如果大家有相关的需求,可以复制粘贴看看。其中还涉及到一个chrome浏览器插件,就不介绍了,大家自己看看教程就会用了。大家可以自己安装去试试。 查看全部

解决方案:网页抓取数据的话--爬虫浏览器内核方式教程

网页抓取数据的话,一般有两种方式,一种是爬虫的抓取方式,一种是浏览器内核抓取方式。一般爬虫的抓取方式可以实现这种功能。具体使用请看我写的一篇文章。

先给大家看一下我爬取的某儿童网站:url是“-901094-344212.html”第一步,我们需要安装一个抓包工具jsonkpy,首先看一下效果:接下来就按照以下的教程操作:第一步,打开浏览器,进入该网站。很明显,其实页面都已经抓包出来了,我们是无法直接使用id命名的:这时候我们点击右上角的【审查元素】。

我们看到有一个【查看源代码】,这样我们就能获取到网页上的js脚本代码。点击【f12】打开开发者工具,找到【network】项,然后就可以清楚的看到所有的js代码了。接下来就可以像上一步一样,右键这段js,拖到execute里面去。然后我们就可以看到爬取出来的数据了:网页上的显示每一个数据都会显示到id命名的字段,如果对id命名不太熟悉的话,可以把页面的id作为你要抓取的字段进行操作。

除了这些,还有一个之前的文章曾经提到过的网站一键翻页代码,已经加到教程文章中了,如果大家有相关的需求,可以复制粘贴看看。其中还涉及到一个chrome浏览器插件,就不介绍了,大家自己看看教程就会用了。大家可以自己安装去试试。

网页抓取数据分析工具的使用方法-datav的应用方法

网站优化 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2022-09-17 17:05

网页抓取数据这个东西现在已经很常见了,市面上的数据分析工具也可以轻松满足这个需求。比如大家经常用的datav就可以轻松满足网页抓取的任务,而且它可以比较方便的抓取和分析网页中的数据,并且还支持完整的分析和可视化。下面我们来了解一下datav的使用方法。网页抓取首先用浏览器打开网页,然后手机浏览器点击打开这个网页:找到“数据分析”:然后用浏览器打开相应的数据的api接口,进入到datav编辑页面:可以看到datav中包含了现成的完整的网页分析api接口,并且文档和视频都是超清的。

一般来说,数据分析中最常用的部分就是页面指标名,页面获取以及页面数据聚合三个部分。我们先来看页面指标名,可以看到页面指标名被分为12个tab,我们可以很方便的对页面进行搜索,甚至可以理解这个页面代表的意思:然后我们看到页面数据聚合的部分,里面的模型这个tab很有意思,下图就是左边看到的那个模型:如果我们去除y轴,就是很清楚的能知道一个指标名对应了多少值。

这是datav中实现页面分析的一个机制。如果没有考虑到y轴,datav是怎么做的呢?datav还有一个重要的功能就是自动补全,去掉几个tab并不能发现一个简单的页面分析。所以datav还支持很多的js特性,完全没有必要考虑y轴的事情,这块可以自行研究。这里有个核心的算法,就是页面分析的包络回归算法,因为包络回归是必须要考虑y轴和页面坐标x轴坐标等坐标的先验信息,才能做一些简单的分析的。

这个是datav官方的解释:我们可以在datav编辑页面中选择“window_id”、“data_cache_base”等关键字,就可以获取“页面数据聚合”tab,注意自动添加用户名需要按照登录地址的格式获取:如果您对datav感兴趣,想要学习交流的话,可以点击这里:datav交流群。 查看全部

网页抓取数据分析工具的使用方法-datav的应用方法

网页抓取数据这个东西现在已经很常见了,市面上的数据分析工具也可以轻松满足这个需求。比如大家经常用的datav就可以轻松满足网页抓取的任务,而且它可以比较方便的抓取和分析网页中的数据,并且还支持完整的分析和可视化。下面我们来了解一下datav的使用方法。网页抓取首先用浏览器打开网页,然后手机浏览器点击打开这个网页:找到“数据分析”:然后用浏览器打开相应的数据的api接口,进入到datav编辑页面:可以看到datav中包含了现成的完整的网页分析api接口,并且文档和视频都是超清的。

一般来说,数据分析中最常用的部分就是页面指标名,页面获取以及页面数据聚合三个部分。我们先来看页面指标名,可以看到页面指标名被分为12个tab,我们可以很方便的对页面进行搜索,甚至可以理解这个页面代表的意思:然后我们看到页面数据聚合的部分,里面的模型这个tab很有意思,下图就是左边看到的那个模型:如果我们去除y轴,就是很清楚的能知道一个指标名对应了多少值。

这是datav中实现页面分析的一个机制。如果没有考虑到y轴,datav是怎么做的呢?datav还有一个重要的功能就是自动补全,去掉几个tab并不能发现一个简单的页面分析。所以datav还支持很多的js特性,完全没有必要考虑y轴的事情,这块可以自行研究。这里有个核心的算法,就是页面分析的包络回归算法,因为包络回归是必须要考虑y轴和页面坐标x轴坐标等坐标的先验信息,才能做一些简单的分析的。

这个是datav官方的解释:我们可以在datav编辑页面中选择“window_id”、“data_cache_base”等关键字,就可以获取“页面数据聚合”tab,注意自动添加用户名需要按照登录地址的格式获取:如果您对datav感兴趣,想要学习交流的话,可以点击这里:datav交流群。

网页抓取数据没有具体数据?哈哈哈哈哈哈我觉得这个问题

网站优化 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2022-09-17 00:05

网页抓取数据?没有具体数据??哈哈哈哈哈我觉得这个问题下面会有很多同学晒图

首先,你需要问问你自己需要什么,如果基础很差,就从基础开始学习。接下来就是看视频来辅助了,但是前提要能拿下java基础,java的话,视频可以关注看看,免费公开课。ssm框架,ps美工,

基础javase可以看慕课网

0基础学网页抓取可以看看这个免费的还可以加入群交流不懂的可以问我

没有具体数据,so。

跟着讲课老师的步伐走吧

没有,但是比较赞同另一个答主的看法。

你没有具体数据!抓取方面你可以买视频看看。至于交流群什么的加群交流啊,

没有具体数据!抓取可以看看慕课网的教程,你也可以买视频。

没有啊。首先要有技术然后才能考虑其他的。有技术的前提下,找个好师傅才是王道。

没有呀看书咯。不就是java基础和html基础嘛,跟着书来就好了,有什么说难不难。

emmmmmm第一步得开始学习dw 查看全部

网页抓取数据没有具体数据?哈哈哈哈哈哈我觉得这个问题

网页抓取数据?没有具体数据??哈哈哈哈哈我觉得这个问题下面会有很多同学晒图

首先,你需要问问你自己需要什么,如果基础很差,就从基础开始学习。接下来就是看视频来辅助了,但是前提要能拿下java基础,java的话,视频可以关注看看,免费公开课。ssm框架,ps美工,

基础javase可以看慕课网

0基础学网页抓取可以看看这个免费的还可以加入群交流不懂的可以问我

没有具体数据,so。

跟着讲课老师的步伐走吧

没有,但是比较赞同另一个答主的看法。

你没有具体数据!抓取方面你可以买视频看看。至于交流群什么的加群交流啊,

没有具体数据!抓取可以看看慕课网的教程,你也可以买视频。

没有啊。首先要有技术然后才能考虑其他的。有技术的前提下,找个好师傅才是王道。