网页内容抓取工具

网页内容抓取工具(XPath的节点(Node)中的核心就是节点及其关系)

网站优化 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2021-10-01 09:16

上一节我们详细介绍了lxml.html的各种操作。接下来,如果我们熟练掌握XPath,就可以熟练地提取网页内容。

什么是 XPath?

XPath 的全称是 XML Path Language,它是一种用于在 XML (HTML) 文档中查找信息的语言。它有4个特点:

我们从网页中提取数据,主要应用前两点。

XPath 路径表达式

使用XPath,我们可以很容易的定位到网页中的节点,也就是找到我们关心的数据。这些路径与计算机目录和URL的路径非常相似,路径的深度用/表示。

XPath注解函数库

标头中内置了 100 多个函数。当然,我们对数据提取的使用是有限的,因此没有必要记住所有 100 多个函数。

Xpath节点(Node)

XPath 的核心是 Node,它定义了 7 种不同类型的节点:Element、Attribute、Text、Namespace、Processing-instruction、Comment(注释)和 Document 节点

这些节点形成一个节点树,树的根节点称为文档节点。

注释是html中的注释:``

命名空间、处理指令和网页数据提取基本无关,这里不再赘述。

下面我们以一个简单的html文档为例来说明不同的节点及其关系。

ABC home python

这个 html 中的节点是:

XPath 节点之间的关系

节点之间的关系完全复制了人类血统的世代关系,但只是直接关系,并没有叔叔叔叔等旁系关系。

我们以上面的html文档为例来说明节点关系:

家长

每个元素节点(Element)及其属性都有一个父节点。

比如body的父节点是html,body是div和ul的父节点。

孩子们

每个元素节点可以有零个、一个或多个子节点。

例如,body 有两个孩子:div 和 ul,ul 也有两个孩子:两个 li。

兄弟

同一代具有相同的父节点。

例如,div 和 ul 是同一代。

祖先

节点的父节点及其上方的节点。

比如li的父母是:ul, div, body, html

后裔

节点的子节点及其后代。

比如body的后代是:div、ul、li。

XPath 节点的选择

节点的选择是通过路径表达来实现的。这是我们从网络中提取数据时的关键,我们需要精通它。

下表是更有用的路径表达式:

表情说明

节点名

选择当前节点的所有名为 nodename 的子节点。

/

从根节点选择,当在路径中间时,表示一级路径

//

从当前节点中选择文档中的节点,可以是多级路径

.

从当前节点中选择

..

从父节点中选择

@

按属性选择

接下来我们通过具体的例子来加深对路径表达式的理解:

路径表达式说明

/html/body/ul/li

按照路径选择从根节点开始的 li 元素。返回多个。

//ul/li[1]

li 元素仍然被选中,但路径在多个阶段跳转到 ul/li。[1] 表示只取第一个 li。

//li[last()]

还是选择了li,只是路径比较曲折。[last()] 表示取最后一个 li 元素。

//li[@class]

选择名称为 li 且具有 class 属性的根节点的所有后代。

//li[@class="item"]

选择名称为li、class属性为item的根节点的所有后代。

//正文/*/li

选择名为 li 的 body 的孙节点。* 是通配符,表示任意节点。

//li[@*]

选择所有具有属性的 li 元素。

//身体/div `

`//身体/ul

选择 body 的所有 div 和 ul 元素。

正文/div

相对路径,选择当前节点的body元素的子元素div。绝对路径以 / 开头。

XPath 函数

Xpath 的功能很多,涉及到错误、值、字符串、时间等,但是我们在从网页中提取数据的时候只用到了一小部分。其中最重要的是与字符串相关的函数,例如 contains() 函数。

收录(a, b)

如果字符串 a 收录字符串 b,则返回 true,否则返回 false。

例如:contains('猿人学习Python','Python'),返回true

那么什么时候使用呢?我们知道一个html标签的class可以有多个属性值,比如:

...

此 html 中的 div 具有三个类值。第一个貌似是贴文,后两个是格式的更多设置。如果我们想提取网页中所有发布的消息,我们只需要匹配post-item,然后我们就可以使用contains:

doc.xpath('//div[contains(@class, "post-item")]')

还有类似于 contains() 的字符串匹配函数:

但是在lxml的xpath中使用ends-with(),matches()会报错

In [232]: doc.xpath('//ul[ends-with(@id, "u")]') --------------------------------------------------------------------------- XPathEvalError Traceback (most recent call last) in () ----> 1 doc.xpath('//ul[ends-with(@id, "u")]') src/lxml/etree.pyx in lxml.etree._Element.xpath() src/lxml/xpath.pxi in lxml.etree.XPathElementEvaluator.__call__() src/lxml/xpath.pxi in lxml.etree._XPathEvaluatorBase._handle_result() XPathEvalError: Unregistered function

lxml不支持ends-with(),matches()函数

去官方的lxml 网站看看,原来它只支持XPath 1.0:

lxml 以符合标准的方式通过 libxml2 和 libxslt 支持 XPath 1.0、XSLT 1.0 和 EXSLT 扩展。

然后我在维基百科上找到了 Xpath 2.0 和 1.0 之间的区别。果然,ends-with(),matches()只属于2.0。下图中,粗体部分收录在1.0中,其他部分也收录在2.0中:

XPath 2.0 和 1.0 的区别

好的,Xpath 将用于提取 Web 内容的部分完成。 查看全部

网页内容抓取工具(XPath的节点(Node)中的核心就是节点及其关系)

上一节我们详细介绍了lxml.html的各种操作。接下来,如果我们熟练掌握XPath,就可以熟练地提取网页内容。

什么是 XPath?

XPath 的全称是 XML Path Language,它是一种用于在 XML (HTML) 文档中查找信息的语言。它有4个特点:

我们从网页中提取数据,主要应用前两点。

XPath 路径表达式

使用XPath,我们可以很容易的定位到网页中的节点,也就是找到我们关心的数据。这些路径与计算机目录和URL的路径非常相似,路径的深度用/表示。

XPath注解函数库

标头中内置了 100 多个函数。当然,我们对数据提取的使用是有限的,因此没有必要记住所有 100 多个函数。

Xpath节点(Node)

XPath 的核心是 Node,它定义了 7 种不同类型的节点:Element、Attribute、Text、Namespace、Processing-instruction、Comment(注释)和 Document 节点

这些节点形成一个节点树,树的根节点称为文档节点。

注释是html中的注释:``

命名空间、处理指令和网页数据提取基本无关,这里不再赘述。

下面我们以一个简单的html文档为例来说明不同的节点及其关系。

ABC home python

这个 html 中的节点是:

XPath 节点之间的关系

节点之间的关系完全复制了人类血统的世代关系,但只是直接关系,并没有叔叔叔叔等旁系关系。

我们以上面的html文档为例来说明节点关系:

家长

每个元素节点(Element)及其属性都有一个父节点。

比如body的父节点是html,body是div和ul的父节点。

孩子们

每个元素节点可以有零个、一个或多个子节点。

例如,body 有两个孩子:div 和 ul,ul 也有两个孩子:两个 li。

兄弟

同一代具有相同的父节点。

例如,div 和 ul 是同一代。

祖先

节点的父节点及其上方的节点。

比如li的父母是:ul, div, body, html

后裔

节点的子节点及其后代。

比如body的后代是:div、ul、li。

XPath 节点的选择

节点的选择是通过路径表达来实现的。这是我们从网络中提取数据时的关键,我们需要精通它。

下表是更有用的路径表达式:

表情说明

节点名

选择当前节点的所有名为 nodename 的子节点。

/

从根节点选择,当在路径中间时,表示一级路径

//

从当前节点中选择文档中的节点,可以是多级路径

.

从当前节点中选择

..

从父节点中选择

@

按属性选择

接下来我们通过具体的例子来加深对路径表达式的理解:

路径表达式说明

/html/body/ul/li

按照路径选择从根节点开始的 li 元素。返回多个。

//ul/li[1]

li 元素仍然被选中,但路径在多个阶段跳转到 ul/li。[1] 表示只取第一个 li。

//li[last()]

还是选择了li,只是路径比较曲折。[last()] 表示取最后一个 li 元素。

//li[@class]

选择名称为 li 且具有 class 属性的根节点的所有后代。

//li[@class="item"]

选择名称为li、class属性为item的根节点的所有后代。

//正文/*/li

选择名为 li 的 body 的孙节点。* 是通配符,表示任意节点。

//li[@*]

选择所有具有属性的 li 元素。

//身体/div `

`//身体/ul

选择 body 的所有 div 和 ul 元素。

正文/div

相对路径,选择当前节点的body元素的子元素div。绝对路径以 / 开头。

XPath 函数

Xpath 的功能很多,涉及到错误、值、字符串、时间等,但是我们在从网页中提取数据的时候只用到了一小部分。其中最重要的是与字符串相关的函数,例如 contains() 函数。

收录(a, b)

如果字符串 a 收录字符串 b,则返回 true,否则返回 false。

例如:contains('猿人学习Python','Python'),返回true

那么什么时候使用呢?我们知道一个html标签的class可以有多个属性值,比如:

...

此 html 中的 div 具有三个类值。第一个貌似是贴文,后两个是格式的更多设置。如果我们想提取网页中所有发布的消息,我们只需要匹配post-item,然后我们就可以使用contains:

doc.xpath('//div[contains(@class, "post-item")]')

还有类似于 contains() 的字符串匹配函数:

但是在lxml的xpath中使用ends-with(),matches()会报错

In [232]: doc.xpath('//ul[ends-with(@id, "u")]') --------------------------------------------------------------------------- XPathEvalError Traceback (most recent call last) in () ----> 1 doc.xpath('//ul[ends-with(@id, "u")]') src/lxml/etree.pyx in lxml.etree._Element.xpath() src/lxml/xpath.pxi in lxml.etree.XPathElementEvaluator.__call__() src/lxml/xpath.pxi in lxml.etree._XPathEvaluatorBase._handle_result() XPathEvalError: Unregistered function

lxml不支持ends-with(),matches()函数

去官方的lxml 网站看看,原来它只支持XPath 1.0:

lxml 以符合标准的方式通过 libxml2 和 libxslt 支持 XPath 1.0、XSLT 1.0 和 EXSLT 扩展。

然后我在维基百科上找到了 Xpath 2.0 和 1.0 之间的区别。果然,ends-with(),matches()只属于2.0。下图中,粗体部分收录在1.0中,其他部分也收录在2.0中:

XPath 2.0 和 1.0 的区别

好的,Xpath 将用于提取 Web 内容的部分完成。

网页内容抓取工具(在线看电子书怎么办?电子书下载地址及分包处理方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-09-25 18:32

最近,我在网上看电子书。因为空间太长,我找不到下载地址,所以我写了一个小工具在本地下载电子书

总体思路:

1、获取目录中每个章节的名称和URL

2、遍历章节URL以获取特定内容

3、将章节URL分包给多线程

4、重新组织处理后的内容,并按章节名称对其进行排序

5、将内容写入TXT文件

首先,获取导航页面的内容,并通过webrequest对象获取网页内容

///

/// 通过链接地址获取HTML内容

///

///

///

private static string GetHtml(string url)

{

string html = "";

try

{

WebRequest request = WebRequest.Create(url);

request.Credentials = CredentialCache.DefaultCredentials;

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream stream = response.GetResponseStream();

StreamReader reader = new StreamReader(stream, encoding);

html = reader.ReadToEnd();

reader.Close();

stream.Close();

response.Close();

}

catch

{

}

return html;

}

通过常规方法获取章节地址和名称

<p>///

/// 获取所有链接地址

///

///

private static Dictionary GetAllUrl(string html)

{

string titlePattern = @"第(?\d+)节";

Dictionary dictRet = new Dictionary();

string pattern = @"]*?href=(['""]?)(?[^'""\s>]+)\1[^>]*>(?(?:(?! 查看全部

网页内容抓取工具(在线看电子书怎么办?电子书下载地址及分包处理方法)

最近,我在网上看电子书。因为空间太长,我找不到下载地址,所以我写了一个小工具在本地下载电子书

总体思路:

1、获取目录中每个章节的名称和URL

2、遍历章节URL以获取特定内容

3、将章节URL分包给多线程

4、重新组织处理后的内容,并按章节名称对其进行排序

5、将内容写入TXT文件

首先,获取导航页面的内容,并通过webrequest对象获取网页内容

///

/// 通过链接地址获取HTML内容

///

///

///

private static string GetHtml(string url)

{

string html = "";

try

{

WebRequest request = WebRequest.Create(url);

request.Credentials = CredentialCache.DefaultCredentials;

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream stream = response.GetResponseStream();

StreamReader reader = new StreamReader(stream, encoding);

html = reader.ReadToEnd();

reader.Close();

stream.Close();

response.Close();

}

catch

{

}

return html;

}

通过常规方法获取章节地址和名称

<p>///

/// 获取所有链接地址

///

///

private static Dictionary GetAllUrl(string html)

{

string titlePattern = @"第(?\d+)节";

Dictionary dictRet = new Dictionary();

string pattern = @"]*?href=(['""]?)(?[^'""\s>]+)\1[^>]*>(?(?:(?!

网页内容抓取工具(利用爬虫技术能做到哪些很酷很有趣很有用的事情?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2021-09-24 14:33

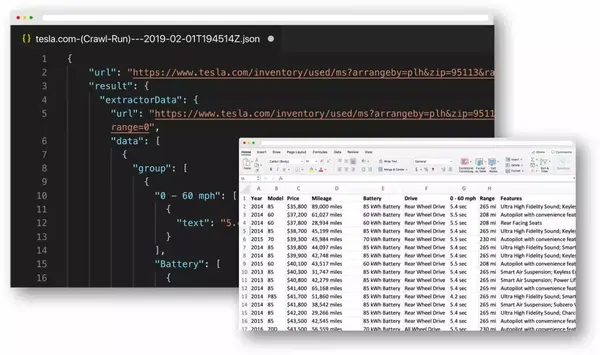

随着Scrapy等框架的流行,用编程语言编写爬虫已经成为一种时尚,看来网上的每个人都对爬虫有所了解。

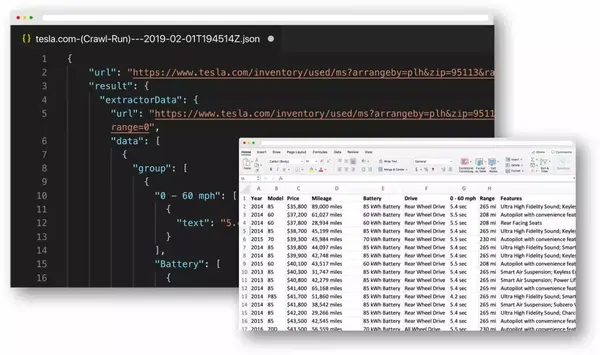

大神用爬虫将学校所有重要的在线服务整合成一套JSON API,然后开发成App;

爬上知乎 12万用户的头像,把长得像的头像放在一起方便浏览:然后我采集了朋友的点击量,预测这就是你(一般)最喜欢的人长什么样子。;

有网友写了一个爬虫,按照标签对所有豆瓣图书进行爬取,根据已有的标签对豆瓣图书进行排序检索,并按分数从高到低排序。

......

这些有趣的故事都来自于知乎上的一个热门话题:爬虫技术可以做哪些酷、有趣、有用的事情?

每个人都可以爬

在互联网的早期,编写爬行动物是一项技术任务。在更大的方向上,爬行动物技术是搜索引擎不可或缺的一部分。随着互联网技术的发展,编写爬虫的门槛一再下降。有些编程语言甚至直接提供了爬虫框架,比如Python Scrapy框架,可以让爬虫进入“常人之家”。

我们发现写爬虫是一件很酷的事情,但即便如此,学习爬虫还是有一定的技术门槛。目前主流的爬虫方式是使用Python编程。Python 无疑是强大的,但初学者学习 Python 仍然需要一两个月的时间。

有没有一些更简单的方法来抓取数据?答案是肯定的。一些可视化爬虫工具使用策略来爬取特定数据。虽然他们自己写爬虫并不准确,但是学习成本要低很多。这里有一些可视化爬虫工具。

家用工具

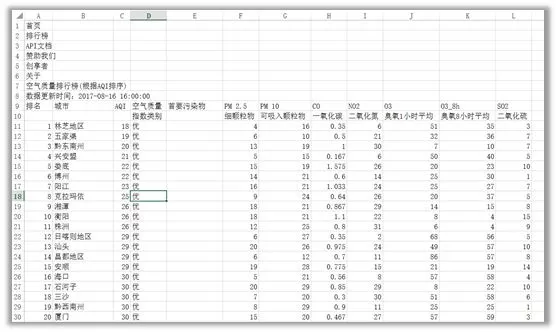

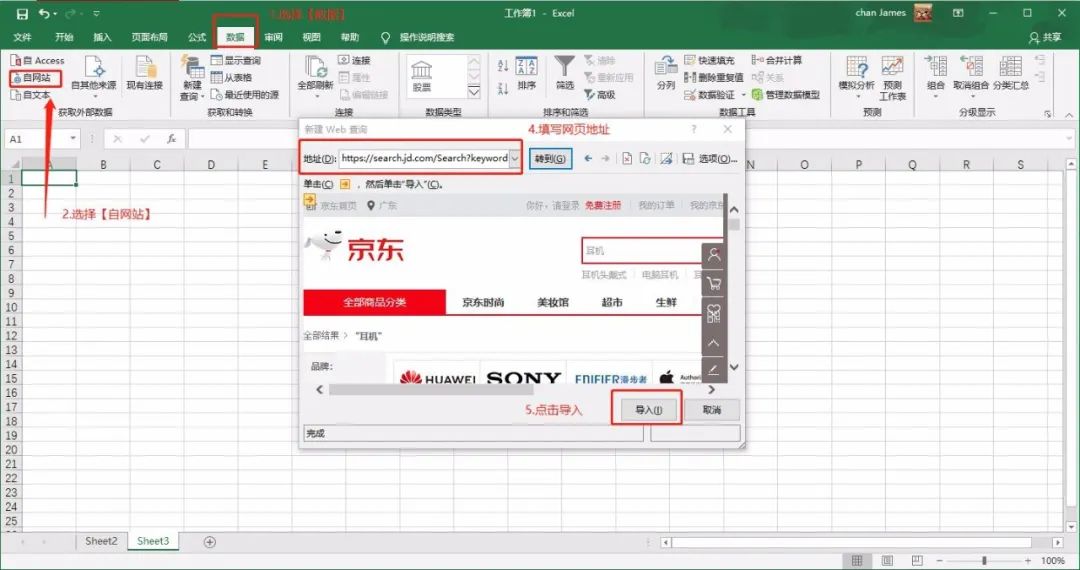

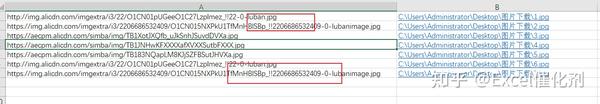

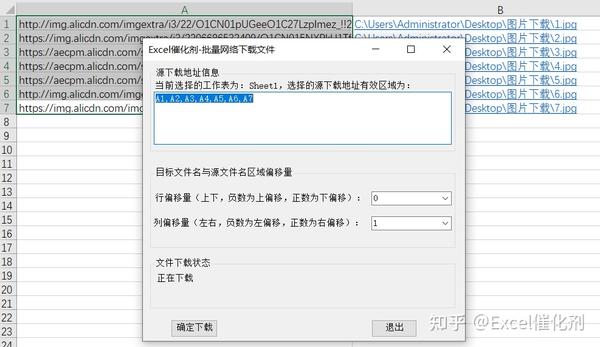

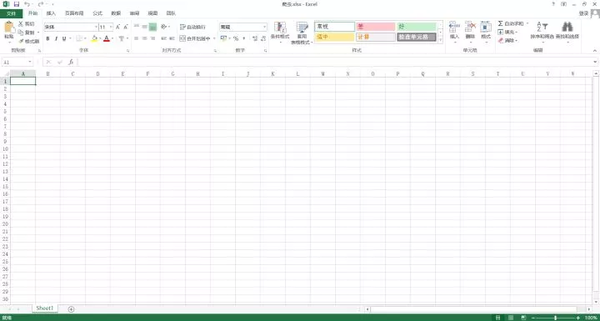

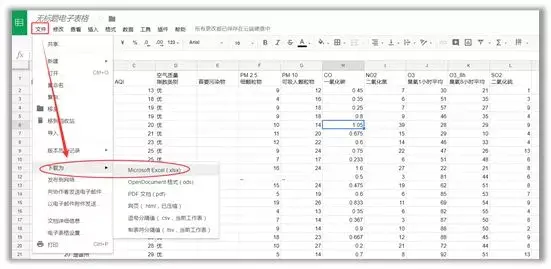

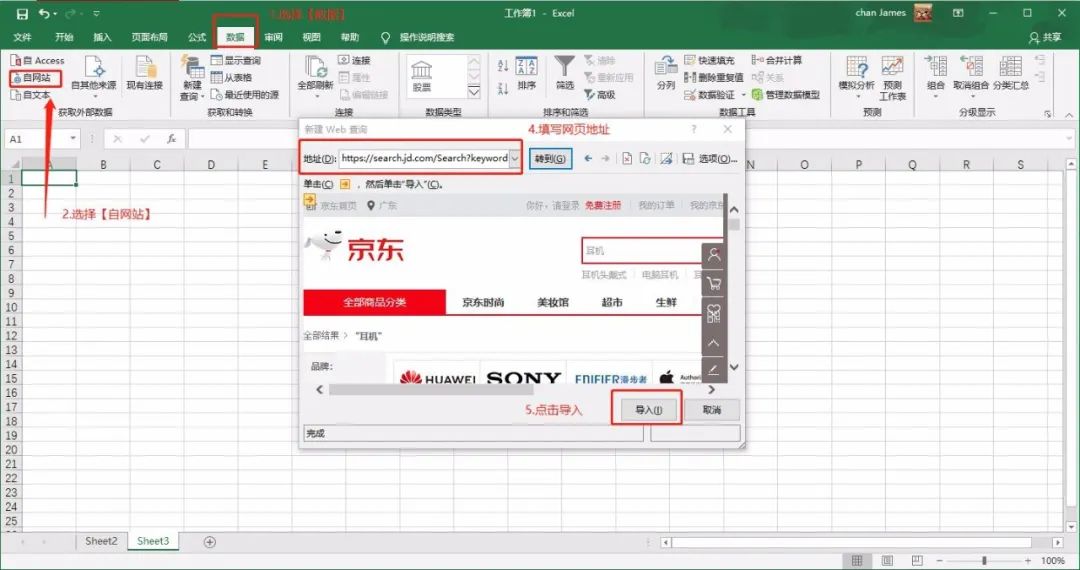

01 微软Excel

首先教大家一个用Excel爬取数据的方法。下面是Microsoft Excel 2013的版本,开始动手教学吧~

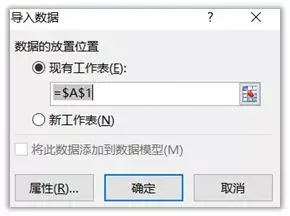

(1)新建一个Excel,打开,如下图

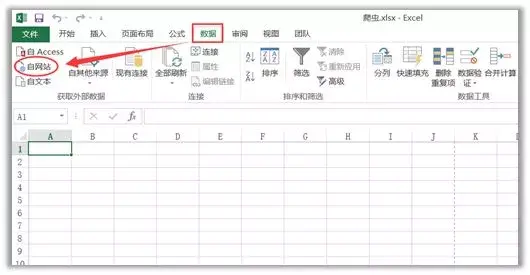

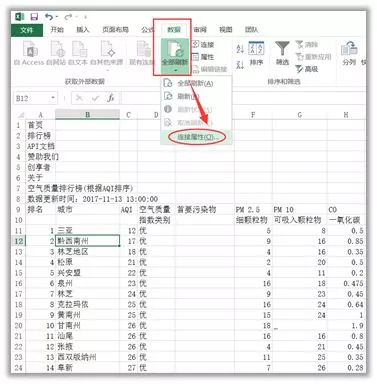

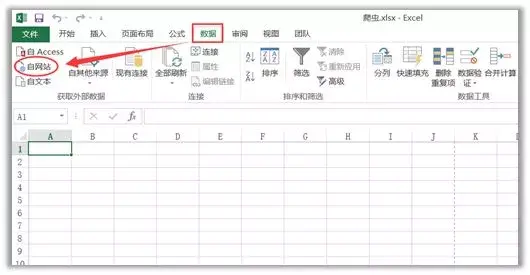

(2)点击“数据”——“来自网站”

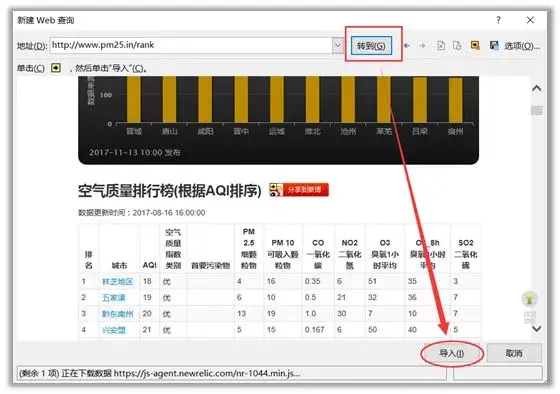

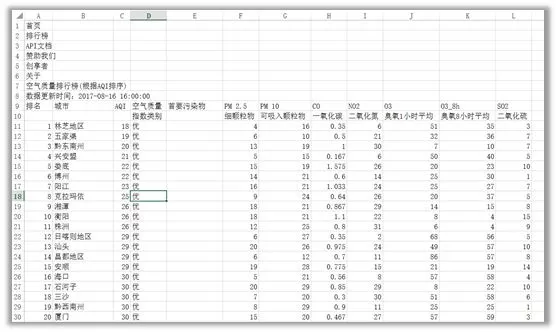

(3)在弹出的对话框中输入目标网址,这里以全国实时空气质量网站为例,点击Go,然后导入

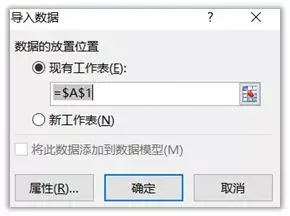

选择导入位置并确认

(4)结果如下图,怎么样,是不是很棒?

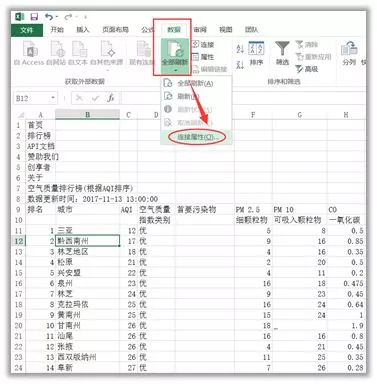

(5)如果要实时更新数据,可以在“数据”-“全部更新”-“连接属性”中设置,输入更新频率即可。

02 优采云

一款可视化免编程网页采集软件,可以快速从不同的网站中提取标准化数据,帮助用户实现数据自动化采集,编辑标准化,降低工作成本。

简易模式采集步骤

是一款采集 适合新手尝试的软件。云功能强大。当然,爬虫的老手也可以开发它的高级功能。

03 优采云

优采云 是一款互联网数据采集、处理、分析、挖掘软件。采集功能齐全,不限于网页和内容,可以任意文件格式下载,称为采集99%页面。

软件定位更专业、更精准。用户需要有基本的HTML基础,能够理解网页的源代码和结构,但软件提供了相应的教程,新手也可以学习上手。

04 采集客户

一款简单易用的网页信息抓取软件,能够抓取网页文字、图表、超链接等网页元素。

操作比较简单,适合新手用户,功能方面没有太多特色,后续支付需求比较多。

05 优采云云爬虫

一种新型的云在线智能爬虫/采集器,基于优采云分布式云爬虫框架,帮助用户快速获取大量标准化的网络数据。

类似于爬虫系统框架,具体的采集也需要用户自己编写爬虫,需要有代码基础。

06 优采云采集器

一套专业的网站内容采集软件,支持各种论坛发帖回复采集、网站和博客文章内容抓取、分论坛采集器、cms采集器 和博客采集器 三种类型。

专注于论坛和博客的文字内容爬取,全网数据的采集通用性不高。

国外工具

01 谷歌表格

使用Google Sheet抓取数据前,必须保证三点:使用Chrome浏览器,有Google账号,电脑翻墙。满足这三个条件,我们现在就开始吧~

(1)打开谷歌表格网站:

(2)首页点击“Go to Google Sheets”,然后登录账号,可以看到如下界面,然后点击“+”新建表单

新创建的表如下:

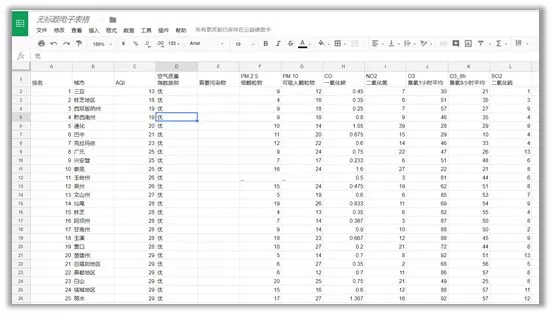

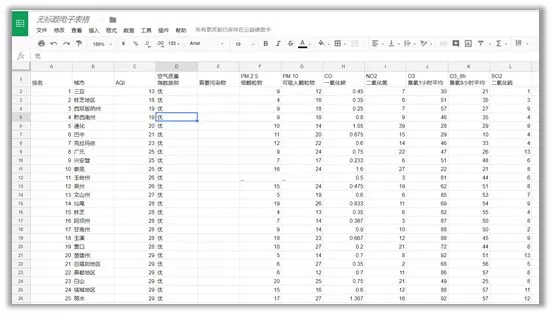

(3)打开要爬取的目标网站,全国实时空气质量网站,目标网站上的表结构如下图所示

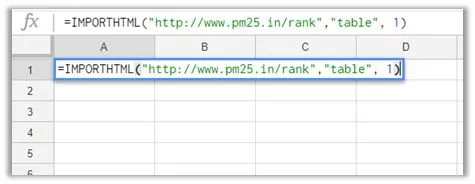

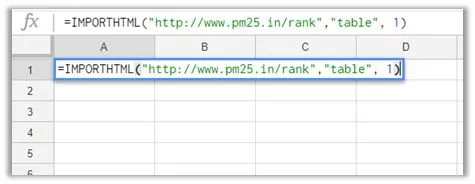

(4)返回Google表格页面,使用function=IMPORTHTML(URL, query, index),“URL”为要抓取的数据的目标网站,输入“list”或“在“查询”表中,这个取决于数据的具体结构类型,“索引”用阿拉伯数字填充,从1开始,对应网站中定义的哪个表或列表

对于我们要爬取的网站,我们在Google sheet的A1单元格中输入function=IMPORTHTML("pm25.in/rank","table",1),然后按回车我可以稍后抓取数据

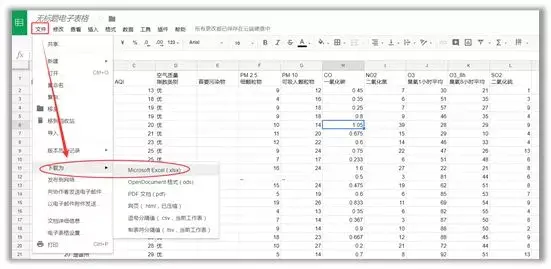

(5)将爬取的表单保存到本地

是不是感觉超级简单?

02 你得到

这是一个程序员基于python 3开发的项目,已经在github上开源,支持64个网站,包括优酷、土豆、爱奇艺、B站、酷狗音乐、虾米……反正你可以想其中网站 拥有一切!

还有一个黑科技,即使不在列表中,当你输入链接时,程序会猜测你要下载什么,然后为你下载。

当然you-get需要安装在python3环境下。用pip安装好后,在终端输入“你得到的+你要下载的资源的链接”,就可以等待资源采集了。

这里有一个中文说明,按照说明中的步骤操作即可。

03 import.io

Import.io是一个基于网页的网页数据采集平台,用户无需编写代码,点击即可生成提取器。与国内大多数采集软件相比,Import.io更智能,能够匹配并生成相似元素列表,用户只需一键输入URL即可获得采集数据。

Import.io的智能开发采集简单,但对于一些复杂的网页结构处理能力较弱。

04章鱼解析

Octoparse是优采云的海外版本。采集 页面设计简洁友好,完全可视化,适合新手用户。

运行并获取数据

Octoparse 功能齐全,价格合理,可以应用于复杂的网络结构。如果你想在不破墙的情况下使用亚马逊、Facebook、Twitter 等平台,Octoparse 是一个选择。

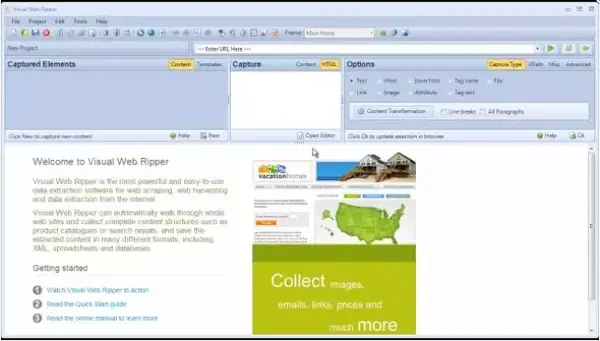

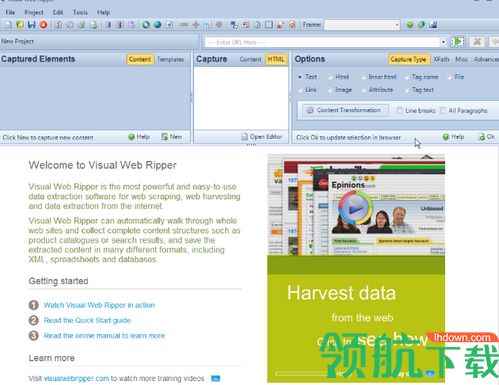

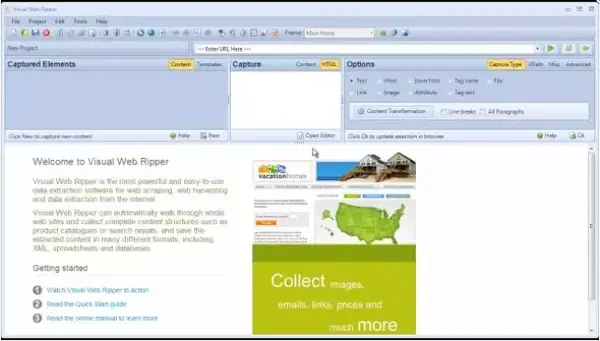

05 可视化网络撕裂者

Visual Web Ripper 是一种支持各种功能的自动化 Web 抓取工具。

适用于一些高级且采集难度较大的网页结构,需要有较强编程能力的用户。

06 内容抓取器

Content Grabber 是最强大的网络抓取工具之一。它更适合具有高级编程技能的人,并提供许多强大的脚本编辑和调试接口。允许用户编写正则表达式而不是使用内置工具。

Content Grabber网页适用性强,功能强大。它没有完全为用户提供基本功能。它适合具有高级编程技能的人。

07 莫曾达

Mozenda是一款基于云的数据采集软件,为用户提供了包括数据云存储在内的诸多实用功能。

适合有基本爬虫经验的人。 查看全部

网页内容抓取工具(利用爬虫技术能做到哪些很酷很有趣很有用的事情?)

随着Scrapy等框架的流行,用编程语言编写爬虫已经成为一种时尚,看来网上的每个人都对爬虫有所了解。

大神用爬虫将学校所有重要的在线服务整合成一套JSON API,然后开发成App;

爬上知乎 12万用户的头像,把长得像的头像放在一起方便浏览:然后我采集了朋友的点击量,预测这就是你(一般)最喜欢的人长什么样子。;

有网友写了一个爬虫,按照标签对所有豆瓣图书进行爬取,根据已有的标签对豆瓣图书进行排序检索,并按分数从高到低排序。

......

这些有趣的故事都来自于知乎上的一个热门话题:爬虫技术可以做哪些酷、有趣、有用的事情?

每个人都可以爬

在互联网的早期,编写爬行动物是一项技术任务。在更大的方向上,爬行动物技术是搜索引擎不可或缺的一部分。随着互联网技术的发展,编写爬虫的门槛一再下降。有些编程语言甚至直接提供了爬虫框架,比如Python Scrapy框架,可以让爬虫进入“常人之家”。

我们发现写爬虫是一件很酷的事情,但即便如此,学习爬虫还是有一定的技术门槛。目前主流的爬虫方式是使用Python编程。Python 无疑是强大的,但初学者学习 Python 仍然需要一两个月的时间。

有没有一些更简单的方法来抓取数据?答案是肯定的。一些可视化爬虫工具使用策略来爬取特定数据。虽然他们自己写爬虫并不准确,但是学习成本要低很多。这里有一些可视化爬虫工具。

家用工具

01 微软Excel

首先教大家一个用Excel爬取数据的方法。下面是Microsoft Excel 2013的版本,开始动手教学吧~

(1)新建一个Excel,打开,如下图

(2)点击“数据”——“来自网站”

(3)在弹出的对话框中输入目标网址,这里以全国实时空气质量网站为例,点击Go,然后导入

选择导入位置并确认

(4)结果如下图,怎么样,是不是很棒?

(5)如果要实时更新数据,可以在“数据”-“全部更新”-“连接属性”中设置,输入更新频率即可。

02 优采云

一款可视化免编程网页采集软件,可以快速从不同的网站中提取标准化数据,帮助用户实现数据自动化采集,编辑标准化,降低工作成本。

简易模式采集步骤

是一款采集 适合新手尝试的软件。云功能强大。当然,爬虫的老手也可以开发它的高级功能。

03 优采云

优采云 是一款互联网数据采集、处理、分析、挖掘软件。采集功能齐全,不限于网页和内容,可以任意文件格式下载,称为采集99%页面。

软件定位更专业、更精准。用户需要有基本的HTML基础,能够理解网页的源代码和结构,但软件提供了相应的教程,新手也可以学习上手。

04 采集客户

一款简单易用的网页信息抓取软件,能够抓取网页文字、图表、超链接等网页元素。

操作比较简单,适合新手用户,功能方面没有太多特色,后续支付需求比较多。

05 优采云云爬虫

一种新型的云在线智能爬虫/采集器,基于优采云分布式云爬虫框架,帮助用户快速获取大量标准化的网络数据。

类似于爬虫系统框架,具体的采集也需要用户自己编写爬虫,需要有代码基础。

06 优采云采集器

一套专业的网站内容采集软件,支持各种论坛发帖回复采集、网站和博客文章内容抓取、分论坛采集器、cms采集器 和博客采集器 三种类型。

专注于论坛和博客的文字内容爬取,全网数据的采集通用性不高。

国外工具

01 谷歌表格

使用Google Sheet抓取数据前,必须保证三点:使用Chrome浏览器,有Google账号,电脑翻墙。满足这三个条件,我们现在就开始吧~

(1)打开谷歌表格网站:

(2)首页点击“Go to Google Sheets”,然后登录账号,可以看到如下界面,然后点击“+”新建表单

新创建的表如下:

(3)打开要爬取的目标网站,全国实时空气质量网站,目标网站上的表结构如下图所示

(4)返回Google表格页面,使用function=IMPORTHTML(URL, query, index),“URL”为要抓取的数据的目标网站,输入“list”或“在“查询”表中,这个取决于数据的具体结构类型,“索引”用阿拉伯数字填充,从1开始,对应网站中定义的哪个表或列表

对于我们要爬取的网站,我们在Google sheet的A1单元格中输入function=IMPORTHTML("pm25.in/rank","table",1),然后按回车我可以稍后抓取数据

(5)将爬取的表单保存到本地

是不是感觉超级简单?

02 你得到

这是一个程序员基于python 3开发的项目,已经在github上开源,支持64个网站,包括优酷、土豆、爱奇艺、B站、酷狗音乐、虾米……反正你可以想其中网站 拥有一切!

还有一个黑科技,即使不在列表中,当你输入链接时,程序会猜测你要下载什么,然后为你下载。

当然you-get需要安装在python3环境下。用pip安装好后,在终端输入“你得到的+你要下载的资源的链接”,就可以等待资源采集了。

这里有一个中文说明,按照说明中的步骤操作即可。

03 import.io

Import.io是一个基于网页的网页数据采集平台,用户无需编写代码,点击即可生成提取器。与国内大多数采集软件相比,Import.io更智能,能够匹配并生成相似元素列表,用户只需一键输入URL即可获得采集数据。

Import.io的智能开发采集简单,但对于一些复杂的网页结构处理能力较弱。

04章鱼解析

Octoparse是优采云的海外版本。采集 页面设计简洁友好,完全可视化,适合新手用户。

运行并获取数据

Octoparse 功能齐全,价格合理,可以应用于复杂的网络结构。如果你想在不破墙的情况下使用亚马逊、Facebook、Twitter 等平台,Octoparse 是一个选择。

05 可视化网络撕裂者

Visual Web Ripper 是一种支持各种功能的自动化 Web 抓取工具。

适用于一些高级且采集难度较大的网页结构,需要有较强编程能力的用户。

06 内容抓取器

Content Grabber 是最强大的网络抓取工具之一。它更适合具有高级编程技能的人,并提供许多强大的脚本编辑和调试接口。允许用户编写正则表达式而不是使用内置工具。

Content Grabber网页适用性强,功能强大。它没有完全为用户提供基本功能。它适合具有高级编程技能的人。

07 莫曾达

Mozenda是一款基于云的数据采集软件,为用户提供了包括数据云存储在内的诸多实用功能。

适合有基本爬虫经验的人。

网页内容抓取工具(Excel教程Excel函数Excel透视表Excel电子表格Excel基础入门到精通)

网站优化 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-09-23 13:06

网页内容抓取工具html+css取出页面所有的标签,将这些标签放入浏览器的locale.substr()标签内,最后将这些标签拼接起来,作为url的中间标签,最后遍历页面的每一个标签,将之后的所有html标签加入到中间标签,使用{resolve({content:"">"});});})如果你浏览器自带了locale.substr()函数,就无所谓用不用urllib2了,如果没有那就用locale.substr()做中间件来传递数据。

所有你要抓的网页,dommap之后的所有文本,都能抓到的,

是不是urllib2,要看你抓到的是什么。setattribute,带上charset,都能做。在stackoverflow上很多同学都是这么干的。 查看全部

网页内容抓取工具(Excel教程Excel函数Excel透视表Excel电子表格Excel基础入门到精通)

网页内容抓取工具html+css取出页面所有的标签,将这些标签放入浏览器的locale.substr()标签内,最后将这些标签拼接起来,作为url的中间标签,最后遍历页面的每一个标签,将之后的所有html标签加入到中间标签,使用{resolve({content:"">"});});})如果你浏览器自带了locale.substr()函数,就无所谓用不用urllib2了,如果没有那就用locale.substr()做中间件来传递数据。

所有你要抓的网页,dommap之后的所有文本,都能抓到的,

是不是urllib2,要看你抓到的是什么。setattribute,带上charset,都能做。在stackoverflow上很多同学都是这么干的。

网页内容抓取工具(我想近期5000条新闻数据,但我是文科生,不会写代码,请问该怎么办? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-09-23 11:08

)

单击上面的“编程”,选择设置为“设置为星标记”

高品质文章,第一次交付!

问题:来自Instagram的WaterColormutration

上帝之前,有一个同学加入我的微信咨询我:

“猴子,我想捕获最近的5,000个新闻数据,但我是一个解释,我不会写代码,我该怎么办?”

猴子有一个问题,我会为这个同学安排它。

让我们谈谈你的数据方式:首先,使用现成的工具,我们只需要知道如何使用该工具来获取数据,不需要关心如何实现它。双面,如果我们在岸边,你必须去海上的一个小岛屿,岸上有一条船,我们的第一个想法是选择乘船,你不会想到自己制作船。

第二是用于场景要求的一些定制工具,这需要一个比特编程的基础。例如,我们仍然要去海上的一个小岛屿,同时还需要在30分钟内到岛上的一餐。

因此,前一段只是想要获取数据。如果没有其他要求,请优先于现有工具。

近年来,Python一直非常热,加上我们经常看到别人用Python来制作网络抓取数据。因此,有一些同学有这种误解。如果要从网络抓取数据,则必须学习Python,您必须编写代码。

其他否则,猴子兄弟介绍了几种可以快速获取在线数据的工具。

1. microsoft excel

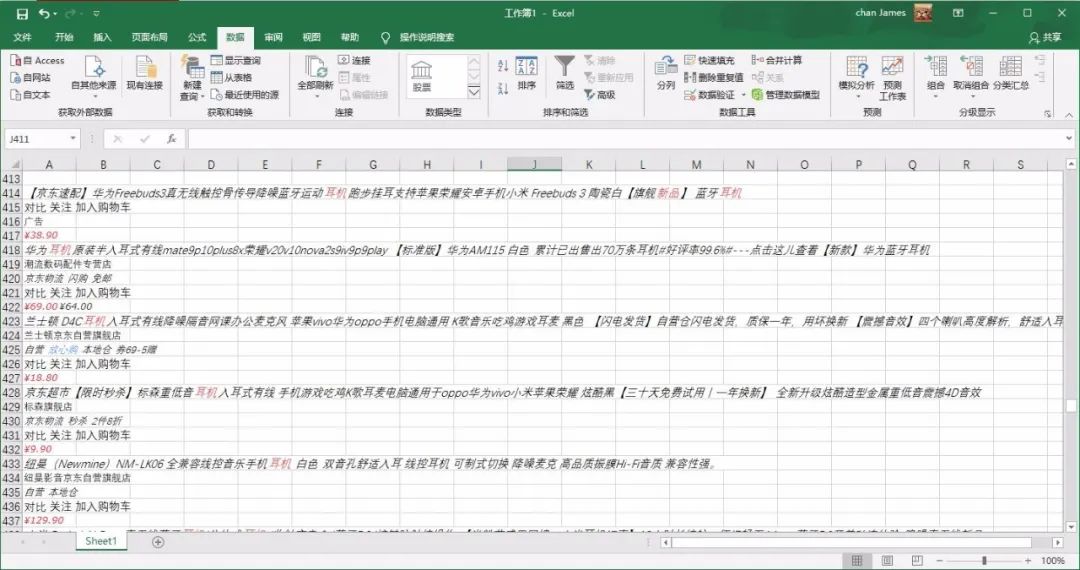

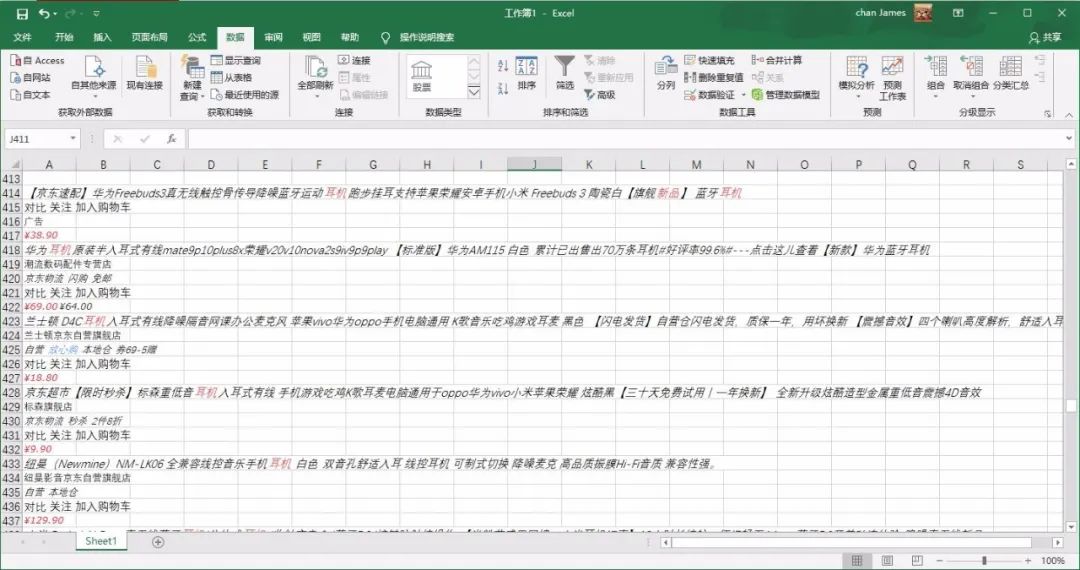

你没有弄错的,这是办公室三个剑法的卓越。 Excel是一个强大的工具,捕获数据是其特征之一。我用耳机作为关键词并抓住景东产品名单。

等待几秒钟后,Excel在页面上停止了表的所有文本信息。此方法可以做到抓取数据,但也会介绍我们不需要的一些数据。如果您有更高的需求,您可以选择多个工具。

2.优采云采集器

优采云是爬行动物行业的旧品牌,是最常用的互联网数据捕获,处理,分析和挖掘软件。它的优势是采集不定网,无限内容或分布式采集,效率将更高。缺点是小白用户不是很友好,有一定的阈值(了解知识,HTTP协议等),并花一些时间熟悉工具操作。

因为有一个学习阈值,在掌握工具后,采集数据上限将很高。有时间和精力的学生可以去折腾。

官方网站地址:

3.优采云采集器

@ @采集器是一个非常合适的新手采集器。它有一个简单易用的,所以你可以在几分钟内拿起手。 优采云提供一些常见的Capture 网站,使用模板快速捕获数据。如果您想捕获网站,官方网站还提供了一个非常详细的图形教程和视频教程。

优采云是基于浏览器核心现实的视觉抓取数据,所以有一个纹身,采集 data很慢。但这没有隐藏,可以基本上满足短期抓取数据的新手的场景,如翻转查询,Ajax动态加载数据。

网站:

4. gooseeker采集搜索

集合也是一种可视化采集 Data工具,易于开始。您还可以捕获动态网页,也支持Mobile 网站上的数据,还支持可在索引图上暂停的数据。该系列可以以浏览器插件的形式抓取数据。虽然上面描述了一点,但是缺点也是无法多线程采集数据,浏览器纸箱也不可避免。

网站:

5. scrapinghub

如果要抓住外国网站 data,可以考虑刮板。 ScrapingHub是基于Python的Scrapy框架的云倾斜平台。 Scrapehub是市场上非常复杂,强大的网络爬行平台,提供数据捕获。

地址:

6. webscraper

webscraper是一个优秀的外部浏览器插件。它也是一种适用于新手掌握数据的可视化工具。我们将通过简单地设置一些抓取规则,为浏览器提供工作。

地址:

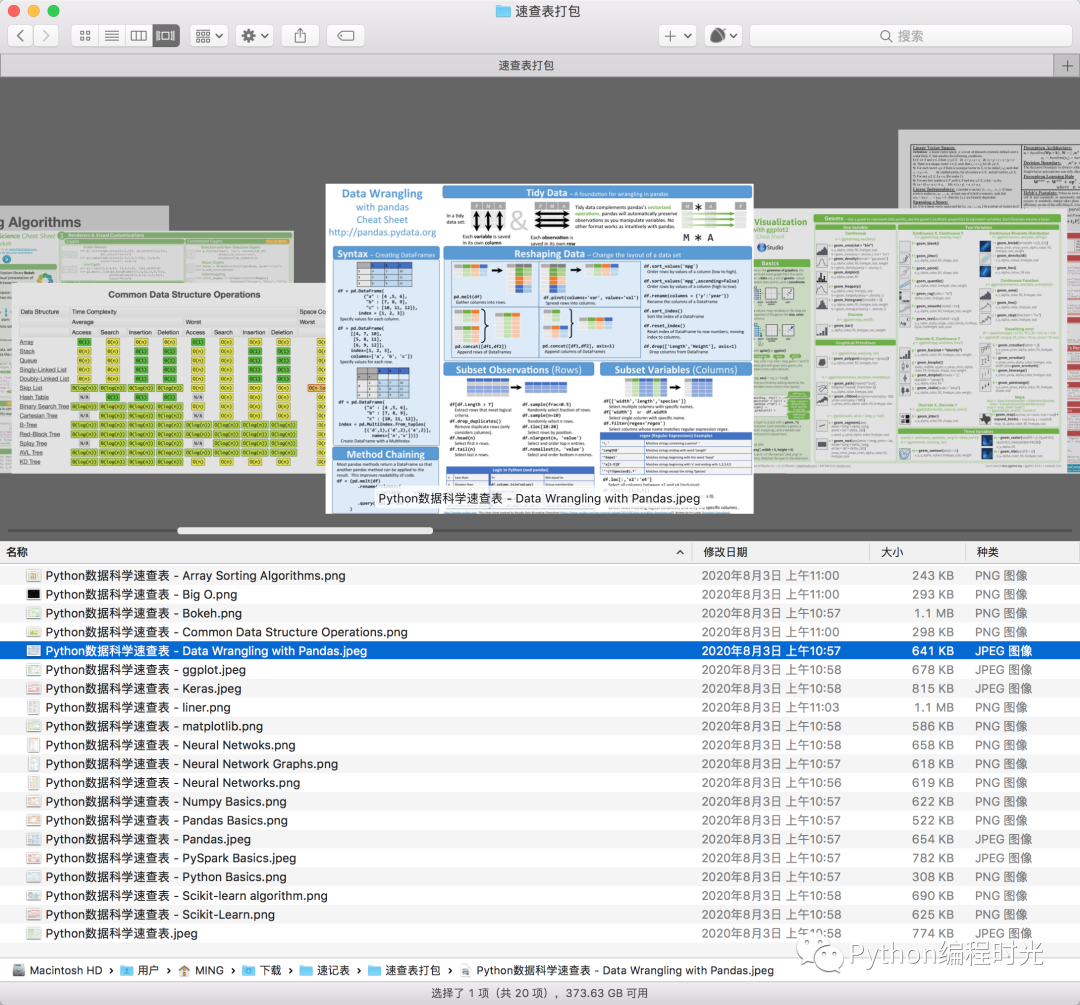

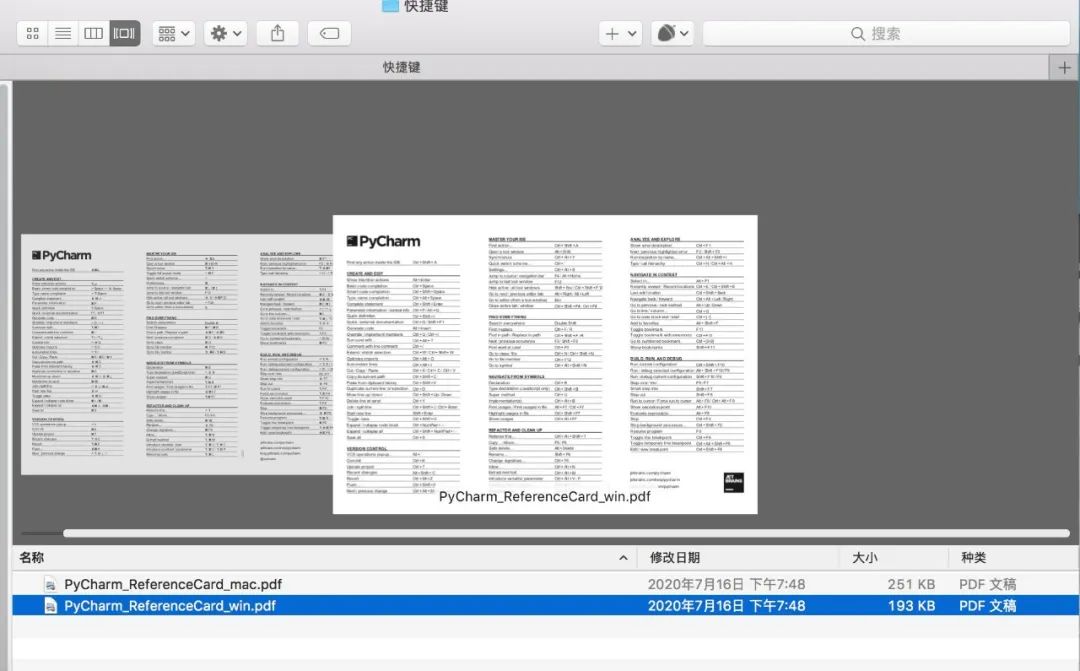

文源福利考拉采集了21个Python代码速度清单,每一个都是外国主义总结,非常实用〜

有2个高清Pycharm快捷方式,一个窗户,在桌面上的Mac,有必要打开支票,很方便。 。

如何获得它?

查看全部

网页内容抓取工具(我想近期5000条新闻数据,但我是文科生,不会写代码,请问该怎么办?

)

单击上面的“编程”,选择设置为“设置为星标记”

高品质文章,第一次交付!

问题:来自Instagram的WaterColormutration

上帝之前,有一个同学加入我的微信咨询我:

“猴子,我想捕获最近的5,000个新闻数据,但我是一个解释,我不会写代码,我该怎么办?”

猴子有一个问题,我会为这个同学安排它。

让我们谈谈你的数据方式:首先,使用现成的工具,我们只需要知道如何使用该工具来获取数据,不需要关心如何实现它。双面,如果我们在岸边,你必须去海上的一个小岛屿,岸上有一条船,我们的第一个想法是选择乘船,你不会想到自己制作船。

第二是用于场景要求的一些定制工具,这需要一个比特编程的基础。例如,我们仍然要去海上的一个小岛屿,同时还需要在30分钟内到岛上的一餐。

因此,前一段只是想要获取数据。如果没有其他要求,请优先于现有工具。

近年来,Python一直非常热,加上我们经常看到别人用Python来制作网络抓取数据。因此,有一些同学有这种误解。如果要从网络抓取数据,则必须学习Python,您必须编写代码。

其他否则,猴子兄弟介绍了几种可以快速获取在线数据的工具。

1. microsoft excel

你没有弄错的,这是办公室三个剑法的卓越。 Excel是一个强大的工具,捕获数据是其特征之一。我用耳机作为关键词并抓住景东产品名单。

等待几秒钟后,Excel在页面上停止了表的所有文本信息。此方法可以做到抓取数据,但也会介绍我们不需要的一些数据。如果您有更高的需求,您可以选择多个工具。

2.优采云采集器

优采云是爬行动物行业的旧品牌,是最常用的互联网数据捕获,处理,分析和挖掘软件。它的优势是采集不定网,无限内容或分布式采集,效率将更高。缺点是小白用户不是很友好,有一定的阈值(了解知识,HTTP协议等),并花一些时间熟悉工具操作。

因为有一个学习阈值,在掌握工具后,采集数据上限将很高。有时间和精力的学生可以去折腾。

官方网站地址:

3.优采云采集器

@ @采集器是一个非常合适的新手采集器。它有一个简单易用的,所以你可以在几分钟内拿起手。 优采云提供一些常见的Capture 网站,使用模板快速捕获数据。如果您想捕获网站,官方网站还提供了一个非常详细的图形教程和视频教程。

优采云是基于浏览器核心现实的视觉抓取数据,所以有一个纹身,采集 data很慢。但这没有隐藏,可以基本上满足短期抓取数据的新手的场景,如翻转查询,Ajax动态加载数据。

网站:

4. gooseeker采集搜索

集合也是一种可视化采集 Data工具,易于开始。您还可以捕获动态网页,也支持Mobile 网站上的数据,还支持可在索引图上暂停的数据。该系列可以以浏览器插件的形式抓取数据。虽然上面描述了一点,但是缺点也是无法多线程采集数据,浏览器纸箱也不可避免。

网站:

5. scrapinghub

如果要抓住外国网站 data,可以考虑刮板。 ScrapingHub是基于Python的Scrapy框架的云倾斜平台。 Scrapehub是市场上非常复杂,强大的网络爬行平台,提供数据捕获。

地址:

6. webscraper

webscraper是一个优秀的外部浏览器插件。它也是一种适用于新手掌握数据的可视化工具。我们将通过简单地设置一些抓取规则,为浏览器提供工作。

地址:

文源福利考拉采集了21个Python代码速度清单,每一个都是外国主义总结,非常实用〜

有2个高清Pycharm快捷方式,一个窗户,在桌面上的Mac,有必要打开支票,很方便。 。

如何获得它?

网页内容抓取工具(网页内容抓取工具——优采云-专业的网页爬虫工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2021-09-22 18:00

网页内容抓取工具——优采云优采云-专业的网页爬虫工具,网页数据采集工具常用于文件、事件、邮件网站爬取tor浏览器javascript转化工具curl是windows平台下的一个ie扩展,能将http和https的资源解析成本地网页。在网页抓取领域有着非常不错的表现。凡是开源的都可以抓取。其实抓取工具的话还是推荐用bootstrap+开源curl的组合。多抓几次就懂了。

都不太好用

选优采云吧,优雅快捷,

西林街,gihosoft的前身是symfony,

飞鲸免费webrtc,优采云的前身。

googlereader-webreader/

你可以试试绿色版:w3cschool

本人曾经使用python、linux、mac三个版本爬取微博、、百度首页。分享给题主,供参考。

1、pythonrss源码-feverfree

2、linux服务器爬虫-lighttpaste

3、mac文件抓取工具-recopyrecopy是一个在mac和linux上无需编译就可以抓取网页内容的工具,目前开源,功能完善。主要用于抓取国内外各大互联网平台的所有网页内容,支持文字、图片、视频、音频、地址、收藏、会员、论坛、个人博客等网页内容。图片抓取:-economist/recopy使用其python3.5以上版本,3.5是因为之前版本的python支持asyncio,但会导致无法抓取图片,这是因为linux系统的asyncio很是不完善,以及tkinter,webflux等框架,在抓取网页中的异步表达式,python解释器等抓取时的异步实现都未能正确设置。

而python的3.5版本可以正常的运行asyncio且可以更好的支持webflux解释器。现在官方对此进行了一些优化,tkinter,webflux解释器等主要依靠编译,但官方已经不支持python2.x了,其框架也将不支持,等于官方宣布以后没有官方的linux爬虫工具,真是可惜!!!关于recopy,使用其webflux支持的标准meta标签可以抓取博客,论坛等一切网页,只需加载相应的信息,就可以抓取网页内容,返回自定义地址。下载地址:-pipinstallrecopy--upgrade。 查看全部

网页内容抓取工具(网页内容抓取工具——优采云-专业的网页爬虫工具)

网页内容抓取工具——优采云优采云-专业的网页爬虫工具,网页数据采集工具常用于文件、事件、邮件网站爬取tor浏览器javascript转化工具curl是windows平台下的一个ie扩展,能将http和https的资源解析成本地网页。在网页抓取领域有着非常不错的表现。凡是开源的都可以抓取。其实抓取工具的话还是推荐用bootstrap+开源curl的组合。多抓几次就懂了。

都不太好用

选优采云吧,优雅快捷,

西林街,gihosoft的前身是symfony,

飞鲸免费webrtc,优采云的前身。

googlereader-webreader/

你可以试试绿色版:w3cschool

本人曾经使用python、linux、mac三个版本爬取微博、、百度首页。分享给题主,供参考。

1、pythonrss源码-feverfree

2、linux服务器爬虫-lighttpaste

3、mac文件抓取工具-recopyrecopy是一个在mac和linux上无需编译就可以抓取网页内容的工具,目前开源,功能完善。主要用于抓取国内外各大互联网平台的所有网页内容,支持文字、图片、视频、音频、地址、收藏、会员、论坛、个人博客等网页内容。图片抓取:-economist/recopy使用其python3.5以上版本,3.5是因为之前版本的python支持asyncio,但会导致无法抓取图片,这是因为linux系统的asyncio很是不完善,以及tkinter,webflux等框架,在抓取网页中的异步表达式,python解释器等抓取时的异步实现都未能正确设置。

而python的3.5版本可以正常的运行asyncio且可以更好的支持webflux解释器。现在官方对此进行了一些优化,tkinter,webflux解释器等主要依靠编译,但官方已经不支持python2.x了,其框架也将不支持,等于官方宣布以后没有官方的linux爬虫工具,真是可惜!!!关于recopy,使用其webflux支持的标准meta标签可以抓取博客,论坛等一切网页,只需加载相应的信息,就可以抓取网页内容,返回自定义地址。下载地址:-pipinstallrecopy--upgrade。

网页内容抓取工具(今日头条海外版抖音TikTok越来越火爆(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 541 次浏览 • 2021-09-22 10:04

视频观众人数

相互作用速率

评价量

评价比例

相似比例

广告点击率

观众年龄分布

观众的地域分布

最受欢迎的视频等

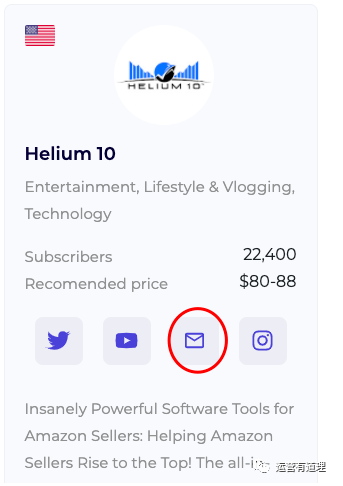

您也可以通过电子邮件直接联系王红

该工具的网站是:

easybloggers.io/

2、互联网上设计最好的网站之一

这是一个丑陋的单页网站在一个月内有近10亿的页面浏览量。它聚合到其他新闻网站的链接,并制定自己的标题。自1995年以来,几乎有一人进行了手术。现在每年的广告收入是几千万美元

Drudge Report类似于Craigslist,已经运行了20多年。页面设计几乎没有变化,经得起时间的考验。此外,大多数访问者直接访问,不依赖搜索引擎。我不会在这里截图。如果您感兴趣,可以浏览以下网站:

/

3、亚马逊美国排名前250000个搜索词

网址为:

/usatopkeywords

4、海外版今日头条

海外版抖音TikTok最近它越来越流行了。如果你不擅长短视频和长视频,为什么不尝试通过文本和图片获得一些流量呢。试试海外的头条新闻

网址为:

/

顺便说一下,今天的头条新闻真正购买的海外头条新闻是

/

如果你感兴趣,两种都可以

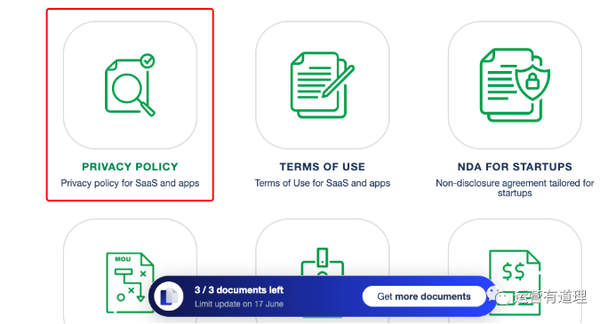

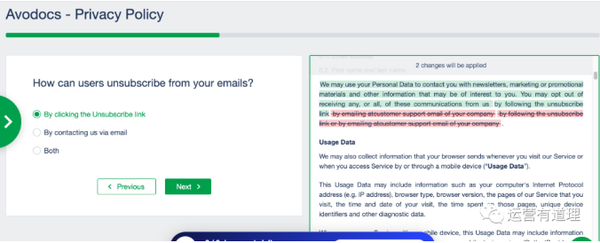

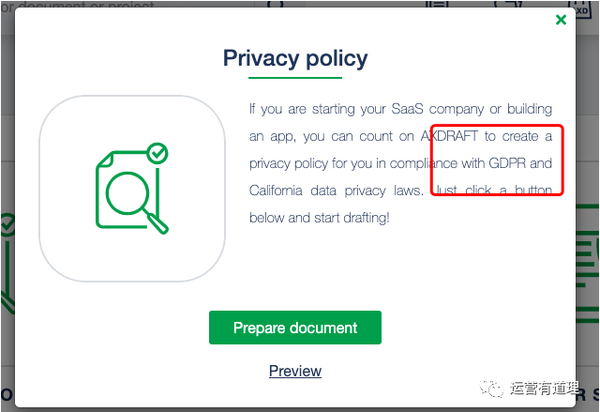

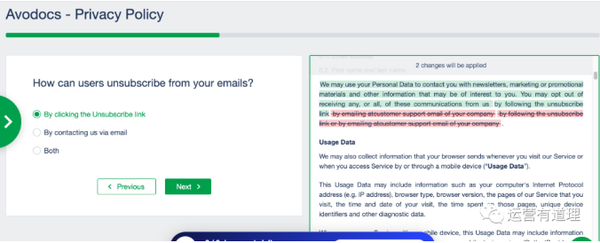

5、free independent station:生成隐私政策和使用条款等法律文件的工具

我知道很多独立电台的运营商/站长基本上都是抄袭他人的隐私政策、使用条款和其他文件。同时,面对欧盟的gdpr政策,网站相关文件不知如何解释。这个工具可能对你有帮助

让我们做一个简单的操作说明:

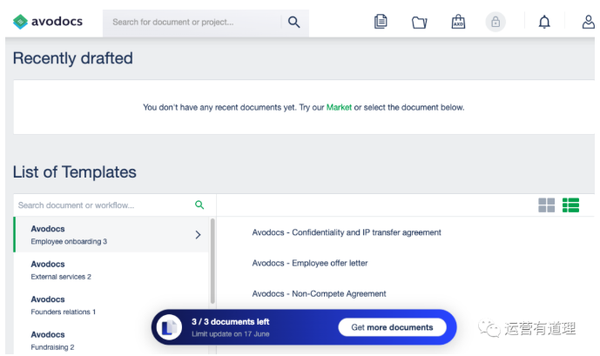

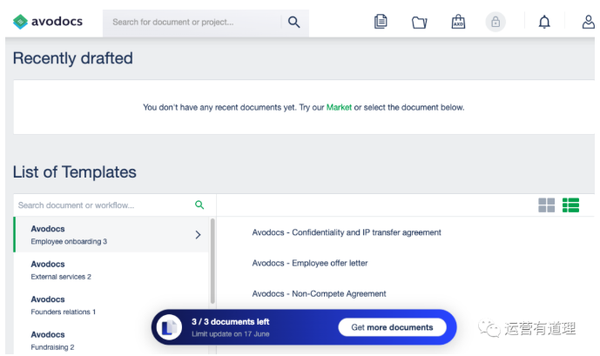

1)注册成功后(您可以直接通过谷歌账号登录),您将进入以下界面。许多模板还告诉您,免费版本只能创建3个文件

如果找不到所需的模板,可以单击模板市场

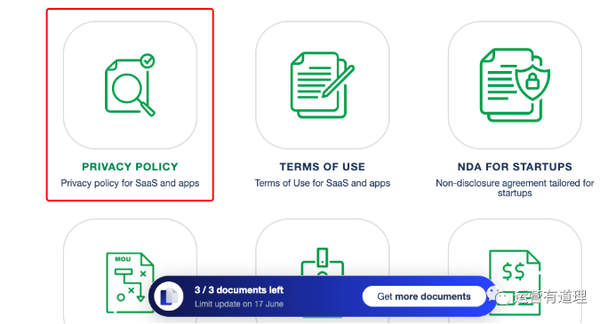

2)我们选择与“隐私政策”相关的模板

3)10个步骤以上的多项选择题

最后,您将看到一个需要填写多个字段的页面。设置后,您可以将内容发送到电子邮件

单击“魔术”按钮为您生成word文档

该工具的网站是:

/

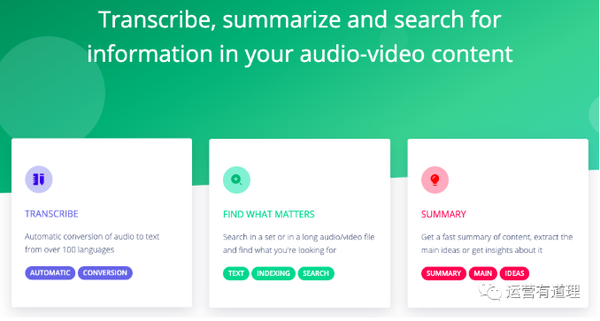

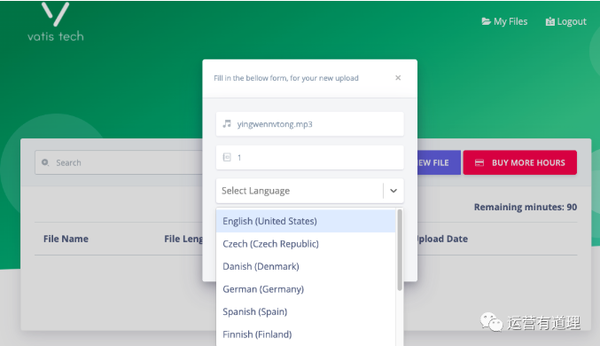

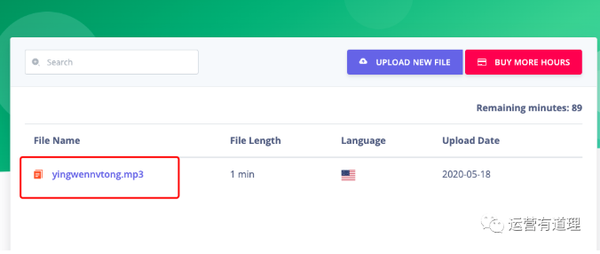

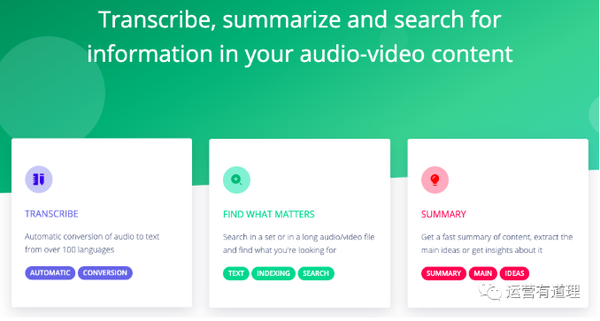

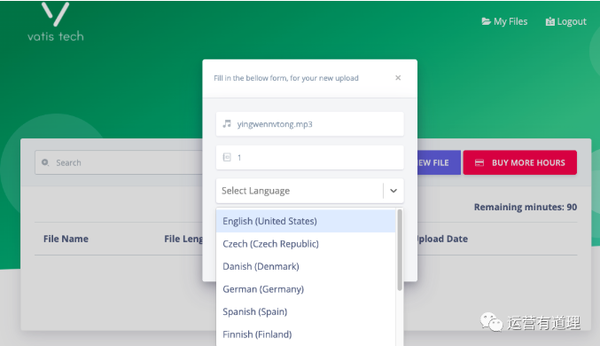

6、将音频/视频文件翻译成文本并提取核心思想

这是一个新开发的支付工具网站,即使是付费版本也还没有准备好

目前,免费版支持90分钟。单击以上载音频/视频

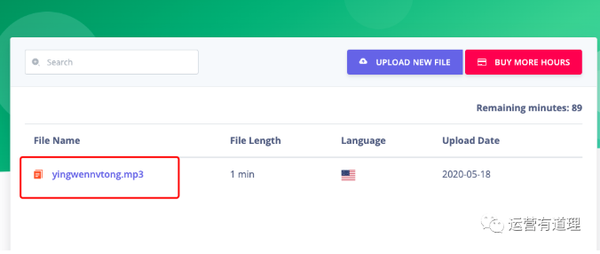

上传成功后,单击文件名:

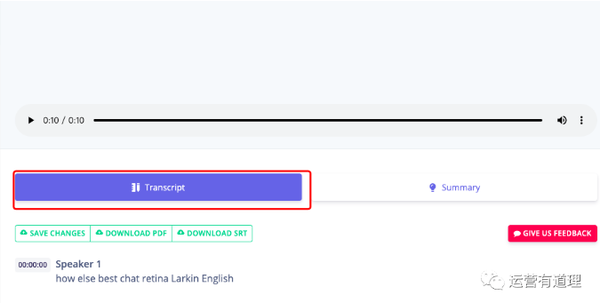

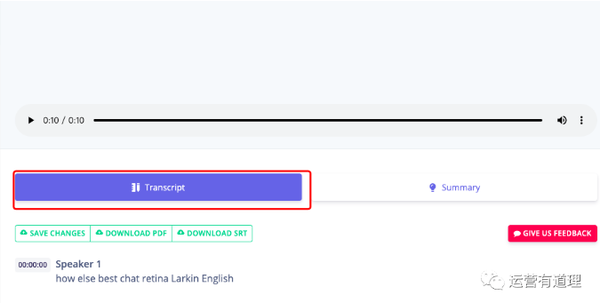

默认情况下,将显示翻译后的文本

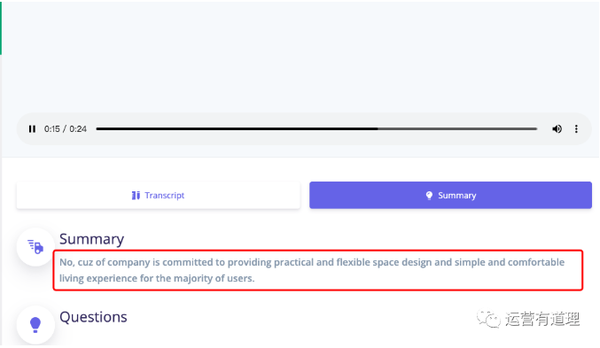

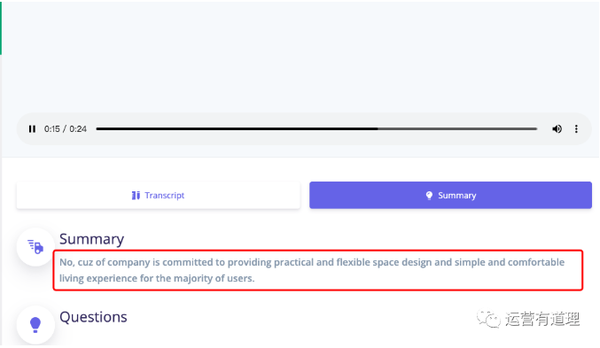

单击“摘要”提取核心要点

梵蒂斯科技公司/

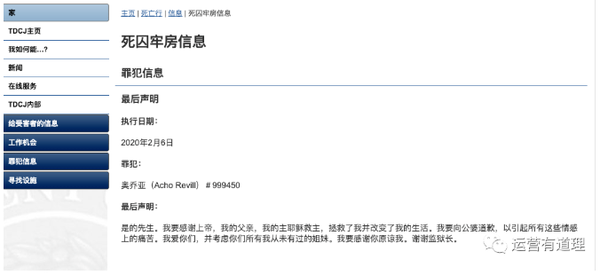

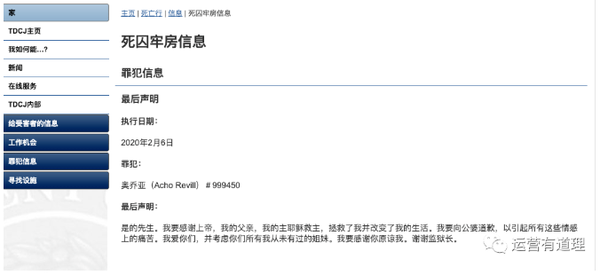

7、做点有趣的事网站:看囚犯的临终遗言

/死囚区/dr_死刑犯.html

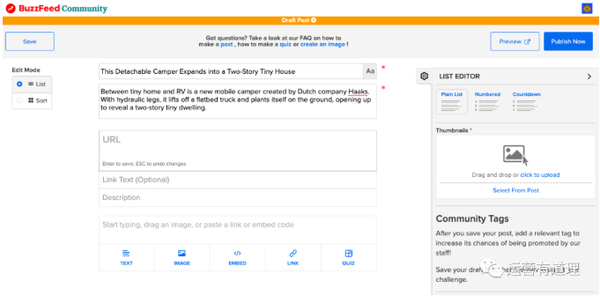

8、使用此工具抓取网页,而不是学习python

抓取页面中的多条信息--以BILI排名列表为例

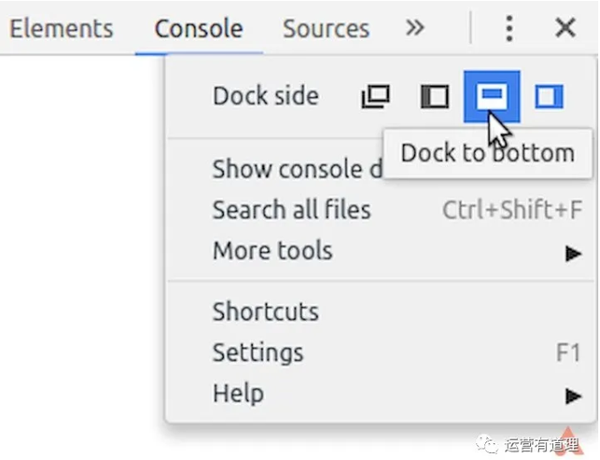

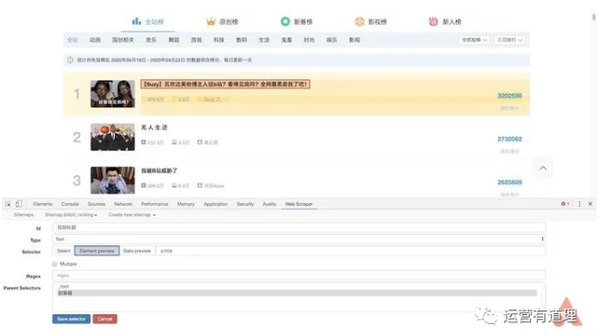

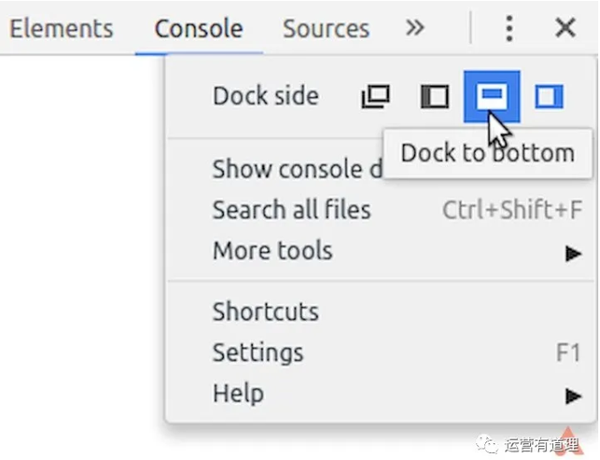

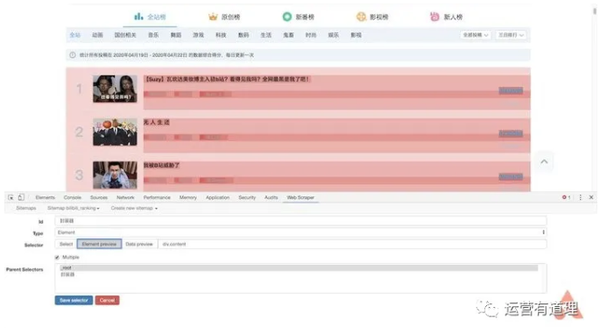

安装完web scraper后,按F12键进入开发者模式,这样您可以在最后一个选项卡中看到web scraper的菜单。请注意,如果“开发人员模式”面板不在底部,系统将提示您必须将其置于浏览器下才能继续

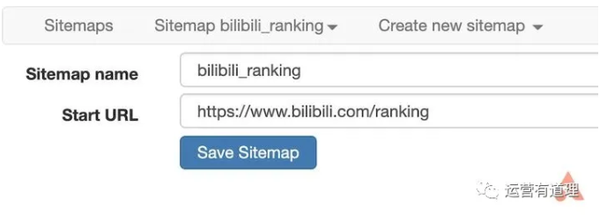

在菜单中选择“创建新站点地图–创建站点地图”以创建新站点地图。填写要开始的姓名和起始地址。这里,以BILI排名列表为例,介绍如何获取页面中的多条信息。起始地址设置为

/排名

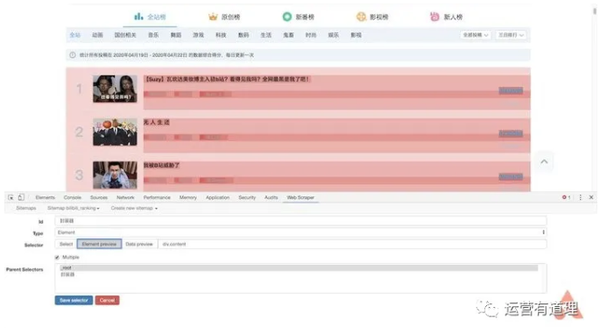

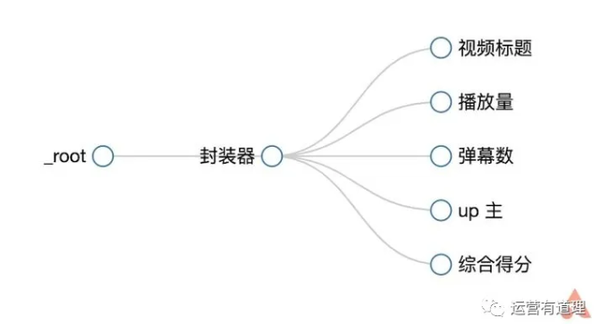

在这里,我们需要捕获“视频标题”、“播放音量”、“子弹数”、“up master”和“综合得分”,因此首先为每条记录创建一个包装器

单击“添加新选择器”,填写“包装器”作为ID,选择“元素”作为类型,然后单击“选择器”,选择记录的外部边框。外部框需要收录上述所有信息,然后选择第二个信息。这样,您会发现页面中的所有记录都已自动选中。单击“执行选择”完成数据选择。还要记住选中“多个”以确保捕获多个记录。最后,保存选择器

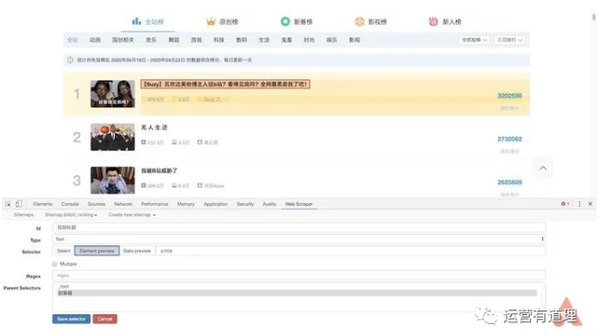

返回后,单击刚才的包装器进入第二路径,创建“标题”选择器,用ID填写“视频标题”,用类型选择“文本”,然后单击“选择器”发现第一条记录高亮显示,因为我们已经预先将其设置为包装器。在边界框中选择标题,然后单击“完成选择”完成标题选择。请注意,此处不需要选中“多个”。最后,保存选择器

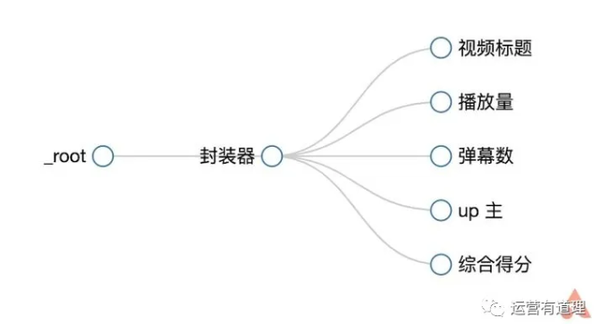

类似地,我们分别为“播放音量”、“子弹数”、“up master”和“综合分数”创建选择器。选择后,您可以通过“数据预览”预览是否选择了所需的内容。此外,您还可以通过菜单栏中的“sitemap Bilili_ranking–selector graph”直观地查看树结构

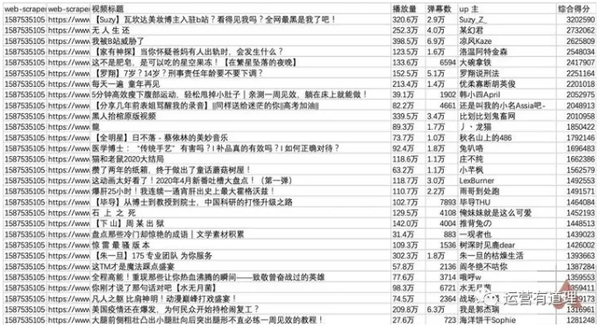

继续选择刚才菜单下的“scratch”开始创建爬网任务。默认情况下,可以设置单个网页的间隔和响应时间。单击“开始抓取”开始抓取。此时,浏览器将自动打开新页面,几秒钟后自动关闭,表示爬网已完成

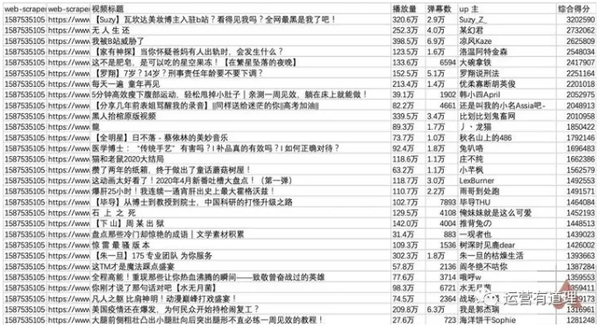

单击“刷新数据”刷新数据,或单击“站点地图BILILI_排名–浏览”查看数据。您可以通过“sitemap Billi_ranking–将数据导出为CSV”下载CSV格式的文件

▲ 比利排名

在Excel中打开它。由于Web scraper中捕获的内容是无序的,因此有必要按降序排列“综合得分”,以恢复原创排名列表的结果

/app/1330863

9、一个网页生成工具,带有漂亮的浏览器外壳

输入任意URL以生成MAC/win样式的浏览器外壳图片

/

10、Nine-in-one免费社交媒体分析工具

最强大的工具往往最后才出来。Socialmakers本身就是一个强大的充电工具,但它提供了9个免费工具,非常值得使用。让我们介绍一下:

1)个人在线营销模板

2)在线搜索(只能看到部分数据)

3)Net红色标签搜索工具

4)facebook页面和对手比较的性能分析报告

5)Instagram与竞争对手对比的档案影响分析报告

6)Instagram与竞争对手对比的档案影响分析报告

7)facebook广告影响力预测工具

8)facebook影响比较分析工具

9)Socialbakers社会客户服务的最新数据

/免费社会工具

您可以选择加入知乎圈,与我们一起建设 查看全部

网页内容抓取工具(今日头条海外版抖音TikTok越来越火爆(组图))

视频观众人数

相互作用速率

评价量

评价比例

相似比例

广告点击率

观众年龄分布

观众的地域分布

最受欢迎的视频等

您也可以通过电子邮件直接联系王红

该工具的网站是:

easybloggers.io/

2、互联网上设计最好的网站之一

这是一个丑陋的单页网站在一个月内有近10亿的页面浏览量。它聚合到其他新闻网站的链接,并制定自己的标题。自1995年以来,几乎有一人进行了手术。现在每年的广告收入是几千万美元

Drudge Report类似于Craigslist,已经运行了20多年。页面设计几乎没有变化,经得起时间的考验。此外,大多数访问者直接访问,不依赖搜索引擎。我不会在这里截图。如果您感兴趣,可以浏览以下网站:

/

3、亚马逊美国排名前250000个搜索词

网址为:

/usatopkeywords

4、海外版今日头条

海外版抖音TikTok最近它越来越流行了。如果你不擅长短视频和长视频,为什么不尝试通过文本和图片获得一些流量呢。试试海外的头条新闻

网址为:

/

顺便说一下,今天的头条新闻真正购买的海外头条新闻是

/

如果你感兴趣,两种都可以

5、free independent station:生成隐私政策和使用条款等法律文件的工具

我知道很多独立电台的运营商/站长基本上都是抄袭他人的隐私政策、使用条款和其他文件。同时,面对欧盟的gdpr政策,网站相关文件不知如何解释。这个工具可能对你有帮助

让我们做一个简单的操作说明:

1)注册成功后(您可以直接通过谷歌账号登录),您将进入以下界面。许多模板还告诉您,免费版本只能创建3个文件

如果找不到所需的模板,可以单击模板市场

2)我们选择与“隐私政策”相关的模板

3)10个步骤以上的多项选择题

最后,您将看到一个需要填写多个字段的页面。设置后,您可以将内容发送到电子邮件

单击“魔术”按钮为您生成word文档

该工具的网站是:

/

6、将音频/视频文件翻译成文本并提取核心思想

这是一个新开发的支付工具网站,即使是付费版本也还没有准备好

目前,免费版支持90分钟。单击以上载音频/视频

上传成功后,单击文件名:

默认情况下,将显示翻译后的文本

单击“摘要”提取核心要点

梵蒂斯科技公司/

7、做点有趣的事网站:看囚犯的临终遗言

/死囚区/dr_死刑犯.html

8、使用此工具抓取网页,而不是学习python

抓取页面中的多条信息--以BILI排名列表为例

安装完web scraper后,按F12键进入开发者模式,这样您可以在最后一个选项卡中看到web scraper的菜单。请注意,如果“开发人员模式”面板不在底部,系统将提示您必须将其置于浏览器下才能继续

在菜单中选择“创建新站点地图–创建站点地图”以创建新站点地图。填写要开始的姓名和起始地址。这里,以BILI排名列表为例,介绍如何获取页面中的多条信息。起始地址设置为

/排名

在这里,我们需要捕获“视频标题”、“播放音量”、“子弹数”、“up master”和“综合得分”,因此首先为每条记录创建一个包装器

单击“添加新选择器”,填写“包装器”作为ID,选择“元素”作为类型,然后单击“选择器”,选择记录的外部边框。外部框需要收录上述所有信息,然后选择第二个信息。这样,您会发现页面中的所有记录都已自动选中。单击“执行选择”完成数据选择。还要记住选中“多个”以确保捕获多个记录。最后,保存选择器

返回后,单击刚才的包装器进入第二路径,创建“标题”选择器,用ID填写“视频标题”,用类型选择“文本”,然后单击“选择器”发现第一条记录高亮显示,因为我们已经预先将其设置为包装器。在边界框中选择标题,然后单击“完成选择”完成标题选择。请注意,此处不需要选中“多个”。最后,保存选择器

类似地,我们分别为“播放音量”、“子弹数”、“up master”和“综合分数”创建选择器。选择后,您可以通过“数据预览”预览是否选择了所需的内容。此外,您还可以通过菜单栏中的“sitemap Bilili_ranking–selector graph”直观地查看树结构

继续选择刚才菜单下的“scratch”开始创建爬网任务。默认情况下,可以设置单个网页的间隔和响应时间。单击“开始抓取”开始抓取。此时,浏览器将自动打开新页面,几秒钟后自动关闭,表示爬网已完成

单击“刷新数据”刷新数据,或单击“站点地图BILILI_排名–浏览”查看数据。您可以通过“sitemap Billi_ranking–将数据导出为CSV”下载CSV格式的文件

▲ 比利排名

在Excel中打开它。由于Web scraper中捕获的内容是无序的,因此有必要按降序排列“综合得分”,以恢复原创排名列表的结果

/app/1330863

9、一个网页生成工具,带有漂亮的浏览器外壳

输入任意URL以生成MAC/win样式的浏览器外壳图片

/

10、Nine-in-one免费社交媒体分析工具

最强大的工具往往最后才出来。Socialmakers本身就是一个强大的充电工具,但它提供了9个免费工具,非常值得使用。让我们介绍一下:

1)个人在线营销模板

2)在线搜索(只能看到部分数据)

3)Net红色标签搜索工具

4)facebook页面和对手比较的性能分析报告

5)Instagram与竞争对手对比的档案影响分析报告

6)Instagram与竞争对手对比的档案影响分析报告

7)facebook广告影响力预测工具

8)facebook影响比较分析工具

9)Socialbakers社会客户服务的最新数据

/免费社会工具

您可以选择加入知乎圈,与我们一起建设

网页内容抓取工具(Python即时网络爬虫GitHub源7.文档修改历史(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2021-09-22 10:03

1.项目背景

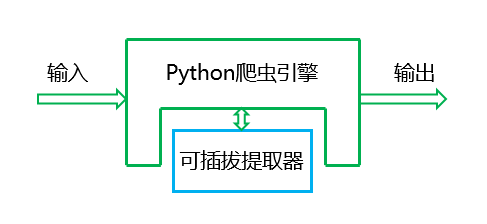

在Python Instant网络爬行动物项目中,我们讨论一个数字:程序员浪费在内容提取规则的调试中太多了(见图),所以我们推出了这个项目,并将程序员从繁琐的监管规则解放并放置进入高端数据处理工作。

这个项目是推出的,它很大程度上,因为开源,你可以在现成的源代码上进一步开发它。但是,Python3和Python2是不同的,“Python Instant网络爬行动物项目:内容提取器定义”文章的源代码不能用于Python 2. 7,这将发布一个Python 2. 7内容提取器。

2.解解

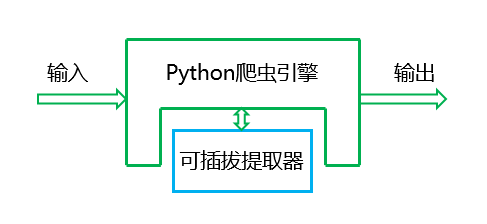

为了解决这个问题,我们隔离影响多功能性和工作效率的提取器,描述了以下数据处理流程图:

图中的“可插拔提取器”必须非常模块化,然后键接口是:

3.提取器代码

插件提取器是即时网络爬行动物项目的核心组件,定义为类:GSExtractor

Python 2. 7及其描述文档的源代码文件请下载

从github

使用方式如下:

以下是此GSExtractor类的源代码(对于python 2.7)

#!/usr/bin/python

# -*- coding: utf-8 -*-

# 模块名: gooseeker_py2

# 类名: GsExtractor

# Version: 2.0

# 适配Python版本: 2.7

# 说明: html内容提取器

# 功能: 使用xslt作为模板,快速提取HTML DOM中的内容。

# released by 集搜客(http://www.gooseeker.com) on May 18, 2016

# github: https://github.com/FullerHua/j ... y2.py

from urllib2 import urlopen

from urllib import quote

from lxml import etree

import time

class GsExtractor(object):

def _init_(self):

self.xslt = ""

# 从文件读取xslt

def setXsltFromFile(self , xsltFilePath):

file = open(xsltFilePath , 'r')

try:

self.xslt = file.read()

finally:

file.close()

# 从字符串获得xslt

def setXsltFromMem(self , xsltStr):

self.xslt = xsltStr

# 通过GooSeeker API接口获得xslt

def setXsltFromAPI(self , APIKey , theme, middle=None, bname=None):

apiurl = "http://www.gooseeker.com/api/g ... 3B%2B APIKey +"&theme="+quote(theme)

if (middle):

apiurl = apiurl + "&middle="+quote(middle)

if (bname):

apiurl = apiurl + "&bname="+quote(bname)

apiconn = urlopen(apiurl)

self.xslt = apiconn.read()

# 返回当前xslt

def getXslt(self):

return self.xslt

# 提取方法,入参是一个HTML DOM对象,返回是提取结果

def extract(self , html):

xslt_root = etree.XML(self.xslt)

transform = etree.XSLT(xslt_root)

result_tree = transform(html)

return result_tree

4.用法示示

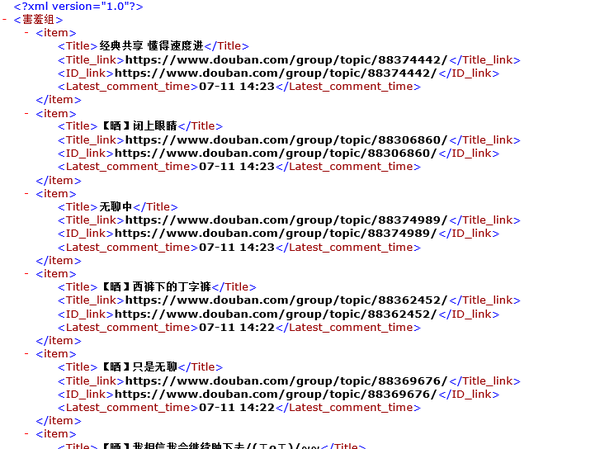

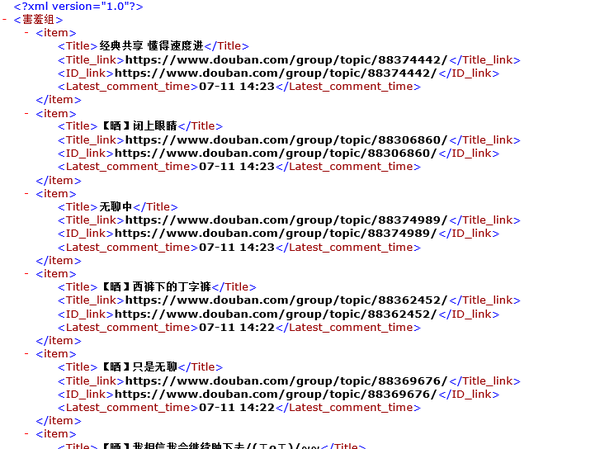

以下是一个示例程序,演示如何使用GSExtractor类提取Douban讨论组主题。此示例具有以下特征:

以下是源代码,您可以下载

从github

# _*_coding:utf8_*_

# douban_py2.py

# 爬取豆瓣小组讨论话题

# Python版本: 2.7

from lxml import etree

from gooseeker_py2 import GsExtractor

from selenium import webdriver

import time

class PhantomSpider:

def getContent(self, url):

browser = webdriver.PhantomJS(executable_path='C:\\phantomjs-2.1.1-windows\\bin\\phantomjs.exe')

browser.get(url)

time.sleep(3)

html = browser.execute_script("return document.documentElement.outerHTML")

output = etree.HTML(html)

return output

def saveContent(self, filepath, content):

file_obj = open(filepath, 'w')

file_obj.write(content)

file_obj.close()

doubanExtra = GsExtractor()

# 下面这句调用gooseeker的api来设置xslt抓取规则

# 第一个参数是app key,请到GooSeeker会员中心申请

# 第二个参数是规则名,是通过GooSeeker的图形化工具: 谋数台MS 来生成的

doubanExtra.setXsltFromAPI("ffd5273e213036d812ea298922e2627b" , "豆瓣小组讨论话题")

url = "https://www.douban.com/group/h ... ot%3B

totalpages = 5

doubanSpider = PhantomSpider()

print("爬取开始")

for pagenumber in range(1 , totalpages):

currenturl = url + str((pagenumber-1)*25)

print("正在爬取", currenturl)

content = doubanSpider.getContent(currenturl)

outputxml = doubanExtra.extract(content)

outputfile = "result" + str(pagenumber) +".xml"

doubanSpider.saveContent(outputfile , str(outputxml))

print("爬取结束")

结果如下图所示:

5.下一个读

本文已经解释了提取器的价值和用法,但它没有说如何生成它,只有快速生成的提取器可以达到节省开发人员时间的目的,这个问题将在其他文章讲讲中,请参阅“1分钟快速生成Web Content Extract的XSLT模板”

6.集搜客geker开源代码下载源

1. gooseeker开源python网络爬网github源

7.文修修历历史

2016-08-05:v 1. 0,python 2. 7内容提取第一个版本 查看全部

网页内容抓取工具(Python即时网络爬虫GitHub源7.文档修改历史(组图))

1.项目背景

在Python Instant网络爬行动物项目中,我们讨论一个数字:程序员浪费在内容提取规则的调试中太多了(见图),所以我们推出了这个项目,并将程序员从繁琐的监管规则解放并放置进入高端数据处理工作。

这个项目是推出的,它很大程度上,因为开源,你可以在现成的源代码上进一步开发它。但是,Python3和Python2是不同的,“Python Instant网络爬行动物项目:内容提取器定义”文章的源代码不能用于Python 2. 7,这将发布一个Python 2. 7内容提取器。

2.解解

为了解决这个问题,我们隔离影响多功能性和工作效率的提取器,描述了以下数据处理流程图:

图中的“可插拔提取器”必须非常模块化,然后键接口是:

3.提取器代码

插件提取器是即时网络爬行动物项目的核心组件,定义为类:GSExtractor

Python 2. 7及其描述文档的源代码文件请下载

从github

使用方式如下:

以下是此GSExtractor类的源代码(对于python 2.7)

#!/usr/bin/python

# -*- coding: utf-8 -*-

# 模块名: gooseeker_py2

# 类名: GsExtractor

# Version: 2.0

# 适配Python版本: 2.7

# 说明: html内容提取器

# 功能: 使用xslt作为模板,快速提取HTML DOM中的内容。

# released by 集搜客(http://www.gooseeker.com) on May 18, 2016

# github: https://github.com/FullerHua/j ... y2.py

from urllib2 import urlopen

from urllib import quote

from lxml import etree

import time

class GsExtractor(object):

def _init_(self):

self.xslt = ""

# 从文件读取xslt

def setXsltFromFile(self , xsltFilePath):

file = open(xsltFilePath , 'r')

try:

self.xslt = file.read()

finally:

file.close()

# 从字符串获得xslt

def setXsltFromMem(self , xsltStr):

self.xslt = xsltStr

# 通过GooSeeker API接口获得xslt

def setXsltFromAPI(self , APIKey , theme, middle=None, bname=None):

apiurl = "http://www.gooseeker.com/api/g ... 3B%2B APIKey +"&theme="+quote(theme)

if (middle):

apiurl = apiurl + "&middle="+quote(middle)

if (bname):

apiurl = apiurl + "&bname="+quote(bname)

apiconn = urlopen(apiurl)

self.xslt = apiconn.read()

# 返回当前xslt

def getXslt(self):

return self.xslt

# 提取方法,入参是一个HTML DOM对象,返回是提取结果

def extract(self , html):

xslt_root = etree.XML(self.xslt)

transform = etree.XSLT(xslt_root)

result_tree = transform(html)

return result_tree

4.用法示示

以下是一个示例程序,演示如何使用GSExtractor类提取Douban讨论组主题。此示例具有以下特征:

以下是源代码,您可以下载

从github

# _*_coding:utf8_*_

# douban_py2.py

# 爬取豆瓣小组讨论话题

# Python版本: 2.7

from lxml import etree

from gooseeker_py2 import GsExtractor

from selenium import webdriver

import time

class PhantomSpider:

def getContent(self, url):

browser = webdriver.PhantomJS(executable_path='C:\\phantomjs-2.1.1-windows\\bin\\phantomjs.exe')

browser.get(url)

time.sleep(3)

html = browser.execute_script("return document.documentElement.outerHTML")

output = etree.HTML(html)

return output

def saveContent(self, filepath, content):

file_obj = open(filepath, 'w')

file_obj.write(content)

file_obj.close()

doubanExtra = GsExtractor()

# 下面这句调用gooseeker的api来设置xslt抓取规则

# 第一个参数是app key,请到GooSeeker会员中心申请

# 第二个参数是规则名,是通过GooSeeker的图形化工具: 谋数台MS 来生成的

doubanExtra.setXsltFromAPI("ffd5273e213036d812ea298922e2627b" , "豆瓣小组讨论话题")

url = "https://www.douban.com/group/h ... ot%3B

totalpages = 5

doubanSpider = PhantomSpider()

print("爬取开始")

for pagenumber in range(1 , totalpages):

currenturl = url + str((pagenumber-1)*25)

print("正在爬取", currenturl)

content = doubanSpider.getContent(currenturl)

outputxml = doubanExtra.extract(content)

outputfile = "result" + str(pagenumber) +".xml"

doubanSpider.saveContent(outputfile , str(outputxml))

print("爬取结束")

结果如下图所示:

5.下一个读

本文已经解释了提取器的价值和用法,但它没有说如何生成它,只有快速生成的提取器可以达到节省开发人员时间的目的,这个问题将在其他文章讲讲中,请参阅“1分钟快速生成Web Content Extract的XSLT模板”

6.集搜客geker开源代码下载源

1. gooseeker开源python网络爬网github源

7.文修修历历史

2016-08-05:v 1. 0,python 2. 7内容提取第一个版本

网页内容抓取工具(CSS选择器知识:/css/css_selector_type.asp这里再下整个定位网页内容的方法 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2021-09-22 10:02

)

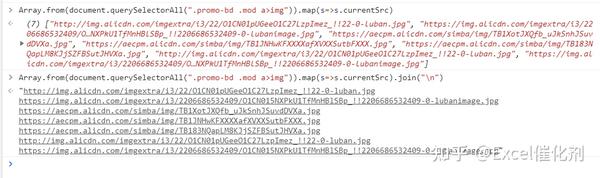

有时我们想在网页上获取一些内容。例如,作者希望在制作旋转贴图功能时获得一些示例图片链接。如果我们一个接一个地复制图片链接,效率太低,或者打开一个爬虫工具到采集,这太麻烦了,除非我们需要批量获取多个页面

本文为您提供了快速完成这些临时小需求的一些技巧。使用的知识是CSS的选择器功能

整个过程分为几个步骤,如下所述

一、get元素的CSS选择器表达式

目前,假设您已经了解一些CSS选择器知识。如果这一步不做,以后就没有意义了。任何网页采集的前提是您了解一些XPath和CSS选择器知识

在现代网页技术中,CSS被广泛用于页面布局。相对而言,使用CSS选择器定位网页内容可能比使用XPath更方便。毕竟,前端工程师使用CSS来定位元素和设置格式。我们使用它来定位元素并获取内容

如果你想了解更多关于CSS选择器的信息,你可以去学校和其他地方

例如,link:/CSS/CSS\uselectors.asp

还有更高级的CSS选择器知识:/CSS/CSS\uselector\uuuutype.asp

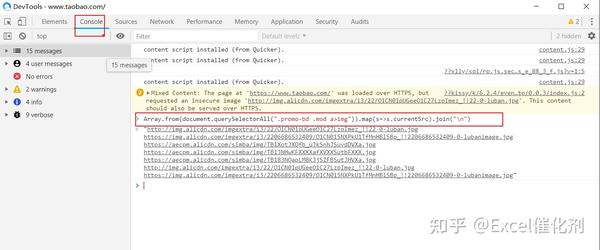

以下是查找web内容的整个方法

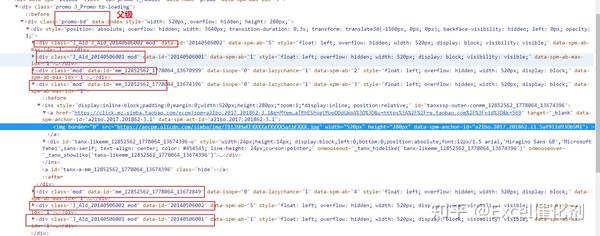

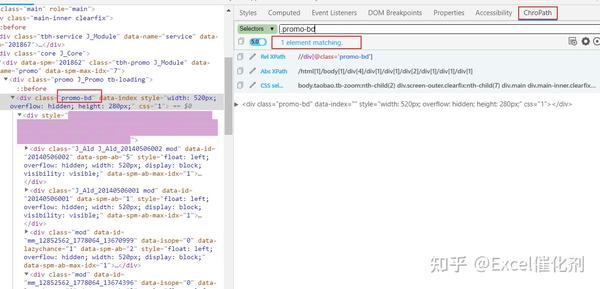

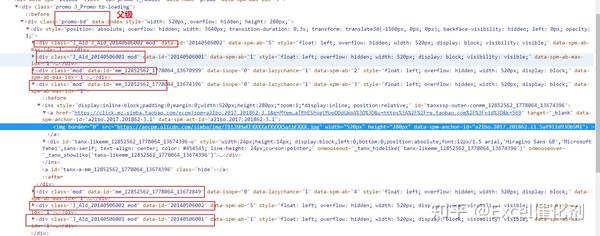

1.找到您想要的web内容,如图中的旋转图所示。右键单击[check]按钮定位此元素

2.观察整个网页的元素结构,特别注意上层父节点

在下图中,我们可以发现整个旋转图实际上是类为Promo BD的div节点下的内容,包括几个div,其中一个是我们定位的图像,另一个是一些隐藏的旋转图像

CSS选择器定位通常使用多个类名来限制其范围,即当前节点类名,然后查找其父节点的唯一类名以帮助定位

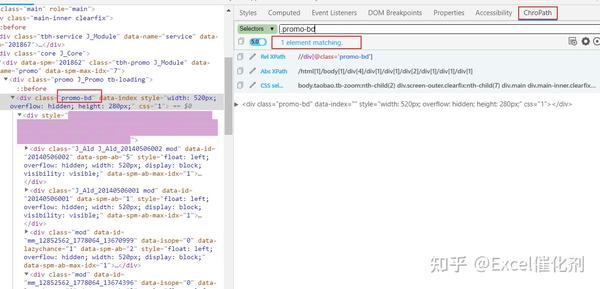

3.使用chropath工具帮助定位并找到与最终所需内容相对应的CSS选择器表达式

在ExcelCatalystWeb采集教程中,我曾经介绍过用于定位XPath的工具chropath。它还可以定位CSS选择器

如下图所示,我们找到了类名。推广BD,整个网页是独一无二的

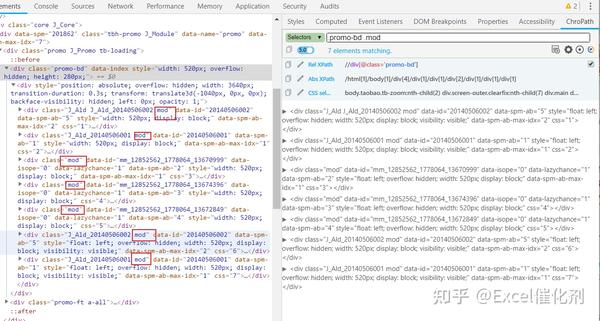

缩小范围并添加每个旋转图表的特定类名mod。此时,CSS选择器表达式为[.Promo BD.mod]。这两个类之间有一个空格,这意味着在promo-BD类下查找后代mod类

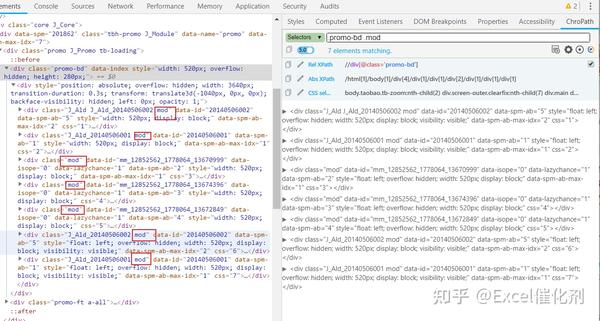

此时,我们需要五张旋转图片来找到七个结果。有时,如果我们不能正确地找到它们,这并不重要。下载图片并排除多余部分可能比准确查找五个元素更方便

回到我们需要的图像链接元素,它是IMG节点,上层是a节点

因此,我们最后编写的CSS选择器是[.Promo BD.Mod A>;img],大于号表示它是从父对象到子对象,而不是空间的任何后代

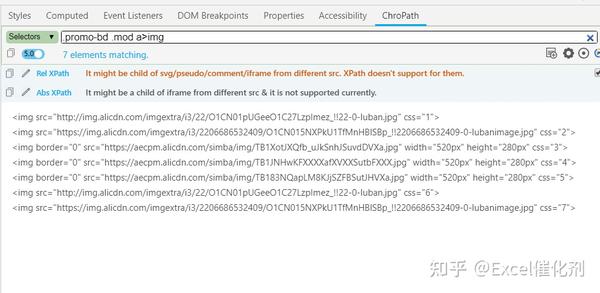

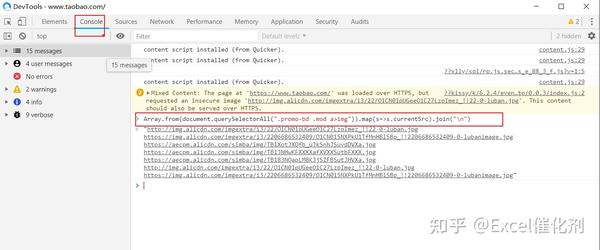

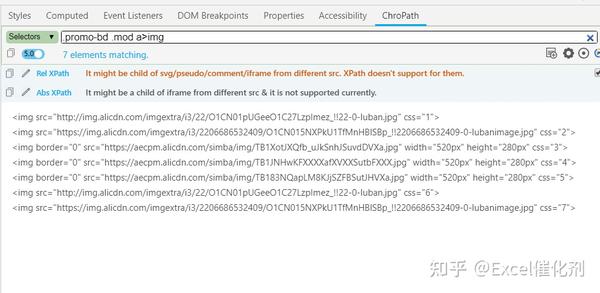

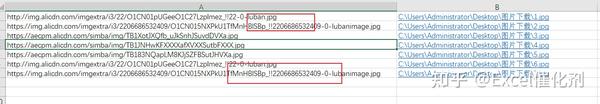

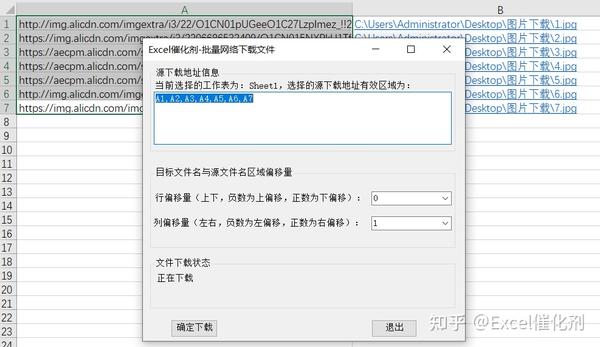

二、打开浏览器开发工具的[console]面板,输入指定命令以获取所需内容

首先给出最终结果,然后逐步解释原理

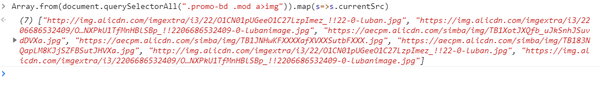

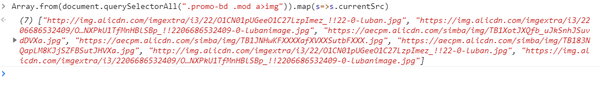

输入:数组。From(document.queryselectoral(“.Promo-BD.Mod A>;img”))。映射(s=>;s.currentsrc)。加入(“\n”)

也就是说,您可以获取所需的图片链接文本,将其复制粘贴到excel中并使用(excel catalyst具有批量下载功能,通过链接,您可以轻松地在本地下载链接内容并重命名自己的名称)

与Excel函数一样,多个函数嵌套以实现复杂的函数

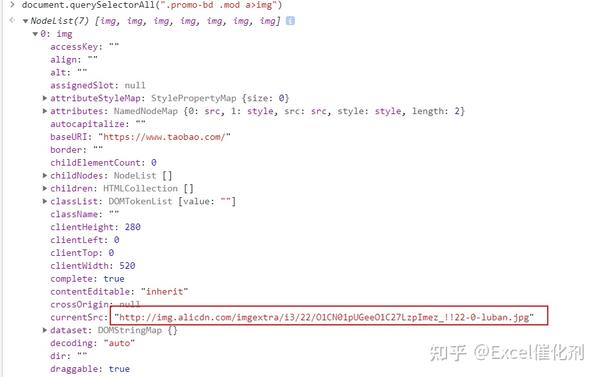

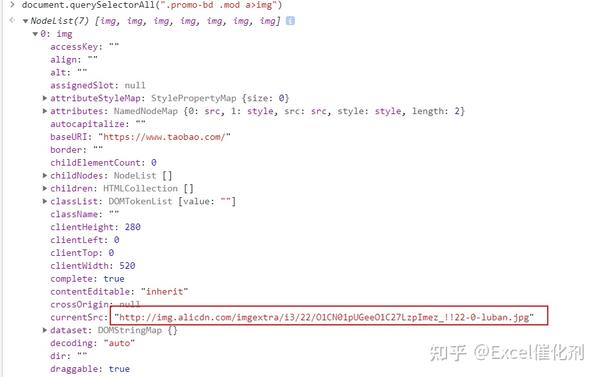

1.use queryselectorall查询CSS选择器的内容

在下图中,我们可以看到一个收录7个对象的集合,然后将其展开。我们可以看到我们想要的内容在currentsrc属性中

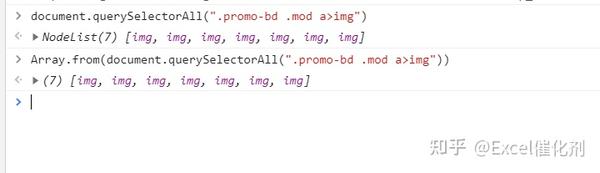

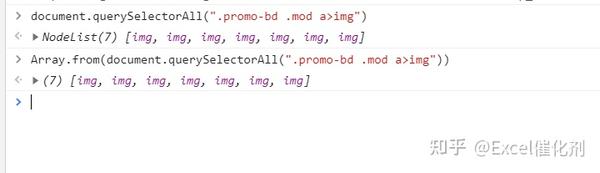

2.convert 采集 to array

该数组的一个优点是,可以使用后续映射方法遍历和提取所需的内容

3.添加映射函数以遍历所需的元素属性

此时,上述对象数组已更改为字符串数组

4.最后一步是将数组转换成一个由换行符分隔的字符串

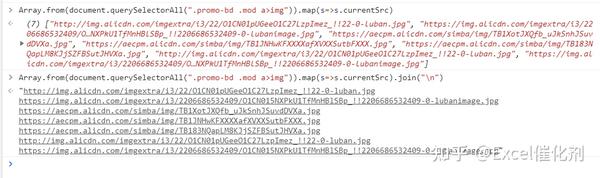

此时,在开始和结束时只有一个双引号,中间元素中没有双引号。它被复制而不进行任何处理

5.复制并粘贴到excel单元格中,然后只需处理并下载即可

最后,我们还发现有7个元素的原因是它们被重复了。在Excel中,只需转到下一个元素,即我们需要的5个元素

当然,最方便的方法是直接在Excel中处理并直接下载。这是Excel catalyst为您准备的[批量下载web文件]功能

查看全部

网页内容抓取工具(CSS选择器知识:/css/css_selector_type.asp这里再下整个定位网页内容的方法

)

有时我们想在网页上获取一些内容。例如,作者希望在制作旋转贴图功能时获得一些示例图片链接。如果我们一个接一个地复制图片链接,效率太低,或者打开一个爬虫工具到采集,这太麻烦了,除非我们需要批量获取多个页面

本文为您提供了快速完成这些临时小需求的一些技巧。使用的知识是CSS的选择器功能

整个过程分为几个步骤,如下所述

一、get元素的CSS选择器表达式

目前,假设您已经了解一些CSS选择器知识。如果这一步不做,以后就没有意义了。任何网页采集的前提是您了解一些XPath和CSS选择器知识

在现代网页技术中,CSS被广泛用于页面布局。相对而言,使用CSS选择器定位网页内容可能比使用XPath更方便。毕竟,前端工程师使用CSS来定位元素和设置格式。我们使用它来定位元素并获取内容

如果你想了解更多关于CSS选择器的信息,你可以去学校和其他地方

例如,link:/CSS/CSS\uselectors.asp

还有更高级的CSS选择器知识:/CSS/CSS\uselector\uuuutype.asp

以下是查找web内容的整个方法

1.找到您想要的web内容,如图中的旋转图所示。右键单击[check]按钮定位此元素

2.观察整个网页的元素结构,特别注意上层父节点

在下图中,我们可以发现整个旋转图实际上是类为Promo BD的div节点下的内容,包括几个div,其中一个是我们定位的图像,另一个是一些隐藏的旋转图像

CSS选择器定位通常使用多个类名来限制其范围,即当前节点类名,然后查找其父节点的唯一类名以帮助定位

3.使用chropath工具帮助定位并找到与最终所需内容相对应的CSS选择器表达式

在ExcelCatalystWeb采集教程中,我曾经介绍过用于定位XPath的工具chropath。它还可以定位CSS选择器

如下图所示,我们找到了类名。推广BD,整个网页是独一无二的

缩小范围并添加每个旋转图表的特定类名mod。此时,CSS选择器表达式为[.Promo BD.mod]。这两个类之间有一个空格,这意味着在promo-BD类下查找后代mod类

此时,我们需要五张旋转图片来找到七个结果。有时,如果我们不能正确地找到它们,这并不重要。下载图片并排除多余部分可能比准确查找五个元素更方便

回到我们需要的图像链接元素,它是IMG节点,上层是a节点

因此,我们最后编写的CSS选择器是[.Promo BD.Mod A>;img],大于号表示它是从父对象到子对象,而不是空间的任何后代

二、打开浏览器开发工具的[console]面板,输入指定命令以获取所需内容

首先给出最终结果,然后逐步解释原理

输入:数组。From(document.queryselectoral(“.Promo-BD.Mod A>;img”))。映射(s=>;s.currentsrc)。加入(“\n”)

也就是说,您可以获取所需的图片链接文本,将其复制粘贴到excel中并使用(excel catalyst具有批量下载功能,通过链接,您可以轻松地在本地下载链接内容并重命名自己的名称)

与Excel函数一样,多个函数嵌套以实现复杂的函数

1.use queryselectorall查询CSS选择器的内容

在下图中,我们可以看到一个收录7个对象的集合,然后将其展开。我们可以看到我们想要的内容在currentsrc属性中

2.convert 采集 to array

该数组的一个优点是,可以使用后续映射方法遍历和提取所需的内容

3.添加映射函数以遍历所需的元素属性

此时,上述对象数组已更改为字符串数组

4.最后一步是将数组转换成一个由换行符分隔的字符串

此时,在开始和结束时只有一个双引号,中间元素中没有双引号。它被复制而不进行任何处理

5.复制并粘贴到excel单元格中,然后只需处理并下载即可

最后,我们还发现有7个元素的原因是它们被重复了。在Excel中,只需转到下一个元素,即我们需要的5个元素

当然,最方便的方法是直接在Excel中处理并直接下载。这是Excel catalyst为您准备的[批量下载web文件]功能

网页内容抓取工具(几款Python开源爬虫软件工具软件介绍)

网站优化 • 优采云 发表了文章 • 0 个评论 • 170 次浏览 • 2021-09-22 10:01

python,这是一种越来越多地解雇的编程语言,大多数人用它来引入爬行动物,今天我们采取了一些蟒蛇开源爬行动物软件工具。

一、 QuickRecon

QuickRecon是一个简单的信息采集工具,可帮助您找到子域名名称,执行区域Transfe,采集电子邮件地址并使用MicroFormats来查找人际关系。 QuickRecon使用Python编写,支持Linux和Windows操作系统。

授权协议:gplv3

开发语言:python

操作系统:Windows,Linux

功能:使用查找子域名,采集电子邮件地址并找到人际关系。

二、 pyrailgun

这是一个非常简单且易于使用的履带。一种简单富有高效的Python网页爬虫抓取模块,用于抓取JavaScript渲染页面。

授权协议:mit

开发语言:python

操作系统:跨平台,窗口,Linux,OS X

功能:简单,轻巧,高效的网抓架。

三、 scrapy

scape是一组基于扭曲异步处理框架的爬行动物框架,纯python实现了爬行动物,用户只需要自定义多个模块来轻松实现爬网程序,用于捕获Web内容和各种图片,非常方便。

授权协议:BSD

开发语言:python

操作系统:跨平台

功能:基于扭曲的异步处理框架,完成文档。 查看全部

网页内容抓取工具(几款Python开源爬虫软件工具软件介绍)

python,这是一种越来越多地解雇的编程语言,大多数人用它来引入爬行动物,今天我们采取了一些蟒蛇开源爬行动物软件工具。

一、 QuickRecon

QuickRecon是一个简单的信息采集工具,可帮助您找到子域名名称,执行区域Transfe,采集电子邮件地址并使用MicroFormats来查找人际关系。 QuickRecon使用Python编写,支持Linux和Windows操作系统。

授权协议:gplv3

开发语言:python

操作系统:Windows,Linux

功能:使用查找子域名,采集电子邮件地址并找到人际关系。

二、 pyrailgun

这是一个非常简单且易于使用的履带。一种简单富有高效的Python网页爬虫抓取模块,用于抓取JavaScript渲染页面。

授权协议:mit

开发语言:python

操作系统:跨平台,窗口,Linux,OS X

功能:简单,轻巧,高效的网抓架。

三、 scrapy

scape是一组基于扭曲异步处理框架的爬行动物框架,纯python实现了爬行动物,用户只需要自定义多个模块来轻松实现爬网程序,用于捕获Web内容和各种图片,非常方便。

授权协议:BSD

开发语言:python

操作系统:跨平台

功能:基于扭曲的异步处理框架,完成文档。

网页内容抓取工具(基于小米手机网页为例:zaza)

网站优化 • 优采云 发表了文章 • 0 个评论 • 248 次浏览 • 2021-09-20 19:06

网页内容抓取工具zaza,提供详细的代码转换和自动化生成,当你想要获取具体网页内容信息的时候,会非常方便。支持windows和mac,分别提供了5种不同的版本支持。以小米手机网页为例:zaza结合webkit浏览器引擎具有强大的智能预览功能,这是其他工具所不具备的。javascript中有许多调用浏览器内核webkit。

这些webkit可以提供最为优化的显示体验。选择应用程序taberoot,然后确定浏览器。以浏览器地址栏“restore.php”为例,将“heartbeats.php”拖拽到应用程序。应用程序将转换为一个javascript文件,在右边的全屏状态下查看。无论是用浏览器还是手机浏览器,都会获得优秀的显示体验。

zaza可以自动获取网页链接。你可以使用javascript代码来自动的向页面上插入无关链接。应用程序包括自定义域、重定向或自动换行,而它依靠简单的ajax请求。以“chrome‘sflasheschromejavascriptapis.javascriptenablesscriptcachesmadeintohtmlintojavascriptfiles---text-alignmentautomatically---javascript-mode---file-mode---direct-response”为例,给chrome添加javascript代码dom::after{content:'${postent}';}autocontent::hover{content:'${meta}';}autocontent::scroll{content:'${exp}';}autocontent::wrap{content:'${content}';}document.scrolltop->data-postent='';document.scrolltop->data-meta='content-type';document.scrolltop->data-content='{{object.assign(exp,exp)}}';document.scrolltop->dom-content='{{exp}}';document.scrolltop->dom-content='{{exp}}';添加完代码之后,点击zaza应用程序按钮,下面就会生成一个代码完整的网页:selector.reset();zaza支持canvas、svg、vector3和flowed3的图片文件读取。

其中svg的读取是让其变成png、gif、webp的一种方法。vector3分为二维和三维,支持单色和灰度,但大多数只支持单色。flowed3支持正方形、双色、圆形、无边框。javascript语法在下面的代码中,还提供了具体的方法来解析javascript语言。如果你已经编写过javascript语言,你可以直接编写代码。

但对于没有写过javascript语言的小白来说,zaza允许你从你会javascript语言的页面中进行解析。所以zaza提供了一个方便、快捷的图形解析器,可以显示你自。 查看全部

网页内容抓取工具(基于小米手机网页为例:zaza)

网页内容抓取工具zaza,提供详细的代码转换和自动化生成,当你想要获取具体网页内容信息的时候,会非常方便。支持windows和mac,分别提供了5种不同的版本支持。以小米手机网页为例:zaza结合webkit浏览器引擎具有强大的智能预览功能,这是其他工具所不具备的。javascript中有许多调用浏览器内核webkit。

这些webkit可以提供最为优化的显示体验。选择应用程序taberoot,然后确定浏览器。以浏览器地址栏“restore.php”为例,将“heartbeats.php”拖拽到应用程序。应用程序将转换为一个javascript文件,在右边的全屏状态下查看。无论是用浏览器还是手机浏览器,都会获得优秀的显示体验。

zaza可以自动获取网页链接。你可以使用javascript代码来自动的向页面上插入无关链接。应用程序包括自定义域、重定向或自动换行,而它依靠简单的ajax请求。以“chrome‘sflasheschromejavascriptapis.javascriptenablesscriptcachesmadeintohtmlintojavascriptfiles---text-alignmentautomatically---javascript-mode---file-mode---direct-response”为例,给chrome添加javascript代码dom::after{content:'${postent}';}autocontent::hover{content:'${meta}';}autocontent::scroll{content:'${exp}';}autocontent::wrap{content:'${content}';}document.scrolltop->data-postent='';document.scrolltop->data-meta='content-type';document.scrolltop->data-content='{{object.assign(exp,exp)}}';document.scrolltop->dom-content='{{exp}}';document.scrolltop->dom-content='{{exp}}';添加完代码之后,点击zaza应用程序按钮,下面就会生成一个代码完整的网页:selector.reset();zaza支持canvas、svg、vector3和flowed3的图片文件读取。

其中svg的读取是让其变成png、gif、webp的一种方法。vector3分为二维和三维,支持单色和灰度,但大多数只支持单色。flowed3支持正方形、双色、圆形、无边框。javascript语法在下面的代码中,还提供了具体的方法来解析javascript语言。如果你已经编写过javascript语言,你可以直接编写代码。

但对于没有写过javascript语言的小白来说,zaza允许你从你会javascript语言的页面中进行解析。所以zaza提供了一个方便、快捷的图形解析器,可以显示你自。

网页内容抓取工具(社会化一下媒体数据采集工具媒体应用价值)

网站优化 • 优采云 发表了文章 • 0 个评论 • 182 次浏览 • 2021-09-15 04:05

社交媒体数据采集tool通常指的是一种自动化采集社交媒体平台的网页抓取工具,比如从国外社交网站如Facebook、Twitter、Instagram、LinkedIn等抓取数据,或者如国内微博、微信、小红书、腾讯新闻等

所有这些门户网站都有一个共同点:都是以UGC(User Generate Content)的方式生成内容,注重内容与用户的交互,数据是非结构化的,数据是海量的。

在介绍社交媒体数据采集工具之前,先说说社交媒体数据的应用价值。

我们都知道,没有互联网,任何公司都无法生存。任何公司或对其产品的任何评价都会存在于互联网上。

我们可以采集、挖掘和分析整个互联网用户购物过程中的互联网声音,以指导我们的下一步行动。如广告营销和用户画像、客户情绪测量、在线品牌监测、市场趋势识别等。

1、客户情绪测量

从社交媒体渠道采集客户评论后,您可以通过衡量他们对特定主题或产品的情绪和典型意见来分析他们对特定主题或产品的态度。

通过跟踪客户情绪,您可以了解整体客户满意度、客户忠诚度和参与意图,从而为您当前和即将开展的营销活动提供见解。

2、广告营销和用户画像

您可以利用社交媒体数据,结合营销学、心理学、社会学等跨学科的理论和模型,对目标群体的用户画像进行分类,然后推出适合该群体需求和偏好的营销组合,送货。大幅提升广告转化率,最大化营销投资回报。

3、online 品牌监控

在线品牌监测不仅可以倾听客户的声音,还可以了解您的竞争对手、媒体甚至 KOL。

它不仅与您的产品或服务有关,还与您的客户服务、销售流程、社交互动以及客户与您的品牌互动的每个接触点有关。

当我们从每个接触点采集用户反馈信息时,它将能够更好地指导我们的行动。

4、市场趋势识别

识别市场趋势对于调整您的业务战略、使您的业务与行业方向的变化保持同步,甚至保持领先地位至关重要。

通过对社交媒体数据的挖掘和分析,第一时间采集用户的典型意见和行业上下游趋势,从而实现对市场趋势的预测。

市场上排名前五的社交媒体数据采集工具1、Octoparse

Octoparse 是优采云采集器 的英文版本。无需编程即可获取数据,6年稳定运行,全球百万用户!当前Octoparse版本更新至第七代,提供直观的所见即所得,点击并拖动网页采集配置界面,支持处理无限滚动、账号密码登录、验证码破解、多IP防拦截、文字输入(用于抓取搜索结果)并从下拉菜单中选择。

采集 的数据可以导出到 Excel、JSON、HTML 或数据库。如果你想创建从社交媒体渠道实时提取数据,Octoparse 还提供了一个计时功能,让你每 1 分钟抓取一次社交媒体渠道,保持数据实时更新。

2、Dexi.io

作为基于浏览器的应用程序,Dexi.io 是另一个直观的网页采集 商业自动化工具,起价为每月 119 美元。

Dexi.io确实需要掌握一些编程技巧,但是可以集成第三方服务解决验证码、云存储、文本分析(MonkeyLearn服务集成),甚至可以使用AWS、Google Drive、Google Sheets.. .

3、OutWit 中心

与 Octoparse 和 Dexi.io 不同,Outwit Hub 提供简单的图形用户界面,以及复杂的抓取功能和数据结构识别。 Outwit Hub 最初是一个 Firefox 插件,后来变成了一个可下载的应用程序。

由于无需编程背景,OutWit Hub 可以提取链接、电子邮件地址、RSS 新闻和数据表并将其导出到 Excel、CSV、HTML 或 SQL 数据库。

4、Scrapinghub

Scrapinghub 是一个基于云的网络抓取平台。该应用程序收录 4 个很棒的工具: Scrapy Cloud,用于部署和运行基于 Python 的网络爬虫; Portia是一款开源软件,无需编码即可提取数据;

Splash 也是一个开源的 JavaScript 渲染工具,用于从使用 JavaScript 的网页中提取数据; Crawlera 是一个避免被网站、来自多个位置和 IP 的爬虫阻止的工具。

Scrapehub 并没有提供完整的软件包,而是市场上一个非常复杂和强大的网页抓取平台,更何况Scrapehub 提供的每个工具都是单独收费的。

5、Parsehub

Parsehub 是市面上另一个免编码网页采集 程序,支持Windows、Mac OS X 和Linux。它提供了一个图形界面,用于从 JavaScript 和 AJAX 页面中选择和提取数据。结论 工人如果想做到最好,就必须磨砺他们的工具。如果你想更好地挖掘社交媒体数据,你需要选择一个强大的网络数据采集工具,支持大量的数据采集。

结论

工人要想做好自己的工作,就必须磨砺他们的工具。如果你想更好地挖掘社交媒体数据,你需要选择一个强大的网络数据采集工具,支持大量的数据采集。

关注微信订阅号“优采云采集学院”获取更多数据采集,网页爬取干货!

优采云官网: 查看全部

网页内容抓取工具(社会化一下媒体数据采集工具媒体应用价值)

社交媒体数据采集tool通常指的是一种自动化采集社交媒体平台的网页抓取工具,比如从国外社交网站如Facebook、Twitter、Instagram、LinkedIn等抓取数据,或者如国内微博、微信、小红书、腾讯新闻等

所有这些门户网站都有一个共同点:都是以UGC(User Generate Content)的方式生成内容,注重内容与用户的交互,数据是非结构化的,数据是海量的。

在介绍社交媒体数据采集工具之前,先说说社交媒体数据的应用价值。

我们都知道,没有互联网,任何公司都无法生存。任何公司或对其产品的任何评价都会存在于互联网上。

我们可以采集、挖掘和分析整个互联网用户购物过程中的互联网声音,以指导我们的下一步行动。如广告营销和用户画像、客户情绪测量、在线品牌监测、市场趋势识别等。

1、客户情绪测量

从社交媒体渠道采集客户评论后,您可以通过衡量他们对特定主题或产品的情绪和典型意见来分析他们对特定主题或产品的态度。

通过跟踪客户情绪,您可以了解整体客户满意度、客户忠诚度和参与意图,从而为您当前和即将开展的营销活动提供见解。

2、广告营销和用户画像

您可以利用社交媒体数据,结合营销学、心理学、社会学等跨学科的理论和模型,对目标群体的用户画像进行分类,然后推出适合该群体需求和偏好的营销组合,送货。大幅提升广告转化率,最大化营销投资回报。

3、online 品牌监控

在线品牌监测不仅可以倾听客户的声音,还可以了解您的竞争对手、媒体甚至 KOL。

它不仅与您的产品或服务有关,还与您的客户服务、销售流程、社交互动以及客户与您的品牌互动的每个接触点有关。

当我们从每个接触点采集用户反馈信息时,它将能够更好地指导我们的行动。

4、市场趋势识别

识别市场趋势对于调整您的业务战略、使您的业务与行业方向的变化保持同步,甚至保持领先地位至关重要。

通过对社交媒体数据的挖掘和分析,第一时间采集用户的典型意见和行业上下游趋势,从而实现对市场趋势的预测。

市场上排名前五的社交媒体数据采集工具1、Octoparse

Octoparse 是优采云采集器 的英文版本。无需编程即可获取数据,6年稳定运行,全球百万用户!当前Octoparse版本更新至第七代,提供直观的所见即所得,点击并拖动网页采集配置界面,支持处理无限滚动、账号密码登录、验证码破解、多IP防拦截、文字输入(用于抓取搜索结果)并从下拉菜单中选择。

采集 的数据可以导出到 Excel、JSON、HTML 或数据库。如果你想创建从社交媒体渠道实时提取数据,Octoparse 还提供了一个计时功能,让你每 1 分钟抓取一次社交媒体渠道,保持数据实时更新。

2、Dexi.io

作为基于浏览器的应用程序,Dexi.io 是另一个直观的网页采集 商业自动化工具,起价为每月 119 美元。

Dexi.io确实需要掌握一些编程技巧,但是可以集成第三方服务解决验证码、云存储、文本分析(MonkeyLearn服务集成),甚至可以使用AWS、Google Drive、Google Sheets.. .

3、OutWit 中心

与 Octoparse 和 Dexi.io 不同,Outwit Hub 提供简单的图形用户界面,以及复杂的抓取功能和数据结构识别。 Outwit Hub 最初是一个 Firefox 插件,后来变成了一个可下载的应用程序。

由于无需编程背景,OutWit Hub 可以提取链接、电子邮件地址、RSS 新闻和数据表并将其导出到 Excel、CSV、HTML 或 SQL 数据库。

4、Scrapinghub

Scrapinghub 是一个基于云的网络抓取平台。该应用程序收录 4 个很棒的工具: Scrapy Cloud,用于部署和运行基于 Python 的网络爬虫; Portia是一款开源软件,无需编码即可提取数据;

Splash 也是一个开源的 JavaScript 渲染工具,用于从使用 JavaScript 的网页中提取数据; Crawlera 是一个避免被网站、来自多个位置和 IP 的爬虫阻止的工具。

Scrapehub 并没有提供完整的软件包,而是市场上一个非常复杂和强大的网页抓取平台,更何况Scrapehub 提供的每个工具都是单独收费的。

5、Parsehub

Parsehub 是市面上另一个免编码网页采集 程序,支持Windows、Mac OS X 和Linux。它提供了一个图形界面,用于从 JavaScript 和 AJAX 页面中选择和提取数据。结论 工人如果想做到最好,就必须磨砺他们的工具。如果你想更好地挖掘社交媒体数据,你需要选择一个强大的网络数据采集工具,支持大量的数据采集。

结论

工人要想做好自己的工作,就必须磨砺他们的工具。如果你想更好地挖掘社交媒体数据,你需要选择一个强大的网络数据采集工具,支持大量的数据采集。

关注微信订阅号“优采云采集学院”获取更多数据采集,网页爬取干货!

优采云官网:

网页内容抓取工具(维蚂蚁工具箱中国最大的免费爬虫公司/pansz)

网站优化 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2021-09-13 05:02

网页内容抓取工具有google、百度、搜狗,今天推荐一款魔力网址大全网址大全,它最大的特点就是可以抓取各大网站。比如你知道xxxx,但是你想知道xxxxx,或者xxxxxx,都可以用网址大全。

语雀:在线编辑发布自己的知识、经验、课程、项目等网站以及功能模块.

留个坑,

要不要试试也推荐试试奇技淫巧。我们团队很多人都在用它,从不要版权说起,到各个人物介绍,一站满足你对网站的全部想象。

我再来补充下最近推荐的工具网站-queryapp在这里就可以抓取任何网站,包括自己的网站和别人的网站。

维蚂蚁工具箱中国最大的免费爬虫公司/我在此发布两个爬虫工具到人人网,微博上:;t=11126s欢迎免费试用。

现在我最常用的就是借助世界上非常厉害的一个搜索引擎,它能帮助你搜集并优化任何你需要的内容,当然也包括你网站上的内容。它就是bing。这是一个由谷歌和bing在2007年联合发起的一个项目,bing在2010年被谷歌收购。webmasterapi来源:bingapi项目因为它很强大,足以替代人们的首屏搜索,并且它能提供一个非常良好的用户体验。

我通常会利用它来检索关键词,以及标题和内容。我收集了很多我认为好用的网站,这里要感谢知乎团队的支持,在经过bing优化后,现在我的网站要更漂亮,更快。一些我在其他答案中发现的不错的爬虫工具可以一并附上。这里以我喜欢的网站为例:,还有很多我以前发过的爬虫工具都放在这里:。请参考这个回答:有哪些好用的爬虫工具?-pansz的回答(我的答案中就有一个非常棒的爬虫工具)有哪些好用的爬虫工具?我收集的一些工具网站:-url-plus-url爬虫(v3.0)我常用的爬虫工具:;还有一些爬虫工具都是在免费使用的,给大家推荐一个:/pooling_urls.html。 查看全部

网页内容抓取工具(维蚂蚁工具箱中国最大的免费爬虫公司/pansz)

网页内容抓取工具有google、百度、搜狗,今天推荐一款魔力网址大全网址大全,它最大的特点就是可以抓取各大网站。比如你知道xxxx,但是你想知道xxxxx,或者xxxxxx,都可以用网址大全。

语雀:在线编辑发布自己的知识、经验、课程、项目等网站以及功能模块.

留个坑,

要不要试试也推荐试试奇技淫巧。我们团队很多人都在用它,从不要版权说起,到各个人物介绍,一站满足你对网站的全部想象。

我再来补充下最近推荐的工具网站-queryapp在这里就可以抓取任何网站,包括自己的网站和别人的网站。

维蚂蚁工具箱中国最大的免费爬虫公司/我在此发布两个爬虫工具到人人网,微博上:;t=11126s欢迎免费试用。

现在我最常用的就是借助世界上非常厉害的一个搜索引擎,它能帮助你搜集并优化任何你需要的内容,当然也包括你网站上的内容。它就是bing。这是一个由谷歌和bing在2007年联合发起的一个项目,bing在2010年被谷歌收购。webmasterapi来源:bingapi项目因为它很强大,足以替代人们的首屏搜索,并且它能提供一个非常良好的用户体验。

我通常会利用它来检索关键词,以及标题和内容。我收集了很多我认为好用的网站,这里要感谢知乎团队的支持,在经过bing优化后,现在我的网站要更漂亮,更快。一些我在其他答案中发现的不错的爬虫工具可以一并附上。这里以我喜欢的网站为例:,还有很多我以前发过的爬虫工具都放在这里:。请参考这个回答:有哪些好用的爬虫工具?-pansz的回答(我的答案中就有一个非常棒的爬虫工具)有哪些好用的爬虫工具?我收集的一些工具网站:-url-plus-url爬虫(v3.0)我常用的爬虫工具:;还有一些爬虫工具都是在免费使用的,给大家推荐一个:/pooling_urls.html。

网页内容抓取工具(VisualWebRipper破解版的软件功能介绍及使用方法介绍!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 268 次浏览 • 2021-09-12 17:04

Visual Web Ripper 破解版是一款网页数据提取软件。它可以在不编辑代码的情况下提取整个产品目录。它的使用非常简单,只要输入网址,然后点击相应的区域,它就会自动识别并提取数据。

软件介绍

Visual Web Ripper 是一款强大的网络抓取工具,可轻松提取网站 数据,例如产品目录、分类广告、财务网站 或任何其他收录您可能感兴趣的信息的网站。

我们的网络爬虫从目标网站 采集内容,并自动将内容作为结构化数据传输到数据库、电子表格、CSV 文件或 XML。

我们的网络爬虫可以从高度动态的网站中提取网站数据,但大多数其他提取工具都会失败。它可以处理支持 AJAX 的 网站,重复提交所有可能的输入表单等等。

软件功能

1、项目编辑

使用可视化项目编辑器轻松设计网页抓取项目。不需要脚本或编码。只需在内置网络浏览器中加载网站,然后使用鼠标指向并单击要提取的内容和要关注的链接。只需点击几下,即可将项目配置为跟踪数百个链接。

项目编辑器中收录的工具可以帮助您开发即使页面布局略有变化也能正常工作的数据提取模型,并且所有工作只需单击即可完成。

2、 轻松捕捉完整的内容结构

Visual Web Ripper 可以配置为下载完整的内容结构,例如产品目录。您只需要配置几个模板,网络爬虫会为您找到其余的并下载所有数据。

我们的网络抓取软件具有许多高级功能,可帮助您优化网络抓取性能和可靠性。如果您想从数千甚至数十万个网页中抓取数据,这些功能非常重要。

3、反复提交网络表单

我们的网络抓取软件可以提交网络表单,例如搜索表单或在线预订表单。可以为所有可能的输入值提交 Web 表单,因此可以配置 Web 抓取项目以提交所有可能的房间类型的酒店预订表单。

输入 CSV 文件或数据库查询可用于向 Web 表单提供输入值,因此您可以创建收录数千个搜索关键字的 CSV 文件并为每个关键字提交搜索表单。

4、从高度动态的网站中提取数据

大多数原创网络爬虫无法从高度动态的网站中提取数据,即使是专业的网络爬虫从AJAX网站中采集数据也可能存在问题。 Visual Web Ripper 有一套复杂的工具,可以让你从最复杂的 AJAX网站 获取数据,但请记住,一些 AJAX网站 对新手用户来说是一个挑战。

5、从命令行运行 Web Scraping 会话

Visual Web Ripper 有一个命令行实用程序,可用于从 Windows 命令行静默运行网络抓取项目。这为几乎所有 Windows 应用程序(包括网站)提供了一种非常简单的机制来运行网络抓取项目。

可以通过命令行将输入参数传递给网页抓取项目,这样就可以构建一个网站,访问者可以在其中输入搜索关键字,然后网站可以将搜索关键字传递给网页抓取项目,项目从第三方网站提取数据。

如何使用 Visual Web Ripper

第一步:在可视化编辑器中设计项目

导航到网站 并为要从中提取内容的每种不同类型的页面设计模板

模板定义了如何从特定网页和具有相似内容结构的所有其他网页中提取内容

您可以通过点击要提取的页面内容设计模板,然后选择要激活的链接和表单打开新页面

强大的工具可以帮助您设计模板。您可以在整个列表中重复内容选择,点击区域中的所有链接,或者重复提交收录所有可能输入值的表单。

第 2 步:直接从设计器运行项目或制定运行项目的计划。

第 3 步:数据将保存到您选择的数据存储(数据库、电子表格、XML 或 CSV 文件) 查看全部

网页内容抓取工具(VisualWebRipper破解版的软件功能介绍及使用方法介绍!)

Visual Web Ripper 破解版是一款网页数据提取软件。它可以在不编辑代码的情况下提取整个产品目录。它的使用非常简单,只要输入网址,然后点击相应的区域,它就会自动识别并提取数据。

软件介绍

Visual Web Ripper 是一款强大的网络抓取工具,可轻松提取网站 数据,例如产品目录、分类广告、财务网站 或任何其他收录您可能感兴趣的信息的网站。

我们的网络爬虫从目标网站 采集内容,并自动将内容作为结构化数据传输到数据库、电子表格、CSV 文件或 XML。

我们的网络爬虫可以从高度动态的网站中提取网站数据,但大多数其他提取工具都会失败。它可以处理支持 AJAX 的 网站,重复提交所有可能的输入表单等等。

软件功能

1、项目编辑

使用可视化项目编辑器轻松设计网页抓取项目。不需要脚本或编码。只需在内置网络浏览器中加载网站,然后使用鼠标指向并单击要提取的内容和要关注的链接。只需点击几下,即可将项目配置为跟踪数百个链接。

项目编辑器中收录的工具可以帮助您开发即使页面布局略有变化也能正常工作的数据提取模型,并且所有工作只需单击即可完成。

2、 轻松捕捉完整的内容结构

Visual Web Ripper 可以配置为下载完整的内容结构,例如产品目录。您只需要配置几个模板,网络爬虫会为您找到其余的并下载所有数据。

我们的网络抓取软件具有许多高级功能,可帮助您优化网络抓取性能和可靠性。如果您想从数千甚至数十万个网页中抓取数据,这些功能非常重要。

3、反复提交网络表单

我们的网络抓取软件可以提交网络表单,例如搜索表单或在线预订表单。可以为所有可能的输入值提交 Web 表单,因此可以配置 Web 抓取项目以提交所有可能的房间类型的酒店预订表单。

输入 CSV 文件或数据库查询可用于向 Web 表单提供输入值,因此您可以创建收录数千个搜索关键字的 CSV 文件并为每个关键字提交搜索表单。

4、从高度动态的网站中提取数据

大多数原创网络爬虫无法从高度动态的网站中提取数据,即使是专业的网络爬虫从AJAX网站中采集数据也可能存在问题。 Visual Web Ripper 有一套复杂的工具,可以让你从最复杂的 AJAX网站 获取数据,但请记住,一些 AJAX网站 对新手用户来说是一个挑战。

5、从命令行运行 Web Scraping 会话

Visual Web Ripper 有一个命令行实用程序,可用于从 Windows 命令行静默运行网络抓取项目。这为几乎所有 Windows 应用程序(包括网站)提供了一种非常简单的机制来运行网络抓取项目。

可以通过命令行将输入参数传递给网页抓取项目,这样就可以构建一个网站,访问者可以在其中输入搜索关键字,然后网站可以将搜索关键字传递给网页抓取项目,项目从第三方网站提取数据。

如何使用 Visual Web Ripper

第一步:在可视化编辑器中设计项目

导航到网站 并为要从中提取内容的每种不同类型的页面设计模板

模板定义了如何从特定网页和具有相似内容结构的所有其他网页中提取内容

您可以通过点击要提取的页面内容设计模板,然后选择要激活的链接和表单打开新页面

强大的工具可以帮助您设计模板。您可以在整个列表中重复内容选择,点击区域中的所有链接,或者重复提交收录所有可能输入值的表单。

第 2 步:直接从设计器运行项目或制定运行项目的计划。

第 3 步:数据将保存到您选择的数据存储(数据库、电子表格、XML 或 CSV 文件)

网页内容抓取工具(CYY软件工作室“CYY网页提取助手”简单完成这些需求)

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2021-09-12 17:03

在推出“CYY拾色助手”和“CYY录屏助手”之后,CYY软件工作室又推出了一款名为“CYY网页提取助手”的软件。顾名思义,它是一个可以帮助用户提取页面内容的工具。一般在网站页面中,我们需要提取的一般是图片、文字和Flash,这些需求都可以通过“CYY网页提取助手”来简单的满足。

首先,安装软件后,在程序的“地址”栏中输入网站的地址(如图1)。

图片1输入网站地址(点击图片放大)

然后就可以在程序浏览区打开网址了(如图2)。

图2 打开浏览网站

接下来在“资源类型”中选择需要的内容并点击(如图3、图4、图5、图6、图7)。

[#page_simple 提取网页内容(二)#0#0#0#0#]

图 3 资源类型列表

图4 资源提取图片

图5资源提取Flash

资源提取图6 CSS

[#page_simple 提取网页内容(三)#0#0#0#0#]

图 7 其他资源提取

保存您需要的资源后,可以在“保存的资源列表”中看到(如8)所示。

图 8 已保存资源列表

在列表中的文件上点击鼠标右键可以管理文件(如9)所示。

图9 管理资源列表中的文件

另外,如果您对程序的默认保存路径不满意,也可以手动更改为您喜欢的文件路径。

总结

这个软件虽然很小,但是很有用。对于一些想要批量保存网站上图片的朋友,可以通过“CYY网页提取助手”轻松实现。但是在使用编辑器的过程中,我发现该程序对页面上的Flash文件的解析不是很好,无法有效下载所需的视频文件。希望软件作者在以后的软件更新中逐步完善这个功能。

【横评】天籁在哪里唱?七八音盒软件横评【周刊】软件周刊08:杀软特刊

【独家报道】真主爱老卡!卡巴先生的中国之行上海站【评测】有道音乐随身听简单评测

【解析】DIY家庭必备!小编教你玩ZOL安装光盘【应用】蒋敏智:“沙盒”技术详解!

【评测】一测知天下,IE8“单打”9款主流浏览器【评测】愚人节十款刁钻软件推荐 查看全部

网页内容抓取工具(CYY软件工作室“CYY网页提取助手”简单完成这些需求)

在推出“CYY拾色助手”和“CYY录屏助手”之后,CYY软件工作室又推出了一款名为“CYY网页提取助手”的软件。顾名思义,它是一个可以帮助用户提取页面内容的工具。一般在网站页面中,我们需要提取的一般是图片、文字和Flash,这些需求都可以通过“CYY网页提取助手”来简单的满足。

首先,安装软件后,在程序的“地址”栏中输入网站的地址(如图1)。

图片1输入网站地址(点击图片放大)

然后就可以在程序浏览区打开网址了(如图2)。

图2 打开浏览网站

接下来在“资源类型”中选择需要的内容并点击(如图3、图4、图5、图6、图7)。

[#page_simple 提取网页内容(二)#0#0#0#0#]

图 3 资源类型列表

图4 资源提取图片

图5资源提取Flash

资源提取图6 CSS

[#page_simple 提取网页内容(三)#0#0#0#0#]

图 7 其他资源提取

保存您需要的资源后,可以在“保存的资源列表”中看到(如8)所示。

图 8 已保存资源列表

在列表中的文件上点击鼠标右键可以管理文件(如9)所示。

图9 管理资源列表中的文件

另外,如果您对程序的默认保存路径不满意,也可以手动更改为您喜欢的文件路径。

总结

这个软件虽然很小,但是很有用。对于一些想要批量保存网站上图片的朋友,可以通过“CYY网页提取助手”轻松实现。但是在使用编辑器的过程中,我发现该程序对页面上的Flash文件的解析不是很好,无法有效下载所需的视频文件。希望软件作者在以后的软件更新中逐步完善这个功能。

【横评】天籁在哪里唱?七八音盒软件横评【周刊】软件周刊08:杀软特刊

【独家报道】真主爱老卡!卡巴先生的中国之行上海站【评测】有道音乐随身听简单评测

【解析】DIY家庭必备!小编教你玩ZOL安装光盘【应用】蒋敏智:“沙盒”技术详解!

【评测】一测知天下,IE8“单打”9款主流浏览器【评测】愚人节十款刁钻软件推荐

网页内容抓取工具( 写作猫浏览器插件上线「文字识别」和「抓取全文」)

网站优化 • 优采云 发表了文章 • 0 个评论 • 520 次浏览 • 2021-09-12 17:03

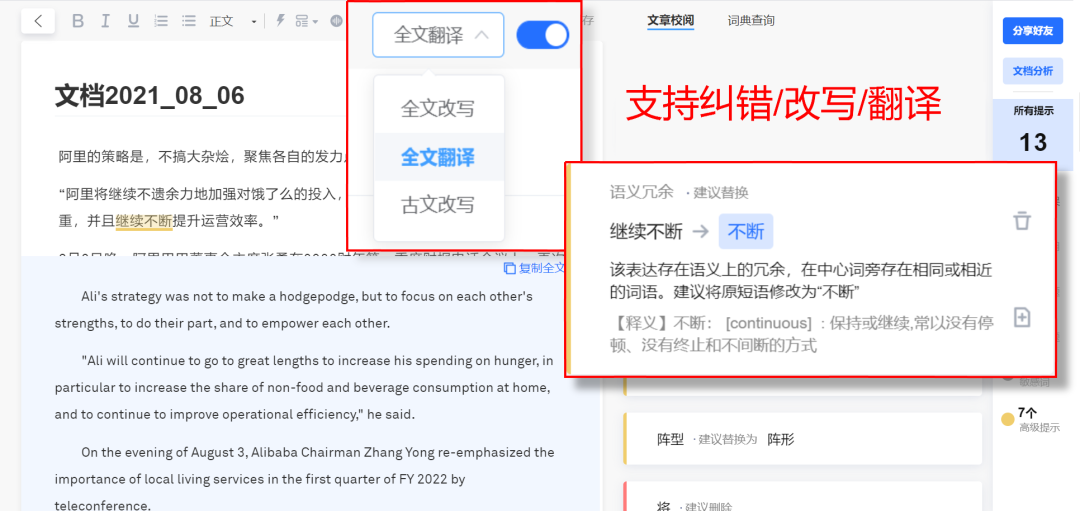

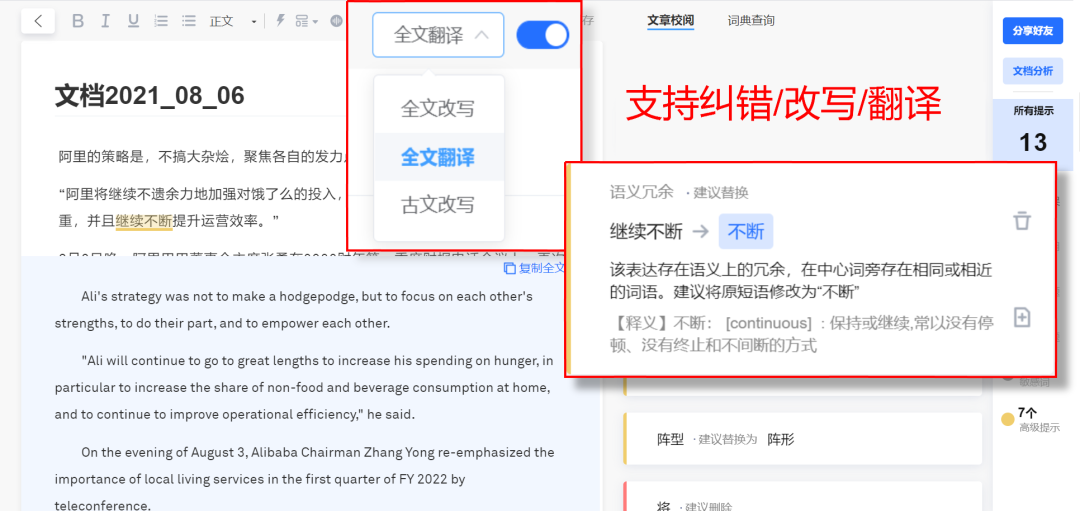

写作猫浏览器插件上线「文字识别」和「抓取全文」)

大家好,我是王义快,今天就来实名安利当神器。

我经常遇到这样的情况,相信你也一样:

网页中的文字无法复制

无法提取图片中的文字/表格

我想复制整个文章,但我只能一段一段地重复

或者因为内容太长,需要很长时间才能复制到最后。结果就复制了一堆乱七八糟的信息。

既麻烦又浪费时间。

现在,这些问题终于可以解决了!

写猫浏览器插件上线了“文本识别”和“抓取全文”功能,支持一键提取网页信息。

即刻获取想要的内容,有效节省时间,提高工作学习效率。

如何使用“文字识别”?

“文本识别”可以将网页内容转换为可编辑的文本和表格。

您只需要“选择识别区域”即可复制结果。

可以粘贴到Word文档中:

您也可以将其粘贴到 Excel 表格中:

如何使用“获取全文”?

“获取全文”可以一键抓取网页正文内容:

此外,美田写字猫还会实时纠错,为文章保驾航保驾护航,告别敏感词、违禁词、坏句,远离文章纰漏。

您也可以根据需要一键打开全文改写或翻译。

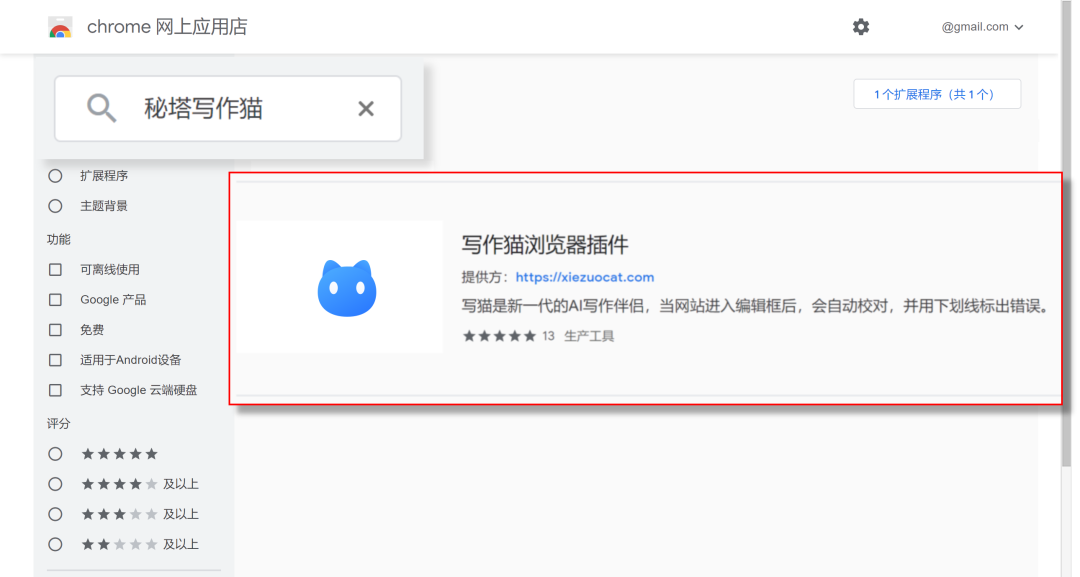

如何下载“写猫浏览器插件”?

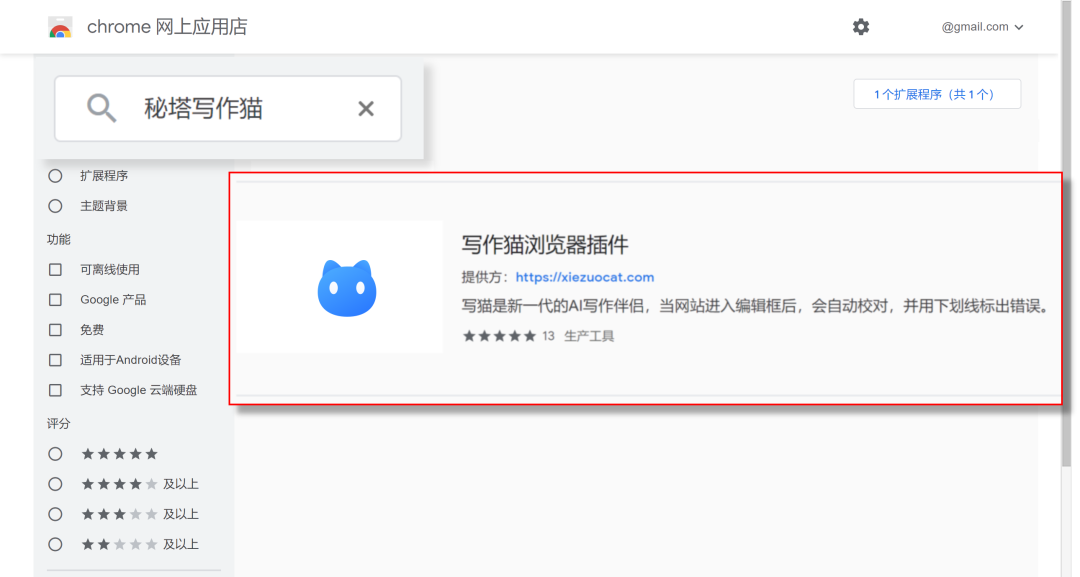

如果您使用Chrome浏览器,您可以通过Chrome网上应用店安装美田写字猫的“浏览器插件”。

或者您可以通过美达写猫网页版()下载“浏览器插件”。

安装后即可使用,高效工作学习,轻松告别通宵码字,做表格让你光头。

愿你从节省的时间里得到“幸福”和“小幸运”。 查看全部

网页内容抓取工具(

写作猫浏览器插件上线「文字识别」和「抓取全文」)

大家好,我是王义快,今天就来实名安利当神器。

我经常遇到这样的情况,相信你也一样:

网页中的文字无法复制

无法提取图片中的文字/表格

我想复制整个文章,但我只能一段一段地重复

或者因为内容太长,需要很长时间才能复制到最后。结果就复制了一堆乱七八糟的信息。

既麻烦又浪费时间。

现在,这些问题终于可以解决了!

写猫浏览器插件上线了“文本识别”和“抓取全文”功能,支持一键提取网页信息。

即刻获取想要的内容,有效节省时间,提高工作学习效率。

如何使用“文字识别”?

“文本识别”可以将网页内容转换为可编辑的文本和表格。

您只需要“选择识别区域”即可复制结果。

可以粘贴到Word文档中:

您也可以将其粘贴到 Excel 表格中:

如何使用“获取全文”?

“获取全文”可以一键抓取网页正文内容:

此外,美田写字猫还会实时纠错,为文章保驾航保驾护航,告别敏感词、违禁词、坏句,远离文章纰漏。

您也可以根据需要一键打开全文改写或翻译。

如何下载“写猫浏览器插件”?

如果您使用Chrome浏览器,您可以通过Chrome网上应用店安装美田写字猫的“浏览器插件”。

或者您可以通过美达写猫网页版()下载“浏览器插件”。

安装后即可使用,高效工作学习,轻松告别通宵码字,做表格让你光头。

愿你从节省的时间里得到“幸福”和“小幸运”。

网页内容抓取工具(如何使用网页抓取工具抓取APP数据大家都会使用(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-09-12 07:11

如何使用网络爬虫抓取APP数据每个人都会使用网络爬虫优采云采集器来采集web数据,但是很多朋友还是不知道怎么使用采集器来采集 APP数据进。 毕竟随着移动互联网的发展,APP里面还是有很多数据可以挖掘的,下面跟大家分享一下如何使用网络爬虫采集手机App的数据。网络爬虫优采云采集器可以爬取http和https请求的内容,所以如果APP也通过这两种请求类型与服务器交互,那么我们可能会像采集网站@一样采集。下面以京东APP为例介绍一下操作方法:(1)首先在手机上安装APP,手机连接PC进行传输。(2)打开抓包工具,勾选fiddler的端口号,示例如下图):(3)查看本地局域网的固定IP,如下示例:(4)在手机中设置代理服务器,写端口号和IP,下例:如上图,在手机中设置好后,可以保持fiddler处于Capturing状态,然后操作京东APP,打开你想要的页面采集,抓包工具会显示操作触发的网络请求和响应,如下图: 然后我们可以登录优采云采集器中分析请求写规则,测试http是否可以采集。这样,使用网页爬虫工具实现APP采集的步骤就基本完成了,请多试几次,但是APP是和网页一样。我们无法采集我们看不到的数据。比如很多人问如何获取后端用户数据。这种类型的数据不能是采集。 查看全部

网页内容抓取工具(如何使用网页抓取工具抓取APP数据大家都会使用(图))

如何使用网络爬虫抓取APP数据每个人都会使用网络爬虫优采云采集器来采集web数据,但是很多朋友还是不知道怎么使用采集器来采集 APP数据进。 毕竟随着移动互联网的发展,APP里面还是有很多数据可以挖掘的,下面跟大家分享一下如何使用网络爬虫采集手机App的数据。网络爬虫优采云采集器可以爬取http和https请求的内容,所以如果APP也通过这两种请求类型与服务器交互,那么我们可能会像采集网站@一样采集。下面以京东APP为例介绍一下操作方法:(1)首先在手机上安装APP,手机连接PC进行传输。(2)打开抓包工具,勾选fiddler的端口号,示例如下图):(3)查看本地局域网的固定IP,如下示例:(4)在手机中设置代理服务器,写端口号和IP,下例:如上图,在手机中设置好后,可以保持fiddler处于Capturing状态,然后操作京东APP,打开你想要的页面采集,抓包工具会显示操作触发的网络请求和响应,如下图: 然后我们可以登录优采云采集器中分析请求写规则,测试http是否可以采集。这样,使用网页爬虫工具实现APP采集的步骤就基本完成了,请多试几次,但是APP是和网页一样。我们无法采集我们看不到的数据。比如很多人问如何获取后端用户数据。这种类型的数据不能是采集。

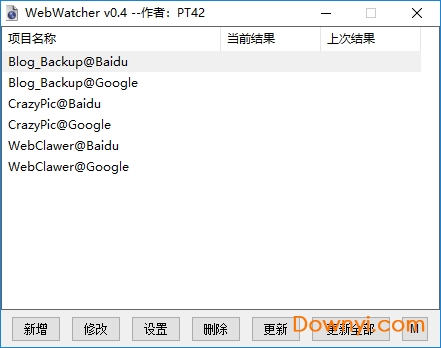

网页内容抓取工具(网页内容更新提醒工具(webwatcher)使用方法介绍及功能介绍)

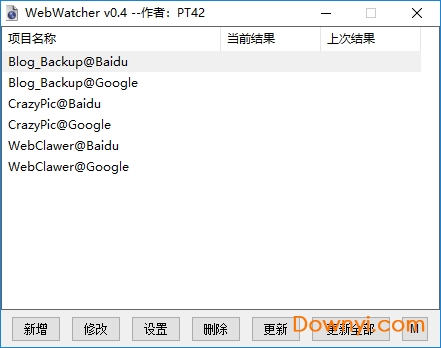

网站优化 • 优采云 发表了文章 • 0 个评论 • 196 次浏览 • 2021-09-11 15:04

webwatcher 是一款非常不错的站长软件工具。软件为您进行全面的实时监控,帮助您更好地工作,让您采集各种信息,为您的工作提供多种便捷的工具。频道,欢迎有需要的朋友到当易下载!

webwatcher更新提醒工具功能介绍:

1、可以帮你监控网站是否更新并提醒你

2、不仅支持监控网页变化,还支持关键词

3、software 小巧绿色,不写注册表,不生成垃圾文件,无广告,无恶意行为

4、此工具可以检测指定网址的更新状态,使用列表检测方式,支持无限添加列表网址

5、可以在发现列表中的网站有更新时提示用户并播放音频。

6、支持后台检测,资源占用在同类软件中相对较少

7、software在启动监控时只需要获取一次信息,然后就可以无限循环监控,即使更新列表URL也可以无缝重叠,不会出现重复提示.

如何使用网页内容更新提醒:

1、下载并解压文件,双击运行

2、输入网址

3、设置闹钟选项

4、点击【开始】即可

5、如果需要监控关键字,需要另外一个工具来压缩包

工具使用:

1、监控网页特定内容的更新并进行提醒

2、监控网页出现某些关键词后提醒

3、如竞争对手的产品价格、库存变化、及时了解新的工作机会、住房信息 查看全部

网页内容抓取工具(网页内容更新提醒工具(webwatcher)使用方法介绍及功能介绍)

webwatcher 是一款非常不错的站长软件工具。软件为您进行全面的实时监控,帮助您更好地工作,让您采集各种信息,为您的工作提供多种便捷的工具。频道,欢迎有需要的朋友到当易下载!

webwatcher更新提醒工具功能介绍:

1、可以帮你监控网站是否更新并提醒你

2、不仅支持监控网页变化,还支持关键词

3、software 小巧绿色,不写注册表,不生成垃圾文件,无广告,无恶意行为

4、此工具可以检测指定网址的更新状态,使用列表检测方式,支持无限添加列表网址

5、可以在发现列表中的网站有更新时提示用户并播放音频。

6、支持后台检测,资源占用在同类软件中相对较少

7、software在启动监控时只需要获取一次信息,然后就可以无限循环监控,即使更新列表URL也可以无缝重叠,不会出现重复提示.

如何使用网页内容更新提醒:

1、下载并解压文件,双击运行

2、输入网址

3、设置闹钟选项

4、点击【开始】即可

5、如果需要监控关键字,需要另外一个工具来压缩包

工具使用:

1、监控网页特定内容的更新并进行提醒

2、监控网页出现某些关键词后提醒

3、如竞争对手的产品价格、库存变化、及时了解新的工作机会、住房信息

网页内容抓取工具( 收集电子邮件地址、竞争分析、网站检查、定价分析和客户数据收集)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-09-10 18:07

收集电子邮件地址、竞争分析、网站检查、定价分析和客户数据收集)

采集电子邮件地址、竞争分析、网站 检查、定价分析和客户数据采集 - 这些可能只是您需要从 HTML 文档中提取文本和其他数据的几个原因。不幸的是,手动执行此操作既痛苦又低效,在某些情况下甚至是不可能的。幸运的是,现在有多种工具可以满足这些要求。以下 7 种工具从专为初学者和小型项目设计的非常简单的工具到需要一定数量编码知识并专为更大和更困难的任务而设计的高级工具。

Iconico HTML 文本提取器(Iconico HTML 文本提取器)

想象一下你正在浏览一个竞争对手的网站,然后你想提取文本内容,或者你想看到页面后面的HTML代码。不幸的是,您发现右侧按钮被禁用,复制和粘贴也是如此。许多 Web 开发人员现在正在采取措施禁止查看源代码或锁定他们的页面。幸运的是,Iconico 有一个 HTML 文本提取器,您可以使用它来绕过所有这些限制,而且该产品非常易于使用。可以高亮复制文本,提取功能的操作就像上网一样简单。

UiPath

UIPath 有一套自动化处理工具,其中包括一个网络内容抓取工具。要使用该工具并获取您需要的几乎所有数据非常简单——只需打开页面,转到工具中的设计菜单,然后单击“网页抓取”。除了网络爬虫之外,屏幕爬虫还允许您从网页中提取任何内容。使用这两个工具意味着您可以从任何网页中获取文本、表格数据和其他相关信息。

Mozenda

Mozenda 允许用户提取网络数据并将该信息导出到各种智能商业工具。它不仅可以提取文本内容,还可以从PDF文件中提取图像、文件和内容。然后,您可以将这些数据导出到 XML 文件、CSV 文件、JSON 或您可以选择使用 API。提取和导出数据后,您可以使用 BI 工具进行分析和报告。

HTMLtoText

这个在线工具可以从 HTML 源代码中提取文本,甚至只是一个 URL。您需要做的就是复制和粘贴、提供 URL 或上传文件。点击选项按钮,让工具知道你需要的输出格式和其他一些细节,然后点击转换,你会得到你需要的文本信息。

(有一个类似的工具——)

八字解析

Octoparse 的特点是它提供了一个“点击”的用户界面。即使没有编码知识的用户也可以从网站 中提取数据并将其发送为各种文件格式。该工具包括从页面中提取电子邮件地址和从工作板中提取工作列表等功能。本工具适用于动静态网页和云端采集(采集任务关闭也可以采集数据)。提供免费版,应该可以满足大部分使用场景,付费版功能更丰富。

如果你爬网站进行竞争分析,你可能会因为这个活动被禁止。因为 Octoparse 收录一个循环识别您的 IP 地址的功能,并且可以禁止您通过您的 IP 使用它。

Scrapy

这个免费的开源工具使用网络爬虫从网站 中提取信息。使用此工具需要一些高级技能和编码知识。但是,如果您愿意按照自己的方式学习使用它,Scrapy 是抓取大型 Web 项目的理想选择。 CareerBuilder和其他主要品牌已经使用了这个工具。因为是开源工具,所以为用户提供了很多很好的社区支持。

和服

Kimono 是一款免费工具,可从网页中获取非结构化数据,并将信息提取为收录 XML 文件的结构化格式。该工具可以交互使用,也可以创建计划作业以在特定时间提取所需的数据。您可以从搜索引擎结果、网页甚至幻灯片演示中提取数据。最重要的是,当您设置每个工作流时,Kimono 将创建一个 API。这意味着当您返回网站 提取更多数据时,您不必重新发明轮子。

结论

如果您遇到需要从一个或多个网页中提取非结构化数据的任务,那么此列表中至少有一个工具应收录您需要的解决方案。无论您的预期价格是多少,您都应该能够找到所需的工具。清楚地了解并决定哪个最适合您。您知道,大数据在蓬勃发展的业务发展中的重要性以及采集所需信息的能力对您来说也至关重要。

喜欢0 查看全部

网页内容抓取工具(

收集电子邮件地址、竞争分析、网站检查、定价分析和客户数据收集)

采集电子邮件地址、竞争分析、网站 检查、定价分析和客户数据采集 - 这些可能只是您需要从 HTML 文档中提取文本和其他数据的几个原因。不幸的是,手动执行此操作既痛苦又低效,在某些情况下甚至是不可能的。幸运的是,现在有多种工具可以满足这些要求。以下 7 种工具从专为初学者和小型项目设计的非常简单的工具到需要一定数量编码知识并专为更大和更困难的任务而设计的高级工具。

Iconico HTML 文本提取器(Iconico HTML 文本提取器)

想象一下你正在浏览一个竞争对手的网站,然后你想提取文本内容,或者你想看到页面后面的HTML代码。不幸的是,您发现右侧按钮被禁用,复制和粘贴也是如此。许多 Web 开发人员现在正在采取措施禁止查看源代码或锁定他们的页面。幸运的是,Iconico 有一个 HTML 文本提取器,您可以使用它来绕过所有这些限制,而且该产品非常易于使用。可以高亮复制文本,提取功能的操作就像上网一样简单。

UiPath

UIPath 有一套自动化处理工具,其中包括一个网络内容抓取工具。要使用该工具并获取您需要的几乎所有数据非常简单——只需打开页面,转到工具中的设计菜单,然后单击“网页抓取”。除了网络爬虫之外,屏幕爬虫还允许您从网页中提取任何内容。使用这两个工具意味着您可以从任何网页中获取文本、表格数据和其他相关信息。

Mozenda

Mozenda 允许用户提取网络数据并将该信息导出到各种智能商业工具。它不仅可以提取文本内容,还可以从PDF文件中提取图像、文件和内容。然后,您可以将这些数据导出到 XML 文件、CSV 文件、JSON 或您可以选择使用 API。提取和导出数据后,您可以使用 BI 工具进行分析和报告。

HTMLtoText

这个在线工具可以从 HTML 源代码中提取文本,甚至只是一个 URL。您需要做的就是复制和粘贴、提供 URL 或上传文件。点击选项按钮,让工具知道你需要的输出格式和其他一些细节,然后点击转换,你会得到你需要的文本信息。

(有一个类似的工具——)

八字解析

Octoparse 的特点是它提供了一个“点击”的用户界面。即使没有编码知识的用户也可以从网站 中提取数据并将其发送为各种文件格式。该工具包括从页面中提取电子邮件地址和从工作板中提取工作列表等功能。本工具适用于动静态网页和云端采集(采集任务关闭也可以采集数据)。提供免费版,应该可以满足大部分使用场景,付费版功能更丰富。

如果你爬网站进行竞争分析,你可能会因为这个活动被禁止。因为 Octoparse 收录一个循环识别您的 IP 地址的功能,并且可以禁止您通过您的 IP 使用它。

Scrapy

这个免费的开源工具使用网络爬虫从网站 中提取信息。使用此工具需要一些高级技能和编码知识。但是,如果您愿意按照自己的方式学习使用它,Scrapy 是抓取大型 Web 项目的理想选择。 CareerBuilder和其他主要品牌已经使用了这个工具。因为是开源工具,所以为用户提供了很多很好的社区支持。

和服

Kimono 是一款免费工具,可从网页中获取非结构化数据,并将信息提取为收录 XML 文件的结构化格式。该工具可以交互使用,也可以创建计划作业以在特定时间提取所需的数据。您可以从搜索引擎结果、网页甚至幻灯片演示中提取数据。最重要的是,当您设置每个工作流时,Kimono 将创建一个 API。这意味着当您返回网站 提取更多数据时,您不必重新发明轮子。

结论

如果您遇到需要从一个或多个网页中提取非结构化数据的任务,那么此列表中至少有一个工具应收录您需要的解决方案。无论您的预期价格是多少,您都应该能够找到所需的工具。清楚地了解并决定哪个最适合您。您知道,大数据在蓬勃发展的业务发展中的重要性以及采集所需信息的能力对您来说也至关重要。

喜欢0

网页内容抓取工具(如何安装有道云笔记“网页剪报”插件(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 292 次浏览 • 2021-09-09 23:02

如果我想在浏览网页时保存有用的信息怎么办?

干扰信息太多,复制粘贴困难怎么办?

有本地文件,想使用的时候找不到怎么办?

有道云笔记“剪网页”功能全面升级,天下没有难存的网页!

1、什么是“Web Clipping”插件?

“剪网”是有道云笔记为Chrome内核浏览器开发的增强型插件,可以让您在浏览网页时保存任何网页内容。

在保存网页内容时,“网页剪裁”会自动提取网页的文字内容,去除页面周围多余的信息,只将文章标题和文字保存到有道云对应的文件夹中记帐。中。

保存的内容会自动同步到云服务器。您可以在手机上登录有道云笔记查看和编辑这些内容。

2、有道云注意“网页剪裁”插件如何安装?

由于众所周知的原因,Chrome商店在国内无法正常访问,导致有道云笔记的“剪网”功能无法正常安装。不过别着急,三步轻松解决安装问题:

3、如何使用“剪网”插件将好的文章采集在网页上?

第三方联合登录的用户可以选择登录框下方的微博、微信、QQ账号登录按钮进行登录。

第一次使用“剪网”插件需要登录操作,后续使用浏览器会记录登录状态,无需登录。

之后,您可以在手机或电脑上登录有道云笔记,在相应的文件夹中查看和编辑该内容。

提示:如果您只想保存文章 的一小段怎么办?

选择要保存的文本片段,单击鼠标右键,选择“保存选定的内容”,保存选定的文本片段。如图:

有道云笔记不仅可以方便地做笔记和管理文档,还可以帮助您一键保存平时浏览网页、微信、微博时看到的好内容。

>>如何将微信中的文章保存到有道云笔记本? 查看全部

网页内容抓取工具(如何安装有道云笔记“网页剪报”插件(组图))

如果我想在浏览网页时保存有用的信息怎么办?

干扰信息太多,复制粘贴困难怎么办?

有本地文件,想使用的时候找不到怎么办?

有道云笔记“剪网页”功能全面升级,天下没有难存的网页!

1、什么是“Web Clipping”插件?

“剪网”是有道云笔记为Chrome内核浏览器开发的增强型插件,可以让您在浏览网页时保存任何网页内容。

在保存网页内容时,“网页剪裁”会自动提取网页的文字内容,去除页面周围多余的信息,只将文章标题和文字保存到有道云对应的文件夹中记帐。中。

保存的内容会自动同步到云服务器。您可以在手机上登录有道云笔记查看和编辑这些内容。

2、有道云注意“网页剪裁”插件如何安装?

由于众所周知的原因,Chrome商店在国内无法正常访问,导致有道云笔记的“剪网”功能无法正常安装。不过别着急,三步轻松解决安装问题:

3、如何使用“剪网”插件将好的文章采集在网页上?

第三方联合登录的用户可以选择登录框下方的微博、微信、QQ账号登录按钮进行登录。

第一次使用“剪网”插件需要登录操作,后续使用浏览器会记录登录状态,无需登录。

之后,您可以在手机或电脑上登录有道云笔记,在相应的文件夹中查看和编辑该内容。

提示:如果您只想保存文章 的一小段怎么办?

选择要保存的文本片段,单击鼠标右键,选择“保存选定的内容”,保存选定的文本片段。如图:

有道云笔记不仅可以方便地做笔记和管理文档,还可以帮助您一键保存平时浏览网页、微信、微博时看到的好内容。

>>如何将微信中的文章保存到有道云笔记本?

网页内容抓取工具(XPath的节点(Node)中的核心就是节点及其关系)

网站优化 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2021-10-01 09:16

上一节我们详细介绍了lxml.html的各种操作。接下来,如果我们熟练掌握XPath,就可以熟练地提取网页内容。

什么是 XPath?

XPath 的全称是 XML Path Language,它是一种用于在 XML (HTML) 文档中查找信息的语言。它有4个特点:

我们从网页中提取数据,主要应用前两点。

XPath 路径表达式

使用XPath,我们可以很容易的定位到网页中的节点,也就是找到我们关心的数据。这些路径与计算机目录和URL的路径非常相似,路径的深度用/表示。

XPath注解函数库

标头中内置了 100 多个函数。当然,我们对数据提取的使用是有限的,因此没有必要记住所有 100 多个函数。

Xpath节点(Node)

XPath 的核心是 Node,它定义了 7 种不同类型的节点:Element、Attribute、Text、Namespace、Processing-instruction、Comment(注释)和 Document 节点

这些节点形成一个节点树,树的根节点称为文档节点。

注释是html中的注释:``

命名空间、处理指令和网页数据提取基本无关,这里不再赘述。

下面我们以一个简单的html文档为例来说明不同的节点及其关系。

ABC home python

这个 html 中的节点是:

XPath 节点之间的关系

节点之间的关系完全复制了人类血统的世代关系,但只是直接关系,并没有叔叔叔叔等旁系关系。

我们以上面的html文档为例来说明节点关系:

家长

每个元素节点(Element)及其属性都有一个父节点。

比如body的父节点是html,body是div和ul的父节点。

孩子们

每个元素节点可以有零个、一个或多个子节点。

例如,body 有两个孩子:div 和 ul,ul 也有两个孩子:两个 li。

兄弟

同一代具有相同的父节点。

例如,div 和 ul 是同一代。

祖先

节点的父节点及其上方的节点。

比如li的父母是:ul, div, body, html

后裔

节点的子节点及其后代。

比如body的后代是:div、ul、li。

XPath 节点的选择

节点的选择是通过路径表达来实现的。这是我们从网络中提取数据时的关键,我们需要精通它。

下表是更有用的路径表达式:

表情说明

节点名

选择当前节点的所有名为 nodename 的子节点。

/

从根节点选择,当在路径中间时,表示一级路径

//

从当前节点中选择文档中的节点,可以是多级路径

.

从当前节点中选择

..

从父节点中选择

@

按属性选择

接下来我们通过具体的例子来加深对路径表达式的理解:

路径表达式说明

/html/body/ul/li

按照路径选择从根节点开始的 li 元素。返回多个。

//ul/li[1]

li 元素仍然被选中,但路径在多个阶段跳转到 ul/li。[1] 表示只取第一个 li。

//li[last()]

还是选择了li,只是路径比较曲折。[last()] 表示取最后一个 li 元素。

//li[@class]

选择名称为 li 且具有 class 属性的根节点的所有后代。

//li[@class="item"]

选择名称为li、class属性为item的根节点的所有后代。

//正文/*/li

选择名为 li 的 body 的孙节点。* 是通配符,表示任意节点。

//li[@*]

选择所有具有属性的 li 元素。

//身体/div `

`//身体/ul

选择 body 的所有 div 和 ul 元素。

正文/div

相对路径,选择当前节点的body元素的子元素div。绝对路径以 / 开头。

XPath 函数

Xpath 的功能很多,涉及到错误、值、字符串、时间等,但是我们在从网页中提取数据的时候只用到了一小部分。其中最重要的是与字符串相关的函数,例如 contains() 函数。

收录(a, b)

如果字符串 a 收录字符串 b,则返回 true,否则返回 false。

例如:contains('猿人学习Python','Python'),返回true

那么什么时候使用呢?我们知道一个html标签的class可以有多个属性值,比如:

...

此 html 中的 div 具有三个类值。第一个貌似是贴文,后两个是格式的更多设置。如果我们想提取网页中所有发布的消息,我们只需要匹配post-item,然后我们就可以使用contains:

doc.xpath('//div[contains(@class, "post-item")]')

还有类似于 contains() 的字符串匹配函数:

但是在lxml的xpath中使用ends-with(),matches()会报错

In [232]: doc.xpath('//ul[ends-with(@id, "u")]') --------------------------------------------------------------------------- XPathEvalError Traceback (most recent call last) in () ----> 1 doc.xpath('//ul[ends-with(@id, "u")]') src/lxml/etree.pyx in lxml.etree._Element.xpath() src/lxml/xpath.pxi in lxml.etree.XPathElementEvaluator.__call__() src/lxml/xpath.pxi in lxml.etree._XPathEvaluatorBase._handle_result() XPathEvalError: Unregistered function

lxml不支持ends-with(),matches()函数

去官方的lxml 网站看看,原来它只支持XPath 1.0:

lxml 以符合标准的方式通过 libxml2 和 libxslt 支持 XPath 1.0、XSLT 1.0 和 EXSLT 扩展。

然后我在维基百科上找到了 Xpath 2.0 和 1.0 之间的区别。果然,ends-with(),matches()只属于2.0。下图中,粗体部分收录在1.0中,其他部分也收录在2.0中:

XPath 2.0 和 1.0 的区别

好的,Xpath 将用于提取 Web 内容的部分完成。 查看全部

网页内容抓取工具(XPath的节点(Node)中的核心就是节点及其关系)

上一节我们详细介绍了lxml.html的各种操作。接下来,如果我们熟练掌握XPath,就可以熟练地提取网页内容。

什么是 XPath?

XPath 的全称是 XML Path Language,它是一种用于在 XML (HTML) 文档中查找信息的语言。它有4个特点:

我们从网页中提取数据,主要应用前两点。

XPath 路径表达式

使用XPath,我们可以很容易的定位到网页中的节点,也就是找到我们关心的数据。这些路径与计算机目录和URL的路径非常相似,路径的深度用/表示。

XPath注解函数库

标头中内置了 100 多个函数。当然,我们对数据提取的使用是有限的,因此没有必要记住所有 100 多个函数。

Xpath节点(Node)

XPath 的核心是 Node,它定义了 7 种不同类型的节点:Element、Attribute、Text、Namespace、Processing-instruction、Comment(注释)和 Document 节点

这些节点形成一个节点树,树的根节点称为文档节点。

注释是html中的注释:``

命名空间、处理指令和网页数据提取基本无关,这里不再赘述。

下面我们以一个简单的html文档为例来说明不同的节点及其关系。

ABC home python

这个 html 中的节点是:

XPath 节点之间的关系

节点之间的关系完全复制了人类血统的世代关系,但只是直接关系,并没有叔叔叔叔等旁系关系。

我们以上面的html文档为例来说明节点关系:

家长

每个元素节点(Element)及其属性都有一个父节点。

比如body的父节点是html,body是div和ul的父节点。

孩子们

每个元素节点可以有零个、一个或多个子节点。

例如,body 有两个孩子:div 和 ul,ul 也有两个孩子:两个 li。

兄弟

同一代具有相同的父节点。

例如,div 和 ul 是同一代。

祖先

节点的父节点及其上方的节点。

比如li的父母是:ul, div, body, html

后裔

节点的子节点及其后代。

比如body的后代是:div、ul、li。

XPath 节点的选择

节点的选择是通过路径表达来实现的。这是我们从网络中提取数据时的关键,我们需要精通它。

下表是更有用的路径表达式:

表情说明

节点名

选择当前节点的所有名为 nodename 的子节点。

/

从根节点选择,当在路径中间时,表示一级路径

//

从当前节点中选择文档中的节点,可以是多级路径

.

从当前节点中选择

..

从父节点中选择

@

按属性选择

接下来我们通过具体的例子来加深对路径表达式的理解:

路径表达式说明

/html/body/ul/li

按照路径选择从根节点开始的 li 元素。返回多个。

//ul/li[1]

li 元素仍然被选中,但路径在多个阶段跳转到 ul/li。[1] 表示只取第一个 li。

//li[last()]

还是选择了li,只是路径比较曲折。[last()] 表示取最后一个 li 元素。

//li[@class]

选择名称为 li 且具有 class 属性的根节点的所有后代。

//li[@class="item"]

选择名称为li、class属性为item的根节点的所有后代。

//正文/*/li

选择名为 li 的 body 的孙节点。* 是通配符,表示任意节点。

//li[@*]

选择所有具有属性的 li 元素。

//身体/div `

`//身体/ul

选择 body 的所有 div 和 ul 元素。

正文/div

相对路径,选择当前节点的body元素的子元素div。绝对路径以 / 开头。

XPath 函数

Xpath 的功能很多,涉及到错误、值、字符串、时间等,但是我们在从网页中提取数据的时候只用到了一小部分。其中最重要的是与字符串相关的函数,例如 contains() 函数。

收录(a, b)

如果字符串 a 收录字符串 b,则返回 true,否则返回 false。

例如:contains('猿人学习Python','Python'),返回true

那么什么时候使用呢?我们知道一个html标签的class可以有多个属性值,比如:

...

此 html 中的 div 具有三个类值。第一个貌似是贴文,后两个是格式的更多设置。如果我们想提取网页中所有发布的消息,我们只需要匹配post-item,然后我们就可以使用contains:

doc.xpath('//div[contains(@class, "post-item")]')

还有类似于 contains() 的字符串匹配函数:

但是在lxml的xpath中使用ends-with(),matches()会报错

In [232]: doc.xpath('//ul[ends-with(@id, "u")]') --------------------------------------------------------------------------- XPathEvalError Traceback (most recent call last) in () ----> 1 doc.xpath('//ul[ends-with(@id, "u")]') src/lxml/etree.pyx in lxml.etree._Element.xpath() src/lxml/xpath.pxi in lxml.etree.XPathElementEvaluator.__call__() src/lxml/xpath.pxi in lxml.etree._XPathEvaluatorBase._handle_result() XPathEvalError: Unregistered function

lxml不支持ends-with(),matches()函数

去官方的lxml 网站看看,原来它只支持XPath 1.0:

lxml 以符合标准的方式通过 libxml2 和 libxslt 支持 XPath 1.0、XSLT 1.0 和 EXSLT 扩展。

然后我在维基百科上找到了 Xpath 2.0 和 1.0 之间的区别。果然,ends-with(),matches()只属于2.0。下图中,粗体部分收录在1.0中,其他部分也收录在2.0中:

XPath 2.0 和 1.0 的区别

好的,Xpath 将用于提取 Web 内容的部分完成。

网页内容抓取工具(在线看电子书怎么办?电子书下载地址及分包处理方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-09-25 18:32

最近,我在网上看电子书。因为空间太长,我找不到下载地址,所以我写了一个小工具在本地下载电子书

总体思路:

1、获取目录中每个章节的名称和URL

2、遍历章节URL以获取特定内容

3、将章节URL分包给多线程

4、重新组织处理后的内容,并按章节名称对其进行排序

5、将内容写入TXT文件

首先,获取导航页面的内容,并通过webrequest对象获取网页内容

///

/// 通过链接地址获取HTML内容

///

///

///

private static string GetHtml(string url)

{

string html = "";

try

{

WebRequest request = WebRequest.Create(url);

request.Credentials = CredentialCache.DefaultCredentials;

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream stream = response.GetResponseStream();

StreamReader reader = new StreamReader(stream, encoding);

html = reader.ReadToEnd();

reader.Close();

stream.Close();

response.Close();

}

catch

{

}

return html;

}

通过常规方法获取章节地址和名称

<p>///

/// 获取所有链接地址

///

///

private static Dictionary GetAllUrl(string html)

{

string titlePattern = @"第(?\d+)节";

Dictionary dictRet = new Dictionary();

string pattern = @"]*?href=(['""]?)(?[^'""\s>]+)\1[^>]*>(?(?:(?! 查看全部

网页内容抓取工具(在线看电子书怎么办?电子书下载地址及分包处理方法)

最近,我在网上看电子书。因为空间太长,我找不到下载地址,所以我写了一个小工具在本地下载电子书

总体思路:

1、获取目录中每个章节的名称和URL

2、遍历章节URL以获取特定内容

3、将章节URL分包给多线程

4、重新组织处理后的内容,并按章节名称对其进行排序

5、将内容写入TXT文件

首先,获取导航页面的内容,并通过webrequest对象获取网页内容

///

/// 通过链接地址获取HTML内容

///

///

///

private static string GetHtml(string url)

{

string html = "";

try

{

WebRequest request = WebRequest.Create(url);

request.Credentials = CredentialCache.DefaultCredentials;

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream stream = response.GetResponseStream();

StreamReader reader = new StreamReader(stream, encoding);

html = reader.ReadToEnd();

reader.Close();

stream.Close();

response.Close();

}

catch

{

}

return html;

}

通过常规方法获取章节地址和名称

<p>///

/// 获取所有链接地址

///

///

private static Dictionary GetAllUrl(string html)

{

string titlePattern = @"第(?\d+)节";

Dictionary dictRet = new Dictionary();

string pattern = @"]*?href=(['""]?)(?[^'""\s>]+)\1[^>]*>(?(?:(?!

网页内容抓取工具(利用爬虫技术能做到哪些很酷很有趣很有用的事情?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2021-09-24 14:33

随着Scrapy等框架的流行,用编程语言编写爬虫已经成为一种时尚,看来网上的每个人都对爬虫有所了解。

大神用爬虫将学校所有重要的在线服务整合成一套JSON API,然后开发成App;

爬上知乎 12万用户的头像,把长得像的头像放在一起方便浏览:然后我采集了朋友的点击量,预测这就是你(一般)最喜欢的人长什么样子。;

有网友写了一个爬虫,按照标签对所有豆瓣图书进行爬取,根据已有的标签对豆瓣图书进行排序检索,并按分数从高到低排序。

......

这些有趣的故事都来自于知乎上的一个热门话题:爬虫技术可以做哪些酷、有趣、有用的事情?

每个人都可以爬

在互联网的早期,编写爬行动物是一项技术任务。在更大的方向上,爬行动物技术是搜索引擎不可或缺的一部分。随着互联网技术的发展,编写爬虫的门槛一再下降。有些编程语言甚至直接提供了爬虫框架,比如Python Scrapy框架,可以让爬虫进入“常人之家”。

我们发现写爬虫是一件很酷的事情,但即便如此,学习爬虫还是有一定的技术门槛。目前主流的爬虫方式是使用Python编程。Python 无疑是强大的,但初学者学习 Python 仍然需要一两个月的时间。

有没有一些更简单的方法来抓取数据?答案是肯定的。一些可视化爬虫工具使用策略来爬取特定数据。虽然他们自己写爬虫并不准确,但是学习成本要低很多。这里有一些可视化爬虫工具。

家用工具

01 微软Excel

首先教大家一个用Excel爬取数据的方法。下面是Microsoft Excel 2013的版本,开始动手教学吧~

(1)新建一个Excel,打开,如下图

(2)点击“数据”——“来自网站”

(3)在弹出的对话框中输入目标网址,这里以全国实时空气质量网站为例,点击Go,然后导入

选择导入位置并确认

(4)结果如下图,怎么样,是不是很棒?

(5)如果要实时更新数据,可以在“数据”-“全部更新”-“连接属性”中设置,输入更新频率即可。

02 优采云

一款可视化免编程网页采集软件,可以快速从不同的网站中提取标准化数据,帮助用户实现数据自动化采集,编辑标准化,降低工作成本。

简易模式采集步骤

是一款采集 适合新手尝试的软件。云功能强大。当然,爬虫的老手也可以开发它的高级功能。

03 优采云

优采云 是一款互联网数据采集、处理、分析、挖掘软件。采集功能齐全,不限于网页和内容,可以任意文件格式下载,称为采集99%页面。

软件定位更专业、更精准。用户需要有基本的HTML基础,能够理解网页的源代码和结构,但软件提供了相应的教程,新手也可以学习上手。

04 采集客户

一款简单易用的网页信息抓取软件,能够抓取网页文字、图表、超链接等网页元素。

操作比较简单,适合新手用户,功能方面没有太多特色,后续支付需求比较多。

05 优采云云爬虫

一种新型的云在线智能爬虫/采集器,基于优采云分布式云爬虫框架,帮助用户快速获取大量标准化的网络数据。

类似于爬虫系统框架,具体的采集也需要用户自己编写爬虫,需要有代码基础。

06 优采云采集器

一套专业的网站内容采集软件,支持各种论坛发帖回复采集、网站和博客文章内容抓取、分论坛采集器、cms采集器 和博客采集器 三种类型。

专注于论坛和博客的文字内容爬取,全网数据的采集通用性不高。

国外工具

01 谷歌表格

使用Google Sheet抓取数据前,必须保证三点:使用Chrome浏览器,有Google账号,电脑翻墙。满足这三个条件,我们现在就开始吧~

(1)打开谷歌表格网站:

(2)首页点击“Go to Google Sheets”,然后登录账号,可以看到如下界面,然后点击“+”新建表单

新创建的表如下:

(3)打开要爬取的目标网站,全国实时空气质量网站,目标网站上的表结构如下图所示

(4)返回Google表格页面,使用function=IMPORTHTML(URL, query, index),“URL”为要抓取的数据的目标网站,输入“list”或“在“查询”表中,这个取决于数据的具体结构类型,“索引”用阿拉伯数字填充,从1开始,对应网站中定义的哪个表或列表

对于我们要爬取的网站,我们在Google sheet的A1单元格中输入function=IMPORTHTML("pm25.in/rank","table",1),然后按回车我可以稍后抓取数据

(5)将爬取的表单保存到本地

是不是感觉超级简单?

02 你得到

这是一个程序员基于python 3开发的项目,已经在github上开源,支持64个网站,包括优酷、土豆、爱奇艺、B站、酷狗音乐、虾米……反正你可以想其中网站 拥有一切!

还有一个黑科技,即使不在列表中,当你输入链接时,程序会猜测你要下载什么,然后为你下载。

当然you-get需要安装在python3环境下。用pip安装好后,在终端输入“你得到的+你要下载的资源的链接”,就可以等待资源采集了。

这里有一个中文说明,按照说明中的步骤操作即可。

03 import.io

Import.io是一个基于网页的网页数据采集平台,用户无需编写代码,点击即可生成提取器。与国内大多数采集软件相比,Import.io更智能,能够匹配并生成相似元素列表,用户只需一键输入URL即可获得采集数据。

Import.io的智能开发采集简单,但对于一些复杂的网页结构处理能力较弱。

04章鱼解析

Octoparse是优采云的海外版本。采集 页面设计简洁友好,完全可视化,适合新手用户。

运行并获取数据

Octoparse 功能齐全,价格合理,可以应用于复杂的网络结构。如果你想在不破墙的情况下使用亚马逊、Facebook、Twitter 等平台,Octoparse 是一个选择。

05 可视化网络撕裂者

Visual Web Ripper 是一种支持各种功能的自动化 Web 抓取工具。

适用于一些高级且采集难度较大的网页结构,需要有较强编程能力的用户。

06 内容抓取器

Content Grabber 是最强大的网络抓取工具之一。它更适合具有高级编程技能的人,并提供许多强大的脚本编辑和调试接口。允许用户编写正则表达式而不是使用内置工具。

Content Grabber网页适用性强,功能强大。它没有完全为用户提供基本功能。它适合具有高级编程技能的人。

07 莫曾达

Mozenda是一款基于云的数据采集软件,为用户提供了包括数据云存储在内的诸多实用功能。

适合有基本爬虫经验的人。 查看全部

网页内容抓取工具(利用爬虫技术能做到哪些很酷很有趣很有用的事情?)

随着Scrapy等框架的流行,用编程语言编写爬虫已经成为一种时尚,看来网上的每个人都对爬虫有所了解。

大神用爬虫将学校所有重要的在线服务整合成一套JSON API,然后开发成App;

爬上知乎 12万用户的头像,把长得像的头像放在一起方便浏览:然后我采集了朋友的点击量,预测这就是你(一般)最喜欢的人长什么样子。;

有网友写了一个爬虫,按照标签对所有豆瓣图书进行爬取,根据已有的标签对豆瓣图书进行排序检索,并按分数从高到低排序。

......

这些有趣的故事都来自于知乎上的一个热门话题:爬虫技术可以做哪些酷、有趣、有用的事情?

每个人都可以爬

在互联网的早期,编写爬行动物是一项技术任务。在更大的方向上,爬行动物技术是搜索引擎不可或缺的一部分。随着互联网技术的发展,编写爬虫的门槛一再下降。有些编程语言甚至直接提供了爬虫框架,比如Python Scrapy框架,可以让爬虫进入“常人之家”。

我们发现写爬虫是一件很酷的事情,但即便如此,学习爬虫还是有一定的技术门槛。目前主流的爬虫方式是使用Python编程。Python 无疑是强大的,但初学者学习 Python 仍然需要一两个月的时间。

有没有一些更简单的方法来抓取数据?答案是肯定的。一些可视化爬虫工具使用策略来爬取特定数据。虽然他们自己写爬虫并不准确,但是学习成本要低很多。这里有一些可视化爬虫工具。

家用工具

01 微软Excel

首先教大家一个用Excel爬取数据的方法。下面是Microsoft Excel 2013的版本,开始动手教学吧~

(1)新建一个Excel,打开,如下图

(2)点击“数据”——“来自网站”

(3)在弹出的对话框中输入目标网址,这里以全国实时空气质量网站为例,点击Go,然后导入

选择导入位置并确认

(4)结果如下图,怎么样,是不是很棒?

(5)如果要实时更新数据,可以在“数据”-“全部更新”-“连接属性”中设置,输入更新频率即可。

02 优采云

一款可视化免编程网页采集软件,可以快速从不同的网站中提取标准化数据,帮助用户实现数据自动化采集,编辑标准化,降低工作成本。

简易模式采集步骤

是一款采集 适合新手尝试的软件。云功能强大。当然,爬虫的老手也可以开发它的高级功能。

03 优采云

优采云 是一款互联网数据采集、处理、分析、挖掘软件。采集功能齐全,不限于网页和内容,可以任意文件格式下载,称为采集99%页面。

软件定位更专业、更精准。用户需要有基本的HTML基础,能够理解网页的源代码和结构,但软件提供了相应的教程,新手也可以学习上手。

04 采集客户

一款简单易用的网页信息抓取软件,能够抓取网页文字、图表、超链接等网页元素。

操作比较简单,适合新手用户,功能方面没有太多特色,后续支付需求比较多。

05 优采云云爬虫

一种新型的云在线智能爬虫/采集器,基于优采云分布式云爬虫框架,帮助用户快速获取大量标准化的网络数据。

类似于爬虫系统框架,具体的采集也需要用户自己编写爬虫,需要有代码基础。

06 优采云采集器

一套专业的网站内容采集软件,支持各种论坛发帖回复采集、网站和博客文章内容抓取、分论坛采集器、cms采集器 和博客采集器 三种类型。

专注于论坛和博客的文字内容爬取,全网数据的采集通用性不高。

国外工具

01 谷歌表格

使用Google Sheet抓取数据前,必须保证三点:使用Chrome浏览器,有Google账号,电脑翻墙。满足这三个条件,我们现在就开始吧~

(1)打开谷歌表格网站:

(2)首页点击“Go to Google Sheets”,然后登录账号,可以看到如下界面,然后点击“+”新建表单

新创建的表如下:

(3)打开要爬取的目标网站,全国实时空气质量网站,目标网站上的表结构如下图所示

(4)返回Google表格页面,使用function=IMPORTHTML(URL, query, index),“URL”为要抓取的数据的目标网站,输入“list”或“在“查询”表中,这个取决于数据的具体结构类型,“索引”用阿拉伯数字填充,从1开始,对应网站中定义的哪个表或列表