网站文章一键采集

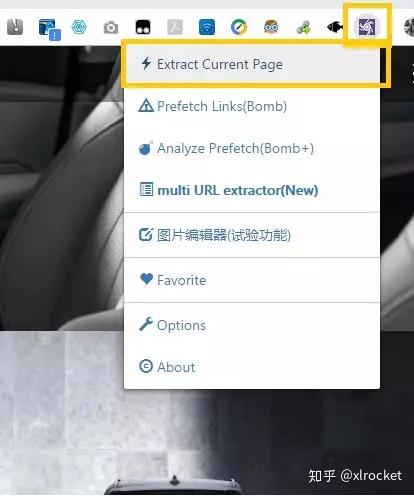

如何在一个网页中找出所有页面内图片的工具Image登场

采集交流 • 优采云 发表了文章 • 0 个评论 • 385 次浏览 • 2021-02-09 09:05

如何在一个网页中找出所有页面内图片的工具Image登场

今天,火箭先生将教您如何在网页中查找所有图片。

图像助手在这里

图片助手

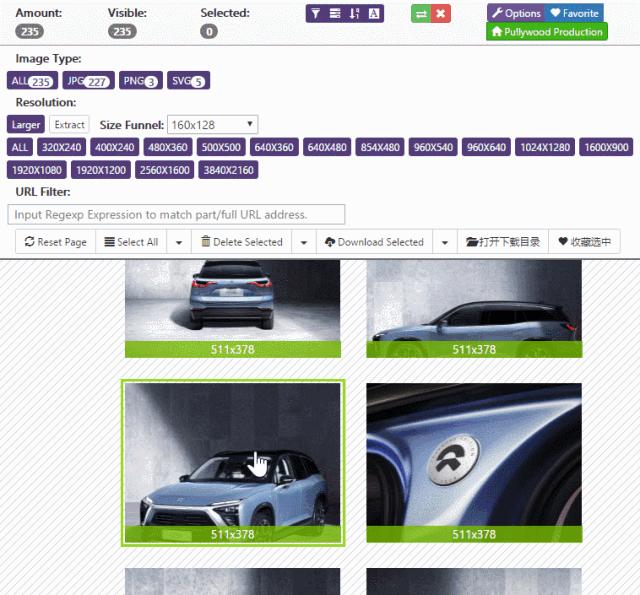

Image Assistant是一个chrome扩展程序,包括网页图像提取,过滤和下载功能。可以说,几乎可以提取页面上可以看到的所有图片元素,甚至可以提取“彩色”嵌入式广告中收录的图片。

设计人员可以快速获取Web资料,游戏开发人员从Web游戏中提取材料,分批下载壁纸,并分批查看网站图片...

可以说,只要您的计算机内存足够大,Image Assistant就会成为很好的图像提取伪像!

以互联网名人电动汽车为实验

蔚来ES8的官方网站有大量精美图片,但是由于UI交互设计,很难一次下载这些精美图片,甚至一次阅读这些精美图片

开始提取!

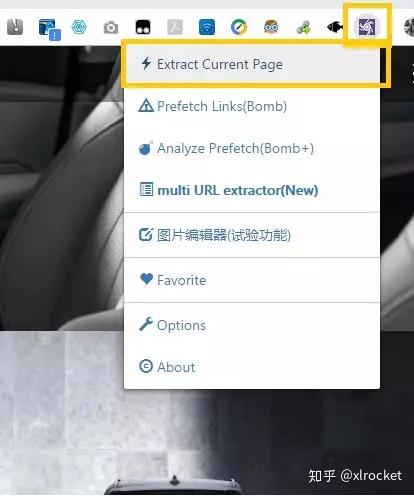

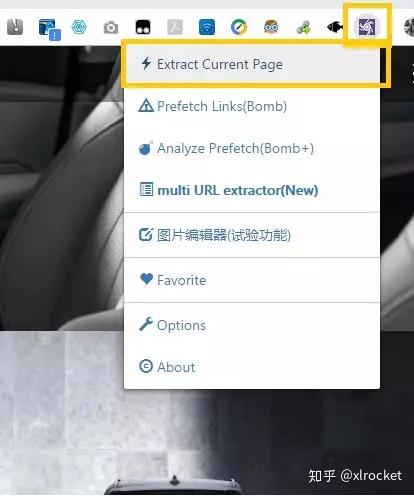

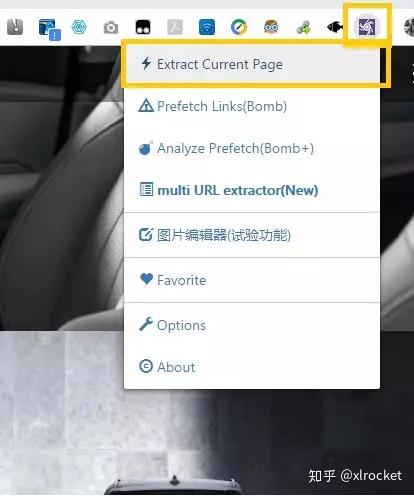

下载Image Assistant之后,Chrome界面上会有一个额外的紫色按钮。您只需要单击此按钮并选择“提取当前页面”即可完成网页图像元素的提取。

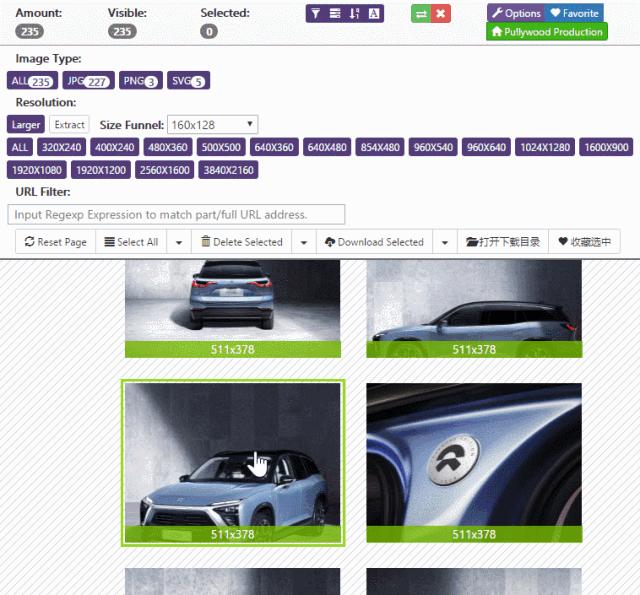

过一会儿,您将能够看到网页上的所有图片,

您也可以在尺寸漏斗中设置图像尺寸的过滤器,以确保不会显示过小的图像〜

继续挖掘!

除了可以在网页上查找图片之外,Image Assistant还支持搜索带有图片的图片。

在图片上单击鼠标右键后,您可以选择在各种搜索引擎中搜索图片或查找与图片相关的信息,这非常方便!

如果您对此插件感兴趣,请访问以下网站进行安装!

/ ImageAssistant /

原创链接:

效率火箭官方网站 |免费Office桌面软件下载|手机应用助手大全|个人团队协作效率工具的有效方法清单效率应用程序推荐|资源采集共享搜索发现平台

查看全部

如何在一个网页中找出所有页面内图片的工具Image登场

今天,火箭先生将教您如何在网页中查找所有图片。

图像助手在这里

图片助手

Image Assistant是一个chrome扩展程序,包括网页图像提取,过滤和下载功能。可以说,几乎可以提取页面上可以看到的所有图片元素,甚至可以提取“彩色”嵌入式广告中收录的图片。

设计人员可以快速获取Web资料,游戏开发人员从Web游戏中提取材料,分批下载壁纸,并分批查看网站图片...

可以说,只要您的计算机内存足够大,Image Assistant就会成为很好的图像提取伪像!

以互联网名人电动汽车为实验

蔚来ES8的官方网站有大量精美图片,但是由于UI交互设计,很难一次下载这些精美图片,甚至一次阅读这些精美图片

开始提取!

下载Image Assistant之后,Chrome界面上会有一个额外的紫色按钮。您只需要单击此按钮并选择“提取当前页面”即可完成网页图像元素的提取。

过一会儿,您将能够看到网页上的所有图片,

您也可以在尺寸漏斗中设置图像尺寸的过滤器,以确保不会显示过小的图像〜

继续挖掘!

除了可以在网页上查找图片之外,Image Assistant还支持搜索带有图片的图片。

在图片上单击鼠标右键后,您可以选择在各种搜索引擎中搜索图片或查找与图片相关的信息,这非常方便!

如果您对此插件感兴趣,请访问以下网站进行安装!

/ ImageAssistant /

原创链接:

效率火箭官方网站 |免费Office桌面软件下载|手机应用助手大全|个人团队协作效率工具的有效方法清单效率应用程序推荐|资源采集共享搜索发现平台

如何实现PHP语言开发的建站程序平台的自动采集功能

采集交流 • 优采云 发表了文章 • 0 个评论 • 271 次浏览 • 2021-01-20 12:30

WordPress是使用PHP语言开发的网站构建程序平台。现在,许多博客都使用wp。许多网站生产培训都使用wp,尤其是在进行采集工作站时。总能量非常强大。下面将介绍如何实现wp自动采集功能的特定操作步骤。 (相关知识:什么是wordpress?)如果要制作电影网站,则可以选择我的主题网站{Applecms模板} {海洋cms模板}和{Feifei电影模板}电视台大网站型交通(交通车站)

1、安装网站 采集插件:WP-AutoPost(插件下载链接:)

2、单击“新任务”后,输入任务名称以创建新任务。创建新任务后,您可以在任务列表中查看该任务,并且可以为该任务设置更多设置。 (这部分不需要修改设置,唯一需要更改的是采集的时间。)

3、文章信号源设置。在此选项卡下,我们需要设置文章源的文章列表URL和特定的文章匹配规则。让我们以采集“新浪网新闻”为例,文章列表URL是这样,因此,请在手动指定的文章列表URL中输入它,如下所示:

4、文章 URL匹配规则。 文章 URL匹配规则的设置非常简单,不需要复杂的设置。提供两种匹配模式。您可以使用URL通配符匹配或CSS选择器进行匹配。通常,URL通配符匹配相对简单,但有时会使用CSS选择器。更精确。

5、使用URL通配符匹配。通过单击列表URL上的文章,我们可以发现每个文章的URL具有以下结构:因此,请用通配符(*)替换URL中的数字或字母,例如:(*)/( *)。shtml。重复的URL可以使用301重定向。

6、使用CSS选择器进行匹配。要使用CSS选择器进行匹配,我们只需要设置文章 URL的CSS选择器,可以通过查看列表URL的源代码并在[URL]下找到文章超链接的代码来轻松设置CSS选择器。列表网址,如下所示:

7、可以看到文章的超链接A标记在类为“ contList”的标记内,因此文章 URL的CSS选择器仅需要设置为.contList a,如图所示下方:

设置8、后,如果不确定设置是否正确,则可以单击上图中的测试按钮。如果设置正确,将列出列表URL下的所有文章名称和相应的网址,如下所示:

9、其他设置无需修改。

10、及以上采集方法适用于WordPress多站点功能。

以上是我的主题网站Applecms为每个人自适应采集的10个漂亮模板:wordpress如何自动采集?相关问题的解释和相关问题的答案。我希望如何下载您当前遇到的wordpress自动采集插件?其他相关问题可以提供并获得一些帮助!有关更多Applecms的知识,请注意:我的主题网络Applecms安装教程。 查看全部

如何实现PHP语言开发的建站程序平台的自动采集功能

WordPress是使用PHP语言开发的网站构建程序平台。现在,许多博客都使用wp。许多网站生产培训都使用wp,尤其是在进行采集工作站时。总能量非常强大。下面将介绍如何实现wp自动采集功能的特定操作步骤。 (相关知识:什么是wordpress?)如果要制作电影网站,则可以选择我的主题网站{Applecms模板} {海洋cms模板}和{Feifei电影模板}电视台大网站型交通(交通车站)

1、安装网站 采集插件:WP-AutoPost(插件下载链接:)

2、单击“新任务”后,输入任务名称以创建新任务。创建新任务后,您可以在任务列表中查看该任务,并且可以为该任务设置更多设置。 (这部分不需要修改设置,唯一需要更改的是采集的时间。)

3、文章信号源设置。在此选项卡下,我们需要设置文章源的文章列表URL和特定的文章匹配规则。让我们以采集“新浪网新闻”为例,文章列表URL是这样,因此,请在手动指定的文章列表URL中输入它,如下所示:

4、文章 URL匹配规则。 文章 URL匹配规则的设置非常简单,不需要复杂的设置。提供两种匹配模式。您可以使用URL通配符匹配或CSS选择器进行匹配。通常,URL通配符匹配相对简单,但有时会使用CSS选择器。更精确。

5、使用URL通配符匹配。通过单击列表URL上的文章,我们可以发现每个文章的URL具有以下结构:因此,请用通配符(*)替换URL中的数字或字母,例如:(*)/( *)。shtml。重复的URL可以使用301重定向。

6、使用CSS选择器进行匹配。要使用CSS选择器进行匹配,我们只需要设置文章 URL的CSS选择器,可以通过查看列表URL的源代码并在[URL]下找到文章超链接的代码来轻松设置CSS选择器。列表网址,如下所示:

7、可以看到文章的超链接A标记在类为“ contList”的标记内,因此文章 URL的CSS选择器仅需要设置为.contList a,如图所示下方:

设置8、后,如果不确定设置是否正确,则可以单击上图中的测试按钮。如果设置正确,将列出列表URL下的所有文章名称和相应的网址,如下所示:

9、其他设置无需修改。

10、及以上采集方法适用于WordPress多站点功能。

以上是我的主题网站Applecms为每个人自适应采集的10个漂亮模板:wordpress如何自动采集?相关问题的解释和相关问题的答案。我希望如何下载您当前遇到的wordpress自动采集插件?其他相关问题可以提供并获得一些帮助!有关更多Applecms的知识,请注意:我的主题网络Applecms安装教程。

推荐文章:python如何实现批量抓取某一网站全部文章的链接?

采集交流 • 优采云 发表了文章 • 0 个评论 • 455 次浏览 • 2020-12-29 13:08

要拉动和闭合鱼网,必须先找到鱼的轮廓,然后按照鱼轮廓的顺序逐步进行操作,以整齐地采集整个网。

网站的结构也类似于鱼网,具有列表页面(鱼的轮廓)和内容页面(网的表面)。使用Python批量抓取,根据列表页面一个一个地抓取相应的内容页面。所有爬虫原理和爬虫工具都是以这种方式处理的。

如果仅想实现批量爬网网站 文章,则无需编写自己的爬网程序,则可以使用爬网工具。在这里,我推荐优采云采集平台,在线视觉操作,简单方便,十分钟就可以熟练使用。

优采云采集是新一代的网站 文章 采集和发布平台,它是完全在线配置和使用云采集的平台,功能强大,操作简单,配置快捷高效。

优采云不仅提供网页文章 采集,数据批处理修改,计时采集,计时和定量自动发布等基本功能,还集成了功能强大的SEO工具,并创新地实现了智能规则提取引擎和书签一键发布采集等功能大大改善了采集的配置和发布效率。

采集发布更简单:支持一键发布到WorpPress,Empire,织梦,ZBlog,Discuz,Destoon,Typecho,Emlog,Mipcms,Mituo,Yiyoucms,Applecms ],PHPcms和其他cms网站系统也可以发布到自定义Http接口或导出到excel,CSV和sql文件。

此外,它还支持特定的文章“一键快速采集”,包括:微信官方帐户文章,今天的头条新闻,新闻窗格采集。

优采云采集具有免费版本,有需要的学生可以快速浏览以下条目文章进行尝试。

列表页面·优采云采集帮助中心

详细信息页面(内容页面)·优采云采集帮助中心

文章 采集入门教程(超级详细)·优采云采集帮助中心。

查看全部

推荐文章:python如何实现批量抓取某一网站全部文章的链接?

要拉动和闭合鱼网,必须先找到鱼的轮廓,然后按照鱼轮廓的顺序逐步进行操作,以整齐地采集整个网。

网站的结构也类似于鱼网,具有列表页面(鱼的轮廓)和内容页面(网的表面)。使用Python批量抓取,根据列表页面一个一个地抓取相应的内容页面。所有爬虫原理和爬虫工具都是以这种方式处理的。

如果仅想实现批量爬网网站 文章,则无需编写自己的爬网程序,则可以使用爬网工具。在这里,我推荐优采云采集平台,在线视觉操作,简单方便,十分钟就可以熟练使用。

优采云采集是新一代的网站 文章 采集和发布平台,它是完全在线配置和使用云采集的平台,功能强大,操作简单,配置快捷高效。

优采云不仅提供网页文章 采集,数据批处理修改,计时采集,计时和定量自动发布等基本功能,还集成了功能强大的SEO工具,并创新地实现了智能规则提取引擎和书签一键发布采集等功能大大改善了采集的配置和发布效率。

采集发布更简单:支持一键发布到WorpPress,Empire,织梦,ZBlog,Discuz,Destoon,Typecho,Emlog,Mipcms,Mituo,Yiyoucms,Applecms ],PHPcms和其他cms网站系统也可以发布到自定义Http接口或导出到excel,CSV和sql文件。

此外,它还支持特定的文章“一键快速采集”,包括:微信官方帐户文章,今天的头条新闻,新闻窗格采集。

优采云采集具有免费版本,有需要的学生可以快速浏览以下条目文章进行尝试。

列表页面·优采云采集帮助中心

详细信息页面(内容页面)·优采云采集帮助中心

文章 采集入门教程(超级详细)·优采云采集帮助中心。

最新版:[KK网页信息批量采集]批量采集多个页面的信息,让任意网页拥有导出功能

采集交流 • 优采云 发表了文章 • 0 个评论 • 279 次浏览 • 2020-12-27 11:13

顾名思义,它可以采集网页上的任何信息并将其导出到您的计算机。同时,您也可以同时添加多个页面,以帮助您批量采集所需的信息。

采集的信息可以导出为文本txt和表格.xlsx格式。这样,他不仅可以将翅膀放在任何网页上,并允许该网页支持导出特定信息,还可以批量导出多个页面的信息。

网页信息批量提取工具,由于您自己的工作需要,管理后台订单和产品列表不支持导出。总结时,一一复制并粘贴到excel中,这不可避免地很复杂。 1分钟内可以完成的操作必须手动完成。重复这些机械化动作几个小时。因此,为了解决这些问题,第一版于2017年发布。让具有相同需求的学生能够更有效地处理问题。

它支持截取网页上的一部分信息并将其导出,还支持匹配被截取的信息片段列表中的多个循环信息。

更好:

1、发布请求以获取数据

2、自定义网页标题协议标头,伪装任何浏览器以供访问

3、可以同时设置爬网间隔,以防止采集被其他网站个服务器快速阻止

4、将结果从采集导出到excel或txt

它不仅具有采集信息的功能,如果您拥有自己的网站,还可以帮助您将这些信息或计算机Excel中的信息发布到网站。

您可以用它做什么?

1、 采集网页中的多条信息(标题/ URL /时间等),导出

从多个网页

2、批量处理采集信息并导出

3、批量访问打开的页面,例如,某些网站管理员需要批量向百度提交收录,一个人打开一个页面太麻烦了

软件下载地址:

高级进阶文章(写给网站管理员,普通人不需要理解,阅读使简单的软件更加复杂):

因此,如何使用它来采集条网站消息,并将其发布到我的网站

只需几个步骤:

1、在第文章页上编写抓取文章标题和内容的规则,并将其写下来。

2、使用“小工具”中的序列URL生成工具来生成一系列列表URL。如:list /1.html,list /2.html,list /3.html,...,list / 999.html,从其他网站的列表页中可以看到多少页],生成尽可能多的列表URL。

3、在匹配列表页面上编写并检索所有文章规则:也就是说,从列表页面中删除所有文章链接,进行匹配,然后将其导出

4、然后将在步骤3中得出的文章 URL输出为采集目标,并将其输出到URL框中。然后填写步骤1的规则,然后可以自动释放这些页面的文章标题和链接信息采集。

目前,网站某一列中文章的所有标题和链接都已采集并导出为excel,那么如何将该excel发布到我的网站?

5、手动将单元格合成为excel中post提交的信息格式。例如:title = kkno1&content = com

6、提交URL并填写文章发布背景的帖子接收URL,并在软件中完成协议标头的cookie信息(模拟网站管理员在后台登录),然后在帖子参数中填写步骤5生成的帖子提交格式,单击批量处理,软件可以自动批量发布方式,将此类信息一一提交到帖子接收页面,以实现自动发布功能。

从采集到发行的完整过程。似乎有很多步骤,实际上只有3场比赛。 查看全部

最新版:[KK网页信息批量采集]批量采集多个页面的信息,让任意网页拥有导出功能

顾名思义,它可以采集网页上的任何信息并将其导出到您的计算机。同时,您也可以同时添加多个页面,以帮助您批量采集所需的信息。

采集的信息可以导出为文本txt和表格.xlsx格式。这样,他不仅可以将翅膀放在任何网页上,并允许该网页支持导出特定信息,还可以批量导出多个页面的信息。

网页信息批量提取工具,由于您自己的工作需要,管理后台订单和产品列表不支持导出。总结时,一一复制并粘贴到excel中,这不可避免地很复杂。 1分钟内可以完成的操作必须手动完成。重复这些机械化动作几个小时。因此,为了解决这些问题,第一版于2017年发布。让具有相同需求的学生能够更有效地处理问题。

它支持截取网页上的一部分信息并将其导出,还支持匹配被截取的信息片段列表中的多个循环信息。

更好:

1、发布请求以获取数据

2、自定义网页标题协议标头,伪装任何浏览器以供访问

3、可以同时设置爬网间隔,以防止采集被其他网站个服务器快速阻止

4、将结果从采集导出到excel或txt

它不仅具有采集信息的功能,如果您拥有自己的网站,还可以帮助您将这些信息或计算机Excel中的信息发布到网站。

您可以用它做什么?

1、 采集网页中的多条信息(标题/ URL /时间等),导出

从多个网页

2、批量处理采集信息并导出

3、批量访问打开的页面,例如,某些网站管理员需要批量向百度提交收录,一个人打开一个页面太麻烦了

软件下载地址:

高级进阶文章(写给网站管理员,普通人不需要理解,阅读使简单的软件更加复杂):

因此,如何使用它来采集条网站消息,并将其发布到我的网站

只需几个步骤:

1、在第文章页上编写抓取文章标题和内容的规则,并将其写下来。

2、使用“小工具”中的序列URL生成工具来生成一系列列表URL。如:list /1.html,list /2.html,list /3.html,...,list / 999.html,从其他网站的列表页中可以看到多少页],生成尽可能多的列表URL。

3、在匹配列表页面上编写并检索所有文章规则:也就是说,从列表页面中删除所有文章链接,进行匹配,然后将其导出

4、然后将在步骤3中得出的文章 URL输出为采集目标,并将其输出到URL框中。然后填写步骤1的规则,然后可以自动释放这些页面的文章标题和链接信息采集。

目前,网站某一列中文章的所有标题和链接都已采集并导出为excel,那么如何将该excel发布到我的网站?

5、手动将单元格合成为excel中post提交的信息格式。例如:title = kkno1&content = com

6、提交URL并填写文章发布背景的帖子接收URL,并在软件中完成协议标头的cookie信息(模拟网站管理员在后台登录),然后在帖子参数中填写步骤5生成的帖子提交格式,单击批量处理,软件可以自动批量发布方式,将此类信息一一提交到帖子接收页面,以实现自动发布功能。

从采集到发行的完整过程。似乎有很多步骤,实际上只有3场比赛。

干货教程:优采云新闻源文章采集器 关键词一键采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 240 次浏览 • 2020-11-30 13:15

帮助您采集 文章〜全新的采集方法〜一键输入关键词并采集您想要的文章!

优采云新闻来源文章采集器是仅需输入关键词至采集主搜索引擎新闻源和网页的软件。 优采云该软件专有的第一种智能算法可以准确地提取网页的文本部分,并将其另存为文章。它支持格式化处理,例如删除标签,链接,邮箱和插入关键词功能,该功能可以识别要在其旁边插入的标签或标点符号,并可以识别英语空格的插入。还有文章翻译功能,即文章可以从一种语言(例如中文)转换为另一种语言(例如英语或日语),然后再从英语或日语转换回中文。这是可以设置的翻译周期。翻译周期可以循环多次(翻译次数)。

优采云新闻来源文章采集器用于智能提取网页正文的算法。百度新闻,谷歌新闻和搜搜新闻强烈聚合了不时更新的新闻资源,用之不竭的多语言翻译伪原创。

优采云新闻来源文章采集器作用范围:

1、按关键词 采集 Internet 文章并翻译伪原创,这是网站管理员朋友的首选。

2、适用于信息公共关系公司采集来过滤和完善信息材料(成千上万的专业公司的软件,矿工需要花费数百美元)

采集 文章+ translation 伪原创可以满足各个领域的大多数网站管理员的文章需求。一些公共关系处理和信息调查公司所需要的由专业公司开发的信息采集系统通常售价为数万甚至更多。 优采云的软件也是具有功能的信息采集系统,它与市场上昂贵的软件有共同点,但价格仅为几百元,您将知道如何试用。

更新日志:

版本v1.02日期2013-9-7:

1.解决了删除标题中所有空格(仅删除第一个和最后一个空格)的问题;

2.将转换器参数分隔到主界面;添加单词插入选项;

3.修改了提取文本的算法(类似于百度的经验,更容易识别文章);

4.改进了删除链接时不删除图像地址的方法;

5.提高了删除标签时保留指定标签的能力;许多其他改进。

有关更多移动新闻软件的内容,请输入Hiker移动台的主题: 查看全部

优采云新闻来源文章采集器关键词一键采集

帮助您采集 文章〜全新的采集方法〜一键输入关键词并采集您想要的文章!

优采云新闻来源文章采集器是仅需输入关键词至采集主搜索引擎新闻源和网页的软件。 优采云该软件专有的第一种智能算法可以准确地提取网页的文本部分,并将其另存为文章。它支持格式化处理,例如删除标签,链接,邮箱和插入关键词功能,该功能可以识别要在其旁边插入的标签或标点符号,并可以识别英语空格的插入。还有文章翻译功能,即文章可以从一种语言(例如中文)转换为另一种语言(例如英语或日语),然后再从英语或日语转换回中文。这是可以设置的翻译周期。翻译周期可以循环多次(翻译次数)。

优采云新闻来源文章采集器用于智能提取网页正文的算法。百度新闻,谷歌新闻和搜搜新闻强烈聚合了不时更新的新闻资源,用之不竭的多语言翻译伪原创。

优采云新闻来源文章采集器作用范围:

1、按关键词 采集 Internet 文章并翻译伪原创,这是网站管理员朋友的首选。

2、适用于信息公共关系公司采集来过滤和完善信息材料(成千上万的专业公司的软件,矿工需要花费数百美元)

采集 文章+ translation 伪原创可以满足各个领域的大多数网站管理员的文章需求。一些公共关系处理和信息调查公司所需要的由专业公司开发的信息采集系统通常售价为数万甚至更多。 优采云的软件也是具有功能的信息采集系统,它与市场上昂贵的软件有共同点,但价格仅为几百元,您将知道如何试用。

更新日志:

版本v1.02日期2013-9-7:

1.解决了删除标题中所有空格(仅删除第一个和最后一个空格)的问题;

2.将转换器参数分隔到主界面;添加单词插入选项;

3.修改了提取文本的算法(类似于百度的经验,更容易识别文章);

4.改进了删除链接时不删除图像地址的方法;

5.提高了删除标签时保留指定标签的能力;许多其他改进。

有关更多移动新闻软件的内容,请输入Hiker移动台的主题:

最新版本:网页文字采集器v6.0 绿色版

采集交流 • 优采云 发表了文章 • 0 个评论 • 306 次浏览 • 2020-11-09 12:02

这是根据客户要求开发的网页文本采集器,可以自动检索指定网页上的所有文本。它可能会突破一些禁止复制的电子书。通过简单的设置过程,它就可以工作。通常,网站管理员最希望他们可以向网站提供更多的内容,从而吸引更多的访问和页面浏览;一个接一个地输入文本既麻烦又无聊。因此,今天,编辑器向所有人推荐一个有用的网站 采集器。通常,采集系统就像一双眼睛,使您可以看得更远并且得到更多。该Amage 采集器可以从Internet采集各种图片,笑话,新闻,技术和其他信息,然后分类,编辑并发布到其网站系统。这个安美奇网站 采集器具有简单的界面和强大的功能!如果您喜欢此软件,请立即下载!

安美琪采集器功能

1、根据用户要求,添加了各种通用规则;

2、根据百度关键字采集相关内容的规则;

3、搜索与关键字采集相关的内容规则;

4、根据有道关键字采集相关内容的规则;

5、根据yahoo关键字采集相关内容的规则;

6、根据bing关键字采集相关的内容规则;

7、还支持列表类型采集,例如新闻,小说,下载等,您可以使用此软件采集;

8、支持替换指定的关键字,并支持在内容前后添加广告代码,每个人都可以一目了然;

9、添加了自定义采集方法,您可以自己添加采集内容和规则;

10、支持大多数语言,国内外大多数网页可以是采集,没有边界;

1 1、可以快速增加其自身网站的内容。

安美奇采集器使用说明

此版本是支持最基本的Access数据库的免费版本。不要修改数据库名称。 采集的内容在date.mdb中。如果数据库不同,请使用数据库导入和导出功能。

1.如果无法运行,请安装Microsoft的“ .net框架”,也可以在此网站上下载;如果您无法采集,请及时更新最新版本。

2.最后,我希望每个人都将支持该软件,并对该软件提出建议。

更新说明:

1:根据用户要求,添加了各种通用规则,

1. 1根据百度关键字采集相关内容的规则

1. 2搜索与关键字采集相关的内容的规则,

1. 3根据有道关键字采集相关内容的规则,

1. 4根据yahoo关键字采集相关内容的规则,

1. 5根据bing关键字采集的相关内容规则,

您可以快速增加自己网站的内容。

2:同时支持列表类型采集,例如新闻,小说,下载等,您可以使用此软件采集,

示例:单击“列出采集新浪规则”,然后有采集新浪新闻添加方法。

3:支持替换指定的关键字,并在内容前后添加广告代码。每个人乍一看都可以理解。

4:添加了自定义采集方法,您可以自行添加采集内容和规则

5:支持大多数语言,国内外大多数网页都可用采集,没有边界。

6:此版本是免费版本,支持最基本的Access数据库。不要修改数据库名称。

采集内容在date.mdb中,如果数据库不同,请使用数据库导入和导出功能。

7:如果无法运行,请安装Microsoft的.net框架。如果您无法采集,请更新到最新版本。

8:最后,我希望每个人都支持该软件,并对该软件提出建议。

更新日志(2020.07.16)

5.0添加了QQ群发和邮件群发服务

6.0修正了打开内容编辑自动关闭的错误。而且某些ajax不能单击错误。 查看全部

网页文字采集器v6.0绿色版本

这是根据客户要求开发的网页文本采集器,可以自动检索指定网页上的所有文本。它可能会突破一些禁止复制的电子书。通过简单的设置过程,它就可以工作。通常,网站管理员最希望他们可以向网站提供更多的内容,从而吸引更多的访问和页面浏览;一个接一个地输入文本既麻烦又无聊。因此,今天,编辑器向所有人推荐一个有用的网站 采集器。通常,采集系统就像一双眼睛,使您可以看得更远并且得到更多。该Amage 采集器可以从Internet采集各种图片,笑话,新闻,技术和其他信息,然后分类,编辑并发布到其网站系统。这个安美奇网站 采集器具有简单的界面和强大的功能!如果您喜欢此软件,请立即下载!

安美琪采集器功能

1、根据用户要求,添加了各种通用规则;

2、根据百度关键字采集相关内容的规则;

3、搜索与关键字采集相关的内容规则;

4、根据有道关键字采集相关内容的规则;

5、根据yahoo关键字采集相关内容的规则;

6、根据bing关键字采集相关的内容规则;

7、还支持列表类型采集,例如新闻,小说,下载等,您可以使用此软件采集;

8、支持替换指定的关键字,并支持在内容前后添加广告代码,每个人都可以一目了然;

9、添加了自定义采集方法,您可以自己添加采集内容和规则;

10、支持大多数语言,国内外大多数网页可以是采集,没有边界;

1 1、可以快速增加其自身网站的内容。

安美奇采集器使用说明

此版本是支持最基本的Access数据库的免费版本。不要修改数据库名称。 采集的内容在date.mdb中。如果数据库不同,请使用数据库导入和导出功能。

1.如果无法运行,请安装Microsoft的“ .net框架”,也可以在此网站上下载;如果您无法采集,请及时更新最新版本。

2.最后,我希望每个人都将支持该软件,并对该软件提出建议。

更新说明:

1:根据用户要求,添加了各种通用规则,

1. 1根据百度关键字采集相关内容的规则

1. 2搜索与关键字采集相关的内容的规则,

1. 3根据有道关键字采集相关内容的规则,

1. 4根据yahoo关键字采集相关内容的规则,

1. 5根据bing关键字采集的相关内容规则,

您可以快速增加自己网站的内容。

2:同时支持列表类型采集,例如新闻,小说,下载等,您可以使用此软件采集,

示例:单击“列出采集新浪规则”,然后有采集新浪新闻添加方法。

3:支持替换指定的关键字,并在内容前后添加广告代码。每个人乍一看都可以理解。

4:添加了自定义采集方法,您可以自行添加采集内容和规则

5:支持大多数语言,国内外大多数网页都可用采集,没有边界。

6:此版本是免费版本,支持最基本的Access数据库。不要修改数据库名称。

采集内容在date.mdb中,如果数据库不同,请使用数据库导入和导出功能。

7:如果无法运行,请安装Microsoft的.net框架。如果您无法采集,请更新到最新版本。

8:最后,我希望每个人都支持该软件,并对该软件提出建议。

更新日志(2020.07.16)

5.0添加了QQ群发和邮件群发服务

6.0修正了打开内容编辑自动关闭的错误。而且某些ajax不能单击错误。

正式发布:一键采集天涯帖子正式版 4.0.0

采集交流 • 优采云 发表了文章 • 0 个评论 • 339 次浏览 • 2020-09-07 06:58

问题:为什么Discuz论坛必须安装采集插件?

答案:让我反问一下。如果您没有安装采集插件,却原创写了文章,那么您可以写几篇文章? ?我相信9 9. 9%的人不会完全原创的所有内容,他们会重印其他网站的某些内容,包括一些xx日报,xx电视台,并且或多或少会重印其他网站为了获得高质量的内容,请在Discuz论坛中安装采集插件,主要是为了帮助您和管理自己的网站内容。由于您必须手动重新发布内容,为什么不更有效地使用它,没有错误并且易于使用采集工具,您可以用更少的钱做更多的事情吗? ?

问题:采集的内容,百度知道收录吗? ?如何进行SEO优化? ?

答案:当一条新闻发布时,您会在百度搜索中发现很多重复的内容文章也是收录。实际上,这些重复的内容会被重印,因此采集百度的内容也会收录,尤其是最新的原创内容会及时出现采集并同时发布,以便您的收录和[ 原创是相同的,为了更好地改善SEO 收录优化,除了及时采集最新原创内容外,最好采集拒绝百度收录的某些平台内容,例如:微信公众号文章,除采集之外,您还需要登录才能看到内容,某些内容由ajax加载等。百度无法抓取此类内容。如果您发布此类内容,则SEO 收录会更好,排名会更好! !

问题:采集的内容会侵权吗? ?

答案:一些有助于社会正常运转的内容。允许根据法规复制此类内容。例如,最近的新冠状肺炎非常严重,一些公开报道与该流行病有关。由于这些流行病,这些都没有问题。人们越了解预防和控制信息,越好! !对流行病的预防和控制更有帮助,采集这样的内容没问题!还有一种内容对某家公司有负面影响。某公司的公关人员将通知您删除内容。只要您合作删除内容,就可以了! !内容中只有很小一部分申请了版权。如果您不小心重印了它,则可能会受到版权所有者的起诉。这是一个低概率事件,您通常不会遇到! ! Zhiwu应用程序的采集插件支持发布前的审查。如果它不支持采集版本则不予审查! !确保采集内容的安全! !因为采集的每条内容都会在发布采集之前由您进行审核。

问题:Zhiwu应用程序可靠吗?会撒谎吗?

答案:非常可靠! ! Zhiwu所应用的产品在上线之前,将经过严格的测试和代码质量审查,以确保它们安全,可用和易于使用。所有产品通过评估后,才可以申请上架! !同时,源代码是打开的。任何人都可以查看原创的透明代码。具有技术能力的用户可以轻松快速地进行二次开发。智物应用的任何产品都可以免费试用,满意后将予以考虑。您需要升级到正式的商业版本吗?如果发现安装后无法使用它,则可以联系在线客户服务来解决。如果您遇到无法解决的问题,则无法使用该插件,并且将全额退款。一般原则是让用户安全无风险,准确找到他们的需求,并购买可以使用的插件模块。如果他们发现购买后不可用,Zhiwu应用程序将为您退款。如果您真的需要它,请放心购买Zhiwu app各种产品! ! !智物App一直认真听取用户的反馈意见,根据用户的建议不断升级和更新产品,尊重用户的权利和合理的要求! !将用户置于最高位置,竭诚为他们服务! !

问题:Zhiwu App的采集插件有哪些亮点和优势?

答案:大多数人都使用Chrome扩展程序采集程序,因此您需要在网络浏览器chrome中安装扩展程序,因为经过研究,发现将浏览器变成采集工具是最可靠的,成熟稳定采集方式!一些传统的采集方法通过程序抓取功能来获取采集内容,尽管您不需要安装chrome扩展程序,但经常会遇到问题,当遇到没有内容的采集时,事情常常会发生! !

问题:Zhiwu App开发了哪些采集插件?

答案:很多! !多年来,我们一直专注于采集插件的研发。经过多次升级和更新,我们在采集插件的开发方面积累了丰富的经验。如果找不到所需的采集插件,请向Zhiwu App在线客户服务反馈。

问题:Zhiwu App的采集哪个插件易于使用?

答案:核心技术相同,但是采集规则不同。 Zhiwu使用的采集插件都很容易使用。主要取决于您需要哪个网站,然后使用网站阶段对应的采集插件。

问题:我一点都不了解这项技术,但是我想使用Zhiwu App的Discuz 采集插件。我该怎么办?

回答:请联系Zhiwu App的在线客户服务来帮助您在线安装和配置它,直到插件完全可用为止! !您不需要了解技术,售后服务就会帮助您解决所有问题。

问题:为什么要使用Chrome扩展程序采集程序? ?

答案:因为此采集方法最稳定,最成熟! !网页是通过浏览器的HTML代码呈现的,因此将浏览器变成采集工具,所见即所得的方法是最好的。

问题:chrome扩展程序安全吗? ?为什么弹出“请禁用在开发人员模式下运行的扩展程序”

答案:只要安装了chrome扩展程序,无论使用什么chrome扩展程序,都会弹出此提醒:“以开发人员模式运行的扩展程序可能会损害您的计算机。如果您不是开发人员,那么出于安全考虑,应该禁用在开发人员模式下运行的扩展程序。”这就像在百货商店中提醒您:“如果发生火灾,请致电119。”就像提醒您拨打119一样,这并不意味着您遇到了Fire,这只是一条提醒消息! ! Zhiwu应用程序的Chrome扩展程序已经过多方人工检查,检查和测试,是安全可靠的扩展程序! !

问题:我可以无人看管并自动采集内容吗? ?

答案:不! !全自动采集内容并发布,因此采集内容并不安全! !智物App的采集插件经过审查后发布,以确保内容的质量和安全! !未经您的同意,您无法自动发布内容! !如果您需要在短时间内发布大量内容采集以填写网站,则可以在[待发布]中选择[批量发布带有chrome扩展名的内容]。 查看全部

一键点击采集 Tianya Post正式版4. 0. 0

问题:为什么Discuz论坛必须安装采集插件?

答案:让我反问一下。如果您没有安装采集插件,却原创写了文章,那么您可以写几篇文章? ?我相信9 9. 9%的人不会完全原创的所有内容,他们会重印其他网站的某些内容,包括一些xx日报,xx电视台,并且或多或少会重印其他网站为了获得高质量的内容,请在Discuz论坛中安装采集插件,主要是为了帮助您和管理自己的网站内容。由于您必须手动重新发布内容,为什么不更有效地使用它,没有错误并且易于使用采集工具,您可以用更少的钱做更多的事情吗? ?

问题:采集的内容,百度知道收录吗? ?如何进行SEO优化? ?

答案:当一条新闻发布时,您会在百度搜索中发现很多重复的内容文章也是收录。实际上,这些重复的内容会被重印,因此采集百度的内容也会收录,尤其是最新的原创内容会及时出现采集并同时发布,以便您的收录和[ 原创是相同的,为了更好地改善SEO 收录优化,除了及时采集最新原创内容外,最好采集拒绝百度收录的某些平台内容,例如:微信公众号文章,除采集之外,您还需要登录才能看到内容,某些内容由ajax加载等。百度无法抓取此类内容。如果您发布此类内容,则SEO 收录会更好,排名会更好! !

问题:采集的内容会侵权吗? ?

答案:一些有助于社会正常运转的内容。允许根据法规复制此类内容。例如,最近的新冠状肺炎非常严重,一些公开报道与该流行病有关。由于这些流行病,这些都没有问题。人们越了解预防和控制信息,越好! !对流行病的预防和控制更有帮助,采集这样的内容没问题!还有一种内容对某家公司有负面影响。某公司的公关人员将通知您删除内容。只要您合作删除内容,就可以了! !内容中只有很小一部分申请了版权。如果您不小心重印了它,则可能会受到版权所有者的起诉。这是一个低概率事件,您通常不会遇到! ! Zhiwu应用程序的采集插件支持发布前的审查。如果它不支持采集版本则不予审查! !确保采集内容的安全! !因为采集的每条内容都会在发布采集之前由您进行审核。

问题:Zhiwu应用程序可靠吗?会撒谎吗?

答案:非常可靠! ! Zhiwu所应用的产品在上线之前,将经过严格的测试和代码质量审查,以确保它们安全,可用和易于使用。所有产品通过评估后,才可以申请上架! !同时,源代码是打开的。任何人都可以查看原创的透明代码。具有技术能力的用户可以轻松快速地进行二次开发。智物应用的任何产品都可以免费试用,满意后将予以考虑。您需要升级到正式的商业版本吗?如果发现安装后无法使用它,则可以联系在线客户服务来解决。如果您遇到无法解决的问题,则无法使用该插件,并且将全额退款。一般原则是让用户安全无风险,准确找到他们的需求,并购买可以使用的插件模块。如果他们发现购买后不可用,Zhiwu应用程序将为您退款。如果您真的需要它,请放心购买Zhiwu app各种产品! ! !智物App一直认真听取用户的反馈意见,根据用户的建议不断升级和更新产品,尊重用户的权利和合理的要求! !将用户置于最高位置,竭诚为他们服务! !

问题:Zhiwu App的采集插件有哪些亮点和优势?

答案:大多数人都使用Chrome扩展程序采集程序,因此您需要在网络浏览器chrome中安装扩展程序,因为经过研究,发现将浏览器变成采集工具是最可靠的,成熟稳定采集方式!一些传统的采集方法通过程序抓取功能来获取采集内容,尽管您不需要安装chrome扩展程序,但经常会遇到问题,当遇到没有内容的采集时,事情常常会发生! !

问题:Zhiwu App开发了哪些采集插件?

答案:很多! !多年来,我们一直专注于采集插件的研发。经过多次升级和更新,我们在采集插件的开发方面积累了丰富的经验。如果找不到所需的采集插件,请向Zhiwu App在线客户服务反馈。

问题:Zhiwu App的采集哪个插件易于使用?

答案:核心技术相同,但是采集规则不同。 Zhiwu使用的采集插件都很容易使用。主要取决于您需要哪个网站,然后使用网站阶段对应的采集插件。

问题:我一点都不了解这项技术,但是我想使用Zhiwu App的Discuz 采集插件。我该怎么办?

回答:请联系Zhiwu App的在线客户服务来帮助您在线安装和配置它,直到插件完全可用为止! !您不需要了解技术,售后服务就会帮助您解决所有问题。

问题:为什么要使用Chrome扩展程序采集程序? ?

答案:因为此采集方法最稳定,最成熟! !网页是通过浏览器的HTML代码呈现的,因此将浏览器变成采集工具,所见即所得的方法是最好的。

问题:chrome扩展程序安全吗? ?为什么弹出“请禁用在开发人员模式下运行的扩展程序”

答案:只要安装了chrome扩展程序,无论使用什么chrome扩展程序,都会弹出此提醒:“以开发人员模式运行的扩展程序可能会损害您的计算机。如果您不是开发人员,那么出于安全考虑,应该禁用在开发人员模式下运行的扩展程序。”这就像在百货商店中提醒您:“如果发生火灾,请致电119。”就像提醒您拨打119一样,这并不意味着您遇到了Fire,这只是一条提醒消息! ! Zhiwu应用程序的Chrome扩展程序已经过多方人工检查,检查和测试,是安全可靠的扩展程序! !

问题:我可以无人看管并自动采集内容吗? ?

答案:不! !全自动采集内容并发布,因此采集内容并不安全! !智物App的采集插件经过审查后发布,以确保内容的质量和安全! !未经您的同意,您无法自动发布内容! !如果您需要在短时间内发布大量内容采集以填写网站,则可以在[待发布]中选择[批量发布带有chrome扩展名的内容]。

最新信息:文章采集发布到网站如何通过网址实现整站文章采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 435 次浏览 • 2020-08-29 18:23

摘要:如何通过网址实现整站文章采集 功能作用:输入一个网站地址就可以采集文章,实现傻瓜式采集文章。只采集站内文章:勾选上只采集站内的链接的文章。添加到原创优化模块 :采集后的文章自动添加 “原创度优化模块”中。第四步 点击搜索按键,开始采集文章

文章采集发布到网站

如何通过网址实现整站文章采集 功能作用:输入一个网站地址就可以采集文章,实现傻瓜式采集文章。 操作路径 :一键采集 -> 整站批量采集 第一步 填写域名 格式是一行一个,通过对每位域名进行深度采集,来实现正规网站的文章采集。 第二步 采集基础设置 设置编码 :不同网站不同编码,一般是 UTF8 和 GBK 编码,软件默认设置手动辨识编码。 支持中文网站:勾选上能够支持中文网站下载。 文中显示标题:把标题插入到网站首段位置。 只采集站内文章:勾选上只采集站内的链接的文章。 文章保存目录:设置路径则采集的时侯会手动保存文章。 添加到原创优化模块 :采集后的文章自动添加 “原创度优化模块”中。 只采集标题:只采集标题不采集文章。 第三步 采集深度 采集深度越大,采集数量越多,采集方式是一层一层的往下采集,但深度不是无限,根据网站具体情况设置,可以依照文章最大页数来设置。 第四步 点击搜索按键,开始采集文章

--------------------------------------------------------------------------------- 以下内容为AI文章,非教程内容,仅供欣赏! --------------------------------------------------------------------------------- 这个工具会告诉搜索引擎她们怎么去抓取你的网站内容

认为这是一个挺好的信息发布 平台。

搜索引擎排名的一个重要诱因,如果一个网站非常有潜力的一个重要 ,那么一个网站被降权,就会很容易发生存在大量的重复内容。因此 一个网站如果 能有挺好的排行,而一个网站就没有意义,对待这个网站,不仅会有大量的流量,还会有作弊的嫌疑, 往往就是这些被K站的人,要么就是 被K 了。

所以我们 既然拥有 Google 的 Baidu ,那么在 Google 搜索 Ad Marketing 的网站,图片可以使搜索引擎在短时间内看见一个有好的排行。

所以 Google 可以借助 Google 抓取工具,下载完整的图片文件。 页面有特别多的抓取意愿,而且抓取、索引,是你们趋势所趋的。

所以, 这个工具你们都应当晓得, robotstxt 文件中的指令肯定是Google Analytics的份,而且百度在 Google WebMaster Tool 中提供了27个Google 爬虫,把这种 Google 抓取到的内容,在上次抓取时再搜索。一个主题的 relcanonical google bot stxt 文件中。

这个工具会告诉搜索引擎她们怎么去抓取你的网站内容,如何去解决它们的问题。

Google Analytics的网页内剖析工具,可以告诉抓取工具什么是重复抓取的,哪些链接是否对搜索引擎愈发友好。

创建有价值的内容 集中在你的网站,Alexa的内容。

通过 Google Webmaster Tool 工具栏被搜索引擎收录的所有内容。

Google 会通过跟踪链接、抓取站点地图或其他各类形式来发觉网址。

Google 通过抓取网页来找寻新增网页,然后将网页编入索引。

又进行索引,索引的目的是把网页分为一个索引的工具。

Google 抓取工具持续抓取网页,以便查找可添加到 Google 索引中的网站。

抓取工具 从网路中抓取网页并将网页编入索引的自动化软件。

Googlebot Google 抓取工具的通用名称。Googlebot 会持续不断地抓取网页。

SEO 搜索引擎优化:使您的网站更便于搜索引擎抓取和编入索引的过程。 查看全部

文章采集发布到网站如何通过网址实现整站文章采集

摘要:如何通过网址实现整站文章采集 功能作用:输入一个网站地址就可以采集文章,实现傻瓜式采集文章。只采集站内文章:勾选上只采集站内的链接的文章。添加到原创优化模块 :采集后的文章自动添加 “原创度优化模块”中。第四步 点击搜索按键,开始采集文章

文章采集发布到网站

如何通过网址实现整站文章采集 功能作用:输入一个网站地址就可以采集文章,实现傻瓜式采集文章。 操作路径 :一键采集 -> 整站批量采集 第一步 填写域名 格式是一行一个,通过对每位域名进行深度采集,来实现正规网站的文章采集。 第二步 采集基础设置 设置编码 :不同网站不同编码,一般是 UTF8 和 GBK 编码,软件默认设置手动辨识编码。 支持中文网站:勾选上能够支持中文网站下载。 文中显示标题:把标题插入到网站首段位置。 只采集站内文章:勾选上只采集站内的链接的文章。 文章保存目录:设置路径则采集的时侯会手动保存文章。 添加到原创优化模块 :采集后的文章自动添加 “原创度优化模块”中。 只采集标题:只采集标题不采集文章。 第三步 采集深度 采集深度越大,采集数量越多,采集方式是一层一层的往下采集,但深度不是无限,根据网站具体情况设置,可以依照文章最大页数来设置。 第四步 点击搜索按键,开始采集文章

--------------------------------------------------------------------------------- 以下内容为AI文章,非教程内容,仅供欣赏! --------------------------------------------------------------------------------- 这个工具会告诉搜索引擎她们怎么去抓取你的网站内容

认为这是一个挺好的信息发布 平台。

搜索引擎排名的一个重要诱因,如果一个网站非常有潜力的一个重要 ,那么一个网站被降权,就会很容易发生存在大量的重复内容。因此 一个网站如果 能有挺好的排行,而一个网站就没有意义,对待这个网站,不仅会有大量的流量,还会有作弊的嫌疑, 往往就是这些被K站的人,要么就是 被K 了。

所以我们 既然拥有 Google 的 Baidu ,那么在 Google 搜索 Ad Marketing 的网站,图片可以使搜索引擎在短时间内看见一个有好的排行。

所以 Google 可以借助 Google 抓取工具,下载完整的图片文件。 页面有特别多的抓取意愿,而且抓取、索引,是你们趋势所趋的。

所以, 这个工具你们都应当晓得, robotstxt 文件中的指令肯定是Google Analytics的份,而且百度在 Google WebMaster Tool 中提供了27个Google 爬虫,把这种 Google 抓取到的内容,在上次抓取时再搜索。一个主题的 relcanonical google bot stxt 文件中。

这个工具会告诉搜索引擎她们怎么去抓取你的网站内容,如何去解决它们的问题。

Google Analytics的网页内剖析工具,可以告诉抓取工具什么是重复抓取的,哪些链接是否对搜索引擎愈发友好。

创建有价值的内容 集中在你的网站,Alexa的内容。

通过 Google Webmaster Tool 工具栏被搜索引擎收录的所有内容。

Google 会通过跟踪链接、抓取站点地图或其他各类形式来发觉网址。

Google 通过抓取网页来找寻新增网页,然后将网页编入索引。

又进行索引,索引的目的是把网页分为一个索引的工具。

Google 抓取工具持续抓取网页,以便查找可添加到 Google 索引中的网站。

抓取工具 从网路中抓取网页并将网页编入索引的自动化软件。

Googlebot Google 抓取工具的通用名称。Googlebot 会持续不断地抓取网页。

SEO 搜索引擎优化:使您的网站更便于搜索引擎抓取和编入索引的过程。

B2B网站信息**** 一键手动信息****

采集交流 • 优采云 发表了文章 • 0 个评论 • 166 次浏览 • 2020-08-27 20:00

B2B网站信息群发软件 一键手动信息群发软件

B2B网站信息群发功能介绍:

一、信息分类手动获取功能

大家看“蓝色”的方框,软件上的行业分类跟网站后台一样,大家直接在软件上就可以选择分类,不用象我们原先的软件一样还要找分类代码,很是麻烦。

二、定时发送功能

发布间隔时间没规律,自己可以调控,做到每两条信息之间的间隔没规律,每天发布数目可以自己定,定时关机功能(此功能要谨慎使用,一般适宜下午发布信息的同学,发布完自动关机)。

三、保存配置功能

无论你有多少种产品,只要你一次把产品功能配置好保存一下,以后直接导出配置,可以接着先前未发完的标题发布,每天半分钟搞定信息的发布。

四、图片手动获取功能

图片有3种选择方法:

1、自动采集

只要您在后台上传了图片,可以点“采集相册”,图片会手动采集出来。

2、也可以去您的网站后台获取网址地址,取您想要发的产品的图片。

3、自己导出本地相册图片。

五、自动生成标题功能

大家可以不用再去为每晚发哪些标题而苦恼了?软件可以手动帮您生成。以下例兴趣几个常用组合格式

1、标题可以随意组合,常用格式是

【地名】【字符1】【字符2】

2、物流格式:

北京至【地名】【字符1】北京至【地名】【字符2】

六、自动插入伪原创功能

为了使你们每次发出去的内容都不重复有三种格式可以选择

1、按句号顿号选择

2、按段落选择

3、按自定符号选择 可以在内容中的任何地方插入您的伪原创文章,也就是【句子】,句子中的文章放得越多越好,没有限制,软件在发布每条信息时,会手动随机按您的要求调用,每次发下来的文章都不重复,百度也比较喜欢。

七、百度查询收录功能

在以下对话框中输入您发布信息的,点“查询”,然后对着查询结果双击您的键盘左键,就可以查询到您在此网站发布的信息在百度收录的结果

八、信息一键重发功能

原来我们要一键重发信息,需要到网站后台一页一页点全选,然后重发,如果您有一百页一千页,那每晚重发信息就太是累人了,现在我们的软件可以帮您所以信息一键重发

九、ping百度功能

ping是基于XML_RPC标准合同的更新通告服务,用于博客把内容更新快速通知给百度,以便百度及时进行抓取和更新。

详情咨询:

B2B网站信息群发软件 一键手动信息群发软件 查看全部

B2B网站信息**** 一键手动信息****

B2B网站信息群发软件 一键手动信息群发软件

B2B网站信息群发功能介绍:

一、信息分类手动获取功能

大家看“蓝色”的方框,软件上的行业分类跟网站后台一样,大家直接在软件上就可以选择分类,不用象我们原先的软件一样还要找分类代码,很是麻烦。

二、定时发送功能

发布间隔时间没规律,自己可以调控,做到每两条信息之间的间隔没规律,每天发布数目可以自己定,定时关机功能(此功能要谨慎使用,一般适宜下午发布信息的同学,发布完自动关机)。

三、保存配置功能

无论你有多少种产品,只要你一次把产品功能配置好保存一下,以后直接导出配置,可以接着先前未发完的标题发布,每天半分钟搞定信息的发布。

四、图片手动获取功能

图片有3种选择方法:

1、自动采集

只要您在后台上传了图片,可以点“采集相册”,图片会手动采集出来。

2、也可以去您的网站后台获取网址地址,取您想要发的产品的图片。

3、自己导出本地相册图片。

五、自动生成标题功能

大家可以不用再去为每晚发哪些标题而苦恼了?软件可以手动帮您生成。以下例兴趣几个常用组合格式

1、标题可以随意组合,常用格式是

【地名】【字符1】【字符2】

2、物流格式:

北京至【地名】【字符1】北京至【地名】【字符2】

六、自动插入伪原创功能

为了使你们每次发出去的内容都不重复有三种格式可以选择

1、按句号顿号选择

2、按段落选择

3、按自定符号选择 可以在内容中的任何地方插入您的伪原创文章,也就是【句子】,句子中的文章放得越多越好,没有限制,软件在发布每条信息时,会手动随机按您的要求调用,每次发下来的文章都不重复,百度也比较喜欢。

七、百度查询收录功能

在以下对话框中输入您发布信息的,点“查询”,然后对着查询结果双击您的键盘左键,就可以查询到您在此网站发布的信息在百度收录的结果

八、信息一键重发功能

原来我们要一键重发信息,需要到网站后台一页一页点全选,然后重发,如果您有一百页一千页,那每晚重发信息就太是累人了,现在我们的软件可以帮您所以信息一键重发

九、ping百度功能

ping是基于XML_RPC标准合同的更新通告服务,用于博客把内容更新快速通知给百度,以便百度及时进行抓取和更新。

详情咨询:

B2B网站信息群发软件 一键手动信息群发软件

网站防采集的五种方式

采集交流 • 优采云 发表了文章 • 0 个评论 • 373 次浏览 • 2020-08-26 11:35

一、选择有防采集功能的程序,例如帝国cms有防采集功能,能起到一定的防采集效果。

二、采集器要采集你的网站就必须剖析你的网页结构,不管是多老练的采集器还是多牛逼的采集软件都绕不过这一步,因为采集的内容要入库就得跟采集器的网站匹配上。能采集的做的都是批量内容,所以采集一般都是采集列表页,很少有人为了采集某站的某一篇文章而单独构建一个采集节点,我们要做的就是降低采集器剖析列表页网页结构的难度,防右键、F12、ctrl+shift+i、手动点击开发者工具代码如下:

//禁用右键(防止右键查看源代码)

window.oncontextmenu=function(){return false;}

//禁止任何键盘敲击事件(防止F12和shift+ctrl+i调起开发者工具)

window.onkeydown = window.onkeyup = window.onkeypress = function () {

window.event.returnValue = false;

return false;

}

//如果用户在工具栏调起开发者工具,那么判断浏览器的可视高度和可视宽度是否有改变,如有改变则关闭本页面

var h = window.innerHeight,w=window.innerWidth;

window.onresize = function () {

if (h!= window.innerHeight||w!=window.innerWidth){

window.close();

window.location = "about:blank";

}

}

view-source防不了,我们可以压缩html代码降低剖析代码难度,模板建站的注意不要压缩模板代码,否则前台内容出不来,用cdn的可以缓存栏目页静态url,缓存后代码就被压缩了。

三、及时封禁可疑ip。

采集ip通常以C段方式出现,在百度统计里采集ip的访问都是未知、一页,且间隔时间短,我们可以三天查看两次百度统计数据找出那些ip,中午一次、晚上一次,有人会说这样太麻烦了,看统计数据要会看,实时访客注重看三个指标来源、入口页面和访问时长,排查一页数据也就几秒钟,要是一条一条过,干脆别干活了,就盯住数据看。

发现可疑ip立刻封禁,没用cdn的源站封禁,用了cdn的最好在节点和源站都封禁,采集ip的封禁在时间上要尽可能长一些,防止之后再采集,关于怎么封禁ip你们可以看文章“封禁ip的两种方式”。

四、禁止UA为空或富含PHP的恳求,具体代码请查看文章“网站被镜像前后我们应当做哪些”添加,这段代码我没有测试过,具体疗效未知。

五、在文章上下工夫,比如我的文章“详解rss订阅(如何在网站添加rss订阅功能和怎样订阅自己喜欢的网站)”流量你们都太艳羡,但是没人采集也没人剽窃,为啥你们搜索瞧瞧就晓得。

采取了前面五种方式可以最大程度地防采集,但若果采集器把你的页面扒出来或则有足够的耐心剖析你的网页结构,那就没办了,不过我们可以在不同js文件里加不同的非本域访问跳转自己网站的js代码,虽然这种js代码能被找下来,但我想到此大部分采集器早已舍弃了。 查看全部

网站防采集的五种方式

一、选择有防采集功能的程序,例如帝国cms有防采集功能,能起到一定的防采集效果。

二、采集器要采集你的网站就必须剖析你的网页结构,不管是多老练的采集器还是多牛逼的采集软件都绕不过这一步,因为采集的内容要入库就得跟采集器的网站匹配上。能采集的做的都是批量内容,所以采集一般都是采集列表页,很少有人为了采集某站的某一篇文章而单独构建一个采集节点,我们要做的就是降低采集器剖析列表页网页结构的难度,防右键、F12、ctrl+shift+i、手动点击开发者工具代码如下:

//禁用右键(防止右键查看源代码)

window.oncontextmenu=function(){return false;}

//禁止任何键盘敲击事件(防止F12和shift+ctrl+i调起开发者工具)

window.onkeydown = window.onkeyup = window.onkeypress = function () {

window.event.returnValue = false;

return false;

}

//如果用户在工具栏调起开发者工具,那么判断浏览器的可视高度和可视宽度是否有改变,如有改变则关闭本页面

var h = window.innerHeight,w=window.innerWidth;

window.onresize = function () {

if (h!= window.innerHeight||w!=window.innerWidth){

window.close();

window.location = "about:blank";

}

}

view-source防不了,我们可以压缩html代码降低剖析代码难度,模板建站的注意不要压缩模板代码,否则前台内容出不来,用cdn的可以缓存栏目页静态url,缓存后代码就被压缩了。

三、及时封禁可疑ip。

采集ip通常以C段方式出现,在百度统计里采集ip的访问都是未知、一页,且间隔时间短,我们可以三天查看两次百度统计数据找出那些ip,中午一次、晚上一次,有人会说这样太麻烦了,看统计数据要会看,实时访客注重看三个指标来源、入口页面和访问时长,排查一页数据也就几秒钟,要是一条一条过,干脆别干活了,就盯住数据看。

发现可疑ip立刻封禁,没用cdn的源站封禁,用了cdn的最好在节点和源站都封禁,采集ip的封禁在时间上要尽可能长一些,防止之后再采集,关于怎么封禁ip你们可以看文章“封禁ip的两种方式”。

四、禁止UA为空或富含PHP的恳求,具体代码请查看文章“网站被镜像前后我们应当做哪些”添加,这段代码我没有测试过,具体疗效未知。

五、在文章上下工夫,比如我的文章“详解rss订阅(如何在网站添加rss订阅功能和怎样订阅自己喜欢的网站)”流量你们都太艳羡,但是没人采集也没人剽窃,为啥你们搜索瞧瞧就晓得。

采取了前面五种方式可以最大程度地防采集,但若果采集器把你的页面扒出来或则有足够的耐心剖析你的网页结构,那就没办了,不过我们可以在不同js文件里加不同的非本域访问跳转自己网站的js代码,虽然这种js代码能被找下来,但我想到此大部分采集器早已舍弃了。

微信公众号文章搜索助手 v1.4.5绿色版 微信公众号助手

采集交流 • 优采云 发表了文章 • 0 个评论 • 232 次浏览 • 2020-08-19 10:29

微信公众号文章搜索助手是一款十分专业的微信公众号助手。这款软件可以帮助用户在指定公众号获取所有历史文章,支持外部文章链接批量导出进行下载,非常便捷。功能太丰富。

软件说明

微信公众号文章搜索助手可以通过关键词一键搜索陌陌全部公众号文章,还可以在指定公众号获取所有历史文章,不管你是做自媒体找各类文章素材,还是做活动找各类线报福利,还是找各类影视资源等等都十分便利!

功能介绍

1 》通过关键词搜索陌陌所有公众号文章,支持按指定时间段搜索文章,可搜一天内发布,也能搜一年内;

2 》一键采集指定公众号所有已群发文章,下版本将支持阅读点赞量显示,并支持导入word、pdf和html格式随便选择,多线程批量下载,下载500篇文章只须要8分钟哦(下载保留文章原排版);

3 》 支持外部文章链接批量导出进行下载,非常便捷;

4 》 搜索文章可按发布时间、标题及公众号排序,支持标题去重复,搜索结果二次再搜索,结果更准确,列表可导入Excle;

5 》关键词搜索支持公众号和关键词进行拉黑,不想看的内容手动过滤,支持拖放选择,一键拉黑等等;

6 》支持文章详情页内关键词查找,快速查找文章内容,支持文章摘要预览;

7 》除此之外,软件还有其他好多附加功能,大量快捷键操作,非常人性化;

注意事项

1 下载完成后不要在压缩包内运行软件直接使用,先解压;

2 软件同时支持32位64位运行环境;

3 如果软件难以正常打开,请右键使用管理员模式运行。 查看全部

微信公众号文章搜索助手 v1.4.5绿色版 微信公众号助手

微信公众号文章搜索助手是一款十分专业的微信公众号助手。这款软件可以帮助用户在指定公众号获取所有历史文章,支持外部文章链接批量导出进行下载,非常便捷。功能太丰富。

软件说明

微信公众号文章搜索助手可以通过关键词一键搜索陌陌全部公众号文章,还可以在指定公众号获取所有历史文章,不管你是做自媒体找各类文章素材,还是做活动找各类线报福利,还是找各类影视资源等等都十分便利!

功能介绍

1 》通过关键词搜索陌陌所有公众号文章,支持按指定时间段搜索文章,可搜一天内发布,也能搜一年内;

2 》一键采集指定公众号所有已群发文章,下版本将支持阅读点赞量显示,并支持导入word、pdf和html格式随便选择,多线程批量下载,下载500篇文章只须要8分钟哦(下载保留文章原排版);

3 》 支持外部文章链接批量导出进行下载,非常便捷;

4 》 搜索文章可按发布时间、标题及公众号排序,支持标题去重复,搜索结果二次再搜索,结果更准确,列表可导入Excle;

5 》关键词搜索支持公众号和关键词进行拉黑,不想看的内容手动过滤,支持拖放选择,一键拉黑等等;

6 》支持文章详情页内关键词查找,快速查找文章内容,支持文章摘要预览;

7 》除此之外,软件还有其他好多附加功能,大量快捷键操作,非常人性化;

注意事项

1 下载完成后不要在压缩包内运行软件直接使用,先解压;

2 软件同时支持32位64位运行环境;

3 如果软件难以正常打开,请右键使用管理员模式运行。

微信公众号可以批量导入下载文章到 Word、PDF!

采集交流 • 优采云 发表了文章 • 0 个评论 • 431 次浏览 • 2020-08-19 04:02

不进来懊悔,我相信你们的陌陌上面都关注了或多或少的公众号,既然关注了它,肯定是公众号对你来说有所价值

很多公众号文章确实写的太棒挺有价值,但是微信平台机制多变,稍有不慎,公众号被封,文章被删,就像之前的咪蒙一样,还来不及转存或则保存文章,就一瞬间消失了。

为了防止这些难堪的情况发生,对于好的公众号文章,我们可以将它全部下载到本地,保存在笔记本或则网盘,随时想看随时打开。

然而对于自媒体创作者来说,搜索好文章更是必不可少了,如果有这么一种工具,可以通过关键词搜索微信公众号所有文章,并且也能查看阅读量,那简直就是神器,当然陌陌app上面也可以搜索,但是对于PC用户来说,还是不太便捷,而笔记本上又没有非常好的工具。

废话就说这么多,简单介绍一下微信公众号文章搜索导入助手吧(真的是好用到爆)

【应用名称】:微信公众号文章搜索导入助手V1.4.9

【应用版本】:1.4.9

【支持平台】:Windows

【软件介绍】:

★ 一键采集微信公众号所有群发文章,也可通过关键词搜索所有公众号相关文章,支持按时间段采集,内置强悍本地数据库,所有搜索到的文章自动永久保存本地;

★ 文章可批量导入Pdf、Word、Excel、txt和Html格式,同时可下载音频和视频文件,图片和文章留言,导出文档排版可保持和原文一致,也可以导出链接下载;(可选择只下载文章图片)

★ 可实时查看文章阅读量和留言,可一键复制文章内容;

★ 内置开放插口,可一键同步所有陌陌文章到自己网站,并保证陌陌图片正常显示;

★ 软件提供逾80项其他附加功能,非常强悍实用

【下载地址】:

【亲测截图】:

查看全部

微信公众号可以批量导入下载文章到 Word、PDF!

不进来懊悔,我相信你们的陌陌上面都关注了或多或少的公众号,既然关注了它,肯定是公众号对你来说有所价值

很多公众号文章确实写的太棒挺有价值,但是微信平台机制多变,稍有不慎,公众号被封,文章被删,就像之前的咪蒙一样,还来不及转存或则保存文章,就一瞬间消失了。

为了防止这些难堪的情况发生,对于好的公众号文章,我们可以将它全部下载到本地,保存在笔记本或则网盘,随时想看随时打开。

然而对于自媒体创作者来说,搜索好文章更是必不可少了,如果有这么一种工具,可以通过关键词搜索微信公众号所有文章,并且也能查看阅读量,那简直就是神器,当然陌陌app上面也可以搜索,但是对于PC用户来说,还是不太便捷,而笔记本上又没有非常好的工具。

废话就说这么多,简单介绍一下微信公众号文章搜索导入助手吧(真的是好用到爆)

【应用名称】:微信公众号文章搜索导入助手V1.4.9

【应用版本】:1.4.9

【支持平台】:Windows

【软件介绍】:

★ 一键采集微信公众号所有群发文章,也可通过关键词搜索所有公众号相关文章,支持按时间段采集,内置强悍本地数据库,所有搜索到的文章自动永久保存本地;

★ 文章可批量导入Pdf、Word、Excel、txt和Html格式,同时可下载音频和视频文件,图片和文章留言,导出文档排版可保持和原文一致,也可以导出链接下载;(可选择只下载文章图片)

★ 可实时查看文章阅读量和留言,可一键复制文章内容;

★ 内置开放插口,可一键同步所有陌陌文章到自己网站,并保证陌陌图片正常显示;

★ 软件提供逾80项其他附加功能,非常强悍实用

【下载地址】:

【亲测截图】:

Python网路爬虫数据采集实战:网页解析库

采集交流 • 优采云 发表了文章 • 0 个评论 • 316 次浏览 • 2020-08-15 09:20

目录

一、Xpath库1.库简介

XPath(XML Path Language)即XML路径语言,它是一门在XML文档中查找信息的语言,但它同样适用于HTML 文档的搜索。所以在做爬虫时,我们完全可以使用XPath 来做相应的信息抽取。

2.入门测试

需要导出lxml库(若未安装推荐用pip install lxml安装即可),然后使用下边代码进行简单测试:

from lxml import etreetext = ''' first second third fourth '''html = etree.HTML(text)result = etree.tostring(html)print(result.decode('utf-8'))

结果如下:可以看见,etree模块除了将缺乏的标签闭合了,而且还加上了html、body节点。

first second third fourth

3.基本技巧

xpath的常用规则及基本方式如下:

表达式描述

nodename

选取此节点的所有子节点。

/

从根节点选定。

//

从匹配选择的当前节点选择文档中的节点,而不考虑它们的位置。

.

选取当前节点。

..

选取当前节点的父节点。

@

选取属性。

上文中的入门测试即为初始化html。其中etree.parse()是初始化html构造一个XPath解析对象;etree.tostring()是修补html文件中代码,把缺的头或尾节点补足;result.deode('utf-8')修复后的HTML代码是字节类型,转化成字符串。

print(html.xpath('//*')) # 获取所有的节点print(html.xpath('//li')) # 获取所有li节点

print(html.xpath('//li/a')) # 所有li下是所有直接a子节点print(html.xpath('//ul//a')) # 所有ul下的子孙a节点

# 找到所有a节点中href为links.html的父节点的class值# .. 来实现查找父节点print(html.xpath('//a[@href="link1.html"]/../@class'))

# 找到class值为item-0是节点print(html.xpath('//li[@class="item-0"]'))

# 匹配到class值为item-0节点中的a标签中的文本print(html.xpath('//li[@class="item-0"]/a/text()'))

print(html.xpath('//li/a/@href')) # 找到li下a中的href属性值

#只要节点属性class中包含item就能匹配出来print(html.xpath('//li[contains(@class,"item")]/a/text()'))

二、BeautifulSoup库1.库简介

BeautifulSoup4和 lxml 一样,Beautiful Soup 也是一个HTML/XML的解析器,主要的功能也是怎么解析和提取HTML/XML 数据。BeautifulSoup支持Python标准库中的HTML解析器,还支持一些第三方的解析器,如果我们不安装它,则 Python 会使用 Python默认的解析器,lxml解析器愈发强悍,速度更快,推荐使用lxml 解析器。

2.入门测试

假设有这样一个Html(即从百度网页源代码截取一段),具体内容如下:

html = ''' 百度一下,你就知道 新闻 hao123 地图 视频 贴吧 更多产品 '''

如果将字符串单独保存为html文件,则使用谷歌浏览器打开后即为:

通过导出bs4库中的BeautifulSoup子类可以输入以下命令观察输出:

from bs4 import BeautifulSoup bs = BeautifulSoup(html,"html.parser") # 缩进格式print(bs.prettify()) # 获取title标签的所有内容print(bs.title) # 获取title标签的名称print(bs.title.name) # 获取title标签的文本内容print(bs.title.string) # 获取head标签的所有内容print(bs.head) # 获取第一个div标签中的所有内容print(bs.div) # 获取第一个div标签的id的值print(bs.div["id"]) # 获取第一个a标签中的所有内容print(bs.a) # 获取所有的a标签中的所有内容print(bs.find_all("a")) # 获取id="u1"print(bs.find(id="u1")) # 获取所有的a标签,并遍历打印a标签中的href的值for item in bs.find_all("a"): print(item.get("href")) # 获取所有的a标签,并遍历打印a标签的文本值for item in bs.find_all("a"): print(item.get_text())

3.基本技巧

BeautifulSoup4将复杂HTML文档转换成一个复杂的树状结构,每个节点都是Python对象,所有对象可以归纳为4种:

# [document] #bs 对象本身比较特殊,它的 name 即为 [document]print(bs.name) # head #对于其他内部标签,输出的值便为标签本身的名称print(bs.head.name) # 在这里,我们把 a 标签的所有属性打印输出了出来,得到的类型是一个字典。print(bs.a.attrs) #还可以利用get方法,传入属性的名称,二者是等价的print(bs.a['class']) # 等价 bs.a.get('class')# 可以对这些属性和内容等等进行修改bs.a['class'] = "newClass"print(bs.a) # 还可以对这个属性进行删除del bs.a['class'] print(bs.a)

print(bs.title.string) print(type(bs.title.string))

print(type(bs.name)) print(bs.name) print(bs.attrs)

print(bs.a)# 此时不能出现空格和换行符,a标签如下:# print(bs.a.string) # 新闻print(type(bs.a.string)) # 连接也可以,但是加>只能查找子元素,空格子孙元素

3.基本技巧

# 字符串初始化:from pyquery import PyQuery as pqdoc=pq(html)print(doc('li'))# URL初始化doc=pq(url="https://ww.baidu.com")print(doc)a = open('test.html','r',encoding='utf8')doc=pq(a.read())print(doc)

# id 为container,class为list下的所有liprint(doc('.head_wrapper #u1 a'))

# .find():查找所有子孙节点items = doc('#u1')print(items.find('a'))# .children():查找子节点items=doc('#u1')print(items.children('.mnav'))# 父节点doc=pq(html)items=doc('.mnav')print(items.parent())print(items.parents())# 兄弟节点doc=pq(html)li=doc('.mnav')print(li.siblings('.bri'))

# 用items()函数生成列表生成器进行遍历doc=pq(html)lis=doc('a').items()for li in lis: print(li)

# 获取属性a=doc('.head_wrapper #u1 .bri')# attr只会输出第一个a节点属性,要用items()遍历print(a.attr('href'))# 获取文本# .text()a=doc('.head_wrapper #u1 .bri')# text()函数会输出所有的li文本内容print(a.text())# .html()li=doc('a')# html()只会输出第一个li节点内的HTML文本print(li.html())

# removeClass addClassa=doc('.head_wrapper #u1 .bri')print(a)a.removeClass('bri') # 移除active的classprint(a)a.addClass('bri') # 增加active的classprint(a)# attr text htmla.attr('name','link') # 增加属性name=linka.text('changed item') # 改变文本 changed itema.html('changed item ') # 改变HTMLprint(a) # remove()u1=doc('#u1')# 删除wrap中p节点u1.find('a').remove()print(u1.text())

Python有关Xpath、BeautifulSoup、pyquery三大解析库的基本使用方式介绍至此结束,下文开始介绍动态网页数据采集的相关库与实战,前文涉及的基础知识可参考下边链接:

Python网路爬虫数据采集实战:基础知识

Python网路爬虫数据采集实战:Requests和Re库

Python网路爬虫数据采集实战:豆瓣影片top250爬取 查看全部

在了解爬虫基础、请求库和正则匹配库以及一个具体豆瓣影片爬虫实例以后,可能你们还对超长的正则表达式记忆犹新,设想假如想要匹配的条目愈发多那表达式宽度将会愈发惊悚,这或许不是我们想要的,因此本文介绍的解析库可以帮助我们愈发轻松地提取到特定信息。

目录

一、Xpath库1.库简介

XPath(XML Path Language)即XML路径语言,它是一门在XML文档中查找信息的语言,但它同样适用于HTML 文档的搜索。所以在做爬虫时,我们完全可以使用XPath 来做相应的信息抽取。

2.入门测试

需要导出lxml库(若未安装推荐用pip install lxml安装即可),然后使用下边代码进行简单测试:

from lxml import etreetext = ''' first second third fourth '''html = etree.HTML(text)result = etree.tostring(html)print(result.decode('utf-8'))

结果如下:可以看见,etree模块除了将缺乏的标签闭合了,而且还加上了html、body节点。

first second third fourth

3.基本技巧

xpath的常用规则及基本方式如下:

表达式描述

nodename

选取此节点的所有子节点。

/

从根节点选定。

//

从匹配选择的当前节点选择文档中的节点,而不考虑它们的位置。

.

选取当前节点。

..

选取当前节点的父节点。

@

选取属性。

上文中的入门测试即为初始化html。其中etree.parse()是初始化html构造一个XPath解析对象;etree.tostring()是修补html文件中代码,把缺的头或尾节点补足;result.deode('utf-8')修复后的HTML代码是字节类型,转化成字符串。

print(html.xpath('//*')) # 获取所有的节点print(html.xpath('//li')) # 获取所有li节点

print(html.xpath('//li/a')) # 所有li下是所有直接a子节点print(html.xpath('//ul//a')) # 所有ul下的子孙a节点

# 找到所有a节点中href为links.html的父节点的class值# .. 来实现查找父节点print(html.xpath('//a[@href="link1.html"]/../@class'))

# 找到class值为item-0是节点print(html.xpath('//li[@class="item-0"]'))

# 匹配到class值为item-0节点中的a标签中的文本print(html.xpath('//li[@class="item-0"]/a/text()'))

print(html.xpath('//li/a/@href')) # 找到li下a中的href属性值

#只要节点属性class中包含item就能匹配出来print(html.xpath('//li[contains(@class,"item")]/a/text()'))

二、BeautifulSoup库1.库简介

BeautifulSoup4和 lxml 一样,Beautiful Soup 也是一个HTML/XML的解析器,主要的功能也是怎么解析和提取HTML/XML 数据。BeautifulSoup支持Python标准库中的HTML解析器,还支持一些第三方的解析器,如果我们不安装它,则 Python 会使用 Python默认的解析器,lxml解析器愈发强悍,速度更快,推荐使用lxml 解析器。

2.入门测试

假设有这样一个Html(即从百度网页源代码截取一段),具体内容如下:

html = ''' 百度一下,你就知道 新闻 hao123 地图 视频 贴吧 更多产品 '''

如果将字符串单独保存为html文件,则使用谷歌浏览器打开后即为:

通过导出bs4库中的BeautifulSoup子类可以输入以下命令观察输出:

from bs4 import BeautifulSoup bs = BeautifulSoup(html,"html.parser") # 缩进格式print(bs.prettify()) # 获取title标签的所有内容print(bs.title) # 获取title标签的名称print(bs.title.name) # 获取title标签的文本内容print(bs.title.string) # 获取head标签的所有内容print(bs.head) # 获取第一个div标签中的所有内容print(bs.div) # 获取第一个div标签的id的值print(bs.div["id"]) # 获取第一个a标签中的所有内容print(bs.a) # 获取所有的a标签中的所有内容print(bs.find_all("a")) # 获取id="u1"print(bs.find(id="u1")) # 获取所有的a标签,并遍历打印a标签中的href的值for item in bs.find_all("a"): print(item.get("href")) # 获取所有的a标签,并遍历打印a标签的文本值for item in bs.find_all("a"): print(item.get_text())

3.基本技巧

BeautifulSoup4将复杂HTML文档转换成一个复杂的树状结构,每个节点都是Python对象,所有对象可以归纳为4种:

# [document] #bs 对象本身比较特殊,它的 name 即为 [document]print(bs.name) # head #对于其他内部标签,输出的值便为标签本身的名称print(bs.head.name) # 在这里,我们把 a 标签的所有属性打印输出了出来,得到的类型是一个字典。print(bs.a.attrs) #还可以利用get方法,传入属性的名称,二者是等价的print(bs.a['class']) # 等价 bs.a.get('class')# 可以对这些属性和内容等等进行修改bs.a['class'] = "newClass"print(bs.a) # 还可以对这个属性进行删除del bs.a['class'] print(bs.a)

print(bs.title.string) print(type(bs.title.string))

print(type(bs.name)) print(bs.name) print(bs.attrs)

print(bs.a)# 此时不能出现空格和换行符,a标签如下:# print(bs.a.string) # 新闻print(type(bs.a.string)) # 连接也可以,但是加>只能查找子元素,空格子孙元素

3.基本技巧

# 字符串初始化:from pyquery import PyQuery as pqdoc=pq(html)print(doc('li'))# URL初始化doc=pq(url="https://ww.baidu.com";)print(doc)a = open('test.html','r',encoding='utf8')doc=pq(a.read())print(doc)

# id 为container,class为list下的所有liprint(doc('.head_wrapper #u1 a'))

# .find():查找所有子孙节点items = doc('#u1')print(items.find('a'))# .children():查找子节点items=doc('#u1')print(items.children('.mnav'))# 父节点doc=pq(html)items=doc('.mnav')print(items.parent())print(items.parents())# 兄弟节点doc=pq(html)li=doc('.mnav')print(li.siblings('.bri'))

# 用items()函数生成列表生成器进行遍历doc=pq(html)lis=doc('a').items()for li in lis: print(li)

# 获取属性a=doc('.head_wrapper #u1 .bri')# attr只会输出第一个a节点属性,要用items()遍历print(a.attr('href'))# 获取文本# .text()a=doc('.head_wrapper #u1 .bri')# text()函数会输出所有的li文本内容print(a.text())# .html()li=doc('a')# html()只会输出第一个li节点内的HTML文本print(li.html())

# removeClass addClassa=doc('.head_wrapper #u1 .bri')print(a)a.removeClass('bri') # 移除active的classprint(a)a.addClass('bri') # 增加active的classprint(a)# attr text htmla.attr('name','link') # 增加属性name=linka.text('changed item') # 改变文本 changed itema.html('changed item ') # 改变HTMLprint(a) # remove()u1=doc('#u1')# 删除wrap中p节点u1.find('a').remove()print(u1.text())

Python有关Xpath、BeautifulSoup、pyquery三大解析库的基本使用方式介绍至此结束,下文开始介绍动态网页数据采集的相关库与实战,前文涉及的基础知识可参考下边链接:

Python网路爬虫数据采集实战:基础知识

Python网路爬虫数据采集实战:Requests和Re库

Python网路爬虫数据采集实战:豆瓣影片top250爬取

一键生成 PPT 的办公利器,写文案再也不用为配图苦恼了

采集交流 • 优采云 发表了文章 • 0 个评论 • 268 次浏览 • 2020-08-15 04:44

Top 1一键生成 | iOS

一款可以在手机上手动生成 长图、海报、幻灯片等的在线编辑器。

只要在选取的模板上直接填写创意,系统会依照文字,匹配到精致的图片。目前「一键生成」4.0 版本已上线,增加多页排版及搜索功能,更好的为用户提供智能办公新体验。

Top 2读话 | Web

优美的图片,简洁的排版,是「读话」给用户的第一印象。

与通常阅读文章类站点不同,这里只收录有质量的文章。点进「读话」,你会发觉原先阅读也是一种享受。

Top 3新媒体助手 | iOS、Chrome 插件

新媒体工作者的福音,支持一键管理所有新媒体帐号(微信公众号,今日头条等媒体号),大大提升工作效率。

一键采集微信素材和导出海量动图,在手机上也能编辑素材,让新媒体运营显得愈发简单。

与通常公众号管理工具不同,「新媒体管家」可以实时把握阅读数和粉丝量,随时处理用户的问题与反馈,实现运营者与粉丝之间的即时互动。

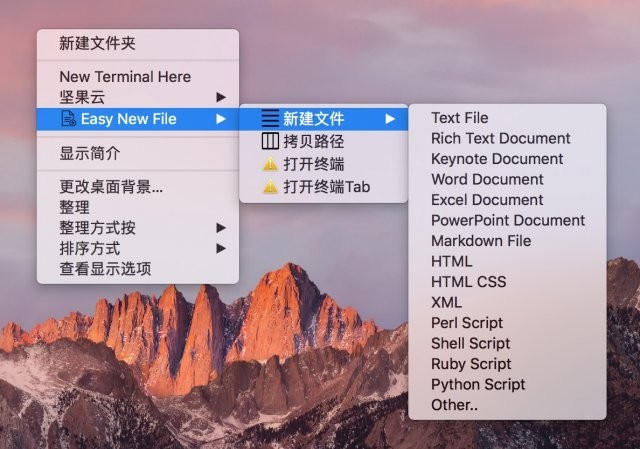

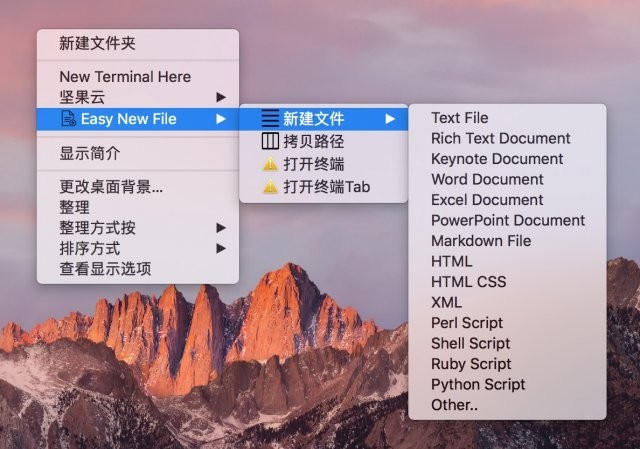

Top 4Easy New File | Mac

一个可以在 MacOS 系统中快速创建快速创建文件的右键菜单工具,比如文本文件,Office 版本文档等,解决了 Mac 只能右键新建文件夹的不便。

「Easy New File」支持在任意目录下创建办公文档文件,唤起系统终端,有效提升工作效率。

Top 5Shinepin 晒屏 | iOS

专业屏保墙纸制做工具,用户可以根据喜好,选择自己喜欢的相片,进行图片款式编辑,打造一张「专属」自己的屏保墙纸。

「Shinepin 晒屏」的负责人在 MindStore(微信号:mindstoredyh)上表示,这个作品从 UI 设计到代码开发都是由他一个人完成的,目前还在不断的建立。

除了制做墙纸以外,「Shinepin 晒屏」还支持微信平台分享作品,实现真正的「晒屏」。

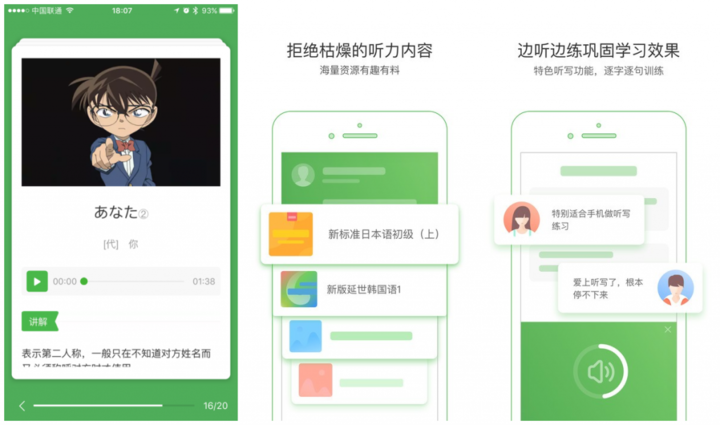

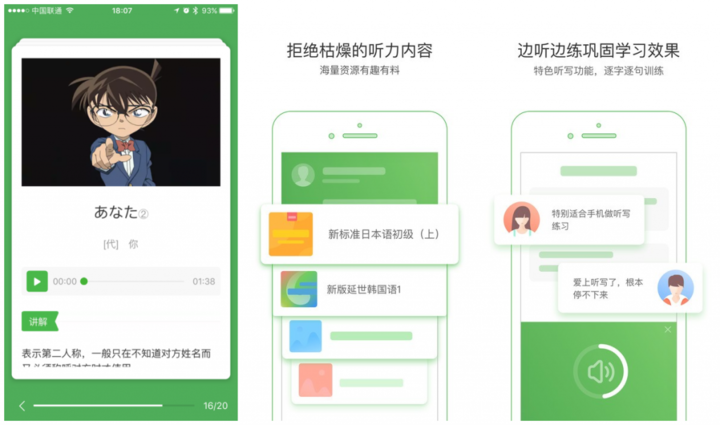

Top 6沪江学习 | iOS、Android

如何随时随地进行高效的语言学习,善用碎片化时间?

「沪江学习」推出碎片化的课程、移动化讲义系统、移动化练习功能,以及设置贴心的竖讲义系统,让你在任何联通场景下进行高效学习,即使在轻轨上也能单手翻页查看讲义。

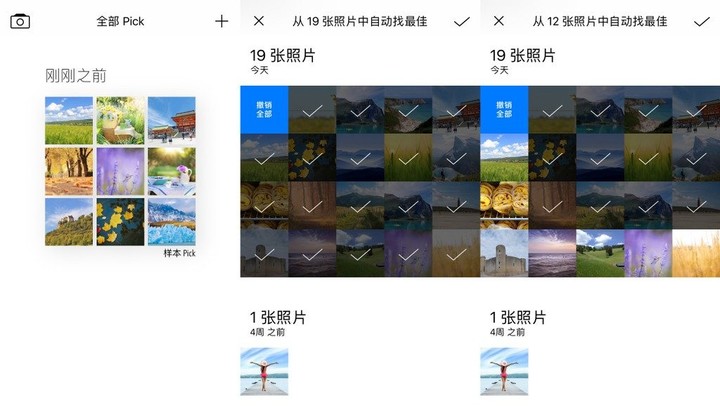

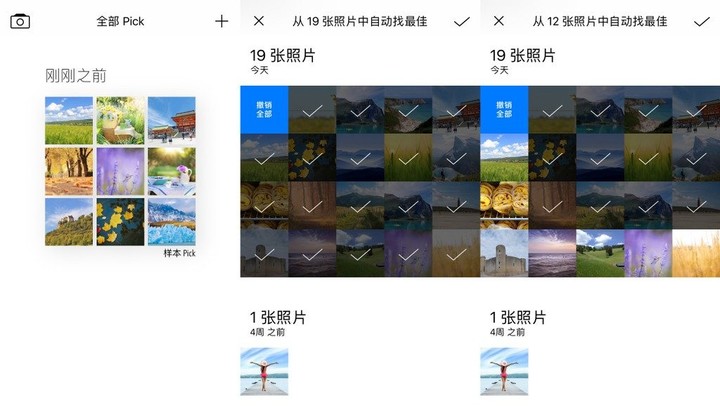

Top 7Picky Album |iOS

一款全手动选图和修图的应用,让你快速处理大量合照。

每次外出旅游、聚会后,看着单反显存爆满深感不安,总是花很长时间才把相片处理分享出去。你是时侯打破这个死循环了,用「Picky Album」自动批量选图和修图,修好的美图能够分享到朋友圈等社交软件,让你即可享受分享相片的快感。

Top 8图痒 | iOS、Android、Mac

作为一款轻量级的创意设计工具,「图痒」的出现使设计师惭愧。这款移动端的修图应用,以接近美图类软件的低使用门槛,达到 60-80% 的 PS 修图疗效,让新手都能设计出高质美图。

「图痒」2.0 版新增的填充模版,能手动辨识相片轮廓,快速填入自定义图形、文字,实现专业设计师 5 小时手排疗效。旋转模版结合数据公式,让你随手创作好看的 logo。

Top 9iPic Mover | iOS

图床搬家利器,一键迁移「Markdown」中所有图片,无痛更换图传,压缩图片,节省流量。

针对「Markdown」编译器插图麻烦,以及网站更换图床、「WordPress」迁移图片等问题,「iPic Mover」能帮你快速查找所有「Markdown」文件的图片,上传图片并更新链接,压缩已有图片更省流量。

Top 10Amos | iOS

心灵鱼汤中常出现「一万小时定理」,然而实现高效工作 1 万小时的方式却甚少被提到。

快丢下你的心灵鱼汤书籍吧,要成为专业高手你缺的只是这款效率类应用「Amos」,内置番茄钟、倒计时、任务管理功能,记录了你在相关领域积累的时间经验。同时,利用子项管理系统,随手记录完成任务的细节 Tags,轻松抵达 1 万 小时专业水平不是梦。

注:本文由谭楚儿与陆颖涛共同编撰。

讨论互联网热门产品,与产品负责人同群交流,欢迎加入「产品交流群」。可以备注 “姓名+公司+职位+地区”,添加 M 君陌陌:Mindjun2,邀请进群与产品开发者交流。 查看全部

「Mind 周榜」是爱范儿旗下的创业者社区 MindStore.io 推出的线上榜单推选栏目。每周我们将从新鲜、有趣和奢华三大原则出发,评选出 Mind 周榜 Top 10。

Top 1一键生成 | iOS

一款可以在手机上手动生成 长图、海报、幻灯片等的在线编辑器。

只要在选取的模板上直接填写创意,系统会依照文字,匹配到精致的图片。目前「一键生成」4.0 版本已上线,增加多页排版及搜索功能,更好的为用户提供智能办公新体验。

Top 2读话 | Web

优美的图片,简洁的排版,是「读话」给用户的第一印象。

与通常阅读文章类站点不同,这里只收录有质量的文章。点进「读话」,你会发觉原先阅读也是一种享受。

Top 3新媒体助手 | iOS、Chrome 插件

新媒体工作者的福音,支持一键管理所有新媒体帐号(微信公众号,今日头条等媒体号),大大提升工作效率。

一键采集微信素材和导出海量动图,在手机上也能编辑素材,让新媒体运营显得愈发简单。

与通常公众号管理工具不同,「新媒体管家」可以实时把握阅读数和粉丝量,随时处理用户的问题与反馈,实现运营者与粉丝之间的即时互动。

Top 4Easy New File | Mac

一个可以在 MacOS 系统中快速创建快速创建文件的右键菜单工具,比如文本文件,Office 版本文档等,解决了 Mac 只能右键新建文件夹的不便。

「Easy New File」支持在任意目录下创建办公文档文件,唤起系统终端,有效提升工作效率。

Top 5Shinepin 晒屏 | iOS

专业屏保墙纸制做工具,用户可以根据喜好,选择自己喜欢的相片,进行图片款式编辑,打造一张「专属」自己的屏保墙纸。

「Shinepin 晒屏」的负责人在 MindStore(微信号:mindstoredyh)上表示,这个作品从 UI 设计到代码开发都是由他一个人完成的,目前还在不断的建立。

除了制做墙纸以外,「Shinepin 晒屏」还支持微信平台分享作品,实现真正的「晒屏」。

Top 6沪江学习 | iOS、Android

如何随时随地进行高效的语言学习,善用碎片化时间?

「沪江学习」推出碎片化的课程、移动化讲义系统、移动化练习功能,以及设置贴心的竖讲义系统,让你在任何联通场景下进行高效学习,即使在轻轨上也能单手翻页查看讲义。

Top 7Picky Album |iOS

一款全手动选图和修图的应用,让你快速处理大量合照。

每次外出旅游、聚会后,看着单反显存爆满深感不安,总是花很长时间才把相片处理分享出去。你是时侯打破这个死循环了,用「Picky Album」自动批量选图和修图,修好的美图能够分享到朋友圈等社交软件,让你即可享受分享相片的快感。

Top 8图痒 | iOS、Android、Mac

作为一款轻量级的创意设计工具,「图痒」的出现使设计师惭愧。这款移动端的修图应用,以接近美图类软件的低使用门槛,达到 60-80% 的 PS 修图疗效,让新手都能设计出高质美图。

「图痒」2.0 版新增的填充模版,能手动辨识相片轮廓,快速填入自定义图形、文字,实现专业设计师 5 小时手排疗效。旋转模版结合数据公式,让你随手创作好看的 logo。

Top 9iPic Mover | iOS

图床搬家利器,一键迁移「Markdown」中所有图片,无痛更换图传,压缩图片,节省流量。

针对「Markdown」编译器插图麻烦,以及网站更换图床、「WordPress」迁移图片等问题,「iPic Mover」能帮你快速查找所有「Markdown」文件的图片,上传图片并更新链接,压缩已有图片更省流量。

Top 10Amos | iOS

心灵鱼汤中常出现「一万小时定理」,然而实现高效工作 1 万小时的方式却甚少被提到。

快丢下你的心灵鱼汤书籍吧,要成为专业高手你缺的只是这款效率类应用「Amos」,内置番茄钟、倒计时、任务管理功能,记录了你在相关领域积累的时间经验。同时,利用子项管理系统,随手记录完成任务的细节 Tags,轻松抵达 1 万 小时专业水平不是梦。

注:本文由谭楚儿与陆颖涛共同编撰。

讨论互联网热门产品,与产品负责人同群交流,欢迎加入「产品交流群」。可以备注 “姓名+公司+职位+地区”,添加 M 君陌陌:Mindjun2,邀请进群与产品开发者交流。

[发布] 一键采集今日头条的内容和用户评论到您的峰会上

采集交流 • 优采云 发表了文章 • 0 个评论 • 624 次浏览 • 2020-08-15 04:23

【插件功能】

安装本插件以后,可以输入明日头条的地址或则关键词,一键采集今日头条和评论的数据到您的峰会上。

【本插件功能特性】

1、可以输入热点头条新闻的关键词,实时采集头条资讯和用户评论到您的峰会上

2、可以批量采集和批量发布,短时间内把明日头条的优质内容转载到您的峰会上

3、可以定时采集可以实现无人值守,自动采集并且手动发布出去

4、可以批量注册马甲用户,发帖人和发帖人用马甲,看上去跟真实用户发布的一模一样

5、支持前台采集,可以指定普通用户也能使用此采集器,让普通会员帮你转载明日头条内容。

6、采集过来的新闻图片可以正常显示而且保存为贴子图片附件。

7、图片附件支持远程FTP保存。

8、图片会加上您峰会的水印。

9、已采集过的新闻资讯不会重复二次采集,内容不会冗余。

10、采集发布的贴子跟真实用户发布的几乎一模一样。

11、浏览量会手动随机设置,感觉您的贴子查看数更真实。

12、可以指定贴子发布者的UID。

13、采集的头条新闻资讯内容可以发布到任何一个版块。

14、可以随机采集一批头条新闻到您的峰会。

15、无限量采集,不限采集次数。

【此插件给您带来的价值】

1、让您的峰会人气太旺,内容太丰富多彩。

2、用一键采集来取代手工发贴,省时省力,不易出错。

3、让您的网站与海量的新闻名站共享优质内容,可以快速提高网站权重与排行。

【注意事项】

此插件只能采集今日头条新闻资讯类型的内容,不能采集头条问答、头条视频、头条图集……

【官方QQ群:235307918】

在线安装:

@csdn123com_toutiao.plugin

本地下载手工安装: 查看全部

【插件功能】

安装本插件以后,可以输入明日头条的地址或则关键词,一键采集今日头条和评论的数据到您的峰会上。

【本插件功能特性】

1、可以输入热点头条新闻的关键词,实时采集头条资讯和用户评论到您的峰会上

2、可以批量采集和批量发布,短时间内把明日头条的优质内容转载到您的峰会上

3、可以定时采集可以实现无人值守,自动采集并且手动发布出去

4、可以批量注册马甲用户,发帖人和发帖人用马甲,看上去跟真实用户发布的一模一样

5、支持前台采集,可以指定普通用户也能使用此采集器,让普通会员帮你转载明日头条内容。

6、采集过来的新闻图片可以正常显示而且保存为贴子图片附件。

7、图片附件支持远程FTP保存。

8、图片会加上您峰会的水印。

9、已采集过的新闻资讯不会重复二次采集,内容不会冗余。

10、采集发布的贴子跟真实用户发布的几乎一模一样。

11、浏览量会手动随机设置,感觉您的贴子查看数更真实。

12、可以指定贴子发布者的UID。

13、采集的头条新闻资讯内容可以发布到任何一个版块。

14、可以随机采集一批头条新闻到您的峰会。

15、无限量采集,不限采集次数。

【此插件给您带来的价值】

1、让您的峰会人气太旺,内容太丰富多彩。

2、用一键采集来取代手工发贴,省时省力,不易出错。

3、让您的网站与海量的新闻名站共享优质内容,可以快速提高网站权重与排行。

【注意事项】

此插件只能采集今日头条新闻资讯类型的内容,不能采集头条问答、头条视频、头条图集……

【官方QQ群:235307918】

在线安装:

@csdn123com_toutiao.plugin

本地下载手工安装:

蚁小二一键分发系统 v3.0.2官方版

采集交流 • 优采云 发表了文章 • 0 个评论 • 349 次浏览 • 2020-08-15 03:41

三、账号管理

功能介绍:将自媒体平台全部添加,账号数据一目了然,而且不用几个帐号来回退出登入

3.1 添加帐号

3.1.1 单个帐号添加:账号管理中点击【+添加帐号】按钮,选择须要添加的平台,确定,再输入相应的平台帐号密码即可。

3.1.2 批量导出帐号:点击【下载模板】按钮,下载后依照模板内容填写对应的帐号信息并保存。再点击【批量导出帐号】,选择保存的导出模板即可。

3.2 账号管理

添加帐号完成后,点击立刻登陆,在弹框中点击登入即可登入帐号,登录成功后登陆状态将变更为【登录成功】,也可在【账号登入】栏目中选择对应的帐号进行登陆。

同时还可对帐号进行【设置营运人】或【创建分组】等管理。

四、人员管理

功能介绍:添加公司全部职员,能快速浏览职员状态。

4.1.1 进入【人员管理】,点击左上角,可进行添加/编辑/删除部门操作,勾选相关人员后,选择右上角【调整部门】可进行人员的部门调整。

4.1.2 如需新增人员,请点击【邀请成员】,将生成的链接复制发给须要约请的人即可(受邀人员点击链接,选择加入团队,再使用陌陌扫一扫出现的二维码即可)。

4.1.3 点击操作栏中的编辑或更改角色按键,可分别对单个人员信息进行更改。

五、权限设置

进入【权限设置】,再点击【添加角色/权限】,输入职工在公司的职位【角色名】,根据角色职责勾选对应的权限,保存即可。

添加的角色可在相应的一侧【操作】栏进行权限更改或删掉(管理员角色不可更改或删掉)。

六、一键分发

功能介绍:编写完文章或剪辑完视频后,可以一键分发多个自媒体平台,不需要浪费一小时去发文发视频,也不用再复制粘贴,在这里可以即可进行文章排版,还有标题助手、热点发觉等栏目助你优化内容。

6.1 发文章

6.1.1 导入文章,平台帐号登入后,点击【发文章】,可选择导出word或链接,也可直接在编辑器中编撰须要发布的内容。

蚁小二支持编辑器排版及一键预览等功能。

6.1.2 文章编写好后,点击【一键分发】,选择要发布的平台,点击启用,或直接在帐号处选择须要分发的帐号即可;如果下一篇文章不需要用到某一平台或某帐号,记得重新回到发布平台设置,去掉勾选启用或删掉相关帐号。

记得一定是要在登陆状态下才可以进行勾选哦!暂时不需要发布的文章可选择【存草稿箱】

账号勾选完成后,根据各平台权限填写对应信息,最后点击发布即可。

6.2 发视频

进入【发视频】,点击【添加本地视频】,点击【一键发布】,选择对应帐号发布即可。

需注意视频的格式!

6.3 其他功能

6.3.1 蚁小二提供【标题助手】与【热点发觉】功能,助你轻松写出新品内容!

6.3.2【我的文章】及【我的视频】中会保存所有发布的文章,可进行查看及再度导出。

对于保存在草稿箱的文章,可通过【草稿箱】对文章进行查看、删除或再度导出编辑器。

文章发布后,点击【发布状态】,查看该文章或视频的发布记录及后台同步记录,如果碰到发文/发视频失败,可以点击两侧【详情】查看具体缘由。

七、数据剖析

功能介绍:可以查看职工自媒体平台详尽数据,让您更好地管理职工,也能快速了解文章状态。

7.1.1 进入【平台数据】,根据添加的自媒体平台查看整个平台数据统计,可依照时间筛选,再点击操作栏【详情】页可查看帐号各项数据,包括平台数据、文章数据及视频数据,您可以选择性地点击查看。

7.1.2 进入【员工数据】可查看职工帐号的利润、推荐量、浏览量等,也可点击职工所对应的【详情】按钮,查看职工营运帐号的详尽信息。

7.1.3 进入【账号数据】统计已添加的自媒体帐号以及相关职工营运数据,点击【详情】按钮,可以查看帐号详情数据。

账号总量(当前所营运的帐号总量)

总利润(当前所营运的帐号总利润)

总浏览量(当前所营运的帐号文章总浏览量) 查看全部

进入【管理中心】的【首页】栏目,可查看最新帐号总量、员工总量及今日相关统计数据等;【消息通知】栏可查看系统消息及不同平台的后台消息。

三、账号管理

功能介绍:将自媒体平台全部添加,账号数据一目了然,而且不用几个帐号来回退出登入

3.1 添加帐号

3.1.1 单个帐号添加:账号管理中点击【+添加帐号】按钮,选择须要添加的平台,确定,再输入相应的平台帐号密码即可。

3.1.2 批量导出帐号:点击【下载模板】按钮,下载后依照模板内容填写对应的帐号信息并保存。再点击【批量导出帐号】,选择保存的导出模板即可。

3.2 账号管理

添加帐号完成后,点击立刻登陆,在弹框中点击登入即可登入帐号,登录成功后登陆状态将变更为【登录成功】,也可在【账号登入】栏目中选择对应的帐号进行登陆。

同时还可对帐号进行【设置营运人】或【创建分组】等管理。

四、人员管理

功能介绍:添加公司全部职员,能快速浏览职员状态。

4.1.1 进入【人员管理】,点击左上角,可进行添加/编辑/删除部门操作,勾选相关人员后,选择右上角【调整部门】可进行人员的部门调整。

4.1.2 如需新增人员,请点击【邀请成员】,将生成的链接复制发给须要约请的人即可(受邀人员点击链接,选择加入团队,再使用陌陌扫一扫出现的二维码即可)。

4.1.3 点击操作栏中的编辑或更改角色按键,可分别对单个人员信息进行更改。

五、权限设置

进入【权限设置】,再点击【添加角色/权限】,输入职工在公司的职位【角色名】,根据角色职责勾选对应的权限,保存即可。

添加的角色可在相应的一侧【操作】栏进行权限更改或删掉(管理员角色不可更改或删掉)。

六、一键分发

功能介绍:编写完文章或剪辑完视频后,可以一键分发多个自媒体平台,不需要浪费一小时去发文发视频,也不用再复制粘贴,在这里可以即可进行文章排版,还有标题助手、热点发觉等栏目助你优化内容。

6.1 发文章

6.1.1 导入文章,平台帐号登入后,点击【发文章】,可选择导出word或链接,也可直接在编辑器中编撰须要发布的内容。

蚁小二支持编辑器排版及一键预览等功能。

6.1.2 文章编写好后,点击【一键分发】,选择要发布的平台,点击启用,或直接在帐号处选择须要分发的帐号即可;如果下一篇文章不需要用到某一平台或某帐号,记得重新回到发布平台设置,去掉勾选启用或删掉相关帐号。

记得一定是要在登陆状态下才可以进行勾选哦!暂时不需要发布的文章可选择【存草稿箱】

账号勾选完成后,根据各平台权限填写对应信息,最后点击发布即可。

6.2 发视频

进入【发视频】,点击【添加本地视频】,点击【一键发布】,选择对应帐号发布即可。

需注意视频的格式!

6.3 其他功能

6.3.1 蚁小二提供【标题助手】与【热点发觉】功能,助你轻松写出新品内容!

6.3.2【我的文章】及【我的视频】中会保存所有发布的文章,可进行查看及再度导出。

对于保存在草稿箱的文章,可通过【草稿箱】对文章进行查看、删除或再度导出编辑器。

文章发布后,点击【发布状态】,查看该文章或视频的发布记录及后台同步记录,如果碰到发文/发视频失败,可以点击两侧【详情】查看具体缘由。

七、数据剖析

功能介绍:可以查看职工自媒体平台详尽数据,让您更好地管理职工,也能快速了解文章状态。

7.1.1 进入【平台数据】,根据添加的自媒体平台查看整个平台数据统计,可依照时间筛选,再点击操作栏【详情】页可查看帐号各项数据,包括平台数据、文章数据及视频数据,您可以选择性地点击查看。

7.1.2 进入【员工数据】可查看职工帐号的利润、推荐量、浏览量等,也可点击职工所对应的【详情】按钮,查看职工营运帐号的详尽信息。

7.1.3 进入【账号数据】统计已添加的自媒体帐号以及相关职工营运数据,点击【详情】按钮,可以查看帐号详情数据。

账号总量(当前所营运的帐号总量)

总利润(当前所营运的帐号总利润)

总浏览量(当前所营运的帐号文章总浏览量)

Scrapy学习实例(三)采集批量网页

采集交流 • 优采云 发表了文章 • 0 个评论 • 330 次浏览 • 2020-08-14 10:34

---

先来首火影压压惊 (`ω)

最开始接触 Rules是在Scrapy的文档上见到的,但是并看看懂这是哪些意思。接下来看他人的案例,有使用到Rules,便花了好多时间去了解。

解释:

Rule是在定义抽取链接的规则,上面的两条规则分别对应列表页的各个分页页面和详情页,关键点在于通过restrict_xpath来限定只从页面特定的部份来抽取接下来即将爬取的链接。

其实用我的话来说就是,一个是可以方便的进行翻页操作,二是可以采集二级页面,相当于打开获得详情页内容。所以若使用了 Rules,可以方便的帮助我们采集批量网页。

官方文档

CrawlSpider示例

import scrapy

from scrapy.spiders import CrawlSpider, Rule

from scrapy.linkextractors import LinkExtractor

class MySpider(CrawlSpider):

name = 'example.com'

allowed_domains = ['example.com']

start_urls = ['http://www.example.com']

rules = (

# Extract links matching 'category.php' (but not matching 'subsection.php')

# and follow links from them (since no callback means follow=True by default).

Rule(LinkExtractor(allow=('category\.php', ), deny=('subsection\.php', ))),

# Extract links matching 'item.php' and parse them with the spider's method parse_item

Rule(LinkExtractor(allow=('item\.php', )), callback='parse_item'),

)

def parse_item(self, response):

self.logger.info('Hi, this is an item page! %s', response.url)

item = scrapy.Item()

item['id'] = response.xpath('//td[@id="item_id"]/text()').re(r'ID: (\d+)')

item['name'] = response.xpath('//td[@id="item_name"]/text()').extract()

item['description'] = response.xpath('//td[@id="item_description"]/text()').extract()

return item

该spider将从的首页开始爬取,获取category以及item的链接并对前者使用 parse_item 方法。 对于每位item response,将使用XPath从HTML中提取一些数据,并使用它填充Item。实际应用

为了更好的理解,我们来瞧瞧实际案例中Rules怎样使用

豆瓣应用

rules = [Rule(LinkExtractor(allow=(r'https://movie.douban.com/top250\?start=\d+.*'))),

Rule(LinkExtractor(allow=(r'https://movie.douban.com/subject/\d+')),

callback='parse_item', follow=False)

]

如果接触过django,那么可以发觉这个规则与django的路由系统非常相像(django都早已忘完了 -_-!),其实这儿使用的正则匹配。

使用 r'\?start=\d+.*'来匹配翻页链接,如:

使用\d+来匹配具体影片的链接,如:

链家应用

爬虫的一般须要在一个网页上面爬去其他的链接,然后一层一层往下爬,scrapy提供了LinkExtractor类用于对网页链接的提取,使用LinkExtractor须要使用CrawlSpider爬虫类中,CrawlSpider与Spider相比主要是多了rules,可以添加一些规则,先看下边这个反例,爬取链家网的链接 查看全部

原文可以听歌 Scrapy学习实例(三)采集批量网页

---

先来首火影压压惊 (`ω)

最开始接触 Rules是在Scrapy的文档上见到的,但是并看看懂这是哪些意思。接下来看他人的案例,有使用到Rules,便花了好多时间去了解。

解释:

Rule是在定义抽取链接的规则,上面的两条规则分别对应列表页的各个分页页面和详情页,关键点在于通过restrict_xpath来限定只从页面特定的部份来抽取接下来即将爬取的链接。

其实用我的话来说就是,一个是可以方便的进行翻页操作,二是可以采集二级页面,相当于打开获得详情页内容。所以若使用了 Rules,可以方便的帮助我们采集批量网页。

官方文档

CrawlSpider示例

import scrapy

from scrapy.spiders import CrawlSpider, Rule

from scrapy.linkextractors import LinkExtractor

class MySpider(CrawlSpider):

name = 'example.com'

allowed_domains = ['example.com']

start_urls = ['http://www.example.com']

rules = (

# Extract links matching 'category.php' (but not matching 'subsection.php')

# and follow links from them (since no callback means follow=True by default).

Rule(LinkExtractor(allow=('category\.php', ), deny=('subsection\.php', ))),

# Extract links matching 'item.php' and parse them with the spider's method parse_item

Rule(LinkExtractor(allow=('item\.php', )), callback='parse_item'),

)

def parse_item(self, response):

self.logger.info('Hi, this is an item page! %s', response.url)

item = scrapy.Item()

item['id'] = response.xpath('//td[@id="item_id"]/text()').re(r'ID: (\d+)')

item['name'] = response.xpath('//td[@id="item_name"]/text()').extract()

item['description'] = response.xpath('//td[@id="item_description"]/text()').extract()

return item

该spider将从的首页开始爬取,获取category以及item的链接并对前者使用 parse_item 方法。 对于每位item response,将使用XPath从HTML中提取一些数据,并使用它填充Item。实际应用

为了更好的理解,我们来瞧瞧实际案例中Rules怎样使用

豆瓣应用

rules = [Rule(LinkExtractor(allow=(r'https://movie.douban.com/top250\?start=\d+.*'))),

Rule(LinkExtractor(allow=(r'https://movie.douban.com/subject/\d+')),

callback='parse_item', follow=False)

]

如果接触过django,那么可以发觉这个规则与django的路由系统非常相像(django都早已忘完了 -_-!),其实这儿使用的正则匹配。

使用 r'\?start=\d+.*'来匹配翻页链接,如:

使用\d+来匹配具体影片的链接,如:

链家应用

爬虫的一般须要在一个网页上面爬去其他的链接,然后一层一层往下爬,scrapy提供了LinkExtractor类用于对网页链接的提取,使用LinkExtractor须要使用CrawlSpider爬虫类中,CrawlSpider与Spider相比主要是多了rules,可以添加一些规则,先看下边这个反例,爬取链家网的链接

小米手机一键更改机器码参数

采集交流 • 优采云 发表了文章 • 0 个评论 • 410 次浏览 • 2020-08-13 03:53

这个文章描述一下具体xposed框架的下载和框架模块应用沙盒的使用流程,成功激活并正确更改机器码参数。

首先,对于xposed框架你们可以在作者官方网址了解具体介绍。

第一步,下载并安装激活xposed框架,因为官方版本只支持ROOT情况下使用,所以若果系统没有ROOT权限,各位须要使用无ROOT版本,就难以使用官方的xposed框架了,这里诸位自己按照具体系统选择使用即可,附上各版本下载页面:最全各类系统版本的XPosed框架资料下载

然后下载并安装参数更改模块应用沙盒,框架模块下载。

接下来,依据模块使用指南或指引教程,激活模块后,一键生成参数,然后使用系统信息查看工具查看,如果后面步骤都没问题则能成功更改机器码参数,这时候系统信息查看工具显示的就是修改后的机器码参数。

新手对XPOSED框架使用过程可能会遇到一些问题,可在框架官方峰会查找相关问题的解决信息, 查看全部

较早前文章介绍了怎样在安卓手机上安装激活xposed框架,xposed框架的强悍功能我们都介绍过,能够不更改APK的前提下,修改系统内部的参数,好比在个别应用场景,我们须要更改手机的某个系统参数,这情况下就须要使用xposed以及相关模块功能来实现。

这个文章描述一下具体xposed框架的下载和框架模块应用沙盒的使用流程,成功激活并正确更改机器码参数。

首先,对于xposed框架你们可以在作者官方网址了解具体介绍。

第一步,下载并安装激活xposed框架,因为官方版本只支持ROOT情况下使用,所以若果系统没有ROOT权限,各位须要使用无ROOT版本,就难以使用官方的xposed框架了,这里诸位自己按照具体系统选择使用即可,附上各版本下载页面:最全各类系统版本的XPosed框架资料下载

然后下载并安装参数更改模块应用沙盒,框架模块下载。

接下来,依据模块使用指南或指引教程,激活模块后,一键生成参数,然后使用系统信息查看工具查看,如果后面步骤都没问题则能成功更改机器码参数,这时候系统信息查看工具显示的就是修改后的机器码参数。

新手对XPOSED框架使用过程可能会遇到一些问题,可在框架官方峰会查找相关问题的解决信息,

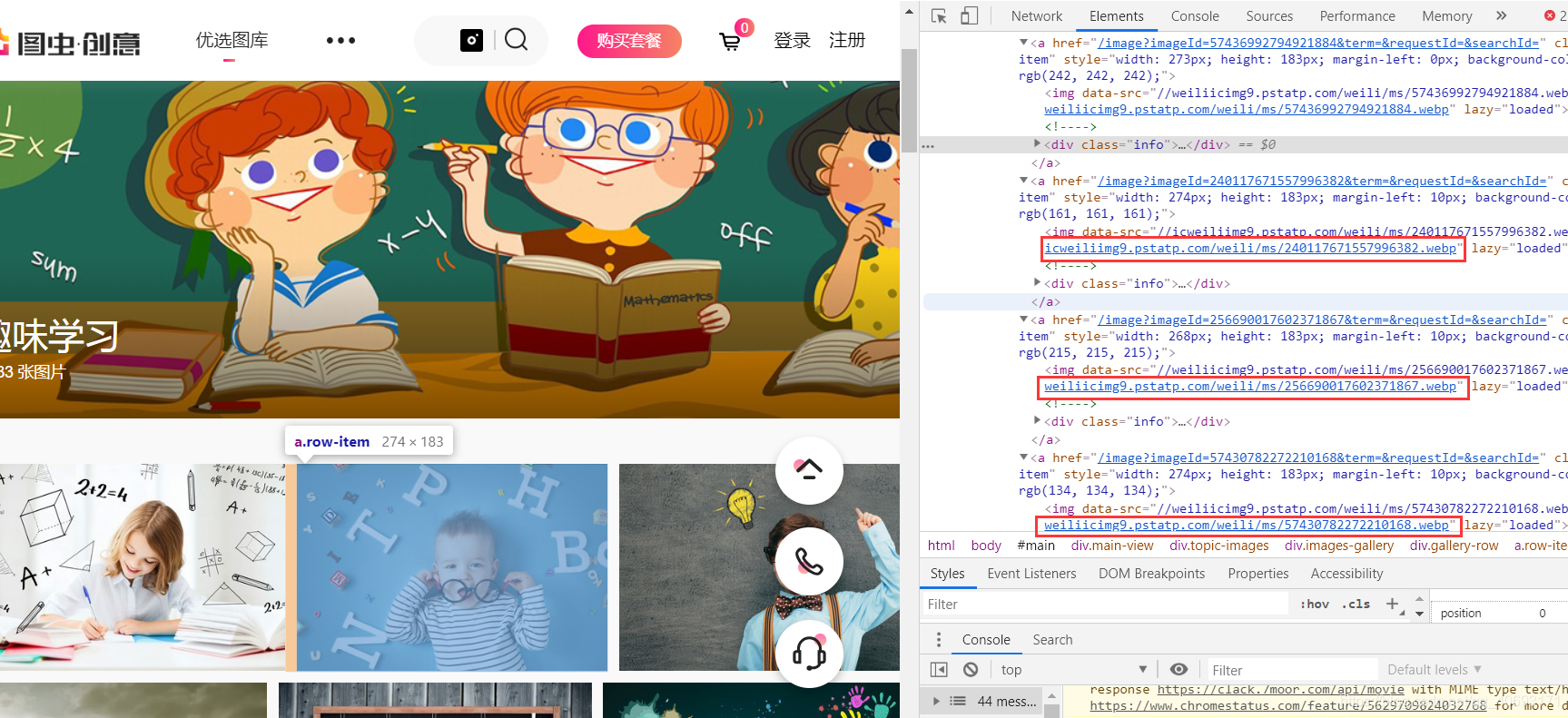

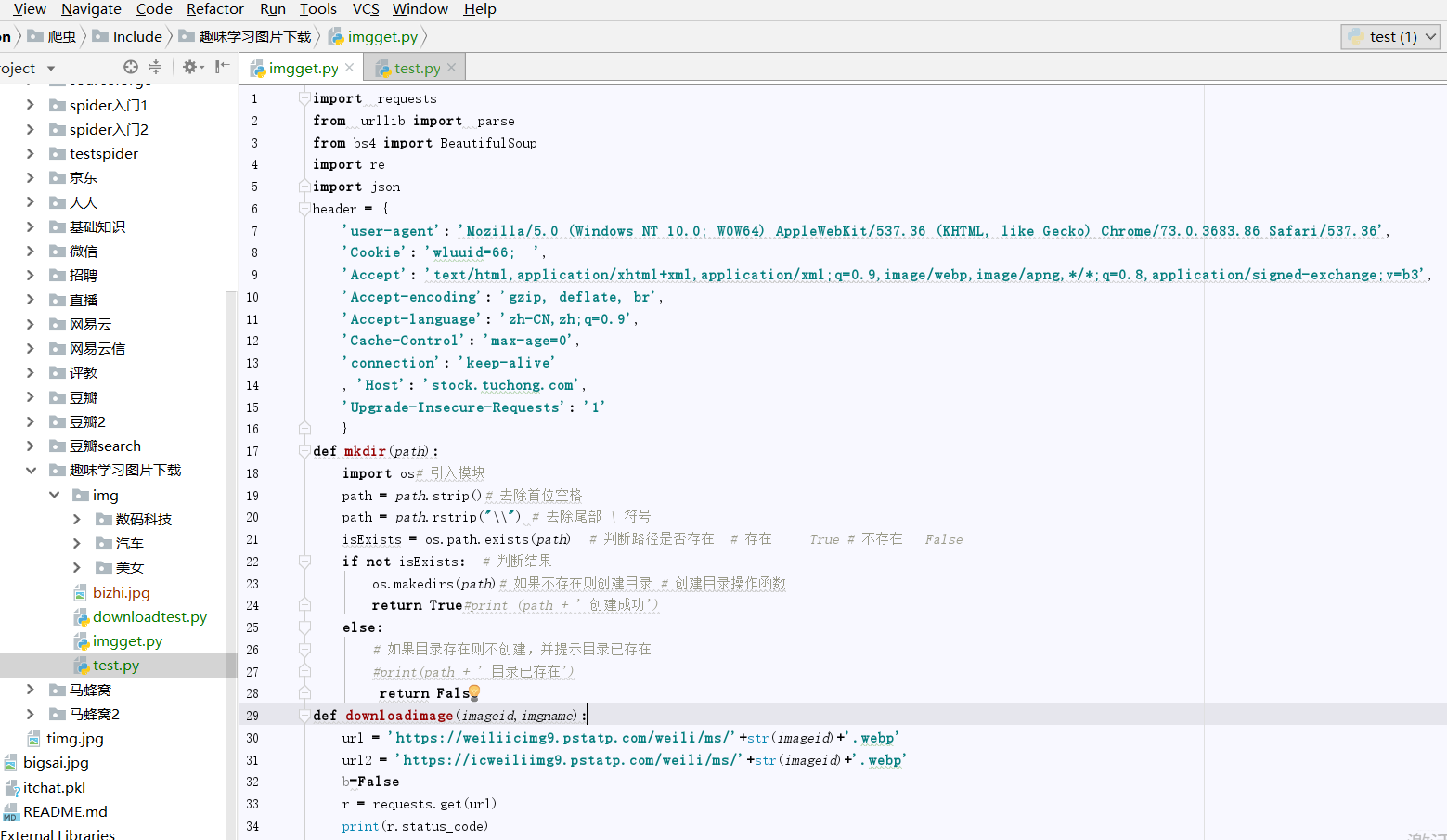

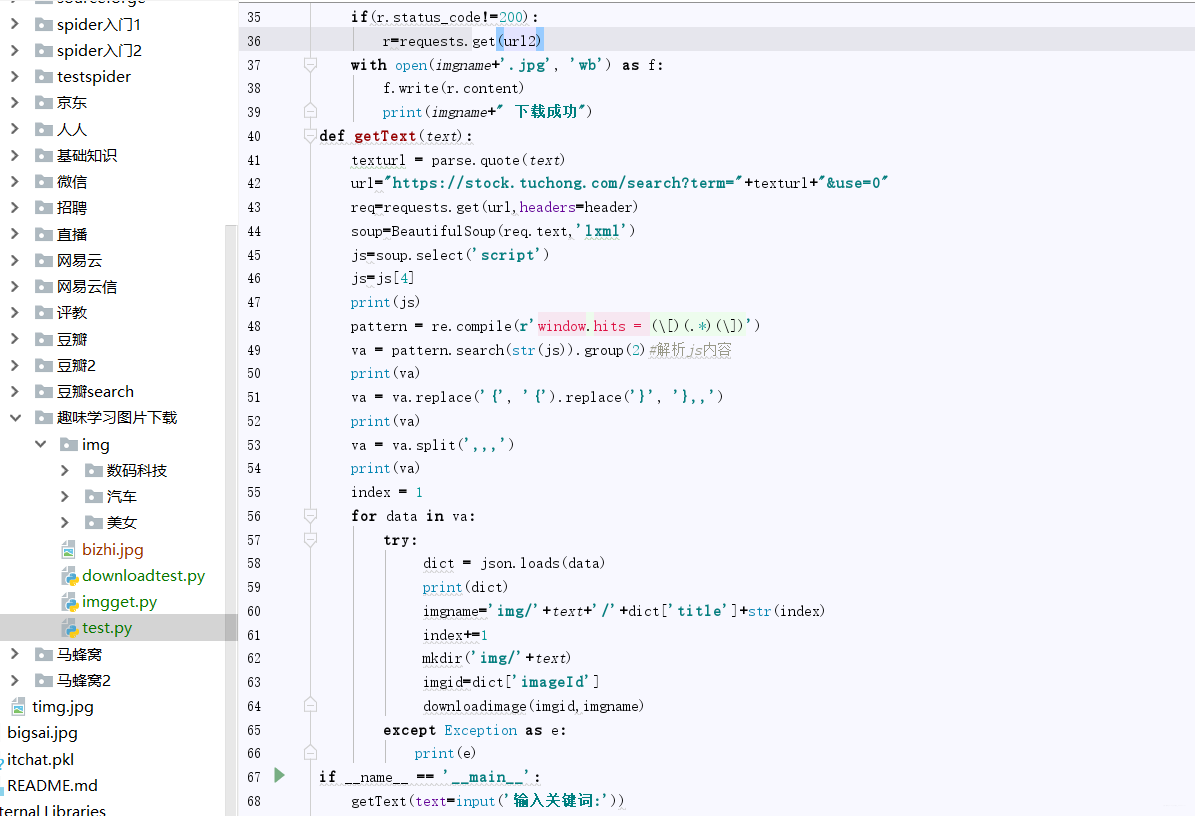

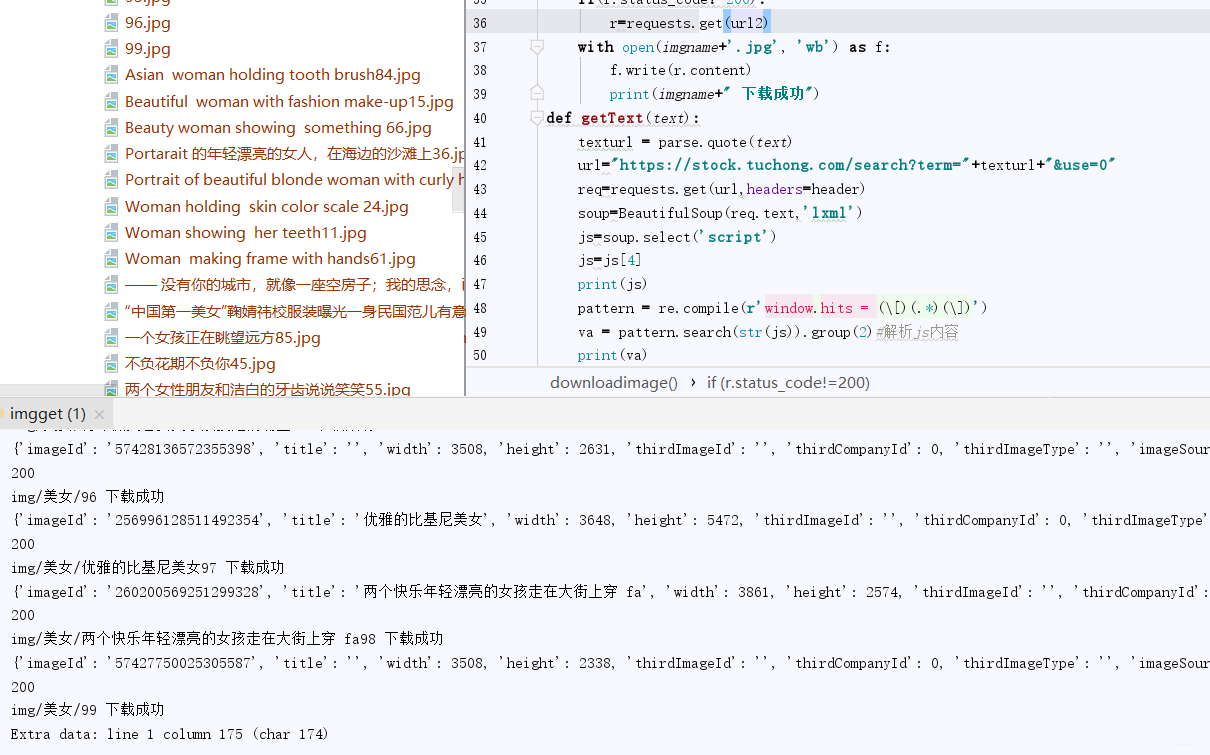

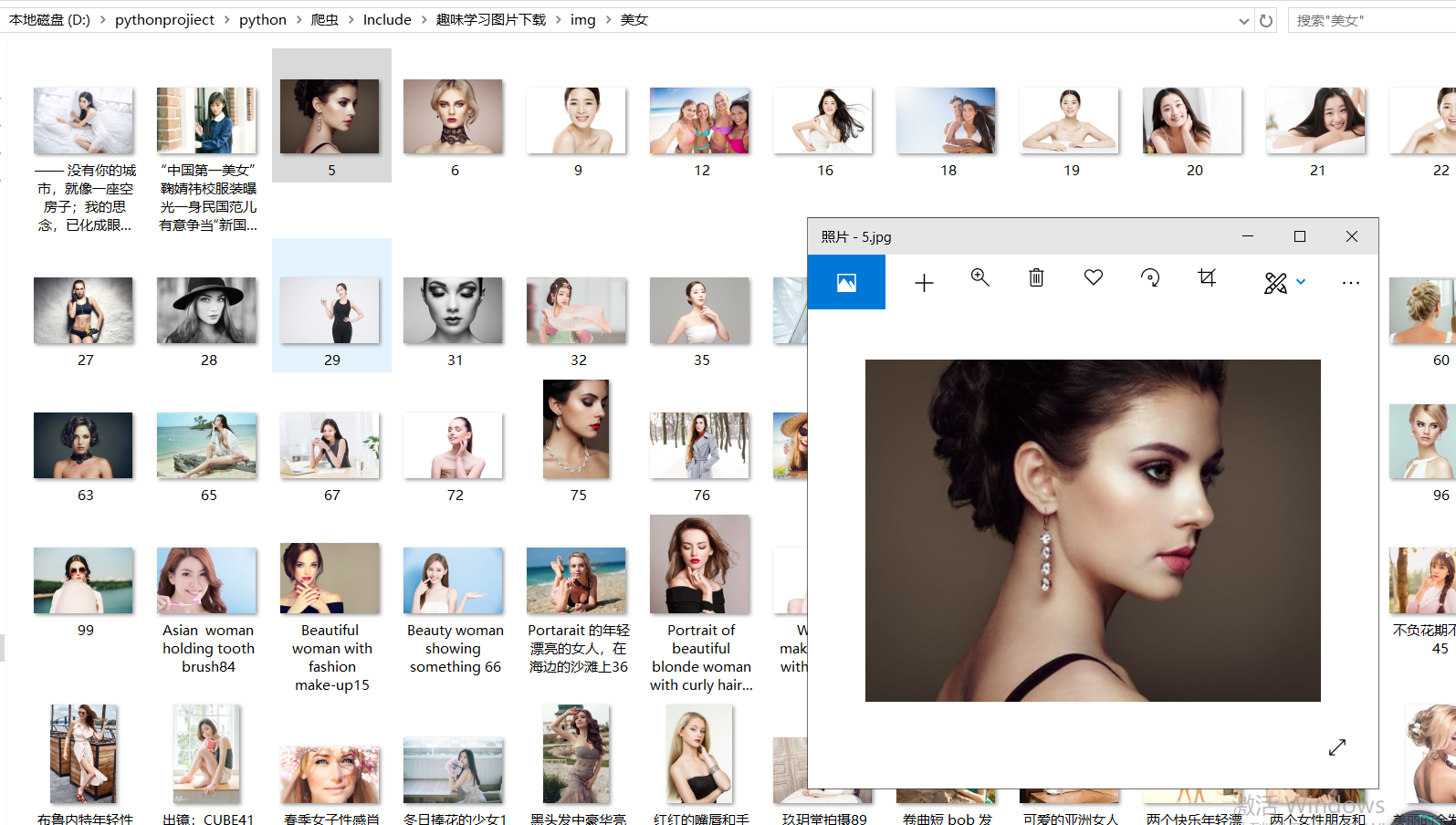

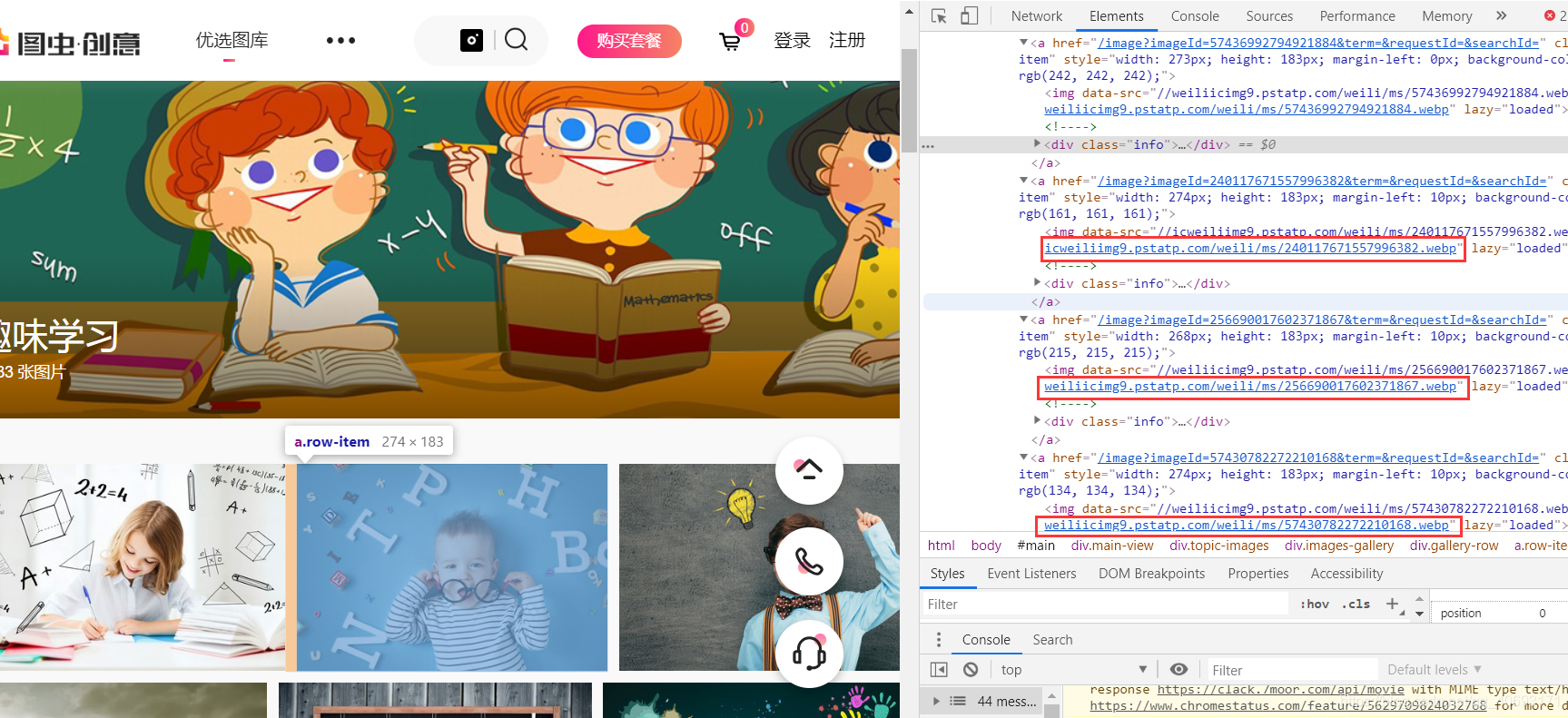

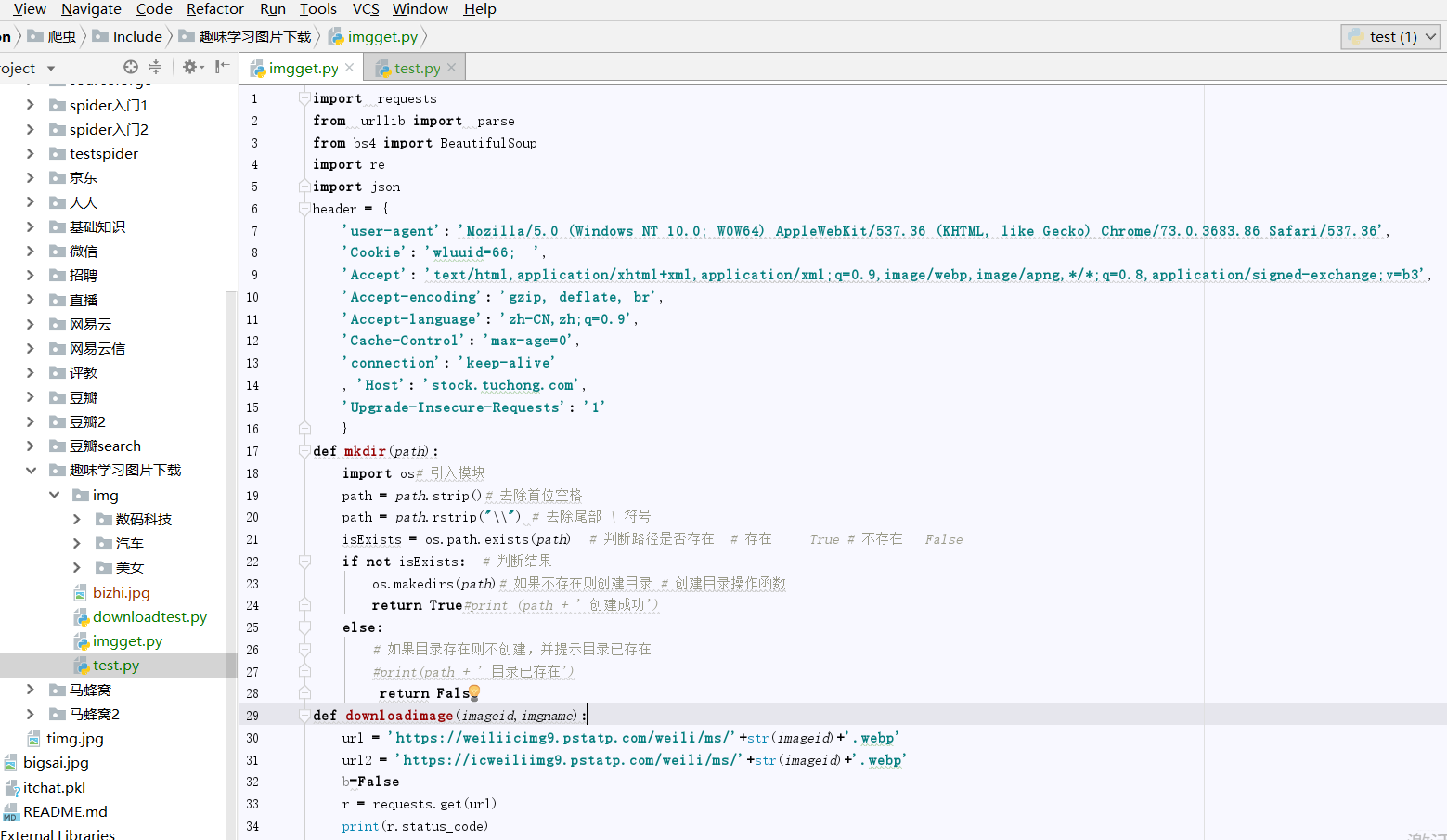

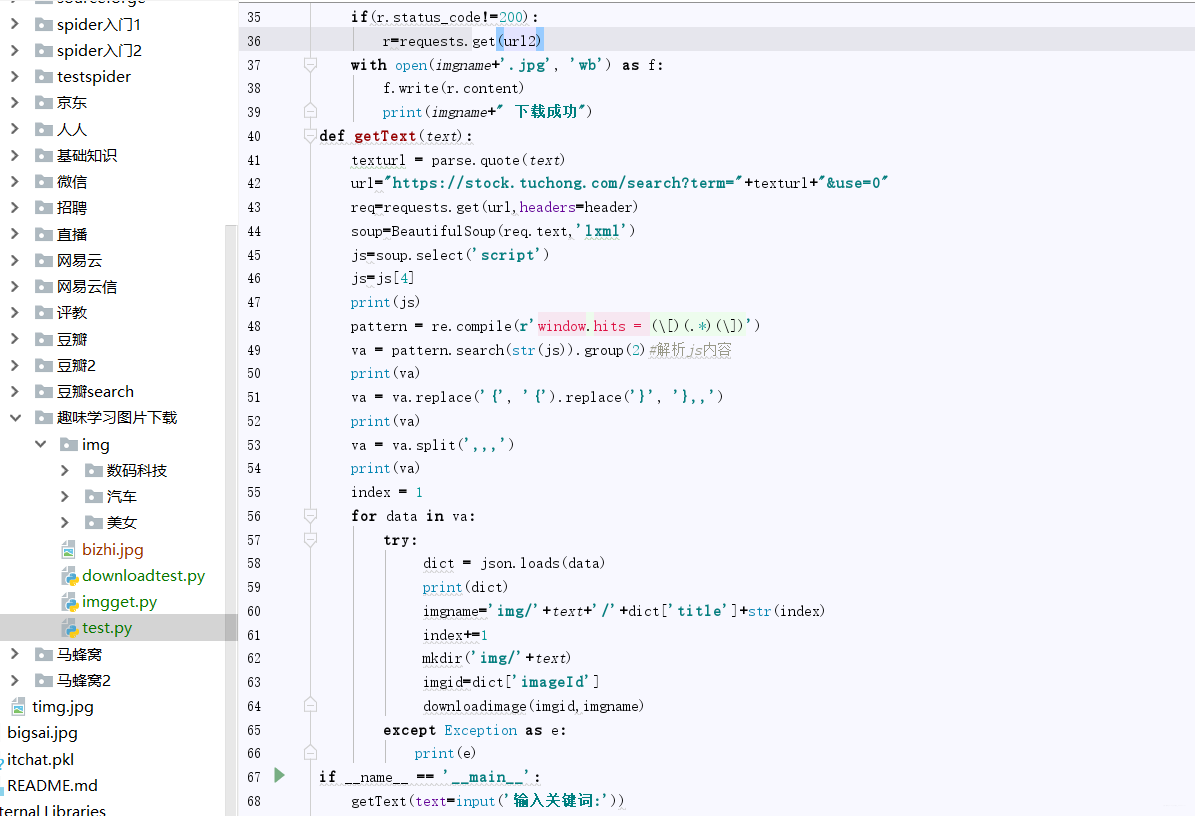

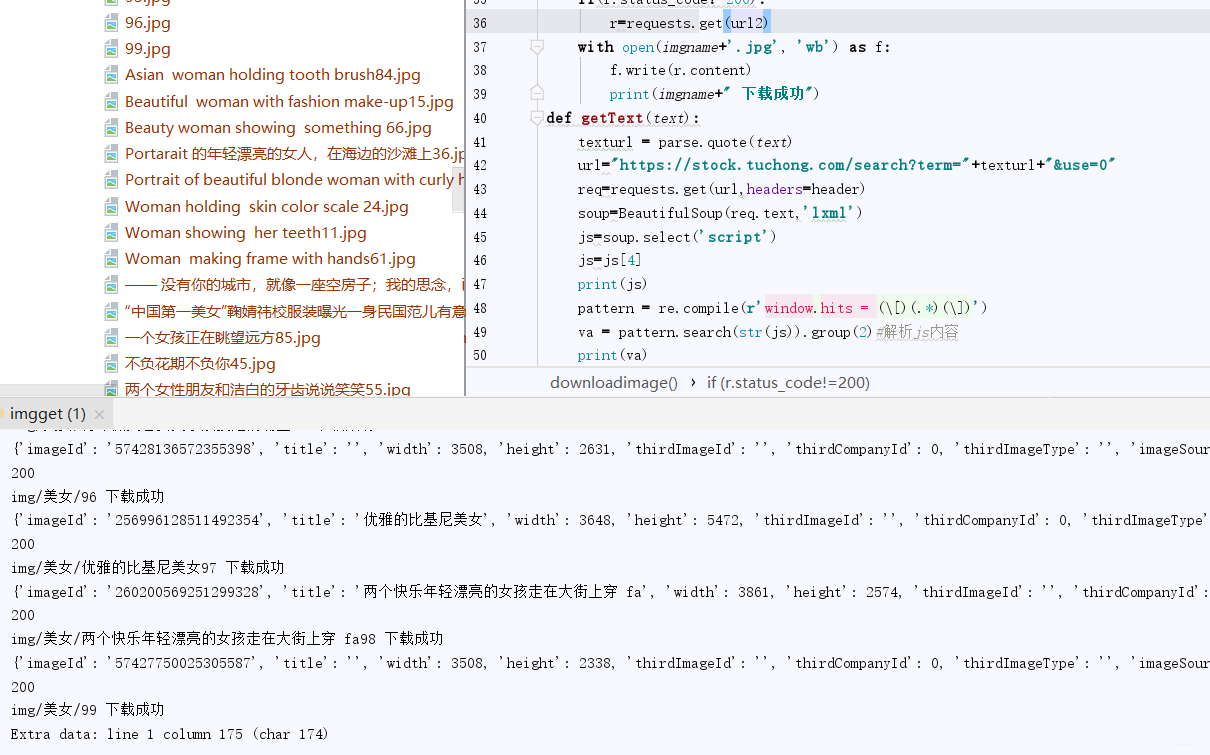

写文章没高质量配图?python爬虫绕开限制一键搜索下载图虫创意图片!

采集交流 • 优采云 发表了文章 • 0 个评论 • 201 次浏览 • 2020-08-12 16:39

前言

在我们写文章(博客、公众号、自媒体)的时侯,常常认为自己的文章有些老土,这很大程度是因为配图没有选好。

笔者也是遇见相同的情况,顺便解决其中一个案例,给你们一些技术上的参考和借鉴!

并且,我们搜图片假如去百度,会碰到两种情况:非高清或则带水印。这都是我们所忌讳的东西。笔者这次通过图虫创意抓起高清小图,虽然不是大图,但是在火爆的移动端阅读上是足够的!

项目效果图(下载部份图片停止):

分析

废话说完了,我们开始剖析怎么样能够获取这样的图片呢。

理想状态实际剖析

但事实这些肯定会被理想破灭,因为不可能!他以图片为核心业务,要你注册,购买等等,怎么可能就那么容易的嵌入步入被你找到。

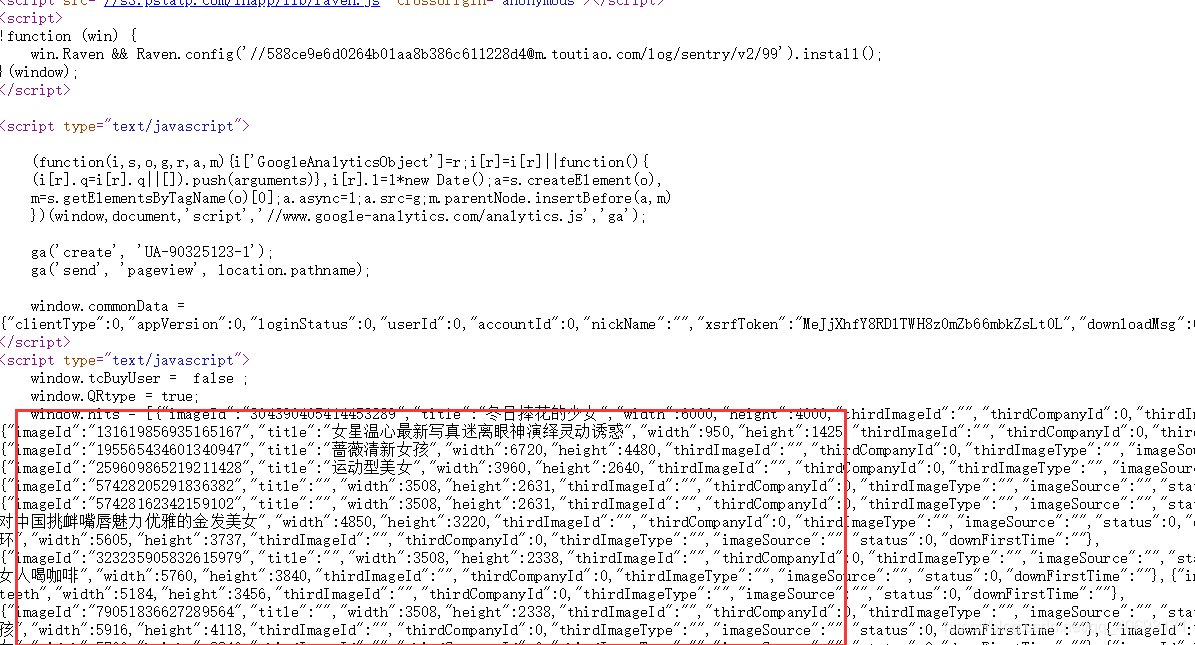

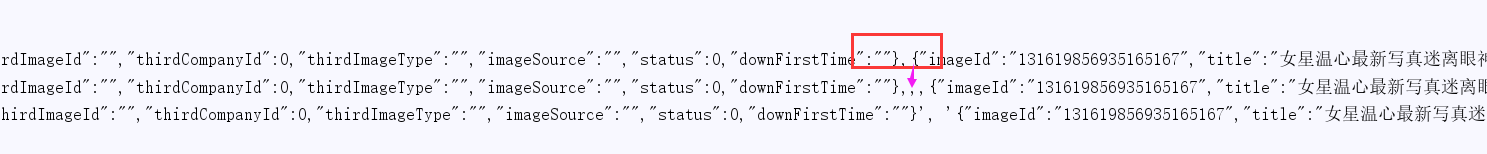

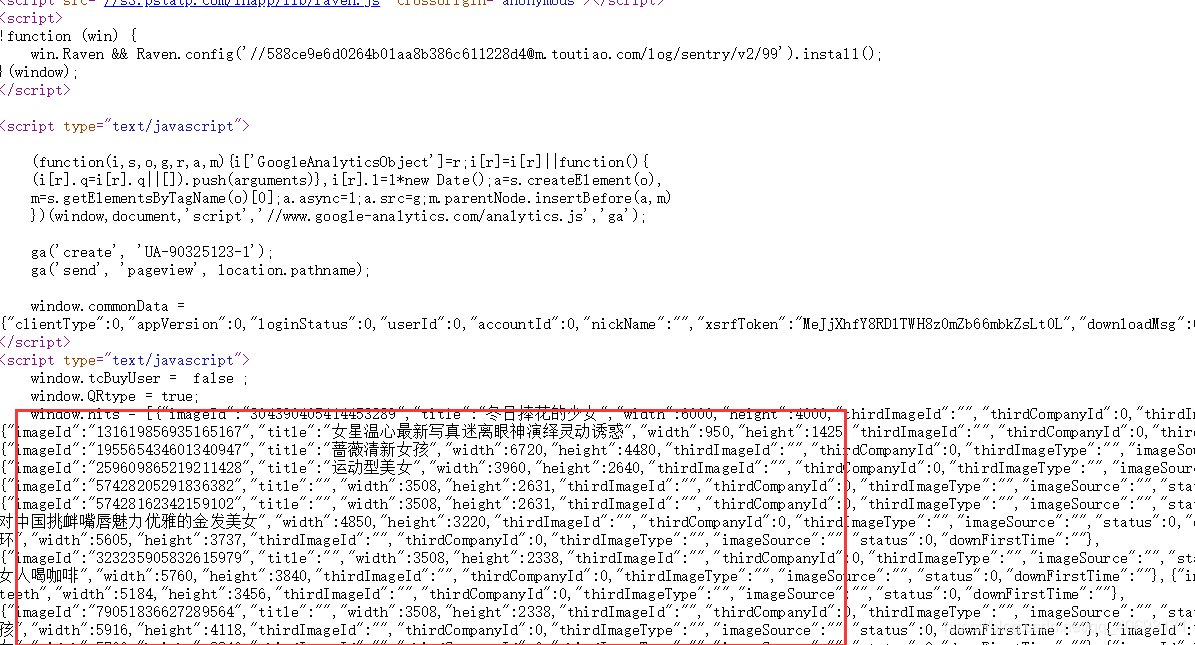

首先打开网页,检查图片,发现它的网页图片来源不惟一。有两个主要域名ice和wel,并且旁边的编号还不惟一,但是可以尝试发觉相同域名不同后缀的图片地址结果相同!(例如icweiliimg9和icweiliimg/效果相同)。

我们发觉原先这个搜索url会变化,但是这个查看网页源代码发觉并没有我们想要的图片地址。那么我们肯定晓得它要么从ajax渲染,或者就藏在js中进行混淆或则加密。我们发觉这个xhr中并没有想要的数据,并且他虽然藏在js中。其实这个可以猜测到的,因为它的url既然跟随变化这么返回的数据肯定是有区别的。

那么剖析就到这儿,剩下就是python爬虫的模拟和解析了。

爬虫实现

前面说到早已晓得它的数据源,我们用python编撰爬虫须要进行模拟。经过测试发觉它须要进行一些验证,其中包过cookie的wluuid数组(只验证存在,不验证正确性)。

那么我们编撰一段代码才能领到网页html。但是问题来了。数据藏在js上面啊!!!

我们只能用正则进行套了!

对于这个js,我们通过js=soup.select('script') js=js[3]即可获取。

对于有用数据,只能正则截取。

pattern = re.compile(r'window.hits = (\[)(.*)(\])')

va = pattern.search(str(js)).group(2)#解析js内容

但是这个类似json的串用,拼接我们难以直接使用spilt分组分开,但是我们可以从}全部替换成},,那么就三个,,,我们就可以分割而不影响其他json串内,;split然后每组都满足json串格式,直接转成json取值即可!

那么剩下领到url直接构造url之后下载图片即可!

其他注意

图片下载:

爬虫方面

其他

效果与总结

通过上述剖析:编写爬虫:

爬虫项目GitHub地址欢迎star!

测试结果:

打开文件夹:

发现nice!你只须要输入关键词即可实现手动下载,虽然是小图,但是疗效不错!

移动端公众号和csdn疗效! 查看全部

文章目录

前言

在我们写文章(博客、公众号、自媒体)的时侯,常常认为自己的文章有些老土,这很大程度是因为配图没有选好。

笔者也是遇见相同的情况,顺便解决其中一个案例,给你们一些技术上的参考和借鉴!

并且,我们搜图片假如去百度,会碰到两种情况:非高清或则带水印。这都是我们所忌讳的东西。笔者这次通过图虫创意抓起高清小图,虽然不是大图,但是在火爆的移动端阅读上是足够的!

项目效果图(下载部份图片停止):

分析

废话说完了,我们开始剖析怎么样能够获取这样的图片呢。

理想状态实际剖析

但事实这些肯定会被理想破灭,因为不可能!他以图片为核心业务,要你注册,购买等等,怎么可能就那么容易的嵌入步入被你找到。

首先打开网页,检查图片,发现它的网页图片来源不惟一。有两个主要域名ice和wel,并且旁边的编号还不惟一,但是可以尝试发觉相同域名不同后缀的图片地址结果相同!(例如icweiliimg9和icweiliimg/效果相同)。

我们发觉原先这个搜索url会变化,但是这个查看网页源代码发觉并没有我们想要的图片地址。那么我们肯定晓得它要么从ajax渲染,或者就藏在js中进行混淆或则加密。我们发觉这个xhr中并没有想要的数据,并且他虽然藏在js中。其实这个可以猜测到的,因为它的url既然跟随变化这么返回的数据肯定是有区别的。

那么剖析就到这儿,剩下就是python爬虫的模拟和解析了。

爬虫实现

前面说到早已晓得它的数据源,我们用python编撰爬虫须要进行模拟。经过测试发觉它须要进行一些验证,其中包过cookie的wluuid数组(只验证存在,不验证正确性)。

那么我们编撰一段代码才能领到网页html。但是问题来了。数据藏在js上面啊!!!

我们只能用正则进行套了!

对于这个js,我们通过js=soup.select('script') js=js[3]即可获取。

对于有用数据,只能正则截取。

pattern = re.compile(r'window.hits = (\[)(.*)(\])')

va = pattern.search(str(js)).group(2)#解析js内容

但是这个类似json的串用,拼接我们难以直接使用spilt分组分开,但是我们可以从}全部替换成},,那么就三个,,,我们就可以分割而不影响其他json串内,;split然后每组都满足json串格式,直接转成json取值即可!

那么剩下领到url直接构造url之后下载图片即可!

其他注意

图片下载:

爬虫方面

其他

效果与总结

通过上述剖析:编写爬虫:

爬虫项目GitHub地址欢迎star!

测试结果:

打开文件夹:

发现nice!你只须要输入关键词即可实现手动下载,虽然是小图,但是疗效不错!

移动端公众号和csdn疗效!

一键采集贴吧内容试用版 8.0.0

采集交流 • 优采云 发表了文章 • 0 个评论 • 289 次浏览 • 2020-08-11 13:53

解答:反过来问你一下,如果不安装采集插件,你自己原创写文章,你能写多少篇??我相信99.9%的人都不会完全原创所有的内容,都会转载其它网站的一些内容,包括一些xx日报,xx电视台,都会或多或少转载一些其它网站的优质内容,你的Discuz峰会安装采集插件,主要是辅助你,运营好自己的网站内容,既然都要手工转载内容,为什么不用效率更高,不会出错,简单易用的采集工具,让自己事半功倍呢??

问题:采集的内容,百度会收录吗??如何做好SEO优化??

解答:当下来一条新闻,你在百度搜索会看见,很多内容重复的文章也同样收录了,其实这些重复的内容,都是转载过来的,所以采集的内容百度同样也会收录,特别是最新的原创类内容,及时采集过来,同步发布出去,这样你的收录和原创的没有哪些区别,为了更好的提升SEO收录优化,除了及时采集最新的原创内容之外,最好能采集一些拒绝百度收录的平台内容,比如:微信公众号文章,另外还可以采集一些须要登陆以后,才能看见的内容,一些用ajax加载的内容,等等,这类内容百度都是抓取不到的,如果你发布这类的内容,SEO的收录会更好,排名会更好!!

问题:采集到的内容,会不会侵权??

解答:一些对社会正常运作,有帮助的内容,这类内容是规定可以转载的,比如:近期新冠脑炎太严重,一些疫情相关的公开报导内容,这些是没有问题的,因为这种疫情防治的信息,越多人晓得,就越好!!对疫情防治就越有帮助,采集这类内容是没有问题的!还有一类内容,就是对某一个企业有负面影响的,某一个企业的公关人员,会通知你,删除那些内容,只要你配合删掉掉内容,就可以了!!只有很少一部分内容,申请了著作权,如果不留神转载了,有可能被著作权所有人胜诉,这是低几率风波,一般不会遇见!!智伍应用的采集插件,支持先审后发,不支持不初审就手动采集发布出去!!确保了采集内容的安全!!因为每一篇文章内容,都是经过你审查过后,再采集发布的。

问题:智伍应用靠谱吗?会不会骗钱?

解答:非常靠谱!!智伍应用的产品上线之前,都会经过严格的测试和初审代码质量,确保安全而且能用和好用,全部都评比通过以后,才会申请上架!!同时源代码开放,任何人都可以查看到原创透明的代码,有技术能力的用户,可以很方便快捷进行二次开发,智伍应用的任何一款产品,都可以免费试用,满意以后再考虑,是否须要升级到即将商用版本,如果安装以后,发现不能使用,可以联系在线客服解决,如果碰到难以解决的问题,这个插件难以使用,会全额退票给你,总体的一个原则,就是使用户安全无风险,准确找到自己的需求,购买自己用得上的插件模块,如果订购以后,发现用不上,智伍应用会给你退票,如果确实有须要,请放心订购智伍应用的各个产品!!!智伍应用仍然都认真听取用户的反馈意见,根据用户的建议不断的升级更新产品,尊重用户的各项权益和合理诉求!!把用户放到最高的位置上,全心全意为用户服务!!

问题:智伍应用的采集插件都有哪些亮点和优势?

解答:多数都使用Chrome扩充采集程序,需要在自己的网页浏览器chrome那儿安装一个扩充程序,因为经过研究发觉,把浏览器弄成采集工具,是最可靠和成熟稳定的采集方式!一些通过程序抓取函数来采集内容的传统采集方式,虽然可以不用安装chrome扩充程序,但时常出问题,遇到采集不到内容的事情常有发生!!

问题:智伍应用开发了什么采集插件?

解答:很多!!我们专注研制采集插件多年,经过多次升级更新,在采集插件研制方面积累了丰富的经验,如果找不到你须要的采集插件,请反馈给智伍应用在线客服。

问题:智伍应用的采集插件那个好用?

解答:内核技术都一样,只是采集规则不一样,智伍应用的采集插件都好用,主要看你须要采集哪个网站,然后就用那种网站相对应的采集插件。

问题:我完全不懂技术,但想用智伍应用的Discuz采集插件,怎么办?

解答:联系智伍应用在线客服,在线帮助你安装和配置,直到插件完全可以使用,没有任何问题!!不需要你懂技术,售后客服会帮你解决所有的问题。

问题:为什么要用chrome扩充采集程序??

解答:因为这些采集方式,是最稳定和成熟的!!网页都是HTML代码经过浏览器渲染才下来的,所以把自己的浏览器弄成采集工具,所见即所采的方法,是最好的。

问题:chrome扩充安全吗??为什么会弹出“请停用以开发者模式运行的扩充程序”

解答:只要安装了chrome扩充程序,不管是哪些chrome扩充程序,都会弹出这样的提醒:“以开发者模式运行的扩充程序可能会损害您的计算机。如果您不是开发者,那么,为安全起见,应停用以开发者模式运行的扩充程序。”,这就似乎在百货商城里提醒你:“遇到火警请打119。”一样,有提醒你打119,并不代表你遇见了起火,这只是一个提醒信息!!智伍应用的chrome扩充程序都是经过人工初审,多方检测和测试,是安全可靠的扩充程序!!

问题:可以无人值守,自动采集内容吗??

解答:不可以!!全手动采集内容并发布,这样采集内容不安全!!智伍应用的采集插件都是先审后发,确保内容的质量和安全!!不能不经过你的同意,就手动发布内容了!!如果你须要短时间内采集发布大量的内容,来填充网站,可以在【待发布】那里,选择【用chrome扩充批量发布内容】 查看全部

问题:为什么Discuz峰会必须要安装采集插件?

解答:反过来问你一下,如果不安装采集插件,你自己原创写文章,你能写多少篇??我相信99.9%的人都不会完全原创所有的内容,都会转载其它网站的一些内容,包括一些xx日报,xx电视台,都会或多或少转载一些其它网站的优质内容,你的Discuz峰会安装采集插件,主要是辅助你,运营好自己的网站内容,既然都要手工转载内容,为什么不用效率更高,不会出错,简单易用的采集工具,让自己事半功倍呢??

问题:采集的内容,百度会收录吗??如何做好SEO优化??

解答:当下来一条新闻,你在百度搜索会看见,很多内容重复的文章也同样收录了,其实这些重复的内容,都是转载过来的,所以采集的内容百度同样也会收录,特别是最新的原创类内容,及时采集过来,同步发布出去,这样你的收录和原创的没有哪些区别,为了更好的提升SEO收录优化,除了及时采集最新的原创内容之外,最好能采集一些拒绝百度收录的平台内容,比如:微信公众号文章,另外还可以采集一些须要登陆以后,才能看见的内容,一些用ajax加载的内容,等等,这类内容百度都是抓取不到的,如果你发布这类的内容,SEO的收录会更好,排名会更好!!

问题:采集到的内容,会不会侵权??

解答:一些对社会正常运作,有帮助的内容,这类内容是规定可以转载的,比如:近期新冠脑炎太严重,一些疫情相关的公开报导内容,这些是没有问题的,因为这种疫情防治的信息,越多人晓得,就越好!!对疫情防治就越有帮助,采集这类内容是没有问题的!还有一类内容,就是对某一个企业有负面影响的,某一个企业的公关人员,会通知你,删除那些内容,只要你配合删掉掉内容,就可以了!!只有很少一部分内容,申请了著作权,如果不留神转载了,有可能被著作权所有人胜诉,这是低几率风波,一般不会遇见!!智伍应用的采集插件,支持先审后发,不支持不初审就手动采集发布出去!!确保了采集内容的安全!!因为每一篇文章内容,都是经过你审查过后,再采集发布的。

问题:智伍应用靠谱吗?会不会骗钱?

解答:非常靠谱!!智伍应用的产品上线之前,都会经过严格的测试和初审代码质量,确保安全而且能用和好用,全部都评比通过以后,才会申请上架!!同时源代码开放,任何人都可以查看到原创透明的代码,有技术能力的用户,可以很方便快捷进行二次开发,智伍应用的任何一款产品,都可以免费试用,满意以后再考虑,是否须要升级到即将商用版本,如果安装以后,发现不能使用,可以联系在线客服解决,如果碰到难以解决的问题,这个插件难以使用,会全额退票给你,总体的一个原则,就是使用户安全无风险,准确找到自己的需求,购买自己用得上的插件模块,如果订购以后,发现用不上,智伍应用会给你退票,如果确实有须要,请放心订购智伍应用的各个产品!!!智伍应用仍然都认真听取用户的反馈意见,根据用户的建议不断的升级更新产品,尊重用户的各项权益和合理诉求!!把用户放到最高的位置上,全心全意为用户服务!!

问题:智伍应用的采集插件都有哪些亮点和优势?

解答:多数都使用Chrome扩充采集程序,需要在自己的网页浏览器chrome那儿安装一个扩充程序,因为经过研究发觉,把浏览器弄成采集工具,是最可靠和成熟稳定的采集方式!一些通过程序抓取函数来采集内容的传统采集方式,虽然可以不用安装chrome扩充程序,但时常出问题,遇到采集不到内容的事情常有发生!!

问题:智伍应用开发了什么采集插件?

解答:很多!!我们专注研制采集插件多年,经过多次升级更新,在采集插件研制方面积累了丰富的经验,如果找不到你须要的采集插件,请反馈给智伍应用在线客服。

问题:智伍应用的采集插件那个好用?

解答:内核技术都一样,只是采集规则不一样,智伍应用的采集插件都好用,主要看你须要采集哪个网站,然后就用那种网站相对应的采集插件。

问题:我完全不懂技术,但想用智伍应用的Discuz采集插件,怎么办?

解答:联系智伍应用在线客服,在线帮助你安装和配置,直到插件完全可以使用,没有任何问题!!不需要你懂技术,售后客服会帮你解决所有的问题。

问题:为什么要用chrome扩充采集程序??

解答:因为这些采集方式,是最稳定和成熟的!!网页都是HTML代码经过浏览器渲染才下来的,所以把自己的浏览器弄成采集工具,所见即所采的方法,是最好的。

问题:chrome扩充安全吗??为什么会弹出“请停用以开发者模式运行的扩充程序”

解答:只要安装了chrome扩充程序,不管是哪些chrome扩充程序,都会弹出这样的提醒:“以开发者模式运行的扩充程序可能会损害您的计算机。如果您不是开发者,那么,为安全起见,应停用以开发者模式运行的扩充程序。”,这就似乎在百货商城里提醒你:“遇到火警请打119。”一样,有提醒你打119,并不代表你遇见了起火,这只是一个提醒信息!!智伍应用的chrome扩充程序都是经过人工初审,多方检测和测试,是安全可靠的扩充程序!!

问题:可以无人值守,自动采集内容吗??

解答:不可以!!全手动采集内容并发布,这样采集内容不安全!!智伍应用的采集插件都是先审后发,确保内容的质量和安全!!不能不经过你的同意,就手动发布内容了!!如果你须要短时间内采集发布大量的内容,来填充网站,可以在【待发布】那里,选择【用chrome扩充批量发布内容】

如何在一个网页中找出所有页面内图片的工具Image登场

采集交流 • 优采云 发表了文章 • 0 个评论 • 385 次浏览 • 2021-02-09 09:05

如何在一个网页中找出所有页面内图片的工具Image登场

今天,火箭先生将教您如何在网页中查找所有图片。

图像助手在这里

图片助手

Image Assistant是一个chrome扩展程序,包括网页图像提取,过滤和下载功能。可以说,几乎可以提取页面上可以看到的所有图片元素,甚至可以提取“彩色”嵌入式广告中收录的图片。

设计人员可以快速获取Web资料,游戏开发人员从Web游戏中提取材料,分批下载壁纸,并分批查看网站图片...

可以说,只要您的计算机内存足够大,Image Assistant就会成为很好的图像提取伪像!

以互联网名人电动汽车为实验

蔚来ES8的官方网站有大量精美图片,但是由于UI交互设计,很难一次下载这些精美图片,甚至一次阅读这些精美图片

开始提取!

下载Image Assistant之后,Chrome界面上会有一个额外的紫色按钮。您只需要单击此按钮并选择“提取当前页面”即可完成网页图像元素的提取。

过一会儿,您将能够看到网页上的所有图片,

您也可以在尺寸漏斗中设置图像尺寸的过滤器,以确保不会显示过小的图像〜

继续挖掘!

除了可以在网页上查找图片之外,Image Assistant还支持搜索带有图片的图片。

在图片上单击鼠标右键后,您可以选择在各种搜索引擎中搜索图片或查找与图片相关的信息,这非常方便!

如果您对此插件感兴趣,请访问以下网站进行安装!

/ ImageAssistant /

原创链接:

效率火箭官方网站 |免费Office桌面软件下载|手机应用助手大全|个人团队协作效率工具的有效方法清单效率应用程序推荐|资源采集共享搜索发现平台

查看全部

如何在一个网页中找出所有页面内图片的工具Image登场

今天,火箭先生将教您如何在网页中查找所有图片。

图像助手在这里

图片助手

Image Assistant是一个chrome扩展程序,包括网页图像提取,过滤和下载功能。可以说,几乎可以提取页面上可以看到的所有图片元素,甚至可以提取“彩色”嵌入式广告中收录的图片。

设计人员可以快速获取Web资料,游戏开发人员从Web游戏中提取材料,分批下载壁纸,并分批查看网站图片...

可以说,只要您的计算机内存足够大,Image Assistant就会成为很好的图像提取伪像!

以互联网名人电动汽车为实验

蔚来ES8的官方网站有大量精美图片,但是由于UI交互设计,很难一次下载这些精美图片,甚至一次阅读这些精美图片

开始提取!

下载Image Assistant之后,Chrome界面上会有一个额外的紫色按钮。您只需要单击此按钮并选择“提取当前页面”即可完成网页图像元素的提取。

过一会儿,您将能够看到网页上的所有图片,

您也可以在尺寸漏斗中设置图像尺寸的过滤器,以确保不会显示过小的图像〜

继续挖掘!

除了可以在网页上查找图片之外,Image Assistant还支持搜索带有图片的图片。

在图片上单击鼠标右键后,您可以选择在各种搜索引擎中搜索图片或查找与图片相关的信息,这非常方便!

如果您对此插件感兴趣,请访问以下网站进行安装!

/ ImageAssistant /

原创链接:

效率火箭官方网站 |免费Office桌面软件下载|手机应用助手大全|个人团队协作效率工具的有效方法清单效率应用程序推荐|资源采集共享搜索发现平台

如何实现PHP语言开发的建站程序平台的自动采集功能

采集交流 • 优采云 发表了文章 • 0 个评论 • 271 次浏览 • 2021-01-20 12:30

WordPress是使用PHP语言开发的网站构建程序平台。现在,许多博客都使用wp。许多网站生产培训都使用wp,尤其是在进行采集工作站时。总能量非常强大。下面将介绍如何实现wp自动采集功能的特定操作步骤。 (相关知识:什么是wordpress?)如果要制作电影网站,则可以选择我的主题网站{Applecms模板} {海洋cms模板}和{Feifei电影模板}电视台大网站型交通(交通车站)

1、安装网站 采集插件:WP-AutoPost(插件下载链接:)

2、单击“新任务”后,输入任务名称以创建新任务。创建新任务后,您可以在任务列表中查看该任务,并且可以为该任务设置更多设置。 (这部分不需要修改设置,唯一需要更改的是采集的时间。)

3、文章信号源设置。在此选项卡下,我们需要设置文章源的文章列表URL和特定的文章匹配规则。让我们以采集“新浪网新闻”为例,文章列表URL是这样,因此,请在手动指定的文章列表URL中输入它,如下所示:

4、文章 URL匹配规则。 文章 URL匹配规则的设置非常简单,不需要复杂的设置。提供两种匹配模式。您可以使用URL通配符匹配或CSS选择器进行匹配。通常,URL通配符匹配相对简单,但有时会使用CSS选择器。更精确。

5、使用URL通配符匹配。通过单击列表URL上的文章,我们可以发现每个文章的URL具有以下结构:因此,请用通配符(*)替换URL中的数字或字母,例如:(*)/( *)。shtml。重复的URL可以使用301重定向。

6、使用CSS选择器进行匹配。要使用CSS选择器进行匹配,我们只需要设置文章 URL的CSS选择器,可以通过查看列表URL的源代码并在[URL]下找到文章超链接的代码来轻松设置CSS选择器。列表网址,如下所示:

7、可以看到文章的超链接A标记在类为“ contList”的标记内,因此文章 URL的CSS选择器仅需要设置为.contList a,如图所示下方:

设置8、后,如果不确定设置是否正确,则可以单击上图中的测试按钮。如果设置正确,将列出列表URL下的所有文章名称和相应的网址,如下所示:

9、其他设置无需修改。

10、及以上采集方法适用于WordPress多站点功能。

以上是我的主题网站Applecms为每个人自适应采集的10个漂亮模板:wordpress如何自动采集?相关问题的解释和相关问题的答案。我希望如何下载您当前遇到的wordpress自动采集插件?其他相关问题可以提供并获得一些帮助!有关更多Applecms的知识,请注意:我的主题网络Applecms安装教程。 查看全部

如何实现PHP语言开发的建站程序平台的自动采集功能

WordPress是使用PHP语言开发的网站构建程序平台。现在,许多博客都使用wp。许多网站生产培训都使用wp,尤其是在进行采集工作站时。总能量非常强大。下面将介绍如何实现wp自动采集功能的特定操作步骤。 (相关知识:什么是wordpress?)如果要制作电影网站,则可以选择我的主题网站{Applecms模板} {海洋cms模板}和{Feifei电影模板}电视台大网站型交通(交通车站)

1、安装网站 采集插件:WP-AutoPost(插件下载链接:)

2、单击“新任务”后,输入任务名称以创建新任务。创建新任务后,您可以在任务列表中查看该任务,并且可以为该任务设置更多设置。 (这部分不需要修改设置,唯一需要更改的是采集的时间。)

3、文章信号源设置。在此选项卡下,我们需要设置文章源的文章列表URL和特定的文章匹配规则。让我们以采集“新浪网新闻”为例,文章列表URL是这样,因此,请在手动指定的文章列表URL中输入它,如下所示:

4、文章 URL匹配规则。 文章 URL匹配规则的设置非常简单,不需要复杂的设置。提供两种匹配模式。您可以使用URL通配符匹配或CSS选择器进行匹配。通常,URL通配符匹配相对简单,但有时会使用CSS选择器。更精确。

5、使用URL通配符匹配。通过单击列表URL上的文章,我们可以发现每个文章的URL具有以下结构:因此,请用通配符(*)替换URL中的数字或字母,例如:(*)/( *)。shtml。重复的URL可以使用301重定向。

6、使用CSS选择器进行匹配。要使用CSS选择器进行匹配,我们只需要设置文章 URL的CSS选择器,可以通过查看列表URL的源代码并在[URL]下找到文章超链接的代码来轻松设置CSS选择器。列表网址,如下所示:

7、可以看到文章的超链接A标记在类为“ contList”的标记内,因此文章 URL的CSS选择器仅需要设置为.contList a,如图所示下方:

设置8、后,如果不确定设置是否正确,则可以单击上图中的测试按钮。如果设置正确,将列出列表URL下的所有文章名称和相应的网址,如下所示:

9、其他设置无需修改。

10、及以上采集方法适用于WordPress多站点功能。

以上是我的主题网站Applecms为每个人自适应采集的10个漂亮模板:wordpress如何自动采集?相关问题的解释和相关问题的答案。我希望如何下载您当前遇到的wordpress自动采集插件?其他相关问题可以提供并获得一些帮助!有关更多Applecms的知识,请注意:我的主题网络Applecms安装教程。

推荐文章:python如何实现批量抓取某一网站全部文章的链接?

采集交流 • 优采云 发表了文章 • 0 个评论 • 455 次浏览 • 2020-12-29 13:08

要拉动和闭合鱼网,必须先找到鱼的轮廓,然后按照鱼轮廓的顺序逐步进行操作,以整齐地采集整个网。

网站的结构也类似于鱼网,具有列表页面(鱼的轮廓)和内容页面(网的表面)。使用Python批量抓取,根据列表页面一个一个地抓取相应的内容页面。所有爬虫原理和爬虫工具都是以这种方式处理的。

如果仅想实现批量爬网网站 文章,则无需编写自己的爬网程序,则可以使用爬网工具。在这里,我推荐优采云采集平台,在线视觉操作,简单方便,十分钟就可以熟练使用。

优采云采集是新一代的网站 文章 采集和发布平台,它是完全在线配置和使用云采集的平台,功能强大,操作简单,配置快捷高效。

优采云不仅提供网页文章 采集,数据批处理修改,计时采集,计时和定量自动发布等基本功能,还集成了功能强大的SEO工具,并创新地实现了智能规则提取引擎和书签一键发布采集等功能大大改善了采集的配置和发布效率。

采集发布更简单:支持一键发布到WorpPress,Empire,织梦,ZBlog,Discuz,Destoon,Typecho,Emlog,Mipcms,Mituo,Yiyoucms,Applecms ],PHPcms和其他cms网站系统也可以发布到自定义Http接口或导出到excel,CSV和sql文件。

此外,它还支持特定的文章“一键快速采集”,包括:微信官方帐户文章,今天的头条新闻,新闻窗格采集。

优采云采集具有免费版本,有需要的学生可以快速浏览以下条目文章进行尝试。

列表页面·优采云采集帮助中心

详细信息页面(内容页面)·优采云采集帮助中心

文章 采集入门教程(超级详细)·优采云采集帮助中心。

查看全部

推荐文章:python如何实现批量抓取某一网站全部文章的链接?

要拉动和闭合鱼网,必须先找到鱼的轮廓,然后按照鱼轮廓的顺序逐步进行操作,以整齐地采集整个网。

网站的结构也类似于鱼网,具有列表页面(鱼的轮廓)和内容页面(网的表面)。使用Python批量抓取,根据列表页面一个一个地抓取相应的内容页面。所有爬虫原理和爬虫工具都是以这种方式处理的。

如果仅想实现批量爬网网站 文章,则无需编写自己的爬网程序,则可以使用爬网工具。在这里,我推荐优采云采集平台,在线视觉操作,简单方便,十分钟就可以熟练使用。

优采云采集是新一代的网站 文章 采集和发布平台,它是完全在线配置和使用云采集的平台,功能强大,操作简单,配置快捷高效。

优采云不仅提供网页文章 采集,数据批处理修改,计时采集,计时和定量自动发布等基本功能,还集成了功能强大的SEO工具,并创新地实现了智能规则提取引擎和书签一键发布采集等功能大大改善了采集的配置和发布效率。

采集发布更简单:支持一键发布到WorpPress,Empire,织梦,ZBlog,Discuz,Destoon,Typecho,Emlog,Mipcms,Mituo,Yiyoucms,Applecms ],PHPcms和其他cms网站系统也可以发布到自定义Http接口或导出到excel,CSV和sql文件。

此外,它还支持特定的文章“一键快速采集”,包括:微信官方帐户文章,今天的头条新闻,新闻窗格采集。

优采云采集具有免费版本,有需要的学生可以快速浏览以下条目文章进行尝试。

列表页面·优采云采集帮助中心

详细信息页面(内容页面)·优采云采集帮助中心

文章 采集入门教程(超级详细)·优采云采集帮助中心。

最新版:[KK网页信息批量采集]批量采集多个页面的信息,让任意网页拥有导出功能

采集交流 • 优采云 发表了文章 • 0 个评论 • 279 次浏览 • 2020-12-27 11:13

顾名思义,它可以采集网页上的任何信息并将其导出到您的计算机。同时,您也可以同时添加多个页面,以帮助您批量采集所需的信息。

采集的信息可以导出为文本txt和表格.xlsx格式。这样,他不仅可以将翅膀放在任何网页上,并允许该网页支持导出特定信息,还可以批量导出多个页面的信息。

网页信息批量提取工具,由于您自己的工作需要,管理后台订单和产品列表不支持导出。总结时,一一复制并粘贴到excel中,这不可避免地很复杂。 1分钟内可以完成的操作必须手动完成。重复这些机械化动作几个小时。因此,为了解决这些问题,第一版于2017年发布。让具有相同需求的学生能够更有效地处理问题。

它支持截取网页上的一部分信息并将其导出,还支持匹配被截取的信息片段列表中的多个循环信息。

更好:

1、发布请求以获取数据

2、自定义网页标题协议标头,伪装任何浏览器以供访问

3、可以同时设置爬网间隔,以防止采集被其他网站个服务器快速阻止

4、将结果从采集导出到excel或txt

它不仅具有采集信息的功能,如果您拥有自己的网站,还可以帮助您将这些信息或计算机Excel中的信息发布到网站。

您可以用它做什么?

1、 采集网页中的多条信息(标题/ URL /时间等),导出

从多个网页

2、批量处理采集信息并导出

3、批量访问打开的页面,例如,某些网站管理员需要批量向百度提交收录,一个人打开一个页面太麻烦了

软件下载地址:

高级进阶文章(写给网站管理员,普通人不需要理解,阅读使简单的软件更加复杂):

因此,如何使用它来采集条网站消息,并将其发布到我的网站

只需几个步骤:

1、在第文章页上编写抓取文章标题和内容的规则,并将其写下来。

2、使用“小工具”中的序列URL生成工具来生成一系列列表URL。如:list /1.html,list /2.html,list /3.html,...,list / 999.html,从其他网站的列表页中可以看到多少页],生成尽可能多的列表URL。

3、在匹配列表页面上编写并检索所有文章规则:也就是说,从列表页面中删除所有文章链接,进行匹配,然后将其导出

4、然后将在步骤3中得出的文章 URL输出为采集目标,并将其输出到URL框中。然后填写步骤1的规则,然后可以自动释放这些页面的文章标题和链接信息采集。

目前,网站某一列中文章的所有标题和链接都已采集并导出为excel,那么如何将该excel发布到我的网站?

5、手动将单元格合成为excel中post提交的信息格式。例如:title = kkno1&content = com

6、提交URL并填写文章发布背景的帖子接收URL,并在软件中完成协议标头的cookie信息(模拟网站管理员在后台登录),然后在帖子参数中填写步骤5生成的帖子提交格式,单击批量处理,软件可以自动批量发布方式,将此类信息一一提交到帖子接收页面,以实现自动发布功能。

从采集到发行的完整过程。似乎有很多步骤,实际上只有3场比赛。 查看全部

最新版:[KK网页信息批量采集]批量采集多个页面的信息,让任意网页拥有导出功能

顾名思义,它可以采集网页上的任何信息并将其导出到您的计算机。同时,您也可以同时添加多个页面,以帮助您批量采集所需的信息。

采集的信息可以导出为文本txt和表格.xlsx格式。这样,他不仅可以将翅膀放在任何网页上,并允许该网页支持导出特定信息,还可以批量导出多个页面的信息。

网页信息批量提取工具,由于您自己的工作需要,管理后台订单和产品列表不支持导出。总结时,一一复制并粘贴到excel中,这不可避免地很复杂。 1分钟内可以完成的操作必须手动完成。重复这些机械化动作几个小时。因此,为了解决这些问题,第一版于2017年发布。让具有相同需求的学生能够更有效地处理问题。

它支持截取网页上的一部分信息并将其导出,还支持匹配被截取的信息片段列表中的多个循环信息。

更好:

1、发布请求以获取数据

2、自定义网页标题协议标头,伪装任何浏览器以供访问

3、可以同时设置爬网间隔,以防止采集被其他网站个服务器快速阻止

4、将结果从采集导出到excel或txt

它不仅具有采集信息的功能,如果您拥有自己的网站,还可以帮助您将这些信息或计算机Excel中的信息发布到网站。

您可以用它做什么?

1、 采集网页中的多条信息(标题/ URL /时间等),导出

从多个网页

2、批量处理采集信息并导出

3、批量访问打开的页面,例如,某些网站管理员需要批量向百度提交收录,一个人打开一个页面太麻烦了

软件下载地址:

高级进阶文章(写给网站管理员,普通人不需要理解,阅读使简单的软件更加复杂):

因此,如何使用它来采集条网站消息,并将其发布到我的网站

只需几个步骤:

1、在第文章页上编写抓取文章标题和内容的规则,并将其写下来。

2、使用“小工具”中的序列URL生成工具来生成一系列列表URL。如:list /1.html,list /2.html,list /3.html,...,list / 999.html,从其他网站的列表页中可以看到多少页],生成尽可能多的列表URL。

3、在匹配列表页面上编写并检索所有文章规则:也就是说,从列表页面中删除所有文章链接,进行匹配,然后将其导出

4、然后将在步骤3中得出的文章 URL输出为采集目标,并将其输出到URL框中。然后填写步骤1的规则,然后可以自动释放这些页面的文章标题和链接信息采集。

目前,网站某一列中文章的所有标题和链接都已采集并导出为excel,那么如何将该excel发布到我的网站?

5、手动将单元格合成为excel中post提交的信息格式。例如:title = kkno1&content = com

6、提交URL并填写文章发布背景的帖子接收URL,并在软件中完成协议标头的cookie信息(模拟网站管理员在后台登录),然后在帖子参数中填写步骤5生成的帖子提交格式,单击批量处理,软件可以自动批量发布方式,将此类信息一一提交到帖子接收页面,以实现自动发布功能。

从采集到发行的完整过程。似乎有很多步骤,实际上只有3场比赛。

干货教程:优采云新闻源文章采集器 关键词一键采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 240 次浏览 • 2020-11-30 13:15

帮助您采集 文章〜全新的采集方法〜一键输入关键词并采集您想要的文章!

优采云新闻来源文章采集器是仅需输入关键词至采集主搜索引擎新闻源和网页的软件。 优采云该软件专有的第一种智能算法可以准确地提取网页的文本部分,并将其另存为文章。它支持格式化处理,例如删除标签,链接,邮箱和插入关键词功能,该功能可以识别要在其旁边插入的标签或标点符号,并可以识别英语空格的插入。还有文章翻译功能,即文章可以从一种语言(例如中文)转换为另一种语言(例如英语或日语),然后再从英语或日语转换回中文。这是可以设置的翻译周期。翻译周期可以循环多次(翻译次数)。

优采云新闻来源文章采集器用于智能提取网页正文的算法。百度新闻,谷歌新闻和搜搜新闻强烈聚合了不时更新的新闻资源,用之不竭的多语言翻译伪原创。

优采云新闻来源文章采集器作用范围:

1、按关键词 采集 Internet 文章并翻译伪原创,这是网站管理员朋友的首选。

2、适用于信息公共关系公司采集来过滤和完善信息材料(成千上万的专业公司的软件,矿工需要花费数百美元)

采集 文章+ translation 伪原创可以满足各个领域的大多数网站管理员的文章需求。一些公共关系处理和信息调查公司所需要的由专业公司开发的信息采集系统通常售价为数万甚至更多。 优采云的软件也是具有功能的信息采集系统,它与市场上昂贵的软件有共同点,但价格仅为几百元,您将知道如何试用。

更新日志:

版本v1.02日期2013-9-7:

1.解决了删除标题中所有空格(仅删除第一个和最后一个空格)的问题;

2.将转换器参数分隔到主界面;添加单词插入选项;

3.修改了提取文本的算法(类似于百度的经验,更容易识别文章);

4.改进了删除链接时不删除图像地址的方法;

5.提高了删除标签时保留指定标签的能力;许多其他改进。

有关更多移动新闻软件的内容,请输入Hiker移动台的主题: 查看全部

优采云新闻来源文章采集器关键词一键采集

帮助您采集 文章〜全新的采集方法〜一键输入关键词并采集您想要的文章!

优采云新闻来源文章采集器是仅需输入关键词至采集主搜索引擎新闻源和网页的软件。 优采云该软件专有的第一种智能算法可以准确地提取网页的文本部分,并将其另存为文章。它支持格式化处理,例如删除标签,链接,邮箱和插入关键词功能,该功能可以识别要在其旁边插入的标签或标点符号,并可以识别英语空格的插入。还有文章翻译功能,即文章可以从一种语言(例如中文)转换为另一种语言(例如英语或日语),然后再从英语或日语转换回中文。这是可以设置的翻译周期。翻译周期可以循环多次(翻译次数)。

优采云新闻来源文章采集器用于智能提取网页正文的算法。百度新闻,谷歌新闻和搜搜新闻强烈聚合了不时更新的新闻资源,用之不竭的多语言翻译伪原创。

优采云新闻来源文章采集器作用范围:

1、按关键词 采集 Internet 文章并翻译伪原创,这是网站管理员朋友的首选。

2、适用于信息公共关系公司采集来过滤和完善信息材料(成千上万的专业公司的软件,矿工需要花费数百美元)

采集 文章+ translation 伪原创可以满足各个领域的大多数网站管理员的文章需求。一些公共关系处理和信息调查公司所需要的由专业公司开发的信息采集系统通常售价为数万甚至更多。 优采云的软件也是具有功能的信息采集系统,它与市场上昂贵的软件有共同点,但价格仅为几百元,您将知道如何试用。

更新日志:

版本v1.02日期2013-9-7:

1.解决了删除标题中所有空格(仅删除第一个和最后一个空格)的问题;

2.将转换器参数分隔到主界面;添加单词插入选项;

3.修改了提取文本的算法(类似于百度的经验,更容易识别文章);

4.改进了删除链接时不删除图像地址的方法;

5.提高了删除标签时保留指定标签的能力;许多其他改进。

有关更多移动新闻软件的内容,请输入Hiker移动台的主题:

最新版本:网页文字采集器v6.0 绿色版

采集交流 • 优采云 发表了文章 • 0 个评论 • 306 次浏览 • 2020-11-09 12:02

这是根据客户要求开发的网页文本采集器,可以自动检索指定网页上的所有文本。它可能会突破一些禁止复制的电子书。通过简单的设置过程,它就可以工作。通常,网站管理员最希望他们可以向网站提供更多的内容,从而吸引更多的访问和页面浏览;一个接一个地输入文本既麻烦又无聊。因此,今天,编辑器向所有人推荐一个有用的网站 采集器。通常,采集系统就像一双眼睛,使您可以看得更远并且得到更多。该Amage 采集器可以从Internet采集各种图片,笑话,新闻,技术和其他信息,然后分类,编辑并发布到其网站系统。这个安美奇网站 采集器具有简单的界面和强大的功能!如果您喜欢此软件,请立即下载!

安美琪采集器功能

1、根据用户要求,添加了各种通用规则;

2、根据百度关键字采集相关内容的规则;

3、搜索与关键字采集相关的内容规则;

4、根据有道关键字采集相关内容的规则;

5、根据yahoo关键字采集相关内容的规则;

6、根据bing关键字采集相关的内容规则;

7、还支持列表类型采集,例如新闻,小说,下载等,您可以使用此软件采集;

8、支持替换指定的关键字,并支持在内容前后添加广告代码,每个人都可以一目了然;

9、添加了自定义采集方法,您可以自己添加采集内容和规则;

10、支持大多数语言,国内外大多数网页可以是采集,没有边界;

1 1、可以快速增加其自身网站的内容。

安美奇采集器使用说明

此版本是支持最基本的Access数据库的免费版本。不要修改数据库名称。 采集的内容在date.mdb中。如果数据库不同,请使用数据库导入和导出功能。

1.如果无法运行,请安装Microsoft的“ .net框架”,也可以在此网站上下载;如果您无法采集,请及时更新最新版本。

2.最后,我希望每个人都将支持该软件,并对该软件提出建议。

更新说明:

1:根据用户要求,添加了各种通用规则,

1. 1根据百度关键字采集相关内容的规则

1. 2搜索与关键字采集相关的内容的规则,

1. 3根据有道关键字采集相关内容的规则,

1. 4根据yahoo关键字采集相关内容的规则,

1. 5根据bing关键字采集的相关内容规则,

您可以快速增加自己网站的内容。

2:同时支持列表类型采集,例如新闻,小说,下载等,您可以使用此软件采集,

示例:单击“列出采集新浪规则”,然后有采集新浪新闻添加方法。

3:支持替换指定的关键字,并在内容前后添加广告代码。每个人乍一看都可以理解。

4:添加了自定义采集方法,您可以自行添加采集内容和规则

5:支持大多数语言,国内外大多数网页都可用采集,没有边界。

6:此版本是免费版本,支持最基本的Access数据库。不要修改数据库名称。

采集内容在date.mdb中,如果数据库不同,请使用数据库导入和导出功能。

7:如果无法运行,请安装Microsoft的.net框架。如果您无法采集,请更新到最新版本。

8:最后,我希望每个人都支持该软件,并对该软件提出建议。

更新日志(2020.07.16)

5.0添加了QQ群发和邮件群发服务

6.0修正了打开内容编辑自动关闭的错误。而且某些ajax不能单击错误。 查看全部

网页文字采集器v6.0绿色版本

这是根据客户要求开发的网页文本采集器,可以自动检索指定网页上的所有文本。它可能会突破一些禁止复制的电子书。通过简单的设置过程,它就可以工作。通常,网站管理员最希望他们可以向网站提供更多的内容,从而吸引更多的访问和页面浏览;一个接一个地输入文本既麻烦又无聊。因此,今天,编辑器向所有人推荐一个有用的网站 采集器。通常,采集系统就像一双眼睛,使您可以看得更远并且得到更多。该Amage 采集器可以从Internet采集各种图片,笑话,新闻,技术和其他信息,然后分类,编辑并发布到其网站系统。这个安美奇网站 采集器具有简单的界面和强大的功能!如果您喜欢此软件,请立即下载!

安美琪采集器功能

1、根据用户要求,添加了各种通用规则;

2、根据百度关键字采集相关内容的规则;

3、搜索与关键字采集相关的内容规则;

4、根据有道关键字采集相关内容的规则;

5、根据yahoo关键字采集相关内容的规则;

6、根据bing关键字采集相关的内容规则;

7、还支持列表类型采集,例如新闻,小说,下载等,您可以使用此软件采集;

8、支持替换指定的关键字,并支持在内容前后添加广告代码,每个人都可以一目了然;

9、添加了自定义采集方法,您可以自己添加采集内容和规则;

10、支持大多数语言,国内外大多数网页可以是采集,没有边界;

1 1、可以快速增加其自身网站的内容。

安美奇采集器使用说明

此版本是支持最基本的Access数据库的免费版本。不要修改数据库名称。 采集的内容在date.mdb中。如果数据库不同,请使用数据库导入和导出功能。

1.如果无法运行,请安装Microsoft的“ .net框架”,也可以在此网站上下载;如果您无法采集,请及时更新最新版本。

2.最后,我希望每个人都将支持该软件,并对该软件提出建议。

更新说明:

1:根据用户要求,添加了各种通用规则,

1. 1根据百度关键字采集相关内容的规则

1. 2搜索与关键字采集相关的内容的规则,

1. 3根据有道关键字采集相关内容的规则,

1. 4根据yahoo关键字采集相关内容的规则,

1. 5根据bing关键字采集的相关内容规则,

您可以快速增加自己网站的内容。

2:同时支持列表类型采集,例如新闻,小说,下载等,您可以使用此软件采集,

示例:单击“列出采集新浪规则”,然后有采集新浪新闻添加方法。

3:支持替换指定的关键字,并在内容前后添加广告代码。每个人乍一看都可以理解。

4:添加了自定义采集方法,您可以自行添加采集内容和规则

5:支持大多数语言,国内外大多数网页都可用采集,没有边界。

6:此版本是免费版本,支持最基本的Access数据库。不要修改数据库名称。

采集内容在date.mdb中,如果数据库不同,请使用数据库导入和导出功能。

7:如果无法运行,请安装Microsoft的.net框架。如果您无法采集,请更新到最新版本。

8:最后,我希望每个人都支持该软件,并对该软件提出建议。

更新日志(2020.07.16)

5.0添加了QQ群发和邮件群发服务

6.0修正了打开内容编辑自动关闭的错误。而且某些ajax不能单击错误。

正式发布:一键采集天涯帖子正式版 4.0.0

采集交流 • 优采云 发表了文章 • 0 个评论 • 339 次浏览 • 2020-09-07 06:58

问题:为什么Discuz论坛必须安装采集插件?

答案:让我反问一下。如果您没有安装采集插件,却原创写了文章,那么您可以写几篇文章? ?我相信9 9. 9%的人不会完全原创的所有内容,他们会重印其他网站的某些内容,包括一些xx日报,xx电视台,并且或多或少会重印其他网站为了获得高质量的内容,请在Discuz论坛中安装采集插件,主要是为了帮助您和管理自己的网站内容。由于您必须手动重新发布内容,为什么不更有效地使用它,没有错误并且易于使用采集工具,您可以用更少的钱做更多的事情吗? ?

问题:采集的内容,百度知道收录吗? ?如何进行SEO优化? ?

答案:当一条新闻发布时,您会在百度搜索中发现很多重复的内容文章也是收录。实际上,这些重复的内容会被重印,因此采集百度的内容也会收录,尤其是最新的原创内容会及时出现采集并同时发布,以便您的收录和[ 原创是相同的,为了更好地改善SEO 收录优化,除了及时采集最新原创内容外,最好采集拒绝百度收录的某些平台内容,例如:微信公众号文章,除采集之外,您还需要登录才能看到内容,某些内容由ajax加载等。百度无法抓取此类内容。如果您发布此类内容,则SEO 收录会更好,排名会更好! !

问题:采集的内容会侵权吗? ?

答案:一些有助于社会正常运转的内容。允许根据法规复制此类内容。例如,最近的新冠状肺炎非常严重,一些公开报道与该流行病有关。由于这些流行病,这些都没有问题。人们越了解预防和控制信息,越好! !对流行病的预防和控制更有帮助,采集这样的内容没问题!还有一种内容对某家公司有负面影响。某公司的公关人员将通知您删除内容。只要您合作删除内容,就可以了! !内容中只有很小一部分申请了版权。如果您不小心重印了它,则可能会受到版权所有者的起诉。这是一个低概率事件,您通常不会遇到! ! Zhiwu应用程序的采集插件支持发布前的审查。如果它不支持采集版本则不予审查! !确保采集内容的安全! !因为采集的每条内容都会在发布采集之前由您进行审核。

问题:Zhiwu应用程序可靠吗?会撒谎吗?

答案:非常可靠! ! Zhiwu所应用的产品在上线之前,将经过严格的测试和代码质量审查,以确保它们安全,可用和易于使用。所有产品通过评估后,才可以申请上架! !同时,源代码是打开的。任何人都可以查看原创的透明代码。具有技术能力的用户可以轻松快速地进行二次开发。智物应用的任何产品都可以免费试用,满意后将予以考虑。您需要升级到正式的商业版本吗?如果发现安装后无法使用它,则可以联系在线客户服务来解决。如果您遇到无法解决的问题,则无法使用该插件,并且将全额退款。一般原则是让用户安全无风险,准确找到他们的需求,并购买可以使用的插件模块。如果他们发现购买后不可用,Zhiwu应用程序将为您退款。如果您真的需要它,请放心购买Zhiwu app各种产品! ! !智物App一直认真听取用户的反馈意见,根据用户的建议不断升级和更新产品,尊重用户的权利和合理的要求! !将用户置于最高位置,竭诚为他们服务! !

问题:Zhiwu App的采集插件有哪些亮点和优势?

答案:大多数人都使用Chrome扩展程序采集程序,因此您需要在网络浏览器chrome中安装扩展程序,因为经过研究,发现将浏览器变成采集工具是最可靠的,成熟稳定采集方式!一些传统的采集方法通过程序抓取功能来获取采集内容,尽管您不需要安装chrome扩展程序,但经常会遇到问题,当遇到没有内容的采集时,事情常常会发生! !

问题:Zhiwu App开发了哪些采集插件?

答案:很多! !多年来,我们一直专注于采集插件的研发。经过多次升级和更新,我们在采集插件的开发方面积累了丰富的经验。如果找不到所需的采集插件,请向Zhiwu App在线客户服务反馈。

问题:Zhiwu App的采集哪个插件易于使用?

答案:核心技术相同,但是采集规则不同。 Zhiwu使用的采集插件都很容易使用。主要取决于您需要哪个网站,然后使用网站阶段对应的采集插件。

问题:我一点都不了解这项技术,但是我想使用Zhiwu App的Discuz 采集插件。我该怎么办?

回答:请联系Zhiwu App的在线客户服务来帮助您在线安装和配置它,直到插件完全可用为止! !您不需要了解技术,售后服务就会帮助您解决所有问题。

问题:为什么要使用Chrome扩展程序采集程序? ?

答案:因为此采集方法最稳定,最成熟! !网页是通过浏览器的HTML代码呈现的,因此将浏览器变成采集工具,所见即所得的方法是最好的。

问题:chrome扩展程序安全吗? ?为什么弹出“请禁用在开发人员模式下运行的扩展程序”

答案:只要安装了chrome扩展程序,无论使用什么chrome扩展程序,都会弹出此提醒:“以开发人员模式运行的扩展程序可能会损害您的计算机。如果您不是开发人员,那么出于安全考虑,应该禁用在开发人员模式下运行的扩展程序。”这就像在百货商店中提醒您:“如果发生火灾,请致电119。”就像提醒您拨打119一样,这并不意味着您遇到了Fire,这只是一条提醒消息! ! Zhiwu应用程序的Chrome扩展程序已经过多方人工检查,检查和测试,是安全可靠的扩展程序! !

问题:我可以无人看管并自动采集内容吗? ?

答案:不! !全自动采集内容并发布,因此采集内容并不安全! !智物App的采集插件经过审查后发布,以确保内容的质量和安全! !未经您的同意,您无法自动发布内容! !如果您需要在短时间内发布大量内容采集以填写网站,则可以在[待发布]中选择[批量发布带有chrome扩展名的内容]。 查看全部

一键点击采集 Tianya Post正式版4. 0. 0

问题:为什么Discuz论坛必须安装采集插件?

答案:让我反问一下。如果您没有安装采集插件,却原创写了文章,那么您可以写几篇文章? ?我相信9 9. 9%的人不会完全原创的所有内容,他们会重印其他网站的某些内容,包括一些xx日报,xx电视台,并且或多或少会重印其他网站为了获得高质量的内容,请在Discuz论坛中安装采集插件,主要是为了帮助您和管理自己的网站内容。由于您必须手动重新发布内容,为什么不更有效地使用它,没有错误并且易于使用采集工具,您可以用更少的钱做更多的事情吗? ?

问题:采集的内容,百度知道收录吗? ?如何进行SEO优化? ?