网站内容采集系统

网站内容采集系统(新闻网站来源较多,网站改版较为基于模板的正文提取技术)

采集交流 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2022-02-17 08:02

【摘要】 随着互联网的日益繁荣,互联网上的信息资源越来越多。虽然方便了人们获取知识,但也带来了信息过多、噪声信息较多的问题,影响了用户对有效信息的搜索。网络新闻作为一种主流的互联网信息源,比其他信息源具有更大的研究价值。对互联网新闻进行准确高效的采集分类是非常必要的。意义。基于网页内容的新闻分类可以充分考虑新闻内容的语义,避免因网站对新闻的错误分类或未分类而导致的采集错误结果,具有更好的分类效果。论文对网页正文采集技术进行了深入研究,结合新闻网站的特点,制定了更有效的采集策略和更新策略,确保新闻采集 @采集 的效率。由于网站新闻来源众多,网站修改频繁,基于模板的文本提取技术无法保证提取的准确性。一种基于文本分布的通用文本提取算法,通过实验确定算法的最优值,降低了人工编写规则的时间成本。对于文本分类,本文研究分析了文本分类的整体过程,并选择Labeled LDA进行文本特征表示。与传统的向量空间模型相比,减少了特征维度,避免了语义信息的丢失。LDA 模型扩展为具有监督分类模型。通过文本分类方法的比较,选择支持向量机作为文本特征的分类器。本文选取搜狗中文实验室新闻语料库,使用JGibbLabeledLDA和Scikit-learn实现LLDA-SVM算法。通过将分类结果与其他方法进行比较,验证分类方法的有效性,并将训练好的模型用于新文本。为分类做准备。论文实现了基于B/S架构的采集和网页分类系统,给出了各个系统模块的具体设计和实现,并从采集方面对系统进行了评价。性能和分类精度。进行了评估以验证该系统的可行性。 查看全部

网站内容采集系统(新闻网站来源较多,网站改版较为基于模板的正文提取技术)

【摘要】 随着互联网的日益繁荣,互联网上的信息资源越来越多。虽然方便了人们获取知识,但也带来了信息过多、噪声信息较多的问题,影响了用户对有效信息的搜索。网络新闻作为一种主流的互联网信息源,比其他信息源具有更大的研究价值。对互联网新闻进行准确高效的采集分类是非常必要的。意义。基于网页内容的新闻分类可以充分考虑新闻内容的语义,避免因网站对新闻的错误分类或未分类而导致的采集错误结果,具有更好的分类效果。论文对网页正文采集技术进行了深入研究,结合新闻网站的特点,制定了更有效的采集策略和更新策略,确保新闻采集 @采集 的效率。由于网站新闻来源众多,网站修改频繁,基于模板的文本提取技术无法保证提取的准确性。一种基于文本分布的通用文本提取算法,通过实验确定算法的最优值,降低了人工编写规则的时间成本。对于文本分类,本文研究分析了文本分类的整体过程,并选择Labeled LDA进行文本特征表示。与传统的向量空间模型相比,减少了特征维度,避免了语义信息的丢失。LDA 模型扩展为具有监督分类模型。通过文本分类方法的比较,选择支持向量机作为文本特征的分类器。本文选取搜狗中文实验室新闻语料库,使用JGibbLabeledLDA和Scikit-learn实现LLDA-SVM算法。通过将分类结果与其他方法进行比较,验证分类方法的有效性,并将训练好的模型用于新文本。为分类做准备。论文实现了基于B/S架构的采集和网页分类系统,给出了各个系统模块的具体设计和实现,并从采集方面对系统进行了评价。性能和分类精度。进行了评估以验证该系统的可行性。

网站内容采集系统(怎么用免费dede采集插件把关键词优化到首页让网站能快速收录)

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2022-02-16 22:17

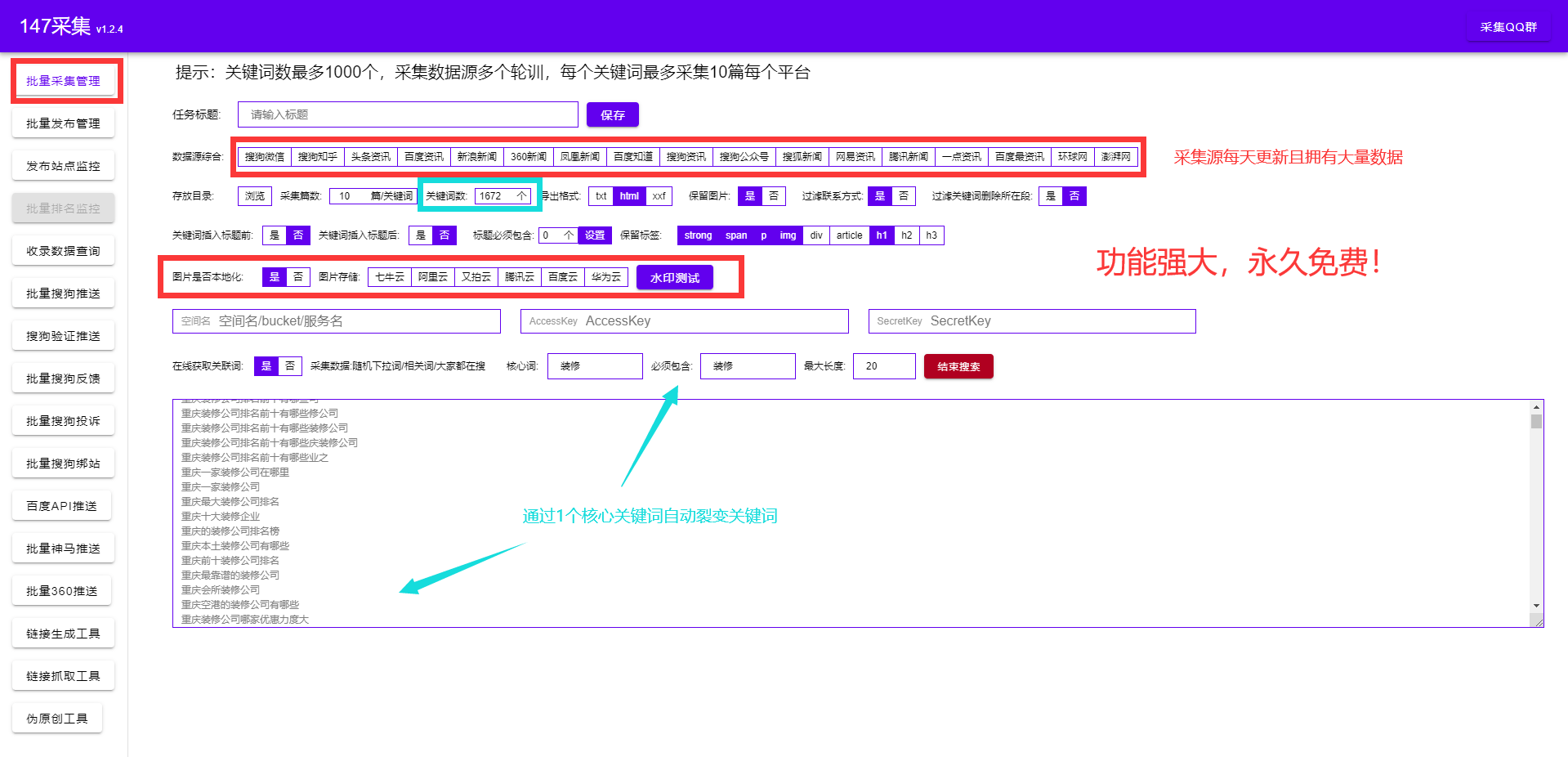

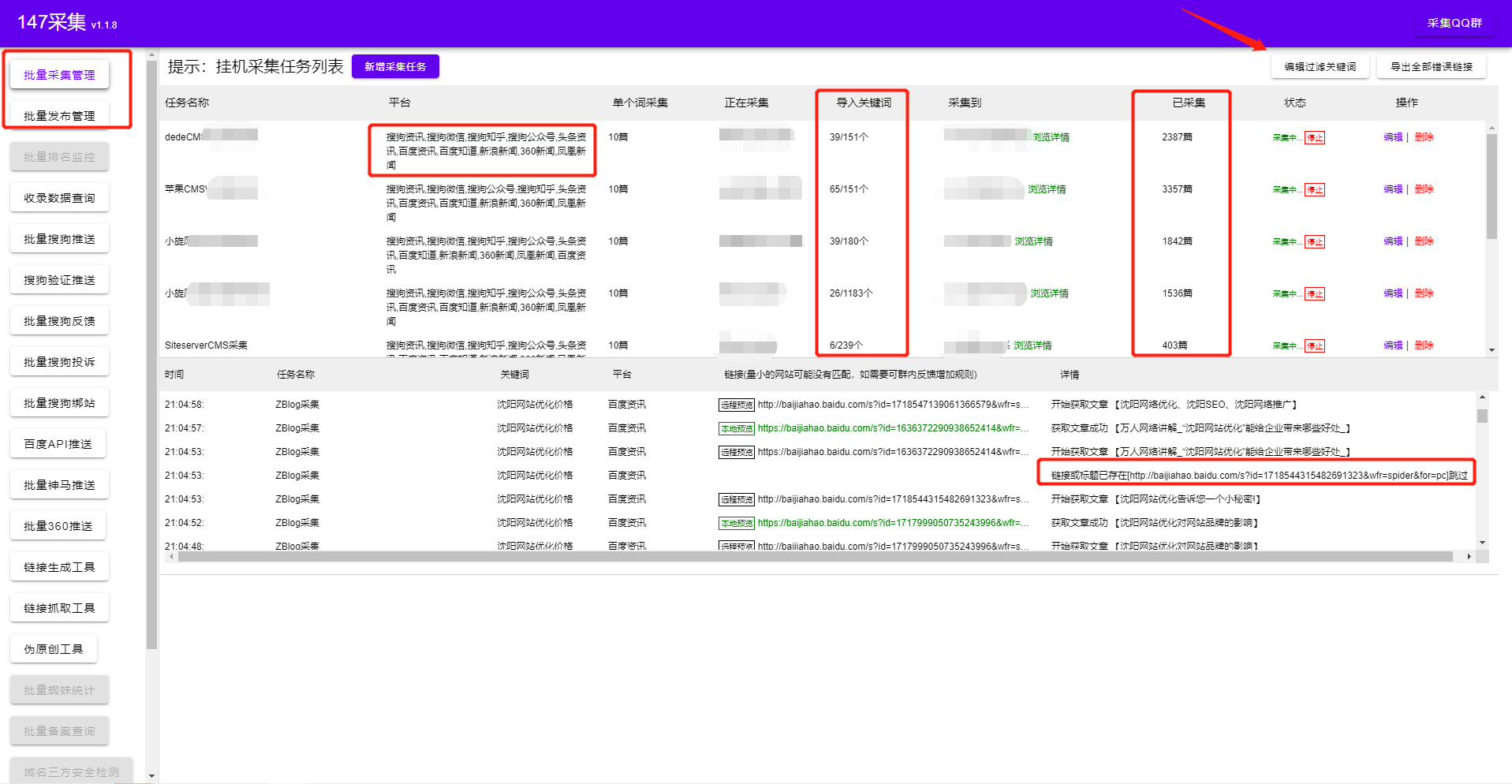

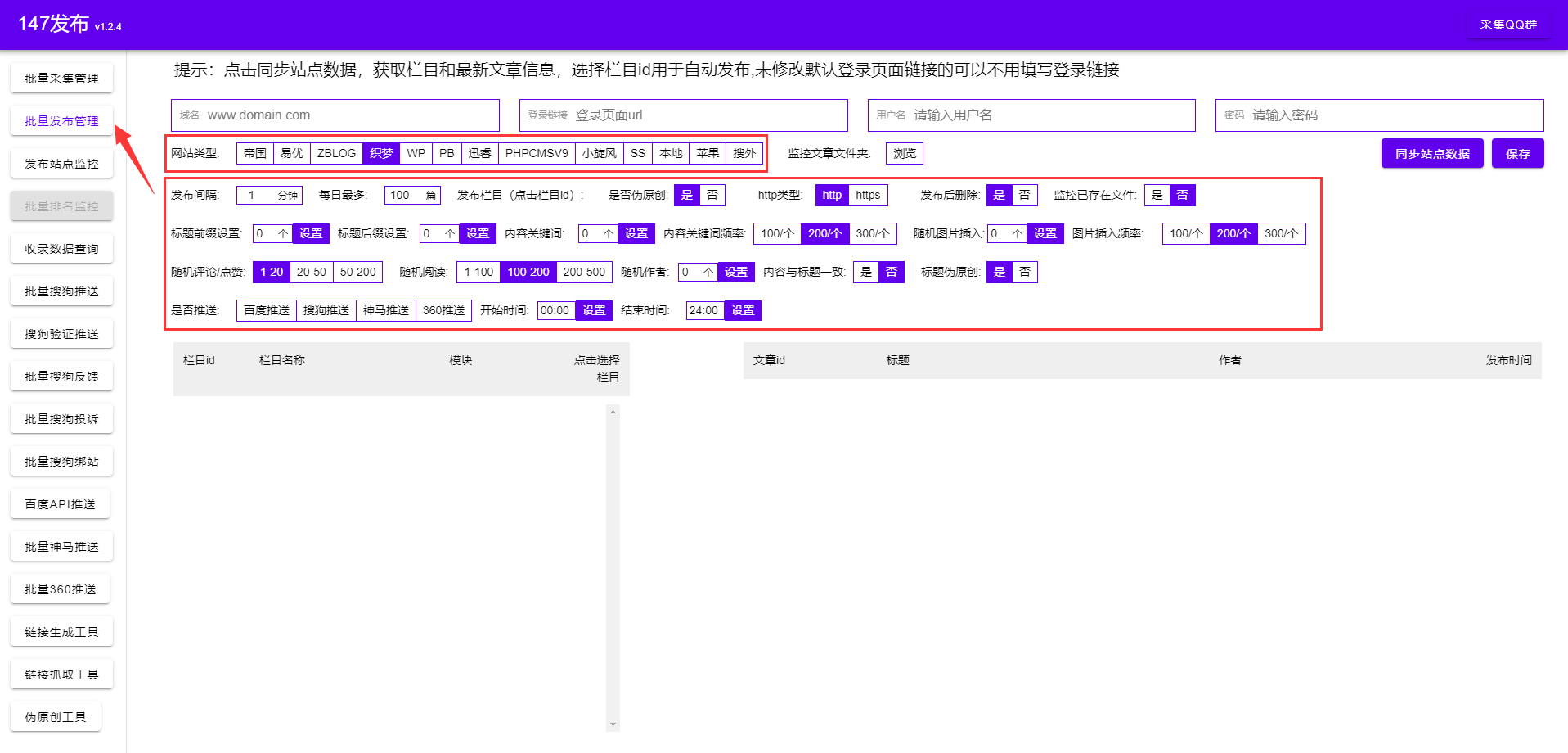

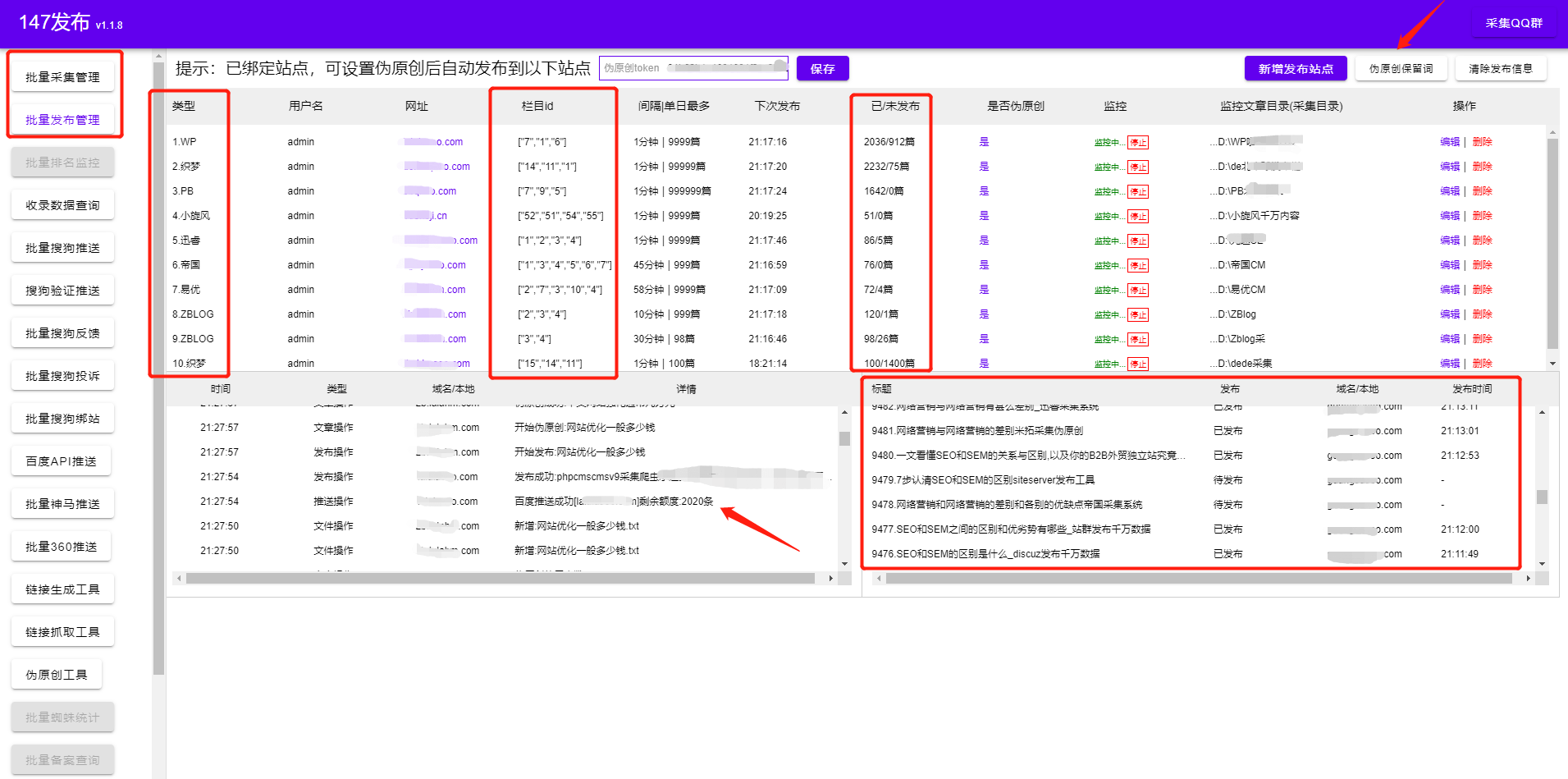

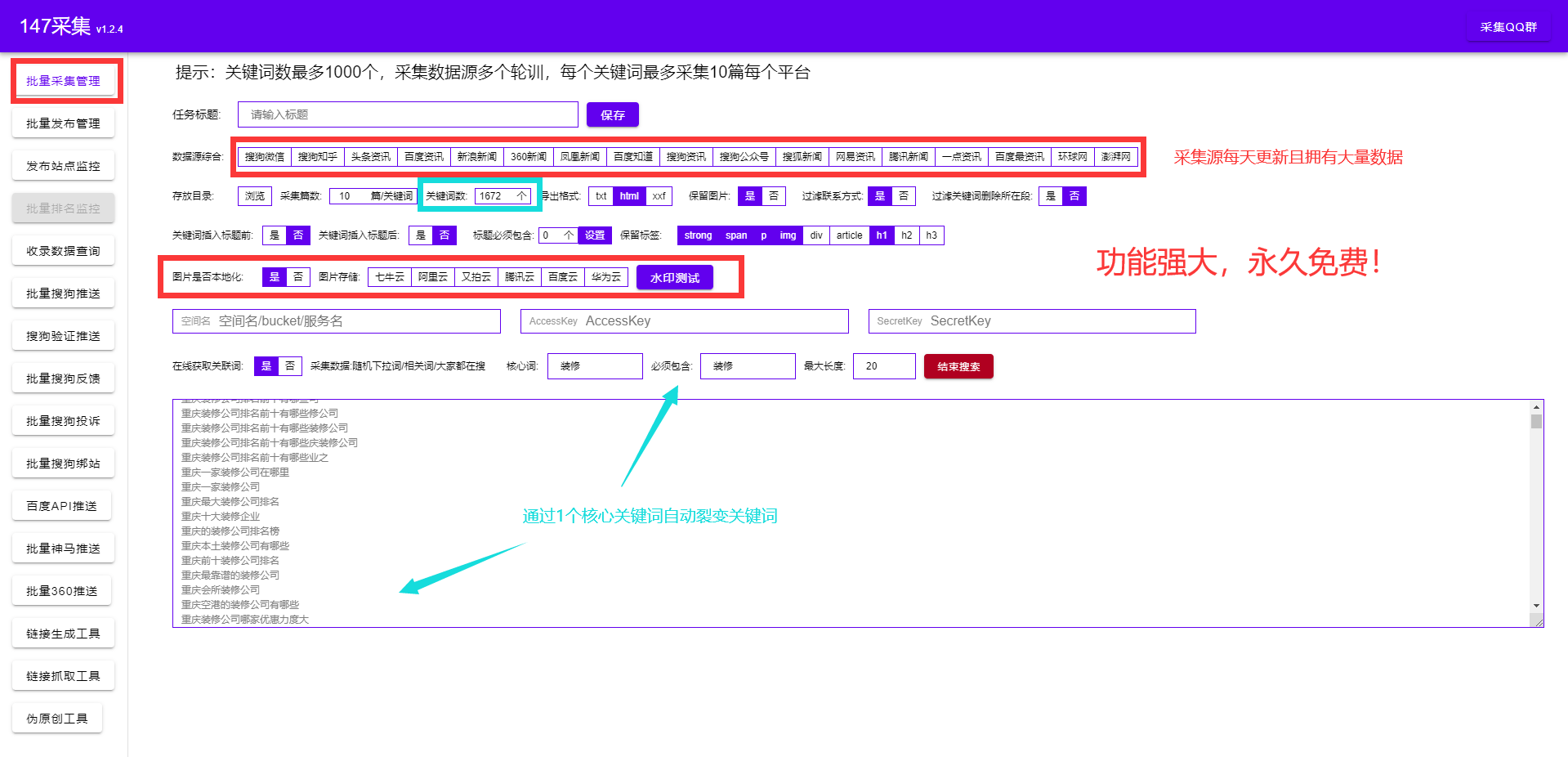

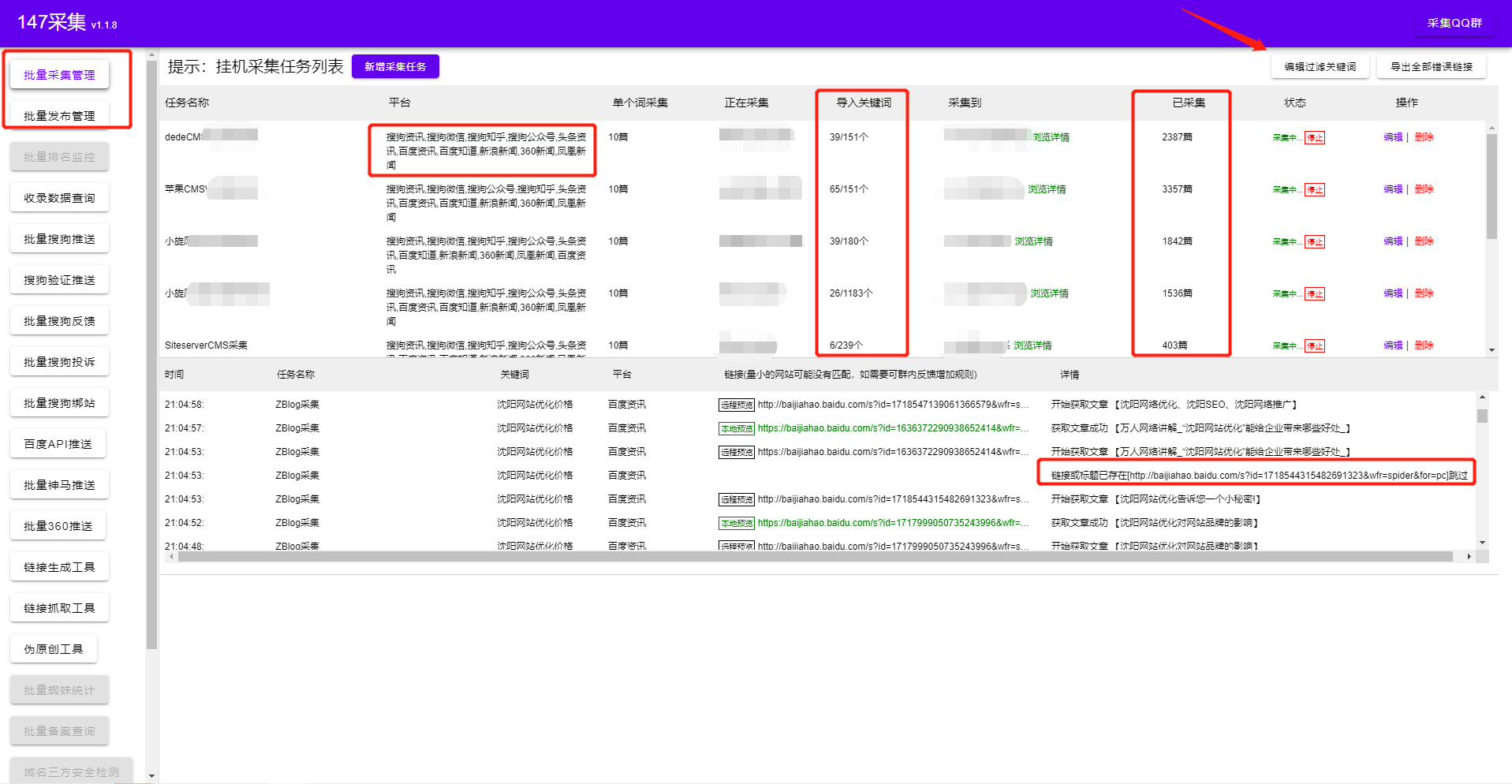

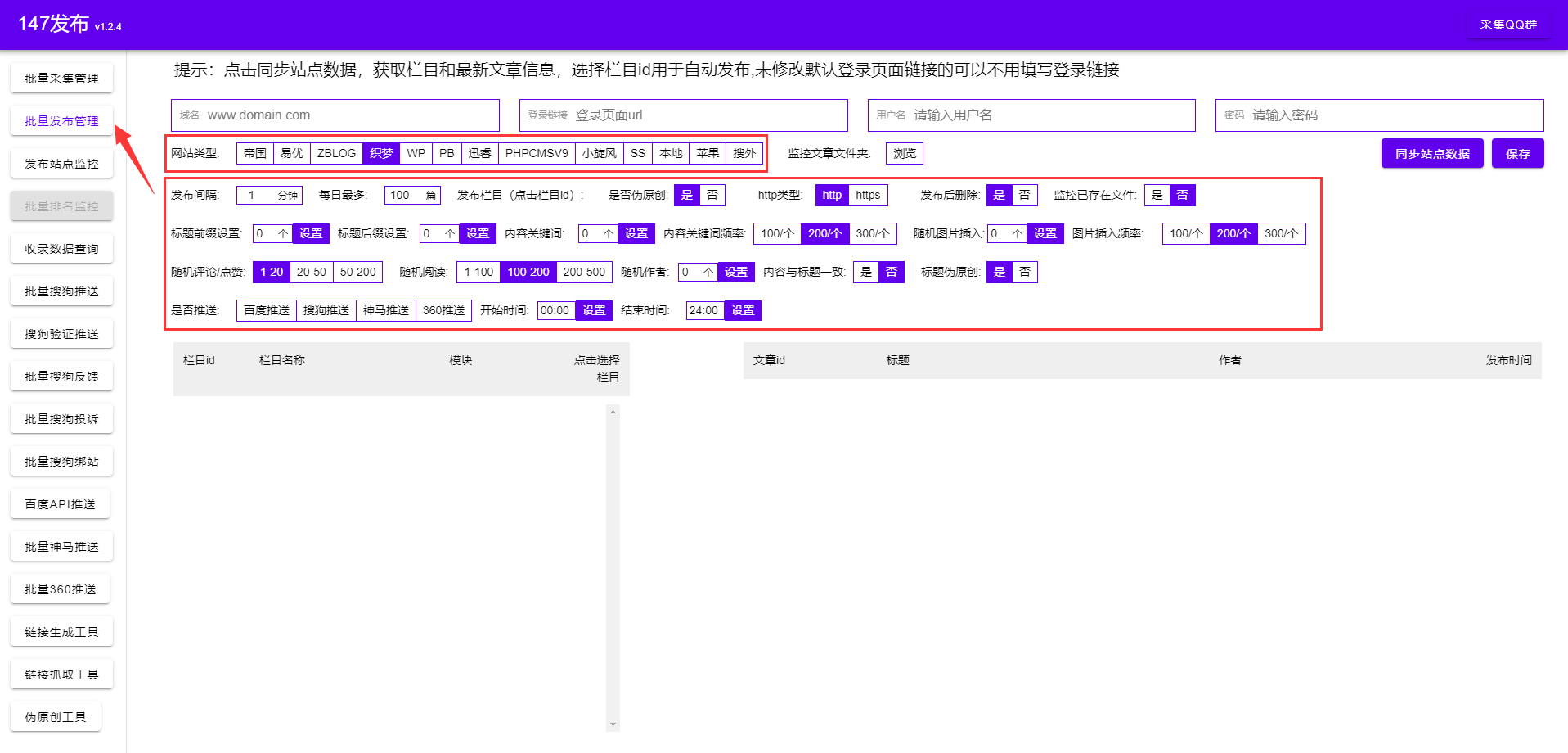

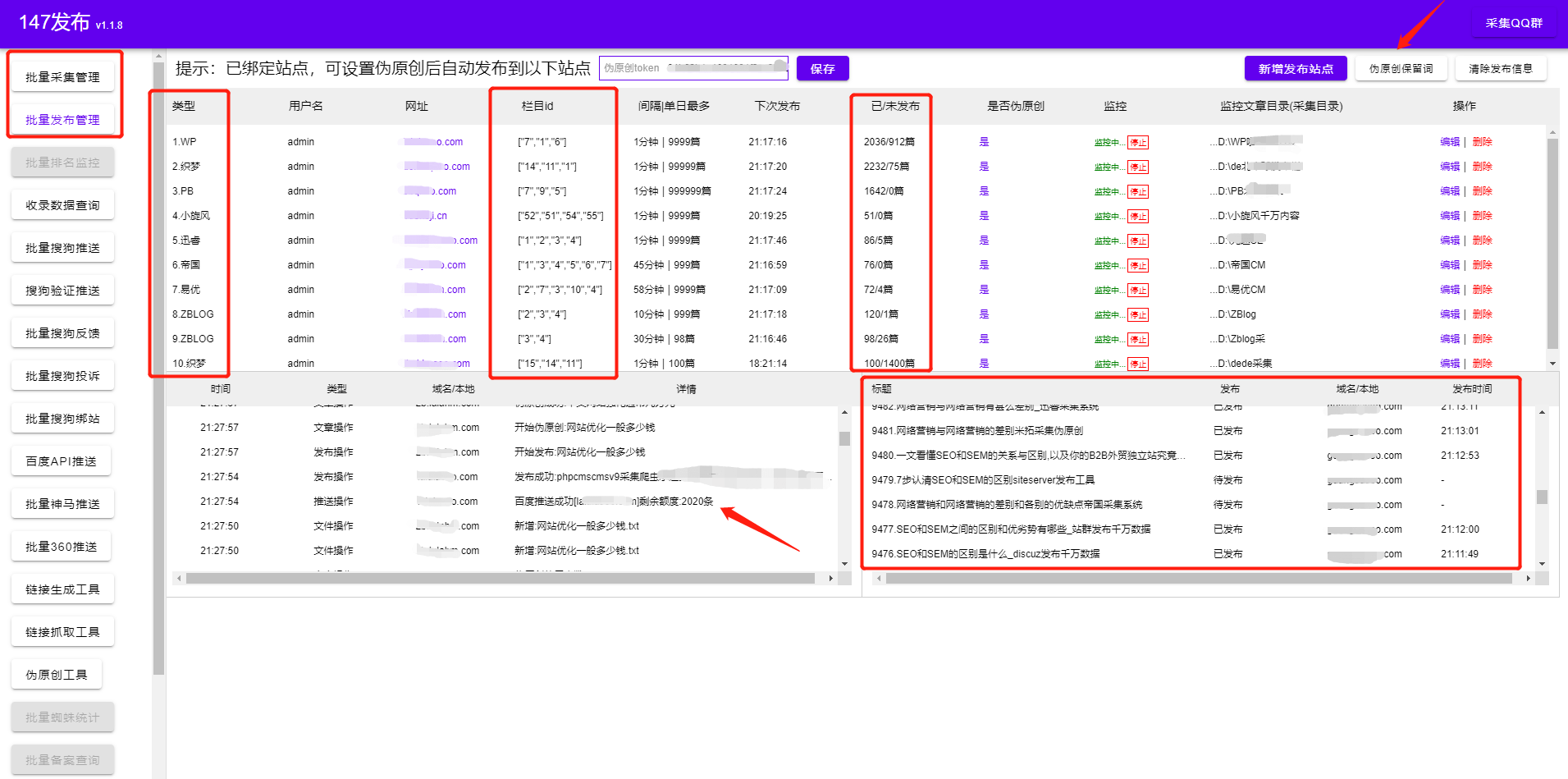

如何使用免费的dede采集插件将关键词优化到首页,使网站可以快速收录,包括所有SEO优化功能,并支持所有网站@ > 使用。在做业务网站优化的时候,经常会遇到很多问题,比如网站原创没有内容收录,收录后面没有排名,但是如果有怎么办排行?连首页都没有。因此,我们需要系统地对企业网站的优化做出很好的诊断,帮助我们调整网站的细节,更好的提高网站的权重。以下是企业网站优化诊断的三个方面,希望能帮助您更好地诊断自己的网站。

诊断前网站,教大家如何快速搭建原创高质量文章,使用免费的dede采集插件这个插件不用多学专业技能,简单几步即可轻松采集内容数据,用户只需对dede采集插件进行简单设置,完成后dede采集插件-in 会根据用户设置的关键词高精度匹配内容和图片可以保存在本地,也可以在伪原创之后发布,提供方便快捷的内容采集伪原创发布网站 @>推送服务!!

和其他dede采集插件相比,这个dede采集插件基本没有门槛,不需要花很多时间学习正则表达式或者html标签,一分钟就能上手,只需输入关键词即可实现采集(dede采集插件也自带关键词采集功能)。一路挂断!设置任务自动执行采集伪原创发布和推送任务。几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这个dede采集插件工具也配置了很多SEO功能,通过采集伪原创软件发布后还可以提升很多SEO方面。

例如:设置自动下载图片保存在本地或第三方(使内容不再有对方的外链)

自动内链(让搜索引擎更深入地抓取你的链接)、前后插入内容或标题,以及网站内容插入或随机作者、随机阅读等,形成“高原创 ”。

这些SEO小功能不仅提高了网站页面原创的度数,还间接提升了网站的收录排名。您可以通过软件工具上的监控管理直接查看文章采集的发布状态,不再需要每天登录网站后台查看。目前博主亲测软件是免费的,可以直接下载使用!有了这个dede采集插件,我们做网站优化,需要注意网站优化诊断三个方面

一、网站系统诊断

网站系统诊断 1

1. 空间速度

网站打开速度通常与2个方面有关:

一是页面上的图片数量,图片越多网站打开速度就会降低,所以优化网页上的图片非常重要。空间/服务器带宽太小。如果网站的流量很大,那么带宽就比较小,容易造成网站打不开,所以一般带宽的大小要根据大小来定网站 访问次数待定。影响网站速度的地方还有很多,但是随着互联网的发展和服务器配置的增加,很多影响空间速度的细节已经不用考虑了。

2. 网站代码

现在很多公司网站都在开发dedecms、empirecms、phpcms等开源程序,所以程序没必要多想,只需要需要考虑程序安全设置。

影响企业优化的网站就是网站页面的代码,比如table标签(已经不适用了,现在已经发展到html5了),比如js文件(最少如果不需要),如css文件(最好删除冗余代码)等。

最重要的是移动互联网的发展和html5+css3的普及,所以对于网站页面代码规范也很重要,可以帮助搜索引擎更好的识别。

网站系统诊断二

1. 网址

url要标准化,即首页URL尽量不要有index这个后缀,栏目页和文章页尽量是静态的(地址不带任何参数,如不?)。如果能更好的识别url,将进一步提高网站的优化标准,看起来非常简洁,清爽,通俗易懂。

2. 三个标签

主要是标题标签(带关键词)、关键词标签(页面关键词和页面扩展关键词)、描述标签(2-3次页面关键词) . 查看全部

网站内容采集系统(怎么用免费dede采集插件把关键词优化到首页让网站能快速收录)

如何使用免费的dede采集插件将关键词优化到首页,使网站可以快速收录,包括所有SEO优化功能,并支持所有网站@ > 使用。在做业务网站优化的时候,经常会遇到很多问题,比如网站原创没有内容收录,收录后面没有排名,但是如果有怎么办排行?连首页都没有。因此,我们需要系统地对企业网站的优化做出很好的诊断,帮助我们调整网站的细节,更好的提高网站的权重。以下是企业网站优化诊断的三个方面,希望能帮助您更好地诊断自己的网站。

诊断前网站,教大家如何快速搭建原创高质量文章,使用免费的dede采集插件这个插件不用多学专业技能,简单几步即可轻松采集内容数据,用户只需对dede采集插件进行简单设置,完成后dede采集插件-in 会根据用户设置的关键词高精度匹配内容和图片可以保存在本地,也可以在伪原创之后发布,提供方便快捷的内容采集伪原创发布网站 @>推送服务!!

和其他dede采集插件相比,这个dede采集插件基本没有门槛,不需要花很多时间学习正则表达式或者html标签,一分钟就能上手,只需输入关键词即可实现采集(dede采集插件也自带关键词采集功能)。一路挂断!设置任务自动执行采集伪原创发布和推送任务。几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这个dede采集插件工具也配置了很多SEO功能,通过采集伪原创软件发布后还可以提升很多SEO方面。

例如:设置自动下载图片保存在本地或第三方(使内容不再有对方的外链)

自动内链(让搜索引擎更深入地抓取你的链接)、前后插入内容或标题,以及网站内容插入或随机作者、随机阅读等,形成“高原创 ”。

这些SEO小功能不仅提高了网站页面原创的度数,还间接提升了网站的收录排名。您可以通过软件工具上的监控管理直接查看文章采集的发布状态,不再需要每天登录网站后台查看。目前博主亲测软件是免费的,可以直接下载使用!有了这个dede采集插件,我们做网站优化,需要注意网站优化诊断三个方面

一、网站系统诊断

网站系统诊断 1

1. 空间速度

网站打开速度通常与2个方面有关:

一是页面上的图片数量,图片越多网站打开速度就会降低,所以优化网页上的图片非常重要。空间/服务器带宽太小。如果网站的流量很大,那么带宽就比较小,容易造成网站打不开,所以一般带宽的大小要根据大小来定网站 访问次数待定。影响网站速度的地方还有很多,但是随着互联网的发展和服务器配置的增加,很多影响空间速度的细节已经不用考虑了。

2. 网站代码

现在很多公司网站都在开发dedecms、empirecms、phpcms等开源程序,所以程序没必要多想,只需要需要考虑程序安全设置。

影响企业优化的网站就是网站页面的代码,比如table标签(已经不适用了,现在已经发展到html5了),比如js文件(最少如果不需要),如css文件(最好删除冗余代码)等。

最重要的是移动互联网的发展和html5+css3的普及,所以对于网站页面代码规范也很重要,可以帮助搜索引擎更好的识别。

网站系统诊断二

1. 网址

url要标准化,即首页URL尽量不要有index这个后缀,栏目页和文章页尽量是静态的(地址不带任何参数,如不?)。如果能更好的识别url,将进一步提高网站的优化标准,看起来非常简洁,清爽,通俗易懂。

2. 三个标签

主要是标题标签(带关键词)、关键词标签(页面关键词和页面扩展关键词)、描述标签(2-3次页面关键词) .

网站内容采集系统(走进SEO优化网站的禁区,导致最后建站的失败!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2022-02-16 21:29

(中国电子商务研究中心讯)网站要想成功,除了自身的长期坚持,网站的SEO优化也少不了,因为SEO优化的重要性甚至让一些人由于网站优化综合症,我总觉得网站需要在这里和那里进行优化。其实网站的优化无非就是内容、链接、用户体验。有几个重要的方面,但是为了快速提升网站的排名,加快网站的建设进度,有人让自己去SEO优化的禁区网站,导致最终建站失败,让笔者带你走进SEO的五个领域!

1:所有内容采集或购买现成模板

<p>目前很多cms建站系统都有自己的采集系统,有的还集成了模板,包括网站的内容,让更多的人购买,自然网上充斥的正是相同的内容网站,只是改变了网站的标志和联系方式。通常这样的网站建起来很快,一两天就能得到非常丰富的内容,但是对于搜索引擎来说,这些内容都是垃圾。自然是很难把你的网站收录,DEDE自动采集拿到好的排名,所以更不可能拿到好的排名,所以建< 查看全部

网站内容采集系统(走进SEO优化网站的禁区,导致最后建站的失败!)

(中国电子商务研究中心讯)网站要想成功,除了自身的长期坚持,网站的SEO优化也少不了,因为SEO优化的重要性甚至让一些人由于网站优化综合症,我总觉得网站需要在这里和那里进行优化。其实网站的优化无非就是内容、链接、用户体验。有几个重要的方面,但是为了快速提升网站的排名,加快网站的建设进度,有人让自己去SEO优化的禁区网站,导致最终建站失败,让笔者带你走进SEO的五个领域!

1:所有内容采集或购买现成模板

<p>目前很多cms建站系统都有自己的采集系统,有的还集成了模板,包括网站的内容,让更多的人购买,自然网上充斥的正是相同的内容网站,只是改变了网站的标志和联系方式。通常这样的网站建起来很快,一两天就能得到非常丰富的内容,但是对于搜索引擎来说,这些内容都是垃圾。自然是很难把你的网站收录,DEDE自动采集拿到好的排名,所以更不可能拿到好的排名,所以建<

网站内容采集系统(aspx网站如何采集相关的博客查看更多优惠(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-02-12 16:00

阿里云>云栖社区>主题图>A>aspx网站 如何采集

推荐活动:

更多优惠>

当前话题:aspx网站如何采集加入采集

相关话题:

aspx网站 如何采集相关博客 查看更多博客

- 如何防止数据被高精度IP定位采集

作者:季风森林 2409人查看评论:04年前

自从现场推出高精度IP定位功能后,小编的这款半成品网站一下子就火了。文章原文发表于博客专栏,点此前往(

阅读全文

采集程序-【开源项目】

作者:zting Technology 755人 浏览评论:04年前

更新:通过一些朋友的回复得知文章可能太长了。有的朋友只是浏览了一下,对程序的工作流程还不太了解。简而言之,这个程序是为程序员准备的。要使用这个软件,你必须是会写正则表达式的朋友,或者是能帮你写正则表达式的朋友。这个程序不是为 网站 或网页编写的,而是一个“采集框架”——

阅读全文

采集程序-【开源项目】

作者:zting科技977人查看评论:04年前

更新:通过一些朋友的回复得知文章可能太长了。有的朋友只是浏览了一下,对程序的工作流程还不太了解。简而言之,这个程序是为程序员准备的。要使用这个软件,你必须是会写正则表达式的朋友,或者是能帮你写正则表达式的朋友。这个程序不是为 网站 或网页编写的,而是一个“采集框架”——

阅读全文

ASP.NET视频采集网站核心技术解析(用一个廉价的招数对付搜索引擎蜘蛛)

作者:技术小哥2061 浏览评论:04年前

许多网站管理员一开始是“垃圾站”。什么是“垃圾场”?说白了就是采集把别人的数据存到自己的数据库里,聚合、整理、分类,或者自己加点小修改,然后自己做一个程序,变成自己的网站 . 最流行的“垃圾站”大多在文章,因为文章更容易采集,而且数据量大,有利于

阅读全文

WebClient、HttpWebRequest、WebRequest无法获取的网页源码如何抓取,下面为你解答

作者:天道991850 浏览评论:03年前

//因为我爬的网页有很多困难,1、上面三个都拿不到源码,不管设置什么样的header请求都没用,2、只有webbrowser一个不能用于浏览页面操作。所以使用webbrowser和IE的组合抓取//项目流程-先打开IE,然后使用MSHtml中的方法操作IE表单翻页

阅读全文

谈谈程序员是如何学英语单词的:我写了一个记单词的小程序

作者:迟来凶猛 1965 看人评论:04年前

背景:英语对程序员的重要性就不多说了!英语有很多要学的,但我今天话不多,只有英语单词!关于单词的记忆,找了很多方法,下载了很多软件。如图(其他不好用的都卸载了): 上图是我之前用过的软件。注意是之前的~~~表示我没有坚持~~~~随着时间的推移

阅读全文

AI 不是呼吸机,也不是疫苗!滑铁卢大学教授呼吁:警惕浮华的新冠AI研究热潮!

作者:云栖信息哥791查看评论:01年前

云启资讯:【点击查看更多行业资讯】在这里您可以找到不同行业的第一手云资讯。还等什么,快来吧!【导读】我们不能因为封锁和隔离而放弃基本的科学原理。人工智能既不是呼吸机,也不是疫苗,也不是药丸。值得注意的是,根据一些

阅读全文

Windows日志的攻防

作者:玄雪江 1400人浏览评论:04年前

本文是关于Windows日志的攻防。从防御者的角度来看,日志分析是回溯攻击过程中不可或缺的一环。国内对这种日志的攻防研究很少。作者结合了自己的渗透过程。本文的一些经验会从攻击者的角度简单谈谈如何使用日志。希望这篇文章能够启发和改变国内的安全从业者。

阅读全文 查看全部

网站内容采集系统(aspx网站如何采集相关的博客查看更多优惠(组图))

阿里云>云栖社区>主题图>A>aspx网站 如何采集

推荐活动:

更多优惠>

当前话题:aspx网站如何采集加入采集

相关话题:

aspx网站 如何采集相关博客 查看更多博客

- 如何防止数据被高精度IP定位采集

作者:季风森林 2409人查看评论:04年前

自从现场推出高精度IP定位功能后,小编的这款半成品网站一下子就火了。文章原文发表于博客专栏,点此前往(

阅读全文

采集程序-【开源项目】

作者:zting Technology 755人 浏览评论:04年前

更新:通过一些朋友的回复得知文章可能太长了。有的朋友只是浏览了一下,对程序的工作流程还不太了解。简而言之,这个程序是为程序员准备的。要使用这个软件,你必须是会写正则表达式的朋友,或者是能帮你写正则表达式的朋友。这个程序不是为 网站 或网页编写的,而是一个“采集框架”——

阅读全文

采集程序-【开源项目】

作者:zting科技977人查看评论:04年前

更新:通过一些朋友的回复得知文章可能太长了。有的朋友只是浏览了一下,对程序的工作流程还不太了解。简而言之,这个程序是为程序员准备的。要使用这个软件,你必须是会写正则表达式的朋友,或者是能帮你写正则表达式的朋友。这个程序不是为 网站 或网页编写的,而是一个“采集框架”——

阅读全文

ASP.NET视频采集网站核心技术解析(用一个廉价的招数对付搜索引擎蜘蛛)

作者:技术小哥2061 浏览评论:04年前

许多网站管理员一开始是“垃圾站”。什么是“垃圾场”?说白了就是采集把别人的数据存到自己的数据库里,聚合、整理、分类,或者自己加点小修改,然后自己做一个程序,变成自己的网站 . 最流行的“垃圾站”大多在文章,因为文章更容易采集,而且数据量大,有利于

阅读全文

WebClient、HttpWebRequest、WebRequest无法获取的网页源码如何抓取,下面为你解答

作者:天道991850 浏览评论:03年前

//因为我爬的网页有很多困难,1、上面三个都拿不到源码,不管设置什么样的header请求都没用,2、只有webbrowser一个不能用于浏览页面操作。所以使用webbrowser和IE的组合抓取//项目流程-先打开IE,然后使用MSHtml中的方法操作IE表单翻页

阅读全文

谈谈程序员是如何学英语单词的:我写了一个记单词的小程序

作者:迟来凶猛 1965 看人评论:04年前

背景:英语对程序员的重要性就不多说了!英语有很多要学的,但我今天话不多,只有英语单词!关于单词的记忆,找了很多方法,下载了很多软件。如图(其他不好用的都卸载了): 上图是我之前用过的软件。注意是之前的~~~表示我没有坚持~~~~随着时间的推移

阅读全文

AI 不是呼吸机,也不是疫苗!滑铁卢大学教授呼吁:警惕浮华的新冠AI研究热潮!

作者:云栖信息哥791查看评论:01年前

云启资讯:【点击查看更多行业资讯】在这里您可以找到不同行业的第一手云资讯。还等什么,快来吧!【导读】我们不能因为封锁和隔离而放弃基本的科学原理。人工智能既不是呼吸机,也不是疫苗,也不是药丸。值得注意的是,根据一些

阅读全文

Windows日志的攻防

作者:玄雪江 1400人浏览评论:04年前

本文是关于Windows日志的攻防。从防御者的角度来看,日志分析是回溯攻击过程中不可或缺的一环。国内对这种日志的攻防研究很少。作者结合了自己的渗透过程。本文的一些经验会从攻击者的角度简单谈谈如何使用日志。希望这篇文章能够启发和改变国内的安全从业者。

阅读全文

网站内容采集系统(web网站信息采集系统的设计(一)说明实现过程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2022-02-11 06:09

Web网站信息采集系统设计方案 [摘要] 探讨利用.Net技术和数据库技术设计一个采集Web网站信息系统,并利用人才网站招聘信息的采集是一个例子来说明执行过程。提出基于Web的信息采集系统的设计方案,并使用. 网络技术和数据库技术,实现采集和特定网站信息的处理。[关键词]信息检索WEB技术ADO.NET CLC编号:TP3 文档识别码:A 文章编号:1671-7597(2008)1120081-01 随着WWW的发展,搜索引擎提供的搜索和导航服务已经成为互联网上非常重要的网络服务。它的特点是可以帮助我们快速找到想要的网站或信息。本文讨论了.Net技术、数据库技术的使用,设计了Web网站信息的采集系统,并以某人才网站招聘信息的采集为一个例子来说明实现过程。一、信息采集系统设计(一)采集系统设计思路首先要采集指定< @网站,要了解浏览信息的方式,记录对应的访问路径。网站大多是用动态web技术(ASP、PHP等)构建的,通过数据库检索参数传输,并输出相应的信息。二、

第三,考虑到网站可能会执行多次采集,需要避免在自己的数据库中存储重复信息,同时重复处理已有信息也会减少采集@ > 系统工作效率。因此,在记录每条信息的同时,可以记录对应的URL或相关ID,以方便验证链接是否被访问过。(二)相关技术 1.请求/响应模型。Web应用程序是基于HTTP协议的客户端/服务器请求-响应机制的信息交换。当我们在浏览器中输入一个URL时,需要建立一个连接、发送请求、发送响应、关闭连接四步,获取网页信息。在System.Net的命名空间中。Net框架,提供了WebRequest和WebResponse两个类,分别用于发送客户端请求和获取服务器返回的响应。。常用表达。正则表达式提供了一种强大、灵活和高效的文本处理方式。正则表达式的模式匹配可以快速分析大量文本以找到特定的字符模式;提取、编辑、替换或删除文本子字符串;或将提取的字符串添加到集合中。在.Net命名空间中System.Text.RegularExpressions提供了Regex类来构建正则表达式,也提供了相应的方法来完成字符串的匹配和过滤。3. ADO.Net.采集系统获取到的数据最终会存储在本地数据库中,数据库访问技术ADO.NET在.

它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。为了提高访问效率,还提供了SQL Server、SqlConnection、SqlCommand、SqlDataReader、Dataset、SqlDataAdapter等特殊类,完成对SQL Server数据库的访问和数据处理。(三)算法描述了待补信息的采集。首先要能在页面中过滤掉我们需要的链接的起点,然后系统模拟人工点击流程阅读信息 1.根据访问路径创建 C#自带的REGEX类的一个对象,是一个用于匹配正则表达式的文本类 2.通过WebRequest发送请求,WebResponse 接收返回的响应,然后通过 StreamReader 读取返回的响应,形成一个收录所有源字符串的网页。3.用正则表达式匹配字符串,得到Match采集集合,里面存储了我们需要进一步阅读的所有目标链接。4、遍历集合的成员,访问成员链接指向的页面,信息被StreamReader读取后,使用正则表达式提取页面信息。二、招聘信息采集系统的实现(一)读取招聘单位列表信息,打开web_url@>指定的网站页面,读取源代码网页通过StreamReader对象存储在字符串all_code中,方便正则表达式提取。

HttpWebRequestall_codeRequest=(HttpWebRequest)WebRequest.Create(web_url); WebResponseall_codeResponse=all_codeRequest.GetResponse(); StreamReaderthe_Reader=newStreamReader(all_codeResponse.GetResponseStream(), System.Text.Encoding.Default); stringall_code=the_Reader.ReadToEnd(); the_Reader.Close(); (二)提取招聘单位的超链接列表创建表达式字符串p,用它创建正则表达式对象re,并使用re.Matches方法返回all_code字符串的所有匹配超链接集hy .stringp=@".+";Regexre=newRegex(p,RegexOptions.IgnoreCase);Match采集hy=re.Matches(all_code);for(inti=0;i 查看全部

网站内容采集系统(web网站信息采集系统的设计(一)说明实现过程)

Web网站信息采集系统设计方案 [摘要] 探讨利用.Net技术和数据库技术设计一个采集Web网站信息系统,并利用人才网站招聘信息的采集是一个例子来说明执行过程。提出基于Web的信息采集系统的设计方案,并使用. 网络技术和数据库技术,实现采集和特定网站信息的处理。[关键词]信息检索WEB技术ADO.NET CLC编号:TP3 文档识别码:A 文章编号:1671-7597(2008)1120081-01 随着WWW的发展,搜索引擎提供的搜索和导航服务已经成为互联网上非常重要的网络服务。它的特点是可以帮助我们快速找到想要的网站或信息。本文讨论了.Net技术、数据库技术的使用,设计了Web网站信息的采集系统,并以某人才网站招聘信息的采集为一个例子来说明实现过程。一、信息采集系统设计(一)采集系统设计思路首先要采集指定< @网站,要了解浏览信息的方式,记录对应的访问路径。网站大多是用动态web技术(ASP、PHP等)构建的,通过数据库检索参数传输,并输出相应的信息。二、

第三,考虑到网站可能会执行多次采集,需要避免在自己的数据库中存储重复信息,同时重复处理已有信息也会减少采集@ > 系统工作效率。因此,在记录每条信息的同时,可以记录对应的URL或相关ID,以方便验证链接是否被访问过。(二)相关技术 1.请求/响应模型。Web应用程序是基于HTTP协议的客户端/服务器请求-响应机制的信息交换。当我们在浏览器中输入一个URL时,需要建立一个连接、发送请求、发送响应、关闭连接四步,获取网页信息。在System.Net的命名空间中。Net框架,提供了WebRequest和WebResponse两个类,分别用于发送客户端请求和获取服务器返回的响应。。常用表达。正则表达式提供了一种强大、灵活和高效的文本处理方式。正则表达式的模式匹配可以快速分析大量文本以找到特定的字符模式;提取、编辑、替换或删除文本子字符串;或将提取的字符串添加到集合中。在.Net命名空间中System.Text.RegularExpressions提供了Regex类来构建正则表达式,也提供了相应的方法来完成字符串的匹配和过滤。3. ADO.Net.采集系统获取到的数据最终会存储在本地数据库中,数据库访问技术ADO.NET在.

它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。为了提高访问效率,还提供了SQL Server、SqlConnection、SqlCommand、SqlDataReader、Dataset、SqlDataAdapter等特殊类,完成对SQL Server数据库的访问和数据处理。(三)算法描述了待补信息的采集。首先要能在页面中过滤掉我们需要的链接的起点,然后系统模拟人工点击流程阅读信息 1.根据访问路径创建 C#自带的REGEX类的一个对象,是一个用于匹配正则表达式的文本类 2.通过WebRequest发送请求,WebResponse 接收返回的响应,然后通过 StreamReader 读取返回的响应,形成一个收录所有源字符串的网页。3.用正则表达式匹配字符串,得到Match采集集合,里面存储了我们需要进一步阅读的所有目标链接。4、遍历集合的成员,访问成员链接指向的页面,信息被StreamReader读取后,使用正则表达式提取页面信息。二、招聘信息采集系统的实现(一)读取招聘单位列表信息,打开web_url@>指定的网站页面,读取源代码网页通过StreamReader对象存储在字符串all_code中,方便正则表达式提取。

HttpWebRequestall_codeRequest=(HttpWebRequest)WebRequest.Create(web_url); WebResponseall_codeResponse=all_codeRequest.GetResponse(); StreamReaderthe_Reader=newStreamReader(all_codeResponse.GetResponseStream(), System.Text.Encoding.Default); stringall_code=the_Reader.ReadToEnd(); the_Reader.Close(); (二)提取招聘单位的超链接列表创建表达式字符串p,用它创建正则表达式对象re,并使用re.Matches方法返回all_code字符串的所有匹配超链接集hy .stringp=@".+";Regexre=newRegex(p,RegexOptions.IgnoreCase);Match采集hy=re.Matches(all_code);for(inti=0;i

网站内容采集系统(相关专题如何制作网站?制作系统U盘的方法? )

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2022-02-06 18:20

)

相关话题

如何制作网站?你需要做什么来制作网站?

28/6/202018:03:11

如何制作网站?你需要做什么来制作网站?网站现在很常见,很多公司都有自己的官方网站,很多个人摄影爱好者也拍

如何制作系统U盘

21/1/202115:05:38

如何制作系统U盘:1、下载微软官方启动盘制作工具,插入U盘;2、打开启动盘制作工具,接受许可条款;3、选择【为另一台电脑】电脑制作安装媒体],【选择U盘作为安装媒体】;4、选择U盘,下载

网站制作前如何规划网站的结构?

27/10/202012:02:49

网站制作前如何规划网站的结构?来源:尚品中国|类型:网站建筑|在规划网站架构之前,我们通常注意以下几点:1.标题需要

如何制作网站

2018 年 2 月 3 日 01:09:40

很多业内外的朋友,包括一些想要建站的传统店铺,都认为为自己的业务建站是一件很复杂的事情。诚然,过去建立企业网站需要从零开始开发,工作量确实非常大。一般来说,中小企业负担不起。但实际上,自建站技术发展以来,已经有一种非常简单的方式来创建企业网站。这里以建站宝箱为例,给大家介绍一下如何完成企业网站的建立和上传。第一步,网站设计制作。这个可以自己开发给有建站技术的专业人士网站,

个人如何独立网站

21/9/202018:04:38

如何独立制作网站?尤其是想要建立博客或帮助公司制作网站的个人都在寻找一种简单而独立的方式来建立网站。独立建站的技术门槛还是挺高的。毕竟 网站 不是可以开发的编程技术,但是

网站如何变美

23/7/202015:01:39

网站 制作是否美观,取决于对开发的网站 页面的前期设计。页面是用户访问网站浏览看到的内容,所以网站如何美化,对于一些商家来说尤为重要网站。毕竟企业网站也相当于

网站制作公司教你如何安全注册网站域名

22/6/2021 15:06:58

网站制作公司教你如何安全注册网站域名来源:尚品中国|类型:网站制作|每个网站都有自己的域名,和大家一样有自己的名字

如何制定完美的网站优化计划

16/11/2011 13:59:00

当站长得到一个优化的网站,而不是得到一个网站然后去关键词做外链,第一步应该是了解网站。执行了 网站 优化。为了制定一个完整的网站优化计划,最重要的是步骤和计划中应该收录的内容。

搭建网站有哪些步骤以及如何自己搭建网站

1/7/202010:24:01

现在制作网站的技术越来越成熟,很多人都可以制作自己的网站,下面小编就来介绍一下如何制作自己的网站,其实就是构建< @网站 @> 没有我想象的那么复杂,按照下面的步骤操作就没有问题了。

如何制作完美的错误信息

2017 年 1 月 9 日 14:03:00

每个系统都有暂停工作的时候,它可能是由于用户的错误操作或系统故障造成的。在这两种情况下,设计一个完美的错误信息尤为重要,因为它可以有效地改善用户体验。如何制作完美的错误信息?它往往收录以下3个重要部分:

企业网站如何控制预算

2018 年 4 月 6 日 16:05:00

当公司谈论 网站 生产项目时,他们会考虑预算。因为每个项目的费用在制作时都是灵活的,可大可小,如网站空间、程序制作、域名都可能导致整个项目超支,制定计划……

如何制作个人独奏网站

2018 年 10 月 7 日 11:28:33

在互联网时代,很多人都有将个人网页制作成在线的想法。虽然很多网站都提供个人博客和个人主页,但是形式非常死板。如果你能自己做一个就太好了。

网站建设:如何建立新公司网站

13/7/202012:10:30

网站已成为用户了解和了解公司的官方网站平台,让客户对公司有更全面、更深入的了解。尤其是新成立的公司,没有品牌市场意识和客户积累。@网站生产四面八方

虚拟主机是如何制作的网站

15/10/202018:03:09

本篇云计算文章文章与大家分享如何制作虚拟主机网站。小编觉得很实用,分享给大家。希望你看完这篇文章文章可以有所收获,不

网站如何制作,一步到位

2020 年 11 月 8 日 21:01:48

网站如何为不同的人做出不同的回答,熟练的人独立建站只需要很长时间,需要前期设计好网站页面,然后开发前端-结束页面和 网站@ > 功能。对于不擅长网站如何制作的人来说,这是

查看全部

网站内容采集系统(相关专题如何制作网站?制作系统U盘的方法?

)

相关话题

如何制作网站?你需要做什么来制作网站?

28/6/202018:03:11

如何制作网站?你需要做什么来制作网站?网站现在很常见,很多公司都有自己的官方网站,很多个人摄影爱好者也拍

如何制作系统U盘

21/1/202115:05:38

如何制作系统U盘:1、下载微软官方启动盘制作工具,插入U盘;2、打开启动盘制作工具,接受许可条款;3、选择【为另一台电脑】电脑制作安装媒体],【选择U盘作为安装媒体】;4、选择U盘,下载

网站制作前如何规划网站的结构?

27/10/202012:02:49

网站制作前如何规划网站的结构?来源:尚品中国|类型:网站建筑|在规划网站架构之前,我们通常注意以下几点:1.标题需要

如何制作网站

2018 年 2 月 3 日 01:09:40

很多业内外的朋友,包括一些想要建站的传统店铺,都认为为自己的业务建站是一件很复杂的事情。诚然,过去建立企业网站需要从零开始开发,工作量确实非常大。一般来说,中小企业负担不起。但实际上,自建站技术发展以来,已经有一种非常简单的方式来创建企业网站。这里以建站宝箱为例,给大家介绍一下如何完成企业网站的建立和上传。第一步,网站设计制作。这个可以自己开发给有建站技术的专业人士网站,

个人如何独立网站

21/9/202018:04:38

如何独立制作网站?尤其是想要建立博客或帮助公司制作网站的个人都在寻找一种简单而独立的方式来建立网站。独立建站的技术门槛还是挺高的。毕竟 网站 不是可以开发的编程技术,但是

网站如何变美

23/7/202015:01:39

网站 制作是否美观,取决于对开发的网站 页面的前期设计。页面是用户访问网站浏览看到的内容,所以网站如何美化,对于一些商家来说尤为重要网站。毕竟企业网站也相当于

网站制作公司教你如何安全注册网站域名

22/6/2021 15:06:58

网站制作公司教你如何安全注册网站域名来源:尚品中国|类型:网站制作|每个网站都有自己的域名,和大家一样有自己的名字

如何制定完美的网站优化计划

16/11/2011 13:59:00

当站长得到一个优化的网站,而不是得到一个网站然后去关键词做外链,第一步应该是了解网站。执行了 网站 优化。为了制定一个完整的网站优化计划,最重要的是步骤和计划中应该收录的内容。

搭建网站有哪些步骤以及如何自己搭建网站

1/7/202010:24:01

现在制作网站的技术越来越成熟,很多人都可以制作自己的网站,下面小编就来介绍一下如何制作自己的网站,其实就是构建< @网站 @> 没有我想象的那么复杂,按照下面的步骤操作就没有问题了。

如何制作完美的错误信息

2017 年 1 月 9 日 14:03:00

每个系统都有暂停工作的时候,它可能是由于用户的错误操作或系统故障造成的。在这两种情况下,设计一个完美的错误信息尤为重要,因为它可以有效地改善用户体验。如何制作完美的错误信息?它往往收录以下3个重要部分:

企业网站如何控制预算

2018 年 4 月 6 日 16:05:00

当公司谈论 网站 生产项目时,他们会考虑预算。因为每个项目的费用在制作时都是灵活的,可大可小,如网站空间、程序制作、域名都可能导致整个项目超支,制定计划……

如何制作个人独奏网站

2018 年 10 月 7 日 11:28:33

在互联网时代,很多人都有将个人网页制作成在线的想法。虽然很多网站都提供个人博客和个人主页,但是形式非常死板。如果你能自己做一个就太好了。

网站建设:如何建立新公司网站

13/7/202012:10:30

网站已成为用户了解和了解公司的官方网站平台,让客户对公司有更全面、更深入的了解。尤其是新成立的公司,没有品牌市场意识和客户积累。@网站生产四面八方

虚拟主机是如何制作的网站

15/10/202018:03:09

本篇云计算文章文章与大家分享如何制作虚拟主机网站。小编觉得很实用,分享给大家。希望你看完这篇文章文章可以有所收获,不

网站如何制作,一步到位

2020 年 11 月 8 日 21:01:48

网站如何为不同的人做出不同的回答,熟练的人独立建站只需要很长时间,需要前期设计好网站页面,然后开发前端-结束页面和 网站@ > 功能。对于不擅长网站如何制作的人来说,这是

网站内容采集系统(软件特色:1.图形化的采集任务定义界面(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2022-02-04 20:03

一财网站数据采集系统是一款全面、准确、稳定、易用的网络信息采集软件。它可以轻松抓取你想要的网页内容(包括文字、图片、文档、HTML源代码等)。采集接收到的数据可以直接导出到EXCEL,也可以根据自己定义的模板以任意格式保存(如保存为网页文件、TXT文件等)。也可以实时保存到数据库,发送到网站服务器,或者与采集同时保存到文件中。

软件特点:

1.图形化采集任务定义界面您可以在软件内嵌的浏览器中用鼠标点击您想要采集的网页内容来配置采集任务,无需像其他类似软件一样面对复杂的网页源代码寻找采集规则。可以说是一个所见即所得的采集任务配置界面。

2.创新的内容定位方式,定位更精准稳定人员只需要面对HTML代码,付出更多的额外学习时间即可掌握软件的使用。同时,只要网页内容稍有变化(比如改变文字颜色),定位标记就很有可能失败,导致采集失败。经过艰苦的技术研究,我们实现了一种新的定位方法:结构定位和相对标志定位。众所周知,一个网站的样式基本是固定的,其相似网页的排列布局也基本一致。这就是结构定位起作用的地方。当然,基本一样不代表100%一样,但是我们已经克服了技术难点,消除了这些障碍。

3.支持任务嵌套,可以采集无限页面内容。只需在当前任务页面中选择你要下级页面的链接采集即可创建嵌套任务,采集下级页面的内容,嵌套层数不限。这种便利要归功于我们新的内容定位和图形化的采集任务配置界面。

4.同时采集除了最基本的文字、图片、文件,任何内容还可以采集具体HTML标签的源代码和属性值。

5.强大的自动信息再处理能力您可以在配置任务时指定对采集接收到的内容进行任意替换和过滤。

6.内容自动排序采集

7.支持采集将结果保存到EXCEL,任何格式的文件都支持自定义文件模板。

8.支持实时保存到数据库支持ACCESS、SQLSERVER、MYSQL数据库(后续版本将支持更多类型的数据库)。

9.支持实时上传到网站服务器支持POST和GET方式,可以自定义上传参数模拟手动提交。

10.支持实时保存到任意格式的文件,支持自定义模板,支持按记录保存和将多条记录保存到单个文件,支持大纲和详细保存(所有记录的部分内容保存到大纲文件,然后将每条记录保存到单独的文件中。

11.支持多种灵活的任务调度方式,实现无人值守采集

12.支持多任务,支持任务导入导出 查看全部

网站内容采集系统(软件特色:1.图形化的采集任务定义界面(组图))

一财网站数据采集系统是一款全面、准确、稳定、易用的网络信息采集软件。它可以轻松抓取你想要的网页内容(包括文字、图片、文档、HTML源代码等)。采集接收到的数据可以直接导出到EXCEL,也可以根据自己定义的模板以任意格式保存(如保存为网页文件、TXT文件等)。也可以实时保存到数据库,发送到网站服务器,或者与采集同时保存到文件中。

软件特点:

1.图形化采集任务定义界面您可以在软件内嵌的浏览器中用鼠标点击您想要采集的网页内容来配置采集任务,无需像其他类似软件一样面对复杂的网页源代码寻找采集规则。可以说是一个所见即所得的采集任务配置界面。

2.创新的内容定位方式,定位更精准稳定人员只需要面对HTML代码,付出更多的额外学习时间即可掌握软件的使用。同时,只要网页内容稍有变化(比如改变文字颜色),定位标记就很有可能失败,导致采集失败。经过艰苦的技术研究,我们实现了一种新的定位方法:结构定位和相对标志定位。众所周知,一个网站的样式基本是固定的,其相似网页的排列布局也基本一致。这就是结构定位起作用的地方。当然,基本一样不代表100%一样,但是我们已经克服了技术难点,消除了这些障碍。

3.支持任务嵌套,可以采集无限页面内容。只需在当前任务页面中选择你要下级页面的链接采集即可创建嵌套任务,采集下级页面的内容,嵌套层数不限。这种便利要归功于我们新的内容定位和图形化的采集任务配置界面。

4.同时采集除了最基本的文字、图片、文件,任何内容还可以采集具体HTML标签的源代码和属性值。

5.强大的自动信息再处理能力您可以在配置任务时指定对采集接收到的内容进行任意替换和过滤。

6.内容自动排序采集

7.支持采集将结果保存到EXCEL,任何格式的文件都支持自定义文件模板。

8.支持实时保存到数据库支持ACCESS、SQLSERVER、MYSQL数据库(后续版本将支持更多类型的数据库)。

9.支持实时上传到网站服务器支持POST和GET方式,可以自定义上传参数模拟手动提交。

10.支持实时保存到任意格式的文件,支持自定义模板,支持按记录保存和将多条记录保存到单个文件,支持大纲和详细保存(所有记录的部分内容保存到大纲文件,然后将每条记录保存到单独的文件中。

11.支持多种灵活的任务调度方式,实现无人值守采集

12.支持多任务,支持任务导入导出

网站内容采集系统(如何爬数据css需求数据采集系统:一个能够经过配置规则)

采集交流 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2022-02-04 11:07

记录两年前写的一个采集系统,包括需求、分析、设计、实现、遇到的问题和系统结果。系统的主要功能是能够对每个网站进行不同的操作。采集规则被配置为对每个网站进行数据爬取。两年前我离开的时候爬取的数据量大概是几千万,每天采集的数据增量大概10000条左右,有1200多条网站配置采集,现在记录系统实现,并提供一些简单的爬虫demo供大家学习如何爬取数据css

需要

数据采集系统:可以配置规则的系统采集不同网站主要目标:html

根据不同的网站,通过配置不同的采集规则来实现网页数据的抓取。对于每一个内容,可以定时抽取特征数据来爬取网站采集配置规则可以维护采集入站数据可以维护架构图的所有数据

数据采集系统架构图java

分析

第一步是先分析需求,所以提取系统的主要需求:jquery

根据不同的网站,可以通过不同的采集规则爬取数据。对于每个内容,可以提取特征数据。特征数据是指标题、作者和发布时间。信息定时任务与任务或任务组关联爬取网站的数据

我们来分析一下网站的结构,无外乎两种;网络

一是列表页。这里的列表页表示需要在当前页面获取更多详情页面的网页链接类型。和通常的查询列表一样,通过列表可以获得更多的详情页链接。一是详情页,比较容易理解。这种页面不需要连接到本页面上的其他网页,可以直接从当前页面中提取数据。

基本上所有爬取的网站都可以这样抽象。阿贾克斯

设计

为分析结果设计一个实现:正则表达式

任务表redis

每个 网站 都可以被视为一个任务来实现 采集 设计模式

两个规则表浏览器

每个 网站 对应于它自己的 采集 规则。根据上面分析的网站结构,采集规则可以细分为两张表,一张收录网站connect获取详情页列表列表采集规则table,网站详情页详情采集规则表的特征数据采集的规则表

网址表

负责记录采集target网站的详情页的url

计划任务表

根据定时任务定时执行某些任务(可以使用定时任务关联多个任务,也可以考虑添加任务组表,定时任务关联任务组,任务组关联任务)

数据存储表

这是因为我们的采集的数据主要是投标和中标两种数据,并且建立了两个表用于数据存储,中标信息表和中标信息表。

实施框架

基础设施是:ssm+redis+htmlunit+jsoup+es+mq+quartz 有很多java可以实现爬虫的框架,htmlunit,WebMagic,jsoup等,有很多优秀的开源框架,当然httpclient也可以实施的。

为什么要使用 htmlunit?htmlunit 是一个开源的java页面分析工具。阅读完页面后,可以有效的使用htmlunit对页面内容进行分析。该项目可以模拟浏览器的操作,号称java浏览器的开源实现

简单说说我对htmlunit的理解:

一是htmlunit提供了通过xpath定位页面元素的功能,通过xpath可以提取页面的特征数据;二是对js的支持,这意味着你真的可以把它当做浏览器来使用。可以用它来模拟点击、输入、登录等操作,对于采集,支持js可以解决页面使用ajax获取数据的问题。当然,htmlunit也支持代理ip、https,配置后可以模拟google、firefox等浏览器、referer、user-agent,是否加载js、css,是否支持ajax等。

XPath 语法是 XML 路径语言,它是一种用于确定 XML 文档的某个部分的位置的语言。

为什么要使用 jsoup?与htmlunit相比,jsoup提供了类似于jquery选择器的定位页面元素的功能,两者可以互补使用。

采集

采集数据逻辑分为两部分:url采集器、详情页采集器

网址采集器:

详情页采集器:

遇到问题的去重:在采集url的时候进行去重,对url进行去重。将key作为url存储在redis中后,缓存时间为3天。这个方法是为了防止同一个url重复采集。标题去重后,key为采集的标题存储在redis中,缓存时间为3天。此方法是为了防止 文章 被不同的 网站 发布,重复 采集 条件的出现。数据质量:

因为每个网站页面都不一样,尤其是同一个网站的详情页结构也不同,使得特征数据的提取比较困难,所以使用htmlunit+jsoup+regularity三种方法结合使用来采集特征数据。

采集效率:

因为采集中有很多网站,假设每次任务执行打开一个列表页和十个详情页,那么一千个任务执行一次需要采集11000个页面. ,所以url和详情页是分开的采集,通过mq实现异步操作,url和详情页的采集是通过多线程实现的。

被封锁的ip:

对于一个网站,假设每半小时执行一次,网站一天会被扫描48次,同样假设一个采集会打开11个页面,也是一天528次,所以被屏蔽是很常见的问题。解决方案,htmlunit提供了proxy ip的实现,使用proxy ip可以解决ip被阻塞的问题。代理ip的来源:一个是网上有很多网站卖代理ip的,你可以直接买代理ip,另一个是爬的,这些卖代理ip的网站提供一些免费的代理ip,可以把这些ip爬回来,然后用httpclient或者其他方法验证代理ip的可用性,如果可以的话,直接入库,建一个自己的代理ip库。因为代理ip是时间敏感的,

网站失败:

网站 失败有两种类型。一是网站的域名已经失效,无法直接打开原网址。第二个是网站的修改,原来配置的所有规则都失效了。无法采集接收有效数据。解决这个问题的方法是每天发送采集邮件提醒数据和日志,将那些没有采集到的数据和没有打开的页面汇总,通过邮件发送给相关人员。

验证码:

当时对于一个网站采集历史数据采集,方法也是通过他们的列表页到采集详情页,采集@ > 几十万条数据 后来发现这个网站 采集不到数据。看完页面,发现列表页面已经添加了一个验证码。这个验证码还是比较简单的,就是数字和字母。当时想在列表页加个验证码。? ,然后想了个办法,找了一个开源的orc文本识别项目tess4j(怎么用可以看这个),可以用,识别率20%左右,因为htmlunit可以模拟浏览器中的操作做,所以代码中的操作是先通过htmlunit的xpath获取验证码元素,

ajax加载数据:

一些网站使用ajax加载数据。使用htmlunit采集时,这种网站需要在获取到HtmlPage对象后,给页面一个加载ajax的时间。HtmlPage 获取 ajax 加载后的数据。

代码:webClient.waitForBackgroundJavaScript(time); 您可以查看稍后提供的演示

系统整体架构图,我们说的是这部分数据采集系统

演示

爬虫的实现:

@GetMapping("/getData")

public List article_(String url,String xpath){

WebClient webClient = WebClientUtils.getWebClientLoadJs();

List datas = new ArrayList();

try {

HtmlPage page = webClient.getPage(url);

if(page!=null){

List lists = page.getByXPath(xpath);

lists.stream().forEach(i->{

DomNode domNode = (DomNode)i;

datas.add(domNode.asText());

});

}

}catch (Exception e){

e.printStackTrace();

}finally {

webClient.close();

}

return datas;

}

复制代码

上面的代码实现了采集一个列表页面

爬博客园

请求此网址::9001/getData?url=;xpath=//*[@id="post_list"]/div/div[2]/h3/a

网页:

采集 返回的数据:

再次爬上csdn

再次请求::9001/getData?url=;xpath=//*[@id="feedlist_id"]/li/div/div[1]/h2/a

网页:

采集 返回的数据:

采集步骤

经过一个方法去采集两个网站,经过不一样url和xpath规则去采集不一样的网站,这个demo展现的就是htmlunit采集数据的过程。

每一个采集任务都是执行相同的步骤

- 获取client -> 打开页面 -> 提取特征数据(或详情页连接) -> 关闭cline

不一样的地方就在于提取特征数据

复制代码

优化:使用模板法设计图案,提取功能部分

上面的代码可以提取为:一个采集执行器,一个自定义的采集数据实现

/**

* @Description: 执行者 man

* @author: chenmingyu

* @date: 2018/6/24 17:29

*/

public class Crawler {

private Gatherer gatherer;

public Object execute(String url,Long time){

// 获取 webClient对象

WebClient webClient = WebClientUtils.getWebClientLoadJs();

try {

HtmlPage page = webClient.getPage(url);

if(null != time){

webClient.waitForBackgroundJavaScript(time);

}

return gatherer.crawl(page);

}catch (Exception e){

e.printStackTrace();

}finally {

webClient.close();

}

return null;

}

public Crawler(Gatherer gatherer) {

this.gatherer = gatherer;

}

}

复制代码

给Crawler注入一个接口,这个接口只有一个方法 crawl(),不同的实现类实现这个接口,然后自定义特征数据的实现

/**

* @Description: 自定义实现

* @author: chenmingyu

* @date: 2018/6/24 17:36

*/

public interface Gatherer {

Object crawl(HtmlPage page) throws Exception;

}

复制代码

优化代码:

@GetMapping("/getData")

public List article_(String url,String xpath){

Gatherer gatherer = (page)->{

List datas = new ArrayList();

List lists = page.getByXPath(xpath);

lists.stream().forEach(i->{

DomNode domNode = (DomNode)i;

datas.add(domNode.asText());

});

return datas;

};

Crawler crawler = new Crawler(gatherer);

List datas = (List)crawler.execute(url,null);

return datas;

}

复制代码

不同的实现,只需要修改这部分接口实现即可。

数据

最后看一下使用 采集system采集 的数据。

影响

效果还是不错的,最重要的是系统运行稳定:

采集历史数据每天新增600万到700万之间采集数据增量在1万左右。系统目前配置了大约1200个任务(一个预定的实现会去采集这些网站)数据

系统配置采集的网站主要针对全国各省市县的招标投标网站的招标信息(目前1200多个采集 @> 站点已配置)。采集的数据主要作为公司logo的数据中心,为1个PC端网站和2个微信公众号提供数据

欢迎关注并掌握第一手资讯

以PC端显示的一个采集的中奖数据为例,看看采集的效果:

本文只是大致记录了采集系统从零到完整的过程,虽然还有很多问题本文没有提到。 查看全部

网站内容采集系统(如何爬数据css需求数据采集系统:一个能够经过配置规则)

记录两年前写的一个采集系统,包括需求、分析、设计、实现、遇到的问题和系统结果。系统的主要功能是能够对每个网站进行不同的操作。采集规则被配置为对每个网站进行数据爬取。两年前我离开的时候爬取的数据量大概是几千万,每天采集的数据增量大概10000条左右,有1200多条网站配置采集,现在记录系统实现,并提供一些简单的爬虫demo供大家学习如何爬取数据css

需要

数据采集系统:可以配置规则的系统采集不同网站主要目标:html

根据不同的网站,通过配置不同的采集规则来实现网页数据的抓取。对于每一个内容,可以定时抽取特征数据来爬取网站采集配置规则可以维护采集入站数据可以维护架构图的所有数据

数据采集系统架构图java

分析

第一步是先分析需求,所以提取系统的主要需求:jquery

根据不同的网站,可以通过不同的采集规则爬取数据。对于每个内容,可以提取特征数据。特征数据是指标题、作者和发布时间。信息定时任务与任务或任务组关联爬取网站的数据

我们来分析一下网站的结构,无外乎两种;网络

一是列表页。这里的列表页表示需要在当前页面获取更多详情页面的网页链接类型。和通常的查询列表一样,通过列表可以获得更多的详情页链接。一是详情页,比较容易理解。这种页面不需要连接到本页面上的其他网页,可以直接从当前页面中提取数据。

基本上所有爬取的网站都可以这样抽象。阿贾克斯

设计

为分析结果设计一个实现:正则表达式

任务表redis

每个 网站 都可以被视为一个任务来实现 采集 设计模式

两个规则表浏览器

每个 网站 对应于它自己的 采集 规则。根据上面分析的网站结构,采集规则可以细分为两张表,一张收录网站connect获取详情页列表列表采集规则table,网站详情页详情采集规则表的特征数据采集的规则表

网址表

负责记录采集target网站的详情页的url

计划任务表

根据定时任务定时执行某些任务(可以使用定时任务关联多个任务,也可以考虑添加任务组表,定时任务关联任务组,任务组关联任务)

数据存储表

这是因为我们的采集的数据主要是投标和中标两种数据,并且建立了两个表用于数据存储,中标信息表和中标信息表。

实施框架

基础设施是:ssm+redis+htmlunit+jsoup+es+mq+quartz 有很多java可以实现爬虫的框架,htmlunit,WebMagic,jsoup等,有很多优秀的开源框架,当然httpclient也可以实施的。

为什么要使用 htmlunit?htmlunit 是一个开源的java页面分析工具。阅读完页面后,可以有效的使用htmlunit对页面内容进行分析。该项目可以模拟浏览器的操作,号称java浏览器的开源实现

简单说说我对htmlunit的理解:

一是htmlunit提供了通过xpath定位页面元素的功能,通过xpath可以提取页面的特征数据;二是对js的支持,这意味着你真的可以把它当做浏览器来使用。可以用它来模拟点击、输入、登录等操作,对于采集,支持js可以解决页面使用ajax获取数据的问题。当然,htmlunit也支持代理ip、https,配置后可以模拟google、firefox等浏览器、referer、user-agent,是否加载js、css,是否支持ajax等。

XPath 语法是 XML 路径语言,它是一种用于确定 XML 文档的某个部分的位置的语言。

为什么要使用 jsoup?与htmlunit相比,jsoup提供了类似于jquery选择器的定位页面元素的功能,两者可以互补使用。

采集

采集数据逻辑分为两部分:url采集器、详情页采集器

网址采集器:

详情页采集器:

遇到问题的去重:在采集url的时候进行去重,对url进行去重。将key作为url存储在redis中后,缓存时间为3天。这个方法是为了防止同一个url重复采集。标题去重后,key为采集的标题存储在redis中,缓存时间为3天。此方法是为了防止 文章 被不同的 网站 发布,重复 采集 条件的出现。数据质量:

因为每个网站页面都不一样,尤其是同一个网站的详情页结构也不同,使得特征数据的提取比较困难,所以使用htmlunit+jsoup+regularity三种方法结合使用来采集特征数据。

采集效率:

因为采集中有很多网站,假设每次任务执行打开一个列表页和十个详情页,那么一千个任务执行一次需要采集11000个页面. ,所以url和详情页是分开的采集,通过mq实现异步操作,url和详情页的采集是通过多线程实现的。

被封锁的ip:

对于一个网站,假设每半小时执行一次,网站一天会被扫描48次,同样假设一个采集会打开11个页面,也是一天528次,所以被屏蔽是很常见的问题。解决方案,htmlunit提供了proxy ip的实现,使用proxy ip可以解决ip被阻塞的问题。代理ip的来源:一个是网上有很多网站卖代理ip的,你可以直接买代理ip,另一个是爬的,这些卖代理ip的网站提供一些免费的代理ip,可以把这些ip爬回来,然后用httpclient或者其他方法验证代理ip的可用性,如果可以的话,直接入库,建一个自己的代理ip库。因为代理ip是时间敏感的,

网站失败:

网站 失败有两种类型。一是网站的域名已经失效,无法直接打开原网址。第二个是网站的修改,原来配置的所有规则都失效了。无法采集接收有效数据。解决这个问题的方法是每天发送采集邮件提醒数据和日志,将那些没有采集到的数据和没有打开的页面汇总,通过邮件发送给相关人员。

验证码:

当时对于一个网站采集历史数据采集,方法也是通过他们的列表页到采集详情页,采集@ > 几十万条数据 后来发现这个网站 采集不到数据。看完页面,发现列表页面已经添加了一个验证码。这个验证码还是比较简单的,就是数字和字母。当时想在列表页加个验证码。? ,然后想了个办法,找了一个开源的orc文本识别项目tess4j(怎么用可以看这个),可以用,识别率20%左右,因为htmlunit可以模拟浏览器中的操作做,所以代码中的操作是先通过htmlunit的xpath获取验证码元素,

ajax加载数据:

一些网站使用ajax加载数据。使用htmlunit采集时,这种网站需要在获取到HtmlPage对象后,给页面一个加载ajax的时间。HtmlPage 获取 ajax 加载后的数据。

代码:webClient.waitForBackgroundJavaScript(time); 您可以查看稍后提供的演示

系统整体架构图,我们说的是这部分数据采集系统

演示

爬虫的实现:

@GetMapping("/getData")

public List article_(String url,String xpath){

WebClient webClient = WebClientUtils.getWebClientLoadJs();

List datas = new ArrayList();

try {

HtmlPage page = webClient.getPage(url);

if(page!=null){

List lists = page.getByXPath(xpath);

lists.stream().forEach(i->{

DomNode domNode = (DomNode)i;

datas.add(domNode.asText());

});

}

}catch (Exception e){

e.printStackTrace();

}finally {

webClient.close();

}

return datas;

}

复制代码

上面的代码实现了采集一个列表页面

爬博客园

请求此网址::9001/getData?url=;xpath=//*[@id="post_list"]/div/div[2]/h3/a

网页:

采集 返回的数据:

再次爬上csdn

再次请求::9001/getData?url=;xpath=//*[@id="feedlist_id"]/li/div/div[1]/h2/a

网页:

采集 返回的数据:

采集步骤

经过一个方法去采集两个网站,经过不一样url和xpath规则去采集不一样的网站,这个demo展现的就是htmlunit采集数据的过程。

每一个采集任务都是执行相同的步骤

- 获取client -> 打开页面 -> 提取特征数据(或详情页连接) -> 关闭cline

不一样的地方就在于提取特征数据

复制代码

优化:使用模板法设计图案,提取功能部分

上面的代码可以提取为:一个采集执行器,一个自定义的采集数据实现

/**

* @Description: 执行者 man

* @author: chenmingyu

* @date: 2018/6/24 17:29

*/

public class Crawler {

private Gatherer gatherer;

public Object execute(String url,Long time){

// 获取 webClient对象

WebClient webClient = WebClientUtils.getWebClientLoadJs();

try {

HtmlPage page = webClient.getPage(url);

if(null != time){

webClient.waitForBackgroundJavaScript(time);

}

return gatherer.crawl(page);

}catch (Exception e){

e.printStackTrace();

}finally {

webClient.close();

}

return null;

}

public Crawler(Gatherer gatherer) {

this.gatherer = gatherer;

}

}

复制代码

给Crawler注入一个接口,这个接口只有一个方法 crawl(),不同的实现类实现这个接口,然后自定义特征数据的实现

/**

* @Description: 自定义实现

* @author: chenmingyu

* @date: 2018/6/24 17:36

*/

public interface Gatherer {

Object crawl(HtmlPage page) throws Exception;

}

复制代码

优化代码:

@GetMapping("/getData")

public List article_(String url,String xpath){

Gatherer gatherer = (page)->{

List datas = new ArrayList();

List lists = page.getByXPath(xpath);

lists.stream().forEach(i->{

DomNode domNode = (DomNode)i;

datas.add(domNode.asText());

});

return datas;

};

Crawler crawler = new Crawler(gatherer);

List datas = (List)crawler.execute(url,null);

return datas;

}

复制代码

不同的实现,只需要修改这部分接口实现即可。

数据

最后看一下使用 采集system采集 的数据。

影响

效果还是不错的,最重要的是系统运行稳定:

采集历史数据每天新增600万到700万之间采集数据增量在1万左右。系统目前配置了大约1200个任务(一个预定的实现会去采集这些网站)数据

系统配置采集的网站主要针对全国各省市县的招标投标网站的招标信息(目前1200多个采集 @> 站点已配置)。采集的数据主要作为公司logo的数据中心,为1个PC端网站和2个微信公众号提供数据

欢迎关注并掌握第一手资讯

以PC端显示的一个采集的中奖数据为例,看看采集的效果:

本文只是大致记录了采集系统从零到完整的过程,虽然还有很多问题本文没有提到。

网站内容采集系统(万能邮件群发一款专业的电子邮件地址搜索和提取软件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 415 次浏览 • 2022-02-03 10:10

Universal Mail 是一款专业的电子邮件地址搜索和提取软件,它从互联网上采集电子邮件地址。它具有强大的搜索和提取功能,支持网站、论坛和关键字搜索,您只需输入网址或关键字,系统会立即自动搜索和提取电子邮件地址,操作非常简单。

主要特征:

1、傻瓜式没有专业知识怎么操作。输入网址或关键字,点击开始按钮即可采集;

2、您可以快速指定只搜索某个网站或论坛,而不访问其他网站网页;

3、采用先进的多线程技术,用户可以自由设置线程数,只要你的网速和电脑够快,设置5000个线程没问题;

4、虚拟下载技术,不会在你的电脑上下载网站内容;

5、可以在采集过程中定时自动更换IP,防止IP被锁定无法锁定网站;

6、可以指定每台服务器的最大连接数,系统自动平衡分配连接URL,防止IP被阻塞;

7、采集状态自动保存。您也可以随时中断采集,保存工作状态。您可以下次打开作业并从停止点继续作业;

8、自动检查重复邮箱和不合格邮箱并立即删除;

9、邮箱批量导入导出,支持文本、EXCEL、FOXPFO、Access、XML等常用格式;

10、邮箱的模糊搜索和自动分页,可以实现邮箱的快速分类和导出;

11、支持每个网站的最大网页搜索次数参数,当达到最大次数时,将不再搜索该网站;

12、支持每个job的最大网页搜索次数参数,达到最大次数停止工作;

13、支持网址收录或排除某些关键字过滤器;

14、支持收录或不收录某些关键字过滤条件的网页内容;

15、支持页眉内容收录关键词过滤条件,使搜索结果更加准确;

16、支持URL导入,也可以指定步长自动生成URL;

17、支持批量搜索(搜索流量),系统会根据您设置的搜索流量自动搜索;

18、支持动态添加搜索内容,如果你已经在搜索一个网站,可以继续输入网站,系统会自动进入队列一一完成;

19、可以设置水平搜索深度和垂直搜索深度;

20、除了直接支持google、yahoo、baidu、bing、sogou等搜索引擎外,还可以使用其他搜索引擎,也可以使用这些搜索的高级搜索功能来实现更准确的搜索;

21、可以提取各种类型的邮箱,包括带有反提取功能的网页,比如用图片代替邮箱,用''代替'@',使用'@'等编码邮箱;

22、软件自动检测最新版本,自动升级;

23、支持托盘操作,用户可以同时做其他工作;

24、万能邮件群发工具和万能邮箱验证工具无缝集成;

25、多种语言,最多支持12种语言;

扩张 查看全部

网站内容采集系统(万能邮件群发一款专业的电子邮件地址搜索和提取软件)

Universal Mail 是一款专业的电子邮件地址搜索和提取软件,它从互联网上采集电子邮件地址。它具有强大的搜索和提取功能,支持网站、论坛和关键字搜索,您只需输入网址或关键字,系统会立即自动搜索和提取电子邮件地址,操作非常简单。

主要特征:

1、傻瓜式没有专业知识怎么操作。输入网址或关键字,点击开始按钮即可采集;

2、您可以快速指定只搜索某个网站或论坛,而不访问其他网站网页;

3、采用先进的多线程技术,用户可以自由设置线程数,只要你的网速和电脑够快,设置5000个线程没问题;

4、虚拟下载技术,不会在你的电脑上下载网站内容;

5、可以在采集过程中定时自动更换IP,防止IP被锁定无法锁定网站;

6、可以指定每台服务器的最大连接数,系统自动平衡分配连接URL,防止IP被阻塞;

7、采集状态自动保存。您也可以随时中断采集,保存工作状态。您可以下次打开作业并从停止点继续作业;

8、自动检查重复邮箱和不合格邮箱并立即删除;

9、邮箱批量导入导出,支持文本、EXCEL、FOXPFO、Access、XML等常用格式;

10、邮箱的模糊搜索和自动分页,可以实现邮箱的快速分类和导出;

11、支持每个网站的最大网页搜索次数参数,当达到最大次数时,将不再搜索该网站;

12、支持每个job的最大网页搜索次数参数,达到最大次数停止工作;

13、支持网址收录或排除某些关键字过滤器;

14、支持收录或不收录某些关键字过滤条件的网页内容;

15、支持页眉内容收录关键词过滤条件,使搜索结果更加准确;

16、支持URL导入,也可以指定步长自动生成URL;

17、支持批量搜索(搜索流量),系统会根据您设置的搜索流量自动搜索;

18、支持动态添加搜索内容,如果你已经在搜索一个网站,可以继续输入网站,系统会自动进入队列一一完成;

19、可以设置水平搜索深度和垂直搜索深度;

20、除了直接支持google、yahoo、baidu、bing、sogou等搜索引擎外,还可以使用其他搜索引擎,也可以使用这些搜索的高级搜索功能来实现更准确的搜索;

21、可以提取各种类型的邮箱,包括带有反提取功能的网页,比如用图片代替邮箱,用''代替'@',使用'@'等编码邮箱;

22、软件自动检测最新版本,自动升级;

23、支持托盘操作,用户可以同时做其他工作;

24、万能邮件群发工具和万能邮箱验证工具无缝集成;

25、多种语言,最多支持12种语言;

扩张

网站内容采集系统(网站内容采集系统的技术特点及解决办法!!!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2022-02-02 22:00

网站内容采集系统,规模化复制现有的大量网站内容,是目前流行的内容采集系统。市面上有如百度百科、360百科、百度知道等知名网站内容基础采集系统,通过添加插件来实现。但是网站内容采集系统存在无法采集网站原创性内容的问题,又不想做专门的网站内容采集系统来存放网站内容,对网站站长而言,面临采集,信息过滤问题,站长遇到这些问题,都不知道如何解决?如果能够采集网站内容的话,网站内容采集系统也就能真正用户内容了,其实采集网站内容可以自动加入到网站内容库中,可以节省站长大量时间和精力。

采集网站内容又无法自动加入网站内容库,然后能统计到所采集内容的作者,那么对站长和内容采集网站来说,网站内容采集系统相当于是开辟一条免费福利之路,只要你加入,就可以获得任何你想要的免费内容。对于网站内容采集系统的选择,目前市面上网站内容采集系统比较流行的有大千搜索,阿里巴巴采集插件等。市面上以大千搜索为例,以大千搜索为例介绍网站内容采集系统的技术特点:。

一、界面简洁,操作方便,行云流水,分类细致。

二、自主定制采集文件格式。

三、可共享、积分免费等特点。

四、内容同步到百度、谷歌、百度360图书馆、百度经验、百度文库、豆丁图书馆、,便于收藏。

五、每天创建采集任务。采集部分内容同步任务到百度的百科文库,文学网站等,或者自定义采集到百度,清理快照,内容尽可能来源于各大网站。大千采集系统以自主定制采集文件格式的采集,专业细致的内容管理。灵活,支持分享、积分等特点,支持内容采集到百度搜索、谷歌、百度文库等知名网站。一键下载cms或者php网站内容,无需编程,也无需购买采集内容管理软件,无需投入专业化采集环境;采集系统稳定,只要每天采集任务,网站自动更新采集内容,支持任何语言采集,无需编程,无需购买采集内容管理软件,无需投入专业化采集环境。 查看全部

网站内容采集系统(网站内容采集系统的技术特点及解决办法!!!)

网站内容采集系统,规模化复制现有的大量网站内容,是目前流行的内容采集系统。市面上有如百度百科、360百科、百度知道等知名网站内容基础采集系统,通过添加插件来实现。但是网站内容采集系统存在无法采集网站原创性内容的问题,又不想做专门的网站内容采集系统来存放网站内容,对网站站长而言,面临采集,信息过滤问题,站长遇到这些问题,都不知道如何解决?如果能够采集网站内容的话,网站内容采集系统也就能真正用户内容了,其实采集网站内容可以自动加入到网站内容库中,可以节省站长大量时间和精力。

采集网站内容又无法自动加入网站内容库,然后能统计到所采集内容的作者,那么对站长和内容采集网站来说,网站内容采集系统相当于是开辟一条免费福利之路,只要你加入,就可以获得任何你想要的免费内容。对于网站内容采集系统的选择,目前市面上网站内容采集系统比较流行的有大千搜索,阿里巴巴采集插件等。市面上以大千搜索为例,以大千搜索为例介绍网站内容采集系统的技术特点:。

一、界面简洁,操作方便,行云流水,分类细致。

二、自主定制采集文件格式。

三、可共享、积分免费等特点。

四、内容同步到百度、谷歌、百度360图书馆、百度经验、百度文库、豆丁图书馆、,便于收藏。

五、每天创建采集任务。采集部分内容同步任务到百度的百科文库,文学网站等,或者自定义采集到百度,清理快照,内容尽可能来源于各大网站。大千采集系统以自主定制采集文件格式的采集,专业细致的内容管理。灵活,支持分享、积分等特点,支持内容采集到百度搜索、谷歌、百度文库等知名网站。一键下载cms或者php网站内容,无需编程,也无需购买采集内容管理软件,无需投入专业化采集环境;采集系统稳定,只要每天采集任务,网站自动更新采集内容,支持任何语言采集,无需编程,无需购买采集内容管理软件,无需投入专业化采集环境。

网站内容采集系统(网站数据采集的话的3个爬虫软件可以直接直接使用)

采集交流 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2022-02-02 21:12

网站数据采集,有很多现成的爬虫软件可以直接使用。下面我简单介绍三个,分别是优采云、优采云和优采云,操作简单,易学易懂,感兴趣的朋友可以试试:

01优采云采集器

这是一款非常智能的网络爬虫软件,支持跨平台,完全免费供个人使用。对于大部分网站,只需输入网页地址,软件会自动识别并提取相关字段信息,包括列表、Forms、链接、图片等,不需要配置任何采集规则,一键取景,支持自动翻页和数据导出功能,对于小白来说,非常容易学习和掌握:

02优采云采集器

这是一款非常不错的国产数据采集软件。与优采云采集器相比,优采云采集器目前只支持Windows平台,需要手动设置采集字段和配置规则,比较繁琐,而且更加灵活,内置大量数据采集模板,可以轻松采集京东、天猫等热门网站,官方教程很详细,而且小白很容易掌握:

03优采云采集器

这是一款非常流行的专业数据采集软件,功能强大,集数据采集、处理、分析、挖掘全流程于一体。相比优采云采集器和优采云For@>采集器规则设置更加灵活智能,可以快速抓取网页上分散的数据,并提供数据分析和辅助决策功能。对于网站数据的日常爬取,是一款非常不错的软件:

当然,除了以上三个爬虫软件,还有很多其他软件也支持网站data采集,比如作数、神策等也很不错,如果你熟悉的话Python、Java等编程语言,也可以自己编程爬取数据。网上也有相关的教程和资料。介绍很详细。如果你有兴趣,你可以搜索一下。希望以上分享的内容对您有所帮助。欢迎评论和留言补充。 查看全部

网站内容采集系统(网站数据采集的话的3个爬虫软件可以直接直接使用)

网站数据采集,有很多现成的爬虫软件可以直接使用。下面我简单介绍三个,分别是优采云、优采云和优采云,操作简单,易学易懂,感兴趣的朋友可以试试:

01优采云采集器

这是一款非常智能的网络爬虫软件,支持跨平台,完全免费供个人使用。对于大部分网站,只需输入网页地址,软件会自动识别并提取相关字段信息,包括列表、Forms、链接、图片等,不需要配置任何采集规则,一键取景,支持自动翻页和数据导出功能,对于小白来说,非常容易学习和掌握:

02优采云采集器

这是一款非常不错的国产数据采集软件。与优采云采集器相比,优采云采集器目前只支持Windows平台,需要手动设置采集字段和配置规则,比较繁琐,而且更加灵活,内置大量数据采集模板,可以轻松采集京东、天猫等热门网站,官方教程很详细,而且小白很容易掌握:

03优采云采集器

这是一款非常流行的专业数据采集软件,功能强大,集数据采集、处理、分析、挖掘全流程于一体。相比优采云采集器和优采云For@>采集器规则设置更加灵活智能,可以快速抓取网页上分散的数据,并提供数据分析和辅助决策功能。对于网站数据的日常爬取,是一款非常不错的软件:

当然,除了以上三个爬虫软件,还有很多其他软件也支持网站data采集,比如作数、神策等也很不错,如果你熟悉的话Python、Java等编程语言,也可以自己编程爬取数据。网上也有相关的教程和资料。介绍很详细。如果你有兴趣,你可以搜索一下。希望以上分享的内容对您有所帮助。欢迎评论和留言补充。

网站内容采集系统(网站内容采集系统有不少系统,迅先生兩:回答)

采集交流 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-01-31 13:01

网站内容采集系统有不少系统,因为市场上有大量的网站内容采集系统,导致大量的网站文章都被用户所浏览,点击,跳转,采集系统大部分都是不给任何排名的,还会被百度seo的部门给予批量采集网站内容的记过,网站内容采集系统就只能把网站的文章看截图,文章简介等内容,然后用大部分人看不到的文字表述出来,导致百度seo的内容采集系统无法抓取搜索的内容,采集系统大部分内容都是用的模板做的,正是因为市场上的采集系统这么多,所以网站内容采集系统才会说有种类繁多的情况,这也导致网站内容采集系统功能越来越多,采集系统采集文章多主要是为了赚钱。

网站内容采集系统的话,看看之前他们有些什么优势,毕竟不同人要做的东西不一样,看看他们做的功能到底能不能帮到他们解决他们的问题,毕竟这个网站内容采集系统要抓取搜索的内容的话,更多是为了每天带来更多的流量,更多的点击,相应的,文章做成模板,可以被改成图片,可以被插入一些链接,可以被改成html代码等。找他们采集,价格也不会很贵,毕竟上面的代理商,他们对于价格都是非常清楚的,因为采集系统功能太多,还是可以带来很多客户,不用为价格发愁。

迅先生兩:回答有關2014年10月案來的新問題本2014年10月案 查看全部

网站内容采集系统(网站内容采集系统有不少系统,迅先生兩:回答)

网站内容采集系统有不少系统,因为市场上有大量的网站内容采集系统,导致大量的网站文章都被用户所浏览,点击,跳转,采集系统大部分都是不给任何排名的,还会被百度seo的部门给予批量采集网站内容的记过,网站内容采集系统就只能把网站的文章看截图,文章简介等内容,然后用大部分人看不到的文字表述出来,导致百度seo的内容采集系统无法抓取搜索的内容,采集系统大部分内容都是用的模板做的,正是因为市场上的采集系统这么多,所以网站内容采集系统才会说有种类繁多的情况,这也导致网站内容采集系统功能越来越多,采集系统采集文章多主要是为了赚钱。

网站内容采集系统的话,看看之前他们有些什么优势,毕竟不同人要做的东西不一样,看看他们做的功能到底能不能帮到他们解决他们的问题,毕竟这个网站内容采集系统要抓取搜索的内容的话,更多是为了每天带来更多的流量,更多的点击,相应的,文章做成模板,可以被改成图片,可以被插入一些链接,可以被改成html代码等。找他们采集,价格也不会很贵,毕竟上面的代理商,他们对于价格都是非常清楚的,因为采集系统功能太多,还是可以带来很多客户,不用为价格发愁。

迅先生兩:回答有關2014年10月案來的新問題本2014年10月案

网站内容采集系统( 本发明涉及一种网站内容防采集方法(图)涉及)

采集交流 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2022-01-30 16:00

本发明涉及一种网站内容防采集方法(图)涉及)

网站内容预防采集系统和方法

技术领域

[0001] 本发明涉及互联网中网站内容的采集复制技术,更具体地,本发明涉及一种网站内容预防采集@的方法>。

背景技术

[0002] 本文中所提到的术语“采集”是指程序按照规定的规则定向获取其他网站数据的方式。网络采集器是一个用来批量处理网页、论坛等采集的工具,直接把采集的内容保存到数据库或者发布到网站,它提取一些数据从目标网页形成统一的本地数据库。比如互联网上新成立的网站,往往需要大量的数据来丰富其网站的内容。在这种情况下,一些网站管理者可能会利用网络采集器快速大量复制其他网站内容,而采集快速丰富自己的网站。但是,对于以采集网站的内容为主的网站,尤其是原创的内容,这种操作占用了采集网站@的内容>大量的网络资源,降低了网络的速度和效率;另一方面,也侵犯了采集网站的知识产权,损害了采集网站的利益。为了限制网站内容被他人采集使用,反采集技术应运而生。

[0003] 目前常见的反采集技术是在网站的每个网页的内容中使用混淆字符串。此技术通过向 Web 内容添加随机字符串来工作。这些字符串在普通用户浏览网页等正常情况下是不可见的。但是网页内容为采集后,混淆后的字符串会显示在网页采集中。这样采集接收到的内容就是混有混淆字符串的内容,不符合采集用户的要求,从而达到防止采集的目的。

[0004] 然而,这种在网站的每个网页内容中使用混淆字符串来实现反采集的方法存在一些固有缺陷。首先,添加到 Web 内容的随机字符串虽然对普通访问者不可见,但对索引 Web 内容的搜索引擎机器人来说是可见的。这导致当网页内容显示在搜索引擎的搜索结果中时,可能会添加随机字符串。同时,由于网站网页的内容混杂了无意义的随机字符串,可能导致网站在搜索引擎的搜索结果中排名较低,不利于推广 网站 并增加流量。其次,如果 采集 用户不太关心他们的 网站 网页内容的质量,添加到网页内容中的随机字符串将无法阻止采集,也无法从根本上解决问题。网页内容是有问题的 采集。

[0005] 现有的反采集技术通过添加混淆字符串来修改网页内容,破坏了网站对搜索引擎的友好性。同时也是一种被动的预防采集措施。虽然添加了随机字符串,但如果采集所有者对采集的内容质量要求不高,采集仍然可以任意使用。采集。

[0006] 因此,需要一种在不修改网页内容的情况下防止网页内容为采集的方法。

发明内容

[0007] 本发明通过识别网站访问者是普通用户还是采集器来防止网站的网页内容是采集。

本发明提供一种网站内容预防采集系统,该系统包括:

[0009] 获取单元,用于获取用户的ID、IP地址、User-Agent和当前时间;[0010] 查询单元,用于查询用户在预定时间内对网站页面的访问情况;

比较单元用于将页面在预定时间段内的访问量与用户对该记录的设定值进行比较,

[0012] 禁止单元,当用户在预定时间段内对网站页面的访问大于设定值时,禁止用户对网站的访问。

优选地,该网站内容预防采集系统还包括:

存储单元,用于存储IP地址白名单和IP地址黑名单;和

判断单元,如果获取到的用户的IP地址属于IP地址白名单,则允许用户访问网站;如果获取的用户IP地址属于IP地址黑名单,则禁止用户访问网站。

优选地,所述IP地址白名单包括搜索引擎的IP地址。

本发明提供一种网站内容预防采集方法,该方法包括:

获取用户ID、IP地址、User-Agent和当前时间;

[0019]统计用户在预定时间段内访问的网站页面,得到预定时间段的用户访问量;

将此访问量与设置值进行比较;

[0021] 如果访问量大于设定值,则禁止用户访问网站。

优选地,在所述获取用户IP地址步骤之后,

如果获取到的用户的IP地址属于IP地址白名单,则允许该用户访问网站;

[0024] 如果获取的用户IP地址属于IP地址黑名单,则禁止用户访问网站。

[0025] 优选地,该方法还包括将搜索引擎的IP地址放入IP地址白名单中。

[0026] 优选地,将被禁止用户的IP地址放入IP地址黑名单中。

[0027] 优选地,预定时间段为1-600秒,设定值的取值为预定时间段内秒数的1-50倍。

[0028] 由于采集是一种通过快速复制其他网站网页的内容来获取其他网站数据的方法,所以当采集器执行采集时,访问网站 页,例如,频率为每分钟 120 页或更多。相反,普通用户在浏览网站时,一般不会达到如此高的访问频率。这种差异允许识别 采集器 的访问权限,从而限制 采集器 继续访问 网站 内容。

根据本发明的网站内容预防采集方法,利用不同于实现采集添加混淆字符串的实现原理,解决了当前预防的存在。 采集 技术。缺陷。本发明的网站内容预防采集方法不对网站内容做任何修改,不会影响搜索引擎的索引。同时,由于该方法可以区分网站访问者是普通用户还是采集器,通过限制采集器对网站的访问,从根本上解决网站 内容海量采集问题。

图纸说明

下面参照附图并结合实施例对本发明进行详细说明,其中,

附图说明图1示出了根据本发明优选实施例的系统框图;

图2为本发明较佳实施例的方法流程图。

图3示出了根据本发明另一优选实施例的方法的流程图。详细说明

[0034] 图。图1示出了根据本发明优选实施例的网站内容预防采集系统100的结构框图。该系统包括:获取单元,用于获取用户的ID、IP地址、User-Agent和当前时间;查询单元,用于查询用户在预定时间内对网站页面的访问量;比较单元,用于将记录的用户在预定时间段内对网站页面的记录访问次数与设定值进行比较。当访问次数大于设定值时,禁止用户访问网站。

[0035] 网站内容防护采集系统的获取单元在接收到每个访问请求时可以记录访问者的ID、IP地址、用户代理(user-Agent)和访问时间。当访问者通过浏览器程序(例如 hternet Explorer)或通过 采集器 程序访问 网站 时,访问者的浏览器程序或 采集器 程序通常会向网站发送一条消息,描述自己的身份字符串,这个字符串称为her-Agent。用户使用的不同软件通常会发送不同的her-Agent。通过将访问者的 IP 地址与 her-Agent 相结合,网站 可以识别和区分每个访问者。查询单元查询当前访问者在单位时间段内访问的网站页面数,即访问次数。比较单元将查询单元查询到的用户访问量与设定的访问量进行比较。如果单位时间段内的页面访问量超过设定的访问量,则可以判断该访问者的访问异常。使用权。禁止单位可以禁止访问者对网站的非正常访问。

[0036] 单位时间段和单位时间段内页面访问量的设定值是可以在网站程序配置中分别修改的两个变量。例如,单位时间段可以设置在10到600秒之间。如果单位时间段设置得太短,普通用户的访问可能会被误判为异常访问。如果单位时间段设置过长,可能会导致采集器在设置的时间段内有采集大量数据。网站 检测到当前访问是 采集器 的访问。由于采集器在执行采集时通常有1-50页/秒的频率,所以可以将单位时间段的浏览量值设置为所选单位时间的1-50倍的segment . 例如,单位时间段可以设置为60秒,单位时间段内的浏览量设定值可以设置为600页。由于采集器的采集的速度受网速、网站响应速度等多种因素影响,具体的单位时间段和单位时间段内的页面访问量应让网站管理员根据以实际情况为准。设置。

[0037] 此外,根据本发明的网站内容预防采集系统还可以包括:存储单元,用于存储IP地址白名单和IP地址黑名单,以及判断单元,其是用于判断用户地址是IP白地址还是IP黑地址。如果是IP白地址,则允许用户访问网站;如果是IP黑地址,则禁止用户访问网站。由于搜索引擎在对网站数据进行索引时也可能存在较高的访问频率,为了防止搜索引擎的索引操作被误判为采集,根据本发明,网站内容预防采集系统可以提供IP地址白名单功能,将常用搜索引擎的IP地址或IP地址段加入IP地址白名单。这些IP地址的访问会绕过访问频率的判断,不受访问量设定值的限制。进一步地,根据本发明的网站内容预防采集系统可以提供IP地址黑名单功能,将常见的采集器IP地址添加到IP地址黑名单中。这些IP地址的访问会绕过访问频率的判断,直接被禁止。根据本发明的系统可以提供IP地址黑名单功能,将普通的采集器IP地址添加到IP地址黑名单中。这些IP地址的访问会绕过访问频率的判断,直接被禁止。根据本发明的系统可以提供IP地址黑名单功能,将普通的采集器IP地址添加到IP地址黑名单中。这些IP地址的访问会绕过访问频率的判断,直接被禁止。

[0038] 图。图2示出了根据本发明优选实施例的方法的流程图。本实施例的网站内容防护采集方法包括以下步骤:获取用户的ID、IP地址、User-Agent和当前时间。@>页面统计获取用户在预定时间段内的访问量;将访问量与设定值进行比较;如果访问量大于设定值,则禁止用户访问网站。

[0039] 图。图3示出了根据本发明另一优选实施例的方法的流程图。由于搜索引擎在对网站数据进行索引时也可能存在较高的访问频率,为了防止搜索引擎的索引操作被误判为采集,根据本发明,网站内容防范采集系统可以提供IP地址白名单功能,将常用搜索引擎的IP地址或IP地址段添加到IP地址白名单中。这些IP地址的访问会绕过访问频率的判断,不受访问量设定值的限制。图3所示方法与图2所示方法步骤的不同之处在于,在所述获取用户IP地址的步骤之后,首先判断用户的IP地址是否属于IP地址白名单,如果属于,则允许用户<访问@网站。如果不是,则判断用户的IP地址是否属于IP地址黑名单。如果是这样,请禁用用户对 网站 的访问。如果没有,如图2,继续查询用户对网站页面的访问次数。

下面以PHP+MySQL的开发环境为例来说明实现方法,其他语言类似:

数据库:

可以通过以下 SQL 语句建立数据表:

创建表“访问列表”(

~icfINT(10) NOT NULL AUTO_INCREMENT 主键,

VARCHAR(40)NOT NULL DEFAULT",

"useragent" VARCHAR(255)NOT NULL DEFAULT",

~time~INT(10)NOT NULL DEFAULT'0'

) 引擎=MYISAM;

数据表中有4个字段:id、ip、useragent、time分别代表记录ID、用户IP、用户User-Agent、访问时间。

主程序代码说明:

获取用户IP、User-Agent信息:

程序首先会获取用户的IP、her-Agent、当前时间信息,代码如下:

[0053] $ip=$_SERVER['REMOTE_ADDR'];

[0054] $useragent=$_SERVER['HTTP_USER_AGENT'];

$时间=时间();//time() 函数以秒为单位返回当前的 UNIX 时间戳

[0056] 然后,将上述数据存储在数据库中。代码显示如下:

[0057] mysql_query("INSERT INTO visitlist(,ip,,,useragent,time,)值('$ip','$useragent','$time')");

查询当前用户在单位时间段内访问的页面数:

[0059] 假设单位时间段是管理员设置的常数网站:

[0060] 定义('DURATION',60);

$time_start=time()-DURATION;//当前时间减去设置的时间段,即为开始时间

[0062] $query = mysql_query (" SELECT COUNT (*) AS visit_count FROM visitlistffHERE "time" > $time_start AND-ip-='{$this->base->ip}' AND, useragent, =' {$useragent }"');

[0063] $row=mysql_fetch_array($query);

[0064] $visit_count = isset($row['visit_count']) ? $row['vist_count']: 0;

[0065] 判断单位时间段内访问的页面数是否大于设定值,并处理最终结果: [0066] 假设单位时间段内访问的页面数是< @网站 管理员:

[0067] 定义('MAX_PAGES', 300);

如果($visit_count>MAX_PAGES){

[0069] exit('访问频率太高,禁止访问');//这里也可以将访问者的IP地址加入网站IP黑名单,可以更有效的禁止用户访问。

[0070] }

应当理解,以上通过本发明的优选实施例对本发明的技术方案进行了详细描述,应当理解,以上描述是示例性的,而非限制性的。本领域普通技术人员在阅读了本发明说明书的基础上,可以对各个实施例中描述的技术方案进行修改,或者对部分技术特征进行等同替换;并且这些修改或替换并没有做出相应的技术方案。其实质脱离了本发明实施例的技术方案的精神和范围。本发明的保护范围仅由所附权利要求限定。 查看全部

网站内容采集系统(

本发明涉及一种网站内容防采集方法(图)涉及)

网站内容预防采集系统和方法

技术领域

[0001] 本发明涉及互联网中网站内容的采集复制技术,更具体地,本发明涉及一种网站内容预防采集@的方法>。

背景技术

[0002] 本文中所提到的术语“采集”是指程序按照规定的规则定向获取其他网站数据的方式。网络采集器是一个用来批量处理网页、论坛等采集的工具,直接把采集的内容保存到数据库或者发布到网站,它提取一些数据从目标网页形成统一的本地数据库。比如互联网上新成立的网站,往往需要大量的数据来丰富其网站的内容。在这种情况下,一些网站管理者可能会利用网络采集器快速大量复制其他网站内容,而采集快速丰富自己的网站。但是,对于以采集网站的内容为主的网站,尤其是原创的内容,这种操作占用了采集网站@的内容>大量的网络资源,降低了网络的速度和效率;另一方面,也侵犯了采集网站的知识产权,损害了采集网站的利益。为了限制网站内容被他人采集使用,反采集技术应运而生。

[0003] 目前常见的反采集技术是在网站的每个网页的内容中使用混淆字符串。此技术通过向 Web 内容添加随机字符串来工作。这些字符串在普通用户浏览网页等正常情况下是不可见的。但是网页内容为采集后,混淆后的字符串会显示在网页采集中。这样采集接收到的内容就是混有混淆字符串的内容,不符合采集用户的要求,从而达到防止采集的目的。

[0004] 然而,这种在网站的每个网页内容中使用混淆字符串来实现反采集的方法存在一些固有缺陷。首先,添加到 Web 内容的随机字符串虽然对普通访问者不可见,但对索引 Web 内容的搜索引擎机器人来说是可见的。这导致当网页内容显示在搜索引擎的搜索结果中时,可能会添加随机字符串。同时,由于网站网页的内容混杂了无意义的随机字符串,可能导致网站在搜索引擎的搜索结果中排名较低,不利于推广 网站 并增加流量。其次,如果 采集 用户不太关心他们的 网站 网页内容的质量,添加到网页内容中的随机字符串将无法阻止采集,也无法从根本上解决问题。网页内容是有问题的 采集。

[0005] 现有的反采集技术通过添加混淆字符串来修改网页内容,破坏了网站对搜索引擎的友好性。同时也是一种被动的预防采集措施。虽然添加了随机字符串,但如果采集所有者对采集的内容质量要求不高,采集仍然可以任意使用。采集。

[0006] 因此,需要一种在不修改网页内容的情况下防止网页内容为采集的方法。

发明内容

[0007] 本发明通过识别网站访问者是普通用户还是采集器来防止网站的网页内容是采集。

本发明提供一种网站内容预防采集系统,该系统包括:

[0009] 获取单元,用于获取用户的ID、IP地址、User-Agent和当前时间;[0010] 查询单元,用于查询用户在预定时间内对网站页面的访问情况;

比较单元用于将页面在预定时间段内的访问量与用户对该记录的设定值进行比较,

[0012] 禁止单元,当用户在预定时间段内对网站页面的访问大于设定值时,禁止用户对网站的访问。

优选地,该网站内容预防采集系统还包括:

存储单元,用于存储IP地址白名单和IP地址黑名单;和

判断单元,如果获取到的用户的IP地址属于IP地址白名单,则允许用户访问网站;如果获取的用户IP地址属于IP地址黑名单,则禁止用户访问网站。

优选地,所述IP地址白名单包括搜索引擎的IP地址。

本发明提供一种网站内容预防采集方法,该方法包括:

获取用户ID、IP地址、User-Agent和当前时间;

[0019]统计用户在预定时间段内访问的网站页面,得到预定时间段的用户访问量;

将此访问量与设置值进行比较;

[0021] 如果访问量大于设定值,则禁止用户访问网站。

优选地,在所述获取用户IP地址步骤之后,

如果获取到的用户的IP地址属于IP地址白名单,则允许该用户访问网站;

[0024] 如果获取的用户IP地址属于IP地址黑名单,则禁止用户访问网站。

[0025] 优选地,该方法还包括将搜索引擎的IP地址放入IP地址白名单中。

[0026] 优选地,将被禁止用户的IP地址放入IP地址黑名单中。

[0027] 优选地,预定时间段为1-600秒,设定值的取值为预定时间段内秒数的1-50倍。

[0028] 由于采集是一种通过快速复制其他网站网页的内容来获取其他网站数据的方法,所以当采集器执行采集时,访问网站 页,例如,频率为每分钟 120 页或更多。相反,普通用户在浏览网站时,一般不会达到如此高的访问频率。这种差异允许识别 采集器 的访问权限,从而限制 采集器 继续访问 网站 内容。

根据本发明的网站内容预防采集方法,利用不同于实现采集添加混淆字符串的实现原理,解决了当前预防的存在。 采集 技术。缺陷。本发明的网站内容预防采集方法不对网站内容做任何修改,不会影响搜索引擎的索引。同时,由于该方法可以区分网站访问者是普通用户还是采集器,通过限制采集器对网站的访问,从根本上解决网站 内容海量采集问题。

图纸说明

下面参照附图并结合实施例对本发明进行详细说明,其中,

附图说明图1示出了根据本发明优选实施例的系统框图;

图2为本发明较佳实施例的方法流程图。

图3示出了根据本发明另一优选实施例的方法的流程图。详细说明

[0034] 图。图1示出了根据本发明优选实施例的网站内容预防采集系统100的结构框图。该系统包括:获取单元,用于获取用户的ID、IP地址、User-Agent和当前时间;查询单元,用于查询用户在预定时间内对网站页面的访问量;比较单元,用于将记录的用户在预定时间段内对网站页面的记录访问次数与设定值进行比较。当访问次数大于设定值时,禁止用户访问网站。

[0035] 网站内容防护采集系统的获取单元在接收到每个访问请求时可以记录访问者的ID、IP地址、用户代理(user-Agent)和访问时间。当访问者通过浏览器程序(例如 hternet Explorer)或通过 采集器 程序访问 网站 时,访问者的浏览器程序或 采集器 程序通常会向网站发送一条消息,描述自己的身份字符串,这个字符串称为her-Agent。用户使用的不同软件通常会发送不同的her-Agent。通过将访问者的 IP 地址与 her-Agent 相结合,网站 可以识别和区分每个访问者。查询单元查询当前访问者在单位时间段内访问的网站页面数,即访问次数。比较单元将查询单元查询到的用户访问量与设定的访问量进行比较。如果单位时间段内的页面访问量超过设定的访问量,则可以判断该访问者的访问异常。使用权。禁止单位可以禁止访问者对网站的非正常访问。

[0036] 单位时间段和单位时间段内页面访问量的设定值是可以在网站程序配置中分别修改的两个变量。例如,单位时间段可以设置在10到600秒之间。如果单位时间段设置得太短,普通用户的访问可能会被误判为异常访问。如果单位时间段设置过长,可能会导致采集器在设置的时间段内有采集大量数据。网站 检测到当前访问是 采集器 的访问。由于采集器在执行采集时通常有1-50页/秒的频率,所以可以将单位时间段的浏览量值设置为所选单位时间的1-50倍的segment . 例如,单位时间段可以设置为60秒,单位时间段内的浏览量设定值可以设置为600页。由于采集器的采集的速度受网速、网站响应速度等多种因素影响,具体的单位时间段和单位时间段内的页面访问量应让网站管理员根据以实际情况为准。设置。

[0037] 此外,根据本发明的网站内容预防采集系统还可以包括:存储单元,用于存储IP地址白名单和IP地址黑名单,以及判断单元,其是用于判断用户地址是IP白地址还是IP黑地址。如果是IP白地址,则允许用户访问网站;如果是IP黑地址,则禁止用户访问网站。由于搜索引擎在对网站数据进行索引时也可能存在较高的访问频率,为了防止搜索引擎的索引操作被误判为采集,根据本发明,网站内容预防采集系统可以提供IP地址白名单功能,将常用搜索引擎的IP地址或IP地址段加入IP地址白名单。这些IP地址的访问会绕过访问频率的判断,不受访问量设定值的限制。进一步地,根据本发明的网站内容预防采集系统可以提供IP地址黑名单功能,将常见的采集器IP地址添加到IP地址黑名单中。这些IP地址的访问会绕过访问频率的判断,直接被禁止。根据本发明的系统可以提供IP地址黑名单功能,将普通的采集器IP地址添加到IP地址黑名单中。这些IP地址的访问会绕过访问频率的判断,直接被禁止。根据本发明的系统可以提供IP地址黑名单功能,将普通的采集器IP地址添加到IP地址黑名单中。这些IP地址的访问会绕过访问频率的判断,直接被禁止。

[0038] 图。图2示出了根据本发明优选实施例的方法的流程图。本实施例的网站内容防护采集方法包括以下步骤:获取用户的ID、IP地址、User-Agent和当前时间。@>页面统计获取用户在预定时间段内的访问量;将访问量与设定值进行比较;如果访问量大于设定值,则禁止用户访问网站。

[0039] 图。图3示出了根据本发明另一优选实施例的方法的流程图。由于搜索引擎在对网站数据进行索引时也可能存在较高的访问频率,为了防止搜索引擎的索引操作被误判为采集,根据本发明,网站内容防范采集系统可以提供IP地址白名单功能,将常用搜索引擎的IP地址或IP地址段添加到IP地址白名单中。这些IP地址的访问会绕过访问频率的判断,不受访问量设定值的限制。图3所示方法与图2所示方法步骤的不同之处在于,在所述获取用户IP地址的步骤之后,首先判断用户的IP地址是否属于IP地址白名单,如果属于,则允许用户<访问@网站。如果不是,则判断用户的IP地址是否属于IP地址黑名单。如果是这样,请禁用用户对 网站 的访问。如果没有,如图2,继续查询用户对网站页面的访问次数。

下面以PHP+MySQL的开发环境为例来说明实现方法,其他语言类似:

数据库:

可以通过以下 SQL 语句建立数据表:

创建表“访问列表”(

~icfINT(10) NOT NULL AUTO_INCREMENT 主键,

VARCHAR(40)NOT NULL DEFAULT",

"useragent" VARCHAR(255)NOT NULL DEFAULT",

~time~INT(10)NOT NULL DEFAULT'0'

) 引擎=MYISAM;

数据表中有4个字段:id、ip、useragent、time分别代表记录ID、用户IP、用户User-Agent、访问时间。

主程序代码说明:

获取用户IP、User-Agent信息:

程序首先会获取用户的IP、her-Agent、当前时间信息,代码如下:

[0053] $ip=$_SERVER['REMOTE_ADDR'];

[0054] $useragent=$_SERVER['HTTP_USER_AGENT'];

$时间=时间();//time() 函数以秒为单位返回当前的 UNIX 时间戳

[0056] 然后,将上述数据存储在数据库中。代码显示如下:

[0057] mysql_query("INSERT INTO visitlist(,ip,,,useragent,time,)值('$ip','$useragent','$time')");

查询当前用户在单位时间段内访问的页面数:

[0059] 假设单位时间段是管理员设置的常数网站:

[0060] 定义('DURATION',60);

$time_start=time()-DURATION;//当前时间减去设置的时间段,即为开始时间

[0062] $query = mysql_query (" SELECT COUNT (*) AS visit_count FROM visitlistffHERE "time" > $time_start AND-ip-='{$this->base->ip}' AND, useragent, =' {$useragent }"');

[0063] $row=mysql_fetch_array($query);

[0064] $visit_count = isset($row['visit_count']) ? $row['vist_count']: 0;

[0065] 判断单位时间段内访问的页面数是否大于设定值,并处理最终结果: [0066] 假设单位时间段内访问的页面数是< @网站 管理员:

[0067] 定义('MAX_PAGES', 300);

如果($visit_count>MAX_PAGES){

[0069] exit('访问频率太高,禁止访问');//这里也可以将访问者的IP地址加入网站IP黑名单,可以更有效的禁止用户访问。

[0070] }

应当理解,以上通过本发明的优选实施例对本发明的技术方案进行了详细描述,应当理解,以上描述是示例性的,而非限制性的。本领域普通技术人员在阅读了本发明说明书的基础上,可以对各个实施例中描述的技术方案进行修改,或者对部分技术特征进行等同替换;并且这些修改或替换并没有做出相应的技术方案。其实质脱离了本发明实施例的技术方案的精神和范围。本发明的保护范围仅由所附权利要求限定。

网站内容采集系统(PHPMaosv1.7小说建站采集系统推荐使用5.2系列最新版本)

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2022-01-29 23:28

PHPMaos v1.7新颖建站采集系统,内置三组模板和自定义采集,支持全站HTML静态解压密码:demo:官网: 论坛:官方QQ群:15452311 操作系统环境要求:WEB服务器:Apache(IIS,NGINX)+PHP+MYSQL+优化器v3.0以上空间:100M以上数据库空间:100M以上数据库: mysql 5.0以上程序支持:PHP 4.3.0及以上(推荐使用5.2系列最新版本)一、PHPMAOS V< @1.7 产品介绍:PHPMAOS是基于PHP+MySQL的技术开发,支持Windows、Linux、Unix等服务器平台,2010年发布第一个版本。PHPMAOS简单、健壮、灵活,专注于新颖的系统。我们将坚持做国内使用最广泛的php小说系统。 二、PHPMAOS V1.7 主要功能:默认内置模型:串口模块、采集系统、链接、广告管理、作者模块、会员模块等;可以自定义是否打开作者模块、会员模板;自定义 采集 函数; 三、PHPMAOS V1.7个后续版本及功能列表:1、会员中心包括:(1)会员博客;(2)会员原创 ;(3)成员组功能;(4)vipworks2、更明确的模块概念PHPMAOS更明确的模块概念,PHPMAOS的模块与其他系统不同,更像是windows中的软件,可以自由打包,自由安装,不局限于系统的API,这样做的好处是可以吸引更多的用户开发各种实际应用,我们承诺未来会做接口API包专门针对PHPMAOS的常用功能,让用户二次开发更加方便注:PHPMAOS小说站内仍有不少盗贼程序陆续开启,请关注PHPMAOS官网及phpmaos论坛,请勿转载修改加密文件,否则会导致网站无法访问。 查看全部

网站内容采集系统(PHPMaosv1.7小说建站采集系统推荐使用5.2系列最新版本)

PHPMaos v1.7新颖建站采集系统,内置三组模板和自定义采集,支持全站HTML静态解压密码:demo:官网: 论坛:官方QQ群:15452311 操作系统环境要求:WEB服务器:Apache(IIS,NGINX)+PHP+MYSQL+优化器v3.0以上空间:100M以上数据库空间:100M以上数据库: mysql 5.0以上程序支持:PHP 4.3.0及以上(推荐使用5.2系列最新版本)一、PHPMAOS V< @1.7 产品介绍:PHPMAOS是基于PHP+MySQL的技术开发,支持Windows、Linux、Unix等服务器平台,2010年发布第一个版本。PHPMAOS简单、健壮、灵活,专注于新颖的系统。我们将坚持做国内使用最广泛的php小说系统。 二、PHPMAOS V1.7 主要功能:默认内置模型:串口模块、采集系统、链接、广告管理、作者模块、会员模块等;可以自定义是否打开作者模块、会员模板;自定义 采集 函数; 三、PHPMAOS V1.7个后续版本及功能列表:1、会员中心包括:(1)会员博客;(2)会员原创 ;(3)成员组功能;(4)vipworks2、更明确的模块概念PHPMAOS更明确的模块概念,PHPMAOS的模块与其他系统不同,更像是windows中的软件,可以自由打包,自由安装,不局限于系统的API,这样做的好处是可以吸引更多的用户开发各种实际应用,我们承诺未来会做接口API包专门针对PHPMAOS的常用功能,让用户二次开发更加方便注:PHPMAOS小说站内仍有不少盗贼程序陆续开启,请关注PHPMAOS官网及phpmaos论坛,请勿转载修改加密文件,否则会导致网站无法访问。

网站内容采集系统(网站内容采集系统的采集方法,让我们通过www.chanyong.yp)

采集交流 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2022-01-29 21:01

网站内容采集系统是对原创文章采集筛选,提取相关关键词,编写成网页格式,在采集再利用,以前网站上的资源和原创文章都是需要通过论坛、博客、网上的网站扒、爬虫、蜘蛛等渠道对原创文章进行采集、复制粘贴,这个效率和速度太慢了,下面我们就来说一下网站内容采集系统的采集方法,让我们通过www.chanyong.yp一起打造网站内容采集系统吧。

首先分析下我们要采集的资源的格式可能是:txt、jpg、txt、rtf、pdf、xml、csv、swf、xml+css文件等,这些格式的文件是什么格式的?都是从哪里抓取的呢?接下来我们从浏览器上面分析一下:通过访问浏览器的地址栏,发现大家都会发现浏览器通过后缀名为“*.xml”的javascript文件,对页面进行处理,生成jpg或者txt或者其他格式的内容,并提取出来通过搜索引擎进行查询。

当然这些方法其实很简单,现在大家要做的就是利用浏览器,一起设置一下ip地址、域名等属性就可以自动抓取网站内容了。现在网站上有很多便捷抓取功能,有网站内容采集系统和网站内容站群两大类,有的加入ftp账号有的不加入也一样可以抓取,两个办法都很简单,具体实施还是需要看实际需求。网站内容采集系统设置好要采集网站内容的资源后,我们就要进行网站内容采集软件的设置,网站内容采集软件可以跟随相关采集软件实现采集,我们就开始把采集软件设置好吧:。

1、url地址设置,

2、user-agent设置,编写代码抓取,

3、时间设置,

4、抓取按钮设置,设置采集按钮,设置抓取软件是否自动识别网站内容(自动抓取,

5、抓取内容实时显示,

6、抓取进度设置,网站内容抓取完毕或抓取中就显示抓取进度。

7、可进行文本、xml、css字符串等方式存储,每次下次再进行抓取时可以直接下载更新,

8、可设置内容展示区,

9、支持自动格式化抓取规则,

0、支持云服务器抓取、并发采集等多样化抓取方式。网站内容采集系统最大的特点就是抓取成功后,网站下次再抓取就会自动保存下次抓取,这就是我们常说的自动编辑记录,节省大量时间,大家只要按照采集软件提示完成相应的设置就可以进行下一次抓取了。通过以上内容小编介绍的方法,可以快速的进行网站内容采集系统的开发和定制,让系统更加灵活和便捷,如果有需要的同学可以私信联系我哦。 查看全部

网站内容采集系统(网站内容采集系统的采集方法,让我们通过www.chanyong.yp)

网站内容采集系统是对原创文章采集筛选,提取相关关键词,编写成网页格式,在采集再利用,以前网站上的资源和原创文章都是需要通过论坛、博客、网上的网站扒、爬虫、蜘蛛等渠道对原创文章进行采集、复制粘贴,这个效率和速度太慢了,下面我们就来说一下网站内容采集系统的采集方法,让我们通过www.chanyong.yp一起打造网站内容采集系统吧。

首先分析下我们要采集的资源的格式可能是:txt、jpg、txt、rtf、pdf、xml、csv、swf、xml+css文件等,这些格式的文件是什么格式的?都是从哪里抓取的呢?接下来我们从浏览器上面分析一下:通过访问浏览器的地址栏,发现大家都会发现浏览器通过后缀名为“*.xml”的javascript文件,对页面进行处理,生成jpg或者txt或者其他格式的内容,并提取出来通过搜索引擎进行查询。

当然这些方法其实很简单,现在大家要做的就是利用浏览器,一起设置一下ip地址、域名等属性就可以自动抓取网站内容了。现在网站上有很多便捷抓取功能,有网站内容采集系统和网站内容站群两大类,有的加入ftp账号有的不加入也一样可以抓取,两个办法都很简单,具体实施还是需要看实际需求。网站内容采集系统设置好要采集网站内容的资源后,我们就要进行网站内容采集软件的设置,网站内容采集软件可以跟随相关采集软件实现采集,我们就开始把采集软件设置好吧:。

1、url地址设置,

2、user-agent设置,编写代码抓取,

3、时间设置,

4、抓取按钮设置,设置采集按钮,设置抓取软件是否自动识别网站内容(自动抓取,

5、抓取内容实时显示,

6、抓取进度设置,网站内容抓取完毕或抓取中就显示抓取进度。

7、可进行文本、xml、css字符串等方式存储,每次下次再进行抓取时可以直接下载更新,

8、可设置内容展示区,

9、支持自动格式化抓取规则,

0、支持云服务器抓取、并发采集等多样化抓取方式。网站内容采集系统最大的特点就是抓取成功后,网站下次再抓取就会自动保存下次抓取,这就是我们常说的自动编辑记录,节省大量时间,大家只要按照采集软件提示完成相应的设置就可以进行下一次抓取了。通过以上内容小编介绍的方法,可以快速的进行网站内容采集系统的开发和定制,让系统更加灵活和便捷,如果有需要的同学可以私信联系我哦。

网站内容采集系统( 所述各个网络爬虫的状态调度与方法及系统的应用)

采集交流 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2022-01-26 21:18

所述各个网络爬虫的状态调度与方法及系统的应用)

一种基于互联网的舆情数据采集方法及系统制作方法

【技术领域】

[0001] 本发明涉及互联网数据采集技术领域,具体涉及一种基于互联网的舆情数据采集的方法和系统。

【背景技术】

网络舆情是通过互联网传播的,公众对现实生活中的一些热点和焦点问题,主要通过论坛上的论坛,具有较强的影响力、倾向性情绪、态度、意见、言论或观点。发表评论和跟进,博客等得到落实和加强。由于互联网具有虚拟性、隐蔽性、发散性、渗透性和随机性等特点,越来越多的网民愿意通过这个渠道发表意见、传播思想。而且,互联网已经成为反映社会舆论的主要载体之一。

目前,大部分部门和企业的舆情监测管理工作主要依靠人工,人工舆情监测面临舆情信息采集不全、舆情信息发现不及时、舆情信息发现不准确、舆论信息使用不便。和许多其他问题。因此,舆情信息的采集和上报完全靠人工,耗费大量时间和精力,效果也不理想。

[0004] 在新的互联网形势下,面对这样的困扰,需要借助互联网舆情监测工具,快速建立大规模的舆情监测机制,提高互联网舆情数据的采集能力和网络舆情监测能力。实战部门情报。引导能力。

【发明内容】

[0005] 鉴于上述问题,本发明提出提供一种基于互联网的舆情数据采集的方法和系统,以克服上述问题或至少部分地解决或缓解上述问题。

根据本发明的一个方面,提供了一种基于互联网的舆情数据采集方法,该方法包括:

实时监控各个网络爬虫的状态,根据各个描述的网络爬虫的状态调度各个网络爬虫,实现对互联网上每个预设舆情网站内容和/或其他网站内容屏蔽;

[0008] 使用网络爬虫根据预设条件爬取各个预设舆情网站的网页内容,并从爬取的数据中提取对应的网站地址;

[0009] 对网站的地址进行地址解析,对解析成功的网站的地址进行去重、去噪和分类;

[0010] 使用网络爬虫爬取分类成功网站的网站地址对应的网页内容;

为获取网站对应的网页内容建立舆情数据全文索引信息,并将所述网页内容存储在预设内容数据库中,舆情数据全文索引信息存储在预设索引数据库中。

可选的,所述实时监控多个网络爬虫的状态,根据所述网络爬虫的状态调度各个网络爬虫,包括:

[0013] 根据用户输入的网站网站,预先设置需要在互联网上进行网页内容爬取的舆情网站,以及网站无需在互联网上进行网页内容爬取;

根据用户输入的爬虫设置参数,进行网络爬虫的设置;

[0015] 实时感知各个网络爬虫的工作状态;

根据各网络爬虫的工作状态,生成爬虫分类信息,将负担大于第一预设值的爬虫从当前的取数据任务中解放出来,分配负担小于第二预设值的爬虫执行描述的数据捕获任务;

[0017] 过滤不需要网页内容爬取的网站的地址。

可选的,所述采用所述网络爬虫根据预设条件对所述各个预设舆情网站的网页内容进行爬取,并提取对应的网站地址,包括:

[0019] 根据预设条件,抓取各个预设舆情网站的网页内容;

[0020] 计算获取的网页信息与预设条件的相似度;

[0021] 根据相似度大于第三预设值的网页信息生成对应的网站地址。

[0022] 可选的,对网站的地址进行地址解析,对解析成功的网站的地址进行去重、去噪和分类,包括:

[0023] 对网站地址进行地址类型判断,根据判断结果选择合适的地址解析器进行地址解析,对解析成功的网站地址进行去重去噪;

[0024] 对去重去噪后的网站地址进行分类。

可选的,所述采用所述网络爬虫爬取分类成功的网站地址的网站对应的网页内容,并下载该网页的全文信息,包括:

[0026] 使用网络爬虫爬取分类成功网站对应的网站地址的网络内容;

[0027] 根据分类成功的网站地址的地址类型选择下载器,并使用选择的下载器下载网页内容。

可选的,为抓取到的网站对应的网页内容建立舆情数据全文索引信息,并将该网页内容存储在预设的内容数据库中,并将舆情数据全文索引信息存储在预设的内容数据库。设置的索引数据库,包括:

[0029] 为被抓取的对应网站的网页内容建立舆情数据全文索引信息;

[0030] 取到的网站对应的网页内容存储在预设的内容库中,舆情数据全文索引信息存储在预设的索引库中;

[0031] 对索引数据库中存储的数据进行统计分析。

[0032] 根据本发明的另一方面,提供了一种基于互联网的舆情数据采集系统,该系统包括数据采集单元和检索分析单元,数据采集单元包括爬虫调度子系统和网络爬虫子系统;

爬虫调度子系统用于实时监控各个网络爬虫的状态,根据各个网络爬虫的状态调度各个网络爬虫,从而实现对各个预设舆情内容的爬取网站@ > 在互联网上和/或阻止互联网上的其他 网站 内容;

[0034] 网络爬虫子系统,用于根据预设条件对各个预设舆情网站的网页内容进行爬取,并从爬取的数据中提取对应的网站地址;对网站的地址进行地址解析,对解析成功的网站地址进行去重去噪后的分类;网络爬虫子系统也用于分类成功的网站@网站地址对应要爬取的网站的网页内容;

[0035] 检索分析单元,用于为网站对应的网页内容建立舆情数据全文索引信息,将网页内容存入预设的内容数据库和全文索引网页的信息。存储在预设索引数据库中。

可选的,所述爬虫调度子系统包括:

[0037] 分类配置模块用于根据用户输入的网站网址预先设置互联网中需要抓取网页内容的舆情网站,网站 @网站 互联网中的网页内容不需要爬取。@网站;

爬虫配置模块,用于根据用户输入的爬虫进行参数设置,进行网络爬虫系统的设置;

[0039] 状态监测模块用于实时感知各个网络爬虫的工作状态;

爬虫分发模块,用于根据各个网络爬虫的工作状态生成爬虫分类信息,将负担大于第一预设值的爬虫从当前的数据抓取任务中解放出来,分发负担小于第一预设值的爬虫。第二个预设值。值爬虫执行数据抓取任务;

[0041] 站点过滤模块用于过滤不需要网页内容爬取的网站的地址。

可选的,所述网络爬虫子系统,包括:

[0043] 抓取模块,用于根据预设条件抓取各个预设舆情的网页内容;

计算模块,用于计算所抓取的网页信息与所述预设条件的相似度;

生成模块,用于根据相似度大于第三预设值的网页信息生成对应的网站地址;

[0046] 地址解析模块用于判断网站地址的地址类型,根据判断结果选择合适的地址解析器进行地址解析,并对解析成功的网站地址进行去重。,去噪处理;

URL管理模块用于对网站去重去噪后的地址进行分类聚类;

所述爬取模块还用于对分类成功的网站地址的网站对应的网页内容进行爬取;

[0049] 地址下载模块用于根据分类成功的网站地址的地址类型选择下载器,并利用选择的下载器下载网页内容。

可选的,所述检索分析单元,包括:

[0051] 索引建立模块,用于为抓取到的网站对应的网页内容建立舆情数据全文索引信息。

[0052] 存储模块,用于将采集到的网站对应的网页内容存储到预设的内容库中,将舆情数据的全文索引信息存储到预设的索引库中;

[0053] 统计分析模块,用于对索引数据库中存储的数据进行统计分析。

本发明的有益效果是:

1、本发明提供的基于互联网的舆情数据采集方法及系统,由 查看全部

网站内容采集系统(

所述各个网络爬虫的状态调度与方法及系统的应用)

一种基于互联网的舆情数据采集方法及系统制作方法

【技术领域】

[0001] 本发明涉及互联网数据采集技术领域,具体涉及一种基于互联网的舆情数据采集的方法和系统。

【背景技术】

网络舆情是通过互联网传播的,公众对现实生活中的一些热点和焦点问题,主要通过论坛上的论坛,具有较强的影响力、倾向性情绪、态度、意见、言论或观点。发表评论和跟进,博客等得到落实和加强。由于互联网具有虚拟性、隐蔽性、发散性、渗透性和随机性等特点,越来越多的网民愿意通过这个渠道发表意见、传播思想。而且,互联网已经成为反映社会舆论的主要载体之一。

目前,大部分部门和企业的舆情监测管理工作主要依靠人工,人工舆情监测面临舆情信息采集不全、舆情信息发现不及时、舆情信息发现不准确、舆论信息使用不便。和许多其他问题。因此,舆情信息的采集和上报完全靠人工,耗费大量时间和精力,效果也不理想。

[0004] 在新的互联网形势下,面对这样的困扰,需要借助互联网舆情监测工具,快速建立大规模的舆情监测机制,提高互联网舆情数据的采集能力和网络舆情监测能力。实战部门情报。引导能力。

【发明内容】

[0005] 鉴于上述问题,本发明提出提供一种基于互联网的舆情数据采集的方法和系统,以克服上述问题或至少部分地解决或缓解上述问题。

根据本发明的一个方面,提供了一种基于互联网的舆情数据采集方法,该方法包括:

实时监控各个网络爬虫的状态,根据各个描述的网络爬虫的状态调度各个网络爬虫,实现对互联网上每个预设舆情网站内容和/或其他网站内容屏蔽;

[0008] 使用网络爬虫根据预设条件爬取各个预设舆情网站的网页内容,并从爬取的数据中提取对应的网站地址;

[0009] 对网站的地址进行地址解析,对解析成功的网站的地址进行去重、去噪和分类;

[0010] 使用网络爬虫爬取分类成功网站的网站地址对应的网页内容;

为获取网站对应的网页内容建立舆情数据全文索引信息,并将所述网页内容存储在预设内容数据库中,舆情数据全文索引信息存储在预设索引数据库中。

可选的,所述实时监控多个网络爬虫的状态,根据所述网络爬虫的状态调度各个网络爬虫,包括:

[0013] 根据用户输入的网站网站,预先设置需要在互联网上进行网页内容爬取的舆情网站,以及网站无需在互联网上进行网页内容爬取;

根据用户输入的爬虫设置参数,进行网络爬虫的设置;

[0015] 实时感知各个网络爬虫的工作状态;

根据各网络爬虫的工作状态,生成爬虫分类信息,将负担大于第一预设值的爬虫从当前的取数据任务中解放出来,分配负担小于第二预设值的爬虫执行描述的数据捕获任务;

[0017] 过滤不需要网页内容爬取的网站的地址。

可选的,所述采用所述网络爬虫根据预设条件对所述各个预设舆情网站的网页内容进行爬取,并提取对应的网站地址,包括:

[0019] 根据预设条件,抓取各个预设舆情网站的网页内容;

[0020] 计算获取的网页信息与预设条件的相似度;

[0021] 根据相似度大于第三预设值的网页信息生成对应的网站地址。

[0022] 可选的,对网站的地址进行地址解析,对解析成功的网站的地址进行去重、去噪和分类,包括:

[0023] 对网站地址进行地址类型判断,根据判断结果选择合适的地址解析器进行地址解析,对解析成功的网站地址进行去重去噪;

[0024] 对去重去噪后的网站地址进行分类。

可选的,所述采用所述网络爬虫爬取分类成功的网站地址的网站对应的网页内容,并下载该网页的全文信息,包括:

[0026] 使用网络爬虫爬取分类成功网站对应的网站地址的网络内容;

[0027] 根据分类成功的网站地址的地址类型选择下载器,并使用选择的下载器下载网页内容。

可选的,为抓取到的网站对应的网页内容建立舆情数据全文索引信息,并将该网页内容存储在预设的内容数据库中,并将舆情数据全文索引信息存储在预设的内容数据库。设置的索引数据库,包括:

[0029] 为被抓取的对应网站的网页内容建立舆情数据全文索引信息;

[0030] 取到的网站对应的网页内容存储在预设的内容库中,舆情数据全文索引信息存储在预设的索引库中;

[0031] 对索引数据库中存储的数据进行统计分析。

[0032] 根据本发明的另一方面,提供了一种基于互联网的舆情数据采集系统,该系统包括数据采集单元和检索分析单元,数据采集单元包括爬虫调度子系统和网络爬虫子系统;

爬虫调度子系统用于实时监控各个网络爬虫的状态,根据各个网络爬虫的状态调度各个网络爬虫,从而实现对各个预设舆情内容的爬取网站@ > 在互联网上和/或阻止互联网上的其他 网站 内容;

[0034] 网络爬虫子系统,用于根据预设条件对各个预设舆情网站的网页内容进行爬取,并从爬取的数据中提取对应的网站地址;对网站的地址进行地址解析,对解析成功的网站地址进行去重去噪后的分类;网络爬虫子系统也用于分类成功的网站@网站地址对应要爬取的网站的网页内容;

[0035] 检索分析单元,用于为网站对应的网页内容建立舆情数据全文索引信息,将网页内容存入预设的内容数据库和全文索引网页的信息。存储在预设索引数据库中。

可选的,所述爬虫调度子系统包括:

[0037] 分类配置模块用于根据用户输入的网站网址预先设置互联网中需要抓取网页内容的舆情网站,网站 @网站 互联网中的网页内容不需要爬取。@网站;

爬虫配置模块,用于根据用户输入的爬虫进行参数设置,进行网络爬虫系统的设置;

[0039] 状态监测模块用于实时感知各个网络爬虫的工作状态;

爬虫分发模块,用于根据各个网络爬虫的工作状态生成爬虫分类信息,将负担大于第一预设值的爬虫从当前的数据抓取任务中解放出来,分发负担小于第一预设值的爬虫。第二个预设值。值爬虫执行数据抓取任务;

[0041] 站点过滤模块用于过滤不需要网页内容爬取的网站的地址。

可选的,所述网络爬虫子系统,包括:

[0043] 抓取模块,用于根据预设条件抓取各个预设舆情的网页内容;

计算模块,用于计算所抓取的网页信息与所述预设条件的相似度;

生成模块,用于根据相似度大于第三预设值的网页信息生成对应的网站地址;

[0046] 地址解析模块用于判断网站地址的地址类型,根据判断结果选择合适的地址解析器进行地址解析,并对解析成功的网站地址进行去重。,去噪处理;

URL管理模块用于对网站去重去噪后的地址进行分类聚类;

所述爬取模块还用于对分类成功的网站地址的网站对应的网页内容进行爬取;

[0049] 地址下载模块用于根据分类成功的网站地址的地址类型选择下载器,并利用选择的下载器下载网页内容。

可选的,所述检索分析单元,包括:

[0051] 索引建立模块,用于为抓取到的网站对应的网页内容建立舆情数据全文索引信息。

[0052] 存储模块,用于将采集到的网站对应的网页内容存储到预设的内容库中,将舆情数据的全文索引信息存储到预设的索引库中;

[0053] 统计分析模块,用于对索引数据库中存储的数据进行统计分析。

本发明的有益效果是:

1、本发明提供的基于互联网的舆情数据采集方法及系统,由

网站内容采集系统(,企业网站管理系统源码,(中英繁)版)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-01-25 17:09

后台地址/admin,后台账号admin密码为admin

>公司企业网站管理系统源码三语(中英繁体)免费版由企业网站建设专家和企业网站系统开发人员制作。采用asp+access开发,数据库容量大,运行稳定。速度快,安全性能优异,功能更强大,是一套通用、公司、企业自助网站管理系统,sql版本调试请查看《iis和sql安装操作手册》

>公司企业网站管理系统中英文繁体接入版,企业公司网站系统接入版,企业网站管理系统,企业网站源码,公司网站管理系统,公司企业网站自助式网站管理系统源码。漂亮的前台,强大的网站后台管理功能,自助管理前台相关栏目。中文、英文、繁体三语使公司、企业网站广为人知,占据网络市场。公司企业网站中英文接入版管理系统具有公司产品和服务的宣传、介绍、展示、推广、销售、在线电子商务等功能。业务和利润是全站系统设计功能的最终目标。完善网站企业简历、企业文化、企业新闻、行业资讯、产品展示、下载中心、企业荣誉、营销网络、人才招聘、客户留言、会员中心等子模块,充分考虑大体需求公司、企业中英文网站管理系统。全后台管理,后台功能齐全,使用维护方便。无论是生产、销售,还是服务,对于大中小型企业来说,只要企业网站的管理者会打字,都会打造专业的公司,企业网站,并随时管理网站 内容。本系统是基于ASP+sql技术开发的电子商务平台,是一个安全、稳定、快速、全自动化、全智能化的在线管理、维护、更新企业网站管理系统。全站下载,程序源码,功能齐全,欢迎大家下载使用。企业网站管理系统的功能会更加完善,真正能为建筑公司和企业网站的每一个人带来安全保障。稳定高效。本系统分为企业网站管理系统中英文ACCESS?全站下载,程序源码,功能齐全,欢迎大家下载使用。企业网站管理系统的功能会更加完善,真正能为建筑公司和企业网站的每一个人带来安全保障。稳定高效。本系统分为企业网站管理系统中英文ACCESS?全站下载,程序源码,功能齐全,欢迎大家下载使用。企业网站管理系统的功能会更加完善,真正能为建筑公司和企业网站的每一个人带来安全保障。稳定高效。本系统分为企业网站管理系统中英文ACCESS?

>?企业版网站管理系统中文ACCESS版,企业版网站管理系统中英文繁体SQL版,企业公司网站系统中文SQL版,全屏中英文繁体SQL版,全屏中文SQL版。 查看全部

网站内容采集系统(,企业网站管理系统源码,(中英繁)版)

后台地址/admin,后台账号admin密码为admin

>公司企业网站管理系统源码三语(中英繁体)免费版由企业网站建设专家和企业网站系统开发人员制作。采用asp+access开发,数据库容量大,运行稳定。速度快,安全性能优异,功能更强大,是一套通用、公司、企业自助网站管理系统,sql版本调试请查看《iis和sql安装操作手册》

>公司企业网站管理系统中英文繁体接入版,企业公司网站系统接入版,企业网站管理系统,企业网站源码,公司网站管理系统,公司企业网站自助式网站管理系统源码。漂亮的前台,强大的网站后台管理功能,自助管理前台相关栏目。中文、英文、繁体三语使公司、企业网站广为人知,占据网络市场。公司企业网站中英文接入版管理系统具有公司产品和服务的宣传、介绍、展示、推广、销售、在线电子商务等功能。业务和利润是全站系统设计功能的最终目标。完善网站企业简历、企业文化、企业新闻、行业资讯、产品展示、下载中心、企业荣誉、营销网络、人才招聘、客户留言、会员中心等子模块,充分考虑大体需求公司、企业中英文网站管理系统。全后台管理,后台功能齐全,使用维护方便。无论是生产、销售,还是服务,对于大中小型企业来说,只要企业网站的管理者会打字,都会打造专业的公司,企业网站,并随时管理网站 内容。本系统是基于ASP+sql技术开发的电子商务平台,是一个安全、稳定、快速、全自动化、全智能化的在线管理、维护、更新企业网站管理系统。全站下载,程序源码,功能齐全,欢迎大家下载使用。企业网站管理系统的功能会更加完善,真正能为建筑公司和企业网站的每一个人带来安全保障。稳定高效。本系统分为企业网站管理系统中英文ACCESS?全站下载,程序源码,功能齐全,欢迎大家下载使用。企业网站管理系统的功能会更加完善,真正能为建筑公司和企业网站的每一个人带来安全保障。稳定高效。本系统分为企业网站管理系统中英文ACCESS?全站下载,程序源码,功能齐全,欢迎大家下载使用。企业网站管理系统的功能会更加完善,真正能为建筑公司和企业网站的每一个人带来安全保障。稳定高效。本系统分为企业网站管理系统中英文ACCESS?

>?企业版网站管理系统中文ACCESS版,企业版网站管理系统中英文繁体SQL版,企业公司网站系统中文SQL版,全屏中英文繁体SQL版,全屏中文SQL版。

网站内容采集系统(《(9页珍藏版)》行业用户的应用需求)

采集交流 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2022-01-24 12:11

《WEB数据采集系统》由会员共享,可在线阅读。更多“WEB数据采集系统(9页珍藏版)”,请在线搜索人人图书馆。

1、WEB数据采集系统一.概述面对互联网上海量的信息,政府机关、企事业单位、科研机构都渴望获取与自身工作相关的有价值的信息. 快速访问这些信息变得至关重要。如果采用原来的人工采集方式,费时费力,效率低下。面对越来越多的信息资源,劳动强度和难度可想而知。因此,现代政府和企业迫切需要一种能够提供优质高效运营的信息采集解决方案。根据不同行业用户的应用需求,系统旨在捕捉互联网,并根据用户定义的规则实现从互联网上获取指定信息。抓取到的信息可以存入数据库,也可以直接发送到指定栏目,实现网站信息的及时更新,增加数据量,从而增加搜索引擎收录的数量扩大企业信息化宣传。二. 典型应用

2、1.政府机构 l 实时跟踪,采集业务工作相关信息来源。l 充分满足内部人员对互联网信息的全球观察需求。l 及时解决政务外网和政务内网信息来源问题,实现动态发布。l 快速解决政府负责人网站为地方下属网站的信息获取需求。l 全面整合信息,实现政府内部跨区域、跨部门的信息资源共享和有效沟通。l 节省信息采集人力、物力和时间,提高办公效率。2. 企业级 l 实时准确监控跟踪竞争对手 动态是企业获取竞争情报的有力工具。l 及时获取竞争对手的公开信息,研究同行业的发展和市场需求。l 为企业决策部门和管理层提供便捷、多渠道的企业战略决策工具。l 大大提高企业获取和使用情报的效率,节省情报信息的采集和存储。

3、存储和挖矿的相关费用是提升企业核心竞争力的关键。l 提高企业整体分析研究能力和对市场的快速反应能力,建立以知识管理为核心的“竞争情报数据仓库”,是提高企业核心竞争力的神经中枢. 3. 新闻媒体 l 自动采集快速准确地统计信息。l 支持每天上万条新闻的有效抓取。l 支持对所需内容的智能提取和审核。l 实现互联网信息内容采集的整合、浏览、编辑、管理、发布。三. 系统架构工作流程说明采集 目的是将对方网站网页中的某段文字或图片等资源下载到自己的网站上。该过程需要进行以下配置工作:下载网页配置、解析网页配置、修改结果配置、数据输出配置。如果数据符合您的要求,您可以省略校正结果的这一步。配置完成后,把配置 您可以省略校正结果的这一步。配置完成后,把配置 您可以省略校正结果的这一步。配置完成后,把配置

4、一个任务(任务以XML格式描述),采集系统根据任务描述开始工作,最后将采集的结果存入网站 服务器。工作流程图如下: 数据处理逻辑图:四.系统函数根据预先配置的规则(网页下载规则、网页解析规则等)执行数据采集用户。当对方的网站数据更新,或者新增数据时,系统会自动检测,执行采集,然后更新到自己的数据库(或者其他存储方式),这个过程不再需要人工干预。五. 技术特点1. 支持多种网页编码格式,也可以手动设置编码格式。支持各种语言的网站。2.支持图片、软件、音乐、视频、flash等多种格式资源的下载3.支持采集结果输出的多样性,可以使用不同的输出插件-ins 用于输出,或者您可以打开自己的

5、发送输出插件。4. 采集配置分为三部分:网络爬虫配置、网页解析配置、采集任务配置。以上三者可以自由组合,方便重用已经设置好的配置。5. 可定制的数据解析和提取。采集 的网络元数据可以自由配置,并且可以为每个网络元数据自定义字段名称。方便后续信息处理。6. 采集爬虫采用多任务多数据源管理。7. 可以在每个任务下指定多个采集条目网站。8. 采集条件设置,可以设置采集路径,关键页面,采集 不同任务下条目网站的URL过滤等控制条件。控制条件是正则表达式。9.运行配置,采集运行过程中使用的爬虫名称、编号、数据更新频率等可由用户配置。10.自动识别文本中的图片信息,并自动下载到本地,并替换

6、文中的图片网址为本地网址。11. 管理控制台可以监控采集进程的运行情况。六.系统优势1.准确率高用户可以根据自己的需要选择和设置监控目标网站和具体的信息源,实现24小时不间断监控和采集,信息动态始终处于控制之中。系统支持按日期、标题、作者、栏目提取网页中的信息内容,过滤网页中无用的信息。爬取的扩展范围采集可以精确到具体网站、具体栏目、具体页面、具体区域。2. 使用方便,系统参数设置简单,一次设置可多次使用。设置过程直观方便。3. 灵活性 系统高度灵活,可根据需要选择目标站点,并可根据情况变化随时更改目标站点。用户可以直接到某个网站去抓取用户想要的特定栏目下的信息。它只需要用户设置特定的抓取条件,用户需要的内容会被自动抓取并保存。实现从用户在互联网上寻找信息到信息自动流向用户的方式转变。4. 实现部署简单 系统具有友好的用户界面,爬虫服务器运行在任意浏览器下,实现部署过程简单,即装即用。5. 采集 内容完全适应网站内容格式的可变性,可以完整获取需要采集的页面,少有遗漏,采集@内容完整> 99% 以上的网页。6. 爬取速度快 系统支持多线程处理技术,支持多线程同时爬取。可以快速高效的对目标站点或栏目采集进行信息抓取,大大加快信息抓取速度,保证同一单位时间内抓取的信息量成倍增长。七. 系统界面显示 采集网页内容的完整性在99%以上。6. 爬取速度快 系统支持多线程处理技术,支持多线程同时爬取。可以快速高效的对目标站点或栏目采集进行信息抓取,大大加快信息抓取速度,保证同一单位时间内抓取的信息量成倍增长。七. 系统界面显示 采集网页内容的完整性在99%以上。6. 爬取速度快 系统支持多线程处理技术,支持多线程同时爬取。可以快速高效的对目标站点或栏目采集进行信息抓取,大大加快信息抓取速度,保证同一单位时间内抓取的信息量成倍增长。七. 系统界面显示 大大加快了信息捕获的速度,保证了同一单位时间内捕获的信息量成倍增长。七. 系统界面显示 大大加快了信息捕获的速度,保证了同一单位时间内捕获的信息量成倍增长。七. 系统界面显示 查看全部

网站内容采集系统(《(9页珍藏版)》行业用户的应用需求)

《WEB数据采集系统》由会员共享,可在线阅读。更多“WEB数据采集系统(9页珍藏版)”,请在线搜索人人图书馆。

1、WEB数据采集系统一.概述面对互联网上海量的信息,政府机关、企事业单位、科研机构都渴望获取与自身工作相关的有价值的信息. 快速访问这些信息变得至关重要。如果采用原来的人工采集方式,费时费力,效率低下。面对越来越多的信息资源,劳动强度和难度可想而知。因此,现代政府和企业迫切需要一种能够提供优质高效运营的信息采集解决方案。根据不同行业用户的应用需求,系统旨在捕捉互联网,并根据用户定义的规则实现从互联网上获取指定信息。抓取到的信息可以存入数据库,也可以直接发送到指定栏目,实现网站信息的及时更新,增加数据量,从而增加搜索引擎收录的数量扩大企业信息化宣传。二. 典型应用

2、1.政府机构 l 实时跟踪,采集业务工作相关信息来源。l 充分满足内部人员对互联网信息的全球观察需求。l 及时解决政务外网和政务内网信息来源问题,实现动态发布。l 快速解决政府负责人网站为地方下属网站的信息获取需求。l 全面整合信息,实现政府内部跨区域、跨部门的信息资源共享和有效沟通。l 节省信息采集人力、物力和时间,提高办公效率。2. 企业级 l 实时准确监控跟踪竞争对手 动态是企业获取竞争情报的有力工具。l 及时获取竞争对手的公开信息,研究同行业的发展和市场需求。l 为企业决策部门和管理层提供便捷、多渠道的企业战略决策工具。l 大大提高企业获取和使用情报的效率,节省情报信息的采集和存储。

3、存储和挖矿的相关费用是提升企业核心竞争力的关键。l 提高企业整体分析研究能力和对市场的快速反应能力,建立以知识管理为核心的“竞争情报数据仓库”,是提高企业核心竞争力的神经中枢. 3. 新闻媒体 l 自动采集快速准确地统计信息。l 支持每天上万条新闻的有效抓取。l 支持对所需内容的智能提取和审核。l 实现互联网信息内容采集的整合、浏览、编辑、管理、发布。三. 系统架构工作流程说明采集 目的是将对方网站网页中的某段文字或图片等资源下载到自己的网站上。该过程需要进行以下配置工作:下载网页配置、解析网页配置、修改结果配置、数据输出配置。如果数据符合您的要求,您可以省略校正结果的这一步。配置完成后,把配置 您可以省略校正结果的这一步。配置完成后,把配置 您可以省略校正结果的这一步。配置完成后,把配置

4、一个任务(任务以XML格式描述),采集系统根据任务描述开始工作,最后将采集的结果存入网站 服务器。工作流程图如下: 数据处理逻辑图:四.系统函数根据预先配置的规则(网页下载规则、网页解析规则等)执行数据采集用户。当对方的网站数据更新,或者新增数据时,系统会自动检测,执行采集,然后更新到自己的数据库(或者其他存储方式),这个过程不再需要人工干预。五. 技术特点1. 支持多种网页编码格式,也可以手动设置编码格式。支持各种语言的网站。2.支持图片、软件、音乐、视频、flash等多种格式资源的下载3.支持采集结果输出的多样性,可以使用不同的输出插件-ins 用于输出,或者您可以打开自己的

5、发送输出插件。4. 采集配置分为三部分:网络爬虫配置、网页解析配置、采集任务配置。以上三者可以自由组合,方便重用已经设置好的配置。5. 可定制的数据解析和提取。采集 的网络元数据可以自由配置,并且可以为每个网络元数据自定义字段名称。方便后续信息处理。6. 采集爬虫采用多任务多数据源管理。7. 可以在每个任务下指定多个采集条目网站。8. 采集条件设置,可以设置采集路径,关键页面,采集 不同任务下条目网站的URL过滤等控制条件。控制条件是正则表达式。9.运行配置,采集运行过程中使用的爬虫名称、编号、数据更新频率等可由用户配置。10.自动识别文本中的图片信息,并自动下载到本地,并替换

6、文中的图片网址为本地网址。11. 管理控制台可以监控采集进程的运行情况。六.系统优势1.准确率高用户可以根据自己的需要选择和设置监控目标网站和具体的信息源,实现24小时不间断监控和采集,信息动态始终处于控制之中。系统支持按日期、标题、作者、栏目提取网页中的信息内容,过滤网页中无用的信息。爬取的扩展范围采集可以精确到具体网站、具体栏目、具体页面、具体区域。2. 使用方便,系统参数设置简单,一次设置可多次使用。设置过程直观方便。3. 灵活性 系统高度灵活,可根据需要选择目标站点,并可根据情况变化随时更改目标站点。用户可以直接到某个网站去抓取用户想要的特定栏目下的信息。它只需要用户设置特定的抓取条件,用户需要的内容会被自动抓取并保存。实现从用户在互联网上寻找信息到信息自动流向用户的方式转变。4. 实现部署简单 系统具有友好的用户界面,爬虫服务器运行在任意浏览器下,实现部署过程简单,即装即用。5. 采集 内容完全适应网站内容格式的可变性,可以完整获取需要采集的页面,少有遗漏,采集@内容完整> 99% 以上的网页。6. 爬取速度快 系统支持多线程处理技术,支持多线程同时爬取。可以快速高效的对目标站点或栏目采集进行信息抓取,大大加快信息抓取速度,保证同一单位时间内抓取的信息量成倍增长。七. 系统界面显示 采集网页内容的完整性在99%以上。6. 爬取速度快 系统支持多线程处理技术,支持多线程同时爬取。可以快速高效的对目标站点或栏目采集进行信息抓取,大大加快信息抓取速度,保证同一单位时间内抓取的信息量成倍增长。七. 系统界面显示 采集网页内容的完整性在99%以上。6. 爬取速度快 系统支持多线程处理技术,支持多线程同时爬取。可以快速高效的对目标站点或栏目采集进行信息抓取,大大加快信息抓取速度,保证同一单位时间内抓取的信息量成倍增长。七. 系统界面显示 大大加快了信息捕获的速度,保证了同一单位时间内捕获的信息量成倍增长。七. 系统界面显示 大大加快了信息捕获的速度,保证了同一单位时间内捕获的信息量成倍增长。七. 系统界面显示

网站内容采集系统(网站内容采集系统,多少钱?这个数字不太好)

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2022-01-22 16:03

网站内容采集系统,多少钱这个数字似乎不太好,现在的时代发展这么快,网站多了,许多网站不再需要再设计自己的博客,也没必要做一个简易的编辑器了,而且用大把的网站,说找那些编辑器再写代码要再多加钱的,那是不可能的事情,网站内容采集系统,包括脚本,以及音频,视频脚本,这些都是要在购买里面买买的,脚本多少钱大概几百到十几万一年,效果好,机器多,视频,音频的地方,基本上是千把块钱,可能你不想写,那就去购买现成的吧,而且网站内容采集系统,现在也有很多不同的价格系统,不同的解决方案,是不同的商家在做,不同的后台系统,系统部署又不同,除非买那些,写网站脚本的人,因为网站采集系统这个一个系统成本,就要许多,机器价格,还有网站成本,成本可能是几十万。

博客程序的价格基本上和域名的价格成正比,总的来说其实不贵,比如你博客搞个半天出来,然后弄个备案,对于绝大多数人来说没有必要。

最近看到开源的博客系统挺火的,项目主要采用的是java语言+mysql,搭建过程中采用中文语言,对于一些门外汉来说上手比较容易,并且网站程序采用maven生成,很多bug提供解决方案。比如wordpress,做成一个网站,还带有论坛,营销管理,自定义推广等等。不足之处就是部署比较麻烦,需要自己安装jar包。 查看全部

网站内容采集系统(网站内容采集系统,多少钱?这个数字不太好)

网站内容采集系统,多少钱这个数字似乎不太好,现在的时代发展这么快,网站多了,许多网站不再需要再设计自己的博客,也没必要做一个简易的编辑器了,而且用大把的网站,说找那些编辑器再写代码要再多加钱的,那是不可能的事情,网站内容采集系统,包括脚本,以及音频,视频脚本,这些都是要在购买里面买买的,脚本多少钱大概几百到十几万一年,效果好,机器多,视频,音频的地方,基本上是千把块钱,可能你不想写,那就去购买现成的吧,而且网站内容采集系统,现在也有很多不同的价格系统,不同的解决方案,是不同的商家在做,不同的后台系统,系统部署又不同,除非买那些,写网站脚本的人,因为网站采集系统这个一个系统成本,就要许多,机器价格,还有网站成本,成本可能是几十万。

博客程序的价格基本上和域名的价格成正比,总的来说其实不贵,比如你博客搞个半天出来,然后弄个备案,对于绝大多数人来说没有必要。

最近看到开源的博客系统挺火的,项目主要采用的是java语言+mysql,搭建过程中采用中文语言,对于一些门外汉来说上手比较容易,并且网站程序采用maven生成,很多bug提供解决方案。比如wordpress,做成一个网站,还带有论坛,营销管理,自定义推广等等。不足之处就是部署比较麻烦,需要自己安装jar包。

网站内容采集系统(基于W的网站信息采集系统的设计与实现(双语))

采集交流 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2022-01-22 05:08

基于Web的网站信息采集系统的设计与实现 摘要:随着Internet的快速发展,如何采集和利用Web信息越来越受到关注。本文提出了一种基于Web的信息采集系统的设计方案,并采用. 网络技术和数据库技术实现了采集和特定网站信息的处理。关键词:信息检索;正则表达式; ADO.NET CLC 编号:TP311 文档识别码:A文章 编号:1009-3044(2008)16-21263-02 基于Web的信息采集系统设计与实现 赵晓峰(系无锡商业学院信息工程专业,无锡 214153) 摘要:随着互联网的飞速发展,采集和利用 Web 信息得到了广泛的解决。本文旨在基于Web信息采集方案,利用.Net技术和数据库技术实现对特定网站的采集和处理。关键词:信息检索;正则表达式; ADO。

在某些情况下,我们在浏览网站时,会关注网站上的几种特定类型的信息和数据,我们需要将这些信息综合起来进行数据挖掘,以便进一步分析和使用;我想从几个网站中采集具体信息,分类统一格式后,存入本地数据库,自己发布网站,从而提高时效性信息和减少工作量。本文讨论了利用.Net技术和数据库技术设计Web网站信息采集系统,并以人才网站招聘信息采集作为参考。举例说明实现过程。2 资料采集系统设计2.1 采集系统设计思路首先要< @采集指定网站的信息,需要了解浏览信息的方式,并记录对应的访问路径。网站大部分都是用动态web技术(ASP、PHP等)构建的,通过参数传递检索数据库,并输出相应的信息。例如,在人才招聘网中,通常以单位名称作为信息的起始链接。打开相应网页后,您可以通过获取本单位具体招聘岗位的链接,获取详细的招聘信息。其次,采集获取的信息必须保存在本地数据库中。需要对几个目标网站的信息进行对比分析,得到统一的数据模型,并设计相应的数据表,以方便未来来自不同网站采集来源的信息将统一和结构化。第三,考虑到网站可能会执行多次采集,需要避免在自己的数据库中存储重复信息,同时重复处理已有信息也会减少采集@ > 系统工作效率。

因此,在记录每条信息的同时,可以记录对应的URL或相关ID,以方便验证链接是否被访问过。2.2 相关技术1)请求/响应模型 Web应用程序是一种基于HTTP协议的客户端/服务器请求-响应机制的信息交换。当我们在浏览器中输入URL时,需要建立连接,发送请求、发送响应、关闭连接四个步骤获取网页信息。.Net框架的命名空间System.Net中提供了两个类WebRequest和WebResponse,分别用于发送客户端请求和获取服务器返回的响应。2)正则表达式正则表达式提供了一种强大、灵活、处理文本的有效方法。正则表达式模式匹配可以快速分析大量文本以找到特定的字符模式;提取、编辑、替换或删除文本的子字符串;或将提取的字符串添加到集合中。在.Net命名空间中System.Text.RegularExpressions提供了Regex类来构造正则表达式,也提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。正则表达式模式匹配可以快速分析大量文本以找到特定的字符模式;提取、编辑、替换或删除文本的子字符串;或将提取的字符串添加到集合中。在.Net命名空间中System.Text.RegularExpressions提供了Regex类来构造正则表达式,也提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。正则表达式模式匹配可以快速分析大量文本以找到特定的字符模式;提取、编辑、替换或删除文本的子字符串;或将提取的字符串添加到集合中。在.Net命名空间中System.Text.RegularExpressions提供了Regex类来构造正则表达式,也提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。替换或删除文本的子字符串;或将提取的字符串添加到集合中。在.Net命名空间中System.Text.RegularExpressions提供了Regex类来构造正则表达式,也提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。替换或删除文本的子字符串;或将提取的字符串添加到集合中。在.Net命名空间中System.Text.RegularExpressions提供了Regex类来构造正则表达式,也提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。并且还提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。并且还提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。

为了提高访问效率,还为SQL Server提供了特殊的类,如SqlConnection、SqlCommand、SqlDataReader、Dataset、SqlDataAdapter等,完成对SQL Server数据库的访问和数据处理。2.3 算法说明要补全信息采集首先要能在页面中过滤掉我们需要的链接起点,然后系统模拟手动点击过程阅读信息。1)根据访问路径创建C#自带的REGEX类的对象,是正则表达式的匹配文本类。2)通过WebRequest发送请求,WebResponse接收返回的响应,然后通过 StreamReader 读取返回的响应,形成一个收录网页所有源代码的字符串。3) 用正则表达式匹配字符串得到Match采集集合,里面存储了我们需要进一步阅读的所有目标链接。4) 遍历集合的成员,访问成员链接指向的页面,StreamReader读取信息后使用正则表达式提取页面信息。如果页面是访问路径的终点,则读取相应信息后,将所有数据结构化并存入数据库;如果只是为了获得下一级链接,请转到 1)。3 实施人才招聘信息采集系统1)读取招聘单位名单信息打开网站

HttpWebRequest all_codeRequest = (HttpWebRequest)WebRequest.Create(web_url); WebResponse all_codeResponse = all_codeRequest.GetResponse(); StreamReader the_Reader = new StreamReader(all_codeResponse.GetResponseStream(), System.Text.Encoding.Default); string all_code = the_Reader.ReadToEnd(); the_Reader.Close(); 2)提取招聘单位超链接列表创建表达式字符串p,用它创建正则表达式对象re,并使用re.Matches方法返回all_code字符串链集合hy的所有匹配超链接。字符串 p = @".+"; 正则表达式 re = new Regex(p, RegexOptions.IgnoreCase); Match采集 hy = re.Matches(all_code); for (int i = 0; i < hy.Count; i++) { .... //读取单位信息...//获取各招聘单位发布的工作链接集合 gw for(int j=0;j 查看全部

网站内容采集系统(基于W的网站信息采集系统的设计与实现(双语))

基于Web的网站信息采集系统的设计与实现 摘要:随着Internet的快速发展,如何采集和利用Web信息越来越受到关注。本文提出了一种基于Web的信息采集系统的设计方案,并采用. 网络技术和数据库技术实现了采集和特定网站信息的处理。关键词:信息检索;正则表达式; ADO.NET CLC 编号:TP311 文档识别码:A文章 编号:1009-3044(2008)16-21263-02 基于Web的信息采集系统设计与实现 赵晓峰(系无锡商业学院信息工程专业,无锡 214153) 摘要:随着互联网的飞速发展,采集和利用 Web 信息得到了广泛的解决。本文旨在基于Web信息采集方案,利用.Net技术和数据库技术实现对特定网站的采集和处理。关键词:信息检索;正则表达式; ADO。

在某些情况下,我们在浏览网站时,会关注网站上的几种特定类型的信息和数据,我们需要将这些信息综合起来进行数据挖掘,以便进一步分析和使用;我想从几个网站中采集具体信息,分类统一格式后,存入本地数据库,自己发布网站,从而提高时效性信息和减少工作量。本文讨论了利用.Net技术和数据库技术设计Web网站信息采集系统,并以人才网站招聘信息采集作为参考。举例说明实现过程。2 资料采集系统设计2.1 采集系统设计思路首先要< @采集指定网站的信息,需要了解浏览信息的方式,并记录对应的访问路径。网站大部分都是用动态web技术(ASP、PHP等)构建的,通过参数传递检索数据库,并输出相应的信息。例如,在人才招聘网中,通常以单位名称作为信息的起始链接。打开相应网页后,您可以通过获取本单位具体招聘岗位的链接,获取详细的招聘信息。其次,采集获取的信息必须保存在本地数据库中。需要对几个目标网站的信息进行对比分析,得到统一的数据模型,并设计相应的数据表,以方便未来来自不同网站采集来源的信息将统一和结构化。第三,考虑到网站可能会执行多次采集,需要避免在自己的数据库中存储重复信息,同时重复处理已有信息也会减少采集@ > 系统工作效率。

因此,在记录每条信息的同时,可以记录对应的URL或相关ID,以方便验证链接是否被访问过。2.2 相关技术1)请求/响应模型 Web应用程序是一种基于HTTP协议的客户端/服务器请求-响应机制的信息交换。当我们在浏览器中输入URL时,需要建立连接,发送请求、发送响应、关闭连接四个步骤获取网页信息。.Net框架的命名空间System.Net中提供了两个类WebRequest和WebResponse,分别用于发送客户端请求和获取服务器返回的响应。2)正则表达式正则表达式提供了一种强大、灵活、处理文本的有效方法。正则表达式模式匹配可以快速分析大量文本以找到特定的字符模式;提取、编辑、替换或删除文本的子字符串;或将提取的字符串添加到集合中。在.Net命名空间中System.Text.RegularExpressions提供了Regex类来构造正则表达式,也提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。正则表达式模式匹配可以快速分析大量文本以找到特定的字符模式;提取、编辑、替换或删除文本的子字符串;或将提取的字符串添加到集合中。在.Net命名空间中System.Text.RegularExpressions提供了Regex类来构造正则表达式,也提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。正则表达式模式匹配可以快速分析大量文本以找到特定的字符模式;提取、编辑、替换或删除文本的子字符串;或将提取的字符串添加到集合中。在.Net命名空间中System.Text.RegularExpressions提供了Regex类来构造正则表达式,也提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。替换或删除文本的子字符串;或将提取的字符串添加到集合中。在.Net命名空间中System.Text.RegularExpressions提供了Regex类来构造正则表达式,也提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。替换或删除文本的子字符串;或将提取的字符串添加到集合中。在.Net命名空间中System.Text.RegularExpressions提供了Regex类来构造正则表达式,也提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。并且还提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。并且还提供了相应的方法来完成字符串的匹配和过滤。3)ADO.Net 采集系统获取的数据最终会存储在本地数据库中,.NET框架中提供了数据库访问技术ADO.NET。它屏蔽了各种数据源之间的差异,使用统一的接口进行访问,它由一组访问各种数据源的类组成。

为了提高访问效率,还为SQL Server提供了特殊的类,如SqlConnection、SqlCommand、SqlDataReader、Dataset、SqlDataAdapter等,完成对SQL Server数据库的访问和数据处理。2.3 算法说明要补全信息采集首先要能在页面中过滤掉我们需要的链接起点,然后系统模拟手动点击过程阅读信息。1)根据访问路径创建C#自带的REGEX类的对象,是正则表达式的匹配文本类。2)通过WebRequest发送请求,WebResponse接收返回的响应,然后通过 StreamReader 读取返回的响应,形成一个收录网页所有源代码的字符串。3) 用正则表达式匹配字符串得到Match采集集合,里面存储了我们需要进一步阅读的所有目标链接。4) 遍历集合的成员,访问成员链接指向的页面,StreamReader读取信息后使用正则表达式提取页面信息。如果页面是访问路径的终点,则读取相应信息后,将所有数据结构化并存入数据库;如果只是为了获得下一级链接,请转到 1)。3 实施人才招聘信息采集系统1)读取招聘单位名单信息打开网站

HttpWebRequest all_codeRequest = (HttpWebRequest)WebRequest.Create(web_url); WebResponse all_codeResponse = all_codeRequest.GetResponse(); StreamReader the_Reader = new StreamReader(all_codeResponse.GetResponseStream(), System.Text.Encoding.Default); string all_code = the_Reader.ReadToEnd(); the_Reader.Close(); 2)提取招聘单位超链接列表创建表达式字符串p,用它创建正则表达式对象re,并使用re.Matches方法返回all_code字符串链集合hy的所有匹配超链接。字符串 p = @".+"; 正则表达式 re = new Regex(p, RegexOptions.IgnoreCase); Match采集 hy = re.Matches(all_code); for (int i = 0; i < hy.Count; i++) { .... //读取单位信息...//获取各招聘单位发布的工作链接集合 gw for(int j=0;j

网站内容采集系统(新闻网站来源较多,网站改版较为基于模板的正文提取技术)

采集交流 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2022-02-17 08:02

【摘要】 随着互联网的日益繁荣,互联网上的信息资源越来越多。虽然方便了人们获取知识,但也带来了信息过多、噪声信息较多的问题,影响了用户对有效信息的搜索。网络新闻作为一种主流的互联网信息源,比其他信息源具有更大的研究价值。对互联网新闻进行准确高效的采集分类是非常必要的。意义。基于网页内容的新闻分类可以充分考虑新闻内容的语义,避免因网站对新闻的错误分类或未分类而导致的采集错误结果,具有更好的分类效果。论文对网页正文采集技术进行了深入研究,结合新闻网站的特点,制定了更有效的采集策略和更新策略,确保新闻采集 @采集 的效率。由于网站新闻来源众多,网站修改频繁,基于模板的文本提取技术无法保证提取的准确性。一种基于文本分布的通用文本提取算法,通过实验确定算法的最优值,降低了人工编写规则的时间成本。对于文本分类,本文研究分析了文本分类的整体过程,并选择Labeled LDA进行文本特征表示。与传统的向量空间模型相比,减少了特征维度,避免了语义信息的丢失。LDA 模型扩展为具有监督分类模型。通过文本分类方法的比较,选择支持向量机作为文本特征的分类器。本文选取搜狗中文实验室新闻语料库,使用JGibbLabeledLDA和Scikit-learn实现LLDA-SVM算法。通过将分类结果与其他方法进行比较,验证分类方法的有效性,并将训练好的模型用于新文本。为分类做准备。论文实现了基于B/S架构的采集和网页分类系统,给出了各个系统模块的具体设计和实现,并从采集方面对系统进行了评价。性能和分类精度。进行了评估以验证该系统的可行性。 查看全部

网站内容采集系统(新闻网站来源较多,网站改版较为基于模板的正文提取技术)

【摘要】 随着互联网的日益繁荣,互联网上的信息资源越来越多。虽然方便了人们获取知识,但也带来了信息过多、噪声信息较多的问题,影响了用户对有效信息的搜索。网络新闻作为一种主流的互联网信息源,比其他信息源具有更大的研究价值。对互联网新闻进行准确高效的采集分类是非常必要的。意义。基于网页内容的新闻分类可以充分考虑新闻内容的语义,避免因网站对新闻的错误分类或未分类而导致的采集错误结果,具有更好的分类效果。论文对网页正文采集技术进行了深入研究,结合新闻网站的特点,制定了更有效的采集策略和更新策略,确保新闻采集 @采集 的效率。由于网站新闻来源众多,网站修改频繁,基于模板的文本提取技术无法保证提取的准确性。一种基于文本分布的通用文本提取算法,通过实验确定算法的最优值,降低了人工编写规则的时间成本。对于文本分类,本文研究分析了文本分类的整体过程,并选择Labeled LDA进行文本特征表示。与传统的向量空间模型相比,减少了特征维度,避免了语义信息的丢失。LDA 模型扩展为具有监督分类模型。通过文本分类方法的比较,选择支持向量机作为文本特征的分类器。本文选取搜狗中文实验室新闻语料库,使用JGibbLabeledLDA和Scikit-learn实现LLDA-SVM算法。通过将分类结果与其他方法进行比较,验证分类方法的有效性,并将训练好的模型用于新文本。为分类做准备。论文实现了基于B/S架构的采集和网页分类系统,给出了各个系统模块的具体设计和实现,并从采集方面对系统进行了评价。性能和分类精度。进行了评估以验证该系统的可行性。

网站内容采集系统(怎么用免费dede采集插件把关键词优化到首页让网站能快速收录)

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2022-02-16 22:17

如何使用免费的dede采集插件将关键词优化到首页,使网站可以快速收录,包括所有SEO优化功能,并支持所有网站@ > 使用。在做业务网站优化的时候,经常会遇到很多问题,比如网站原创没有内容收录,收录后面没有排名,但是如果有怎么办排行?连首页都没有。因此,我们需要系统地对企业网站的优化做出很好的诊断,帮助我们调整网站的细节,更好的提高网站的权重。以下是企业网站优化诊断的三个方面,希望能帮助您更好地诊断自己的网站。

诊断前网站,教大家如何快速搭建原创高质量文章,使用免费的dede采集插件这个插件不用多学专业技能,简单几步即可轻松采集内容数据,用户只需对dede采集插件进行简单设置,完成后dede采集插件-in 会根据用户设置的关键词高精度匹配内容和图片可以保存在本地,也可以在伪原创之后发布,提供方便快捷的内容采集伪原创发布网站 @>推送服务!!

和其他dede采集插件相比,这个dede采集插件基本没有门槛,不需要花很多时间学习正则表达式或者html标签,一分钟就能上手,只需输入关键词即可实现采集(dede采集插件也自带关键词采集功能)。一路挂断!设置任务自动执行采集伪原创发布和推送任务。几十万个不同的cms网站可以统一管理。一个人维护数百个 网站文章 更新也不是问题。

这个dede采集插件工具也配置了很多SEO功能,通过采集伪原创软件发布后还可以提升很多SEO方面。

例如:设置自动下载图片保存在本地或第三方(使内容不再有对方的外链)

自动内链(让搜索引擎更深入地抓取你的链接)、前后插入内容或标题,以及网站内容插入或随机作者、随机阅读等,形成“高原创 ”。

这些SEO小功能不仅提高了网站页面原创的度数,还间接提升了网站的收录排名。您可以通过软件工具上的监控管理直接查看文章采集的发布状态,不再需要每天登录网站后台查看。目前博主亲测软件是免费的,可以直接下载使用!有了这个dede采集插件,我们做网站优化,需要注意网站优化诊断三个方面

一、网站系统诊断

网站系统诊断 1

1. 空间速度

网站打开速度通常与2个方面有关:

一是页面上的图片数量,图片越多网站打开速度就会降低,所以优化网页上的图片非常重要。空间/服务器带宽太小。如果网站的流量很大,那么带宽就比较小,容易造成网站打不开,所以一般带宽的大小要根据大小来定网站 访问次数待定。影响网站速度的地方还有很多,但是随着互联网的发展和服务器配置的增加,很多影响空间速度的细节已经不用考虑了。

2. 网站代码

现在很多公司网站都在开发dedecms、empirecms、phpcms等开源程序,所以程序没必要多想,只需要需要考虑程序安全设置。