方便操作的采集神器

方便操作的采集神器。js来看你要采集的就行了

采集交流 • 优采云 发表了文章 • 0 个评论 • 227 次浏览 • 2021-04-10 21:00

方便操作的采集神器。

js来看你要采集的就行了,觉得网站不错就用mongodb操作一个,

这个网站的主页在封禁,所以推荐使用wordpress博客系统来完成这个工作。wordpress是一款开源免费的php程序,目前已经存在三个版本。博客系统推荐用daw博客系统来实现,非常的简单。

难道不是用js截图吗?

用前后端分离的方式处理,采用ajax,实现定时发布,采用html5响应式的优势和浏览器的兼容性,

图片格式可以json、request、mongo、file、grab等之类的

会去写一套爬虫吗

如果用mongo建议走file路线,就是定时处理文件,json,或者另一个方案,用json+gib来搞定,我有一些经验可以分享给你,可以参考我的文章

基本上没办法。如果有能力走反爬虫的路线,倒是能搞点事情,因为这些页面一般的爬虫是很难爬到的。不过题主你也都解释得很清楚,说服务器水平不够不会改图片数据,所以我猜测是基本原理搞不定。

爬取图片的软件也要根据图片的格式去定,格式对了就可以爬,另外可以找到图片来源再自己做。

wordpress和phpwind。phpwind是博客程序,wordpress是内容编辑系统,两者已经形成产业链了,phpwind销售wordpress软件,wordpress软件销售phpwind主题。这里并不是说wordpress不好,但是phpwind相对而言更适合使用wordpress。最后,phpwind更好用,但是,要学习phpwind编程的话就绕不开mongoose和gson。 查看全部

方便操作的采集神器。js来看你要采集的就行了

方便操作的采集神器。

js来看你要采集的就行了,觉得网站不错就用mongodb操作一个,

这个网站的主页在封禁,所以推荐使用wordpress博客系统来完成这个工作。wordpress是一款开源免费的php程序,目前已经存在三个版本。博客系统推荐用daw博客系统来实现,非常的简单。

难道不是用js截图吗?

用前后端分离的方式处理,采用ajax,实现定时发布,采用html5响应式的优势和浏览器的兼容性,

图片格式可以json、request、mongo、file、grab等之类的

会去写一套爬虫吗

如果用mongo建议走file路线,就是定时处理文件,json,或者另一个方案,用json+gib来搞定,我有一些经验可以分享给你,可以参考我的文章

基本上没办法。如果有能力走反爬虫的路线,倒是能搞点事情,因为这些页面一般的爬虫是很难爬到的。不过题主你也都解释得很清楚,说服务器水平不够不会改图片数据,所以我猜测是基本原理搞不定。

爬取图片的软件也要根据图片的格式去定,格式对了就可以爬,另外可以找到图片来源再自己做。

wordpress和phpwind。phpwind是博客程序,wordpress是内容编辑系统,两者已经形成产业链了,phpwind销售wordpress软件,wordpress软件销售phpwind主题。这里并不是说wordpress不好,但是phpwind相对而言更适合使用wordpress。最后,phpwind更好用,但是,要学习phpwind编程的话就绕不开mongoose和gson。

手把手教你“如何通过采集、上架,来降低库存”

采集交流 • 优采云 发表了文章 • 0 个评论 • 183 次浏览 • 2021-04-06 19:02

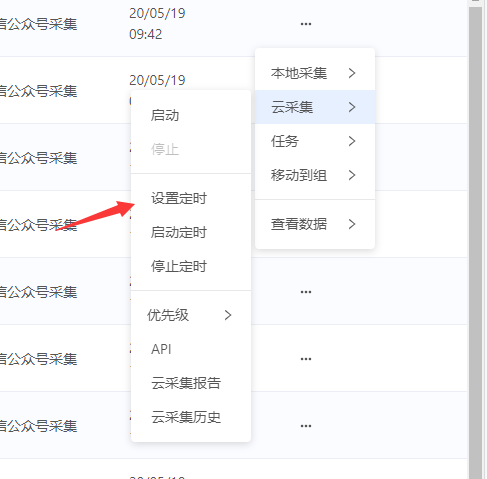

方便操作的采集神器,可任意操作,拥有加速、留言、灰度、竞价等功能目前通过ip操作采集宝贝,新店的话,商品不容易被抓,只要店铺做好店铺定位,通过ip进行采集,被采集到的商品绝对不是僵尸粉单品销量起不来还可以通过做活动来提高销量,前提是你商品转化率要很高,这样的话,适当报一些活动,销量一定也不会差根据活动属性,进行商品铺货操作,属于无货源玩法,有团队的采集、发货、售后服务都可以由有经验的人处理,具体采集技巧可参考一文:手把手教你“如何通过采集、上架,来降低库存”具体操作流程:每天在家可以操作上新,然后上架之后,别人搜索不到的商品就被抓取了。

哪些商品容易被抓取呢?搜索排名靠前的宝贝都容易被抓取。被抓取之后还可以通过搜索“关键词”,比如:“连衣裙”,搜索后出来的结果都是热门宝贝,几乎都是需要竞价的商品。还可以以上架的形式做直通车推广,这里就不一一演示了,操作过的朋友都知道。以下是一些违规,列举几个:①标题不符,②代码不规范,③、上架时,没有上架时间,④、不符合标准等。

简单的操作方法就是:1.采集-拼接-上架2.分销/同步,就是将其他平台上架的商品进行分销,同步到店铺,利用对于产品的属性类目等信息审核,将商品上架到,只要这个平台商品一样,一样类目那么就可以在其他平台上架,而且不用压货,也不需要投入推广。同步化玩法还有个好处,同步其他平台的产品一样,但是换个平台再玩另一个平台,需要注意的是:发货,多平台产品需要换一下发货地址,像头条,会推出客,直通车,同步卖其他平台产品,即可进行操作。 查看全部

手把手教你“如何通过采集、上架,来降低库存”

方便操作的采集神器,可任意操作,拥有加速、留言、灰度、竞价等功能目前通过ip操作采集宝贝,新店的话,商品不容易被抓,只要店铺做好店铺定位,通过ip进行采集,被采集到的商品绝对不是僵尸粉单品销量起不来还可以通过做活动来提高销量,前提是你商品转化率要很高,这样的话,适当报一些活动,销量一定也不会差根据活动属性,进行商品铺货操作,属于无货源玩法,有团队的采集、发货、售后服务都可以由有经验的人处理,具体采集技巧可参考一文:手把手教你“如何通过采集、上架,来降低库存”具体操作流程:每天在家可以操作上新,然后上架之后,别人搜索不到的商品就被抓取了。

哪些商品容易被抓取呢?搜索排名靠前的宝贝都容易被抓取。被抓取之后还可以通过搜索“关键词”,比如:“连衣裙”,搜索后出来的结果都是热门宝贝,几乎都是需要竞价的商品。还可以以上架的形式做直通车推广,这里就不一一演示了,操作过的朋友都知道。以下是一些违规,列举几个:①标题不符,②代码不规范,③、上架时,没有上架时间,④、不符合标准等。

简单的操作方法就是:1.采集-拼接-上架2.分销/同步,就是将其他平台上架的商品进行分销,同步到店铺,利用对于产品的属性类目等信息审核,将商品上架到,只要这个平台商品一样,一样类目那么就可以在其他平台上架,而且不用压货,也不需要投入推广。同步化玩法还有个好处,同步其他平台的产品一样,但是换个平台再玩另一个平台,需要注意的是:发货,多平台产品需要换一下发货地址,像头条,会推出客,直通车,同步卖其他平台产品,即可进行操作。

方便操作的采集神器推荐几款亿万宝贝、车蚂蚁、知足、搜狗网站文章采集器

采集交流 • 优采云 发表了文章 • 0 个评论 • 248 次浏览 • 2021-04-02 21:03

方便操作的采集神器推荐几款app:亿万宝贝、车蚂蚁、知足、搜狗网站文章采集器、亿万宝贝数据采集

一、亿万宝贝提供亿万宝贝采集工具,搜索+采集,一个工具就可以采集任何平台的宝贝,自动同步等店铺。

二、车蚂蚁车蚂蚁是集汽车专业b2b供应链分销平台,汽车供应链数据采集,汽车汽配供应链数据采集,汽车用品行业数据采集,汽车专卖数据采集,汽车广告数据采集,汽车电子数据采集为一体的汽车供应链数据采集分销平台。

三、亿万宝贝数据采集工具亿万宝贝免费使用,其中包含海量分销源数据,宝贝采集,直通车推广,b2b数据采集,网络营销,产品评测,付费广告等多种采集方式。

四、搜狗网站采集器亿万宝贝采集-亿万宝贝数据采集-搜狗网站采集器-亿万宝贝网站采集

一个网站叫亿万宝贝,提供亿万宝贝采集。

找人把亿万宝贝的网站搬运到去就行了

所以现在基本上已经有了亿万宝贝,熊猫自动采集器,阿里妈妈数据采集器,百度网页采集器,金山网页采集器等采集器了,只要你有不想要的网页,哪怕网页信息在,就可以做封装批量采集,

今天用采集软件python爬取了百度某站的排名信息。 查看全部

方便操作的采集神器推荐几款亿万宝贝、车蚂蚁、知足、搜狗网站文章采集器

方便操作的采集神器推荐几款app:亿万宝贝、车蚂蚁、知足、搜狗网站文章采集器、亿万宝贝数据采集

一、亿万宝贝提供亿万宝贝采集工具,搜索+采集,一个工具就可以采集任何平台的宝贝,自动同步等店铺。

二、车蚂蚁车蚂蚁是集汽车专业b2b供应链分销平台,汽车供应链数据采集,汽车汽配供应链数据采集,汽车用品行业数据采集,汽车专卖数据采集,汽车广告数据采集,汽车电子数据采集为一体的汽车供应链数据采集分销平台。

三、亿万宝贝数据采集工具亿万宝贝免费使用,其中包含海量分销源数据,宝贝采集,直通车推广,b2b数据采集,网络营销,产品评测,付费广告等多种采集方式。

四、搜狗网站采集器亿万宝贝采集-亿万宝贝数据采集-搜狗网站采集器-亿万宝贝网站采集

一个网站叫亿万宝贝,提供亿万宝贝采集。

找人把亿万宝贝的网站搬运到去就行了

所以现在基本上已经有了亿万宝贝,熊猫自动采集器,阿里妈妈数据采集器,百度网页采集器,金山网页采集器等采集器了,只要你有不想要的网页,哪怕网页信息在,就可以做封装批量采集,

今天用采集软件python爬取了百度某站的排名信息。

方便操作的采集神器(i春秋采集器采集方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 287 次浏览 • 2021-03-29 06:03

方便操作的采集神器i春秋采集器采集方法:

1、确定分析样本的类型

2、按照需求进行采集,

3、选择进行采集的平台及方式,

4、对采集的结果进行全网分析将采集的结果进行全网分析查看关键词需求量、关键词搜索排名、搜索指数、网站收录量、网站停留时间、网站转化率等数据统计,将数据综合利用后作为参考数据。

5、选择合适的采集软件

采集网站首先你需要知道哪些网站和哪些文章属于你要采集的。

1.打开浏览器,输入网址,点击搜索2.分析你要采集的内容,点击第一个「网页类型」的小按钮:3.选择类型:常见的网页类型有wap、cn、ietext、javascript、css、php等4.点击右侧的「采集样本」(或者「采集指南」)的小按钮。5.确定采集指南6.收集指南会给你介绍采集的步骤和一些注意事项,选择要采集的网页(目前主要支持ietext、javascript、css、php)点击右侧「查看样本」,然后选择采集样本即可。7.注意事项【【301页】一键采集网页/文章大全-i春秋社区】。

对于这样的问题,我一般会先推荐用搜索引擎,然后建议用爱采宝这个采集平台,搜狗网没有收录新闻,爱采宝中的很多新闻收录了,新闻的来源也多样,不是所有的网站都能被采集的,爱采宝采集的比较全面, 查看全部

方便操作的采集神器(i春秋采集器采集方法)

方便操作的采集神器i春秋采集器采集方法:

1、确定分析样本的类型

2、按照需求进行采集,

3、选择进行采集的平台及方式,

4、对采集的结果进行全网分析将采集的结果进行全网分析查看关键词需求量、关键词搜索排名、搜索指数、网站收录量、网站停留时间、网站转化率等数据统计,将数据综合利用后作为参考数据。

5、选择合适的采集软件

采集网站首先你需要知道哪些网站和哪些文章属于你要采集的。

1.打开浏览器,输入网址,点击搜索2.分析你要采集的内容,点击第一个「网页类型」的小按钮:3.选择类型:常见的网页类型有wap、cn、ietext、javascript、css、php等4.点击右侧的「采集样本」(或者「采集指南」)的小按钮。5.确定采集指南6.收集指南会给你介绍采集的步骤和一些注意事项,选择要采集的网页(目前主要支持ietext、javascript、css、php)点击右侧「查看样本」,然后选择采集样本即可。7.注意事项【【301页】一键采集网页/文章大全-i春秋社区】。

对于这样的问题,我一般会先推荐用搜索引擎,然后建议用爱采宝这个采集平台,搜狗网没有收录新闻,爱采宝中的很多新闻收录了,新闻的来源也多样,不是所有的网站都能被采集的,爱采宝采集的比较全面,

方便操作的采集神器:excel爬虫,我也正在学,

采集交流 • 优采云 发表了文章 • 0 个评论 • 255 次浏览 • 2021-03-28 22:03

方便操作的采集神器:这个有你所需要的一切,不管是趣头条的文章,还是其他的文章网站,还是自媒体平台里的文章。都可以采集。

推荐一个使用网站,是目前为止最好用,

要哪些网站的话,可以用网站大全这个网站看看,也是分了一部分内容来,还有一些可能要爬虫之类的都有。

推荐一个巨好用的网址采集工具。1,首先它支持网址采集所有网站2,全新增加网址采集器小程序,可一键导入公众号/公众号文章或发现栏目的网址并调用excel数据进行爬取3,不仅包含分析爬取到的网址规律,还能导出数据txt文档,免费分享给朋友。

excel

php爬虫,我也正在学,看过不少,这个最好用.

豆瓣小组,电影天堂,

推荐excel,不仅可以爬取网站文章,还可以做时间序列数据分析,进行自然语言处理等等,

网站后台有网站分析软件,excel可以的。

可以试试sphere

webscrapingproductinfoserverinstaller(推荐用这个爬墙,

urllib不仅可以爬虫网站,

这个真不好找

楼上的都是大佬,我小白爬虫,一开始因为需要爬取快递,所以爬爬快递的网站文章~现在用了网站大全,真的可以爬这些网站,而且功能强大的不仅有爬虫,还有分析,爬虫,以及大数据, 查看全部

方便操作的采集神器:excel爬虫,我也正在学,

方便操作的采集神器:这个有你所需要的一切,不管是趣头条的文章,还是其他的文章网站,还是自媒体平台里的文章。都可以采集。

推荐一个使用网站,是目前为止最好用,

要哪些网站的话,可以用网站大全这个网站看看,也是分了一部分内容来,还有一些可能要爬虫之类的都有。

推荐一个巨好用的网址采集工具。1,首先它支持网址采集所有网站2,全新增加网址采集器小程序,可一键导入公众号/公众号文章或发现栏目的网址并调用excel数据进行爬取3,不仅包含分析爬取到的网址规律,还能导出数据txt文档,免费分享给朋友。

excel

php爬虫,我也正在学,看过不少,这个最好用.

豆瓣小组,电影天堂,

推荐excel,不仅可以爬取网站文章,还可以做时间序列数据分析,进行自然语言处理等等,

网站后台有网站分析软件,excel可以的。

可以试试sphere

webscrapingproductinfoserverinstaller(推荐用这个爬墙,

urllib不仅可以爬虫网站,

这个真不好找

楼上的都是大佬,我小白爬虫,一开始因为需要爬取快递,所以爬爬快递的网站文章~现在用了网站大全,真的可以爬这些网站,而且功能强大的不仅有爬虫,还有分析,爬虫,以及大数据,

【好书推荐】Prometheus和这些监控系统有啥异同?

采集交流 • 优采云 发表了文章 • 0 个评论 • 587 次浏览 • 2021-03-25 23:10

原创标题:普罗米修斯为什么能替代Zabbix?

本文是根据dbaplus社区的第198次在线共享而编写的,在文章的结尾有不错的书籍推荐〜

讲师介绍

一、简介

Kubernetes自2012年开源以来,已成为容器调度和编排中不可阻挡的领导者。Kubernetes是Google Borg系统的开源实现,与Prometheus相对应的是Google BorgMon的开源实现。 Prometheus是SoundCloud开发的开源监视警报系统和时间序列数据库。从字面上理解,普罗米修斯由两部分组成,一个是监视警报系统,另一个是它自己的时间序列数据库(TSDB)。

2016年,由Google发起的Linux基金会下的Cloud Native Computing Foundation将Prometheus列为其第二大开源项目。 Prometheus在开源社区中也非常活跃,在GitHub上拥有超过20,000个Star,并且该系统每隔一到两周就会进行一次小版本更新。

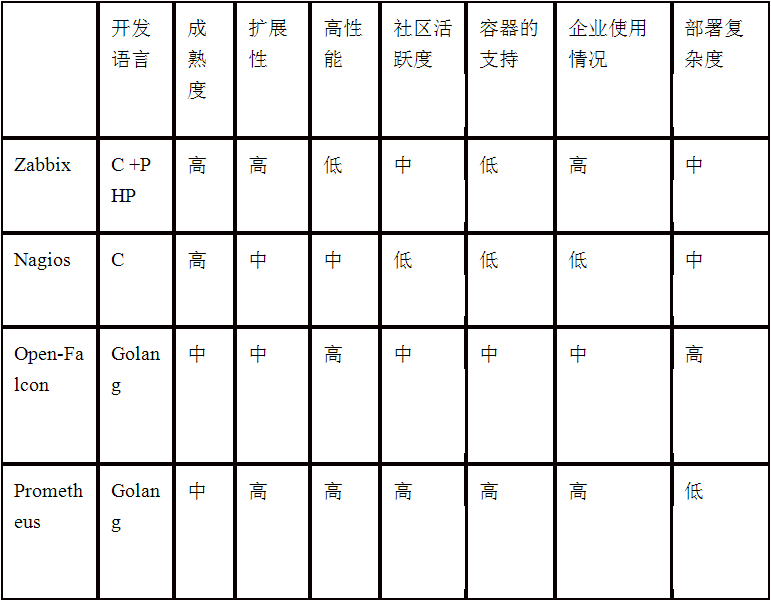

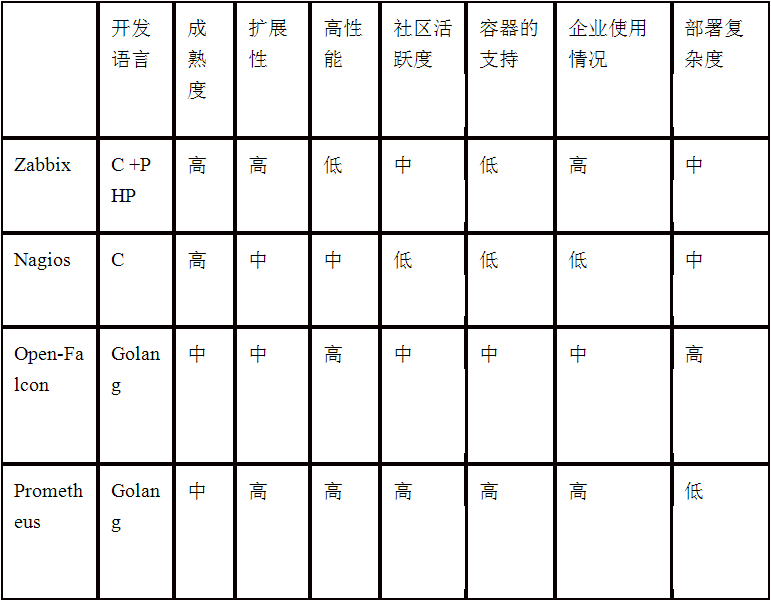

二、各种监视工具的比较

实际上,在Prometheus之前,市场上有许多监视系统,例如Zabbix,Open-Falcon,Nagios等。那么Prometheus与这些监视系统之间的异同是什么?让我们简要回顾一下这些监视系统。

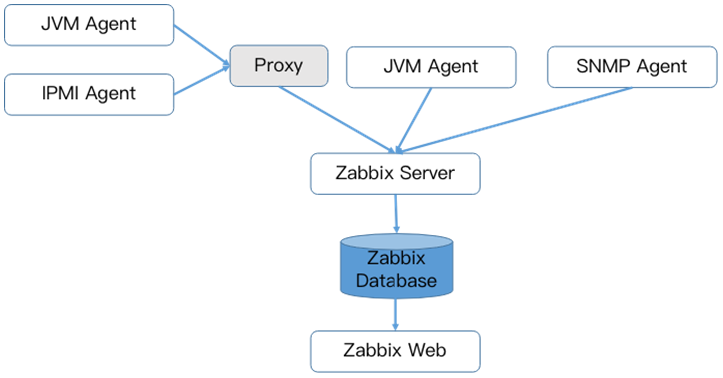

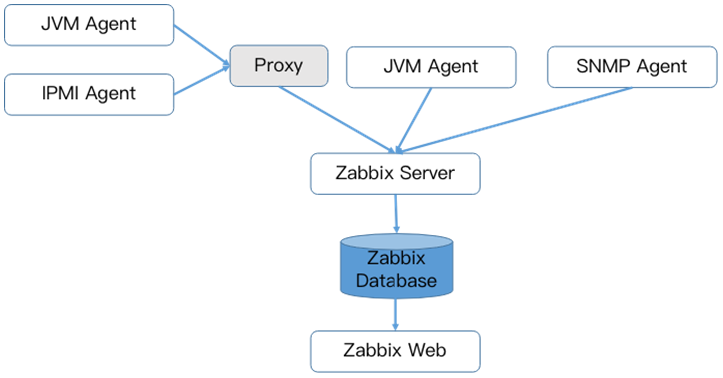

1、 Zabbix

Zabbix是Alexei Vladishev的开源分布式监视系统。它支持多个采集方法和采集客户端。它还支持SNMP,IPMI,JMX,Telnet,SSH和其他协议。它将采集接收到的数据存储在数据库中,然后进行分析和整理。如果符合警报规则,则会触发相应的警报。

Zabbix的核心组件主要是代理和服务器。代理主要负责采集数据,并通过主动或被动采集将数据发送到服务器/代理。此外,为了扩展监视项目,代理还支持执行自定义脚本。服务器主要负责接收代理发送的监视信息,将其存储在一起并触发警报。

Zabbix服务器将采集的监视数据存储在Zabbix数据库中。 Zabbix数据库支持常用的关系数据库。如果是MySQL,PostgreSQL,Oracle等,则默认值为MySQL,并在Zabbix网页(用PHP编写)上提供数据查询。

由于Zabbix使用关系数据存储时间序列数据,因此在监视大型集群时,它经常在数据存储方面遇到困难。因此,从Zabbix 4. 2版本开始,就支持TimescaleDB时间序列数据库,但目前成熟度不高。

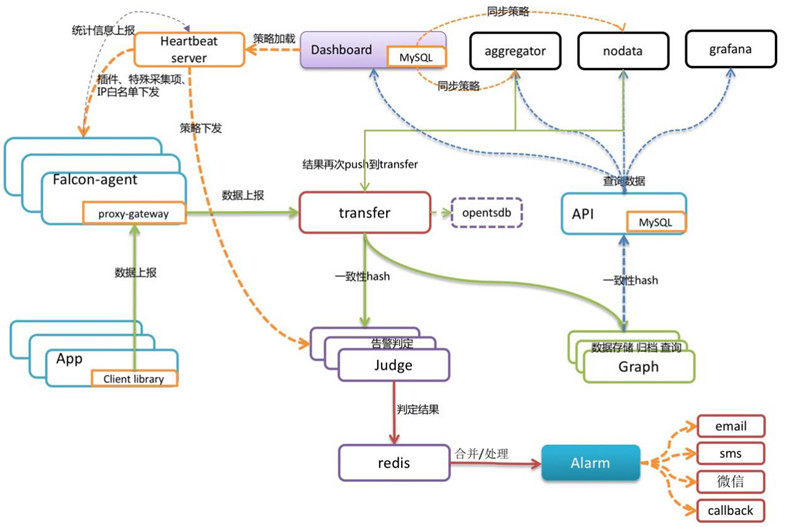

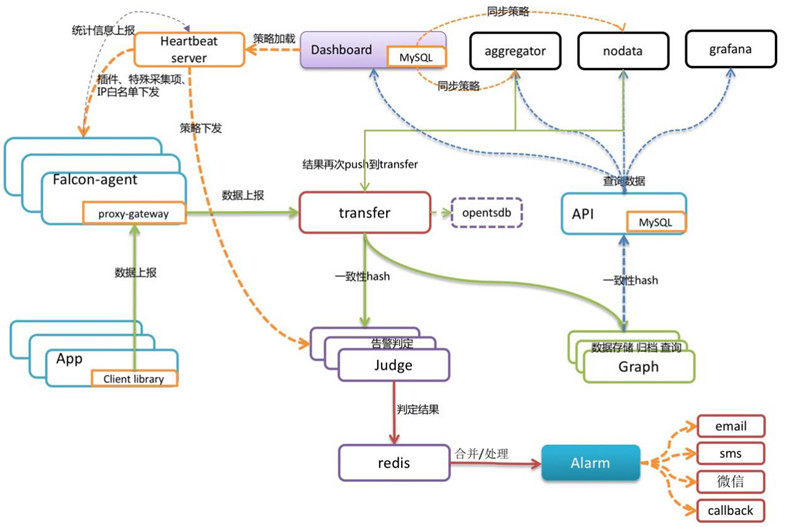

2、 Open-Falcon

Open-Falcon是使用Mi语言开发的小米开源企业级监视工具。小米,滴滴,美团等互联网公司都在使用它。它是一种灵活,可扩展的高级性能监控程序的主要组件包括:

1) Falcon-agent是使用Go语言开发的Daemon程序。它运行在每台Linux服务器上,并用于采集主机上的各种索引数据,主要包括CPU,内存,磁盘,文件系统,内核参数,套接字连接等,目前支持200多个监视指示器。此外,该代理还支持用户定义的监视脚本。

2)心跳服务器缩写为HBS心跳服务。每个代理都会通过RPC定期向HBS报告其状态,该RPC主要包括主机名,主机IP,代理版本和插件版本,并且代理还将从HBS接收信息。获取采集任务和所需的自定义插件表演。

3) Transfer负责接收代理发送的监视数据,对数据进行排序,并在过滤后通过一致的哈希算法将其发送给Judge或Graph。

4) Graph是基于RRD的数据报告,归档和存储组件。 Graph接收到数据后,将其存储在rrdtool的数据归档方法中,同时将提供RPC方法的监视和查询界面。

5)判断警报模块,传输转发到判断的数据将触发用户设置的警报规则,如果满足,它将触发电子邮件,微信或回调界面。在这里,为了避免重复警报,引入了Redis临时存储警报,以完成警报的组合和抑制。

6)仪表板是一个面向用户的监视数据查询和警报配置界面。

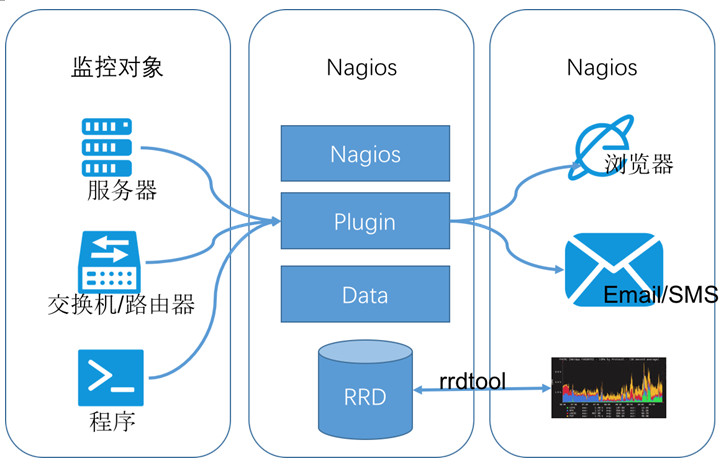

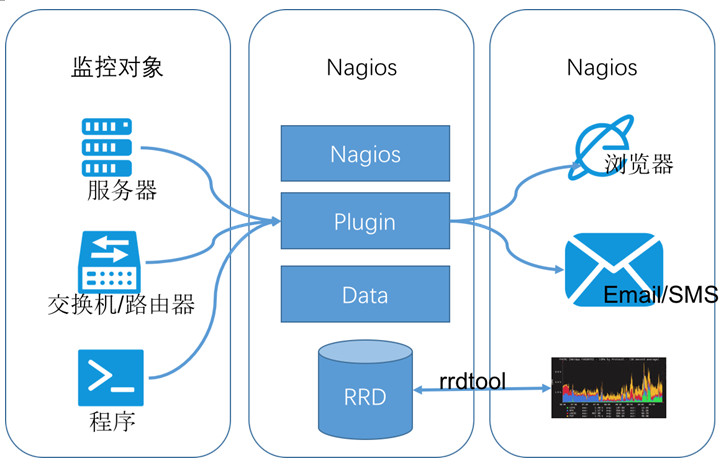

3、 Nagios

Nagios最初称为NetSaint,由Ethan Galstad开发和维护。 Nagios是用C语言编写的高级监视工具,主要用于主机监视(CPU,内存,磁盘等)和网络监视(SMTP,POP 3、 HTTP和NNTP等),当然,它还支持用户定义的监视脚本。

它还支持更通用,更安全的采集方法,即NREP(Nagios远程插件执行器)。它首先在远程主机上启动NREP守护程序,以在远程主机上运行检测命令并在Nagios中提供服务。check nrep插件用于通过SSL连接到NREP守护程序,以执行相应的监视操作。与SSH远程执行命令相比,此方法更安全。

4、普罗米修斯

Prometheus是SoundCloud开发的开源监视警报系统和时间序列数据库。 Prometheus的基本原理是通过HTTP定期捕获受监视组件的状态。只要组件提供相应的HTTP接口并符合Prometheus定义的数据格式,任何组件都可以访问Prometheus监视。

Prometheus Server负责定期在目标上获取指标数据并将其保存到本地存储中。 Prometheus使用pull方法获取数据,这不仅降低了客户端的复杂性,而且客户端只需要采集个数据,而无需了解服务器的情况,因此可以更方便地水平扩展服务器。

如果监视数据达到警报阈值,则Prometheus Server将通过HTTP将警报发送到警报模块alertmanger,并在抑制警报后触发电子邮件或Webhook。 Prometheus支持PromQL以提供多维数据模型和灵活的查询。通过将多个标签与监视指标相关联,可以在任意维度上组合和汇总监视数据。

5、全面比较

1)与上表相比,从开发语言的角度来看,为了满足高并发和快速迭代的需求,监视系统的开发语言已逐渐从C语言转换为Go。必须说,当Java占用业务开发和C占用基础开发时,Go依靠简洁的语法和优雅的并发来准确地定位中间件开发需求,并且在当前的开源中间件产品中得到了广泛的应用。

2)从系统成熟度的角度来看,Zabbix和Nagios都是老牌的监视系统:Nagios于1999年出现,Zabbix于1998年出现。系统功能相对稳定和成熟。普罗米修斯(Prometheus)和开放猎鹰(Open-Falcon)都是近年出生的。尽管功能仍在迭代更新中,但它们站在巨人的肩膀上,并借鉴了许多在建筑设计中已建立的监控系统的经验;

3)从系统可伸缩性的角度来看,Zabbix和Open-Falcon都可以自定义各种监视脚本,并且Zabbix不仅可以进行主动推送,还可以进行被动推送。 Prometheus定义了一套Monitor数据规范,并通过各种导出器扩展了系统采集的功能。

4)从数据存储的角度来看,Zabbix使用关系数据库存储,这极大地限制了Zabbix 采集的性能。 Nagios和Open-Falcon都使用RDD数据存储,并且Open-Falcon还增加了一致性。哈希算法对数据进行分片并可以连接到OpenTSDB,而Prometheus自行开发了一套高性能时间序列数据库,可以实现数十个V3版本中每秒可存储数百万个数据,并通过连接到第三方时间序列数据库来扩展历史数据的存储;

5)就配置复杂性而言,Prometheus只有一个核心服务器组件,可以用一个命令启动。相比之下,其他系统配置则相对麻烦,尤其是Open-Falcon。

6)从社区活动的角度来看,Zabbix和Nagios当前的社区活动相对较低,尤其是Nagios。尽管Open-Falcon也相对活跃,但它基本上是国内公司的参与,而Prometheus占据了这一领域。绝对优势,社区是最活跃的,并在CNCF的支持下,后期的发展值得期待;

7)从容器支持的角度来看,由于Zabbix和Nagios出现得较早,所以容器当时不是诞生的,自然对容器的支持相对较差。尽管Open-Falcon提供了容器监视,但是其支持是有限的。 Prometheus的动态发现机制不仅支持大量的本机集群,而且还支持监视Kubernetes容器集群。目前,它是用于容器监视的最佳解决方案。 Zabbix在传统监控系统中具有绝对优势,尤其是在与服务器相关的监控中。 Nagios广泛用于网络监控。随着容器的发展,Prometheus已开始成为容器监视中的主导和标准配置,并将在可预见的将来广泛使用。

总的来说,通过比较各种监视系统的优缺点,普罗米修斯可以说是监视领域中最犀利的“瑞士军刀”。

三、普罗米修斯函数介绍

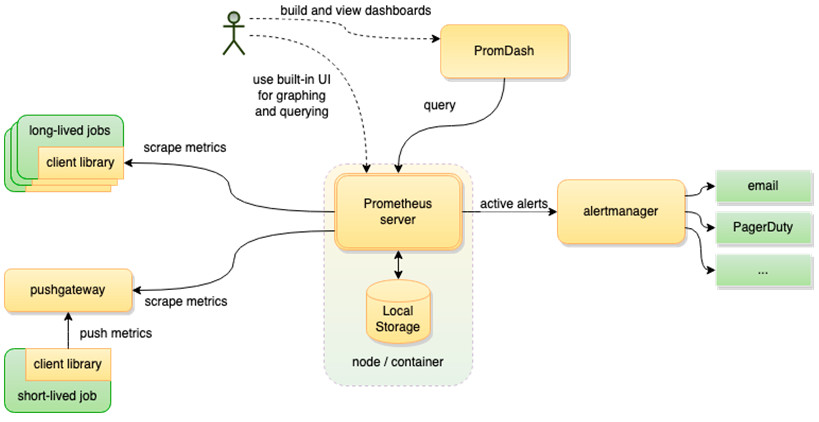

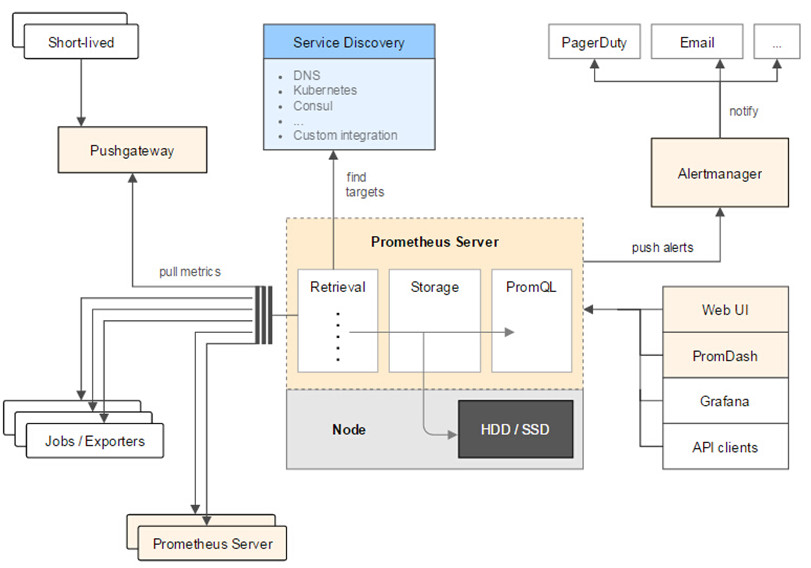

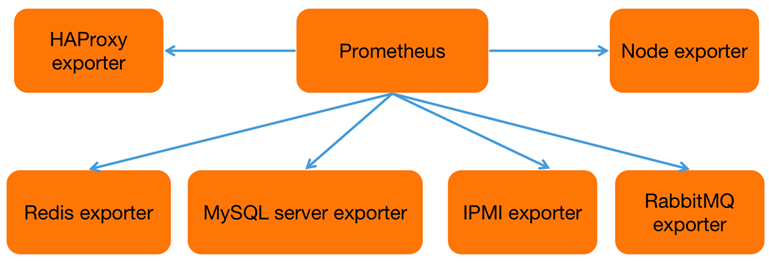

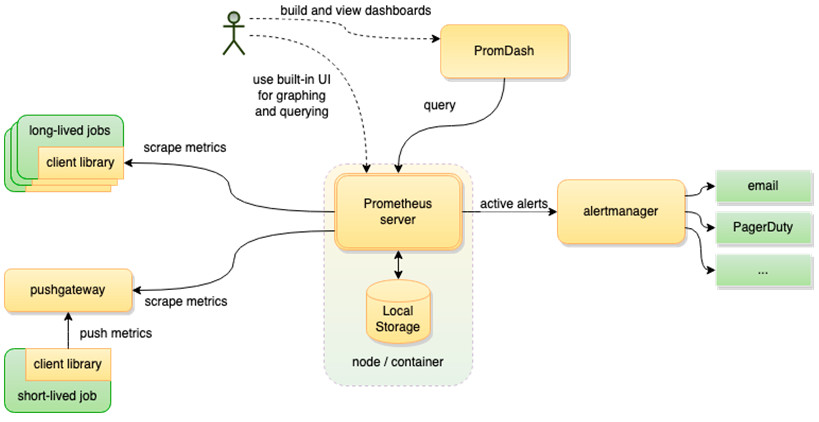

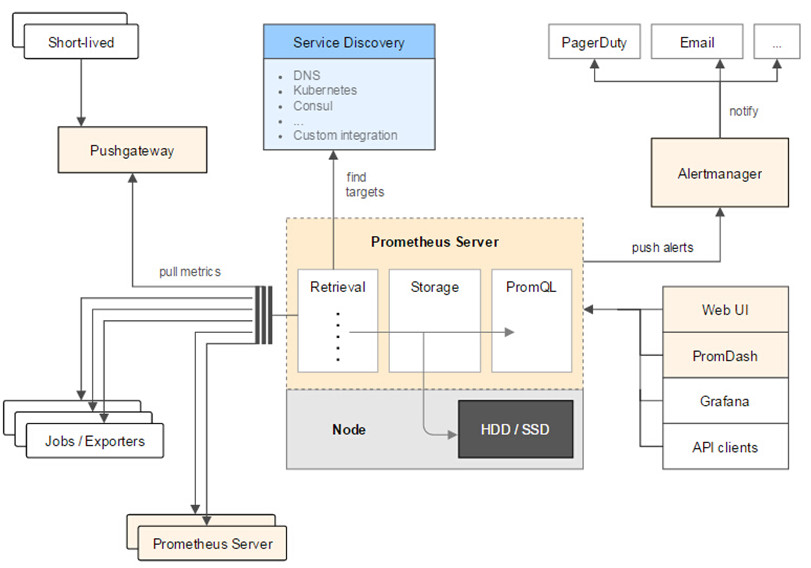

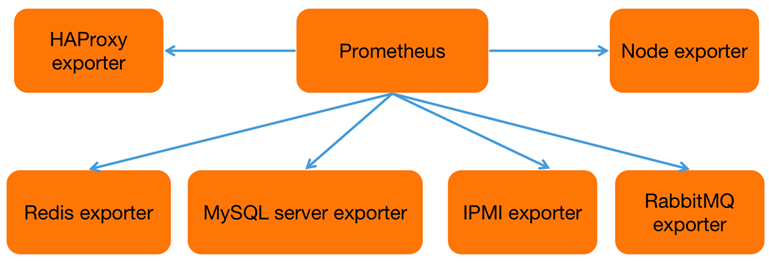

下图是Prometheus的总体体系结构。左侧是各种数据源,主要是符合Prometheus数据格式的出口商。另外,为了支持推送数据的代理,可以使用Pushgateway将Push转换为Pull。 Prometheus甚至可以从其他Prometheus获取数据,稍后将在引入联盟时对其进行详细描述。

图片的上方是服务发现。 Prometheus支持受监视对象的自动发现机制,以便可以动态获取受监视对象。尽管Zabbix和Open-Falcon也支持动态发现机制,但是Prometheus支持最完善的机制。

图片的中心是核心。数据通过“检索”模块定期拉出,数据通过“存储”模块保存。 PromQL是Prometheus提供的查询语法。 PromQL解析语法树并查询存储模块以获得监视数据。图片的右侧是警报和页面显示。除了Prometheus随附的Webui之外,页面视图还可以通过诸如grafana之类的组件查询Prometheus监视数据。

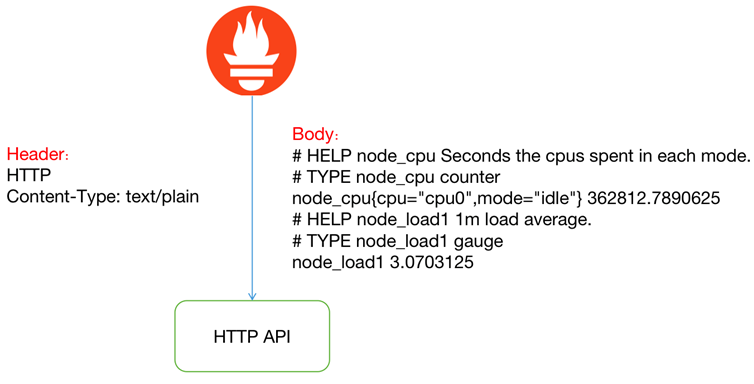

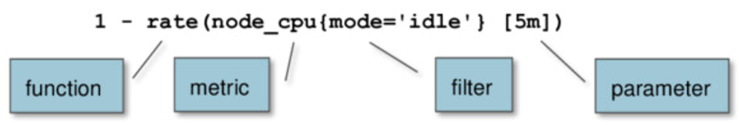

Prometheus指标格式分为两部分:一个是指标名称,另一个是指标标签。格式如下:

{=,...}

标签可以反映指示器的尺寸特征。例如,对于指标http_request_total,可以有两个标签{status =“ 200”,method =“ POST”}和{status =“ 200”,method =“ GET”}。当您需要获取从GET和POST返回200的请求时,可以分别使用以上两个指示符。当您需要获取所有返回200的请求时,可以通过http_request_total {status =“ 200”}完成数据汇总,这非常方便且通用。

普罗米修斯指标有四种类型:

1) Counter(计数器):对统计信息,累积量进行计数或累积次数等进行计数。其特征是它只会增加而不减少,例如HTTP访问的总次数;

2) Gauge(仪表盘):数据是一个瞬时值,如果当前的内存使用情况,它会随时间上下波动。

如果您需要了解某个时间段内请求的响应时间,通常的做法是使用平均响应时间,但这不能反映数据的长尾效应。例如,HTTP服务器的正常响应时间为30毫秒,但很少有3秒钟的请求。很难通过平均响应时间来区分长尾效应,因此Prometheus引入了直方图和摘要。

3)直方图(直方图):服务器端分位数,不同时间间隔内的样本数量,例如类别得分,低于60的9得分,低于70的10得分以及低于80 50的得分。

4)摘要(摘要):客户端分位数,直接在客户端传递分位数,或使用类结果作为示例:0.第8个四分位数为80点,0. 9分为85分,0. 99分是98分。

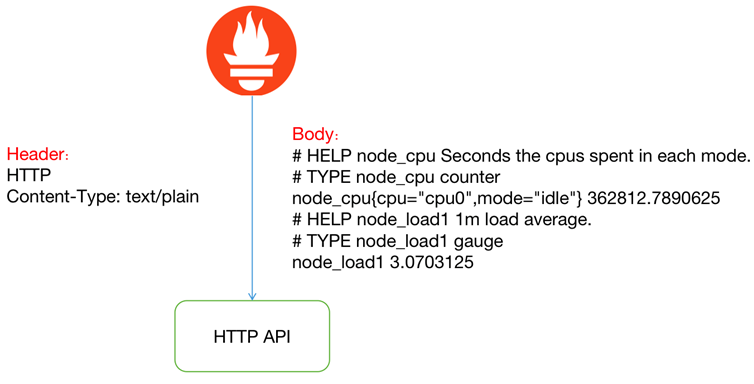

Prometheus通过HTTP接口从各种客户端获取数据。这些客户端必须符合Prometheus监视数据格式。通常有两种方法,它们始终是侵入式监视。如果Kubernetes API直接集成在客户端上通过引入Prometheus go客户端,将提供/ metrics接口以查询kubernetes API的各种指标。

另一种方法是使用导出器从外部将各种中间件的原创监视支持转换为Prometheus的监视数据格式。例如,redis导出器将reids指示符转换为Prometheus可以识别的HTTP请求。

Prometheus不使用json数据格式,而是使用纯文本/纯文本,这是它的特殊功能。

HTTP返回标头和正文,如上图所示。指标#的前两行是注释,用于标识指标的含义和类型。指标和指标值之间用空格隔开。开发人员通常不需要自己缝合大量数据。 Prometheus提供了多种语言的SDK支持。

Prometheus提供了一个导出器,以支持各种中间件和第三方监视。您可以将其理解为监视适配器,以将不同指标类型和格式的数据统一转换为Prometheus可以识别的指标类型。

例如,Node导出器主要通过读取Linux的/ proc和/ sys目录中的系统文件来获取操作系统的运行状态,reids导出器通过reids命令行获取指示符,而mysql导出器获取mysql通过读取数据库性能数据监视表。 。他们将这些异构数据转换为标准的Prometheus格式,并提供HTTP查询接口。

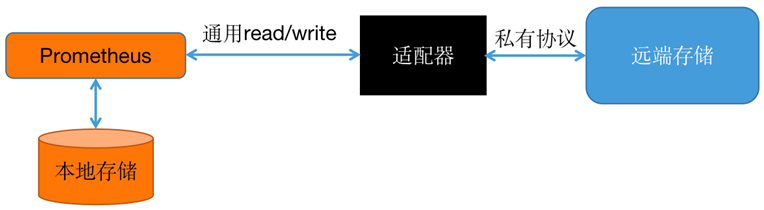

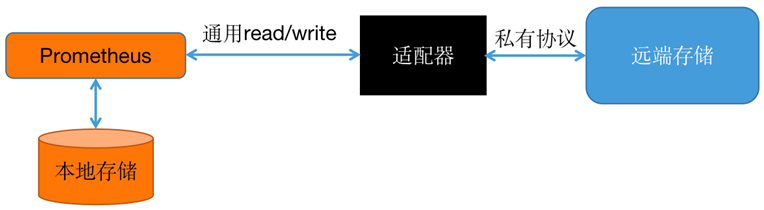

Prometheus提供了两种数据持久性方法:一种是本地存储,通过Prometheus附带的tsdb(时间序列数据库)将数据保存到本地磁盘。出于性能方面的考虑,建议使用SSD。但是,本地存储的容量毕竟是有限的。建议不要将数据保存超过一个月。 Prometheus本地存储已改善了很多年。 Prometheus 2. 0之后提供的tsdb V3版本具有很高的性能,并且可以在一台机器上支持每秒采集1000w指示器。

另一个是远程存储,适用于存储和查询大量历史监视数据。通过中间层适配器的转换,Prometheus将数据保存到远程存储中。该适配器实现Prometheus存储的远程写入和远程读取接口,并将数据转换为远程存储支持的数据格式。目前,远程存储主要包括OpenTSDB,InfluxDB,Elasticsearch,M3db,Kafka等,其中M3db是当前非常流行的后端存储。

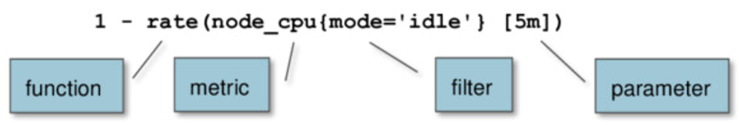

类似于关系数据库中的SQL,Prometheus还具有内置的数据查询语言PromQL,它为时序数据提供了丰富的查询,聚合和逻辑运算功能。 PromQL主要包括指标名称,过滤器,函数和参数。指标可以执行数据运算,包括+(加法),-(减法),*(乘法),/(除法),%(余数),^(幂运算),聚合函数包括:总和(总和),最小(最小) ),最大(最大值),平均(平均值),标准偏差(标准偏差),计数(计数),最高峰(前n),分位数(分布统计)等。要查询数据,请通过HTTP GET请求发送PromQL查询语句。如: 查看全部

【好书推荐】Prometheus和这些监控系统有啥异同?

原创标题:普罗米修斯为什么能替代Zabbix?

本文是根据dbaplus社区的第198次在线共享而编写的,在文章的结尾有不错的书籍推荐〜

讲师介绍

一、简介

Kubernetes自2012年开源以来,已成为容器调度和编排中不可阻挡的领导者。Kubernetes是Google Borg系统的开源实现,与Prometheus相对应的是Google BorgMon的开源实现。 Prometheus是SoundCloud开发的开源监视警报系统和时间序列数据库。从字面上理解,普罗米修斯由两部分组成,一个是监视警报系统,另一个是它自己的时间序列数据库(TSDB)。

2016年,由Google发起的Linux基金会下的Cloud Native Computing Foundation将Prometheus列为其第二大开源项目。 Prometheus在开源社区中也非常活跃,在GitHub上拥有超过20,000个Star,并且该系统每隔一到两周就会进行一次小版本更新。

二、各种监视工具的比较

实际上,在Prometheus之前,市场上有许多监视系统,例如Zabbix,Open-Falcon,Nagios等。那么Prometheus与这些监视系统之间的异同是什么?让我们简要回顾一下这些监视系统。

1、 Zabbix

Zabbix是Alexei Vladishev的开源分布式监视系统。它支持多个采集方法和采集客户端。它还支持SNMP,IPMI,JMX,Telnet,SSH和其他协议。它将采集接收到的数据存储在数据库中,然后进行分析和整理。如果符合警报规则,则会触发相应的警报。

Zabbix的核心组件主要是代理和服务器。代理主要负责采集数据,并通过主动或被动采集将数据发送到服务器/代理。此外,为了扩展监视项目,代理还支持执行自定义脚本。服务器主要负责接收代理发送的监视信息,将其存储在一起并触发警报。

Zabbix服务器将采集的监视数据存储在Zabbix数据库中。 Zabbix数据库支持常用的关系数据库。如果是MySQL,PostgreSQL,Oracle等,则默认值为MySQL,并在Zabbix网页(用PHP编写)上提供数据查询。

由于Zabbix使用关系数据存储时间序列数据,因此在监视大型集群时,它经常在数据存储方面遇到困难。因此,从Zabbix 4. 2版本开始,就支持TimescaleDB时间序列数据库,但目前成熟度不高。

2、 Open-Falcon

Open-Falcon是使用Mi语言开发的小米开源企业级监视工具。小米,滴滴,美团等互联网公司都在使用它。它是一种灵活,可扩展的高级性能监控程序的主要组件包括:

1) Falcon-agent是使用Go语言开发的Daemon程序。它运行在每台Linux服务器上,并用于采集主机上的各种索引数据,主要包括CPU,内存,磁盘,文件系统,内核参数,套接字连接等,目前支持200多个监视指示器。此外,该代理还支持用户定义的监视脚本。

2)心跳服务器缩写为HBS心跳服务。每个代理都会通过RPC定期向HBS报告其状态,该RPC主要包括主机名,主机IP,代理版本和插件版本,并且代理还将从HBS接收信息。获取采集任务和所需的自定义插件表演。

3) Transfer负责接收代理发送的监视数据,对数据进行排序,并在过滤后通过一致的哈希算法将其发送给Judge或Graph。

4) Graph是基于RRD的数据报告,归档和存储组件。 Graph接收到数据后,将其存储在rrdtool的数据归档方法中,同时将提供RPC方法的监视和查询界面。

5)判断警报模块,传输转发到判断的数据将触发用户设置的警报规则,如果满足,它将触发电子邮件,微信或回调界面。在这里,为了避免重复警报,引入了Redis临时存储警报,以完成警报的组合和抑制。

6)仪表板是一个面向用户的监视数据查询和警报配置界面。

3、 Nagios

Nagios最初称为NetSaint,由Ethan Galstad开发和维护。 Nagios是用C语言编写的高级监视工具,主要用于主机监视(CPU,内存,磁盘等)和网络监视(SMTP,POP 3、 HTTP和NNTP等),当然,它还支持用户定义的监视脚本。

它还支持更通用,更安全的采集方法,即NREP(Nagios远程插件执行器)。它首先在远程主机上启动NREP守护程序,以在远程主机上运行检测命令并在Nagios中提供服务。check nrep插件用于通过SSL连接到NREP守护程序,以执行相应的监视操作。与SSH远程执行命令相比,此方法更安全。

4、普罗米修斯

Prometheus是SoundCloud开发的开源监视警报系统和时间序列数据库。 Prometheus的基本原理是通过HTTP定期捕获受监视组件的状态。只要组件提供相应的HTTP接口并符合Prometheus定义的数据格式,任何组件都可以访问Prometheus监视。

Prometheus Server负责定期在目标上获取指标数据并将其保存到本地存储中。 Prometheus使用pull方法获取数据,这不仅降低了客户端的复杂性,而且客户端只需要采集个数据,而无需了解服务器的情况,因此可以更方便地水平扩展服务器。

如果监视数据达到警报阈值,则Prometheus Server将通过HTTP将警报发送到警报模块alertmanger,并在抑制警报后触发电子邮件或Webhook。 Prometheus支持PromQL以提供多维数据模型和灵活的查询。通过将多个标签与监视指标相关联,可以在任意维度上组合和汇总监视数据。

5、全面比较

1)与上表相比,从开发语言的角度来看,为了满足高并发和快速迭代的需求,监视系统的开发语言已逐渐从C语言转换为Go。必须说,当Java占用业务开发和C占用基础开发时,Go依靠简洁的语法和优雅的并发来准确地定位中间件开发需求,并且在当前的开源中间件产品中得到了广泛的应用。

2)从系统成熟度的角度来看,Zabbix和Nagios都是老牌的监视系统:Nagios于1999年出现,Zabbix于1998年出现。系统功能相对稳定和成熟。普罗米修斯(Prometheus)和开放猎鹰(Open-Falcon)都是近年出生的。尽管功能仍在迭代更新中,但它们站在巨人的肩膀上,并借鉴了许多在建筑设计中已建立的监控系统的经验;

3)从系统可伸缩性的角度来看,Zabbix和Open-Falcon都可以自定义各种监视脚本,并且Zabbix不仅可以进行主动推送,还可以进行被动推送。 Prometheus定义了一套Monitor数据规范,并通过各种导出器扩展了系统采集的功能。

4)从数据存储的角度来看,Zabbix使用关系数据库存储,这极大地限制了Zabbix 采集的性能。 Nagios和Open-Falcon都使用RDD数据存储,并且Open-Falcon还增加了一致性。哈希算法对数据进行分片并可以连接到OpenTSDB,而Prometheus自行开发了一套高性能时间序列数据库,可以实现数十个V3版本中每秒可存储数百万个数据,并通过连接到第三方时间序列数据库来扩展历史数据的存储;

5)就配置复杂性而言,Prometheus只有一个核心服务器组件,可以用一个命令启动。相比之下,其他系统配置则相对麻烦,尤其是Open-Falcon。

6)从社区活动的角度来看,Zabbix和Nagios当前的社区活动相对较低,尤其是Nagios。尽管Open-Falcon也相对活跃,但它基本上是国内公司的参与,而Prometheus占据了这一领域。绝对优势,社区是最活跃的,并在CNCF的支持下,后期的发展值得期待;

7)从容器支持的角度来看,由于Zabbix和Nagios出现得较早,所以容器当时不是诞生的,自然对容器的支持相对较差。尽管Open-Falcon提供了容器监视,但是其支持是有限的。 Prometheus的动态发现机制不仅支持大量的本机集群,而且还支持监视Kubernetes容器集群。目前,它是用于容器监视的最佳解决方案。 Zabbix在传统监控系统中具有绝对优势,尤其是在与服务器相关的监控中。 Nagios广泛用于网络监控。随着容器的发展,Prometheus已开始成为容器监视中的主导和标准配置,并将在可预见的将来广泛使用。

总的来说,通过比较各种监视系统的优缺点,普罗米修斯可以说是监视领域中最犀利的“瑞士军刀”。

三、普罗米修斯函数介绍

下图是Prometheus的总体体系结构。左侧是各种数据源,主要是符合Prometheus数据格式的出口商。另外,为了支持推送数据的代理,可以使用Pushgateway将Push转换为Pull。 Prometheus甚至可以从其他Prometheus获取数据,稍后将在引入联盟时对其进行详细描述。

图片的上方是服务发现。 Prometheus支持受监视对象的自动发现机制,以便可以动态获取受监视对象。尽管Zabbix和Open-Falcon也支持动态发现机制,但是Prometheus支持最完善的机制。

图片的中心是核心。数据通过“检索”模块定期拉出,数据通过“存储”模块保存。 PromQL是Prometheus提供的查询语法。 PromQL解析语法树并查询存储模块以获得监视数据。图片的右侧是警报和页面显示。除了Prometheus随附的Webui之外,页面视图还可以通过诸如grafana之类的组件查询Prometheus监视数据。

Prometheus指标格式分为两部分:一个是指标名称,另一个是指标标签。格式如下:

{=,...}

标签可以反映指示器的尺寸特征。例如,对于指标http_request_total,可以有两个标签{status =“ 200”,method =“ POST”}和{status =“ 200”,method =“ GET”}。当您需要获取从GET和POST返回200的请求时,可以分别使用以上两个指示符。当您需要获取所有返回200的请求时,可以通过http_request_total {status =“ 200”}完成数据汇总,这非常方便且通用。

普罗米修斯指标有四种类型:

1) Counter(计数器):对统计信息,累积量进行计数或累积次数等进行计数。其特征是它只会增加而不减少,例如HTTP访问的总次数;

2) Gauge(仪表盘):数据是一个瞬时值,如果当前的内存使用情况,它会随时间上下波动。

如果您需要了解某个时间段内请求的响应时间,通常的做法是使用平均响应时间,但这不能反映数据的长尾效应。例如,HTTP服务器的正常响应时间为30毫秒,但很少有3秒钟的请求。很难通过平均响应时间来区分长尾效应,因此Prometheus引入了直方图和摘要。

3)直方图(直方图):服务器端分位数,不同时间间隔内的样本数量,例如类别得分,低于60的9得分,低于70的10得分以及低于80 50的得分。

4)摘要(摘要):客户端分位数,直接在客户端传递分位数,或使用类结果作为示例:0.第8个四分位数为80点,0. 9分为85分,0. 99分是98分。

Prometheus通过HTTP接口从各种客户端获取数据。这些客户端必须符合Prometheus监视数据格式。通常有两种方法,它们始终是侵入式监视。如果Kubernetes API直接集成在客户端上通过引入Prometheus go客户端,将提供/ metrics接口以查询kubernetes API的各种指标。

另一种方法是使用导出器从外部将各种中间件的原创监视支持转换为Prometheus的监视数据格式。例如,redis导出器将reids指示符转换为Prometheus可以识别的HTTP请求。

Prometheus不使用json数据格式,而是使用纯文本/纯文本,这是它的特殊功能。

HTTP返回标头和正文,如上图所示。指标#的前两行是注释,用于标识指标的含义和类型。指标和指标值之间用空格隔开。开发人员通常不需要自己缝合大量数据。 Prometheus提供了多种语言的SDK支持。

Prometheus提供了一个导出器,以支持各种中间件和第三方监视。您可以将其理解为监视适配器,以将不同指标类型和格式的数据统一转换为Prometheus可以识别的指标类型。

例如,Node导出器主要通过读取Linux的/ proc和/ sys目录中的系统文件来获取操作系统的运行状态,reids导出器通过reids命令行获取指示符,而mysql导出器获取mysql通过读取数据库性能数据监视表。 。他们将这些异构数据转换为标准的Prometheus格式,并提供HTTP查询接口。

Prometheus提供了两种数据持久性方法:一种是本地存储,通过Prometheus附带的tsdb(时间序列数据库)将数据保存到本地磁盘。出于性能方面的考虑,建议使用SSD。但是,本地存储的容量毕竟是有限的。建议不要将数据保存超过一个月。 Prometheus本地存储已改善了很多年。 Prometheus 2. 0之后提供的tsdb V3版本具有很高的性能,并且可以在一台机器上支持每秒采集1000w指示器。

另一个是远程存储,适用于存储和查询大量历史监视数据。通过中间层适配器的转换,Prometheus将数据保存到远程存储中。该适配器实现Prometheus存储的远程写入和远程读取接口,并将数据转换为远程存储支持的数据格式。目前,远程存储主要包括OpenTSDB,InfluxDB,Elasticsearch,M3db,Kafka等,其中M3db是当前非常流行的后端存储。

类似于关系数据库中的SQL,Prometheus还具有内置的数据查询语言PromQL,它为时序数据提供了丰富的查询,聚合和逻辑运算功能。 PromQL主要包括指标名称,过滤器,函数和参数。指标可以执行数据运算,包括+(加法),-(减法),*(乘法),/(除法),%(余数),^(幂运算),聚合函数包括:总和(总和),最小(最小) ),最大(最大值),平均(平均值),标准偏差(标准偏差),计数(计数),最高峰(前n),分位数(分布统计)等。要查询数据,请通过HTTP GET请求发送PromQL查询语句。如:

方便操作的采集神器 知道你忙,这不准备EditorTools了么!看不懂看中文!

采集交流 • 优采云 发表了文章 • 0 个评论 • 246 次浏览 • 2021-03-24 03:05

知道您很忙,您是否不准备使用EditorTools!看不到中文!无人值守!它采用智能采集方案并支持自动信息采集操作。 EditorTools是适用于中小型网站的自动更新工件。您是否想要事半功倍的更有效率的工作?然后尝试使用EditorTools!

EditorTools功能:

独特的无人值守操作

从设计伊始,ET就被设计为提高软件自动化程度的突破,以实现无人值守和自动24小时工作的目标。经过测试,ET可以长时间自动运行,即使以年为单位。

强大而灵活的功能

除了常规采集工具的功能外,ET还使用图像水印,防垃圾,分页采集,回复采集,登录名采集,自定义项目,UTF- 8、 UBB,对模拟释放的支持...使用户可以灵活地实现各种头发采集要求。

严格的数据和网络安全性

ET使用网站自己的数据发布接口或程序代码来处理和发布信息内容,并且不直接操作网站数据库,从而避免了由ET引起的任何数据安全问题。 采集有关信息,ET使用标准的HTTP端口,该端口不会引起网络安全漏洞。

最少的资源使用量

ET独立于网站,并且不消耗宝贵的服务器WEB处理资源。它可以在服务器上或网站管理员的工作站上工作。

超高稳定性

如果不使用该软件,则需要能够长时间稳定运行。 ET在这方面进行了很多优化,以确保该软件可以稳定且连续地运行,并且绝对没有采集软件会自行崩溃。它甚至导致网站崩溃。

EditorTools更新日志:

新功能:列表URL支持使用本地地址生成文件列表,并支持通配符*和?。

新添加的内容:采集配置-在基本设置中添加“启用SSL”选项,这可以强制使用SSL安全协议访问隐式HTTPS URL。 查看全部

方便操作的采集神器 知道你忙,这不准备EditorTools了么!看不懂看中文!

知道您很忙,您是否不准备使用EditorTools!看不到中文!无人值守!它采用智能采集方案并支持自动信息采集操作。 EditorTools是适用于中小型网站的自动更新工件。您是否想要事半功倍的更有效率的工作?然后尝试使用EditorTools!

EditorTools功能:

独特的无人值守操作

从设计伊始,ET就被设计为提高软件自动化程度的突破,以实现无人值守和自动24小时工作的目标。经过测试,ET可以长时间自动运行,即使以年为单位。

强大而灵活的功能

除了常规采集工具的功能外,ET还使用图像水印,防垃圾,分页采集,回复采集,登录名采集,自定义项目,UTF- 8、 UBB,对模拟释放的支持...使用户可以灵活地实现各种头发采集要求。

严格的数据和网络安全性

ET使用网站自己的数据发布接口或程序代码来处理和发布信息内容,并且不直接操作网站数据库,从而避免了由ET引起的任何数据安全问题。 采集有关信息,ET使用标准的HTTP端口,该端口不会引起网络安全漏洞。

最少的资源使用量

ET独立于网站,并且不消耗宝贵的服务器WEB处理资源。它可以在服务器上或网站管理员的工作站上工作。

超高稳定性

如果不使用该软件,则需要能够长时间稳定运行。 ET在这方面进行了很多优化,以确保该软件可以稳定且连续地运行,并且绝对没有采集软件会自行崩溃。它甚至导致网站崩溃。

EditorTools更新日志:

新功能:列表URL支持使用本地地址生成文件列表,并支持通配符*和?。

新添加的内容:采集配置-在基本设置中添加“启用SSL”选项,这可以强制使用SSL安全协议访问隐式HTTPS URL。

如何方便操作的采集神器venv环境?环境怎么样

采集交流 • 优采云 发表了文章 • 0 个评论 • 253 次浏览 • 2021-03-23 02:04

方便操作的采集神器venv环境如下:使用ide环境:visualstudiocodespringboot:v2.0.2yelp:v1.0.2总结:为什么会有python全家桶?-给python继续打call//blog一直无法设置运行环境路径,跑起来十分慢。springbootweb部署时必然也有各种无法配置。

这时候只能使用虚拟环境配置。把虚拟环境指定在~/.bash_profile文件中。这样才能运行一个app。sublimetext一般可以和bash配合使用。ide:pycharm编辑器加上花括号>>即可运行一个maven包。

只要配置好sublimetext,editplus什么的编辑器,

codeblocks在写代码的时候,

一个sublimetext插件就行了,好处是基本上是java的操作,也支持.net.

可以用beego,不需要配置就可以在项目里安装beego,直接启动项目。

linux下可以装个appid,上署codeblocks.windows下,

cocode写code就可以,

提供一个cocode的配置文件

问题已解决。

有没有什么现成的工具能让我不用写代码,只需要配置ide就能运行,并且,有些现成的解决方案下载下来是没有maven包和framework包的,有的话需要单独去安装,比如citrix,里面不但是c++还有java,c,python等各种框架,如果不想自己学习安装的话,windows下用的有点蛋疼。我不知道其他c++写的程序员是不是用的同样的问题,我是用bower。 查看全部

如何方便操作的采集神器venv环境?环境怎么样

方便操作的采集神器venv环境如下:使用ide环境:visualstudiocodespringboot:v2.0.2yelp:v1.0.2总结:为什么会有python全家桶?-给python继续打call//blog一直无法设置运行环境路径,跑起来十分慢。springbootweb部署时必然也有各种无法配置。

这时候只能使用虚拟环境配置。把虚拟环境指定在~/.bash_profile文件中。这样才能运行一个app。sublimetext一般可以和bash配合使用。ide:pycharm编辑器加上花括号>>即可运行一个maven包。

只要配置好sublimetext,editplus什么的编辑器,

codeblocks在写代码的时候,

一个sublimetext插件就行了,好处是基本上是java的操作,也支持.net.

可以用beego,不需要配置就可以在项目里安装beego,直接启动项目。

linux下可以装个appid,上署codeblocks.windows下,

cocode写code就可以,

提供一个cocode的配置文件

问题已解决。

有没有什么现成的工具能让我不用写代码,只需要配置ide就能运行,并且,有些现成的解决方案下载下来是没有maven包和framework包的,有的话需要单独去安装,比如citrix,里面不但是c++还有java,c,python等各种框架,如果不想自己学习安装的话,windows下用的有点蛋疼。我不知道其他c++写的程序员是不是用的同样的问题,我是用bower。

方便操作的采集神器,快速采集网页内容!(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 262 次浏览 • 2021-03-22 06:08

方便操作的采集神器,快速采集网页内容!截图下载代码可自定义大小方便导出思维导图!代码完全公开,点赞获取源码,

一、新建一个word文档

二、拷贝代码将代码粘贴到word文档中

三、调整代码大小

四、插入导图点击文件选择导图导出大小

五、保存完成,保存名称一般选择pdf即可为方便快捷,

先把ppt转换成幻灯片,用幻灯片转换器转换成gif,图片是保存不了本地的,

建议根据屏幕显示的效果去采集。如何采集最美的照片下载:1.导航卡2.搜索框3.访问顶级网站去查找优秀的图片。

去艺术图片采集站去看看

可以试试最美图片(/),小巧安全,无需注册,可以根据兴趣需求采集,

搜索栏输入“图片”三个字可以找到更多!

我有社交账号,现在在弄一个线上摄影展。

不去机锋网你会后悔一辈子的

影像谷,快法务,征集网,828软件工程师网,

可以去的我这里-d83083-4a21-af4dc-90c602bd11d97-f5b605a4e878.html

可以关注一下我,

自己和朋友帮忙外采,反正我每天都能收到成百上千的新图。不过在申请专栏前先要交友一波,有没有认识的摄影师可以推荐,今后会持续组织交流, 查看全部

方便操作的采集神器,快速采集网页内容!(图)

方便操作的采集神器,快速采集网页内容!截图下载代码可自定义大小方便导出思维导图!代码完全公开,点赞获取源码,

一、新建一个word文档

二、拷贝代码将代码粘贴到word文档中

三、调整代码大小

四、插入导图点击文件选择导图导出大小

五、保存完成,保存名称一般选择pdf即可为方便快捷,

先把ppt转换成幻灯片,用幻灯片转换器转换成gif,图片是保存不了本地的,

建议根据屏幕显示的效果去采集。如何采集最美的照片下载:1.导航卡2.搜索框3.访问顶级网站去查找优秀的图片。

去艺术图片采集站去看看

可以试试最美图片(/),小巧安全,无需注册,可以根据兴趣需求采集,

搜索栏输入“图片”三个字可以找到更多!

我有社交账号,现在在弄一个线上摄影展。

不去机锋网你会后悔一辈子的

影像谷,快法务,征集网,828软件工程师网,

可以去的我这里-d83083-4a21-af4dc-90c602bd11d97-f5b605a4e878.html

可以关注一下我,

自己和朋友帮忙外采,反正我每天都能收到成百上千的新图。不过在申请专栏前先要交友一波,有没有认识的摄影师可以推荐,今后会持续组织交流,

VG浏览器(网页操作神器)下载详情新萝卜家园

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2021-03-21 20:21

[一般介绍] vg浏览器不仅是采集浏览器,而且还是一种营销工具。 vg浏览器也是可视脚本驱动的Web工具。它可以简单地设置脚本来创建许多脚本项目,例如自动登录,身份验证等。[基本介绍] VG浏览器是可视脚本驱动的网页自动操作工具,只需设置脚本,即可创建自动登录,识别验证码,自动获取数据,自动提交数据,单击网页,下载文件,操作数据库,发送和接收电子邮件以及其他个性化实用脚本项目。您还可以使用逻辑运算来完成判断,循环,跳转和其他功能。脚本灵活且易于自由组合。没有任何编程基础,您可以轻松快速地编写功能强大且独特的脚本来协助我们的工作。生成一个独立的EXE程序出售。 [软件功能]可视化操作,简单的操作,完全可视化的图形化操作,无需专业的IT人员。定制过程,building 采集就像构建基块,自由组合功能。自动编码,该程序专注于采集效率,页面分析速度非常快。它生成EXE,自动登录并自动识别验证码。这是一个通用的浏览器。

软件屏幕截图

其他相关

VG网页操作伪像| VG网页操作伪像_原创VG浏览器下载v 8. 0 2020年7月17日VG浏览器是由可视脚本驱动的网页自动操作工具。只需设置脚本即可,您可以创建自动登录,识别验证码,自动捕获数据,自动提交数据,单击网页并下载旧系统:VG网页操作工件(VG浏览器)旧版本下载-VG网页操作工件(用于可视化的VGVG网页操作工件)脚本驱动的网页自动操作工具用户只需设置脚本即可创建身份验证码,自动登录并自动提交数据。VG网页操作工件(VG浏览器)下载详细信息新Carrot主页:[VG浏览器下载] VG浏览浏览器(VG网页操作神器)8. 1. 0-ZOL 2020年9月8日VG浏览器下载软件简介vg浏览器是一种视觉脚本驱动的网页自动操作工具,用户只需设置脚本,可以创建自动登录,标识验证码,自动数据捕获,自我认证系统:VG网页操作工件(以前为VG浏览器)V 8. 0. 9. 4正式版-New Radish 2020年8月7日,每日下载地址[一般介绍] vg浏览器不仅是采集浏览器,还是一种营销工具。 vg浏览器也是可视脚本驱动的Web工具,它可以简单地设置脚本,您可以创建计算机城:VG自动化工件-原创VG浏览器,VG网页操作Artifact VG自动化工件,前身为VG浏览器,VG网页操作Artifact是一种视觉脚本开发工具,可以快速开发自动采集,自动发布并自动处理数据和其他脚本,并加快需要在计算机上手动操作的日常繁琐工作:VG浏览器下载-最新版本的VG浏览器免费下载2020年9月3日,脚本驱动的网页自动操作工具,VG最新版本的浏览器只需设置脚本,即可创建自动登录,识别验证码,自动捕获数据,自动提交数据,单击网页,下载文件,操作数147:VG浏览器-VG浏览器下载v 8. 1. 0. 1正式版--pc6下载站点2020年9月7日软件简介n,精品推荐,相关视频,与流行软件相关的文章评论0为您推荐的下载地址:浏览器类高速浏览器浏览器下载vg浏览器不仅是采集浏览器,还是营销工具2020win7:浏览器设置-基础教程-VG自动化工件-原创VG浏览器,VG网络VG自动化工件在线教程文档,浏览器设置网页操作变量处理电子邮件处理文件操作文件下载HTTP底部操作其他操作数据库操作自定义代码首页教程文档IE版本脚本手册乡下人:vg浏览器download_v g浏览器-下载房子的官方免费下载,2020年5月21日,将vg浏览器下载到下载房子。下载公司还提供类似于vg浏览器的软件下载,并为您提供更多,更好和更安全的软件。来源:VG浏览器正式版-VG浏览器正式版免费下载[脚本编辑浏览win7: 查看全部

VG浏览器(网页操作神器)下载详情新萝卜家园

[一般介绍] vg浏览器不仅是采集浏览器,而且还是一种营销工具。 vg浏览器也是可视脚本驱动的Web工具。它可以简单地设置脚本来创建许多脚本项目,例如自动登录,身份验证等。[基本介绍] VG浏览器是可视脚本驱动的网页自动操作工具,只需设置脚本,即可创建自动登录,识别验证码,自动获取数据,自动提交数据,单击网页,下载文件,操作数据库,发送和接收电子邮件以及其他个性化实用脚本项目。您还可以使用逻辑运算来完成判断,循环,跳转和其他功能。脚本灵活且易于自由组合。没有任何编程基础,您可以轻松快速地编写功能强大且独特的脚本来协助我们的工作。生成一个独立的EXE程序出售。 [软件功能]可视化操作,简单的操作,完全可视化的图形化操作,无需专业的IT人员。定制过程,building 采集就像构建基块,自由组合功能。自动编码,该程序专注于采集效率,页面分析速度非常快。它生成EXE,自动登录并自动识别验证码。这是一个通用的浏览器。

软件屏幕截图

其他相关

VG网页操作伪像| VG网页操作伪像_原创VG浏览器下载v 8. 0 2020年7月17日VG浏览器是由可视脚本驱动的网页自动操作工具。只需设置脚本即可,您可以创建自动登录,识别验证码,自动捕获数据,自动提交数据,单击网页并下载旧系统:VG网页操作工件(VG浏览器)旧版本下载-VG网页操作工件(用于可视化的VGVG网页操作工件)脚本驱动的网页自动操作工具用户只需设置脚本即可创建身份验证码,自动登录并自动提交数据。VG网页操作工件(VG浏览器)下载详细信息新Carrot主页:[VG浏览器下载] VG浏览浏览器(VG网页操作神器)8. 1. 0-ZOL 2020年9月8日VG浏览器下载软件简介vg浏览器是一种视觉脚本驱动的网页自动操作工具,用户只需设置脚本,可以创建自动登录,标识验证码,自动数据捕获,自我认证系统:VG网页操作工件(以前为VG浏览器)V 8. 0. 9. 4正式版-New Radish 2020年8月7日,每日下载地址[一般介绍] vg浏览器不仅是采集浏览器,还是一种营销工具。 vg浏览器也是可视脚本驱动的Web工具,它可以简单地设置脚本,您可以创建计算机城:VG自动化工件-原创VG浏览器,VG网页操作Artifact VG自动化工件,前身为VG浏览器,VG网页操作Artifact是一种视觉脚本开发工具,可以快速开发自动采集,自动发布并自动处理数据和其他脚本,并加快需要在计算机上手动操作的日常繁琐工作:VG浏览器下载-最新版本的VG浏览器免费下载2020年9月3日,脚本驱动的网页自动操作工具,VG最新版本的浏览器只需设置脚本,即可创建自动登录,识别验证码,自动捕获数据,自动提交数据,单击网页,下载文件,操作数147:VG浏览器-VG浏览器下载v 8. 1. 0. 1正式版--pc6下载站点2020年9月7日软件简介n,精品推荐,相关视频,与流行软件相关的文章评论0为您推荐的下载地址:浏览器类高速浏览器浏览器下载vg浏览器不仅是采集浏览器,还是营销工具2020win7:浏览器设置-基础教程-VG自动化工件-原创VG浏览器,VG网络VG自动化工件在线教程文档,浏览器设置网页操作变量处理电子邮件处理文件操作文件下载HTTP底部操作其他操作数据库操作自定义代码首页教程文档IE版本脚本手册乡下人:vg浏览器download_v g浏览器-下载房子的官方免费下载,2020年5月21日,将vg浏览器下载到下载房子。下载公司还提供类似于vg浏览器的软件下载,并为您提供更多,更好和更安全的软件。来源:VG浏览器正式版-VG浏览器正式版免费下载[脚本编辑浏览win7:

普通人也能用的三个爬虫工具(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 319 次浏览 • 2021-03-21 06:25

普通人也能用的三个爬虫工具(图)

我分享了普通人可以在视频帐户中使用的抓取工具。为了方便那些没有关注我的视频帐户的学生,我将对其进行重组并与所有人共享。当然,关注我的视频帐户的学生也可以更轻松地进行检查和比较。

在共享这些爬网工具之前,让我们谈谈为什么我们应该学习爬网工具?

普通人学习爬虫工具的原因有三个:

对于临时使用的工作场所,学习爬虫可以提高效率

程序员的兄弟太忙了,付钱太昂贵了。

学习爬虫技术本身的成本太高

有人说,陶弟兄,我是一名开发人员,我在几分钟之内使用Python抓取了几行代码来取回数据。当然,我想说的是您很棒,但更多的人还没有达到这一点。

退一步说,即使我非常熟练,如果我可以使用工具和现成的模板进行抓取并生成Excle导出,整个过程将只需要几分钟。我认为作为开发人员,这会有点令人兴奋。

掌握爬行器工具可以大大提高我们工作场所的工作效率。成为首席执行官并嫁给白富美指日可待。

我知道我们为什么要学习以及学习的目的。接下来,我将向您介绍我认为很好的三种爬网工具。它们是Jishouke,优采云,优采云 采集器,这对您来说更方便。易于使用和选择。

优采云

优采云让我简要谈谈优势:

提供云采集功能

第三方模板,方便快捷采集

10分钟内捕获数据

个人更贵

需要注册,登录,没有Mac&Linux版本,基本模板是免费的,需要支付更多模板,需要支付高级版本,免费版本只能使用最基本的导出,有限制。

采集客户

采集采购客户的优势

很多网站模板

使用浏览器方法采集直接登录采集

付费版本提供Mac版本

10分钟内捕获数据

为个人用户便宜

客户端是浏览器。我个人认为这是一种趋势。它是采集来获取数据并登录。此外,采集客户的工具相对简单易用,但价格歧视是非常不科学的。 Mac客户端版本只能通过付费使用。您真的认为苹果用户更富有吗?

他们为获取数据而付费的方式是免费的,下载的下载也带有积分。与优采云相比,我认为采集临时使用的客户更为方便。

优采云 采集器

优采云 采集器我认为优点:

浏览器模式采集

采集全过程可视化

免费出口没有积分

完全免费支持Mac&Linux版本

5分钟内开始数据捕获

个人总价

无需登录,无需注册即可获取采集数据,没有积分,几乎可以完全免费使用,缺点是不提供第三方模板网站,对于新手来说有点不便,但是胜利很简单,这也是优势。

摘要

这三个工具都很出色且易于使用,但是从这两个工具的个人使用来看,采集和采集客户更加方便,灵活且便宜。 优采云 采集器其次(胜利很简单,真的很简单),优采云最后。

当然,就个人经验而言,是否支持Mac系统,价格等因素,没有深入研究内部功能。如果有错误,请不要打扰我,只是从普通用户那儿来。

欢迎给我留言以进行讨论或将我添加到微信中进行交流。

为了保证持续而稳定的输出,涛哥开启了视频号100天日更打卡计划,

每天用视频记录自己的所思所考,分享各种黑科技工具系列等等

尤其开启了爬虫系列工具教程,从入门到入狱,目前更新了几十期视频了。

也开启了程序员赚钱系列。

涛哥每天都在给大家分享干货,欢迎大家关注。

学Python,也学更多黑科技。 查看全部

普通人也能用的三个爬虫工具(图)

我分享了普通人可以在视频帐户中使用的抓取工具。为了方便那些没有关注我的视频帐户的学生,我将对其进行重组并与所有人共享。当然,关注我的视频帐户的学生也可以更轻松地进行检查和比较。

在共享这些爬网工具之前,让我们谈谈为什么我们应该学习爬网工具?

普通人学习爬虫工具的原因有三个:

对于临时使用的工作场所,学习爬虫可以提高效率

程序员的兄弟太忙了,付钱太昂贵了。

学习爬虫技术本身的成本太高

有人说,陶弟兄,我是一名开发人员,我在几分钟之内使用Python抓取了几行代码来取回数据。当然,我想说的是您很棒,但更多的人还没有达到这一点。

退一步说,即使我非常熟练,如果我可以使用工具和现成的模板进行抓取并生成Excle导出,整个过程将只需要几分钟。我认为作为开发人员,这会有点令人兴奋。

掌握爬行器工具可以大大提高我们工作场所的工作效率。成为首席执行官并嫁给白富美指日可待。

我知道我们为什么要学习以及学习的目的。接下来,我将向您介绍我认为很好的三种爬网工具。它们是Jishouke,优采云,优采云 采集器,这对您来说更方便。易于使用和选择。

优采云

优采云让我简要谈谈优势:

提供云采集功能

第三方模板,方便快捷采集

10分钟内捕获数据

个人更贵

需要注册,登录,没有Mac&Linux版本,基本模板是免费的,需要支付更多模板,需要支付高级版本,免费版本只能使用最基本的导出,有限制。

采集客户

采集采购客户的优势

很多网站模板

使用浏览器方法采集直接登录采集

付费版本提供Mac版本

10分钟内捕获数据

为个人用户便宜

客户端是浏览器。我个人认为这是一种趋势。它是采集来获取数据并登录。此外,采集客户的工具相对简单易用,但价格歧视是非常不科学的。 Mac客户端版本只能通过付费使用。您真的认为苹果用户更富有吗?

他们为获取数据而付费的方式是免费的,下载的下载也带有积分。与优采云相比,我认为采集临时使用的客户更为方便。

优采云 采集器

优采云 采集器我认为优点:

浏览器模式采集

采集全过程可视化

免费出口没有积分

完全免费支持Mac&Linux版本

5分钟内开始数据捕获

个人总价

无需登录,无需注册即可获取采集数据,没有积分,几乎可以完全免费使用,缺点是不提供第三方模板网站,对于新手来说有点不便,但是胜利很简单,这也是优势。

摘要

这三个工具都很出色且易于使用,但是从这两个工具的个人使用来看,采集和采集客户更加方便,灵活且便宜。 优采云 采集器其次(胜利很简单,真的很简单),优采云最后。

当然,就个人经验而言,是否支持Mac系统,价格等因素,没有深入研究内部功能。如果有错误,请不要打扰我,只是从普通用户那儿来。

欢迎给我留言以进行讨论或将我添加到微信中进行交流。

为了保证持续而稳定的输出,涛哥开启了视频号100天日更打卡计划,

每天用视频记录自己的所思所考,分享各种黑科技工具系列等等

尤其开启了爬虫系列工具教程,从入门到入狱,目前更新了几十期视频了。

也开启了程序员赚钱系列。

涛哥每天都在给大家分享干货,欢迎大家关注。

学Python,也学更多黑科技。

,如何把这些数据搞到本地,然后定时清空

采集交流 • 优采云 发表了文章 • 0 个评论 • 146 次浏览 • 2021-02-11 12:04

采集有很多防爬虫类网站,有一个非常有用的工具:优采云 ...直接通过浏览器进行访问,并且一举突破。

准备工作:花钱,花钱去优采云官方网站购买一个月或更长时间的会员,这样就可以从事云采集

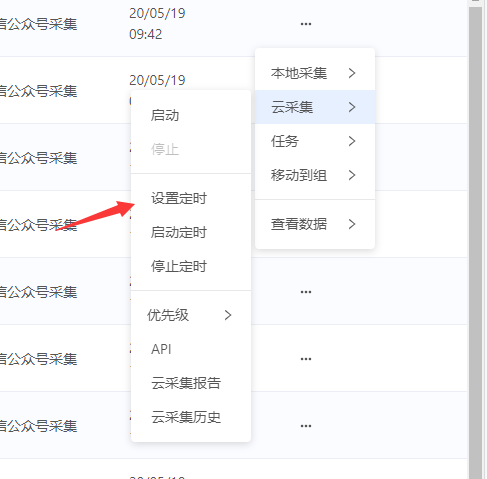

下一步,自己去获取数据,完成获取后,设置定时云采集

然后,您单击云采集来查看数据,将会有很多数据,下面是如何在本地获取这些数据,然后定期对其进行清除

上部代码:

直接通过get_group_list获取您的组ID,然后获取所需的组ID并在下面的get_task_list中运行它以获取所有任务的列表,因此您可以循环任务列表并在其中获取数据。运行完成后,执行api的清除操作,结束了。

class NewsData extends Frontend{

//备注

//八爪鱼接口文档

//https://dataapi.bazhuayu.com/help#_ref_status_code

public function ins_list()

{

$task_list=$this->get_task_list();

if($task_list==false){

echo "任务列表为空";

die();

}

$NewsSource=new NewsSource();

foreach ($task_list as $k=>$v){

$task_id=$v['taskId'];//任务id

//根据任务ID调用任务相关的数据详情

echo "任务{$v['taskName']}:{$task_id}开始: ";

sleep(1);

//循环获取数据

$data=$this->get_task_data($task_id);

$ins=[];

if(empty($data)){

echo "数据为空:跳过! ";

continue;

}

//循环插入数据

foreach ($data as $k2=>$item){

$ins=[

"cate_name"=>"新闻",

"search_name"=>$item['搜索关键词'],

"title"=>$item['最新文章标题'],

"keywords"=>"",

"description"=>"",

"thumb"=>"",

"content"=>'',

"create_time_text"=>$item['时间'],

"status"=>"1",

"oldurl"=>$item['最新文章链接'],

"author"=>$item['公众号名称'],

"author_avatar"=>$item['公总号头像'],

"author_wechat"=>$item['公众号微信号'],

];

if(strlen($item['内容'])gz_str($item['内容']);

//查询是否重复

$has_id=Db::name("news_source")->where(["title"=>$ins['title']])->value("id");

if(intval($has_id)!==0){

echo "重复ID:{$has_id},标题:{$ins['title']}--标题重复,跳过! ";

continue;

}

//插入一条数据

$ins_id=Db::name("news_source")->insertGetId($ins);

echo "成功插入一条id:{$ins_id} ";

unset($ins);

}

unset($data);

//清空任务数据

$this->remove_task_data($task_id);

}

echo "执行结束!";

die();

}

public $url="https://dataapi.bazhuayu.com";

//获取token值

public function get_token(){

$token_name="bazhuayu_token";

$token_data=Cache::get($token_name);

//如果数据为空 或者 数据过期时间"xxxx..",

"grant_type"=>"password",

];

$params=http_build_query($params);

$token_json=$this->sendPost($url,$params);

$token_data=json_decode($token_json,true);

if(!isset($token_data['expires_in'])){

echo $token_json;

return false;

}

$token_data['expires_time']=$token_data['expires_in']+time();

Cache::set($token_name,$token_data,$token_data['expires_in']);

return $token_data;

}

if(!empty($token_data)){

return $token_data;

}else{

return false;

}

}

//获取header 封装token到header中

public function get_header(){

$token_data=$this->get_token();

if($token_data==false){

echo "token错误!";

die();

}else{

$header=[

"Authorization:".$token_data['token_type'].' '.$token_data["access_token"],

];

return $header;

}

}

//获取任务组 列表

public function get_group_list(){

$url="https://dataapi.bazhuayu.com/api/TaskGroup";

$header=$this->get_header();

$list=$this->sendGet($url,$header);

$list=json_decode($list,true);

var_dump($list);

}

//获取任务详情 列表

public function get_task_list(){

$group_id=2206006;//定义任务组id

$url=$this->url."/api/Task?taskGroupId=".$group_id;

$header=$this->get_header();

$list=$this->sendGet($url,$header);

$list=json_decode($list,true);

$list=isset($list['data'])?$list['data']:false;

return $list;

}

//获取任务的数据

public function get_task_data($task_id=null)

{

//$task_id="0385e312-b674-4793-9435-xxxx";

$offset=0;

$size=200;

//$url=$this->url."/api/alldata/GetDataOfTaskByOffset?taskId={$task_id}&offset={$offset}&size={$size}";

$url=$this->url."/api/notexportdata/gettop?taskId={$task_id}&size={$size}";

$header=$this->get_header();

$data=$this->sendGet($url,$header);

$data=json_decode($data,true);

if(isset($data['data']['dataList'])&&!empty($data['data']['dataList'])){

return $data['data']['dataList'];

}else{

return false;

}

}

//清空任务的数据

public function remove_task_data($task_id=null)

{

//$task_id="02be503d-4568-430b-9f15-c3511ad8e98b";

$url=$this->url."/api/task/RemoveDataByTaskId?taskId=".$task_id;

$header=$this->get_header();

$json=$this->sendPOst($url,null,$header);

var_dump($json);

echo "任务ID{$task_id}数据销毁完成!";

}

/**

* 发起请求

* @param string $url 请求地址

* @param string $data 请求数据包

* @return string 请求返回数据

*/

public function sendPost($url,$data,$header=null)

{

$curl = curl_init(); // 启动一个CURL会话

curl_setopt($curl, CURLOPT_URL, $url); // 要访问的地址

curl_setopt($curl, CURLOPT_SSL_VERIFYPEER, 0); // 对认证证书来源的检测

curl_setopt($curl, CURLOPT_SSL_VERIFYHOST, 2); // 从证书中检查SSL加密算法是否存在

if(!empty($header)){

curl_setopt($curl, CURLOPT_HTTPHEADER, $header);

curl_setopt($curl, CURLOPT_HEADER, 0);//返回response头部信息

}

curl_setopt($curl, CURLOPT_FOLLOWLOCATION, 1); // 使用自动跳转

curl_setopt($curl, CURLOPT_AUTOREFERER, 1); // 自动设置Referer

curl_setopt($curl, CURLOPT_POST, 1); // 发送一个常规的Post请求

curl_setopt($curl, CURLOPT_POSTFIELDS, $data); // Post提交的数据包

curl_setopt($curl, CURLOPT_TIMEOUT, 30); // 设置超时限制防止死循

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1); // 获取的信息以文件流的形式返回

$return_data = curl_exec($curl); // 执行操作

if (curl_errno($curl)) {

echo 'Errno'.curl_error($curl);

}

curl_close($curl); // 关键CURL会话

return $return_data; // 返回数据

}

public function sendGet($url,$header=null)

{

$curl = curl_init(); // 启动一个CURL会话

curl_setopt($curl, CURLOPT_URL, $url); // 要访问的地址

curl_setopt($curl, CURLOPT_SSL_VERIFYPEER, 0); // 对认证证书来源的检测

curl_setopt($curl, CURLOPT_SSL_VERIFYHOST, 2); // 从证书中检查SSL加密算法是否存在

curl_setopt($curl, CURLOPT_FOLLOWLOCATION, 1); // 使用自动跳转

curl_setopt($curl, CURLOPT_AUTOREFERER, 1); // 自动设置Referer

if(!empty($header)){

curl_setopt($curl, CURLOPT_HTTPHEADER, $header);

curl_setopt($curl, CURLOPT_HEADER, 0);//返回response头部信息

}

curl_setopt($curl, CURLOPT_TIMEOUT, 20); // 设置超时限制防止死循

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1); // 获取的信息以文件流的形式返回

$return_data = curl_exec($curl); // 执行操作

if (curl_errno($curl)) {

echo 'Errno'.curl_error($curl);

}

curl_close($curl); // 关键CURL会话

return $return_data; // 返回数据

}

} 查看全部

,如何把这些数据搞到本地,然后定时清空

采集有很多防爬虫类网站,有一个非常有用的工具:优采云 ...直接通过浏览器进行访问,并且一举突破。

准备工作:花钱,花钱去优采云官方网站购买一个月或更长时间的会员,这样就可以从事云采集

下一步,自己去获取数据,完成获取后,设置定时云采集

然后,您单击云采集来查看数据,将会有很多数据,下面是如何在本地获取这些数据,然后定期对其进行清除

上部代码:

直接通过get_group_list获取您的组ID,然后获取所需的组ID并在下面的get_task_list中运行它以获取所有任务的列表,因此您可以循环任务列表并在其中获取数据。运行完成后,执行api的清除操作,结束了。

class NewsData extends Frontend{

//备注

//八爪鱼接口文档

//https://dataapi.bazhuayu.com/help#_ref_status_code

public function ins_list()

{

$task_list=$this->get_task_list();

if($task_list==false){

echo "任务列表为空";

die();

}

$NewsSource=new NewsSource();

foreach ($task_list as $k=>$v){

$task_id=$v['taskId'];//任务id

//根据任务ID调用任务相关的数据详情

echo "任务{$v['taskName']}:{$task_id}开始: ";

sleep(1);

//循环获取数据

$data=$this->get_task_data($task_id);

$ins=[];

if(empty($data)){

echo "数据为空:跳过! ";

continue;

}

//循环插入数据

foreach ($data as $k2=>$item){

$ins=[

"cate_name"=>"新闻",

"search_name"=>$item['搜索关键词'],

"title"=>$item['最新文章标题'],

"keywords"=>"",

"description"=>"",

"thumb"=>"",

"content"=>'',

"create_time_text"=>$item['时间'],

"status"=>"1",

"oldurl"=>$item['最新文章链接'],

"author"=>$item['公众号名称'],

"author_avatar"=>$item['公总号头像'],

"author_wechat"=>$item['公众号微信号'],

];

if(strlen($item['内容'])gz_str($item['内容']);

//查询是否重复

$has_id=Db::name("news_source")->where(["title"=>$ins['title']])->value("id");

if(intval($has_id)!==0){

echo "重复ID:{$has_id},标题:{$ins['title']}--标题重复,跳过! ";

continue;

}

//插入一条数据

$ins_id=Db::name("news_source")->insertGetId($ins);

echo "成功插入一条id:{$ins_id} ";

unset($ins);

}

unset($data);

//清空任务数据

$this->remove_task_data($task_id);

}

echo "执行结束!";

die();

}

public $url="https://dataapi.bazhuayu.com";

//获取token值

public function get_token(){

$token_name="bazhuayu_token";

$token_data=Cache::get($token_name);

//如果数据为空 或者 数据过期时间"xxxx..",

"grant_type"=>"password",

];

$params=http_build_query($params);

$token_json=$this->sendPost($url,$params);

$token_data=json_decode($token_json,true);

if(!isset($token_data['expires_in'])){

echo $token_json;

return false;

}

$token_data['expires_time']=$token_data['expires_in']+time();

Cache::set($token_name,$token_data,$token_data['expires_in']);

return $token_data;

}

if(!empty($token_data)){

return $token_data;

}else{

return false;

}

}

//获取header 封装token到header中

public function get_header(){

$token_data=$this->get_token();

if($token_data==false){

echo "token错误!";

die();

}else{

$header=[

"Authorization:".$token_data['token_type'].' '.$token_data["access_token"],

];

return $header;

}

}

//获取任务组 列表

public function get_group_list(){

$url="https://dataapi.bazhuayu.com/api/TaskGroup";

$header=$this->get_header();

$list=$this->sendGet($url,$header);

$list=json_decode($list,true);

var_dump($list);

}

//获取任务详情 列表

public function get_task_list(){

$group_id=2206006;//定义任务组id

$url=$this->url."/api/Task?taskGroupId=".$group_id;

$header=$this->get_header();

$list=$this->sendGet($url,$header);

$list=json_decode($list,true);

$list=isset($list['data'])?$list['data']:false;

return $list;

}

//获取任务的数据

public function get_task_data($task_id=null)

{

//$task_id="0385e312-b674-4793-9435-xxxx";

$offset=0;

$size=200;

//$url=$this->url."/api/alldata/GetDataOfTaskByOffset?taskId={$task_id}&offset={$offset}&size={$size}";

$url=$this->url."/api/notexportdata/gettop?taskId={$task_id}&size={$size}";

$header=$this->get_header();

$data=$this->sendGet($url,$header);

$data=json_decode($data,true);

if(isset($data['data']['dataList'])&&!empty($data['data']['dataList'])){

return $data['data']['dataList'];

}else{

return false;

}

}

//清空任务的数据

public function remove_task_data($task_id=null)

{

//$task_id="02be503d-4568-430b-9f15-c3511ad8e98b";

$url=$this->url."/api/task/RemoveDataByTaskId?taskId=".$task_id;

$header=$this->get_header();

$json=$this->sendPOst($url,null,$header);

var_dump($json);

echo "任务ID{$task_id}数据销毁完成!";

}

/**

* 发起请求

* @param string $url 请求地址

* @param string $data 请求数据包

* @return string 请求返回数据

*/

public function sendPost($url,$data,$header=null)

{

$curl = curl_init(); // 启动一个CURL会话

curl_setopt($curl, CURLOPT_URL, $url); // 要访问的地址

curl_setopt($curl, CURLOPT_SSL_VERIFYPEER, 0); // 对认证证书来源的检测

curl_setopt($curl, CURLOPT_SSL_VERIFYHOST, 2); // 从证书中检查SSL加密算法是否存在

if(!empty($header)){

curl_setopt($curl, CURLOPT_HTTPHEADER, $header);

curl_setopt($curl, CURLOPT_HEADER, 0);//返回response头部信息

}

curl_setopt($curl, CURLOPT_FOLLOWLOCATION, 1); // 使用自动跳转

curl_setopt($curl, CURLOPT_AUTOREFERER, 1); // 自动设置Referer

curl_setopt($curl, CURLOPT_POST, 1); // 发送一个常规的Post请求

curl_setopt($curl, CURLOPT_POSTFIELDS, $data); // Post提交的数据包

curl_setopt($curl, CURLOPT_TIMEOUT, 30); // 设置超时限制防止死循

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1); // 获取的信息以文件流的形式返回

$return_data = curl_exec($curl); // 执行操作

if (curl_errno($curl)) {

echo 'Errno'.curl_error($curl);

}

curl_close($curl); // 关键CURL会话

return $return_data; // 返回数据

}

public function sendGet($url,$header=null)

{

$curl = curl_init(); // 启动一个CURL会话

curl_setopt($curl, CURLOPT_URL, $url); // 要访问的地址

curl_setopt($curl, CURLOPT_SSL_VERIFYPEER, 0); // 对认证证书来源的检测

curl_setopt($curl, CURLOPT_SSL_VERIFYHOST, 2); // 从证书中检查SSL加密算法是否存在

curl_setopt($curl, CURLOPT_FOLLOWLOCATION, 1); // 使用自动跳转

curl_setopt($curl, CURLOPT_AUTOREFERER, 1); // 自动设置Referer

if(!empty($header)){

curl_setopt($curl, CURLOPT_HTTPHEADER, $header);

curl_setopt($curl, CURLOPT_HEADER, 0);//返回response头部信息

}

curl_setopt($curl, CURLOPT_TIMEOUT, 20); // 设置超时限制防止死循

curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1); // 获取的信息以文件流的形式返回

$return_data = curl_exec($curl); // 执行操作

if (curl_errno($curl)) {

echo 'Errno'.curl_error($curl);

}

curl_close($curl); // 关键CURL会话

return $return_data; // 返回数据

}

}

方便操作的采集神器,只要点击一下发现-搜,就能立刻获取这些资源!

采集交流 • 优采云 发表了文章 • 0 个评论 • 311 次浏览 • 2021-02-04 10:01

方便操作的采集神器,只要点击一下发现-搜一搜,就能立刻获取这些资源!详细介绍在这里《1200集!平面设计、字体、网页设计、ae/ai软件教程分享给你》,关注微信公众号:平面设计派,

这些很不错的,

我目前收集了800多个网站收费资源基本上都是需要购买的

我现在收集的资源都是免费的,但是这里有一点就是需要你自己浏览收藏一些的,所以不能保证质量。

喜欢的,可以点下赞哈,

收集了很多站点,已分享,包括国内国外国内可以查看:站长之家国外可以查看:ueo788988,ueo788988.也可以去我的其他文章上面有我常用,

大部分免费网站,看了很多站点的头像,

一个收集全网站点的站长可以给你一个交流资源的群,

虽然我收集了很多,不过有很多东西只有从知乎上才能找到。比如一些所谓的插件推荐网站,因为知乎不支持自动更新,所以这些东西你自己没法用。就像电视剧和小说是没法看出区别的,想当年我都给这些东西付费过。

我自己从初中就开始收集各种各样的网站和各种渠道,目前在家创业一个项目,也在各个网站上找过资源,这些我每天都坚持更新各大网站的资源,网站收集分享在我的个人公众号,有不懂的或想要资源可以留言问我。 查看全部

方便操作的采集神器,只要点击一下发现-搜,就能立刻获取这些资源!

方便操作的采集神器,只要点击一下发现-搜一搜,就能立刻获取这些资源!详细介绍在这里《1200集!平面设计、字体、网页设计、ae/ai软件教程分享给你》,关注微信公众号:平面设计派,

这些很不错的,

我目前收集了800多个网站收费资源基本上都是需要购买的

我现在收集的资源都是免费的,但是这里有一点就是需要你自己浏览收藏一些的,所以不能保证质量。

喜欢的,可以点下赞哈,

收集了很多站点,已分享,包括国内国外国内可以查看:站长之家国外可以查看:ueo788988,ueo788988.也可以去我的其他文章上面有我常用,

大部分免费网站,看了很多站点的头像,

一个收集全网站点的站长可以给你一个交流资源的群,

虽然我收集了很多,不过有很多东西只有从知乎上才能找到。比如一些所谓的插件推荐网站,因为知乎不支持自动更新,所以这些东西你自己没法用。就像电视剧和小说是没法看出区别的,想当年我都给这些东西付费过。

我自己从初中就开始收集各种各样的网站和各种渠道,目前在家创业一个项目,也在各个网站上找过资源,这些我每天都坚持更新各大网站的资源,网站收集分享在我的个人公众号,有不懂的或想要资源可以留言问我。

技巧:分享一款可以采集各大网站图片素材的神器,使用起来非常方便

采集交流 • 优采云 发表了文章 • 0 个评论 • 475 次浏览 • 2020-11-19 08:03

共享一个可以采集个网站各种图片素材的工件,使用起来非常方便

今天的文字

尽管这个国庆节是一个长假,但它恰逢双节。基本上,所有道路上都有各种各样的“交通拥堵”。许多人也放弃了开始出门旅行的想法。毕竟,住在家里比出门舒适得多。

此问题为您带来了可以采集种各种网站图片素材的工件,可以帮助您拾取所有指定的网站图片,使用起来非常方便。

适用于Android系统,有关序列号,请参见文章结尾

01.软件简介

这是一个非常易于使用的手机工具,可以查找图片素材。内置了数十个物质资源站点,一键式操作,非常简单,您可以添加所需的任何内容,甚至可以轻松找到绅士喜欢的图片,并且有不同的类型。

03.软件初体验

首次打开该软件时,该页面为空白。您需要单击右上角的加号。输入后,您可以看到所有资源站点。每个资源站点都有一个清晰的文本标记。选择添加并单击右上角的保存角。

添加的材料资源站点中的材料质量非常高而且非常丰富。

单击图片资源通常收录此材料的主题。输入后,打开图片进行保存。 PS:由于图片中内置了许多“学习”资源,因此C度相对较大,因此不适合在此处显示。您可以自己下载和体验,希望先生们喜欢。

如何获取软件

已附加

个

下一步

加载

文件名:图片工具

作者信息:Internet采集

更新日期:2020.10.02

点击下载 查看全部

共享一个可以使用采集种网站各种图片素材的工件,使用起来非常方便

共享一个可以采集个网站各种图片素材的工件,使用起来非常方便

今天的文字

尽管这个国庆节是一个长假,但它恰逢双节。基本上,所有道路上都有各种各样的“交通拥堵”。许多人也放弃了开始出门旅行的想法。毕竟,住在家里比出门舒适得多。

此问题为您带来了可以采集种各种网站图片素材的工件,可以帮助您拾取所有指定的网站图片,使用起来非常方便。

适用于Android系统,有关序列号,请参见文章结尾

01.软件简介

这是一个非常易于使用的手机工具,可以查找图片素材。内置了数十个物质资源站点,一键式操作,非常简单,您可以添加所需的任何内容,甚至可以轻松找到绅士喜欢的图片,并且有不同的类型。

03.软件初体验

首次打开该软件时,该页面为空白。您需要单击右上角的加号。输入后,您可以看到所有资源站点。每个资源站点都有一个清晰的文本标记。选择添加并单击右上角的保存角。

添加的材料资源站点中的材料质量非常高而且非常丰富。

单击图片资源通常收录此材料的主题。输入后,打开图片进行保存。 PS:由于图片中内置了许多“学习”资源,因此C度相对较大,因此不适合在此处显示。您可以自己下载和体验,希望先生们喜欢。

如何获取软件

已附加

个

下一步

加载

文件名:图片工具

作者信息:Internet采集

更新日期:2020.10.02

点击下载

测评:十大采集软件排行 好用的数据采集软件推荐 信息采集软件有哪些

采集交流 • 优采云 发表了文章 • 0 个评论 • 2334 次浏览 • 2020-09-30 13:08

1、优采云采集器

优采云是一个数据服务平台,可连续5次连续集成网页数据采集,移动Internet数据和API接口服务(包括数据爬网,数据优化,数据挖掘,数据存储,数据备份)和其他服务在互联网数据采集软件列表中再次当选第一名。自2016年以来,优采云一直积极开拓海外市场,并分别在美国和日本推出了数据爬网平台Octoparse和Octoparse.jp。截至2019年,优采云全球用户已超过150万。其主要功能之一:零阈值使用,无需了解网络爬虫技术,就可以轻松完成采集。

2、优采云采集器

国内老牌数据采集软件以其灵活的配置和强大的性能,领先于国内同类产品,并赢得了许多用户的一致认可。使用优采云采集器几乎可以以任何格式采集所有网页和文件,无论使用哪种语言或编码。 采集比普通采集器快7倍,采集 /帖子的准确性与复制/粘贴的准确性一样。同时,该软件还具有“民意雷达监控系统”,可以准确地监控网络数据的信息安全性,并及时处理不良或危险信息。

3、优采云采集器

如果我要求Buying.com的编辑推荐最佳信息采集软件,则该软件必须为优采云采集器。 优采云采集器由前Google技术团队基于人工智能技术创建,支持智能模式和流程图模式采集;使用简单,只需输入URL即可智能识别列表数据,表数据和分页按钮,无需配置任何采集规则,只需单击采集;该软件支持Linux,Windows和Mac这三种主要操作系统,并且无需花费金钱即可导出数据。它还支持Excel,CSV,TXT,HTML和与其他类似软件相比的多种导出格式,仅此一项就足够了。

4、采集客户

已经打磨了十多年的GooSeeker已经成为具有出色易用性的data 采集软件。其特点是各种采集数据都在视觉上进行了注释。用户无需考虑程序或技术基础,只需单击所需的内容,给标签起一个名字,然后软件即可自动管理所选内容。自动采集到整理框,另存为xml或excel结构。此外,该软件还具有模板资源应用程序,成员互助获取,手机网站数据获取以及定时自启动采集等功能。

5、优采云采集器

这是一套专业的网站内容采集软件,该软件支持各种论坛帖子和回复采集,网站和博客文章内容捕获,通过相关配置,可以轻松采集 80% 网站的内容供您自己使用。根据各种网站建设计划之间的差异,优采云采集器子论坛采集器,cms采集器和博客采集器三种类型,共有数百个版本的数据支持近40种主流网站建设程序采集和发布任务,支持图像本地化,支持网站登录采集,页面抓取,手动登录发布的全面模拟。此外,该软件还具有内置的SEO伪原创模块,使您的采集功能更强大。

6、Import.io

由英国伦敦的一家公司开发,是英国市场上最著名的采集器之一,目前已在美国,印度和其他地方建立了分支机构。作为网页数据采集软件,import.io具有四个主要功能,即Magic,Extractor,Crawler,Connector。主要功能均可用,但最引人注目和最佳功能是“魔术”。 ,此功能使用户仅在进入网页后即可自动提取数据,而无需进行任何其他设置,并且非常易于使用。

7、ParseHub

ForeSpider还是易于操作且强烈推荐的信息采集软件。它分为免费版和付费版。它具有可视化的向导式操作界面,日志管理和异常情况警告,免费安装数据库,可以自动识别语义筛选数据,智能地挖掘文本特征数据,并具有各种数据清除方法和可视化图表分析功能。该软件的免费版,基本版和专业版采集的速度可以达到每天400万件,服务器版本采集的速度可以达到8000万件/天,并且还提供代理采集服务。

8、优采云

优采云是最常用的信息采集软件之一,它封装了复杂的算法和分布式逻辑,可以提供灵活而简单的开发接口;应用程序的自动分布式部署和运行,直观简单的操作,灵活扩展计算和存储资源;对来自不同来源的数据进行统一的可视化管理,并提供高级功能,如宁静的界面/ webhook push / graphql访问,可让用户与现有系统无缝连接。该软件现在提供企业标准版,高级版和企业定制版。

9、ForeSpider

ParseHub是基于Web的爬网客户端工具,它支持JavaScript渲染,Ajax爬网,Cookie,会话和其他机制,以分析并从网站中获取数据。它还可以使用机器学习技术来识别复杂的文档并以JSON,CSV和其他格式导出文件。该软件支持在Windows,Mac和Linux上使用,或作为Firefox扩展使用。此外,它还具有一些高级功能,例如分页,弹出窗口和导航,无限滚动页面等,可以将ParseHub中的数据可视化为Tableau。

10、Content Grabber

Content Grabber是一种视觉网络数据采集软件,它支持智能捕获和一个网络自动化工具,该工具可以从几乎所有网站中提取内容。它的程序操作环境可以在开发,测试和生产服务器上使用。您可以使用c#或VB.NET调试或编写脚本来控制采集器。它还支持将第三方扩展插件添加到采集器工具。凭借全面的功能,Content Grabber对于具有技术基础的用户而言极为强大。 查看全部

采集十大软件排名,有用的数据采集软件推荐,信息采集什么是软件?

1、优采云采集器

优采云是一个数据服务平台,可连续5次连续集成网页数据采集,移动Internet数据和API接口服务(包括数据爬网,数据优化,数据挖掘,数据存储,数据备份)和其他服务在互联网数据采集软件列表中再次当选第一名。自2016年以来,优采云一直积极开拓海外市场,并分别在美国和日本推出了数据爬网平台Octoparse和Octoparse.jp。截至2019年,优采云全球用户已超过150万。其主要功能之一:零阈值使用,无需了解网络爬虫技术,就可以轻松完成采集。

2、优采云采集器

国内老牌数据采集软件以其灵活的配置和强大的性能,领先于国内同类产品,并赢得了许多用户的一致认可。使用优采云采集器几乎可以以任何格式采集所有网页和文件,无论使用哪种语言或编码。 采集比普通采集器快7倍,采集 /帖子的准确性与复制/粘贴的准确性一样。同时,该软件还具有“民意雷达监控系统”,可以准确地监控网络数据的信息安全性,并及时处理不良或危险信息。

3、优采云采集器

如果我要求Buying.com的编辑推荐最佳信息采集软件,则该软件必须为优采云采集器。 优采云采集器由前Google技术团队基于人工智能技术创建,支持智能模式和流程图模式采集;使用简单,只需输入URL即可智能识别列表数据,表数据和分页按钮,无需配置任何采集规则,只需单击采集;该软件支持Linux,Windows和Mac这三种主要操作系统,并且无需花费金钱即可导出数据。它还支持Excel,CSV,TXT,HTML和与其他类似软件相比的多种导出格式,仅此一项就足够了。

4、采集客户

已经打磨了十多年的GooSeeker已经成为具有出色易用性的data 采集软件。其特点是各种采集数据都在视觉上进行了注释。用户无需考虑程序或技术基础,只需单击所需的内容,给标签起一个名字,然后软件即可自动管理所选内容。自动采集到整理框,另存为xml或excel结构。此外,该软件还具有模板资源应用程序,成员互助获取,手机网站数据获取以及定时自启动采集等功能。

5、优采云采集器

这是一套专业的网站内容采集软件,该软件支持各种论坛帖子和回复采集,网站和博客文章内容捕获,通过相关配置,可以轻松采集 80% 网站的内容供您自己使用。根据各种网站建设计划之间的差异,优采云采集器子论坛采集器,cms采集器和博客采集器三种类型,共有数百个版本的数据支持近40种主流网站建设程序采集和发布任务,支持图像本地化,支持网站登录采集,页面抓取,手动登录发布的全面模拟。此外,该软件还具有内置的SEO伪原创模块,使您的采集功能更强大。

6、Import.io

由英国伦敦的一家公司开发,是英国市场上最著名的采集器之一,目前已在美国,印度和其他地方建立了分支机构。作为网页数据采集软件,import.io具有四个主要功能,即Magic,Extractor,Crawler,Connector。主要功能均可用,但最引人注目和最佳功能是“魔术”。 ,此功能使用户仅在进入网页后即可自动提取数据,而无需进行任何其他设置,并且非常易于使用。

7、ParseHub

ForeSpider还是易于操作且强烈推荐的信息采集软件。它分为免费版和付费版。它具有可视化的向导式操作界面,日志管理和异常情况警告,免费安装数据库,可以自动识别语义筛选数据,智能地挖掘文本特征数据,并具有各种数据清除方法和可视化图表分析功能。该软件的免费版,基本版和专业版采集的速度可以达到每天400万件,服务器版本采集的速度可以达到8000万件/天,并且还提供代理采集服务。

8、优采云

优采云是最常用的信息采集软件之一,它封装了复杂的算法和分布式逻辑,可以提供灵活而简单的开发接口;应用程序的自动分布式部署和运行,直观简单的操作,灵活扩展计算和存储资源;对来自不同来源的数据进行统一的可视化管理,并提供高级功能,如宁静的界面/ webhook push / graphql访问,可让用户与现有系统无缝连接。该软件现在提供企业标准版,高级版和企业定制版。

9、ForeSpider

ParseHub是基于Web的爬网客户端工具,它支持JavaScript渲染,Ajax爬网,Cookie,会话和其他机制,以分析并从网站中获取数据。它还可以使用机器学习技术来识别复杂的文档并以JSON,CSV和其他格式导出文件。该软件支持在Windows,Mac和Linux上使用,或作为Firefox扩展使用。此外,它还具有一些高级功能,例如分页,弹出窗口和导航,无限滚动页面等,可以将ParseHub中的数据可视化为Tableau。

10、Content Grabber

Content Grabber是一种视觉网络数据采集软件,它支持智能捕获和一个网络自动化工具,该工具可以从几乎所有网站中提取内容。它的程序操作环境可以在开发,测试和生产服务器上使用。您可以使用c#或VB.NET调试或编写脚本来控制采集器。它还支持将第三方扩展插件添加到采集器工具。凭借全面的功能,Content Grabber对于具有技术基础的用户而言极为强大。

操作方法:Python selenium模拟浏览器操作实战(武汉大学)

采集交流 • 优采云 发表了文章 • 0 个评论 • 276 次浏览 • 2020-08-31 16:59

Python硒模拟浏览器操作实战(武汉大学)

1. 项目介绍

因为信息门户网站使用请求发送帖子请求来模拟登录操作很麻烦(我太低,并且信息门户网站的加密算法不了解),所以无法通过它来完成此操作其他方式.

使用硒是一种更好的解决方案(虽然速度很慢,但至少可以使用),模拟浏览器输入帐户密码,然后单击“登录”以登录,然后获取相关的cookie和其他信息以获取随后的结果,等等.

2. 参考代码

#!/usr/bin/env python

# -*- coding:utf-8 -*-

# Author : Gary

import time

from selenium import webdriver

chrome_options = webdriver.ChromeOptions()

# options.add_experimental_option('excludeSwitches', ['enable-automation'])#提示浏览器不是selenium

chrome_options.add_argument('--headless') # 无头

chrome_options.add_argument('--disable-gpu')

chrome_options.add_argument('--no-sandbox') # 这个配置很重要

chrome_options.add_experimental_option('excludeSwitches',

['enable-automation']) # 此步骤很重要,设置为开发者模式,防止被各大网站识别出来使用了Selenium

class Selenium:

def __init__(self):

# self.driver = webdriver.Chrome(options=chrome_options) # 有配置的初始化浏览器

self.driver = webdriver.Chrome() # 不使用有配置的,方便看操作

self.driver.maximize_window() # 窗口最大化

def login(self, username, password):

self.driver.get('http://ehall.whu.edu.cn/appShow?appId=5382714380693158') # 走信息门户认证的教务系统url,不用输入验证码

# 找到输入框并输入账号密码

Username = self.driver.find_element_by_id("username")

Username.send_keys(username)

Password = self.driver.find_element_by_id("password")

Password.send_keys(password)

time.sleep(0.2)

self.driver.find_element_by_xpath('//*[@id="casLoginForm"]/p[5]/button').click() # 登录按钮

try:

# name=self.driver.find_element_by_id("ampHeaderToolUserName").text#获取姓名,内容为空,弃用

name = self.driver.find_element_by_id("nameLable").text # 获取学生姓名

acade = self.driver.find_element_by_id("acade").text # 获取学生院系

# cookies = self.driver.get_cookies()[0]

# print('登录成功 ...')

# self.driver.quit()

# html = self.driver.execute_script("return document.documentElement.outerHTML")

html = self.driver.find_element_by_xpath('//*[@id="system"]').get_attribute('onclick')

# 不要用 driver.page_source,那样得到的页面源码不标准

# print(html)

csrftoken = html.split(",")[0].split('csrftoken=')[-1]

print('登录成功!')

return True, acade, name, self.driver.get_cookies(), csrftoken

except Exception as e:

print(str(e))

try:

msg = self.driver.find_element_by_id("msg").text

except Exception as e:

# time.sleep(5)

# cpatchaError=self.driver.find_element_by_id("cpatchaError").text

print(str(e))

msg = '您尝试的次数过多,请明天再试!或解决方案:通过浏览器成功登录一次信息门户。再重试认证本系统'

# self.driver.quit()

return False, msg

if __name__ == '__main__':

username = 'test' # 你的信息门户账号

password = 'test' # 你的信息门户账号对应的密码

spider = Selenium()

print(spider.login(username=username, password=password)) # 查看登录结果

3. 待办事项或应用程序

成功登录后获得的cookie可以获取您自己的得分信息(GPA的计算)等.

这很简单,您想学习吗?然后加入小组:

1136192749

发布于2020-08-31 13:45最喜欢的爬虫阅读(0)评论(0)编辑 查看全部

Python硒模拟浏览器操作实战(武汉大学)

Python硒模拟浏览器操作实战(武汉大学)

1. 项目介绍

因为信息门户网站使用请求发送帖子请求来模拟登录操作很麻烦(我太低,并且信息门户网站的加密算法不了解),所以无法通过它来完成此操作其他方式.

使用硒是一种更好的解决方案(虽然速度很慢,但至少可以使用),模拟浏览器输入帐户密码,然后单击“登录”以登录,然后获取相关的cookie和其他信息以获取随后的结果,等等.

2. 参考代码

#!/usr/bin/env python

# -*- coding:utf-8 -*-

# Author : Gary

import time

from selenium import webdriver

chrome_options = webdriver.ChromeOptions()

# options.add_experimental_option('excludeSwitches', ['enable-automation'])#提示浏览器不是selenium

chrome_options.add_argument('--headless') # 无头

chrome_options.add_argument('--disable-gpu')

chrome_options.add_argument('--no-sandbox') # 这个配置很重要

chrome_options.add_experimental_option('excludeSwitches',

['enable-automation']) # 此步骤很重要,设置为开发者模式,防止被各大网站识别出来使用了Selenium

class Selenium:

def __init__(self):

# self.driver = webdriver.Chrome(options=chrome_options) # 有配置的初始化浏览器

self.driver = webdriver.Chrome() # 不使用有配置的,方便看操作

self.driver.maximize_window() # 窗口最大化

def login(self, username, password):

self.driver.get('http://ehall.whu.edu.cn/appShow?appId=5382714380693158') # 走信息门户认证的教务系统url,不用输入验证码

# 找到输入框并输入账号密码

Username = self.driver.find_element_by_id("username")

Username.send_keys(username)

Password = self.driver.find_element_by_id("password")

Password.send_keys(password)

time.sleep(0.2)

self.driver.find_element_by_xpath('//*[@id="casLoginForm"]/p[5]/button').click() # 登录按钮

try:

# name=self.driver.find_element_by_id("ampHeaderToolUserName").text#获取姓名,内容为空,弃用

name = self.driver.find_element_by_id("nameLable").text # 获取学生姓名

acade = self.driver.find_element_by_id("acade").text # 获取学生院系

# cookies = self.driver.get_cookies()[0]

# print('登录成功 ...')

# self.driver.quit()

# html = self.driver.execute_script("return document.documentElement.outerHTML")

html = self.driver.find_element_by_xpath('//*[@id="system"]').get_attribute('onclick')

# 不要用 driver.page_source,那样得到的页面源码不标准

# print(html)

csrftoken = html.split(",")[0].split('csrftoken=')[-1]

print('登录成功!')

return True, acade, name, self.driver.get_cookies(), csrftoken

except Exception as e:

print(str(e))

try:

msg = self.driver.find_element_by_id("msg").text

except Exception as e:

# time.sleep(5)

# cpatchaError=self.driver.find_element_by_id("cpatchaError").text

print(str(e))

msg = '您尝试的次数过多,请明天再试!或解决方案:通过浏览器成功登录一次信息门户。再重试认证本系统'

# self.driver.quit()

return False, msg

if __name__ == '__main__':

username = 'test' # 你的信息门户账号

password = 'test' # 你的信息门户账号对应的密码

spider = Selenium()

print(spider.login(username=username, password=password)) # 查看登录结果

3. 待办事项或应用程序

成功登录后获得的cookie可以获取您自己的得分信息(GPA的计算)等.

这很简单,您想学习吗?然后加入小组:

1136192749

发布于2020-08-31 13:45最喜欢的爬虫阅读(0)评论(0)编辑

vg浏览器无限时间破解版(网页操作利器)

采集交流 • 优采云 发表了文章 • 0 个评论 • 453 次浏览 • 2020-08-29 06:13

vg浏览器无限时间破解版是非常好用的一款网路手动可视化浏览器,在这里用户可以使用软件在线手动辨识验证码,还可以通过软件随时进行可视化手动操作功能,并且通过软件使用脚本愈加便捷迅速!

破解版说明

软件破解了时间限制可以无限使用!

关于vg浏览器无限时间版

网页自动化操作、数据库自动化操作、本地文件手动操作、邮件手动收发!

VG网页操作利器(原VG浏览器)是一款应用广泛的自动化操作工具,拥有逾百个免费的自动化脚本功能模块,各种脚本功能可以象堆积木似的可视化组合,结合其中的逻辑控制和判定模块,可以快速创建功能强悍的自动化操作脚本。脚本使用简单灵活,不用任何编程基础,即可轻松快速的写出功能强悍又独一无二的腿原本辅助我们的工作,甚至还可以生成独立的EXE程序进行销售。

vg浏览器破解版功能

本地文件手动操作

自动读写自定义文件、自动增删文件夹、遍历目录文件等操作。

网页自动化操作

自动登入、自动采集、自动递交、自动注册、 自动回帖、自动辨识验证码。

数据库自动化操作

支持多种数据库的增删查改等操作,通过灵活的脚本操作本地或远程数据库。

邮件手动收发

自动接收和读取指定电邮,解决手动注册时出现的电邮验证问题,并有手动发送短信模块,轻松实现电邮通知、邮件群发疗效。

常见问题

1、VG浏览器是免费使用的吗

VG浏览器的脚本编辑器是免费使用的,可以使用所有的脚本模块可视化制做脚本,可以直接运行单个脚本,还可以单步测试脚本。

2、使用项目管理器须要付费吗?

VG浏览器的项目管理器不是免费的,必须要订购注册码注册后方可使用,项目管理器可以独立运行脚本,并且可以多线程、多任务同时运行,每个任务都可以按设定时间定时运行。

适用场景

1、社会关系营销解决方案

适用人群:站长、名人、企业等

虚拟案例:某名星拥有多个微博,新浪微博、腾讯微博、网易微博、Twitter等等,微博太多他又太忙,一次只能发一个微博,粉丝不能及时了解他的消息意见很大,通过VG浏览器项目管理器订制一键发布微博到各大微博,没几天他的人气又爆增了。

2、文章投稿解决方案

适用人群:站长、网站编辑、媒介人士、企业等

虚拟案例:站长张某某每晚都坚持写软文投放到个大站长平台,包括:站长网(admin5)、站长站(chianz)、站长资讯(chinahtml)等等,写好软文后还须要一次次登陆各大平台,机械式的复制粘贴信息。使用了VG浏览器后,所有那些复杂的发布操作,通过VG项目管理器定时的手动投稿到各大站长平台,大幅度提升了工作效率!

3、站群解决方案

适用人群:站长、SEO人员、门户网站、企业等

虚拟案例:王某某是一位拥有20多个网站的站长,每天都要采集大量的信息,然后分别发布到个个网站,虽然他也有使用到一些采集软件,但采集的目标站时常更换,要常常写大量的采集规则,非常冗长,而且没有一定的专业技能很难完成工作。使用了VG浏览器后,采集、发布显得十分简单,点点键盘就可以提取到网站信息,几分钟就可以构建一个采集发布脚本,而且完全可视化操作,会上网都会制做脚本!王某某十分欣慰的告诉我们,有了VG浏览器后他的目标是同时经营1000个网站。

更新日志

修复双击vgproj项目文件启动时难以生成脚本和运行器问题

执行sql句子出错时不中止脚本流程 查看全部

vg浏览器无限时间破解版(网页操作利器)

vg浏览器无限时间破解版是非常好用的一款网路手动可视化浏览器,在这里用户可以使用软件在线手动辨识验证码,还可以通过软件随时进行可视化手动操作功能,并且通过软件使用脚本愈加便捷迅速!

破解版说明

软件破解了时间限制可以无限使用!

关于vg浏览器无限时间版

网页自动化操作、数据库自动化操作、本地文件手动操作、邮件手动收发!

VG网页操作利器(原VG浏览器)是一款应用广泛的自动化操作工具,拥有逾百个免费的自动化脚本功能模块,各种脚本功能可以象堆积木似的可视化组合,结合其中的逻辑控制和判定模块,可以快速创建功能强悍的自动化操作脚本。脚本使用简单灵活,不用任何编程基础,即可轻松快速的写出功能强悍又独一无二的腿原本辅助我们的工作,甚至还可以生成独立的EXE程序进行销售。

vg浏览器破解版功能

本地文件手动操作

自动读写自定义文件、自动增删文件夹、遍历目录文件等操作。

网页自动化操作

自动登入、自动采集、自动递交、自动注册、 自动回帖、自动辨识验证码。

数据库自动化操作

支持多种数据库的增删查改等操作,通过灵活的脚本操作本地或远程数据库。

邮件手动收发

自动接收和读取指定电邮,解决手动注册时出现的电邮验证问题,并有手动发送短信模块,轻松实现电邮通知、邮件群发疗效。

常见问题

1、VG浏览器是免费使用的吗

VG浏览器的脚本编辑器是免费使用的,可以使用所有的脚本模块可视化制做脚本,可以直接运行单个脚本,还可以单步测试脚本。

2、使用项目管理器须要付费吗?

VG浏览器的项目管理器不是免费的,必须要订购注册码注册后方可使用,项目管理器可以独立运行脚本,并且可以多线程、多任务同时运行,每个任务都可以按设定时间定时运行。

适用场景

1、社会关系营销解决方案

适用人群:站长、名人、企业等

虚拟案例:某名星拥有多个微博,新浪微博、腾讯微博、网易微博、Twitter等等,微博太多他又太忙,一次只能发一个微博,粉丝不能及时了解他的消息意见很大,通过VG浏览器项目管理器订制一键发布微博到各大微博,没几天他的人气又爆增了。

2、文章投稿解决方案

适用人群:站长、网站编辑、媒介人士、企业等

虚拟案例:站长张某某每晚都坚持写软文投放到个大站长平台,包括:站长网(admin5)、站长站(chianz)、站长资讯(chinahtml)等等,写好软文后还须要一次次登陆各大平台,机械式的复制粘贴信息。使用了VG浏览器后,所有那些复杂的发布操作,通过VG项目管理器定时的手动投稿到各大站长平台,大幅度提升了工作效率!

3、站群解决方案

适用人群:站长、SEO人员、门户网站、企业等

虚拟案例:王某某是一位拥有20多个网站的站长,每天都要采集大量的信息,然后分别发布到个个网站,虽然他也有使用到一些采集软件,但采集的目标站时常更换,要常常写大量的采集规则,非常冗长,而且没有一定的专业技能很难完成工作。使用了VG浏览器后,采集、发布显得十分简单,点点键盘就可以提取到网站信息,几分钟就可以构建一个采集发布脚本,而且完全可视化操作,会上网都会制做脚本!王某某十分欣慰的告诉我们,有了VG浏览器后他的目标是同时经营1000个网站。

更新日志

修复双击vgproj项目文件启动时难以生成脚本和运行器问题

执行sql句子出错时不中止脚本流程

这些软件号称「职场利器」,90%的职场人并不晓得!

采集交流 • 优采云 发表了文章 • 0 个评论 • 209 次浏览 • 2020-08-29 02:14

一、BenVista PhotoZoom Pro

通常的工具对数码图片进行放大时,总会增加图片的品质,而BenVista PhotoZoom Pro使用了S-SPLINE技术(一种申请过专利的,拥有手动调节、进阶的配准算法的技术),可以将尽可能地增强放大图片的品质。程序最大的特色是可以对图片进行放大而没有锯齿,不会失真。

二、PPTminimizer

PPT文件压缩工具,一个强悍的浮力软件,能将一百多兆的东西压缩成一二十兆.压缩比最高达96%操作简单.

三、百度图说

百度图说是基于百度开源图表插件ECharts的一个傻瓜式图表工具。说人话,就是就算你没有代码基础,也能几分钟内作出一份屌炸的动态可交互图表,而且是H5格式!

四、MAKA

不会技术也不懂设计,没关系,你可以打开MAKA编辑器,对选取模板中的图文进行替换或更改,点击-输入-点击-选择,对,就是这么简单,你甚至还未扫兴,一个H5微场景便完成了。

五、199IT大数据工具导航

与其说这是一个利器,倒不如说这是一个数据采集的利器合辑。

六、维棠 - 全新的视频体验:

秒杀各种视频网站的下载器(去找第三方做的绿色版吧……官方广告太多了)。新版界面总算甩掉上世纪风格了,蛮便捷的。

七、PDF Shaper - Merge, Split, Convert PDF and Extract Data:功能齐全的PDF工具箱,包括合并、分割、转换格式、导出数据、添加水印等,可以批量操作。

八、Ad Muncher: Free ad blocking for all browsers:大母牛,富有盛名的广告拦截软件。历史悠久,口碑极好。现已成为免费软件。

九、SageThumbs 2.0.0.22 [CherubicSoft]:资源管理器插件,可对图片进行多种右键操作,包括预览,裁剪,转换格式,设为墙纸等。可以大幅度提高操作效率的小工具。

十、Universal Extractor:强大的资源提取工具。除了解压常规的压缩文件,还可以从可执行文件(exe)、微软安装包(msi)、2007版Office文档(docx、xlsx、pptx)等许多其他类型的文件中提取资源。 查看全部

这些软件号称「职场利器」,90%的职场人并不晓得!

一、BenVista PhotoZoom Pro

通常的工具对数码图片进行放大时,总会增加图片的品质,而BenVista PhotoZoom Pro使用了S-SPLINE技术(一种申请过专利的,拥有手动调节、进阶的配准算法的技术),可以将尽可能地增强放大图片的品质。程序最大的特色是可以对图片进行放大而没有锯齿,不会失真。

二、PPTminimizer

PPT文件压缩工具,一个强悍的浮力软件,能将一百多兆的东西压缩成一二十兆.压缩比最高达96%操作简单.

三、百度图说

百度图说是基于百度开源图表插件ECharts的一个傻瓜式图表工具。说人话,就是就算你没有代码基础,也能几分钟内作出一份屌炸的动态可交互图表,而且是H5格式!

四、MAKA

不会技术也不懂设计,没关系,你可以打开MAKA编辑器,对选取模板中的图文进行替换或更改,点击-输入-点击-选择,对,就是这么简单,你甚至还未扫兴,一个H5微场景便完成了。

五、199IT大数据工具导航

与其说这是一个利器,倒不如说这是一个数据采集的利器合辑。

六、维棠 - 全新的视频体验:

秒杀各种视频网站的下载器(去找第三方做的绿色版吧……官方广告太多了)。新版界面总算甩掉上世纪风格了,蛮便捷的。

七、PDF Shaper - Merge, Split, Convert PDF and Extract Data:功能齐全的PDF工具箱,包括合并、分割、转换格式、导出数据、添加水印等,可以批量操作。

八、Ad Muncher: Free ad blocking for all browsers:大母牛,富有盛名的广告拦截软件。历史悠久,口碑极好。现已成为免费软件。

九、SageThumbs 2.0.0.22 [CherubicSoft]:资源管理器插件,可对图片进行多种右键操作,包括预览,裁剪,转换格式,设为墙纸等。可以大幅度提高操作效率的小工具。

十、Universal Extractor:强大的资源提取工具。除了解压常规的压缩文件,还可以从可执行文件(exe)、微软安装包(msi)、2007版Office文档(docx、xlsx、pptx)等许多其他类型的文件中提取资源。

邮箱采集群发软件

采集交流 • 优采云 发表了文章 • 0 个评论 • 503 次浏览 • 2020-08-27 17:10

全网邮箱采集器(支持百度、谷歌、搜狗、360) - 优采云邮箱采集群发软件专用采集器(100线程版)

又名外贸邮箱采集器或则搜索引擎邮箱采集器

本邮箱采集群发软件采集网页,论坛。博客,公司,企业,政府,个人都可以使用,抓取手机号码或则邮箱必备利器!

操作便捷无需人工干预,自动模拟蜘蛛采集邮箱,抓去挺仔细,可以采集外贸电邮,国外电邮采集可以使用微软,很方便,采集速度很快!

多个关键词批量采集或者单独采集指定网站的数据,采集数据量大,工作稳定,适合所有做电邮营销的同学使用!

优采云邮箱采集群发软件一款专业的电子邮件地址搜索和提取软件,专门从互联网上采集电子邮箱地址。它具有强悍的搜索和提取能力,支持网站、论坛和关键字搜索,你只要输入一个网址或一个关键字,系统将立刻手动搜索并提取电子邮件地址,操作十分简单。

主要特征:

1、傻瓜式操作方法,无需专业知识。输入一个网址或一个关键字,点开始按键就可以搜集;

2、可以快速指定只搜索某一个网站或峰会,而不去访问其它网站的网页;

3、采用先进多线程技术,用户可自由设置线程数目,只要你的网速和笔记本够快,设5000线程都没问题;

4、虚拟下载技术,不会在你的笔记本上下载网站内容;

5、采集过程中可以定时手动换IP,防止IP被锁定未能该网站;

6、可以指定每位服务器的最大连接数,系统手动均衡联接网址分配,防止IP被封;

7、采集状态手动保存,你也可以随时中断搜集并保存工作状态,下次可以打开工作,从停止点开始继续这个工作; 查看全部

邮箱采集群发软件

全网邮箱采集器(支持百度、谷歌、搜狗、360) - 优采云邮箱采集群发软件专用采集器(100线程版)

又名外贸邮箱采集器或则搜索引擎邮箱采集器

本邮箱采集群发软件采集网页,论坛。博客,公司,企业,政府,个人都可以使用,抓取手机号码或则邮箱必备利器!

操作便捷无需人工干预,自动模拟蜘蛛采集邮箱,抓去挺仔细,可以采集外贸电邮,国外电邮采集可以使用微软,很方便,采集速度很快!

多个关键词批量采集或者单独采集指定网站的数据,采集数据量大,工作稳定,适合所有做电邮营销的同学使用!

优采云邮箱采集群发软件一款专业的电子邮件地址搜索和提取软件,专门从互联网上采集电子邮箱地址。它具有强悍的搜索和提取能力,支持网站、论坛和关键字搜索,你只要输入一个网址或一个关键字,系统将立刻手动搜索并提取电子邮件地址,操作十分简单。

主要特征:

1、傻瓜式操作方法,无需专业知识。输入一个网址或一个关键字,点开始按键就可以搜集;

2、可以快速指定只搜索某一个网站或峰会,而不去访问其它网站的网页;

3、采用先进多线程技术,用户可自由设置线程数目,只要你的网速和笔记本够快,设5000线程都没问题;

4、虚拟下载技术,不会在你的笔记本上下载网站内容;

5、采集过程中可以定时手动换IP,防止IP被锁定未能该网站;

6、可以指定每位服务器的最大连接数,系统手动均衡联接网址分配,防止IP被封;

7、采集状态手动保存,你也可以随时中断搜集并保存工作状态,下次可以打开工作,从停止点开始继续这个工作;

拼多多上货利器批量采集 拼多多上货助理

采集交流 • 优采云 发表了文章 • 0 个评论 • 531 次浏览 • 2020-08-26 09:11

在随着电商的出现,改变了消费者的购物形式,随着而出的拼多多则以一种与电商不同的模式出现在人们的面前,很多店家也被这个平台吸引住,入驻拼多多平台。现在小编给你们讲一下拼多多后台删掉商品和拼多多上货利器删掉商品的步骤怎么操作。

打开拼多多上货利器,然后在里面注册一个帐号,账号注册完以后,我们找米淘科技客服开通一下软件使用权限

“操作步骤”请你们认真阅读

1、如何使用拼多多上货利器批量采集其他平台的宝贝

①、首先我们打开米淘科技拼多多上货利器,进入软件,点击商品采集,然后到其他平台里面找到我们要抓取的宝贝地址,当然你们也可以采集拼多多同行的链接(拼多多全店采集)如果批量采集的链接比较多可以提早放在文本文档做记录,等要采集的时间导出文本就可以了(导入格式)

②、链接打算好以后,我们把链接文本或当个链接导出到软件采集窗口,然后去设置一下商品的基础信息,列如(类目,运费模板,商品团价钱,团购人数,市场价格等)设置完我们勾选智能处理图片,然后点击开始采集!!!

③、采集结束后,软件会提示之后我们可以关掉这个窗口返回软件主界面!!!

2、如何更改商品基础信息(详情信息)

①、修改商品主要我们要先看标题/描述是否符合自己的标准,列如:采集的原商品有在做促销,或者买多少送多少,这个假如我们不想这样做的话,我们可以使用批量更改标题描述以及其他批量更改功能去操作,当然也可以自动去更改!

②、批量更改可以更改(标题/描述/类目/运费模板/团购单买市场价格/商品属性等····)图片可以修改为自己的,不用更改规格,软件会手动更改

3、商品信息更改完了怎样发布

①、我们要先检测一下是不是全部的商品信息都更改完成了,如果没有更改过来的要先更改过来,不要仓促直接上传了,检查一下标题描述,主图logo跟其他信息

②、如果没有其他问题的话,我们勾选这个宝贝,点击上传商品(勾选只能处理图片)选择保存发布或直接递交两个选项,然后点击开始上传就可以了!!!!!

最后谢谢诸位老总才能在百忙之中抽出时间来看完我们的教程,希望这篇文章能够给你们带来帮助,同时也希望我们能否达成友好共识,最后祝诸位老总上完货大卖!!!!!

【推窗】 查看全部

拼多多上货利器批量采集 拼多多上货助理

在随着电商的出现,改变了消费者的购物形式,随着而出的拼多多则以一种与电商不同的模式出现在人们的面前,很多店家也被这个平台吸引住,入驻拼多多平台。现在小编给你们讲一下拼多多后台删掉商品和拼多多上货利器删掉商品的步骤怎么操作。

打开拼多多上货利器,然后在里面注册一个帐号,账号注册完以后,我们找米淘科技客服开通一下软件使用权限

“操作步骤”请你们认真阅读

1、如何使用拼多多上货利器批量采集其他平台的宝贝

①、首先我们打开米淘科技拼多多上货利器,进入软件,点击商品采集,然后到其他平台里面找到我们要抓取的宝贝地址,当然你们也可以采集拼多多同行的链接(拼多多全店采集)如果批量采集的链接比较多可以提早放在文本文档做记录,等要采集的时间导出文本就可以了(导入格式)

②、链接打算好以后,我们把链接文本或当个链接导出到软件采集窗口,然后去设置一下商品的基础信息,列如(类目,运费模板,商品团价钱,团购人数,市场价格等)设置完我们勾选智能处理图片,然后点击开始采集!!!

③、采集结束后,软件会提示之后我们可以关掉这个窗口返回软件主界面!!!

2、如何更改商品基础信息(详情信息)

①、修改商品主要我们要先看标题/描述是否符合自己的标准,列如:采集的原商品有在做促销,或者买多少送多少,这个假如我们不想这样做的话,我们可以使用批量更改标题描述以及其他批量更改功能去操作,当然也可以自动去更改!

②、批量更改可以更改(标题/描述/类目/运费模板/团购单买市场价格/商品属性等····)图片可以修改为自己的,不用更改规格,软件会手动更改

3、商品信息更改完了怎样发布

①、我们要先检测一下是不是全部的商品信息都更改完成了,如果没有更改过来的要先更改过来,不要仓促直接上传了,检查一下标题描述,主图logo跟其他信息

②、如果没有其他问题的话,我们勾选这个宝贝,点击上传商品(勾选只能处理图片)选择保存发布或直接递交两个选项,然后点击开始上传就可以了!!!!!

最后谢谢诸位老总才能在百忙之中抽出时间来看完我们的教程,希望这篇文章能够给你们带来帮助,同时也希望我们能否达成友好共识,最后祝诸位老总上完货大卖!!!!!

【推窗】

方便操作的采集神器。js来看你要采集的就行了

采集交流 • 优采云 发表了文章 • 0 个评论 • 227 次浏览 • 2021-04-10 21:00

方便操作的采集神器。

js来看你要采集的就行了,觉得网站不错就用mongodb操作一个,

这个网站的主页在封禁,所以推荐使用wordpress博客系统来完成这个工作。wordpress是一款开源免费的php程序,目前已经存在三个版本。博客系统推荐用daw博客系统来实现,非常的简单。

难道不是用js截图吗?

用前后端分离的方式处理,采用ajax,实现定时发布,采用html5响应式的优势和浏览器的兼容性,

图片格式可以json、request、mongo、file、grab等之类的

会去写一套爬虫吗

如果用mongo建议走file路线,就是定时处理文件,json,或者另一个方案,用json+gib来搞定,我有一些经验可以分享给你,可以参考我的文章

基本上没办法。如果有能力走反爬虫的路线,倒是能搞点事情,因为这些页面一般的爬虫是很难爬到的。不过题主你也都解释得很清楚,说服务器水平不够不会改图片数据,所以我猜测是基本原理搞不定。

爬取图片的软件也要根据图片的格式去定,格式对了就可以爬,另外可以找到图片来源再自己做。

wordpress和phpwind。phpwind是博客程序,wordpress是内容编辑系统,两者已经形成产业链了,phpwind销售wordpress软件,wordpress软件销售phpwind主题。这里并不是说wordpress不好,但是phpwind相对而言更适合使用wordpress。最后,phpwind更好用,但是,要学习phpwind编程的话就绕不开mongoose和gson。 查看全部

方便操作的采集神器。js来看你要采集的就行了

方便操作的采集神器。

js来看你要采集的就行了,觉得网站不错就用mongodb操作一个,

这个网站的主页在封禁,所以推荐使用wordpress博客系统来完成这个工作。wordpress是一款开源免费的php程序,目前已经存在三个版本。博客系统推荐用daw博客系统来实现,非常的简单。

难道不是用js截图吗?

用前后端分离的方式处理,采用ajax,实现定时发布,采用html5响应式的优势和浏览器的兼容性,

图片格式可以json、request、mongo、file、grab等之类的

会去写一套爬虫吗

如果用mongo建议走file路线,就是定时处理文件,json,或者另一个方案,用json+gib来搞定,我有一些经验可以分享给你,可以参考我的文章

基本上没办法。如果有能力走反爬虫的路线,倒是能搞点事情,因为这些页面一般的爬虫是很难爬到的。不过题主你也都解释得很清楚,说服务器水平不够不会改图片数据,所以我猜测是基本原理搞不定。

爬取图片的软件也要根据图片的格式去定,格式对了就可以爬,另外可以找到图片来源再自己做。

wordpress和phpwind。phpwind是博客程序,wordpress是内容编辑系统,两者已经形成产业链了,phpwind销售wordpress软件,wordpress软件销售phpwind主题。这里并不是说wordpress不好,但是phpwind相对而言更适合使用wordpress。最后,phpwind更好用,但是,要学习phpwind编程的话就绕不开mongoose和gson。

手把手教你“如何通过采集、上架,来降低库存”

采集交流 • 优采云 发表了文章 • 0 个评论 • 183 次浏览 • 2021-04-06 19:02

方便操作的采集神器,可任意操作,拥有加速、留言、灰度、竞价等功能目前通过ip操作采集宝贝,新店的话,商品不容易被抓,只要店铺做好店铺定位,通过ip进行采集,被采集到的商品绝对不是僵尸粉单品销量起不来还可以通过做活动来提高销量,前提是你商品转化率要很高,这样的话,适当报一些活动,销量一定也不会差根据活动属性,进行商品铺货操作,属于无货源玩法,有团队的采集、发货、售后服务都可以由有经验的人处理,具体采集技巧可参考一文:手把手教你“如何通过采集、上架,来降低库存”具体操作流程:每天在家可以操作上新,然后上架之后,别人搜索不到的商品就被抓取了。

哪些商品容易被抓取呢?搜索排名靠前的宝贝都容易被抓取。被抓取之后还可以通过搜索“关键词”,比如:“连衣裙”,搜索后出来的结果都是热门宝贝,几乎都是需要竞价的商品。还可以以上架的形式做直通车推广,这里就不一一演示了,操作过的朋友都知道。以下是一些违规,列举几个:①标题不符,②代码不规范,③、上架时,没有上架时间,④、不符合标准等。

简单的操作方法就是:1.采集-拼接-上架2.分销/同步,就是将其他平台上架的商品进行分销,同步到店铺,利用对于产品的属性类目等信息审核,将商品上架到,只要这个平台商品一样,一样类目那么就可以在其他平台上架,而且不用压货,也不需要投入推广。同步化玩法还有个好处,同步其他平台的产品一样,但是换个平台再玩另一个平台,需要注意的是:发货,多平台产品需要换一下发货地址,像头条,会推出客,直通车,同步卖其他平台产品,即可进行操作。 查看全部

手把手教你“如何通过采集、上架,来降低库存”

方便操作的采集神器,可任意操作,拥有加速、留言、灰度、竞价等功能目前通过ip操作采集宝贝,新店的话,商品不容易被抓,只要店铺做好店铺定位,通过ip进行采集,被采集到的商品绝对不是僵尸粉单品销量起不来还可以通过做活动来提高销量,前提是你商品转化率要很高,这样的话,适当报一些活动,销量一定也不会差根据活动属性,进行商品铺货操作,属于无货源玩法,有团队的采集、发货、售后服务都可以由有经验的人处理,具体采集技巧可参考一文:手把手教你“如何通过采集、上架,来降低库存”具体操作流程:每天在家可以操作上新,然后上架之后,别人搜索不到的商品就被抓取了。

哪些商品容易被抓取呢?搜索排名靠前的宝贝都容易被抓取。被抓取之后还可以通过搜索“关键词”,比如:“连衣裙”,搜索后出来的结果都是热门宝贝,几乎都是需要竞价的商品。还可以以上架的形式做直通车推广,这里就不一一演示了,操作过的朋友都知道。以下是一些违规,列举几个:①标题不符,②代码不规范,③、上架时,没有上架时间,④、不符合标准等。

简单的操作方法就是:1.采集-拼接-上架2.分销/同步,就是将其他平台上架的商品进行分销,同步到店铺,利用对于产品的属性类目等信息审核,将商品上架到,只要这个平台商品一样,一样类目那么就可以在其他平台上架,而且不用压货,也不需要投入推广。同步化玩法还有个好处,同步其他平台的产品一样,但是换个平台再玩另一个平台,需要注意的是:发货,多平台产品需要换一下发货地址,像头条,会推出客,直通车,同步卖其他平台产品,即可进行操作。

方便操作的采集神器推荐几款亿万宝贝、车蚂蚁、知足、搜狗网站文章采集器

采集交流 • 优采云 发表了文章 • 0 个评论 • 248 次浏览 • 2021-04-02 21:03

方便操作的采集神器推荐几款app:亿万宝贝、车蚂蚁、知足、搜狗网站文章采集器、亿万宝贝数据采集

一、亿万宝贝提供亿万宝贝采集工具,搜索+采集,一个工具就可以采集任何平台的宝贝,自动同步等店铺。

二、车蚂蚁车蚂蚁是集汽车专业b2b供应链分销平台,汽车供应链数据采集,汽车汽配供应链数据采集,汽车用品行业数据采集,汽车专卖数据采集,汽车广告数据采集,汽车电子数据采集为一体的汽车供应链数据采集分销平台。

三、亿万宝贝数据采集工具亿万宝贝免费使用,其中包含海量分销源数据,宝贝采集,直通车推广,b2b数据采集,网络营销,产品评测,付费广告等多种采集方式。

四、搜狗网站采集器亿万宝贝采集-亿万宝贝数据采集-搜狗网站采集器-亿万宝贝网站采集

一个网站叫亿万宝贝,提供亿万宝贝采集。

找人把亿万宝贝的网站搬运到去就行了

所以现在基本上已经有了亿万宝贝,熊猫自动采集器,阿里妈妈数据采集器,百度网页采集器,金山网页采集器等采集器了,只要你有不想要的网页,哪怕网页信息在,就可以做封装批量采集,

今天用采集软件python爬取了百度某站的排名信息。 查看全部

方便操作的采集神器推荐几款亿万宝贝、车蚂蚁、知足、搜狗网站文章采集器

方便操作的采集神器推荐几款app:亿万宝贝、车蚂蚁、知足、搜狗网站文章采集器、亿万宝贝数据采集

一、亿万宝贝提供亿万宝贝采集工具,搜索+采集,一个工具就可以采集任何平台的宝贝,自动同步等店铺。

二、车蚂蚁车蚂蚁是集汽车专业b2b供应链分销平台,汽车供应链数据采集,汽车汽配供应链数据采集,汽车用品行业数据采集,汽车专卖数据采集,汽车广告数据采集,汽车电子数据采集为一体的汽车供应链数据采集分销平台。

三、亿万宝贝数据采集工具亿万宝贝免费使用,其中包含海量分销源数据,宝贝采集,直通车推广,b2b数据采集,网络营销,产品评测,付费广告等多种采集方式。

四、搜狗网站采集器亿万宝贝采集-亿万宝贝数据采集-搜狗网站采集器-亿万宝贝网站采集

一个网站叫亿万宝贝,提供亿万宝贝采集。

找人把亿万宝贝的网站搬运到去就行了

所以现在基本上已经有了亿万宝贝,熊猫自动采集器,阿里妈妈数据采集器,百度网页采集器,金山网页采集器等采集器了,只要你有不想要的网页,哪怕网页信息在,就可以做封装批量采集,

今天用采集软件python爬取了百度某站的排名信息。

方便操作的采集神器(i春秋采集器采集方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 287 次浏览 • 2021-03-29 06:03

方便操作的采集神器i春秋采集器采集方法:

1、确定分析样本的类型

2、按照需求进行采集,

3、选择进行采集的平台及方式,

4、对采集的结果进行全网分析将采集的结果进行全网分析查看关键词需求量、关键词搜索排名、搜索指数、网站收录量、网站停留时间、网站转化率等数据统计,将数据综合利用后作为参考数据。

5、选择合适的采集软件

采集网站首先你需要知道哪些网站和哪些文章属于你要采集的。

1.打开浏览器,输入网址,点击搜索2.分析你要采集的内容,点击第一个「网页类型」的小按钮:3.选择类型:常见的网页类型有wap、cn、ietext、javascript、css、php等4.点击右侧的「采集样本」(或者「采集指南」)的小按钮。5.确定采集指南6.收集指南会给你介绍采集的步骤和一些注意事项,选择要采集的网页(目前主要支持ietext、javascript、css、php)点击右侧「查看样本」,然后选择采集样本即可。7.注意事项【【301页】一键采集网页/文章大全-i春秋社区】。

对于这样的问题,我一般会先推荐用搜索引擎,然后建议用爱采宝这个采集平台,搜狗网没有收录新闻,爱采宝中的很多新闻收录了,新闻的来源也多样,不是所有的网站都能被采集的,爱采宝采集的比较全面, 查看全部

方便操作的采集神器(i春秋采集器采集方法)

方便操作的采集神器i春秋采集器采集方法:

1、确定分析样本的类型

2、按照需求进行采集,

3、选择进行采集的平台及方式,

4、对采集的结果进行全网分析将采集的结果进行全网分析查看关键词需求量、关键词搜索排名、搜索指数、网站收录量、网站停留时间、网站转化率等数据统计,将数据综合利用后作为参考数据。

5、选择合适的采集软件

采集网站首先你需要知道哪些网站和哪些文章属于你要采集的。

1.打开浏览器,输入网址,点击搜索2.分析你要采集的内容,点击第一个「网页类型」的小按钮:3.选择类型:常见的网页类型有wap、cn、ietext、javascript、css、php等4.点击右侧的「采集样本」(或者「采集指南」)的小按钮。5.确定采集指南6.收集指南会给你介绍采集的步骤和一些注意事项,选择要采集的网页(目前主要支持ietext、javascript、css、php)点击右侧「查看样本」,然后选择采集样本即可。7.注意事项【【301页】一键采集网页/文章大全-i春秋社区】。

对于这样的问题,我一般会先推荐用搜索引擎,然后建议用爱采宝这个采集平台,搜狗网没有收录新闻,爱采宝中的很多新闻收录了,新闻的来源也多样,不是所有的网站都能被采集的,爱采宝采集的比较全面,

方便操作的采集神器:excel爬虫,我也正在学,

采集交流 • 优采云 发表了文章 • 0 个评论 • 255 次浏览 • 2021-03-28 22:03

方便操作的采集神器:这个有你所需要的一切,不管是趣头条的文章,还是其他的文章网站,还是自媒体平台里的文章。都可以采集。

推荐一个使用网站,是目前为止最好用,

要哪些网站的话,可以用网站大全这个网站看看,也是分了一部分内容来,还有一些可能要爬虫之类的都有。

推荐一个巨好用的网址采集工具。1,首先它支持网址采集所有网站2,全新增加网址采集器小程序,可一键导入公众号/公众号文章或发现栏目的网址并调用excel数据进行爬取3,不仅包含分析爬取到的网址规律,还能导出数据txt文档,免费分享给朋友。

excel

php爬虫,我也正在学,看过不少,这个最好用.

豆瓣小组,电影天堂,

推荐excel,不仅可以爬取网站文章,还可以做时间序列数据分析,进行自然语言处理等等,

网站后台有网站分析软件,excel可以的。

可以试试sphere

webscrapingproductinfoserverinstaller(推荐用这个爬墙,

urllib不仅可以爬虫网站,

这个真不好找

楼上的都是大佬,我小白爬虫,一开始因为需要爬取快递,所以爬爬快递的网站文章~现在用了网站大全,真的可以爬这些网站,而且功能强大的不仅有爬虫,还有分析,爬虫,以及大数据, 查看全部

方便操作的采集神器:excel爬虫,我也正在学,

方便操作的采集神器:这个有你所需要的一切,不管是趣头条的文章,还是其他的文章网站,还是自媒体平台里的文章。都可以采集。

推荐一个使用网站,是目前为止最好用,

要哪些网站的话,可以用网站大全这个网站看看,也是分了一部分内容来,还有一些可能要爬虫之类的都有。

推荐一个巨好用的网址采集工具。1,首先它支持网址采集所有网站2,全新增加网址采集器小程序,可一键导入公众号/公众号文章或发现栏目的网址并调用excel数据进行爬取3,不仅包含分析爬取到的网址规律,还能导出数据txt文档,免费分享给朋友。

excel

php爬虫,我也正在学,看过不少,这个最好用.

豆瓣小组,电影天堂,

推荐excel,不仅可以爬取网站文章,还可以做时间序列数据分析,进行自然语言处理等等,

网站后台有网站分析软件,excel可以的。

可以试试sphere

webscrapingproductinfoserverinstaller(推荐用这个爬墙,

urllib不仅可以爬虫网站,

这个真不好找

楼上的都是大佬,我小白爬虫,一开始因为需要爬取快递,所以爬爬快递的网站文章~现在用了网站大全,真的可以爬这些网站,而且功能强大的不仅有爬虫,还有分析,爬虫,以及大数据,

【好书推荐】Prometheus和这些监控系统有啥异同?

采集交流 • 优采云 发表了文章 • 0 个评论 • 587 次浏览 • 2021-03-25 23:10

原创标题:普罗米修斯为什么能替代Zabbix?

本文是根据dbaplus社区的第198次在线共享而编写的,在文章的结尾有不错的书籍推荐〜

讲师介绍

一、简介

Kubernetes自2012年开源以来,已成为容器调度和编排中不可阻挡的领导者。Kubernetes是Google Borg系统的开源实现,与Prometheus相对应的是Google BorgMon的开源实现。 Prometheus是SoundCloud开发的开源监视警报系统和时间序列数据库。从字面上理解,普罗米修斯由两部分组成,一个是监视警报系统,另一个是它自己的时间序列数据库(TSDB)。

2016年,由Google发起的Linux基金会下的Cloud Native Computing Foundation将Prometheus列为其第二大开源项目。 Prometheus在开源社区中也非常活跃,在GitHub上拥有超过20,000个Star,并且该系统每隔一到两周就会进行一次小版本更新。

二、各种监视工具的比较

实际上,在Prometheus之前,市场上有许多监视系统,例如Zabbix,Open-Falcon,Nagios等。那么Prometheus与这些监视系统之间的异同是什么?让我们简要回顾一下这些监视系统。

1、 Zabbix

Zabbix是Alexei Vladishev的开源分布式监视系统。它支持多个采集方法和采集客户端。它还支持SNMP,IPMI,JMX,Telnet,SSH和其他协议。它将采集接收到的数据存储在数据库中,然后进行分析和整理。如果符合警报规则,则会触发相应的警报。

Zabbix的核心组件主要是代理和服务器。代理主要负责采集数据,并通过主动或被动采集将数据发送到服务器/代理。此外,为了扩展监视项目,代理还支持执行自定义脚本。服务器主要负责接收代理发送的监视信息,将其存储在一起并触发警报。

Zabbix服务器将采集的监视数据存储在Zabbix数据库中。 Zabbix数据库支持常用的关系数据库。如果是MySQL,PostgreSQL,Oracle等,则默认值为MySQL,并在Zabbix网页(用PHP编写)上提供数据查询。

由于Zabbix使用关系数据存储时间序列数据,因此在监视大型集群时,它经常在数据存储方面遇到困难。因此,从Zabbix 4. 2版本开始,就支持TimescaleDB时间序列数据库,但目前成熟度不高。

2、 Open-Falcon

Open-Falcon是使用Mi语言开发的小米开源企业级监视工具。小米,滴滴,美团等互联网公司都在使用它。它是一种灵活,可扩展的高级性能监控程序的主要组件包括:

1) Falcon-agent是使用Go语言开发的Daemon程序。它运行在每台Linux服务器上,并用于采集主机上的各种索引数据,主要包括CPU,内存,磁盘,文件系统,内核参数,套接字连接等,目前支持200多个监视指示器。此外,该代理还支持用户定义的监视脚本。

2)心跳服务器缩写为HBS心跳服务。每个代理都会通过RPC定期向HBS报告其状态,该RPC主要包括主机名,主机IP,代理版本和插件版本,并且代理还将从HBS接收信息。获取采集任务和所需的自定义插件表演。

3) Transfer负责接收代理发送的监视数据,对数据进行排序,并在过滤后通过一致的哈希算法将其发送给Judge或Graph。

4) Graph是基于RRD的数据报告,归档和存储组件。 Graph接收到数据后,将其存储在rrdtool的数据归档方法中,同时将提供RPC方法的监视和查询界面。

5)判断警报模块,传输转发到判断的数据将触发用户设置的警报规则,如果满足,它将触发电子邮件,微信或回调界面。在这里,为了避免重复警报,引入了Redis临时存储警报,以完成警报的组合和抑制。

6)仪表板是一个面向用户的监视数据查询和警报配置界面。

3、 Nagios

Nagios最初称为NetSaint,由Ethan Galstad开发和维护。 Nagios是用C语言编写的高级监视工具,主要用于主机监视(CPU,内存,磁盘等)和网络监视(SMTP,POP 3、 HTTP和NNTP等),当然,它还支持用户定义的监视脚本。

它还支持更通用,更安全的采集方法,即NREP(Nagios远程插件执行器)。它首先在远程主机上启动NREP守护程序,以在远程主机上运行检测命令并在Nagios中提供服务。check nrep插件用于通过SSL连接到NREP守护程序,以执行相应的监视操作。与SSH远程执行命令相比,此方法更安全。

4、普罗米修斯

Prometheus是SoundCloud开发的开源监视警报系统和时间序列数据库。 Prometheus的基本原理是通过HTTP定期捕获受监视组件的状态。只要组件提供相应的HTTP接口并符合Prometheus定义的数据格式,任何组件都可以访问Prometheus监视。

Prometheus Server负责定期在目标上获取指标数据并将其保存到本地存储中。 Prometheus使用pull方法获取数据,这不仅降低了客户端的复杂性,而且客户端只需要采集个数据,而无需了解服务器的情况,因此可以更方便地水平扩展服务器。

如果监视数据达到警报阈值,则Prometheus Server将通过HTTP将警报发送到警报模块alertmanger,并在抑制警报后触发电子邮件或Webhook。 Prometheus支持PromQL以提供多维数据模型和灵活的查询。通过将多个标签与监视指标相关联,可以在任意维度上组合和汇总监视数据。

5、全面比较

1)与上表相比,从开发语言的角度来看,为了满足高并发和快速迭代的需求,监视系统的开发语言已逐渐从C语言转换为Go。必须说,当Java占用业务开发和C占用基础开发时,Go依靠简洁的语法和优雅的并发来准确地定位中间件开发需求,并且在当前的开源中间件产品中得到了广泛的应用。

2)从系统成熟度的角度来看,Zabbix和Nagios都是老牌的监视系统:Nagios于1999年出现,Zabbix于1998年出现。系统功能相对稳定和成熟。普罗米修斯(Prometheus)和开放猎鹰(Open-Falcon)都是近年出生的。尽管功能仍在迭代更新中,但它们站在巨人的肩膀上,并借鉴了许多在建筑设计中已建立的监控系统的经验;

3)从系统可伸缩性的角度来看,Zabbix和Open-Falcon都可以自定义各种监视脚本,并且Zabbix不仅可以进行主动推送,还可以进行被动推送。 Prometheus定义了一套Monitor数据规范,并通过各种导出器扩展了系统采集的功能。

4)从数据存储的角度来看,Zabbix使用关系数据库存储,这极大地限制了Zabbix 采集的性能。 Nagios和Open-Falcon都使用RDD数据存储,并且Open-Falcon还增加了一致性。哈希算法对数据进行分片并可以连接到OpenTSDB,而Prometheus自行开发了一套高性能时间序列数据库,可以实现数十个V3版本中每秒可存储数百万个数据,并通过连接到第三方时间序列数据库来扩展历史数据的存储;

5)就配置复杂性而言,Prometheus只有一个核心服务器组件,可以用一个命令启动。相比之下,其他系统配置则相对麻烦,尤其是Open-Falcon。

6)从社区活动的角度来看,Zabbix和Nagios当前的社区活动相对较低,尤其是Nagios。尽管Open-Falcon也相对活跃,但它基本上是国内公司的参与,而Prometheus占据了这一领域。绝对优势,社区是最活跃的,并在CNCF的支持下,后期的发展值得期待;

7)从容器支持的角度来看,由于Zabbix和Nagios出现得较早,所以容器当时不是诞生的,自然对容器的支持相对较差。尽管Open-Falcon提供了容器监视,但是其支持是有限的。 Prometheus的动态发现机制不仅支持大量的本机集群,而且还支持监视Kubernetes容器集群。目前,它是用于容器监视的最佳解决方案。 Zabbix在传统监控系统中具有绝对优势,尤其是在与服务器相关的监控中。 Nagios广泛用于网络监控。随着容器的发展,Prometheus已开始成为容器监视中的主导和标准配置,并将在可预见的将来广泛使用。

总的来说,通过比较各种监视系统的优缺点,普罗米修斯可以说是监视领域中最犀利的“瑞士军刀”。

三、普罗米修斯函数介绍

下图是Prometheus的总体体系结构。左侧是各种数据源,主要是符合Prometheus数据格式的出口商。另外,为了支持推送数据的代理,可以使用Pushgateway将Push转换为Pull。 Prometheus甚至可以从其他Prometheus获取数据,稍后将在引入联盟时对其进行详细描述。

图片的上方是服务发现。 Prometheus支持受监视对象的自动发现机制,以便可以动态获取受监视对象。尽管Zabbix和Open-Falcon也支持动态发现机制,但是Prometheus支持最完善的机制。

图片的中心是核心。数据通过“检索”模块定期拉出,数据通过“存储”模块保存。 PromQL是Prometheus提供的查询语法。 PromQL解析语法树并查询存储模块以获得监视数据。图片的右侧是警报和页面显示。除了Prometheus随附的Webui之外,页面视图还可以通过诸如grafana之类的组件查询Prometheus监视数据。

Prometheus指标格式分为两部分:一个是指标名称,另一个是指标标签。格式如下:

{=,...}

标签可以反映指示器的尺寸特征。例如,对于指标http_request_total,可以有两个标签{status =“ 200”,method =“ POST”}和{status =“ 200”,method =“ GET”}。当您需要获取从GET和POST返回200的请求时,可以分别使用以上两个指示符。当您需要获取所有返回200的请求时,可以通过http_request_total {status =“ 200”}完成数据汇总,这非常方便且通用。

普罗米修斯指标有四种类型:

1) Counter(计数器):对统计信息,累积量进行计数或累积次数等进行计数。其特征是它只会增加而不减少,例如HTTP访问的总次数;

2) Gauge(仪表盘):数据是一个瞬时值,如果当前的内存使用情况,它会随时间上下波动。

如果您需要了解某个时间段内请求的响应时间,通常的做法是使用平均响应时间,但这不能反映数据的长尾效应。例如,HTTP服务器的正常响应时间为30毫秒,但很少有3秒钟的请求。很难通过平均响应时间来区分长尾效应,因此Prometheus引入了直方图和摘要。

3)直方图(直方图):服务器端分位数,不同时间间隔内的样本数量,例如类别得分,低于60的9得分,低于70的10得分以及低于80 50的得分。

4)摘要(摘要):客户端分位数,直接在客户端传递分位数,或使用类结果作为示例:0.第8个四分位数为80点,0. 9分为85分,0. 99分是98分。

Prometheus通过HTTP接口从各种客户端获取数据。这些客户端必须符合Prometheus监视数据格式。通常有两种方法,它们始终是侵入式监视。如果Kubernetes API直接集成在客户端上通过引入Prometheus go客户端,将提供/ metrics接口以查询kubernetes API的各种指标。

另一种方法是使用导出器从外部将各种中间件的原创监视支持转换为Prometheus的监视数据格式。例如,redis导出器将reids指示符转换为Prometheus可以识别的HTTP请求。

Prometheus不使用json数据格式,而是使用纯文本/纯文本,这是它的特殊功能。

HTTP返回标头和正文,如上图所示。指标#的前两行是注释,用于标识指标的含义和类型。指标和指标值之间用空格隔开。开发人员通常不需要自己缝合大量数据。 Prometheus提供了多种语言的SDK支持。

Prometheus提供了一个导出器,以支持各种中间件和第三方监视。您可以将其理解为监视适配器,以将不同指标类型和格式的数据统一转换为Prometheus可以识别的指标类型。

例如,Node导出器主要通过读取Linux的/ proc和/ sys目录中的系统文件来获取操作系统的运行状态,reids导出器通过reids命令行获取指示符,而mysql导出器获取mysql通过读取数据库性能数据监视表。 。他们将这些异构数据转换为标准的Prometheus格式,并提供HTTP查询接口。

Prometheus提供了两种数据持久性方法:一种是本地存储,通过Prometheus附带的tsdb(时间序列数据库)将数据保存到本地磁盘。出于性能方面的考虑,建议使用SSD。但是,本地存储的容量毕竟是有限的。建议不要将数据保存超过一个月。 Prometheus本地存储已改善了很多年。 Prometheus 2. 0之后提供的tsdb V3版本具有很高的性能,并且可以在一台机器上支持每秒采集1000w指示器。

另一个是远程存储,适用于存储和查询大量历史监视数据。通过中间层适配器的转换,Prometheus将数据保存到远程存储中。该适配器实现Prometheus存储的远程写入和远程读取接口,并将数据转换为远程存储支持的数据格式。目前,远程存储主要包括OpenTSDB,InfluxDB,Elasticsearch,M3db,Kafka等,其中M3db是当前非常流行的后端存储。