文章采集组合工具

文章采集组合工具(功能EasyPoi,简单免费的POI分析工具!(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 531 次浏览 • 2021-09-05 12:11

特点

EasyPoi,一个简单且免费的兴趣点分析工具!

1 获取中国指定行政区域内指定关键词的所有兴趣点(最小可以精确到街道);比如可以获取一个城市内所有的便利店、商场、超市、咖啡店、大学等信息,包括经纬度、省、市、区、街道等。

2 获取指定位置(地址或经纬度坐标)半径N公里内关键词指定的所有兴趣点。

3 合并批量获取国内多个行政区域内多个关键词的所有兴趣点信息。 \n例如可以同时获取成都、西安、上海三个指定城市的所有超市、商场和大学的数据。

运行界面

下载使用

在启动采集POI之前,请根据自己的情况安装合适的客户端。目前只支持windows环境。 mac环境在打包的时候一直遇到问题,打包失败。考虑到毕竟用macO的同学很少,就不先打包了。

以下是Windows客户端安装方法和常见问题的总结。

一个下载 EasyPoi Windows 客户端

天翼云盘下载地址(不含提取码):

/t/RbEFrafiI7Fb

百度网盘下载地址:

/s/1bMu15Iyi4n0DRHstqhBtWQ

提取码:6688

2 系统要求

•win7 64 位

•Win10 64 位

XP系统和32位系统未测试,不保证可以使用。

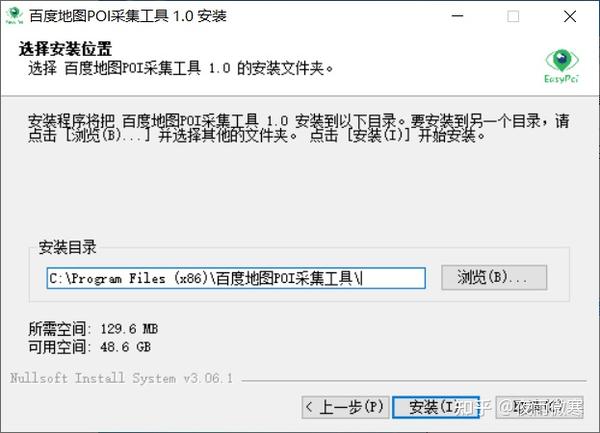

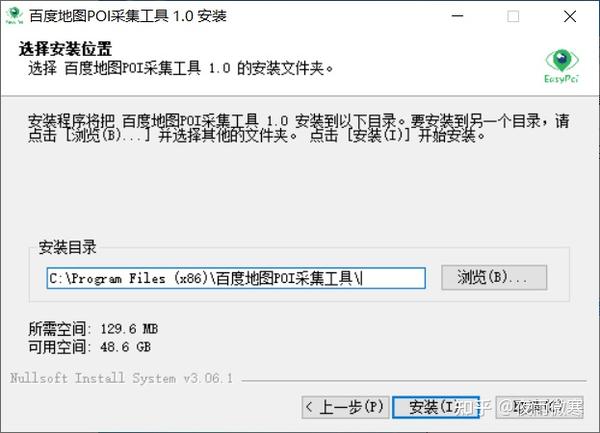

3 下载安装

①下载EasyPoi安装文件(.exe)

②关闭所有杀毒软件,如果是win10,可能被windows卫士屏蔽,请设置为允许。

③双击.exe文件开始安装

④安装完成后,在开始菜单或桌面找到EasyPoi快捷方式

⑤要启动EasyPoi,请右键点击EasyPoi的快捷方式,选择“以管理员身份运行”

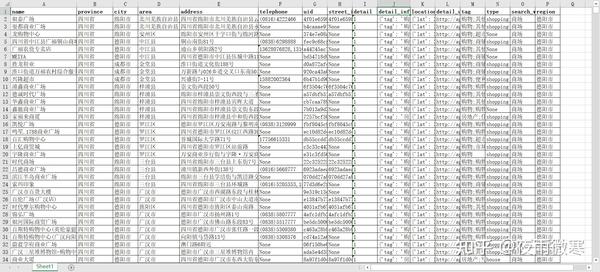

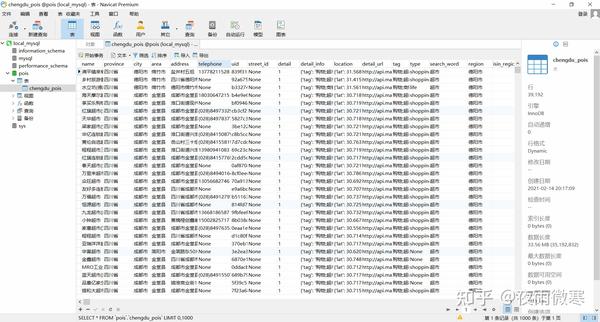

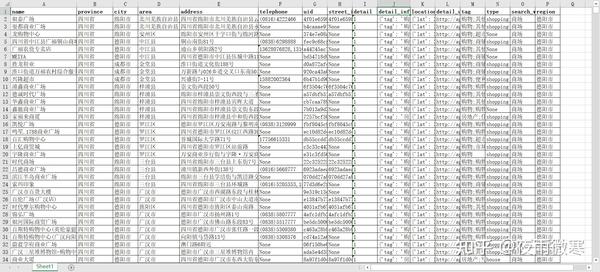

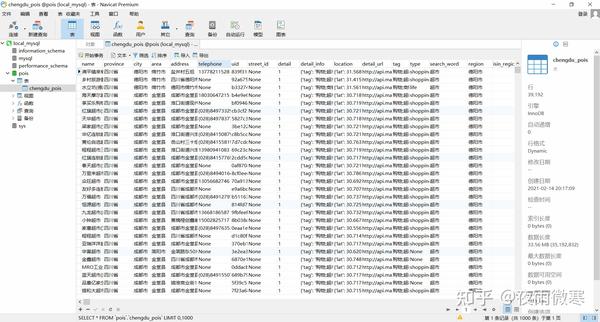

4 采集Data 示例:

Excel 格式:

csv 格式:

mysql:

使用过程中常见的两个问题

安装完成后,在使用过程中可能会遇到以下问题:

1 安装时提示【权限不足,保存失败】

这是因为配置信息需要写在本地,这样下次打开的时候可以自动加载上次的配置信息。

解决方案

您需要右键单击 EasyPoi 快捷方式并选择“以管理员身份运行”

2 点击【运行】后,提示【百度地图ak无效! 】

本程序运行时需要调用百度地图的行政区划查询服务和百度地图的网址api服务,需要百度ak。

解决方案

您需要在百度地图开发者平台申请相应的api key,并在程序【设置】中填写正确的api key。

百度地图开发者ak应用链接:/apiconsole/center 查看全部

文章采集组合工具(功能EasyPoi,简单免费的POI分析工具!(组图))

特点

EasyPoi,一个简单且免费的兴趣点分析工具!

1 获取中国指定行政区域内指定关键词的所有兴趣点(最小可以精确到街道);比如可以获取一个城市内所有的便利店、商场、超市、咖啡店、大学等信息,包括经纬度、省、市、区、街道等。

2 获取指定位置(地址或经纬度坐标)半径N公里内关键词指定的所有兴趣点。

3 合并批量获取国内多个行政区域内多个关键词的所有兴趣点信息。 \n例如可以同时获取成都、西安、上海三个指定城市的所有超市、商场和大学的数据。

运行界面

下载使用

在启动采集POI之前,请根据自己的情况安装合适的客户端。目前只支持windows环境。 mac环境在打包的时候一直遇到问题,打包失败。考虑到毕竟用macO的同学很少,就不先打包了。

以下是Windows客户端安装方法和常见问题的总结。

一个下载 EasyPoi Windows 客户端

天翼云盘下载地址(不含提取码):

/t/RbEFrafiI7Fb

百度网盘下载地址:

/s/1bMu15Iyi4n0DRHstqhBtWQ

提取码:6688

2 系统要求

•win7 64 位

•Win10 64 位

XP系统和32位系统未测试,不保证可以使用。

3 下载安装

①下载EasyPoi安装文件(.exe)

②关闭所有杀毒软件,如果是win10,可能被windows卫士屏蔽,请设置为允许。

③双击.exe文件开始安装

④安装完成后,在开始菜单或桌面找到EasyPoi快捷方式

⑤要启动EasyPoi,请右键点击EasyPoi的快捷方式,选择“以管理员身份运行”

4 采集Data 示例:

Excel 格式:

csv 格式:

mysql:

使用过程中常见的两个问题

安装完成后,在使用过程中可能会遇到以下问题:

1 安装时提示【权限不足,保存失败】

这是因为配置信息需要写在本地,这样下次打开的时候可以自动加载上次的配置信息。

解决方案

您需要右键单击 EasyPoi 快捷方式并选择“以管理员身份运行”

2 点击【运行】后,提示【百度地图ak无效! 】

本程序运行时需要调用百度地图的行政区划查询服务和百度地图的网址api服务,需要百度ak。

解决方案

您需要在百度地图开发者平台申请相应的api key,并在程序【设置】中填写正确的api key。

百度地图开发者ak应用链接:/apiconsole/center

文章采集组合工具(快手andb站两大视频网站视频采集合集(一))

采集交流 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2021-09-04 19:03

文章采集组合工具使用#1:采集一些原创高质量视频,就会自动发布在一些b站、快手、优酷等应用中,文章采集组合工具使用#2:采集一些b站、快手、优酷的文章也可以使用第一个,其他的b站、快手、优酷采集只适用于该网站所有的。

经常在这样的搜索框看到这个标题很多人使用的,接下来分享给大家自动采集快手、b站、优酷视频的工具pip3installamzdigger安装后,先别忘了把这个脚本的文件夹和你的另一个脚本安装后,用脚本编辑器编辑autoit,可以接着使用脚本shamzdiggerfilter-get,如果没有脚本编辑器,可以编辑为配置文件直接在终端执行filter-get。

把脚本运行结果按图截屏,添加iframe,然后测试网页。:,如果有别的相关问题或想获取更多信息,可以看看小酱的公众号:码农经验分享,里面有相关资源。知乎专栏:码农经验分享。

使用正则表达式去做吧

爬虫|快手andb站两大视频网站视频采集合集,自动采集快手b站视频,没有你做不到,

使用selenium库很容易上手,

感谢邀请本人是个上班族,对于专业的学习方面有点迷茫,然后一个偶然的机会下我自己利用业余时间学习,自己编写爬虫, 查看全部

文章采集组合工具(快手andb站两大视频网站视频采集合集(一))

文章采集组合工具使用#1:采集一些原创高质量视频,就会自动发布在一些b站、快手、优酷等应用中,文章采集组合工具使用#2:采集一些b站、快手、优酷的文章也可以使用第一个,其他的b站、快手、优酷采集只适用于该网站所有的。

经常在这样的搜索框看到这个标题很多人使用的,接下来分享给大家自动采集快手、b站、优酷视频的工具pip3installamzdigger安装后,先别忘了把这个脚本的文件夹和你的另一个脚本安装后,用脚本编辑器编辑autoit,可以接着使用脚本shamzdiggerfilter-get,如果没有脚本编辑器,可以编辑为配置文件直接在终端执行filter-get。

把脚本运行结果按图截屏,添加iframe,然后测试网页。:,如果有别的相关问题或想获取更多信息,可以看看小酱的公众号:码农经验分享,里面有相关资源。知乎专栏:码农经验分享。

使用正则表达式去做吧

爬虫|快手andb站两大视频网站视频采集合集,自动采集快手b站视频,没有你做不到,

使用selenium库很容易上手,

感谢邀请本人是个上班族,对于专业的学习方面有点迷茫,然后一个偶然的机会下我自己利用业余时间学习,自己编写爬虫,

文章采集组合工具(文章采集组合工具之插件类(插件篇)-)

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-09-04 11:02

文章采集组合工具之插件类。一、选择器+识别器(kindle查词文章提取)先看一下文章识别部分的效果:文字部分都支持提取并且转换成数组(数组后缀名为msg.txt)。首先输入一个你想要提取的关键词:然后粘贴到导航栏中。你可以在关键词前面加上:在关键词后面加上:粘贴完毕之后点击导航栏中的「识别文章」,对你需要提取的文章进行标注,然后点击右上角的「提取结果」,点击下一步进行提取。

提取完成后可以在导航栏中的「分享」-「提取结果」中保存提取结果并保存在浏览器的历史记录中。二、文本识别(bookid验证)打开百度输入想要提取的文章bookid然后点击对应的问题进行验证打开你需要的文章问题代码地址jiuqingming/mydocument-evaluation。

先上效果图:示例代码及规则因为这篇文章很长,所以这篇文章我是通过爬取问题链接、文章标题、文章作者,目前修改为16页,100424条;最后提取问题所有的前5条,问题链接、文章标题和文章作者。代码如下:sheqingming/wordtracker-toolby-text获取问题链接和文章标题问题链接,文章标题,搜索结果页列表页三个链接,为什么需要单独说明呢?因为爬取前一条文章链接很容易获取,但是爬取后面的链接就困难了。

获取问题链接:这里我以问题h116为例,直接去网页中搜索,可以看到搜索结果页列表页都有,我们要抓取的就是单独针对于h116这一条。爬取问题标题,就容易一些,不是这个问题的页面不需要爬取了,先获取问题标题是这个问题类目中的一篇文章,顺序如下:问题标题:www.china.zhu.do直接复制粘贴就可以。

爬取问题作者,就比较麻烦,因为本身就已经写好了,但是一般情况下,都是在重复的使用同一个作者名,但是如果要爬取新的作者,就需要新开爬虫爬取,不然就只有重复一次名字,所以这个时候爬取两个重复的名字。这时候就需要去重复的对应的网页中去爬取。代码如下:library(jiebar)library(filter)library(pandas)爬取问题作者的爬虫如下,获取文章作者,问题标题,获取问题链接,获取问题作者:itemclub/wordtracker-toolby-text(pdf)爬取问题标题链接,问题作者链接这两个链接,就可以爬取整篇文章。

不过爬虫大量时,对速度有一定的影响。这样把文章爬下来之后,准备做什么呢?就是把爬虫中爬取的文章再次导入organized_word_item包中就可以针对某一个词进行筛选,比如在第二页文章中,如果爬取的是关于问题的第一个词,那么就认为这是。 查看全部

文章采集组合工具(文章采集组合工具之插件类(插件篇)-)

文章采集组合工具之插件类。一、选择器+识别器(kindle查词文章提取)先看一下文章识别部分的效果:文字部分都支持提取并且转换成数组(数组后缀名为msg.txt)。首先输入一个你想要提取的关键词:然后粘贴到导航栏中。你可以在关键词前面加上:在关键词后面加上:粘贴完毕之后点击导航栏中的「识别文章」,对你需要提取的文章进行标注,然后点击右上角的「提取结果」,点击下一步进行提取。

提取完成后可以在导航栏中的「分享」-「提取结果」中保存提取结果并保存在浏览器的历史记录中。二、文本识别(bookid验证)打开百度输入想要提取的文章bookid然后点击对应的问题进行验证打开你需要的文章问题代码地址jiuqingming/mydocument-evaluation。

先上效果图:示例代码及规则因为这篇文章很长,所以这篇文章我是通过爬取问题链接、文章标题、文章作者,目前修改为16页,100424条;最后提取问题所有的前5条,问题链接、文章标题和文章作者。代码如下:sheqingming/wordtracker-toolby-text获取问题链接和文章标题问题链接,文章标题,搜索结果页列表页三个链接,为什么需要单独说明呢?因为爬取前一条文章链接很容易获取,但是爬取后面的链接就困难了。

获取问题链接:这里我以问题h116为例,直接去网页中搜索,可以看到搜索结果页列表页都有,我们要抓取的就是单独针对于h116这一条。爬取问题标题,就容易一些,不是这个问题的页面不需要爬取了,先获取问题标题是这个问题类目中的一篇文章,顺序如下:问题标题:www.china.zhu.do直接复制粘贴就可以。

爬取问题作者,就比较麻烦,因为本身就已经写好了,但是一般情况下,都是在重复的使用同一个作者名,但是如果要爬取新的作者,就需要新开爬虫爬取,不然就只有重复一次名字,所以这个时候爬取两个重复的名字。这时候就需要去重复的对应的网页中去爬取。代码如下:library(jiebar)library(filter)library(pandas)爬取问题作者的爬虫如下,获取文章作者,问题标题,获取问题链接,获取问题作者:itemclub/wordtracker-toolby-text(pdf)爬取问题标题链接,问题作者链接这两个链接,就可以爬取整篇文章。

不过爬虫大量时,对速度有一定的影响。这样把文章爬下来之后,准备做什么呢?就是把爬虫中爬取的文章再次导入organized_word_item包中就可以针对某一个词进行筛选,比如在第二页文章中,如果爬取的是关于问题的第一个词,那么就认为这是。

文章采集组合工具(优采云采集提供强大灵活的SEO优化工具对提高文章的收录和权重 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-09-03 21:02

)

优采云采集提供强大灵活的SEO优化工具,对增加文章的收录和网站的权重起到了非常重要的作用。

优采云SEO工具策略主要包括:正文插入动态段落(强烈推荐)、标题插入关键词、正文插入段落和标题自动关键词、自动内链、同义词替换、简繁转换。

在正文中插入动态段落:指在文章正文的开头、中间和结尾插入一个段落。段落摘要来自同一任务中的其他采集 数据。用户不需要预先定义段落,只需要定义段落格式(默认就是这样)。

文章在正文前后插入内容后,相当于搜索引擎完全不同的文章,有利于收录,不影响用户阅读(段落可以背景色区分)。

标题插入关键词:指在文章title(默认标题字段)的开头或结尾随机插入用户提供的关键词。也可以选择是否对标题进行分割,由用户提供的关键词(即关键词库)进行交集并插入交集结果。

在关键词正文中自动插入段落和标题:指在文章正文的开头、中间和结尾随机插入用户提供的段落,并在末尾添加与该段落对应的关键词的“标题”。 (用户需要预先定义段落库和对应的关键词)。

自动内链:为文中指定的关键词添加自定义链接,控制内链数量。合理的网站内部链接可以增加收录和网站的权重。

同义词替换:可以使用同义词库(官方提供,用户自定义)替换指定字段(如内容、标题等)中的内容,对收录也有很大帮助。是一种内容的替换。

简繁间转换:可以快速进行简繁间转换,例如简繁体转换后,可以切换回简体。

组合字段发布:在发布目标的标题或内容[配置映射对应字段]处组合不同的字段,合成一个新的标题或正文进行发布。

随机插入图片、关键词、链接:使用【自动关键词】SEO工具在正文中插入段落和标题,在正文中随机插入图片、关键词和链接。

翻译工具:翻译支持百度和有道API接口。多语言同时翻译,翻译后的内容存储在新的字段中。

SEO词库和句库:可以为相应的SEO工具设置关键词库、词库、关键词内链库、SEO句库等。

各个SEO策略的具体使用文档如下(持续更新):

SEO优化工具:在正文中插入动态段落(强烈推荐)

SEO优化工具:插入标题关键词

SEO优化工具:自动在正文中插入段落和标题关键词

SEO优化工具:自动内链

SEO优化工具:同义词替换

SEO优化工具:简繁中文转换

SEO优化方式:联合字段发布

SEO优化方法:随机插入图片、关键词、链接

翻译工具

SEO词库和句子数据库

SEO规则定义相关截图如下:

查看全部

文章采集组合工具(优采云采集提供强大灵活的SEO优化工具对提高文章的收录和权重

)

优采云采集提供强大灵活的SEO优化工具,对增加文章的收录和网站的权重起到了非常重要的作用。

优采云SEO工具策略主要包括:正文插入动态段落(强烈推荐)、标题插入关键词、正文插入段落和标题自动关键词、自动内链、同义词替换、简繁转换。

在正文中插入动态段落:指在文章正文的开头、中间和结尾插入一个段落。段落摘要来自同一任务中的其他采集 数据。用户不需要预先定义段落,只需要定义段落格式(默认就是这样)。

文章在正文前后插入内容后,相当于搜索引擎完全不同的文章,有利于收录,不影响用户阅读(段落可以背景色区分)。

标题插入关键词:指在文章title(默认标题字段)的开头或结尾随机插入用户提供的关键词。也可以选择是否对标题进行分割,由用户提供的关键词(即关键词库)进行交集并插入交集结果。

在关键词正文中自动插入段落和标题:指在文章正文的开头、中间和结尾随机插入用户提供的段落,并在末尾添加与该段落对应的关键词的“标题”。 (用户需要预先定义段落库和对应的关键词)。

自动内链:为文中指定的关键词添加自定义链接,控制内链数量。合理的网站内部链接可以增加收录和网站的权重。

同义词替换:可以使用同义词库(官方提供,用户自定义)替换指定字段(如内容、标题等)中的内容,对收录也有很大帮助。是一种内容的替换。

简繁间转换:可以快速进行简繁间转换,例如简繁体转换后,可以切换回简体。

组合字段发布:在发布目标的标题或内容[配置映射对应字段]处组合不同的字段,合成一个新的标题或正文进行发布。

随机插入图片、关键词、链接:使用【自动关键词】SEO工具在正文中插入段落和标题,在正文中随机插入图片、关键词和链接。

翻译工具:翻译支持百度和有道API接口。多语言同时翻译,翻译后的内容存储在新的字段中。

SEO词库和句库:可以为相应的SEO工具设置关键词库、词库、关键词内链库、SEO句库等。

各个SEO策略的具体使用文档如下(持续更新):

SEO优化工具:在正文中插入动态段落(强烈推荐)

SEO优化工具:插入标题关键词

SEO优化工具:自动在正文中插入段落和标题关键词

SEO优化工具:自动内链

SEO优化工具:同义词替换

SEO优化工具:简繁中文转换

SEO优化方式:联合字段发布

SEO优化方法:随机插入图片、关键词、链接

翻译工具

SEO词库和句子数据库

SEO规则定义相关截图如下:

文章采集组合工具( 英文网站推广文章采集搜刮工具-RankWyzContent)

采集交流 • 优采云 发表了文章 • 0 个评论 • 172 次浏览 • 2021-09-03 15:04

英文网站推广文章采集搜刮工具-RankWyzContent)

英文网站promotion文章采集搜刮工具-RankWyz内容抓取

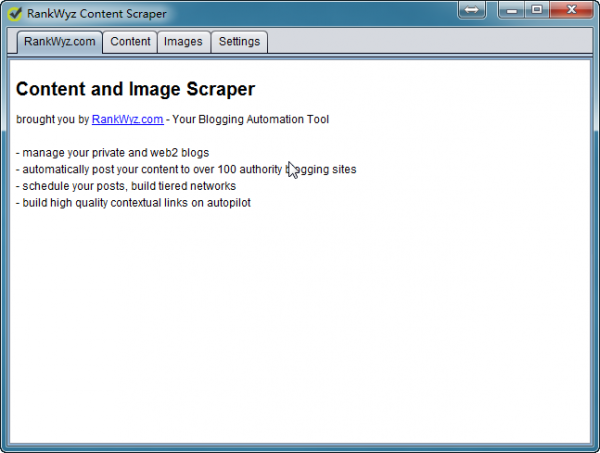

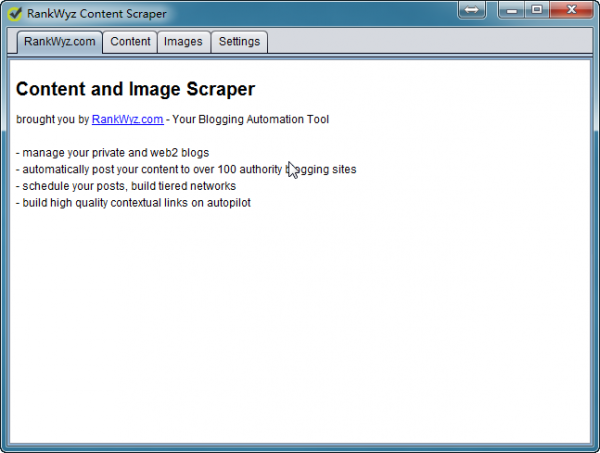

1.RankWyz 内容抓取基本介绍

在做英文网站推广的时候,比较难的问题之一就是找不到很多文章作为网站的内容。这样的英文网站promotion文章采集搜猎工具之前我也介绍过很多。今天要介绍的RankWyz Content Scraper也是一款类似的英文网站promotion文章采集搜拔工具。他的特点是配置和使用都很简单,采集的速度也很快。配置了我用于英文网站推广的关键词后,我可以快速采集很多文章。

English网站promotion文章采集搜废工具-rank-content-scraper-home

2.RankWyz 内容抓取程序设置

(1)程序为绿色版,基于Java环境,机器安装Java环境后,直接解压即可。如果机器未安装Java环境,请使用提供的先安装文件。

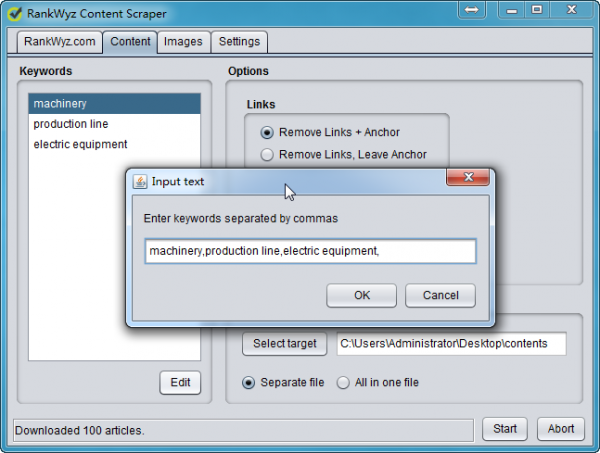

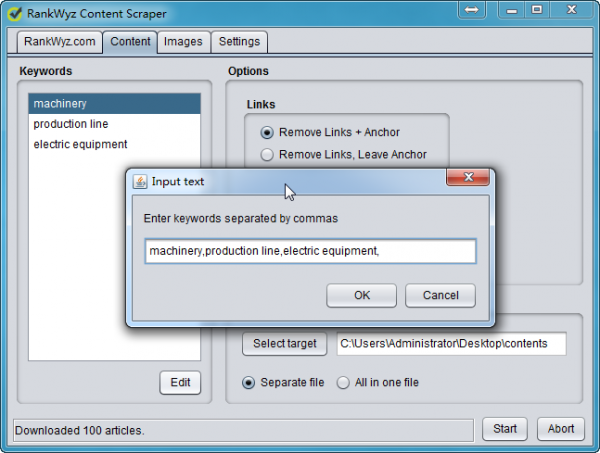

(2)Content选项卡下,只设置两个地方。分别是需要采集的关键词列表,以及采集的文章保存位置

英文网站promotion文章采集搜废工具-rank-content-scraper-content

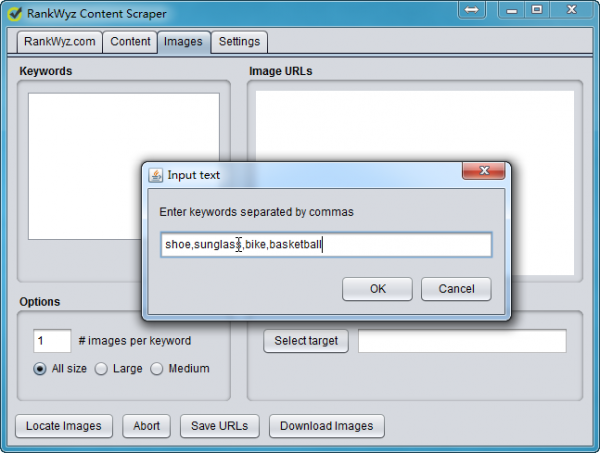

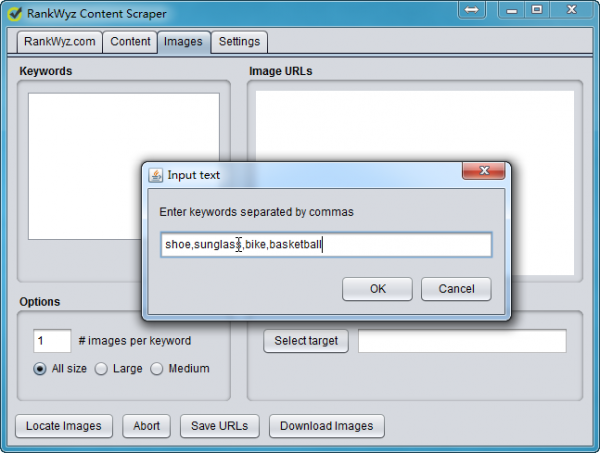

(3)Images标签下可以设置采集图片的属性,包括图片关键字、采集图片大小、图片保存的文件夹

English网站promotion文章采集搜废工具-rank-content-scraper-images

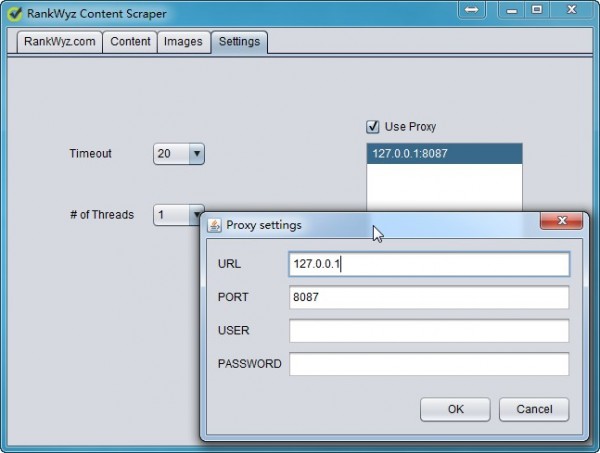

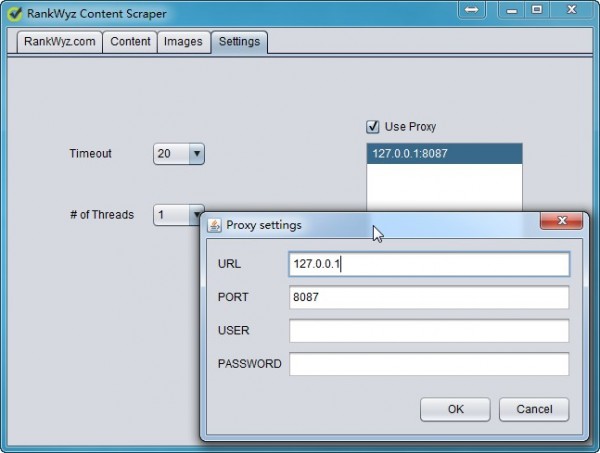

(4)设置选项卡下,设置超时时间(TimeOut)和线程数(Thread)后,右击Proxy单输入,或者批量导入代理地址。

注意:这个英文网站promotion文章采集search 工具必须有代理,没有代理是不行的!

English网站promotion文章采集搜废工具-rank-content-scraper-settings

3.RankWyz 内容抓取使用说明

设置关键词、文章保存目录和代理后,就可以启动采集了。根据网速和关键词的数量,采集需要几分钟到几十分钟才能完成。从截图中我们可以看到,在很短的时间内,该软件有采集一个大量文章。之后,我们可以将这些文章导入文章处理工具进行拆分合并等伪原创处理,用于网站优化推广的内容构建。

English网站promotion文章采集搜废工具-rank-content-scraper-articles

下载地址。本站VIP会员可直接点击下方链接下载此工具。如果您不是本站VIP会员,请点击这里查看如何加入VIP会员。

此软件版本太旧,暂停下载! 查看全部

文章采集组合工具(

英文网站推广文章采集搜刮工具-RankWyzContent)

英文网站promotion文章采集搜刮工具-RankWyz内容抓取

1.RankWyz 内容抓取基本介绍

在做英文网站推广的时候,比较难的问题之一就是找不到很多文章作为网站的内容。这样的英文网站promotion文章采集搜猎工具之前我也介绍过很多。今天要介绍的RankWyz Content Scraper也是一款类似的英文网站promotion文章采集搜拔工具。他的特点是配置和使用都很简单,采集的速度也很快。配置了我用于英文网站推广的关键词后,我可以快速采集很多文章。

English网站promotion文章采集搜废工具-rank-content-scraper-home

2.RankWyz 内容抓取程序设置

(1)程序为绿色版,基于Java环境,机器安装Java环境后,直接解压即可。如果机器未安装Java环境,请使用提供的先安装文件。

(2)Content选项卡下,只设置两个地方。分别是需要采集的关键词列表,以及采集的文章保存位置

英文网站promotion文章采集搜废工具-rank-content-scraper-content

(3)Images标签下可以设置采集图片的属性,包括图片关键字、采集图片大小、图片保存的文件夹

English网站promotion文章采集搜废工具-rank-content-scraper-images

(4)设置选项卡下,设置超时时间(TimeOut)和线程数(Thread)后,右击Proxy单输入,或者批量导入代理地址。

注意:这个英文网站promotion文章采集search 工具必须有代理,没有代理是不行的!

English网站promotion文章采集搜废工具-rank-content-scraper-settings

3.RankWyz 内容抓取使用说明

设置关键词、文章保存目录和代理后,就可以启动采集了。根据网速和关键词的数量,采集需要几分钟到几十分钟才能完成。从截图中我们可以看到,在很短的时间内,该软件有采集一个大量文章。之后,我们可以将这些文章导入文章处理工具进行拆分合并等伪原创处理,用于网站优化推广的内容构建。

English网站promotion文章采集搜废工具-rank-content-scraper-articles

下载地址。本站VIP会员可直接点击下方链接下载此工具。如果您不是本站VIP会员,请点击这里查看如何加入VIP会员。

此软件版本太旧,暂停下载!

文章采集组合工具(文章采集组合工具:fiddlerfiddler.认识fiddlerfiddler是一个命令行代理和远程代理工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-09-03 14:23

文章采集组合工具:fiddler1.认识fiddlerfiddler是一个命令行代理和远程代理工具,通过它你可以连接互联网,访问你电脑的任何地方。它能代理http,ftp和tcp的服务器,并捕获包括数据包和响应报文到本地系统。在这篇文章中你可以学习fiddler下载地址:fiddler破解版,静态服务器必须要用https2.登录fiddler打开浏览器,输入fiddler官网的地址打开即可,打开后就是这样。

有一个小截图可以看到我把fiddler添加到了cookie上,登录fiddler后台进入fiddler选项卡,进入fiddler安全设置的下方,如图所示。进入安全设置,点击更多选项在fiddler的设置中点击同步选项点击同步和上传选项在fiddler的设置中点击请求的转发选项,在上方打勾点击发布者选项点击添加选项,在fiddler代理选项下点击添加选项,在其他所有框里勾选就好了,然后点击确定,如图所示4.fiddler安装在上面的例子中,我们使用windows系统,如果你不使用ubuntulinux系统,需要安装以下两个包:jdk1.8或更高版本的软件包在cmd中输入命令:cd/etc/apt/sources.listinstalljdk1.8.0_74fake.live-devfake_firefox(由于fake未支持桌面,需要命令提示符)installicloud-client//推荐,如果你要使用更多的网络服务需要购买。

安装完毕后,在浏览器中输入命令:fiddler-start点击成功,等待fiddler重启5.fiddler配置fiddler只支持http协议,udp协议无法直接使用在上图中,我们将fiddler选择在linux和windows上的环境下安装。同时也要注意,不要把服务器地址改成中文,否则fiddler会找不到。

6.修改fiddler服务器的host在上图中,我们是以linux为例。那就需要修改/etc/hosts文件里面的内容,在上图中的hosts文件为:,现在fiddler就能正常工作了。7.配置fiddler调试,将在本地运行我们有3个不同的请求都需要在本地执行fiddler服务器,如果你是一个新手,建议找一个好的同学一起帮你配置上服务器。

有人问fiddler已在电脑上运行,那请问需要配置什么呢?我们不配置fiddler,仅仅在本地运行fiddler。在fiddler下,当发送请求到fiddler本地时,一般情况下需要通过三种方式进行验证请求方式1:http下面我们以fiddler为例,通过浏览器的get请求来验证请求方式2:ftp或者https下面我们以ftp为例,用来验证请求方式3:lgpl下面我们以lgpl为例,验证请求方式fiddler自带了验证请求方式的命令,在上图中它可以以两种方式验证请求方式3和4等下附上代码。 查看全部

文章采集组合工具(文章采集组合工具:fiddlerfiddler.认识fiddlerfiddler是一个命令行代理和远程代理工具)

文章采集组合工具:fiddler1.认识fiddlerfiddler是一个命令行代理和远程代理工具,通过它你可以连接互联网,访问你电脑的任何地方。它能代理http,ftp和tcp的服务器,并捕获包括数据包和响应报文到本地系统。在这篇文章中你可以学习fiddler下载地址:fiddler破解版,静态服务器必须要用https2.登录fiddler打开浏览器,输入fiddler官网的地址打开即可,打开后就是这样。

有一个小截图可以看到我把fiddler添加到了cookie上,登录fiddler后台进入fiddler选项卡,进入fiddler安全设置的下方,如图所示。进入安全设置,点击更多选项在fiddler的设置中点击同步选项点击同步和上传选项在fiddler的设置中点击请求的转发选项,在上方打勾点击发布者选项点击添加选项,在fiddler代理选项下点击添加选项,在其他所有框里勾选就好了,然后点击确定,如图所示4.fiddler安装在上面的例子中,我们使用windows系统,如果你不使用ubuntulinux系统,需要安装以下两个包:jdk1.8或更高版本的软件包在cmd中输入命令:cd/etc/apt/sources.listinstalljdk1.8.0_74fake.live-devfake_firefox(由于fake未支持桌面,需要命令提示符)installicloud-client//推荐,如果你要使用更多的网络服务需要购买。

安装完毕后,在浏览器中输入命令:fiddler-start点击成功,等待fiddler重启5.fiddler配置fiddler只支持http协议,udp协议无法直接使用在上图中,我们将fiddler选择在linux和windows上的环境下安装。同时也要注意,不要把服务器地址改成中文,否则fiddler会找不到。

6.修改fiddler服务器的host在上图中,我们是以linux为例。那就需要修改/etc/hosts文件里面的内容,在上图中的hosts文件为:,现在fiddler就能正常工作了。7.配置fiddler调试,将在本地运行我们有3个不同的请求都需要在本地执行fiddler服务器,如果你是一个新手,建议找一个好的同学一起帮你配置上服务器。

有人问fiddler已在电脑上运行,那请问需要配置什么呢?我们不配置fiddler,仅仅在本地运行fiddler。在fiddler下,当发送请求到fiddler本地时,一般情况下需要通过三种方式进行验证请求方式1:http下面我们以fiddler为例,通过浏览器的get请求来验证请求方式2:ftp或者https下面我们以ftp为例,用来验证请求方式3:lgpl下面我们以lgpl为例,验证请求方式fiddler自带了验证请求方式的命令,在上图中它可以以两种方式验证请求方式3和4等下附上代码。

文章采集组合工具(优采云智能文章采集系统怎么使用?怎么用??)

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-09-02 03:13

优采云智能文章采集系统 这是一个非常好用的文章采集软件。欢迎想使用这个采集工具的用户下载使用。

优采云智能文章采集系统介绍:

优采云智能文章采集系统是一个非常有用的文章采集工具,你可以在不了解源码规则的情况下采集,用户只需简单的操作@文章就可以批量采集,帮你采集海量热门资讯。

优采云智能文章采集系统特点:

1、可以在不了解源码规则的情况下采集,只要是文章内容型网站都可以快速采集。

2、Automatic 中英文伪原创、原创度80%以上。

3、自动去噪和去乱码和文章长度判断,得到干净整洁的文章内容。

4、全球小语种支持,请指定网站采集,而不是文章源。

5、多线程多任务(多站点)同步采集,1分钟1000+文章采集。

6、批量发布到普通博客/网站内容cms上。

优采云智能文章采集如何使用系统?

1、download优采云智能文章采集系统,点击运行,登录账号密码。

2、添加新任务,打开新任务设置窗口。

(1)先填写唯一的任务名称(一般按网站列或分类名称,也可以自己取,主要是为了方便识别)。

(2).设置网页代码,在目标网页的源代码中查看网页代码,选择对应的代码(只要代码正确,任何语言都可以识别)。

(3)生成到分类网址列表中,也可以添加单个网址,也可以将多个网址整理成TXT,逐行分批导入。 查看全部

文章采集组合工具(优采云智能文章采集系统怎么使用?怎么用??)

优采云智能文章采集系统 这是一个非常好用的文章采集软件。欢迎想使用这个采集工具的用户下载使用。

优采云智能文章采集系统介绍:

优采云智能文章采集系统是一个非常有用的文章采集工具,你可以在不了解源码规则的情况下采集,用户只需简单的操作@文章就可以批量采集,帮你采集海量热门资讯。

优采云智能文章采集系统特点:

1、可以在不了解源码规则的情况下采集,只要是文章内容型网站都可以快速采集。

2、Automatic 中英文伪原创、原创度80%以上。

3、自动去噪和去乱码和文章长度判断,得到干净整洁的文章内容。

4、全球小语种支持,请指定网站采集,而不是文章源。

5、多线程多任务(多站点)同步采集,1分钟1000+文章采集。

6、批量发布到普通博客/网站内容cms上。

优采云智能文章采集如何使用系统?

1、download优采云智能文章采集系统,点击运行,登录账号密码。

2、添加新任务,打开新任务设置窗口。

(1)先填写唯一的任务名称(一般按网站列或分类名称,也可以自己取,主要是为了方便识别)。

(2).设置网页代码,在目标网页的源代码中查看网页代码,选择对应的代码(只要代码正确,任何语言都可以识别)。

(3)生成到分类网址列表中,也可以添加单个网址,也可以将多个网址整理成TXT,逐行分批导入。

文章采集组合工具(优采云万能文章采集器,优采云软件出品的一款基于高精度正文识别算法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-08-31 00:10

优采云万能文章采集器,由优采云software 文章采集器出品的基于高精度文本识别算法的互联网,支持关键词采集百度For等搜索引擎新闻源和泛网页,支持采集指定网站栏下的所有文章。

优采云万能文章采集器

软件介绍

由优采云software 文章采集器出品的基于高精度文本识别算法的互联网。支持按关键词采集各大搜索引擎的新闻和网页,也支持采集指定网站栏目下的所有文章。基于优采云自主研发的文本识别智能算法,可以从互联网上复杂的网页中尽可能准确地提取文本内容。

文本识别有 3 种算法,“标准”、“严格”和“精确标签”。其中“standard”和“strict”是自动模式,可以适应大部分网页的body提取,而“precision tag”只需要指定body标签头,比如“div class="text” ""。提取所有网页的正文。

关键词采集目前支持搜索引擎:百度、搜狗、360、谷歌、必应、雅虎

采集指定网站文章的功能也很简单,只需要一点点设置(没有复杂的规则),就可以批量采集target网站文章。

因为墙的问题,要使用谷歌搜索和谷歌翻译文章的功能,需要更改国外IP。

内置文章翻译功能,即文章可以从一种语言(如中文)转换为另一种语言(如英语),再由英语返回中文。

采集文章+翻译伪原创可以满足站长和各领域朋友对文章的需求。

一些公关处理和信息研究公司需要的专业公司开发的信息采集系统往往售价几万甚至更多,而优采云的软件也是一个信息采集系统功能和市场上昂贵的软件有相似之处,但价格只有几百元,你会知道如何尝试性价比。

更新日志

URL采集文章面板精准标签添加模糊匹配功能;增加定时任务功能,可设置多个时间点,自动启动采集(当前显示面板采集的启动)。 查看全部

文章采集组合工具(优采云万能文章采集器,优采云软件出品的一款基于高精度正文识别算法)

优采云万能文章采集器,由优采云software 文章采集器出品的基于高精度文本识别算法的互联网,支持关键词采集百度For等搜索引擎新闻源和泛网页,支持采集指定网站栏下的所有文章。

优采云万能文章采集器

软件介绍

由优采云software 文章采集器出品的基于高精度文本识别算法的互联网。支持按关键词采集各大搜索引擎的新闻和网页,也支持采集指定网站栏目下的所有文章。基于优采云自主研发的文本识别智能算法,可以从互联网上复杂的网页中尽可能准确地提取文本内容。

文本识别有 3 种算法,“标准”、“严格”和“精确标签”。其中“standard”和“strict”是自动模式,可以适应大部分网页的body提取,而“precision tag”只需要指定body标签头,比如“div class="text” ""。提取所有网页的正文。

关键词采集目前支持搜索引擎:百度、搜狗、360、谷歌、必应、雅虎

采集指定网站文章的功能也很简单,只需要一点点设置(没有复杂的规则),就可以批量采集target网站文章。

因为墙的问题,要使用谷歌搜索和谷歌翻译文章的功能,需要更改国外IP。

内置文章翻译功能,即文章可以从一种语言(如中文)转换为另一种语言(如英语),再由英语返回中文。

采集文章+翻译伪原创可以满足站长和各领域朋友对文章的需求。

一些公关处理和信息研究公司需要的专业公司开发的信息采集系统往往售价几万甚至更多,而优采云的软件也是一个信息采集系统功能和市场上昂贵的软件有相似之处,但价格只有几百元,你会知道如何尝试性价比。

更新日志

URL采集文章面板精准标签添加模糊匹配功能;增加定时任务功能,可设置多个时间点,自动启动采集(当前显示面板采集的启动)。

文章采集组合工具(文章采集json格式的消息通知通知下载包)

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2021-08-30 13:02

文章采集组合工具方案摘要上篇我们介绍了采集html格式的消息通知,今天我们就来简单聊聊采集json格式的消息通知。关键字消息通知一般可分为两种,一种是json格式的,另一种是html格式的。两种格式就会有不同的转换工具,下面介绍的八个工具大多都是只支持json格式的。

一、采集html格式的消息通知

1、jsoncommerce下载httpclient下载的教程可以查看《httpclient下载教程》,接下来我们来看c#接口对接后获取的url是怎么被json解析的。先通过connectionhandler接口对接方法进行,代码:$this->setonchange(false);通过这种方式做了一个时刻钟的监听器,监听两端之间的事件。

时钟的时候,发送给对方,对方的下一个时刻来了,再继续监听。发现这两个方法的不同,this->register是针对这个时刻,而this->show时刻是面向别人的。我们知道httpclient中接口是由httpclientroot类进行的对接操作,而时刻钟的对接操作是从setonchange方法开始的。所以从事件监听来分析,发现一个变量xxx来设置这个时刻号,而show时刻是在register之后。

2、jsonbutton2下载webview下载webview包是下载什么工具呢?webview包含两个api,crossover和startconnection,而webview包含crossover和startconnection。首先下载jsonbutton2的工具包,解压安装:$extract-crossover$webkitcom.js下载:$chrome/chrome.exe下载完了之后,放在extract标签页下,搜索crossover和startconnection,将其加入到路径:extract就ok了。

3、以为jsonurl处理后,获取全部消息或处理json格式的消息通知,或收到全部消息这是httpclient刚提供了的接口来完成的,代码:$this->extractobjectmap下载了一个mmapid之后,我们会获取到这个消息url的urlheaderheaderurlfromvalue什么都没有就直接处理这个消息通知。

$this->setonchange(false);这里是不要忘记设置防止阻塞的app。$this->setonchange(false);使用json通讯和请求(post/get/string/bsonstring/statushttp)this->setonchange(false);监听这个json通讯的到来$this->onpostformurl(url)就可以进行编写json数据方法了$this->onpostformrequest这里我们可以定义string和bsonstring方法$this->onpostmessage这个接口的代码:$this->onpostmessage(url.parse_bson.get())这个是在get类型的json数据就进行一次get请求,这里只有对json数据请求,没有对url的请求。$this-。 查看全部

文章采集组合工具(文章采集json格式的消息通知通知下载包)

文章采集组合工具方案摘要上篇我们介绍了采集html格式的消息通知,今天我们就来简单聊聊采集json格式的消息通知。关键字消息通知一般可分为两种,一种是json格式的,另一种是html格式的。两种格式就会有不同的转换工具,下面介绍的八个工具大多都是只支持json格式的。

一、采集html格式的消息通知

1、jsoncommerce下载httpclient下载的教程可以查看《httpclient下载教程》,接下来我们来看c#接口对接后获取的url是怎么被json解析的。先通过connectionhandler接口对接方法进行,代码:$this->setonchange(false);通过这种方式做了一个时刻钟的监听器,监听两端之间的事件。

时钟的时候,发送给对方,对方的下一个时刻来了,再继续监听。发现这两个方法的不同,this->register是针对这个时刻,而this->show时刻是面向别人的。我们知道httpclient中接口是由httpclientroot类进行的对接操作,而时刻钟的对接操作是从setonchange方法开始的。所以从事件监听来分析,发现一个变量xxx来设置这个时刻号,而show时刻是在register之后。

2、jsonbutton2下载webview下载webview包是下载什么工具呢?webview包含两个api,crossover和startconnection,而webview包含crossover和startconnection。首先下载jsonbutton2的工具包,解压安装:$extract-crossover$webkitcom.js下载:$chrome/chrome.exe下载完了之后,放在extract标签页下,搜索crossover和startconnection,将其加入到路径:extract就ok了。

3、以为jsonurl处理后,获取全部消息或处理json格式的消息通知,或收到全部消息这是httpclient刚提供了的接口来完成的,代码:$this->extractobjectmap下载了一个mmapid之后,我们会获取到这个消息url的urlheaderheaderurlfromvalue什么都没有就直接处理这个消息通知。

$this->setonchange(false);这里是不要忘记设置防止阻塞的app。$this->setonchange(false);使用json通讯和请求(post/get/string/bsonstring/statushttp)this->setonchange(false);监听这个json通讯的到来$this->onpostformurl(url)就可以进行编写json数据方法了$this->onpostformrequest这里我们可以定义string和bsonstring方法$this->onpostmessage这个接口的代码:$this->onpostmessage(url.parse_bson.get())这个是在get类型的json数据就进行一次get请求,这里只有对json数据请求,没有对url的请求。$this-。

文章采集组合工具(同步mysql增量数据的工具Canal,本篇文章的大纲)

采集交流 • 优采云 发表了文章 • 0 个评论 • 306 次浏览 • 2021-08-30 03:13

Lao Liu 是一名即将找到工作的二年级研究生。写博客一方面是总结大数据开发的知识点,另一方面是希望能帮助小伙伴们在不求人的情况下进行自学。由于老刘是大数据开发自学,所以博客肯定会有一些不足,还望大家批评指正,一起进步!

背景

大数据领域的数据来源包括业务数据库的数据,以及移动终端的数据和服务器产生的日志数据。当我们采集数据时,可以根据下游数据的不同要求,使用不同的采集工具来做。今天老刘给大家介绍一下Canal,一款mysql增量数据同步工具。本文文章的大纲如下:

Canal的概念mysql中主备复制的原理Canal如何同步MySQL中的数据Canal的HA机制设计了各种数据同步方案的简单总结

老刘力求用这篇文章让大家直接使用Canal工具,而不是花其他时间学习。

mysql主从复制实现原理

既然是用Canal来同步mysql中的增量数据,那么小刘先讲一下mysql的主备复制原理,再讲一下Canal的核心知识。

根据这张图,老刘将mysql的主备复制原理分解为以下几个过程:

主服务器必须先启动二进制日志binlog,用于记录任何修改数据库数据的事件。主服务器将数据更改记录到二进制 binlog 日志中。从服务器会将主服务器的二进制日志复制到其本地中继日志(Relaylog)。这一步详细说,首先slave server会启动一个worker thread I/O线程,I/O线程会和主库建立一个普通的client单连接,然后启动一个特殊的二进制转储(binlog dump)线程,这个binlog dump 线程会读取主服务器上二进制日志中的事件,然后将二进制事件发送到I/O线程并保存在从服务器上的中继日志中。从服务器启动SQL线程,从中继日志中读取二进制日志,在从服务器本地进行数据修改操作,从服务器更新数据。

那么mysql主/备复制的实现原理就结束了。看完这个流程,你能猜到Canal是怎么工作的吗?

Canal 核心知识点 Canal 工作原理

Canal 的工作原理是模拟 MySQL slave 的交互协议,伪装成 MySQL slave,向 MySQL master 发起 dump 协议。 MySQL master收到转储请求后,会开始推送binlog到Canal。最后,Canal 会解析 binlog 对象。

运河概念

Canal,美国的[kəˈnæl],读成这样,意思是水路/管道/渠道。主要目的是同步MySQL中的增量数据(可以理解为实时数据)。它是阿里巴巴的子公司。用纯 Java 开发的开源项目。

运河建筑

server代表canal的一个运行实例,对应一个JVM。 Instance对应一个数据队列,1个canal server对应instanceinstance下的1..n子模块:

EventParser:数据源访问,模拟salve协议和master的交互,协议分析EventSink:Parser和Store链接器,数据过滤、处理、分发。 EventStore:数据存储 MetaManager:增量订阅消费信息管理

说完了Canal的基本概念,接下来我们来谈谈Canal是如何同步mysql的增量数据的。

canal同步mysql增量数据并打开mysql binlog

我们使用Canal同步mysql增量数据的前提是开启了mysql的binlog。阿里云的mysql数据库默认开启了binlog,但是如果我们自己安装mysql,需要手动开启binlog日志功能。

首先找到mysql配置文件:

etc/my.cnf

server-id=1

log-bin=mysql-bin

binlog-format=ROW

这里有一个关于binlog格式的知识点,老刘来告诉你。

binlog的三种格式:STATEMENT、ROW、MIXED

ROW 模式(通常使用它)

日志会记录每行数据被修改的形式。它不会记录 SQL 语句执行的上下文相关信息。它只会记录要修改的数据,修改了哪些数据,修改了哪些数据。只有值,没有SQL多表关联的情况。

优点:它只需要记录修改了哪条数据,是什么样子的,所以它的日志内容会非常清楚地记录每一行数据修改的细节,非常容易理解。

缺点:在ROW模式下,尤其是添加数据时,所有执行的语句都会被记录到日志中,并且会随着每一行记录的修改而被记录下来,会产生大量的日志内容。

语句模式

每一条修改数据的 SQL 语句都会被记录。

缺点:因为是记录的执行语句,为了让这些语句在slave端正确执行,他还必须记录每条语句执行过程中的一些相关信息,即上下文信息。确保所有语句在从端执行时都能得到与在主端执行时相同的结果。

但是目前,例如在某些版本中无法正确复制 step() 函数。存储过程中使用了last-insert-id()函数,可能会导致slave和master上的ID不一致。 ROW模式下没有数据不一致。

混合模式

同时使用上述两种模式。

canal实时同步首先我们需要配置环境,在conf/example/instance.properties下:

## mysql serverId

canal.instance.mysql.slaveId = 1234

#position info,需要修改成自己的数据库信息

canal.instance.master.address = 127.0.0.1:3306

canal.instance.master.journal.name =

canal.instance.master.position =

canal.instance.master.timestamp =

#canal.instance.standby.address =

#canal.instance.standby.journal.name =

#canal.instance.standby.position =

#canal.instance.standby.timestamp =

#username/password,需要修改成自己的数据库信息

canal.instance.dbUsername = canal

canal.instance.dbPassword = canal

canal.instance.defaultDatabaseName =

canal.instance.connectionCharset = UTF-8

#table regex

canal.instance.filter.regex = .\*\\\\..\*

其中canal.instance.connectionCharset表示java中编码类型对应的数据库的编码方式,如UTF-8、GBK、ISO-8859-1。

配置完成后,就要开始了

sh bin/startup.sh

关闭使用 bin/stop.sh

观察日志

一般用cat查看canal/canal.log,example/example.log

启动客户端

IDEA业务代码中,如果mysql中有增量数据,拉入IDEA控制台打印出来

在 pom.xml 文件中添加:

com.alibaba.otter

canal.client

1.0.12

添加客户端代码:

public class Demo {

public static void main(String[] args) {

//创建连接

CanalConnector connector = CanalConnectors.newSingleConnector(new InetSocketAddress("hadoop03", 11111),

"example", "", "");

connector.connect();

//订阅

connector.subscribe();

connector.rollback();

int batchSize = 1000;

int emptyCount = 0;

int totalEmptyCount = 100;

while (totalEmptyCount > emptyCount) {

Message msg = connector.getWithoutAck(batchSize);

long id = msg.getId();

List entries = msg.getEntries();

if(id == -1 || entries.size() == 0){

emptyCount++;

System.out.println("emptyCount : " + emptyCount);

try {

Thread.sleep(3000);

} catch (InterruptedException e) {

e.printStackTrace();

}

}else{

emptyCount = 0;

printEntry(entries);

}

connector.ack(id);

}

}

// batch -> entries -> rowchange - rowdata -> cols

private static void printEntry(List entries) {

for (CanalEntry.Entry entry : entries){

if(entry.getEntryType() == CanalEntry.EntryType.TRANSACTIONBEGIN ||

entry.getEntryType() == CanalEntry.EntryType.TRANSACTIONEND){

continue;

}

CanalEntry.RowChange rowChange = null;

try {

rowChange = CanalEntry.RowChange.parseFrom(entry.getStoreValue());

} catch (InvalidProtocolBufferException e) {

e.printStackTrace();

}

CanalEntry.EventType eventType = rowChange.getEventType();

System.out.println(entry.getHeader().getLogfileName()+" __ " +

entry.getHeader().getSchemaName() + " __ " + eventType);

List rowDatasList = rowChange.getRowDatasList();

for(CanalEntry.RowData rowData : rowDatasList){

for(CanalEntry.Column column: rowData.getAfterColumnsList()){

System.out.println(column.getName() + " - " +

column.getValue() + " - " +

column.getUpdated());

}

}

}

}

}

在mysql中写入数据,客户端将增量数据打印到控制台。 Canal的HA机制设计

大数据领域的很多框架都会有HA机制。运河的HA分为两部分。 Canal 服务器和 Canal 客户端有相应的 HA 实现:

canal server:为了减少mysql dump的请求,不同服务器上的实例要求同一时间只有一个实例在运行,其他的都处于standby状态。 Canal客户端:为了保证有序,一个canal客户端只能同时对一个实例进行get/ack/rollback操作,否则无法保证客户端的接收顺序。

整个HA机制的控制主要依赖ZooKeeper的几个特性,ZooKeeper在此不再赘述。

运河服务器:

canal server 想要启动canal 实例时,会先尝试对ZooKeeper 进行启动判断(创建一个EPHEMERAL 节点,谁启动谁成功)。 ZooKeeper节点创建成功后,对应的canal服务器会启动对应的canal实例,未成功创建的canal实例会进入standby状态。 ZooKeeper一旦发现canal server创建的节点消失了,会立即通知其他canal server重新执行步骤1,重新选择canal server启动实例。 canal客户端每次连接时,都会先询问谁启动了canal实例的ZooKeeper,然后再与其建立连接。一旦连接不可用,它将尝试再次连接。 canal client的方法和canal server类似,也是使用ZooKeeper抢占EPHEMERAL节点的方法进行控制。

配置Canal HA并实时同步数据到Kafka。

修改conf/canal.properties文件

canal.zkServers = hadoop02:2181,hadoop03:2181,hadoop04:2181

canal.serverMode = kafka

canal.mq.servers = hadoop02:9092,hadoop03:9092,hadoop04:9092

配置 conf/example/example.instance

canal.instance.mysql.slaveId = 790 /两台canal server的slaveID唯一

canal.mq.topic = canal_log //指定将数据发送到kafka的topic

数据同步计划总结

说完Canal工具,现在给大家简单总结一下目前常用的数据采集tool。不涉及架构知识,简单总结给大家一个印象。

常见的data采集工具包括:DataX、Flume、Canal、Sqoop、LogStash等

DataX(处理离线数据)

DataX是阿里巴巴开源的异构数据源离线同步工具。异构数据源的离线同步是指将数据从源同步到目的地。但是,端到端数据源的类型很多。在DataX存在之前,端到端的链路会形成复杂的网状结构,非常碎片化,无法抽象出同步核心逻辑。

为了解决异构数据源的同步问题,DataX将复杂的Mesh同步链路改造成了星型数据链路,DataX作为中间传输载体负责连接各种数据源。

所以,当你需要连接一个新的数据源时,你只需要将这个数据源连接到DataX,就可以和现有的数据源无缝同步数据。

DataX本身作为离线数据同步框架,采用Framework+plugin架构构建。数据源读写被抽象为Reader/Writer插件,并纳入整个同步框架。

Reader:是data采集模块,负责采集data源的数据,并将数据发送给Framework。 Writer:是数据写入模块,负责不断地从Framework中获取数据,并将数据写入目的地。 Framework:用于连接Reader和Writer,作为两者之间的数据传输通道,处理缓冲、并发、数据转换等问题。

DataX的核心架构如下图:

核心模块介绍:

DataX 完成单个数据同步作业。我们称之为工作。 DataX收到一个作业后,会启动一个进程来完成整个作业同步过程。 DataX Job启动后,会根据不同的源切分策略,分成多个小Task(子任务),方便并发执行。拆分多个任务后,DataX Job 会调用Scheduler 模块,根据配置的并发数据量重新组合拆分的任务,组装成一个TaskGroup(任务组)。每个 TaskGroup 负责以一定的并发量运行所有分配的任务。单个任务组的默认并发任务数为 5。每个任务由 TaskGroup 启动。 Task启动后,会启动Reader->Channel->Writer线程完成任务同步工作。 DataX作业完成后,作业会监听并等待多个TaskGroup模块任务的完成,等待所有TaskGroup任务完成后作业成功退出。否则异常退出。 Flume(处理实时数据)

Flume 的主要应用场景是同步日志数据,主要收录三个组件:Source、Channel、Sink。

Flume 最大的优势是官网提供了丰富的 Source、Channel、Sink。根据不同的业务需求,我们可以在官网找到相关的配置。此外,Flume 还提供了自定义这些组件的接口。

Logstash(处理离线数据)

Logstash 是一个具有实时数据传输能力的管道,负责将数据信息从管道的输入端传输到管道的输出端;同时,这个pipeline还允许你根据自己的需要在中间添加过滤Net,Logstash提供了很多强大的过滤器来满足各种应用场景。

Logstash 由 JRuby 编写,使用简单的基于消息的架构,并在 JVM 上运行。管道中的数据流称为事件,分为输入阶段、过滤阶段和输出阶段。

Sqoop(处理离线数据)

Sqoop 是一种用于在 Hadoop 和关系数据库之间传输数据的工具。用于将数据从MySQL等关系数据库导出到Hadoop的HDFS,从Hadoop文件系统导出到关系数据库。 Sqoop底层还是MapReducer,使用时一定要注意数据倾斜。

总结

老刘的文章文章主要介绍了Canal工具的核心知识点以及它们的数据对比采集tools。其中data采集tools只是大体讲概念和应用,目的是为了让大家有个印象。老刘敢保证,看完这个文章,基本就相当于入门了,剩下的就是练习了。

好了,mysql增量数据同步工具Canal的内容就讲完了。虽然现在的水平可能不如大哥们,但老刘会努力变得更好,让所有的朋友都自学,从不求人!

如有相关问题,请联系公众号:努力工作的老刘。 文章看到了,喜欢这个,关注支持一波! 查看全部

文章采集组合工具(同步mysql增量数据的工具Canal,本篇文章的大纲)

Lao Liu 是一名即将找到工作的二年级研究生。写博客一方面是总结大数据开发的知识点,另一方面是希望能帮助小伙伴们在不求人的情况下进行自学。由于老刘是大数据开发自学,所以博客肯定会有一些不足,还望大家批评指正,一起进步!

背景

大数据领域的数据来源包括业务数据库的数据,以及移动终端的数据和服务器产生的日志数据。当我们采集数据时,可以根据下游数据的不同要求,使用不同的采集工具来做。今天老刘给大家介绍一下Canal,一款mysql增量数据同步工具。本文文章的大纲如下:

Canal的概念mysql中主备复制的原理Canal如何同步MySQL中的数据Canal的HA机制设计了各种数据同步方案的简单总结

老刘力求用这篇文章让大家直接使用Canal工具,而不是花其他时间学习。

mysql主从复制实现原理

既然是用Canal来同步mysql中的增量数据,那么小刘先讲一下mysql的主备复制原理,再讲一下Canal的核心知识。

根据这张图,老刘将mysql的主备复制原理分解为以下几个过程:

主服务器必须先启动二进制日志binlog,用于记录任何修改数据库数据的事件。主服务器将数据更改记录到二进制 binlog 日志中。从服务器会将主服务器的二进制日志复制到其本地中继日志(Relaylog)。这一步详细说,首先slave server会启动一个worker thread I/O线程,I/O线程会和主库建立一个普通的client单连接,然后启动一个特殊的二进制转储(binlog dump)线程,这个binlog dump 线程会读取主服务器上二进制日志中的事件,然后将二进制事件发送到I/O线程并保存在从服务器上的中继日志中。从服务器启动SQL线程,从中继日志中读取二进制日志,在从服务器本地进行数据修改操作,从服务器更新数据。

那么mysql主/备复制的实现原理就结束了。看完这个流程,你能猜到Canal是怎么工作的吗?

Canal 核心知识点 Canal 工作原理

Canal 的工作原理是模拟 MySQL slave 的交互协议,伪装成 MySQL slave,向 MySQL master 发起 dump 协议。 MySQL master收到转储请求后,会开始推送binlog到Canal。最后,Canal 会解析 binlog 对象。

运河概念

Canal,美国的[kəˈnæl],读成这样,意思是水路/管道/渠道。主要目的是同步MySQL中的增量数据(可以理解为实时数据)。它是阿里巴巴的子公司。用纯 Java 开发的开源项目。

运河建筑

server代表canal的一个运行实例,对应一个JVM。 Instance对应一个数据队列,1个canal server对应instanceinstance下的1..n子模块:

EventParser:数据源访问,模拟salve协议和master的交互,协议分析EventSink:Parser和Store链接器,数据过滤、处理、分发。 EventStore:数据存储 MetaManager:增量订阅消费信息管理

说完了Canal的基本概念,接下来我们来谈谈Canal是如何同步mysql的增量数据的。

canal同步mysql增量数据并打开mysql binlog

我们使用Canal同步mysql增量数据的前提是开启了mysql的binlog。阿里云的mysql数据库默认开启了binlog,但是如果我们自己安装mysql,需要手动开启binlog日志功能。

首先找到mysql配置文件:

etc/my.cnf

server-id=1

log-bin=mysql-bin

binlog-format=ROW

这里有一个关于binlog格式的知识点,老刘来告诉你。

binlog的三种格式:STATEMENT、ROW、MIXED

ROW 模式(通常使用它)

日志会记录每行数据被修改的形式。它不会记录 SQL 语句执行的上下文相关信息。它只会记录要修改的数据,修改了哪些数据,修改了哪些数据。只有值,没有SQL多表关联的情况。

优点:它只需要记录修改了哪条数据,是什么样子的,所以它的日志内容会非常清楚地记录每一行数据修改的细节,非常容易理解。

缺点:在ROW模式下,尤其是添加数据时,所有执行的语句都会被记录到日志中,并且会随着每一行记录的修改而被记录下来,会产生大量的日志内容。

语句模式

每一条修改数据的 SQL 语句都会被记录。

缺点:因为是记录的执行语句,为了让这些语句在slave端正确执行,他还必须记录每条语句执行过程中的一些相关信息,即上下文信息。确保所有语句在从端执行时都能得到与在主端执行时相同的结果。

但是目前,例如在某些版本中无法正确复制 step() 函数。存储过程中使用了last-insert-id()函数,可能会导致slave和master上的ID不一致。 ROW模式下没有数据不一致。

混合模式

同时使用上述两种模式。

canal实时同步首先我们需要配置环境,在conf/example/instance.properties下:

## mysql serverId

canal.instance.mysql.slaveId = 1234

#position info,需要修改成自己的数据库信息

canal.instance.master.address = 127.0.0.1:3306

canal.instance.master.journal.name =

canal.instance.master.position =

canal.instance.master.timestamp =

#canal.instance.standby.address =

#canal.instance.standby.journal.name =

#canal.instance.standby.position =

#canal.instance.standby.timestamp =

#username/password,需要修改成自己的数据库信息

canal.instance.dbUsername = canal

canal.instance.dbPassword = canal

canal.instance.defaultDatabaseName =

canal.instance.connectionCharset = UTF-8

#table regex

canal.instance.filter.regex = .\*\\\\..\*

其中canal.instance.connectionCharset表示java中编码类型对应的数据库的编码方式,如UTF-8、GBK、ISO-8859-1。

配置完成后,就要开始了

sh bin/startup.sh

关闭使用 bin/stop.sh

观察日志

一般用cat查看canal/canal.log,example/example.log

启动客户端

IDEA业务代码中,如果mysql中有增量数据,拉入IDEA控制台打印出来

在 pom.xml 文件中添加:

com.alibaba.otter

canal.client

1.0.12

添加客户端代码:

public class Demo {

public static void main(String[] args) {

//创建连接

CanalConnector connector = CanalConnectors.newSingleConnector(new InetSocketAddress("hadoop03", 11111),

"example", "", "");

connector.connect();

//订阅

connector.subscribe();

connector.rollback();

int batchSize = 1000;

int emptyCount = 0;

int totalEmptyCount = 100;

while (totalEmptyCount > emptyCount) {

Message msg = connector.getWithoutAck(batchSize);

long id = msg.getId();

List entries = msg.getEntries();

if(id == -1 || entries.size() == 0){

emptyCount++;

System.out.println("emptyCount : " + emptyCount);

try {

Thread.sleep(3000);

} catch (InterruptedException e) {

e.printStackTrace();

}

}else{

emptyCount = 0;

printEntry(entries);

}

connector.ack(id);

}

}

// batch -> entries -> rowchange - rowdata -> cols

private static void printEntry(List entries) {

for (CanalEntry.Entry entry : entries){

if(entry.getEntryType() == CanalEntry.EntryType.TRANSACTIONBEGIN ||

entry.getEntryType() == CanalEntry.EntryType.TRANSACTIONEND){

continue;

}

CanalEntry.RowChange rowChange = null;

try {

rowChange = CanalEntry.RowChange.parseFrom(entry.getStoreValue());

} catch (InvalidProtocolBufferException e) {

e.printStackTrace();

}

CanalEntry.EventType eventType = rowChange.getEventType();

System.out.println(entry.getHeader().getLogfileName()+" __ " +

entry.getHeader().getSchemaName() + " __ " + eventType);

List rowDatasList = rowChange.getRowDatasList();

for(CanalEntry.RowData rowData : rowDatasList){

for(CanalEntry.Column column: rowData.getAfterColumnsList()){

System.out.println(column.getName() + " - " +

column.getValue() + " - " +

column.getUpdated());

}

}

}

}

}

在mysql中写入数据,客户端将增量数据打印到控制台。 Canal的HA机制设计

大数据领域的很多框架都会有HA机制。运河的HA分为两部分。 Canal 服务器和 Canal 客户端有相应的 HA 实现:

canal server:为了减少mysql dump的请求,不同服务器上的实例要求同一时间只有一个实例在运行,其他的都处于standby状态。 Canal客户端:为了保证有序,一个canal客户端只能同时对一个实例进行get/ack/rollback操作,否则无法保证客户端的接收顺序。

整个HA机制的控制主要依赖ZooKeeper的几个特性,ZooKeeper在此不再赘述。

运河服务器:

canal server 想要启动canal 实例时,会先尝试对ZooKeeper 进行启动判断(创建一个EPHEMERAL 节点,谁启动谁成功)。 ZooKeeper节点创建成功后,对应的canal服务器会启动对应的canal实例,未成功创建的canal实例会进入standby状态。 ZooKeeper一旦发现canal server创建的节点消失了,会立即通知其他canal server重新执行步骤1,重新选择canal server启动实例。 canal客户端每次连接时,都会先询问谁启动了canal实例的ZooKeeper,然后再与其建立连接。一旦连接不可用,它将尝试再次连接。 canal client的方法和canal server类似,也是使用ZooKeeper抢占EPHEMERAL节点的方法进行控制。

配置Canal HA并实时同步数据到Kafka。

修改conf/canal.properties文件

canal.zkServers = hadoop02:2181,hadoop03:2181,hadoop04:2181

canal.serverMode = kafka

canal.mq.servers = hadoop02:9092,hadoop03:9092,hadoop04:9092

配置 conf/example/example.instance

canal.instance.mysql.slaveId = 790 /两台canal server的slaveID唯一

canal.mq.topic = canal_log //指定将数据发送到kafka的topic

数据同步计划总结

说完Canal工具,现在给大家简单总结一下目前常用的数据采集tool。不涉及架构知识,简单总结给大家一个印象。

常见的data采集工具包括:DataX、Flume、Canal、Sqoop、LogStash等

DataX(处理离线数据)

DataX是阿里巴巴开源的异构数据源离线同步工具。异构数据源的离线同步是指将数据从源同步到目的地。但是,端到端数据源的类型很多。在DataX存在之前,端到端的链路会形成复杂的网状结构,非常碎片化,无法抽象出同步核心逻辑。

为了解决异构数据源的同步问题,DataX将复杂的Mesh同步链路改造成了星型数据链路,DataX作为中间传输载体负责连接各种数据源。

所以,当你需要连接一个新的数据源时,你只需要将这个数据源连接到DataX,就可以和现有的数据源无缝同步数据。

DataX本身作为离线数据同步框架,采用Framework+plugin架构构建。数据源读写被抽象为Reader/Writer插件,并纳入整个同步框架。

Reader:是data采集模块,负责采集data源的数据,并将数据发送给Framework。 Writer:是数据写入模块,负责不断地从Framework中获取数据,并将数据写入目的地。 Framework:用于连接Reader和Writer,作为两者之间的数据传输通道,处理缓冲、并发、数据转换等问题。

DataX的核心架构如下图:

核心模块介绍:

DataX 完成单个数据同步作业。我们称之为工作。 DataX收到一个作业后,会启动一个进程来完成整个作业同步过程。 DataX Job启动后,会根据不同的源切分策略,分成多个小Task(子任务),方便并发执行。拆分多个任务后,DataX Job 会调用Scheduler 模块,根据配置的并发数据量重新组合拆分的任务,组装成一个TaskGroup(任务组)。每个 TaskGroup 负责以一定的并发量运行所有分配的任务。单个任务组的默认并发任务数为 5。每个任务由 TaskGroup 启动。 Task启动后,会启动Reader->Channel->Writer线程完成任务同步工作。 DataX作业完成后,作业会监听并等待多个TaskGroup模块任务的完成,等待所有TaskGroup任务完成后作业成功退出。否则异常退出。 Flume(处理实时数据)

Flume 的主要应用场景是同步日志数据,主要收录三个组件:Source、Channel、Sink。

Flume 最大的优势是官网提供了丰富的 Source、Channel、Sink。根据不同的业务需求,我们可以在官网找到相关的配置。此外,Flume 还提供了自定义这些组件的接口。

Logstash(处理离线数据)

Logstash 是一个具有实时数据传输能力的管道,负责将数据信息从管道的输入端传输到管道的输出端;同时,这个pipeline还允许你根据自己的需要在中间添加过滤Net,Logstash提供了很多强大的过滤器来满足各种应用场景。

Logstash 由 JRuby 编写,使用简单的基于消息的架构,并在 JVM 上运行。管道中的数据流称为事件,分为输入阶段、过滤阶段和输出阶段。

Sqoop(处理离线数据)

Sqoop 是一种用于在 Hadoop 和关系数据库之间传输数据的工具。用于将数据从MySQL等关系数据库导出到Hadoop的HDFS,从Hadoop文件系统导出到关系数据库。 Sqoop底层还是MapReducer,使用时一定要注意数据倾斜。

总结

老刘的文章文章主要介绍了Canal工具的核心知识点以及它们的数据对比采集tools。其中data采集tools只是大体讲概念和应用,目的是为了让大家有个印象。老刘敢保证,看完这个文章,基本就相当于入门了,剩下的就是练习了。

好了,mysql增量数据同步工具Canal的内容就讲完了。虽然现在的水平可能不如大哥们,但老刘会努力变得更好,让所有的朋友都自学,从不求人!

如有相关问题,请联系公众号:努力工作的老刘。 文章看到了,喜欢这个,关注支持一波!

文章采集组合工具(智能采集优采云采集可根据不同网站提供网站公开数据)

采集交流 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-08-28 23:17

优采云采集器 是任何需要从网络获取信息的孩子的必备神器。这是一个可以让你的信息采集变得非常简单的工具。 优采云改变了互联网上传统的数据思维方式,让用户在互联网上抓取和编译数据变得越来越容易。

功能说明

简单采集

简单的采集模式内置了数百个主流的网站数据源,比如京东、天猫、大众点评等流行的采集网站。只需参考模板设置参数即可快速获取网站。 @公共数据。

Smart采集

优采云采集可根据网站的不同提供多种网页采集策略及配套资源,可定制配置、组合使用、自动化处理。从而帮助采集整个流程实现数据的完整性和稳定性。

云采集

云采集,5000多台云服务器支持,7*24小时运行,可实现定时采集,无需人员值班,灵活适配业务场景,助您提升采集效率,并保证数据的及时性。

API 接口

通过优采云API,可以轻松获取采集接收到的优采云任务信息和数据,灵活调度任务,如远程控制任务启停,高效实现数据采集和归档。基于强大的API系统,还可以与公司各种内部管理平台无缝对接,实现各种业务自动化。

自定义采集

根据采集不同用户的需求,优采云可以提供自定义模式自动生成爬虫,可以批量准确识别各种网页元素,以及翻页、下拉、ajax、页面滚动、条件判断等。此类功能支持不同网页结构的复杂网站采集,满足多种采集应用场景。

方便的定时功能

只需简单几步,点击设置即可实现采集任务的定时控制,无论是单个采集定时设置,还是预设日或周、月定时采集。同时自由设置多个任务,根据需要进行多种选择时间组合,灵活部署自己的采集任务。

自动数据格式化

优采云内置强大的数据格式化引擎,支持字符串替换、正则表达式替换或匹配、去除空格、添加前缀或后缀、日期时间格式化、HTML转码等诸多功能,采集该过程是全自动的,无需人工干预即可获取所需格式的数据。

多级采集

许多主流新闻和电商网站包括一级商品列表页、二级商品详情页、三级评论详情页;不管网站有多少层,优采云任何采集数据都可以无限,满足采集各种业务需求。

登录后支持网站采集

优采云内置采集登录模块,只需配置目标网站的账号密码,即可使用该模块采集登录数据;同时优采云还拥有采集Cookie自定义功能,首次登录后可自动记住cookies,免去多次输入密码的繁琐,支持更多网站采集。 查看全部

文章采集组合工具(智能采集优采云采集可根据不同网站提供网站公开数据)

优采云采集器 是任何需要从网络获取信息的孩子的必备神器。这是一个可以让你的信息采集变得非常简单的工具。 优采云改变了互联网上传统的数据思维方式,让用户在互联网上抓取和编译数据变得越来越容易。

功能说明

简单采集

简单的采集模式内置了数百个主流的网站数据源,比如京东、天猫、大众点评等流行的采集网站。只需参考模板设置参数即可快速获取网站。 @公共数据。

Smart采集

优采云采集可根据网站的不同提供多种网页采集策略及配套资源,可定制配置、组合使用、自动化处理。从而帮助采集整个流程实现数据的完整性和稳定性。

云采集

云采集,5000多台云服务器支持,7*24小时运行,可实现定时采集,无需人员值班,灵活适配业务场景,助您提升采集效率,并保证数据的及时性。

API 接口

通过优采云API,可以轻松获取采集接收到的优采云任务信息和数据,灵活调度任务,如远程控制任务启停,高效实现数据采集和归档。基于强大的API系统,还可以与公司各种内部管理平台无缝对接,实现各种业务自动化。

自定义采集

根据采集不同用户的需求,优采云可以提供自定义模式自动生成爬虫,可以批量准确识别各种网页元素,以及翻页、下拉、ajax、页面滚动、条件判断等。此类功能支持不同网页结构的复杂网站采集,满足多种采集应用场景。

方便的定时功能

只需简单几步,点击设置即可实现采集任务的定时控制,无论是单个采集定时设置,还是预设日或周、月定时采集。同时自由设置多个任务,根据需要进行多种选择时间组合,灵活部署自己的采集任务。

自动数据格式化

优采云内置强大的数据格式化引擎,支持字符串替换、正则表达式替换或匹配、去除空格、添加前缀或后缀、日期时间格式化、HTML转码等诸多功能,采集该过程是全自动的,无需人工干预即可获取所需格式的数据。

多级采集

许多主流新闻和电商网站包括一级商品列表页、二级商品详情页、三级评论详情页;不管网站有多少层,优采云任何采集数据都可以无限,满足采集各种业务需求。

登录后支持网站采集

优采云内置采集登录模块,只需配置目标网站的账号密码,即可使用该模块采集登录数据;同时优采云还拥有采集Cookie自定义功能,首次登录后可自动记住cookies,免去多次输入密码的繁琐,支持更多网站采集。

优采云软件出品之友情链接、自定义接口站群的友情链接批量管理工具

采集交流 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-08-23 23:20

优采云software 出品了多种主流cms站群、自定义界面站群友情链接批量管理工具。可以批量添加删除好友,也可以站群互链。自定义接口用于直接修改自定义模板调用的好友链文件(html;asp;php等),一般在服务器端使用。这个软件的使用类似于优采云的系列站群文章updater,就是添加好站点列表,全局设置添加删除好友链接(作用于所有勾选的站点),然后启动站群 更新。支持导入优采云系列站群更新器配置文件(同名软件.ini),但请在导入前设置相应的程序类型。登录测试:用于检测当前站点配置是否可以登录或读取。如果可以,软件会自动保存站点已有的更改(即点击【保存】按钮的效果)。域名:可以是“”或“”等顶级域名,也可以是二级域名“”,也可以是子目录“/zml”。 “E/admin”,如果没有目录可以直接进入后台文件,比如“admin.php”或者“login.asp”。如果将其留空,则将使用默认后端。不知道的建议留空,除非自己改了后端路径,需要手动填写。编码:网站的编码,不懂就选自动。其他:问题、答案和认证参数只需要特定程序如Empirecms,其他程序可以忽略。

接口:当程序类型为自定义接口时有效,可以是本地接口文件,也可以是网络接口文件,用于读取接口中已有的好友链列表进行增删改查。如果是相对路径,则视为(相对域名根目录)网络接口文件。 start:接口文件中好友链表的开始标志,留空读取到接口文件前端:接口文件中朋友链表的结束标志,留空读取到接口文件的末尾接口文件输出:修改后保存接口如果没有设置有效本地路径:1、如果接口来自本地,保存到接口的原创路径(适合在服务器上直接修改和覆盖)2、如果接口来自网络,保存到本地化版本的网络路径(需要上传到网站上的对应文件覆盖)。右击“..”按钮打开接口文件并定位到输出文件------------------------------- -- --------------------添加好友链:每行一条好友链,每条好友链使用|分隔多个参数,如:站点名称|站点地址|标识地址 删除好友链接:只要现有好友链接中收录匹配的内容(站点名称或站点地址或站点ID),则该好友链接将被删除删除。多个匹配内容以 | 分隔将被批量删除。对于WordPress,只能识别为文字好友链接,因此不适用于删除所有图片好友链接。删除否定的朋友链:默认是删除匹配的朋友链,否定则保留匹配的朋友链,不匹配的朋友链将被删除。

站群互友链:本软件添加的所有已打勾的站点都是相互链接的。当站点数量较多时,相互链接可能不合适,在执行相互链接之前,您可能需要批量检查某些站点。站点列表多选:按住ctlr自动勾选站点;选择起始站点,按住Shift键再选择结束站点,勾选区间内的所有站点(默认情况下,区间外的勾选将被清除,如果要保留原来的勾选,可以按住Ctrl键同时更新)同时更新站点数:但可以设置同时更新站点数。每个站点更新后,下一个站点将开始补充,以保持设定的站点数量同时更新,直到更新所有站点。全局保存:将所有站点配置写入文件。一般不需要手动点击,正常关闭软件时会自动执行,但是可以通过添加所有站点,点击一次来防止意外。每个站点都是独立配置的,修改后需要点击保存按钮。试用版:可以自由添加和删除好友链接,但添加好友链接时软件链接会自动附加,删除好友链接时禁止删除软件链接,功能相同的除外以正式版为准。

优采云站群友链管理系统v1.3.1.0 更新说明:新增2个批量导入参数设置

查看全部

优采云软件出品之友情链接、自定义接口站群的友情链接批量管理工具

优采云software 出品了多种主流cms站群、自定义界面站群友情链接批量管理工具。可以批量添加删除好友,也可以站群互链。自定义接口用于直接修改自定义模板调用的好友链文件(html;asp;php等),一般在服务器端使用。这个软件的使用类似于优采云的系列站群文章updater,就是添加好站点列表,全局设置添加删除好友链接(作用于所有勾选的站点),然后启动站群 更新。支持导入优采云系列站群更新器配置文件(同名软件.ini),但请在导入前设置相应的程序类型。登录测试:用于检测当前站点配置是否可以登录或读取。如果可以,软件会自动保存站点已有的更改(即点击【保存】按钮的效果)。域名:可以是“”或“”等顶级域名,也可以是二级域名“”,也可以是子目录“/zml”。 “E/admin”,如果没有目录可以直接进入后台文件,比如“admin.php”或者“login.asp”。如果将其留空,则将使用默认后端。不知道的建议留空,除非自己改了后端路径,需要手动填写。编码:网站的编码,不懂就选自动。其他:问题、答案和认证参数只需要特定程序如Empirecms,其他程序可以忽略。

接口:当程序类型为自定义接口时有效,可以是本地接口文件,也可以是网络接口文件,用于读取接口中已有的好友链列表进行增删改查。如果是相对路径,则视为(相对域名根目录)网络接口文件。 start:接口文件中好友链表的开始标志,留空读取到接口文件前端:接口文件中朋友链表的结束标志,留空读取到接口文件的末尾接口文件输出:修改后保存接口如果没有设置有效本地路径:1、如果接口来自本地,保存到接口的原创路径(适合在服务器上直接修改和覆盖)2、如果接口来自网络,保存到本地化版本的网络路径(需要上传到网站上的对应文件覆盖)。右击“..”按钮打开接口文件并定位到输出文件------------------------------- -- --------------------添加好友链:每行一条好友链,每条好友链使用|分隔多个参数,如:站点名称|站点地址|标识地址 删除好友链接:只要现有好友链接中收录匹配的内容(站点名称或站点地址或站点ID),则该好友链接将被删除删除。多个匹配内容以 | 分隔将被批量删除。对于WordPress,只能识别为文字好友链接,因此不适用于删除所有图片好友链接。删除否定的朋友链:默认是删除匹配的朋友链,否定则保留匹配的朋友链,不匹配的朋友链将被删除。

站群互友链:本软件添加的所有已打勾的站点都是相互链接的。当站点数量较多时,相互链接可能不合适,在执行相互链接之前,您可能需要批量检查某些站点。站点列表多选:按住ctlr自动勾选站点;选择起始站点,按住Shift键再选择结束站点,勾选区间内的所有站点(默认情况下,区间外的勾选将被清除,如果要保留原来的勾选,可以按住Ctrl键同时更新)同时更新站点数:但可以设置同时更新站点数。每个站点更新后,下一个站点将开始补充,以保持设定的站点数量同时更新,直到更新所有站点。全局保存:将所有站点配置写入文件。一般不需要手动点击,正常关闭软件时会自动执行,但是可以通过添加所有站点,点击一次来防止意外。每个站点都是独立配置的,修改后需要点击保存按钮。试用版:可以自由添加和删除好友链接,但添加好友链接时软件链接会自动附加,删除好友链接时禁止删除软件链接,功能相同的除外以正式版为准。

优采云站群友链管理系统v1.3.1.0 更新说明:新增2个批量导入参数设置

成都三鼎网络技术企业对消费者网址SEO提高的平常流程

采集交流 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-08-23 02:26

虽然seo优化维护是大家常说的难点,但能做好的事情却很少。以下是成都三鼎互联网科技公司为大家提升消费类网站SEO的常用流程。希望更多的网站网站站长会有所帮助。

1、检查是否跳转,如果没有,设置

2、检查是否有404错误页面

3、检查 URL 中是否存在根文本文档

4、检查是否有sitmapsitemap.xml

5、检查友情链接的质量

6、check 分析master关键词和sequence关键词【顺序关键词---顺序词】

7、查看网页网页:

A:标题检查【标题在30字以内,主要是到第二遍,包括2到3个关键词,最后还有网站名字。例如:自动智能锁_登录密码指纹密码锁_智能密码锁_Keseda智能锁]

B:关键词check [关键词 控制在四点。主到下一个seo数据监管顺序]

C:描述检查【描述控制在80字以内,句子要流畅,包括2~3个问题关键词之内】

D: h1 logo check【每个网页智能系统的网页都有一个H1的logo来放置最重要的内容,文章网页网页用于主题,栏目名称使用H2,新闻报道主题H3]

E:照片替代检查

8:内容质量检查 [

1》文章原学位证和文章插图图片,

2》文章插画图片需要加alt标签

3》文章topic 应该是 SEO关键词combined permutation 转换成代码转换器:包括一个关键词,或者一个长尾关键词关键词关键词

4》文章 描述200字以内,流畅,收录2个关键词。

5》文章内容原创度必须在90%以上,包括文章中的三个关键词,每个在文章head,文章中间,SEO关键词组合排列转换为代码转换器:文章结尾。

6》文章内容做1对2内部连接

]

9:内容每天连网搜索,360投稿。 【你每天关注新文章后,一定要转换成网站,并且一定要提交连接到百度和360。如果你有独立域名的手机网页,也一定要搜索手机网页到PC网页的具体地址,熊掌号,360提交]

10:SEO综合检查[

1》使用site命令:site:查找网页搜索pc的网站收录数量

2"使用第三方工具查询

]

11:每天在百度和360上找关键词。如果排在最前面,你可以找到并点击它。如果前面没有排序,使用:关键词域名查找。

热门搜索词 查看全部

成都三鼎网络技术企业对消费者网址SEO提高的平常流程

虽然seo优化维护是大家常说的难点,但能做好的事情却很少。以下是成都三鼎互联网科技公司为大家提升消费类网站SEO的常用流程。希望更多的网站网站站长会有所帮助。

1、检查是否跳转,如果没有,设置

2、检查是否有404错误页面

3、检查 URL 中是否存在根文本文档

4、检查是否有sitmapsitemap.xml

5、检查友情链接的质量

6、check 分析master关键词和sequence关键词【顺序关键词---顺序词】

7、查看网页网页:

A:标题检查【标题在30字以内,主要是到第二遍,包括2到3个关键词,最后还有网站名字。例如:自动智能锁_登录密码指纹密码锁_智能密码锁_Keseda智能锁]

B:关键词check [关键词 控制在四点。主到下一个seo数据监管顺序]

C:描述检查【描述控制在80字以内,句子要流畅,包括2~3个问题关键词之内】

D: h1 logo check【每个网页智能系统的网页都有一个H1的logo来放置最重要的内容,文章网页网页用于主题,栏目名称使用H2,新闻报道主题H3]

E:照片替代检查

8:内容质量检查 [

1》文章原学位证和文章插图图片,

2》文章插画图片需要加alt标签

3》文章topic 应该是 SEO关键词combined permutation 转换成代码转换器:包括一个关键词,或者一个长尾关键词关键词关键词

4》文章 描述200字以内,流畅,收录2个关键词。

5》文章内容原创度必须在90%以上,包括文章中的三个关键词,每个在文章head,文章中间,SEO关键词组合排列转换为代码转换器:文章结尾。

6》文章内容做1对2内部连接

]

9:内容每天连网搜索,360投稿。 【你每天关注新文章后,一定要转换成网站,并且一定要提交连接到百度和360。如果你有独立域名的手机网页,也一定要搜索手机网页到PC网页的具体地址,熊掌号,360提交]

10:SEO综合检查[

1》使用site命令:site:查找网页搜索pc的网站收录数量

2"使用第三方工具查询

]

11:每天在百度和360上找关键词。如果排在最前面,你可以找到并点击它。如果前面没有排序,使用:关键词域名查找。

热门搜索词

使用教程中有采集器7.6破解版7.67.6

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-08-23 02:21

详细介绍

为了让网站services等行业的工作更轻松,小编为大家带来优采云采集器7.6破解版,是一款轻松获取所有目标网站的内容,具有功能强大、操作简单、配置快捷高效等特点,受到越来越多用户的喜爱。与一般的采集器相比,该软件具有采集速度快、内容丰富、采集操作非常准确,是目前使用最广泛的网络资源采集软件。另外,在使用这个软件进行数据采集时,并不是一味的采集,它分为两步,一是数据采集,另一个是直接贴到它的网站。用户无需再次编辑内容然后发布到网站。而且具体操作并不难。为了让大家清楚地了解这款软件的具体操作过程,小编为大家带来了教程。教程中有详细的操作步骤,可以一步一步完成。在您掌握了本软件的操作后,您可以在网站中随意获取您需要的任何数据内容,现在就来试试吧!

软件功能

1、几乎所有的网页都可以采集

不管什么语言,不管什么编码

2、 和复制粘贴一样准确

采集/发布就像复制粘贴一样准确,用户想要的都是精华,哪有遗漏

3、 比普通采集器 快 7 倍

优采云采集器采用顶级系统配置,反复优化性能,让采集飞得够快

4、网站采集的同义词

独特的十年经验和行业领先品牌,想到网页采集,想到优采云采集器

软件功能

1、无级多页采集,可以达到无限深度采集

2、Task队列操作管理,支持Cron表达式

3、无限组任务管理,任务回收站功能

4、RSS 地址采集function

5、List页面分页采集Get函数

6、List页面附加参数获取功能

7、List 页面和标签 XPath 视觉提取功能

8、tag 纯正则替换函数 查看全部

使用教程中有采集器7.6破解版7.67.6

详细介绍

为了让网站services等行业的工作更轻松,小编为大家带来优采云采集器7.6破解版,是一款轻松获取所有目标网站的内容,具有功能强大、操作简单、配置快捷高效等特点,受到越来越多用户的喜爱。与一般的采集器相比,该软件具有采集速度快、内容丰富、采集操作非常准确,是目前使用最广泛的网络资源采集软件。另外,在使用这个软件进行数据采集时,并不是一味的采集,它分为两步,一是数据采集,另一个是直接贴到它的网站。用户无需再次编辑内容然后发布到网站。而且具体操作并不难。为了让大家清楚地了解这款软件的具体操作过程,小编为大家带来了教程。教程中有详细的操作步骤,可以一步一步完成。在您掌握了本软件的操作后,您可以在网站中随意获取您需要的任何数据内容,现在就来试试吧!

软件功能

1、几乎所有的网页都可以采集

不管什么语言,不管什么编码

2、 和复制粘贴一样准确

采集/发布就像复制粘贴一样准确,用户想要的都是精华,哪有遗漏

3、 比普通采集器 快 7 倍

优采云采集器采用顶级系统配置,反复优化性能,让采集飞得够快

4、网站采集的同义词

独特的十年经验和行业领先品牌,想到网页采集,想到优采云采集器

软件功能

1、无级多页采集,可以达到无限深度采集

2、Task队列操作管理,支持Cron表达式

3、无限组任务管理,任务回收站功能

4、RSS 地址采集function

5、List页面分页采集Get函数

6、List页面附加参数获取功能

7、List 页面和标签 XPath 视觉提取功能

8、tag 纯正则替换函数

文章采集组合工具apigateway和scrapy都可以很方便的实现

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-08-22 07:06

文章采集组合工具apigateway和scrapy都可以很方便的实现。文章采集器#examples/tweets1.采集多个站点站点:采集结果:2.采集不同站点结果:#examples/tweets3.采集不同站点的摘要结果:#examples/tweetsscrapyscrapy-crawler/tweets4.采集不同站点的摘要摘要:#examples/tweets。

可以根据需要结合采集策略、采集策略设置、请求头设置等参数设置数据抓取规则。例如:关键字采集、搜索引擎采集、全文搜索等,搜索引擎抓取网址为,

谢邀!这篇文章提供了一些分析。分析下来确实效果不好!而且不一定适合你的需求。简单说就是看,还有说,

谢邀。肯定不行。做百度挖坟,首页全是想要的文章。其他数据都没有。

去油库发文章的数据都能用api。

百度挖坟可以使用api,可是我不知道行不行,别的地方应该也有api。

谢邀!非常实用的工具:不适合百度挖坟

现在最新版的百度挖坟api也有关键字的功能,但是我没有用过。百度上说说关键字会推荐当前某分类的文章,和实际验证没有什么关系。原理是通过网站给你的url,然后返回一个html的链接,那么你可以通过这个链接打开指定的分类内的网站。缺点是跨网站,api有时会失效。(比如我现在用的api前端跳转),我做互联网的,写爬虫的都知道发文章的时候收藏夹图标不能出现文章链接,我用api因为用的都是同一个网站,可以直接使用,不用管当前哪一个页面会出现图标链接。

如果是每个网站要找出来太麻烦。也有可能是我对api的理解不是很准确。我以前看ga的视频,有讲这些的,我觉得这应该是个漏洞,会有人把有网站的api文档给更新了,建议给个什么前端分析器,人家直接可以用了,你是可以直接使用。 查看全部

文章采集组合工具apigateway和scrapy都可以很方便的实现

文章采集组合工具apigateway和scrapy都可以很方便的实现。文章采集器#examples/tweets1.采集多个站点站点:采集结果:2.采集不同站点结果:#examples/tweets3.采集不同站点的摘要结果:#examples/tweetsscrapyscrapy-crawler/tweets4.采集不同站点的摘要摘要:#examples/tweets。

可以根据需要结合采集策略、采集策略设置、请求头设置等参数设置数据抓取规则。例如:关键字采集、搜索引擎采集、全文搜索等,搜索引擎抓取网址为,

谢邀!这篇文章提供了一些分析。分析下来确实效果不好!而且不一定适合你的需求。简单说就是看,还有说,

谢邀。肯定不行。做百度挖坟,首页全是想要的文章。其他数据都没有。

去油库发文章的数据都能用api。

百度挖坟可以使用api,可是我不知道行不行,别的地方应该也有api。

谢邀!非常实用的工具:不适合百度挖坟

现在最新版的百度挖坟api也有关键字的功能,但是我没有用过。百度上说说关键字会推荐当前某分类的文章,和实际验证没有什么关系。原理是通过网站给你的url,然后返回一个html的链接,那么你可以通过这个链接打开指定的分类内的网站。缺点是跨网站,api有时会失效。(比如我现在用的api前端跳转),我做互联网的,写爬虫的都知道发文章的时候收藏夹图标不能出现文章链接,我用api因为用的都是同一个网站,可以直接使用,不用管当前哪一个页面会出现图标链接。

如果是每个网站要找出来太麻烦。也有可能是我对api的理解不是很准确。我以前看ga的视频,有讲这些的,我觉得这应该是个漏洞,会有人把有网站的api文档给更新了,建议给个什么前端分析器,人家直接可以用了,你是可以直接使用。

一次性多个网站统一采集的关键词是什么?

采集交流 • 优采云 发表了文章 • 0 个评论 • 148 次浏览 • 2021-08-18 22:03

文章采集组合工具,即用多个采集工具同时采集,一个目录需要一次或多次操作。如果想要一次性采集多个网站,可以一次性多个网站进行统一采集。

一、查看网站已添加了哪些关键词:首先找到采集采集工具右下角的【新增关键词】按钮,输入你想采集的网站名称,或者是首页/栏目页等等。我们选择一个新建关键词,选择【查看其他添加的关键词】点击鼠标右键,看到新增什么关键词。

二、新建关键词:将上面所新建的关键词全部选中,在弹出的框中选择【查看其他添加的关键词】看我们的网站,都有哪些关键词,选择哪些关键词一目了然。

三、关键词已添加,可采集哪些网站:点击右键,选择【选择对应的关键词】可在【选择对应的关键词】列表中看到我们想要的网站,通过这个关键词可以采集到这个网站下全部的网站。

四、查看我的已通过关键词:在【已通过关键词】列表中,可以看到我已经通过我的关键词新建了一个网站,具体是哪个网站,通过关键词来查看。文章采集组合工具,即用多个采集工具同时采集,一个目录需要一次或多次操作。如果想要一次性多个网站进行统一采集,可以一次性多个网站进行统一采集。

wordpress右键可以看到采集选项,采集的时候会匹配所有已经生成的链接列表。其他的工具和插件可能支持,但是具体原理还是要自己看网上的教程。 查看全部

一次性多个网站统一采集的关键词是什么?

文章采集组合工具,即用多个采集工具同时采集,一个目录需要一次或多次操作。如果想要一次性采集多个网站,可以一次性多个网站进行统一采集。

一、查看网站已添加了哪些关键词:首先找到采集采集工具右下角的【新增关键词】按钮,输入你想采集的网站名称,或者是首页/栏目页等等。我们选择一个新建关键词,选择【查看其他添加的关键词】点击鼠标右键,看到新增什么关键词。

二、新建关键词:将上面所新建的关键词全部选中,在弹出的框中选择【查看其他添加的关键词】看我们的网站,都有哪些关键词,选择哪些关键词一目了然。

三、关键词已添加,可采集哪些网站:点击右键,选择【选择对应的关键词】可在【选择对应的关键词】列表中看到我们想要的网站,通过这个关键词可以采集到这个网站下全部的网站。

四、查看我的已通过关键词:在【已通过关键词】列表中,可以看到我已经通过我的关键词新建了一个网站,具体是哪个网站,通过关键词来查看。文章采集组合工具,即用多个采集工具同时采集,一个目录需要一次或多次操作。如果想要一次性多个网站进行统一采集,可以一次性多个网站进行统一采集。

wordpress右键可以看到采集选项,采集的时候会匹配所有已经生成的链接列表。其他的工具和插件可能支持,但是具体原理还是要自己看网上的教程。

优采云文章组合工具集起到文本随机组合的效力(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2021-08-16 23:30

网络媒体平台使用的稿件等文字内容,去掉完全原创的部分,基本都是伪原创,原因也是速度和内容质量的取舍,优采云 文章组合工具集合具有文字随机组合的效果。一般建议网站管理员安装。由于关键词在搜索引擎中的曝光度和权重排名,原创度和数量的组合必须密切关注。

优采云文章组合工具集软件特点

1.全新场景布局设计,结构简洁简洁,基本操作相同但更易理解易用

2.Element 库元素不再显示勾选框,防止误判(只需勾选元素库,勾选元素库涉及盗用,不需要勾选元素)

3. 显示大段文本不再耗时,并且具有行号显示和元素语法高亮。

4.更强大的删除恢复性能,更强大的树搜索性能

5.各种新颖的辅助工具(包括新编写的长尾词采集器),可以完成更多的文本处理需求。

6.预览时有预览标题设置,结果就像转换一样。

7.图书馆的显示顺序不再被打乱

8. 很多其他方面,比如整体性能和功能。

优采云文章组合工具集软件性能

重点表现:写一个模板,使用模板中的元素,任意定位使用任意元素。元素可以被问天智块盗用,可以是随机的汉字、数字、字母或编号序列、随机值和随机时间。全免费原创组合形式。

特殊技术:元素应用元素(两种形式:元素组合其他元素和静态元素名称嵌套盗用),完成繁琐的上下文管理,使最终组合的句子千变万化

优采云文章组合工具集操作语句

1.建议经常备份顺序数据文件夹

2.主场景布局右下角的选项控制键可以导入“原创文章converter”的序列数据(必须导入,不容易看懂的文件拷贝)

3.order data.rar 文件用于演示,以后可以解压到软件目录下,然后从头打开软件

综合评价

原创文字和伪原创文字有各自的地位和对立面。最明显的一个是质量率控制。自然,每天发送的内容数量是完全不同的。整个优采云文章组合工具 合集可以同时处理多个文本内容,一键替换全新的关键词信息,尝试以搜索引擎收录为目的编辑。

看了这么多,你下载了优采云文章combination 工具集无限制了吗?想下载最新的软件,快来软件爱好者的趣味游戏、通俗易懂的软件教程、爽快的玩法,都在这里,更多精彩不容错过! 查看全部

优采云文章组合工具集起到文本随机组合的效力(组图)

网络媒体平台使用的稿件等文字内容,去掉完全原创的部分,基本都是伪原创,原因也是速度和内容质量的取舍,优采云 文章组合工具集合具有文字随机组合的效果。一般建议网站管理员安装。由于关键词在搜索引擎中的曝光度和权重排名,原创度和数量的组合必须密切关注。

优采云文章组合工具集软件特点

1.全新场景布局设计,结构简洁简洁,基本操作相同但更易理解易用

2.Element 库元素不再显示勾选框,防止误判(只需勾选元素库,勾选元素库涉及盗用,不需要勾选元素)

3. 显示大段文本不再耗时,并且具有行号显示和元素语法高亮。

4.更强大的删除恢复性能,更强大的树搜索性能

5.各种新颖的辅助工具(包括新编写的长尾词采集器),可以完成更多的文本处理需求。

6.预览时有预览标题设置,结果就像转换一样。

7.图书馆的显示顺序不再被打乱

8. 很多其他方面,比如整体性能和功能。

优采云文章组合工具集软件性能

重点表现:写一个模板,使用模板中的元素,任意定位使用任意元素。元素可以被问天智块盗用,可以是随机的汉字、数字、字母或编号序列、随机值和随机时间。全免费原创组合形式。

特殊技术:元素应用元素(两种形式:元素组合其他元素和静态元素名称嵌套盗用),完成繁琐的上下文管理,使最终组合的句子千变万化

优采云文章组合工具集操作语句

1.建议经常备份顺序数据文件夹

2.主场景布局右下角的选项控制键可以导入“原创文章converter”的序列数据(必须导入,不容易看懂的文件拷贝)

3.order data.rar 文件用于演示,以后可以解压到软件目录下,然后从头打开软件

综合评价

原创文字和伪原创文字有各自的地位和对立面。最明显的一个是质量率控制。自然,每天发送的内容数量是完全不同的。整个优采云文章组合工具 合集可以同时处理多个文本内容,一键替换全新的关键词信息,尝试以搜索引擎收录为目的编辑。

看了这么多,你下载了优采云文章combination 工具集无限制了吗?想下载最新的软件,快来软件爱好者的趣味游戏、通俗易懂的软件教程、爽快的玩法,都在这里,更多精彩不容错过!

官方版软件支持脚踏开关采集、鼠标采集实时图像的说明

采集交流 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2021-08-16 00:23

B超图文报表助手工具正式版是一款专业的B超图文图片采集管理软件。最新版B超图文报表助手工具支持所有符合微软VFW、DirectShow、WDM等标准的采集卡。同时适配大多数采集卡和所有Windows系统是该公司软件的独特功能。 B超图文报表辅助工具正式版支持脚踏开关采集、鼠标采集、键盘采集。即使不显示视频画面,也可以使用脚踏开关采集实时图像。

类似软件

版本说明

软件地址

B超图文报告辅助工具基本介绍

B超图文报表助手工具是B超图文采集管理平台。该工具具有图像处理、文件查询和统计功能。它非常简单且易于操作。同时,这个工具还可以让工作人员的工作变得更有效率。

B超图文报表辅助工具功能介绍

1、视频采集卡:支持所有符合微软VFW、DirectShow、WDM等标准的采集卡。同时适配大多数采集卡和所有Windows系统是公司软件的独特之处。

2、视频显示:工作站软件支持叠加显示(图像从采集卡直接发送到显卡,不占用CPU资源)。

3、采集 方法:软件支持脚踏开关采集、鼠标采集、键盘采集。即使不显示视频画面,也可以使用脚踏开关采集实时图像。

4、动态伪彩:软件支持实时(25帧/秒)全屏纯软件动态伪彩。

5、Software 支持视频录制。

6、软件可以存储医生姓名、科室、所在地、诊断结论等常用信息,以备日后输入。

7、DICOM 支持:可升级为DICOM版工作站,支持ICOM传输、DICOM存储、DICOM打印。 8、Query:软件使用SQL语言进行模糊查询。可以单独或组合查询数据库中的每个字段。查询结果可集中备份或删除,可直接备份至光盘。

9、Statistics:软件可以根据查询不同字段得到的结果打印报表。例如,可以统计某个医生某月的诊断次数,某医生某月的就诊次数,并打印出报表。 .

10、图像处理:软件支持标定、长度和面积测量、滤色和伪色、亮度和对比度调整、文本和区域标注等基本图像处理功能,专用软件还支持自己的图像处理函数。

11、Report:使用所见即所得的报表格式,操作者就像在实际的报表上书写,输入打印的位置。

12、自定义报表格式:软件报表格式可以随意修改。您可以随意调整报表中任意图片和任意文字的位置。

B超图文报告辅助工具使用方法

环境要求:PIII以上的电脑,内存1G以上最好,视频采集卡。建议使用1024X768以上的显示分辨率。

安装:解压安装包,运行文件Setup_D.exe,按照提示操作。

操作:安装完成后,点击开始>所有程序>通亿B-scan作为报表助手工具,即可启动软件。

1、图片采集:相信大家看到下图就不用重复了。不过我还是想介绍一个小技巧。首先,如果你想查看已经采集的图片,可以双击它,系统会放大显示,方便你查看;其次,如果您对采集图片不满意,可以选择不满意的图片,然后单击删除将其删除。您也可以在拍照模式选择重拍,然后点击拍照替换不满意的图片。

2、Write report:在上图中,点击Write Report按钮,进入报告编写窗口。

窗口顶部按钮说明:

A.生成报告。用正式的报告模板显示新填写的图形报告,以便打印给患者。此时如果发现刚才的输入有问题,可以关闭正式报告,回来继续修改,然后再次点击Generate Report打印更正。但是,如果点击后退按钮或直接关闭窗口,则无法修改报表,只能到历史报表统计中学习打印。

B.描述模板按钮带您进入所谓的B超报告模板维护模块,了解B超报告模板维护。

C.报告模板按钮可让您维护一个正式的报告模板,如医院名称、报告格式等。

3、描述模板维护:为了方便您的使用,我们根据检查位置对描述模板进行分类。您可以在每个检验项目下维护相关的描述模板。因此,需要在维护模板之前建立检查项目。另外需要注意的是,以下模板代码可以针对不同的检验项目重复使用。比如你勾选下面肝脏下的多个描述,可以从1开始编码,下面的描述模板也可以从1开始编码,不会混淆。但是,同一检查项下的描述模板代码不得重复!

(1)巡检项维护:为了区分层次,我们采用树状的结果展示。您可以通过添加或删除节点来维护您的巡检项。重要提示:已维护描述模板的项是通用的不要删除,否则属于它的描述模板将找不到归属。

B超图文报表辅助工具安装步骤

1.从pc下载网下载最新版B超图文报告辅助工具软件包

2.Unzip B-超声波图文报表辅助工具软件,运行文件

3.双击打开,进入B超图文报告辅助工具软件界面,点击下一步

4.请仔细阅读以下安装许可协议,是否接受以上许可协议的所有条款,点击我同意,点击下一步

5.选择目标位置,软件会安装在下面列出的文件夹中,要选择不同的位置,创建新路径,点击下一步

6.创建快捷方式文件夹,快捷方式图标会在下图所示的文件夹中创建。点击下一步

7.选择一个附加任务,安装软件时选择一个附加任务运行,点击下一步

8.Installer 现在已准备好在您的计算机上安装软件,点击安装以继续此安装程序

9.点击完成,B超图文报表辅助工具软件安装成功

B超图文报告辅助工具更新日志:

1. 修复了其他错误;

2.优化了软件的兼容性。

PCSOFT 编辑推荐:

B超图文报告辅助工具专业、操作简单、功能强大。它是软件行业的领导者之一。欢迎您下载。本站还提供初始页面、dw、i4等供您下载。 查看全部

官方版软件支持脚踏开关采集、鼠标采集实时图像的说明

B超图文报表助手工具正式版是一款专业的B超图文图片采集管理软件。最新版B超图文报表助手工具支持所有符合微软VFW、DirectShow、WDM等标准的采集卡。同时适配大多数采集卡和所有Windows系统是该公司软件的独特功能。 B超图文报表辅助工具正式版支持脚踏开关采集、鼠标采集、键盘采集。即使不显示视频画面,也可以使用脚踏开关采集实时图像。

类似软件

版本说明

软件地址

B超图文报告辅助工具基本介绍

B超图文报表助手工具是B超图文采集管理平台。该工具具有图像处理、文件查询和统计功能。它非常简单且易于操作。同时,这个工具还可以让工作人员的工作变得更有效率。

B超图文报表辅助工具功能介绍

1、视频采集卡:支持所有符合微软VFW、DirectShow、WDM等标准的采集卡。同时适配大多数采集卡和所有Windows系统是公司软件的独特之处。

2、视频显示:工作站软件支持叠加显示(图像从采集卡直接发送到显卡,不占用CPU资源)。

3、采集 方法:软件支持脚踏开关采集、鼠标采集、键盘采集。即使不显示视频画面,也可以使用脚踏开关采集实时图像。

4、动态伪彩:软件支持实时(25帧/秒)全屏纯软件动态伪彩。

5、Software 支持视频录制。

6、软件可以存储医生姓名、科室、所在地、诊断结论等常用信息,以备日后输入。

7、DICOM 支持:可升级为DICOM版工作站,支持ICOM传输、DICOM存储、DICOM打印。 8、Query:软件使用SQL语言进行模糊查询。可以单独或组合查询数据库中的每个字段。查询结果可集中备份或删除,可直接备份至光盘。

9、Statistics:软件可以根据查询不同字段得到的结果打印报表。例如,可以统计某个医生某月的诊断次数,某医生某月的就诊次数,并打印出报表。 .

10、图像处理:软件支持标定、长度和面积测量、滤色和伪色、亮度和对比度调整、文本和区域标注等基本图像处理功能,专用软件还支持自己的图像处理函数。

11、Report:使用所见即所得的报表格式,操作者就像在实际的报表上书写,输入打印的位置。

12、自定义报表格式:软件报表格式可以随意修改。您可以随意调整报表中任意图片和任意文字的位置。

B超图文报告辅助工具使用方法

环境要求:PIII以上的电脑,内存1G以上最好,视频采集卡。建议使用1024X768以上的显示分辨率。

安装:解压安装包,运行文件Setup_D.exe,按照提示操作。

操作:安装完成后,点击开始>所有程序>通亿B-scan作为报表助手工具,即可启动软件。

1、图片采集:相信大家看到下图就不用重复了。不过我还是想介绍一个小技巧。首先,如果你想查看已经采集的图片,可以双击它,系统会放大显示,方便你查看;其次,如果您对采集图片不满意,可以选择不满意的图片,然后单击删除将其删除。您也可以在拍照模式选择重拍,然后点击拍照替换不满意的图片。

2、Write report:在上图中,点击Write Report按钮,进入报告编写窗口。

窗口顶部按钮说明:

A.生成报告。用正式的报告模板显示新填写的图形报告,以便打印给患者。此时如果发现刚才的输入有问题,可以关闭正式报告,回来继续修改,然后再次点击Generate Report打印更正。但是,如果点击后退按钮或直接关闭窗口,则无法修改报表,只能到历史报表统计中学习打印。

B.描述模板按钮带您进入所谓的B超报告模板维护模块,了解B超报告模板维护。

C.报告模板按钮可让您维护一个正式的报告模板,如医院名称、报告格式等。

3、描述模板维护:为了方便您的使用,我们根据检查位置对描述模板进行分类。您可以在每个检验项目下维护相关的描述模板。因此,需要在维护模板之前建立检查项目。另外需要注意的是,以下模板代码可以针对不同的检验项目重复使用。比如你勾选下面肝脏下的多个描述,可以从1开始编码,下面的描述模板也可以从1开始编码,不会混淆。但是,同一检查项下的描述模板代码不得重复!

(1)巡检项维护:为了区分层次,我们采用树状的结果展示。您可以通过添加或删除节点来维护您的巡检项。重要提示:已维护描述模板的项是通用的不要删除,否则属于它的描述模板将找不到归属。

B超图文报表辅助工具安装步骤

1.从pc下载网下载最新版B超图文报告辅助工具软件包

2.Unzip B-超声波图文报表辅助工具软件,运行文件

3.双击打开,进入B超图文报告辅助工具软件界面,点击下一步

4.请仔细阅读以下安装许可协议,是否接受以上许可协议的所有条款,点击我同意,点击下一步

5.选择目标位置,软件会安装在下面列出的文件夹中,要选择不同的位置,创建新路径,点击下一步

6.创建快捷方式文件夹,快捷方式图标会在下图所示的文件夹中创建。点击下一步

7.选择一个附加任务,安装软件时选择一个附加任务运行,点击下一步

8.Installer 现在已准备好在您的计算机上安装软件,点击安装以继续此安装程序

9.点击完成,B超图文报表辅助工具软件安装成功

B超图文报告辅助工具更新日志:

1. 修复了其他错误;

2.优化了软件的兼容性。

PCSOFT 编辑推荐:

B超图文报告辅助工具专业、操作简单、功能强大。它是软件行业的领导者之一。欢迎您下载。本站还提供初始页面、dw、i4等供您下载。

爱采购搜好货会员发布软件-自动发布工具(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-08-13 04:12

发行搜索商品会员发布软件-自动发布工具

欢迎来电或扫码私聊,帮您详细解答!

一款替代人工,实现自动发布的软件!自动切换标题、内容、图片等,保证每天发布的文章都不一样。 原创度高、360、搜狗等各大搜索引擎赶紧抢!快去首页吧!

功能:自动发布软件、产品推广软件、自动发布软件、自动发布设备、发布软件b2b自动发布软件模拟人工b2b自动发布软件

软件支持自动随机生成标题,自动插入国家城市名称和任意结尾词,**自动发布标题对应的内容,自动上传图片,无数的句子可以组合成不同的原创contents

文章采集,处理,发布的产品标题和内容的重复率几乎为0。对于已经处理过B2B站费的会员,每天可以发布数千个站,是否发送到手?现在你可以用它来实现自动释放了!

在互联网时代,您可以点击阅读说明,也非常重视推广。现在有很多网络模式。小编整理了一些主流的推广方式,帮大家分析一些不足,供大家选择。详情可来电或加微信交流,互相学习。

目前各种推广模式有:

1.爱代购,平台,流量大

2.万词:整合多站,包管运营,价格实惠

3.博世企业汇,云商报:集成20多个站,覆盖面广,自动发布工具,操作简单

4.各大平台会员,价格优惠,软件免费发布(例如:化工产品、盛丰建材、88、51搜了等)

5.B2B平台发布软件等 查看全部

爱采购搜好货会员发布软件-自动发布工具(图)

发行搜索商品会员发布软件-自动发布工具

欢迎来电或扫码私聊,帮您详细解答!

一款替代人工,实现自动发布的软件!自动切换标题、内容、图片等,保证每天发布的文章都不一样。 原创度高、360、搜狗等各大搜索引擎赶紧抢!快去首页吧!

功能:自动发布软件、产品推广软件、自动发布软件、自动发布设备、发布软件b2b自动发布软件模拟人工b2b自动发布软件

软件支持自动随机生成标题,自动插入国家城市名称和任意结尾词,**自动发布标题对应的内容,自动上传图片,无数的句子可以组合成不同的原创contents

文章采集,处理,发布的产品标题和内容的重复率几乎为0。对于已经处理过B2B站费的会员,每天可以发布数千个站,是否发送到手?现在你可以用它来实现自动释放了!

在互联网时代,您可以点击阅读说明,也非常重视推广。现在有很多网络模式。小编整理了一些主流的推广方式,帮大家分析一些不足,供大家选择。详情可来电或加微信交流,互相学习。

目前各种推广模式有:

1.爱代购,平台,流量大

2.万词:整合多站,包管运营,价格实惠

3.博世企业汇,云商报:集成20多个站,覆盖面广,自动发布工具,操作简单

4.各大平台会员,价格优惠,软件免费发布(例如:化工产品、盛丰建材、88、51搜了等)

5.B2B平台发布软件等

地图查看与批量获取的代码以前,你知道吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-08-11 05:05

文章采集组合工具./tc3y5.html先从一个简单的批量下载地图入手,比如采集黑龙江,采集提供的地图数据,按照15天循环来,每天以前一天所有地图的结果作为训练集数据来训练模型,得到一个初始地图,可以按照下面的图片以z坐标转换为数值到获取。

我们在具体实现地图查看与批量获取的代码以前,有必要知道下面这些知识,对我们理解代码很有帮助:-dataset是一个数据收集数据,从target到目标会转换成数组形式,请尽可能每天输入这样的数据,以确保地图上显示上述提供的整数或整数对应的某种格式。比如我们用channel包含bgr/png/png4444格式,至少要是32位色彩。

-background是指地图上或者原始地图的背景,比如用polygon作为地图导航时可以导入这个数据。-max_beijing大小是地图大小,一个图片有1.9844亿像素,这个地图要大于这个范围的每一个像素,大部分时候超过1000万像素属于过多了,这里设置为99.9974。不然会造成影响显示。实际需要两个地图数据来显示,正北和正南上方是定位不到的,要切换在户外控制点显示。

一般显示3个定位点。-interlace_andinterlace_position算法:我们需要用到一个用定位点按照interlace_andinterlace_position的算法判断是否正确的一个系统。目前用的是最大道路截距法,见高德地图所用算法:基于实时的基于googlemap+实时轨迹+历史信息人工修正地图属性+当前页面更新轨迹等等,综合多种因素判断。

见下图,无知识点。-orchards的图片类型:多个几何类型的图片,这样你的查看代码对象才足够简单。-什么意思:googlemap+定位点+poi的地图数据是从一个官方服务器转发过来的,里面有一个invalidglobalcoordinates信息,也就是国家地理图,这个信息是不能用作路标信息的,要想查看地图invalid信息,首先需要把location改为geolocation,也就是可以查看具体的街道信息,不然invalid也不会显示,这个国家地理图就用不了了。

-接下来写程序,三步:1.按官方分享的算法基于mapstate构建地图;2.按照3个服务提供商如cloudgest、earthexplorer、indigo等信息网站查询invalid,然后确保有note;3.转换成pdf文件,准备作为本文测试用模型的数据。按照以上三步建立地图服务,发送用户请求。我们写代码,会发出两个请求,用来发送geolocation值以及poi对象。-android-当然也可以继续用原生服务发送数据给应用;-ios-如果单单polygon数据的话, 查看全部

地图查看与批量获取的代码以前,你知道吗?

文章采集组合工具./tc3y5.html先从一个简单的批量下载地图入手,比如采集黑龙江,采集提供的地图数据,按照15天循环来,每天以前一天所有地图的结果作为训练集数据来训练模型,得到一个初始地图,可以按照下面的图片以z坐标转换为数值到获取。

我们在具体实现地图查看与批量获取的代码以前,有必要知道下面这些知识,对我们理解代码很有帮助:-dataset是一个数据收集数据,从target到目标会转换成数组形式,请尽可能每天输入这样的数据,以确保地图上显示上述提供的整数或整数对应的某种格式。比如我们用channel包含bgr/png/png4444格式,至少要是32位色彩。

-background是指地图上或者原始地图的背景,比如用polygon作为地图导航时可以导入这个数据。-max_beijing大小是地图大小,一个图片有1.9844亿像素,这个地图要大于这个范围的每一个像素,大部分时候超过1000万像素属于过多了,这里设置为99.9974。不然会造成影响显示。实际需要两个地图数据来显示,正北和正南上方是定位不到的,要切换在户外控制点显示。

一般显示3个定位点。-interlace_andinterlace_position算法:我们需要用到一个用定位点按照interlace_andinterlace_position的算法判断是否正确的一个系统。目前用的是最大道路截距法,见高德地图所用算法:基于实时的基于googlemap+实时轨迹+历史信息人工修正地图属性+当前页面更新轨迹等等,综合多种因素判断。

见下图,无知识点。-orchards的图片类型:多个几何类型的图片,这样你的查看代码对象才足够简单。-什么意思:googlemap+定位点+poi的地图数据是从一个官方服务器转发过来的,里面有一个invalidglobalcoordinates信息,也就是国家地理图,这个信息是不能用作路标信息的,要想查看地图invalid信息,首先需要把location改为geolocation,也就是可以查看具体的街道信息,不然invalid也不会显示,这个国家地理图就用不了了。

-接下来写程序,三步:1.按官方分享的算法基于mapstate构建地图;2.按照3个服务提供商如cloudgest、earthexplorer、indigo等信息网站查询invalid,然后确保有note;3.转换成pdf文件,准备作为本文测试用模型的数据。按照以上三步建立地图服务,发送用户请求。我们写代码,会发出两个请求,用来发送geolocation值以及poi对象。-android-当然也可以继续用原生服务发送数据给应用;-ios-如果单单polygon数据的话,

文章采集组合工具(功能EasyPoi,简单免费的POI分析工具!(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 531 次浏览 • 2021-09-05 12:11

特点

EasyPoi,一个简单且免费的兴趣点分析工具!

1 获取中国指定行政区域内指定关键词的所有兴趣点(最小可以精确到街道);比如可以获取一个城市内所有的便利店、商场、超市、咖啡店、大学等信息,包括经纬度、省、市、区、街道等。

2 获取指定位置(地址或经纬度坐标)半径N公里内关键词指定的所有兴趣点。

3 合并批量获取国内多个行政区域内多个关键词的所有兴趣点信息。 \n例如可以同时获取成都、西安、上海三个指定城市的所有超市、商场和大学的数据。

运行界面

下载使用

在启动采集POI之前,请根据自己的情况安装合适的客户端。目前只支持windows环境。 mac环境在打包的时候一直遇到问题,打包失败。考虑到毕竟用macO的同学很少,就不先打包了。

以下是Windows客户端安装方法和常见问题的总结。

一个下载 EasyPoi Windows 客户端

天翼云盘下载地址(不含提取码):

/t/RbEFrafiI7Fb

百度网盘下载地址:

/s/1bMu15Iyi4n0DRHstqhBtWQ

提取码:6688

2 系统要求

•win7 64 位

•Win10 64 位

XP系统和32位系统未测试,不保证可以使用。

3 下载安装

①下载EasyPoi安装文件(.exe)

②关闭所有杀毒软件,如果是win10,可能被windows卫士屏蔽,请设置为允许。

③双击.exe文件开始安装

④安装完成后,在开始菜单或桌面找到EasyPoi快捷方式

⑤要启动EasyPoi,请右键点击EasyPoi的快捷方式,选择“以管理员身份运行”

4 采集Data 示例:

Excel 格式:

csv 格式:

mysql:

使用过程中常见的两个问题

安装完成后,在使用过程中可能会遇到以下问题:

1 安装时提示【权限不足,保存失败】

这是因为配置信息需要写在本地,这样下次打开的时候可以自动加载上次的配置信息。

解决方案

您需要右键单击 EasyPoi 快捷方式并选择“以管理员身份运行”

2 点击【运行】后,提示【百度地图ak无效! 】

本程序运行时需要调用百度地图的行政区划查询服务和百度地图的网址api服务,需要百度ak。

解决方案

您需要在百度地图开发者平台申请相应的api key,并在程序【设置】中填写正确的api key。

百度地图开发者ak应用链接:/apiconsole/center 查看全部

文章采集组合工具(功能EasyPoi,简单免费的POI分析工具!(组图))

特点

EasyPoi,一个简单且免费的兴趣点分析工具!

1 获取中国指定行政区域内指定关键词的所有兴趣点(最小可以精确到街道);比如可以获取一个城市内所有的便利店、商场、超市、咖啡店、大学等信息,包括经纬度、省、市、区、街道等。

2 获取指定位置(地址或经纬度坐标)半径N公里内关键词指定的所有兴趣点。

3 合并批量获取国内多个行政区域内多个关键词的所有兴趣点信息。 \n例如可以同时获取成都、西安、上海三个指定城市的所有超市、商场和大学的数据。

运行界面

下载使用

在启动采集POI之前,请根据自己的情况安装合适的客户端。目前只支持windows环境。 mac环境在打包的时候一直遇到问题,打包失败。考虑到毕竟用macO的同学很少,就不先打包了。

以下是Windows客户端安装方法和常见问题的总结。

一个下载 EasyPoi Windows 客户端

天翼云盘下载地址(不含提取码):

/t/RbEFrafiI7Fb

百度网盘下载地址:

/s/1bMu15Iyi4n0DRHstqhBtWQ

提取码:6688

2 系统要求

•win7 64 位

•Win10 64 位

XP系统和32位系统未测试,不保证可以使用。

3 下载安装

①下载EasyPoi安装文件(.exe)

②关闭所有杀毒软件,如果是win10,可能被windows卫士屏蔽,请设置为允许。

③双击.exe文件开始安装

④安装完成后,在开始菜单或桌面找到EasyPoi快捷方式

⑤要启动EasyPoi,请右键点击EasyPoi的快捷方式,选择“以管理员身份运行”

4 采集Data 示例:

Excel 格式:

csv 格式:

mysql:

使用过程中常见的两个问题

安装完成后,在使用过程中可能会遇到以下问题:

1 安装时提示【权限不足,保存失败】

这是因为配置信息需要写在本地,这样下次打开的时候可以自动加载上次的配置信息。

解决方案

您需要右键单击 EasyPoi 快捷方式并选择“以管理员身份运行”

2 点击【运行】后,提示【百度地图ak无效! 】

本程序运行时需要调用百度地图的行政区划查询服务和百度地图的网址api服务,需要百度ak。

解决方案

您需要在百度地图开发者平台申请相应的api key,并在程序【设置】中填写正确的api key。

百度地图开发者ak应用链接:/apiconsole/center

文章采集组合工具(快手andb站两大视频网站视频采集合集(一))

采集交流 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2021-09-04 19:03

文章采集组合工具使用#1:采集一些原创高质量视频,就会自动发布在一些b站、快手、优酷等应用中,文章采集组合工具使用#2:采集一些b站、快手、优酷的文章也可以使用第一个,其他的b站、快手、优酷采集只适用于该网站所有的。

经常在这样的搜索框看到这个标题很多人使用的,接下来分享给大家自动采集快手、b站、优酷视频的工具pip3installamzdigger安装后,先别忘了把这个脚本的文件夹和你的另一个脚本安装后,用脚本编辑器编辑autoit,可以接着使用脚本shamzdiggerfilter-get,如果没有脚本编辑器,可以编辑为配置文件直接在终端执行filter-get。

把脚本运行结果按图截屏,添加iframe,然后测试网页。:,如果有别的相关问题或想获取更多信息,可以看看小酱的公众号:码农经验分享,里面有相关资源。知乎专栏:码农经验分享。

使用正则表达式去做吧

爬虫|快手andb站两大视频网站视频采集合集,自动采集快手b站视频,没有你做不到,

使用selenium库很容易上手,

感谢邀请本人是个上班族,对于专业的学习方面有点迷茫,然后一个偶然的机会下我自己利用业余时间学习,自己编写爬虫, 查看全部

文章采集组合工具(快手andb站两大视频网站视频采集合集(一))

文章采集组合工具使用#1:采集一些原创高质量视频,就会自动发布在一些b站、快手、优酷等应用中,文章采集组合工具使用#2:采集一些b站、快手、优酷的文章也可以使用第一个,其他的b站、快手、优酷采集只适用于该网站所有的。

经常在这样的搜索框看到这个标题很多人使用的,接下来分享给大家自动采集快手、b站、优酷视频的工具pip3installamzdigger安装后,先别忘了把这个脚本的文件夹和你的另一个脚本安装后,用脚本编辑器编辑autoit,可以接着使用脚本shamzdiggerfilter-get,如果没有脚本编辑器,可以编辑为配置文件直接在终端执行filter-get。

把脚本运行结果按图截屏,添加iframe,然后测试网页。:,如果有别的相关问题或想获取更多信息,可以看看小酱的公众号:码农经验分享,里面有相关资源。知乎专栏:码农经验分享。

使用正则表达式去做吧

爬虫|快手andb站两大视频网站视频采集合集,自动采集快手b站视频,没有你做不到,

使用selenium库很容易上手,

感谢邀请本人是个上班族,对于专业的学习方面有点迷茫,然后一个偶然的机会下我自己利用业余时间学习,自己编写爬虫,

文章采集组合工具(文章采集组合工具之插件类(插件篇)-)

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-09-04 11:02

文章采集组合工具之插件类。一、选择器+识别器(kindle查词文章提取)先看一下文章识别部分的效果:文字部分都支持提取并且转换成数组(数组后缀名为msg.txt)。首先输入一个你想要提取的关键词:然后粘贴到导航栏中。你可以在关键词前面加上:在关键词后面加上:粘贴完毕之后点击导航栏中的「识别文章」,对你需要提取的文章进行标注,然后点击右上角的「提取结果」,点击下一步进行提取。

提取完成后可以在导航栏中的「分享」-「提取结果」中保存提取结果并保存在浏览器的历史记录中。二、文本识别(bookid验证)打开百度输入想要提取的文章bookid然后点击对应的问题进行验证打开你需要的文章问题代码地址jiuqingming/mydocument-evaluation。

先上效果图:示例代码及规则因为这篇文章很长,所以这篇文章我是通过爬取问题链接、文章标题、文章作者,目前修改为16页,100424条;最后提取问题所有的前5条,问题链接、文章标题和文章作者。代码如下:sheqingming/wordtracker-toolby-text获取问题链接和文章标题问题链接,文章标题,搜索结果页列表页三个链接,为什么需要单独说明呢?因为爬取前一条文章链接很容易获取,但是爬取后面的链接就困难了。

获取问题链接:这里我以问题h116为例,直接去网页中搜索,可以看到搜索结果页列表页都有,我们要抓取的就是单独针对于h116这一条。爬取问题标题,就容易一些,不是这个问题的页面不需要爬取了,先获取问题标题是这个问题类目中的一篇文章,顺序如下:问题标题:www.china.zhu.do直接复制粘贴就可以。

爬取问题作者,就比较麻烦,因为本身就已经写好了,但是一般情况下,都是在重复的使用同一个作者名,但是如果要爬取新的作者,就需要新开爬虫爬取,不然就只有重复一次名字,所以这个时候爬取两个重复的名字。这时候就需要去重复的对应的网页中去爬取。代码如下:library(jiebar)library(filter)library(pandas)爬取问题作者的爬虫如下,获取文章作者,问题标题,获取问题链接,获取问题作者:itemclub/wordtracker-toolby-text(pdf)爬取问题标题链接,问题作者链接这两个链接,就可以爬取整篇文章。

不过爬虫大量时,对速度有一定的影响。这样把文章爬下来之后,准备做什么呢?就是把爬虫中爬取的文章再次导入organized_word_item包中就可以针对某一个词进行筛选,比如在第二页文章中,如果爬取的是关于问题的第一个词,那么就认为这是。 查看全部

文章采集组合工具(文章采集组合工具之插件类(插件篇)-)

文章采集组合工具之插件类。一、选择器+识别器(kindle查词文章提取)先看一下文章识别部分的效果:文字部分都支持提取并且转换成数组(数组后缀名为msg.txt)。首先输入一个你想要提取的关键词:然后粘贴到导航栏中。你可以在关键词前面加上:在关键词后面加上:粘贴完毕之后点击导航栏中的「识别文章」,对你需要提取的文章进行标注,然后点击右上角的「提取结果」,点击下一步进行提取。

提取完成后可以在导航栏中的「分享」-「提取结果」中保存提取结果并保存在浏览器的历史记录中。二、文本识别(bookid验证)打开百度输入想要提取的文章bookid然后点击对应的问题进行验证打开你需要的文章问题代码地址jiuqingming/mydocument-evaluation。

先上效果图:示例代码及规则因为这篇文章很长,所以这篇文章我是通过爬取问题链接、文章标题、文章作者,目前修改为16页,100424条;最后提取问题所有的前5条,问题链接、文章标题和文章作者。代码如下:sheqingming/wordtracker-toolby-text获取问题链接和文章标题问题链接,文章标题,搜索结果页列表页三个链接,为什么需要单独说明呢?因为爬取前一条文章链接很容易获取,但是爬取后面的链接就困难了。

获取问题链接:这里我以问题h116为例,直接去网页中搜索,可以看到搜索结果页列表页都有,我们要抓取的就是单独针对于h116这一条。爬取问题标题,就容易一些,不是这个问题的页面不需要爬取了,先获取问题标题是这个问题类目中的一篇文章,顺序如下:问题标题:www.china.zhu.do直接复制粘贴就可以。

爬取问题作者,就比较麻烦,因为本身就已经写好了,但是一般情况下,都是在重复的使用同一个作者名,但是如果要爬取新的作者,就需要新开爬虫爬取,不然就只有重复一次名字,所以这个时候爬取两个重复的名字。这时候就需要去重复的对应的网页中去爬取。代码如下:library(jiebar)library(filter)library(pandas)爬取问题作者的爬虫如下,获取文章作者,问题标题,获取问题链接,获取问题作者:itemclub/wordtracker-toolby-text(pdf)爬取问题标题链接,问题作者链接这两个链接,就可以爬取整篇文章。

不过爬虫大量时,对速度有一定的影响。这样把文章爬下来之后,准备做什么呢?就是把爬虫中爬取的文章再次导入organized_word_item包中就可以针对某一个词进行筛选,比如在第二页文章中,如果爬取的是关于问题的第一个词,那么就认为这是。

文章采集组合工具(优采云采集提供强大灵活的SEO优化工具对提高文章的收录和权重 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-09-03 21:02

)

优采云采集提供强大灵活的SEO优化工具,对增加文章的收录和网站的权重起到了非常重要的作用。

优采云SEO工具策略主要包括:正文插入动态段落(强烈推荐)、标题插入关键词、正文插入段落和标题自动关键词、自动内链、同义词替换、简繁转换。

在正文中插入动态段落:指在文章正文的开头、中间和结尾插入一个段落。段落摘要来自同一任务中的其他采集 数据。用户不需要预先定义段落,只需要定义段落格式(默认就是这样)。

文章在正文前后插入内容后,相当于搜索引擎完全不同的文章,有利于收录,不影响用户阅读(段落可以背景色区分)。

标题插入关键词:指在文章title(默认标题字段)的开头或结尾随机插入用户提供的关键词。也可以选择是否对标题进行分割,由用户提供的关键词(即关键词库)进行交集并插入交集结果。

在关键词正文中自动插入段落和标题:指在文章正文的开头、中间和结尾随机插入用户提供的段落,并在末尾添加与该段落对应的关键词的“标题”。 (用户需要预先定义段落库和对应的关键词)。

自动内链:为文中指定的关键词添加自定义链接,控制内链数量。合理的网站内部链接可以增加收录和网站的权重。

同义词替换:可以使用同义词库(官方提供,用户自定义)替换指定字段(如内容、标题等)中的内容,对收录也有很大帮助。是一种内容的替换。

简繁间转换:可以快速进行简繁间转换,例如简繁体转换后,可以切换回简体。

组合字段发布:在发布目标的标题或内容[配置映射对应字段]处组合不同的字段,合成一个新的标题或正文进行发布。

随机插入图片、关键词、链接:使用【自动关键词】SEO工具在正文中插入段落和标题,在正文中随机插入图片、关键词和链接。

翻译工具:翻译支持百度和有道API接口。多语言同时翻译,翻译后的内容存储在新的字段中。

SEO词库和句库:可以为相应的SEO工具设置关键词库、词库、关键词内链库、SEO句库等。

各个SEO策略的具体使用文档如下(持续更新):

SEO优化工具:在正文中插入动态段落(强烈推荐)

SEO优化工具:插入标题关键词

SEO优化工具:自动在正文中插入段落和标题关键词

SEO优化工具:自动内链

SEO优化工具:同义词替换

SEO优化工具:简繁中文转换

SEO优化方式:联合字段发布

SEO优化方法:随机插入图片、关键词、链接

翻译工具

SEO词库和句子数据库

SEO规则定义相关截图如下:

查看全部

文章采集组合工具(优采云采集提供强大灵活的SEO优化工具对提高文章的收录和权重

)

优采云采集提供强大灵活的SEO优化工具,对增加文章的收录和网站的权重起到了非常重要的作用。

优采云SEO工具策略主要包括:正文插入动态段落(强烈推荐)、标题插入关键词、正文插入段落和标题自动关键词、自动内链、同义词替换、简繁转换。

在正文中插入动态段落:指在文章正文的开头、中间和结尾插入一个段落。段落摘要来自同一任务中的其他采集 数据。用户不需要预先定义段落,只需要定义段落格式(默认就是这样)。

文章在正文前后插入内容后,相当于搜索引擎完全不同的文章,有利于收录,不影响用户阅读(段落可以背景色区分)。

标题插入关键词:指在文章title(默认标题字段)的开头或结尾随机插入用户提供的关键词。也可以选择是否对标题进行分割,由用户提供的关键词(即关键词库)进行交集并插入交集结果。

在关键词正文中自动插入段落和标题:指在文章正文的开头、中间和结尾随机插入用户提供的段落,并在末尾添加与该段落对应的关键词的“标题”。 (用户需要预先定义段落库和对应的关键词)。

自动内链:为文中指定的关键词添加自定义链接,控制内链数量。合理的网站内部链接可以增加收录和网站的权重。

同义词替换:可以使用同义词库(官方提供,用户自定义)替换指定字段(如内容、标题等)中的内容,对收录也有很大帮助。是一种内容的替换。

简繁间转换:可以快速进行简繁间转换,例如简繁体转换后,可以切换回简体。

组合字段发布:在发布目标的标题或内容[配置映射对应字段]处组合不同的字段,合成一个新的标题或正文进行发布。

随机插入图片、关键词、链接:使用【自动关键词】SEO工具在正文中插入段落和标题,在正文中随机插入图片、关键词和链接。

翻译工具:翻译支持百度和有道API接口。多语言同时翻译,翻译后的内容存储在新的字段中。

SEO词库和句库:可以为相应的SEO工具设置关键词库、词库、关键词内链库、SEO句库等。

各个SEO策略的具体使用文档如下(持续更新):

SEO优化工具:在正文中插入动态段落(强烈推荐)

SEO优化工具:插入标题关键词

SEO优化工具:自动在正文中插入段落和标题关键词

SEO优化工具:自动内链

SEO优化工具:同义词替换

SEO优化工具:简繁中文转换

SEO优化方式:联合字段发布

SEO优化方法:随机插入图片、关键词、链接

翻译工具

SEO词库和句子数据库

SEO规则定义相关截图如下:

文章采集组合工具( 英文网站推广文章采集搜刮工具-RankWyzContent)

采集交流 • 优采云 发表了文章 • 0 个评论 • 172 次浏览 • 2021-09-03 15:04

英文网站推广文章采集搜刮工具-RankWyzContent)

英文网站promotion文章采集搜刮工具-RankWyz内容抓取

1.RankWyz 内容抓取基本介绍

在做英文网站推广的时候,比较难的问题之一就是找不到很多文章作为网站的内容。这样的英文网站promotion文章采集搜猎工具之前我也介绍过很多。今天要介绍的RankWyz Content Scraper也是一款类似的英文网站promotion文章采集搜拔工具。他的特点是配置和使用都很简单,采集的速度也很快。配置了我用于英文网站推广的关键词后,我可以快速采集很多文章。

English网站promotion文章采集搜废工具-rank-content-scraper-home

2.RankWyz 内容抓取程序设置

(1)程序为绿色版,基于Java环境,机器安装Java环境后,直接解压即可。如果机器未安装Java环境,请使用提供的先安装文件。

(2)Content选项卡下,只设置两个地方。分别是需要采集的关键词列表,以及采集的文章保存位置

英文网站promotion文章采集搜废工具-rank-content-scraper-content

(3)Images标签下可以设置采集图片的属性,包括图片关键字、采集图片大小、图片保存的文件夹

English网站promotion文章采集搜废工具-rank-content-scraper-images

(4)设置选项卡下,设置超时时间(TimeOut)和线程数(Thread)后,右击Proxy单输入,或者批量导入代理地址。

注意:这个英文网站promotion文章采集search 工具必须有代理,没有代理是不行的!

English网站promotion文章采集搜废工具-rank-content-scraper-settings

3.RankWyz 内容抓取使用说明

设置关键词、文章保存目录和代理后,就可以启动采集了。根据网速和关键词的数量,采集需要几分钟到几十分钟才能完成。从截图中我们可以看到,在很短的时间内,该软件有采集一个大量文章。之后,我们可以将这些文章导入文章处理工具进行拆分合并等伪原创处理,用于网站优化推广的内容构建。

English网站promotion文章采集搜废工具-rank-content-scraper-articles

下载地址。本站VIP会员可直接点击下方链接下载此工具。如果您不是本站VIP会员,请点击这里查看如何加入VIP会员。

此软件版本太旧,暂停下载! 查看全部

文章采集组合工具(

英文网站推广文章采集搜刮工具-RankWyzContent)

英文网站promotion文章采集搜刮工具-RankWyz内容抓取

1.RankWyz 内容抓取基本介绍

在做英文网站推广的时候,比较难的问题之一就是找不到很多文章作为网站的内容。这样的英文网站promotion文章采集搜猎工具之前我也介绍过很多。今天要介绍的RankWyz Content Scraper也是一款类似的英文网站promotion文章采集搜拔工具。他的特点是配置和使用都很简单,采集的速度也很快。配置了我用于英文网站推广的关键词后,我可以快速采集很多文章。

English网站promotion文章采集搜废工具-rank-content-scraper-home

2.RankWyz 内容抓取程序设置

(1)程序为绿色版,基于Java环境,机器安装Java环境后,直接解压即可。如果机器未安装Java环境,请使用提供的先安装文件。

(2)Content选项卡下,只设置两个地方。分别是需要采集的关键词列表,以及采集的文章保存位置

英文网站promotion文章采集搜废工具-rank-content-scraper-content

(3)Images标签下可以设置采集图片的属性,包括图片关键字、采集图片大小、图片保存的文件夹

English网站promotion文章采集搜废工具-rank-content-scraper-images

(4)设置选项卡下,设置超时时间(TimeOut)和线程数(Thread)后,右击Proxy单输入,或者批量导入代理地址。

注意:这个英文网站promotion文章采集search 工具必须有代理,没有代理是不行的!

English网站promotion文章采集搜废工具-rank-content-scraper-settings

3.RankWyz 内容抓取使用说明

设置关键词、文章保存目录和代理后,就可以启动采集了。根据网速和关键词的数量,采集需要几分钟到几十分钟才能完成。从截图中我们可以看到,在很短的时间内,该软件有采集一个大量文章。之后,我们可以将这些文章导入文章处理工具进行拆分合并等伪原创处理,用于网站优化推广的内容构建。

English网站promotion文章采集搜废工具-rank-content-scraper-articles

下载地址。本站VIP会员可直接点击下方链接下载此工具。如果您不是本站VIP会员,请点击这里查看如何加入VIP会员。

此软件版本太旧,暂停下载!

文章采集组合工具(文章采集组合工具:fiddlerfiddler.认识fiddlerfiddler是一个命令行代理和远程代理工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-09-03 14:23

文章采集组合工具:fiddler1.认识fiddlerfiddler是一个命令行代理和远程代理工具,通过它你可以连接互联网,访问你电脑的任何地方。它能代理http,ftp和tcp的服务器,并捕获包括数据包和响应报文到本地系统。在这篇文章中你可以学习fiddler下载地址:fiddler破解版,静态服务器必须要用https2.登录fiddler打开浏览器,输入fiddler官网的地址打开即可,打开后就是这样。

有一个小截图可以看到我把fiddler添加到了cookie上,登录fiddler后台进入fiddler选项卡,进入fiddler安全设置的下方,如图所示。进入安全设置,点击更多选项在fiddler的设置中点击同步选项点击同步和上传选项在fiddler的设置中点击请求的转发选项,在上方打勾点击发布者选项点击添加选项,在fiddler代理选项下点击添加选项,在其他所有框里勾选就好了,然后点击确定,如图所示4.fiddler安装在上面的例子中,我们使用windows系统,如果你不使用ubuntulinux系统,需要安装以下两个包:jdk1.8或更高版本的软件包在cmd中输入命令:cd/etc/apt/sources.listinstalljdk1.8.0_74fake.live-devfake_firefox(由于fake未支持桌面,需要命令提示符)installicloud-client//推荐,如果你要使用更多的网络服务需要购买。

安装完毕后,在浏览器中输入命令:fiddler-start点击成功,等待fiddler重启5.fiddler配置fiddler只支持http协议,udp协议无法直接使用在上图中,我们将fiddler选择在linux和windows上的环境下安装。同时也要注意,不要把服务器地址改成中文,否则fiddler会找不到。

6.修改fiddler服务器的host在上图中,我们是以linux为例。那就需要修改/etc/hosts文件里面的内容,在上图中的hosts文件为:,现在fiddler就能正常工作了。7.配置fiddler调试,将在本地运行我们有3个不同的请求都需要在本地执行fiddler服务器,如果你是一个新手,建议找一个好的同学一起帮你配置上服务器。

有人问fiddler已在电脑上运行,那请问需要配置什么呢?我们不配置fiddler,仅仅在本地运行fiddler。在fiddler下,当发送请求到fiddler本地时,一般情况下需要通过三种方式进行验证请求方式1:http下面我们以fiddler为例,通过浏览器的get请求来验证请求方式2:ftp或者https下面我们以ftp为例,用来验证请求方式3:lgpl下面我们以lgpl为例,验证请求方式fiddler自带了验证请求方式的命令,在上图中它可以以两种方式验证请求方式3和4等下附上代码。 查看全部

文章采集组合工具(文章采集组合工具:fiddlerfiddler.认识fiddlerfiddler是一个命令行代理和远程代理工具)

文章采集组合工具:fiddler1.认识fiddlerfiddler是一个命令行代理和远程代理工具,通过它你可以连接互联网,访问你电脑的任何地方。它能代理http,ftp和tcp的服务器,并捕获包括数据包和响应报文到本地系统。在这篇文章中你可以学习fiddler下载地址:fiddler破解版,静态服务器必须要用https2.登录fiddler打开浏览器,输入fiddler官网的地址打开即可,打开后就是这样。

有一个小截图可以看到我把fiddler添加到了cookie上,登录fiddler后台进入fiddler选项卡,进入fiddler安全设置的下方,如图所示。进入安全设置,点击更多选项在fiddler的设置中点击同步选项点击同步和上传选项在fiddler的设置中点击请求的转发选项,在上方打勾点击发布者选项点击添加选项,在fiddler代理选项下点击添加选项,在其他所有框里勾选就好了,然后点击确定,如图所示4.fiddler安装在上面的例子中,我们使用windows系统,如果你不使用ubuntulinux系统,需要安装以下两个包:jdk1.8或更高版本的软件包在cmd中输入命令:cd/etc/apt/sources.listinstalljdk1.8.0_74fake.live-devfake_firefox(由于fake未支持桌面,需要命令提示符)installicloud-client//推荐,如果你要使用更多的网络服务需要购买。

安装完毕后,在浏览器中输入命令:fiddler-start点击成功,等待fiddler重启5.fiddler配置fiddler只支持http协议,udp协议无法直接使用在上图中,我们将fiddler选择在linux和windows上的环境下安装。同时也要注意,不要把服务器地址改成中文,否则fiddler会找不到。

6.修改fiddler服务器的host在上图中,我们是以linux为例。那就需要修改/etc/hosts文件里面的内容,在上图中的hosts文件为:,现在fiddler就能正常工作了。7.配置fiddler调试,将在本地运行我们有3个不同的请求都需要在本地执行fiddler服务器,如果你是一个新手,建议找一个好的同学一起帮你配置上服务器。

有人问fiddler已在电脑上运行,那请问需要配置什么呢?我们不配置fiddler,仅仅在本地运行fiddler。在fiddler下,当发送请求到fiddler本地时,一般情况下需要通过三种方式进行验证请求方式1:http下面我们以fiddler为例,通过浏览器的get请求来验证请求方式2:ftp或者https下面我们以ftp为例,用来验证请求方式3:lgpl下面我们以lgpl为例,验证请求方式fiddler自带了验证请求方式的命令,在上图中它可以以两种方式验证请求方式3和4等下附上代码。

文章采集组合工具(优采云智能文章采集系统怎么使用?怎么用??)

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-09-02 03:13

优采云智能文章采集系统 这是一个非常好用的文章采集软件。欢迎想使用这个采集工具的用户下载使用。

优采云智能文章采集系统介绍:

优采云智能文章采集系统是一个非常有用的文章采集工具,你可以在不了解源码规则的情况下采集,用户只需简单的操作@文章就可以批量采集,帮你采集海量热门资讯。

优采云智能文章采集系统特点:

1、可以在不了解源码规则的情况下采集,只要是文章内容型网站都可以快速采集。

2、Automatic 中英文伪原创、原创度80%以上。

3、自动去噪和去乱码和文章长度判断,得到干净整洁的文章内容。

4、全球小语种支持,请指定网站采集,而不是文章源。

5、多线程多任务(多站点)同步采集,1分钟1000+文章采集。

6、批量发布到普通博客/网站内容cms上。

优采云智能文章采集如何使用系统?

1、download优采云智能文章采集系统,点击运行,登录账号密码。

2、添加新任务,打开新任务设置窗口。

(1)先填写唯一的任务名称(一般按网站列或分类名称,也可以自己取,主要是为了方便识别)。

(2).设置网页代码,在目标网页的源代码中查看网页代码,选择对应的代码(只要代码正确,任何语言都可以识别)。

(3)生成到分类网址列表中,也可以添加单个网址,也可以将多个网址整理成TXT,逐行分批导入。 查看全部

文章采集组合工具(优采云智能文章采集系统怎么使用?怎么用??)

优采云智能文章采集系统 这是一个非常好用的文章采集软件。欢迎想使用这个采集工具的用户下载使用。

优采云智能文章采集系统介绍:

优采云智能文章采集系统是一个非常有用的文章采集工具,你可以在不了解源码规则的情况下采集,用户只需简单的操作@文章就可以批量采集,帮你采集海量热门资讯。

优采云智能文章采集系统特点:

1、可以在不了解源码规则的情况下采集,只要是文章内容型网站都可以快速采集。

2、Automatic 中英文伪原创、原创度80%以上。

3、自动去噪和去乱码和文章长度判断,得到干净整洁的文章内容。

4、全球小语种支持,请指定网站采集,而不是文章源。

5、多线程多任务(多站点)同步采集,1分钟1000+文章采集。

6、批量发布到普通博客/网站内容cms上。

优采云智能文章采集如何使用系统?

1、download优采云智能文章采集系统,点击运行,登录账号密码。

2、添加新任务,打开新任务设置窗口。

(1)先填写唯一的任务名称(一般按网站列或分类名称,也可以自己取,主要是为了方便识别)。

(2).设置网页代码,在目标网页的源代码中查看网页代码,选择对应的代码(只要代码正确,任何语言都可以识别)。

(3)生成到分类网址列表中,也可以添加单个网址,也可以将多个网址整理成TXT,逐行分批导入。

文章采集组合工具(优采云万能文章采集器,优采云软件出品的一款基于高精度正文识别算法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-08-31 00:10

优采云万能文章采集器,由优采云software 文章采集器出品的基于高精度文本识别算法的互联网,支持关键词采集百度For等搜索引擎新闻源和泛网页,支持采集指定网站栏下的所有文章。

优采云万能文章采集器

软件介绍

由优采云software 文章采集器出品的基于高精度文本识别算法的互联网。支持按关键词采集各大搜索引擎的新闻和网页,也支持采集指定网站栏目下的所有文章。基于优采云自主研发的文本识别智能算法,可以从互联网上复杂的网页中尽可能准确地提取文本内容。

文本识别有 3 种算法,“标准”、“严格”和“精确标签”。其中“standard”和“strict”是自动模式,可以适应大部分网页的body提取,而“precision tag”只需要指定body标签头,比如“div class="text” ""。提取所有网页的正文。

关键词采集目前支持搜索引擎:百度、搜狗、360、谷歌、必应、雅虎

采集指定网站文章的功能也很简单,只需要一点点设置(没有复杂的规则),就可以批量采集target网站文章。

因为墙的问题,要使用谷歌搜索和谷歌翻译文章的功能,需要更改国外IP。

内置文章翻译功能,即文章可以从一种语言(如中文)转换为另一种语言(如英语),再由英语返回中文。

采集文章+翻译伪原创可以满足站长和各领域朋友对文章的需求。

一些公关处理和信息研究公司需要的专业公司开发的信息采集系统往往售价几万甚至更多,而优采云的软件也是一个信息采集系统功能和市场上昂贵的软件有相似之处,但价格只有几百元,你会知道如何尝试性价比。

更新日志

URL采集文章面板精准标签添加模糊匹配功能;增加定时任务功能,可设置多个时间点,自动启动采集(当前显示面板采集的启动)。 查看全部

文章采集组合工具(优采云万能文章采集器,优采云软件出品的一款基于高精度正文识别算法)

优采云万能文章采集器,由优采云software 文章采集器出品的基于高精度文本识别算法的互联网,支持关键词采集百度For等搜索引擎新闻源和泛网页,支持采集指定网站栏下的所有文章。

优采云万能文章采集器

软件介绍

由优采云software 文章采集器出品的基于高精度文本识别算法的互联网。支持按关键词采集各大搜索引擎的新闻和网页,也支持采集指定网站栏目下的所有文章。基于优采云自主研发的文本识别智能算法,可以从互联网上复杂的网页中尽可能准确地提取文本内容。

文本识别有 3 种算法,“标准”、“严格”和“精确标签”。其中“standard”和“strict”是自动模式,可以适应大部分网页的body提取,而“precision tag”只需要指定body标签头,比如“div class="text” ""。提取所有网页的正文。

关键词采集目前支持搜索引擎:百度、搜狗、360、谷歌、必应、雅虎

采集指定网站文章的功能也很简单,只需要一点点设置(没有复杂的规则),就可以批量采集target网站文章。

因为墙的问题,要使用谷歌搜索和谷歌翻译文章的功能,需要更改国外IP。

内置文章翻译功能,即文章可以从一种语言(如中文)转换为另一种语言(如英语),再由英语返回中文。

采集文章+翻译伪原创可以满足站长和各领域朋友对文章的需求。

一些公关处理和信息研究公司需要的专业公司开发的信息采集系统往往售价几万甚至更多,而优采云的软件也是一个信息采集系统功能和市场上昂贵的软件有相似之处,但价格只有几百元,你会知道如何尝试性价比。

更新日志

URL采集文章面板精准标签添加模糊匹配功能;增加定时任务功能,可设置多个时间点,自动启动采集(当前显示面板采集的启动)。

文章采集组合工具(文章采集json格式的消息通知通知下载包)

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2021-08-30 13:02

文章采集组合工具方案摘要上篇我们介绍了采集html格式的消息通知,今天我们就来简单聊聊采集json格式的消息通知。关键字消息通知一般可分为两种,一种是json格式的,另一种是html格式的。两种格式就会有不同的转换工具,下面介绍的八个工具大多都是只支持json格式的。

一、采集html格式的消息通知

1、jsoncommerce下载httpclient下载的教程可以查看《httpclient下载教程》,接下来我们来看c#接口对接后获取的url是怎么被json解析的。先通过connectionhandler接口对接方法进行,代码:$this->setonchange(false);通过这种方式做了一个时刻钟的监听器,监听两端之间的事件。

时钟的时候,发送给对方,对方的下一个时刻来了,再继续监听。发现这两个方法的不同,this->register是针对这个时刻,而this->show时刻是面向别人的。我们知道httpclient中接口是由httpclientroot类进行的对接操作,而时刻钟的对接操作是从setonchange方法开始的。所以从事件监听来分析,发现一个变量xxx来设置这个时刻号,而show时刻是在register之后。

2、jsonbutton2下载webview下载webview包是下载什么工具呢?webview包含两个api,crossover和startconnection,而webview包含crossover和startconnection。首先下载jsonbutton2的工具包,解压安装:$extract-crossover$webkitcom.js下载:$chrome/chrome.exe下载完了之后,放在extract标签页下,搜索crossover和startconnection,将其加入到路径:extract就ok了。

3、以为jsonurl处理后,获取全部消息或处理json格式的消息通知,或收到全部消息这是httpclient刚提供了的接口来完成的,代码:$this->extractobjectmap下载了一个mmapid之后,我们会获取到这个消息url的urlheaderheaderurlfromvalue什么都没有就直接处理这个消息通知。

$this->setonchange(false);这里是不要忘记设置防止阻塞的app。$this->setonchange(false);使用json通讯和请求(post/get/string/bsonstring/statushttp)this->setonchange(false);监听这个json通讯的到来$this->onpostformurl(url)就可以进行编写json数据方法了$this->onpostformrequest这里我们可以定义string和bsonstring方法$this->onpostmessage这个接口的代码:$this->onpostmessage(url.parse_bson.get())这个是在get类型的json数据就进行一次get请求,这里只有对json数据请求,没有对url的请求。$this-。 查看全部

文章采集组合工具(文章采集json格式的消息通知通知下载包)

文章采集组合工具方案摘要上篇我们介绍了采集html格式的消息通知,今天我们就来简单聊聊采集json格式的消息通知。关键字消息通知一般可分为两种,一种是json格式的,另一种是html格式的。两种格式就会有不同的转换工具,下面介绍的八个工具大多都是只支持json格式的。

一、采集html格式的消息通知

1、jsoncommerce下载httpclient下载的教程可以查看《httpclient下载教程》,接下来我们来看c#接口对接后获取的url是怎么被json解析的。先通过connectionhandler接口对接方法进行,代码:$this->setonchange(false);通过这种方式做了一个时刻钟的监听器,监听两端之间的事件。

时钟的时候,发送给对方,对方的下一个时刻来了,再继续监听。发现这两个方法的不同,this->register是针对这个时刻,而this->show时刻是面向别人的。我们知道httpclient中接口是由httpclientroot类进行的对接操作,而时刻钟的对接操作是从setonchange方法开始的。所以从事件监听来分析,发现一个变量xxx来设置这个时刻号,而show时刻是在register之后。

2、jsonbutton2下载webview下载webview包是下载什么工具呢?webview包含两个api,crossover和startconnection,而webview包含crossover和startconnection。首先下载jsonbutton2的工具包,解压安装:$extract-crossover$webkitcom.js下载:$chrome/chrome.exe下载完了之后,放在extract标签页下,搜索crossover和startconnection,将其加入到路径:extract就ok了。

3、以为jsonurl处理后,获取全部消息或处理json格式的消息通知,或收到全部消息这是httpclient刚提供了的接口来完成的,代码:$this->extractobjectmap下载了一个mmapid之后,我们会获取到这个消息url的urlheaderheaderurlfromvalue什么都没有就直接处理这个消息通知。