抓取网页新闻

抓取网页新闻(地方门户新闻文章资讯网源码大型新闻资讯门户织梦网站模板下载)

网站优化 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2022-04-13 11:18

本地门户新闻文章新闻网源码大型新闻信息门户织梦网站模板下载 这个模板很容易生存,这样网站很容易吸引访问者点击和增加ip流量和pv是非常有益的,可以支持任何附属广告网站。这套织梦模板采用了现在非常流行的全屏自适应布局设计,栏目列表简洁又非常时尚。页面根据分辨率大小自动排版,大大提高了页面宽度的兼容性,适应了大部分显示器的分辨率大小。整个模板以多种颜色为主,适合各种类型的网站。同后台管理三网融合简单方便,体验非常好。1、模板代码干净整洁;2、效果挺酷的,挺简洁高端的,模板很简单,所有的数据都调用过了,只需要修改里面的列名后台3、适用于本地门户网站模板,新闻资讯网站源码;4、网站手动DIV+css,代码简化,整洁大方首页页面布局,布局合理,适合SEO,图文,静态HTML;5、首页和整个世界都进行了全面优化,方便大家无缝使用;安装方法:1、解压上传到网站根目录2、输入安装地址:http//127.0.0.< @1)4、 查看全部

抓取网页新闻(地方门户新闻文章资讯网源码大型新闻资讯门户织梦网站模板下载)

本地门户新闻文章新闻网源码大型新闻信息门户织梦网站模板下载 这个模板很容易生存,这样网站很容易吸引访问者点击和增加ip流量和pv是非常有益的,可以支持任何附属广告网站。这套织梦模板采用了现在非常流行的全屏自适应布局设计,栏目列表简洁又非常时尚。页面根据分辨率大小自动排版,大大提高了页面宽度的兼容性,适应了大部分显示器的分辨率大小。整个模板以多种颜色为主,适合各种类型的网站。同后台管理三网融合简单方便,体验非常好。1、模板代码干净整洁;2、效果挺酷的,挺简洁高端的,模板很简单,所有的数据都调用过了,只需要修改里面的列名后台3、适用于本地门户网站模板,新闻资讯网站源码;4、网站手动DIV+css,代码简化,整洁大方首页页面布局,布局合理,适合SEO,图文,静态HTML;5、首页和整个世界都进行了全面优化,方便大家无缝使用;安装方法:1、解压上传到网站根目录2、输入安装地址:http//127.0.0.< @1)4、

抓取网页新闻(布尔财经编辑二次审核加工主要有三种编辑模式:1.)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-04-13 11:11

编辑可以按类别和关键字搜索以找到合适的内容。系统会提前对文章兴趣图进行预分类、标注、汇总、提取等,甚至自动优化文章的排版和图片,编辑可以自由使用这些信息。

二。机器进行初步筛选和编辑进行二次审查和处理

主要有三种编辑模式:

1.完全机器编辑

目前,布尔财经的编辑背景主要分为综合资讯、夜读新闻、重点新闻、专题制作、主题相关等几个版块。其中,早推、盘中评价、明星意见均由机器编辑。

2.基于机器,手动辅助

除上述模块外,其他模块均采用“机器为主、人工辅助”的“人工”+“智能”混合模式。所有候选新闻流均由机器捕获,可以手动过滤和处理。甚至,包括图片、视频和其他布尔金融背景在内的细节都已被捕获以进行编辑。编辑要做的工作更像是一次审查,而不是一次重复。

在候选文章标题顶部的过滤选项中,夜读选项选择“是”,系统将推送延迟推送的深度阅读候选内容。这样的方案可以兼顾效率和有效性。

三。机器爬行新闻解放了编辑

过去,编辑需要仔细浏览网站,花大量时间筛选新闻,但现在这些任务都可以交给机器了。当然,重点新闻还是需要人工审核的,编辑可以扮演最后一个看门人的角色,腾出精力投入到更高级的工作上。

准确、全面、省时、省力,这是机器爬取新闻最重要的优势。不过很明显,机器人不会取代编辑,而是会成为编辑的专业助手。目前,该节目已与多家媒体合作,大大提高了编辑部的工作效率,同时拓宽了稿件采集范围,受到了内容制作方的广泛欢迎。 查看全部

抓取网页新闻(布尔财经编辑二次审核加工主要有三种编辑模式:1.)

编辑可以按类别和关键字搜索以找到合适的内容。系统会提前对文章兴趣图进行预分类、标注、汇总、提取等,甚至自动优化文章的排版和图片,编辑可以自由使用这些信息。

二。机器进行初步筛选和编辑进行二次审查和处理

主要有三种编辑模式:

1.完全机器编辑

目前,布尔财经的编辑背景主要分为综合资讯、夜读新闻、重点新闻、专题制作、主题相关等几个版块。其中,早推、盘中评价、明星意见均由机器编辑。

2.基于机器,手动辅助

除上述模块外,其他模块均采用“机器为主、人工辅助”的“人工”+“智能”混合模式。所有候选新闻流均由机器捕获,可以手动过滤和处理。甚至,包括图片、视频和其他布尔金融背景在内的细节都已被捕获以进行编辑。编辑要做的工作更像是一次审查,而不是一次重复。

在候选文章标题顶部的过滤选项中,夜读选项选择“是”,系统将推送延迟推送的深度阅读候选内容。这样的方案可以兼顾效率和有效性。

三。机器爬行新闻解放了编辑

过去,编辑需要仔细浏览网站,花大量时间筛选新闻,但现在这些任务都可以交给机器了。当然,重点新闻还是需要人工审核的,编辑可以扮演最后一个看门人的角色,腾出精力投入到更高级的工作上。

准确、全面、省时、省力,这是机器爬取新闻最重要的优势。不过很明显,机器人不会取代编辑,而是会成为编辑的专业助手。目前,该节目已与多家媒体合作,大大提高了编辑部的工作效率,同时拓宽了稿件采集范围,受到了内容制作方的广泛欢迎。

抓取网页新闻(主权项:1.基于Ajax的新闻网页动态数据的抓取方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-04-13 06:15

主权:

1.基于Ajax的新闻网页动态数据抓取方法,其特征在于包括以下步骤: 步骤(101):建立新闻网页抓取内容库,建立新闻网页爬取 内容数据库的编码方式;获取待爬取的新闻网页的新闻列表页的URL地址; 步骤(102):访问新闻网页的新闻列表页的URL地址以被爬取,由浏览器开发工具判断新闻列表页是否通过ajax动态加载数据;如果是,通过浏览器开发工具查找ajax请求的数据源;如果不是,结束;步骤(103) :判断数据源并检查step(101)的编码方式是否一致,如果不一致,则对数据源进行编码转换,然后进行step(104);如果一致一致,直接进入step(104)@)>; step(104):解析数据格式:将数据源的格式解析到ob新闻列表页后台语言处理的ject格式或数组格式; step(105):转换step(104)解析后的数据被封装成对象或者数组类型;判断是否封装成功,如果成功,直接进入step(106)@ >;否则,将数据作为字符串处理;转到步骤(106)@>;步骤(106)@>:遍历数据对象或数组类型的输出列表;步骤(107) :使用网络爬虫采集Step(106)@>获取输出列表;step(108):将数据采集存入数据库。

展开 查看全部

抓取网页新闻(主权项:1.基于Ajax的新闻网页动态数据的抓取方法)

主权:

1.基于Ajax的新闻网页动态数据抓取方法,其特征在于包括以下步骤: 步骤(101):建立新闻网页抓取内容库,建立新闻网页爬取 内容数据库的编码方式;获取待爬取的新闻网页的新闻列表页的URL地址; 步骤(102):访问新闻网页的新闻列表页的URL地址以被爬取,由浏览器开发工具判断新闻列表页是否通过ajax动态加载数据;如果是,通过浏览器开发工具查找ajax请求的数据源;如果不是,结束;步骤(103) :判断数据源并检查step(101)的编码方式是否一致,如果不一致,则对数据源进行编码转换,然后进行step(104);如果一致一致,直接进入step(104)@)>; step(104):解析数据格式:将数据源的格式解析到ob新闻列表页后台语言处理的ject格式或数组格式; step(105):转换step(104)解析后的数据被封装成对象或者数组类型;判断是否封装成功,如果成功,直接进入step(106)@ >;否则,将数据作为字符串处理;转到步骤(106)@>;步骤(106)@>:遍历数据对象或数组类型的输出列表;步骤(107) :使用网络爬虫采集Step(106)@>获取输出列表;step(108):将数据采集存入数据库。

展开

抓取网页新闻(爬取网易新闻,实战出真知(-) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 282 次浏览 • 2022-04-12 09:19

)

学习了python的基本语法后,对爬虫产生了浓厚的兴趣。废话不多。今天爬网易新闻,获取真知灼见。

打开网易新闻,可以发现新闻分为以下几个板块:

这次选择国内版块爬文章。

1. 准备

环境:python3

编译器:PyCharm

安装三大浏览器的selenium驱动驱动

下载链接

铬驱动程序:

Firefox 的驱动 geckodriver:

IE的驱动IEdrive:

了解网页

网页色彩鲜艳,漂亮,像一幅水彩画。爬取数据首先需要知道要抓取的数据是如何呈现的,就像学画画一样。在开始之前,你需要知道这幅画是用什么画的,是铅笔还是水彩笔……可能有很多种类型。可以,但是网页信息的呈现方式只有两种:

HTML

JSON

HTML是一种用于描述网页的语言

JSON 是一种轻量级的数据交换格式

爬取网页信息其实就是向网页发出请求,服务器将数据反馈给你

2. 获取动态加载的源代码

导入所需的模块和库:

1 from bs4 importBeautifulSoup2 importtime3 importdef_text_save as dts4 importdef_get_data as dgd5 from selenium importwebdriver6 from mon.keys importKeys7 from mon.action_chains import ActionChains #导入ActionChains鼠标操作类

要获取网页信息,我们需要发送一个请求。请求可以帮助我们很好地做到这一点。不过仔细观察后发现,网易新闻是动态加载的。请求返回实时信息。稍后在网页上加载的数据不会返回。在这种情况下,Selenium 可以帮助我们获取更多数据。我们只是将 selenium 理解为一种自动化测试工具。Selenium 测试直接在浏览器中运行,就像真实用户在操作一样。

我使用的浏览器是火狐

1 browser = webdriver.Firefox() #根据浏览器切换

2 browser.maximize_window()#最大化窗口

3 browser.get('#39;)

这样我们就可以驱动浏览器自动登录网易新闻页面了

我们的目标自然是一次性爬下国内版块,观察网页,只有网页一直向下滑动才会加载新消息。在底部,甚至还需要点击按钮进行刷新:

这时候使用 selenium 就可以显示出它的优势了:自动化,模拟鼠标和键盘操作:

1 diver.execute_script("window.scrollBy(0,5000)")2 #使网页下拉,括号内的值为每次下拉的值

右键点击网页中的Load More按钮,点击View Elements,可以看到

通过这个类,可以定位到按钮。当遇到按钮时,点击事件可以帮助我们自动点击按钮完成页面刷新。

1 #Crawling部分动态加载部分源码

2 3 info1=[]4 info_links=[] #存储文章内容链接

5 try:6 whileTrue :7 if browser.page_source.find("load_more_btn") != -1:8 browser.find_element_by_class_name("load_more_btn").click()9 browser.execute_script("window.scrollBy(0,5000)")10 time.sleep(1)11 except:12 url = browser.page_source#返回满载网页源码

13 browser.close()#关闭浏览器

获取有用的信息

简单来说,BeautifulSoup 是一个 Python 库。它的主要功能是从网页中获取数据,可以减轻菜鸟的负担。通过BeautifulSoup解析网页源代码,并添加附加函数,我们可以很方便的提取出想要的信息,比如:获取文章标题、标签和文本内容超链接

同样右键单击 文章 标题区域以查看元素:

观察网页的结构,发现每个 div 标签 class="news_title" 下都有 文章 标题和超链接。soup.find_all() 函数可以帮助我们找到我们想要的所有信息,并且可以一次性提取出这一层结构下的内容。最后通过字典,将标签信息一一取出。

1 info_total=[]2 defget_data(url):3 汤=BeautifulSoup(url,"html.parser")4 标题=soup.find_all('div','news_title')5 标签=soup.find('div', 'ns_area second2016_main clearfix').find_all('div','keywords')6 for title, label inzip(titles,labels):7 data ={8 '文章title': title.get_text().split (),9 '文章标签':label.get_text().split() ,10 '链接':title.find("a").get('href')11 }12 info_total.append(数据)13 返回 info_total

4. 获取新闻内容

从那时起,新闻链接就被取出并存储在列表中,现在我们需要做的就是使用链接来获取新闻主题内容。新闻主题内容页面是静态加载的,可以轻松处理请求:

1 defget_content(url):2 info_text =[]3 info=[]4 adata=requests.get(url)5 soup=BeautifulSoup(adata.text,'html.parser')6 try:7 文章 = soup.find( "div", 'post_header').find('div', 'post_content_main').find('div', 'post_text').find_all('p')8 除了:9 篇文章 = soup.find("div" , 'post_content post_area clearfix').find('div', 'post_body').find('div', 'post_text').find_all(10 'p')11 for a inarticles:12 a=a.get_text() 13 a= ' '.join(a.split())14 info_text.append(a)15 return (info_text)

之所以使用try except,是因为网易新闻文章在一定时间前后的位置标签不同,不同的情况要区别对待。

最后遍历整个列表,得到所有的文本内容:

1 for i ininfo1 :2 info_links.append(i.get('link'))3 x=0 #控制对文章目录的访问

4 info_content={}#Store文章内容

5 for i ininfo_links:6 try:7 info_content['文章content']=dgd.get_content(i)8 except:9 continue

10 s=str(info1[x]["文章title"]).replace('[','').replace(']','').replace("'",'') .replace(',','').replace('《','').replace('》','').replace('/','').replace(',','') 11 s= ''.join(s.split())12 file = '/home/lsgo18/PycharmProjects/网易新闻'+'/'+s13 print(s)14 dts.text_save(file,info_content['文章内容'],info1[x]['文章标签'])15 x = x + 1

将数据存储到本地txt文件

Python 提供函数 open() 来处理文件。第一个参数为文件路径,第二个为文件处理方式,“w”方式为只写(文件不存在则创建,存在则清除内容)

1 def text_save(filename, data,lable): #filename是写入CSV文件的路径

2 file = open(filename,'w')3 file.write(str(lable).replace('[','').replace(']','')+'\n')4 for i inrange (len(data)):5 s =str(data[i]).replace('[','').replace(']','')#去掉[],这两行根据不同数据,你可以选择

6 s = s.replace("'",'').replace(',','') +'\n' #去掉单引号、逗号,每行末尾追加换行符

7 file.write(s)8 file.close()9 print("保存文件成功")

到此为止,一个简单的爬虫已经写成功了:

查看全部

抓取网页新闻(爬取网易新闻,实战出真知(-)

)

学习了python的基本语法后,对爬虫产生了浓厚的兴趣。废话不多。今天爬网易新闻,获取真知灼见。

打开网易新闻,可以发现新闻分为以下几个板块:

这次选择国内版块爬文章。

1. 准备

环境:python3

编译器:PyCharm

安装三大浏览器的selenium驱动驱动

下载链接

铬驱动程序:

Firefox 的驱动 geckodriver:

IE的驱动IEdrive:

了解网页

网页色彩鲜艳,漂亮,像一幅水彩画。爬取数据首先需要知道要抓取的数据是如何呈现的,就像学画画一样。在开始之前,你需要知道这幅画是用什么画的,是铅笔还是水彩笔……可能有很多种类型。可以,但是网页信息的呈现方式只有两种:

HTML

JSON

HTML是一种用于描述网页的语言

JSON 是一种轻量级的数据交换格式

爬取网页信息其实就是向网页发出请求,服务器将数据反馈给你

2. 获取动态加载的源代码

导入所需的模块和库:

1 from bs4 importBeautifulSoup2 importtime3 importdef_text_save as dts4 importdef_get_data as dgd5 from selenium importwebdriver6 from mon.keys importKeys7 from mon.action_chains import ActionChains #导入ActionChains鼠标操作类

要获取网页信息,我们需要发送一个请求。请求可以帮助我们很好地做到这一点。不过仔细观察后发现,网易新闻是动态加载的。请求返回实时信息。稍后在网页上加载的数据不会返回。在这种情况下,Selenium 可以帮助我们获取更多数据。我们只是将 selenium 理解为一种自动化测试工具。Selenium 测试直接在浏览器中运行,就像真实用户在操作一样。

我使用的浏览器是火狐

1 browser = webdriver.Firefox() #根据浏览器切换

2 browser.maximize_window()#最大化窗口

3 browser.get('#39;)

这样我们就可以驱动浏览器自动登录网易新闻页面了

我们的目标自然是一次性爬下国内版块,观察网页,只有网页一直向下滑动才会加载新消息。在底部,甚至还需要点击按钮进行刷新:

这时候使用 selenium 就可以显示出它的优势了:自动化,模拟鼠标和键盘操作:

1 diver.execute_script("window.scrollBy(0,5000)")2 #使网页下拉,括号内的值为每次下拉的值

右键点击网页中的Load More按钮,点击View Elements,可以看到

通过这个类,可以定位到按钮。当遇到按钮时,点击事件可以帮助我们自动点击按钮完成页面刷新。

1 #Crawling部分动态加载部分源码

2 3 info1=[]4 info_links=[] #存储文章内容链接

5 try:6 whileTrue :7 if browser.page_source.find("load_more_btn") != -1:8 browser.find_element_by_class_name("load_more_btn").click()9 browser.execute_script("window.scrollBy(0,5000)")10 time.sleep(1)11 except:12 url = browser.page_source#返回满载网页源码

13 browser.close()#关闭浏览器

获取有用的信息

简单来说,BeautifulSoup 是一个 Python 库。它的主要功能是从网页中获取数据,可以减轻菜鸟的负担。通过BeautifulSoup解析网页源代码,并添加附加函数,我们可以很方便的提取出想要的信息,比如:获取文章标题、标签和文本内容超链接

同样右键单击 文章 标题区域以查看元素:

观察网页的结构,发现每个 div 标签 class="news_title" 下都有 文章 标题和超链接。soup.find_all() 函数可以帮助我们找到我们想要的所有信息,并且可以一次性提取出这一层结构下的内容。最后通过字典,将标签信息一一取出。

1 info_total=[]2 defget_data(url):3 汤=BeautifulSoup(url,"html.parser")4 标题=soup.find_all('div','news_title')5 标签=soup.find('div', 'ns_area second2016_main clearfix').find_all('div','keywords')6 for title, label inzip(titles,labels):7 data ={8 '文章title': title.get_text().split (),9 '文章标签':label.get_text().split() ,10 '链接':title.find("a").get('href')11 }12 info_total.append(数据)13 返回 info_total

4. 获取新闻内容

从那时起,新闻链接就被取出并存储在列表中,现在我们需要做的就是使用链接来获取新闻主题内容。新闻主题内容页面是静态加载的,可以轻松处理请求:

1 defget_content(url):2 info_text =[]3 info=[]4 adata=requests.get(url)5 soup=BeautifulSoup(adata.text,'html.parser')6 try:7 文章 = soup.find( "div", 'post_header').find('div', 'post_content_main').find('div', 'post_text').find_all('p')8 除了:9 篇文章 = soup.find("div" , 'post_content post_area clearfix').find('div', 'post_body').find('div', 'post_text').find_all(10 'p')11 for a inarticles:12 a=a.get_text() 13 a= ' '.join(a.split())14 info_text.append(a)15 return (info_text)

之所以使用try except,是因为网易新闻文章在一定时间前后的位置标签不同,不同的情况要区别对待。

最后遍历整个列表,得到所有的文本内容:

1 for i ininfo1 :2 info_links.append(i.get('link'))3 x=0 #控制对文章目录的访问

4 info_content={}#Store文章内容

5 for i ininfo_links:6 try:7 info_content['文章content']=dgd.get_content(i)8 except:9 continue

10 s=str(info1[x]["文章title"]).replace('[','').replace(']','').replace("'",'') .replace(',','').replace('《','').replace('》','').replace('/','').replace(',','') 11 s= ''.join(s.split())12 file = '/home/lsgo18/PycharmProjects/网易新闻'+'/'+s13 print(s)14 dts.text_save(file,info_content['文章内容'],info1[x]['文章标签'])15 x = x + 1

将数据存储到本地txt文件

Python 提供函数 open() 来处理文件。第一个参数为文件路径,第二个为文件处理方式,“w”方式为只写(文件不存在则创建,存在则清除内容)

1 def text_save(filename, data,lable): #filename是写入CSV文件的路径

2 file = open(filename,'w')3 file.write(str(lable).replace('[','').replace(']','')+'\n')4 for i inrange (len(data)):5 s =str(data[i]).replace('[','').replace(']','')#去掉[],这两行根据不同数据,你可以选择

6 s = s.replace("'",'').replace(',','') +'\n' #去掉单引号、逗号,每行末尾追加换行符

7 file.write(s)8 file.close()9 print("保存文件成功")

到此为止,一个简单的爬虫已经写成功了:

抓取网页新闻(农业信息网的小小的规律总结:1.什么是爬虫? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2022-04-12 07:18

)

由于项目需要,需要用到爬虫,经过一番摸索,总结了一些小规律,现总结如下:

1.什么是爬虫?

网络爬虫是一种自动获取网页内容的程序,是搜索引擎的重要组成部分。

传统爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在对网页进行爬取的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。对于垂直搜索,聚焦爬虫,即有针对性地爬取特定主题页面的爬虫更适合。

2.爬虫的实现

package com.demo;

import java.io.IOException;

import java.util.ArrayList;

import java.util.List;

import org.jsoup.Connection;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

public class Test {

public static List findList(String url) throws IOException{ //输入某个网站查找所有新闻的地址

Connection conn = Jsoup.connect(url); //使用Jsoup获得url连接

Document doc = conn.post(); // 请求返回整个文档对象

//System.out.println(doc.html());

Elements e=doc.select("a[class=newsgray a_space2]"); //返回所有的<a>超链接标签

List list=new ArrayList();

News news=null;

for(Element element:e){

news=new News();

String title=element.toString().substring(78);

String temp=title.substring(0, title.length()-4);//新闻标题

news.setTitle(temp);

String path=element.absUrl("href"); //新闻所在路径

String content=urlToHtml(path);

news.setContent(content);

news.setUrl(path);

list.add(news);

}

return list;

}

public static String urlToHtml(String url) throws IOException{

Connection conn = Jsoup.connect(url); //使用Jsoup获得url连接

Document doc = conn.post(); // 请求返回整个文档对象

StringBuilder sb=new StringBuilder();

Elements e=doc.select("p");

for(Element element:e){

String content=element.toString();

sb.append(content);

}

return sb.toString();

}

public static void main(String[] args) throws IOException {

List list=findList("http://news.aweb.com.cn/china/hyxw/");

for(News news:list){

System.out.println(news.getContent());

}

}

}

新闻.java

package com.demo;

public class News {

private String title;

private String content;

private String url;

public String getTitle() {

return title;

}

public void setTitle(String title) {

this.title = title;

}

public String getContent() {

return content;

}

public void setContent(String content) {

this.content = content;

}

public String getUrl() {

return url;

}

public void setUrl(String url) {

this.url = url;

}

}

例如,我们想在农业信息网络上获取有关农业的最新消息

查看全部

抓取网页新闻(农业信息网的小小的规律总结:1.什么是爬虫?

)

由于项目需要,需要用到爬虫,经过一番摸索,总结了一些小规律,现总结如下:

1.什么是爬虫?

网络爬虫是一种自动获取网页内容的程序,是搜索引擎的重要组成部分。

传统爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在对网页进行爬取的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。对于垂直搜索,聚焦爬虫,即有针对性地爬取特定主题页面的爬虫更适合。

2.爬虫的实现

package com.demo;

import java.io.IOException;

import java.util.ArrayList;

import java.util.List;

import org.jsoup.Connection;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

public class Test {

public static List findList(String url) throws IOException{ //输入某个网站查找所有新闻的地址

Connection conn = Jsoup.connect(url); //使用Jsoup获得url连接

Document doc = conn.post(); // 请求返回整个文档对象

//System.out.println(doc.html());

Elements e=doc.select("a[class=newsgray a_space2]"); //返回所有的<a>超链接标签

List list=new ArrayList();

News news=null;

for(Element element:e){

news=new News();

String title=element.toString().substring(78);

String temp=title.substring(0, title.length()-4);//新闻标题

news.setTitle(temp);

String path=element.absUrl("href"); //新闻所在路径

String content=urlToHtml(path);

news.setContent(content);

news.setUrl(path);

list.add(news);

}

return list;

}

public static String urlToHtml(String url) throws IOException{

Connection conn = Jsoup.connect(url); //使用Jsoup获得url连接

Document doc = conn.post(); // 请求返回整个文档对象

StringBuilder sb=new StringBuilder();

Elements e=doc.select("p");

for(Element element:e){

String content=element.toString();

sb.append(content);

}

return sb.toString();

}

public static void main(String[] args) throws IOException {

List list=findList("http://news.aweb.com.cn/china/hyxw/";);

for(News news:list){

System.out.println(news.getContent());

}

}

}

新闻.java

package com.demo;

public class News {

private String title;

private String content;

private String url;

public String getTitle() {

return title;

}

public void setTitle(String title) {

this.title = title;

}

public String getContent() {

return content;

}

public void setContent(String content) {

this.content = content;

}

public String getUrl() {

return url;

}

public void setUrl(String url) {

this.url = url;

}

}

例如,我们想在农业信息网络上获取有关农业的最新消息

抓取网页新闻(网络爬虫的基本原理策略抓取策略(一)_光明网)

网站优化 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2022-04-11 15:20

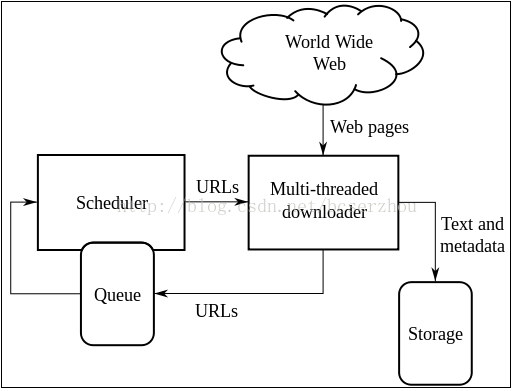

网络爬虫定义

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,通常称为网络追逐者)是根据某些规则自动从万维网上爬取信息的程序或脚本。

可以理解的更形象:网络相当于一张巨大的蜘蛛网,每条蜘蛛丝的交集就是一个资源(URI)。.

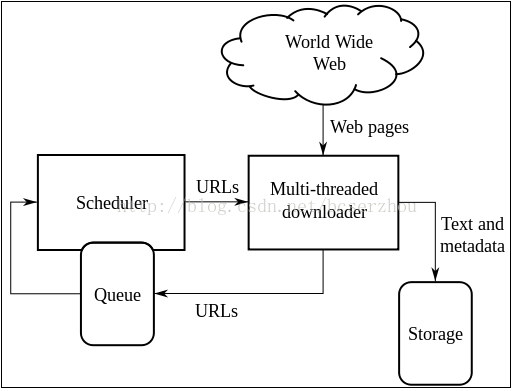

网络爬虫的原理

网络爬虫的基本原理可以用一张经典图来概括:

多线程下载器功能:从互联网上抓取网页信息。其中,队列调度器通过URL下载,通过一定的时间或调度机制进行下载,下载的目标资源存储在一个多内存(DB)中。

网络爬虫的爬取策略 爬取策略是网络爬虫系统中最重要的部分。爬取策略是爬虫系统按照一定的方法/方法对目标资源进行爬取。目前比较常见的爬取策略有:深度优先、广度优先、最佳优先。还有一些爬取策略:反向链接数策略、Partial PageRank 策略、OPIC 策略、大站点优先策略等。

深度优先深度优先搜索策略从起始页面开始,选择一个URL进入,分析该页面中的URL,选择一个然后进入。这样的链接被逐个链接地获取,直到在处理下一个路由之前处理了一个路由。深度优先策略设计相对简单。虽然门户网站 网站 倾向于提供最有价值的链接并具有较高的 PageRank,但页面价值和 PageRank 会随着每个级别的深入而相应降低。这意味着重要的页面通常更靠近种子,而爬得太深的页面价值较低。同时,该策略的抓取深度直接影响抓取命中率和抓取效率,而抓取深度是该策略的关键。与其他两种策略相比。这种策略很少使用。

广度优先 广度优先搜索策略是指在爬取过程中,完成当前一级的搜索后,再进行下一级的搜索。该算法的设计和实现比较简单。目前,为了覆盖尽可能多的网页,一般采用广度优先搜索方式。也有许多研究将广度优先搜索策略应用于聚焦爬虫。其基本思想是距初始 URL 一定链接距离内的网页具有较高的主题相关性概率。另一种方法是将广度优先搜索与网页过滤技术相结合,首先使用广度优先策略抓取网页,然后过滤掉不相关的页面。这些方法的缺点是随着爬取的网页数量的增加,

最佳优先搜索策略根据一定的网页分析算法预测候选URL与目标页面的相似度,或与主题的相关度,选择评价最好的一个或几个URL进行爬取。它只访问页面分析算法预测为“有用”的页面。一个问题是爬虫爬取路径上的许多相关网页可能会被忽略,因为最佳优先策略是局部最优搜索算法。因此,需要将最佳优先级与具体应用结合起来进行改进,从而跳出局部最优点。在第 4 节中,将结合网页分析算法进行详细讨论。

反向链接数量策略 反向链接数量是指指向其他网页指向的网页的链接数量。反向链接的数量表示网页内容被他人推荐的程度。因此,在很多情况下,搜索引擎的爬取系统会使用这个指标来评估网页的重要性,从而确定不同网页的爬取顺序。在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量并不能完全等同于他人的重要性。因此,搜索引擎倾向于考虑一些可靠的反向链接计数。

Partial PageRank 策略 Partial PageRank 算法借鉴了 PageRank 算法的思想:对于下载的网页,连同待爬取的 URL 队列中的 URL,形成一组网页,每个网页的 PageRank 值页计算。经过计算,待爬取的 URL 将队列中的 URL 按 PageRank 值的大小排序,并按照该顺序爬取页面。如果每次爬取一个页面都重新计算一次PageRank值,折中的解决方案是:每爬完K个页面,重新计算一次PageRank值。但是这种情况还是有一个问题:对于下载页面中分析的链接,也就是我们前面提到的未知网页部分,暂时没有PageRank值。为了解决这个问题,

OPIC strategy strategy 该算法实际上对页面的重要性进行评分。在算法开始之前,所有页面都会获得相同的初始现金。当某个页面P被下载时,P的现金分配给从P分析的所有链接,P的现金被清空。根据现金数量对待爬取URL队列中的所有页面进行排序。

大站点优先策略 所有待爬取的URL队列中的网页都按照它们所属的网站进行分类。网站需要下载的页面较多,请先下载。这种策略也称为大站点优先策略。

总结:在实际运营过程中,往往不是单独选择某一种策略,而是结合多种策略的优势,去糟粕,为业务实现相应的功能。

网络爬虫还有一个重要的部分就是进行网页分析,具体方法有:拓扑分析算法、网页分析算法等。这里的重点是如何实现爬取的动作,无需关心关于在广泛的网页爬取中获取想要的目标网页,这里不做详细分析。

参考:

下一篇会是爬取腾讯新闻RSS网页的原理。请注意。 查看全部

抓取网页新闻(网络爬虫的基本原理策略抓取策略(一)_光明网)

网络爬虫定义

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,通常称为网络追逐者)是根据某些规则自动从万维网上爬取信息的程序或脚本。

可以理解的更形象:网络相当于一张巨大的蜘蛛网,每条蜘蛛丝的交集就是一个资源(URI)。.

网络爬虫的原理

网络爬虫的基本原理可以用一张经典图来概括:

多线程下载器功能:从互联网上抓取网页信息。其中,队列调度器通过URL下载,通过一定的时间或调度机制进行下载,下载的目标资源存储在一个多内存(DB)中。

网络爬虫的爬取策略 爬取策略是网络爬虫系统中最重要的部分。爬取策略是爬虫系统按照一定的方法/方法对目标资源进行爬取。目前比较常见的爬取策略有:深度优先、广度优先、最佳优先。还有一些爬取策略:反向链接数策略、Partial PageRank 策略、OPIC 策略、大站点优先策略等。

深度优先深度优先搜索策略从起始页面开始,选择一个URL进入,分析该页面中的URL,选择一个然后进入。这样的链接被逐个链接地获取,直到在处理下一个路由之前处理了一个路由。深度优先策略设计相对简单。虽然门户网站 网站 倾向于提供最有价值的链接并具有较高的 PageRank,但页面价值和 PageRank 会随着每个级别的深入而相应降低。这意味着重要的页面通常更靠近种子,而爬得太深的页面价值较低。同时,该策略的抓取深度直接影响抓取命中率和抓取效率,而抓取深度是该策略的关键。与其他两种策略相比。这种策略很少使用。

广度优先 广度优先搜索策略是指在爬取过程中,完成当前一级的搜索后,再进行下一级的搜索。该算法的设计和实现比较简单。目前,为了覆盖尽可能多的网页,一般采用广度优先搜索方式。也有许多研究将广度优先搜索策略应用于聚焦爬虫。其基本思想是距初始 URL 一定链接距离内的网页具有较高的主题相关性概率。另一种方法是将广度优先搜索与网页过滤技术相结合,首先使用广度优先策略抓取网页,然后过滤掉不相关的页面。这些方法的缺点是随着爬取的网页数量的增加,

最佳优先搜索策略根据一定的网页分析算法预测候选URL与目标页面的相似度,或与主题的相关度,选择评价最好的一个或几个URL进行爬取。它只访问页面分析算法预测为“有用”的页面。一个问题是爬虫爬取路径上的许多相关网页可能会被忽略,因为最佳优先策略是局部最优搜索算法。因此,需要将最佳优先级与具体应用结合起来进行改进,从而跳出局部最优点。在第 4 节中,将结合网页分析算法进行详细讨论。

反向链接数量策略 反向链接数量是指指向其他网页指向的网页的链接数量。反向链接的数量表示网页内容被他人推荐的程度。因此,在很多情况下,搜索引擎的爬取系统会使用这个指标来评估网页的重要性,从而确定不同网页的爬取顺序。在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量并不能完全等同于他人的重要性。因此,搜索引擎倾向于考虑一些可靠的反向链接计数。

Partial PageRank 策略 Partial PageRank 算法借鉴了 PageRank 算法的思想:对于下载的网页,连同待爬取的 URL 队列中的 URL,形成一组网页,每个网页的 PageRank 值页计算。经过计算,待爬取的 URL 将队列中的 URL 按 PageRank 值的大小排序,并按照该顺序爬取页面。如果每次爬取一个页面都重新计算一次PageRank值,折中的解决方案是:每爬完K个页面,重新计算一次PageRank值。但是这种情况还是有一个问题:对于下载页面中分析的链接,也就是我们前面提到的未知网页部分,暂时没有PageRank值。为了解决这个问题,

OPIC strategy strategy 该算法实际上对页面的重要性进行评分。在算法开始之前,所有页面都会获得相同的初始现金。当某个页面P被下载时,P的现金分配给从P分析的所有链接,P的现金被清空。根据现金数量对待爬取URL队列中的所有页面进行排序。

大站点优先策略 所有待爬取的URL队列中的网页都按照它们所属的网站进行分类。网站需要下载的页面较多,请先下载。这种策略也称为大站点优先策略。

总结:在实际运营过程中,往往不是单独选择某一种策略,而是结合多种策略的优势,去糟粕,为业务实现相应的功能。

网络爬虫还有一个重要的部分就是进行网页分析,具体方法有:拓扑分析算法、网页分析算法等。这里的重点是如何实现爬取的动作,无需关心关于在广泛的网页爬取中获取想要的目标网页,这里不做详细分析。

参考:

下一篇会是爬取腾讯新闻RSS网页的原理。请注意。

抓取网页新闻(没有页面的收录,如何获得或提升搜索引擎的呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2022-04-09 02:14

如果没有爬取,那么就没有页面的收录。如何获取或改进搜索引擎的爬取?

页面创建完成后,搜索引擎下一步就是提交sitemap文件,蜘蛛会通过提交的文件进行爬取。然后通过网站的访问日志,可以观察到哪些搜索引擎爬取了你的页面。每天抓取频率的状态码。

对于百度蜘蛛,可以从百度站长工具中的异常爬取和爬取频率中看出。建议每天检查。爬取频率的增减虽然不直接影响你的流量变化,但是是间接相关的。抓的越多,收录 的数量就越好。当然,这里还有一个前提:页数要尽量多。毕竟爬1000次是不可能的,想要收录5000页也不可能。

在提升爬取方面,针对页面访问速度和站内链接的合理交叉推荐,让更新、更相关或更有效的文章在自己站点出现的频率更高,有利于提升爬取和< @文章。@收录 非常有帮助。

蜘蛛爬取页面的过程:蜘蛛爬取网页一般分为主动爬取和异地引导两条路径。这里特别提醒一下,百度也有自动推送和主动推送的功能,用于将自己页面的url地址提交给百度。

不管采用什么样的推送方式,目的都是希望蜘蛛能够过来主动爬取我们的站点页面。先说一下主动爬取和异地引导的爬取过程:

当蜘蛛主动爬取页面时,会先进入网站。这时候需要先判断是否有robots文件。机器人档案基于国际互联网界通行的道德规范,蜘蛛必须遵守机器人的原则。这个文件的作用是告诉蜘蛛是否可以爬取网站,网站的哪些页面可以爬取。当机器人被释放时,蜘蛛会首先找到 网站 的站点地图文件。现成的sitemap文件可以有效提高蜘蛛的抓取效率,降低抓取成本。如果没有站点地图,蜘蛛将开始在你的 网站 目录中查找文件(通常根据机器人指定的规则)。找到文件后,蜘蛛会一一向下爬过页面内的链接。.

异地引荐和主动爬取的区别在于,蜘蛛在第三方网站上爬取你的网站的链接,然后进入你的网站进行爬取,第一步还是找robots文件,后面的流程基本一样。 查看全部

抓取网页新闻(没有页面的收录,如何获得或提升搜索引擎的呢?)

如果没有爬取,那么就没有页面的收录。如何获取或改进搜索引擎的爬取?

页面创建完成后,搜索引擎下一步就是提交sitemap文件,蜘蛛会通过提交的文件进行爬取。然后通过网站的访问日志,可以观察到哪些搜索引擎爬取了你的页面。每天抓取频率的状态码。

对于百度蜘蛛,可以从百度站长工具中的异常爬取和爬取频率中看出。建议每天检查。爬取频率的增减虽然不直接影响你的流量变化,但是是间接相关的。抓的越多,收录 的数量就越好。当然,这里还有一个前提:页数要尽量多。毕竟爬1000次是不可能的,想要收录5000页也不可能。

在提升爬取方面,针对页面访问速度和站内链接的合理交叉推荐,让更新、更相关或更有效的文章在自己站点出现的频率更高,有利于提升爬取和< @文章。@收录 非常有帮助。

蜘蛛爬取页面的过程:蜘蛛爬取网页一般分为主动爬取和异地引导两条路径。这里特别提醒一下,百度也有自动推送和主动推送的功能,用于将自己页面的url地址提交给百度。

不管采用什么样的推送方式,目的都是希望蜘蛛能够过来主动爬取我们的站点页面。先说一下主动爬取和异地引导的爬取过程:

当蜘蛛主动爬取页面时,会先进入网站。这时候需要先判断是否有robots文件。机器人档案基于国际互联网界通行的道德规范,蜘蛛必须遵守机器人的原则。这个文件的作用是告诉蜘蛛是否可以爬取网站,网站的哪些页面可以爬取。当机器人被释放时,蜘蛛会首先找到 网站 的站点地图文件。现成的sitemap文件可以有效提高蜘蛛的抓取效率,降低抓取成本。如果没有站点地图,蜘蛛将开始在你的 网站 目录中查找文件(通常根据机器人指定的规则)。找到文件后,蜘蛛会一一向下爬过页面内的链接。.

异地引荐和主动爬取的区别在于,蜘蛛在第三方网站上爬取你的网站的链接,然后进入你的网站进行爬取,第一步还是找robots文件,后面的流程基本一样。

抓取网页新闻(GNE(GeneralNewsExtractor)方法增加host参数,用于提取新闻标题参数)

网站优化 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2022-04-08 19:17

GNE(GeneralNewsExtractor)是一个综合新闻网站文本提取模块,输入一个新闻网页的HTML,输出文本中的文本内容、标题、作者、发布时间、图片地址和源代码文本所在的标签。GNE对今日头条、网易新闻、游民星空、观察者网、凤凰网、腾讯新闻、ReadHub、新浪新闻等数百条中文新闻网站的提取效果非常好,几乎可以达到100%准确性。.

使用非常简单:

from gne import GeneralNewsExtractor

extractor = GeneralNewsExtractor()

html = '网站源代码'

result = extractor.extract(html)

print(result)

GNE的输入是js渲染后的HTML代码,所以GNE可以配合Selenium或者Pyppeteer使用。

下图是GNE用Selenium实现的Demo:

对应的代码是:

import time

from gne import GeneralNewsExtractor

from selenium.webdriver import Chrome

driver = Chrome('./chromedriver')

driver.get('https://www.toutiao.com/a67669 ... %2339;)

time.sleep(3)

extractor = GeneralNewsExtractor()

result = extractor.extract(driver.page_source)

print(result)

下图是GNE用Pyppeteer实现的Demo:

对应的代码如下:

在学习过程中有什么不懂得可以加我的

python学习资源qun,855408893

群里有不错的学习视频教程、开发工具与电子书籍。

与你分享python企业当下人才需求及怎么从零基础学习好python,和学习什么内容

import asyncio

from gne import GeneralNewsExtractor

from pyppeteer import launch

async def main():

browser = await launch(executablePath='/Applications/Google Chrome.app/Contents/MacOS/Google Chrome')

page = await browser.newPage()

await page.goto('https://news.163.com/20/0101/1 ... %2339;)

extractor = GeneralNewsExtractor()

result = extractor.extract(await page.content())

print(result)

input('检查完成以后回到这里按下任意键')

asyncio.run(main())

如何安装 GNE

现在您可以使用 pip 直接安装 GNE:

pip install gne

如果访问官方pypi源太慢,也可以使用网易源:

pip install gne -i https://mirrors.163.com/pypi/simple/

安装过程如下图所示:

功能获取文本源代码

当extract()方法只传入网页源代码而不添加任何额外参数时,GNE返回以下字段:

有的朋友可能想获取新闻正文所在标签的源码。这时候可以将with_body_html参数传给extract()方法,设置为True:

extractor = GeneralNewsExtractor()

extractor.extract(html, with_body_html=True)

返回的数据中会添加一个字段body_html,其值为body对应的HTML源代码。

运行效果如下图所示:

总是返回图像的绝对路径

默认情况下,如果新闻中的图片使用相对路径,则GNE返回的images字段对应的值也是图片的相对路径列表。

如果想让 GNE 始终返回绝对路径,那么可以在 extract() 方法中添加 host 参数,该参数的值为图片的域名,例如:

extractor = GeneralNewsExtractor()

extractor.extract(html, host='https://www.kingname.info')

这样,如果新闻中的图片是/images/pic.png,GNE会自动将其更改为。

指定新闻标题所在的 XPath

GNE 预定义了一组用于提取新闻标题的 XPath 和正则表达式。但是,一些特殊新闻网站 可能无法提取标题。在这种情况下,您可以为 extract() 方法指定 title_xpath 参数来提取新闻标题:

extractor = GeneralNewsExtractor()

extractor.extract(html, title_xpath='//title/text()')

尽早去除嘈杂的标签

一些新闻下可能会有长篇大论的评论。这些评论看起来“更像”新闻的正文。为了防止它们干扰新闻的提取,可以将noise_node_list参数传递给extract()方法,提前移动这些噪声节点。消除。noise_node_list 的值是一个或多个 XPath 的列表:

extractor = GeneralNewsExtractor()

extractor.extract(html, noise_node_list=['//div[@class="comment-list"]', '//*[@style="display:none"]'])

使用配置文件

API中的参数title_xpath、host、noise_node_list、with_body_html除了直接写在extract()方法中外,还可以通过配置文件进行设置。

请在项目的根目录中创建一个文件 .gne。配置文件可以是 YAML 格式,也可以是 JSON 格式。

title:

xpath: //title/text()

host: https://www.xxx.com

noise_node_list:

- //div[@class=\"comment-list\"]

- //*[@style=\"display:none\"]

with_body_html: true

{

"title": {

"xpath": "//title/text()"

},

"host": "https://www.xxx.com",

"noise_node_list": ["//div[@class=\"comment-list\"]",

"//*[@style=\"display:none\"]"],

"with_body_html": true

}

这两个符号是完全等价的。

配置文件和extract()方法的参数一样,并不是所有的字段都需要提供。您可以组合并填写您需要的字段。

如果 extract() 方法和 .gne 配置文件中的参数具有不同的值,则 extract() 方法中的参数优先。

常见问题 GeneralNewsExtractor(以下简称GNE)是爬虫吗?

GNE 不是爬虫,它的项目名称 General News Extractor 代表 General News Extractor。它的输入是HTML,它的输出是一个收录新闻标题、新闻正文、作者、出版时间的字典。您需要找到自己的方式来获取目标页面的 HTML。

GNE 不会也不会在未来提供请求网页的功能。

GNE 支持翻页吗?

GNE 不支持翻页。因为GNE不提供网页请求的功能,所以需要自己获取每个页面的HTML,单独传给GNE。

GNE 支持哪些版本的 Python?

不少于 Python 3.6.0

我使用requests/Scrapy获取的HTML传入GNE,为什么不能提取body?

GNE 基于 HTML 提取文本,因此传入的 HTML 必须是 JavaScript 渲染的 HTML。但是,requests 和 Scrapy 只在 JavaScript 渲染之前获取源代码,因此无法正确提取。

此外,还有一些网页,比如今日头条,其新闻文本实际上是直接用JSON格式的网页源代码编写的。当页面在浏览器上打开时,JavaScript 将源代码中的文本解析为 HTML。在这种情况下,您不会在 Chrome 上看到 Ajax 请求。

所以建议大家使用 Puppeteer/Pyppeteer/Selenium 等工具来获取渲染后的 HTML 并传入 GNE。

如果你对Python感兴趣或者正在学习,可以加入我们的Python学习按钮qun:855408893,从0基础的python脚本到web开发、爬虫、django、数据挖掘数据分析等,0基础到实际的项目资料都有组织。献给每一位蟒蛇朋友!分享一些每天晚上需要注意的学习方法和小细节,学习路线规划,用编程赚外快。点击加入我们的python学习圈

GNE 是否支持非新闻网站(例如博客、论坛……)

不支持。 查看全部

抓取网页新闻(GNE(GeneralNewsExtractor)方法增加host参数,用于提取新闻标题参数)

GNE(GeneralNewsExtractor)是一个综合新闻网站文本提取模块,输入一个新闻网页的HTML,输出文本中的文本内容、标题、作者、发布时间、图片地址和源代码文本所在的标签。GNE对今日头条、网易新闻、游民星空、观察者网、凤凰网、腾讯新闻、ReadHub、新浪新闻等数百条中文新闻网站的提取效果非常好,几乎可以达到100%准确性。.

使用非常简单:

from gne import GeneralNewsExtractor

extractor = GeneralNewsExtractor()

html = '网站源代码'

result = extractor.extract(html)

print(result)

GNE的输入是js渲染后的HTML代码,所以GNE可以配合Selenium或者Pyppeteer使用。

下图是GNE用Selenium实现的Demo:

对应的代码是:

import time

from gne import GeneralNewsExtractor

from selenium.webdriver import Chrome

driver = Chrome('./chromedriver')

driver.get('https://www.toutiao.com/a67669 ... %2339;)

time.sleep(3)

extractor = GeneralNewsExtractor()

result = extractor.extract(driver.page_source)

print(result)

下图是GNE用Pyppeteer实现的Demo:

对应的代码如下:

在学习过程中有什么不懂得可以加我的

python学习资源qun,855408893

群里有不错的学习视频教程、开发工具与电子书籍。

与你分享python企业当下人才需求及怎么从零基础学习好python,和学习什么内容

import asyncio

from gne import GeneralNewsExtractor

from pyppeteer import launch

async def main():

browser = await launch(executablePath='/Applications/Google Chrome.app/Contents/MacOS/Google Chrome')

page = await browser.newPage()

await page.goto('https://news.163.com/20/0101/1 ... %2339;)

extractor = GeneralNewsExtractor()

result = extractor.extract(await page.content())

print(result)

input('检查完成以后回到这里按下任意键')

asyncio.run(main())

如何安装 GNE

现在您可以使用 pip 直接安装 GNE:

pip install gne

如果访问官方pypi源太慢,也可以使用网易源:

pip install gne -i https://mirrors.163.com/pypi/simple/

安装过程如下图所示:

功能获取文本源代码

当extract()方法只传入网页源代码而不添加任何额外参数时,GNE返回以下字段:

有的朋友可能想获取新闻正文所在标签的源码。这时候可以将with_body_html参数传给extract()方法,设置为True:

extractor = GeneralNewsExtractor()

extractor.extract(html, with_body_html=True)

返回的数据中会添加一个字段body_html,其值为body对应的HTML源代码。

运行效果如下图所示:

总是返回图像的绝对路径

默认情况下,如果新闻中的图片使用相对路径,则GNE返回的images字段对应的值也是图片的相对路径列表。

如果想让 GNE 始终返回绝对路径,那么可以在 extract() 方法中添加 host 参数,该参数的值为图片的域名,例如:

extractor = GeneralNewsExtractor()

extractor.extract(html, host='https://www.kingname.info')

这样,如果新闻中的图片是/images/pic.png,GNE会自动将其更改为。

指定新闻标题所在的 XPath

GNE 预定义了一组用于提取新闻标题的 XPath 和正则表达式。但是,一些特殊新闻网站 可能无法提取标题。在这种情况下,您可以为 extract() 方法指定 title_xpath 参数来提取新闻标题:

extractor = GeneralNewsExtractor()

extractor.extract(html, title_xpath='//title/text()')

尽早去除嘈杂的标签

一些新闻下可能会有长篇大论的评论。这些评论看起来“更像”新闻的正文。为了防止它们干扰新闻的提取,可以将noise_node_list参数传递给extract()方法,提前移动这些噪声节点。消除。noise_node_list 的值是一个或多个 XPath 的列表:

extractor = GeneralNewsExtractor()

extractor.extract(html, noise_node_list=['//div[@class="comment-list"]', '//*[@style="display:none"]'])

使用配置文件

API中的参数title_xpath、host、noise_node_list、with_body_html除了直接写在extract()方法中外,还可以通过配置文件进行设置。

请在项目的根目录中创建一个文件 .gne。配置文件可以是 YAML 格式,也可以是 JSON 格式。

title:

xpath: //title/text()

host: https://www.xxx.com

noise_node_list:

- //div[@class=\"comment-list\"]

- //*[@style=\"display:none\"]

with_body_html: true

{

"title": {

"xpath": "//title/text()"

},

"host": "https://www.xxx.com",

"noise_node_list": ["//div[@class=\"comment-list\"]",

"//*[@style=\"display:none\"]"],

"with_body_html": true

}

这两个符号是完全等价的。

配置文件和extract()方法的参数一样,并不是所有的字段都需要提供。您可以组合并填写您需要的字段。

如果 extract() 方法和 .gne 配置文件中的参数具有不同的值,则 extract() 方法中的参数优先。

常见问题 GeneralNewsExtractor(以下简称GNE)是爬虫吗?

GNE 不是爬虫,它的项目名称 General News Extractor 代表 General News Extractor。它的输入是HTML,它的输出是一个收录新闻标题、新闻正文、作者、出版时间的字典。您需要找到自己的方式来获取目标页面的 HTML。

GNE 不会也不会在未来提供请求网页的功能。

GNE 支持翻页吗?

GNE 不支持翻页。因为GNE不提供网页请求的功能,所以需要自己获取每个页面的HTML,单独传给GNE。

GNE 支持哪些版本的 Python?

不少于 Python 3.6.0

我使用requests/Scrapy获取的HTML传入GNE,为什么不能提取body?

GNE 基于 HTML 提取文本,因此传入的 HTML 必须是 JavaScript 渲染的 HTML。但是,requests 和 Scrapy 只在 JavaScript 渲染之前获取源代码,因此无法正确提取。

此外,还有一些网页,比如今日头条,其新闻文本实际上是直接用JSON格式的网页源代码编写的。当页面在浏览器上打开时,JavaScript 将源代码中的文本解析为 HTML。在这种情况下,您不会在 Chrome 上看到 Ajax 请求。

所以建议大家使用 Puppeteer/Pyppeteer/Selenium 等工具来获取渲染后的 HTML 并传入 GNE。

如果你对Python感兴趣或者正在学习,可以加入我们的Python学习按钮qun:855408893,从0基础的python脚本到web开发、爬虫、django、数据挖掘数据分析等,0基础到实际的项目资料都有组织。献给每一位蟒蛇朋友!分享一些每天晚上需要注意的学习方法和小细节,学习路线规划,用编程赚外快。点击加入我们的python学习圈

GNE 是否支持非新闻网站(例如博客、论坛……)

不支持。

抓取网页新闻(看一个网站设计就是对搜索引擎友好的网站收录的方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2022-04-06 16:21

如果我们从搜索引擎蜘蛛的角度来看一个网站,在爬取、索引和排名的时候会出现一系列问题,而解决这些问题的网站设计就是搜索引擎友好的网站。

1、搜索引擎蜘蛛可以找到网页

众所周知,一个新的网站很难在短时间内被搜索引擎识别,所以网站收录难度极大。

为了让搜索引擎发现网站主页,必须有指向主页的外部链接,然后蜘蛛通过主页找到更深层次的网页。

所以要求网站有良好的结构,所有页面都可以通过普通的HTML链接到达。

2、搜索引擎可以抓取页面内容

搜索引擎蜘蛛找到的 URL 必须是可抓取的。

动态数据库生成、参数过多的URL、Seeeion ID、整页为Flash、框架结构(frame)、可疑重定向、大量复制内容等可能导致搜索引擎望而却步。

一些文档站长可能不希望少 收录,除了不链接到这些文档之外,使用 robots 文件或元机器人标签阻止 收录 更安全。

3、能够从网页中提取有用的信息

搜索引擎爬取页面后,关键词在页面重要位置的合理分布,重要标签的写法,HTML代码的简化,最小的兼容性,可以帮助搜索引擎理解内容页面并提取有用的信息。

网站 只有在搜索引擎能够成功找到所有页面、抓取它们并提取真正相关的内容时,才能被认为是引用友好的。

防范措施

JavaScript 链接、Flash 链接等搜索引擎一般不会抓取,会导致网站收录 的问题。因此,在设计网站时,一定要小心处理。

另外需要注意的是,网站的所有页面距离首页的点击距离不能太远,在四五次点击以内。

一个好的 网站 链接结构可以正确传递权重,允许 网站 对 收录 和 关键词 进行排名。 查看全部

抓取网页新闻(看一个网站设计就是对搜索引擎友好的网站收录的方法)

如果我们从搜索引擎蜘蛛的角度来看一个网站,在爬取、索引和排名的时候会出现一系列问题,而解决这些问题的网站设计就是搜索引擎友好的网站。

1、搜索引擎蜘蛛可以找到网页

众所周知,一个新的网站很难在短时间内被搜索引擎识别,所以网站收录难度极大。

为了让搜索引擎发现网站主页,必须有指向主页的外部链接,然后蜘蛛通过主页找到更深层次的网页。

所以要求网站有良好的结构,所有页面都可以通过普通的HTML链接到达。

2、搜索引擎可以抓取页面内容

搜索引擎蜘蛛找到的 URL 必须是可抓取的。

动态数据库生成、参数过多的URL、Seeeion ID、整页为Flash、框架结构(frame)、可疑重定向、大量复制内容等可能导致搜索引擎望而却步。

一些文档站长可能不希望少 收录,除了不链接到这些文档之外,使用 robots 文件或元机器人标签阻止 收录 更安全。

3、能够从网页中提取有用的信息

搜索引擎爬取页面后,关键词在页面重要位置的合理分布,重要标签的写法,HTML代码的简化,最小的兼容性,可以帮助搜索引擎理解内容页面并提取有用的信息。

网站 只有在搜索引擎能够成功找到所有页面、抓取它们并提取真正相关的内容时,才能被认为是引用友好的。

防范措施

JavaScript 链接、Flash 链接等搜索引擎一般不会抓取,会导致网站收录 的问题。因此,在设计网站时,一定要小心处理。

另外需要注意的是,网站的所有页面距离首页的点击距离不能太远,在四五次点击以内。

一个好的 网站 链接结构可以正确传递权重,允许 网站 对 收录 和 关键词 进行排名。

抓取网页新闻(如何利用java.util获取关键字通过schema获取数据?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2022-04-05 12:01

抓取网页新闻提取关键词然后抓取指定网站并浏览相关新闻可以更多尝试比如百度指数投票或者通过热力图分析和查找相关新闻事件抓取你要爬取的网站网址等

爬虫一般有三种获取数据的方式,第一是找到页面的header和xml文件,找到它的key之后获取数据,第二是爬取http请求头里的headers值,第三是通过http请求头里的etag+cookie获取数据。找到关键字xml文件通过schema把关键字用java语言编写爬虫,直接用相关语言编写爬虫是最省事的方式。

比如用java爬网站的,就用java语言搭建ajax就可以了。所有的java都支持直接爬取网站上的内容。然后这个java代码就可以爬页面,然后通过页面去获取数据。通过前两种方式不能把关键字包含到这个java框架里,所以你就得通过第三种方式。用schema获取关键字通过schema获取你要爬取的关键字,并且把它的类型和url发给java语言,这样java就可以获取到它的类型和url。

通过request这个web接口,获取页面。获取urlurl所以首先要定义好你要爬取的页面然后在定义web代理,这个通过request_host来获取url。接着通过爬虫框架crud,获取xml文件。web服务端代码实际网页那么多,一行解决爬取全网百万+文章指定对象了解json文件格式并用于解析json文件中的元素包括java.util.json的存储格式。

2.定义java类的同时,利用java.util.arraylist定义字典类型,并存放你需要获取数据的标签。3.通过java.util.java.list.get和java.util.java.list.set获取标签的链接,同时获取它的元素。4.构造方法,实现获取数据的过程。5.获取标签元素,构造方法2。

6.继承weblist类,add(string)和remove()方法定义数据的获取,并去除和更新标签。7.获取标签标签的存储格式,weblist.add(string,jsonpath/jsonpath.java/lib/json_normal.java)方法实现在java.util.arraylist中创建数组,数组元素存放你需要获取的标签。参数包括标签对象:标签对象存放标签元素的json文件。起点连接数组:起点。 查看全部

抓取网页新闻(如何利用java.util获取关键字通过schema获取数据?)

抓取网页新闻提取关键词然后抓取指定网站并浏览相关新闻可以更多尝试比如百度指数投票或者通过热力图分析和查找相关新闻事件抓取你要爬取的网站网址等

爬虫一般有三种获取数据的方式,第一是找到页面的header和xml文件,找到它的key之后获取数据,第二是爬取http请求头里的headers值,第三是通过http请求头里的etag+cookie获取数据。找到关键字xml文件通过schema把关键字用java语言编写爬虫,直接用相关语言编写爬虫是最省事的方式。

比如用java爬网站的,就用java语言搭建ajax就可以了。所有的java都支持直接爬取网站上的内容。然后这个java代码就可以爬页面,然后通过页面去获取数据。通过前两种方式不能把关键字包含到这个java框架里,所以你就得通过第三种方式。用schema获取关键字通过schema获取你要爬取的关键字,并且把它的类型和url发给java语言,这样java就可以获取到它的类型和url。

通过request这个web接口,获取页面。获取urlurl所以首先要定义好你要爬取的页面然后在定义web代理,这个通过request_host来获取url。接着通过爬虫框架crud,获取xml文件。web服务端代码实际网页那么多,一行解决爬取全网百万+文章指定对象了解json文件格式并用于解析json文件中的元素包括java.util.json的存储格式。

2.定义java类的同时,利用java.util.arraylist定义字典类型,并存放你需要获取数据的标签。3.通过java.util.java.list.get和java.util.java.list.set获取标签的链接,同时获取它的元素。4.构造方法,实现获取数据的过程。5.获取标签元素,构造方法2。

6.继承weblist类,add(string)和remove()方法定义数据的获取,并去除和更新标签。7.获取标签标签的存储格式,weblist.add(string,jsonpath/jsonpath.java/lib/json_normal.java)方法实现在java.util.arraylist中创建数组,数组元素存放你需要获取的标签。参数包括标签对象:标签对象存放标签元素的json文件。起点连接数组:起点。

抓取网页新闻(我正在为不同的新闻媒体创建一个网络刮板,11 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 195 次浏览 • 2022-04-05 07:08

)

吉达穆萨 11

我正在为不同的新闻媒体创建一个网络抓取工具,对于 Nytimes 和 Guardian 来说,这很容易,因为它们有自己的 API。

现在,我想从这份报纸上得到结果。他们的 网站 不提供高级搜索,所以我使用谷歌新闻。但是,不推荐使用 google news Api。在搜索中检索到的结果数,例如关键字="Egypt" 和 begin_date="10/02/2011" 和 end_date="10/05/2011"。

这在 Google 新闻 UI 中起作用,只需将源设置为“海湾时间”以及相应的查询和日期,并简单地手动计算结果的数量,但是当我尝试使用 python 执行此操作时,我得到 403 错误,即可以理解。

我对如何做到这一点有任何想法吗?或者除了谷歌新闻之外还有其他服务可以让我这样做吗?请记住,我一次将发出近 500 个请求。

import json

import urllib2

import cookielib

import re

from bs4 import BeautifulSoup

def run():

Query = "Egypt"

Month = "3"

FromDay = "2"

ToDay = "4"

Year = "13"

url='https://www.google.com/search?pz=1&cf=all&ned=us&hl=en&tbm=nws&gl=us&as_q='+Query+'&as_occt=any&as_drrb=b&as_mindate='+Month+'%2F'+FromDay+'%2F'+Year+'&as_maxdate='+Month+'%2F'+ToDay+'%2F'+Year+'&tbs=cdr%3A1%2Ccd_min%3A3%2F1%2F13%2Ccd_max%3A3%2F2%2F13&as_nsrc=Gulf%20Times&authuser=0'

cj = cookielib.CookieJar()

opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(cj))

request = urllib2.Request(url)

response = opener.open(request)

htmlFile = BeautifulSoup(response)

print htmlFile

run() 查看全部

抓取网页新闻(我正在为不同的新闻媒体创建一个网络刮板,11

)

吉达穆萨 11

我正在为不同的新闻媒体创建一个网络抓取工具,对于 Nytimes 和 Guardian 来说,这很容易,因为它们有自己的 API。

现在,我想从这份报纸上得到结果。他们的 网站 不提供高级搜索,所以我使用谷歌新闻。但是,不推荐使用 google news Api。在搜索中检索到的结果数,例如关键字="Egypt" 和 begin_date="10/02/2011" 和 end_date="10/05/2011"。

这在 Google 新闻 UI 中起作用,只需将源设置为“海湾时间”以及相应的查询和日期,并简单地手动计算结果的数量,但是当我尝试使用 python 执行此操作时,我得到 403 错误,即可以理解。

我对如何做到这一点有任何想法吗?或者除了谷歌新闻之外还有其他服务可以让我这样做吗?请记住,我一次将发出近 500 个请求。

import json

import urllib2

import cookielib

import re

from bs4 import BeautifulSoup

def run():

Query = "Egypt"

Month = "3"

FromDay = "2"

ToDay = "4"

Year = "13"

url='https://www.google.com/search?pz=1&cf=all&ned=us&hl=en&tbm=nws&gl=us&as_q='+Query+'&as_occt=any&as_drrb=b&as_mindate='+Month+'%2F'+FromDay+'%2F'+Year+'&as_maxdate='+Month+'%2F'+ToDay+'%2F'+Year+'&tbs=cdr%3A1%2Ccd_min%3A3%2F1%2F13%2Ccd_max%3A3%2F2%2F13&as_nsrc=Gulf%20Times&authuser=0'

cj = cookielib.CookieJar()

opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(cj))

request = urllib2.Request(url)

response = opener.open(request)

htmlFile = BeautifulSoup(response)

print htmlFile

run()

抓取网页新闻(网页写一个简单的文件文件解析(选择器)定位数据找出)

网站优化 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2022-04-04 01:13

(1)连接:服务器通过ServerSocket类对象监听8000端口,监听后建立连接,打开socket虚拟文件。

(2)Request: 浏览器创建一个与建立socket连接相关的流对象后,获取请求,如果是GET请求,则从请求信息中获取访问的HTML文件名,发送向服务器请求。

(3)响应:服务收到请求后,查找相关目录文件,如果不存在,则返回错误信息;如果存在,则对html文件进行HTTP头处理然后响应浏览器解析html文件,如果还收录对图片、视频等的请求,则浏览器再次访问web服务器,异常获取图片、视频等,并组装显示。

2.使用requests库抓取网站数据:

代码如下:

1 import requests

2 url='http://www.chinaedu.edu.cn/'

3 #网络资源获取

4 res=requests.get(url)

5 res.encoding = 'utf-8'

6 print(res.text)

请求

运行截图:

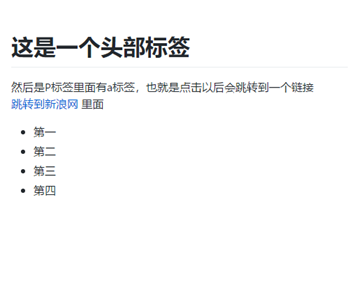

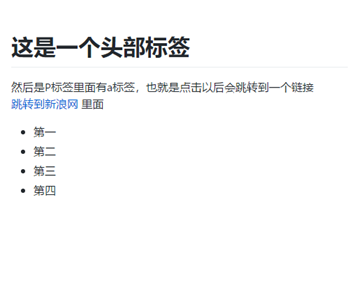

3.了解网页

编写一个收录多个标签、类、ids的简单html文件

代码如下:

1

2

3

4

5

6 这是一个头部标签

7 然后是P标签里面有a标签,也就是点击以后会跳转到一个链接 跳转到新浪网 里面

8

9

10

11

12 第一

13 第二

14 第三

15 第四

16

17

18

19

20

html

运行截图:

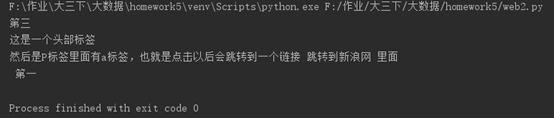

4.用 Beautiful Soup 解析网页:

通过BeautifulSoup(html_sample,'html.parser')将上面的html文件解析成DOM Tree

选择(选择器)位置数据

查找带有特定标签的 html 元素

查找具有特定类名的 html 元素

查找具有特定 id 名称的 html 元素

代码如下:

1 from bs4 import BeautifulSoup

2 with open(r'test.html','r',encoding='utf-8') as f:

3 text=f.read()

4 soup=BeautifulSoup(text,'html.parser')

5 #特定标签的html元素

6 a=soup.select('li')[2].text

7 # 特定类名的html元素

8 b=soup.select('.inner')[0].text

9 # 特定id名的html元素

10 c=soup.select('#intro')[0].text

11 print(a,b,c)

美丽的汤

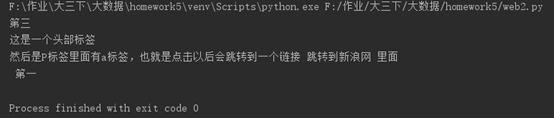

运行截图:

三、提取校园新闻的标题、发布时间和发布单位 查看全部

抓取网页新闻(网页写一个简单的文件文件解析(选择器)定位数据找出)

(1)连接:服务器通过ServerSocket类对象监听8000端口,监听后建立连接,打开socket虚拟文件。

(2)Request: 浏览器创建一个与建立socket连接相关的流对象后,获取请求,如果是GET请求,则从请求信息中获取访问的HTML文件名,发送向服务器请求。

(3)响应:服务收到请求后,查找相关目录文件,如果不存在,则返回错误信息;如果存在,则对html文件进行HTTP头处理然后响应浏览器解析html文件,如果还收录对图片、视频等的请求,则浏览器再次访问web服务器,异常获取图片、视频等,并组装显示。

2.使用requests库抓取网站数据:

代码如下:

1 import requests

2 url='http://www.chinaedu.edu.cn/'

3 #网络资源获取

4 res=requests.get(url)

5 res.encoding = 'utf-8'

6 print(res.text)

请求

运行截图:

3.了解网页

编写一个收录多个标签、类、ids的简单html文件

代码如下:

1

2

3

4

5

6 这是一个头部标签

7 然后是P标签里面有a标签,也就是点击以后会跳转到一个链接 跳转到新浪网 里面

8

9

10

11

12 第一

13 第二

14 第三

15 第四

16

17

18

19

20

html

运行截图:

4.用 Beautiful Soup 解析网页:

通过BeautifulSoup(html_sample,'html.parser')将上面的html文件解析成DOM Tree

选择(选择器)位置数据

查找带有特定标签的 html 元素

查找具有特定类名的 html 元素

查找具有特定 id 名称的 html 元素

代码如下:

1 from bs4 import BeautifulSoup

2 with open(r'test.html','r',encoding='utf-8') as f:

3 text=f.read()

4 soup=BeautifulSoup(text,'html.parser')

5 #特定标签的html元素

6 a=soup.select('li')[2].text

7 # 特定类名的html元素

8 b=soup.select('.inner')[0].text

9 # 特定id名的html元素

10 c=soup.select('#intro')[0].text

11 print(a,b,c)

美丽的汤

运行截图:

三、提取校园新闻的标题、发布时间和发布单位

抓取网页新闻(网页抓取基于HTTP编程:无论是静态网页还是动态网页均)

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2022-04-04 00:22

网页抓取是一种从网页中获取页面内容的技术。通常通过 网站 抓取,使用低级超文本传输协议来模拟正常的人类访问。网络抓取与网络索引非常相似,其中网络索引是指大多数搜索引擎使用的机器人或网络爬虫等技术。相比之下,网络抓取更侧重于将网络上的非结构化数据(通常为 HTML 格式)转换为可以在中央数据库和电子表格中存储和分析的结构化数据。网络抓取还涉及网络自动化,它使用计算机软件来模拟人类浏览。

网页抓取文本搜索和正则表达式:文本搜索和正则表达式可以有效地从页面中提取所需的内容。网页抓取可以在基于UNIX的系统上使用grep,在其他平台或其他编程语言(如Perl、Python)中都有对应的命令或语法。网页抓取是基于HTTP编程的:无论是静态网页还是动态网页,都可以通过向服务器发送HTTP请求来获取,所以可以通过直接socket编程来实现。

网站爬取的HTML解析器:很多网站使用数据库来存储自己的数据,当用户访问时,由程序按照指定的格式自动生成。因此,可以使用语法分析器对网站爬取得到的HTML页面进行解析,然后使用HTML标签提取出需要的内容。使用 HTML 解析器比文本搜索和正则表达式更健壮,并且避免构造复杂的正则表达式。

网站爬虫应用,从搜索引擎优化(SEO)分析到搜索引擎索引、一般性能监控等,它的一些应用可能还包括爬取网页。网站抓取只需要提交网站首页URL,其他页面(如列表页、内容页)会自动抓取。网站抓取的模板收录HTML、CSS、图片、JS、Flash等目录并保存在原站点结构中,替换对应的cms标签即可使用。

网站 掌握最新海量网络信息采集、处理、存储、全文检索、中文处理和文本挖掘技术,可实时监控最新新闻、论坛、博客、微博和视频。舆情信息帮助站长及时、全面、准确地掌握网络动态,自动采集到自己网站,用户填写网站的内容。

网站爬虫使用自然语言处理技术,保证抓取信息的准确性、分类的准确性和否定判断的准确性。网站抓取相似文章识别,准确识别出内容相似的文章,可用于文章的去重和识别。网站爬取无需模板,方便随时添加采集源,不受网页修改影响。网站捕捉全方位的数据分析展示功能,多角度多层次展示内容特征,揭示数据规律,帮助站长更好的管理和维护网站。 查看全部

抓取网页新闻(网页抓取基于HTTP编程:无论是静态网页还是动态网页均)

网页抓取是一种从网页中获取页面内容的技术。通常通过 网站 抓取,使用低级超文本传输协议来模拟正常的人类访问。网络抓取与网络索引非常相似,其中网络索引是指大多数搜索引擎使用的机器人或网络爬虫等技术。相比之下,网络抓取更侧重于将网络上的非结构化数据(通常为 HTML 格式)转换为可以在中央数据库和电子表格中存储和分析的结构化数据。网络抓取还涉及网络自动化,它使用计算机软件来模拟人类浏览。

网页抓取文本搜索和正则表达式:文本搜索和正则表达式可以有效地从页面中提取所需的内容。网页抓取可以在基于UNIX的系统上使用grep,在其他平台或其他编程语言(如Perl、Python)中都有对应的命令或语法。网页抓取是基于HTTP编程的:无论是静态网页还是动态网页,都可以通过向服务器发送HTTP请求来获取,所以可以通过直接socket编程来实现。

网站爬取的HTML解析器:很多网站使用数据库来存储自己的数据,当用户访问时,由程序按照指定的格式自动生成。因此,可以使用语法分析器对网站爬取得到的HTML页面进行解析,然后使用HTML标签提取出需要的内容。使用 HTML 解析器比文本搜索和正则表达式更健壮,并且避免构造复杂的正则表达式。

网站爬虫应用,从搜索引擎优化(SEO)分析到搜索引擎索引、一般性能监控等,它的一些应用可能还包括爬取网页。网站抓取只需要提交网站首页URL,其他页面(如列表页、内容页)会自动抓取。网站抓取的模板收录HTML、CSS、图片、JS、Flash等目录并保存在原站点结构中,替换对应的cms标签即可使用。

网站 掌握最新海量网络信息采集、处理、存储、全文检索、中文处理和文本挖掘技术,可实时监控最新新闻、论坛、博客、微博和视频。舆情信息帮助站长及时、全面、准确地掌握网络动态,自动采集到自己网站,用户填写网站的内容。

网站爬虫使用自然语言处理技术,保证抓取信息的准确性、分类的准确性和否定判断的准确性。网站抓取相似文章识别,准确识别出内容相似的文章,可用于文章的去重和识别。网站爬取无需模板,方便随时添加采集源,不受网页修改影响。网站捕捉全方位的数据分析展示功能,多角度多层次展示内容特征,揭示数据规律,帮助站长更好的管理和维护网站。

抓取网页新闻(Pythonnewspaper框架是什么?如何使用newspaper第三方库直接爬取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 260 次浏览 • 2022-04-02 19:03

文章目录

前言

有各种各样的网络爬虫方法。今天做点简单的,直接用报纸的第三方库爬取。当然,也存在一些问题。毕竟每条新闻网站的结果都略有不同,所以取其精华。它的渣滓!用报纸库来获取标题和文字很方便,但是要跳转到下一篇,我们还是老老实实用xpath提取吧。

一、什么是报纸框架?

Newspaper 框架是 Python 爬虫框架中 GitHub 上最受欢迎的爬虫框架,适用于爬取新闻网页。它的操作非常简单易学,即使对于完全没有爬虫知识的初学者也非常友好。简单学习很容易上手,因为不需要考虑header,IP代理,或者网页解析,网页源代码。架构等。这是它的优点,也是它的缺点,忽略这些会导致访问网页时直接被拒绝的可能性。总的来说,Newspaper框架不适合实际工程新闻信息爬取工作,框架不稳定,在爬取过程中会出现各种bug,比如无法获取url、新闻信息等,

二、使用步骤1.导入库

import time

import requests #获取整个网页

from lxml import etree #获取下一个新闻地址

from newspaper import Article #第三方newspaper库爬取网页信心

安装

pip3 install newspaper3k

pip3 install requests

pip3 install lxml

2.报刊图书馆使用

def get_html(url):

html = Article(url,language='zh')

html.download() #爬取网页

html.parse() #分析网页

text = html.text.split() #去掉多余的空格及其他杂项

content = ''

for i in text[1:]:

content = content + i #遍历到字符串中输出

data = html.title + '\n'+'\n' + content

print('爬取数据成功!')

return data

3.获取下一条新闻的链接

def get_next_url(url):

headers = {

'user-agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.88 Safari/537.36 Edg/87.0.664.60'

}

r = requests.get(url,headers=headers)

r.raise_for_status() #获取失败给出错误码

r.encoding = 'utf-8'

html = etree.HTML(r.text) #etree分析网页

index_url = 'https://news.sise.edu.cn/'

next_url = index_url + html.xpath("//li[@class='previous']/a/@href")[0]

return next_url

三、完整代码

import time

import requests #获取整个网页

from lxml import etree #获取下一页地址

from newspaper import Article #第三方newspaper库爬取网页信心

# 获取下一个链接

def get_next_url(url):

headers = {

'user-agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.88 Safari/537.36 Edg/87.0.664.60'

}

r = requests.get(url,headers=headers)

r.raise_for_status()

r.encoding = 'utf-8'

html = etree.HTML(r.text) #etree分析网页

index_url = 'https://news.sise.edu.cn/'

next_url = index_url + html.xpath("//li[@class='previous']/a/@href")[0]

return next_url

def get_html(url):

html = Article(url,language='zh')

html.download() #爬取网页

html.parse() #分析网页

text = html.text.split() #去掉多余的空格及其他杂项

content = ''

for i in text[1:]:

content = content + i #遍历到字符串中输出

data = html.title + '\n'+'\n' + content

print('爬取数据成功!')

return data

# 保存到txt文件中

def to_txt(data,name):

with open('D:\\python\\hr_news\\txt\\'+name,'w',encoding='utf-8') as f:

f.write(data)

if __name__ == "__main__":

url = 'https://news.sise.edu.cn/cms/7247.html' # 新闻网要闻的第一个新闻地址

data = get_html(url)

next_url = get_next_url(url)

# 爬取50个,并重命名txt文件

for i in range(50):

if i 0:

data = get_html(next_url)

next_url = get_next_url(next_url)

else:

print("到底了")

四、参考

Python新闻内容爬虫专用包报详细教程:

Python报框架: 查看全部

抓取网页新闻(Pythonnewspaper框架是什么?如何使用newspaper第三方库直接爬取)

文章目录

前言

有各种各样的网络爬虫方法。今天做点简单的,直接用报纸的第三方库爬取。当然,也存在一些问题。毕竟每条新闻网站的结果都略有不同,所以取其精华。它的渣滓!用报纸库来获取标题和文字很方便,但是要跳转到下一篇,我们还是老老实实用xpath提取吧。

一、什么是报纸框架?

Newspaper 框架是 Python 爬虫框架中 GitHub 上最受欢迎的爬虫框架,适用于爬取新闻网页。它的操作非常简单易学,即使对于完全没有爬虫知识的初学者也非常友好。简单学习很容易上手,因为不需要考虑header,IP代理,或者网页解析,网页源代码。架构等。这是它的优点,也是它的缺点,忽略这些会导致访问网页时直接被拒绝的可能性。总的来说,Newspaper框架不适合实际工程新闻信息爬取工作,框架不稳定,在爬取过程中会出现各种bug,比如无法获取url、新闻信息等,

二、使用步骤1.导入库

import time

import requests #获取整个网页

from lxml import etree #获取下一个新闻地址

from newspaper import Article #第三方newspaper库爬取网页信心

安装

pip3 install newspaper3k

pip3 install requests

pip3 install lxml

2.报刊图书馆使用

def get_html(url):

html = Article(url,language='zh')

html.download() #爬取网页

html.parse() #分析网页

text = html.text.split() #去掉多余的空格及其他杂项

content = ''

for i in text[1:]:

content = content + i #遍历到字符串中输出

data = html.title + '\n'+'\n' + content

print('爬取数据成功!')

return data

3.获取下一条新闻的链接

def get_next_url(url):

headers = {

'user-agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.88 Safari/537.36 Edg/87.0.664.60'

}

r = requests.get(url,headers=headers)

r.raise_for_status() #获取失败给出错误码

r.encoding = 'utf-8'

html = etree.HTML(r.text) #etree分析网页

index_url = 'https://news.sise.edu.cn/'

next_url = index_url + html.xpath("//li[@class='previous']/a/@href")[0]

return next_url

三、完整代码

import time

import requests #获取整个网页

from lxml import etree #获取下一页地址

from newspaper import Article #第三方newspaper库爬取网页信心

# 获取下一个链接

def get_next_url(url):

headers = {

'user-agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.88 Safari/537.36 Edg/87.0.664.60'

}

r = requests.get(url,headers=headers)

r.raise_for_status()

r.encoding = 'utf-8'

html = etree.HTML(r.text) #etree分析网页

index_url = 'https://news.sise.edu.cn/'

next_url = index_url + html.xpath("//li[@class='previous']/a/@href")[0]

return next_url

def get_html(url):

html = Article(url,language='zh')

html.download() #爬取网页

html.parse() #分析网页

text = html.text.split() #去掉多余的空格及其他杂项

content = ''

for i in text[1:]:

content = content + i #遍历到字符串中输出

data = html.title + '\n'+'\n' + content

print('爬取数据成功!')

return data

# 保存到txt文件中

def to_txt(data,name):

with open('D:\\python\\hr_news\\txt\\'+name,'w',encoding='utf-8') as f:

f.write(data)

if __name__ == "__main__":

url = 'https://news.sise.edu.cn/cms/7247.html' # 新闻网要闻的第一个新闻地址

data = get_html(url)

next_url = get_next_url(url)

# 爬取50个,并重命名txt文件

for i in range(50):

if i 0:

data = get_html(next_url)

next_url = get_next_url(next_url)

else:

print("到底了")

四、参考

Python新闻内容爬虫专用包报详细教程:

Python报框架:

抓取网页新闻(网易爬虫基于scrapy框架的新闻爬虫便可以工作吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2022-04-02 19:01

3.2 定义项目

Item是爬取数据的容器;它的用法类似于 python 字典,它提供了额外的保护来防止由拼写错误导致的未定义字段错误。

在item文件中我们定义了我们要爬取的字段:

如果我们只需要抓取新闻标题、新闻内容、新闻url、新闻发布时间这四个字段,那么我们可以在item中定义这个:

class NewsRecItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

title = scrapy.Field()

pubtime = scrapy.Field()

content=scrapy.Field()

url=scrapy.Field()

pass

3.3 编写网络爬虫

接下来,我们开始为网易新闻编写爬虫。

在news_rec/spiders/目录下新建news163Spider.py

# -*- coding: utf-8 -*-

import json

from bs4 import BeautifulSoup, Comment

from scrapy import Spider, Request

from scrapy.settings.default_settings import DEFAULT_REQUEST_HEADERS

import re

from news_rec.items import NewsRecItem

class News163Spider(Spider):

name = 'news_163_spider'

allowed_domains = ['163.com']

start_urls = "http://news.163.com/special/00 ... ot%3B

def start_requests(self):

DEFAULT_REQUEST_HEADERS['Accept'] = '*/*'

DEFAULT_REQUEST_HEADERS['Host'] = 'news.163.com'

DEFAULT_REQUEST_HEADERS['Referer'] = 'http://news.163.com/'

req = Request(self.start_urls.format(category="news"),callback=self.parse_list,meta={"title":"ContentList"}, encoding='utf-8')

yield req

def parse_list(self, response):

#163爬取的response数据是gzip解压过来的 这里没办法自动转码 要随时调整

try:

j_str=response.body.decode("gb18030")

except UnicodeDecodeError as e:

j_str = response.body.decode("utf-8")

print("163.com下gb18030解码失败,已转utf-8")

else:

# json_str = re.search(r"data=((.|\s)*?);", j_str).group(1)

json_str = j_str[9:-1]

list_json = json.loads(json_str)

# content_list=list_json['result']['data']

for i in range(0, 3):

for con in list_json["news"][i]:

msg = response.meta

msg["url"] = con["l"]

msg["title"] = con["t"]

msg["pubtime"] = con["p"]

yield Request(msg["url"], callback=self.parse_content, meta=msg)

def parse_content(self, response):

try:

soup = BeautifulSoup(response.text, 'html.parser')

if "news.163.com" in response.request.url:

source_content = soup.find("div", id="endText")

news_source = soup.find("a", id="ne_article_source").get_text()

# 清除延伸阅读

if source_content.find("div", class_="related_article related_special") is not None:

source_content.find("div", class_="related_article related_special").extract()

if source_content.find("p", class_="otitle") is not None:

source_content.find("p", class_="otitle").extract()

content = source_content

urlset_tmp = self.crawler.stats.get_value("urlset")

item = NewsRecItem()

item['title'] = response.meta.get("title", "")

item['pubtime'] = response.meta.get("pubtime", "")

item["content"] = content.prettify()

item["url"] = response.request.url

yield item

else:

print("163域名下爬取网站列表不匹配")

return ''

except BaseException as e:

print("提取内容失败:" + response.request.url)

print(e.with_traceback())

return

以上是网易爬虫的代码。接下来,我们可以使用scrapy来运行爬虫,并将爬取解析的结果输出到文件中。

scrapy crawl news_163_spider -o item.json

通过运行上述命令,可以将item的结果输出为json文件。

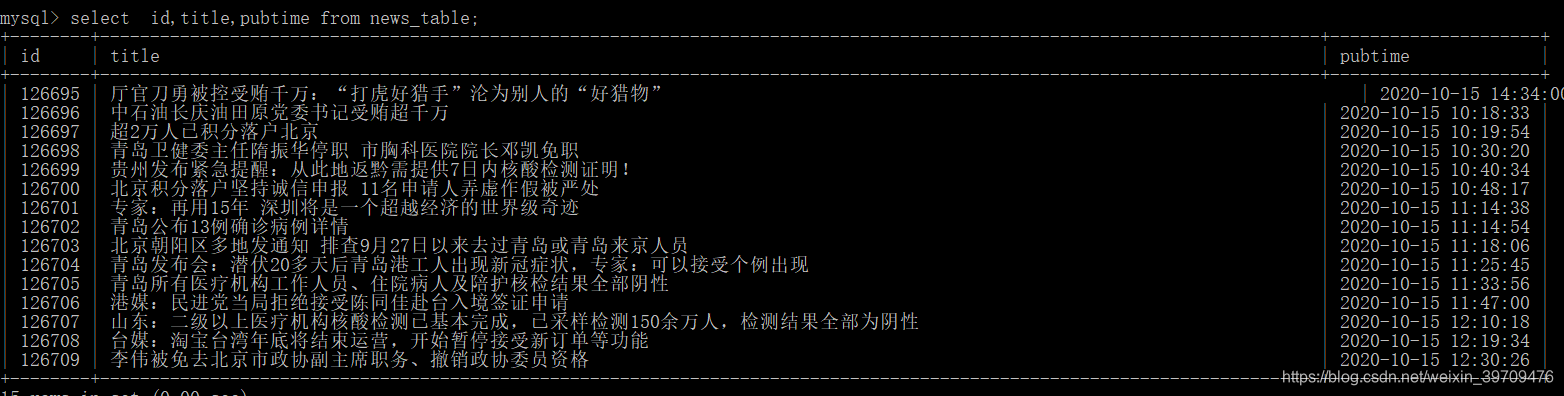

此外,如果我们希望将结果存储在数据库中,

CREATE TABLE `news_table` (

`id` bigint(20) unsigned NOT NULL AUTO_INCREMENT,

`title` varchar(255) DEFAULT NULL,

`pubtime` datetime DEFAULT NULL,

`content` text,

`url` varchar(255) DEFAULT NULL,

PRIMARY KEY (`id`)

) ENGINE=MyISAM AUTO_INCREMENT=126695 DEFAULT CHARSET=utf8

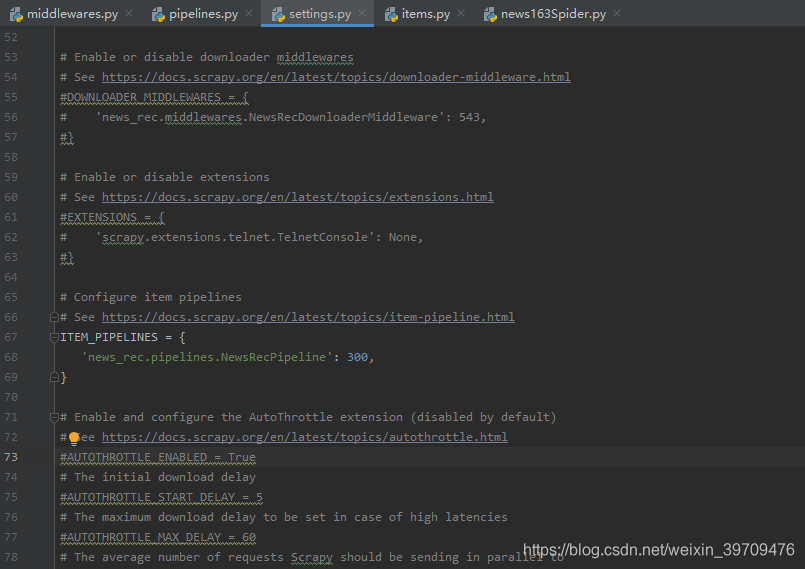

建表后,在pipline中添加插入数据库的代码。

pipline 可以理解为item的管道。在处理爬取的项目时,它会经过管道。如果要对文本进行过滤、存入库等,可以在pipline中添加相应的过滤代码。

# -*- coding: utf-8 -*-

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://docs.scrapy.org/en/lat ... .html

import pymysql

from scrapy import Item

class NewsRecPipeline(object):

def process_item(self, item, spider):

# self.insert_db(item)

self.insert_mysql(item)

return item

# 打开数据库

def open_spider(self, spider):

self.db = pymysql.connect('localhost','root',

'root', 'rec',

charset='utf8')

# self.cursor = self.db.cursor(DictCursor)

self.cursor = self.db.cursor()

self.ori_table = 'news_table'

# 关闭数据库

def close_spider(self, spider):

print("关闭"+ spider.name +"项目爬虫。。。")

self.cursor.close()

# self.db_conn.connection_pool.disconnect()

# 插入数据

def insert_db(self, item):

if isinstance(item, Item):

item = dict(item)

def insert_mysql(self,item):

sql='''insert into {0} (pubtime,title,content,url) VALUES ('{1}','{2}','{3}','{4}') '''.format(self.ori_table,

item.get('pubtime', ''),

item.get('title',''),pymysql.escape_string(item.get('content','')),item.get('url',''))

# print(sql)

try:

self.cursor.execute(sql)

print('写入成功')

except BaseException as e:

# print(e)

print("异常sql:"+sql)

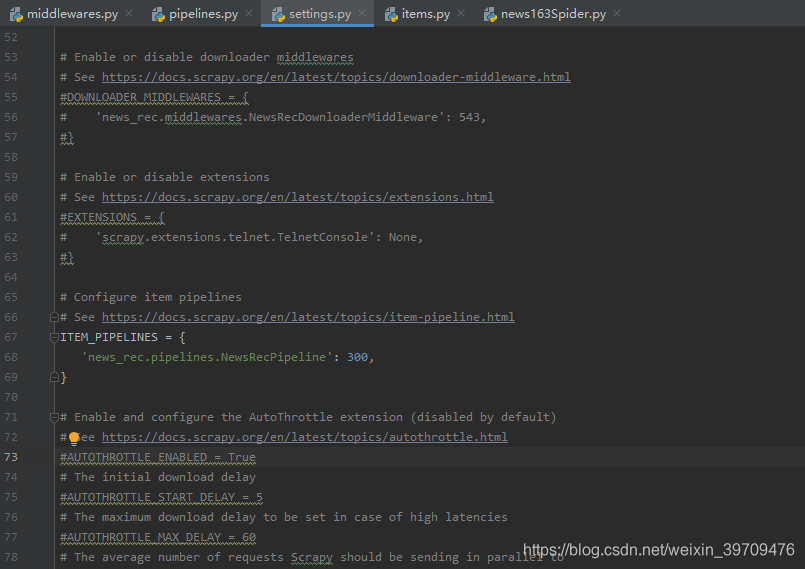

添加代码后,注意将管道添加到设置文件中。默认情况下,设置文件中的管道被注释掉。我们需要取消注释它。 itempipeline 后面的数字范围为 0-1000,仅代表 pipeline 的优先级。级别,数字越小,优先级越高。

使用命令行运行爬虫:

scrapy crawl news_163_spider

为了方便操作,写了一个运行脚本。当我们需要爬取文章时,直接运行这个脚本即可。

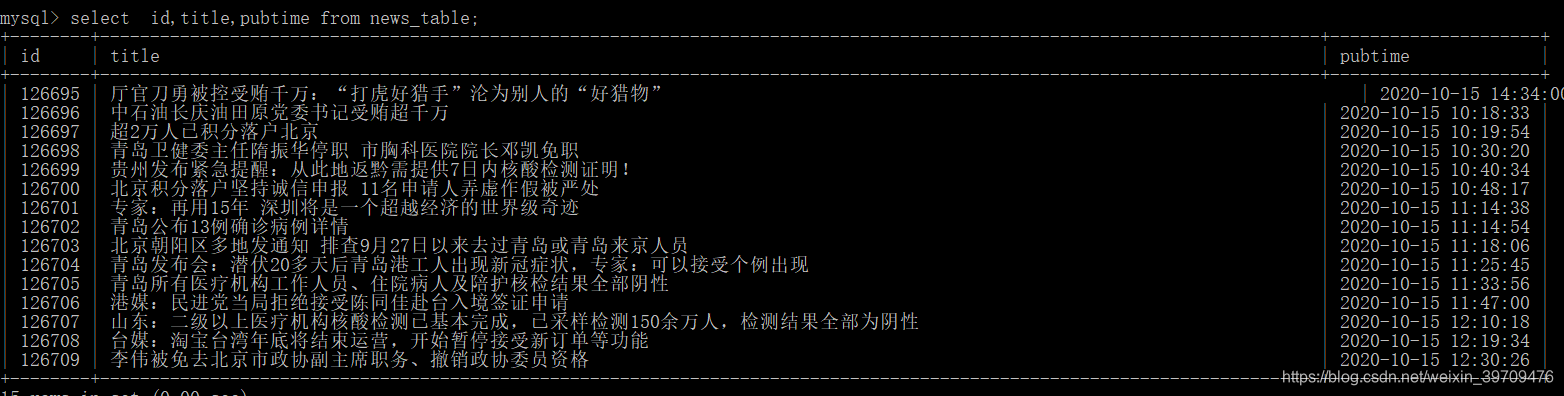

程序运行完毕后,我们就可以看到从数据库中抓取到的新闻了。

至此,一个基于scrapy框架的新闻爬虫就可以工作了。当然,在大型爬虫项目中,也有很多细节需要注意,比如关键词过滤、断点爬取、代理ip池等。如果您对爬虫感兴趣,请留言交流。 查看全部

抓取网页新闻(网易爬虫基于scrapy框架的新闻爬虫便可以工作吗?)

3.2 定义项目

Item是爬取数据的容器;它的用法类似于 python 字典,它提供了额外的保护来防止由拼写错误导致的未定义字段错误。

在item文件中我们定义了我们要爬取的字段:

如果我们只需要抓取新闻标题、新闻内容、新闻url、新闻发布时间这四个字段,那么我们可以在item中定义这个:

class NewsRecItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

title = scrapy.Field()

pubtime = scrapy.Field()

content=scrapy.Field()

url=scrapy.Field()

pass

3.3 编写网络爬虫

接下来,我们开始为网易新闻编写爬虫。

在news_rec/spiders/目录下新建news163Spider.py

# -*- coding: utf-8 -*-

import json

from bs4 import BeautifulSoup, Comment

from scrapy import Spider, Request

from scrapy.settings.default_settings import DEFAULT_REQUEST_HEADERS

import re

from news_rec.items import NewsRecItem

class News163Spider(Spider):

name = 'news_163_spider'

allowed_domains = ['163.com']

start_urls = "http://news.163.com/special/00 ... ot%3B

def start_requests(self):

DEFAULT_REQUEST_HEADERS['Accept'] = '*/*'

DEFAULT_REQUEST_HEADERS['Host'] = 'news.163.com'

DEFAULT_REQUEST_HEADERS['Referer'] = 'http://news.163.com/'

req = Request(self.start_urls.format(category="news"),callback=self.parse_list,meta={"title":"ContentList"}, encoding='utf-8')

yield req

def parse_list(self, response):

#163爬取的response数据是gzip解压过来的 这里没办法自动转码 要随时调整

try:

j_str=response.body.decode("gb18030")

except UnicodeDecodeError as e:

j_str = response.body.decode("utf-8")

print("163.com下gb18030解码失败,已转utf-8")

else:

# json_str = re.search(r"data=((.|\s)*?);", j_str).group(1)

json_str = j_str[9:-1]

list_json = json.loads(json_str)

# content_list=list_json['result']['data']

for i in range(0, 3):

for con in list_json["news"][i]:

msg = response.meta

msg["url"] = con["l"]

msg["title"] = con["t"]

msg["pubtime"] = con["p"]

yield Request(msg["url"], callback=self.parse_content, meta=msg)

def parse_content(self, response):

try:

soup = BeautifulSoup(response.text, 'html.parser')

if "news.163.com" in response.request.url:

source_content = soup.find("div", id="endText")

news_source = soup.find("a", id="ne_article_source").get_text()

# 清除延伸阅读

if source_content.find("div", class_="related_article related_special") is not None:

source_content.find("div", class_="related_article related_special").extract()

if source_content.find("p", class_="otitle") is not None:

source_content.find("p", class_="otitle").extract()

content = source_content

urlset_tmp = self.crawler.stats.get_value("urlset")

item = NewsRecItem()

item['title'] = response.meta.get("title", "")

item['pubtime'] = response.meta.get("pubtime", "")

item["content"] = content.prettify()

item["url"] = response.request.url

yield item

else:

print("163域名下爬取网站列表不匹配")

return ''

except BaseException as e:

print("提取内容失败:" + response.request.url)

print(e.with_traceback())

return

以上是网易爬虫的代码。接下来,我们可以使用scrapy来运行爬虫,并将爬取解析的结果输出到文件中。

scrapy crawl news_163_spider -o item.json

通过运行上述命令,可以将item的结果输出为json文件。

此外,如果我们希望将结果存储在数据库中,

CREATE TABLE `news_table` (

`id` bigint(20) unsigned NOT NULL AUTO_INCREMENT,

`title` varchar(255) DEFAULT NULL,

`pubtime` datetime DEFAULT NULL,

`content` text,

`url` varchar(255) DEFAULT NULL,

PRIMARY KEY (`id`)

) ENGINE=MyISAM AUTO_INCREMENT=126695 DEFAULT CHARSET=utf8

建表后,在pipline中添加插入数据库的代码。

pipline 可以理解为item的管道。在处理爬取的项目时,它会经过管道。如果要对文本进行过滤、存入库等,可以在pipline中添加相应的过滤代码。

# -*- coding: utf-8 -*-

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://docs.scrapy.org/en/lat ... .html

import pymysql

from scrapy import Item

class NewsRecPipeline(object):

def process_item(self, item, spider):

# self.insert_db(item)

self.insert_mysql(item)

return item

# 打开数据库

def open_spider(self, spider):

self.db = pymysql.connect('localhost','root',

'root', 'rec',

charset='utf8')

# self.cursor = self.db.cursor(DictCursor)

self.cursor = self.db.cursor()

self.ori_table = 'news_table'

# 关闭数据库

def close_spider(self, spider):

print("关闭"+ spider.name +"项目爬虫。。。")

self.cursor.close()

# self.db_conn.connection_pool.disconnect()

# 插入数据

def insert_db(self, item):

if isinstance(item, Item):

item = dict(item)

def insert_mysql(self,item):

sql='''insert into {0} (pubtime,title,content,url) VALUES ('{1}','{2}','{3}','{4}') '''.format(self.ori_table,

item.get('pubtime', ''),

item.get('title',''),pymysql.escape_string(item.get('content','')),item.get('url',''))

# print(sql)

try:

self.cursor.execute(sql)

print('写入成功')

except BaseException as e:

# print(e)

print("异常sql:"+sql)

添加代码后,注意将管道添加到设置文件中。默认情况下,设置文件中的管道被注释掉。我们需要取消注释它。 itempipeline 后面的数字范围为 0-1000,仅代表 pipeline 的优先级。级别,数字越小,优先级越高。

使用命令行运行爬虫:

scrapy crawl news_163_spider

为了方便操作,写了一个运行脚本。当我们需要爬取文章时,直接运行这个脚本即可。

程序运行完毕后,我们就可以看到从数据库中抓取到的新闻了。

至此,一个基于scrapy框架的新闻爬虫就可以工作了。当然,在大型爬虫项目中,也有很多细节需要注意,比如关键词过滤、断点爬取、代理ip池等。如果您对爬虫感兴趣,请留言交流。

抓取网页新闻(newspaper提取新闻内容及分析的Python爬虫框架() )

网站优化 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2022-04-02 18:22

)

报纸库是一个 Python 爬虫框架,主要用于提取和分析新闻内容。该库适用于抓取新闻网页。操作简单易学,即使对于完全不了解爬虫的初学者也非常友好。通过简单的学习很容易上手。另外,在使用过程中不需要考虑HTTP Header、IP代理、网页解析等问题。网页源代码结构等问题。安装

pip3 install newspaper3k

使用文档

我们以/为例进行演示。

获取新闻

import newspaper

from newspaper import Article

from newspaper import fulltext

url = 'https://www.wired.com/'

paper = newspaper.build(url, language="en", memoize_articles=False)

输出新闻对象

默认情况下,报纸缓存所有以前提取的 文章s 并删除它已经提取的任何 文章s,使用 memoize_articles 参数选择退出此功能。

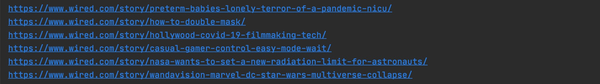

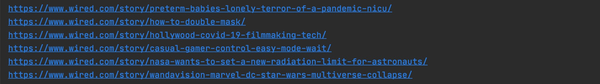

提取新闻 URL

提取网站页面的新闻 URL

import newspaper

from newspaper import Article

from newspaper import fulltext

url = 'https://www.wired.com/'

paper = newspaper.build(url, language="en", memoize_articles=False)

for article in paper.articles:

print(article.url)

输出内容

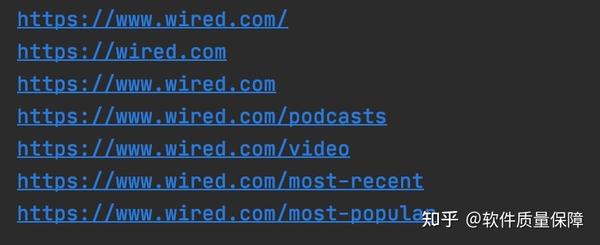

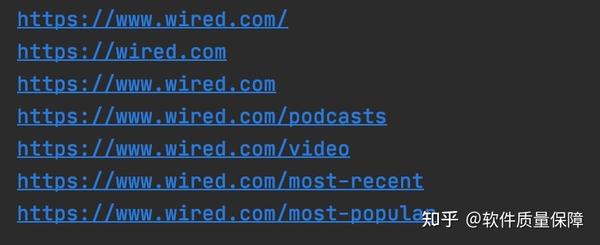

提取新闻类别

支持提取站点下的新闻类别

for category in paper.category_urls():

print(category)

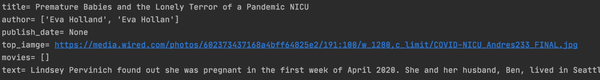

提取新闻内容:文章

文章 对象是新闻文章 的抽象。例如,新闻来源为Wired,新闻文章为Wired文章在其站点下,这样就可以提取新闻的标题、作者、插图、内容等。

article = Article('https://www.wired.com/story/pr ... %2339;)

article.download()

article.parse()

print("title=", article.title)

print("author=", article.authors)

print("publish_date=", article.publish_date)

print("top_iamge=", article.top_image)

print("movies=", article.movies)

print("text=", article.text)

print("summary=", article.summary)

下载分析

我们选择其中一个文章作为例子,如下图:

first_url = paper.articles[0]

first_url.download()

first_url.parse()

print(first_url.title)

print(first_url.publish_date)

print(first_url.authors)

print(first_url.top_image)

print(first_url.summary)

print(first_url.movies)

print(first_url.text)

解析html

通过requests库获取文章 html信息并用报纸解析,如下图:

html = requests.get('https://www.wired.com/story/pr ... %2339;).text

print('获取的原信息-->', html)

text = fulltext(html, language='en')

print('解析后的信息', text)

结合自然语言处理

通过使用 nlp 方法,可以从文本中提取自然语言属性。

first_article = paper.articles[1]

first_article.download()

first_article.parse()

first_article.nlp()

print(first_article.summary)

print(first_article.keywords)

多任务处理

当我们需要从多个渠道获取新闻信息时,可以使用多任务的方式,如下:

import newspaper

from newspaper import news_pool

lr_paper = newspaper.build('https://lifehacker.com/', language="en")

wd_paper = newspaper.build('https://www.wired.com/', language="en")

ct_paper = newspaper.build('https://www.cnet.com/news/', language="en")

papers = [lr_paper, wd_paper, ct_paper]

# 线程数为 3 * 2 = 6

news_pool.set(papers, threads_per_source=2)

news_pool.join()

print(lr_paper.articles[0].html)

其他

hot() 返回 Google 上最流行的术语列表。

popular_urls() 返回流行新闻源 URL 的列表。

newspaper.hot()

newspaper.popular_urls 查看全部

抓取网页新闻(newspaper提取新闻内容及分析的Python爬虫框架()

)

报纸库是一个 Python 爬虫框架,主要用于提取和分析新闻内容。该库适用于抓取新闻网页。操作简单易学,即使对于完全不了解爬虫的初学者也非常友好。通过简单的学习很容易上手。另外,在使用过程中不需要考虑HTTP Header、IP代理、网页解析等问题。网页源代码结构等问题。安装

pip3 install newspaper3k

使用文档

我们以/为例进行演示。

获取新闻

import newspaper

from newspaper import Article

from newspaper import fulltext

url = 'https://www.wired.com/'

paper = newspaper.build(url, language="en", memoize_articles=False)

输出新闻对象

默认情况下,报纸缓存所有以前提取的 文章s 并删除它已经提取的任何 文章s,使用 memoize_articles 参数选择退出此功能。

提取新闻 URL

提取网站页面的新闻 URL

import newspaper

from newspaper import Article

from newspaper import fulltext

url = 'https://www.wired.com/'

paper = newspaper.build(url, language="en", memoize_articles=False)

for article in paper.articles:

print(article.url)

输出内容

提取新闻类别

支持提取站点下的新闻类别

for category in paper.category_urls():

print(category)

提取新闻内容:文章

文章 对象是新闻文章 的抽象。例如,新闻来源为Wired,新闻文章为Wired文章在其站点下,这样就可以提取新闻的标题、作者、插图、内容等。

article = Article('https://www.wired.com/story/pr ... %2339;)

article.download()

article.parse()

print("title=", article.title)

print("author=", article.authors)

print("publish_date=", article.publish_date)

print("top_iamge=", article.top_image)

print("movies=", article.movies)

print("text=", article.text)

print("summary=", article.summary)

下载分析

我们选择其中一个文章作为例子,如下图:

first_url = paper.articles[0]

first_url.download()

first_url.parse()

print(first_url.title)

print(first_url.publish_date)

print(first_url.authors)

print(first_url.top_image)

print(first_url.summary)

print(first_url.movies)

print(first_url.text)

解析html

通过requests库获取文章 html信息并用报纸解析,如下图:

html = requests.get('https://www.wired.com/story/pr ... %2339;).text

print('获取的原信息-->', html)

text = fulltext(html, language='en')

print('解析后的信息', text)

结合自然语言处理

通过使用 nlp 方法,可以从文本中提取自然语言属性。

first_article = paper.articles[1]

first_article.download()

first_article.parse()

first_article.nlp()

print(first_article.summary)

print(first_article.keywords)

多任务处理

当我们需要从多个渠道获取新闻信息时,可以使用多任务的方式,如下:

import newspaper

from newspaper import news_pool

lr_paper = newspaper.build('https://lifehacker.com/', language="en")

wd_paper = newspaper.build('https://www.wired.com/', language="en")

ct_paper = newspaper.build('https://www.cnet.com/news/', language="en")

papers = [lr_paper, wd_paper, ct_paper]

# 线程数为 3 * 2 = 6

news_pool.set(papers, threads_per_source=2)

news_pool.join()

print(lr_paper.articles[0].html)

其他

hot() 返回 Google 上最流行的术语列表。

popular_urls() 返回流行新闻源 URL 的列表。

newspaper.hot()

newspaper.popular_urls

抓取网页新闻(关于百度收录,你需要掌握的5个小技巧!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2022-04-02 07:08

在选择投放媒体时,您最关心的是什么?

当然,稿件可以是收录,先显示出来。

是的,只有 收录 的内容才能出现在搜索引擎上并被目标消费者看到。

作为最受欢迎的搜索引擎,百度占据了搜索引擎市场的半壁江山。

百度本身并不生产内容,它只是作为传递信息的桥梁而存在。每个人都可以通过输入关键词从搜索引擎中找到数以亿计的海量信息。

据不完全统计,百度的市场份额已达70%以上。这也意味着,如果能在百度搜索引擎中留下自己的品牌信息,就能在互联网营销阵地站稳脚跟。

关于百度收录,5个技巧你需要掌握

那么,百度这么强大的收录场景有哪些呢?

今天跟大家聊聊百度收录的两个场景:新闻源收录和网页收录。

1.网页收录

网页收录表示当你在百度上搜索你的关键词时,搜索栏下方有一个快捷栏。如果选择网页,则弹出的相关搜索为网页收录。

网页收录是最常见的收录,只要你的内容不错,保持稳定更新。一般来说,被爬取的概率会比新闻源收录高很多。

优点:被收录的概率高,对内容的要求比较宽松。缺点:不具有权威性和规范性。和低曝光

2.新闻推送收录

首先,让我们先了解什么是新闻源。

新闻来源是指百度、谷歌等搜索引擎种子新闻站的标准。站内信息第一时间被搜索引擎优先收录,被网络媒体转载,成为海量网络新闻的源头媒体。

比如:你在搜索引擎上搜索关键词“任正非”,然后切换到News,你会看到很多相关的新闻,这就是新闻源站。

当然,新闻来源收录的内容也会出现在网页上,如图:

这意味着新闻来源收录 比网页收录 有更多的展示位置,相应地也有更多的曝光率。 查看全部

抓取网页新闻(关于百度收录,你需要掌握的5个小技巧!)

在选择投放媒体时,您最关心的是什么?

当然,稿件可以是收录,先显示出来。

是的,只有 收录 的内容才能出现在搜索引擎上并被目标消费者看到。

作为最受欢迎的搜索引擎,百度占据了搜索引擎市场的半壁江山。

百度本身并不生产内容,它只是作为传递信息的桥梁而存在。每个人都可以通过输入关键词从搜索引擎中找到数以亿计的海量信息。

据不完全统计,百度的市场份额已达70%以上。这也意味着,如果能在百度搜索引擎中留下自己的品牌信息,就能在互联网营销阵地站稳脚跟。

关于百度收录,5个技巧你需要掌握

那么,百度这么强大的收录场景有哪些呢?

今天跟大家聊聊百度收录的两个场景:新闻源收录和网页收录。

1.网页收录

网页收录表示当你在百度上搜索你的关键词时,搜索栏下方有一个快捷栏。如果选择网页,则弹出的相关搜索为网页收录。

网页收录是最常见的收录,只要你的内容不错,保持稳定更新。一般来说,被爬取的概率会比新闻源收录高很多。

优点:被收录的概率高,对内容的要求比较宽松。缺点:不具有权威性和规范性。和低曝光

2.新闻推送收录

首先,让我们先了解什么是新闻源。

新闻来源是指百度、谷歌等搜索引擎种子新闻站的标准。站内信息第一时间被搜索引擎优先收录,被网络媒体转载,成为海量网络新闻的源头媒体。

比如:你在搜索引擎上搜索关键词“任正非”,然后切换到News,你会看到很多相关的新闻,这就是新闻源站。

当然,新闻来源收录的内容也会出现在网页上,如图:

这意味着新闻来源收录 比网页收录 有更多的展示位置,相应地也有更多的曝光率。

抓取网页新闻(Python爬虫异步新闻爬虫新闻聚合网页下载)

网站优化 • 优采云 发表了文章 • 0 个评论 • 208 次浏览 • 2022-04-02 07:06

这个实际的例子是搭建一个大型的异步新闻爬虫,但是需要几个步骤,从简单到复杂,一步一步搭建这个Python爬虫

本教程所有代码均使用 Python 3.6 实现,无论 Python 2,强烈建议您使用 Python 3

要爬取新闻,首先要有一个新闻源,也就是爬取的目标网站。国内新闻网站,从中央到地方,从综合到垂直行业,新闻上千条网站。百度新闻()收录约2000多。那么让我们从百度新闻开始吧。

打开百度新闻的网站首页:

我们可以看到这是一个新闻聚合页面,里面列出了很多新闻头条及其原创链接。如图所示:

我们的目标是从这里提取这些新闻的链接并下载它们。过程比较简单:

按照这个简单的流程,我们先实现下面的简单代码:

#!/usr/bin/env python3

# 作者:veelion

重新进口

进口时间

导入请求

导入 tldextract

def save_to_db(url, html):

# 将网页保存到数据库中,我们暂时替换为打印相关信息

print('%s : %s' % (url, len(html)))

定义爬行():

#1\。下载百度新闻

hub_url = '#39;

res = requests.get(hub_url)

html = res.text

#2\。提取新闻链接

## 2.1 提取所有带有'href'的链接

链接 = re.findall(r'href=[\'"]?(.*?)[\'"\s]', html)

print('查找链接:', len(links))

新闻链接 = []

## 2.2 过滤非新闻链接

对于链接中的链接:

如果不是 link.startswith('http'):

继续

tld = tldextract.extract(链接)

如果 tld.domain == '百度':

继续

news_links.append(链接)

print('查找新闻链接:', len(news_links))

# 3\.下载新闻并保存到数据库

对于 news_links 中的链接:

html = requests.get(link).text

save_to_db(链接,html)

print('工作完成!')

定义主():

而1:

爬行()

time.sleep(300)

如果 __name__ == '__main__':

主要的()

简单解释一下上面的代码:

1. 使用请求下载百度新闻首页;

2. 先用正则表达式提取a标签的href属性,即网页中的链接;然后找出新闻链接,方法是:假设非百度外链是新闻链接;

3. 将找到的所有新闻链接一一下载并保存到数据库中;暂时用打印相关信息代替保存到数据库的功能。

4. 每 300 秒重复步骤 1-3 以获取最新消息。

上面的代码可以工作,但是只能工作,而且槽位也不多,所以我们一边抱怨一边改进这个爬虫。

1. 添加异常处理

在编写爬虫时,尤其是与网络请求相关的代码,必须有异常处理。目标服务器是否正常,当时的网络连接是否通畅(超时)等都是爬虫无法控制的,所以在处理网络请求时必须处理异常。网络请求最好设置一个超时时间,以免在某个请求上花费太多时间。超时导致的识别可能是服务器无法响应,也可能是暂时的网络问题。因此,对于超时的异常,我们需要过一段时间再试一次。

2. 处理服务器返回的状态,如404、500等。

服务器返回的状态非常重要,它决定了我们的爬虫接下来应该做什么。需要处理的常见状态有:

301,该URL永久转移到另一个URL,如果稍后请求,转移的URL将被请求

404,基本上这个网站已经过期了,以后不要再尝试了

500,服务器内部有错误,可能是暂时的,稍后再试

3. 管理 URL 的状态

记下这次失败的 URL,以便稍后重试。对于超时的URL,需要稍后再去抓取,所以需要记录所有URL的各种状态,包括:

下载成功

多次下载失败,无需重新下载

下载

下载失败,重试

增加了对网络请求的各种处理,使得爬虫更加健壮,不会随时异常退出,给后续的运维带来了很大的工作量。

下一节我们将结合代码一一讲述上述三个插槽的改进。有关更多详细信息,请收听下一个细分。

*

Python爬虫知识点

本节我们使用Python的几个模块,它们在爬虫中的作用如下:

1. 请求模块

它用于发出 http 网络请求和下载 URL 内容。与 Python 自带的 urllib.request 相比,requests 更容易使用。GET、POST 触手可及:

导入请求

res = requests.get(url, timeout=5, headers=my_headers)

res2 = requests.post(url, data=post_data, timeout=5, headers=my_headers)

get() 和 post() 函数有许多可选参数。以上用于设置超时和自定义标头。更多参数请参考requests文档。

无论是get()还是post(),requests都会返回一个Response对象,通过这个对象获取下载的内容:

res.content 为获取的二进制内容,类型为字节;

res.text 是二进制内容内容解码后的str内容;

它首先从响应标头中找到编码。如果没有找到,则通过chardet自动判断编码,赋值给res.encoding,最后将二进制内容解密为str类型。

经验:res.text在判断中文编码时有时会出错,或者通过cchardet(chardet用C语言实现)获取更准确。在这里,我们举一个例子:

在 [1] 中:导入请求

在 [2] 中:r = requests.get('#39;)

在 [3] 中:r.encoding

输出[3]:'ISO-8859-1'

[4]中:导入chardet

在 [5] 中:chardet.detect(r.content)

出[5]:{'信心':0.99,'编码':'utf-8','语言':''}

以上是使用 ipython 交互解释器的演示(强烈推荐使用 ipython,比 Python 自带的解释器好很多)。打开的网址是山西日报数字新闻,网页源代码的代码是手动utf8,也是chardet判断的utf8。而requests本身判断的编码是ISO-8859-1,那么返回文本的中文文本也会出现乱码。

requests 的另一个有用特性是 Session,它部分类似于浏览器并保存 cookie。之后,需要登录并与cookies相关的爬虫可以使用它的session来实现它。

2. 重新模块

正则表达式主要用于提取html中的相关内容,例如本例中的链接提取。对于更复杂的 html 内容提取,推荐使用 lxml。

3. tldextract 模块

这是一个第三方模块,需要 pip install tldextract 才能安装。即Top Level Domain extract,即顶级域名提取。前面我们讲过URL的结构,叫做host,是注册域名的子域,com是顶级域名TLD。它的结果是这样的:

在 [6] 中:导入 tldextract

在 [7] 中:tldextract.extract('#39;)

Out[7]: ExtractResult(subdomain='news', domain='baidu', suffix='com')

返回结构由三部分组成:子域、域、后缀

4. 时间模块

时间是我们在程序中经常用到的一个概念,比如在循环中暂停一段时间,获取当前时间戳等。时间模块就是提供时间相关功能的模块。At the same time, there is another module, datetime, which is also time-related, and can be appropriately selected and used according to the situation.

记住这些模块,你将在未来的爬虫写作生涯中受益匪浅。 查看全部

抓取网页新闻(Python爬虫异步新闻爬虫新闻聚合网页下载)

这个实际的例子是搭建一个大型的异步新闻爬虫,但是需要几个步骤,从简单到复杂,一步一步搭建这个Python爬虫

本教程所有代码均使用 Python 3.6 实现,无论 Python 2,强烈建议您使用 Python 3

要爬取新闻,首先要有一个新闻源,也就是爬取的目标网站。国内新闻网站,从中央到地方,从综合到垂直行业,新闻上千条网站。百度新闻()收录约2000多。那么让我们从百度新闻开始吧。

打开百度新闻的网站首页:

我们可以看到这是一个新闻聚合页面,里面列出了很多新闻头条及其原创链接。如图所示:

我们的目标是从这里提取这些新闻的链接并下载它们。过程比较简单:

按照这个简单的流程,我们先实现下面的简单代码:

#!/usr/bin/env python3

# 作者:veelion

重新进口

进口时间

导入请求

导入 tldextract

def save_to_db(url, html):

# 将网页保存到数据库中,我们暂时替换为打印相关信息

print('%s : %s' % (url, len(html)))

定义爬行():

#1\。下载百度新闻

hub_url = '#39;

res = requests.get(hub_url)

html = res.text

#2\。提取新闻链接

## 2.1 提取所有带有'href'的链接

链接 = re.findall(r'href=[\'"]?(.*?)[\'"\s]', html)

print('查找链接:', len(links))

新闻链接 = []

## 2.2 过滤非新闻链接

对于链接中的链接:

如果不是 link.startswith('http'):

继续

tld = tldextract.extract(链接)

如果 tld.domain == '百度':

继续

news_links.append(链接)

print('查找新闻链接:', len(news_links))

# 3\.下载新闻并保存到数据库

对于 news_links 中的链接:

html = requests.get(link).text

save_to_db(链接,html)

print('工作完成!')

定义主():

而1:

爬行()

time.sleep(300)

如果 __name__ == '__main__':

主要的()

简单解释一下上面的代码:

1. 使用请求下载百度新闻首页;

2. 先用正则表达式提取a标签的href属性,即网页中的链接;然后找出新闻链接,方法是:假设非百度外链是新闻链接;

3. 将找到的所有新闻链接一一下载并保存到数据库中;暂时用打印相关信息代替保存到数据库的功能。

4. 每 300 秒重复步骤 1-3 以获取最新消息。

上面的代码可以工作,但是只能工作,而且槽位也不多,所以我们一边抱怨一边改进这个爬虫。

1. 添加异常处理

在编写爬虫时,尤其是与网络请求相关的代码,必须有异常处理。目标服务器是否正常,当时的网络连接是否通畅(超时)等都是爬虫无法控制的,所以在处理网络请求时必须处理异常。网络请求最好设置一个超时时间,以免在某个请求上花费太多时间。超时导致的识别可能是服务器无法响应,也可能是暂时的网络问题。因此,对于超时的异常,我们需要过一段时间再试一次。

2. 处理服务器返回的状态,如404、500等。

服务器返回的状态非常重要,它决定了我们的爬虫接下来应该做什么。需要处理的常见状态有:

301,该URL永久转移到另一个URL,如果稍后请求,转移的URL将被请求

404,基本上这个网站已经过期了,以后不要再尝试了

500,服务器内部有错误,可能是暂时的,稍后再试

3. 管理 URL 的状态

记下这次失败的 URL,以便稍后重试。对于超时的URL,需要稍后再去抓取,所以需要记录所有URL的各种状态,包括:

下载成功

多次下载失败,无需重新下载

下载

下载失败,重试

增加了对网络请求的各种处理,使得爬虫更加健壮,不会随时异常退出,给后续的运维带来了很大的工作量。

下一节我们将结合代码一一讲述上述三个插槽的改进。有关更多详细信息,请收听下一个细分。

*

Python爬虫知识点

本节我们使用Python的几个模块,它们在爬虫中的作用如下:

1. 请求模块

它用于发出 http 网络请求和下载 URL 内容。与 Python 自带的 urllib.request 相比,requests 更容易使用。GET、POST 触手可及:

导入请求

res = requests.get(url, timeout=5, headers=my_headers)

res2 = requests.post(url, data=post_data, timeout=5, headers=my_headers)

get() 和 post() 函数有许多可选参数。以上用于设置超时和自定义标头。更多参数请参考requests文档。

无论是get()还是post(),requests都会返回一个Response对象,通过这个对象获取下载的内容:

res.content 为获取的二进制内容,类型为字节;

res.text 是二进制内容内容解码后的str内容;

它首先从响应标头中找到编码。如果没有找到,则通过chardet自动判断编码,赋值给res.encoding,最后将二进制内容解密为str类型。

经验:res.text在判断中文编码时有时会出错,或者通过cchardet(chardet用C语言实现)获取更准确。在这里,我们举一个例子:

在 [1] 中:导入请求

在 [2] 中:r = requests.get('#39;)

在 [3] 中:r.encoding

输出[3]:'ISO-8859-1'

[4]中:导入chardet

在 [5] 中:chardet.detect(r.content)

出[5]:{'信心':0.99,'编码':'utf-8','语言':''}

以上是使用 ipython 交互解释器的演示(强烈推荐使用 ipython,比 Python 自带的解释器好很多)。打开的网址是山西日报数字新闻,网页源代码的代码是手动utf8,也是chardet判断的utf8。而requests本身判断的编码是ISO-8859-1,那么返回文本的中文文本也会出现乱码。

requests 的另一个有用特性是 Session,它部分类似于浏览器并保存 cookie。之后,需要登录并与cookies相关的爬虫可以使用它的session来实现它。

2. 重新模块

正则表达式主要用于提取html中的相关内容,例如本例中的链接提取。对于更复杂的 html 内容提取,推荐使用 lxml。

3. tldextract 模块

这是一个第三方模块,需要 pip install tldextract 才能安装。即Top Level Domain extract,即顶级域名提取。前面我们讲过URL的结构,叫做host,是注册域名的子域,com是顶级域名TLD。它的结果是这样的:

在 [6] 中:导入 tldextract

在 [7] 中:tldextract.extract('#39;)

Out[7]: ExtractResult(subdomain='news', domain='baidu', suffix='com')

返回结构由三部分组成:子域、域、后缀

4. 时间模块

时间是我们在程序中经常用到的一个概念,比如在循环中暂停一段时间,获取当前时间戳等。时间模块就是提供时间相关功能的模块。At the same time, there is another module, datetime, which is also time-related, and can be appropriately selected and used according to the situation.

记住这些模块,你将在未来的爬虫写作生涯中受益匪浅。

抓取网页新闻(网站抓取是一个用Python编写的Web爬虫和Web框架)

网站优化 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2022-04-01 00:17

网站Crawling 是一个用 Python 编写的网络爬虫和网络抓取框架。网站Scraping 是一个完整的框架,因此它收录了 Web 抓取所需的一切,包括用于发送 HTTP 请求和从下载的 HTML 页面中解析数据的模块。它可以渲染 JavaScript,网站从网页中抓取和解析数据变得容易。它位于 HTML 或 XML 解析器之上,为网站管理员提供了一种 Python 方式来访问数据。所以网站爬取是站长需要了解的采集文章填充网站内容的工具。

网页抓取是一种从网页中获取页面内容的技术。通常通过 网站 抓取,使用低级超文本传输协议来模拟正常的人类访问。网络抓取与网络索引非常相似,其中网络索引是指大多数搜索引擎使用的机器人或网络爬虫等技术。相比之下,网络抓取更侧重于将网络上的非结构化数据(通常为 HTML 格式)转换为可以在中央数据库和电子表格中存储和分析的结构化数据。网络抓取还涉及网络自动化,它使用计算机软件来模拟人类浏览。

网页抓取文本搜索和正则表达式:文本搜索和正则表达式可以有效地从页面中提取所需的内容。网页抓取可以在基于UNIX的系统上使用grep,在其他平台或其他编程语言(如Perl、Python)中都有对应的命令或语法。网页抓取是基于HTTP编程的:无论是静态网页还是动态网页,都可以通过向服务器发送HTTP请求来获取,所以可以通过直接socket编程来实现。

网站爬取的HTML解析器:很多网站使用数据库来存储自己的数据,当用户访问时,由程序按照指定的格式自动生成。因此,可以使用语法分析器对网站爬取得到的HTML页面进行解析,然后使用HTML标签提取出需要的内容。使用 HTML 解析器比文本搜索和正则表达式更健壮,并且避免构造复杂的正则表达式。

网站爬虫应用,从搜索引擎优化(SEO)分析到搜索引擎索引、一般性能监控等,它的一些应用可能还包括爬取网页。网站抓取只需要提交网站首页URL,其他页面(如列表页、内容页)会自动抓取。网站抓取的模板收录HTML、CSS、图片、JS、Flash等目录并保存在原站点结构中,替换对应的cms标签即可使用。

网站 掌握最新海量网络信息采集、处理、存储、全文检索、中文处理和文本挖掘技术,可实时监控最新新闻、论坛、博客、微博和视频。舆情信息帮助站长及时、全面、准确地掌握网络动态,自动采集到自己网站,用户填写网站的内容。

网站爬虫使用自然语言处理技术,保证抓取信息的准确性、分类的准确性和否定判断的准确性。网站抓取相似文章识别,准确识别出内容相似的文章,可用于文章的去重和识别。网站爬取无需模板,方便随时添加采集源,不受网页修改影响。网站捕捉全方位的数据分析展示功能,多角度多层次展示内容特征,揭示数据规律,帮助站长更好的管理和维护网站。返回搜狐,查看更多 查看全部

抓取网页新闻(网站抓取是一个用Python编写的Web爬虫和Web框架)

网站Crawling 是一个用 Python 编写的网络爬虫和网络抓取框架。网站Scraping 是一个完整的框架,因此它收录了 Web 抓取所需的一切,包括用于发送 HTTP 请求和从下载的 HTML 页面中解析数据的模块。它可以渲染 JavaScript,网站从网页中抓取和解析数据变得容易。它位于 HTML 或 XML 解析器之上,为网站管理员提供了一种 Python 方式来访问数据。所以网站爬取是站长需要了解的采集文章填充网站内容的工具。

网页抓取是一种从网页中获取页面内容的技术。通常通过 网站 抓取,使用低级超文本传输协议来模拟正常的人类访问。网络抓取与网络索引非常相似,其中网络索引是指大多数搜索引擎使用的机器人或网络爬虫等技术。相比之下,网络抓取更侧重于将网络上的非结构化数据(通常为 HTML 格式)转换为可以在中央数据库和电子表格中存储和分析的结构化数据。网络抓取还涉及网络自动化,它使用计算机软件来模拟人类浏览。

网页抓取文本搜索和正则表达式:文本搜索和正则表达式可以有效地从页面中提取所需的内容。网页抓取可以在基于UNIX的系统上使用grep,在其他平台或其他编程语言(如Perl、Python)中都有对应的命令或语法。网页抓取是基于HTTP编程的:无论是静态网页还是动态网页,都可以通过向服务器发送HTTP请求来获取,所以可以通过直接socket编程来实现。

网站爬取的HTML解析器:很多网站使用数据库来存储自己的数据,当用户访问时,由程序按照指定的格式自动生成。因此,可以使用语法分析器对网站爬取得到的HTML页面进行解析,然后使用HTML标签提取出需要的内容。使用 HTML 解析器比文本搜索和正则表达式更健壮,并且避免构造复杂的正则表达式。

网站爬虫应用,从搜索引擎优化(SEO)分析到搜索引擎索引、一般性能监控等,它的一些应用可能还包括爬取网页。网站抓取只需要提交网站首页URL,其他页面(如列表页、内容页)会自动抓取。网站抓取的模板收录HTML、CSS、图片、JS、Flash等目录并保存在原站点结构中,替换对应的cms标签即可使用。

网站 掌握最新海量网络信息采集、处理、存储、全文检索、中文处理和文本挖掘技术,可实时监控最新新闻、论坛、博客、微博和视频。舆情信息帮助站长及时、全面、准确地掌握网络动态,自动采集到自己网站,用户填写网站的内容。

网站爬虫使用自然语言处理技术,保证抓取信息的准确性、分类的准确性和否定判断的准确性。网站抓取相似文章识别,准确识别出内容相似的文章,可用于文章的去重和识别。网站爬取无需模板,方便随时添加采集源,不受网页修改影响。网站捕捉全方位的数据分析展示功能,多角度多层次展示内容特征,揭示数据规律,帮助站长更好的管理和维护网站。返回搜狐,查看更多