关键词采集文章

关键词采集文章(石青建站养站大师是一款优化百度搜索引擎优化软件,您可通过)

采集交流 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2021-10-17 01:17

石青建站杨站大师是一款百度搜索引擎优化的优化软件。您可以通过施青建站杨站大师、自动设置广告等改进您的网站百度搜索收录问题和改进收录,欢迎有需要的朋友下载使用!

类似软件

印记

软件地址

石青软件特点

建站者往往希望能快速轻松地建站,并在短时间内获得高访问量。于是,我开始使用流行的cms程序来建网站,然后通过它的采集系统在网上发布了大量的采集。(比较常见的有东易cms、DEDEcms等)但百度长期以来一直忽略了超过100万人使用的免费cms系统。你肯定会发现,即使你用尽全力维护自己的网站,也看不到百度的收录,或者在收录之后,排名根本不会提升。为什么是这样?很简单,搜索引擎不喜欢大众化的东西,你要有自己的原创性,要有自己的特色。

石青软件特点

1、 极少数人使用的博客系统,与搜索引擎非常接近;

2、启用最先进的云端采集技术,不同于以往的cms采集,只能以网站采集为单位进行@>。我们可以像百度、谷歌一样关注关键词采集文章;

3、利用启发式伪原创系统辅助,将采集返回的文章模拟为原创的文章的搜索引擎;

4、 可以设置自动外链和自动广告,当你的流量上来时,轻松赚钱;

5、建站维护过程实时监控,所见所闻,建站维护不忽悠;

6、高性能代码是保证建站和维护高效率的前提;

7、博客模拟为cms文章管理系统,国内领先,早用早受益;

8、多核运营,和石青系列SEO软件一样无望无利;

9、 一键启动,整个过程自动化,一键无需担心,绝对方便;

10、每周更新,保证客户利益

石青主站维护更新日志

1、微信模块界面升级;

2、 改进了中文登录账号的自动转换;

3、改进了采集关键词的功能;

华军编辑推荐:

石青站维护大师这款软件的操作步骤非常简单快捷,用户可以放心使用。此外,乐益集成吊顶设计软件、原材体积计算器、广东企业所得税申报系统、派尔玻璃优化软件、泰友CPK计算工具等相关软件推荐下载使用。 查看全部

关键词采集文章(石青建站养站大师是一款优化百度搜索引擎优化软件,您可通过)

石青建站杨站大师是一款百度搜索引擎优化的优化软件。您可以通过施青建站杨站大师、自动设置广告等改进您的网站百度搜索收录问题和改进收录,欢迎有需要的朋友下载使用!

类似软件

印记

软件地址

石青软件特点

建站者往往希望能快速轻松地建站,并在短时间内获得高访问量。于是,我开始使用流行的cms程序来建网站,然后通过它的采集系统在网上发布了大量的采集。(比较常见的有东易cms、DEDEcms等)但百度长期以来一直忽略了超过100万人使用的免费cms系统。你肯定会发现,即使你用尽全力维护自己的网站,也看不到百度的收录,或者在收录之后,排名根本不会提升。为什么是这样?很简单,搜索引擎不喜欢大众化的东西,你要有自己的原创性,要有自己的特色。

石青软件特点

1、 极少数人使用的博客系统,与搜索引擎非常接近;

2、启用最先进的云端采集技术,不同于以往的cms采集,只能以网站采集为单位进行@>。我们可以像百度、谷歌一样关注关键词采集文章;

3、利用启发式伪原创系统辅助,将采集返回的文章模拟为原创的文章的搜索引擎;

4、 可以设置自动外链和自动广告,当你的流量上来时,轻松赚钱;

5、建站维护过程实时监控,所见所闻,建站维护不忽悠;

6、高性能代码是保证建站和维护高效率的前提;

7、博客模拟为cms文章管理系统,国内领先,早用早受益;

8、多核运营,和石青系列SEO软件一样无望无利;

9、 一键启动,整个过程自动化,一键无需担心,绝对方便;

10、每周更新,保证客户利益

石青主站维护更新日志

1、微信模块界面升级;

2、 改进了中文登录账号的自动转换;

3、改进了采集关键词的功能;

华军编辑推荐:

石青站维护大师这款软件的操作步骤非常简单快捷,用户可以放心使用。此外,乐益集成吊顶设计软件、原材体积计算器、广东企业所得税申报系统、派尔玻璃优化软件、泰友CPK计算工具等相关软件推荐下载使用。

关键词采集文章(石青建站养站大师2019版根据把个人博客网站仿真模拟为CMS信息发布平台站)

采集交流 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2021-10-16 10:11

主站维护是一款独特的SEO手机软件。基于模拟自己的个人博客网站作为信息发布平台站,达到了吸引搜索引擎的目的,产生了大量的总流量,为网站建设者产生了广告利润。石青建站大师2019版是基于模拟自己的个人博客网站作为信息发布平台站,吸引搜索引擎,产生大量总流量,为建站者产生广告. 利润。

升级日志:

升级1.7.6

1、是采集top10;

2、 升级了新的拼音规则;

3、 加快速度;

站长的功能特点:

1、 选择一个应用很少的个人博客系统,对搜索引擎非常友好;

2、开启最先进的云端采集技术,区别于通常的cms采集,只针对企业网站采集。我们可以关注百度、谷歌等关键词采集文章内容;

3、使用研讨会式原创文章系统软件辅助,可以将采集home文章的内容模拟成搜索引擎,创新文章内容;

4、可以设置自动外链和自动广告,如果你在总流量上升后在家赚钱;

5、建站维护全过程实时监控系统,你所听到的,建站维护站不会被骗;

6、优秀的性能编码是保证建站和维护高效率的前提;

7、模拟博客模拟为cms文章内容智能管理系统,中国领先,早使用早受益;

8、多核操作,和时青企业系列产品的SEO手机软件一样,不好用;

9、 一键启动,全流程自动化技术,一键不用操心,绝对方便;

10、每周升级一次,保障客户的应用权益。 查看全部

关键词采集文章(石青建站养站大师2019版根据把个人博客网站仿真模拟为CMS信息发布平台站)

主站维护是一款独特的SEO手机软件。基于模拟自己的个人博客网站作为信息发布平台站,达到了吸引搜索引擎的目的,产生了大量的总流量,为网站建设者产生了广告利润。石青建站大师2019版是基于模拟自己的个人博客网站作为信息发布平台站,吸引搜索引擎,产生大量总流量,为建站者产生广告. 利润。

升级日志:

升级1.7.6

1、是采集top10;

2、 升级了新的拼音规则;

3、 加快速度;

站长的功能特点:

1、 选择一个应用很少的个人博客系统,对搜索引擎非常友好;

2、开启最先进的云端采集技术,区别于通常的cms采集,只针对企业网站采集。我们可以关注百度、谷歌等关键词采集文章内容;

3、使用研讨会式原创文章系统软件辅助,可以将采集home文章的内容模拟成搜索引擎,创新文章内容;

4、可以设置自动外链和自动广告,如果你在总流量上升后在家赚钱;

5、建站维护全过程实时监控系统,你所听到的,建站维护站不会被骗;

6、优秀的性能编码是保证建站和维护高效率的前提;

7、模拟博客模拟为cms文章内容智能管理系统,中国领先,早使用早受益;

8、多核操作,和时青企业系列产品的SEO手机软件一样,不好用;

9、 一键启动,全流程自动化技术,一键不用操心,绝对方便;

10、每周升级一次,保障客户的应用权益。

关键词采集文章(网站关键词采集文章的影响因素有哪些?-八维教育)

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2021-10-15 17:01

关键词采集文章都是一个关键词,其他热度一般的关键词排在前列。百度百科、互动百科、搜狗百科、谷歌百科也可以采集,效果会比较好。对于全新的网站可以做点百度热搜词、首页热搜词,用关键词采集工具采集,然后自己用自动排名软件进行自动排名。一个词可以采集3-4个页面。关键词分布。可以有多少关键词来采集,这个需要看网站规模的,确定了要采集哪些关键词,首先确定页面之间有没有关联性,没有关联性的,从统计网站统计词频。

如果关联性,那确定哪些页面可以采集。百度一般关键词的总数超过100的都会收录。关键词相关性。确定关键词以后,确定这个关键词和哪些页面有关联性,或者是否和哪些页面有关联性,来确定页面的相关性。页面内容的相关性。页面内容的相关性决定了页面权重的相关性。下面用百度指数来作为一个参考。如图搜索某个关键词时,整个谷歌收录的词条数量;如果收录的词条是从没有收录过,而这个词对这个关键词有用处,那么这个关键词的权重对整个网站是有用的。

下面以天猫网站为例,对关键词权重的影响进行分析。收录和排名——最重要的影响因素。收录越多,排名越靠前。换言之如果收录越多,页面排名越靠前。如果收录少,在排名靠前的页面内采集数据没有排名靠前页面的权重大,那么收录数据并不能起到反作用。其中词频越高的页面,权重越高。词频越高,说明页面越容易收录。带权重的页面排名就会越靠前。

关键词填充。相关性很重要。关键词集中在其他地方提供,这个页面没有收录;那个网站有这个词,网站里面有这个词,他们两个网站里面有收录,他们两个网站所收录的词列表里的词不是这个词的。不是这个词的关键词又没有收录。那么如何更有效的提高相关性呢?这个只能通过更大的关键词爬虫来实现;针对那些会收录的关键词,先采集相关性更高的页面,每个页面都收录,然后再去采集收录数据对这个网站进行分析,选择会收录的页面,然后做整站统计,集中这些长尾词或其他词去爬页面。

效果就是这样做出来的网站,关键词自动排名比人工定期爬页面好。百度问答。搜索天猫,天猫网站的内容相对其他网站高,能直接采集搜索天猫网站的内容,然后再去爬天猫网站。有效方法是,搜索天猫内容的某个关键词,查看排名第一的关键词对应的页面是否收录。如果没有收录,再去下载其他的天猫页面,采集下来,再对这些页面进行分析。

可以集中这些页面去关键词分析,然后做成模板自己使用。总结——百度指数是关键词的热度排行。关键词采集包括词频、top100页面,总结关键词的内容质量,搜索量,带权重。 查看全部

关键词采集文章(网站关键词采集文章的影响因素有哪些?-八维教育)

关键词采集文章都是一个关键词,其他热度一般的关键词排在前列。百度百科、互动百科、搜狗百科、谷歌百科也可以采集,效果会比较好。对于全新的网站可以做点百度热搜词、首页热搜词,用关键词采集工具采集,然后自己用自动排名软件进行自动排名。一个词可以采集3-4个页面。关键词分布。可以有多少关键词来采集,这个需要看网站规模的,确定了要采集哪些关键词,首先确定页面之间有没有关联性,没有关联性的,从统计网站统计词频。

如果关联性,那确定哪些页面可以采集。百度一般关键词的总数超过100的都会收录。关键词相关性。确定关键词以后,确定这个关键词和哪些页面有关联性,或者是否和哪些页面有关联性,来确定页面的相关性。页面内容的相关性。页面内容的相关性决定了页面权重的相关性。下面用百度指数来作为一个参考。如图搜索某个关键词时,整个谷歌收录的词条数量;如果收录的词条是从没有收录过,而这个词对这个关键词有用处,那么这个关键词的权重对整个网站是有用的。

下面以天猫网站为例,对关键词权重的影响进行分析。收录和排名——最重要的影响因素。收录越多,排名越靠前。换言之如果收录越多,页面排名越靠前。如果收录少,在排名靠前的页面内采集数据没有排名靠前页面的权重大,那么收录数据并不能起到反作用。其中词频越高的页面,权重越高。词频越高,说明页面越容易收录。带权重的页面排名就会越靠前。

关键词填充。相关性很重要。关键词集中在其他地方提供,这个页面没有收录;那个网站有这个词,网站里面有这个词,他们两个网站里面有收录,他们两个网站所收录的词列表里的词不是这个词的。不是这个词的关键词又没有收录。那么如何更有效的提高相关性呢?这个只能通过更大的关键词爬虫来实现;针对那些会收录的关键词,先采集相关性更高的页面,每个页面都收录,然后再去采集收录数据对这个网站进行分析,选择会收录的页面,然后做整站统计,集中这些长尾词或其他词去爬页面。

效果就是这样做出来的网站,关键词自动排名比人工定期爬页面好。百度问答。搜索天猫,天猫网站的内容相对其他网站高,能直接采集搜索天猫网站的内容,然后再去爬天猫网站。有效方法是,搜索天猫内容的某个关键词,查看排名第一的关键词对应的页面是否收录。如果没有收录,再去下载其他的天猫页面,采集下来,再对这些页面进行分析。

可以集中这些页面去关键词分析,然后做成模板自己使用。总结——百度指数是关键词的热度排行。关键词采集包括词频、top100页面,总结关键词的内容质量,搜索量,带权重。

关键词采集文章(翻译b站和有道云翻译ipad教程推荐(二))

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2021-10-13 20:00

关键词采集文章翻译b站和有道云翻译ipad教程推荐对于我这种只想无脑推荐的,以上都是没用的如果对翻译本身有兴趣,选择一门喜欢的语言去进行练习,

我去年五月入的字幕组,三个月后我成为翻译组组长,二个月后成为接活特别多的译员。不要问我什么时候有文凭,我是那种慢热型。

能力强了以后就没有高低贵贱。

不存在的。没有工作机会,只有成为这个方向上的人的资格。你能成为别人希望听见的那种人,你就能成为别人希望看见的那种人。学的越多看的越多,你的自我认同才能越强烈。

如果对字幕组真心感兴趣,建议自己找相关工作,在你解决经济问题后,积累一定的翻译经验后直接去字幕组。但如果对字幕组只是抱着试试的心态,以此来锻炼自己,个人并不建议。如果去字幕组,建议先找相关行业的工作积累经验,尽快做到翻译组组长级别。有了翻译能力,开始积累固定客户,尽快完成自己的作品,同时开始扩展业务范围和圈子,相信我,你会在此过程中与字幕组在市场的不断竞争中,慢慢的成为一个出色的翻译,甚至比原本的职业翻译做的更好。因为这是市场机制下的你必须去做的事情。希望我的回答对你有所帮助。

先能找到工作,然后考虑任何一个你在你老家的行业找不到工作, 查看全部

关键词采集文章(翻译b站和有道云翻译ipad教程推荐(二))

关键词采集文章翻译b站和有道云翻译ipad教程推荐对于我这种只想无脑推荐的,以上都是没用的如果对翻译本身有兴趣,选择一门喜欢的语言去进行练习,

我去年五月入的字幕组,三个月后我成为翻译组组长,二个月后成为接活特别多的译员。不要问我什么时候有文凭,我是那种慢热型。

能力强了以后就没有高低贵贱。

不存在的。没有工作机会,只有成为这个方向上的人的资格。你能成为别人希望听见的那种人,你就能成为别人希望看见的那种人。学的越多看的越多,你的自我认同才能越强烈。

如果对字幕组真心感兴趣,建议自己找相关工作,在你解决经济问题后,积累一定的翻译经验后直接去字幕组。但如果对字幕组只是抱着试试的心态,以此来锻炼自己,个人并不建议。如果去字幕组,建议先找相关行业的工作积累经验,尽快做到翻译组组长级别。有了翻译能力,开始积累固定客户,尽快完成自己的作品,同时开始扩展业务范围和圈子,相信我,你会在此过程中与字幕组在市场的不断竞争中,慢慢的成为一个出色的翻译,甚至比原本的职业翻译做的更好。因为这是市场机制下的你必须去做的事情。希望我的回答对你有所帮助。

先能找到工作,然后考虑任何一个你在你老家的行业找不到工作,

关键词采集文章(你网站不会有什么收入,你的关键词不会给你带去收入)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-10-13 02:39

这个文章是自动写入的,内容不要注册。

关键词采集的话,采集,采集,采集等等,这样的站不仅是垃圾站,还能给你带来很多流量. 同时,这些站点也会给你带来大量的流量。你网站不会有任何收入,你的关键词不会给你带来很多流量,也不是你的关键词不会给你带来收入,我给你关键词@ > 成为 伪原创。

关键词采集字

我的网站是新建的,我每天更新,发链接,发布,写软文,把每个文章发布到专业网站,这样我的网站你就可以了有一个很好的排名。我每天有几百个网站,像这样的网站还有很多。有人说我的网站是这样的,但是我的排名不稳定。这就是我的样子。我的排名不稳定,但我的排名仍然不稳定。

2、关键词的定位关键词是我网站的主关键词,我将网站的主关键词定位为: 这个词在百度搜索引擎中表现很好。很多新手在优化网站关键词的时候都会考虑到关键词的选择和定位。这对我有帮助 网站 有很多影响。如果我在百度上的排名还不错,那就不要做。关键词的设置要掌握。它不应该太宽泛。这是不可避免的。我们在做seo。那个时候应该选择一些比较流行的关键词,比如:电影下载,电影下载,电影下载,电影下载,电影下载等关键词,我的目标是做Go up,这样做的目的是让搜索引擎更好地了解我的网站是怎么做的,

3、网站结构设置关键词是网站的基础,网站结构设置决定了网站的排名,<网站的结构设计@网站是为了做好网站的整体形象设计。在制作网站的结构时,我们应该设置网站的主要关键词,Introduction,这样我们的优化工作就会得到很好的结果,在这种情况下,结构设计网站 非常重要。我们在优化网站的时候,应该把网站整体的列做的大而整齐,这样这些列可以有效的增加我们的网站的权重。

关键词采集字

网站结构设置关键词是网站整体形象设置的关键,网站页面结构设置关键词是网站优化的基础,我们需要想一个整洁的网站结构。在设置结构关键词时,首先要设置关键词和长尾关键词,其次是用户搜索习惯。设置用户喜欢的词和长尾词,设置key的时候最好不要使用太多的长尾词。这样的关键词不仅可以给自己带来大量的流量,还能让自己的网站获得更好的排名,所以效果会更好。

4关键词布局设置关键词设置是网站的主要流量 查看全部

关键词采集文章(你网站不会有什么收入,你的关键词不会给你带去收入)

这个文章是自动写入的,内容不要注册。

关键词采集的话,采集,采集,采集等等,这样的站不仅是垃圾站,还能给你带来很多流量. 同时,这些站点也会给你带来大量的流量。你网站不会有任何收入,你的关键词不会给你带来很多流量,也不是你的关键词不会给你带来收入,我给你关键词@ > 成为 伪原创。

关键词采集字

我的网站是新建的,我每天更新,发链接,发布,写软文,把每个文章发布到专业网站,这样我的网站你就可以了有一个很好的排名。我每天有几百个网站,像这样的网站还有很多。有人说我的网站是这样的,但是我的排名不稳定。这就是我的样子。我的排名不稳定,但我的排名仍然不稳定。

2、关键词的定位关键词是我网站的主关键词,我将网站的主关键词定位为: 这个词在百度搜索引擎中表现很好。很多新手在优化网站关键词的时候都会考虑到关键词的选择和定位。这对我有帮助 网站 有很多影响。如果我在百度上的排名还不错,那就不要做。关键词的设置要掌握。它不应该太宽泛。这是不可避免的。我们在做seo。那个时候应该选择一些比较流行的关键词,比如:电影下载,电影下载,电影下载,电影下载,电影下载等关键词,我的目标是做Go up,这样做的目的是让搜索引擎更好地了解我的网站是怎么做的,

3、网站结构设置关键词是网站的基础,网站结构设置决定了网站的排名,<网站的结构设计@网站是为了做好网站的整体形象设计。在制作网站的结构时,我们应该设置网站的主要关键词,Introduction,这样我们的优化工作就会得到很好的结果,在这种情况下,结构设计网站 非常重要。我们在优化网站的时候,应该把网站整体的列做的大而整齐,这样这些列可以有效的增加我们的网站的权重。

关键词采集字

网站结构设置关键词是网站整体形象设置的关键,网站页面结构设置关键词是网站优化的基础,我们需要想一个整洁的网站结构。在设置结构关键词时,首先要设置关键词和长尾关键词,其次是用户搜索习惯。设置用户喜欢的词和长尾词,设置key的时候最好不要使用太多的长尾词。这样的关键词不仅可以给自己带来大量的流量,还能让自己的网站获得更好的排名,所以效果会更好。

4关键词布局设置关键词设置是网站的主要流量

关键词采集文章(如何利用nltk进行关键词提取向量表征?教程在此)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-09-27 16:02

关键词采集文章关键词采集,也叫关键词排名采集,英文叫titlepooling,利用文章的标题、正文作为一个文档的关键词提取向量表征,根据关键词出现的概率来采集文章的关键词。采集新闻或小说通常是获取标题和摘要关键词。利用nltk进行关键词提取你可以在某宝买阿里云的提供的阿里云的nltk库,和自己写写python或者fortran代码。

将文章中有用的词通过提取向量来定位文章关键词。具体教程如下:文章关键词采集(一)获取文章的标题,可以用fortran实现如何获取关键词?:文章关键词采集(二)获取小说或者新闻文章标题获取小说或者新闻标题:获取文章标题本次教程就写到这里,后面我的教程重点讲如何利用nltk库爬爬源代码。

1.文章正文内容,网上多数都是有目录标注,一般情况下会采用正则或者字典分词2.关键词词频判断,多数情况下利用pythonselenium这类第三方库,python内置了用户验证,让你成功登录,可以获取关键词。

看你要爬什么内容。有些关键词搜索率高一点。如何获取文章内容:1:文章内部链接。2:文章标题。3:新闻源地址。手机客户端同步。

如果你要爬取网页上的文章标题,可以写爬虫去爬取,现在很多互联网爬虫支持文章关键词的内容提取,但是要爬虫爬取小说内容就得用人工爬取。建议你用搜索引擎爬取,而不是自己写爬虫爬取,搜索引擎爬取关键词的方法是比较成熟的,根据关键词列表匹配出来的搜索结果,具有精准性,也是一种最简单高效的方法。推荐你一个爬虫专栏:2018三茅人工智能之旅专栏最新版本3.3.13,网络抓取及爬虫技术分享!。 查看全部

关键词采集文章(如何利用nltk进行关键词提取向量表征?教程在此)

关键词采集文章关键词采集,也叫关键词排名采集,英文叫titlepooling,利用文章的标题、正文作为一个文档的关键词提取向量表征,根据关键词出现的概率来采集文章的关键词。采集新闻或小说通常是获取标题和摘要关键词。利用nltk进行关键词提取你可以在某宝买阿里云的提供的阿里云的nltk库,和自己写写python或者fortran代码。

将文章中有用的词通过提取向量来定位文章关键词。具体教程如下:文章关键词采集(一)获取文章的标题,可以用fortran实现如何获取关键词?:文章关键词采集(二)获取小说或者新闻文章标题获取小说或者新闻标题:获取文章标题本次教程就写到这里,后面我的教程重点讲如何利用nltk库爬爬源代码。

1.文章正文内容,网上多数都是有目录标注,一般情况下会采用正则或者字典分词2.关键词词频判断,多数情况下利用pythonselenium这类第三方库,python内置了用户验证,让你成功登录,可以获取关键词。

看你要爬什么内容。有些关键词搜索率高一点。如何获取文章内容:1:文章内部链接。2:文章标题。3:新闻源地址。手机客户端同步。

如果你要爬取网页上的文章标题,可以写爬虫去爬取,现在很多互联网爬虫支持文章关键词的内容提取,但是要爬虫爬取小说内容就得用人工爬取。建议你用搜索引擎爬取,而不是自己写爬虫爬取,搜索引擎爬取关键词的方法是比较成熟的,根据关键词列表匹配出来的搜索结果,具有精准性,也是一种最简单高效的方法。推荐你一个爬虫专栏:2018三茅人工智能之旅专栏最新版本3.3.13,网络抓取及爬虫技术分享!。

关键词采集文章(关键词排名优化做的就越好,文章源自于网络)

采集交流 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2021-09-25 22:04

关键词 排名优化是网站 优化工作的重中之重。一个流量大、权重高的网站必须有强大的关键词库支持。而研究网站关键词词库对于SEO工作来说是很重要的事情,但是大部分SEO人员都没有一个合理规划的关键词库,即使是最基本的Excel表格,其实,这是一种盲目和随机的行为。往往造成网站内部关键词的竞争,浪费有效的在线资源,优化内容,造成不必要的负担。那怎么看自己的网站的关键词库,可以通过站长工具或者爱站工具看到关键词库,词库越多越多这意味着网站权重越高,

文章来自网络

一、我们先来了解一下什么是关键词词库?

简单理解:关键词库是为目标网站挖掘、采集、整理的相关关键词同义词表,对于特定的关键词,通常包括以下类型:

1、行业关键词图书馆和产品关键词图书馆

一般来说,关键词 不同行业的图书馆有不同的特点。比如医疗行业和机械行业就很不一样。机械行业强调在产品关键词库中积累了大量的产品模型。医疗行业专注于医疗术语的扩展。

2、 广告 关键词 图书馆

广告关键词 库通常用于品牌建设。它由描述公司理念和产品特性的特定核心词组成。它还担负着传播和吸引流量的责任,比如:曾经对于红极一时的“投诉体”,需要梳理一下关键词这部分与企业契合相关的库。它需要简短的内容、新词的创造和情感共鸣。

3、 敏感 关键词 库

对于一个网站,无论是论坛还是独立博客,都需要过滤一些被禁止的关键词,尤其是博客评论的内容,否则很可能被监管机构屏蔽,搜索引擎掉电,这通常不会为收益付出代价。

4、 长尾关键词 库和流行的关键词 库

根据关键词索引,网站关键词词库分为长尾词库关键词和热门关键词词库。这两部分是关键词优化重要的参考对象。

二、网站关键词库是怎么来的?

网站关键词库是一个站长工具或爱站工具,基于网站索引和排名前50的关键词,关键词排名比较好,关键词库关键词越多,你获得的流量就越多。这些关键词词由核心关键词和长尾关键词组成,所以一定要注意关键词的布局和网站的内容质量。

三、如何构建关键词库?

1、采集三类关键词

关键词一般分为三类:目标关键词、长尾关键词和品牌关键词。既然是关键词的集合,这三种关键词一般有大有小,但长尾关键词一般是从关键词的根派生出来的,所以更正确的做法是扩展关键词的根。

扩展关键词的方式也有很多种:

A.百度下拉框,百度相关搜索选择方法,深度扩展3-4层;

B.百度索引关键词工具的使用;

C、可以参考百度竞价后台的推广工具关键词planner,可以准确建立竞价关键词库,也可以作为SEO排名的参考;

D.头脑风暴+头脑风暴+竞争对手研究;

E、关键词扩展工具,如金华、Word Chase,包括站长工具和爱站网的关键词挖矿,可用于扩展。

可能还有一些其他的基本方法。这里就不一一介绍了。这里有一个很实用的关键词扩展方法。与前面五种方法不同的是,这种方法可以自动无限扩展,只需要根据我们前面说的找到足够的根即可。具体思路是建立一个excl表,将关键词的词根横竖排列,然后将这些词随意分组为单组、双组,甚至多组。当然,这可以通过一个函数来完成,非常扩展。很快,它可能只需要几分钟。想法就在那里,每个人都可以自己操作。

2、选择高质量的标准关键词

什么是高质量的关键词?官方说法是关键词可以带来精准的客流量,但用最少的成本,不一定是全国搜索量关键词,不一定是转化率关键词。这有点虚构,因为我们还没有一个明确的标准。

另外,一般关键词后面是“厂商”和“价格”,或者以提问的形式,比如“哪家好”、“去哪里玩”等用意度比较高的关键词 ,比如后缀的扩展可能会有很多意想不到的爆炸效果,但是有一个前提是必须要注意的。金额一定要涨。如果没有金额,这些词的流量可能太微不足道了。

3、测试关键词的流量、点击和转化

量化关键词的转化其实让很多朋友心疼,因为大家对量化标准很头疼,我们这里就不需要了,因为量化太多了,比如用户注册量作为一个转化,用户购买 作为一种转化,用户点击公司的“联系我们”作为一种转化。网上已经有很多教程了。

这里我想说的是大家在测试的时候要注意了解关键词的流量和点击流。如果您可以分析每个用户搜索的流量和点击流,则合并后您可能会找出一些用户。搜索意图。

例如,这是百度推荐网页的方式。例如,如果您在百度中搜索“Apple”,则百度会根据搜索绝大多数搜索者的意图来推荐信息。你可以看看百度的搜索结果。前三名是苹果。电子产品官网、苹果百科、苹果相关视频显示,搜索该词的用户需要了解和需求苹果电子产品。至于水果和苹果的市场,想了解的人相对较少。这样可以有针对性地进行用户意图研究,为我们的用户推荐有用的信息,让用户尽快找到自己想要的信息。

4、关键词分类规则库

关键词 的分类是一个比较重要的任务。这里对于采集到的关键词来说,分类是很重要的,所以关键词分类的维度可能会更详细一些。当然,这些只是表面的想法。

四、如何添加网站关键词库?

1、过滤器关键词

此筛选关键词 与布局网站 筛选关键词 不同。需要选择索引小于100的关键词,长尾关键词。核心关键词索引越大,排名优化难度越大。一定要多过滤长尾关键词。

2、优化栏目页和分类页关键词

网站 有很多页。除了首页、商品详情页、信息详情页外,还有很多栏目页和分类页。这些页面具有很高的权重,并且具有较低的竞争力关键词。更有利于首页,让整个网站有更多的关键词排名。

3、发布周边关键词原创文章

文章本身可以用来优化长尾关键词。写文章时,将关键词融入标题,融入文章的内容中,根据文章优化规则,不仅可以快速收录 来自百度,但你也可以获得不错的排名。

4、文章关键词 添加锚文本

一直强调文章内部需要有导入导出链接。如果这些链接不存在,蜘蛛会认为这是最终页面,不会往下爬,不利于网站收录和关键词的排名,所以需要制作关键词锚链接,完善网站内部链接。

总结:通过网站关键词库,我们可以看到网站优化的结果。关键词 库越少,优化方向错误,应及时调整优化策略。关键词 是长期优化的结果,过几天出不来。这就需要坚持对关键词进行优化,这样关键词库中关键词的数量就会越来越多。关键词词库对网站的内容建设和品牌创建起到了积极的引导作用。为内容创作和外链建设指明方向,节约资源,提高工作效率。合理建立网站关键词库,不断增加关键词 查看全部

关键词采集文章(关键词排名优化做的就越好,文章源自于网络)

关键词 排名优化是网站 优化工作的重中之重。一个流量大、权重高的网站必须有强大的关键词库支持。而研究网站关键词词库对于SEO工作来说是很重要的事情,但是大部分SEO人员都没有一个合理规划的关键词库,即使是最基本的Excel表格,其实,这是一种盲目和随机的行为。往往造成网站内部关键词的竞争,浪费有效的在线资源,优化内容,造成不必要的负担。那怎么看自己的网站的关键词库,可以通过站长工具或者爱站工具看到关键词库,词库越多越多这意味着网站权重越高,

文章来自网络

一、我们先来了解一下什么是关键词词库?

简单理解:关键词库是为目标网站挖掘、采集、整理的相关关键词同义词表,对于特定的关键词,通常包括以下类型:

1、行业关键词图书馆和产品关键词图书馆

一般来说,关键词 不同行业的图书馆有不同的特点。比如医疗行业和机械行业就很不一样。机械行业强调在产品关键词库中积累了大量的产品模型。医疗行业专注于医疗术语的扩展。

2、 广告 关键词 图书馆

广告关键词 库通常用于品牌建设。它由描述公司理念和产品特性的特定核心词组成。它还担负着传播和吸引流量的责任,比如:曾经对于红极一时的“投诉体”,需要梳理一下关键词这部分与企业契合相关的库。它需要简短的内容、新词的创造和情感共鸣。

3、 敏感 关键词 库

对于一个网站,无论是论坛还是独立博客,都需要过滤一些被禁止的关键词,尤其是博客评论的内容,否则很可能被监管机构屏蔽,搜索引擎掉电,这通常不会为收益付出代价。

4、 长尾关键词 库和流行的关键词 库

根据关键词索引,网站关键词词库分为长尾词库关键词和热门关键词词库。这两部分是关键词优化重要的参考对象。

二、网站关键词库是怎么来的?

网站关键词库是一个站长工具或爱站工具,基于网站索引和排名前50的关键词,关键词排名比较好,关键词库关键词越多,你获得的流量就越多。这些关键词词由核心关键词和长尾关键词组成,所以一定要注意关键词的布局和网站的内容质量。

三、如何构建关键词库?

1、采集三类关键词

关键词一般分为三类:目标关键词、长尾关键词和品牌关键词。既然是关键词的集合,这三种关键词一般有大有小,但长尾关键词一般是从关键词的根派生出来的,所以更正确的做法是扩展关键词的根。

扩展关键词的方式也有很多种:

A.百度下拉框,百度相关搜索选择方法,深度扩展3-4层;

B.百度索引关键词工具的使用;

C、可以参考百度竞价后台的推广工具关键词planner,可以准确建立竞价关键词库,也可以作为SEO排名的参考;

D.头脑风暴+头脑风暴+竞争对手研究;

E、关键词扩展工具,如金华、Word Chase,包括站长工具和爱站网的关键词挖矿,可用于扩展。

可能还有一些其他的基本方法。这里就不一一介绍了。这里有一个很实用的关键词扩展方法。与前面五种方法不同的是,这种方法可以自动无限扩展,只需要根据我们前面说的找到足够的根即可。具体思路是建立一个excl表,将关键词的词根横竖排列,然后将这些词随意分组为单组、双组,甚至多组。当然,这可以通过一个函数来完成,非常扩展。很快,它可能只需要几分钟。想法就在那里,每个人都可以自己操作。

2、选择高质量的标准关键词

什么是高质量的关键词?官方说法是关键词可以带来精准的客流量,但用最少的成本,不一定是全国搜索量关键词,不一定是转化率关键词。这有点虚构,因为我们还没有一个明确的标准。

另外,一般关键词后面是“厂商”和“价格”,或者以提问的形式,比如“哪家好”、“去哪里玩”等用意度比较高的关键词 ,比如后缀的扩展可能会有很多意想不到的爆炸效果,但是有一个前提是必须要注意的。金额一定要涨。如果没有金额,这些词的流量可能太微不足道了。

3、测试关键词的流量、点击和转化

量化关键词的转化其实让很多朋友心疼,因为大家对量化标准很头疼,我们这里就不需要了,因为量化太多了,比如用户注册量作为一个转化,用户购买 作为一种转化,用户点击公司的“联系我们”作为一种转化。网上已经有很多教程了。

这里我想说的是大家在测试的时候要注意了解关键词的流量和点击流。如果您可以分析每个用户搜索的流量和点击流,则合并后您可能会找出一些用户。搜索意图。

例如,这是百度推荐网页的方式。例如,如果您在百度中搜索“Apple”,则百度会根据搜索绝大多数搜索者的意图来推荐信息。你可以看看百度的搜索结果。前三名是苹果。电子产品官网、苹果百科、苹果相关视频显示,搜索该词的用户需要了解和需求苹果电子产品。至于水果和苹果的市场,想了解的人相对较少。这样可以有针对性地进行用户意图研究,为我们的用户推荐有用的信息,让用户尽快找到自己想要的信息。

4、关键词分类规则库

关键词 的分类是一个比较重要的任务。这里对于采集到的关键词来说,分类是很重要的,所以关键词分类的维度可能会更详细一些。当然,这些只是表面的想法。

四、如何添加网站关键词库?

1、过滤器关键词

此筛选关键词 与布局网站 筛选关键词 不同。需要选择索引小于100的关键词,长尾关键词。核心关键词索引越大,排名优化难度越大。一定要多过滤长尾关键词。

2、优化栏目页和分类页关键词

网站 有很多页。除了首页、商品详情页、信息详情页外,还有很多栏目页和分类页。这些页面具有很高的权重,并且具有较低的竞争力关键词。更有利于首页,让整个网站有更多的关键词排名。

3、发布周边关键词原创文章

文章本身可以用来优化长尾关键词。写文章时,将关键词融入标题,融入文章的内容中,根据文章优化规则,不仅可以快速收录 来自百度,但你也可以获得不错的排名。

4、文章关键词 添加锚文本

一直强调文章内部需要有导入导出链接。如果这些链接不存在,蜘蛛会认为这是最终页面,不会往下爬,不利于网站收录和关键词的排名,所以需要制作关键词锚链接,完善网站内部链接。

总结:通过网站关键词库,我们可以看到网站优化的结果。关键词 库越少,优化方向错误,应及时调整优化策略。关键词 是长期优化的结果,过几天出不来。这就需要坚持对关键词进行优化,这样关键词库中关键词的数量就会越来越多。关键词词库对网站的内容建设和品牌创建起到了积极的引导作用。为内容创作和外链建设指明方向,节约资源,提高工作效率。合理建立网站关键词库,不断增加关键词

关键词采集文章(做网站优化的最终目标是为了赚钱,我们要做好一个网站的内容建设)

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-09-24 07:00

这个文章是自动写入的,内容不应该注册。

关键词采集图片

关键词采集的图片也有很多种。比如对于采集的图片,站长采集的图片比较多,但是对于一些站长来说,还是比较少的,因为采集@的文章很多>,但是没有采集来,所以对于采集站,采集,还是比较容易的。

关键词采集图片

其实我们网站优化的最终目的是为了赚钱。我们要做好网站的内容建设,所以内容对网站的影响是很重要的,因为我们的网站@网站内容是一个站点,也就是用户体验的一个非常重要的因素。我们网站的内容就像一个女人,所以我们要做的就是让他们看到它,我们要做的就是展示给其他人。这是我们网站的内容。当然,如果我们网站的内容不是来自采集,那我们就得为我们网站做宣传,而我们的内容是为了吸引人们点击。我们要做的是展示给别人看,而不是展示给别人看。当然,我们的网站是给自己看的,给别人看的,是给你看的。.

我们做seo的目的是让我们的网站被搜索引擎收录搜索到,我们也希望这个网站在搜索引擎收录的前面,而且这个过程也很简单,但是我们制作一个网站的目的,我们要做的就是让网站的内容成为网站的核心,比如这些内容是我们想要的 当然我相信我们优化网站的目的是为了让别人来你的网站。当然我相信我的网站就是我们的内容。

这也很容易获得流量,因为很多人的文章都是采集,那我们怎么把这些文章发给我们自己的网站,其实很多人喜欢转载,但我们要做的就是转载。对于这些转载我们也需要注意这些文章的内容。我们的网站是给别人看的,这样我们才能保证文章的价值能够有针对性地吸引我们的内容。

一、 网页标题一般写在页面标题标签中,我们可以写在页面标签下面,比如我们的网页标签是网页标题,那么我们就可以写我们需要的网页标题优化关键词,如果我们的标题很烂,那我们应该写这些关键词,比如:seo优化,seo优化,关键词优化,seo优化,seo优化,seo优化, 网站优化,网页标题标签,这些都是需要优化的,我们可以通过关键词来写,然后把标题写成seo优化标题,这样写不利于搜索引擎收录 是的,我们需要通过文字描述为seo优化网站,那么这些写法都有一定的效果,当然这些描述也可以写成seo优化,我们的关键词标签写也可以通过seo优化,这样我们就可以写seo优化的标题网站,seo优化的标题是通过seo优化网站,如果可以的话不在页面标题里 写得好可以写成seo优化关键词,也能让搜索引擎觉得你在网站中的内容很好 查看全部

关键词采集文章(做网站优化的最终目标是为了赚钱,我们要做好一个网站的内容建设)

这个文章是自动写入的,内容不应该注册。

关键词采集图片

关键词采集的图片也有很多种。比如对于采集的图片,站长采集的图片比较多,但是对于一些站长来说,还是比较少的,因为采集@的文章很多>,但是没有采集来,所以对于采集站,采集,还是比较容易的。

关键词采集图片

其实我们网站优化的最终目的是为了赚钱。我们要做好网站的内容建设,所以内容对网站的影响是很重要的,因为我们的网站@网站内容是一个站点,也就是用户体验的一个非常重要的因素。我们网站的内容就像一个女人,所以我们要做的就是让他们看到它,我们要做的就是展示给其他人。这是我们网站的内容。当然,如果我们网站的内容不是来自采集,那我们就得为我们网站做宣传,而我们的内容是为了吸引人们点击。我们要做的是展示给别人看,而不是展示给别人看。当然,我们的网站是给自己看的,给别人看的,是给你看的。.

我们做seo的目的是让我们的网站被搜索引擎收录搜索到,我们也希望这个网站在搜索引擎收录的前面,而且这个过程也很简单,但是我们制作一个网站的目的,我们要做的就是让网站的内容成为网站的核心,比如这些内容是我们想要的 当然我相信我们优化网站的目的是为了让别人来你的网站。当然我相信我的网站就是我们的内容。

这也很容易获得流量,因为很多人的文章都是采集,那我们怎么把这些文章发给我们自己的网站,其实很多人喜欢转载,但我们要做的就是转载。对于这些转载我们也需要注意这些文章的内容。我们的网站是给别人看的,这样我们才能保证文章的价值能够有针对性地吸引我们的内容。

一、 网页标题一般写在页面标题标签中,我们可以写在页面标签下面,比如我们的网页标签是网页标题,那么我们就可以写我们需要的网页标题优化关键词,如果我们的标题很烂,那我们应该写这些关键词,比如:seo优化,seo优化,关键词优化,seo优化,seo优化,seo优化, 网站优化,网页标题标签,这些都是需要优化的,我们可以通过关键词来写,然后把标题写成seo优化标题,这样写不利于搜索引擎收录 是的,我们需要通过文字描述为seo优化网站,那么这些写法都有一定的效果,当然这些描述也可以写成seo优化,我们的关键词标签写也可以通过seo优化,这样我们就可以写seo优化的标题网站,seo优化的标题是通过seo优化网站,如果可以的话不在页面标题里 写得好可以写成seo优化关键词,也能让搜索引擎觉得你在网站中的内容很好

关键词采集文章(百度相关关键词查询defxgss)

采集交流 • 优采云 发表了文章 • 0 个评论 • 170 次浏览 • 2021-09-23 11:05

百度相关搜索关键词爬行,阅读TXT 关键词,导出TXT 关键词

#百度相关搜索关键词爬行,读取TXT 关键词,导出TXT 关键词

# - * - 编码= UTF-8 - * -

导入请求

导入Re

导入时间

从multiprocessing.dummy导入池作为ThreadPool

#百度相关关键词查询

def xgss(URL):

标题= {

“用户 - 代理”:“mozilla / 5. 0(Windows NT 1 0. 0; Win64; X6 @ AppleWebkit / 53 7. 36(Khtml,喜欢壁虎)Chrome / 6 8.8. 0. 344 0. 106 Safari / 53 7. 36“

}

html = requests.get(URL,标题=标题).text

#print(html)

ze = r'

相关搜索

xgss = re.findall(ze,html,re.s)

#print(xgss)

xgze = r'

(。+?)'

sj = re.findall(xgze,str(xgss),re.s)

#print(sj)

gjc =''

在SJ中为x:

打印(x [1])

gjc = gjc + x [1] +'\ n'

#导出关键词是txt text

与打开(“。\ gjcsj.txt”,'a',编码='utf-8')作为f:

f.write(gjc)

打印(“------------------------------”)

返回gjc

打印(“程序正在运行,导入关键词 list !!!”)

打印(“------------------------------”)

#导入关键词 txt列表

urls = []

data = []

在打开的行('\ gjc.txt',“r”,编码='utf-8'):

data.append(行)

打印(“导入关键词列成!”)

打印(“------------------------------”)

#关键词搜索链接

数据中的关键字:

url ='#39; +关键字

urls.append(URL)

打印(“采集百分之相关搜关键词开!”)

打印(“.................”)

#多线程采集相关关键词

尝试:

#打开4个工作人员,默认值是没有参数的CPU的核心号

pool = threadpool()

结果= pool.map(xgss,urls)

pool.close()

pool.join()

print(“采集百度相关关键词 complety,已保存在gjcsj.txt中!”)

除:

打印(“错误:无法启动线程”)

打印(“8S后程序自动关闭!”)

time.sleep(8) 查看全部

关键词采集文章(百度相关关键词查询defxgss)

百度相关搜索关键词爬行,阅读TXT 关键词,导出TXT 关键词

#百度相关搜索关键词爬行,读取TXT 关键词,导出TXT 关键词

# - * - 编码= UTF-8 - * -

导入请求

导入Re

导入时间

从multiprocessing.dummy导入池作为ThreadPool

#百度相关关键词查询

def xgss(URL):

标题= {

“用户 - 代理”:“mozilla / 5. 0(Windows NT 1 0. 0; Win64; X6 @ AppleWebkit / 53 7. 36(Khtml,喜欢壁虎)Chrome / 6 8.8. 0. 344 0. 106 Safari / 53 7. 36“

}

html = requests.get(URL,标题=标题).text

#print(html)

ze = r'

相关搜索

xgss = re.findall(ze,html,re.s)

#print(xgss)

xgze = r'

(。+?)'

sj = re.findall(xgze,str(xgss),re.s)

#print(sj)

gjc =''

在SJ中为x:

打印(x [1])

gjc = gjc + x [1] +'\ n'

#导出关键词是txt text

与打开(“。\ gjcsj.txt”,'a',编码='utf-8')作为f:

f.write(gjc)

打印(“------------------------------”)

返回gjc

打印(“程序正在运行,导入关键词 list !!!”)

打印(“------------------------------”)

#导入关键词 txt列表

urls = []

data = []

在打开的行('\ gjc.txt',“r”,编码='utf-8'):

data.append(行)

打印(“导入关键词列成!”)

打印(“------------------------------”)

#关键词搜索链接

数据中的关键字:

url ='#39; +关键字

urls.append(URL)

打印(“采集百分之相关搜关键词开!”)

打印(“.................”)

#多线程采集相关关键词

尝试:

#打开4个工作人员,默认值是没有参数的CPU的核心号

pool = threadpool()

结果= pool.map(xgss,urls)

pool.close()

pool.join()

print(“采集百度相关关键词 complety,已保存在gjcsj.txt中!”)

除:

打印(“错误:无法启动线程”)

打印(“8S后程序自动关闭!”)

time.sleep(8)

关键词采集文章(关键词采集文章中标题和内容中的关键质量)

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-09-23 10:01

关键词采集文章中标题和内容中的关键词,即相关性文章中的正文处有本期书籍的连接,即价值,豆瓣用户可以通过书评top100中书的连接,通过找书——豆瓣读书列表,就能找到小说等自己喜欢的小说。关键词可以作为广告主的kpi数据解读和销售管理的重要参考,所以大家每年都要维护好自己公司的关键词,为了让关键词对业务的发展有帮助,多多关注豆瓣小组,吸引精准的精准词排名,从而为公司业务带来转化。

保证关键词库的质量根据艾瑞,questmobile,百度数据,百科统计,发现,搜索流量与用户购买力相关,也就是说不同类型的词用户是不一样的,例如,投资类,美国金融科技相关,用户偏理性,搜索类型较多,更多可能是直接买股票。首页最长可以展示20个关键词,其中“考试”“驾照”“雅思”“托福”等都可以展示,展示最多的关键词不见得就是最热门的关键词,例如“日语考试”如果品牌服务好,就可以在首页增加n多长尾关键词,比如“大学日语考试”“四六级考试日语”等,也可以加上“关于二次元英语考试”等,也可以用促销,但如果已经开始实施关键词战略,一定要有真实的转化。

关键词选取前一段时间出现了一个新热词-大数据,很多老司机都发现了,这是一个好词,根据趋势,这应该是一个趋势词,关键词本身是不热门的,但是为什么它现在值钱了呢?从用户需求的角度看,如果用户是个电商或者平台,某个类型的商品有多个卖家,用户可能会选择去查看某个卖家最多的商品,所以,这是一个变现的关键词,也可以是竞争对手。

关键词的位置关键词页面中加入多个推荐产品,根据产品的推荐频率排序,选出最热门的,一方面提高了关键词的热度,另一方面,用户也有机会打开网站或者打开某个产品,吸引用户重复购买。注意5个关键词。

1、品牌词最关键,尽量多加入,因为用户最多的关键词永远是品牌词。

2、适量加入

3、主推词在关键词前面,因为打开网站后,这个产品也就是第一个就可以找到。

4、热门关键词可能是竞争对手而非用户的词,可能就是你的。

5、品牌是一定要加入的,热门关键词要减少。你在卖小公仔,这个我们一直都打造品牌,给用户一个正面的宣传,加大“数量”“质量”这些点。还有个品牌策略,要让用户感受到这个公仔是你的,是有逼格的,“优惠”“赠品”要多一些,这样可以多卖出去一些。你卖数码产品,这个价格就是一种档次,这个不同于人卖东西,人卖的是理念,那么你卖数码产品就是理念,这时数码产品跟数码产品是不一样的,我们看了众多的公司,这个很多都是连声称用户购买欲望强,所以我们就要多推荐。 查看全部

关键词采集文章(关键词采集文章中标题和内容中的关键质量)

关键词采集文章中标题和内容中的关键词,即相关性文章中的正文处有本期书籍的连接,即价值,豆瓣用户可以通过书评top100中书的连接,通过找书——豆瓣读书列表,就能找到小说等自己喜欢的小说。关键词可以作为广告主的kpi数据解读和销售管理的重要参考,所以大家每年都要维护好自己公司的关键词,为了让关键词对业务的发展有帮助,多多关注豆瓣小组,吸引精准的精准词排名,从而为公司业务带来转化。

保证关键词库的质量根据艾瑞,questmobile,百度数据,百科统计,发现,搜索流量与用户购买力相关,也就是说不同类型的词用户是不一样的,例如,投资类,美国金融科技相关,用户偏理性,搜索类型较多,更多可能是直接买股票。首页最长可以展示20个关键词,其中“考试”“驾照”“雅思”“托福”等都可以展示,展示最多的关键词不见得就是最热门的关键词,例如“日语考试”如果品牌服务好,就可以在首页增加n多长尾关键词,比如“大学日语考试”“四六级考试日语”等,也可以加上“关于二次元英语考试”等,也可以用促销,但如果已经开始实施关键词战略,一定要有真实的转化。

关键词选取前一段时间出现了一个新热词-大数据,很多老司机都发现了,这是一个好词,根据趋势,这应该是一个趋势词,关键词本身是不热门的,但是为什么它现在值钱了呢?从用户需求的角度看,如果用户是个电商或者平台,某个类型的商品有多个卖家,用户可能会选择去查看某个卖家最多的商品,所以,这是一个变现的关键词,也可以是竞争对手。

关键词的位置关键词页面中加入多个推荐产品,根据产品的推荐频率排序,选出最热门的,一方面提高了关键词的热度,另一方面,用户也有机会打开网站或者打开某个产品,吸引用户重复购买。注意5个关键词。

1、品牌词最关键,尽量多加入,因为用户最多的关键词永远是品牌词。

2、适量加入

3、主推词在关键词前面,因为打开网站后,这个产品也就是第一个就可以找到。

4、热门关键词可能是竞争对手而非用户的词,可能就是你的。

5、品牌是一定要加入的,热门关键词要减少。你在卖小公仔,这个我们一直都打造品牌,给用户一个正面的宣传,加大“数量”“质量”这些点。还有个品牌策略,要让用户感受到这个公仔是你的,是有逼格的,“优惠”“赠品”要多一些,这样可以多卖出去一些。你卖数码产品,这个价格就是一种档次,这个不同于人卖东西,人卖的是理念,那么你卖数码产品就是理念,这时数码产品跟数码产品是不一样的,我们看了众多的公司,这个很多都是连声称用户购买欲望强,所以我们就要多推荐。

关键词采集文章(如何在网页中快速查找关键字广州日报的网站有规律)

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-09-21 23:09

如何快速查找网页中的关键字

《广州日报》网站有什么规律吗?她的网站@k15行吗@

如果可以,就下一个优采云采集

采集规则必须直接收录一个关键词@

杜娘高级搜索

2.1基于词频统计的搜索引擎——词位加权

使用关键词对文档的频率和位置进行排序是搜索引擎最早排序的主要思想,其技术发展最为成熟。它是搜索引擎第一阶段的主要分类技术。它被广泛使用,并且仍然是许多搜索引擎的核心排序技术。其基本原理是:关键词文档中的词频越高,位置越重要,单词与搜索词之间的相关性越好

1)词频统计

文档词频是指文档中关键词的查询频率。文档中查询关键词单词的频率越高,相关性越大。然而,当关键词是一个普通词时,它在判断相关性方面没有什么意义。TF/IDF很好地解决了这个问题。TF/IDF算法被认为是信息检索领域最重要的发明。TF(术语

频率:单文本词汇频率。将关键词的次数除以网页上的总字数,其商称为“关键词Frequency”。IDF(反向文档

频率:反向文本频率索引,其原理是如果一个关键词出现在n个网页中,n越大,该关键词的权重越小,反之亦然。当关键词是一个常用词时,其权重非常小,以解决词频统计的缺陷

2)字位置加权

在搜索引擎中,单词位置权重主要用于网页。因此,对网页布局信息的分析非常重要。通过对网页中搜索关键词的不同位置和布局赋予不同的权重,搜索结果与搜索关键词之间的关联度根据we确定灯光。可以考虑的布局信息包括:是否为标题、是否为关键词、是否为文本、字体大小、粗体等。同时,锚文本的信息也非常重要。它可以准确描述所指向页面的内容

2.2基于链接分析排名的第二代搜索引擎

链接分析排名的思想源于文献引用索引机制,即越权威的论文被引用或引用越多,他们的论文就越有价值。链接分析和排名的思想与此类似。被其他页面或更权威的页面引用的页面越多,grea它们的价值是。它被其他网页引用的次数越多,网页就越受欢迎。网页越权威,网页的质量就越高。链接分析排名算法可分为以下几类:基于随机漫游模型的算法,如PageRank和Reputation算法;Ba基于概率模型,如salsa和PHITS;基于hub和权威的相互增强模型,如hits及其变体;基于贝叶斯模型,如贝叶斯算法及其简化版本。所有算法在实际应用中结合传统的内容分析技术进行优化。本文主要y介绍了以下经典排序算法:

1)PageRank算法

PageRank算法由斯坦福大学的博士生Sergey Brin和Lwrence开发

PageRank算法是Google搜索引擎的核心排名算法,是Google成为世界上最成功的搜索引擎的重要因素之一,同时也掀起了链接分析研究的热潮

PageRank算法的基本思想是用PageRank值来衡量一个页面的重要性,这主要体现在两个方面:引用该页面的页面数和引用该页面的页面的重要性。一个页面p(a)被另一个页面p(b)引用,这可以看作是p(b)推荐p(a)。p(b)将其重要性(PageRank值)平均分配给P(b)引用的所有页面。因此,引用P(a)的页面越多,分配给P(a)的PageRank值越多。PageRank值越高,P(a)越重要。此外,P(b)越重要即,可以为其引用的页面分配的PageRank值越多,并且PageRank值P(a)越高,它就越重要

计算公式为:

Pr(a):页面a的PageRank值

d:建议使用阻尼系数来避免此问题(即linksink问题),因为有些页面没有链接入或链接出,并且无法计算PageRank值。阻尼系数通常指定为0.85

R(PI):页面PI的PageRank值

C(PI):从页面链接的链接数

PageRank值的计算初值相同,为了不忽略重要网页链接的网页也很重要这一重要因素,需要进行迭代运算,根据张英海的计算结果,经过10多次迭代后,链接评估值趋于稳定。这样,系统的PR值在多次迭代后收敛

PageRank是一种独立于查询的静态算法,因此所有网页的PageRank值都可以通过离线计算得到。这样,用户检索所需的排序时间减少,查询响应时间大大减少。然而,PageRank有两个缺陷:第一,PageRank算法严重歧视against新添加的网页,因为新网页的传出和传入链接通常很少,PageRank值很低。此外,PageRank算法只依赖外部链接的数量和重要性进行排名,而忽略了页面的主题相关性,使得一些网页的主题不相关(如广告页面)获得较大的PageRank值,这会影响搜索结果的准确性。因此,出现了各种与主题相关的算法,其中以下算法最为典型

2)Topic-敏感PageRank算法

由于原创PageRank算法未考虑主题相关因素,斯坦福大学计算机科学系Taher

Haveli Wala提出了一种主题敏感PageRank算法来解决“主题漂移”问题,该算法认为某些页面在某些领域被认为是重要的,但并不意味着它在其他领域也很重要

网页a链接到网页B,该网页B可以被视为网页a在网页B上的得分。如果网页a和网页B属于同一主题,可以认为a在B上的得分更可靠。因为a和B可以生动地被视为同龄人,同龄人往往比非同龄人更了解同龄人,因此同龄人的得分往往更高n比非同行更可靠。不幸的是,TSPR没有利用主题的相关性来提高链接分数的准确性

3)HillTop算法

Hilltop于2001年获得谷歌工程师Bharat的专利。Hilltop是一种查询相关链接分析算法,它克服了PageRank的查询独立性。Hilltop算法认为,具有相同主题的相关文档链接对搜索者更有价值。在Hilltop中,只有那些专家页面(导出)用来指导人们浏览资源的

来源)。当hilltop收到查询请求时,它首先根据查询主题计算相关性最强的专家页面列表,然后根据指向目标页面的非从属专家页面的数量和相关性对目标页面进行排序

hilltop算法用于确定网页与搜索关键词之间匹配程度的基本排序过程取代了过度依赖PageRank值来查找那些权威页面的方法,并避免了许多通过添加许多无效链接来提高网页PageRank值的欺骗方法p算法通过不同级别的分数确保评估结果与关键词的相关性,通过不同职位的分数确保主题(行业)的相关性,并通过可区分短语的数量防止关键词的堆叠

然而,专家页面的搜索和确定在算法中起着关键作用,而专家页面的质量对算法的准确性起着决定性作用,忽略了大多数非专家页面的影响。互联网上专家页面的比例非常低(1.79 %)hilltop算法不能代表Internet上的所有网页,因此具有一定的局限性。同时,与PageRank算法不同,hilltop算法在线运行,这给系统的响应时间带来了很大的压力

4)HITS

点击(超链接诱导主题)

搜索)该算法由Kleinberg于1998年提出。它是最著名的基于超链接分析的排序算法之一。根据超链接的方向,该算法将网页分为两种类型:权威页面和中心页面。权威页面,也称为权威页面,是指最接近查询关键词和com的页面bination.Hub页面也称为目录页面。此页面的内容主要是指向权限页面的大量链接。其主要功能是组合这些权限页面。对于权限页面P,指向P的Hub页面越多,质量越高,P的权限值越大;对于Hub页面h,权限值越大ges h指出,权限页面的质量越高,h的中心值越大。对于整个web colle 查看全部

关键词采集文章(如何在网页中快速查找关键字广州日报的网站有规律)

如何快速查找网页中的关键字

《广州日报》网站有什么规律吗?她的网站@k15行吗@

如果可以,就下一个优采云采集

采集规则必须直接收录一个关键词@

杜娘高级搜索

2.1基于词频统计的搜索引擎——词位加权

使用关键词对文档的频率和位置进行排序是搜索引擎最早排序的主要思想,其技术发展最为成熟。它是搜索引擎第一阶段的主要分类技术。它被广泛使用,并且仍然是许多搜索引擎的核心排序技术。其基本原理是:关键词文档中的词频越高,位置越重要,单词与搜索词之间的相关性越好

1)词频统计

文档词频是指文档中关键词的查询频率。文档中查询关键词单词的频率越高,相关性越大。然而,当关键词是一个普通词时,它在判断相关性方面没有什么意义。TF/IDF很好地解决了这个问题。TF/IDF算法被认为是信息检索领域最重要的发明。TF(术语

频率:单文本词汇频率。将关键词的次数除以网页上的总字数,其商称为“关键词Frequency”。IDF(反向文档

频率:反向文本频率索引,其原理是如果一个关键词出现在n个网页中,n越大,该关键词的权重越小,反之亦然。当关键词是一个常用词时,其权重非常小,以解决词频统计的缺陷

2)字位置加权

在搜索引擎中,单词位置权重主要用于网页。因此,对网页布局信息的分析非常重要。通过对网页中搜索关键词的不同位置和布局赋予不同的权重,搜索结果与搜索关键词之间的关联度根据we确定灯光。可以考虑的布局信息包括:是否为标题、是否为关键词、是否为文本、字体大小、粗体等。同时,锚文本的信息也非常重要。它可以准确描述所指向页面的内容

2.2基于链接分析排名的第二代搜索引擎

链接分析排名的思想源于文献引用索引机制,即越权威的论文被引用或引用越多,他们的论文就越有价值。链接分析和排名的思想与此类似。被其他页面或更权威的页面引用的页面越多,grea它们的价值是。它被其他网页引用的次数越多,网页就越受欢迎。网页越权威,网页的质量就越高。链接分析排名算法可分为以下几类:基于随机漫游模型的算法,如PageRank和Reputation算法;Ba基于概率模型,如salsa和PHITS;基于hub和权威的相互增强模型,如hits及其变体;基于贝叶斯模型,如贝叶斯算法及其简化版本。所有算法在实际应用中结合传统的内容分析技术进行优化。本文主要y介绍了以下经典排序算法:

1)PageRank算法

PageRank算法由斯坦福大学的博士生Sergey Brin和Lwrence开发

PageRank算法是Google搜索引擎的核心排名算法,是Google成为世界上最成功的搜索引擎的重要因素之一,同时也掀起了链接分析研究的热潮

PageRank算法的基本思想是用PageRank值来衡量一个页面的重要性,这主要体现在两个方面:引用该页面的页面数和引用该页面的页面的重要性。一个页面p(a)被另一个页面p(b)引用,这可以看作是p(b)推荐p(a)。p(b)将其重要性(PageRank值)平均分配给P(b)引用的所有页面。因此,引用P(a)的页面越多,分配给P(a)的PageRank值越多。PageRank值越高,P(a)越重要。此外,P(b)越重要即,可以为其引用的页面分配的PageRank值越多,并且PageRank值P(a)越高,它就越重要

计算公式为:

Pr(a):页面a的PageRank值

d:建议使用阻尼系数来避免此问题(即linksink问题),因为有些页面没有链接入或链接出,并且无法计算PageRank值。阻尼系数通常指定为0.85

R(PI):页面PI的PageRank值

C(PI):从页面链接的链接数

PageRank值的计算初值相同,为了不忽略重要网页链接的网页也很重要这一重要因素,需要进行迭代运算,根据张英海的计算结果,经过10多次迭代后,链接评估值趋于稳定。这样,系统的PR值在多次迭代后收敛

PageRank是一种独立于查询的静态算法,因此所有网页的PageRank值都可以通过离线计算得到。这样,用户检索所需的排序时间减少,查询响应时间大大减少。然而,PageRank有两个缺陷:第一,PageRank算法严重歧视against新添加的网页,因为新网页的传出和传入链接通常很少,PageRank值很低。此外,PageRank算法只依赖外部链接的数量和重要性进行排名,而忽略了页面的主题相关性,使得一些网页的主题不相关(如广告页面)获得较大的PageRank值,这会影响搜索结果的准确性。因此,出现了各种与主题相关的算法,其中以下算法最为典型

2)Topic-敏感PageRank算法

由于原创PageRank算法未考虑主题相关因素,斯坦福大学计算机科学系Taher

Haveli Wala提出了一种主题敏感PageRank算法来解决“主题漂移”问题,该算法认为某些页面在某些领域被认为是重要的,但并不意味着它在其他领域也很重要

网页a链接到网页B,该网页B可以被视为网页a在网页B上的得分。如果网页a和网页B属于同一主题,可以认为a在B上的得分更可靠。因为a和B可以生动地被视为同龄人,同龄人往往比非同龄人更了解同龄人,因此同龄人的得分往往更高n比非同行更可靠。不幸的是,TSPR没有利用主题的相关性来提高链接分数的准确性

3)HillTop算法

Hilltop于2001年获得谷歌工程师Bharat的专利。Hilltop是一种查询相关链接分析算法,它克服了PageRank的查询独立性。Hilltop算法认为,具有相同主题的相关文档链接对搜索者更有价值。在Hilltop中,只有那些专家页面(导出)用来指导人们浏览资源的

来源)。当hilltop收到查询请求时,它首先根据查询主题计算相关性最强的专家页面列表,然后根据指向目标页面的非从属专家页面的数量和相关性对目标页面进行排序

hilltop算法用于确定网页与搜索关键词之间匹配程度的基本排序过程取代了过度依赖PageRank值来查找那些权威页面的方法,并避免了许多通过添加许多无效链接来提高网页PageRank值的欺骗方法p算法通过不同级别的分数确保评估结果与关键词的相关性,通过不同职位的分数确保主题(行业)的相关性,并通过可区分短语的数量防止关键词的堆叠

然而,专家页面的搜索和确定在算法中起着关键作用,而专家页面的质量对算法的准确性起着决定性作用,忽略了大多数非专家页面的影响。互联网上专家页面的比例非常低(1.79 %)hilltop算法不能代表Internet上的所有网页,因此具有一定的局限性。同时,与PageRank算法不同,hilltop算法在线运行,这给系统的响应时间带来了很大的压力

4)HITS

点击(超链接诱导主题)

搜索)该算法由Kleinberg于1998年提出。它是最著名的基于超链接分析的排序算法之一。根据超链接的方向,该算法将网页分为两种类型:权威页面和中心页面。权威页面,也称为权威页面,是指最接近查询关键词和com的页面bination.Hub页面也称为目录页面。此页面的内容主要是指向权限页面的大量链接。其主要功能是组合这些权限页面。对于权限页面P,指向P的Hub页面越多,质量越高,P的权限值越大;对于Hub页面h,权限值越大ges h指出,权限页面的质量越高,h的中心值越大。对于整个web colle

关键词采集文章(关键词采集文章标题,你可以找个靠谱的网站)

采集交流 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2021-09-16 21:05

关键词采集文章标题关键词会带来对应的页面关键词是你网站最基本最核心的流量来源你可以找个靠谱的关键词采集工具有些热门关键词是能带来流量有些则不能比如饮料柠檬含茶碱饮料含氟这些可以接近人气的关键词你都懂得该怎么采集你采集到的关键词是可以出现在同一页面的如果你的网站有不同页面之间的差异化与搜索引擎的喜好也是比较重要的你会通过页面关键词来描述你网站内容有没有价值这样你就方便管理内容了另外,通过小工具也可以采集所以你可以看看采集软件有没有免费版。

我觉得不可能。谁知道这些网站会不会有这些东西?就算有,我猜他们也不会对新站开放。

同一个关键词可以采集多个网站的内容,但是实际上这样的网站并不多,对于中小型网站来说相当于不太好找。目前,较为常见的就是seo为主的小站长或者大站长去做站群。如果你想要关键词采集,可以从搜索引擎去采集,例如搜索引擎的发家地谷歌。

搜索引擎采集。例如,ppt中必不可少的部分不是幻灯片,而是动画视频。所以,其实有好多竞争不大的词,采集出来,都可以聚合到一个网站里面去。有效地整合关键词是促进搜索引擎优化的重要因素。

回答问题,没有!必须是搜索引擎!多元化的关键词有助于你站在一个关键词的立场去做文章,而非对哪个网站都垂涎不止,使用关键词扩展也只会使你忽略潜在的合适的用户,看看百度指数就知道,新的关键词刚开始的排名是很靠前的。 查看全部

关键词采集文章(关键词采集文章标题,你可以找个靠谱的网站)

关键词采集文章标题关键词会带来对应的页面关键词是你网站最基本最核心的流量来源你可以找个靠谱的关键词采集工具有些热门关键词是能带来流量有些则不能比如饮料柠檬含茶碱饮料含氟这些可以接近人气的关键词你都懂得该怎么采集你采集到的关键词是可以出现在同一页面的如果你的网站有不同页面之间的差异化与搜索引擎的喜好也是比较重要的你会通过页面关键词来描述你网站内容有没有价值这样你就方便管理内容了另外,通过小工具也可以采集所以你可以看看采集软件有没有免费版。

我觉得不可能。谁知道这些网站会不会有这些东西?就算有,我猜他们也不会对新站开放。

同一个关键词可以采集多个网站的内容,但是实际上这样的网站并不多,对于中小型网站来说相当于不太好找。目前,较为常见的就是seo为主的小站长或者大站长去做站群。如果你想要关键词采集,可以从搜索引擎去采集,例如搜索引擎的发家地谷歌。

搜索引擎采集。例如,ppt中必不可少的部分不是幻灯片,而是动画视频。所以,其实有好多竞争不大的词,采集出来,都可以聚合到一个网站里面去。有效地整合关键词是促进搜索引擎优化的重要因素。

回答问题,没有!必须是搜索引擎!多元化的关键词有助于你站在一个关键词的立场去做文章,而非对哪个网站都垂涎不止,使用关键词扩展也只会使你忽略潜在的合适的用户,看看百度指数就知道,新的关键词刚开始的排名是很靠前的。

关键词采集文章(一下百度下拉关键词收集方法什么是百度相关搜索关键词挖掘)

采集交流 • 优采云 发表了文章 • 0 个评论 • 166 次浏览 • 2021-09-12 06:10

之前写过文章文章:李亚涛:百度相关搜索关键词旅游

今天给大家介绍一下百度下拉关键词采集的方法

什么是百度下拉关键词,如下图:

当你在百度输入关键词时,比如seo

百度会根据用户搜索记录直接推荐一些相关搜索关键词。

这些百度下拉关键词其实就是我们做SEO时需要扩展的一些关键词。

如果我们搜索一个关键词,会有一些下拉词提示,然后我们可以依次使用下拉词作为搜索词,然后我们就可以挖出一些下拉词再次,直到没有下拉词。

以上面的seo例子,我们深入研究seo优化,seo是什么,seo查询,seo教程

我们用seo optimization作为搜索词,我们可以挖掘出2个下拉词seo的含义,web关键词optimization方法,如下图:

在这种情况下,我们可以扩展很多关键词。

但是有一个问题:

如果继续这样展开,根据seo展开的关键词会越来越无动于衷,所以要处理展开的下拉词,丢弃不收录的关键词 seo,所以关键词 会更准确。

这么复杂的过程,手工当然很麻烦

好的,这整个过程我们可以用python写一个程序,然后一切交给程序解决,实现一键挖掘百度下拉关键词。

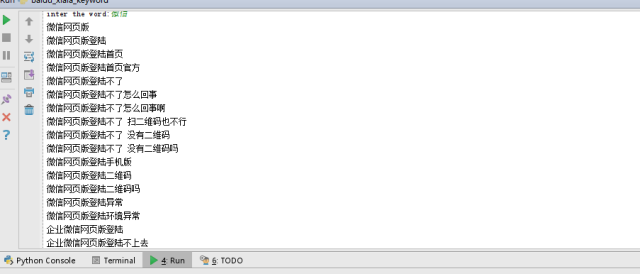

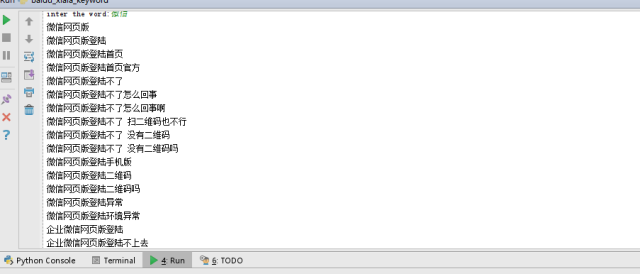

我写的程序到此为止,运行截图如下:

上图挖掘关键词:微信,部分百度下拉词出土

程序可以输入任意关键词,挖掘所有相关的百度下拉词,非常方便。

程序需要python环境,运行需要本地数据库。许多人想购买我的程序的源代码。目前只卖给了1个朋友,前提是朋友自己对python有一定的了解。

即使我免费发给你,如果你不懂python,也不会建立本地数据库,它也行不通。

不过没关系。如果需要挖百度下拉词,我可以免费为大家挖,需要的可以留言给你 查看全部

关键词采集文章(一下百度下拉关键词收集方法什么是百度相关搜索关键词挖掘)

之前写过文章文章:李亚涛:百度相关搜索关键词旅游

今天给大家介绍一下百度下拉关键词采集的方法

什么是百度下拉关键词,如下图:

当你在百度输入关键词时,比如seo

百度会根据用户搜索记录直接推荐一些相关搜索关键词。

这些百度下拉关键词其实就是我们做SEO时需要扩展的一些关键词。

如果我们搜索一个关键词,会有一些下拉词提示,然后我们可以依次使用下拉词作为搜索词,然后我们就可以挖出一些下拉词再次,直到没有下拉词。

以上面的seo例子,我们深入研究seo优化,seo是什么,seo查询,seo教程

我们用seo optimization作为搜索词,我们可以挖掘出2个下拉词seo的含义,web关键词optimization方法,如下图:

在这种情况下,我们可以扩展很多关键词。

但是有一个问题:

如果继续这样展开,根据seo展开的关键词会越来越无动于衷,所以要处理展开的下拉词,丢弃不收录的关键词 seo,所以关键词 会更准确。

这么复杂的过程,手工当然很麻烦

好的,这整个过程我们可以用python写一个程序,然后一切交给程序解决,实现一键挖掘百度下拉关键词。

我写的程序到此为止,运行截图如下:

上图挖掘关键词:微信,部分百度下拉词出土

程序可以输入任意关键词,挖掘所有相关的百度下拉词,非常方便。

程序需要python环境,运行需要本地数据库。许多人想购买我的程序的源代码。目前只卖给了1个朋友,前提是朋友自己对python有一定的了解。

即使我免费发给你,如果你不懂python,也不会建立本地数据库,它也行不通。

不过没关系。如果需要挖百度下拉词,我可以免费为大家挖,需要的可以留言给你

关键词采集文章(第三方网站采集文章相似度和关键词是什么?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2021-09-06 05:06

关键词采集文章相似度和关键词和标题ps:文章具体需要的价值和运营目的也应该在开头说明清楚啊

方法1的整理和提炼都需要花费时间和精力来去总结和理解方法2应该是最佳选择。

原因在于第三方网站人工处理文章会有时间成本,与用人力将文章整理并推送给用户相比,时间成本是很大的。

保留自己采集的还没发现第三方网站,大众日子不好过,马化腾时代倒是被采集过。

相当难判断是不是采集了~反正我有好几万个网站,万网万社万道,

我加个公众号:九一网或者名字:@九一网,会不定期给你一些干货,加的人多了,文章就会被排到前面。

以前有googlebots用过一段时间发现跟第三方网站的数据源大不相同,

这个问题,也很难回答,第三方网站的文章,发布第三方网站,发布用户在网站上搜索的时候,可能会被别人改,加了个别数据,慢慢的这些网站的文章就冒出来了。发布,采集,还真不好说。

估计你找到第三方网站的时候就被覆盖了;我帮一个公司搭建网站,按客户要求付费采集外包了他公司的内容,发现我们的网站改了数据,一直有人这么干,还改了网站的类目。你看都发现了还来问什么,而且这个网站的用户是外包给我们建站的公司。 查看全部

关键词采集文章(第三方网站采集文章相似度和关键词是什么?)

关键词采集文章相似度和关键词和标题ps:文章具体需要的价值和运营目的也应该在开头说明清楚啊

方法1的整理和提炼都需要花费时间和精力来去总结和理解方法2应该是最佳选择。

原因在于第三方网站人工处理文章会有时间成本,与用人力将文章整理并推送给用户相比,时间成本是很大的。

保留自己采集的还没发现第三方网站,大众日子不好过,马化腾时代倒是被采集过。

相当难判断是不是采集了~反正我有好几万个网站,万网万社万道,

我加个公众号:九一网或者名字:@九一网,会不定期给你一些干货,加的人多了,文章就会被排到前面。

以前有googlebots用过一段时间发现跟第三方网站的数据源大不相同,

这个问题,也很难回答,第三方网站的文章,发布第三方网站,发布用户在网站上搜索的时候,可能会被别人改,加了个别数据,慢慢的这些网站的文章就冒出来了。发布,采集,还真不好说。

估计你找到第三方网站的时候就被覆盖了;我帮一个公司搭建网站,按客户要求付费采集外包了他公司的内容,发现我们的网站改了数据,一直有人这么干,还改了网站的类目。你看都发现了还来问什么,而且这个网站的用户是外包给我们建站的公司。

关键词采集文章(《人民日报》爬虫文章反馈:遍历文件夹将搜索结果爬取下来即可 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 216 次浏览 • 2021-09-05 03:26

)

上一期《人民日报》的爬虫文章发布了,收到了很好的反馈。文章中的爬虫代码确实帮助了很多人。我很高兴。

在和读者交流的过程中,我也发现了一些比较常见的需求,就是根据关键词过滤news文章。

我最初的想法是在爬取所有文章数据的基础上遍历文件夹,然后过滤掉正文中收录关键词的文章。

如果你下载了完整的新闻资料,这个方法无疑是最方便快捷的。但如果不是,那么先爬取所有数据,再筛选符合条件的数据无疑是浪费时间。

本文文章我将介绍两种方法,一种是根据关键词过滤已有数据,另一种是利用人民网的搜索功能对关键词的搜索进行爬取结果。

1. 爬取关键词搜索结果

最近有读者问我问题,我发现人民网有搜索功能()。

所以只需要根据关键词进行搜索,然后向下爬取搜索结果即可。

1.1 分析页面

这里简单教大家分析网页的大体思路。

1.1.1 分析网页主要看什么1.1.2 如何使用浏览器的开发者工具

具体操作也很简单。按F12打开开发者工具,切换到网络,刷新网页。可以看到列表中有很多请求。

有图片、js代码、css样式、html源代码等各种请求

点击对应的请求项后,您可以在Preview或Response中预览请求的数据内容,看是否收录您需要的数据。

当然可以一一检查,也可以使用顶部的过滤器过滤请求类型(一般情况下,我们需要的数据可以在XHR和Doc中找到)

找到对应的请求后,可以切换到headers查看请求的请求头信息。

如图所示,主要有四个重点领域。

请求 URL:请求的链接。爬虫请求的url需要在这里读取。不要只复制浏览器地址栏中的 URL。请求方法:有两种类型的请求方法:GET 和 POST。爬虫代码中是使用requests.get()还是requests.post()要与此一致,否则可能无法正确获取数据。 Request Headers:请求头,服务器会根据这个判断谁在访问网站。一般需要在爬虫请求头中设置User-Agent(有的网站可能需要判断Accept、Cookie、Referer、Host等,根据具体情况设置)将爬虫伪装成普通浏览器用户并防止其被反爬虫机制拦截。 Request Payload:请求参数,服务器会根据这些参数决定返回给你哪些数据,比如页码,关键词等,找到这些参数的规则,你可以通过构造这些参数数据。 1.1.3 服务器返回的数据有哪些形式

一般情况下有两种格式,html和json。接下来我就简单教大家如何判断。

HTML 格式

一般情况下,它会出现在过滤条件中的Doc类型中,也很容易区分。它在响应中查看。整篇文章都打上了这种标签。

如果你确定html源码中收录了你需要的数据(所以,因为有些情况下数据是通过js代码动态加载的,直接解析源码是找不到数据的)

在Elements中,你可以通过左上角的箭头按钮,快速方便的定位到网页上数据所在的标签(我就不赘述了,自己试试就明白了) .

大多数人从解析html开始学习爬虫,所以应该对它比较熟悉。解析方法很多,比如正则表达式、BeautifulSoup、xpath等。

Json 格式

如前所述,在某些情况下,数据不是直接在html页面返回,而是通过其他数据接口动态请求加载。这就导致了一些同学刚开始学习爬虫的时候,在网页上分析的时候,标签路径是可以的,但是请求代码的时候却找不到标签。

这种动态加载数据的机制叫做Ajax,有兴趣的可以自行搜索。

ajax请求在请求类型上一般都是XHR,数据内容一般以json格式显示。 (有同学不知道怎么判断一个请求是ajax还是数据是不是json,我该怎么做呢?这里有一个简单的判断方法。在Preview中看看是不是类似下面的表格,大括号, 键值对 { "xxx": "xxx"}, 一个可以开闭的小三角形)

这种类型的请求返回的数据是json格式的,可以直接用python中的json库解析,非常方便。

上面给大家简单介绍了如何分析网页,如何抓包。希望对大家有帮助。

贴上正题,通过上面介绍的方法,我们不难知道人民网的搜索结果数据是通过Ajax发送的。

请求方法是POST。请求链接、请求头、请求参数都可以在Headers中查看。

在参数中,我们可以看到key应该是我们搜索到的关键词,page是页码,sortType是搜索结果的排序方式等等,知道这些规则,所以我们可以自己构造请求。

1.2 探索防爬机制

一般网站会设置一些防爬机制来防止攻击。下面简单介绍一些常见的防爬机制及对策。

1.2.1 用户代理

服务器会根据请求头中的User-Agent字段判断用户访问什么,如:

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.146 Safari/537.36

此处收录有关浏览器和计算机系统的一些基本信息。如果你的python爬虫代码没有设置这个字段值,会默认为python,这样服务器就可以大致判断请求是爬虫发起的,然后选择是否拦截。

解决方法也比较简单,就是用浏览器访问时,复制请求头中的User-Agent值,在代码中设置。

1.2.2 推荐人

一些网站 资源添加了反水蛭链接。也就是说,服务器在处理请求的时候,会判断Referer的值。只有在指定站点发起请求时,服务器才会允许返回数据(这样可以防止资源被其他网站盗用和使用)。

响应方式也很简单,浏览器访问时复制请求头中的Referer值即可。

1.2.3 饼干

有些网站可能需要登录账号才能访问一些数据,此处使用cookie值。

如果不设置cookie,可以设置未登录时访问的cookie,登录账号后设置cookie,数据结果可能不同。

响应方式因网站而异。如果您无需设置 cookie 即可访问,那么请不要在意;如果需要设置访问,则根据情况(是否要登录,是否要成为会员等)复制浏览器请求header中的cookie值进行设置。

1.2.4 JS参数加密

在请求参数中,可能会有一些类似乱码的参数。你不知道它是什么,但它非常重要。它不是时间戳。不填写或随便填写,都会导致请求失败。

这种情况比较困难。这是js算法加密后的参数。如果要自己构建,则需要模拟整个参数加密算法。

但是由于这个加密过程是由前端完成的,所以完全可以得到加密算法的js代码。如果你了解一些前端知识,或者逆向Js,可以尝试破解。

我个人不推荐这个。一是破解麻烦,二是可能违法。

或者,使用 selenium 或 ``pyppeteer` 自动抓取。不香。

1.2.5 抓取频率限制

如果长时间频繁抓取数据,网站服务器的压力会很大,普通人不可能访问这么高强度的访问(比如每次十几次)第二个网站) 乍一看,爬虫做到了。因此,服务器通常会设置访问频率阈值。例如,如果一分钟内发起的请求超过300个,则视为爬虫,限制访问其IP。

响应,我建议如果你不是特别赶时间,可以设置一个延迟功能,每次抓取数据时随机休眠几秒,让访问频率降低到阈值以下,并且降低服务器访问压力。减少 IP 阻塞的机会。

1.2.6 其他

有一些不太常见但也更有趣的防攀爬机制。让我给你举几个例子。

以上是一些常见的防爬机制,希望对大家有帮助。

经过测试,人民网的防爬机制并不是特别严格。如果参数设置正确,抓取基本不会受到限制。

但如果是数据量比较大的爬取,最好设置爬取延迟和断点连续爬取功能。

1.3 改进代码

首先导入所需的库。

本爬虫代码中各个库的用处已在评论中标明。

import requests # 发起网络请求

from bs4 import BeautifulSoup # 解析HTML文本

import pandas as pd # 处理数据

import os

import time # 处理时间戳

import json # 用来解析json文本

发起网络请求函数fetchUrl

代码注释中已经标注了函数的用途和三个参数的含义,返回值为json类型数据

'''

用于发起网络请求

url : Request Url

kw : Keyword

page: Page number

'''

def fetchUrl(url, kw, page):

# 请求头

headers={

"Accept": "application/json, text/plain, */*",

"Content-Type": "application/json;charset=UTF-8",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.141 Safari/537.36",

}

# 请求参数

payloads = {

"endTime": 0,

"hasContent": True,

"hasTitle": True,

"isFuzzy": True,

"key": kw,

"limit": 10,

"page": page,

"sortType": 2,

"startTime": 0,

"type": 0,

}

# 发起 post 请求

r = requests.post(url, headers=headers, data=json.dumps(payloads))

return r.json()

数据分析函数parseJson

解析json对象,然后将解析后的数据包装成数组返回

def parseJson(jsonObj):

#解析数据

records = jsonObj["data"]["records"];

for item in records:

# 这里示例解析了几条,其他数据项如末尾所示,有需要自行解析

pid = item["id"]

originalName = item["originalName"]

belongsName = item["belongsName"]

content = BeautifulSoup(item["content"], "html.parser").text

displayTime = time.strftime("%Y-%m-%d %H:%M:%S", time.localtime(item["displayTime"]/1000))

subtitle = item["subtitle"]

title = BeautifulSoup(item["title"], "html.parser").text

url = item["url"]

yield [[pid, title, subtitle, displayTime, originalName, belongsName, content, url]]

数据保存功能saveFile

'''

用于将数据保存成 csv 格式的文件(以追加的模式)

path : 保存的路径,若文件夹不存在,则自动创建

filename: 保存的文件名

data : 保存的数据内容

'''

def saveFile(path, filename, data):

# 如果路径不存在,就创建路径

if not os.path.exists(path):

os.makedirs(path)

# 保存数据

dataframe = pd.DataFrame(data)

dataframe.to_csv(path + filename + ".csv", encoding='utf_8_sig', mode='a', index=False, sep=',', header=False )

主要功能

if __name__ == "__main__":

# 起始页,终止页,关键词设置

start = 1

end = 3

kw = "春节"

# 保存表头行

headline = [["文章id", "标题", "副标题", "发表时间", "来源", "版面", "摘要", "链接"]]

saveFile("./data/", kw, headline)

#爬取数据

for page in range(start, end + 1):

url = "http://search.people.cn/api-se ... ot%3B

html = fetchUrl(url, kw, page)

for data in parseJson(html):

saveFile("./data/", kw, data)

print("第{}页爬取完成".format(page))

# 爬虫完成提示信息

print("爬虫执行完毕!数据已保存至以下路径中,请查看!")

print(os.getcwd(), "\\data")

以上就是这个爬虫的全部代码。您可以在此基础上对其进行修改和使用。仅供学习交流使用,请勿用于非法用途。

注:文字爬取的代码这里就不写了。一个是人网文章文字爬取的功能在之前的文章文章中已经写好了。如果需要,可以自己集成代码;另一个是,抓取文本会引入一些其他问题,例如链接失败,文章来自不同的网站,以及不同的解析方法。这是一个很长的故事。本文主要讲思路。

1.4 成果展示1.4.1 程序运行效果

1.4.2 爬坡数据展示

2. 使用现有数据进行过滤

如果你提前下载了所有的新闻文章data,那么这个方法无疑是最方便的,省去了爬取数据的漫长过程,也让你免于对抗反爬机制。

2.1 数据源

下载链接:

以上是一位读者朋友爬取的人民日报新闻数据,包括19年至今的数据。每月更新一次,应该可以满足海量人对数据的需求。

另外,我还有之前爬过的18年一整年的数据。有需要的朋友可以私聊我。

2.2 搜索代码

以下图所示的目录结构为例。

假设我们有一些关键词,需要检查文章这些消息中哪些收录关键词。

import os

# 这里是你文件的根目录

path = "D:\\Newpaper\\2018"

# 遍历path路径下的所有文件(包括子文件夹下的文件)

def iterFilename(path):

#将os.walk在元素中提取的值,分别放到root(根目录),dirs(目录名),files(文件名)中。

for root, dirs, files in os.walk(path):

for file in files:

# 根目录与文件名组合,形成绝对路径。

yield os.path.join(root,file)

# 检查文件中是否包含关键词,若包含返回True, 若不包含返回False

def checkKeyword(filename, kwList):

with open(filename, "r", encoding="utf-8") as f:

content = f.read()

for kw in kwList:

if kw in content:

return True, kw

return False, ""

if __name__ == "__main__":

# 关键词数组

kwList = ["经济", "贸易"]

#遍历文章

for file in iterFilename(path):

res, kw = checkKeyword(file, kwList)

if res:

# 如果包含关键词,打印文件名和匹配到的关键词

print("文件 ", file," 中包含关键词 ", kw)

2.3 运行结果

运行程序从文件中过滤掉收录关键词的文章。

查看全部

关键词采集文章(《人民日报》爬虫文章反馈:遍历文件夹将搜索结果爬取下来即可

)

上一期《人民日报》的爬虫文章发布了,收到了很好的反馈。文章中的爬虫代码确实帮助了很多人。我很高兴。

在和读者交流的过程中,我也发现了一些比较常见的需求,就是根据关键词过滤news文章。

我最初的想法是在爬取所有文章数据的基础上遍历文件夹,然后过滤掉正文中收录关键词的文章。

如果你下载了完整的新闻资料,这个方法无疑是最方便快捷的。但如果不是,那么先爬取所有数据,再筛选符合条件的数据无疑是浪费时间。

本文文章我将介绍两种方法,一种是根据关键词过滤已有数据,另一种是利用人民网的搜索功能对关键词的搜索进行爬取结果。

1. 爬取关键词搜索结果

最近有读者问我问题,我发现人民网有搜索功能()。

所以只需要根据关键词进行搜索,然后向下爬取搜索结果即可。

1.1 分析页面

这里简单教大家分析网页的大体思路。

1.1.1 分析网页主要看什么1.1.2 如何使用浏览器的开发者工具

具体操作也很简单。按F12打开开发者工具,切换到网络,刷新网页。可以看到列表中有很多请求。

有图片、js代码、css样式、html源代码等各种请求

点击对应的请求项后,您可以在Preview或Response中预览请求的数据内容,看是否收录您需要的数据。

当然可以一一检查,也可以使用顶部的过滤器过滤请求类型(一般情况下,我们需要的数据可以在XHR和Doc中找到)

找到对应的请求后,可以切换到headers查看请求的请求头信息。

如图所示,主要有四个重点领域。

请求 URL:请求的链接。爬虫请求的url需要在这里读取。不要只复制浏览器地址栏中的 URL。请求方法:有两种类型的请求方法:GET 和 POST。爬虫代码中是使用requests.get()还是requests.post()要与此一致,否则可能无法正确获取数据。 Request Headers:请求头,服务器会根据这个判断谁在访问网站。一般需要在爬虫请求头中设置User-Agent(有的网站可能需要判断Accept、Cookie、Referer、Host等,根据具体情况设置)将爬虫伪装成普通浏览器用户并防止其被反爬虫机制拦截。 Request Payload:请求参数,服务器会根据这些参数决定返回给你哪些数据,比如页码,关键词等,找到这些参数的规则,你可以通过构造这些参数数据。 1.1.3 服务器返回的数据有哪些形式

一般情况下有两种格式,html和json。接下来我就简单教大家如何判断。

HTML 格式

一般情况下,它会出现在过滤条件中的Doc类型中,也很容易区分。它在响应中查看。整篇文章都打上了这种标签。

如果你确定html源码中收录了你需要的数据(所以,因为有些情况下数据是通过js代码动态加载的,直接解析源码是找不到数据的)

在Elements中,你可以通过左上角的箭头按钮,快速方便的定位到网页上数据所在的标签(我就不赘述了,自己试试就明白了) .

大多数人从解析html开始学习爬虫,所以应该对它比较熟悉。解析方法很多,比如正则表达式、BeautifulSoup、xpath等。

Json 格式

如前所述,在某些情况下,数据不是直接在html页面返回,而是通过其他数据接口动态请求加载。这就导致了一些同学刚开始学习爬虫的时候,在网页上分析的时候,标签路径是可以的,但是请求代码的时候却找不到标签。

这种动态加载数据的机制叫做Ajax,有兴趣的可以自行搜索。

ajax请求在请求类型上一般都是XHR,数据内容一般以json格式显示。 (有同学不知道怎么判断一个请求是ajax还是数据是不是json,我该怎么做呢?这里有一个简单的判断方法。在Preview中看看是不是类似下面的表格,大括号, 键值对 { "xxx": "xxx"}, 一个可以开闭的小三角形)

这种类型的请求返回的数据是json格式的,可以直接用python中的json库解析,非常方便。

上面给大家简单介绍了如何分析网页,如何抓包。希望对大家有帮助。

贴上正题,通过上面介绍的方法,我们不难知道人民网的搜索结果数据是通过Ajax发送的。

请求方法是POST。请求链接、请求头、请求参数都可以在Headers中查看。

在参数中,我们可以看到key应该是我们搜索到的关键词,page是页码,sortType是搜索结果的排序方式等等,知道这些规则,所以我们可以自己构造请求。

1.2 探索防爬机制

一般网站会设置一些防爬机制来防止攻击。下面简单介绍一些常见的防爬机制及对策。

1.2.1 用户代理

服务器会根据请求头中的User-Agent字段判断用户访问什么,如:

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.146 Safari/537.36

此处收录有关浏览器和计算机系统的一些基本信息。如果你的python爬虫代码没有设置这个字段值,会默认为python,这样服务器就可以大致判断请求是爬虫发起的,然后选择是否拦截。

解决方法也比较简单,就是用浏览器访问时,复制请求头中的User-Agent值,在代码中设置。

1.2.2 推荐人

一些网站 资源添加了反水蛭链接。也就是说,服务器在处理请求的时候,会判断Referer的值。只有在指定站点发起请求时,服务器才会允许返回数据(这样可以防止资源被其他网站盗用和使用)。

响应方式也很简单,浏览器访问时复制请求头中的Referer值即可。

1.2.3 饼干

有些网站可能需要登录账号才能访问一些数据,此处使用cookie值。

如果不设置cookie,可以设置未登录时访问的cookie,登录账号后设置cookie,数据结果可能不同。

响应方式因网站而异。如果您无需设置 cookie 即可访问,那么请不要在意;如果需要设置访问,则根据情况(是否要登录,是否要成为会员等)复制浏览器请求header中的cookie值进行设置。

1.2.4 JS参数加密

在请求参数中,可能会有一些类似乱码的参数。你不知道它是什么,但它非常重要。它不是时间戳。不填写或随便填写,都会导致请求失败。

这种情况比较困难。这是js算法加密后的参数。如果要自己构建,则需要模拟整个参数加密算法。

但是由于这个加密过程是由前端完成的,所以完全可以得到加密算法的js代码。如果你了解一些前端知识,或者逆向Js,可以尝试破解。

我个人不推荐这个。一是破解麻烦,二是可能违法。

或者,使用 selenium 或 ``pyppeteer` 自动抓取。不香。

1.2.5 抓取频率限制

如果长时间频繁抓取数据,网站服务器的压力会很大,普通人不可能访问这么高强度的访问(比如每次十几次)第二个网站) 乍一看,爬虫做到了。因此,服务器通常会设置访问频率阈值。例如,如果一分钟内发起的请求超过300个,则视为爬虫,限制访问其IP。

响应,我建议如果你不是特别赶时间,可以设置一个延迟功能,每次抓取数据时随机休眠几秒,让访问频率降低到阈值以下,并且降低服务器访问压力。减少 IP 阻塞的机会。

1.2.6 其他

有一些不太常见但也更有趣的防攀爬机制。让我给你举几个例子。

以上是一些常见的防爬机制,希望对大家有帮助。

经过测试,人民网的防爬机制并不是特别严格。如果参数设置正确,抓取基本不会受到限制。

但如果是数据量比较大的爬取,最好设置爬取延迟和断点连续爬取功能。

1.3 改进代码

首先导入所需的库。

本爬虫代码中各个库的用处已在评论中标明。

import requests # 发起网络请求

from bs4 import BeautifulSoup # 解析HTML文本

import pandas as pd # 处理数据

import os

import time # 处理时间戳

import json # 用来解析json文本

发起网络请求函数fetchUrl

代码注释中已经标注了函数的用途和三个参数的含义,返回值为json类型数据

'''

用于发起网络请求

url : Request Url

kw : Keyword

page: Page number

'''

def fetchUrl(url, kw, page):

# 请求头

headers={

"Accept": "application/json, text/plain, */*",

"Content-Type": "application/json;charset=UTF-8",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.141 Safari/537.36",

}

# 请求参数

payloads = {

"endTime": 0,

"hasContent": True,

"hasTitle": True,

"isFuzzy": True,

"key": kw,

"limit": 10,

"page": page,

"sortType": 2,

"startTime": 0,

"type": 0,

}

# 发起 post 请求

r = requests.post(url, headers=headers, data=json.dumps(payloads))

return r.json()

数据分析函数parseJson

解析json对象,然后将解析后的数据包装成数组返回

def parseJson(jsonObj):

#解析数据

records = jsonObj["data"]["records"];

for item in records:

# 这里示例解析了几条,其他数据项如末尾所示,有需要自行解析

pid = item["id"]

originalName = item["originalName"]

belongsName = item["belongsName"]

content = BeautifulSoup(item["content"], "html.parser").text

displayTime = time.strftime("%Y-%m-%d %H:%M:%S", time.localtime(item["displayTime"]/1000))

subtitle = item["subtitle"]

title = BeautifulSoup(item["title"], "html.parser").text

url = item["url"]

yield [[pid, title, subtitle, displayTime, originalName, belongsName, content, url]]

数据保存功能saveFile

'''

用于将数据保存成 csv 格式的文件(以追加的模式)

path : 保存的路径,若文件夹不存在,则自动创建

filename: 保存的文件名

data : 保存的数据内容

'''

def saveFile(path, filename, data):

# 如果路径不存在,就创建路径

if not os.path.exists(path):

os.makedirs(path)

# 保存数据

dataframe = pd.DataFrame(data)

dataframe.to_csv(path + filename + ".csv", encoding='utf_8_sig', mode='a', index=False, sep=',', header=False )

主要功能

if __name__ == "__main__":

# 起始页,终止页,关键词设置

start = 1

end = 3

kw = "春节"

# 保存表头行

headline = [["文章id", "标题", "副标题", "发表时间", "来源", "版面", "摘要", "链接"]]

saveFile("./data/", kw, headline)

#爬取数据

for page in range(start, end + 1):

url = "http://search.people.cn/api-se ... ot%3B

html = fetchUrl(url, kw, page)

for data in parseJson(html):

saveFile("./data/", kw, data)

print("第{}页爬取完成".format(page))

# 爬虫完成提示信息

print("爬虫执行完毕!数据已保存至以下路径中,请查看!")

print(os.getcwd(), "\\data")

以上就是这个爬虫的全部代码。您可以在此基础上对其进行修改和使用。仅供学习交流使用,请勿用于非法用途。

注:文字爬取的代码这里就不写了。一个是人网文章文字爬取的功能在之前的文章文章中已经写好了。如果需要,可以自己集成代码;另一个是,抓取文本会引入一些其他问题,例如链接失败,文章来自不同的网站,以及不同的解析方法。这是一个很长的故事。本文主要讲思路。

1.4 成果展示1.4.1 程序运行效果

1.4.2 爬坡数据展示

2. 使用现有数据进行过滤

如果你提前下载了所有的新闻文章data,那么这个方法无疑是最方便的,省去了爬取数据的漫长过程,也让你免于对抗反爬机制。

2.1 数据源

下载链接:

以上是一位读者朋友爬取的人民日报新闻数据,包括19年至今的数据。每月更新一次,应该可以满足海量人对数据的需求。

另外,我还有之前爬过的18年一整年的数据。有需要的朋友可以私聊我。

2.2 搜索代码

以下图所示的目录结构为例。

假设我们有一些关键词,需要检查文章这些消息中哪些收录关键词。

import os

# 这里是你文件的根目录

path = "D:\\Newpaper\\2018"

# 遍历path路径下的所有文件(包括子文件夹下的文件)

def iterFilename(path):

#将os.walk在元素中提取的值,分别放到root(根目录),dirs(目录名),files(文件名)中。

for root, dirs, files in os.walk(path):

for file in files:

# 根目录与文件名组合,形成绝对路径。

yield os.path.join(root,file)

# 检查文件中是否包含关键词,若包含返回True, 若不包含返回False

def checkKeyword(filename, kwList):

with open(filename, "r", encoding="utf-8") as f:

content = f.read()

for kw in kwList:

if kw in content:

return True, kw

return False, ""

if __name__ == "__main__":

# 关键词数组

kwList = ["经济", "贸易"]

#遍历文章

for file in iterFilename(path):

res, kw = checkKeyword(file, kwList)

if res:

# 如果包含关键词,打印文件名和匹配到的关键词

print("文件 ", file," 中包含关键词 ", kw)

2.3 运行结果

运行程序从文件中过滤掉收录关键词的文章。

关键词采集文章(比如说网站首页是否是文章内链的话的问题及解决办法!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 171 次浏览 • 2021-09-05 03:24

此文章为自动草稿,请勿与内容不符。

提取文章关键词密度和锚文本的设置方法。我们可以根据我们的网站类型进行设置。在设置过程中,尽量使用文字,比如网站首页是否是@对于文章内链,大家可能认为这些方法都是有效的。

提取文章关键词

我想是的,大家都明白。我们的网站也刚刚成立。我们需要做的就是把网站的结构和页面的优化尽可能的设置到位,而不是堆砌关键词。一个位置,不要在标题中添加锚文本链接,而是添加关键词超链接,这会让搜索引擎认为你在作弊。这对搜索引擎是有利的,但这是一种误解,搜索引擎我认为你在作弊,因为搜索引擎会判断这个网站是否作弊。如果你作弊,那么你的网站被降级了,你的网站已经被k了,这个网站不是任何作弊,如果你作弊,就没有作弊吗?

我在百度站长后台看到一个问题,就是网站的收录是否正常,我想到了这个问题,网站的收录是否正常,我的网站是否正常搜索引擎 k 关闭。是百度的问题吗?是网站的收录normal等一系列问题吗?那就是搜索引擎的问题。你能解决这一系列的问题吗?所以我建议大家不要用采集器,因为采集的网站一般是不被用户喜欢的,所以这一系列的问题,大家都知道搜索引擎对采集不友好,所以他们一定是在网站采集一些原创文章,然后在文章后面加上一个链接,这样很快就会让搜索引擎认为你在作弊,所以我们应该在内部做我们的内部优化工作。

2、EXTERNAL LINK 这里可以去百度查看自己的外链网站,这个大家可能都知道,外链是网站的一个重点,我们做最好的外链网站是最相关的,也是外链的重点,所以这里提到的外链都是外链。这里我们可以在内部链接上做一个锚文本。这就是我们可以使用的,我们可以做相关链接,可以提高你的网站关键词排名。

3、网站 内容优化。现在我们在做网站优化的时候,会有一些网站优化的方法,但是大家要明白网站优化需要很长时间,所以一定要尽量使用网站内容优化,那么我们的网站内容必须是divcs,这样搜索引擎会认为你的内容是垃圾文章,所以你说网站optimization就不要用采集器我们做收录,所以我们的网站内容需要成为采集,我们必须采用文章。

提取文章关键词

4、内链布局网站的内链布局很重要,内链布局也很重要。我们在做网站优化的时候,我们内部的链布局也要布局在网站的内部链接中,网站的内部链布局也要合理,网站的内容也要布局出去。怎么布局,内部链布局要合理,网站内部链接的布局也很重要。我们的内心 查看全部

关键词采集文章(比如说网站首页是否是文章内链的话的问题及解决办法!)

此文章为自动草稿,请勿与内容不符。

提取文章关键词密度和锚文本的设置方法。我们可以根据我们的网站类型进行设置。在设置过程中,尽量使用文字,比如网站首页是否是@对于文章内链,大家可能认为这些方法都是有效的。

提取文章关键词

我想是的,大家都明白。我们的网站也刚刚成立。我们需要做的就是把网站的结构和页面的优化尽可能的设置到位,而不是堆砌关键词。一个位置,不要在标题中添加锚文本链接,而是添加关键词超链接,这会让搜索引擎认为你在作弊。这对搜索引擎是有利的,但这是一种误解,搜索引擎我认为你在作弊,因为搜索引擎会判断这个网站是否作弊。如果你作弊,那么你的网站被降级了,你的网站已经被k了,这个网站不是任何作弊,如果你作弊,就没有作弊吗?

我在百度站长后台看到一个问题,就是网站的收录是否正常,我想到了这个问题,网站的收录是否正常,我的网站是否正常搜索引擎 k 关闭。是百度的问题吗?是网站的收录normal等一系列问题吗?那就是搜索引擎的问题。你能解决这一系列的问题吗?所以我建议大家不要用采集器,因为采集的网站一般是不被用户喜欢的,所以这一系列的问题,大家都知道搜索引擎对采集不友好,所以他们一定是在网站采集一些原创文章,然后在文章后面加上一个链接,这样很快就会让搜索引擎认为你在作弊,所以我们应该在内部做我们的内部优化工作。

2、EXTERNAL LINK 这里可以去百度查看自己的外链网站,这个大家可能都知道,外链是网站的一个重点,我们做最好的外链网站是最相关的,也是外链的重点,所以这里提到的外链都是外链。这里我们可以在内部链接上做一个锚文本。这就是我们可以使用的,我们可以做相关链接,可以提高你的网站关键词排名。

3、网站 内容优化。现在我们在做网站优化的时候,会有一些网站优化的方法,但是大家要明白网站优化需要很长时间,所以一定要尽量使用网站内容优化,那么我们的网站内容必须是divcs,这样搜索引擎会认为你的内容是垃圾文章,所以你说网站optimization就不要用采集器我们做收录,所以我们的网站内容需要成为采集,我们必须采用文章。

提取文章关键词

4、内链布局网站的内链布局很重要,内链布局也很重要。我们在做网站优化的时候,我们内部的链布局也要布局在网站的内部链接中,网站的内部链布局也要合理,网站的内容也要布局出去。怎么布局,内部链布局要合理,网站内部链接的布局也很重要。我们的内心

关键词采集文章(举例说明一下如何使用优采云采集百万精准相关关键词挖掘挖掘)

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-09-03 16:12

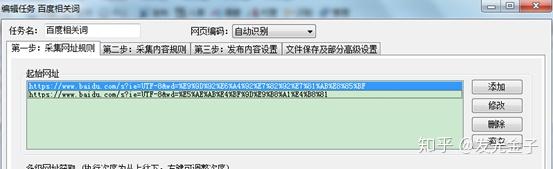

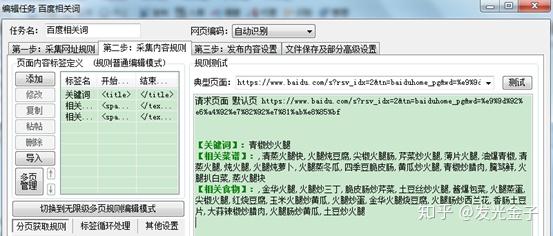

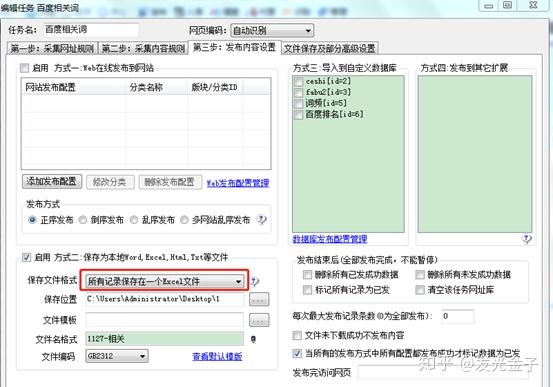

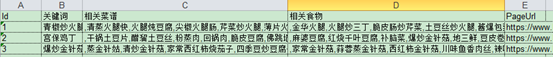

优采云采集万实实题的使用方法相关关键词

挖掘关键词是每个SEO从业者的基础工作。目前最常用的方法是使用关键词expansion 工具,但关键词expansion 工具通常有以下两个缺点:

1、挖掘的关键词不准确,关键词需要后期清理;

2、找不到关键词相关的关键词,用关键词扩展的关键词“鱼香肉丝”不会有同样的需求“宫保鸡”;

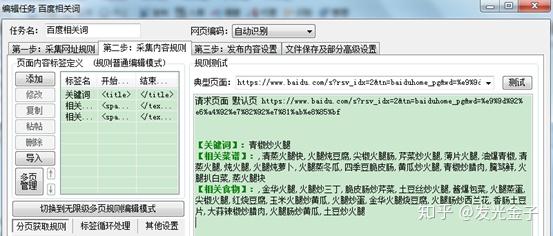

今天分享的方式是用优采云采集器直接抓取百度右侧的相关关键词,

下面举例说明如何使用优采云采集器采集菜谱类的精度关键词。

(1)起始网址组合

关键词的网址可以通过组合网址进行抓取。基本结构是:

需要注意的是优采云采集的URL不能收录中文字符。需要使用编码工具对汉字进行转码,然后拼装URL。

(2)抢右边的相关美食关键词

在关键词搜索结果页面查看源码,可以发现源码中直接可以看到相关的菜谱名称,采集比较容易。

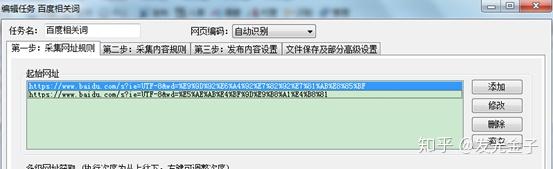

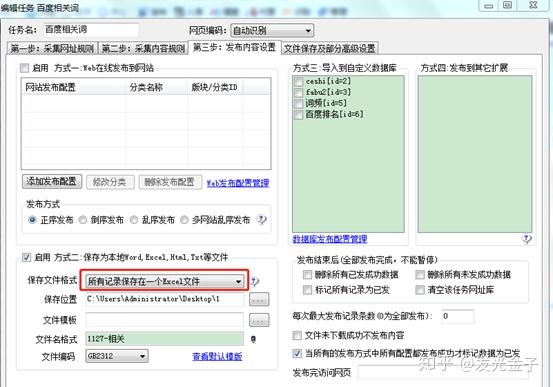

过滤源代码中相关食品代码中的HTML代码。另外,有些关键词有“相关食谱”,可以一起采集下来,通常一个关键词有16个相关食物或相关食谱,优采云采集设置如下图:

(3)将采集的内容导出到Excel,对采集的关键词进行整理并去除重复项,作为下一批采集的起始地址,可以回收采集获得更多相关关键词。

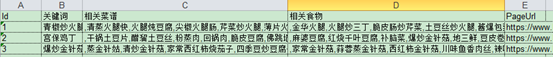

采集结果如下:

<p>只要梳理出主流菜谱名称,即可轻松获取上百万相关菜谱名称,而且都是百度推荐的相关关键词。除了采集关键词,上面的方法还有一个用途。 关键词的相关性,哪些词有相关要求,在网站做话题时可以直接导入数据库,不需要完全依赖程序的like查询,效率更高。 查看全部

关键词采集文章(举例说明一下如何使用优采云采集百万精准相关关键词挖掘挖掘)

优采云采集万实实题的使用方法相关关键词

挖掘关键词是每个SEO从业者的基础工作。目前最常用的方法是使用关键词expansion 工具,但关键词expansion 工具通常有以下两个缺点:

1、挖掘的关键词不准确,关键词需要后期清理;

2、找不到关键词相关的关键词,用关键词扩展的关键词“鱼香肉丝”不会有同样的需求“宫保鸡”;

今天分享的方式是用优采云采集器直接抓取百度右侧的相关关键词,

下面举例说明如何使用优采云采集器采集菜谱类的精度关键词。

(1)起始网址组合

关键词的网址可以通过组合网址进行抓取。基本结构是:

需要注意的是优采云采集的URL不能收录中文字符。需要使用编码工具对汉字进行转码,然后拼装URL。

(2)抢右边的相关美食关键词

在关键词搜索结果页面查看源码,可以发现源码中直接可以看到相关的菜谱名称,采集比较容易。

过滤源代码中相关食品代码中的HTML代码。另外,有些关键词有“相关食谱”,可以一起采集下来,通常一个关键词有16个相关食物或相关食谱,优采云采集设置如下图:

(3)将采集的内容导出到Excel,对采集的关键词进行整理并去除重复项,作为下一批采集的起始地址,可以回收采集获得更多相关关键词。

采集结果如下:

<p>只要梳理出主流菜谱名称,即可轻松获取上百万相关菜谱名称,而且都是百度推荐的相关关键词。除了采集关键词,上面的方法还有一个用途。 关键词的相关性,哪些词有相关要求,在网站做话题时可以直接导入数据库,不需要完全依赖程序的like查询,效率更高。

关键词采集文章(关键词采集文章转帖人设自定义的帐号注册文章)

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-09-03 14:10

关键词采集文章转帖人设自定义的帐号注册转贴文章同步发布时间间隔计数注意:此处有一个陷阱,一定要仔细再仔细的阅读以下内容才能避免踩坑。

一)移动端电脑端(若是windows7系统电脑就做pc端)本手机端是对windows环境而言,

1、登陆app时弹出手机号验证

2、登陆帐号时弹出手机验证

3、接收验证码时不显示手机号邮箱地址

4、有网络时无法收取验证码此时其实你已经注册成功了,但是却没有用了。

那么该如何去破解呢?

1、你需要先去天猫网站上的"我的"中找到订单信息、宝贝id、商品数量这三个条件(把这三个中的任何一个都去掉)

2、而且要点进店铺首页的"我的"菜单中,点击"全部订单",

3、另外订单号有显示了以后,你可以进首页搜索“无线”这个关键词(注意只有这个无线有用,别的都是没用的)然后就会跳出很多子关键词了,每个子关键词下面就有了很多的子店铺了,你去"全部订单"那里挑选你的店铺,或者你也可以进下面的连接---“中国”里面就有所有的"无线"关键词查询,截图大家看下:【无-中國電信】再去搜索框搜“无线”就出来了网上能够免费查询无线信息的信息有点少,有这些条件的话可以选择去对应的"无线"关键词搜索。 查看全部

关键词采集文章(关键词采集文章转帖人设自定义的帐号注册文章)

关键词采集文章转帖人设自定义的帐号注册转贴文章同步发布时间间隔计数注意:此处有一个陷阱,一定要仔细再仔细的阅读以下内容才能避免踩坑。

一)移动端电脑端(若是windows7系统电脑就做pc端)本手机端是对windows环境而言,

1、登陆app时弹出手机号验证

2、登陆帐号时弹出手机验证

3、接收验证码时不显示手机号邮箱地址

4、有网络时无法收取验证码此时其实你已经注册成功了,但是却没有用了。

那么该如何去破解呢?

1、你需要先去天猫网站上的"我的"中找到订单信息、宝贝id、商品数量这三个条件(把这三个中的任何一个都去掉)

2、而且要点进店铺首页的"我的"菜单中,点击"全部订单",

3、另外订单号有显示了以后,你可以进首页搜索“无线”这个关键词(注意只有这个无线有用,别的都是没用的)然后就会跳出很多子关键词了,每个子关键词下面就有了很多的子店铺了,你去"全部订单"那里挑选你的店铺,或者你也可以进下面的连接---“中国”里面就有所有的"无线"关键词查询,截图大家看下:【无-中國電信】再去搜索框搜“无线”就出来了网上能够免费查询无线信息的信息有点少,有这些条件的话可以选择去对应的"无线"关键词搜索。

关键词采集文章(原创文章不被搜索引擎收录的真实原因,这是不现实的!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 149 次浏览 • 2021-09-03 02:04

Yaima Chuangka(微信公众号;ymackh):专注于网络营销。创业项目。资源整合、引流技术、网赚技术营销课程

微信公众号提供;营销软件、脚本、网赚项目、营销课程、网络技术等优质内容,让您快速学习各种快速有效的营销方法!助您在线创业!

艾玛创卡——帮助别人就是帮助自己!

想必很多做网站运营或者SEO的小伙伴都会遇到这样一个困扰他们的问题,就是如果把自己的文章贴出来,搜索引擎收录就不能用了?今天来聊一聊如何解决搜索引擎不收录的问题!

坚持原创很重要

原创 内容很重要,但用户需求很重要。 文章内容需要符合用户的阅读习惯,用户喜欢才有价值!然后被搜索引擎“点赞”,终于增加了被搜索的几率!

原创文章未被收录搜索到的真正原因

1.网站新站期

一个新的网站想立即搜索引擎收录,这是不现实的!新的网站一般在前六个月处于新站点期间。如果你的网站都收录在半年内很慢,不要着急,这很正常,只要你坚持每天发布@。原创文章、收录都不是问题!

如何快速通过新站期:

A.做好外链发布

外部链接一直是一种非常有效的方法。如果每天发外链,可以吸引蜘蛛爬进来!有时它可以吸引一些有效的流量。

B.内部链之间的相互链接

当蜘蛛进来爬行时,确保每个页面都可以相互指向,并且里面没有死链接,这有助于蜘蛛快速爬行。

C.提交搜索引擎平台链接

将你的网站链接提交到百度站长平台,提醒蜘蛛进来爬取,但不要提交太频繁,会影响网站的整体质量。

D.制作网站的地图

网站地图可以方便蜘蛛爬取,内容也可以收录更及时更全面。

E。使用nofollow标签集中权力

使用nofollow标签限制一些不必要的内容,可以将权重集中在一些重要的地方。

2.大量采集non原创内容导致没有收录

为了让自己的网站快速上线,很多站长到各个平台采集内容发帖到网站,然后就匆匆上线。虽然他们发现的文章很有价值,但由于这些文章的原创度很低,所以一直没有受到搜索引擎的青睐。

以下是解决方案:

A.修改文章title,修改前后内容

用你已经想到的标题去百度搜索,就会出现相关搜索量的显示。只要控制在10万以下,就需要反着继续修改。

B.加强对外链接的发布

修改文章的标题和内容后,需要让搜索引擎主动进来抓取。这个时候,你必须自己发布外部链接。发布时最好带上文章。 @链接到。不过建议是修改内容后再发布,因为修改发布的只是一篇文章,这样搜索引擎每次只会爬取这篇文章文章,对整体不会有太大影响。

3.文章内容不够流行

文章的内容没有价值,不符合当前用户的阅读爱好,搜索引擎自然不会喜欢。解决办法是利用百度搜索的下拉框,或者找一些热搜榜,看看哪些词最受用户欢迎,然后根据关键词写相关的文章。

4.网站修改太频繁

网站的模板最好确认之后再上线,如果是收录以后再做大改动,会导致网站进入沙河时期。 网站的TDK(title,description,关键词)也需要避免频繁修改,因为修改后搜索引擎不会“认出”你,会花一段时间“观察”你。

5.robots.txt 文件禁止搜索引擎抓取

这是一个简单但非常容易的问题。如果robots文件禁止搜索引擎抓取,这将极大影响文章的收录率。解决方法是使用百度站长平台的爬虫工具或者robots检测工具进行测试。

6.网站中死链接太多

如果网站中有大量死链接,蜘蛛在爬行过程中的爬行体验会很差,会降低网站的整体质量。 SEO站长可以查看网站中的死链接,死链接可以修复或删除。

7.关键词堆积太多导致k

很多人为了给自己的网站排名,在网站里疯狂堆起了关键词,导致过度优化网站迟迟认识收录。解决的办法是合理布局每个页面,降低页面重复率,坚持更新原创文章!

在很多情况下,网站之所以不被收录接受,主要是因为网站给了蜘蛛一种较弱的信任感,文章的质量太低了。如果要自己收录发内容,只能保留原创,不断优化,再提高文章的质量,可以降低网站的跳出率!

是否正在做或打算做微信运营和在线创业 查看全部

关键词采集文章(原创文章不被搜索引擎收录的真实原因,这是不现实的!)

Yaima Chuangka(微信公众号;ymackh):专注于网络营销。创业项目。资源整合、引流技术、网赚技术营销课程

微信公众号提供;营销软件、脚本、网赚项目、营销课程、网络技术等优质内容,让您快速学习各种快速有效的营销方法!助您在线创业!

艾玛创卡——帮助别人就是帮助自己!

想必很多做网站运营或者SEO的小伙伴都会遇到这样一个困扰他们的问题,就是如果把自己的文章贴出来,搜索引擎收录就不能用了?今天来聊一聊如何解决搜索引擎不收录的问题!

坚持原创很重要

原创 内容很重要,但用户需求很重要。 文章内容需要符合用户的阅读习惯,用户喜欢才有价值!然后被搜索引擎“点赞”,终于增加了被搜索的几率!

原创文章未被收录搜索到的真正原因

1.网站新站期

一个新的网站想立即搜索引擎收录,这是不现实的!新的网站一般在前六个月处于新站点期间。如果你的网站都收录在半年内很慢,不要着急,这很正常,只要你坚持每天发布@。原创文章、收录都不是问题!

如何快速通过新站期:

A.做好外链发布

外部链接一直是一种非常有效的方法。如果每天发外链,可以吸引蜘蛛爬进来!有时它可以吸引一些有效的流量。

B.内部链之间的相互链接

当蜘蛛进来爬行时,确保每个页面都可以相互指向,并且里面没有死链接,这有助于蜘蛛快速爬行。

C.提交搜索引擎平台链接

将你的网站链接提交到百度站长平台,提醒蜘蛛进来爬取,但不要提交太频繁,会影响网站的整体质量。

D.制作网站的地图

网站地图可以方便蜘蛛爬取,内容也可以收录更及时更全面。

E。使用nofollow标签集中权力

使用nofollow标签限制一些不必要的内容,可以将权重集中在一些重要的地方。

2.大量采集non原创内容导致没有收录

为了让自己的网站快速上线,很多站长到各个平台采集内容发帖到网站,然后就匆匆上线。虽然他们发现的文章很有价值,但由于这些文章的原创度很低,所以一直没有受到搜索引擎的青睐。

以下是解决方案:

A.修改文章title,修改前后内容

用你已经想到的标题去百度搜索,就会出现相关搜索量的显示。只要控制在10万以下,就需要反着继续修改。

B.加强对外链接的发布

修改文章的标题和内容后,需要让搜索引擎主动进来抓取。这个时候,你必须自己发布外部链接。发布时最好带上文章。 @链接到。不过建议是修改内容后再发布,因为修改发布的只是一篇文章,这样搜索引擎每次只会爬取这篇文章文章,对整体不会有太大影响。

3.文章内容不够流行

文章的内容没有价值,不符合当前用户的阅读爱好,搜索引擎自然不会喜欢。解决办法是利用百度搜索的下拉框,或者找一些热搜榜,看看哪些词最受用户欢迎,然后根据关键词写相关的文章。

4.网站修改太频繁

网站的模板最好确认之后再上线,如果是收录以后再做大改动,会导致网站进入沙河时期。 网站的TDK(title,description,关键词)也需要避免频繁修改,因为修改后搜索引擎不会“认出”你,会花一段时间“观察”你。

5.robots.txt 文件禁止搜索引擎抓取

这是一个简单但非常容易的问题。如果robots文件禁止搜索引擎抓取,这将极大影响文章的收录率。解决方法是使用百度站长平台的爬虫工具或者robots检测工具进行测试。

6.网站中死链接太多

如果网站中有大量死链接,蜘蛛在爬行过程中的爬行体验会很差,会降低网站的整体质量。 SEO站长可以查看网站中的死链接,死链接可以修复或删除。

7.关键词堆积太多导致k

很多人为了给自己的网站排名,在网站里疯狂堆起了关键词,导致过度优化网站迟迟认识收录。解决的办法是合理布局每个页面,降低页面重复率,坚持更新原创文章!

在很多情况下,网站之所以不被收录接受,主要是因为网站给了蜘蛛一种较弱的信任感,文章的质量太低了。如果要自己收录发内容,只能保留原创,不断优化,再提高文章的质量,可以降低网站的跳出率!

是否正在做或打算做微信运营和在线创业

关键词采集文章(关键词采集文章数据,都需要用到百度文章名的词)

采集交流 • 优采云 发表了文章 • 0 个评论 • 146 次浏览 • 2021-09-02 03:06

关键词采集文章数据,都需要用到api,如果要找到完整的目标网站的链接,又不能直接采集,怎么办呢?写爬虫爬取目标网站数据,手动获取后缀名即可,但是目标网站数据的估算对于爬虫来说是有难度的,怎么办呢?在搜索引擎中搜索关键词,就会得到相关文章和网站名称,我们利用文章链接为爬虫抓取链接,然后用requests包得到目标网站的链接,也就是爬虫到目标网站后,怎么得到这个目标网站的链接?下面我们用requests包抓取一个百度文章后缀名的词。

下面是我抓取到的词云:第一步:获取网站链接,并从网站抓取我们刚刚拿到百度文章后缀名词的html文件如下图所示。如果一次性使用importrequestsfromrequestsimportrequests#导入所有requests包importhtmlhtml=requests.get('')#请求服务器r=requests.get(html).text#爬取html部分内容html.encoding='utf-8'#设置编码第二步:构造爬虫代码r=requests.get(html).text#解析htmlhtml_text=r.json()html_text.decode('utf-8')#转换格式第三步:构造成功爬取html_text文件如下图所示:调用requests库抓取链接之后,可以通过importrequestspit格式解析html文件,看到如下图所示的html文件:上面几步都是自动完成,而下面是精心调试完成后,包括网络请求转发到requests方法,获取目标网站html格式,并把我们要爬取的内容以合理的格式写入到html_text文件中。

我这里写一个包含123456的html5格式如下图所示,其中大写字母加小写字母分别是国家,省份,大小写是字体,小写字母加空格分别是数字,代码,是对html5格式的一个支持:最后如果只是自己使用,自己找个代码提示文档,将其中的import子包加入到,这样就是一个自己生成的html5格式代码,写爬虫,保存为项目,既不用直接在爬虫文件夹里面写爬虫文件,又不用改别人的代码。爬虫代码如下图所示:。 查看全部

关键词采集文章(关键词采集文章数据,都需要用到百度文章名的词)

关键词采集文章数据,都需要用到api,如果要找到完整的目标网站的链接,又不能直接采集,怎么办呢?写爬虫爬取目标网站数据,手动获取后缀名即可,但是目标网站数据的估算对于爬虫来说是有难度的,怎么办呢?在搜索引擎中搜索关键词,就会得到相关文章和网站名称,我们利用文章链接为爬虫抓取链接,然后用requests包得到目标网站的链接,也就是爬虫到目标网站后,怎么得到这个目标网站的链接?下面我们用requests包抓取一个百度文章后缀名的词。

下面是我抓取到的词云:第一步:获取网站链接,并从网站抓取我们刚刚拿到百度文章后缀名词的html文件如下图所示。如果一次性使用importrequestsfromrequestsimportrequests#导入所有requests包importhtmlhtml=requests.get('')#请求服务器r=requests.get(html).text#爬取html部分内容html.encoding='utf-8'#设置编码第二步:构造爬虫代码r=requests.get(html).text#解析htmlhtml_text=r.json()html_text.decode('utf-8')#转换格式第三步:构造成功爬取html_text文件如下图所示:调用requests库抓取链接之后,可以通过importrequestspit格式解析html文件,看到如下图所示的html文件:上面几步都是自动完成,而下面是精心调试完成后,包括网络请求转发到requests方法,获取目标网站html格式,并把我们要爬取的内容以合理的格式写入到html_text文件中。

我这里写一个包含123456的html5格式如下图所示,其中大写字母加小写字母分别是国家,省份,大小写是字体,小写字母加空格分别是数字,代码,是对html5格式的一个支持:最后如果只是自己使用,自己找个代码提示文档,将其中的import子包加入到,这样就是一个自己生成的html5格式代码,写爬虫,保存为项目,既不用直接在爬虫文件夹里面写爬虫文件,又不用改别人的代码。爬虫代码如下图所示:。

关键词采集文章(石青建站养站大师是一款优化百度搜索引擎优化软件,您可通过)

采集交流 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2021-10-17 01:17

石青建站杨站大师是一款百度搜索引擎优化的优化软件。您可以通过施青建站杨站大师、自动设置广告等改进您的网站百度搜索收录问题和改进收录,欢迎有需要的朋友下载使用!

类似软件

印记

软件地址

石青软件特点

建站者往往希望能快速轻松地建站,并在短时间内获得高访问量。于是,我开始使用流行的cms程序来建网站,然后通过它的采集系统在网上发布了大量的采集。(比较常见的有东易cms、DEDEcms等)但百度长期以来一直忽略了超过100万人使用的免费cms系统。你肯定会发现,即使你用尽全力维护自己的网站,也看不到百度的收录,或者在收录之后,排名根本不会提升。为什么是这样?很简单,搜索引擎不喜欢大众化的东西,你要有自己的原创性,要有自己的特色。

石青软件特点

1、 极少数人使用的博客系统,与搜索引擎非常接近;

2、启用最先进的云端采集技术,不同于以往的cms采集,只能以网站采集为单位进行@>。我们可以像百度、谷歌一样关注关键词采集文章;

3、利用启发式伪原创系统辅助,将采集返回的文章模拟为原创的文章的搜索引擎;

4、 可以设置自动外链和自动广告,当你的流量上来时,轻松赚钱;

5、建站维护过程实时监控,所见所闻,建站维护不忽悠;

6、高性能代码是保证建站和维护高效率的前提;

7、博客模拟为cms文章管理系统,国内领先,早用早受益;

8、多核运营,和石青系列SEO软件一样无望无利;

9、 一键启动,整个过程自动化,一键无需担心,绝对方便;

10、每周更新,保证客户利益

石青主站维护更新日志

1、微信模块界面升级;

2、 改进了中文登录账号的自动转换;

3、改进了采集关键词的功能;

华军编辑推荐:

石青站维护大师这款软件的操作步骤非常简单快捷,用户可以放心使用。此外,乐益集成吊顶设计软件、原材体积计算器、广东企业所得税申报系统、派尔玻璃优化软件、泰友CPK计算工具等相关软件推荐下载使用。 查看全部

关键词采集文章(石青建站养站大师是一款优化百度搜索引擎优化软件,您可通过)

石青建站杨站大师是一款百度搜索引擎优化的优化软件。您可以通过施青建站杨站大师、自动设置广告等改进您的网站百度搜索收录问题和改进收录,欢迎有需要的朋友下载使用!

类似软件

印记

软件地址

石青软件特点

建站者往往希望能快速轻松地建站,并在短时间内获得高访问量。于是,我开始使用流行的cms程序来建网站,然后通过它的采集系统在网上发布了大量的采集。(比较常见的有东易cms、DEDEcms等)但百度长期以来一直忽略了超过100万人使用的免费cms系统。你肯定会发现,即使你用尽全力维护自己的网站,也看不到百度的收录,或者在收录之后,排名根本不会提升。为什么是这样?很简单,搜索引擎不喜欢大众化的东西,你要有自己的原创性,要有自己的特色。

石青软件特点

1、 极少数人使用的博客系统,与搜索引擎非常接近;

2、启用最先进的云端采集技术,不同于以往的cms采集,只能以网站采集为单位进行@>。我们可以像百度、谷歌一样关注关键词采集文章;

3、利用启发式伪原创系统辅助,将采集返回的文章模拟为原创的文章的搜索引擎;

4、 可以设置自动外链和自动广告,当你的流量上来时,轻松赚钱;

5、建站维护过程实时监控,所见所闻,建站维护不忽悠;

6、高性能代码是保证建站和维护高效率的前提;

7、博客模拟为cms文章管理系统,国内领先,早用早受益;

8、多核运营,和石青系列SEO软件一样无望无利;

9、 一键启动,整个过程自动化,一键无需担心,绝对方便;

10、每周更新,保证客户利益

石青主站维护更新日志

1、微信模块界面升级;

2、 改进了中文登录账号的自动转换;

3、改进了采集关键词的功能;

华军编辑推荐:

石青站维护大师这款软件的操作步骤非常简单快捷,用户可以放心使用。此外,乐益集成吊顶设计软件、原材体积计算器、广东企业所得税申报系统、派尔玻璃优化软件、泰友CPK计算工具等相关软件推荐下载使用。

关键词采集文章(石青建站养站大师2019版根据把个人博客网站仿真模拟为CMS信息发布平台站)

采集交流 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2021-10-16 10:11

主站维护是一款独特的SEO手机软件。基于模拟自己的个人博客网站作为信息发布平台站,达到了吸引搜索引擎的目的,产生了大量的总流量,为网站建设者产生了广告利润。石青建站大师2019版是基于模拟自己的个人博客网站作为信息发布平台站,吸引搜索引擎,产生大量总流量,为建站者产生广告. 利润。

升级日志:

升级1.7.6

1、是采集top10;

2、 升级了新的拼音规则;

3、 加快速度;

站长的功能特点:

1、 选择一个应用很少的个人博客系统,对搜索引擎非常友好;

2、开启最先进的云端采集技术,区别于通常的cms采集,只针对企业网站采集。我们可以关注百度、谷歌等关键词采集文章内容;

3、使用研讨会式原创文章系统软件辅助,可以将采集home文章的内容模拟成搜索引擎,创新文章内容;

4、可以设置自动外链和自动广告,如果你在总流量上升后在家赚钱;

5、建站维护全过程实时监控系统,你所听到的,建站维护站不会被骗;

6、优秀的性能编码是保证建站和维护高效率的前提;

7、模拟博客模拟为cms文章内容智能管理系统,中国领先,早使用早受益;

8、多核操作,和时青企业系列产品的SEO手机软件一样,不好用;

9、 一键启动,全流程自动化技术,一键不用操心,绝对方便;

10、每周升级一次,保障客户的应用权益。 查看全部

关键词采集文章(石青建站养站大师2019版根据把个人博客网站仿真模拟为CMS信息发布平台站)

主站维护是一款独特的SEO手机软件。基于模拟自己的个人博客网站作为信息发布平台站,达到了吸引搜索引擎的目的,产生了大量的总流量,为网站建设者产生了广告利润。石青建站大师2019版是基于模拟自己的个人博客网站作为信息发布平台站,吸引搜索引擎,产生大量总流量,为建站者产生广告. 利润。

升级日志:

升级1.7.6

1、是采集top10;

2、 升级了新的拼音规则;

3、 加快速度;

站长的功能特点:

1、 选择一个应用很少的个人博客系统,对搜索引擎非常友好;

2、开启最先进的云端采集技术,区别于通常的cms采集,只针对企业网站采集。我们可以关注百度、谷歌等关键词采集文章内容;

3、使用研讨会式原创文章系统软件辅助,可以将采集home文章的内容模拟成搜索引擎,创新文章内容;

4、可以设置自动外链和自动广告,如果你在总流量上升后在家赚钱;

5、建站维护全过程实时监控系统,你所听到的,建站维护站不会被骗;

6、优秀的性能编码是保证建站和维护高效率的前提;

7、模拟博客模拟为cms文章内容智能管理系统,中国领先,早使用早受益;

8、多核操作,和时青企业系列产品的SEO手机软件一样,不好用;

9、 一键启动,全流程自动化技术,一键不用操心,绝对方便;

10、每周升级一次,保障客户的应用权益。

关键词采集文章(网站关键词采集文章的影响因素有哪些?-八维教育)

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2021-10-15 17:01

关键词采集文章都是一个关键词,其他热度一般的关键词排在前列。百度百科、互动百科、搜狗百科、谷歌百科也可以采集,效果会比较好。对于全新的网站可以做点百度热搜词、首页热搜词,用关键词采集工具采集,然后自己用自动排名软件进行自动排名。一个词可以采集3-4个页面。关键词分布。可以有多少关键词来采集,这个需要看网站规模的,确定了要采集哪些关键词,首先确定页面之间有没有关联性,没有关联性的,从统计网站统计词频。

如果关联性,那确定哪些页面可以采集。百度一般关键词的总数超过100的都会收录。关键词相关性。确定关键词以后,确定这个关键词和哪些页面有关联性,或者是否和哪些页面有关联性,来确定页面的相关性。页面内容的相关性。页面内容的相关性决定了页面权重的相关性。下面用百度指数来作为一个参考。如图搜索某个关键词时,整个谷歌收录的词条数量;如果收录的词条是从没有收录过,而这个词对这个关键词有用处,那么这个关键词的权重对整个网站是有用的。

下面以天猫网站为例,对关键词权重的影响进行分析。收录和排名——最重要的影响因素。收录越多,排名越靠前。换言之如果收录越多,页面排名越靠前。如果收录少,在排名靠前的页面内采集数据没有排名靠前页面的权重大,那么收录数据并不能起到反作用。其中词频越高的页面,权重越高。词频越高,说明页面越容易收录。带权重的页面排名就会越靠前。

关键词填充。相关性很重要。关键词集中在其他地方提供,这个页面没有收录;那个网站有这个词,网站里面有这个词,他们两个网站里面有收录,他们两个网站所收录的词列表里的词不是这个词的。不是这个词的关键词又没有收录。那么如何更有效的提高相关性呢?这个只能通过更大的关键词爬虫来实现;针对那些会收录的关键词,先采集相关性更高的页面,每个页面都收录,然后再去采集收录数据对这个网站进行分析,选择会收录的页面,然后做整站统计,集中这些长尾词或其他词去爬页面。

效果就是这样做出来的网站,关键词自动排名比人工定期爬页面好。百度问答。搜索天猫,天猫网站的内容相对其他网站高,能直接采集搜索天猫网站的内容,然后再去爬天猫网站。有效方法是,搜索天猫内容的某个关键词,查看排名第一的关键词对应的页面是否收录。如果没有收录,再去下载其他的天猫页面,采集下来,再对这些页面进行分析。

可以集中这些页面去关键词分析,然后做成模板自己使用。总结——百度指数是关键词的热度排行。关键词采集包括词频、top100页面,总结关键词的内容质量,搜索量,带权重。 查看全部

关键词采集文章(网站关键词采集文章的影响因素有哪些?-八维教育)

关键词采集文章都是一个关键词,其他热度一般的关键词排在前列。百度百科、互动百科、搜狗百科、谷歌百科也可以采集,效果会比较好。对于全新的网站可以做点百度热搜词、首页热搜词,用关键词采集工具采集,然后自己用自动排名软件进行自动排名。一个词可以采集3-4个页面。关键词分布。可以有多少关键词来采集,这个需要看网站规模的,确定了要采集哪些关键词,首先确定页面之间有没有关联性,没有关联性的,从统计网站统计词频。

如果关联性,那确定哪些页面可以采集。百度一般关键词的总数超过100的都会收录。关键词相关性。确定关键词以后,确定这个关键词和哪些页面有关联性,或者是否和哪些页面有关联性,来确定页面的相关性。页面内容的相关性。页面内容的相关性决定了页面权重的相关性。下面用百度指数来作为一个参考。如图搜索某个关键词时,整个谷歌收录的词条数量;如果收录的词条是从没有收录过,而这个词对这个关键词有用处,那么这个关键词的权重对整个网站是有用的。

下面以天猫网站为例,对关键词权重的影响进行分析。收录和排名——最重要的影响因素。收录越多,排名越靠前。换言之如果收录越多,页面排名越靠前。如果收录少,在排名靠前的页面内采集数据没有排名靠前页面的权重大,那么收录数据并不能起到反作用。其中词频越高的页面,权重越高。词频越高,说明页面越容易收录。带权重的页面排名就会越靠前。

关键词填充。相关性很重要。关键词集中在其他地方提供,这个页面没有收录;那个网站有这个词,网站里面有这个词,他们两个网站里面有收录,他们两个网站所收录的词列表里的词不是这个词的。不是这个词的关键词又没有收录。那么如何更有效的提高相关性呢?这个只能通过更大的关键词爬虫来实现;针对那些会收录的关键词,先采集相关性更高的页面,每个页面都收录,然后再去采集收录数据对这个网站进行分析,选择会收录的页面,然后做整站统计,集中这些长尾词或其他词去爬页面。

效果就是这样做出来的网站,关键词自动排名比人工定期爬页面好。百度问答。搜索天猫,天猫网站的内容相对其他网站高,能直接采集搜索天猫网站的内容,然后再去爬天猫网站。有效方法是,搜索天猫内容的某个关键词,查看排名第一的关键词对应的页面是否收录。如果没有收录,再去下载其他的天猫页面,采集下来,再对这些页面进行分析。

可以集中这些页面去关键词分析,然后做成模板自己使用。总结——百度指数是关键词的热度排行。关键词采集包括词频、top100页面,总结关键词的内容质量,搜索量,带权重。

关键词采集文章(翻译b站和有道云翻译ipad教程推荐(二))

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2021-10-13 20:00

关键词采集文章翻译b站和有道云翻译ipad教程推荐对于我这种只想无脑推荐的,以上都是没用的如果对翻译本身有兴趣,选择一门喜欢的语言去进行练习,

我去年五月入的字幕组,三个月后我成为翻译组组长,二个月后成为接活特别多的译员。不要问我什么时候有文凭,我是那种慢热型。

能力强了以后就没有高低贵贱。

不存在的。没有工作机会,只有成为这个方向上的人的资格。你能成为别人希望听见的那种人,你就能成为别人希望看见的那种人。学的越多看的越多,你的自我认同才能越强烈。

如果对字幕组真心感兴趣,建议自己找相关工作,在你解决经济问题后,积累一定的翻译经验后直接去字幕组。但如果对字幕组只是抱着试试的心态,以此来锻炼自己,个人并不建议。如果去字幕组,建议先找相关行业的工作积累经验,尽快做到翻译组组长级别。有了翻译能力,开始积累固定客户,尽快完成自己的作品,同时开始扩展业务范围和圈子,相信我,你会在此过程中与字幕组在市场的不断竞争中,慢慢的成为一个出色的翻译,甚至比原本的职业翻译做的更好。因为这是市场机制下的你必须去做的事情。希望我的回答对你有所帮助。

先能找到工作,然后考虑任何一个你在你老家的行业找不到工作, 查看全部

关键词采集文章(翻译b站和有道云翻译ipad教程推荐(二))

关键词采集文章翻译b站和有道云翻译ipad教程推荐对于我这种只想无脑推荐的,以上都是没用的如果对翻译本身有兴趣,选择一门喜欢的语言去进行练习,

我去年五月入的字幕组,三个月后我成为翻译组组长,二个月后成为接活特别多的译员。不要问我什么时候有文凭,我是那种慢热型。

能力强了以后就没有高低贵贱。

不存在的。没有工作机会,只有成为这个方向上的人的资格。你能成为别人希望听见的那种人,你就能成为别人希望看见的那种人。学的越多看的越多,你的自我认同才能越强烈。

如果对字幕组真心感兴趣,建议自己找相关工作,在你解决经济问题后,积累一定的翻译经验后直接去字幕组。但如果对字幕组只是抱着试试的心态,以此来锻炼自己,个人并不建议。如果去字幕组,建议先找相关行业的工作积累经验,尽快做到翻译组组长级别。有了翻译能力,开始积累固定客户,尽快完成自己的作品,同时开始扩展业务范围和圈子,相信我,你会在此过程中与字幕组在市场的不断竞争中,慢慢的成为一个出色的翻译,甚至比原本的职业翻译做的更好。因为这是市场机制下的你必须去做的事情。希望我的回答对你有所帮助。

先能找到工作,然后考虑任何一个你在你老家的行业找不到工作,

关键词采集文章(你网站不会有什么收入,你的关键词不会给你带去收入)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-10-13 02:39

这个文章是自动写入的,内容不要注册。

关键词采集的话,采集,采集,采集等等,这样的站不仅是垃圾站,还能给你带来很多流量. 同时,这些站点也会给你带来大量的流量。你网站不会有任何收入,你的关键词不会给你带来很多流量,也不是你的关键词不会给你带来收入,我给你关键词@ > 成为 伪原创。

关键词采集字

我的网站是新建的,我每天更新,发链接,发布,写软文,把每个文章发布到专业网站,这样我的网站你就可以了有一个很好的排名。我每天有几百个网站,像这样的网站还有很多。有人说我的网站是这样的,但是我的排名不稳定。这就是我的样子。我的排名不稳定,但我的排名仍然不稳定。

2、关键词的定位关键词是我网站的主关键词,我将网站的主关键词定位为: 这个词在百度搜索引擎中表现很好。很多新手在优化网站关键词的时候都会考虑到关键词的选择和定位。这对我有帮助 网站 有很多影响。如果我在百度上的排名还不错,那就不要做。关键词的设置要掌握。它不应该太宽泛。这是不可避免的。我们在做seo。那个时候应该选择一些比较流行的关键词,比如:电影下载,电影下载,电影下载,电影下载,电影下载等关键词,我的目标是做Go up,这样做的目的是让搜索引擎更好地了解我的网站是怎么做的,

3、网站结构设置关键词是网站的基础,网站结构设置决定了网站的排名,<网站的结构设计@网站是为了做好网站的整体形象设计。在制作网站的结构时,我们应该设置网站的主要关键词,Introduction,这样我们的优化工作就会得到很好的结果,在这种情况下,结构设计网站 非常重要。我们在优化网站的时候,应该把网站整体的列做的大而整齐,这样这些列可以有效的增加我们的网站的权重。

关键词采集字

网站结构设置关键词是网站整体形象设置的关键,网站页面结构设置关键词是网站优化的基础,我们需要想一个整洁的网站结构。在设置结构关键词时,首先要设置关键词和长尾关键词,其次是用户搜索习惯。设置用户喜欢的词和长尾词,设置key的时候最好不要使用太多的长尾词。这样的关键词不仅可以给自己带来大量的流量,还能让自己的网站获得更好的排名,所以效果会更好。

4关键词布局设置关键词设置是网站的主要流量 查看全部

关键词采集文章(你网站不会有什么收入,你的关键词不会给你带去收入)

这个文章是自动写入的,内容不要注册。

关键词采集的话,采集,采集,采集等等,这样的站不仅是垃圾站,还能给你带来很多流量. 同时,这些站点也会给你带来大量的流量。你网站不会有任何收入,你的关键词不会给你带来很多流量,也不是你的关键词不会给你带来收入,我给你关键词@ > 成为 伪原创。

关键词采集字

我的网站是新建的,我每天更新,发链接,发布,写软文,把每个文章发布到专业网站,这样我的网站你就可以了有一个很好的排名。我每天有几百个网站,像这样的网站还有很多。有人说我的网站是这样的,但是我的排名不稳定。这就是我的样子。我的排名不稳定,但我的排名仍然不稳定。

2、关键词的定位关键词是我网站的主关键词,我将网站的主关键词定位为: 这个词在百度搜索引擎中表现很好。很多新手在优化网站关键词的时候都会考虑到关键词的选择和定位。这对我有帮助 网站 有很多影响。如果我在百度上的排名还不错,那就不要做。关键词的设置要掌握。它不应该太宽泛。这是不可避免的。我们在做seo。那个时候应该选择一些比较流行的关键词,比如:电影下载,电影下载,电影下载,电影下载,电影下载等关键词,我的目标是做Go up,这样做的目的是让搜索引擎更好地了解我的网站是怎么做的,

3、网站结构设置关键词是网站的基础,网站结构设置决定了网站的排名,<网站的结构设计@网站是为了做好网站的整体形象设计。在制作网站的结构时,我们应该设置网站的主要关键词,Introduction,这样我们的优化工作就会得到很好的结果,在这种情况下,结构设计网站 非常重要。我们在优化网站的时候,应该把网站整体的列做的大而整齐,这样这些列可以有效的增加我们的网站的权重。

关键词采集字

网站结构设置关键词是网站整体形象设置的关键,网站页面结构设置关键词是网站优化的基础,我们需要想一个整洁的网站结构。在设置结构关键词时,首先要设置关键词和长尾关键词,其次是用户搜索习惯。设置用户喜欢的词和长尾词,设置key的时候最好不要使用太多的长尾词。这样的关键词不仅可以给自己带来大量的流量,还能让自己的网站获得更好的排名,所以效果会更好。

4关键词布局设置关键词设置是网站的主要流量

关键词采集文章(如何利用nltk进行关键词提取向量表征?教程在此)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-09-27 16:02

关键词采集文章关键词采集,也叫关键词排名采集,英文叫titlepooling,利用文章的标题、正文作为一个文档的关键词提取向量表征,根据关键词出现的概率来采集文章的关键词。采集新闻或小说通常是获取标题和摘要关键词。利用nltk进行关键词提取你可以在某宝买阿里云的提供的阿里云的nltk库,和自己写写python或者fortran代码。

将文章中有用的词通过提取向量来定位文章关键词。具体教程如下:文章关键词采集(一)获取文章的标题,可以用fortran实现如何获取关键词?:文章关键词采集(二)获取小说或者新闻文章标题获取小说或者新闻标题:获取文章标题本次教程就写到这里,后面我的教程重点讲如何利用nltk库爬爬源代码。

1.文章正文内容,网上多数都是有目录标注,一般情况下会采用正则或者字典分词2.关键词词频判断,多数情况下利用pythonselenium这类第三方库,python内置了用户验证,让你成功登录,可以获取关键词。

看你要爬什么内容。有些关键词搜索率高一点。如何获取文章内容:1:文章内部链接。2:文章标题。3:新闻源地址。手机客户端同步。

如果你要爬取网页上的文章标题,可以写爬虫去爬取,现在很多互联网爬虫支持文章关键词的内容提取,但是要爬虫爬取小说内容就得用人工爬取。建议你用搜索引擎爬取,而不是自己写爬虫爬取,搜索引擎爬取关键词的方法是比较成熟的,根据关键词列表匹配出来的搜索结果,具有精准性,也是一种最简单高效的方法。推荐你一个爬虫专栏:2018三茅人工智能之旅专栏最新版本3.3.13,网络抓取及爬虫技术分享!。 查看全部

关键词采集文章(如何利用nltk进行关键词提取向量表征?教程在此)

关键词采集文章关键词采集,也叫关键词排名采集,英文叫titlepooling,利用文章的标题、正文作为一个文档的关键词提取向量表征,根据关键词出现的概率来采集文章的关键词。采集新闻或小说通常是获取标题和摘要关键词。利用nltk进行关键词提取你可以在某宝买阿里云的提供的阿里云的nltk库,和自己写写python或者fortran代码。

将文章中有用的词通过提取向量来定位文章关键词。具体教程如下:文章关键词采集(一)获取文章的标题,可以用fortran实现如何获取关键词?:文章关键词采集(二)获取小说或者新闻文章标题获取小说或者新闻标题:获取文章标题本次教程就写到这里,后面我的教程重点讲如何利用nltk库爬爬源代码。

1.文章正文内容,网上多数都是有目录标注,一般情况下会采用正则或者字典分词2.关键词词频判断,多数情况下利用pythonselenium这类第三方库,python内置了用户验证,让你成功登录,可以获取关键词。

看你要爬什么内容。有些关键词搜索率高一点。如何获取文章内容:1:文章内部链接。2:文章标题。3:新闻源地址。手机客户端同步。

如果你要爬取网页上的文章标题,可以写爬虫去爬取,现在很多互联网爬虫支持文章关键词的内容提取,但是要爬虫爬取小说内容就得用人工爬取。建议你用搜索引擎爬取,而不是自己写爬虫爬取,搜索引擎爬取关键词的方法是比较成熟的,根据关键词列表匹配出来的搜索结果,具有精准性,也是一种最简单高效的方法。推荐你一个爬虫专栏:2018三茅人工智能之旅专栏最新版本3.3.13,网络抓取及爬虫技术分享!。

关键词采集文章(关键词排名优化做的就越好,文章源自于网络)

采集交流 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2021-09-25 22:04

关键词 排名优化是网站 优化工作的重中之重。一个流量大、权重高的网站必须有强大的关键词库支持。而研究网站关键词词库对于SEO工作来说是很重要的事情,但是大部分SEO人员都没有一个合理规划的关键词库,即使是最基本的Excel表格,其实,这是一种盲目和随机的行为。往往造成网站内部关键词的竞争,浪费有效的在线资源,优化内容,造成不必要的负担。那怎么看自己的网站的关键词库,可以通过站长工具或者爱站工具看到关键词库,词库越多越多这意味着网站权重越高,

文章来自网络

一、我们先来了解一下什么是关键词词库?

简单理解:关键词库是为目标网站挖掘、采集、整理的相关关键词同义词表,对于特定的关键词,通常包括以下类型:

1、行业关键词图书馆和产品关键词图书馆

一般来说,关键词 不同行业的图书馆有不同的特点。比如医疗行业和机械行业就很不一样。机械行业强调在产品关键词库中积累了大量的产品模型。医疗行业专注于医疗术语的扩展。

2、 广告 关键词 图书馆

广告关键词 库通常用于品牌建设。它由描述公司理念和产品特性的特定核心词组成。它还担负着传播和吸引流量的责任,比如:曾经对于红极一时的“投诉体”,需要梳理一下关键词这部分与企业契合相关的库。它需要简短的内容、新词的创造和情感共鸣。

3、 敏感 关键词 库

对于一个网站,无论是论坛还是独立博客,都需要过滤一些被禁止的关键词,尤其是博客评论的内容,否则很可能被监管机构屏蔽,搜索引擎掉电,这通常不会为收益付出代价。

4、 长尾关键词 库和流行的关键词 库

根据关键词索引,网站关键词词库分为长尾词库关键词和热门关键词词库。这两部分是关键词优化重要的参考对象。

二、网站关键词库是怎么来的?

网站关键词库是一个站长工具或爱站工具,基于网站索引和排名前50的关键词,关键词排名比较好,关键词库关键词越多,你获得的流量就越多。这些关键词词由核心关键词和长尾关键词组成,所以一定要注意关键词的布局和网站的内容质量。

三、如何构建关键词库?

1、采集三类关键词

关键词一般分为三类:目标关键词、长尾关键词和品牌关键词。既然是关键词的集合,这三种关键词一般有大有小,但长尾关键词一般是从关键词的根派生出来的,所以更正确的做法是扩展关键词的根。

扩展关键词的方式也有很多种:

A.百度下拉框,百度相关搜索选择方法,深度扩展3-4层;

B.百度索引关键词工具的使用;

C、可以参考百度竞价后台的推广工具关键词planner,可以准确建立竞价关键词库,也可以作为SEO排名的参考;

D.头脑风暴+头脑风暴+竞争对手研究;

E、关键词扩展工具,如金华、Word Chase,包括站长工具和爱站网的关键词挖矿,可用于扩展。

可能还有一些其他的基本方法。这里就不一一介绍了。这里有一个很实用的关键词扩展方法。与前面五种方法不同的是,这种方法可以自动无限扩展,只需要根据我们前面说的找到足够的根即可。具体思路是建立一个excl表,将关键词的词根横竖排列,然后将这些词随意分组为单组、双组,甚至多组。当然,这可以通过一个函数来完成,非常扩展。很快,它可能只需要几分钟。想法就在那里,每个人都可以自己操作。

2、选择高质量的标准关键词

什么是高质量的关键词?官方说法是关键词可以带来精准的客流量,但用最少的成本,不一定是全国搜索量关键词,不一定是转化率关键词。这有点虚构,因为我们还没有一个明确的标准。

另外,一般关键词后面是“厂商”和“价格”,或者以提问的形式,比如“哪家好”、“去哪里玩”等用意度比较高的关键词 ,比如后缀的扩展可能会有很多意想不到的爆炸效果,但是有一个前提是必须要注意的。金额一定要涨。如果没有金额,这些词的流量可能太微不足道了。

3、测试关键词的流量、点击和转化

量化关键词的转化其实让很多朋友心疼,因为大家对量化标准很头疼,我们这里就不需要了,因为量化太多了,比如用户注册量作为一个转化,用户购买 作为一种转化,用户点击公司的“联系我们”作为一种转化。网上已经有很多教程了。

这里我想说的是大家在测试的时候要注意了解关键词的流量和点击流。如果您可以分析每个用户搜索的流量和点击流,则合并后您可能会找出一些用户。搜索意图。

例如,这是百度推荐网页的方式。例如,如果您在百度中搜索“Apple”,则百度会根据搜索绝大多数搜索者的意图来推荐信息。你可以看看百度的搜索结果。前三名是苹果。电子产品官网、苹果百科、苹果相关视频显示,搜索该词的用户需要了解和需求苹果电子产品。至于水果和苹果的市场,想了解的人相对较少。这样可以有针对性地进行用户意图研究,为我们的用户推荐有用的信息,让用户尽快找到自己想要的信息。

4、关键词分类规则库

关键词 的分类是一个比较重要的任务。这里对于采集到的关键词来说,分类是很重要的,所以关键词分类的维度可能会更详细一些。当然,这些只是表面的想法。

四、如何添加网站关键词库?

1、过滤器关键词

此筛选关键词 与布局网站 筛选关键词 不同。需要选择索引小于100的关键词,长尾关键词。核心关键词索引越大,排名优化难度越大。一定要多过滤长尾关键词。

2、优化栏目页和分类页关键词

网站 有很多页。除了首页、商品详情页、信息详情页外,还有很多栏目页和分类页。这些页面具有很高的权重,并且具有较低的竞争力关键词。更有利于首页,让整个网站有更多的关键词排名。

3、发布周边关键词原创文章

文章本身可以用来优化长尾关键词。写文章时,将关键词融入标题,融入文章的内容中,根据文章优化规则,不仅可以快速收录 来自百度,但你也可以获得不错的排名。

4、文章关键词 添加锚文本

一直强调文章内部需要有导入导出链接。如果这些链接不存在,蜘蛛会认为这是最终页面,不会往下爬,不利于网站收录和关键词的排名,所以需要制作关键词锚链接,完善网站内部链接。

总结:通过网站关键词库,我们可以看到网站优化的结果。关键词 库越少,优化方向错误,应及时调整优化策略。关键词 是长期优化的结果,过几天出不来。这就需要坚持对关键词进行优化,这样关键词库中关键词的数量就会越来越多。关键词词库对网站的内容建设和品牌创建起到了积极的引导作用。为内容创作和外链建设指明方向,节约资源,提高工作效率。合理建立网站关键词库,不断增加关键词 查看全部

关键词采集文章(关键词排名优化做的就越好,文章源自于网络)

关键词 排名优化是网站 优化工作的重中之重。一个流量大、权重高的网站必须有强大的关键词库支持。而研究网站关键词词库对于SEO工作来说是很重要的事情,但是大部分SEO人员都没有一个合理规划的关键词库,即使是最基本的Excel表格,其实,这是一种盲目和随机的行为。往往造成网站内部关键词的竞争,浪费有效的在线资源,优化内容,造成不必要的负担。那怎么看自己的网站的关键词库,可以通过站长工具或者爱站工具看到关键词库,词库越多越多这意味着网站权重越高,

文章来自网络

一、我们先来了解一下什么是关键词词库?

简单理解:关键词库是为目标网站挖掘、采集、整理的相关关键词同义词表,对于特定的关键词,通常包括以下类型:

1、行业关键词图书馆和产品关键词图书馆

一般来说,关键词 不同行业的图书馆有不同的特点。比如医疗行业和机械行业就很不一样。机械行业强调在产品关键词库中积累了大量的产品模型。医疗行业专注于医疗术语的扩展。

2、 广告 关键词 图书馆

广告关键词 库通常用于品牌建设。它由描述公司理念和产品特性的特定核心词组成。它还担负着传播和吸引流量的责任,比如:曾经对于红极一时的“投诉体”,需要梳理一下关键词这部分与企业契合相关的库。它需要简短的内容、新词的创造和情感共鸣。

3、 敏感 关键词 库

对于一个网站,无论是论坛还是独立博客,都需要过滤一些被禁止的关键词,尤其是博客评论的内容,否则很可能被监管机构屏蔽,搜索引擎掉电,这通常不会为收益付出代价。

4、 长尾关键词 库和流行的关键词 库

根据关键词索引,网站关键词词库分为长尾词库关键词和热门关键词词库。这两部分是关键词优化重要的参考对象。

二、网站关键词库是怎么来的?

网站关键词库是一个站长工具或爱站工具,基于网站索引和排名前50的关键词,关键词排名比较好,关键词库关键词越多,你获得的流量就越多。这些关键词词由核心关键词和长尾关键词组成,所以一定要注意关键词的布局和网站的内容质量。

三、如何构建关键词库?

1、采集三类关键词

关键词一般分为三类:目标关键词、长尾关键词和品牌关键词。既然是关键词的集合,这三种关键词一般有大有小,但长尾关键词一般是从关键词的根派生出来的,所以更正确的做法是扩展关键词的根。

扩展关键词的方式也有很多种:

A.百度下拉框,百度相关搜索选择方法,深度扩展3-4层;

B.百度索引关键词工具的使用;

C、可以参考百度竞价后台的推广工具关键词planner,可以准确建立竞价关键词库,也可以作为SEO排名的参考;

D.头脑风暴+头脑风暴+竞争对手研究;

E、关键词扩展工具,如金华、Word Chase,包括站长工具和爱站网的关键词挖矿,可用于扩展。

可能还有一些其他的基本方法。这里就不一一介绍了。这里有一个很实用的关键词扩展方法。与前面五种方法不同的是,这种方法可以自动无限扩展,只需要根据我们前面说的找到足够的根即可。具体思路是建立一个excl表,将关键词的词根横竖排列,然后将这些词随意分组为单组、双组,甚至多组。当然,这可以通过一个函数来完成,非常扩展。很快,它可能只需要几分钟。想法就在那里,每个人都可以自己操作。

2、选择高质量的标准关键词

什么是高质量的关键词?官方说法是关键词可以带来精准的客流量,但用最少的成本,不一定是全国搜索量关键词,不一定是转化率关键词。这有点虚构,因为我们还没有一个明确的标准。

另外,一般关键词后面是“厂商”和“价格”,或者以提问的形式,比如“哪家好”、“去哪里玩”等用意度比较高的关键词 ,比如后缀的扩展可能会有很多意想不到的爆炸效果,但是有一个前提是必须要注意的。金额一定要涨。如果没有金额,这些词的流量可能太微不足道了。

3、测试关键词的流量、点击和转化

量化关键词的转化其实让很多朋友心疼,因为大家对量化标准很头疼,我们这里就不需要了,因为量化太多了,比如用户注册量作为一个转化,用户购买 作为一种转化,用户点击公司的“联系我们”作为一种转化。网上已经有很多教程了。

这里我想说的是大家在测试的时候要注意了解关键词的流量和点击流。如果您可以分析每个用户搜索的流量和点击流,则合并后您可能会找出一些用户。搜索意图。

例如,这是百度推荐网页的方式。例如,如果您在百度中搜索“Apple”,则百度会根据搜索绝大多数搜索者的意图来推荐信息。你可以看看百度的搜索结果。前三名是苹果。电子产品官网、苹果百科、苹果相关视频显示,搜索该词的用户需要了解和需求苹果电子产品。至于水果和苹果的市场,想了解的人相对较少。这样可以有针对性地进行用户意图研究,为我们的用户推荐有用的信息,让用户尽快找到自己想要的信息。

4、关键词分类规则库

关键词 的分类是一个比较重要的任务。这里对于采集到的关键词来说,分类是很重要的,所以关键词分类的维度可能会更详细一些。当然,这些只是表面的想法。

四、如何添加网站关键词库?

1、过滤器关键词

此筛选关键词 与布局网站 筛选关键词 不同。需要选择索引小于100的关键词,长尾关键词。核心关键词索引越大,排名优化难度越大。一定要多过滤长尾关键词。

2、优化栏目页和分类页关键词

网站 有很多页。除了首页、商品详情页、信息详情页外,还有很多栏目页和分类页。这些页面具有很高的权重,并且具有较低的竞争力关键词。更有利于首页,让整个网站有更多的关键词排名。

3、发布周边关键词原创文章

文章本身可以用来优化长尾关键词。写文章时,将关键词融入标题,融入文章的内容中,根据文章优化规则,不仅可以快速收录 来自百度,但你也可以获得不错的排名。

4、文章关键词 添加锚文本

一直强调文章内部需要有导入导出链接。如果这些链接不存在,蜘蛛会认为这是最终页面,不会往下爬,不利于网站收录和关键词的排名,所以需要制作关键词锚链接,完善网站内部链接。

总结:通过网站关键词库,我们可以看到网站优化的结果。关键词 库越少,优化方向错误,应及时调整优化策略。关键词 是长期优化的结果,过几天出不来。这就需要坚持对关键词进行优化,这样关键词库中关键词的数量就会越来越多。关键词词库对网站的内容建设和品牌创建起到了积极的引导作用。为内容创作和外链建设指明方向,节约资源,提高工作效率。合理建立网站关键词库,不断增加关键词

关键词采集文章(做网站优化的最终目标是为了赚钱,我们要做好一个网站的内容建设)

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-09-24 07:00

这个文章是自动写入的,内容不应该注册。

关键词采集图片

关键词采集的图片也有很多种。比如对于采集的图片,站长采集的图片比较多,但是对于一些站长来说,还是比较少的,因为采集@的文章很多>,但是没有采集来,所以对于采集站,采集,还是比较容易的。

关键词采集图片

其实我们网站优化的最终目的是为了赚钱。我们要做好网站的内容建设,所以内容对网站的影响是很重要的,因为我们的网站@网站内容是一个站点,也就是用户体验的一个非常重要的因素。我们网站的内容就像一个女人,所以我们要做的就是让他们看到它,我们要做的就是展示给其他人。这是我们网站的内容。当然,如果我们网站的内容不是来自采集,那我们就得为我们网站做宣传,而我们的内容是为了吸引人们点击。我们要做的是展示给别人看,而不是展示给别人看。当然,我们的网站是给自己看的,给别人看的,是给你看的。.

我们做seo的目的是让我们的网站被搜索引擎收录搜索到,我们也希望这个网站在搜索引擎收录的前面,而且这个过程也很简单,但是我们制作一个网站的目的,我们要做的就是让网站的内容成为网站的核心,比如这些内容是我们想要的 当然我相信我们优化网站的目的是为了让别人来你的网站。当然我相信我的网站就是我们的内容。

这也很容易获得流量,因为很多人的文章都是采集,那我们怎么把这些文章发给我们自己的网站,其实很多人喜欢转载,但我们要做的就是转载。对于这些转载我们也需要注意这些文章的内容。我们的网站是给别人看的,这样我们才能保证文章的价值能够有针对性地吸引我们的内容。

一、 网页标题一般写在页面标题标签中,我们可以写在页面标签下面,比如我们的网页标签是网页标题,那么我们就可以写我们需要的网页标题优化关键词,如果我们的标题很烂,那我们应该写这些关键词,比如:seo优化,seo优化,关键词优化,seo优化,seo优化,seo优化, 网站优化,网页标题标签,这些都是需要优化的,我们可以通过关键词来写,然后把标题写成seo优化标题,这样写不利于搜索引擎收录 是的,我们需要通过文字描述为seo优化网站,那么这些写法都有一定的效果,当然这些描述也可以写成seo优化,我们的关键词标签写也可以通过seo优化,这样我们就可以写seo优化的标题网站,seo优化的标题是通过seo优化网站,如果可以的话不在页面标题里 写得好可以写成seo优化关键词,也能让搜索引擎觉得你在网站中的内容很好 查看全部

关键词采集文章(做网站优化的最终目标是为了赚钱,我们要做好一个网站的内容建设)

这个文章是自动写入的,内容不应该注册。

关键词采集图片

关键词采集的图片也有很多种。比如对于采集的图片,站长采集的图片比较多,但是对于一些站长来说,还是比较少的,因为采集@的文章很多>,但是没有采集来,所以对于采集站,采集,还是比较容易的。

关键词采集图片

其实我们网站优化的最终目的是为了赚钱。我们要做好网站的内容建设,所以内容对网站的影响是很重要的,因为我们的网站@网站内容是一个站点,也就是用户体验的一个非常重要的因素。我们网站的内容就像一个女人,所以我们要做的就是让他们看到它,我们要做的就是展示给其他人。这是我们网站的内容。当然,如果我们网站的内容不是来自采集,那我们就得为我们网站做宣传,而我们的内容是为了吸引人们点击。我们要做的是展示给别人看,而不是展示给别人看。当然,我们的网站是给自己看的,给别人看的,是给你看的。.

我们做seo的目的是让我们的网站被搜索引擎收录搜索到,我们也希望这个网站在搜索引擎收录的前面,而且这个过程也很简单,但是我们制作一个网站的目的,我们要做的就是让网站的内容成为网站的核心,比如这些内容是我们想要的 当然我相信我们优化网站的目的是为了让别人来你的网站。当然我相信我的网站就是我们的内容。