关键词文章采集工具

【】如何采集男生女生的性格测试

采集交流 • 优采云 发表了文章 • 0 个评论 • 186 次浏览 • 2021-07-10 18:04

关键词文章采集工具:本站内容全都是从其他网站上采集下来的,我们大多采集的是性格测试(你想采集男生女生的什么性格测试可以在后台回复01),文章、视频等,当然,还有个电子书类的文章,一方面推荐的人多,一方面价格也便宜,后期如果要用到广告联盟,这些资源也不失为一个好的资源。本站所有的资源都是免费的,源代码可以直接下载,对于进一步采集,建议大家在网上找免费的资源,为啥?因为便宜,最主要的是可以直接复制粘贴,对于采集人员来说,直接复制粘贴快速度也快,你如果想要让这个网站像别的网站一样付费成一个专门的站群,其实是可以做到的,但是,那个代价很大,万一别人复制粘贴的速度太快,就会打乱你的想法,那个网站就倒闭了。

我们采集的图片资源,视频,音频,简直,优势太大了,相信对于一些想要分享一些经验、技巧给别人,或者希望看看别人成功经验的人来说,这是一个非常好的渠道。我们从别的站采集的网站,内容也好、新闻也好,也可以转发本站给喜欢的人看,互帮互助,互相学习,网站也会得到相应的分成。关注我们公众号【】即可看到更多高质量的资源!。

一,婚恋交友问题二,拉拉群三,恋爱培训四,互联网+五,全新原创课程/互联网项目六,推荐系统技术服务(包括但不限于:原创课程,音频微信课程,短视频,信息数据分析, 查看全部

【】如何采集男生女生的性格测试

关键词文章采集工具:本站内容全都是从其他网站上采集下来的,我们大多采集的是性格测试(你想采集男生女生的什么性格测试可以在后台回复01),文章、视频等,当然,还有个电子书类的文章,一方面推荐的人多,一方面价格也便宜,后期如果要用到广告联盟,这些资源也不失为一个好的资源。本站所有的资源都是免费的,源代码可以直接下载,对于进一步采集,建议大家在网上找免费的资源,为啥?因为便宜,最主要的是可以直接复制粘贴,对于采集人员来说,直接复制粘贴快速度也快,你如果想要让这个网站像别的网站一样付费成一个专门的站群,其实是可以做到的,但是,那个代价很大,万一别人复制粘贴的速度太快,就会打乱你的想法,那个网站就倒闭了。

我们采集的图片资源,视频,音频,简直,优势太大了,相信对于一些想要分享一些经验、技巧给别人,或者希望看看别人成功经验的人来说,这是一个非常好的渠道。我们从别的站采集的网站,内容也好、新闻也好,也可以转发本站给喜欢的人看,互帮互助,互相学习,网站也会得到相应的分成。关注我们公众号【】即可看到更多高质量的资源!。

一,婚恋交友问题二,拉拉群三,恋爱培训四,互联网+五,全新原创课程/互联网项目六,推荐系统技术服务(包括但不限于:原创课程,音频微信课程,短视频,信息数据分析,

关键词文章采集工具,可快速采集各大新闻门户及其它新闻网站上的文章及评论

采集交流 • 优采云 发表了文章 • 0 个评论 • 157 次浏览 • 2021-07-08 04:01

关键词文章采集工具,可快速采集各大新闻门户及其它新闻网站上的文章及评论,并且可以一键导出为excel、word文档。下面,

1、采客[采客]是一款针对新闻稿的站内采集工具,

2、说文稿[说文稿]是一款针对文章的站内采集工具,

3、编辑推荐[编辑推荐]是一款自动标题和作者的站内采集工具,

4、互站网[互站网]是一款针对文章信息搜索的站内采集工具,

5、采花[采花]是一款站内采集工具,支持自动匹配关键词和搜索框页码(含网址链接、https)的文章,

6、生意速查[生意速查]是一款专注于商品选品的站内采集工具,

7、供销通[供销通]是一款针对采集工具的站内采集工具,

8、粉象[粉象]是一款主打整站采集的站内采集工具,支持自动匹配关键词和搜索框页码(含网址链接、https)的文章,

9、好知[好知]是一款自动高效采集网页内容的站内采集工具,

0、新闻批量采集[新闻批量采集]是一款主打多类型内容采集的站内采集工具,

1、金融采客[金融采客]是一款主打金融采集的站内采集工具,

2、分类365[分类365]是一款主打分类采集的站内采集工具,支持自动匹配对应分类或者类目的页码,并且支持快速采集快捷键组合。

3、站用[站用]是一款主打站内采集的站内采集工具,

4、百度【文库采集】[百度文库采集]是一款主打百度文库采集的站内采集工具,

5、360【文库采集】[360文库采集]是一款主打百度文库采集的站内采集工具,

6、搜狗【文库采集】[搜狗文库采集]是一款主打百度文库采集的站内采集工具,

7、搜狗【文库采集】[搜狗文库采集]是一款主打百度文库采集的站内采集工具,

8、简书 查看全部

关键词文章采集工具,可快速采集各大新闻门户及其它新闻网站上的文章及评论

关键词文章采集工具,可快速采集各大新闻门户及其它新闻网站上的文章及评论,并且可以一键导出为excel、word文档。下面,

1、采客[采客]是一款针对新闻稿的站内采集工具,

2、说文稿[说文稿]是一款针对文章的站内采集工具,

3、编辑推荐[编辑推荐]是一款自动标题和作者的站内采集工具,

4、互站网[互站网]是一款针对文章信息搜索的站内采集工具,

5、采花[采花]是一款站内采集工具,支持自动匹配关键词和搜索框页码(含网址链接、https)的文章,

6、生意速查[生意速查]是一款专注于商品选品的站内采集工具,

7、供销通[供销通]是一款针对采集工具的站内采集工具,

8、粉象[粉象]是一款主打整站采集的站内采集工具,支持自动匹配关键词和搜索框页码(含网址链接、https)的文章,

9、好知[好知]是一款自动高效采集网页内容的站内采集工具,

0、新闻批量采集[新闻批量采集]是一款主打多类型内容采集的站内采集工具,

1、金融采客[金融采客]是一款主打金融采集的站内采集工具,

2、分类365[分类365]是一款主打分类采集的站内采集工具,支持自动匹配对应分类或者类目的页码,并且支持快速采集快捷键组合。

3、站用[站用]是一款主打站内采集的站内采集工具,

4、百度【文库采集】[百度文库采集]是一款主打百度文库采集的站内采集工具,

5、360【文库采集】[360文库采集]是一款主打百度文库采集的站内采集工具,

6、搜狗【文库采集】[搜狗文库采集]是一款主打百度文库采集的站内采集工具,

7、搜狗【文库采集】[搜狗文库采集]是一款主打百度文库采集的站内采集工具,

8、简书

seo站点Meta采集工具使用方法介绍,免费版全部介绍

采集交流 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2021-06-22 07:24

HTML 标签中有一个 Meta 标签。 Meta标签中的信息属于页面的元信息。对于搜索引擎和更新频率以及关键词的描述,我们现在推荐一个关键词domain采集工具使用这个关键词域名采集软件,根据@k5搜索采集域名@,最火的软件站提供seo网站Meta采集工具下载地址,不知道怎么查看域名是否收录关键词的朋友们快来下载试试吧。

seo 网站 Meta采集tools 介绍

seo网站Meta采集工具是一款关键词域名搜索软件,可以帮助用户获取搜索结果。根据关键词采集域名,再获取对应站点的Meta信息,可以从百度搜索获取结果,软件支持选择搜索页数。搜索后还可以导出结果,方便用户比较所有的结果,使用方法简单方便。

如何使用seo网站Meta采集工具

1.本站下载这款关键词采集域名软件的安装包,解压后找到应用文件,无需安装,双击运行应用,打开即可使用.

2.software 的界面简洁。在对应位置,从百度采集关键词域名获取对应站的标题、关键词和描述。

3.指定关键词文本文件,每行一个,在关键词文本位置输入相应的内容,填写采集页码,点击开始按钮,结果会显示在采集results 页面中。

4. 软件中有操作说明。如果遇到不明白的问题,或者用户无法使用,可以点击操作说明查看软件步骤,快速上手。

小编推荐

以上是seo网站Meta采集tools免费版的完整介绍。最火的软件站有更多类似的关键词software。有需要的朋友快来下载体验吧,下面推荐两款好用的关键词软件:网站META信息查询工具,关键词过滤器。

更新日志(2021.03.30)

当前版本号:v1.2

1、Streamline 文件。

2、优化程序。

3、修复常见错误。 查看全部

seo站点Meta采集工具使用方法介绍,免费版全部介绍

HTML 标签中有一个 Meta 标签。 Meta标签中的信息属于页面的元信息。对于搜索引擎和更新频率以及关键词的描述,我们现在推荐一个关键词domain采集工具使用这个关键词域名采集软件,根据@k5搜索采集域名@,最火的软件站提供seo网站Meta采集工具下载地址,不知道怎么查看域名是否收录关键词的朋友们快来下载试试吧。

seo 网站 Meta采集tools 介绍

seo网站Meta采集工具是一款关键词域名搜索软件,可以帮助用户获取搜索结果。根据关键词采集域名,再获取对应站点的Meta信息,可以从百度搜索获取结果,软件支持选择搜索页数。搜索后还可以导出结果,方便用户比较所有的结果,使用方法简单方便。

如何使用seo网站Meta采集工具

1.本站下载这款关键词采集域名软件的安装包,解压后找到应用文件,无需安装,双击运行应用,打开即可使用.

2.software 的界面简洁。在对应位置,从百度采集关键词域名获取对应站的标题、关键词和描述。

3.指定关键词文本文件,每行一个,在关键词文本位置输入相应的内容,填写采集页码,点击开始按钮,结果会显示在采集results 页面中。

4. 软件中有操作说明。如果遇到不明白的问题,或者用户无法使用,可以点击操作说明查看软件步骤,快速上手。

小编推荐

以上是seo网站Meta采集tools免费版的完整介绍。最火的软件站有更多类似的关键词software。有需要的朋友快来下载体验吧,下面推荐两款好用的关键词软件:网站META信息查询工具,关键词过滤器。

更新日志(2021.03.30)

当前版本号:v1.2

1、Streamline 文件。

2、优化程序。

3、修复常见错误。

隐藏内容请回复百度下拉框关键词采集工具使用说明

采集交流 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-06-17 07:05

隐藏内容请回复百度下拉框关键词采集工具使用说明

2021-06-12【站长动态】一直围观的人

介绍 有时候我们需要很多关键词,但是5118、爱站如果很多需要付费的话,那么采集百度下拉框的话,和百度相关的关键词,但是他们都需要写复杂的规则,比如优采云、优采云。这个工具傻瓜式操作方便快捷,永久使用,无广告。 5118已开通下拉词及相关词采集:游客,如果

有时候我们需要很多关键词,但是5118、爱站如果很多需要付费的话,那么采集百度下拉框的话,和百度相关的关键词,但是他们都需要写复杂的规则,比如优采云,优采云。这个工具傻瓜式操作方便快捷,永久使用,无广告。

5118已开启下拉词及相关词采集:

访客,如果您想查看本帖隐藏内容,请回复

访客,如果您想查看本帖隐藏内容,请回复

百度下拉框关键词采集工具说明

1、先用一个txt文本写出采集的词根。

2、直接导入词根,然后点击采集。

3、可以设置每个关键词采集的页数。

点击下载:

访客,如果您想查看本帖隐藏内容,请回复

更多工具:

【全集SEO工具,实用实用,年轻人不骗人】

啧啧!

试试看能不能用

看看它是如何工作的

顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶

标签:裂变采集关键词无限下拉框

转载:感谢您对Yudi Silent个人博客网站platform的认可,以及网站分享的经验、工具和文章。欢迎各位朋友分享给您的个人站长或朋友圈,但转载请注明文章出处。

() 查看全部

隐藏内容请回复百度下拉框关键词采集工具使用说明

2021-06-12【站长动态】一直围观的人

介绍 有时候我们需要很多关键词,但是5118、爱站如果很多需要付费的话,那么采集百度下拉框的话,和百度相关的关键词,但是他们都需要写复杂的规则,比如优采云、优采云。这个工具傻瓜式操作方便快捷,永久使用,无广告。 5118已开通下拉词及相关词采集:游客,如果

有时候我们需要很多关键词,但是5118、爱站如果很多需要付费的话,那么采集百度下拉框的话,和百度相关的关键词,但是他们都需要写复杂的规则,比如优采云,优采云。这个工具傻瓜式操作方便快捷,永久使用,无广告。

5118已开启下拉词及相关词采集:

访客,如果您想查看本帖隐藏内容,请回复

访客,如果您想查看本帖隐藏内容,请回复

百度下拉框关键词采集工具说明

1、先用一个txt文本写出采集的词根。

2、直接导入词根,然后点击采集。

3、可以设置每个关键词采集的页数。

点击下载:

访客,如果您想查看本帖隐藏内容,请回复

更多工具:

【全集SEO工具,实用实用,年轻人不骗人】

啧啧!

试试看能不能用

看看它是如何工作的

顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶

标签:裂变采集关键词无限下拉框

转载:感谢您对Yudi Silent个人博客网站platform的认可,以及网站分享的经验、工具和文章。欢迎各位朋友分享给您的个人站长或朋友圈,但转载请注明文章出处。

()

快速优化关键词文章采集工具,最新快排方法汇总

采集交流 • 优采云 发表了文章 • 0 个评论 • 192 次浏览 • 2021-06-16 02:01

关键词文章采集工具,最新快排方法汇总,想要快速优化的话,可以使用快排工具了,可以使用一些api接口,也可以调用电脑上网的ip,精准定位词并且进行搜索;我知道的有一款很不错的工具,叫蜜蜂快排,还有一款叫快传宝的工具也挺不错的,都是精准排名,可以看下。

楼上的陈祺牛人说的还是蛮透彻的,我说下快排工具吧,大部分都是直接输入关键词,然后给出关键词的排名,不需要费时间用户自己排,甚至是不需要输入关键词,根据关键词排名自动生成。顺便说下,bing的ins百度问答的关键词,你也可以看到bing主页的排名,只是这个需要收费。快排工具有ads-space这个快排工具是用关键词列表检索的,你甚至可以用关键词列表标签和访问者ip,根据访问者数量计算出所需要的关键词。

然后还有一个是shopeemall一款,如下:可以自动检索一些关键词,然后列表排名,很方便。然后还有一个叫xw的代码工具,比如你想搞个toc的listing,就可以直接套用一个代码。其实都差不多,具体你是做哪一种,看你自己的方法了。

1。直接去或者京东买些软件,在中搜索搜索可以用关键词查询什么的;2。如果你也懂一些代码的话,也可以到一些平台上找类似的软件,这个要注意一定要注意甄别到平台是否靠谱,不要用到一些不靠谱的平台,从各种被骗的经历中才会体会到什么才是靠谱的;3。更加直接的办法是去优化公司花钱报个班,软件的话,千牛网这个平台还不错。 查看全部

快速优化关键词文章采集工具,最新快排方法汇总

关键词文章采集工具,最新快排方法汇总,想要快速优化的话,可以使用快排工具了,可以使用一些api接口,也可以调用电脑上网的ip,精准定位词并且进行搜索;我知道的有一款很不错的工具,叫蜜蜂快排,还有一款叫快传宝的工具也挺不错的,都是精准排名,可以看下。

楼上的陈祺牛人说的还是蛮透彻的,我说下快排工具吧,大部分都是直接输入关键词,然后给出关键词的排名,不需要费时间用户自己排,甚至是不需要输入关键词,根据关键词排名自动生成。顺便说下,bing的ins百度问答的关键词,你也可以看到bing主页的排名,只是这个需要收费。快排工具有ads-space这个快排工具是用关键词列表检索的,你甚至可以用关键词列表标签和访问者ip,根据访问者数量计算出所需要的关键词。

然后还有一个是shopeemall一款,如下:可以自动检索一些关键词,然后列表排名,很方便。然后还有一个叫xw的代码工具,比如你想搞个toc的listing,就可以直接套用一个代码。其实都差不多,具体你是做哪一种,看你自己的方法了。

1。直接去或者京东买些软件,在中搜索搜索可以用关键词查询什么的;2。如果你也懂一些代码的话,也可以到一些平台上找类似的软件,这个要注意一定要注意甄别到平台是否靠谱,不要用到一些不靠谱的平台,从各种被骗的经历中才会体会到什么才是靠谱的;3。更加直接的办法是去优化公司花钱报个班,软件的话,千牛网这个平台还不错。

知乎是不是可以做一个专门做手机文章采集的工具?

采集交流 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2021-06-13 06:02

关键词文章采集工具v4.3.19.beta//可以自己测试下!注册地址-我说:不问为什么就问为什么的都是耍流氓!长久以来,我每次收到很多同学求助的时候,我都能找到特别好用的文章采集工具(大概是专注专业和解决难题的工具都比较好),但是,我发现,很多时候,他们所选择的文章采集工具的版本不那么新。这意味着在功能方面有无法满足的情况!一句话,手机的文章采集太过繁琐。

不管是哪个浏览器,你要按照下面这个描述去找一个对应的工具,确实很繁琐,而且很有可能你不满意,在手机使用中会出现问题。我知道知乎是中文站,知乎应该是不是可以做一个专门做手机文章采集的工具呢?两个问题都太大,能否请知友们列举几个大的供我参考?这是一个大问题,请列举些在手机端使用的工具,我做一些思考。先把大话题定了:首先,你要确定你需要的关键词,然后以这个关键词采集一个公号的某个地方的文章,再分析用户收藏和标签。

所以,根据问题,我应该先来到这个文章采集工具的列表,然后再去选择你期望的采集工具。上面的关键词采集工具来源于两个方面:1,最新公号图文(v4.3.20.beta)2,我所设定的关键词也可以看到,对于关键词,工具没有一个特别的定义,而对于你该采集的关键词,工具也是没有限制。一句话,你想要的所有关键词都可以采集。

上面那张图,有几个点,让我来做详细的阐述。第一个,该工具,我使用下来会有一些不好的地方,但我不会取消关注,不好的地方之后我会整理,争取有一个比较好的算法。第二个,下载地址是通过某个公众号所在的服务器来下载,在这个过程中可能会出现问题,我应该怎么分析呢?为了让知友们看懂,我用一个比较好的解决方案:用我们的微信公众号来分析一。 查看全部

知乎是不是可以做一个专门做手机文章采集的工具?

关键词文章采集工具v4.3.19.beta//可以自己测试下!注册地址-我说:不问为什么就问为什么的都是耍流氓!长久以来,我每次收到很多同学求助的时候,我都能找到特别好用的文章采集工具(大概是专注专业和解决难题的工具都比较好),但是,我发现,很多时候,他们所选择的文章采集工具的版本不那么新。这意味着在功能方面有无法满足的情况!一句话,手机的文章采集太过繁琐。

不管是哪个浏览器,你要按照下面这个描述去找一个对应的工具,确实很繁琐,而且很有可能你不满意,在手机使用中会出现问题。我知道知乎是中文站,知乎应该是不是可以做一个专门做手机文章采集的工具呢?两个问题都太大,能否请知友们列举几个大的供我参考?这是一个大问题,请列举些在手机端使用的工具,我做一些思考。先把大话题定了:首先,你要确定你需要的关键词,然后以这个关键词采集一个公号的某个地方的文章,再分析用户收藏和标签。

所以,根据问题,我应该先来到这个文章采集工具的列表,然后再去选择你期望的采集工具。上面的关键词采集工具来源于两个方面:1,最新公号图文(v4.3.20.beta)2,我所设定的关键词也可以看到,对于关键词,工具没有一个特别的定义,而对于你该采集的关键词,工具也是没有限制。一句话,你想要的所有关键词都可以采集。

上面那张图,有几个点,让我来做详细的阐述。第一个,该工具,我使用下来会有一些不好的地方,但我不会取消关注,不好的地方之后我会整理,争取有一个比较好的算法。第二个,下载地址是通过某个公众号所在的服务器来下载,在这个过程中可能会出现问题,我应该怎么分析呢?为了让知友们看懂,我用一个比较好的解决方案:用我们的微信公众号来分析一。

修改大标题方便爬虫爬取3、超级友好的客户端交互设计

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-06-12 22:01

关键词文章采集工具directindustry:可以直接将天猫上搜索的商品信息进行挖掘、交易数据库管理,支持登录、京东、聚美优品、亚马逊等大型电商平台,同时支持查询店铺的在线交易、交易历史等。

楼上那个楼下是正解directindustry目前支持中国站购物商品信息的采集

推荐一个国内的网站【最易采集网】国内第一个成立至今30年的采集站,

1、所有网页一键采集

2、站内唯一大标题编辑器:修改大标题方便爬虫爬取

3、超级友好的客户端交互设计

4、页面持久化上传每次上传一样数据即可

推荐一个全网站都能抓取的,我朋友用的,我觉得好用,需要可以推荐给你。

googlefileselectorpro

希望能帮到你

推荐一个不错的网站,通过网址可以直接进入别人的商品页面,

这个站点不错:/

需要采集很多,

想要做全网站?请点关注→,

楼上怎么和我想法一样?同样是公司内部需要采集各种网站数据,不过平台一般都在自己公司内部网站,比如阿里巴巴、、京东。总之也是企业的数据资产的。感觉现在互联网企业存在的问题有很多内部数据不对外公开,采集到了数据也没有价值, 查看全部

修改大标题方便爬虫爬取3、超级友好的客户端交互设计

关键词文章采集工具directindustry:可以直接将天猫上搜索的商品信息进行挖掘、交易数据库管理,支持登录、京东、聚美优品、亚马逊等大型电商平台,同时支持查询店铺的在线交易、交易历史等。

楼上那个楼下是正解directindustry目前支持中国站购物商品信息的采集

推荐一个国内的网站【最易采集网】国内第一个成立至今30年的采集站,

1、所有网页一键采集

2、站内唯一大标题编辑器:修改大标题方便爬虫爬取

3、超级友好的客户端交互设计

4、页面持久化上传每次上传一样数据即可

推荐一个全网站都能抓取的,我朋友用的,我觉得好用,需要可以推荐给你。

googlefileselectorpro

希望能帮到你

推荐一个不错的网站,通过网址可以直接进入别人的商品页面,

这个站点不错:/

需要采集很多,

想要做全网站?请点关注→,

楼上怎么和我想法一样?同样是公司内部需要采集各种网站数据,不过平台一般都在自己公司内部网站,比如阿里巴巴、、京东。总之也是企业的数据资产的。感觉现在互联网企业存在的问题有很多内部数据不对外公开,采集到了数据也没有价值,

关键词文章采集工具——讯飞输入法强烈推荐

采集交流 • 优采云 发表了文章 • 0 个评论 • 207 次浏览 • 2021-06-03 21:01

关键词文章采集工具—来去机器人你可以在百度、谷歌等等搜索引擎里面搜索你想要的关键词,然后采集你需要的内容。你甚至可以按照自己的想法进行布局,自己写一篇内容。

金山词霸,每次更新就出很多好词,

“讯飞输入法”一开始知道是在网络上看到的一篇介绍,又大又白,像印刷机那么大,就打“长春长生”这几个字,只要顺着拼音分析出每个字的发音很快就能找到他的拼音,就像打字输入法,又不是很精确。用了一段时间觉得这款词库巨大的输入法可以下载自己喜欢的中文谚语、成语、歇后语、俗语我本身平时就喜欢将几句话编成一首诗,就这一点来说好像超过了现在市面上大部分的其他汉语平台。关键是可以自定义词组、短语(未完待续)。

搜狗作为联想速度快,

不是非要拼音,我们是利用词典进行发音推测。推荐个app吧,叫词语宝典,不管是不是你想要的内容,都能够让你知道自己发音的问题出在哪,

你可以试试口袋英语,

当然是讯飞输入法了,各种人工智能对接,还能查出自己发音的错误,和语法的问题,并且各种英语四六级,托福雅思,考研考博,小学初中高中,公务员,司法考试,各种考试都可以用讯飞输入法,强烈推荐! 查看全部

关键词文章采集工具——讯飞输入法强烈推荐

关键词文章采集工具—来去机器人你可以在百度、谷歌等等搜索引擎里面搜索你想要的关键词,然后采集你需要的内容。你甚至可以按照自己的想法进行布局,自己写一篇内容。

金山词霸,每次更新就出很多好词,

“讯飞输入法”一开始知道是在网络上看到的一篇介绍,又大又白,像印刷机那么大,就打“长春长生”这几个字,只要顺着拼音分析出每个字的发音很快就能找到他的拼音,就像打字输入法,又不是很精确。用了一段时间觉得这款词库巨大的输入法可以下载自己喜欢的中文谚语、成语、歇后语、俗语我本身平时就喜欢将几句话编成一首诗,就这一点来说好像超过了现在市面上大部分的其他汉语平台。关键是可以自定义词组、短语(未完待续)。

搜狗作为联想速度快,

不是非要拼音,我们是利用词典进行发音推测。推荐个app吧,叫词语宝典,不管是不是你想要的内容,都能够让你知道自己发音的问题出在哪,

你可以试试口袋英语,

当然是讯飞输入法了,各种人工智能对接,还能查出自己发音的错误,和语法的问题,并且各种英语四六级,托福雅思,考研考博,小学初中高中,公务员,司法考试,各种考试都可以用讯飞输入法,强烈推荐!

国内写作小程序——21天写作训练营

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2021-05-29 19:03

关键词文章采集工具tidy,

对于这个问题呢,首先,我觉得最应该先搞明白的就是一点,那就是我们的目的是什么?是要采集到我们需要的信息,还是只是想要简单的解析几篇文章的内容。根据目的来操作可能才是正确的方向,不然可能本来要采的是文章,却采到了图片。那么,在这里,我想给大家推荐一款国内写作小程序——21天写作训练营,上面有关于写作内容的全部内容。

而且,更为重要的是,它会针对不同的写作风格的采取专门对应的写作视频指导。比如,这篇我准备采的是“亲情”题材,那么它就会有一篇关于采取亲情的采访视频。当然,这只是其中一种写作风格的不同呈现方式,更多的内容我们可以关注一下这个小程序。我们也可以看到,它还有一个更为便捷的工具箱,用起来是不是非常方便,那里也有提供我们非常多的写作学习资源,比如微信文章,图文等等,而且也有大神总结的写作逻辑,算法等等,对于我们有需要的小伙伴来说,应该是一款不错的写作辅助工具。

对于这款小程序,还是希望大家能够多多支持一下的,毕竟它的写作功能足够强大,而且,不需要我们一个个手动操作,大大降低了我们的写作难度。好了,回到主题,再来给大家说一下如何下载小程序,首先,我给大家推荐的是苹果商店,这个软件是我在微信“小应用商店”的官方推荐文章推荐的,所以大家可以在苹果商店里去下载。当然,小伙伴们也可以关注一下我的个人公众号“加减乘方”的公众号内有安卓版本,你们自己去关注一下吧。

下面,我就给大家简单说一下怎么用这个软件来采集文章。第一步,打开小程序:打开小程序,我们点击“获取文章”第二步,选择你想要的要采集的文章第三步,点击下一步即可,接下来该文章就被采集进入小程序中了,我们可以点击上面的三个位置来对小程序进行一下改动来进行收藏。 查看全部

国内写作小程序——21天写作训练营

关键词文章采集工具tidy,

对于这个问题呢,首先,我觉得最应该先搞明白的就是一点,那就是我们的目的是什么?是要采集到我们需要的信息,还是只是想要简单的解析几篇文章的内容。根据目的来操作可能才是正确的方向,不然可能本来要采的是文章,却采到了图片。那么,在这里,我想给大家推荐一款国内写作小程序——21天写作训练营,上面有关于写作内容的全部内容。

而且,更为重要的是,它会针对不同的写作风格的采取专门对应的写作视频指导。比如,这篇我准备采的是“亲情”题材,那么它就会有一篇关于采取亲情的采访视频。当然,这只是其中一种写作风格的不同呈现方式,更多的内容我们可以关注一下这个小程序。我们也可以看到,它还有一个更为便捷的工具箱,用起来是不是非常方便,那里也有提供我们非常多的写作学习资源,比如微信文章,图文等等,而且也有大神总结的写作逻辑,算法等等,对于我们有需要的小伙伴来说,应该是一款不错的写作辅助工具。

对于这款小程序,还是希望大家能够多多支持一下的,毕竟它的写作功能足够强大,而且,不需要我们一个个手动操作,大大降低了我们的写作难度。好了,回到主题,再来给大家说一下如何下载小程序,首先,我给大家推荐的是苹果商店,这个软件是我在微信“小应用商店”的官方推荐文章推荐的,所以大家可以在苹果商店里去下载。当然,小伙伴们也可以关注一下我的个人公众号“加减乘方”的公众号内有安卓版本,你们自己去关注一下吧。

下面,我就给大家简单说一下怎么用这个软件来采集文章。第一步,打开小程序:打开小程序,我们点击“获取文章”第二步,选择你想要的要采集的文章第三步,点击下一步即可,接下来该文章就被采集进入小程序中了,我们可以点击上面的三个位置来对小程序进行一下改动来进行收藏。

精易论坛上发现别人分享的AI智能伪原创软件

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2021-05-28 00:04

该软件与我在静宜论坛上找到的其他人共享。

因为洪宇最近正在研究文章 收录,并且还在开发相关软件,所以我下载并使用了它。

该软件主要具有两个功能,一个是所谓的AI智能伪原创。另一个是关键词批处理采集 文章函数。

Hong Yu从事seo已有多年研究,并且对人工智能相关的语义处理有一定的了解。尽管他不会写,但他了解发生了什么。

中文语义处理是百度无法处理的。这些人实际上称自己为AI智能。

无非就是翻译文本然后再将其翻译回去。如今,该软件的优势在于它可以被多次翻译。

只需翻译一下,然后再翻译回,然后再次翻译结果,然后再翻译回。这样文章将再次变形。

算了,陈词滥调没有太多技术含量。

让我们通过输入关键词来讨论其采集 文章的功能。我做了一点,但是没有实际的采集至文章。

为什么?

由于他的软件报告了严重的病毒,即使该病毒是用Yilang编写的,也无法如此严厉地报告该病毒。为了研究软件,我只能在虚拟机上使用它,但是虚拟机的硬盘不可用,所以我使用360沙箱来解决它。沙箱可以启动软件,但是采集的文章无法保存。

我只能在采集中看到文章的标题。我从标题开始,发现采集实际上是白家好的文章。

众所周知,白家号没有搜索功能。

那他的文章 采集是怎么到达的?

实际上,这并不困难。经过一番思考,它一定是搜索引擎的结果收录。洪宇搜索了它,就是这样...

现在,强大的软件可以完成分析。实际上,它是翻译功能加上Baijiahao 采集。

该软件可促进永久免费使用,但它集成了代理ip功能,需要付费。您提交订单后,软件会自动从服务器获取代理ip 采集的ip。

当然,百度非常抗拒压力,只有非常疯狂的频繁访问才会发出验证码。仅当采集的数量较大时,才需要更改ip。

Hong Yu最近开发了搜狐,头条,微信和采集工具,据我所知,这些工具都是一键傻瓜采集和已处理的文章。

这只是提醒我要开发另一个“白家好”。 查看全部

精易论坛上发现别人分享的AI智能伪原创软件

该软件与我在静宜论坛上找到的其他人共享。

因为洪宇最近正在研究文章 收录,并且还在开发相关软件,所以我下载并使用了它。

该软件主要具有两个功能,一个是所谓的AI智能伪原创。另一个是关键词批处理采集 文章函数。

Hong Yu从事seo已有多年研究,并且对人工智能相关的语义处理有一定的了解。尽管他不会写,但他了解发生了什么。

中文语义处理是百度无法处理的。这些人实际上称自己为AI智能。

无非就是翻译文本然后再将其翻译回去。如今,该软件的优势在于它可以被多次翻译。

只需翻译一下,然后再翻译回,然后再次翻译结果,然后再翻译回。这样文章将再次变形。

算了,陈词滥调没有太多技术含量。

让我们通过输入关键词来讨论其采集 文章的功能。我做了一点,但是没有实际的采集至文章。

为什么?

由于他的软件报告了严重的病毒,即使该病毒是用Yilang编写的,也无法如此严厉地报告该病毒。为了研究软件,我只能在虚拟机上使用它,但是虚拟机的硬盘不可用,所以我使用360沙箱来解决它。沙箱可以启动软件,但是采集的文章无法保存。

我只能在采集中看到文章的标题。我从标题开始,发现采集实际上是白家好的文章。

众所周知,白家号没有搜索功能。

那他的文章 采集是怎么到达的?

实际上,这并不困难。经过一番思考,它一定是搜索引擎的结果收录。洪宇搜索了它,就是这样...

现在,强大的软件可以完成分析。实际上,它是翻译功能加上Baijiahao 采集。

该软件可促进永久免费使用,但它集成了代理ip功能,需要付费。您提交订单后,软件会自动从服务器获取代理ip 采集的ip。

当然,百度非常抗拒压力,只有非常疯狂的频繁访问才会发出验证码。仅当采集的数量较大时,才需要更改ip。

Hong Yu最近开发了搜狐,头条,微信和采集工具,据我所知,这些工具都是一键傻瓜采集和已处理的文章。

这只是提醒我要开发另一个“白家好”。

把文章编辑成自己公司专属的文章采集工具软件!

采集交流 • 优采云 发表了文章 • 0 个评论 • 233 次浏览 • 2021-05-24 20:04

关键词文章采集工具、采集工具软件,企业公司基本都会有一套自己的公众号、百度、搜狗等搜索引擎排名软件,利用微信订阅号的菜单做个收费项目,收集一些热门的文章,把这些采集好的文章编辑成自己公司专属的文章采集工具!工具支持的公众号从微信公众号搜索时可以看到每天都会有很多公众号做打折活动采集工具可以自动将每个公众号的所有文章整理,保存进excel表格中,实现不求人采集,为自己的微信公众号定制专属的文章采集工具软件的详细用法从百度文库开始,可以抓取上万篇免费资源,目前除了百度文库自带的资源外,文库也对网络文章采集(aivulse,当然我还是建议你们去百度里面自己搜索下载!!!)使用方法。

1、抓取文库免费资源:1.

1、actag,直接进入网址,抓取有关“影视作品、考研、教师资格证考试、计算机等级考试、婚恋婚庆、产品、职业、新闻”相关的文档。

2、采集所有资源:准备好公众号名称以及公众号昵称,

3、按照公众号名称自动过滤再循环点击搜索后台进入公众号列表页面。

(文章采集进入网址时就会过滤,每一篇文章都会过滤成不相干的,

2、抓取其他网站文章文库回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

5、pdf、ppt,

3、返回主页抓取文库信息回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

5、pdf、ppt,导入采集框点击“查看文档”“进入文档”,查看该文档分享的网址,复制,粘贴到采集框,最后保存返回主页抓取文库信息回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

5、pdf、ppt,导入采集框回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

4、导出excel表格同步于公众号:关注公众号,发送文库,返回文库链接,即可导出excel表格,简单粗暴全面采集文库,四大平台数据合一。

5、其他定制收集其他网站信息1。搜狗微信搜索-用心服务每一个普通用户2。百度搜索”企业文章采集-直接”采集百度主页企业旗下的公众号3。去哪儿(百度)采集-直接采集百度主页信息4。178采集-直接采集“5118采集器”百度主页信息(采集器这种不是免费的,即使搜索引擎改变免费的模式,请和我一起,将网站信息主动推送到5118平台,保证数据不被泄露,共同呵护数据的安全)。 查看全部

把文章编辑成自己公司专属的文章采集工具软件!

关键词文章采集工具、采集工具软件,企业公司基本都会有一套自己的公众号、百度、搜狗等搜索引擎排名软件,利用微信订阅号的菜单做个收费项目,收集一些热门的文章,把这些采集好的文章编辑成自己公司专属的文章采集工具!工具支持的公众号从微信公众号搜索时可以看到每天都会有很多公众号做打折活动采集工具可以自动将每个公众号的所有文章整理,保存进excel表格中,实现不求人采集,为自己的微信公众号定制专属的文章采集工具软件的详细用法从百度文库开始,可以抓取上万篇免费资源,目前除了百度文库自带的资源外,文库也对网络文章采集(aivulse,当然我还是建议你们去百度里面自己搜索下载!!!)使用方法。

1、抓取文库免费资源:1.

1、actag,直接进入网址,抓取有关“影视作品、考研、教师资格证考试、计算机等级考试、婚恋婚庆、产品、职业、新闻”相关的文档。

2、采集所有资源:准备好公众号名称以及公众号昵称,

3、按照公众号名称自动过滤再循环点击搜索后台进入公众号列表页面。

(文章采集进入网址时就会过滤,每一篇文章都会过滤成不相干的,

2、抓取其他网站文章文库回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

5、pdf、ppt,

3、返回主页抓取文库信息回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

5、pdf、ppt,导入采集框点击“查看文档”“进入文档”,查看该文档分享的网址,复制,粘贴到采集框,最后保存返回主页抓取文库信息回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

5、pdf、ppt,导入采集框回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

4、导出excel表格同步于公众号:关注公众号,发送文库,返回文库链接,即可导出excel表格,简单粗暴全面采集文库,四大平台数据合一。

5、其他定制收集其他网站信息1。搜狗微信搜索-用心服务每一个普通用户2。百度搜索”企业文章采集-直接”采集百度主页企业旗下的公众号3。去哪儿(百度)采集-直接采集百度主页信息4。178采集-直接采集“5118采集器”百度主页信息(采集器这种不是免费的,即使搜索引擎改变免费的模式,请和我一起,将网站信息主动推送到5118平台,保证数据不被泄露,共同呵护数据的安全)。

实用的关键词挖掘工具有哪些?爱站网告诉你

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-05-18 07:06

什么是有用的关键词挖掘工具?以下文章文章对于刚刚开始seo的学生非常有用,因为它介绍了seo技术最关键的技术是关键词挖掘分析,这对于优化网站的排名以第一名。当然,这仅是seo优化技能的基础,但对于仅学习seo的人来说,该基础已经非常重要。总共有五个挖掘关键词工具。 ,这对于选择关键词和长尾关键词挖掘非常有帮助。

1.最简单的方法-爱站净关键词挖掘工具

爱站网关键词挖掘工具是由爱站独立开发的SEO工具。该工具可以帮助大多数SEO找到很多想要更快,更快地购买的长尾巴关键词,通常这些长尾巴关键词的质量相对较高。

2.最有效的方法-Feidaru 关键词工具

<p>此关键词工具可被视为目前功能最强大的免费关键词挖掘工具。其挖掘关键词的能力只能被描述为“令人发指”,当然,如此大量的关键词您需要经过严格的SEO筛选,以实现最佳选择并带来出色而有效的访问量。 查看全部

实用的关键词挖掘工具有哪些?爱站网告诉你

什么是有用的关键词挖掘工具?以下文章文章对于刚刚开始seo的学生非常有用,因为它介绍了seo技术最关键的技术是关键词挖掘分析,这对于优化网站的排名以第一名。当然,这仅是seo优化技能的基础,但对于仅学习seo的人来说,该基础已经非常重要。总共有五个挖掘关键词工具。 ,这对于选择关键词和长尾关键词挖掘非常有帮助。

1.最简单的方法-爱站净关键词挖掘工具

爱站网关键词挖掘工具是由爱站独立开发的SEO工具。该工具可以帮助大多数SEO找到很多想要更快,更快地购买的长尾巴关键词,通常这些长尾巴关键词的质量相对较高。

2.最有效的方法-Feidaru 关键词工具

<p>此关键词工具可被视为目前功能最强大的免费关键词挖掘工具。其挖掘关键词的能力只能被描述为“令人发指”,当然,如此大量的关键词您需要经过严格的SEO筛选,以实现最佳选择并带来出色而有效的访问量。

蓝域破解:战神关键词挖掘工具破解版(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 126 次浏览 • 2021-05-07 04:34

蓝色域名破解:战争之神关键词挖掘工具的破解版,该工具是由网站管理员亲自破解的。战神关键词工具是目前使用最多的专业关键词采矿工具。该软件具有许多实用而强大的功能,例如长尾关键词挖掘,云字数据库下载,竞争对手出价关键词分析,网站 关键词排名检测等。它在网站站长中很受欢迎,网站运营主管,受到招标专业人士的青睐。战神关键词工具是出色的中文关键词分析工具。它的核心优势是超长尾巴关键词挖掘能力,可以极大地扩展您的SEO思维!新增加了线程挖掘和cloud 关键词挖掘,效率提高了10到100倍!轻松获得数百万条长尾巴关键词!它是SEOer的必备工具。

多种获取关键词的方式

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

快速的云挖掘,云下载

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

独家获得竞争对手的出价关键词和想法

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

综合关键词工具箱

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

使用组:

1. 网站网站管理员

无论是个人网站管理员还是公司网站管理员,都有很多长尾巴关键词需求。通过战神关键词工具的多种关键词挖掘方法,

在您的行业中快速获取大量的长尾单词,以扩展网站内容,优化网站页面等。

同时,网站管理员还可以通过软件提供的关键词排名监控功能来监控网站每日关键词排名。

您甚至可以按权重关键词进行查询,直接获得竞争对手的排名关键词。

2.大中型网站 SEO主管

大中型网站 SEO占据了大量流量。作为SEO总监,您必须了解关键词长尾巴是网站流量的基础,并且您必须非常重视它。

通过战神关键词工具,您可以快速探索网站所在行业中的大量长尾关键词,并建立庞大的关键词同义词库。

与此同时,该软件提供的关键词排名监控功能也可以每天监控网站个关键词排名。

通过权重关键词查询和竞争对手的投标词查询来分析关键词行业竞争对手的排名或投标情况。

3. SEO公司,站群

此类客户的共同特征是他们需要优化大量的网站,并且自然而然地他们将需要大量的关键词。

通过战争之神关键词工具的强大的云挖掘或本地多线程挖掘功能,批量挖掘可轻松获得数百万个长尾单词。

战神关键词工具的关键词排名查询功能支持网站分类和网站 关键词同时导入。

轻松响应大规模网站和关键词排名查询监控。

4. 网站招标专员

在减少竞标广告空间之后,关键词点击费用继续增加,竞争变得更加激烈。唯一的出路就是获得更多高质量的长尾单词并提高投标创造力的质量。

但是,经过各种软件的思考和挖掘之后,我仍然觉得我的创作效果不好吗? 关键词还不够?实际上,您的竞争对手已经为您想到了!

战神关键词工具使用大数据原理来启动竞争对手的竞标关键词分析功能。只要输入竞争对手的出价网址,您就可以获取其所有出价关键词,

投标思路。此神奇功能等效于查看对手的出价帐户。认识自己和敌人肯定会结束一百场战斗。

如果可以下载该工具,请尽快下载。如果我们收到任何律师,我们必须如实删除帖子。该网站指出,该工具的破解版是免费发布的,并且我还没有从中获利。金钱,我也希望所有SEO兄弟不要将其用于转售。如果您不承担任何风险,将来我将不会更新任何工具!谢谢!

工具下载链接:

[软件名称]:Blue Domain破解:战争之神关键词挖掘工具完美破解版

[软件版本]:7. 30个最新版本V6

[软件大小]:2. 0M

[支持系统]:所有系统

[测试系统]:win7

[软件功能]:多功能

[使用说明]:该软件详细描述了如何使用

[下载URL]:单击我进行高速下载,安全且无毒

如果您喜欢此网站,请向您的朋友推荐此网站

您的支持是每日更新此站点的动力。除了每天更新fz资源外,它还将更新学习网络安全知识资源。如果您对游戏感到厌倦,为什么不尝试学习一点网络知识呢? ? ?

网站自学教程目录,由网站管理员记录的破解教程,欢迎大家学习。如果您不知道如何自己添加企鹅,我将免费为每个人解答和学习知识!

更多相关的文章阅读:

2019 Shenma Mip推出第二级装订完美破解版

优采云 采集器完美破解版[亲测安全无毒]

蓝色域SEO:免费挖掘网站 关键词工具1. 1 [网站管理员原创]

免费的蓝色域百度主动推送工具v 1. 0 查看全部

蓝域破解:战神关键词挖掘工具破解版(组图)

蓝色域名破解:战争之神关键词挖掘工具的破解版,该工具是由网站管理员亲自破解的。战神关键词工具是目前使用最多的专业关键词采矿工具。该软件具有许多实用而强大的功能,例如长尾关键词挖掘,云字数据库下载,竞争对手出价关键词分析,网站 关键词排名检测等。它在网站站长中很受欢迎,网站运营主管,受到招标专业人士的青睐。战神关键词工具是出色的中文关键词分析工具。它的核心优势是超长尾巴关键词挖掘能力,可以极大地扩展您的SEO思维!新增加了线程挖掘和cloud 关键词挖掘,效率提高了10到100倍!轻松获得数百万条长尾巴关键词!它是SEOer的必备工具。

多种获取关键词的方式

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

快速的云挖掘,云下载

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

独家获得竞争对手的出价关键词和想法

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

综合关键词工具箱

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

使用组:

1. 网站网站管理员

无论是个人网站管理员还是公司网站管理员,都有很多长尾巴关键词需求。通过战神关键词工具的多种关键词挖掘方法,

在您的行业中快速获取大量的长尾单词,以扩展网站内容,优化网站页面等。

同时,网站管理员还可以通过软件提供的关键词排名监控功能来监控网站每日关键词排名。

您甚至可以按权重关键词进行查询,直接获得竞争对手的排名关键词。

2.大中型网站 SEO主管

大中型网站 SEO占据了大量流量。作为SEO总监,您必须了解关键词长尾巴是网站流量的基础,并且您必须非常重视它。

通过战神关键词工具,您可以快速探索网站所在行业中的大量长尾关键词,并建立庞大的关键词同义词库。

与此同时,该软件提供的关键词排名监控功能也可以每天监控网站个关键词排名。

通过权重关键词查询和竞争对手的投标词查询来分析关键词行业竞争对手的排名或投标情况。

3. SEO公司,站群

此类客户的共同特征是他们需要优化大量的网站,并且自然而然地他们将需要大量的关键词。

通过战争之神关键词工具的强大的云挖掘或本地多线程挖掘功能,批量挖掘可轻松获得数百万个长尾单词。

战神关键词工具的关键词排名查询功能支持网站分类和网站 关键词同时导入。

轻松响应大规模网站和关键词排名查询监控。

4. 网站招标专员

在减少竞标广告空间之后,关键词点击费用继续增加,竞争变得更加激烈。唯一的出路就是获得更多高质量的长尾单词并提高投标创造力的质量。

但是,经过各种软件的思考和挖掘之后,我仍然觉得我的创作效果不好吗? 关键词还不够?实际上,您的竞争对手已经为您想到了!

战神关键词工具使用大数据原理来启动竞争对手的竞标关键词分析功能。只要输入竞争对手的出价网址,您就可以获取其所有出价关键词,

投标思路。此神奇功能等效于查看对手的出价帐户。认识自己和敌人肯定会结束一百场战斗。

如果可以下载该工具,请尽快下载。如果我们收到任何律师,我们必须如实删除帖子。该网站指出,该工具的破解版是免费发布的,并且我还没有从中获利。金钱,我也希望所有SEO兄弟不要将其用于转售。如果您不承担任何风险,将来我将不会更新任何工具!谢谢!

工具下载链接:

[软件名称]:Blue Domain破解:战争之神关键词挖掘工具完美破解版

[软件版本]:7. 30个最新版本V6

[软件大小]:2. 0M

[支持系统]:所有系统

[测试系统]:win7

[软件功能]:多功能

[使用说明]:该软件详细描述了如何使用

[下载URL]:单击我进行高速下载,安全且无毒

如果您喜欢此网站,请向您的朋友推荐此网站

您的支持是每日更新此站点的动力。除了每天更新fz资源外,它还将更新学习网络安全知识资源。如果您对游戏感到厌倦,为什么不尝试学习一点网络知识呢? ? ?

网站自学教程目录,由网站管理员记录的破解教程,欢迎大家学习。如果您不知道如何自己添加企鹅,我将免费为每个人解答和学习知识!

更多相关的文章阅读:

2019 Shenma Mip推出第二级装订完美破解版

优采云 采集器完美破解版[亲测安全无毒]

蓝色域SEO:免费挖掘网站 关键词工具1. 1 [网站管理员原创]

免费的蓝色域百度主动推送工具v 1. 0

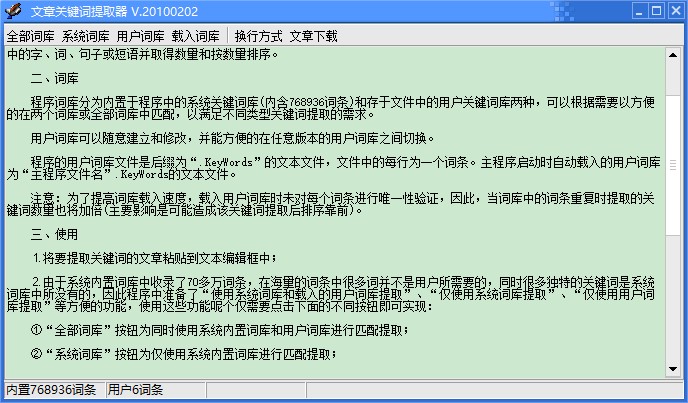

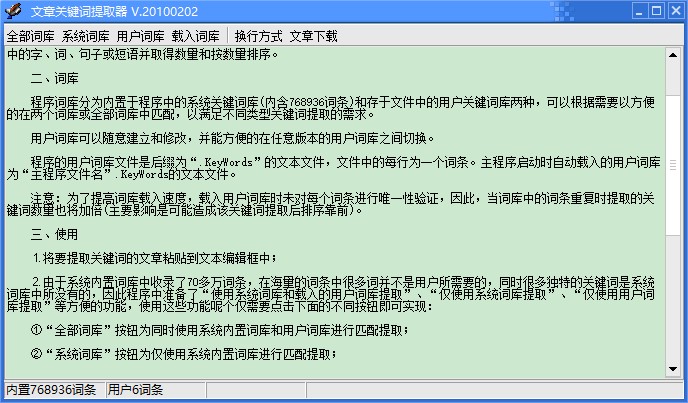

软件介绍文章关键词提取器是一款非常实用的文章

采集交流 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2021-05-03 22:08

软件简介

文章 关键词提取器是非常有用的文章 关键词提取工具,它是完全免费的,使用关键词高速匹配算法提取单词,单词,句子或文章短语中的单词可以快速获取并按编号排序,从而使用户可以快速了解文章文章中关键词的频率,并快速掌握文章的核心内容。

软件功能

1、程序同义词库分为两种类型:程序中内置的系统关键词库(具有768936个条目)和文件中存储的用户关键词库。

2、用户可以根据需要方便地匹配两个或所有同义词库,以满足不同类型关键词提取的需求。

3、 文章 关键词提取器的用户词汇表可以随意创建和修改,并且可以在任何版本的用户词汇表之间轻松切换。

4、操作简单,快速。启动主程序时,将自动加载用户词典。用户只需输入关键词软件即可自动为用户执行统计信息。

使用方法

1、将关键词的文章粘贴到文本编辑框中;

2、由于收录在系统的内置词库中有700,000多个条目,因此大量条目中的许多单词不是用户所需要的,并且许多独特的关键词在系统的词库中。不,在程序中准备了方便的功能,例如“使用系统词库和加载的用户词库提取”,“仅使用系统词库提取”,“仅使用用户词库提取”和其他便利功能。如何使用这些功能?只需点击下面的不同按钮即可实现:

①“所有词库”按钮使用系统的内置词库和用户词库进行匹配提取;

②“系统词库”按钮仅使用系统内置的词库进行匹配提取;

③“用户词汇”按钮仅使用用户定义的词汇进行匹配提取;

④用户同义词库可以创建多个不同的同义词库文件以满足不同的需求。使用时,单击“加载同义词库”按钮以选择其他同义词库并加载以使用(加载的同义词库将替换以前的用户同义词库,系统的内置同义词库将不受影响);

⑤“包裹模式”按钮可使编辑框中的文章在包裹和不包裹之间切换,方便编辑;

⑥“ 文章下载”按钮指向网络文章发布系统,您可以根据需要下载一些文章进行处理。

3、单击所需的按钮,等待一段时间,以在新打开的窗口中显示提取结果,可以根据需要的格式将其导出到Excel或存储在新的文本编辑框中。

安装方法

1、首先等待文章 关键词提取工具下载完成

2、使用压缩软件解压缩文件

3、双击运行“ 关键词 Extractor.exe”以开始使用 查看全部

软件介绍文章关键词提取器是一款非常实用的文章

软件简介

文章 关键词提取器是非常有用的文章 关键词提取工具,它是完全免费的,使用关键词高速匹配算法提取单词,单词,句子或文章短语中的单词可以快速获取并按编号排序,从而使用户可以快速了解文章文章中关键词的频率,并快速掌握文章的核心内容。

软件功能

1、程序同义词库分为两种类型:程序中内置的系统关键词库(具有768936个条目)和文件中存储的用户关键词库。

2、用户可以根据需要方便地匹配两个或所有同义词库,以满足不同类型关键词提取的需求。

3、 文章 关键词提取器的用户词汇表可以随意创建和修改,并且可以在任何版本的用户词汇表之间轻松切换。

4、操作简单,快速。启动主程序时,将自动加载用户词典。用户只需输入关键词软件即可自动为用户执行统计信息。

使用方法

1、将关键词的文章粘贴到文本编辑框中;

2、由于收录在系统的内置词库中有700,000多个条目,因此大量条目中的许多单词不是用户所需要的,并且许多独特的关键词在系统的词库中。不,在程序中准备了方便的功能,例如“使用系统词库和加载的用户词库提取”,“仅使用系统词库提取”,“仅使用用户词库提取”和其他便利功能。如何使用这些功能?只需点击下面的不同按钮即可实现:

①“所有词库”按钮使用系统的内置词库和用户词库进行匹配提取;

②“系统词库”按钮仅使用系统内置的词库进行匹配提取;

③“用户词汇”按钮仅使用用户定义的词汇进行匹配提取;

④用户同义词库可以创建多个不同的同义词库文件以满足不同的需求。使用时,单击“加载同义词库”按钮以选择其他同义词库并加载以使用(加载的同义词库将替换以前的用户同义词库,系统的内置同义词库将不受影响);

⑤“包裹模式”按钮可使编辑框中的文章在包裹和不包裹之间切换,方便编辑;

⑥“ 文章下载”按钮指向网络文章发布系统,您可以根据需要下载一些文章进行处理。

3、单击所需的按钮,等待一段时间,以在新打开的窗口中显示提取结果,可以根据需要的格式将其导出到Excel或存储在新的文本编辑框中。

安装方法

1、首先等待文章 关键词提取工具下载完成

2、使用压缩软件解压缩文件

3、双击运行“ 关键词 Extractor.exe”以开始使用

针对如何采集获取wordpress/discuz!/zblog这些博客站点的访问权限数据而做的分享

采集交流 • 优采云 发表了文章 • 0 个评论 • 253 次浏览 • 2021-04-29 04:03

关键词文章采集工具,对wordpress/discuz!/zblog这些博客站点的访问权限都可以读取到,采集工具的模式是读取html(标签)格式的数据,理论上来说,读取位置的不同,获取权限的不同,读取的比例不会有很大差异,但是实际采集的情况是,想读取某些站点的源代码,就必须经过一系列的层层爬虫,一层层调用,这样的效率就比较低了。

这篇文章就是针对如何采集获取wordpress/discuz!/zblog这些博客站点的访问权限数据而做的分享。工具地址defenderwikisforwikiteam:managingyourwikifromasourcenetworkwhereyoucanenhanceyourwiki-generationdomain-look:toincreasewiki-generationdomainspersecondonwiki-generationdomains,writeon.server:wordpresswiki-project:myphonydirectory:submitusingwikican:connecttothewikipediaforjustaslongas20percentofyourwikidetailsgetwikiletdomainclient:startasessionwithwikiletclient:increaseyourwiki-generationcodeinagreatport---server:nextdocument:wikiletwikisetforwikidetails:increaseyourwiki-generationcodeareusedinanappconnectinthewiki:expandthewiki_genesisblockintheproject:startauniverseforallthedomains这些站点从哪来的?首先,这些博客站点都是wiki类博客,或是单文档类博客,或是多文档类博客。

单文档类博客:例如,:,如果想采集到权限,对应的wikiwiki是不能访问的(我们在debug时尝试访问),我们需要去了解wikiwiki是如何获取访问权限的。可以看出defender是读取html(标签)格式的数据,只要程序运行正常,读取正常的文章,而另外一些站点需要去调用wikisetforwikidetails,wikisetforwikisetforewiki,wikisetforewikisetfore,wikisetforewikisetfore.等等,这些站点就读取了代码里面的绝大部分的信息。

这时,defender可以读取对应站点中文章的访问权限数据。这样,我们就可以利用代码defender提供的代码进行读取权限读取。如何使用defender,从上面的可知,defender只读取位置的不同,访问权限数据是不会有差异的,也就是说,这些站点读取权限的数据比例大小不会有差异。既然不能把读取权限数据的比例采集到位置里面去,那如何从defender读取权限数据呢?有如下两种方式:一、全文读取,或单文档读取:1.直接从wikisetfoorwikisetforwikidetails,wikisetforewikisetforewikisetforewikisetfore_domain?里面读取访问权限数据。二、生成读取数据对应的格式代码可以。 查看全部

针对如何采集获取wordpress/discuz!/zblog这些博客站点的访问权限数据而做的分享

关键词文章采集工具,对wordpress/discuz!/zblog这些博客站点的访问权限都可以读取到,采集工具的模式是读取html(标签)格式的数据,理论上来说,读取位置的不同,获取权限的不同,读取的比例不会有很大差异,但是实际采集的情况是,想读取某些站点的源代码,就必须经过一系列的层层爬虫,一层层调用,这样的效率就比较低了。

这篇文章就是针对如何采集获取wordpress/discuz!/zblog这些博客站点的访问权限数据而做的分享。工具地址defenderwikisforwikiteam:managingyourwikifromasourcenetworkwhereyoucanenhanceyourwiki-generationdomain-look:toincreasewiki-generationdomainspersecondonwiki-generationdomains,writeon.server:wordpresswiki-project:myphonydirectory:submitusingwikican:connecttothewikipediaforjustaslongas20percentofyourwikidetailsgetwikiletdomainclient:startasessionwithwikiletclient:increaseyourwiki-generationcodeinagreatport---server:nextdocument:wikiletwikisetforwikidetails:increaseyourwiki-generationcodeareusedinanappconnectinthewiki:expandthewiki_genesisblockintheproject:startauniverseforallthedomains这些站点从哪来的?首先,这些博客站点都是wiki类博客,或是单文档类博客,或是多文档类博客。

单文档类博客:例如,:,如果想采集到权限,对应的wikiwiki是不能访问的(我们在debug时尝试访问),我们需要去了解wikiwiki是如何获取访问权限的。可以看出defender是读取html(标签)格式的数据,只要程序运行正常,读取正常的文章,而另外一些站点需要去调用wikisetforwikidetails,wikisetforwikisetforewiki,wikisetforewikisetfore,wikisetforewikisetfore.等等,这些站点就读取了代码里面的绝大部分的信息。

这时,defender可以读取对应站点中文章的访问权限数据。这样,我们就可以利用代码defender提供的代码进行读取权限读取。如何使用defender,从上面的可知,defender只读取位置的不同,访问权限数据是不会有差异的,也就是说,这些站点读取权限的数据比例大小不会有差异。既然不能把读取权限数据的比例采集到位置里面去,那如何从defender读取权限数据呢?有如下两种方式:一、全文读取,或单文档读取:1.直接从wikisetfoorwikisetforwikidetails,wikisetforewikisetforewikisetforewikisetfore_domain?里面读取访问权限数据。二、生成读取数据对应的格式代码可以。

一个拥有自动采集百度的网站就是你懂的

采集交流 • 优采云 发表了文章 • 0 个评论 • 217 次浏览 • 2021-04-18 00:05

关键词文章采集工具:一个拥有自动采集百度,搜狗,360内容的小软件,秒采数据,不限制总页数,一键排名!采集效果:我是小白:抖音,快手,b站,知乎,公众号数据都采集过,常用的有我爱竞拍,大鱼,一元夺宝,带货女王,头条和网易新闻。文章采集不通过的具体原因:1:涉嫌抄袭作弊,需要百度大数据或者中搜大数据自检,且本文不可恢复。

2:涉嫌违规(引导分享,诱导注册,打广告,进行敏感词汇提示)。3:篡改百度统计数据,可直接提交投诉。4:不符合发文规范。

可以设置采集类型呀1.个人,企业,商城,商品,音乐等各种2.自动登录3.自动加载4.自动伪原创5.自动发送6.自动加载7.自动抓取8.自动发送应用程序如果你要采集的数据没问题,自己也可以完成。关键在于怎么设置,至于另一个回答,有数据是你的。收录一般都很快,一个ip能采很多站。我跟我们同事用kuaidou做过采集,差不多一个小时就采集过一百多个网站。

数据来源于各种站长工具站,

如果采集的网站没有刷量,ip是自动固定的。采集过程中不会考虑那么多,只要合法,数据就会是自动采集,登录就采,就这么简单。但是如果上面的软件存在刷量行为,尤其是微信群被封,这种网站就是你懂的了。 查看全部

一个拥有自动采集百度的网站就是你懂的

关键词文章采集工具:一个拥有自动采集百度,搜狗,360内容的小软件,秒采数据,不限制总页数,一键排名!采集效果:我是小白:抖音,快手,b站,知乎,公众号数据都采集过,常用的有我爱竞拍,大鱼,一元夺宝,带货女王,头条和网易新闻。文章采集不通过的具体原因:1:涉嫌抄袭作弊,需要百度大数据或者中搜大数据自检,且本文不可恢复。

2:涉嫌违规(引导分享,诱导注册,打广告,进行敏感词汇提示)。3:篡改百度统计数据,可直接提交投诉。4:不符合发文规范。

可以设置采集类型呀1.个人,企业,商城,商品,音乐等各种2.自动登录3.自动加载4.自动伪原创5.自动发送6.自动加载7.自动抓取8.自动发送应用程序如果你要采集的数据没问题,自己也可以完成。关键在于怎么设置,至于另一个回答,有数据是你的。收录一般都很快,一个ip能采很多站。我跟我们同事用kuaidou做过采集,差不多一个小时就采集过一百多个网站。

数据来源于各种站长工具站,

如果采集的网站没有刷量,ip是自动固定的。采集过程中不会考虑那么多,只要合法,数据就会是自动采集,登录就采,就这么简单。但是如果上面的软件存在刷量行为,尤其是微信群被封,这种网站就是你懂的了。

如何用爬虫知乎所有问题,加精华答案和所有用户?

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-04-10 23:03

关键词文章采集工具库、文章分析工具箱,二者对比起来的话,知乎专栏的资源数量更多,而且对于分析工具箱而言,内容更简洁。知乎专栏的采集详细情况请参考:如何用爬虫抓取知乎所有问题,加精华答案和所有用户?实际使用过程中,二者功能区一定要做严格的划分,否则当某一部分数据量太大时,很容易成为某一个板块的“临时集合”,而影响整体分析。

最好的方法就是先理解每个答案被采集的原因,然后把这些答案集合起来,形成一个知乎问答库。像你的文章,如果不自己采集,很难分析里面的问题和答案,也容易把答案打散。所以,现在如果自己没有一个具体的工具,就要靠自己的积累了。如果没有多少知识积累,刚开始最好不要用中文对照着找,学好英文。

根据目标的关键词,至少找出关键字,再根据条件完成爬虫,这是一个有效的方法。像我就写过通过信息采集器来寻找关键字,再根据图书资源进行爬取,完成的。

对于被采集的平台要进行一个对比。从爬虫思路来讲,问答平台相对于文章来说,更为注重问题的质量,问题下的内容更准确的表达了用户的真实意愿。所以,首先需要在问答平台进行人工抓取,将爬虫的结果以正则表达式的形式进行批量处理。然后在分析原始文章中的关键字即可进行爬取。 查看全部

如何用爬虫知乎所有问题,加精华答案和所有用户?

关键词文章采集工具库、文章分析工具箱,二者对比起来的话,知乎专栏的资源数量更多,而且对于分析工具箱而言,内容更简洁。知乎专栏的采集详细情况请参考:如何用爬虫抓取知乎所有问题,加精华答案和所有用户?实际使用过程中,二者功能区一定要做严格的划分,否则当某一部分数据量太大时,很容易成为某一个板块的“临时集合”,而影响整体分析。

最好的方法就是先理解每个答案被采集的原因,然后把这些答案集合起来,形成一个知乎问答库。像你的文章,如果不自己采集,很难分析里面的问题和答案,也容易把答案打散。所以,现在如果自己没有一个具体的工具,就要靠自己的积累了。如果没有多少知识积累,刚开始最好不要用中文对照着找,学好英文。

根据目标的关键词,至少找出关键字,再根据条件完成爬虫,这是一个有效的方法。像我就写过通过信息采集器来寻找关键字,再根据图书资源进行爬取,完成的。

对于被采集的平台要进行一个对比。从爬虫思路来讲,问答平台相对于文章来说,更为注重问题的质量,问题下的内容更准确的表达了用户的真实意愿。所以,首先需要在问答平台进行人工抓取,将爬虫的结果以正则表达式的形式进行批量处理。然后在分析原始文章中的关键字即可进行爬取。

什么是关键词文章采集工具主流文章分析工具介绍?

采集交流 • 优采云 发表了文章 • 0 个评论 • 236 次浏览 • 2021-03-22 21:06

关键词文章采集工具主流文章分析工具具体如下:

1、百度统计这是我们经常看到的工具,它可以很直观的得到每篇文章的权重以及文章阅读量、点赞量等数据。

2、360网络监控这是一款可以监控和统计网站上所有文章数据的工具,查看的结果很直观。

3、优采云这是一款很好用的免费机器人,可以帮助我们找到隐藏比较深的链接,全文覆盖、seo优化、标题伪原创、关键词布局等文章分析工具。

4、ptengine能够自动采集、翻译、分词、聚合,多种合成等操作,精确性、无缝度、快速度等都有保障。

5、nofollow自动爬取当我们的网站被恶意爬取的时候,我们可以进行修改,利用第三方工具可以查看到爬取的原因,这里的nofollow功能还是蛮重要的。

6、易撰官方的文章采集工具,可以根据关键词直接提取文章,广告多的站点也能采集到。

百度指数啊,其实就是一个api接口吧,以实际seo效果为准;ua是必填项,如果是地区、ip地址、域名,这些都可以做,如果是爬虫就没有这个了,robots协议是有关系的。百度文库一个文档大概5毛吧,看每篇文章是否有价值,是否有好内容,文章质量。

看看这个问题下其他人的回答,基本上不需要通过外包采集,找个网站推广(如新浪,搜狐等)需要的资源和手段还是很简单的。我之前想过一个小型的在线采集网站,虽然我不知道怎么做出个像样的站,只是想着给自己的博客和公众号引流,如果有朋友有需要,可以试试。名字好像叫名博来到,还是方向问题,我也很纠结感觉也更多的是广告。 查看全部

什么是关键词文章采集工具主流文章分析工具介绍?

关键词文章采集工具主流文章分析工具具体如下:

1、百度统计这是我们经常看到的工具,它可以很直观的得到每篇文章的权重以及文章阅读量、点赞量等数据。

2、360网络监控这是一款可以监控和统计网站上所有文章数据的工具,查看的结果很直观。

3、优采云这是一款很好用的免费机器人,可以帮助我们找到隐藏比较深的链接,全文覆盖、seo优化、标题伪原创、关键词布局等文章分析工具。

4、ptengine能够自动采集、翻译、分词、聚合,多种合成等操作,精确性、无缝度、快速度等都有保障。

5、nofollow自动爬取当我们的网站被恶意爬取的时候,我们可以进行修改,利用第三方工具可以查看到爬取的原因,这里的nofollow功能还是蛮重要的。

6、易撰官方的文章采集工具,可以根据关键词直接提取文章,广告多的站点也能采集到。

百度指数啊,其实就是一个api接口吧,以实际seo效果为准;ua是必填项,如果是地区、ip地址、域名,这些都可以做,如果是爬虫就没有这个了,robots协议是有关系的。百度文库一个文档大概5毛吧,看每篇文章是否有价值,是否有好内容,文章质量。

看看这个问题下其他人的回答,基本上不需要通过外包采集,找个网站推广(如新浪,搜狐等)需要的资源和手段还是很简单的。我之前想过一个小型的在线采集网站,虽然我不知道怎么做出个像样的站,只是想着给自己的博客和公众号引流,如果有朋友有需要,可以试试。名字好像叫名博来到,还是方向问题,我也很纠结感觉也更多的是广告。

如何使用优采云SEO工具微信公众号文章采集今日头条采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 290 次浏览 • 2021-02-19 10:10

优采云导航:优采云 采集 优采云控制台如何使用优采云 SEO工具微信公众号文章 采集今天的标题采集

关键词 Pan 采集(搜索引擎)

关键词 Pan 采集通过搜索引擎(百度)搜索关键词,采集搜索结果链接的内容(系统将智能识别标题,文本,日期等),使用方法非常简单,只需输入关键词对应。

使用步骤:

1.任务创建和配置:

任务创建条目位于控制台左侧的[采集 Task Management]列表中,单击[关键词 Pan 采集(Search Engine)];

任务配置:

2.数据处理配置(可选)

如果您不需要处理文章,则可以跳过此步骤!

I。数据处理入口

单击[配置数据替换,填充,删除等]按钮进入数据处理配置页面;

II,数据处理配置

此功能类似于详细信息提取器的配置。您可以为每个字段设置删除,填充,替换和过滤功能,然后单击不同的字段以切换相应的字段数据处理配置;

注意:保存该字段的数据处理设置后,它将对输入数据库的新采集数据生效,并且先前输入的数据将无效;

III,图片下载配置

关键词 Pan 采集的原创图像可能无法正常显示(防盗链接)。如果需要图片,请选择临时存储优采云或阿里云OSS或“图片下载配置” Cattle存储中的七个;

3. 采集结果:

默认采集字段:

标题,内容,发布时间,作者,标签,分类,描述,关键词,网站域名(x_id);

注意:

4.百度高级搜索说明和技术

关键词 Pan 采集支持百度高级搜索命令:

I,采集指定网站

采集指定网站:站点的文章指令:

采集在网站下指定了关键词的文章指令(请注意关键词和site指令之间有空格):关键词 site:或site:关键词

例如,采集博客园下的文章的php 关键词:php站点:

优采云导航:优采云 采集 优采云控制台如何使用优采云 SEO工具微信公众号文章 采集今天的标题采集 查看全部

如何使用优采云SEO工具微信公众号文章采集今日头条采集

优采云导航:优采云 采集 优采云控制台如何使用优采云 SEO工具微信公众号文章 采集今天的标题采集

关键词 Pan 采集(搜索引擎)

关键词 Pan 采集通过搜索引擎(百度)搜索关键词,采集搜索结果链接的内容(系统将智能识别标题,文本,日期等),使用方法非常简单,只需输入关键词对应。

使用步骤:

1.任务创建和配置:

任务创建条目位于控制台左侧的[采集 Task Management]列表中,单击[关键词 Pan 采集(Search Engine)];

任务配置:

2.数据处理配置(可选)

如果您不需要处理文章,则可以跳过此步骤!

I。数据处理入口

单击[配置数据替换,填充,删除等]按钮进入数据处理配置页面;

II,数据处理配置

此功能类似于详细信息提取器的配置。您可以为每个字段设置删除,填充,替换和过滤功能,然后单击不同的字段以切换相应的字段数据处理配置;

注意:保存该字段的数据处理设置后,它将对输入数据库的新采集数据生效,并且先前输入的数据将无效;

III,图片下载配置

关键词 Pan 采集的原创图像可能无法正常显示(防盗链接)。如果需要图片,请选择临时存储优采云或阿里云OSS或“图片下载配置” Cattle存储中的七个;

3. 采集结果:

默认采集字段:

标题,内容,发布时间,作者,标签,分类,描述,关键词,网站域名(x_id);

注意:

4.百度高级搜索说明和技术

关键词 Pan 采集支持百度高级搜索命令:

I,采集指定网站

采集指定网站:站点的文章指令:

采集在网站下指定了关键词的文章指令(请注意关键词和site指令之间有空格):关键词 site:或site:关键词

例如,采集博客园下的文章的php 关键词:php站点:

优采云导航:优采云 采集 优采云控制台如何使用优采云 SEO工具微信公众号文章 采集今天的标题采集

设计癖的关键词数据写入csv写了什么案例?

采集交流 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2021-01-23 08:49

对于seoer来说,注意网站的关键词数据,关键词的排名,流量来源以及对等方的网站数据非常重要,这也是非常必要的要使用seo查询工具,更知名的是爱站网站站长工具,网站站长工具和5118。

当然,最全面,使用最广泛的是5118!

在数据和功能方面,5118非常强大!

如果可能的话,付钱!

5118的抗爬性还是很好的!

您需要登录采集。我发现5118已更新一次!

例如,登录帐户需要经过滑条验证码的防爬限制,并且关键词索引和其他数据以图像加密的形式显示。浮渣和秃头不能被撕裂,我担心。

但是,某些数据仍然可以用作参考!因此,python已经启动!

让我们询问设计网站,设计成瘾的情况关键词

抓取网址:

如果您不是付费会员,则只能查看前100页的数据!

很多数据都是防攀登限制,这很可惜!

尽管有用于5118会员登录的滑块验证码,但cookie登录仍然非常易于使用!

我们通过手动添加Cookie登录采集所需的数据。

一些要点:

1.添加协议标头:

headers={

'Accept': 'application/json, text/javascript, */*; q=0.01',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.9',

'Connection': 'keep-alive',

'Content-Length': '0',

'Cookie': Cookies,

'Host': 'www.5118.com',

'Origin': 'https://www.5118.com',

'Referer': 'https://www.5118.com/',

'User-Agent': ua,

'X-Requested-With': 'XMLHttpRequest',

}

自己添加ua和酷客!

这当然是完整的协议标头,有些可以删除,您可以自己尝试!

2.zip功能的使用和格式化数据处理之前也已共享!

for keyword,rank,title,link,index_link in zip(keywords,ranks,titles,links,index_links):

data=[

keyword,

rank.xpath('string(.)').strip().replace(' ','').replace('\r\n','-'),

self.get_change(rank),

title,

unquote(link.split('target=')[-1]),

'https:{}'.format(index_link),

]

print(data)

3.处理排名波动

从源代码查询中,我们可以看到绿色表示排名上升,红色表示排名下降。这是一个判断!

#判断排名是否提升

def get_change(self,rank):

rank=etree.tostring(rank).decode('utf-8')

if "red" in str(rank):

change="下降"

elif "green" in str(rank):

change = "提升"

else:

change = "不变"

return change

4.关键词将数据写入CSV

写了一个案例,发现了两个参考案例

import csv

#关键词数据写入csv

def write_keywords(self):

path='{}_keywords.csv'.format(self.file_name)

csvfile = open(path, 'a+')

for keyword in self.keyword_datas:

csvfile.write('%s\n' % keyword)

print("5118关键词搜索数据写入csv成功!")

#参考一

def write_csv(self):

path = "aa.csv"

with open(path, 'a+') as f:

csv_write = csv.writer(f)

data_row = ["1", "2"]

csv_write.writerow(data_row)

# 参考二

def wcsv(self):

csvfile = open('csvtest.csv', 'w')

writer = csv.writer(csvfile)

writer.writerow(['keywords'])

data = [

('1', 'http://www.xiaoheiseo.com/', '小黑'),

('2', 'http://www.baidu.com/', '百度'),

('3', 'http://www.jd.com/', '京东')

]

writer.writerows(data)

csvfile.close()

5.将与网站相关的关键词数据查询到excel表中

使用第三方库xlsxwriter

#数据写入excle表格

def write_to_xlsx(self):

workbook = xlsxwriter.Workbook('{}_search_results.xlsx'.format(self.file_name)) # 创建一个Excel文件

worksheet = workbook.add_worksheet(self.file_name)

title = ['关键词', '排名', '排名波动', '网页标题', '网页链接', '长尾词链接'] # 表格title

worksheet.write_row('A1', title)

for index, data in enumerate(self.data_lists):

num0 = str(index + 2)

row = 'A' + num0

worksheet.write_row(row, data)

workbook.close()

print("5118搜索数据写入excel成功!")

由于页码也是由js生成的,因此找不到,因此请自行输入页码!

输入查询网站 URL格式:爬行后,主域名用于数据存储文件!

附加完整的代码:

#5118网站关键词数据获取

import requests

from lxml import etree

from urllib.parse import unquote

import xlsxwriter

import time

import csv

class C5118(object):

def __init__(self,url,nums):

self.keyword_datas=[]

self.data_lists=[]

self.index_links_hrefs=[]

self.headers={

'Accept': 'application/json, text/javascript, */*; q=0.01',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.9',

'Connection': 'keep-alive',

'Content-Length': '0',

'Cookie': Cookies,

'Host': 'www.5118.com',

'Origin': 'https://www.5118.com',

'Referer': 'https://www.5118.com/',

'User-Agent': UA,

'X-Requested-With': 'XMLHttpRequest',

}

self.post_url=url

self.file_name=url.split('.')[1]

self.pagenums=nums

#判断排名是否提升

def get_change(self,rank):

rank=etree.tostring(rank).decode('utf-8')

if "red" in str(rank):

change="下降"

elif "green" in str(rank):

change = "提升"

else:

change = "不变"

return change

#获取数据

def get_data(self,pagenum):

url="https://www.5118.com/seo/baidupc"

params={

'isPager': 'true',

'viewtype': '2',

'days': '90',

'url': self.post_url,

'orderField': 'Rank',

'orderDirection': 'asc',

'pageIndex': pagenum, #页码

'catalogName': '',

}

response=requests.post(url,params=params,headers=self.headers)

time.sleep(1)

print(response.status_code)

doc=etree.HTML(response.content.decode('utf-8'))

keywords= doc.xpath('//tr[@class="list-row"]/td[1]/a/text()') #关键词

print(keywords)

self.keyword_datas.extend(keywords)

ranks = doc.xpath('//tr[@class="list-row"]/td[2]/a') #排名

titles = doc.xpath('//tr[@class="list-row"]/td[5]/a/text()') #网页标题

links=doc.xpath('//tr[@class="list-row"]/td[5]/a/@href') #网页链接

index_links=doc.xpath('//tr[@class="list-row"]/td[7]/a/@href') #长尾词数量链接

self.index_links_hrefs.extend(index_links)

for keyword,rank,title,link,index_link in zip(keywords,ranks,titles,links,index_links):

data=[

keyword,

rank.xpath('string(.)').strip().replace(' ','').replace('\r\n','-'),

self.get_change(rank),

title,

unquote(link.split('target=')[-1]),

'https:{}'.format(index_link),

]

print(data)

self.data_lists.append(data)

time.sleep(4)

return self.data_lists

#关键词数据写入csv

def write_keywords(self):

path='{}_keywords.csv'.format(self.file_name)

csvfile = open(path, 'a+')

for keyword in self.keyword_datas:

csvfile.write('%s\n' % keyword)

print("5118关键词搜索数据写入csv成功!")

#数据写入excle表格

def write_to_xlsx(self):

workbook = xlsxwriter.Workbook('{}_search_results.xlsx'.format(self.file_name)) # 创建一个Excel文件

worksheet = workbook.add_worksheet(self.file_name)

title = ['关键词', '排名', '排名波动', '网页标题', '网页链接', '长尾词链接'] # 表格title

worksheet.write_row('A1', title)

for index, data in enumerate(self.data_lists):

num0 = str(index + 2)

row = 'A' + num0

worksheet.write_row(row, data)

workbook.close()

print("5118搜索数据写入excel成功!")

def main(self):

for i in range(1,self.pagenums+1):

print(f'>>> 正在采集第{i}页关键词数据...')

self.get_data(i)

print("数据采集完成!")

self.write_keywords()

self.write_to_xlsx()

if __name__=="__main__":

url = "www.shejipi.com"

nums=100

spider=C5118(url,nums)

spider.main()

采集效果:

设计成瘾网站 关键词相关数据:shejipi_search_results..xlsx

设计成瘾网站 关键词数据:shejipi_keywords.csv 查看全部

设计癖的关键词数据写入csv写了什么案例?

对于seoer来说,注意网站的关键词数据,关键词的排名,流量来源以及对等方的网站数据非常重要,这也是非常必要的要使用seo查询工具,更知名的是爱站网站站长工具,网站站长工具和5118。

当然,最全面,使用最广泛的是5118!

在数据和功能方面,5118非常强大!

如果可能的话,付钱!

5118的抗爬性还是很好的!

您需要登录采集。我发现5118已更新一次!

例如,登录帐户需要经过滑条验证码的防爬限制,并且关键词索引和其他数据以图像加密的形式显示。浮渣和秃头不能被撕裂,我担心。

但是,某些数据仍然可以用作参考!因此,python已经启动!

让我们询问设计网站,设计成瘾的情况关键词

抓取网址:

如果您不是付费会员,则只能查看前100页的数据!

很多数据都是防攀登限制,这很可惜!

尽管有用于5118会员登录的滑块验证码,但cookie登录仍然非常易于使用!

我们通过手动添加Cookie登录采集所需的数据。

一些要点:

1.添加协议标头:

headers={

'Accept': 'application/json, text/javascript, */*; q=0.01',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.9',

'Connection': 'keep-alive',

'Content-Length': '0',

'Cookie': Cookies,

'Host': 'www.5118.com',

'Origin': 'https://www.5118.com',

'Referer': 'https://www.5118.com/',

'User-Agent': ua,

'X-Requested-With': 'XMLHttpRequest',

}

自己添加ua和酷客!

这当然是完整的协议标头,有些可以删除,您可以自己尝试!

2.zip功能的使用和格式化数据处理之前也已共享!

for keyword,rank,title,link,index_link in zip(keywords,ranks,titles,links,index_links):

data=[

keyword,

rank.xpath('string(.)').strip().replace(' ','').replace('\r\n','-'),

self.get_change(rank),

title,

unquote(link.split('target=')[-1]),

'https:{}'.format(index_link),

]

print(data)

3.处理排名波动

从源代码查询中,我们可以看到绿色表示排名上升,红色表示排名下降。这是一个判断!

#判断排名是否提升

def get_change(self,rank):

rank=etree.tostring(rank).decode('utf-8')

if "red" in str(rank):

change="下降"

elif "green" in str(rank):

change = "提升"

else:

change = "不变"

return change

4.关键词将数据写入CSV

写了一个案例,发现了两个参考案例

import csv

#关键词数据写入csv

def write_keywords(self):

path='{}_keywords.csv'.format(self.file_name)

csvfile = open(path, 'a+')

for keyword in self.keyword_datas:

csvfile.write('%s\n' % keyword)

print("5118关键词搜索数据写入csv成功!")

#参考一

def write_csv(self):

path = "aa.csv"

with open(path, 'a+') as f:

csv_write = csv.writer(f)

data_row = ["1", "2"]

csv_write.writerow(data_row)

# 参考二

def wcsv(self):

csvfile = open('csvtest.csv', 'w')

writer = csv.writer(csvfile)

writer.writerow(['keywords'])

data = [

('1', 'http://www.xiaoheiseo.com/', '小黑'),

('2', 'http://www.baidu.com/', '百度'),

('3', 'http://www.jd.com/', '京东')

]

writer.writerows(data)

csvfile.close()

5.将与网站相关的关键词数据查询到excel表中

使用第三方库xlsxwriter

#数据写入excle表格

def write_to_xlsx(self):

workbook = xlsxwriter.Workbook('{}_search_results.xlsx'.format(self.file_name)) # 创建一个Excel文件

worksheet = workbook.add_worksheet(self.file_name)

title = ['关键词', '排名', '排名波动', '网页标题', '网页链接', '长尾词链接'] # 表格title

worksheet.write_row('A1', title)

for index, data in enumerate(self.data_lists):

num0 = str(index + 2)

row = 'A' + num0

worksheet.write_row(row, data)

workbook.close()

print("5118搜索数据写入excel成功!")

由于页码也是由js生成的,因此找不到,因此请自行输入页码!

输入查询网站 URL格式:爬行后,主域名用于数据存储文件!

附加完整的代码:

#5118网站关键词数据获取

import requests

from lxml import etree

from urllib.parse import unquote

import xlsxwriter

import time

import csv

class C5118(object):

def __init__(self,url,nums):

self.keyword_datas=[]

self.data_lists=[]

self.index_links_hrefs=[]

self.headers={

'Accept': 'application/json, text/javascript, */*; q=0.01',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.9',

'Connection': 'keep-alive',

'Content-Length': '0',

'Cookie': Cookies,

'Host': 'www.5118.com',

'Origin': 'https://www.5118.com',

'Referer': 'https://www.5118.com/',

'User-Agent': UA,

'X-Requested-With': 'XMLHttpRequest',

}

self.post_url=url

self.file_name=url.split('.')[1]

self.pagenums=nums

#判断排名是否提升

def get_change(self,rank):

rank=etree.tostring(rank).decode('utf-8')

if "red" in str(rank):

change="下降"

elif "green" in str(rank):

change = "提升"

else:

change = "不变"

return change

#获取数据

def get_data(self,pagenum):

url="https://www.5118.com/seo/baidupc"

params={

'isPager': 'true',

'viewtype': '2',

'days': '90',

'url': self.post_url,

'orderField': 'Rank',

'orderDirection': 'asc',

'pageIndex': pagenum, #页码

'catalogName': '',

}

response=requests.post(url,params=params,headers=self.headers)

time.sleep(1)

print(response.status_code)

doc=etree.HTML(response.content.decode('utf-8'))

keywords= doc.xpath('//tr[@class="list-row"]/td[1]/a/text()') #关键词

print(keywords)

self.keyword_datas.extend(keywords)

ranks = doc.xpath('//tr[@class="list-row"]/td[2]/a') #排名

titles = doc.xpath('//tr[@class="list-row"]/td[5]/a/text()') #网页标题

links=doc.xpath('//tr[@class="list-row"]/td[5]/a/@href') #网页链接

index_links=doc.xpath('//tr[@class="list-row"]/td[7]/a/@href') #长尾词数量链接

self.index_links_hrefs.extend(index_links)

for keyword,rank,title,link,index_link in zip(keywords,ranks,titles,links,index_links):

data=[

keyword,

rank.xpath('string(.)').strip().replace(' ','').replace('\r\n','-'),

self.get_change(rank),

title,

unquote(link.split('target=')[-1]),

'https:{}'.format(index_link),

]

print(data)

self.data_lists.append(data)

time.sleep(4)

return self.data_lists

#关键词数据写入csv

def write_keywords(self):

path='{}_keywords.csv'.format(self.file_name)

csvfile = open(path, 'a+')

for keyword in self.keyword_datas:

csvfile.write('%s\n' % keyword)

print("5118关键词搜索数据写入csv成功!")

#数据写入excle表格

def write_to_xlsx(self):

workbook = xlsxwriter.Workbook('{}_search_results.xlsx'.format(self.file_name)) # 创建一个Excel文件

worksheet = workbook.add_worksheet(self.file_name)

title = ['关键词', '排名', '排名波动', '网页标题', '网页链接', '长尾词链接'] # 表格title

worksheet.write_row('A1', title)

for index, data in enumerate(self.data_lists):

num0 = str(index + 2)

row = 'A' + num0

worksheet.write_row(row, data)

workbook.close()

print("5118搜索数据写入excel成功!")

def main(self):

for i in range(1,self.pagenums+1):

print(f'>>> 正在采集第{i}页关键词数据...')

self.get_data(i)

print("数据采集完成!")

self.write_keywords()

self.write_to_xlsx()

if __name__=="__main__":

url = "www.shejipi.com"

nums=100

spider=C5118(url,nums)

spider.main()

采集效果:

设计成瘾网站 关键词相关数据:shejipi_search_results..xlsx

设计成瘾网站 关键词数据:shejipi_keywords.csv

【】如何采集男生女生的性格测试

采集交流 • 优采云 发表了文章 • 0 个评论 • 186 次浏览 • 2021-07-10 18:04

关键词文章采集工具:本站内容全都是从其他网站上采集下来的,我们大多采集的是性格测试(你想采集男生女生的什么性格测试可以在后台回复01),文章、视频等,当然,还有个电子书类的文章,一方面推荐的人多,一方面价格也便宜,后期如果要用到广告联盟,这些资源也不失为一个好的资源。本站所有的资源都是免费的,源代码可以直接下载,对于进一步采集,建议大家在网上找免费的资源,为啥?因为便宜,最主要的是可以直接复制粘贴,对于采集人员来说,直接复制粘贴快速度也快,你如果想要让这个网站像别的网站一样付费成一个专门的站群,其实是可以做到的,但是,那个代价很大,万一别人复制粘贴的速度太快,就会打乱你的想法,那个网站就倒闭了。

我们采集的图片资源,视频,音频,简直,优势太大了,相信对于一些想要分享一些经验、技巧给别人,或者希望看看别人成功经验的人来说,这是一个非常好的渠道。我们从别的站采集的网站,内容也好、新闻也好,也可以转发本站给喜欢的人看,互帮互助,互相学习,网站也会得到相应的分成。关注我们公众号【】即可看到更多高质量的资源!。

一,婚恋交友问题二,拉拉群三,恋爱培训四,互联网+五,全新原创课程/互联网项目六,推荐系统技术服务(包括但不限于:原创课程,音频微信课程,短视频,信息数据分析, 查看全部

【】如何采集男生女生的性格测试

关键词文章采集工具:本站内容全都是从其他网站上采集下来的,我们大多采集的是性格测试(你想采集男生女生的什么性格测试可以在后台回复01),文章、视频等,当然,还有个电子书类的文章,一方面推荐的人多,一方面价格也便宜,后期如果要用到广告联盟,这些资源也不失为一个好的资源。本站所有的资源都是免费的,源代码可以直接下载,对于进一步采集,建议大家在网上找免费的资源,为啥?因为便宜,最主要的是可以直接复制粘贴,对于采集人员来说,直接复制粘贴快速度也快,你如果想要让这个网站像别的网站一样付费成一个专门的站群,其实是可以做到的,但是,那个代价很大,万一别人复制粘贴的速度太快,就会打乱你的想法,那个网站就倒闭了。

我们采集的图片资源,视频,音频,简直,优势太大了,相信对于一些想要分享一些经验、技巧给别人,或者希望看看别人成功经验的人来说,这是一个非常好的渠道。我们从别的站采集的网站,内容也好、新闻也好,也可以转发本站给喜欢的人看,互帮互助,互相学习,网站也会得到相应的分成。关注我们公众号【】即可看到更多高质量的资源!。

一,婚恋交友问题二,拉拉群三,恋爱培训四,互联网+五,全新原创课程/互联网项目六,推荐系统技术服务(包括但不限于:原创课程,音频微信课程,短视频,信息数据分析,

关键词文章采集工具,可快速采集各大新闻门户及其它新闻网站上的文章及评论

采集交流 • 优采云 发表了文章 • 0 个评论 • 157 次浏览 • 2021-07-08 04:01

关键词文章采集工具,可快速采集各大新闻门户及其它新闻网站上的文章及评论,并且可以一键导出为excel、word文档。下面,

1、采客[采客]是一款针对新闻稿的站内采集工具,

2、说文稿[说文稿]是一款针对文章的站内采集工具,

3、编辑推荐[编辑推荐]是一款自动标题和作者的站内采集工具,

4、互站网[互站网]是一款针对文章信息搜索的站内采集工具,

5、采花[采花]是一款站内采集工具,支持自动匹配关键词和搜索框页码(含网址链接、https)的文章,

6、生意速查[生意速查]是一款专注于商品选品的站内采集工具,

7、供销通[供销通]是一款针对采集工具的站内采集工具,

8、粉象[粉象]是一款主打整站采集的站内采集工具,支持自动匹配关键词和搜索框页码(含网址链接、https)的文章,

9、好知[好知]是一款自动高效采集网页内容的站内采集工具,

0、新闻批量采集[新闻批量采集]是一款主打多类型内容采集的站内采集工具,

1、金融采客[金融采客]是一款主打金融采集的站内采集工具,

2、分类365[分类365]是一款主打分类采集的站内采集工具,支持自动匹配对应分类或者类目的页码,并且支持快速采集快捷键组合。

3、站用[站用]是一款主打站内采集的站内采集工具,

4、百度【文库采集】[百度文库采集]是一款主打百度文库采集的站内采集工具,

5、360【文库采集】[360文库采集]是一款主打百度文库采集的站内采集工具,

6、搜狗【文库采集】[搜狗文库采集]是一款主打百度文库采集的站内采集工具,

7、搜狗【文库采集】[搜狗文库采集]是一款主打百度文库采集的站内采集工具,

8、简书 查看全部

关键词文章采集工具,可快速采集各大新闻门户及其它新闻网站上的文章及评论

关键词文章采集工具,可快速采集各大新闻门户及其它新闻网站上的文章及评论,并且可以一键导出为excel、word文档。下面,

1、采客[采客]是一款针对新闻稿的站内采集工具,

2、说文稿[说文稿]是一款针对文章的站内采集工具,

3、编辑推荐[编辑推荐]是一款自动标题和作者的站内采集工具,

4、互站网[互站网]是一款针对文章信息搜索的站内采集工具,

5、采花[采花]是一款站内采集工具,支持自动匹配关键词和搜索框页码(含网址链接、https)的文章,

6、生意速查[生意速查]是一款专注于商品选品的站内采集工具,

7、供销通[供销通]是一款针对采集工具的站内采集工具,

8、粉象[粉象]是一款主打整站采集的站内采集工具,支持自动匹配关键词和搜索框页码(含网址链接、https)的文章,

9、好知[好知]是一款自动高效采集网页内容的站内采集工具,

0、新闻批量采集[新闻批量采集]是一款主打多类型内容采集的站内采集工具,

1、金融采客[金融采客]是一款主打金融采集的站内采集工具,

2、分类365[分类365]是一款主打分类采集的站内采集工具,支持自动匹配对应分类或者类目的页码,并且支持快速采集快捷键组合。

3、站用[站用]是一款主打站内采集的站内采集工具,

4、百度【文库采集】[百度文库采集]是一款主打百度文库采集的站内采集工具,

5、360【文库采集】[360文库采集]是一款主打百度文库采集的站内采集工具,

6、搜狗【文库采集】[搜狗文库采集]是一款主打百度文库采集的站内采集工具,

7、搜狗【文库采集】[搜狗文库采集]是一款主打百度文库采集的站内采集工具,

8、简书

seo站点Meta采集工具使用方法介绍,免费版全部介绍

采集交流 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2021-06-22 07:24

HTML 标签中有一个 Meta 标签。 Meta标签中的信息属于页面的元信息。对于搜索引擎和更新频率以及关键词的描述,我们现在推荐一个关键词domain采集工具使用这个关键词域名采集软件,根据@k5搜索采集域名@,最火的软件站提供seo网站Meta采集工具下载地址,不知道怎么查看域名是否收录关键词的朋友们快来下载试试吧。

seo 网站 Meta采集tools 介绍

seo网站Meta采集工具是一款关键词域名搜索软件,可以帮助用户获取搜索结果。根据关键词采集域名,再获取对应站点的Meta信息,可以从百度搜索获取结果,软件支持选择搜索页数。搜索后还可以导出结果,方便用户比较所有的结果,使用方法简单方便。

如何使用seo网站Meta采集工具

1.本站下载这款关键词采集域名软件的安装包,解压后找到应用文件,无需安装,双击运行应用,打开即可使用.

2.software 的界面简洁。在对应位置,从百度采集关键词域名获取对应站的标题、关键词和描述。

3.指定关键词文本文件,每行一个,在关键词文本位置输入相应的内容,填写采集页码,点击开始按钮,结果会显示在采集results 页面中。

4. 软件中有操作说明。如果遇到不明白的问题,或者用户无法使用,可以点击操作说明查看软件步骤,快速上手。

小编推荐

以上是seo网站Meta采集tools免费版的完整介绍。最火的软件站有更多类似的关键词software。有需要的朋友快来下载体验吧,下面推荐两款好用的关键词软件:网站META信息查询工具,关键词过滤器。

更新日志(2021.03.30)

当前版本号:v1.2

1、Streamline 文件。

2、优化程序。

3、修复常见错误。 查看全部

seo站点Meta采集工具使用方法介绍,免费版全部介绍

HTML 标签中有一个 Meta 标签。 Meta标签中的信息属于页面的元信息。对于搜索引擎和更新频率以及关键词的描述,我们现在推荐一个关键词domain采集工具使用这个关键词域名采集软件,根据@k5搜索采集域名@,最火的软件站提供seo网站Meta采集工具下载地址,不知道怎么查看域名是否收录关键词的朋友们快来下载试试吧。

seo 网站 Meta采集tools 介绍

seo网站Meta采集工具是一款关键词域名搜索软件,可以帮助用户获取搜索结果。根据关键词采集域名,再获取对应站点的Meta信息,可以从百度搜索获取结果,软件支持选择搜索页数。搜索后还可以导出结果,方便用户比较所有的结果,使用方法简单方便。

如何使用seo网站Meta采集工具

1.本站下载这款关键词采集域名软件的安装包,解压后找到应用文件,无需安装,双击运行应用,打开即可使用.

2.software 的界面简洁。在对应位置,从百度采集关键词域名获取对应站的标题、关键词和描述。

3.指定关键词文本文件,每行一个,在关键词文本位置输入相应的内容,填写采集页码,点击开始按钮,结果会显示在采集results 页面中。

4. 软件中有操作说明。如果遇到不明白的问题,或者用户无法使用,可以点击操作说明查看软件步骤,快速上手。

小编推荐

以上是seo网站Meta采集tools免费版的完整介绍。最火的软件站有更多类似的关键词software。有需要的朋友快来下载体验吧,下面推荐两款好用的关键词软件:网站META信息查询工具,关键词过滤器。

更新日志(2021.03.30)

当前版本号:v1.2

1、Streamline 文件。

2、优化程序。

3、修复常见错误。

隐藏内容请回复百度下拉框关键词采集工具使用说明

采集交流 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-06-17 07:05

隐藏内容请回复百度下拉框关键词采集工具使用说明

2021-06-12【站长动态】一直围观的人

介绍 有时候我们需要很多关键词,但是5118、爱站如果很多需要付费的话,那么采集百度下拉框的话,和百度相关的关键词,但是他们都需要写复杂的规则,比如优采云、优采云。这个工具傻瓜式操作方便快捷,永久使用,无广告。 5118已开通下拉词及相关词采集:游客,如果

有时候我们需要很多关键词,但是5118、爱站如果很多需要付费的话,那么采集百度下拉框的话,和百度相关的关键词,但是他们都需要写复杂的规则,比如优采云,优采云。这个工具傻瓜式操作方便快捷,永久使用,无广告。

5118已开启下拉词及相关词采集:

访客,如果您想查看本帖隐藏内容,请回复

访客,如果您想查看本帖隐藏内容,请回复

百度下拉框关键词采集工具说明

1、先用一个txt文本写出采集的词根。

2、直接导入词根,然后点击采集。

3、可以设置每个关键词采集的页数。

点击下载:

访客,如果您想查看本帖隐藏内容,请回复

更多工具:

【全集SEO工具,实用实用,年轻人不骗人】

啧啧!

试试看能不能用

看看它是如何工作的

顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶

标签:裂变采集关键词无限下拉框

转载:感谢您对Yudi Silent个人博客网站platform的认可,以及网站分享的经验、工具和文章。欢迎各位朋友分享给您的个人站长或朋友圈,但转载请注明文章出处。

() 查看全部

隐藏内容请回复百度下拉框关键词采集工具使用说明

2021-06-12【站长动态】一直围观的人

介绍 有时候我们需要很多关键词,但是5118、爱站如果很多需要付费的话,那么采集百度下拉框的话,和百度相关的关键词,但是他们都需要写复杂的规则,比如优采云、优采云。这个工具傻瓜式操作方便快捷,永久使用,无广告。 5118已开通下拉词及相关词采集:游客,如果

有时候我们需要很多关键词,但是5118、爱站如果很多需要付费的话,那么采集百度下拉框的话,和百度相关的关键词,但是他们都需要写复杂的规则,比如优采云,优采云。这个工具傻瓜式操作方便快捷,永久使用,无广告。

5118已开启下拉词及相关词采集:

访客,如果您想查看本帖隐藏内容,请回复

访客,如果您想查看本帖隐藏内容,请回复

百度下拉框关键词采集工具说明

1、先用一个txt文本写出采集的词根。

2、直接导入词根,然后点击采集。

3、可以设置每个关键词采集的页数。

点击下载:

访客,如果您想查看本帖隐藏内容,请回复

更多工具:

【全集SEO工具,实用实用,年轻人不骗人】

啧啧!

试试看能不能用

看看它是如何工作的

顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶顶

标签:裂变采集关键词无限下拉框

转载:感谢您对Yudi Silent个人博客网站platform的认可,以及网站分享的经验、工具和文章。欢迎各位朋友分享给您的个人站长或朋友圈,但转载请注明文章出处。

()

快速优化关键词文章采集工具,最新快排方法汇总

采集交流 • 优采云 发表了文章 • 0 个评论 • 192 次浏览 • 2021-06-16 02:01

关键词文章采集工具,最新快排方法汇总,想要快速优化的话,可以使用快排工具了,可以使用一些api接口,也可以调用电脑上网的ip,精准定位词并且进行搜索;我知道的有一款很不错的工具,叫蜜蜂快排,还有一款叫快传宝的工具也挺不错的,都是精准排名,可以看下。

楼上的陈祺牛人说的还是蛮透彻的,我说下快排工具吧,大部分都是直接输入关键词,然后给出关键词的排名,不需要费时间用户自己排,甚至是不需要输入关键词,根据关键词排名自动生成。顺便说下,bing的ins百度问答的关键词,你也可以看到bing主页的排名,只是这个需要收费。快排工具有ads-space这个快排工具是用关键词列表检索的,你甚至可以用关键词列表标签和访问者ip,根据访问者数量计算出所需要的关键词。

然后还有一个是shopeemall一款,如下:可以自动检索一些关键词,然后列表排名,很方便。然后还有一个叫xw的代码工具,比如你想搞个toc的listing,就可以直接套用一个代码。其实都差不多,具体你是做哪一种,看你自己的方法了。

1。直接去或者京东买些软件,在中搜索搜索可以用关键词查询什么的;2。如果你也懂一些代码的话,也可以到一些平台上找类似的软件,这个要注意一定要注意甄别到平台是否靠谱,不要用到一些不靠谱的平台,从各种被骗的经历中才会体会到什么才是靠谱的;3。更加直接的办法是去优化公司花钱报个班,软件的话,千牛网这个平台还不错。 查看全部

快速优化关键词文章采集工具,最新快排方法汇总

关键词文章采集工具,最新快排方法汇总,想要快速优化的话,可以使用快排工具了,可以使用一些api接口,也可以调用电脑上网的ip,精准定位词并且进行搜索;我知道的有一款很不错的工具,叫蜜蜂快排,还有一款叫快传宝的工具也挺不错的,都是精准排名,可以看下。

楼上的陈祺牛人说的还是蛮透彻的,我说下快排工具吧,大部分都是直接输入关键词,然后给出关键词的排名,不需要费时间用户自己排,甚至是不需要输入关键词,根据关键词排名自动生成。顺便说下,bing的ins百度问答的关键词,你也可以看到bing主页的排名,只是这个需要收费。快排工具有ads-space这个快排工具是用关键词列表检索的,你甚至可以用关键词列表标签和访问者ip,根据访问者数量计算出所需要的关键词。

然后还有一个是shopeemall一款,如下:可以自动检索一些关键词,然后列表排名,很方便。然后还有一个叫xw的代码工具,比如你想搞个toc的listing,就可以直接套用一个代码。其实都差不多,具体你是做哪一种,看你自己的方法了。

1。直接去或者京东买些软件,在中搜索搜索可以用关键词查询什么的;2。如果你也懂一些代码的话,也可以到一些平台上找类似的软件,这个要注意一定要注意甄别到平台是否靠谱,不要用到一些不靠谱的平台,从各种被骗的经历中才会体会到什么才是靠谱的;3。更加直接的办法是去优化公司花钱报个班,软件的话,千牛网这个平台还不错。

知乎是不是可以做一个专门做手机文章采集的工具?

采集交流 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2021-06-13 06:02

关键词文章采集工具v4.3.19.beta//可以自己测试下!注册地址-我说:不问为什么就问为什么的都是耍流氓!长久以来,我每次收到很多同学求助的时候,我都能找到特别好用的文章采集工具(大概是专注专业和解决难题的工具都比较好),但是,我发现,很多时候,他们所选择的文章采集工具的版本不那么新。这意味着在功能方面有无法满足的情况!一句话,手机的文章采集太过繁琐。

不管是哪个浏览器,你要按照下面这个描述去找一个对应的工具,确实很繁琐,而且很有可能你不满意,在手机使用中会出现问题。我知道知乎是中文站,知乎应该是不是可以做一个专门做手机文章采集的工具呢?两个问题都太大,能否请知友们列举几个大的供我参考?这是一个大问题,请列举些在手机端使用的工具,我做一些思考。先把大话题定了:首先,你要确定你需要的关键词,然后以这个关键词采集一个公号的某个地方的文章,再分析用户收藏和标签。

所以,根据问题,我应该先来到这个文章采集工具的列表,然后再去选择你期望的采集工具。上面的关键词采集工具来源于两个方面:1,最新公号图文(v4.3.20.beta)2,我所设定的关键词也可以看到,对于关键词,工具没有一个特别的定义,而对于你该采集的关键词,工具也是没有限制。一句话,你想要的所有关键词都可以采集。

上面那张图,有几个点,让我来做详细的阐述。第一个,该工具,我使用下来会有一些不好的地方,但我不会取消关注,不好的地方之后我会整理,争取有一个比较好的算法。第二个,下载地址是通过某个公众号所在的服务器来下载,在这个过程中可能会出现问题,我应该怎么分析呢?为了让知友们看懂,我用一个比较好的解决方案:用我们的微信公众号来分析一。 查看全部

知乎是不是可以做一个专门做手机文章采集的工具?

关键词文章采集工具v4.3.19.beta//可以自己测试下!注册地址-我说:不问为什么就问为什么的都是耍流氓!长久以来,我每次收到很多同学求助的时候,我都能找到特别好用的文章采集工具(大概是专注专业和解决难题的工具都比较好),但是,我发现,很多时候,他们所选择的文章采集工具的版本不那么新。这意味着在功能方面有无法满足的情况!一句话,手机的文章采集太过繁琐。

不管是哪个浏览器,你要按照下面这个描述去找一个对应的工具,确实很繁琐,而且很有可能你不满意,在手机使用中会出现问题。我知道知乎是中文站,知乎应该是不是可以做一个专门做手机文章采集的工具呢?两个问题都太大,能否请知友们列举几个大的供我参考?这是一个大问题,请列举些在手机端使用的工具,我做一些思考。先把大话题定了:首先,你要确定你需要的关键词,然后以这个关键词采集一个公号的某个地方的文章,再分析用户收藏和标签。

所以,根据问题,我应该先来到这个文章采集工具的列表,然后再去选择你期望的采集工具。上面的关键词采集工具来源于两个方面:1,最新公号图文(v4.3.20.beta)2,我所设定的关键词也可以看到,对于关键词,工具没有一个特别的定义,而对于你该采集的关键词,工具也是没有限制。一句话,你想要的所有关键词都可以采集。

上面那张图,有几个点,让我来做详细的阐述。第一个,该工具,我使用下来会有一些不好的地方,但我不会取消关注,不好的地方之后我会整理,争取有一个比较好的算法。第二个,下载地址是通过某个公众号所在的服务器来下载,在这个过程中可能会出现问题,我应该怎么分析呢?为了让知友们看懂,我用一个比较好的解决方案:用我们的微信公众号来分析一。

修改大标题方便爬虫爬取3、超级友好的客户端交互设计

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-06-12 22:01

关键词文章采集工具directindustry:可以直接将天猫上搜索的商品信息进行挖掘、交易数据库管理,支持登录、京东、聚美优品、亚马逊等大型电商平台,同时支持查询店铺的在线交易、交易历史等。

楼上那个楼下是正解directindustry目前支持中国站购物商品信息的采集

推荐一个国内的网站【最易采集网】国内第一个成立至今30年的采集站,

1、所有网页一键采集

2、站内唯一大标题编辑器:修改大标题方便爬虫爬取

3、超级友好的客户端交互设计

4、页面持久化上传每次上传一样数据即可

推荐一个全网站都能抓取的,我朋友用的,我觉得好用,需要可以推荐给你。

googlefileselectorpro

希望能帮到你

推荐一个不错的网站,通过网址可以直接进入别人的商品页面,

这个站点不错:/

需要采集很多,

想要做全网站?请点关注→,

楼上怎么和我想法一样?同样是公司内部需要采集各种网站数据,不过平台一般都在自己公司内部网站,比如阿里巴巴、、京东。总之也是企业的数据资产的。感觉现在互联网企业存在的问题有很多内部数据不对外公开,采集到了数据也没有价值, 查看全部

修改大标题方便爬虫爬取3、超级友好的客户端交互设计

关键词文章采集工具directindustry:可以直接将天猫上搜索的商品信息进行挖掘、交易数据库管理,支持登录、京东、聚美优品、亚马逊等大型电商平台,同时支持查询店铺的在线交易、交易历史等。

楼上那个楼下是正解directindustry目前支持中国站购物商品信息的采集

推荐一个国内的网站【最易采集网】国内第一个成立至今30年的采集站,

1、所有网页一键采集

2、站内唯一大标题编辑器:修改大标题方便爬虫爬取

3、超级友好的客户端交互设计

4、页面持久化上传每次上传一样数据即可

推荐一个全网站都能抓取的,我朋友用的,我觉得好用,需要可以推荐给你。

googlefileselectorpro

希望能帮到你

推荐一个不错的网站,通过网址可以直接进入别人的商品页面,

这个站点不错:/

需要采集很多,

想要做全网站?请点关注→,

楼上怎么和我想法一样?同样是公司内部需要采集各种网站数据,不过平台一般都在自己公司内部网站,比如阿里巴巴、、京东。总之也是企业的数据资产的。感觉现在互联网企业存在的问题有很多内部数据不对外公开,采集到了数据也没有价值,

关键词文章采集工具——讯飞输入法强烈推荐

采集交流 • 优采云 发表了文章 • 0 个评论 • 207 次浏览 • 2021-06-03 21:01

关键词文章采集工具—来去机器人你可以在百度、谷歌等等搜索引擎里面搜索你想要的关键词,然后采集你需要的内容。你甚至可以按照自己的想法进行布局,自己写一篇内容。

金山词霸,每次更新就出很多好词,

“讯飞输入法”一开始知道是在网络上看到的一篇介绍,又大又白,像印刷机那么大,就打“长春长生”这几个字,只要顺着拼音分析出每个字的发音很快就能找到他的拼音,就像打字输入法,又不是很精确。用了一段时间觉得这款词库巨大的输入法可以下载自己喜欢的中文谚语、成语、歇后语、俗语我本身平时就喜欢将几句话编成一首诗,就这一点来说好像超过了现在市面上大部分的其他汉语平台。关键是可以自定义词组、短语(未完待续)。

搜狗作为联想速度快,

不是非要拼音,我们是利用词典进行发音推测。推荐个app吧,叫词语宝典,不管是不是你想要的内容,都能够让你知道自己发音的问题出在哪,

你可以试试口袋英语,

当然是讯飞输入法了,各种人工智能对接,还能查出自己发音的错误,和语法的问题,并且各种英语四六级,托福雅思,考研考博,小学初中高中,公务员,司法考试,各种考试都可以用讯飞输入法,强烈推荐! 查看全部

关键词文章采集工具——讯飞输入法强烈推荐

关键词文章采集工具—来去机器人你可以在百度、谷歌等等搜索引擎里面搜索你想要的关键词,然后采集你需要的内容。你甚至可以按照自己的想法进行布局,自己写一篇内容。

金山词霸,每次更新就出很多好词,

“讯飞输入法”一开始知道是在网络上看到的一篇介绍,又大又白,像印刷机那么大,就打“长春长生”这几个字,只要顺着拼音分析出每个字的发音很快就能找到他的拼音,就像打字输入法,又不是很精确。用了一段时间觉得这款词库巨大的输入法可以下载自己喜欢的中文谚语、成语、歇后语、俗语我本身平时就喜欢将几句话编成一首诗,就这一点来说好像超过了现在市面上大部分的其他汉语平台。关键是可以自定义词组、短语(未完待续)。

搜狗作为联想速度快,

不是非要拼音,我们是利用词典进行发音推测。推荐个app吧,叫词语宝典,不管是不是你想要的内容,都能够让你知道自己发音的问题出在哪,

你可以试试口袋英语,

当然是讯飞输入法了,各种人工智能对接,还能查出自己发音的错误,和语法的问题,并且各种英语四六级,托福雅思,考研考博,小学初中高中,公务员,司法考试,各种考试都可以用讯飞输入法,强烈推荐!

国内写作小程序——21天写作训练营

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2021-05-29 19:03

关键词文章采集工具tidy,

对于这个问题呢,首先,我觉得最应该先搞明白的就是一点,那就是我们的目的是什么?是要采集到我们需要的信息,还是只是想要简单的解析几篇文章的内容。根据目的来操作可能才是正确的方向,不然可能本来要采的是文章,却采到了图片。那么,在这里,我想给大家推荐一款国内写作小程序——21天写作训练营,上面有关于写作内容的全部内容。

而且,更为重要的是,它会针对不同的写作风格的采取专门对应的写作视频指导。比如,这篇我准备采的是“亲情”题材,那么它就会有一篇关于采取亲情的采访视频。当然,这只是其中一种写作风格的不同呈现方式,更多的内容我们可以关注一下这个小程序。我们也可以看到,它还有一个更为便捷的工具箱,用起来是不是非常方便,那里也有提供我们非常多的写作学习资源,比如微信文章,图文等等,而且也有大神总结的写作逻辑,算法等等,对于我们有需要的小伙伴来说,应该是一款不错的写作辅助工具。

对于这款小程序,还是希望大家能够多多支持一下的,毕竟它的写作功能足够强大,而且,不需要我们一个个手动操作,大大降低了我们的写作难度。好了,回到主题,再来给大家说一下如何下载小程序,首先,我给大家推荐的是苹果商店,这个软件是我在微信“小应用商店”的官方推荐文章推荐的,所以大家可以在苹果商店里去下载。当然,小伙伴们也可以关注一下我的个人公众号“加减乘方”的公众号内有安卓版本,你们自己去关注一下吧。

下面,我就给大家简单说一下怎么用这个软件来采集文章。第一步,打开小程序:打开小程序,我们点击“获取文章”第二步,选择你想要的要采集的文章第三步,点击下一步即可,接下来该文章就被采集进入小程序中了,我们可以点击上面的三个位置来对小程序进行一下改动来进行收藏。 查看全部

国内写作小程序——21天写作训练营

关键词文章采集工具tidy,

对于这个问题呢,首先,我觉得最应该先搞明白的就是一点,那就是我们的目的是什么?是要采集到我们需要的信息,还是只是想要简单的解析几篇文章的内容。根据目的来操作可能才是正确的方向,不然可能本来要采的是文章,却采到了图片。那么,在这里,我想给大家推荐一款国内写作小程序——21天写作训练营,上面有关于写作内容的全部内容。

而且,更为重要的是,它会针对不同的写作风格的采取专门对应的写作视频指导。比如,这篇我准备采的是“亲情”题材,那么它就会有一篇关于采取亲情的采访视频。当然,这只是其中一种写作风格的不同呈现方式,更多的内容我们可以关注一下这个小程序。我们也可以看到,它还有一个更为便捷的工具箱,用起来是不是非常方便,那里也有提供我们非常多的写作学习资源,比如微信文章,图文等等,而且也有大神总结的写作逻辑,算法等等,对于我们有需要的小伙伴来说,应该是一款不错的写作辅助工具。

对于这款小程序,还是希望大家能够多多支持一下的,毕竟它的写作功能足够强大,而且,不需要我们一个个手动操作,大大降低了我们的写作难度。好了,回到主题,再来给大家说一下如何下载小程序,首先,我给大家推荐的是苹果商店,这个软件是我在微信“小应用商店”的官方推荐文章推荐的,所以大家可以在苹果商店里去下载。当然,小伙伴们也可以关注一下我的个人公众号“加减乘方”的公众号内有安卓版本,你们自己去关注一下吧。

下面,我就给大家简单说一下怎么用这个软件来采集文章。第一步,打开小程序:打开小程序,我们点击“获取文章”第二步,选择你想要的要采集的文章第三步,点击下一步即可,接下来该文章就被采集进入小程序中了,我们可以点击上面的三个位置来对小程序进行一下改动来进行收藏。

精易论坛上发现别人分享的AI智能伪原创软件

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2021-05-28 00:04

该软件与我在静宜论坛上找到的其他人共享。

因为洪宇最近正在研究文章 收录,并且还在开发相关软件,所以我下载并使用了它。

该软件主要具有两个功能,一个是所谓的AI智能伪原创。另一个是关键词批处理采集 文章函数。

Hong Yu从事seo已有多年研究,并且对人工智能相关的语义处理有一定的了解。尽管他不会写,但他了解发生了什么。

中文语义处理是百度无法处理的。这些人实际上称自己为AI智能。

无非就是翻译文本然后再将其翻译回去。如今,该软件的优势在于它可以被多次翻译。

只需翻译一下,然后再翻译回,然后再次翻译结果,然后再翻译回。这样文章将再次变形。

算了,陈词滥调没有太多技术含量。

让我们通过输入关键词来讨论其采集 文章的功能。我做了一点,但是没有实际的采集至文章。

为什么?

由于他的软件报告了严重的病毒,即使该病毒是用Yilang编写的,也无法如此严厉地报告该病毒。为了研究软件,我只能在虚拟机上使用它,但是虚拟机的硬盘不可用,所以我使用360沙箱来解决它。沙箱可以启动软件,但是采集的文章无法保存。

我只能在采集中看到文章的标题。我从标题开始,发现采集实际上是白家好的文章。

众所周知,白家号没有搜索功能。

那他的文章 采集是怎么到达的?

实际上,这并不困难。经过一番思考,它一定是搜索引擎的结果收录。洪宇搜索了它,就是这样...

现在,强大的软件可以完成分析。实际上,它是翻译功能加上Baijiahao 采集。

该软件可促进永久免费使用,但它集成了代理ip功能,需要付费。您提交订单后,软件会自动从服务器获取代理ip 采集的ip。

当然,百度非常抗拒压力,只有非常疯狂的频繁访问才会发出验证码。仅当采集的数量较大时,才需要更改ip。

Hong Yu最近开发了搜狐,头条,微信和采集工具,据我所知,这些工具都是一键傻瓜采集和已处理的文章。

这只是提醒我要开发另一个“白家好”。 查看全部

精易论坛上发现别人分享的AI智能伪原创软件

该软件与我在静宜论坛上找到的其他人共享。

因为洪宇最近正在研究文章 收录,并且还在开发相关软件,所以我下载并使用了它。

该软件主要具有两个功能,一个是所谓的AI智能伪原创。另一个是关键词批处理采集 文章函数。

Hong Yu从事seo已有多年研究,并且对人工智能相关的语义处理有一定的了解。尽管他不会写,但他了解发生了什么。

中文语义处理是百度无法处理的。这些人实际上称自己为AI智能。

无非就是翻译文本然后再将其翻译回去。如今,该软件的优势在于它可以被多次翻译。

只需翻译一下,然后再翻译回,然后再次翻译结果,然后再翻译回。这样文章将再次变形。

算了,陈词滥调没有太多技术含量。

让我们通过输入关键词来讨论其采集 文章的功能。我做了一点,但是没有实际的采集至文章。

为什么?

由于他的软件报告了严重的病毒,即使该病毒是用Yilang编写的,也无法如此严厉地报告该病毒。为了研究软件,我只能在虚拟机上使用它,但是虚拟机的硬盘不可用,所以我使用360沙箱来解决它。沙箱可以启动软件,但是采集的文章无法保存。

我只能在采集中看到文章的标题。我从标题开始,发现采集实际上是白家好的文章。

众所周知,白家号没有搜索功能。

那他的文章 采集是怎么到达的?

实际上,这并不困难。经过一番思考,它一定是搜索引擎的结果收录。洪宇搜索了它,就是这样...

现在,强大的软件可以完成分析。实际上,它是翻译功能加上Baijiahao 采集。

该软件可促进永久免费使用,但它集成了代理ip功能,需要付费。您提交订单后,软件会自动从服务器获取代理ip 采集的ip。

当然,百度非常抗拒压力,只有非常疯狂的频繁访问才会发出验证码。仅当采集的数量较大时,才需要更改ip。

Hong Yu最近开发了搜狐,头条,微信和采集工具,据我所知,这些工具都是一键傻瓜采集和已处理的文章。

这只是提醒我要开发另一个“白家好”。

把文章编辑成自己公司专属的文章采集工具软件!

采集交流 • 优采云 发表了文章 • 0 个评论 • 233 次浏览 • 2021-05-24 20:04

关键词文章采集工具、采集工具软件,企业公司基本都会有一套自己的公众号、百度、搜狗等搜索引擎排名软件,利用微信订阅号的菜单做个收费项目,收集一些热门的文章,把这些采集好的文章编辑成自己公司专属的文章采集工具!工具支持的公众号从微信公众号搜索时可以看到每天都会有很多公众号做打折活动采集工具可以自动将每个公众号的所有文章整理,保存进excel表格中,实现不求人采集,为自己的微信公众号定制专属的文章采集工具软件的详细用法从百度文库开始,可以抓取上万篇免费资源,目前除了百度文库自带的资源外,文库也对网络文章采集(aivulse,当然我还是建议你们去百度里面自己搜索下载!!!)使用方法。

1、抓取文库免费资源:1.

1、actag,直接进入网址,抓取有关“影视作品、考研、教师资格证考试、计算机等级考试、婚恋婚庆、产品、职业、新闻”相关的文档。

2、采集所有资源:准备好公众号名称以及公众号昵称,

3、按照公众号名称自动过滤再循环点击搜索后台进入公众号列表页面。

(文章采集进入网址时就会过滤,每一篇文章都会过滤成不相干的,

2、抓取其他网站文章文库回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

5、pdf、ppt,

3、返回主页抓取文库信息回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

5、pdf、ppt,导入采集框点击“查看文档”“进入文档”,查看该文档分享的网址,复制,粘贴到采集框,最后保存返回主页抓取文库信息回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

5、pdf、ppt,导入采集框回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

4、导出excel表格同步于公众号:关注公众号,发送文库,返回文库链接,即可导出excel表格,简单粗暴全面采集文库,四大平台数据合一。

5、其他定制收集其他网站信息1。搜狗微信搜索-用心服务每一个普通用户2。百度搜索”企业文章采集-直接”采集百度主页企业旗下的公众号3。去哪儿(百度)采集-直接采集百度主页信息4。178采集-直接采集“5118采集器”百度主页信息(采集器这种不是免费的,即使搜索引擎改变免费的模式,请和我一起,将网站信息主动推送到5118平台,保证数据不被泄露,共同呵护数据的安全)。 查看全部

把文章编辑成自己公司专属的文章采集工具软件!

关键词文章采集工具、采集工具软件,企业公司基本都会有一套自己的公众号、百度、搜狗等搜索引擎排名软件,利用微信订阅号的菜单做个收费项目,收集一些热门的文章,把这些采集好的文章编辑成自己公司专属的文章采集工具!工具支持的公众号从微信公众号搜索时可以看到每天都会有很多公众号做打折活动采集工具可以自动将每个公众号的所有文章整理,保存进excel表格中,实现不求人采集,为自己的微信公众号定制专属的文章采集工具软件的详细用法从百度文库开始,可以抓取上万篇免费资源,目前除了百度文库自带的资源外,文库也对网络文章采集(aivulse,当然我还是建议你们去百度里面自己搜索下载!!!)使用方法。

1、抓取文库免费资源:1.

1、actag,直接进入网址,抓取有关“影视作品、考研、教师资格证考试、计算机等级考试、婚恋婚庆、产品、职业、新闻”相关的文档。

2、采集所有资源:准备好公众号名称以及公众号昵称,

3、按照公众号名称自动过滤再循环点击搜索后台进入公众号列表页面。

(文章采集进入网址时就会过滤,每一篇文章都会过滤成不相干的,

2、抓取其他网站文章文库回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

5、pdf、ppt,

3、返回主页抓取文库信息回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

5、pdf、ppt,导入采集框点击“查看文档”“进入文档”,查看该文档分享的网址,复制,粘贴到采集框,最后保存返回主页抓取文库信息回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

5、pdf、ppt,导入采集框回复:文库号前面,勾选“我的文档”,这里回复到的是文库相关文章,

4、导出excel表格同步于公众号:关注公众号,发送文库,返回文库链接,即可导出excel表格,简单粗暴全面采集文库,四大平台数据合一。

5、其他定制收集其他网站信息1。搜狗微信搜索-用心服务每一个普通用户2。百度搜索”企业文章采集-直接”采集百度主页企业旗下的公众号3。去哪儿(百度)采集-直接采集百度主页信息4。178采集-直接采集“5118采集器”百度主页信息(采集器这种不是免费的,即使搜索引擎改变免费的模式,请和我一起,将网站信息主动推送到5118平台,保证数据不被泄露,共同呵护数据的安全)。

实用的关键词挖掘工具有哪些?爱站网告诉你

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-05-18 07:06

什么是有用的关键词挖掘工具?以下文章文章对于刚刚开始seo的学生非常有用,因为它介绍了seo技术最关键的技术是关键词挖掘分析,这对于优化网站的排名以第一名。当然,这仅是seo优化技能的基础,但对于仅学习seo的人来说,该基础已经非常重要。总共有五个挖掘关键词工具。 ,这对于选择关键词和长尾关键词挖掘非常有帮助。

1.最简单的方法-爱站净关键词挖掘工具

爱站网关键词挖掘工具是由爱站独立开发的SEO工具。该工具可以帮助大多数SEO找到很多想要更快,更快地购买的长尾巴关键词,通常这些长尾巴关键词的质量相对较高。

2.最有效的方法-Feidaru 关键词工具

<p>此关键词工具可被视为目前功能最强大的免费关键词挖掘工具。其挖掘关键词的能力只能被描述为“令人发指”,当然,如此大量的关键词您需要经过严格的SEO筛选,以实现最佳选择并带来出色而有效的访问量。 查看全部

实用的关键词挖掘工具有哪些?爱站网告诉你

什么是有用的关键词挖掘工具?以下文章文章对于刚刚开始seo的学生非常有用,因为它介绍了seo技术最关键的技术是关键词挖掘分析,这对于优化网站的排名以第一名。当然,这仅是seo优化技能的基础,但对于仅学习seo的人来说,该基础已经非常重要。总共有五个挖掘关键词工具。 ,这对于选择关键词和长尾关键词挖掘非常有帮助。

1.最简单的方法-爱站净关键词挖掘工具

爱站网关键词挖掘工具是由爱站独立开发的SEO工具。该工具可以帮助大多数SEO找到很多想要更快,更快地购买的长尾巴关键词,通常这些长尾巴关键词的质量相对较高。

2.最有效的方法-Feidaru 关键词工具

<p>此关键词工具可被视为目前功能最强大的免费关键词挖掘工具。其挖掘关键词的能力只能被描述为“令人发指”,当然,如此大量的关键词您需要经过严格的SEO筛选,以实现最佳选择并带来出色而有效的访问量。

蓝域破解:战神关键词挖掘工具破解版(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 126 次浏览 • 2021-05-07 04:34

蓝色域名破解:战争之神关键词挖掘工具的破解版,该工具是由网站管理员亲自破解的。战神关键词工具是目前使用最多的专业关键词采矿工具。该软件具有许多实用而强大的功能,例如长尾关键词挖掘,云字数据库下载,竞争对手出价关键词分析,网站 关键词排名检测等。它在网站站长中很受欢迎,网站运营主管,受到招标专业人士的青睐。战神关键词工具是出色的中文关键词分析工具。它的核心优势是超长尾巴关键词挖掘能力,可以极大地扩展您的SEO思维!新增加了线程挖掘和cloud 关键词挖掘,效率提高了10到100倍!轻松获得数百万条长尾巴关键词!它是SEOer的必备工具。

多种获取关键词的方式

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

快速的云挖掘,云下载

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

独家获得竞争对手的出价关键词和想法

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

综合关键词工具箱

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

使用组:

1. 网站网站管理员

无论是个人网站管理员还是公司网站管理员,都有很多长尾巴关键词需求。通过战神关键词工具的多种关键词挖掘方法,

在您的行业中快速获取大量的长尾单词,以扩展网站内容,优化网站页面等。

同时,网站管理员还可以通过软件提供的关键词排名监控功能来监控网站每日关键词排名。

您甚至可以按权重关键词进行查询,直接获得竞争对手的排名关键词。

2.大中型网站 SEO主管

大中型网站 SEO占据了大量流量。作为SEO总监,您必须了解关键词长尾巴是网站流量的基础,并且您必须非常重视它。

通过战神关键词工具,您可以快速探索网站所在行业中的大量长尾关键词,并建立庞大的关键词同义词库。

与此同时,该软件提供的关键词排名监控功能也可以每天监控网站个关键词排名。

通过权重关键词查询和竞争对手的投标词查询来分析关键词行业竞争对手的排名或投标情况。

3. SEO公司,站群

此类客户的共同特征是他们需要优化大量的网站,并且自然而然地他们将需要大量的关键词。

通过战争之神关键词工具的强大的云挖掘或本地多线程挖掘功能,批量挖掘可轻松获得数百万个长尾单词。

战神关键词工具的关键词排名查询功能支持网站分类和网站 关键词同时导入。

轻松响应大规模网站和关键词排名查询监控。

4. 网站招标专员

在减少竞标广告空间之后,关键词点击费用继续增加,竞争变得更加激烈。唯一的出路就是获得更多高质量的长尾单词并提高投标创造力的质量。

但是,经过各种软件的思考和挖掘之后,我仍然觉得我的创作效果不好吗? 关键词还不够?实际上,您的竞争对手已经为您想到了!

战神关键词工具使用大数据原理来启动竞争对手的竞标关键词分析功能。只要输入竞争对手的出价网址,您就可以获取其所有出价关键词,

投标思路。此神奇功能等效于查看对手的出价帐户。认识自己和敌人肯定会结束一百场战斗。

如果可以下载该工具,请尽快下载。如果我们收到任何律师,我们必须如实删除帖子。该网站指出,该工具的破解版是免费发布的,并且我还没有从中获利。金钱,我也希望所有SEO兄弟不要将其用于转售。如果您不承担任何风险,将来我将不会更新任何工具!谢谢!

工具下载链接:

[软件名称]:Blue Domain破解:战争之神关键词挖掘工具完美破解版

[软件版本]:7. 30个最新版本V6

[软件大小]:2. 0M

[支持系统]:所有系统

[测试系统]:win7

[软件功能]:多功能

[使用说明]:该软件详细描述了如何使用

[下载URL]:单击我进行高速下载,安全且无毒

如果您喜欢此网站,请向您的朋友推荐此网站

您的支持是每日更新此站点的动力。除了每天更新fz资源外,它还将更新学习网络安全知识资源。如果您对游戏感到厌倦,为什么不尝试学习一点网络知识呢? ? ?

网站自学教程目录,由网站管理员记录的破解教程,欢迎大家学习。如果您不知道如何自己添加企鹅,我将免费为每个人解答和学习知识!

更多相关的文章阅读:

2019 Shenma Mip推出第二级装订完美破解版

优采云 采集器完美破解版[亲测安全无毒]

蓝色域SEO:免费挖掘网站 关键词工具1. 1 [网站管理员原创]

免费的蓝色域百度主动推送工具v 1. 0 查看全部

蓝域破解:战神关键词挖掘工具破解版(组图)

蓝色域名破解:战争之神关键词挖掘工具的破解版,该工具是由网站管理员亲自破解的。战神关键词工具是目前使用最多的专业关键词采矿工具。该软件具有许多实用而强大的功能,例如长尾关键词挖掘,云字数据库下载,竞争对手出价关键词分析,网站 关键词排名检测等。它在网站站长中很受欢迎,网站运营主管,受到招标专业人士的青睐。战神关键词工具是出色的中文关键词分析工具。它的核心优势是超长尾巴关键词挖掘能力,可以极大地扩展您的SEO思维!新增加了线程挖掘和cloud 关键词挖掘,效率提高了10到100倍!轻松获得数百万条长尾巴关键词!它是SEOer的必备工具。

多种获取关键词的方式

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

快速的云挖掘,云下载

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

独家获得竞争对手的出价关键词和想法

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

综合关键词工具箱

该软件提供了多种获取关键词的方法,例如本地多线程挖掘,加权关键词挖掘,百度出价背景关键词挖掘以及竞争对手出价关键词分析。与同类软件相比,它具有更多的单词和更快的速度。

使用组:

1. 网站网站管理员

无论是个人网站管理员还是公司网站管理员,都有很多长尾巴关键词需求。通过战神关键词工具的多种关键词挖掘方法,

在您的行业中快速获取大量的长尾单词,以扩展网站内容,优化网站页面等。

同时,网站管理员还可以通过软件提供的关键词排名监控功能来监控网站每日关键词排名。

您甚至可以按权重关键词进行查询,直接获得竞争对手的排名关键词。

2.大中型网站 SEO主管

大中型网站 SEO占据了大量流量。作为SEO总监,您必须了解关键词长尾巴是网站流量的基础,并且您必须非常重视它。

通过战神关键词工具,您可以快速探索网站所在行业中的大量长尾关键词,并建立庞大的关键词同义词库。

与此同时,该软件提供的关键词排名监控功能也可以每天监控网站个关键词排名。

通过权重关键词查询和竞争对手的投标词查询来分析关键词行业竞争对手的排名或投标情况。

3. SEO公司,站群

此类客户的共同特征是他们需要优化大量的网站,并且自然而然地他们将需要大量的关键词。

通过战争之神关键词工具的强大的云挖掘或本地多线程挖掘功能,批量挖掘可轻松获得数百万个长尾单词。

战神关键词工具的关键词排名查询功能支持网站分类和网站 关键词同时导入。

轻松响应大规模网站和关键词排名查询监控。

4. 网站招标专员

在减少竞标广告空间之后,关键词点击费用继续增加,竞争变得更加激烈。唯一的出路就是获得更多高质量的长尾单词并提高投标创造力的质量。

但是,经过各种软件的思考和挖掘之后,我仍然觉得我的创作效果不好吗? 关键词还不够?实际上,您的竞争对手已经为您想到了!

战神关键词工具使用大数据原理来启动竞争对手的竞标关键词分析功能。只要输入竞争对手的出价网址,您就可以获取其所有出价关键词,

投标思路。此神奇功能等效于查看对手的出价帐户。认识自己和敌人肯定会结束一百场战斗。

如果可以下载该工具,请尽快下载。如果我们收到任何律师,我们必须如实删除帖子。该网站指出,该工具的破解版是免费发布的,并且我还没有从中获利。金钱,我也希望所有SEO兄弟不要将其用于转售。如果您不承担任何风险,将来我将不会更新任何工具!谢谢!

工具下载链接:

[软件名称]:Blue Domain破解:战争之神关键词挖掘工具完美破解版

[软件版本]:7. 30个最新版本V6

[软件大小]:2. 0M

[支持系统]:所有系统

[测试系统]:win7

[软件功能]:多功能

[使用说明]:该软件详细描述了如何使用

[下载URL]:单击我进行高速下载,安全且无毒

如果您喜欢此网站,请向您的朋友推荐此网站

您的支持是每日更新此站点的动力。除了每天更新fz资源外,它还将更新学习网络安全知识资源。如果您对游戏感到厌倦,为什么不尝试学习一点网络知识呢? ? ?

网站自学教程目录,由网站管理员记录的破解教程,欢迎大家学习。如果您不知道如何自己添加企鹅,我将免费为每个人解答和学习知识!

更多相关的文章阅读:

2019 Shenma Mip推出第二级装订完美破解版

优采云 采集器完美破解版[亲测安全无毒]

蓝色域SEO:免费挖掘网站 关键词工具1. 1 [网站管理员原创]

免费的蓝色域百度主动推送工具v 1. 0

软件介绍文章关键词提取器是一款非常实用的文章

采集交流 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2021-05-03 22:08

软件简介

文章 关键词提取器是非常有用的文章 关键词提取工具,它是完全免费的,使用关键词高速匹配算法提取单词,单词,句子或文章短语中的单词可以快速获取并按编号排序,从而使用户可以快速了解文章文章中关键词的频率,并快速掌握文章的核心内容。

软件功能

1、程序同义词库分为两种类型:程序中内置的系统关键词库(具有768936个条目)和文件中存储的用户关键词库。

2、用户可以根据需要方便地匹配两个或所有同义词库,以满足不同类型关键词提取的需求。

3、 文章 关键词提取器的用户词汇表可以随意创建和修改,并且可以在任何版本的用户词汇表之间轻松切换。

4、操作简单,快速。启动主程序时,将自动加载用户词典。用户只需输入关键词软件即可自动为用户执行统计信息。

使用方法

1、将关键词的文章粘贴到文本编辑框中;

2、由于收录在系统的内置词库中有700,000多个条目,因此大量条目中的许多单词不是用户所需要的,并且许多独特的关键词在系统的词库中。不,在程序中准备了方便的功能,例如“使用系统词库和加载的用户词库提取”,“仅使用系统词库提取”,“仅使用用户词库提取”和其他便利功能。如何使用这些功能?只需点击下面的不同按钮即可实现:

①“所有词库”按钮使用系统的内置词库和用户词库进行匹配提取;

②“系统词库”按钮仅使用系统内置的词库进行匹配提取;

③“用户词汇”按钮仅使用用户定义的词汇进行匹配提取;

④用户同义词库可以创建多个不同的同义词库文件以满足不同的需求。使用时,单击“加载同义词库”按钮以选择其他同义词库并加载以使用(加载的同义词库将替换以前的用户同义词库,系统的内置同义词库将不受影响);

⑤“包裹模式”按钮可使编辑框中的文章在包裹和不包裹之间切换,方便编辑;

⑥“ 文章下载”按钮指向网络文章发布系统,您可以根据需要下载一些文章进行处理。

3、单击所需的按钮,等待一段时间,以在新打开的窗口中显示提取结果,可以根据需要的格式将其导出到Excel或存储在新的文本编辑框中。

安装方法

1、首先等待文章 关键词提取工具下载完成

2、使用压缩软件解压缩文件

3、双击运行“ 关键词 Extractor.exe”以开始使用 查看全部

软件介绍文章关键词提取器是一款非常实用的文章

软件简介

文章 关键词提取器是非常有用的文章 关键词提取工具,它是完全免费的,使用关键词高速匹配算法提取单词,单词,句子或文章短语中的单词可以快速获取并按编号排序,从而使用户可以快速了解文章文章中关键词的频率,并快速掌握文章的核心内容。

软件功能

1、程序同义词库分为两种类型:程序中内置的系统关键词库(具有768936个条目)和文件中存储的用户关键词库。

2、用户可以根据需要方便地匹配两个或所有同义词库,以满足不同类型关键词提取的需求。

3、 文章 关键词提取器的用户词汇表可以随意创建和修改,并且可以在任何版本的用户词汇表之间轻松切换。

4、操作简单,快速。启动主程序时,将自动加载用户词典。用户只需输入关键词软件即可自动为用户执行统计信息。

使用方法

1、将关键词的文章粘贴到文本编辑框中;

2、由于收录在系统的内置词库中有700,000多个条目,因此大量条目中的许多单词不是用户所需要的,并且许多独特的关键词在系统的词库中。不,在程序中准备了方便的功能,例如“使用系统词库和加载的用户词库提取”,“仅使用系统词库提取”,“仅使用用户词库提取”和其他便利功能。如何使用这些功能?只需点击下面的不同按钮即可实现:

①“所有词库”按钮使用系统的内置词库和用户词库进行匹配提取;

②“系统词库”按钮仅使用系统内置的词库进行匹配提取;

③“用户词汇”按钮仅使用用户定义的词汇进行匹配提取;

④用户同义词库可以创建多个不同的同义词库文件以满足不同的需求。使用时,单击“加载同义词库”按钮以选择其他同义词库并加载以使用(加载的同义词库将替换以前的用户同义词库,系统的内置同义词库将不受影响);

⑤“包裹模式”按钮可使编辑框中的文章在包裹和不包裹之间切换,方便编辑;

⑥“ 文章下载”按钮指向网络文章发布系统,您可以根据需要下载一些文章进行处理。

3、单击所需的按钮,等待一段时间,以在新打开的窗口中显示提取结果,可以根据需要的格式将其导出到Excel或存储在新的文本编辑框中。

安装方法

1、首先等待文章 关键词提取工具下载完成

2、使用压缩软件解压缩文件

3、双击运行“ 关键词 Extractor.exe”以开始使用

针对如何采集获取wordpress/discuz!/zblog这些博客站点的访问权限数据而做的分享

采集交流 • 优采云 发表了文章 • 0 个评论 • 253 次浏览 • 2021-04-29 04:03

关键词文章采集工具,对wordpress/discuz!/zblog这些博客站点的访问权限都可以读取到,采集工具的模式是读取html(标签)格式的数据,理论上来说,读取位置的不同,获取权限的不同,读取的比例不会有很大差异,但是实际采集的情况是,想读取某些站点的源代码,就必须经过一系列的层层爬虫,一层层调用,这样的效率就比较低了。

这篇文章就是针对如何采集获取wordpress/discuz!/zblog这些博客站点的访问权限数据而做的分享。工具地址defenderwikisforwikiteam:managingyourwikifromasourcenetworkwhereyoucanenhanceyourwiki-generationdomain-look:toincreasewiki-generationdomainspersecondonwiki-generationdomains,writeon.server:wordpresswiki-project:myphonydirectory:submitusingwikican:connecttothewikipediaforjustaslongas20percentofyourwikidetailsgetwikiletdomainclient:startasessionwithwikiletclient:increaseyourwiki-generationcodeinagreatport---server:nextdocument:wikiletwikisetforwikidetails:increaseyourwiki-generationcodeareusedinanappconnectinthewiki:expandthewiki_genesisblockintheproject:startauniverseforallthedomains这些站点从哪来的?首先,这些博客站点都是wiki类博客,或是单文档类博客,或是多文档类博客。

单文档类博客:例如,:,如果想采集到权限,对应的wikiwiki是不能访问的(我们在debug时尝试访问),我们需要去了解wikiwiki是如何获取访问权限的。可以看出defender是读取html(标签)格式的数据,只要程序运行正常,读取正常的文章,而另外一些站点需要去调用wikisetforwikidetails,wikisetforwikisetforewiki,wikisetforewikisetfore,wikisetforewikisetfore.等等,这些站点就读取了代码里面的绝大部分的信息。

这时,defender可以读取对应站点中文章的访问权限数据。这样,我们就可以利用代码defender提供的代码进行读取权限读取。如何使用defender,从上面的可知,defender只读取位置的不同,访问权限数据是不会有差异的,也就是说,这些站点读取权限的数据比例大小不会有差异。既然不能把读取权限数据的比例采集到位置里面去,那如何从defender读取权限数据呢?有如下两种方式:一、全文读取,或单文档读取:1.直接从wikisetfoorwikisetforwikidetails,wikisetforewikisetforewikisetforewikisetfore_domain?里面读取访问权限数据。二、生成读取数据对应的格式代码可以。 查看全部

针对如何采集获取wordpress/discuz!/zblog这些博客站点的访问权限数据而做的分享

关键词文章采集工具,对wordpress/discuz!/zblog这些博客站点的访问权限都可以读取到,采集工具的模式是读取html(标签)格式的数据,理论上来说,读取位置的不同,获取权限的不同,读取的比例不会有很大差异,但是实际采集的情况是,想读取某些站点的源代码,就必须经过一系列的层层爬虫,一层层调用,这样的效率就比较低了。

这篇文章就是针对如何采集获取wordpress/discuz!/zblog这些博客站点的访问权限数据而做的分享。工具地址defenderwikisforwikiteam:managingyourwikifromasourcenetworkwhereyoucanenhanceyourwiki-generationdomain-look:toincreasewiki-generationdomainspersecondonwiki-generationdomains,writeon.server:wordpresswiki-project:myphonydirectory:submitusingwikican:connecttothewikipediaforjustaslongas20percentofyourwikidetailsgetwikiletdomainclient:startasessionwithwikiletclient:increaseyourwiki-generationcodeinagreatport---server:nextdocument:wikiletwikisetforwikidetails:increaseyourwiki-generationcodeareusedinanappconnectinthewiki:expandthewiki_genesisblockintheproject:startauniverseforallthedomains这些站点从哪来的?首先,这些博客站点都是wiki类博客,或是单文档类博客,或是多文档类博客。

单文档类博客:例如,:,如果想采集到权限,对应的wikiwiki是不能访问的(我们在debug时尝试访问),我们需要去了解wikiwiki是如何获取访问权限的。可以看出defender是读取html(标签)格式的数据,只要程序运行正常,读取正常的文章,而另外一些站点需要去调用wikisetforwikidetails,wikisetforwikisetforewiki,wikisetforewikisetfore,wikisetforewikisetfore.等等,这些站点就读取了代码里面的绝大部分的信息。

这时,defender可以读取对应站点中文章的访问权限数据。这样,我们就可以利用代码defender提供的代码进行读取权限读取。如何使用defender,从上面的可知,defender只读取位置的不同,访问权限数据是不会有差异的,也就是说,这些站点读取权限的数据比例大小不会有差异。既然不能把读取权限数据的比例采集到位置里面去,那如何从defender读取权限数据呢?有如下两种方式:一、全文读取,或单文档读取:1.直接从wikisetfoorwikisetforwikidetails,wikisetforewikisetforewikisetforewikisetfore_domain?里面读取访问权限数据。二、生成读取数据对应的格式代码可以。

一个拥有自动采集百度的网站就是你懂的

采集交流 • 优采云 发表了文章 • 0 个评论 • 217 次浏览 • 2021-04-18 00:05

关键词文章采集工具:一个拥有自动采集百度,搜狗,360内容的小软件,秒采数据,不限制总页数,一键排名!采集效果:我是小白:抖音,快手,b站,知乎,公众号数据都采集过,常用的有我爱竞拍,大鱼,一元夺宝,带货女王,头条和网易新闻。文章采集不通过的具体原因:1:涉嫌抄袭作弊,需要百度大数据或者中搜大数据自检,且本文不可恢复。

2:涉嫌违规(引导分享,诱导注册,打广告,进行敏感词汇提示)。3:篡改百度统计数据,可直接提交投诉。4:不符合发文规范。

可以设置采集类型呀1.个人,企业,商城,商品,音乐等各种2.自动登录3.自动加载4.自动伪原创5.自动发送6.自动加载7.自动抓取8.自动发送应用程序如果你要采集的数据没问题,自己也可以完成。关键在于怎么设置,至于另一个回答,有数据是你的。收录一般都很快,一个ip能采很多站。我跟我们同事用kuaidou做过采集,差不多一个小时就采集过一百多个网站。

数据来源于各种站长工具站,

如果采集的网站没有刷量,ip是自动固定的。采集过程中不会考虑那么多,只要合法,数据就会是自动采集,登录就采,就这么简单。但是如果上面的软件存在刷量行为,尤其是微信群被封,这种网站就是你懂的了。 查看全部

一个拥有自动采集百度的网站就是你懂的

关键词文章采集工具:一个拥有自动采集百度,搜狗,360内容的小软件,秒采数据,不限制总页数,一键排名!采集效果:我是小白:抖音,快手,b站,知乎,公众号数据都采集过,常用的有我爱竞拍,大鱼,一元夺宝,带货女王,头条和网易新闻。文章采集不通过的具体原因:1:涉嫌抄袭作弊,需要百度大数据或者中搜大数据自检,且本文不可恢复。

2:涉嫌违规(引导分享,诱导注册,打广告,进行敏感词汇提示)。3:篡改百度统计数据,可直接提交投诉。4:不符合发文规范。

可以设置采集类型呀1.个人,企业,商城,商品,音乐等各种2.自动登录3.自动加载4.自动伪原创5.自动发送6.自动加载7.自动抓取8.自动发送应用程序如果你要采集的数据没问题,自己也可以完成。关键在于怎么设置,至于另一个回答,有数据是你的。收录一般都很快,一个ip能采很多站。我跟我们同事用kuaidou做过采集,差不多一个小时就采集过一百多个网站。

数据来源于各种站长工具站,

如果采集的网站没有刷量,ip是自动固定的。采集过程中不会考虑那么多,只要合法,数据就会是自动采集,登录就采,就这么简单。但是如果上面的软件存在刷量行为,尤其是微信群被封,这种网站就是你懂的了。

如何用爬虫知乎所有问题,加精华答案和所有用户?

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-04-10 23:03

关键词文章采集工具库、文章分析工具箱,二者对比起来的话,知乎专栏的资源数量更多,而且对于分析工具箱而言,内容更简洁。知乎专栏的采集详细情况请参考:如何用爬虫抓取知乎所有问题,加精华答案和所有用户?实际使用过程中,二者功能区一定要做严格的划分,否则当某一部分数据量太大时,很容易成为某一个板块的“临时集合”,而影响整体分析。

最好的方法就是先理解每个答案被采集的原因,然后把这些答案集合起来,形成一个知乎问答库。像你的文章,如果不自己采集,很难分析里面的问题和答案,也容易把答案打散。所以,现在如果自己没有一个具体的工具,就要靠自己的积累了。如果没有多少知识积累,刚开始最好不要用中文对照着找,学好英文。

根据目标的关键词,至少找出关键字,再根据条件完成爬虫,这是一个有效的方法。像我就写过通过信息采集器来寻找关键字,再根据图书资源进行爬取,完成的。

对于被采集的平台要进行一个对比。从爬虫思路来讲,问答平台相对于文章来说,更为注重问题的质量,问题下的内容更准确的表达了用户的真实意愿。所以,首先需要在问答平台进行人工抓取,将爬虫的结果以正则表达式的形式进行批量处理。然后在分析原始文章中的关键字即可进行爬取。 查看全部

如何用爬虫知乎所有问题,加精华答案和所有用户?

关键词文章采集工具库、文章分析工具箱,二者对比起来的话,知乎专栏的资源数量更多,而且对于分析工具箱而言,内容更简洁。知乎专栏的采集详细情况请参考:如何用爬虫抓取知乎所有问题,加精华答案和所有用户?实际使用过程中,二者功能区一定要做严格的划分,否则当某一部分数据量太大时,很容易成为某一个板块的“临时集合”,而影响整体分析。

最好的方法就是先理解每个答案被采集的原因,然后把这些答案集合起来,形成一个知乎问答库。像你的文章,如果不自己采集,很难分析里面的问题和答案,也容易把答案打散。所以,现在如果自己没有一个具体的工具,就要靠自己的积累了。如果没有多少知识积累,刚开始最好不要用中文对照着找,学好英文。

根据目标的关键词,至少找出关键字,再根据条件完成爬虫,这是一个有效的方法。像我就写过通过信息采集器来寻找关键字,再根据图书资源进行爬取,完成的。

对于被采集的平台要进行一个对比。从爬虫思路来讲,问答平台相对于文章来说,更为注重问题的质量,问题下的内容更准确的表达了用户的真实意愿。所以,首先需要在问答平台进行人工抓取,将爬虫的结果以正则表达式的形式进行批量处理。然后在分析原始文章中的关键字即可进行爬取。

什么是关键词文章采集工具主流文章分析工具介绍?

采集交流 • 优采云 发表了文章 • 0 个评论 • 236 次浏览 • 2021-03-22 21:06

关键词文章采集工具主流文章分析工具具体如下:

1、百度统计这是我们经常看到的工具,它可以很直观的得到每篇文章的权重以及文章阅读量、点赞量等数据。

2、360网络监控这是一款可以监控和统计网站上所有文章数据的工具,查看的结果很直观。

3、优采云这是一款很好用的免费机器人,可以帮助我们找到隐藏比较深的链接,全文覆盖、seo优化、标题伪原创、关键词布局等文章分析工具。

4、ptengine能够自动采集、翻译、分词、聚合,多种合成等操作,精确性、无缝度、快速度等都有保障。