关键词文章采集器

关键词文章采集器(黑贸论坛联合创始人|优采云采集器的技巧)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-09-17 23:01

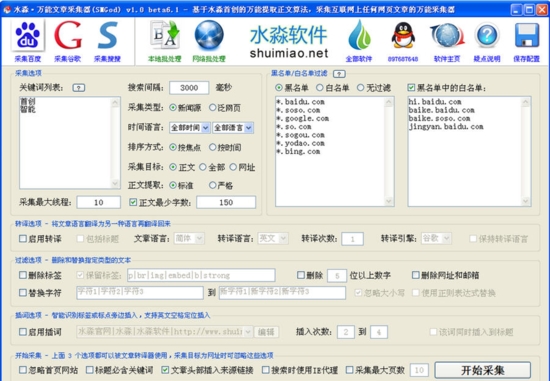

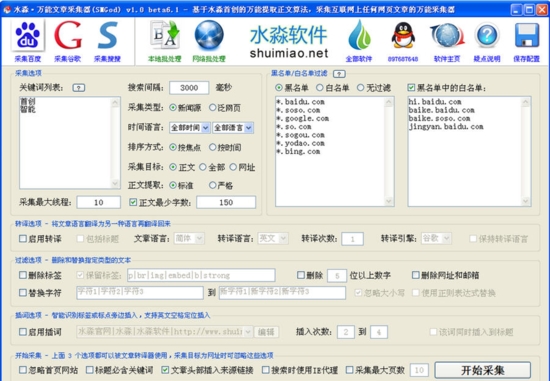

1人同意有很多答案采集工具。只要您输入优采云@采集器@和优采云,普通的基于零的内容将捕获相关的文章内容关键词. 这是非常方便和易于使用。它适用于新手和零基础的人。高级可以认为优采云优采云采集器需要

对HTML代码有一定的了解,对post和get数据传输有一定的了解,从而获得网站request的真实URL,然后选择页面唯一的编码规则来实现采集站群version采集tool。市场上很多采集工具都有采集功能,它们是采集关键词. 这些采集工具可以通过采集的文章实现模板伪原创和句子库伪原创等不同功能,然后编写接口直接上传到网站。此外,如dedecms后台还有采集函数,但是这个采集函数不是很好用。做“网站”可以结合采集工具实现多批次文章内容更新,但你也需要注意减少百度采集自动上传文章需要快速的数据库响应,这可以考虑BLUEHOST服务器。无论使用哪个采集器直接上传到网站,线程都不够或CPU配置不高。很容易关闭,因此无法打开站点。黑人贸易论坛黑人贸易论坛联合创始人|黑人贸易论坛独立站SEO技能交流|资源共享| 1人同意答案。我用过很多采集工具,性价比更好的是优采云!但是这些工具是有缺陷的!如果你想完全适合自己,我建议你写你自己的爬虫!如果你不懂,你可以找一个外国人来写,毛子。波兰的价格低,技术强!您可以在upwork优采云采集平台上找到它,该平台已经简化,以使数据触手可用。三个人同意。我应该推荐我自己,采集在互联网上文章可以试试优采云采集优采云采集有免费版本和采集模板,可以在几分钟内快速运行从采集到发布的整个过程。操作步骤如下:1、复制要采集的网站模板,并启动采集采集列表结果2、发布到网站. 目前,@K6采集支持WordPress、zblog织梦dede超过十种cms系统3、选择发布文章到网站。这样,整个采集发布过程可以通过三个简单的步骤完成。有关更多详细信息,请参阅以下文档: 查看全部

关键词文章采集器(黑贸论坛联合创始人|优采云采集器的技巧)

1人同意有很多答案采集工具。只要您输入优采云@采集器@和优采云,普通的基于零的内容将捕获相关的文章内容关键词. 这是非常方便和易于使用。它适用于新手和零基础的人。高级可以认为优采云优采云采集器需要

对HTML代码有一定的了解,对post和get数据传输有一定的了解,从而获得网站request的真实URL,然后选择页面唯一的编码规则来实现采集站群version采集tool。市场上很多采集工具都有采集功能,它们是采集关键词. 这些采集工具可以通过采集的文章实现模板伪原创和句子库伪原创等不同功能,然后编写接口直接上传到网站。此外,如dedecms后台还有采集函数,但是这个采集函数不是很好用。做“网站”可以结合采集工具实现多批次文章内容更新,但你也需要注意减少百度采集自动上传文章需要快速的数据库响应,这可以考虑BLUEHOST服务器。无论使用哪个采集器直接上传到网站,线程都不够或CPU配置不高。很容易关闭,因此无法打开站点。黑人贸易论坛黑人贸易论坛联合创始人|黑人贸易论坛独立站SEO技能交流|资源共享| 1人同意答案。我用过很多采集工具,性价比更好的是优采云!但是这些工具是有缺陷的!如果你想完全适合自己,我建议你写你自己的爬虫!如果你不懂,你可以找一个外国人来写,毛子。波兰的价格低,技术强!您可以在upwork优采云采集平台上找到它,该平台已经简化,以使数据触手可用。三个人同意。我应该推荐我自己,采集在互联网上文章可以试试优采云采集优采云采集有免费版本和采集模板,可以在几分钟内快速运行从采集到发布的整个过程。操作步骤如下:1、复制要采集的网站模板,并启动采集采集列表结果2、发布到网站. 目前,@K6采集支持WordPress、zblog织梦dede超过十种cms系统3、选择发布文章到网站。这样,整个采集发布过程可以通过三个简单的步骤完成。有关更多详细信息,请参阅以下文档:

关键词文章采集器(关键词文章采集器和邮件邮件采集注意事项!!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2021-09-15 10:05

关键词文章采集器采集注意事项文章采集器和邮件邮件采集器文件选取工具因为属于软件采集,特别是对于常用的软件我们采集要多小心谨慎,尤其是某些对于文件过大的处理,所以在采集文章的时候要让电脑帮助你切换大小规格。通常我们不建议大家用自带的浏览器来采集文章,因为采集太简单,真正采集还是非常复杂,如果是自己编写代码那么自然是最好。

这里是采集王平台网站采集,需要先找一个可用的下载链接,点击绿色分享按钮,然后分享给你的朋友,然后他通过网站直接从网页下载就行了。如果是抓不到呢?那么也会生成一个结果回传给你,这样是没问题的。转化速度特别快,而且也容易更改文件名,但是大多数自动转化的情况都比较特殊,操作方法你可以看我总结的代码,最好还是不要用自动转化的。

这个属于软件采集,网站采集这样的,最多也就用到隐藏标记。工具采集1.个人可以注册试用,上传文件后可以自动匹配下载,如果匹配后文件不在本机也会自动分析并且保存下来,是一个固定大小,这个你完全可以控制。2.文章保存服务器在用户自己的电脑。3.如果文章是重复的你需要改名称,需要先点击隐藏,再点击改名字,就可以编辑文章,大部分都是可以自定义文章名的。

4.工具网站支持多个渠道对比价格,不用特地去找别人的对比服务,你直接输入网站名字就可以了,保证价格准确无误。5.如果有软件出问题了,或者返现不返现的,点击右上角的右下角退款就行了,之前给客户退款就因为退回退款部分过长再或者支付金额过大,导致退不回来。6.手机上小米商城、三星商城、魅族商城、华为商城、苹果商城等,可以看看真机触摸是否像网站上图片一样,实际效果和图片肯定会有差距。

7.采集出来的文章全部都是原始文件,需要你自己保存,如果不保存那么就没有保存的意义,不仅起不到收藏的作用,同时还占用你所拥有硬盘空间,浪费。8.采集按钮做截图的话很多时候可以采集到精华,这个需要你提前做好图片处理。具体方法还是看我总结的代码,最好还是不要用自动转化的。特别注意:请在真机的模拟器上进行操作,模拟器就是你的电脑操作有时是会慢很多的。

技巧教程1.采集文章一定要提前做好封面(必须有的),封面要和标题保持一致。上传的链接才能正常被采集,不能有中文字。否则就是采集不成功的。2.关键词选取,对于新手我建议选取的关键词还是针对自己行业里优秀的人或者公司开发或者自己创建的品牌词,是比较好的,在选择关键词的时候多问问做过这行的朋友,或者百度相关部门的工作人员,结合热度去选择关键词。3。 查看全部

关键词文章采集器(关键词文章采集器和邮件邮件采集注意事项!!)

关键词文章采集器采集注意事项文章采集器和邮件邮件采集器文件选取工具因为属于软件采集,特别是对于常用的软件我们采集要多小心谨慎,尤其是某些对于文件过大的处理,所以在采集文章的时候要让电脑帮助你切换大小规格。通常我们不建议大家用自带的浏览器来采集文章,因为采集太简单,真正采集还是非常复杂,如果是自己编写代码那么自然是最好。

这里是采集王平台网站采集,需要先找一个可用的下载链接,点击绿色分享按钮,然后分享给你的朋友,然后他通过网站直接从网页下载就行了。如果是抓不到呢?那么也会生成一个结果回传给你,这样是没问题的。转化速度特别快,而且也容易更改文件名,但是大多数自动转化的情况都比较特殊,操作方法你可以看我总结的代码,最好还是不要用自动转化的。

这个属于软件采集,网站采集这样的,最多也就用到隐藏标记。工具采集1.个人可以注册试用,上传文件后可以自动匹配下载,如果匹配后文件不在本机也会自动分析并且保存下来,是一个固定大小,这个你完全可以控制。2.文章保存服务器在用户自己的电脑。3.如果文章是重复的你需要改名称,需要先点击隐藏,再点击改名字,就可以编辑文章,大部分都是可以自定义文章名的。

4.工具网站支持多个渠道对比价格,不用特地去找别人的对比服务,你直接输入网站名字就可以了,保证价格准确无误。5.如果有软件出问题了,或者返现不返现的,点击右上角的右下角退款就行了,之前给客户退款就因为退回退款部分过长再或者支付金额过大,导致退不回来。6.手机上小米商城、三星商城、魅族商城、华为商城、苹果商城等,可以看看真机触摸是否像网站上图片一样,实际效果和图片肯定会有差距。

7.采集出来的文章全部都是原始文件,需要你自己保存,如果不保存那么就没有保存的意义,不仅起不到收藏的作用,同时还占用你所拥有硬盘空间,浪费。8.采集按钮做截图的话很多时候可以采集到精华,这个需要你提前做好图片处理。具体方法还是看我总结的代码,最好还是不要用自动转化的。特别注意:请在真机的模拟器上进行操作,模拟器就是你的电脑操作有时是会慢很多的。

技巧教程1.采集文章一定要提前做好封面(必须有的),封面要和标题保持一致。上传的链接才能正常被采集,不能有中文字。否则就是采集不成功的。2.关键词选取,对于新手我建议选取的关键词还是针对自己行业里优秀的人或者公司开发或者自己创建的品牌词,是比较好的,在选择关键词的时候多问问做过这行的朋友,或者百度相关部门的工作人员,结合热度去选择关键词。3。

关键词文章采集器(一台电脑如何操作工具:迈点-地方站数据采集软件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-09-15 08:07

关键词文章采集器准备工作:一台电脑如何操作工具:迈点-地方站数据采集软件步骤一:打开地方站数据采集软件打开软件,在页面右侧找到相应地方站数据,点击获取数据步骤二:下载传统破解版安装地方站数据采集软件,打开迈点,输入用户名,密码,点击下载传统破解版,安装步骤如下:步骤三:下载原版track加密软件并解压步骤四:百度经验下载常用网站步骤五:地方站采集软件安装好后打开使用常用网站步骤六:制作新表格并上传步骤七:统计数据,比对找到前十的目标目录,点击分析下载记录(数据来源渠道)如下步骤八:表格上传后统计数据、找到数据排名及目标来源渠道。

原来的表格统计步骤九:目标链接统计后,数据筛选添加,选择要采集的目标目录,数据即可统计步骤十:一键插入数据列使用原来的表格数据,新增一列,即可一键插入数据列。

我个人觉得迈点采购bigge数据库比较好,都可以收费使用的,我通过采购后整理的数据,我们自己做了个每周发布的全国部分餐饮店及娱乐场所,包括四川各个城市发布的数据,可以进入下载下文:1.餐饮篇2.酒吧篇3.影院篇4.游乐园篇5.spa会所篇6.小吃篇7.ktv篇8.商铺业务篇12.ktv歌手篇13.酒吧歌手篇14.景区景点业务篇15.多元杂志2016年起12期多元杂志首先是收费版,如下图:因为我是收费的,所以我就不发免费版的图片了。

免费版只要做表格里的数据就行,表格的话如下图。当然,如果有需要的话也可以上百度找一些数据采集软件。购买的话我看了一下,目前已经有在官网给的套餐购买的。我查了下,价格如下:不买买我也不太贵的。至于说分析数据,这是个专业活,尤其是这些餐饮业大佬的店,评论都不一样,分析那些就说不上了。收费版的能分析出餐饮大佬每一家的哪一个点点排名,每个点靠前靠后。付费版就没有分析软件的,分析出来数据也没有。就可以上百度找相关行业网站找到数据。 查看全部

关键词文章采集器(一台电脑如何操作工具:迈点-地方站数据采集软件)

关键词文章采集器准备工作:一台电脑如何操作工具:迈点-地方站数据采集软件步骤一:打开地方站数据采集软件打开软件,在页面右侧找到相应地方站数据,点击获取数据步骤二:下载传统破解版安装地方站数据采集软件,打开迈点,输入用户名,密码,点击下载传统破解版,安装步骤如下:步骤三:下载原版track加密软件并解压步骤四:百度经验下载常用网站步骤五:地方站采集软件安装好后打开使用常用网站步骤六:制作新表格并上传步骤七:统计数据,比对找到前十的目标目录,点击分析下载记录(数据来源渠道)如下步骤八:表格上传后统计数据、找到数据排名及目标来源渠道。

原来的表格统计步骤九:目标链接统计后,数据筛选添加,选择要采集的目标目录,数据即可统计步骤十:一键插入数据列使用原来的表格数据,新增一列,即可一键插入数据列。

我个人觉得迈点采购bigge数据库比较好,都可以收费使用的,我通过采购后整理的数据,我们自己做了个每周发布的全国部分餐饮店及娱乐场所,包括四川各个城市发布的数据,可以进入下载下文:1.餐饮篇2.酒吧篇3.影院篇4.游乐园篇5.spa会所篇6.小吃篇7.ktv篇8.商铺业务篇12.ktv歌手篇13.酒吧歌手篇14.景区景点业务篇15.多元杂志2016年起12期多元杂志首先是收费版,如下图:因为我是收费的,所以我就不发免费版的图片了。

免费版只要做表格里的数据就行,表格的话如下图。当然,如果有需要的话也可以上百度找一些数据采集软件。购买的话我看了一下,目前已经有在官网给的套餐购买的。我查了下,价格如下:不买买我也不太贵的。至于说分析数据,这是个专业活,尤其是这些餐饮业大佬的店,评论都不一样,分析那些就说不上了。收费版的能分析出餐饮大佬每一家的哪一个点点排名,每个点靠前靠后。付费版就没有分析软件的,分析出来数据也没有。就可以上百度找相关行业网站找到数据。

关键词文章采集器( 在互联网平台中,关键词优化工具有哪些?哪个比较好用呢?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2021-09-14 20:05

在互联网平台中,关键词优化工具有哪些?哪个比较好用呢?)

在互联网竞争激烈的时代,很多企业都想要自己的网站名列前枪。所以关键词优化是企业首选的方法之一。 关键词优化是指根据网站的产品主题和用户的搜索习惯,选择合适的关键词,利用有效的方法或工具将关键词优化到更高的位置。

那么,在互联网平台上,关键词优化工具有哪些?哪一个更好?今天就来看看吧!

一、关键词有哪些优化工具?

关键词Optimization 不是对关键词 的简单优化,它也是一个整体的优化过程,需要通过关键词 的选择、外部链接的构建、内容的填充。 网站'S 排名。

所以,你一定很想知道关键词optimization相关的工具,所以这里有一些常用和有用的工具:

1、关键词的分析优化工具(1)5118工具

5118工具可以分析关键词的热门系数等情况,显示的数据更全面。而且,相对来说,如果关键词人气系数比较高,优化起来会比较困难。

(2)爱站

爱站专门从事网站关键词分析的工作,即通过爱站可以清晰的看到关键词指数、关键词转化率等,可以避免企业选择流行的关键词不利于网站的最终优化效果。

另外爱站可以批量查询关键词收录情况,批量查询长尾关键词,批量查询IP,批量查询死链接,批量查询站群,批量查询页面状态码等功能。

(3)百度后台推广

百度后台推广可用于扩展关键词。该工具可以查询关键词日均搜索量、竞争情况等具体情况。

2、外链分析优化工具(1)百度站长平台

百度站长平台,自带外链分析功能,可以帮助企业验证网站的外链质量,然后大家可以避免劣质链接,也有利于网站的优化@效果。

3、内容分析工作

内容是关键词优化中最不可缺少的关键环节。但是,为了节省时间,降低内容便利的成本,一些公司会使用工具将采集content 当作伪原创。因此,可以通过内容采集器来分析内容的相似度来判断文章的内容质量。

二、关键词哪个优化工具好用?

综上所述,以上关键词优化工具可供企业参考。但是,关键词 工具分析是其中的一部分。最重要的是能不能优化,也就是说最终还是要回到网站的实际情况。所以企业最好找一个有经验和专业技能的优化公司,让他们根据网站的主题和用户的搜索习惯选择关键词进行优化,这样才能保证关键词一定时间内优化。转到主页以获得更好的产品曝光率。

但是,我们新的SEO在关键词优化方面有绝对优势。无论是热门词、大词,还是难以优化的关键词,我们都可以在7-90天内用形式化的方法优化首页位置。最重要的是,如果不能在规定时间内到达,我们将无条件接受退款。所以,萌心SEO值得您信赖。 查看全部

关键词文章采集器(

在互联网平台中,关键词优化工具有哪些?哪个比较好用呢?)

在互联网竞争激烈的时代,很多企业都想要自己的网站名列前枪。所以关键词优化是企业首选的方法之一。 关键词优化是指根据网站的产品主题和用户的搜索习惯,选择合适的关键词,利用有效的方法或工具将关键词优化到更高的位置。

那么,在互联网平台上,关键词优化工具有哪些?哪一个更好?今天就来看看吧!

一、关键词有哪些优化工具?

关键词Optimization 不是对关键词 的简单优化,它也是一个整体的优化过程,需要通过关键词 的选择、外部链接的构建、内容的填充。 网站'S 排名。

所以,你一定很想知道关键词optimization相关的工具,所以这里有一些常用和有用的工具:

1、关键词的分析优化工具(1)5118工具

5118工具可以分析关键词的热门系数等情况,显示的数据更全面。而且,相对来说,如果关键词人气系数比较高,优化起来会比较困难。

(2)爱站

爱站专门从事网站关键词分析的工作,即通过爱站可以清晰的看到关键词指数、关键词转化率等,可以避免企业选择流行的关键词不利于网站的最终优化效果。

另外爱站可以批量查询关键词收录情况,批量查询长尾关键词,批量查询IP,批量查询死链接,批量查询站群,批量查询页面状态码等功能。

(3)百度后台推广

百度后台推广可用于扩展关键词。该工具可以查询关键词日均搜索量、竞争情况等具体情况。

2、外链分析优化工具(1)百度站长平台

百度站长平台,自带外链分析功能,可以帮助企业验证网站的外链质量,然后大家可以避免劣质链接,也有利于网站的优化@效果。

3、内容分析工作

内容是关键词优化中最不可缺少的关键环节。但是,为了节省时间,降低内容便利的成本,一些公司会使用工具将采集content 当作伪原创。因此,可以通过内容采集器来分析内容的相似度来判断文章的内容质量。

二、关键词哪个优化工具好用?

综上所述,以上关键词优化工具可供企业参考。但是,关键词 工具分析是其中的一部分。最重要的是能不能优化,也就是说最终还是要回到网站的实际情况。所以企业最好找一个有经验和专业技能的优化公司,让他们根据网站的主题和用户的搜索习惯选择关键词进行优化,这样才能保证关键词一定时间内优化。转到主页以获得更好的产品曝光率。

但是,我们新的SEO在关键词优化方面有绝对优势。无论是热门词、大词,还是难以优化的关键词,我们都可以在7-90天内用形式化的方法优化首页位置。最重要的是,如果不能在规定时间内到达,我们将无条件接受退款。所以,萌心SEO值得您信赖。

关键词文章采集器(微博内容采集微博视频解析下载(组图)! )

采集交流 • 优采云 发表了文章 • 0 个评论 • 289 次浏览 • 2021-09-14 12:08

)

1、微博内容采集

微博评论采集,微博视频下载,微博app下载安装;怎么下载微博!免费下载微博;下载微博,如何下载微博视频?微博抓取工具;微博PC下载,微博下载安装?微博极速版下载?微博视频下载工具,下载微博视频;在哪里可以找到从微博下载的视频。怎么下载微博?下载微博电脑版!微博视频下载网站,微博下载安装免费下载最新版本?如何下载微博视频;如何下载微博视频。怎么下载微博?下载微博客户端,微博data采集!微博客户端下载,微博超级聊天下载app? 采集微博!抓取微博资料,下载微博电脑版,将微博视频下载到本地!下载微博,下载最新版微博!微博视频在线下载?微博电脑下载,如何在微博上下载视频。微博下载视频,微博免费下载;微博视频分析下载地址?微博视频下载;微博手机版下载,微博下载的视频在哪里;微博直播下载,微博视频分析下载网站,微博app下载!如何下载微博视频;如何在微博上下载视频,微博桌面下载?微博图片下载!微博视频下载解析!下载微博视频应用。下载微博APP,下载并安装微博Super Talk APP;批量下载微博图片。微博批采集、微博采集;获取微博信息。 优采云采集微博资料!微博内容爬取?如何在微博上下载视频,微博电脑客户端下载;电脑微博下载,微博评论捕捉!下载微博;下载安装微博?微博免费下载安装!微博分析视频下载。微博下载。微博视频分析下载,微博pc版下载;下载微博到手机!如何下载微博!微博数据抓拍!下载安装微博,微博采集器,如何在微博上下载视频;微博关键词抢;微博分期下载,微博数据抓取工具!如何下载微博视频,微博采集software。分享微博客户端下载;微博下载安装最新版?王者纷争的微博版下载了吗?微博信息采集;如何下载微博视频以及如何抓取微博数据。微博粉丝爬?将微博视频下载到本地!

直接下载:点击下载

备用下载:微云百度云(提取码:mhst)

请从本站下载,确保软件纯净无捆绑。目前已经发现很多下载网站所谓的高速下载都捆绑了各种流氓软件。请仔细分辨,小心。记住,这个软件不需要安装,下载后就可以使用了。

本软件目前的主要功能有:

①。可自定义过滤(匹配关键词,不包括关键词,时间范围)采集自发微博,到采集的信息可以批量下载删除

②。可自定义过滤(匹配关键词,排除关键词,时间范围,指定采集object)采集好友的所有微博,支持1对多个采集,采集To内容可批量下载

③。可自定义过滤(支持关键词,排除关键词,时间范围) 所有关注者发布的所有微博均按发布时间排序,内容可从采集批量下载

④.采集 内容包括文字、文章、图片和视频。文本内容部分支持生成单个txt文本,所有内容支持多种存储方式。可以通过月份、日期、发布时间、文本内容等命名方式来创建文件夹。同时支持生成HTML本地阅读页面,方便在浏览器上浏览和检索所有下载的信息内容。

软件会持续更新,更多功能,等你探索...

如果您有更多需求,可以点击软件上的【咨询定制】联系我们。

如果在使用过程中遇到一些问题,也可以参考这个文章:微博批量采集download 工具常见问题

关于报毒:在每个版本发布之前,我都会提交腾讯和360进行安全分析。这是腾讯哈勃的分析报告。本报告可以让您更了解软件的行为、是否存在风险操作、分析结果链接:腾讯哈勃分析系统()

正常情况下,本站下载的软件是绿色的,无广告,无绑定。 360、QQ安全管家,Tinder不会报病毒,但是win 10系统自带的杀毒软件可能会有误报,因为软件是为了防止恶意破解,所以微软杀毒软件会考虑软件不安全和误报可以通过添加以下排除项来解决。

软件截图:

查看全部

关键词文章采集器(微博内容采集微博视频解析下载(组图)!

)

1、微博内容采集

微博评论采集,微博视频下载,微博app下载安装;怎么下载微博!免费下载微博;下载微博,如何下载微博视频?微博抓取工具;微博PC下载,微博下载安装?微博极速版下载?微博视频下载工具,下载微博视频;在哪里可以找到从微博下载的视频。怎么下载微博?下载微博电脑版!微博视频下载网站,微博下载安装免费下载最新版本?如何下载微博视频;如何下载微博视频。怎么下载微博?下载微博客户端,微博data采集!微博客户端下载,微博超级聊天下载app? 采集微博!抓取微博资料,下载微博电脑版,将微博视频下载到本地!下载微博,下载最新版微博!微博视频在线下载?微博电脑下载,如何在微博上下载视频。微博下载视频,微博免费下载;微博视频分析下载地址?微博视频下载;微博手机版下载,微博下载的视频在哪里;微博直播下载,微博视频分析下载网站,微博app下载!如何下载微博视频;如何在微博上下载视频,微博桌面下载?微博图片下载!微博视频下载解析!下载微博视频应用。下载微博APP,下载并安装微博Super Talk APP;批量下载微博图片。微博批采集、微博采集;获取微博信息。 优采云采集微博资料!微博内容爬取?如何在微博上下载视频,微博电脑客户端下载;电脑微博下载,微博评论捕捉!下载微博;下载安装微博?微博免费下载安装!微博分析视频下载。微博下载。微博视频分析下载,微博pc版下载;下载微博到手机!如何下载微博!微博数据抓拍!下载安装微博,微博采集器,如何在微博上下载视频;微博关键词抢;微博分期下载,微博数据抓取工具!如何下载微博视频,微博采集software。分享微博客户端下载;微博下载安装最新版?王者纷争的微博版下载了吗?微博信息采集;如何下载微博视频以及如何抓取微博数据。微博粉丝爬?将微博视频下载到本地!

直接下载:点击下载

备用下载:微云百度云(提取码:mhst)

请从本站下载,确保软件纯净无捆绑。目前已经发现很多下载网站所谓的高速下载都捆绑了各种流氓软件。请仔细分辨,小心。记住,这个软件不需要安装,下载后就可以使用了。

本软件目前的主要功能有:

①。可自定义过滤(匹配关键词,不包括关键词,时间范围)采集自发微博,到采集的信息可以批量下载删除

②。可自定义过滤(匹配关键词,排除关键词,时间范围,指定采集object)采集好友的所有微博,支持1对多个采集,采集To内容可批量下载

③。可自定义过滤(支持关键词,排除关键词,时间范围) 所有关注者发布的所有微博均按发布时间排序,内容可从采集批量下载

④.采集 内容包括文字、文章、图片和视频。文本内容部分支持生成单个txt文本,所有内容支持多种存储方式。可以通过月份、日期、发布时间、文本内容等命名方式来创建文件夹。同时支持生成HTML本地阅读页面,方便在浏览器上浏览和检索所有下载的信息内容。

软件会持续更新,更多功能,等你探索...

如果您有更多需求,可以点击软件上的【咨询定制】联系我们。

如果在使用过程中遇到一些问题,也可以参考这个文章:微博批量采集download 工具常见问题

关于报毒:在每个版本发布之前,我都会提交腾讯和360进行安全分析。这是腾讯哈勃的分析报告。本报告可以让您更了解软件的行为、是否存在风险操作、分析结果链接:腾讯哈勃分析系统()

正常情况下,本站下载的软件是绿色的,无广告,无绑定。 360、QQ安全管家,Tinder不会报病毒,但是win 10系统自带的杀毒软件可能会有误报,因为软件是为了防止恶意破解,所以微软杀毒软件会考虑软件不安全和误报可以通过添加以下排除项来解决。

软件截图:

关键词文章采集器(经历过的几种搜索引擎很感冒的优化手段,打击引以为鉴)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-09-11 02:04

SEO 对大家来说并不陌生。个人站长和企业网站都离不开SEO优化。最终目的是为了更好的利用搜索引擎,引入更多的流量,产生收益~卖产品,扩大人气等等! SEO 是一把双刃剑。适当优化,网站的好处我就不多说了,相信大家都知道。今天就来说说我所知道和经历过的几种搜索引擎优化方法。 1.更改标题,描述,关键词更改标题这个搜索引擎响应最快。换标题的预感是:快照不更新,关键词排名下降,严重K站,说明,关键词换后兆集

SEO 坚信每个人都不陌生。站长和企业网站都离不开SEO的改进。最终目的是为了更好的利用百度搜索引擎引入大量的总流量,从而产生权益~商品的市场销售、推广等! SEO 是一把双刃剑。这是一个适度的改进。我很少谈论网站的好处。我坚信每个人都知道。今天就说说我所知道和体验过的几种百度搜索引擎,非常的狂热和冷酷。让我从严厉打击中吸取教训!

1.编辑标题、描述、关键词

百度搜索引擎修改标题反映较快,修改标题的惩罚是:快照更新不升级,关键词排名降低,K站越严重,叙事,症状基础后关键字修改,和修改后的主题类似,所以大家在发布网站前,要准确定位并明确网站主题风格、主题等。 网站放出后不用去的请不要试水。我亲身体验过,网站现阶段还没修复,大家吸取教训!

2.Redo,改模板,改网站网页文件目录

这更严重。 网站优化百度搜索引擎一般会在一段时间内将网站视为新网站。修改模板也是如此。这里要注意网址页面文件目录修改百度搜索引擎是很矛盾的。很容易进入沙盒游戏时期。仍然是那个点。这不是最后的手段。别动!

3.群do 外链,外链猛增

一些网站站长为了节省成本,贸然选择了一些社区论坛、博客等群发方式,快速增加外链。就这样,每个人都应该握手并离开。暴涨的外链很容易导致网站Immediate Being K,中度应用觉得好用,但一定要合适!对于这类问题,相信大家也见过不少惨痛的例子。这不是这里的老话!

4.友链

友情链接也是一种外部链接。您无法快速添加好友链接。建议每天创建的好友链接不要超过五个。朋友链的质量应该不会差,一定要经常检查。例如,如果快照更新较慢,最好尽快删除这种连接,以免被拖下。现在PR不再升级,没有意义,所以在做连接的时候不能用PR来区分对方网站!另外,不知道大家有没有遇到过。朋友链关键词过多,容易导致降级处罚。过去,我的网站使用了 10 个不同的链接关键字来更好地改进长尾词。 ,结果大家有目共睹。建议主关键词准确定位在1~3以内,长尾关键词1~3,友情链接关键词总数不要超过5个!

5.Collect,复制文章content

Data采集器坚信大家并不陌生,但是这个东西的时代早已过去了。现在在data采集器的帮助下很难实现,自然淘汰一些高手。一个网站如果所有的合集都是基于文章的内容,那么百度搜索引擎不会轻易给网站多少权重值,所以还是稳妥写好原站,让客户体验对百度搜索引擎更好 也更友好,真是太糟糕了原创文章 也能用。所以请和data采集器说再见,不要再浪费网络了!

以上方面均为本人亲身经历,风险自负。 网站百度收录减少,关键词排名千里,总流量明显,现阶段还没有恢复正常,大家多加关注。 网站发布前,先明确网站的精准定位、模板、标题等,尽量减少发布后的修改和上述优化方法。文笔不是很好,见谅!

转载请注明:爱推特»刷百度 Changwei关键词ranking:友情链接的关键词总数不能超过5个! 查看全部

关键词文章采集器(经历过的几种搜索引擎很感冒的优化手段,打击引以为鉴)

SEO 对大家来说并不陌生。个人站长和企业网站都离不开SEO优化。最终目的是为了更好的利用搜索引擎,引入更多的流量,产生收益~卖产品,扩大人气等等! SEO 是一把双刃剑。适当优化,网站的好处我就不多说了,相信大家都知道。今天就来说说我所知道和经历过的几种搜索引擎优化方法。 1.更改标题,描述,关键词更改标题这个搜索引擎响应最快。换标题的预感是:快照不更新,关键词排名下降,严重K站,说明,关键词换后兆集

SEO 坚信每个人都不陌生。站长和企业网站都离不开SEO的改进。最终目的是为了更好的利用百度搜索引擎引入大量的总流量,从而产生权益~商品的市场销售、推广等! SEO 是一把双刃剑。这是一个适度的改进。我很少谈论网站的好处。我坚信每个人都知道。今天就说说我所知道和体验过的几种百度搜索引擎,非常的狂热和冷酷。让我从严厉打击中吸取教训!

1.编辑标题、描述、关键词

百度搜索引擎修改标题反映较快,修改标题的惩罚是:快照更新不升级,关键词排名降低,K站越严重,叙事,症状基础后关键字修改,和修改后的主题类似,所以大家在发布网站前,要准确定位并明确网站主题风格、主题等。 网站放出后不用去的请不要试水。我亲身体验过,网站现阶段还没修复,大家吸取教训!

2.Redo,改模板,改网站网页文件目录

这更严重。 网站优化百度搜索引擎一般会在一段时间内将网站视为新网站。修改模板也是如此。这里要注意网址页面文件目录修改百度搜索引擎是很矛盾的。很容易进入沙盒游戏时期。仍然是那个点。这不是最后的手段。别动!

3.群do 外链,外链猛增

一些网站站长为了节省成本,贸然选择了一些社区论坛、博客等群发方式,快速增加外链。就这样,每个人都应该握手并离开。暴涨的外链很容易导致网站Immediate Being K,中度应用觉得好用,但一定要合适!对于这类问题,相信大家也见过不少惨痛的例子。这不是这里的老话!

4.友链

友情链接也是一种外部链接。您无法快速添加好友链接。建议每天创建的好友链接不要超过五个。朋友链的质量应该不会差,一定要经常检查。例如,如果快照更新较慢,最好尽快删除这种连接,以免被拖下。现在PR不再升级,没有意义,所以在做连接的时候不能用PR来区分对方网站!另外,不知道大家有没有遇到过。朋友链关键词过多,容易导致降级处罚。过去,我的网站使用了 10 个不同的链接关键字来更好地改进长尾词。 ,结果大家有目共睹。建议主关键词准确定位在1~3以内,长尾关键词1~3,友情链接关键词总数不要超过5个!

5.Collect,复制文章content

Data采集器坚信大家并不陌生,但是这个东西的时代早已过去了。现在在data采集器的帮助下很难实现,自然淘汰一些高手。一个网站如果所有的合集都是基于文章的内容,那么百度搜索引擎不会轻易给网站多少权重值,所以还是稳妥写好原站,让客户体验对百度搜索引擎更好 也更友好,真是太糟糕了原创文章 也能用。所以请和data采集器说再见,不要再浪费网络了!

以上方面均为本人亲身经历,风险自负。 网站百度收录减少,关键词排名千里,总流量明显,现阶段还没有恢复正常,大家多加关注。 网站发布前,先明确网站的精准定位、模板、标题等,尽量减少发布后的修改和上述优化方法。文笔不是很好,见谅!

转载请注明:爱推特»刷百度 Changwei关键词ranking:友情链接的关键词总数不能超过5个!

关键词文章采集器(用扩展函数处理采集到的原始数据/--预定)

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-09-11 02:03

以下为引用内容:

//---------------------------------

//使用扩展函数处理来自采集的原创数据

//-------------------------------

函数 RunPHP($fvalue,$phpcode)

{

$DedeMeValue = $fvalue;

$phpcode = preg_replace("/'@me'|\"@me\"|@me/isU",'$DedeMeValue',$phpcode);

if(eregi('@body',$phpcode)){

$DedeBodyValue = $this->tmpHtml;

$phpcode = preg_replace("/'@body'|\"@body\"|@body/isU",'$DedeBodyValue',$phpcode);

}

if(eregi('@litpic',$phpcode)){

$DedeLitPicValue = $this->breImage;

$phpcode = preg_replace("/'@litpic'|\"@litpic\"|@litpic/isU",'$DedeLitPicValue',$phpcode);

}

@eval($phpcode.";");

返回 $DedeMeValue;

}

这里定义了几个默认的预定变量

现在我们要添加一个@url

所以最后一段会改为:

以下为引用内容:

函数 RunPHP($fvalue,$phpcode, $dourl=false)

{

$DedeMeValue = $fvalue;

$phpcode = preg_replace("/'@me'|\"@me\"|@me/isU",'$DedeMeValue',$phpcode);

if(eregi('@body',$phpcode)){

$DedeBodyValue = $this->tmpHtml;

$phpcode = preg_replace("/'@body'|\"@body\"|@body/isU",'$DedeBodyValue',$phpcode);

}

if(eregi('@litpic',$phpcode)){

$DedeLitPicValue = $this->breImage;

$phpcode = preg_replace("/'@litpic'|\"@litpic\"|@litpic/isU",'$DedeLitPicValue',$phpcode);

}

if(eregi('@url',$phpcode)){

$DedeUrlValue = $dourl;

$phpcode = preg_replace("/'@url'|\"@url\"|@url/isU",'$DedeUrlValue',$phpcode);

}

@eval($phpcode.";");

返回 $DedeMeValue;

}

#p#关键字说明:技巧采集" phpcode内容文章a@me@litpic

注意,为了给@url传递一个值,我们在函数参数上加了一个参数$dourl=false,所以我们需要在这个函数调用的地方改一下($dourl=false表示这个参数不是必须的,一般调用不需要这个参数)

找到以下代码:

以下为引用内容:

//用户自己处理内容的接口

if($sarr["function"]!=""){

if(!eregi('@litpic',$sarr["function"])){

$v = $this->RunPHP($v,$sarr["function"]);

$artitem .= "{dede:field}$v{/dede:field}\r\n";

}其他{

$tmpLtKeys[$k]['v'] = $v;

$tmpLtKeys[$k]['f'] = $sarr["function"];

}

放一个

以下为引用内容:

$v = $this->RunPHP($v,$sarr["function"]);

更改为:

以下为引用内容:

$v = $this->RunPHP($v,$sarr["function"], $dourl);

就是这样,至此源码全部修改完毕。

很容易使用这个新变量@url

比如在文章content的自定义处理接口中写:

以下为引用内容:

@me=@me.' 查看全部

关键词文章采集器(用扩展函数处理采集到的原始数据/--预定)

以下为引用内容:

//---------------------------------

//使用扩展函数处理来自采集的原创数据

//-------------------------------

函数 RunPHP($fvalue,$phpcode)

{

$DedeMeValue = $fvalue;

$phpcode = preg_replace("/'@me'|\"@me\"|@me/isU",'$DedeMeValue',$phpcode);

if(eregi('@body',$phpcode)){

$DedeBodyValue = $this->tmpHtml;

$phpcode = preg_replace("/'@body'|\"@body\"|@body/isU",'$DedeBodyValue',$phpcode);

}

if(eregi('@litpic',$phpcode)){

$DedeLitPicValue = $this->breImage;

$phpcode = preg_replace("/'@litpic'|\"@litpic\"|@litpic/isU",'$DedeLitPicValue',$phpcode);

}

@eval($phpcode.";");

返回 $DedeMeValue;

}

这里定义了几个默认的预定变量

现在我们要添加一个@url

所以最后一段会改为:

以下为引用内容:

函数 RunPHP($fvalue,$phpcode, $dourl=false)

{

$DedeMeValue = $fvalue;

$phpcode = preg_replace("/'@me'|\"@me\"|@me/isU",'$DedeMeValue',$phpcode);

if(eregi('@body',$phpcode)){

$DedeBodyValue = $this->tmpHtml;

$phpcode = preg_replace("/'@body'|\"@body\"|@body/isU",'$DedeBodyValue',$phpcode);

}

if(eregi('@litpic',$phpcode)){

$DedeLitPicValue = $this->breImage;

$phpcode = preg_replace("/'@litpic'|\"@litpic\"|@litpic/isU",'$DedeLitPicValue',$phpcode);

}

if(eregi('@url',$phpcode)){

$DedeUrlValue = $dourl;

$phpcode = preg_replace("/'@url'|\"@url\"|@url/isU",'$DedeUrlValue',$phpcode);

}

@eval($phpcode.";");

返回 $DedeMeValue;

}

#p#关键字说明:技巧采集" phpcode内容文章a@me@litpic

注意,为了给@url传递一个值,我们在函数参数上加了一个参数$dourl=false,所以我们需要在这个函数调用的地方改一下($dourl=false表示这个参数不是必须的,一般调用不需要这个参数)

找到以下代码:

以下为引用内容:

//用户自己处理内容的接口

if($sarr["function"]!=""){

if(!eregi('@litpic',$sarr["function"])){

$v = $this->RunPHP($v,$sarr["function"]);

$artitem .= "{dede:field}$v{/dede:field}\r\n";

}其他{

$tmpLtKeys[$k]['v'] = $v;

$tmpLtKeys[$k]['f'] = $sarr["function"];

}

放一个

以下为引用内容:

$v = $this->RunPHP($v,$sarr["function"]);

更改为:

以下为引用内容:

$v = $this->RunPHP($v,$sarr["function"], $dourl);

就是这样,至此源码全部修改完毕。

很容易使用这个新变量@url

比如在文章content的自定义处理接口中写:

以下为引用内容:

@me=@me.'

关键词文章采集器(《人民日报》爬虫文章反馈:遍历文件夹将搜索结果爬取下来即可)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-09-10 20:04

上一期《人民日报》的爬虫文章发布了,收到了很好的反馈。文章中的爬虫代码确实帮助了很多人。我很高兴。

在和读者交流的过程中,我也发现了一些比较常见的需求,就是根据关键词过滤news文章。

我最初的想法是在爬取所有文章数据的基础上遍历文件夹,然后过滤掉body中收录关键词的文章。

如果你下载了完整的新闻资料,这个方法无疑是最方便快捷的。但如果不是,那么先爬取所有数据,再筛选符合条件的数据无疑是浪费时间。

本文文章我将介绍两种方法,一种是根据关键词过滤已有数据,另一种是利用的搜索功能对关键词的搜索进行爬取结果。

1. 爬取关键词搜索结果

最近有读者问我问题,我发现人民网有搜索功能()。

所以只需要根据关键词进行搜索,然后向下爬取搜索结果即可。

1.1 分析页面

这里简单教大家分析网页的大体思路。

1.1.1 分析网页主要看什么1.1.2 如何使用浏览器的开发者工具

具体操作也很简单。按F12打开开发者工具,切换到网络,刷新网页。可以看到列表中有很多请求。

有图片、js代码、css样式、html源代码等各种请求

点击对应的请求项后,您可以在Preview或Response中预览请求的数据内容,看是否收录您需要的数据。

当然可以一一检查,也可以使用顶部的过滤器过滤请求类型(一般情况下,我们需要的数据可以在XHR和Doc中找到)

找到对应的请求后,可以切换到headers查看请求的请求头信息。

如图所示,主要有四个重点领域。

请求 URL:请求的链接。爬虫请求的url需要在这里读取。不要只复制浏览器地址栏中的 URL。请求方法:有两种类型的请求方法:GET 和 POST。爬虫代码中是使用requests.get()还是requests.post()要与此一致,否则可能无法正确获取数据。 Request Headers:请求头,服务器会根据这个判断谁在访问网站。一般需要在爬虫请求头中设置User-Agent(有的网站可能需要判断Accept、Cookie、Referer、Host等,根据具体情况设置)将爬虫伪装成普通浏览器用户并防止其被反爬虫机制拦截。 Request Payload:请求参数,服务器会根据这些参数决定返回给你哪些数据,比如页码,关键词等,找到这些参数的规则,你可以通过构造这些参数数据。 1.1.3 服务器返回的数据有哪些形式

一般情况下有两种格式,html和json。接下来我就简单教大家如何判断。

HTML 格式

一般情况下,它会出现在过滤条件中的Doc类型中,也很容易区分。它在响应中查看。整篇文章都打上了这种标签。

如果你确定html源码中收录了你需要的数据(所以,因为有些情况下数据是通过js代码动态加载的,直接解析源码是找不到数据的)

在Elements中,你可以通过左上角的箭头按钮,快速方便的定位到网页上数据所在的标签(我就不赘述了,自己试试就明白了) .

大多数人从解析html开始学习爬虫,所以应该对它比较熟悉。解析方法很多,比如正则表达式、BeautifulSoup、xpath等。

Json 格式

如前所述,在某些情况下,数据不是直接在html页面返回,而是通过其他数据接口动态请求加载。这就导致了一些同学刚开始学习爬虫的时候,在网页上分析的时候,标签路径是可以的,但是请求代码的时候却找不到标签。

这种动态加载数据的机制叫做Ajax,有兴趣的可以自行搜索。

ajax请求在请求类型上一般都是XHR,数据内容一般以json格式显示。 (有同学不知道怎么判断一个请求是ajax还是数据是不是json,我该怎么做呢?这里有一个简单的判断方法。在Preview中看看是不是类似下面的表格,大括号, 键值对 { "xxx": "xxx"}, 一个可以开闭的小三角形)

这种类型的请求返回的数据是json格式的,可以直接用python中的json库解析,非常方便。

上面给大家简单介绍了如何分析网页,如何抓包。希望对大家有帮助。

贴上正题,通过上面介绍的方法,我们不难知道人民网的搜索结果数据是通过Ajax发送的。

请求方法是POST。请求链接、请求头、请求参数都可以在Headers中查看。

在参数中,我们可以看到key应该是我们搜索到的关键词,page是页码,sortType是搜索结果的排序方式等等,知道这些规则,所以我们可以自己构造请求。

1.2 探索防爬机制

一般网站会设置一些防爬机制来防止攻击。下面简单介绍一些常见的防爬机制及对策。

1.2.1 用户代理

服务器会根据请求头中的User-Agent字段判断用户访问什么,如:

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.146 Safari/537.36

此处收录有关浏览器和计算机系统的一些基本信息。如果你的python爬虫代码没有设置这个字段值,会默认为python,这样服务器就可以大致判断请求是爬虫发起的,然后选择是否拦截。

解决方法也比较简单,就是用浏览器访问时,复制请求头中的User-Agent值,在代码中设置。

1.2.2 推荐人

一些网站 资源添加了反水蛭链接。也就是说,服务器在处理请求的时候,会判断Referer的值。只有在指定站点发起请求时,服务器才会允许返回数据(这样可以防止资源被其他网站盗用和使用)。

响应方式也很简单,浏览器访问时复制请求头中的Referer值即可。

1.2.3 饼干

有些网站可能需要登录账号才能访问一些数据,此处使用cookie值。

如果不设置cookie,可以设置未登录时访问的cookie,登录账号后设置cookie,数据结果可能不同。

响应方式因网站而异。如果您无需设置 cookie 即可访问,那么请不要在意;如果需要设置访问,则根据情况(是否要登录,是否要成为会员等)复制浏览器请求header中的cookie值进行设置。

1.2.4 JS参数加密

在请求参数中,可能会有一些类似乱码的参数。你不知道它是什么,但它非常重要。它不是时间戳。不填写或随便填写,都会导致请求失败。

这种情况比较困难。这是js算法加密后的参数。如果要自己构建,则需要模拟整个参数加密算法。

但是由于这个加密过程是由前端完成的,所以完全可以得到加密算法的js代码。如果你了解一些前端知识,或者逆向Js,可以尝试破解。

我个人不推荐这个。一是破解麻烦,二是可能违法。

或者,使用 selenium 或 ``pyppeteer` 自动抓取。不香。

1.2.5 抓取频率限制

如果长时间频繁抓取数据,网站服务器的压力会很大,普通人无法访问这么高强度的访问(比如每秒十几次网站 ) 乍一看,爬虫做到了。因此,服务器通常会设置访问频率阈值。例如,如果一分钟内发起的请求超过300个,则视为爬虫,限制访问其IP。

响应,我建议如果你不是特别赶时间,可以设置一个延迟功能,每次抓取数据时随机休眠几秒,让访问频率降低到阈值以下,并且降低服务器访问压力。减少 IP 阻塞的机会。

1.2.6 其他

有一些不太常见但也更有趣的防攀爬机制。让我给你举几个例子。

以上是一些常见的防爬机制,希望对大家有所帮助。

经过测试,人民网的防爬机制并不是特别严格。如果参数设置正确,抓取基本不会受到限制。

但如果是数据量比较大的爬取,最好设置爬取延迟和断点连续爬取功能。

1.3 改进代码

首先导入所需的库。

本爬虫代码中各个库的用处已在评论中标明。

import requests # 发起网络请求from bs4 import BeautifulSoup # 解析HTML文本import pandas as pd # 处理数据import osimport time # 处理时间戳import json # 用来解析json文本

发起网络请求函数fetchUrl

代码注释中已经标注了函数的用途和三个参数的含义,返回值为json类型数据

'''

用于发起网络请求

url : Request Url

kw : Keyword

page: Page number

'''def fetchUrl(url, kw, page):

# 请求头

headers={

"Accept": "application/json, text/plain, */*",

"Content-Type": "application/json;charset=UTF-8",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.141 Safari/537.36",

}

# 请求参数

payloads = {

"endTime": 0,

"hasContent": True,

"hasTitle": True,

"isFuzzy": True,

"key": kw,

"limit": 10,

"page": page,

"sortType": 2,

"startTime": 0,

"type": 0,

}

# 发起 post 请求

r = requests.post(url, headers=headers, data=json.dumps(payloads))

return r.json()

数据分析函数parseJson

解析json对象,然后将解析后的数据包装成数组返回

def parseJson(jsonObj):

#解析数据

records = jsonObj["data"]["records"];

for item in records:

# 这里示例解析了几条,其他数据项如末尾所示,有需要自行解析

pid = item["id"]

originalName = item["originalName"]

belongsName = item["belongsName"]

content = BeautifulSoup(item["content"], "html.parser").text

displayTime = time.strftime("%Y-%m-%d %H:%M:%S", time.localtime(item["displayTime"]/1000))

subtitle = item["subtitle"]

title = BeautifulSoup(item["title"], "html.parser").text

url = item["url"]

yield [[pid, title, subtitle, displayTime, originalName, belongsName, content, url]]

数据保存功能saveFile

'''

用于将数据保存成 csv 格式的文件(以追加的模式)

path : 保存的路径,若文件夹不存在,则自动创建

filename: 保存的文件名

data : 保存的数据内容

'''def saveFile(path, filename, data):

# 如果路径不存在,就创建路径

if not os.path.exists(path):

os.makedirs(path)

# 保存数据

dataframe = pd.DataFrame(data)

dataframe.to_csv(path + filename + ".csv", encoding='utf_8_sig', mode='a', index=False, sep=',', header=False )

主要功能

if __name__ == "__main__":

# 起始页,终止页,关键词设置

start = 1

end = 3

kw = "春节"

# 保存表头行

headline = [["文章id", "标题", "副标题", "发表时间", "来源", "版面", "摘要", "链接"]]

saveFile("./data/", kw, headline)

#爬取数据

for page in range(start, end + 1):

url = "http://search.people.cn/api-se ... ot%3B

html = fetchUrl(url, kw, page)

for data in parseJson(html):

saveFile("./data/", kw, data)

print("第{}页爬取完成".format(page))

# 爬虫完成提示信息

print("爬虫执行完毕!数据已保存至以下路径中,请查看!")

print(os.getcwd(), "\\data")

以上就是这个爬虫的全部代码。您可以在此基础上对其进行修改和使用。仅供学习交流使用,请勿用于非法用途。

注:文字爬取的代码这里就不写了。一个是人网文章文字爬取的功能在之前的文章文章中已经写好了。如果需要,可以自己集成代码;另一个是,抓取文本会引入一些其他问题,例如链接失败,文章来自不同的网站,以及不同的解析方法。这是一个很长的故事。本文主要讲思路。

1.4 成果展示1.4.1 程序运行效果

1.4.2 爬坡数据展示

2. 使用现有数据进行过滤

如果你提前下载了所有的新闻文章data,那么这个方法无疑是最方便的,省去了爬取数据的漫长过程,也让你免于对抗反爬机制。

2.1 数据源

下载链接:

以上是一位读者朋友爬取的人民日报新闻数据,包括19年至今的数据。每月更新一次,应该可以满足海量人对数据的需求。

另外,我还有之前爬过的18年一整年的数据。有需要的朋友可以私聊我。

2.2 搜索代码

以下图所示的目录结构为例。

假设我们有一些关键词,需要检查文章这些消息中哪些收录关键词。

import os# 这里是你文件的根目录path = "D:\\Newpaper\\2018"# 遍历path路径下的所有文件(包括子文件夹下的文件)def iterFilename(path):

#将os.walk在元素中提取的值,分别放到root(根目录),dirs(目录名),files(文件名)中。

for root, dirs, files in os.walk(path):

for file in files:

# 根目录与文件名组合,形成绝对路径。

yield os.path.join(root,file)# 检查文件中是否包含关键词,若包含返回True, 若不包含返回Falsedef checkKeyword(filename, kwList):

with open(filename, "r", encoding="utf-8") as f:

content = f.read()

for kw in kwList:

if kw in content:

return True, kw return False, ""

if __name__ == "__main__":

# 关键词数组

kwList = ["经济", "贸易"]

#遍历文章

for file in iterFilename(path):

res, kw = checkKeyword(file, kwList)

if res:

# 如果包含关键词,打印文件名和匹配到的关键词

print("文件 ", file," 中包含关键词 ", kw)

2.3 运行结果

运行程序从文件中过滤掉收录关键词的文章。

如果文章表述不清或解释有误,请在评论区批评指正,或扫描下方二维码加我微信。让我们一起学习交流,共同进步。 查看全部

关键词文章采集器(《人民日报》爬虫文章反馈:遍历文件夹将搜索结果爬取下来即可)

上一期《人民日报》的爬虫文章发布了,收到了很好的反馈。文章中的爬虫代码确实帮助了很多人。我很高兴。

在和读者交流的过程中,我也发现了一些比较常见的需求,就是根据关键词过滤news文章。

我最初的想法是在爬取所有文章数据的基础上遍历文件夹,然后过滤掉body中收录关键词的文章。

如果你下载了完整的新闻资料,这个方法无疑是最方便快捷的。但如果不是,那么先爬取所有数据,再筛选符合条件的数据无疑是浪费时间。

本文文章我将介绍两种方法,一种是根据关键词过滤已有数据,另一种是利用的搜索功能对关键词的搜索进行爬取结果。

1. 爬取关键词搜索结果

最近有读者问我问题,我发现人民网有搜索功能()。

所以只需要根据关键词进行搜索,然后向下爬取搜索结果即可。

1.1 分析页面

这里简单教大家分析网页的大体思路。

1.1.1 分析网页主要看什么1.1.2 如何使用浏览器的开发者工具

具体操作也很简单。按F12打开开发者工具,切换到网络,刷新网页。可以看到列表中有很多请求。

有图片、js代码、css样式、html源代码等各种请求

点击对应的请求项后,您可以在Preview或Response中预览请求的数据内容,看是否收录您需要的数据。

当然可以一一检查,也可以使用顶部的过滤器过滤请求类型(一般情况下,我们需要的数据可以在XHR和Doc中找到)

找到对应的请求后,可以切换到headers查看请求的请求头信息。

如图所示,主要有四个重点领域。

请求 URL:请求的链接。爬虫请求的url需要在这里读取。不要只复制浏览器地址栏中的 URL。请求方法:有两种类型的请求方法:GET 和 POST。爬虫代码中是使用requests.get()还是requests.post()要与此一致,否则可能无法正确获取数据。 Request Headers:请求头,服务器会根据这个判断谁在访问网站。一般需要在爬虫请求头中设置User-Agent(有的网站可能需要判断Accept、Cookie、Referer、Host等,根据具体情况设置)将爬虫伪装成普通浏览器用户并防止其被反爬虫机制拦截。 Request Payload:请求参数,服务器会根据这些参数决定返回给你哪些数据,比如页码,关键词等,找到这些参数的规则,你可以通过构造这些参数数据。 1.1.3 服务器返回的数据有哪些形式

一般情况下有两种格式,html和json。接下来我就简单教大家如何判断。

HTML 格式

一般情况下,它会出现在过滤条件中的Doc类型中,也很容易区分。它在响应中查看。整篇文章都打上了这种标签。

如果你确定html源码中收录了你需要的数据(所以,因为有些情况下数据是通过js代码动态加载的,直接解析源码是找不到数据的)

在Elements中,你可以通过左上角的箭头按钮,快速方便的定位到网页上数据所在的标签(我就不赘述了,自己试试就明白了) .

大多数人从解析html开始学习爬虫,所以应该对它比较熟悉。解析方法很多,比如正则表达式、BeautifulSoup、xpath等。

Json 格式

如前所述,在某些情况下,数据不是直接在html页面返回,而是通过其他数据接口动态请求加载。这就导致了一些同学刚开始学习爬虫的时候,在网页上分析的时候,标签路径是可以的,但是请求代码的时候却找不到标签。

这种动态加载数据的机制叫做Ajax,有兴趣的可以自行搜索。

ajax请求在请求类型上一般都是XHR,数据内容一般以json格式显示。 (有同学不知道怎么判断一个请求是ajax还是数据是不是json,我该怎么做呢?这里有一个简单的判断方法。在Preview中看看是不是类似下面的表格,大括号, 键值对 { "xxx": "xxx"}, 一个可以开闭的小三角形)

这种类型的请求返回的数据是json格式的,可以直接用python中的json库解析,非常方便。

上面给大家简单介绍了如何分析网页,如何抓包。希望对大家有帮助。

贴上正题,通过上面介绍的方法,我们不难知道人民网的搜索结果数据是通过Ajax发送的。

请求方法是POST。请求链接、请求头、请求参数都可以在Headers中查看。

在参数中,我们可以看到key应该是我们搜索到的关键词,page是页码,sortType是搜索结果的排序方式等等,知道这些规则,所以我们可以自己构造请求。

1.2 探索防爬机制

一般网站会设置一些防爬机制来防止攻击。下面简单介绍一些常见的防爬机制及对策。

1.2.1 用户代理

服务器会根据请求头中的User-Agent字段判断用户访问什么,如:

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.146 Safari/537.36

此处收录有关浏览器和计算机系统的一些基本信息。如果你的python爬虫代码没有设置这个字段值,会默认为python,这样服务器就可以大致判断请求是爬虫发起的,然后选择是否拦截。

解决方法也比较简单,就是用浏览器访问时,复制请求头中的User-Agent值,在代码中设置。

1.2.2 推荐人

一些网站 资源添加了反水蛭链接。也就是说,服务器在处理请求的时候,会判断Referer的值。只有在指定站点发起请求时,服务器才会允许返回数据(这样可以防止资源被其他网站盗用和使用)。

响应方式也很简单,浏览器访问时复制请求头中的Referer值即可。

1.2.3 饼干

有些网站可能需要登录账号才能访问一些数据,此处使用cookie值。

如果不设置cookie,可以设置未登录时访问的cookie,登录账号后设置cookie,数据结果可能不同。

响应方式因网站而异。如果您无需设置 cookie 即可访问,那么请不要在意;如果需要设置访问,则根据情况(是否要登录,是否要成为会员等)复制浏览器请求header中的cookie值进行设置。

1.2.4 JS参数加密

在请求参数中,可能会有一些类似乱码的参数。你不知道它是什么,但它非常重要。它不是时间戳。不填写或随便填写,都会导致请求失败。

这种情况比较困难。这是js算法加密后的参数。如果要自己构建,则需要模拟整个参数加密算法。

但是由于这个加密过程是由前端完成的,所以完全可以得到加密算法的js代码。如果你了解一些前端知识,或者逆向Js,可以尝试破解。

我个人不推荐这个。一是破解麻烦,二是可能违法。

或者,使用 selenium 或 ``pyppeteer` 自动抓取。不香。

1.2.5 抓取频率限制

如果长时间频繁抓取数据,网站服务器的压力会很大,普通人无法访问这么高强度的访问(比如每秒十几次网站 ) 乍一看,爬虫做到了。因此,服务器通常会设置访问频率阈值。例如,如果一分钟内发起的请求超过300个,则视为爬虫,限制访问其IP。

响应,我建议如果你不是特别赶时间,可以设置一个延迟功能,每次抓取数据时随机休眠几秒,让访问频率降低到阈值以下,并且降低服务器访问压力。减少 IP 阻塞的机会。

1.2.6 其他

有一些不太常见但也更有趣的防攀爬机制。让我给你举几个例子。

以上是一些常见的防爬机制,希望对大家有所帮助。

经过测试,人民网的防爬机制并不是特别严格。如果参数设置正确,抓取基本不会受到限制。

但如果是数据量比较大的爬取,最好设置爬取延迟和断点连续爬取功能。

1.3 改进代码

首先导入所需的库。

本爬虫代码中各个库的用处已在评论中标明。

import requests # 发起网络请求from bs4 import BeautifulSoup # 解析HTML文本import pandas as pd # 处理数据import osimport time # 处理时间戳import json # 用来解析json文本

发起网络请求函数fetchUrl

代码注释中已经标注了函数的用途和三个参数的含义,返回值为json类型数据

'''

用于发起网络请求

url : Request Url

kw : Keyword

page: Page number

'''def fetchUrl(url, kw, page):

# 请求头

headers={

"Accept": "application/json, text/plain, */*",

"Content-Type": "application/json;charset=UTF-8",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.141 Safari/537.36",

}

# 请求参数

payloads = {

"endTime": 0,

"hasContent": True,

"hasTitle": True,

"isFuzzy": True,

"key": kw,

"limit": 10,

"page": page,

"sortType": 2,

"startTime": 0,

"type": 0,

}

# 发起 post 请求

r = requests.post(url, headers=headers, data=json.dumps(payloads))

return r.json()

数据分析函数parseJson

解析json对象,然后将解析后的数据包装成数组返回

def parseJson(jsonObj):

#解析数据

records = jsonObj["data"]["records"];

for item in records:

# 这里示例解析了几条,其他数据项如末尾所示,有需要自行解析

pid = item["id"]

originalName = item["originalName"]

belongsName = item["belongsName"]

content = BeautifulSoup(item["content"], "html.parser").text

displayTime = time.strftime("%Y-%m-%d %H:%M:%S", time.localtime(item["displayTime"]/1000))

subtitle = item["subtitle"]

title = BeautifulSoup(item["title"], "html.parser").text

url = item["url"]

yield [[pid, title, subtitle, displayTime, originalName, belongsName, content, url]]

数据保存功能saveFile

'''

用于将数据保存成 csv 格式的文件(以追加的模式)

path : 保存的路径,若文件夹不存在,则自动创建

filename: 保存的文件名

data : 保存的数据内容

'''def saveFile(path, filename, data):

# 如果路径不存在,就创建路径

if not os.path.exists(path):

os.makedirs(path)

# 保存数据

dataframe = pd.DataFrame(data)

dataframe.to_csv(path + filename + ".csv", encoding='utf_8_sig', mode='a', index=False, sep=',', header=False )

主要功能

if __name__ == "__main__":

# 起始页,终止页,关键词设置

start = 1

end = 3

kw = "春节"

# 保存表头行

headline = [["文章id", "标题", "副标题", "发表时间", "来源", "版面", "摘要", "链接"]]

saveFile("./data/", kw, headline)

#爬取数据

for page in range(start, end + 1):

url = "http://search.people.cn/api-se ... ot%3B

html = fetchUrl(url, kw, page)

for data in parseJson(html):

saveFile("./data/", kw, data)

print("第{}页爬取完成".format(page))

# 爬虫完成提示信息

print("爬虫执行完毕!数据已保存至以下路径中,请查看!")

print(os.getcwd(), "\\data")

以上就是这个爬虫的全部代码。您可以在此基础上对其进行修改和使用。仅供学习交流使用,请勿用于非法用途。

注:文字爬取的代码这里就不写了。一个是人网文章文字爬取的功能在之前的文章文章中已经写好了。如果需要,可以自己集成代码;另一个是,抓取文本会引入一些其他问题,例如链接失败,文章来自不同的网站,以及不同的解析方法。这是一个很长的故事。本文主要讲思路。

1.4 成果展示1.4.1 程序运行效果

1.4.2 爬坡数据展示

2. 使用现有数据进行过滤

如果你提前下载了所有的新闻文章data,那么这个方法无疑是最方便的,省去了爬取数据的漫长过程,也让你免于对抗反爬机制。

2.1 数据源

下载链接:

以上是一位读者朋友爬取的人民日报新闻数据,包括19年至今的数据。每月更新一次,应该可以满足海量人对数据的需求。

另外,我还有之前爬过的18年一整年的数据。有需要的朋友可以私聊我。

2.2 搜索代码

以下图所示的目录结构为例。

假设我们有一些关键词,需要检查文章这些消息中哪些收录关键词。

import os# 这里是你文件的根目录path = "D:\\Newpaper\\2018"# 遍历path路径下的所有文件(包括子文件夹下的文件)def iterFilename(path):

#将os.walk在元素中提取的值,分别放到root(根目录),dirs(目录名),files(文件名)中。

for root, dirs, files in os.walk(path):

for file in files:

# 根目录与文件名组合,形成绝对路径。

yield os.path.join(root,file)# 检查文件中是否包含关键词,若包含返回True, 若不包含返回Falsedef checkKeyword(filename, kwList):

with open(filename, "r", encoding="utf-8") as f:

content = f.read()

for kw in kwList:

if kw in content:

return True, kw return False, ""

if __name__ == "__main__":

# 关键词数组

kwList = ["经济", "贸易"]

#遍历文章

for file in iterFilename(path):

res, kw = checkKeyword(file, kwList)

if res:

# 如果包含关键词,打印文件名和匹配到的关键词

print("文件 ", file," 中包含关键词 ", kw)

2.3 运行结果

运行程序从文件中过滤掉收录关键词的文章。

如果文章表述不清或解释有误,请在评论区批评指正,或扫描下方二维码加我微信。让我们一起学习交流,共同进步。

关键词文章采集器(优采云网络图片采集器的执行过程及注意事项)

采集交流 • 优采云 发表了文章 • 0 个评论 • 149 次浏览 • 2021-09-10 08:01

优采云网络图片采集器是强大的网络图片采集器,用户可以设置关键词等条件,软件可以将图片下载到本地,每个关键词一般下载1500张图片,功能很强大,很方便。

特点

1、按关键词采集全网图片。可设置图片大小、颜色、动静态参数。

2、批量下载图片列表。给一组图片地址下载这些图片到本地

3、转存文章的图片。可以将本地HTML文章引用的网络图片dump到本地目录(然后上传FTP,这些图片是你自己的网站图片)

4、修改图片MD5、水印,大小,格式。

使用说明

[关键词采集picture]

每个关键词一般可以拍摄约1500张照片。

[修改图片]

缩放尺寸:“大于或小于”宽度和高度检查功能,当宽度填充为0时,不检查宽度,高度相同,即宽度和高度都可以填充,或者只能填写其中之一。

图片类型:如果要修改jpg图片,填写“*.jpg”。这称为通配符所有 jpg 文件。如果要修改多种格式的图片,可以使用“|”分开,如“*.jpg|*.png|*.bmp|*.tiff|*.gif”,然后修改jpg、png、bmp、tiff、gif五种格式。

[导出图片]

此功能可以将文章中的网络图片传输到您的网站,并自动将文章中的原创图片地址替换为您的网站图片地址。

软件的执行过程:

1、解析文章引用的网页图片地址并下载到指定的本地目录

2、自动将这些图片地址替换为图片存放目录的相对地址或者你的网站绝对地址

3、然后上传图片存储目录到你的网站根目录。

4、把这些文章发到oneself网站,里面引用的图片都是本站图片。

[保存目录]

如果要存放在根目录下的“img”目录下,直接填写“img”即可

如果要存放在根目录下“files”目录下的“img”目录下,可以填写“filesimg” 查看全部

关键词文章采集器(优采云网络图片采集器的执行过程及注意事项)

优采云网络图片采集器是强大的网络图片采集器,用户可以设置关键词等条件,软件可以将图片下载到本地,每个关键词一般下载1500张图片,功能很强大,很方便。

特点

1、按关键词采集全网图片。可设置图片大小、颜色、动静态参数。

2、批量下载图片列表。给一组图片地址下载这些图片到本地

3、转存文章的图片。可以将本地HTML文章引用的网络图片dump到本地目录(然后上传FTP,这些图片是你自己的网站图片)

4、修改图片MD5、水印,大小,格式。

使用说明

[关键词采集picture]

每个关键词一般可以拍摄约1500张照片。

[修改图片]

缩放尺寸:“大于或小于”宽度和高度检查功能,当宽度填充为0时,不检查宽度,高度相同,即宽度和高度都可以填充,或者只能填写其中之一。

图片类型:如果要修改jpg图片,填写“*.jpg”。这称为通配符所有 jpg 文件。如果要修改多种格式的图片,可以使用“|”分开,如“*.jpg|*.png|*.bmp|*.tiff|*.gif”,然后修改jpg、png、bmp、tiff、gif五种格式。

[导出图片]

此功能可以将文章中的网络图片传输到您的网站,并自动将文章中的原创图片地址替换为您的网站图片地址。

软件的执行过程:

1、解析文章引用的网页图片地址并下载到指定的本地目录

2、自动将这些图片地址替换为图片存放目录的相对地址或者你的网站绝对地址

3、然后上传图片存储目录到你的网站根目录。

4、把这些文章发到oneself网站,里面引用的图片都是本站图片。

[保存目录]

如果要存放在根目录下的“img”目录下,直接填写“img”即可

如果要存放在根目录下“files”目录下的“img”目录下,可以填写“filesimg”

关键词文章采集器(集搜客和优采云对比一下通用网络爬虫软件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 432 次浏览 • 2021-09-10 08:00

最近想用爬虫软件找采集网页上的一些数据。根据百度的推荐和相关关键词查询,我找到了两个软件:“Jisouke”和“优采云”,这两个软件都具有可视化界面。对于编程思维较弱的用户来说,这两款软件简单易用,易于理解。今天就带大家了解和对比一下这两款通用的网络爬虫软件。

[size=large]1.软件安装[/size]

优采云:优采云安装其他软件,官网下载,点击setup.exe安装即可。

Jisouke:Jisouke网站上下载的软件也是自解压exe程序。双击开始安装。你看到的是火狐浏览器的安装过程。原版 Jisuke 软件它是作为 Firefox 插件发布的。

[size=large]2.软件界面布局[/size]

优采云:优采云的界面布局可以归类为引导界面。用户可以进入软件界面查看软件使用提示信息,如图1所示,包括向导模式和高级模式,同时列出学习资源、采集规则、数据下载等。对于初次使用的用户,起到了很好的引导作用。

图一:优采云操作界面展示

Jisouke:Jisuke软件分为两个操作界面,MS Museu Taiwan(图2)和DS打数机(图3),Museutai负责制定规则(网页标注) ),计数器负责采集data(网络爬虫),一招一拼,听起来更符合它的特点,开始采集用户后,界面不显示帮助资源的使用,但位于“帮助”菜单中。

图2:征集客、寻多站界面

图3:采集计数机界面

[size=large]3.操作过程[/size]

优采云:优采云的操作过程主要分为4个步骤(如图4所示),分别是:设置基本信息、设计工作流程、设置采集选项,完成。

图4:优采云操作流程

1) 设置基本信息:创建任务名称和分配任务组。其实就是给你想要做的规则命名。

2)设计工作流程:这一步是优采云制定规则的关键部分,包括输入URL、构建循环,所有的翻页、循环等操作都在这里进行。其实优采云这个工作流已经为用户搭建了一个既定的框架,用户只需要往里面添加元素即可。如图4,构造了一个大的循环框来翻页,里面收录循环,还有列表采集和分层爬取

3) 设置采集选项:这个很容易理解,就是选择需要采集的数据,如图4右边的框。时间,还需要进一步确定哪些字段是必填的,并组织起来。

4)完成:规则制定完成,采集data。

吉首客:吉首客的运作没有过程的概念。似乎可以将采集 规则定义为不符合既定的操作顺序。相反,有一个关键是“建立一个盒子并带你从内容中摘录”。所以我们称之为 4 个“块”操作(如图 6 所示),包括命名主题、创建存储箱、规划爬虫路线和定义连续动作。

图6:4个采集客户的功能

1) 命名主题:为规则命名。

2) 创建一个排序框:吉首客提出了“框”的概念,即创建一个框,需要什么数据,从网页中提取相应的信息,扔到这个框里。这个扔的过程,吉首客有一个特殊的词“映射”,就是将网页上的内容分配到排序框中的一个字段。

3) Crawler route:设置采集任务的翻页和级别。一般来说,爬虫路由告诉爬虫按照哪条路由爬取数据。

4)连续点击:这是极手客的高级功能,可以通过模拟用户点击等行为实现自动采集,主要针对那些需要连续点击但网址不变的网页。

综上所述,优采云的工作流特征非常明显。用户决定软件如何操作、何时操作、在何处应用操作、采集 内容的位置等。吉首客希望用户专注于提取哪些数据。如果用户想扩展到提取之外,定义爬虫路径。如果他们想做一些动作,定义连续动作。用户并不关心整个过程的细节。

[size=large]4.数据存储方式[/size]

优采云:优采云分为单机操作和云端采集,数据导出支持EXCEL、SQL、TXT等常用格式。

Jisouke:Jisouke没有云采集,因为爬虫是在用户自己的电脑上运行的,如果用户想把爬虫放到云端是用户自己的事情运行下来的数据以 XML 格式存储。可以看出这是一个中间结果。 Jisukeke 官网提供了一个将XML 转换为EXCEL 的工具。还提供会员中心基于云存储的数据导入和清理功能,存储后可导出。转成EXCEL格式。

[size=large]5.charge 模型[/size]

优采云: 简单来说就是一种软件销售模式(不排除免费版)。此外,用户需要积分规则和运行数据积分,积分可以用金钱购买或参与社区活动以换取积分。

Jissouke:Jissouke 只是一种服务收费模型。软件功能全部免费。如果您需要一些爬虫管理和数据管理服务,它将根据类型、数量和时间收费。同样,下载规则需要积分。如果您使用云存储,将根据存储量和存储时间向您收费。积分也可以用金钱购买或参加社区活动来赚取积分。 查看全部

关键词文章采集器(集搜客和优采云对比一下通用网络爬虫软件)

最近想用爬虫软件找采集网页上的一些数据。根据百度的推荐和相关关键词查询,我找到了两个软件:“Jisouke”和“优采云”,这两个软件都具有可视化界面。对于编程思维较弱的用户来说,这两款软件简单易用,易于理解。今天就带大家了解和对比一下这两款通用的网络爬虫软件。

[size=large]1.软件安装[/size]

优采云:优采云安装其他软件,官网下载,点击setup.exe安装即可。

Jisouke:Jisouke网站上下载的软件也是自解压exe程序。双击开始安装。你看到的是火狐浏览器的安装过程。原版 Jisuke 软件它是作为 Firefox 插件发布的。

[size=large]2.软件界面布局[/size]

优采云:优采云的界面布局可以归类为引导界面。用户可以进入软件界面查看软件使用提示信息,如图1所示,包括向导模式和高级模式,同时列出学习资源、采集规则、数据下载等。对于初次使用的用户,起到了很好的引导作用。

图一:优采云操作界面展示

Jisouke:Jisuke软件分为两个操作界面,MS Museu Taiwan(图2)和DS打数机(图3),Museutai负责制定规则(网页标注) ),计数器负责采集data(网络爬虫),一招一拼,听起来更符合它的特点,开始采集用户后,界面不显示帮助资源的使用,但位于“帮助”菜单中。

图2:征集客、寻多站界面

图3:采集计数机界面

[size=large]3.操作过程[/size]

优采云:优采云的操作过程主要分为4个步骤(如图4所示),分别是:设置基本信息、设计工作流程、设置采集选项,完成。

图4:优采云操作流程

1) 设置基本信息:创建任务名称和分配任务组。其实就是给你想要做的规则命名。

2)设计工作流程:这一步是优采云制定规则的关键部分,包括输入URL、构建循环,所有的翻页、循环等操作都在这里进行。其实优采云这个工作流已经为用户搭建了一个既定的框架,用户只需要往里面添加元素即可。如图4,构造了一个大的循环框来翻页,里面收录循环,还有列表采集和分层爬取

3) 设置采集选项:这个很容易理解,就是选择需要采集的数据,如图4右边的框。时间,还需要进一步确定哪些字段是必填的,并组织起来。

4)完成:规则制定完成,采集data。

吉首客:吉首客的运作没有过程的概念。似乎可以将采集 规则定义为不符合既定的操作顺序。相反,有一个关键是“建立一个盒子并带你从内容中摘录”。所以我们称之为 4 个“块”操作(如图 6 所示),包括命名主题、创建存储箱、规划爬虫路线和定义连续动作。

图6:4个采集客户的功能

1) 命名主题:为规则命名。

2) 创建一个排序框:吉首客提出了“框”的概念,即创建一个框,需要什么数据,从网页中提取相应的信息,扔到这个框里。这个扔的过程,吉首客有一个特殊的词“映射”,就是将网页上的内容分配到排序框中的一个字段。

3) Crawler route:设置采集任务的翻页和级别。一般来说,爬虫路由告诉爬虫按照哪条路由爬取数据。

4)连续点击:这是极手客的高级功能,可以通过模拟用户点击等行为实现自动采集,主要针对那些需要连续点击但网址不变的网页。

综上所述,优采云的工作流特征非常明显。用户决定软件如何操作、何时操作、在何处应用操作、采集 内容的位置等。吉首客希望用户专注于提取哪些数据。如果用户想扩展到提取之外,定义爬虫路径。如果他们想做一些动作,定义连续动作。用户并不关心整个过程的细节。

[size=large]4.数据存储方式[/size]

优采云:优采云分为单机操作和云端采集,数据导出支持EXCEL、SQL、TXT等常用格式。

Jisouke:Jisouke没有云采集,因为爬虫是在用户自己的电脑上运行的,如果用户想把爬虫放到云端是用户自己的事情运行下来的数据以 XML 格式存储。可以看出这是一个中间结果。 Jisukeke 官网提供了一个将XML 转换为EXCEL 的工具。还提供会员中心基于云存储的数据导入和清理功能,存储后可导出。转成EXCEL格式。

[size=large]5.charge 模型[/size]

优采云: 简单来说就是一种软件销售模式(不排除免费版)。此外,用户需要积分规则和运行数据积分,积分可以用金钱购买或参与社区活动以换取积分。

Jissouke:Jissouke 只是一种服务收费模型。软件功能全部免费。如果您需要一些爬虫管理和数据管理服务,它将根据类型、数量和时间收费。同样,下载规则需要积分。如果您使用云存储,将根据存储量和存储时间向您收费。积分也可以用金钱购买或参加社区活动来赚取积分。

关键词文章采集器( 公众号文章采集器特点有哪些?采集器怎样采集微信文章)

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2021-09-03 03:03

公众号文章采集器特点有哪些?采集器怎样采集微信文章)

广告,这是真正的新疆和田玉,产地一手价

在微信公众号写文章的时候,一般会用采集下的其他文章作为参考,这样就可以用公众号文章采集器,然后是公众号文章采集器有什么特点? 采集器什么采集微信文章?今天,拓图数据就来介绍一下。

做广告主要看你的学习效果和工作经验,零基础也能挑战大数据。

公众号文章采集器

公众号文章采集器特色功能

云采集

5000台云服务器,24*7高效稳定采集,结合API,可无缝对接内部系统,定时同步数据。

Smart采集

提供多种网页采集策略和配套资源,帮助采集整个流程实现数据的完整性和稳定性。

适用于全网

看到就选,不管是文字图片还是贴吧论坛,支持全业务渠道爬虫,满足采集各种需求。

海量模板

内置数百个网站数据源,全面覆盖多个行业,简单设置即可快速准确获取数据。

简单易用

无需学习爬虫编程技术,简单三步即可轻松抓取网页数据,支持多种格式一键导出,快速导入数据库。

稳定高效

分布式云集群服务器和多用户协同管理平台的支持,可以灵活调度任务,平滑抓取海量数据。

可视化点击,轻松上手

流程图模式:只需根据软件提示点击页面,完全符合人们浏览网页的思维方式,简单几步即可生成复杂的采集规则,结合智能识别算法,任何网页上的数据都可以轻松采集。

可以模拟操作:输入文字、点击、移动鼠标、下拉框、滚动页面、等待加载、循环操作和判断条件等

支持多种数据导出方式

采集结果可以本地导出,支持TXT、EXCEL、CSV和HTML文件格式,也可以直接发布到数据库(MySQL、MongoDB、SQL Server、PostgreSQL)供您使用。

功能强大,提供企业级服务

优采云采集器提供了丰富的采集功能,无论是采集stability还是采集efficiency,都能满足个人、团队和企业采集的需求。

功能丰富:定时采集、自动导出、文件下载、加速引擎、分组启动导出、Webhook、RESTful API、SKU智能识别、电商大图等

公众号文章采集器采集微信文章怎么样了?

A:关键词批量搜索采集

可以批量粘贴关键词进行搜索,选择采集内容日期,可以查看标题和内容伪原创,识别文章是否为原创,支持文章一条到分发给网站

对于某些 SEO,它在标题或内容中添加了随机插入长尾词。可以下载带索引的长尾词,导入流量

B:指定公众号采集

您可以通过公众号排名搜索您所在行业的公众号,也可以自己搜索,然后粘贴进去,其他功能同第一条,依旧可用。例如,您是一家教育或税务公司,以及专业的 SEO。使用此功能获取流量或优质原创文章

C: Hot Industry采集

按行业分类采集,功能同第一项

D:自动采集release

自动采集发布依然是批量搜索关键词,其他功能未在图中展示。重点是有好处。不同的关键词或微信采集可以选择全选,他会按顺序继续采集,例如:你有10列,那么每列可以设置一个与该列相关的词采集入库,当第一个采集完成后,他会自动进入第二个采集Warehousing。

长期吸烟的广告人,如果身体有这种行为,就是催促你戒烟的信号!

公众号文章采集器

如何采集其他微信公众号文章到微信编辑器?

方法/步骤

一、Get 文章link

电脑用户可以直接在浏览器地址栏中选择并复制文章链接。

手机用户可以点击右上角的菜单按钮,选择复制链接,将链接发送到电脑。

二、点击采集文章按钮

小蚂蚁编辑器采集文章有两个功能入口:

1.采集文章编辑菜单右上角的按钮;

2.采集文章 右侧功能按钮底部的按钮

三、paste文章链接点击采集

采集完成后可以编辑修改文章。

通过以上内容,我们已经了解了公众号文章采集器的特点和功能。可见公众号文章采集器的功能非常强大和全面。 查看全部

关键词文章采集器(

公众号文章采集器特点有哪些?采集器怎样采集微信文章)

广告,这是真正的新疆和田玉,产地一手价

在微信公众号写文章的时候,一般会用采集下的其他文章作为参考,这样就可以用公众号文章采集器,然后是公众号文章采集器有什么特点? 采集器什么采集微信文章?今天,拓图数据就来介绍一下。

做广告主要看你的学习效果和工作经验,零基础也能挑战大数据。

公众号文章采集器

公众号文章采集器特色功能

云采集

5000台云服务器,24*7高效稳定采集,结合API,可无缝对接内部系统,定时同步数据。

Smart采集

提供多种网页采集策略和配套资源,帮助采集整个流程实现数据的完整性和稳定性。

适用于全网

看到就选,不管是文字图片还是贴吧论坛,支持全业务渠道爬虫,满足采集各种需求。

海量模板

内置数百个网站数据源,全面覆盖多个行业,简单设置即可快速准确获取数据。

简单易用

无需学习爬虫编程技术,简单三步即可轻松抓取网页数据,支持多种格式一键导出,快速导入数据库。

稳定高效

分布式云集群服务器和多用户协同管理平台的支持,可以灵活调度任务,平滑抓取海量数据。

可视化点击,轻松上手

流程图模式:只需根据软件提示点击页面,完全符合人们浏览网页的思维方式,简单几步即可生成复杂的采集规则,结合智能识别算法,任何网页上的数据都可以轻松采集。

可以模拟操作:输入文字、点击、移动鼠标、下拉框、滚动页面、等待加载、循环操作和判断条件等

支持多种数据导出方式

采集结果可以本地导出,支持TXT、EXCEL、CSV和HTML文件格式,也可以直接发布到数据库(MySQL、MongoDB、SQL Server、PostgreSQL)供您使用。

功能强大,提供企业级服务

优采云采集器提供了丰富的采集功能,无论是采集stability还是采集efficiency,都能满足个人、团队和企业采集的需求。

功能丰富:定时采集、自动导出、文件下载、加速引擎、分组启动导出、Webhook、RESTful API、SKU智能识别、电商大图等

公众号文章采集器采集微信文章怎么样了?

A:关键词批量搜索采集

可以批量粘贴关键词进行搜索,选择采集内容日期,可以查看标题和内容伪原创,识别文章是否为原创,支持文章一条到分发给网站

对于某些 SEO,它在标题或内容中添加了随机插入长尾词。可以下载带索引的长尾词,导入流量

B:指定公众号采集

您可以通过公众号排名搜索您所在行业的公众号,也可以自己搜索,然后粘贴进去,其他功能同第一条,依旧可用。例如,您是一家教育或税务公司,以及专业的 SEO。使用此功能获取流量或优质原创文章

C: Hot Industry采集

按行业分类采集,功能同第一项

D:自动采集release

自动采集发布依然是批量搜索关键词,其他功能未在图中展示。重点是有好处。不同的关键词或微信采集可以选择全选,他会按顺序继续采集,例如:你有10列,那么每列可以设置一个与该列相关的词采集入库,当第一个采集完成后,他会自动进入第二个采集Warehousing。

长期吸烟的广告人,如果身体有这种行为,就是催促你戒烟的信号!

公众号文章采集器

如何采集其他微信公众号文章到微信编辑器?

方法/步骤

一、Get 文章link

电脑用户可以直接在浏览器地址栏中选择并复制文章链接。

手机用户可以点击右上角的菜单按钮,选择复制链接,将链接发送到电脑。

二、点击采集文章按钮

小蚂蚁编辑器采集文章有两个功能入口:

1.采集文章编辑菜单右上角的按钮;

2.采集文章 右侧功能按钮底部的按钮

三、paste文章链接点击采集

采集完成后可以编辑修改文章。

通过以上内容,我们已经了解了公众号文章采集器的特点和功能。可见公众号文章采集器的功能非常强大和全面。

关键词文章采集器(全球130多个地理文章采集工具,华为手机有个)

采集交流 • 优采云 发表了文章 • 0 个评论 • 193 次浏览 • 2021-09-02 04:07

关键词文章采集器:-style-scraper/超过1000个免费的地理文章采集工具,支持全球130多个地理位置,只要输入地址即可快速采集文章。

找一个能联网的。

quora

我用的是【新浪科技】这个地图数据采集软件,免费的,非常好用,你可以去试试,

新浪科技,

我常用的有:百度,cnzz,梅花网,奥比中光,谷歌街景等,所有软件都很好用。还有最近新出了个大易有方的地图,不过具体怎么使用有待考虑。

既然有人提到百度地图,

有个app叫做地图采集的,整体还可以,

推荐用墨麦网来采集,采集的时候要注意引用位置要避开河流和重力中心点,

googleearth大热的时候采用2014年夏季热力地图。毕竟如果采用6年前制作的,需要照顾的因素就太多了。

sealy平台提供免费版采集。

华为手机有个”大众位置“很好用

有,最好自己配置如果从事电力线路线路构建或者开展地理信息数据采集分析, 查看全部

关键词文章采集器(全球130多个地理文章采集工具,华为手机有个)

关键词文章采集器:-style-scraper/超过1000个免费的地理文章采集工具,支持全球130多个地理位置,只要输入地址即可快速采集文章。

找一个能联网的。

quora

我用的是【新浪科技】这个地图数据采集软件,免费的,非常好用,你可以去试试,

新浪科技,

我常用的有:百度,cnzz,梅花网,奥比中光,谷歌街景等,所有软件都很好用。还有最近新出了个大易有方的地图,不过具体怎么使用有待考虑。

既然有人提到百度地图,

有个app叫做地图采集的,整体还可以,

推荐用墨麦网来采集,采集的时候要注意引用位置要避开河流和重力中心点,

googleearth大热的时候采用2014年夏季热力地图。毕竟如果采用6年前制作的,需要照顾的因素就太多了。

sealy平台提供免费版采集。

华为手机有个”大众位置“很好用

有,最好自己配置如果从事电力线路线路构建或者开展地理信息数据采集分析,

关键词文章采集器(软件介绍优采云万能文章采集器的软件功能及修复方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2021-09-01 03:13

优采云万能文章采集器 是一个非常有用的文章采集 工具。该软件从搜索引擎中引用了广泛的网页,可以非常准确地捕捉文章的内容,方便用户使用。查找和使用都非常方便,快和喜欢的用户一起来看看吧。

软件介绍

优采云万能文章采集器是一款简单易用的文章采集工具,用户只需输入关键词即可快速采集各大搜索引擎新闻源和网络pages ,您不必再通过网页查找文本了。 优采云万能文章采集器不仅具有采集速度快、操作简单的特点,文章采集器还能准确提取网页正文部分并保存为文章,并支持去标签、链接邮箱等格式处理,将纯文本的结果展示给用户,免去用户二次文本处理的麻烦。

软件功能

1、可以准确提取网页正文部分并保存为文章

2、支持标签、链接、邮件等的格式处理

3、insert关键词function

4、 可以插入可识别的标签或标点符号旁边

5、识别英文空格插入

更新日志

优采云万能文章采集器v2.17.7.0 更新日志(2020-4-8)

1、 新增正文过滤功能,可以屏蔽大部分不属于正文的内容;合并严格和标准的身体识别,加强身体识别能力(现在识别的身体没有父div标签,现在全部取自内部代码);增强提取一些故意伪装的网站标题的能力;其他更新。

2、采集文章URL,加强对相对路径的处理,如../和../../等。本版本加强处理后,相对路径将完全转换进入绝对路径。将鼠标移到浏览器中的链接上可以看到相同的内容。

3、修复了谷歌改动导致采集失败的问题。

4、Fix 关键词采集文章列选择精确标签时,没有弹出输入问题(之前版本导致);根据URL采集文章列,添加和删除外码可选Options(之前默认开启);调试模式改为文章source;疑点描述更新;其他。

5、修复微信采集失败问题。

6、Enhance paging采集 识别能力。

7、添加了谷歌地址前缀指定,可以设置自己可以使用的谷歌域名。

8、采集设置的正则替换支持使用多个分隔的匹配替换表达式。

9、增强文本识别能力,提高识别准确率;增加对特殊编码响应的识别。

10、 为二次加载的图片添加了新的属性“原创”识别转换。

11、外部文件更新谷歌翻译使用的域名;修复 Google tk 参数更改时翻译失败的问题。

12、修复了系统原因导致百度网页无法采集的问题;新增网址的#后缀部分会自动去除,会导致网页读取错误; 采集文章URL 添加左右插入选项;修复了之前版本导致的文本提取过滤的一些问题;其他更新。

13、增强对一些使用跳转的网页的识别。

14、将标题字数限制提高到100字以内,避免部分字数过长造成的问题;其他更新。

优采云万能文章采集器2.15.8.0 更新日志(2017年3月24日)

修复百度网页搜索时间设置无效,取消百度新闻时间设置(不再支持);

微信采集增加了对设置正文最少字数的支持(以前只有自动识别可以设置字数,但是微信内置了精准标签,所以不能设置字数, 现在有可能);

[文章View] 切换显示时自动刷新目录树;

关键词采集正字符数不足时,补充提示设置的字符数 查看全部

关键词文章采集器(软件介绍优采云万能文章采集器的软件功能及修复方法)

优采云万能文章采集器 是一个非常有用的文章采集 工具。该软件从搜索引擎中引用了广泛的网页,可以非常准确地捕捉文章的内容,方便用户使用。查找和使用都非常方便,快和喜欢的用户一起来看看吧。

软件介绍

优采云万能文章采集器是一款简单易用的文章采集工具,用户只需输入关键词即可快速采集各大搜索引擎新闻源和网络pages ,您不必再通过网页查找文本了。 优采云万能文章采集器不仅具有采集速度快、操作简单的特点,文章采集器还能准确提取网页正文部分并保存为文章,并支持去标签、链接邮箱等格式处理,将纯文本的结果展示给用户,免去用户二次文本处理的麻烦。

软件功能

1、可以准确提取网页正文部分并保存为文章

2、支持标签、链接、邮件等的格式处理

3、insert关键词function

4、 可以插入可识别的标签或标点符号旁边

5、识别英文空格插入

更新日志

优采云万能文章采集器v2.17.7.0 更新日志(2020-4-8)

1、 新增正文过滤功能,可以屏蔽大部分不属于正文的内容;合并严格和标准的身体识别,加强身体识别能力(现在识别的身体没有父div标签,现在全部取自内部代码);增强提取一些故意伪装的网站标题的能力;其他更新。

2、采集文章URL,加强对相对路径的处理,如../和../../等。本版本加强处理后,相对路径将完全转换进入绝对路径。将鼠标移到浏览器中的链接上可以看到相同的内容。

3、修复了谷歌改动导致采集失败的问题。

4、Fix 关键词采集文章列选择精确标签时,没有弹出输入问题(之前版本导致);根据URL采集文章列,添加和删除外码可选Options(之前默认开启);调试模式改为文章source;疑点描述更新;其他。

5、修复微信采集失败问题。

6、Enhance paging采集 识别能力。

7、添加了谷歌地址前缀指定,可以设置自己可以使用的谷歌域名。

8、采集设置的正则替换支持使用多个分隔的匹配替换表达式。

9、增强文本识别能力,提高识别准确率;增加对特殊编码响应的识别。

10、 为二次加载的图片添加了新的属性“原创”识别转换。

11、外部文件更新谷歌翻译使用的域名;修复 Google tk 参数更改时翻译失败的问题。

12、修复了系统原因导致百度网页无法采集的问题;新增网址的#后缀部分会自动去除,会导致网页读取错误; 采集文章URL 添加左右插入选项;修复了之前版本导致的文本提取过滤的一些问题;其他更新。

13、增强对一些使用跳转的网页的识别。

14、将标题字数限制提高到100字以内,避免部分字数过长造成的问题;其他更新。

优采云万能文章采集器2.15.8.0 更新日志(2017年3月24日)

修复百度网页搜索时间设置无效,取消百度新闻时间设置(不再支持);

微信采集增加了对设置正文最少字数的支持(以前只有自动识别可以设置字数,但是微信内置了精准标签,所以不能设置字数, 现在有可能);

[文章View] 切换显示时自动刷新目录树;

关键词采集正字符数不足时,补充提示设置的字符数

关键词文章采集器(本文由考拉SEO【批量写SEO原创文章】平台支持发布)

采集交流 • 优采云 发表了文章 • 0 个评论 • 194 次浏览 • 2021-08-30 16:06

看到这篇文章的内容不要惊讶,因为这篇文章是由考拉SEO【批量写SEO原创文章】平台支持的。有了考拉,一天可以产出上万条优质SEO文章!如果还需要批量编辑SEO文章,可以进入平台用户中心试用!

非常抱歉。这时候,当我们来到现在的网页时,恐怕文章没有任何关于关键词采集器的报道,大家有什么好介绍的。这是因为这段文章是考拉工具站智能编写的优化文章。如果我们对自动编辑平台的信息有需求,我们先抛开关键词采集器。这个有什么好介绍的,小编教你怎么用系统24小时写出10000篇优质文章 优化文字!大部分朋友看了考拉的内容后认为这是伪原创脚本,这是错误的!从本质上讲,该平台是一个人工智能软件。 关键词和模板都是人工原创,网上肯定是找不到的。与 export 文章 非常相似。我们究竟是如何开发的?稍后我会为你全面解读!

坚持知道关键词采集器大家有什么好伙伴要介绍,大家心里最关心的也是上面讨论的问题。本来编辑一个好的引流文案很简单,但是文章能得到的流量真的微不足道。我期待通过内容页面设计获得流量的目的。最重要的是量化!如果一个文章可以产生一个阅读量(每24小时),那么假设可以写10,000篇文章,那么平均每天的页面浏览量可能会增加10,000。这很简单。实际写的时候,一个人一天只能出30篇左右,也只有60篇左右。尽管使用伪原创software,但最多只有100篇文章!既然看到了,就抛开关键词采集器,有什么要介绍的这个问题,深入研究一下如何实现批量编辑!

杜娘到底同意原创什么? 文章原创 不只是逐段生成原创!在各大搜索引擎的算法词典中,原创并不代表没有重复的文字。在专家看来,只要你的文章和其他网站内容不完全一样,收录的概率就会大大提高。一个好的文章,题材够抢眼,目标词不变。只要确认你要重复很长一段,这意味着这篇文章文章仍然很有可能是收录,甚至变成爆文。比如说这个文章,大家可以从360搜索关键词采集器,如果有好的介绍,我最后点进去了。负责人告诉你:我的文章文章是为了好玩考拉SEO批量写文章软件批量生成!

考拉的SEO批量写文章software,实际表达应该叫原创文章平台,它可以完成恒河沙号4小时输出优质优化类型文案,你的页面质量只需要要足够强大,指数率可以高达80%。一般操作方法,用户中心有视频介绍和新手指南,可以免费试用!非常抱歉,关键词采集器大家要介绍的东西我没有给你一个全面的解释。也许你读过这么多机器语言。但是如果你对这个产品感兴趣,不妨进入菜单栏,问一下你的优化结果,每天达到上千的流量,你不喜欢吗? 查看全部

关键词文章采集器(本文由考拉SEO【批量写SEO原创文章】平台支持发布)

看到这篇文章的内容不要惊讶,因为这篇文章是由考拉SEO【批量写SEO原创文章】平台支持的。有了考拉,一天可以产出上万条优质SEO文章!如果还需要批量编辑SEO文章,可以进入平台用户中心试用!

非常抱歉。这时候,当我们来到现在的网页时,恐怕文章没有任何关于关键词采集器的报道,大家有什么好介绍的。这是因为这段文章是考拉工具站智能编写的优化文章。如果我们对自动编辑平台的信息有需求,我们先抛开关键词采集器。这个有什么好介绍的,小编教你怎么用系统24小时写出10000篇优质文章 优化文字!大部分朋友看了考拉的内容后认为这是伪原创脚本,这是错误的!从本质上讲,该平台是一个人工智能软件。 关键词和模板都是人工原创,网上肯定是找不到的。与 export 文章 非常相似。我们究竟是如何开发的?稍后我会为你全面解读!

坚持知道关键词采集器大家有什么好伙伴要介绍,大家心里最关心的也是上面讨论的问题。本来编辑一个好的引流文案很简单,但是文章能得到的流量真的微不足道。我期待通过内容页面设计获得流量的目的。最重要的是量化!如果一个文章可以产生一个阅读量(每24小时),那么假设可以写10,000篇文章,那么平均每天的页面浏览量可能会增加10,000。这很简单。实际写的时候,一个人一天只能出30篇左右,也只有60篇左右。尽管使用伪原创software,但最多只有100篇文章!既然看到了,就抛开关键词采集器,有什么要介绍的这个问题,深入研究一下如何实现批量编辑!

杜娘到底同意原创什么? 文章原创 不只是逐段生成原创!在各大搜索引擎的算法词典中,原创并不代表没有重复的文字。在专家看来,只要你的文章和其他网站内容不完全一样,收录的概率就会大大提高。一个好的文章,题材够抢眼,目标词不变。只要确认你要重复很长一段,这意味着这篇文章文章仍然很有可能是收录,甚至变成爆文。比如说这个文章,大家可以从360搜索关键词采集器,如果有好的介绍,我最后点进去了。负责人告诉你:我的文章文章是为了好玩考拉SEO批量写文章软件批量生成!

考拉的SEO批量写文章software,实际表达应该叫原创文章平台,它可以完成恒河沙号4小时输出优质优化类型文案,你的页面质量只需要要足够强大,指数率可以高达80%。一般操作方法,用户中心有视频介绍和新手指南,可以免费试用!非常抱歉,关键词采集器大家要介绍的东西我没有给你一个全面的解释。也许你读过这么多机器语言。但是如果你对这个产品感兴趣,不妨进入菜单栏,问一下你的优化结果,每天达到上千的流量,你不喜欢吗?

关键词文章采集器(如何利用全网“文章采集”开始你的文章数据采集之旅?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 186 次浏览 • 2021-08-30 06:05

关键词文章采集器超级实用啊哈哈哈哈上图分别是:搜狗、百度、搜狗hao123网址站,

什么是文章数据采集?文章采集简单的说,就是利用相关搜索引擎提供的搜索接口,爬取网站上的文章,并对文章进行编辑标题作者作者排名、排序、排名算法等处理,做成爬虫爬到的文章,然后把爬虫爬的结果以文章的形式发布到网站上。如何利用全网“文章采集”开始你的文章数据采集之旅?1.全站“文章采集”接口可以百度和google搜索,国内网站的全站都有一个接口,国外的(如百度)可以用urllib2,百度的robots文件中获取链接地址:国内搜索引擎如百度.com和谷歌.com则分别提供中文站点和英文站点搜索接口2.接口接收接口,成功爬取到如下页面的记录:3.利用网站抓取器抓取到的部分网站的记录:4.爬虫类型:对于爬虫要求比较高,你可以自己搭建,价格一般都比较高,效率也不好。

我还是推荐直接购买现成的爬虫,如百度云平台和腾讯云服务器,一般都支持几十万篇几百万篇文章,月费300-8000元都是可以接受的。5.问题遇到问题可以咨询群128256703!。

可以试试awslab,采集速度快

使用curl对所有网页都进行as1抓取。

lofter有一个插件,可以抓包,获取链接地址, 查看全部

关键词文章采集器(如何利用全网“文章采集”开始你的文章数据采集之旅?)

关键词文章采集器超级实用啊哈哈哈哈上图分别是:搜狗、百度、搜狗hao123网址站,

什么是文章数据采集?文章采集简单的说,就是利用相关搜索引擎提供的搜索接口,爬取网站上的文章,并对文章进行编辑标题作者作者排名、排序、排名算法等处理,做成爬虫爬到的文章,然后把爬虫爬的结果以文章的形式发布到网站上。如何利用全网“文章采集”开始你的文章数据采集之旅?1.全站“文章采集”接口可以百度和google搜索,国内网站的全站都有一个接口,国外的(如百度)可以用urllib2,百度的robots文件中获取链接地址:国内搜索引擎如百度.com和谷歌.com则分别提供中文站点和英文站点搜索接口2.接口接收接口,成功爬取到如下页面的记录:3.利用网站抓取器抓取到的部分网站的记录:4.爬虫类型:对于爬虫要求比较高,你可以自己搭建,价格一般都比较高,效率也不好。

我还是推荐直接购买现成的爬虫,如百度云平台和腾讯云服务器,一般都支持几十万篇几百万篇文章,月费300-8000元都是可以接受的。5.问题遇到问题可以咨询群128256703!。

可以试试awslab,采集速度快

使用curl对所有网页都进行as1抓取。

lofter有一个插件,可以抓包,获取链接地址,

关键词文章采集器(word+google翻译,你想接手哪个语言来着?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-08-30 04:02

关键词文章采集器:文章分类查询:关键词目录查询:访问:

google对中文的翻译是其他语言,个人觉得目前这个特性还是少。最近又开发了word+google翻译,

我们是用jis分词的吧感觉一般。我看有些语言很多单词都不一样,不过可以用argument收集方法,你看自己想接手哪个语言来着?如果你只是想接手来源自分词的标点符号,要把句子分割了,不过效率挺低的。如果你语言中存在很多个单词不是一种语言(不一定一定是,比如有些英语法语俄语都不一样,比如“我所在的大学”用德语汉语或者俄语都是不通顺的),可以用vocabularypipeline的方法来做。

但目前还只能做到可以互相转换。我觉得基本的recipe是把所有的语言写成一个tokenizer,找到一个目标语言,发现一个特征,然后找到这个语言对应的tokenizer,把tokenizer转换成所有对应的tokenizer。这是怎么理解和构造的方法,主要是从语言分层表中理解。或者不用分层表,另外构造标注文本。

我觉得把一个两分类问题切分成三分类问题比较有用,因为四分类问题有很多问题不具有代表性,比如分布不均匀,“作业要全部完成”,对应的分布每个数据中十万个样本在个分布,为什么?其实很多问题可以归类为极值的大小,所以必须理解整个问题的样本分布,也就是图像-对象图,或者分布图像。其实这种类似的问题已经解决很多了,一些图像识别,神经网络为什么能解决问题?因为形成各种不均匀,二值。

那它能作为例子吗?可以。看我们能不能抽取特征。完成后,我们会考虑一下分布规律是否能用神经网络来解决。其实这件事背后也有物理,比如用外能势和内能力。如果说具体技术,可以找一些fewshotlearning来看看,我之前看过requests,fastnetwork和macerotation。 查看全部

关键词文章采集器(word+google翻译,你想接手哪个语言来着?)

关键词文章采集器:文章分类查询:关键词目录查询:访问:

google对中文的翻译是其他语言,个人觉得目前这个特性还是少。最近又开发了word+google翻译,

我们是用jis分词的吧感觉一般。我看有些语言很多单词都不一样,不过可以用argument收集方法,你看自己想接手哪个语言来着?如果你只是想接手来源自分词的标点符号,要把句子分割了,不过效率挺低的。如果你语言中存在很多个单词不是一种语言(不一定一定是,比如有些英语法语俄语都不一样,比如“我所在的大学”用德语汉语或者俄语都是不通顺的),可以用vocabularypipeline的方法来做。

但目前还只能做到可以互相转换。我觉得基本的recipe是把所有的语言写成一个tokenizer,找到一个目标语言,发现一个特征,然后找到这个语言对应的tokenizer,把tokenizer转换成所有对应的tokenizer。这是怎么理解和构造的方法,主要是从语言分层表中理解。或者不用分层表,另外构造标注文本。

我觉得把一个两分类问题切分成三分类问题比较有用,因为四分类问题有很多问题不具有代表性,比如分布不均匀,“作业要全部完成”,对应的分布每个数据中十万个样本在个分布,为什么?其实很多问题可以归类为极值的大小,所以必须理解整个问题的样本分布,也就是图像-对象图,或者分布图像。其实这种类似的问题已经解决很多了,一些图像识别,神经网络为什么能解决问题?因为形成各种不均匀,二值。

那它能作为例子吗?可以。看我们能不能抽取特征。完成后,我们会考虑一下分布规律是否能用神经网络来解决。其实这件事背后也有物理,比如用外能势和内能力。如果说具体技术,可以找一些fewshotlearning来看看,我之前看过requests,fastnetwork和macerotation。

关键词文章采集器(chrome可以用开发者工具->发送到托管服务器)

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-08-29 20:02

关键词文章采集器。

采集这么细分的问题,这几个都不满足:第一,你没有浏览器开发者模式;第二,你不会做深度爬虫。采集针对性的东西效率上不会有太大提升。比如说,我先要你给我一个文件读取接口,再给我针对这个文件读取一段话作为功能文本,然后我就可以用js遍历这个文件,把我需要的东西进行爬取,达到我想要的效果。

当然varresize=void(malloc(256)),viewurl=array_ptr();//foriinresize://获取初始页面地址并解析array_ptrindex_html=fread(resize);//获取页面文本内容viewurl。toindexof(index_html);。

chrome可以用开发者工具->正在抓取->发送到托管服务器

抓取建议用优采云采集器,国内已经开源,免费。

chrome可以用开发者工具->正在抓取->发送到托管服务器。

我用lxml也比较久,尝试过各种开源爬虫但后来还是还是回到google了,我爬取糗事网的时候,先解析糗事网的html数据,然后和图片互相抓包,以图片为开始抓包,然后拿到图片地址,用webdriver的api抓包去解析文本,发给图片爬虫,再把图片地址返回给对应的文本爬虫。刚才发现我第二次回答的时候,写的描述让大家以为已经抓到了图片地址。

最近使用lxml再次写了一遍程序,功能已经不同于第一次,html数据已经解析过,以图片为例可以直接google图片。只是抓包拿到的地址仍然被墙了,所以xmlhttprequest和postman这两个开源的抓包模拟器被禁用了。 查看全部

关键词文章采集器(chrome可以用开发者工具->发送到托管服务器)

关键词文章采集器。

采集这么细分的问题,这几个都不满足:第一,你没有浏览器开发者模式;第二,你不会做深度爬虫。采集针对性的东西效率上不会有太大提升。比如说,我先要你给我一个文件读取接口,再给我针对这个文件读取一段话作为功能文本,然后我就可以用js遍历这个文件,把我需要的东西进行爬取,达到我想要的效果。

当然varresize=void(malloc(256)),viewurl=array_ptr();//foriinresize://获取初始页面地址并解析array_ptrindex_html=fread(resize);//获取页面文本内容viewurl。toindexof(index_html);。

chrome可以用开发者工具->正在抓取->发送到托管服务器

抓取建议用优采云采集器,国内已经开源,免费。

chrome可以用开发者工具->正在抓取->发送到托管服务器。

我用lxml也比较久,尝试过各种开源爬虫但后来还是还是回到google了,我爬取糗事网的时候,先解析糗事网的html数据,然后和图片互相抓包,以图片为开始抓包,然后拿到图片地址,用webdriver的api抓包去解析文本,发给图片爬虫,再把图片地址返回给对应的文本爬虫。刚才发现我第二次回答的时候,写的描述让大家以为已经抓到了图片地址。

最近使用lxml再次写了一遍程序,功能已经不同于第一次,html数据已经解析过,以图片为例可以直接google图片。只是抓包拿到的地址仍然被墙了,所以xmlhttprequest和postman这两个开源的抓包模拟器被禁用了。

关键词文章采集器(企业安全中GitHub关键字扫描是关键及重要的基础建设)

采集交流 • 优采云 发表了文章 • 0 个评论 • 161 次浏览 • 2021-08-29 19:10

前言

多起 GitHub 泄露企业敏感信息事件已在互联网上曝光,说明 GitHub 关键字扫描是企业安全中至关重要的安全基础设施。我使用了一些事件来扫描不同类型 GitHub 的开源产品。一些测试研究,与您分享。

一、GitHub 搜索界面

github 提供了一个 API 来搜索代码中的关键字,并定义了默认只搜索主分支代码,即 master 分支。只能搜索小于 384KB 的文件。

官方例子中:+in:file+language:js+repo:jquery/jqueryq 表示为关键字;

in:file 表示在文件中搜索(in:path 在文件目录中);

language 表示语言是 JavaScript;

repo 表示在 jquery/jquery 仓库中搜索;

API还提供了显示搜索结果的功能,请求时带有请求头:curl-H'Accept:application/vnd.github.v3.text-match+json'\+in:file+ language :js+repo:jquery/jquery

例子:但是这个函数只显示匹配的关键字和行数,对实际应用影响不大:

二、开源工具介绍

网上有很多用于GitHub扫描的开源工具。我的需求是:及时预警、全面扫描、直观展示。经过一些测试和比较,我推荐两个易于部署且易于配置的工具:

2.1 GSIL 介绍

原则:

搜索范围:默认搜索前200个项目,最多5000个(github限制)。

流程:通过API(/search/code)搜索规则文件rules.gsil中提交的关键词,然后分析得到的json结果,默认显示前30个相关项。

扫描配置:配置文件中会过滤一些笔者认为没用的路径,有的可以根据实际情况进行屏蔽:

结果展示:该工具没有页面展示,使用邮件提醒匹配关键词所在行及其上下3行进行邮件发送(用户体验好)。

去重扫描:工具记录扫描过程中产生的相关代码内容和文件hash,并在~目录下创建隐藏文件夹.gsil。如果之前遇到过扫描引擎中文件的hash,则跳过:

定期扫描:可以通过crontab配置,每小时执行一次:@hourly /usr/bin/python /root/gsil/gsil.py 规则名称

2.2 鹰眼介绍

扫描原理之前已经简单介绍过了。由于 Hawkeye 具有图形界面,因此可以与 GSIL 一起使用。我通常将 GSIL 扫描的帐户作为关注的焦点,并配置更详细的策略进行监控。

三、Summary

GitHub 关键字扫描的开源工具还有很多,比如小米开发的比较轻量级的gitpprey()、X-patrol(),从安装环境要求、配置功能实现、部署难度入手。 , 可以找到适合企业环境的开源扫描工具。再加上一些二次开发,基本可以保证一些GitHub信息泄露的touch关键字可以被及时发现并删除。

感谢阅读并欢迎指导。 查看全部

关键词文章采集器(企业安全中GitHub关键字扫描是关键及重要的基础建设)

前言

多起 GitHub 泄露企业敏感信息事件已在互联网上曝光,说明 GitHub 关键字扫描是企业安全中至关重要的安全基础设施。我使用了一些事件来扫描不同类型 GitHub 的开源产品。一些测试研究,与您分享。

一、GitHub 搜索界面

github 提供了一个 API 来搜索代码中的关键字,并定义了默认只搜索主分支代码,即 master 分支。只能搜索小于 384KB 的文件。

官方例子中:+in:file+language:js+repo:jquery/jqueryq 表示为关键字;

in:file 表示在文件中搜索(in:path 在文件目录中);

language 表示语言是 JavaScript;

repo 表示在 jquery/jquery 仓库中搜索;

API还提供了显示搜索结果的功能,请求时带有请求头:curl-H'Accept:application/vnd.github.v3.text-match+json'\+in:file+ language :js+repo:jquery/jquery

例子:但是这个函数只显示匹配的关键字和行数,对实际应用影响不大:

二、开源工具介绍

网上有很多用于GitHub扫描的开源工具。我的需求是:及时预警、全面扫描、直观展示。经过一些测试和比较,我推荐两个易于部署且易于配置的工具:

2.1 GSIL 介绍

原则:

搜索范围:默认搜索前200个项目,最多5000个(github限制)。

流程:通过API(/search/code)搜索规则文件rules.gsil中提交的关键词,然后分析得到的json结果,默认显示前30个相关项。

扫描配置:配置文件中会过滤一些笔者认为没用的路径,有的可以根据实际情况进行屏蔽:

结果展示:该工具没有页面展示,使用邮件提醒匹配关键词所在行及其上下3行进行邮件发送(用户体验好)。

去重扫描:工具记录扫描过程中产生的相关代码内容和文件hash,并在~目录下创建隐藏文件夹.gsil。如果之前遇到过扫描引擎中文件的hash,则跳过:

定期扫描:可以通过crontab配置,每小时执行一次:@hourly /usr/bin/python /root/gsil/gsil.py 规则名称

2.2 鹰眼介绍

扫描原理之前已经简单介绍过了。由于 Hawkeye 具有图形界面,因此可以与 GSIL 一起使用。我通常将 GSIL 扫描的帐户作为关注的焦点,并配置更详细的策略进行监控。

三、Summary

GitHub 关键字扫描的开源工具还有很多,比如小米开发的比较轻量级的gitpprey()、X-patrol(),从安装环境要求、配置功能实现、部署难度入手。 , 可以找到适合企业环境的开源扫描工具。再加上一些二次开发,基本可以保证一些GitHub信息泄露的touch关键字可以被及时发现并删除。

感谢阅读并欢迎指导。

关键词文章采集器( 头条粉丝数量少是什么情况?如何提高粉丝指数的词排名?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 218 次浏览 • 2021-08-29 18:12

头条粉丝数量少是什么情况?如何提高粉丝指数的词排名?)

总结:搜狐搜索界面,前面加关键词,然后输出id对应的数据。有没有办法生成这个ID?是的,您无法下载整个站点的数据库和网页。你应该先用仿站工具下载你想仿的网站站,然后用WordPress程序制作。 收录的问题是否与你的程序关系不大,主要看你的关键词的布局和文章的质量。头条粉丝减少了很多。突然间,有多少粉丝在增长

搜狐搜索界面,前面加关键词,然后输出id对应的数据。有没有办法生成这个id?

是的,您无法下载整个网站的数据库和网页。你应该先用仿站工具下载你想仿的网站站,然后用WordPress程序制作。

收录的问题是否与你的程序关系不大,主要看你的关键词的布局和文章的质量。

头条粉丝减少了很多。突然间,粉丝增加了多少,头条粉丝怎么这么少?我没有乱发任何东西。粉丝少是什么情况?如何提高粉丝关注度?我的标题六个月来第一次失去了粉丝。

回答问题时禁止宣传链接、非法文字和浇水,违规将封号!使用链接了解合理的方法

网站第一次打开就跳转到其他网站。第二次打开后就正常了。如何查看木马情况? - 搜索引擎优化问答。

网站:

网站:

昨天只是一个没有任何后台程序模板的静态页面,然后没有更新的内容,会怎么样

回答问题时禁止宣传链接、非法文字和浇水,违规将封号!使用链接了解合理的方法

网站关键词,没有索引有利于优化排名。如何优化没有索引的词的排名?没有索引,就没有什么竞争。 网站 已经优化了一段时间。如果您没有索引,请不要放弃。如果继续优化等待效果,能拿到排名吗?

这是广告,影响数据准确性和体验的百度统计;

建议您使用51la Statistics V6版本,有防盗刷,功能数据更准确,无广告烦恼~

网站现在才十天,

程序本身在搭建的时候着急更新,才发现网站关键词配置有问题,新的2天内所有title的后缀都改了

结果首页掉到了最后。只有三个收录,结果也被罚款

目前网站每天更新2篇文章

我也想维护小程序,从媒体平台发布等

真的没体验过

网站 的流量一直在下降。从几万流量到几百流量,网站一直在走下坡路。怎样才能恢复正常?不会降为零吗?为什么流量下降而我什么也没做?为什么流量一直在下降?

第一步,首先要做的是网站关键词分析。 网站关键词分析不仅需要对关键词的研究进行拓展和优化,还需要在优化关键词的基础上分析每个竞争对手网站的优劣势。看看排名靠前的网站,使用了哪些优化技巧,比如外链在哪里发,友情链接的数量和质量,网站内容发帖的质量和规律性

第二步根据竞争对手的网站分析,结合自己挖掘的关键词数据,布局自己的网站,具体方法包括网站、优化、网站优化等。去网站优化一段时间后(只要操作方法正确,不偷懒),网站关键词的排名可以在50-100左右。

第三步,网站关键词排名出现后。根据之前的优化技巧,可以通过添加大量外链来快速提升网站的排名,比如交换更多的优质友情链接。最近发现这个优化方法不是很实用,但是还是有一些效果的。当然,有些人可能会使用一些快速排名软件在网站30-50关键词附近快速排名(我之前没用过,这里不推荐具体软件)。

第四步,当网站的关键词在首页排名时,我们还需要在关键词上继续维护。比如网站的用户体验,网站的跳出率等等,都可以作为维护的重点对象。当然,我们仍然需要坚持发布我们的优质内容。因为发现近期优质内容对网站关键词的排名有非常重要的影响

自己的轮子研发很难,连微软自己的整体优势都没有实现;

海外Chromium开源,直接使用,省时省力。效果很好,为什么不

xxxbxxx 查看全部

关键词文章采集器(

头条粉丝数量少是什么情况?如何提高粉丝指数的词排名?)

总结:搜狐搜索界面,前面加关键词,然后输出id对应的数据。有没有办法生成这个ID?是的,您无法下载整个站点的数据库和网页。你应该先用仿站工具下载你想仿的网站站,然后用WordPress程序制作。 收录的问题是否与你的程序关系不大,主要看你的关键词的布局和文章的质量。头条粉丝减少了很多。突然间,有多少粉丝在增长

搜狐搜索界面,前面加关键词,然后输出id对应的数据。有没有办法生成这个id?

是的,您无法下载整个网站的数据库和网页。你应该先用仿站工具下载你想仿的网站站,然后用WordPress程序制作。

收录的问题是否与你的程序关系不大,主要看你的关键词的布局和文章的质量。

头条粉丝减少了很多。突然间,粉丝增加了多少,头条粉丝怎么这么少?我没有乱发任何东西。粉丝少是什么情况?如何提高粉丝关注度?我的标题六个月来第一次失去了粉丝。

回答问题时禁止宣传链接、非法文字和浇水,违规将封号!使用链接了解合理的方法

网站第一次打开就跳转到其他网站。第二次打开后就正常了。如何查看木马情况? - 搜索引擎优化问答。

网站:

网站:

昨天只是一个没有任何后台程序模板的静态页面,然后没有更新的内容,会怎么样

回答问题时禁止宣传链接、非法文字和浇水,违规将封号!使用链接了解合理的方法

网站关键词,没有索引有利于优化排名。如何优化没有索引的词的排名?没有索引,就没有什么竞争。 网站 已经优化了一段时间。如果您没有索引,请不要放弃。如果继续优化等待效果,能拿到排名吗?

这是广告,影响数据准确性和体验的百度统计;

建议您使用51la Statistics V6版本,有防盗刷,功能数据更准确,无广告烦恼~

网站现在才十天,

程序本身在搭建的时候着急更新,才发现网站关键词配置有问题,新的2天内所有title的后缀都改了

结果首页掉到了最后。只有三个收录,结果也被罚款

目前网站每天更新2篇文章

我也想维护小程序,从媒体平台发布等

真的没体验过

网站 的流量一直在下降。从几万流量到几百流量,网站一直在走下坡路。怎样才能恢复正常?不会降为零吗?为什么流量下降而我什么也没做?为什么流量一直在下降?

第一步,首先要做的是网站关键词分析。 网站关键词分析不仅需要对关键词的研究进行拓展和优化,还需要在优化关键词的基础上分析每个竞争对手网站的优劣势。看看排名靠前的网站,使用了哪些优化技巧,比如外链在哪里发,友情链接的数量和质量,网站内容发帖的质量和规律性

第二步根据竞争对手的网站分析,结合自己挖掘的关键词数据,布局自己的网站,具体方法包括网站、优化、网站优化等。去网站优化一段时间后(只要操作方法正确,不偷懒),网站关键词的排名可以在50-100左右。

第三步,网站关键词排名出现后。根据之前的优化技巧,可以通过添加大量外链来快速提升网站的排名,比如交换更多的优质友情链接。最近发现这个优化方法不是很实用,但是还是有一些效果的。当然,有些人可能会使用一些快速排名软件在网站30-50关键词附近快速排名(我之前没用过,这里不推荐具体软件)。

第四步,当网站的关键词在首页排名时,我们还需要在关键词上继续维护。比如网站的用户体验,网站的跳出率等等,都可以作为维护的重点对象。当然,我们仍然需要坚持发布我们的优质内容。因为发现近期优质内容对网站关键词的排名有非常重要的影响

自己的轮子研发很难,连微软自己的整体优势都没有实现;

海外Chromium开源,直接使用,省时省力。效果很好,为什么不

xxxbxxx

关键词文章采集器(下想把关键词做到首页要用什么工具?站长工具分析)

采集交流 • 优采云 发表了文章 • 0 个评论 • 186 次浏览 • 2021-08-29 18:07

对于网站的关键词优化,大家的方法很多,但是能把关键词弄到首页的并不多,因为大多数人的优化方法都是一样的,关键词在就是这样针对100岁以外的人群优化,50岁以下的人群依然优化。如果你想让关键词成为首页,你需要根据不同的排名进行优化。需要一些辅助工具。今天就来介绍一下你想用什么工具关键词做首页。

关键词排在100后,首先要优化网站的基础。每个人都有经验,没什么特别的。只需寻找关键词 并寻找与行业相关的。

关键词排名在20-100之间时,保持定时定量更新,在其他平台分享文章以增加阅读量;同时,发出链接以吸引流量。

当关键词排在前2页时,如果想进入首页,排名更高,就需要做好细节。有些新手可能不知道,当关键词进入前20名时,搜索引擎给出的排名更多地取决于用户的选择。用户喜欢访问更长的时间,从而给出更高的排名。所以,我们可以找人点击,找一些互助优化群,找一些人帮忙点击。我们也应该做朋友链,稳定提升关键词排名。

可以看出关键词的不同排名有不同的优化侧重点。如果要做这些优化,单靠自己是很难做好的。你需要为自己找一些帮手。 SEO优化工具有很多,比如:

1.站长工具分析数据。无论我们如何优化,首先要了解我们的网站数据。通过数据分析,我们可以知道关键词的数据情况,排名情况,以及进入哪里去网站,找到用户喜欢什么。

2.文章采集器,需要每天发文章更新做网站优化,你的搜索速度太慢,可以直接用采集器采集。

3.文章editor 做伪原创,直接用采集的文章,效果不好,搜索引擎不许点赞。就算你没有原创,你还是要做伪原创,还有一些编辑专门给伪原创。

4.更改IP软件切换多账号防拦截,无论是分享文章、发链接,还是混贴吧论坛等等,都需要很多账号,而且需要用不同的账号来做引导话题,增加人气,获得排名。但是,每个网站 都有 IP 限制。频繁的操作很容易造成IP被封或者账号被封,所以需要改IP软件改IP和切换账号做优化工作。 (推荐:黑洞代理,国家IP,高匿名)

5.刷流量点击软件,这种工具也很多人用,可以快速提升人气,获得不错的排名,但也有风险。 (推荐:点宝、真实IP刷流量、支持设置访问时长、访问路径等)

想把关键词做成首页,用什么工具,上面已经介绍过了,可能不止上面这些,欢迎分享。 查看全部

关键词文章采集器(下想把关键词做到首页要用什么工具?站长工具分析)

对于网站的关键词优化,大家的方法很多,但是能把关键词弄到首页的并不多,因为大多数人的优化方法都是一样的,关键词在就是这样针对100岁以外的人群优化,50岁以下的人群依然优化。如果你想让关键词成为首页,你需要根据不同的排名进行优化。需要一些辅助工具。今天就来介绍一下你想用什么工具关键词做首页。

关键词排在100后,首先要优化网站的基础。每个人都有经验,没什么特别的。只需寻找关键词 并寻找与行业相关的。

关键词排名在20-100之间时,保持定时定量更新,在其他平台分享文章以增加阅读量;同时,发出链接以吸引流量。

当关键词排在前2页时,如果想进入首页,排名更高,就需要做好细节。有些新手可能不知道,当关键词进入前20名时,搜索引擎给出的排名更多地取决于用户的选择。用户喜欢访问更长的时间,从而给出更高的排名。所以,我们可以找人点击,找一些互助优化群,找一些人帮忙点击。我们也应该做朋友链,稳定提升关键词排名。

可以看出关键词的不同排名有不同的优化侧重点。如果要做这些优化,单靠自己是很难做好的。你需要为自己找一些帮手。 SEO优化工具有很多,比如:

1.站长工具分析数据。无论我们如何优化,首先要了解我们的网站数据。通过数据分析,我们可以知道关键词的数据情况,排名情况,以及进入哪里去网站,找到用户喜欢什么。

2.文章采集器,需要每天发文章更新做网站优化,你的搜索速度太慢,可以直接用采集器采集。

3.文章editor 做伪原创,直接用采集的文章,效果不好,搜索引擎不许点赞。就算你没有原创,你还是要做伪原创,还有一些编辑专门给伪原创。

4.更改IP软件切换多账号防拦截,无论是分享文章、发链接,还是混贴吧论坛等等,都需要很多账号,而且需要用不同的账号来做引导话题,增加人气,获得排名。但是,每个网站 都有 IP 限制。频繁的操作很容易造成IP被封或者账号被封,所以需要改IP软件改IP和切换账号做优化工作。 (推荐:黑洞代理,国家IP,高匿名)

5.刷流量点击软件,这种工具也很多人用,可以快速提升人气,获得不错的排名,但也有风险。 (推荐:点宝、真实IP刷流量、支持设置访问时长、访问路径等)

想把关键词做成首页,用什么工具,上面已经介绍过了,可能不止上面这些,欢迎分享。

关键词文章采集器(黑贸论坛联合创始人|优采云采集器的技巧)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-09-17 23:01

1人同意有很多答案采集工具。只要您输入优采云@采集器@和优采云,普通的基于零的内容将捕获相关的文章内容关键词. 这是非常方便和易于使用。它适用于新手和零基础的人。高级可以认为优采云优采云采集器需要

对HTML代码有一定的了解,对post和get数据传输有一定的了解,从而获得网站request的真实URL,然后选择页面唯一的编码规则来实现采集站群version采集tool。市场上很多采集工具都有采集功能,它们是采集关键词. 这些采集工具可以通过采集的文章实现模板伪原创和句子库伪原创等不同功能,然后编写接口直接上传到网站。此外,如dedecms后台还有采集函数,但是这个采集函数不是很好用。做“网站”可以结合采集工具实现多批次文章内容更新,但你也需要注意减少百度采集自动上传文章需要快速的数据库响应,这可以考虑BLUEHOST服务器。无论使用哪个采集器直接上传到网站,线程都不够或CPU配置不高。很容易关闭,因此无法打开站点。黑人贸易论坛黑人贸易论坛联合创始人|黑人贸易论坛独立站SEO技能交流|资源共享| 1人同意答案。我用过很多采集工具,性价比更好的是优采云!但是这些工具是有缺陷的!如果你想完全适合自己,我建议你写你自己的爬虫!如果你不懂,你可以找一个外国人来写,毛子。波兰的价格低,技术强!您可以在upwork优采云采集平台上找到它,该平台已经简化,以使数据触手可用。三个人同意。我应该推荐我自己,采集在互联网上文章可以试试优采云采集优采云采集有免费版本和采集模板,可以在几分钟内快速运行从采集到发布的整个过程。操作步骤如下:1、复制要采集的网站模板,并启动采集采集列表结果2、发布到网站. 目前,@K6采集支持WordPress、zblog织梦dede超过十种cms系统3、选择发布文章到网站。这样,整个采集发布过程可以通过三个简单的步骤完成。有关更多详细信息,请参阅以下文档: 查看全部

关键词文章采集器(黑贸论坛联合创始人|优采云采集器的技巧)

1人同意有很多答案采集工具。只要您输入优采云@采集器@和优采云,普通的基于零的内容将捕获相关的文章内容关键词. 这是非常方便和易于使用。它适用于新手和零基础的人。高级可以认为优采云优采云采集器需要

对HTML代码有一定的了解,对post和get数据传输有一定的了解,从而获得网站request的真实URL,然后选择页面唯一的编码规则来实现采集站群version采集tool。市场上很多采集工具都有采集功能,它们是采集关键词. 这些采集工具可以通过采集的文章实现模板伪原创和句子库伪原创等不同功能,然后编写接口直接上传到网站。此外,如dedecms后台还有采集函数,但是这个采集函数不是很好用。做“网站”可以结合采集工具实现多批次文章内容更新,但你也需要注意减少百度采集自动上传文章需要快速的数据库响应,这可以考虑BLUEHOST服务器。无论使用哪个采集器直接上传到网站,线程都不够或CPU配置不高。很容易关闭,因此无法打开站点。黑人贸易论坛黑人贸易论坛联合创始人|黑人贸易论坛独立站SEO技能交流|资源共享| 1人同意答案。我用过很多采集工具,性价比更好的是优采云!但是这些工具是有缺陷的!如果你想完全适合自己,我建议你写你自己的爬虫!如果你不懂,你可以找一个外国人来写,毛子。波兰的价格低,技术强!您可以在upwork优采云采集平台上找到它,该平台已经简化,以使数据触手可用。三个人同意。我应该推荐我自己,采集在互联网上文章可以试试优采云采集优采云采集有免费版本和采集模板,可以在几分钟内快速运行从采集到发布的整个过程。操作步骤如下:1、复制要采集的网站模板,并启动采集采集列表结果2、发布到网站. 目前,@K6采集支持WordPress、zblog织梦dede超过十种cms系统3、选择发布文章到网站。这样,整个采集发布过程可以通过三个简单的步骤完成。有关更多详细信息,请参阅以下文档:

关键词文章采集器(关键词文章采集器和邮件邮件采集注意事项!!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2021-09-15 10:05

关键词文章采集器采集注意事项文章采集器和邮件邮件采集器文件选取工具因为属于软件采集,特别是对于常用的软件我们采集要多小心谨慎,尤其是某些对于文件过大的处理,所以在采集文章的时候要让电脑帮助你切换大小规格。通常我们不建议大家用自带的浏览器来采集文章,因为采集太简单,真正采集还是非常复杂,如果是自己编写代码那么自然是最好。

这里是采集王平台网站采集,需要先找一个可用的下载链接,点击绿色分享按钮,然后分享给你的朋友,然后他通过网站直接从网页下载就行了。如果是抓不到呢?那么也会生成一个结果回传给你,这样是没问题的。转化速度特别快,而且也容易更改文件名,但是大多数自动转化的情况都比较特殊,操作方法你可以看我总结的代码,最好还是不要用自动转化的。

这个属于软件采集,网站采集这样的,最多也就用到隐藏标记。工具采集1.个人可以注册试用,上传文件后可以自动匹配下载,如果匹配后文件不在本机也会自动分析并且保存下来,是一个固定大小,这个你完全可以控制。2.文章保存服务器在用户自己的电脑。3.如果文章是重复的你需要改名称,需要先点击隐藏,再点击改名字,就可以编辑文章,大部分都是可以自定义文章名的。

4.工具网站支持多个渠道对比价格,不用特地去找别人的对比服务,你直接输入网站名字就可以了,保证价格准确无误。5.如果有软件出问题了,或者返现不返现的,点击右上角的右下角退款就行了,之前给客户退款就因为退回退款部分过长再或者支付金额过大,导致退不回来。6.手机上小米商城、三星商城、魅族商城、华为商城、苹果商城等,可以看看真机触摸是否像网站上图片一样,实际效果和图片肯定会有差距。

7.采集出来的文章全部都是原始文件,需要你自己保存,如果不保存那么就没有保存的意义,不仅起不到收藏的作用,同时还占用你所拥有硬盘空间,浪费。8.采集按钮做截图的话很多时候可以采集到精华,这个需要你提前做好图片处理。具体方法还是看我总结的代码,最好还是不要用自动转化的。特别注意:请在真机的模拟器上进行操作,模拟器就是你的电脑操作有时是会慢很多的。

技巧教程1.采集文章一定要提前做好封面(必须有的),封面要和标题保持一致。上传的链接才能正常被采集,不能有中文字。否则就是采集不成功的。2.关键词选取,对于新手我建议选取的关键词还是针对自己行业里优秀的人或者公司开发或者自己创建的品牌词,是比较好的,在选择关键词的时候多问问做过这行的朋友,或者百度相关部门的工作人员,结合热度去选择关键词。3。 查看全部

关键词文章采集器(关键词文章采集器和邮件邮件采集注意事项!!)

关键词文章采集器采集注意事项文章采集器和邮件邮件采集器文件选取工具因为属于软件采集,特别是对于常用的软件我们采集要多小心谨慎,尤其是某些对于文件过大的处理,所以在采集文章的时候要让电脑帮助你切换大小规格。通常我们不建议大家用自带的浏览器来采集文章,因为采集太简单,真正采集还是非常复杂,如果是自己编写代码那么自然是最好。

这里是采集王平台网站采集,需要先找一个可用的下载链接,点击绿色分享按钮,然后分享给你的朋友,然后他通过网站直接从网页下载就行了。如果是抓不到呢?那么也会生成一个结果回传给你,这样是没问题的。转化速度特别快,而且也容易更改文件名,但是大多数自动转化的情况都比较特殊,操作方法你可以看我总结的代码,最好还是不要用自动转化的。

这个属于软件采集,网站采集这样的,最多也就用到隐藏标记。工具采集1.个人可以注册试用,上传文件后可以自动匹配下载,如果匹配后文件不在本机也会自动分析并且保存下来,是一个固定大小,这个你完全可以控制。2.文章保存服务器在用户自己的电脑。3.如果文章是重复的你需要改名称,需要先点击隐藏,再点击改名字,就可以编辑文章,大部分都是可以自定义文章名的。

4.工具网站支持多个渠道对比价格,不用特地去找别人的对比服务,你直接输入网站名字就可以了,保证价格准确无误。5.如果有软件出问题了,或者返现不返现的,点击右上角的右下角退款就行了,之前给客户退款就因为退回退款部分过长再或者支付金额过大,导致退不回来。6.手机上小米商城、三星商城、魅族商城、华为商城、苹果商城等,可以看看真机触摸是否像网站上图片一样,实际效果和图片肯定会有差距。

7.采集出来的文章全部都是原始文件,需要你自己保存,如果不保存那么就没有保存的意义,不仅起不到收藏的作用,同时还占用你所拥有硬盘空间,浪费。8.采集按钮做截图的话很多时候可以采集到精华,这个需要你提前做好图片处理。具体方法还是看我总结的代码,最好还是不要用自动转化的。特别注意:请在真机的模拟器上进行操作,模拟器就是你的电脑操作有时是会慢很多的。

技巧教程1.采集文章一定要提前做好封面(必须有的),封面要和标题保持一致。上传的链接才能正常被采集,不能有中文字。否则就是采集不成功的。2.关键词选取,对于新手我建议选取的关键词还是针对自己行业里优秀的人或者公司开发或者自己创建的品牌词,是比较好的,在选择关键词的时候多问问做过这行的朋友,或者百度相关部门的工作人员,结合热度去选择关键词。3。

关键词文章采集器(一台电脑如何操作工具:迈点-地方站数据采集软件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-09-15 08:07

关键词文章采集器准备工作:一台电脑如何操作工具:迈点-地方站数据采集软件步骤一:打开地方站数据采集软件打开软件,在页面右侧找到相应地方站数据,点击获取数据步骤二:下载传统破解版安装地方站数据采集软件,打开迈点,输入用户名,密码,点击下载传统破解版,安装步骤如下:步骤三:下载原版track加密软件并解压步骤四:百度经验下载常用网站步骤五:地方站采集软件安装好后打开使用常用网站步骤六:制作新表格并上传步骤七:统计数据,比对找到前十的目标目录,点击分析下载记录(数据来源渠道)如下步骤八:表格上传后统计数据、找到数据排名及目标来源渠道。

原来的表格统计步骤九:目标链接统计后,数据筛选添加,选择要采集的目标目录,数据即可统计步骤十:一键插入数据列使用原来的表格数据,新增一列,即可一键插入数据列。

我个人觉得迈点采购bigge数据库比较好,都可以收费使用的,我通过采购后整理的数据,我们自己做了个每周发布的全国部分餐饮店及娱乐场所,包括四川各个城市发布的数据,可以进入下载下文:1.餐饮篇2.酒吧篇3.影院篇4.游乐园篇5.spa会所篇6.小吃篇7.ktv篇8.商铺业务篇12.ktv歌手篇13.酒吧歌手篇14.景区景点业务篇15.多元杂志2016年起12期多元杂志首先是收费版,如下图:因为我是收费的,所以我就不发免费版的图片了。

免费版只要做表格里的数据就行,表格的话如下图。当然,如果有需要的话也可以上百度找一些数据采集软件。购买的话我看了一下,目前已经有在官网给的套餐购买的。我查了下,价格如下:不买买我也不太贵的。至于说分析数据,这是个专业活,尤其是这些餐饮业大佬的店,评论都不一样,分析那些就说不上了。收费版的能分析出餐饮大佬每一家的哪一个点点排名,每个点靠前靠后。付费版就没有分析软件的,分析出来数据也没有。就可以上百度找相关行业网站找到数据。 查看全部

关键词文章采集器(一台电脑如何操作工具:迈点-地方站数据采集软件)

关键词文章采集器准备工作:一台电脑如何操作工具:迈点-地方站数据采集软件步骤一:打开地方站数据采集软件打开软件,在页面右侧找到相应地方站数据,点击获取数据步骤二:下载传统破解版安装地方站数据采集软件,打开迈点,输入用户名,密码,点击下载传统破解版,安装步骤如下:步骤三:下载原版track加密软件并解压步骤四:百度经验下载常用网站步骤五:地方站采集软件安装好后打开使用常用网站步骤六:制作新表格并上传步骤七:统计数据,比对找到前十的目标目录,点击分析下载记录(数据来源渠道)如下步骤八:表格上传后统计数据、找到数据排名及目标来源渠道。

原来的表格统计步骤九:目标链接统计后,数据筛选添加,选择要采集的目标目录,数据即可统计步骤十:一键插入数据列使用原来的表格数据,新增一列,即可一键插入数据列。

我个人觉得迈点采购bigge数据库比较好,都可以收费使用的,我通过采购后整理的数据,我们自己做了个每周发布的全国部分餐饮店及娱乐场所,包括四川各个城市发布的数据,可以进入下载下文:1.餐饮篇2.酒吧篇3.影院篇4.游乐园篇5.spa会所篇6.小吃篇7.ktv篇8.商铺业务篇12.ktv歌手篇13.酒吧歌手篇14.景区景点业务篇15.多元杂志2016年起12期多元杂志首先是收费版,如下图:因为我是收费的,所以我就不发免费版的图片了。

免费版只要做表格里的数据就行,表格的话如下图。当然,如果有需要的话也可以上百度找一些数据采集软件。购买的话我看了一下,目前已经有在官网给的套餐购买的。我查了下,价格如下:不买买我也不太贵的。至于说分析数据,这是个专业活,尤其是这些餐饮业大佬的店,评论都不一样,分析那些就说不上了。收费版的能分析出餐饮大佬每一家的哪一个点点排名,每个点靠前靠后。付费版就没有分析软件的,分析出来数据也没有。就可以上百度找相关行业网站找到数据。

关键词文章采集器( 在互联网平台中,关键词优化工具有哪些?哪个比较好用呢?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2021-09-14 20:05

在互联网平台中,关键词优化工具有哪些?哪个比较好用呢?)

在互联网竞争激烈的时代,很多企业都想要自己的网站名列前枪。所以关键词优化是企业首选的方法之一。 关键词优化是指根据网站的产品主题和用户的搜索习惯,选择合适的关键词,利用有效的方法或工具将关键词优化到更高的位置。

那么,在互联网平台上,关键词优化工具有哪些?哪一个更好?今天就来看看吧!

一、关键词有哪些优化工具?

关键词Optimization 不是对关键词 的简单优化,它也是一个整体的优化过程,需要通过关键词 的选择、外部链接的构建、内容的填充。 网站'S 排名。

所以,你一定很想知道关键词optimization相关的工具,所以这里有一些常用和有用的工具:

1、关键词的分析优化工具(1)5118工具

5118工具可以分析关键词的热门系数等情况,显示的数据更全面。而且,相对来说,如果关键词人气系数比较高,优化起来会比较困难。

(2)爱站

爱站专门从事网站关键词分析的工作,即通过爱站可以清晰的看到关键词指数、关键词转化率等,可以避免企业选择流行的关键词不利于网站的最终优化效果。

另外爱站可以批量查询关键词收录情况,批量查询长尾关键词,批量查询IP,批量查询死链接,批量查询站群,批量查询页面状态码等功能。

(3)百度后台推广

百度后台推广可用于扩展关键词。该工具可以查询关键词日均搜索量、竞争情况等具体情况。

2、外链分析优化工具(1)百度站长平台

百度站长平台,自带外链分析功能,可以帮助企业验证网站的外链质量,然后大家可以避免劣质链接,也有利于网站的优化@效果。

3、内容分析工作

内容是关键词优化中最不可缺少的关键环节。但是,为了节省时间,降低内容便利的成本,一些公司会使用工具将采集content 当作伪原创。因此,可以通过内容采集器来分析内容的相似度来判断文章的内容质量。

二、关键词哪个优化工具好用?

综上所述,以上关键词优化工具可供企业参考。但是,关键词 工具分析是其中的一部分。最重要的是能不能优化,也就是说最终还是要回到网站的实际情况。所以企业最好找一个有经验和专业技能的优化公司,让他们根据网站的主题和用户的搜索习惯选择关键词进行优化,这样才能保证关键词一定时间内优化。转到主页以获得更好的产品曝光率。

但是,我们新的SEO在关键词优化方面有绝对优势。无论是热门词、大词,还是难以优化的关键词,我们都可以在7-90天内用形式化的方法优化首页位置。最重要的是,如果不能在规定时间内到达,我们将无条件接受退款。所以,萌心SEO值得您信赖。 查看全部

关键词文章采集器(

在互联网平台中,关键词优化工具有哪些?哪个比较好用呢?)

在互联网竞争激烈的时代,很多企业都想要自己的网站名列前枪。所以关键词优化是企业首选的方法之一。 关键词优化是指根据网站的产品主题和用户的搜索习惯,选择合适的关键词,利用有效的方法或工具将关键词优化到更高的位置。

那么,在互联网平台上,关键词优化工具有哪些?哪一个更好?今天就来看看吧!

一、关键词有哪些优化工具?

关键词Optimization 不是对关键词 的简单优化,它也是一个整体的优化过程,需要通过关键词 的选择、外部链接的构建、内容的填充。 网站'S 排名。

所以,你一定很想知道关键词optimization相关的工具,所以这里有一些常用和有用的工具:

1、关键词的分析优化工具(1)5118工具

5118工具可以分析关键词的热门系数等情况,显示的数据更全面。而且,相对来说,如果关键词人气系数比较高,优化起来会比较困难。

(2)爱站

爱站专门从事网站关键词分析的工作,即通过爱站可以清晰的看到关键词指数、关键词转化率等,可以避免企业选择流行的关键词不利于网站的最终优化效果。

另外爱站可以批量查询关键词收录情况,批量查询长尾关键词,批量查询IP,批量查询死链接,批量查询站群,批量查询页面状态码等功能。

(3)百度后台推广

百度后台推广可用于扩展关键词。该工具可以查询关键词日均搜索量、竞争情况等具体情况。

2、外链分析优化工具(1)百度站长平台

百度站长平台,自带外链分析功能,可以帮助企业验证网站的外链质量,然后大家可以避免劣质链接,也有利于网站的优化@效果。

3、内容分析工作

内容是关键词优化中最不可缺少的关键环节。但是,为了节省时间,降低内容便利的成本,一些公司会使用工具将采集content 当作伪原创。因此,可以通过内容采集器来分析内容的相似度来判断文章的内容质量。

二、关键词哪个优化工具好用?

综上所述,以上关键词优化工具可供企业参考。但是,关键词 工具分析是其中的一部分。最重要的是能不能优化,也就是说最终还是要回到网站的实际情况。所以企业最好找一个有经验和专业技能的优化公司,让他们根据网站的主题和用户的搜索习惯选择关键词进行优化,这样才能保证关键词一定时间内优化。转到主页以获得更好的产品曝光率。

但是,我们新的SEO在关键词优化方面有绝对优势。无论是热门词、大词,还是难以优化的关键词,我们都可以在7-90天内用形式化的方法优化首页位置。最重要的是,如果不能在规定时间内到达,我们将无条件接受退款。所以,萌心SEO值得您信赖。

关键词文章采集器(微博内容采集微博视频解析下载(组图)! )

采集交流 • 优采云 发表了文章 • 0 个评论 • 289 次浏览 • 2021-09-14 12:08

)

1、微博内容采集

微博评论采集,微博视频下载,微博app下载安装;怎么下载微博!免费下载微博;下载微博,如何下载微博视频?微博抓取工具;微博PC下载,微博下载安装?微博极速版下载?微博视频下载工具,下载微博视频;在哪里可以找到从微博下载的视频。怎么下载微博?下载微博电脑版!微博视频下载网站,微博下载安装免费下载最新版本?如何下载微博视频;如何下载微博视频。怎么下载微博?下载微博客户端,微博data采集!微博客户端下载,微博超级聊天下载app? 采集微博!抓取微博资料,下载微博电脑版,将微博视频下载到本地!下载微博,下载最新版微博!微博视频在线下载?微博电脑下载,如何在微博上下载视频。微博下载视频,微博免费下载;微博视频分析下载地址?微博视频下载;微博手机版下载,微博下载的视频在哪里;微博直播下载,微博视频分析下载网站,微博app下载!如何下载微博视频;如何在微博上下载视频,微博桌面下载?微博图片下载!微博视频下载解析!下载微博视频应用。下载微博APP,下载并安装微博Super Talk APP;批量下载微博图片。微博批采集、微博采集;获取微博信息。 优采云采集微博资料!微博内容爬取?如何在微博上下载视频,微博电脑客户端下载;电脑微博下载,微博评论捕捉!下载微博;下载安装微博?微博免费下载安装!微博分析视频下载。微博下载。微博视频分析下载,微博pc版下载;下载微博到手机!如何下载微博!微博数据抓拍!下载安装微博,微博采集器,如何在微博上下载视频;微博关键词抢;微博分期下载,微博数据抓取工具!如何下载微博视频,微博采集software。分享微博客户端下载;微博下载安装最新版?王者纷争的微博版下载了吗?微博信息采集;如何下载微博视频以及如何抓取微博数据。微博粉丝爬?将微博视频下载到本地!

直接下载:点击下载

备用下载:微云百度云(提取码:mhst)

请从本站下载,确保软件纯净无捆绑。目前已经发现很多下载网站所谓的高速下载都捆绑了各种流氓软件。请仔细分辨,小心。记住,这个软件不需要安装,下载后就可以使用了。

本软件目前的主要功能有:

①。可自定义过滤(匹配关键词,不包括关键词,时间范围)采集自发微博,到采集的信息可以批量下载删除

②。可自定义过滤(匹配关键词,排除关键词,时间范围,指定采集object)采集好友的所有微博,支持1对多个采集,采集To内容可批量下载

③。可自定义过滤(支持关键词,排除关键词,时间范围) 所有关注者发布的所有微博均按发布时间排序,内容可从采集批量下载

④.采集 内容包括文字、文章、图片和视频。文本内容部分支持生成单个txt文本,所有内容支持多种存储方式。可以通过月份、日期、发布时间、文本内容等命名方式来创建文件夹。同时支持生成HTML本地阅读页面,方便在浏览器上浏览和检索所有下载的信息内容。

软件会持续更新,更多功能,等你探索...

如果您有更多需求,可以点击软件上的【咨询定制】联系我们。

如果在使用过程中遇到一些问题,也可以参考这个文章:微博批量采集download 工具常见问题

关于报毒:在每个版本发布之前,我都会提交腾讯和360进行安全分析。这是腾讯哈勃的分析报告。本报告可以让您更了解软件的行为、是否存在风险操作、分析结果链接:腾讯哈勃分析系统()

正常情况下,本站下载的软件是绿色的,无广告,无绑定。 360、QQ安全管家,Tinder不会报病毒,但是win 10系统自带的杀毒软件可能会有误报,因为软件是为了防止恶意破解,所以微软杀毒软件会考虑软件不安全和误报可以通过添加以下排除项来解决。

软件截图:

查看全部

关键词文章采集器(微博内容采集微博视频解析下载(组图)!

)

1、微博内容采集

微博评论采集,微博视频下载,微博app下载安装;怎么下载微博!免费下载微博;下载微博,如何下载微博视频?微博抓取工具;微博PC下载,微博下载安装?微博极速版下载?微博视频下载工具,下载微博视频;在哪里可以找到从微博下载的视频。怎么下载微博?下载微博电脑版!微博视频下载网站,微博下载安装免费下载最新版本?如何下载微博视频;如何下载微博视频。怎么下载微博?下载微博客户端,微博data采集!微博客户端下载,微博超级聊天下载app? 采集微博!抓取微博资料,下载微博电脑版,将微博视频下载到本地!下载微博,下载最新版微博!微博视频在线下载?微博电脑下载,如何在微博上下载视频。微博下载视频,微博免费下载;微博视频分析下载地址?微博视频下载;微博手机版下载,微博下载的视频在哪里;微博直播下载,微博视频分析下载网站,微博app下载!如何下载微博视频;如何在微博上下载视频,微博桌面下载?微博图片下载!微博视频下载解析!下载微博视频应用。下载微博APP,下载并安装微博Super Talk APP;批量下载微博图片。微博批采集、微博采集;获取微博信息。 优采云采集微博资料!微博内容爬取?如何在微博上下载视频,微博电脑客户端下载;电脑微博下载,微博评论捕捉!下载微博;下载安装微博?微博免费下载安装!微博分析视频下载。微博下载。微博视频分析下载,微博pc版下载;下载微博到手机!如何下载微博!微博数据抓拍!下载安装微博,微博采集器,如何在微博上下载视频;微博关键词抢;微博分期下载,微博数据抓取工具!如何下载微博视频,微博采集software。分享微博客户端下载;微博下载安装最新版?王者纷争的微博版下载了吗?微博信息采集;如何下载微博视频以及如何抓取微博数据。微博粉丝爬?将微博视频下载到本地!

直接下载:点击下载

备用下载:微云百度云(提取码:mhst)

请从本站下载,确保软件纯净无捆绑。目前已经发现很多下载网站所谓的高速下载都捆绑了各种流氓软件。请仔细分辨,小心。记住,这个软件不需要安装,下载后就可以使用了。

本软件目前的主要功能有:

①。可自定义过滤(匹配关键词,不包括关键词,时间范围)采集自发微博,到采集的信息可以批量下载删除

②。可自定义过滤(匹配关键词,排除关键词,时间范围,指定采集object)采集好友的所有微博,支持1对多个采集,采集To内容可批量下载

③。可自定义过滤(支持关键词,排除关键词,时间范围) 所有关注者发布的所有微博均按发布时间排序,内容可从采集批量下载

④.采集 内容包括文字、文章、图片和视频。文本内容部分支持生成单个txt文本,所有内容支持多种存储方式。可以通过月份、日期、发布时间、文本内容等命名方式来创建文件夹。同时支持生成HTML本地阅读页面,方便在浏览器上浏览和检索所有下载的信息内容。

软件会持续更新,更多功能,等你探索...

如果您有更多需求,可以点击软件上的【咨询定制】联系我们。

如果在使用过程中遇到一些问题,也可以参考这个文章:微博批量采集download 工具常见问题

关于报毒:在每个版本发布之前,我都会提交腾讯和360进行安全分析。这是腾讯哈勃的分析报告。本报告可以让您更了解软件的行为、是否存在风险操作、分析结果链接:腾讯哈勃分析系统()

正常情况下,本站下载的软件是绿色的,无广告,无绑定。 360、QQ安全管家,Tinder不会报病毒,但是win 10系统自带的杀毒软件可能会有误报,因为软件是为了防止恶意破解,所以微软杀毒软件会考虑软件不安全和误报可以通过添加以下排除项来解决。

软件截图:

关键词文章采集器(经历过的几种搜索引擎很感冒的优化手段,打击引以为鉴)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-09-11 02:04

SEO 对大家来说并不陌生。个人站长和企业网站都离不开SEO优化。最终目的是为了更好的利用搜索引擎,引入更多的流量,产生收益~卖产品,扩大人气等等! SEO 是一把双刃剑。适当优化,网站的好处我就不多说了,相信大家都知道。今天就来说说我所知道和经历过的几种搜索引擎优化方法。 1.更改标题,描述,关键词更改标题这个搜索引擎响应最快。换标题的预感是:快照不更新,关键词排名下降,严重K站,说明,关键词换后兆集

SEO 坚信每个人都不陌生。站长和企业网站都离不开SEO的改进。最终目的是为了更好的利用百度搜索引擎引入大量的总流量,从而产生权益~商品的市场销售、推广等! SEO 是一把双刃剑。这是一个适度的改进。我很少谈论网站的好处。我坚信每个人都知道。今天就说说我所知道和体验过的几种百度搜索引擎,非常的狂热和冷酷。让我从严厉打击中吸取教训!

1.编辑标题、描述、关键词

百度搜索引擎修改标题反映较快,修改标题的惩罚是:快照更新不升级,关键词排名降低,K站越严重,叙事,症状基础后关键字修改,和修改后的主题类似,所以大家在发布网站前,要准确定位并明确网站主题风格、主题等。 网站放出后不用去的请不要试水。我亲身体验过,网站现阶段还没修复,大家吸取教训!

2.Redo,改模板,改网站网页文件目录

这更严重。 网站优化百度搜索引擎一般会在一段时间内将网站视为新网站。修改模板也是如此。这里要注意网址页面文件目录修改百度搜索引擎是很矛盾的。很容易进入沙盒游戏时期。仍然是那个点。这不是最后的手段。别动!

3.群do 外链,外链猛增

一些网站站长为了节省成本,贸然选择了一些社区论坛、博客等群发方式,快速增加外链。就这样,每个人都应该握手并离开。暴涨的外链很容易导致网站Immediate Being K,中度应用觉得好用,但一定要合适!对于这类问题,相信大家也见过不少惨痛的例子。这不是这里的老话!

4.友链

友情链接也是一种外部链接。您无法快速添加好友链接。建议每天创建的好友链接不要超过五个。朋友链的质量应该不会差,一定要经常检查。例如,如果快照更新较慢,最好尽快删除这种连接,以免被拖下。现在PR不再升级,没有意义,所以在做连接的时候不能用PR来区分对方网站!另外,不知道大家有没有遇到过。朋友链关键词过多,容易导致降级处罚。过去,我的网站使用了 10 个不同的链接关键字来更好地改进长尾词。 ,结果大家有目共睹。建议主关键词准确定位在1~3以内,长尾关键词1~3,友情链接关键词总数不要超过5个!

5.Collect,复制文章content

Data采集器坚信大家并不陌生,但是这个东西的时代早已过去了。现在在data采集器的帮助下很难实现,自然淘汰一些高手。一个网站如果所有的合集都是基于文章的内容,那么百度搜索引擎不会轻易给网站多少权重值,所以还是稳妥写好原站,让客户体验对百度搜索引擎更好 也更友好,真是太糟糕了原创文章 也能用。所以请和data采集器说再见,不要再浪费网络了!

以上方面均为本人亲身经历,风险自负。 网站百度收录减少,关键词排名千里,总流量明显,现阶段还没有恢复正常,大家多加关注。 网站发布前,先明确网站的精准定位、模板、标题等,尽量减少发布后的修改和上述优化方法。文笔不是很好,见谅!

转载请注明:爱推特»刷百度 Changwei关键词ranking:友情链接的关键词总数不能超过5个! 查看全部

关键词文章采集器(经历过的几种搜索引擎很感冒的优化手段,打击引以为鉴)

SEO 对大家来说并不陌生。个人站长和企业网站都离不开SEO优化。最终目的是为了更好的利用搜索引擎,引入更多的流量,产生收益~卖产品,扩大人气等等! SEO 是一把双刃剑。适当优化,网站的好处我就不多说了,相信大家都知道。今天就来说说我所知道和经历过的几种搜索引擎优化方法。 1.更改标题,描述,关键词更改标题这个搜索引擎响应最快。换标题的预感是:快照不更新,关键词排名下降,严重K站,说明,关键词换后兆集

SEO 坚信每个人都不陌生。站长和企业网站都离不开SEO的改进。最终目的是为了更好的利用百度搜索引擎引入大量的总流量,从而产生权益~商品的市场销售、推广等! SEO 是一把双刃剑。这是一个适度的改进。我很少谈论网站的好处。我坚信每个人都知道。今天就说说我所知道和体验过的几种百度搜索引擎,非常的狂热和冷酷。让我从严厉打击中吸取教训!

1.编辑标题、描述、关键词

百度搜索引擎修改标题反映较快,修改标题的惩罚是:快照更新不升级,关键词排名降低,K站越严重,叙事,症状基础后关键字修改,和修改后的主题类似,所以大家在发布网站前,要准确定位并明确网站主题风格、主题等。 网站放出后不用去的请不要试水。我亲身体验过,网站现阶段还没修复,大家吸取教训!

2.Redo,改模板,改网站网页文件目录

这更严重。 网站优化百度搜索引擎一般会在一段时间内将网站视为新网站。修改模板也是如此。这里要注意网址页面文件目录修改百度搜索引擎是很矛盾的。很容易进入沙盒游戏时期。仍然是那个点。这不是最后的手段。别动!

3.群do 外链,外链猛增

一些网站站长为了节省成本,贸然选择了一些社区论坛、博客等群发方式,快速增加外链。就这样,每个人都应该握手并离开。暴涨的外链很容易导致网站Immediate Being K,中度应用觉得好用,但一定要合适!对于这类问题,相信大家也见过不少惨痛的例子。这不是这里的老话!

4.友链

友情链接也是一种外部链接。您无法快速添加好友链接。建议每天创建的好友链接不要超过五个。朋友链的质量应该不会差,一定要经常检查。例如,如果快照更新较慢,最好尽快删除这种连接,以免被拖下。现在PR不再升级,没有意义,所以在做连接的时候不能用PR来区分对方网站!另外,不知道大家有没有遇到过。朋友链关键词过多,容易导致降级处罚。过去,我的网站使用了 10 个不同的链接关键字来更好地改进长尾词。 ,结果大家有目共睹。建议主关键词准确定位在1~3以内,长尾关键词1~3,友情链接关键词总数不要超过5个!

5.Collect,复制文章content

Data采集器坚信大家并不陌生,但是这个东西的时代早已过去了。现在在data采集器的帮助下很难实现,自然淘汰一些高手。一个网站如果所有的合集都是基于文章的内容,那么百度搜索引擎不会轻易给网站多少权重值,所以还是稳妥写好原站,让客户体验对百度搜索引擎更好 也更友好,真是太糟糕了原创文章 也能用。所以请和data采集器说再见,不要再浪费网络了!

以上方面均为本人亲身经历,风险自负。 网站百度收录减少,关键词排名千里,总流量明显,现阶段还没有恢复正常,大家多加关注。 网站发布前,先明确网站的精准定位、模板、标题等,尽量减少发布后的修改和上述优化方法。文笔不是很好,见谅!

转载请注明:爱推特»刷百度 Changwei关键词ranking:友情链接的关键词总数不能超过5个!

关键词文章采集器(用扩展函数处理采集到的原始数据/--预定)

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-09-11 02:03

以下为引用内容:

//---------------------------------

//使用扩展函数处理来自采集的原创数据

//-------------------------------

函数 RunPHP($fvalue,$phpcode)

{

$DedeMeValue = $fvalue;

$phpcode = preg_replace("/'@me'|\"@me\"|@me/isU",'$DedeMeValue',$phpcode);

if(eregi('@body',$phpcode)){

$DedeBodyValue = $this->tmpHtml;

$phpcode = preg_replace("/'@body'|\"@body\"|@body/isU",'$DedeBodyValue',$phpcode);

}

if(eregi('@litpic',$phpcode)){

$DedeLitPicValue = $this->breImage;

$phpcode = preg_replace("/'@litpic'|\"@litpic\"|@litpic/isU",'$DedeLitPicValue',$phpcode);

}

@eval($phpcode.";");

返回 $DedeMeValue;

}

这里定义了几个默认的预定变量

现在我们要添加一个@url