优采云自动文章采集 sign failed11

优采云自动文章采集是一个常见的错误信息

采集交流 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2023-02-11 17:26

Sign failed11是一个常见的错误信息,表明优采云软件无法正常登录服务器。这可能是因为用户名/密码错误、网络不稳定、服务器出错等原因所导致的。因此,用户在遭遇sign failed11之前,应该先检查一下账号密码是否正确,再判断当前所处的网络情况。如果都无法解决问题,可以尝试联系优采云客服人员进行帮助。

优采云是一家专注于SEO内容优化技术的公司,其官方网站www.ucaiyun.com上提供了大量关于文章采集的相关信息和教程,用户也可以在上面找到很多帮助性的内容。此外,优采云也有一整套专业、专注、高效、全方位的SEO优化服务体系来帮助用户更好地开展文章采集工作。

总之,sign failed11是一个很常见但又不容易解决的问题。如果遭遇sign failed11问题,用户应该尝试根据上述方法进行尝试并排除出错原因。如果无法解决问题,不妨考虑使用优采云SEO优化来帮助文章采集工作。 查看全部

近年来,随着互联网的发展,文章采集已成为一种流行的媒体技术。在众多的文章采集软件中,优采云自动文章采集是一款性能卓越的软件,它可以帮助用户快速、高效地采集各种类型的文章。然而,有时用户可能会遇到sign failed11的问题,这时就需要更多的关注。

Sign failed11是一个常见的错误信息,表明优采云软件无法正常登录服务器。这可能是因为用户名/密码错误、网络不稳定、服务器出错等原因所导致的。因此,用户在遭遇sign failed11之前,应该先检查一下账号密码是否正确,再判断当前所处的网络情况。如果都无法解决问题,可以尝试联系优采云客服人员进行帮助。

优采云是一家专注于SEO内容优化技术的公司,其官方网站www.ucaiyun.com上提供了大量关于文章采集的相关信息和教程,用户也可以在上面找到很多帮助性的内容。此外,优采云也有一整套专业、专注、高效、全方位的SEO优化服务体系来帮助用户更好地开展文章采集工作。

总之,sign failed11是一个很常见但又不容易解决的问题。如果遭遇sign failed11问题,用户应该尝试根据上述方法进行尝试并排除出错原因。如果无法解决问题,不妨考虑使用优采云SEO优化来帮助文章采集工作。

事实:做了N个采集,都是处理内容失败(官方看下)

采集交流 • 优采云 发表了文章 • 0 个评论 • 382 次浏览 • 2022-12-22 09:29

采集器的问题我们开发已经查过了,下面是他们的回答:

个别文章采集不到和跳课的原因主要有两个。

一种是php无法读取对方的网站。

二是php从对方服务器获取图片保存到本地的时间可能过长。 而且,有些东西读过了,但是图片读不出来(读图片的时候网络突然忙,导致图片打不开)。

这块不是程序造成的,原因是:

1.网络繁忙导致php执行超时

2、目标内容(包括:URL、图片)无响应、404错误或其他错误。

造成这种情况的原因有很多,比如网络拥堵,防盗机制,你自己的服务器突然以某种方式繁忙等等。

解决方案:

全部采集完之后,可以再进行一次采集,这样已经采集到的内容会被跳过,重新采集因为网络繁忙而失败的内容。

ss6 -> ss7采集机制调整不多,所以不会有6线7的不稳定因素

后续版本会在采集机制上做更多的优化。

定时任务采集、断点续采集、内容图片分离采集等。

汇总:渗透测试之信息收集篇(含思维导图)

爱站记录查询

域名助手备案信息查询

11、查询绿盟科技的whois信息

域名查询

查看注册人和邮箱获取更多域名

12. 采集子域 12.1。 子域的功能

采集子域名可以扩大测试范围,同一域名下的二级域名都属于目标范围。

12.2. 常用方法

子域中常见的资产类型一般包括办公系统、邮件系统、论坛、商城等管理系统,网站管理后台也可能出现在子域中。

首先找到目标站点,在官网可以找到相关资产(主要是办公系统、邮件系统等)。 关注页面底部,可能会有管理后台等收获。

查找目标域名信息的方法如下:

FOFA title="公司名称"

百度intitle=公司名称

Google intitle=公司名称

站长之家,可直接搜索名称或网站域名查看相关信息:

钟馗之眼站点=域名

找到官网后,采集子域名。 以下是一些采集子域名的推荐方法。 可以直接输入域名查询。

12.3. 域名类型

A记录、别名记录(CNAME)、MX记录、TXT记录、NS记录:

12.3.1。 A(地址)记录:

用于指定主机名(或域名)对应的IP地址记录。 用户可以将域名下的网站服务器指向自己的网站服务器。 同时,您还可以设置您的域名的二级域名。

12.3.2。 别名(CNAME)记录:

也称为规范名称。 这种类型的记录允许您将多个名称映射到同一台计算机。 通常用于同时提供 WWW 和 MAIL 服务的计算机。 例如,有一台名为“”的计算机(A记录)。 同时提供WWW和MAIL服务,方便用户访问服务。 可以为这台计算机设置两个别名(CNAME):WWW 和 MAIL。 这两个别名的全称是“”和“”。 其实都指向“”。

当你有多个域名需要指向同一个服务器IP时,可以使用同样的方法。 这时候可以给一个域名做一个A记录指向服务器IP,然后把其他域名别名到有之前A记录的域名上。 那么当你的服务器IP地址发生变化的时候,你就不用费心费力地一个一个的改域名了。 您只需要更改做A记录的域名,其他做别名的域名也会自动更改为新的IP地址。

12.3.3。 如何检测CNAME记录?

1、进入命令状态; (开始菜单-运行-CMD【回车】);

2、输入命令“nslookup -q=cname 此处填写对应的域名或二级域名”,查看返回结果是否与设置一致。

12.3.4。 MX(邮件交换器)记录:

它是一条邮件交换记录,指向一个邮件服务器,供电子邮件系统在发送邮件时根据收件人的地址后缀定位邮件服务器。 例如,当Internet上的用户要寄信给 时,用户的邮件系统通过DNS查找该域名的MX记录。 如果MX记录存在,则用户计算机将邮件发送到MX记录指定的邮件服务器。 .

12.3.5。 什么是 TXT 记录? :

TXT记录一般是指对主机名或域名的指令集,例如:

1) admin IN TXT "jack, mobile:";

2)mail IN TXT》邮件主机,存放于xxx,管理员:AAA,Jim IN TXT》联系人:

也就是你可以设置TXT,这样别人就可以联系到你了。

如何检测TXT记录?

1、进入命令状态; (开始菜单-运行-CMD【回车】);

2、输入命令“nslookup -q=txt 在此填写对应的域名或二级域名”,查看返回结果是否与设置一致。

12.3.6。 什么是 NS 记录?

ns记录的全称是Name Server,也就是域名服务器记录,用来明确你的域名当前是由哪台DNS服务器解析的。

12.3.7。 子域名在线查询1

12.3.8。 子域名在线查询2

12.3.9。 DNS检测

12.3.10。 IP138查询子域

12.3.11。 FOFA 搜索子域

语法:域=“”

Tips:以上两种方式不需要爆破,查询速度快。 当资产需要快速采集时,可以先使用,以后再通过其他方式补充。

12.3.12。 Hackertarget 查询子域

注意:通过该方法查询子域名可以得到目标的一个大概的ip段,然后就可以通过ip采集信息了。

12.4。 360映射空间

领域: ”*。”

12.4.1。 图层子域挖掘机

12.4.2。 子域蛮干

pip 安装 aiodns

运行命令 subDomainsBrute.py

subDomainsBrute.py --full -o freebuf2.txt

12.4.3。 子列表3r

pip install -r requirements.txt

提示:以上方法是对子域名进行爆破,因为字典功能更强大,所以效率更高。

帮助文档

<p style="margin-top: 0px;margin-bottom: 0px;">usage: sublist3r.py [-h] -d DOMAIN [-b [BRUTEFORCE]] [-p PORTS] [-v [VERBOSE]]<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />[-t THREADS] [-e ENGINES] [-o OUTPUT] [-n]<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />OPTIONS:<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-h, --help show this help message and exit<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-d DOMAIN, --domain DOMAIN<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Domain name to enumerate it's subdomains<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-b [BRUTEFORCE], --bruteforce [BRUTEFORCE]<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Enable the subbrute bruteforce module<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-p PORTS, --ports PORTS<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Scan the found subdomains against specified tcp ports<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-v [VERBOSE], --verbose [VERBOSE]<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Enable Verbosity and display results in realtime<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-t THREADS, --threads THREADS<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Number of threads to use for subbrute bruteforce<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-e ENGINES, --engines ENGINES<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Specify a comma-separated list of search engines<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-o OUTPUT, --output OUTPUT<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Save the results to text file<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-n, --no-color Output without color</p>

示例:python sublist3r.py -d

中文翻译

-h:帮助

-d : 指定主域名枚举子域名

-b : 调用 subbrute 来暴力枚举子域名

-p : 指定扫描子域名的tpc端口

-v :显示实时详细结果

-t : 指定线程

-e : 指定搜索引擎

-o : 将结果保存到文本

-n : 没有颜色的输出

扫描子域的默认参数

python sublist3r.py -d

使用暴力枚举子域

python sublist3r -b -d

12.4.4。 python2.7.14环境

;C:\Python27;C:\Python27\脚本

12.4.5。 万物皆可

pip3 install --user -r requirements.txt -i

python3 oneforall.py --target run /*采集*/

爆炸子域

例子:

<p style="margin-top: 0px;margin-bottom: 0px;">brute.py --target domain.com --word True run<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />brute.py --targets ./domains.txt --word True run<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />brute.py --target domain.com --word True --concurrent 2000 run<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />brute.py --target domain.com --word True --wordlist subnames.txt run<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />brute.py --target domain.com --word True --recursive True --depth 2 run<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />brute.py --target d.com --fuzz True --place m.*.d.com --rule '[a-z]' run<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />brute.py --target d.com --fuzz True --place m.*.d.com --fuzzlist subnames.txt run</p>

12.4.6。 域名

<p style="margin-top: 0px;margin-bottom: 0px;">dnsburte.py -d aliyun.com -f dnspod.csv -o aliyun.log<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />wydomain.py -d aliyun.com</p>

12.4.7。 模糊域

12.4.8。 隐藏域名主机冲突

隐藏资产检测-主机碰撞

很多时候访问目标资产的IP响应是:401、403、404、500,但是域名请求可以返回正常的业务系统(禁止直接IP访问),因为大部分需要绑定向主机正常请求访问(目前互联网公司的基本做法)(域名已经删除了A记录,但是反向生成的配置还没有更新),那么我们就可以将采集到的目标域名和目标资产的IP段,并用IP段+域名的形式进行捆绑碰撞,可以发现很多有趣的东西。

发送http请求时,将域名和IP列表配对,然后遍历发送请求(相当于修改本地hosts文件),对比对应的标题和响应包大小,快速找出一些隐藏资产。

Hosts collision需要目标的域名和目标的相关IP作为字典

更不用说域名了

相关IP来源有:

目标域名历史分析IP

ip 常规

13.端口扫描

确定目标的大概ip段后,可以先检测ip的开放端口。 某些特定服务可能会在默认端口上打开。 检测开放端口有利于快速采集目标资产,找到目标网站的其他功能站点。

13.1. msscan 端口扫描

msscan -p 1-65535 ip --rate=1000

13.2. 御剑端口扫描工具

13.3. nmap扫描端口并检测端口信息

常用参数,如:

nmap -sV 192.168.0.2

nmap -sT 92.168.0.2

nmap -Pn -A -sC 192.168.0.2

nmap -sU -sT -p0-65535 192.168.122.1

用于扫描目标主机服务版本号和开放端口

如果需要扫描多个ip或者ip段,可以保存到一个txt文件中

nmap -iL ip.txt

扫描列表中的所有 ip。

Nmap 是最常用的端口检测方法。 操作简单,输出结果非常直观。

13.4. 在线端口检测

13.5。 端口扫描器

御剑、msscan、nmap等

御剑高速端口扫描器:

填写你要扫描的ip段(如果只扫描一个ip,只需填写起始IP和结束IP),可以选择不更改默认端口列表,也可以选择自己指定端口。

13.6. 渗透端口

21,22,23,1433,152,3306,3389,5432,5900,50070,50030,50000,27017,27018,11211,9200,9300,7001,7002,6379,5984,873,443,8000-9090,80- 89,80,10000,8888,8649,8083,8080,8089,9090,7778,7001,7002,6082,5984,4440,3312,3311,3128,2601,2604,2222,2082,2083,389,88,512, 51 1025,111,1521,445,135,139,53

13.7。 穿透常用端口及对应服务

1、Web类(web漏洞/敏感目录)

第三方通用组件漏洞struts thinkphp jboss ganglia zabbix

80 网站

80-89网页

8000-9090 网页

2.数据库类(弱口令扫描)

第1433章

第1521章

3306 MySQL

5432 PostgreSQL 数据库

3.特殊服务类(未授权/命令执行类/漏洞)

第443章

873 Rsync 未经授权

5984 CouchDB:5984/_utils/

6379 Redis 未授权

7001,7002 WebLogic默认弱口令,反序列化

9200,9300 elasticsearch 参考WooYun:玩服务器ElasticSearch命令执行漏洞

11211 memcache 未授权访问

27017、27018 Mongodb 未授权访问

执行了 50000 个 SAP 命令

50070、50030 hadoop默认端口未授权访问

4.常用端口类(扫描弱口令/端口爆破)

21 英尺

22 SSH

23 远程登录

2601,2604 zebra路由,默认密码zebra

3389 远程桌面

5.端口总明细

21 英尺

22 SSH

23 远程登录

80 网站

80-89网页

第161话

第389章

443 SSL Heartbleed 和一些网络漏洞测试

445 家中小企业

512,513,514 雷克斯

873 Rsync 未经授权

1025,111 NFS

第1433章

1521 甲骨文:(iSqlPlus 端口:5560、7778)

2082/2083 cpanel主机管理系统登录(国外多用)

2222 DA虚拟主机管理系统登录(国外多用)

2601,2604 zebra路由,默认密码zebra

3128 squid代理默认端口,如果不设置密码,可以直接漫游内网

3306 MySQL

3312/3311康乐主机管理系统登录

3389 远程桌面

4440 rundeck 参考无云:借新浪服务成功漫游新浪内网

5432 PostgreSQL 数据库

5900 越南

5984 CouchDB:5984/_utils/

6082 Varnish 参考WooYun:Varnish HTTP加速器 CLI 未授权访问容易导致直接篡改网站或代理访问内网

6379 Redis 未授权

7001,7002 WebLogic默认弱口令,反序列化

7778 Kloxo 主机控制面板登录

8000-9090是一些常用的web端口,有些运维喜欢在这些非80端口上开启管理后台

8080 tomcat/WDCP主机管理系统,默认弱密码

8080、8089、9090 JBOSS

8083 Vestacp主机管理系统(国外多用)

8649 神经节

8888 amh/LuManager主机管理系统默认端口

9200,9300 elasticsearch 参考WooYun:玩服务器ElasticSearch命令执行漏洞

10000 Virtualmin/Webmin服务器虚拟主机管理系统

11211 memcache 未授权访问

27017、27018 Mongodb 未授权访问

28017 mongodb统计页面

执行了 50000 个 SAP 命令

50070、50030 hadoop默认端口未授权访问

13.8。 常用端口及攻击方式

14.查找真实ip

如果目标网站使用CDN,则隐藏cdn的真实ip。 要想找到真实服务器,就必须获取真实ip,根据这个ip继续查询侧站。

注意:很多情况下,虽然主站使用了CDN,但是子域名不一定使用CDN。 如果主网站和子域名在同一个ip段,那么也是找到子域名真实ip的一种方式。

14.1. Ping多处确认是否使用CDN

14.2. 查询历史DNS解析记录

在查询到的历史分析记录中,最早的历史分析IP很可能记录的是真实IP。 推荐使用此方法快速找到真实IP,但不是所有网站都能找到。

14.2.1。 域名数据库

14.2.2。 微步在线

14.2.3。

14.2.4。 查看DNS

14.3. php信息

如果目标网站存在phpinfo泄露等情况,可以在phpinfo中的SERVER_ADDR或_SERVER["SERVER_ADDR"]中查找真实ip

14.4. 绕过CDN

绕过CDN的方法有很多,请参考

15. 边站和C段

边站通常有业务功能站点。 建议先采集已有IP的边站,再检测C网段,确定C网段的目标后,在C网段的基础上重新采集边站。

辅助站点是与已知目标站点位于同一服务器上但具有不同端口的站点。 通过以下方法搜索到副站后,首先访问确定是否是您需要的站址信息。

15.1.1。 站长主页

用ip网站查询

15.2. 谷歌黑客

15.2.1。 网络空间搜索引擎

比如FOFA搜边站和C段

这种方式效率更高,可以直观的看到站点标题,但也有不收录不常用端口的情况。 虽然这种情况很少见,但您可以在后期补充资产时,通过以下方式再次扫描领取。

15.2.2。 线上段c

c部分使用脚本

<p style="margin-top: 0px;margin-bottom: 0px;">pip install requests<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />#coding:utf-8<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />import requests<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />import json<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />def get_c(ip):<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />print("正在收集{}".format(ip))<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />url="http://api.webscan.cc/?action=query&ip={}".format(ip)<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />req=requests.get(url=url)<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />html=req.text<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />data=req.json()<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />if 'null' not in html:<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />with open("resulit.txt", 'a', encoding='utf-8') as f:<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />f.write(ip + '\n')<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />f.close()<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />for i in data:<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />with open("resulit.txt", 'a',encoding='utf-8') as f:<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />f.write("\t{} {}\n".format(i['domain'],i['title']))<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />print(" [+] {} {}[+]".format(i['domain'],i['title']))<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />f.close()<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />def get_ips(ip):<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />iplist=[]<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />ips_str = ip[:ip.rfind('.')]<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />for ips in range(1, 256):<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />ipadd=ips_str + '.' + str(ips)<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />iplist.append(ipadd)<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />return iplist<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />ip=input("请你输入要查询的ip:")<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />ips=get_ips(ip)<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />for p in ips:<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />get_c(p)</p>

15.2.3。 Nmap、Msscan扫描等

例如:nmap -p 80,443,8000,8080 -Pn 192.168.0.0/24

15.2.4。 公共端口表

21,22,23,80-90,161,389,443,445,873,1099,1433,1521,1900,2082,2083,2222,2601,2604,3128,3306,3311,3312,3389,4440,4848,5432,92,5569,5569,5569 ,6082,6379,7001-7010,7778,8080-8090,8649,8888,9000,9200,10000,11211,27017,28017,50000,50030,50060,135,139,445,53,88

注意:在检测网段C时,一定要确认ip是否属于目标,因为一个网段C中不一定所有的ip都属于目标。

16.网络空间搜索引擎

如果你想在短时间内快速采集资产,那么使用网络空间搜索引擎是一个不错的选择。 可以直观的看到边站、端口、站点标题、IP等信息,点击列出站点即可直接访问。 判断是否是您需要的站点信息。 FOFA 的通用语法

1、同IP端站:ip="192.168.0.1"

2、C段:ip="192.168.0.0/24"

3.子域名:domain=""

4.标题/关键字:title="百度"

5.如果需要将结果缩小到某个城市,可以拼接语句

title="百度" && region="北京"

17.扫描敏感目录/文件

扫描敏感目录需要强大的字典,需要平时积累。 拥有强大的词典可以更高效地查明网站的管理后台。 常见的敏感文件如.git文件泄露,.svn文件泄露,phpinfo泄露等,这一步就成功了一半,各种扫描器就够了。 在域名中输入目标站点,选择对应的词典类型,即可开始扫描,非常方便。

17.1. 御剑

17.2. 7kbstorm

17.3. 扫描仪

在已经安装pip的前提下,可以直接:

<p style="margin-top: 0px;margin-bottom: 0px;">pip install -r requirements.txt</p>

用法示例:

扫描单个 Web 服务

python BBScan.py --host

扫描下其他主机

python BBScan.py --host --network 28

扫描txt文件中的所有主机

蟒蛇 BBScan.py -f .txt

从文件夹中导入所有主机并扫描

python BBScan.py -d 目标/

--network参数用于设置子网掩码,小公司设置为28~30,中型公司设置为26~28,大公司设置为24~26

当然,尽量避免设置为24,扫描太耗时,除非你想在每个src中多扫描几个漏洞。

这个插件是从内部扫描器中提取的,感谢 Jekkay Hu

如果你有非常有用的规则,请找几个网站验证测试一下,然后pull request

脚本也会优化,接下来的事情:

添加有用的规则,更好地分类规则,细化

然后,您可以直接从 rules\request 文件夹中导入 HTTP_request

优化扫描逻辑

17.4. 目录映射

<p style="margin-top: 0px;margin-bottom: 0px;">pip install -r requirement.txt<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />https://github.com/H4ckForJob/dirmap</p>

单一目标

<p style="margin-top: 0px;margin-bottom: 0px;">python3 dirmap.py -i https://target.com -lcf</p>

多个目标

<p style="margin-top: 0px;margin-bottom: 0px;">python3 dirmap.py -iF urls.txt -lcf</p>

17.5。 直接搜索

解压目录搜索.zip

python3 dirsearch.py -u -e *

17.6. 火药

<p style="margin-top: 0px;margin-bottom: 0px;">sudo apt-get install gobuster<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />gobuster dir -u https://www.servyou.com.cn/ -w /usr/share/wordlists/dirbuster/directory-list-2.3-medium.txt -x php -t 50</p>

dir -u URL w dictionary -x 指定后缀 -t 线程数

<p style="margin-top: 0px;margin-bottom: 0px;">dir -u https://www.servyou.com.cn/ -w /usr/share/wordlists/dirbuster/directory-list-2.3-medium.txt -x "php,html,rar,zip" -d --wildcard -o servyou.log | grep ^"3402"</p>

17.7. 网站文件

机器人.txt

跨域.xml

站点地图.xml

后台目录

网站安装包

网站上传目录

mysql管理页面

php信息

网站文本编辑器

测试文件

网站备份文件(.rar、zip、.7z、.tar.gz、.bak)

DS_Store 文件

vim 编辑器备份文件 (.swp)

WEB—INF/web.xml 文件

15.git

16.svn

18.扫描网页备份

例如

配置.php

配置.php~

配置.php.bak

配置.php.swp

配置.php.rar

配置文件.php.tar.gz

19.网站头部信息采集

1.中间件:web服务【Web Servers】apache iis7 iis7.5 iis8 nginx WebLogic tomcat

2.网站组件:js组件jquery、vue页面布局bootstrap

通过浏览器访问

Firefox 插件 Wappalyzer

curl命令查询头部信息

卷曲-i

20. 敏感文件搜索 20.1. GitHub 搜索

in:name test #仓库标题搜索收录关键字test

in:descripton test #仓库描述搜索收录关键字

in:readme test #Readme文件搜索收录关键字

搜索某些系统的密码

++密码+3306&type=密码

github关键词监控

谷歌搜索

站点:sa 密码

站点:root密码

站点:用户;密码

网站:inurl:sql

SVN信息采集

站点:svn

站点:svn 用户名

站点:svn密码

站点:svn 用户名密码

综合信息采集

站点:密码

站点:ftp ftppassword

站点:密码

网站:内部

+&类型=代码

20.2. 谷歌黑客

站点:域名

inurl:url中存在的关键字网页

intext:网页正文中的关键词

filetype:指定文件类型

20.3。 乌云漏洞库

20.4。 网盘搜索

凌云搜索

潘多多:

泛搜索搜索:

泛搜索:

20.5。 社会工作图书馆

姓名/常用id/邮箱/密码/手机登录网盘网站邮箱查找敏感信息

机器人

20.6. 网站注册信息

查询网站注册信息

它通常与社会工程库一起使用。

20.7。 js敏感信息

20.7.1。 搜索器

python3 JSFinder.py -u

python3 JSFinder.py -u -d

python3 JSFinder.py -u -d -ou mi_url.txt -os mi_subdomain.txt

当你想获取更多信息时,可以使用-d进行深度爬取获取更多内容,使用命令-ou、-os指定子域保存的URL和文件名

批量指定url和js链接,获取里面的url。

指定网址:

python JSFinder.py -f 文本.txt

指定JS:

python JSFinder.py -f 文本.txt -j

20.7.2。 加壳模糊器

找到网站交互界面授权密钥

随着WEB前端打包工具的普及,你在日常的渗透测试和安全服务中是否遇到越来越多以Webpack packager为代表的网站? 这类打包器会将整个站点的API和API参数打包在一起进行集中web调用,也方便我们快速发现网站的功能和API列表,但是往往这些打包器生成的JS文件数量异常庞大且总是 JS 代码量极其庞大(高达数万行),给我们手动测试带来了极大的不便,于是 Packer Fuzzer 软件应运而生。

本工具支持自动模糊提取目标站点对应的API和API对应的参数内容,支持模糊高效模糊高效检测七大漏洞:未授权访问、敏感信息泄露、CORS、SQL注入、横向越权访问、弱口令、任意文件上传快速检测。 扫描结束后,该工具还支持自动生成扫描报告,可以选择便于分析的HTML版本,也可以选择比较正规的doc、pdf、txt版本。

sudo apt-get 安装 nodejs && sudo apt-get 安装 npm

混帐克隆

pip3 install -r requirements.txt

python3 PackerFuzzer.py -u

20.7.3。 秘密发现者

一个基于Python脚本的JavaScript敏感信息搜索工具

python3 SecretFinder.py -i -e

cms识别

采集网站信息后,应对网站进行指纹识别。 通过识别指纹,可以确定目标的cms和version,方便下一步测试计划的制定。 可以使用public poc或者自己积累相应的方法进行正式的渗透测试。

21.1. 云溪

21.2. 潮汐指纹

21.3。 CMS指纹识别

确认

21.4。 什么cms

21.5。 御cms识别

22. 非常规作业

1、如果找到了目标的某项资产,却无从下手搜集目标的其他资产,可以查看网站正文中是否有目标的特征,然后使用网络空间搜索引擎(如fofa , 等)特征进行搜索,如:body=”XX公司”或body=”baidu”等。

这种方式一般适用于特征明显、资产数量多的标的,效果往往比较突出。

2、通过以上方式找到特征后,再次搜索body,再搜索,此时fofa上显示的ip,大概率是真实ip。

3.如果需要针对政府网站,可以在批量获取网站首页的时候使用

然后可以结合上一步的方法进行进一步的信息采集。

23、SSL/TLS证书查询

SSL/TLS 证书通常收录域名、子域名和电子邮件地址等信息。 结合证书中的信息,您可以更快地定位到目标资产,获取目标资产的更多信息。

SSL证书搜索引擎:

%。

GetDomainsBySSL.py

24.找到厂商的ip段

25. 移动资产采集 25.1. 微信小程序 支付宝小程序 查看全部

事实:做了N个采集,都是处理内容失败(官方看下)

采集器的问题我们开发已经查过了,下面是他们的回答:

个别文章采集不到和跳课的原因主要有两个。

一种是php无法读取对方的网站。

二是php从对方服务器获取图片保存到本地的时间可能过长。 而且,有些东西读过了,但是图片读不出来(读图片的时候网络突然忙,导致图片打不开)。

这块不是程序造成的,原因是:

1.网络繁忙导致php执行超时

2、目标内容(包括:URL、图片)无响应、404错误或其他错误。

造成这种情况的原因有很多,比如网络拥堵,防盗机制,你自己的服务器突然以某种方式繁忙等等。

解决方案:

全部采集完之后,可以再进行一次采集,这样已经采集到的内容会被跳过,重新采集因为网络繁忙而失败的内容。

ss6 -> ss7采集机制调整不多,所以不会有6线7的不稳定因素

后续版本会在采集机制上做更多的优化。

定时任务采集、断点续采集、内容图片分离采集等。

汇总:渗透测试之信息收集篇(含思维导图)

爱站记录查询

域名助手备案信息查询

11、查询绿盟科技的whois信息

域名查询

查看注册人和邮箱获取更多域名

12. 采集子域 12.1。 子域的功能

采集子域名可以扩大测试范围,同一域名下的二级域名都属于目标范围。

12.2. 常用方法

子域中常见的资产类型一般包括办公系统、邮件系统、论坛、商城等管理系统,网站管理后台也可能出现在子域中。

首先找到目标站点,在官网可以找到相关资产(主要是办公系统、邮件系统等)。 关注页面底部,可能会有管理后台等收获。

查找目标域名信息的方法如下:

FOFA title="公司名称"

百度intitle=公司名称

Google intitle=公司名称

站长之家,可直接搜索名称或网站域名查看相关信息:

钟馗之眼站点=域名

找到官网后,采集子域名。 以下是一些采集子域名的推荐方法。 可以直接输入域名查询。

12.3. 域名类型

A记录、别名记录(CNAME)、MX记录、TXT记录、NS记录:

12.3.1。 A(地址)记录:

用于指定主机名(或域名)对应的IP地址记录。 用户可以将域名下的网站服务器指向自己的网站服务器。 同时,您还可以设置您的域名的二级域名。

12.3.2。 别名(CNAME)记录:

也称为规范名称。 这种类型的记录允许您将多个名称映射到同一台计算机。 通常用于同时提供 WWW 和 MAIL 服务的计算机。 例如,有一台名为“”的计算机(A记录)。 同时提供WWW和MAIL服务,方便用户访问服务。 可以为这台计算机设置两个别名(CNAME):WWW 和 MAIL。 这两个别名的全称是“”和“”。 其实都指向“”。

当你有多个域名需要指向同一个服务器IP时,可以使用同样的方法。 这时候可以给一个域名做一个A记录指向服务器IP,然后把其他域名别名到有之前A记录的域名上。 那么当你的服务器IP地址发生变化的时候,你就不用费心费力地一个一个的改域名了。 您只需要更改做A记录的域名,其他做别名的域名也会自动更改为新的IP地址。

12.3.3。 如何检测CNAME记录?

1、进入命令状态; (开始菜单-运行-CMD【回车】);

2、输入命令“nslookup -q=cname 此处填写对应的域名或二级域名”,查看返回结果是否与设置一致。

12.3.4。 MX(邮件交换器)记录:

它是一条邮件交换记录,指向一个邮件服务器,供电子邮件系统在发送邮件时根据收件人的地址后缀定位邮件服务器。 例如,当Internet上的用户要寄信给 时,用户的邮件系统通过DNS查找该域名的MX记录。 如果MX记录存在,则用户计算机将邮件发送到MX记录指定的邮件服务器。 .

12.3.5。 什么是 TXT 记录? :

TXT记录一般是指对主机名或域名的指令集,例如:

1) admin IN TXT "jack, mobile:";

2)mail IN TXT》邮件主机,存放于xxx,管理员:AAA,Jim IN TXT》联系人:

也就是你可以设置TXT,这样别人就可以联系到你了。

如何检测TXT记录?

1、进入命令状态; (开始菜单-运行-CMD【回车】);

2、输入命令“nslookup -q=txt 在此填写对应的域名或二级域名”,查看返回结果是否与设置一致。

12.3.6。 什么是 NS 记录?

ns记录的全称是Name Server,也就是域名服务器记录,用来明确你的域名当前是由哪台DNS服务器解析的。

12.3.7。 子域名在线查询1

12.3.8。 子域名在线查询2

12.3.9。 DNS检测

12.3.10。 IP138查询子域

12.3.11。 FOFA 搜索子域

语法:域=“”

Tips:以上两种方式不需要爆破,查询速度快。 当资产需要快速采集时,可以先使用,以后再通过其他方式补充。

12.3.12。 Hackertarget 查询子域

注意:通过该方法查询子域名可以得到目标的一个大概的ip段,然后就可以通过ip采集信息了。

12.4。 360映射空间

领域: ”*。”

12.4.1。 图层子域挖掘机

12.4.2。 子域蛮干

pip 安装 aiodns

运行命令 subDomainsBrute.py

subDomainsBrute.py --full -o freebuf2.txt

12.4.3。 子列表3r

pip install -r requirements.txt

提示:以上方法是对子域名进行爆破,因为字典功能更强大,所以效率更高。

帮助文档

<p style="margin-top: 0px;margin-bottom: 0px;">usage: sublist3r.py [-h] -d DOMAIN [-b [BRUTEFORCE]] [-p PORTS] [-v [VERBOSE]]<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />[-t THREADS] [-e ENGINES] [-o OUTPUT] [-n]<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />OPTIONS:<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-h, --help show this help message and exit<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-d DOMAIN, --domain DOMAIN<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Domain name to enumerate it's subdomains<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-b [BRUTEFORCE], --bruteforce [BRUTEFORCE]<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Enable the subbrute bruteforce module<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-p PORTS, --ports PORTS<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Scan the found subdomains against specified tcp ports<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-v [VERBOSE], --verbose [VERBOSE]<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Enable Verbosity and display results in realtime<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-t THREADS, --threads THREADS<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Number of threads to use for subbrute bruteforce<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-e ENGINES, --engines ENGINES<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Specify a comma-separated list of search engines<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-o OUTPUT, --output OUTPUT<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />Save the results to text file<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />-n, --no-color Output without color</p>

示例:python sublist3r.py -d

中文翻译

-h:帮助

-d : 指定主域名枚举子域名

-b : 调用 subbrute 来暴力枚举子域名

-p : 指定扫描子域名的tpc端口

-v :显示实时详细结果

-t : 指定线程

-e : 指定搜索引擎

-o : 将结果保存到文本

-n : 没有颜色的输出

扫描子域的默认参数

python sublist3r.py -d

使用暴力枚举子域

python sublist3r -b -d

12.4.4。 python2.7.14环境

;C:\Python27;C:\Python27\脚本

12.4.5。 万物皆可

pip3 install --user -r requirements.txt -i

python3 oneforall.py --target run /*采集*/

爆炸子域

例子:

<p style="margin-top: 0px;margin-bottom: 0px;">brute.py --target domain.com --word True run<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />brute.py --targets ./domains.txt --word True run<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />brute.py --target domain.com --word True --concurrent 2000 run<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />brute.py --target domain.com --word True --wordlist subnames.txt run<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />brute.py --target domain.com --word True --recursive True --depth 2 run<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />brute.py --target d.com --fuzz True --place m.*.d.com --rule '[a-z]' run<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />brute.py --target d.com --fuzz True --place m.*.d.com --fuzzlist subnames.txt run</p>

12.4.6。 域名

<p style="margin-top: 0px;margin-bottom: 0px;">dnsburte.py -d aliyun.com -f dnspod.csv -o aliyun.log<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />wydomain.py -d aliyun.com</p>

12.4.7。 模糊域

12.4.8。 隐藏域名主机冲突

隐藏资产检测-主机碰撞

很多时候访问目标资产的IP响应是:401、403、404、500,但是域名请求可以返回正常的业务系统(禁止直接IP访问),因为大部分需要绑定向主机正常请求访问(目前互联网公司的基本做法)(域名已经删除了A记录,但是反向生成的配置还没有更新),那么我们就可以将采集到的目标域名和目标资产的IP段,并用IP段+域名的形式进行捆绑碰撞,可以发现很多有趣的东西。

发送http请求时,将域名和IP列表配对,然后遍历发送请求(相当于修改本地hosts文件),对比对应的标题和响应包大小,快速找出一些隐藏资产。

Hosts collision需要目标的域名和目标的相关IP作为字典

更不用说域名了

相关IP来源有:

目标域名历史分析IP

ip 常规

13.端口扫描

确定目标的大概ip段后,可以先检测ip的开放端口。 某些特定服务可能会在默认端口上打开。 检测开放端口有利于快速采集目标资产,找到目标网站的其他功能站点。

13.1. msscan 端口扫描

msscan -p 1-65535 ip --rate=1000

13.2. 御剑端口扫描工具

13.3. nmap扫描端口并检测端口信息

常用参数,如:

nmap -sV 192.168.0.2

nmap -sT 92.168.0.2

nmap -Pn -A -sC 192.168.0.2

nmap -sU -sT -p0-65535 192.168.122.1

用于扫描目标主机服务版本号和开放端口

如果需要扫描多个ip或者ip段,可以保存到一个txt文件中

nmap -iL ip.txt

扫描列表中的所有 ip。

Nmap 是最常用的端口检测方法。 操作简单,输出结果非常直观。

13.4. 在线端口检测

13.5。 端口扫描器

御剑、msscan、nmap等

御剑高速端口扫描器:

填写你要扫描的ip段(如果只扫描一个ip,只需填写起始IP和结束IP),可以选择不更改默认端口列表,也可以选择自己指定端口。

13.6. 渗透端口

21,22,23,1433,152,3306,3389,5432,5900,50070,50030,50000,27017,27018,11211,9200,9300,7001,7002,6379,5984,873,443,8000-9090,80- 89,80,10000,8888,8649,8083,8080,8089,9090,7778,7001,7002,6082,5984,4440,3312,3311,3128,2601,2604,2222,2082,2083,389,88,512, 51 1025,111,1521,445,135,139,53

13.7。 穿透常用端口及对应服务

1、Web类(web漏洞/敏感目录)

第三方通用组件漏洞struts thinkphp jboss ganglia zabbix

80 网站

80-89网页

8000-9090 网页

2.数据库类(弱口令扫描)

第1433章

第1521章

3306 MySQL

5432 PostgreSQL 数据库

3.特殊服务类(未授权/命令执行类/漏洞)

第443章

873 Rsync 未经授权

5984 CouchDB:5984/_utils/

6379 Redis 未授权

7001,7002 WebLogic默认弱口令,反序列化

9200,9300 elasticsearch 参考WooYun:玩服务器ElasticSearch命令执行漏洞

11211 memcache 未授权访问

27017、27018 Mongodb 未授权访问

执行了 50000 个 SAP 命令

50070、50030 hadoop默认端口未授权访问

4.常用端口类(扫描弱口令/端口爆破)

21 英尺

22 SSH

23 远程登录

2601,2604 zebra路由,默认密码zebra

3389 远程桌面

5.端口总明细

21 英尺

22 SSH

23 远程登录

80 网站

80-89网页

第161话

第389章

443 SSL Heartbleed 和一些网络漏洞测试

445 家中小企业

512,513,514 雷克斯

873 Rsync 未经授权

1025,111 NFS

第1433章

1521 甲骨文:(iSqlPlus 端口:5560、7778)

2082/2083 cpanel主机管理系统登录(国外多用)

2222 DA虚拟主机管理系统登录(国外多用)

2601,2604 zebra路由,默认密码zebra

3128 squid代理默认端口,如果不设置密码,可以直接漫游内网

3306 MySQL

3312/3311康乐主机管理系统登录

3389 远程桌面

4440 rundeck 参考无云:借新浪服务成功漫游新浪内网

5432 PostgreSQL 数据库

5900 越南

5984 CouchDB:5984/_utils/

6082 Varnish 参考WooYun:Varnish HTTP加速器 CLI 未授权访问容易导致直接篡改网站或代理访问内网

6379 Redis 未授权

7001,7002 WebLogic默认弱口令,反序列化

7778 Kloxo 主机控制面板登录

8000-9090是一些常用的web端口,有些运维喜欢在这些非80端口上开启管理后台

8080 tomcat/WDCP主机管理系统,默认弱密码

8080、8089、9090 JBOSS

8083 Vestacp主机管理系统(国外多用)

8649 神经节

8888 amh/LuManager主机管理系统默认端口

9200,9300 elasticsearch 参考WooYun:玩服务器ElasticSearch命令执行漏洞

10000 Virtualmin/Webmin服务器虚拟主机管理系统

11211 memcache 未授权访问

27017、27018 Mongodb 未授权访问

28017 mongodb统计页面

执行了 50000 个 SAP 命令

50070、50030 hadoop默认端口未授权访问

13.8。 常用端口及攻击方式

14.查找真实ip

如果目标网站使用CDN,则隐藏cdn的真实ip。 要想找到真实服务器,就必须获取真实ip,根据这个ip继续查询侧站。

注意:很多情况下,虽然主站使用了CDN,但是子域名不一定使用CDN。 如果主网站和子域名在同一个ip段,那么也是找到子域名真实ip的一种方式。

14.1. Ping多处确认是否使用CDN

14.2. 查询历史DNS解析记录

在查询到的历史分析记录中,最早的历史分析IP很可能记录的是真实IP。 推荐使用此方法快速找到真实IP,但不是所有网站都能找到。

14.2.1。 域名数据库

14.2.2。 微步在线

14.2.3。

14.2.4。 查看DNS

14.3. php信息

如果目标网站存在phpinfo泄露等情况,可以在phpinfo中的SERVER_ADDR或_SERVER["SERVER_ADDR"]中查找真实ip

14.4. 绕过CDN

绕过CDN的方法有很多,请参考

15. 边站和C段

边站通常有业务功能站点。 建议先采集已有IP的边站,再检测C网段,确定C网段的目标后,在C网段的基础上重新采集边站。

辅助站点是与已知目标站点位于同一服务器上但具有不同端口的站点。 通过以下方法搜索到副站后,首先访问确定是否是您需要的站址信息。

15.1.1。 站长主页

用ip网站查询

15.2. 谷歌黑客

15.2.1。 网络空间搜索引擎

比如FOFA搜边站和C段

这种方式效率更高,可以直观的看到站点标题,但也有不收录不常用端口的情况。 虽然这种情况很少见,但您可以在后期补充资产时,通过以下方式再次扫描领取。

15.2.2。 线上段c

c部分使用脚本

<p style="margin-top: 0px;margin-bottom: 0px;">pip install requests<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />#coding:utf-8<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />import requests<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />import json<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />def get_c(ip):<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />print("正在收集{}".format(ip))<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />url="http://api.webscan.cc/?action=query&ip={}".format(ip)<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />req=requests.get(url=url)<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />html=req.text<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />data=req.json()<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />if 'null' not in html:<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />with open("resulit.txt", 'a', encoding='utf-8') as f:<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />f.write(ip + '\n')<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />f.close()<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />for i in data:<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />with open("resulit.txt", 'a',encoding='utf-8') as f:<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />f.write("\t{} {}\n".format(i['domain'],i['title']))<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />print(" [+] {} {}[+]".format(i['domain'],i['title']))<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />f.close()<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />def get_ips(ip):<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />iplist=[]<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />ips_str = ip[:ip.rfind('.')]<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />for ips in range(1, 256):<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />ipadd=ips_str + '.' + str(ips)<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />iplist.append(ipadd)<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />return iplist<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />ip=input("请你输入要查询的ip:")<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />ips=get_ips(ip)<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />for p in ips:<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /><br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />get_c(p)</p>

15.2.3。 Nmap、Msscan扫描等

例如:nmap -p 80,443,8000,8080 -Pn 192.168.0.0/24

15.2.4。 公共端口表

21,22,23,80-90,161,389,443,445,873,1099,1433,1521,1900,2082,2083,2222,2601,2604,3128,3306,3311,3312,3389,4440,4848,5432,92,5569,5569,5569 ,6082,6379,7001-7010,7778,8080-8090,8649,8888,9000,9200,10000,11211,27017,28017,50000,50030,50060,135,139,445,53,88

注意:在检测网段C时,一定要确认ip是否属于目标,因为一个网段C中不一定所有的ip都属于目标。

16.网络空间搜索引擎

如果你想在短时间内快速采集资产,那么使用网络空间搜索引擎是一个不错的选择。 可以直观的看到边站、端口、站点标题、IP等信息,点击列出站点即可直接访问。 判断是否是您需要的站点信息。 FOFA 的通用语法

1、同IP端站:ip="192.168.0.1"

2、C段:ip="192.168.0.0/24"

3.子域名:domain=""

4.标题/关键字:title="百度"

5.如果需要将结果缩小到某个城市,可以拼接语句

title="百度" && region="北京"

17.扫描敏感目录/文件

扫描敏感目录需要强大的字典,需要平时积累。 拥有强大的词典可以更高效地查明网站的管理后台。 常见的敏感文件如.git文件泄露,.svn文件泄露,phpinfo泄露等,这一步就成功了一半,各种扫描器就够了。 在域名中输入目标站点,选择对应的词典类型,即可开始扫描,非常方便。

17.1. 御剑

17.2. 7kbstorm

17.3. 扫描仪

在已经安装pip的前提下,可以直接:

<p style="margin-top: 0px;margin-bottom: 0px;">pip install -r requirements.txt</p>

用法示例:

扫描单个 Web 服务

python BBScan.py --host

扫描下其他主机

python BBScan.py --host --network 28

扫描txt文件中的所有主机

蟒蛇 BBScan.py -f .txt

从文件夹中导入所有主机并扫描

python BBScan.py -d 目标/

--network参数用于设置子网掩码,小公司设置为28~30,中型公司设置为26~28,大公司设置为24~26

当然,尽量避免设置为24,扫描太耗时,除非你想在每个src中多扫描几个漏洞。

这个插件是从内部扫描器中提取的,感谢 Jekkay Hu

如果你有非常有用的规则,请找几个网站验证测试一下,然后pull request

脚本也会优化,接下来的事情:

添加有用的规则,更好地分类规则,细化

然后,您可以直接从 rules\request 文件夹中导入 HTTP_request

优化扫描逻辑

17.4. 目录映射

<p style="margin-top: 0px;margin-bottom: 0px;">pip install -r requirement.txt<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />https://github.com/H4ckForJob/dirmap</p>

单一目标

<p style="margin-top: 0px;margin-bottom: 0px;">python3 dirmap.py -i https://target.com -lcf</p>

多个目标

<p style="margin-top: 0px;margin-bottom: 0px;">python3 dirmap.py -iF urls.txt -lcf</p>

17.5。 直接搜索

解压目录搜索.zip

python3 dirsearch.py -u -e *

17.6. 火药

<p style="margin-top: 0px;margin-bottom: 0px;">sudo apt-get install gobuster<br style="outline: 0px;max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />gobuster dir -u https://www.servyou.com.cn/ -w /usr/share/wordlists/dirbuster/directory-list-2.3-medium.txt -x php -t 50</p>

dir -u URL w dictionary -x 指定后缀 -t 线程数

<p style="margin-top: 0px;margin-bottom: 0px;">dir -u https://www.servyou.com.cn/ -w /usr/share/wordlists/dirbuster/directory-list-2.3-medium.txt -x "php,html,rar,zip" -d --wildcard -o servyou.log | grep ^"3402"</p>

17.7. 网站文件

机器人.txt

跨域.xml

站点地图.xml

后台目录

网站安装包

网站上传目录

mysql管理页面

php信息

网站文本编辑器

测试文件

网站备份文件(.rar、zip、.7z、.tar.gz、.bak)

DS_Store 文件

vim 编辑器备份文件 (.swp)

WEB—INF/web.xml 文件

15.git

16.svn

18.扫描网页备份

例如

配置.php

配置.php~

配置.php.bak

配置.php.swp

配置.php.rar

配置文件.php.tar.gz

19.网站头部信息采集

1.中间件:web服务【Web Servers】apache iis7 iis7.5 iis8 nginx WebLogic tomcat

2.网站组件:js组件jquery、vue页面布局bootstrap

通过浏览器访问

Firefox 插件 Wappalyzer

curl命令查询头部信息

卷曲-i

20. 敏感文件搜索 20.1. GitHub 搜索

in:name test #仓库标题搜索收录关键字test

in:descripton test #仓库描述搜索收录关键字

in:readme test #Readme文件搜索收录关键字

搜索某些系统的密码

++密码+3306&type=密码

github关键词监控

谷歌搜索

站点:sa 密码

站点:root密码

站点:用户;密码

网站:inurl:sql

SVN信息采集

站点:svn

站点:svn 用户名

站点:svn密码

站点:svn 用户名密码

综合信息采集

站点:密码

站点:ftp ftppassword

站点:密码

网站:内部

+&类型=代码

20.2. 谷歌黑客

站点:域名

inurl:url中存在的关键字网页

intext:网页正文中的关键词

filetype:指定文件类型

20.3。 乌云漏洞库

20.4。 网盘搜索

凌云搜索

潘多多:

泛搜索搜索:

泛搜索:

20.5。 社会工作图书馆

姓名/常用id/邮箱/密码/手机登录网盘网站邮箱查找敏感信息

机器人

20.6. 网站注册信息

查询网站注册信息

它通常与社会工程库一起使用。

20.7。 js敏感信息

20.7.1。 搜索器

python3 JSFinder.py -u

python3 JSFinder.py -u -d

python3 JSFinder.py -u -d -ou mi_url.txt -os mi_subdomain.txt

当你想获取更多信息时,可以使用-d进行深度爬取获取更多内容,使用命令-ou、-os指定子域保存的URL和文件名

批量指定url和js链接,获取里面的url。

指定网址:

python JSFinder.py -f 文本.txt

指定JS:

python JSFinder.py -f 文本.txt -j

20.7.2。 加壳模糊器

找到网站交互界面授权密钥

随着WEB前端打包工具的普及,你在日常的渗透测试和安全服务中是否遇到越来越多以Webpack packager为代表的网站? 这类打包器会将整个站点的API和API参数打包在一起进行集中web调用,也方便我们快速发现网站的功能和API列表,但是往往这些打包器生成的JS文件数量异常庞大且总是 JS 代码量极其庞大(高达数万行),给我们手动测试带来了极大的不便,于是 Packer Fuzzer 软件应运而生。

本工具支持自动模糊提取目标站点对应的API和API对应的参数内容,支持模糊高效模糊高效检测七大漏洞:未授权访问、敏感信息泄露、CORS、SQL注入、横向越权访问、弱口令、任意文件上传快速检测。 扫描结束后,该工具还支持自动生成扫描报告,可以选择便于分析的HTML版本,也可以选择比较正规的doc、pdf、txt版本。

sudo apt-get 安装 nodejs && sudo apt-get 安装 npm

混帐克隆

pip3 install -r requirements.txt

python3 PackerFuzzer.py -u

20.7.3。 秘密发现者

一个基于Python脚本的JavaScript敏感信息搜索工具

python3 SecretFinder.py -i -e

cms识别

采集网站信息后,应对网站进行指纹识别。 通过识别指纹,可以确定目标的cms和version,方便下一步测试计划的制定。 可以使用public poc或者自己积累相应的方法进行正式的渗透测试。

21.1. 云溪

21.2. 潮汐指纹

21.3。 CMS指纹识别

确认

21.4。 什么cms

21.5。 御cms识别

22. 非常规作业

1、如果找到了目标的某项资产,却无从下手搜集目标的其他资产,可以查看网站正文中是否有目标的特征,然后使用网络空间搜索引擎(如fofa , 等)特征进行搜索,如:body=”XX公司”或body=”baidu”等。

这种方式一般适用于特征明显、资产数量多的标的,效果往往比较突出。

2、通过以上方式找到特征后,再次搜索body,再搜索,此时fofa上显示的ip,大概率是真实ip。

3.如果需要针对政府网站,可以在批量获取网站首页的时候使用

然后可以结合上一步的方法进行进一步的信息采集。

23、SSL/TLS证书查询

SSL/TLS 证书通常收录域名、子域名和电子邮件地址等信息。 结合证书中的信息,您可以更快地定位到目标资产,获取目标资产的更多信息。

SSL证书搜索引擎:

%。

GetDomainsBySSL.py

24.找到厂商的ip段

25. 移动资产采集 25.1. 微信小程序 支付宝小程序

最新版本:iOS 开发苹果登录授权 Sign In with Apple

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2022-12-19 12:30

那里

网上关于苹果登录授权的文章很多,但大部分介绍都有些繁琐,实际操作简单。核心需要获取三个参数:team_id、client_id、key_id,然后通过uapp命令生成JWT令牌到后端。苹果

评测有规定,如果有微信、QQ、脸书等第三方账号登录,必须添加苹果登录名,否则将无法通过审核。苹果登录仅适用于iOS 13及更高版本。

1. 获得team_id和client_id

转到“标识符”页面:/帐户/资源/标识符/列表

单击标识符+,请注意此处输入的com.code0xff.uapp.login是client_id,请将其替换为您自己的。

查看下面的服务列表,勾选“通过 Apple 登录”,点按“编辑”,然后输入您自己的服务器端回调 URL:

到目前为止,我们已经成功获得了两个参数,team_id和client_id。

2. 获取钥匙.txt并key_id

转到密钥页面:/帐户/资源/身份验证密钥/列表

单击“密钥+”创建密钥,然后操作:输入“密钥名称”,选中“通过Apple登录”、“配置”。

配置页面,检查要在哪个应用程序中使用:

点击下载,下载后将文件名改为key.txt放入项目的jwt目录下:

jwt

├── config.json

└── key.txt

到目前为止,我们已经成功获得了钥匙.txt和key_id。

3. 通过 uapp 获取 JWT 代币

JWT 令牌适用于服务器,有效期为 6 个月,因此请记住在将近 6 个月时重新生成并替换它。

如果你还没有安装 uapp,你可以通过 npm 安装它:

npm i -g uapp

完成上述 jwt 目录有一个键.txt后,在下面创建 config.json 并放入上面获得的team_id、client_id key_id。

jwt/config.json如下:

{

"team_id": "3DSM494K6L",

"client_id": "com.code0xff.uapp.login",

"key_id": "3C7FMSZC8Z"

}

然后执行:

uapp info

您可以看到 JWT 令牌,将其发送到后端以供使用。

最近发布:atomic email hunter v11.0

原子邮箱猎手软件是一款非常简单实用的邮箱采集工具软件,原子邮箱猎手软件可以轻松扫描采集邮箱。除了搜索电子邮件地址、电话号码等出现在文本中的信息外,该软件还可以将电子邮件分类。用户可以使用软件进行搜索,用户只需输入关键词即可找到自己需要的内容,非常方便实用。

原子电子邮件猎人软件功能:

1. 如果您选择了 网站 并想从中提取电子邮件地址,请输入其 URL 地址

2. 该程序将采集 网站 上可用的所有电子邮件地址。

3. 您还可以从需要登录名和密码的页面中检索地址。

Atomic 电子邮件猎手软件亮点:

1.程序搜索与指定关键字匹配的网站,并从这些网站中提取电子邮件地址。

2. 如果您没有相关的 网站 列表来搜索电子邮件地址,这可以让您接触到目标受众。

3. 搜索网站邮箱的关键词,输入网址和关键字进行搜索。

原子电子邮件猎人软件功能:

1. 将从这些网页中提取电子邮件地址。搜索可以限于特定国家。

2. 程序将查找网站 中所有带有关键字的页面。从网页中提取电话号码。

3.这是唯一缺少原子猎人的设施,但您可以通过原子铅提取获得电话号码。

原子电子邮件猎手软件的优点:

1. 该程序可以猜测电子邮件地址所有者居住在哪个国家/地区

2. 此插件是为社交网络LinkedIn开发的,用于提取电子邮件地址。

3. 获得必要地址所需要做的就是选择关键词、区域和类别

原子邮件猎手软件介绍:

原子邮箱猎手邮箱采集软件是一款非常不错的邮箱采集软件,该软件可以扫描采集邮箱中的所有邮件,并对邮件进行分类,此外,您还可以搜索文本中出现的电子邮件地址、电话号码等。 查看全部

最新版本:iOS 开发苹果登录授权 Sign In with Apple

那里

网上关于苹果登录授权的文章很多,但大部分介绍都有些繁琐,实际操作简单。核心需要获取三个参数:team_id、client_id、key_id,然后通过uapp命令生成JWT令牌到后端。苹果

评测有规定,如果有微信、QQ、脸书等第三方账号登录,必须添加苹果登录名,否则将无法通过审核。苹果登录仅适用于iOS 13及更高版本。

1. 获得team_id和client_id

转到“标识符”页面:/帐户/资源/标识符/列表

单击标识符+,请注意此处输入的com.code0xff.uapp.login是client_id,请将其替换为您自己的。

查看下面的服务列表,勾选“通过 Apple 登录”,点按“编辑”,然后输入您自己的服务器端回调 URL:

到目前为止,我们已经成功获得了两个参数,team_id和client_id。

2. 获取钥匙.txt并key_id

转到密钥页面:/帐户/资源/身份验证密钥/列表

单击“密钥+”创建密钥,然后操作:输入“密钥名称”,选中“通过Apple登录”、“配置”。

配置页面,检查要在哪个应用程序中使用:

点击下载,下载后将文件名改为key.txt放入项目的jwt目录下:

jwt

├── config.json

└── key.txt

到目前为止,我们已经成功获得了钥匙.txt和key_id。

3. 通过 uapp 获取 JWT 代币

JWT 令牌适用于服务器,有效期为 6 个月,因此请记住在将近 6 个月时重新生成并替换它。

如果你还没有安装 uapp,你可以通过 npm 安装它:

npm i -g uapp

完成上述 jwt 目录有一个键.txt后,在下面创建 config.json 并放入上面获得的team_id、client_id key_id。

jwt/config.json如下:

{

"team_id": "3DSM494K6L",

"client_id": "com.code0xff.uapp.login",

"key_id": "3C7FMSZC8Z"

}

然后执行:

uapp info

您可以看到 JWT 令牌,将其发送到后端以供使用。

最近发布:atomic email hunter v11.0

原子邮箱猎手软件是一款非常简单实用的邮箱采集工具软件,原子邮箱猎手软件可以轻松扫描采集邮箱。除了搜索电子邮件地址、电话号码等出现在文本中的信息外,该软件还可以将电子邮件分类。用户可以使用软件进行搜索,用户只需输入关键词即可找到自己需要的内容,非常方便实用。

原子电子邮件猎人软件功能:

1. 如果您选择了 网站 并想从中提取电子邮件地址,请输入其 URL 地址

2. 该程序将采集 网站 上可用的所有电子邮件地址。

3. 您还可以从需要登录名和密码的页面中检索地址。

Atomic 电子邮件猎手软件亮点:

1.程序搜索与指定关键字匹配的网站,并从这些网站中提取电子邮件地址。

2. 如果您没有相关的 网站 列表来搜索电子邮件地址,这可以让您接触到目标受众。

3. 搜索网站邮箱的关键词,输入网址和关键字进行搜索。

原子电子邮件猎人软件功能:

1. 将从这些网页中提取电子邮件地址。搜索可以限于特定国家。

2. 程序将查找网站 中所有带有关键字的页面。从网页中提取电话号码。

3.这是唯一缺少原子猎人的设施,但您可以通过原子铅提取获得电话号码。

原子电子邮件猎手软件的优点:

1. 该程序可以猜测电子邮件地址所有者居住在哪个国家/地区

2. 此插件是为社交网络LinkedIn开发的,用于提取电子邮件地址。

3. 获得必要地址所需要做的就是选择关键词、区域和类别

原子邮件猎手软件介绍:

原子邮箱猎手邮箱采集软件是一款非常不错的邮箱采集软件,该软件可以扫描采集邮箱中的所有邮件,并对邮件进行分类,此外,您还可以搜索文本中出现的电子邮件地址、电话号码等。

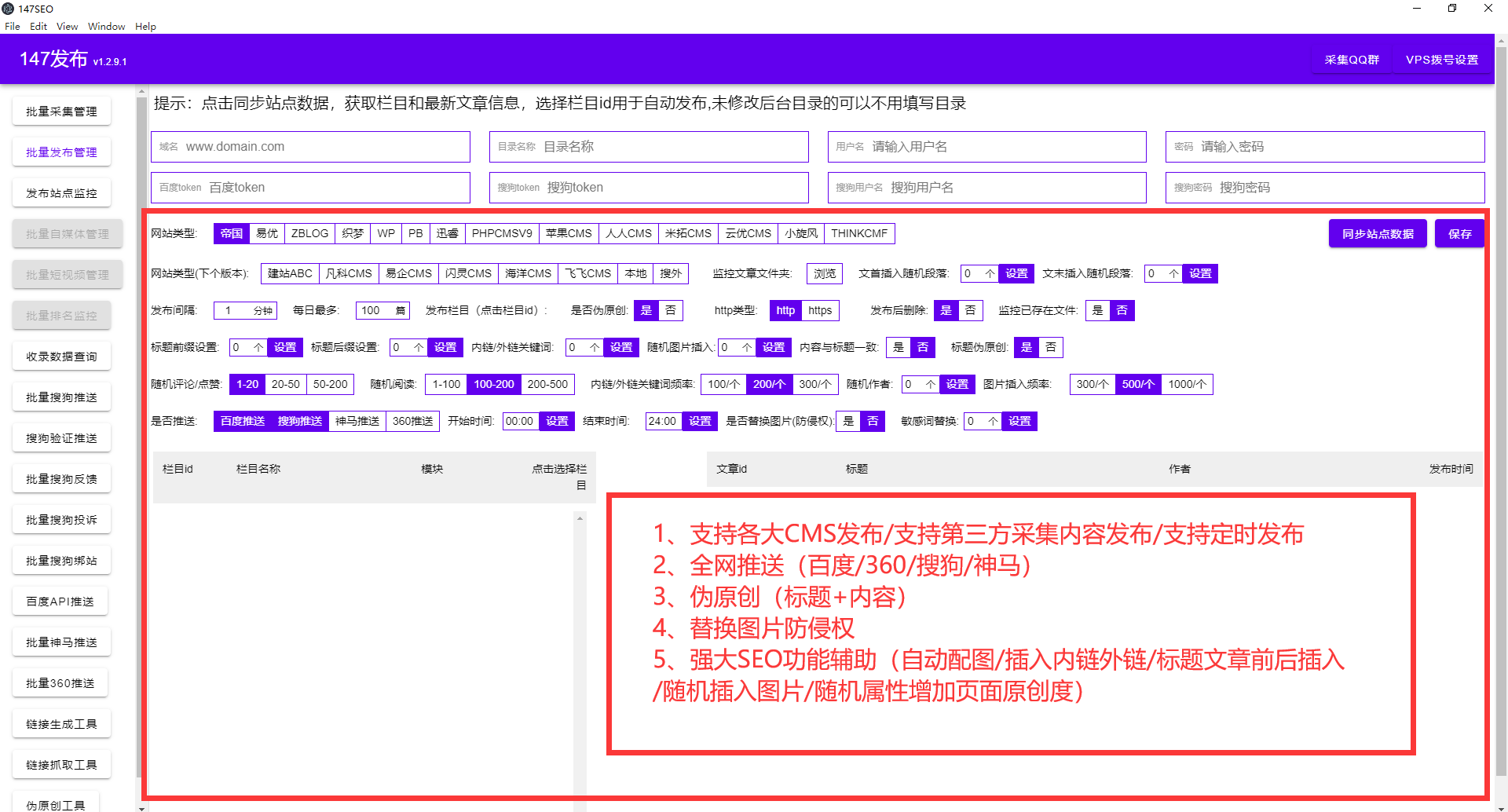

汇总:免费的:WordPress自动采集多个网站数据并自动发布的免费插件

采集交流 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2022-11-07 06:47

WordPress自动采集多个网站数据并自动发布免费插件

云简介采集

:

————————–

作为最新的采集器形式,云采集具有更新快的优点,没有传统软件采集器没有的本地操作。与插件采集器相比,它不会占用大量的服务器资源,将是新型采集器发展方向。

WordPress自动采集插件连接到免费优采云云采集系统,采集系统通过云采集自动发布模式进行真实*敏感*敏感*字*钱。

主要特点:

————————–

云配置采集脚本,自动发布到网站系统,支持网站,包括知乎、好搜索问答、天涯问答、豆瓣群、网站站长首页、汽车之家、*敏*感*字*知识、哔哔李碧丽视频、胡普论坛等。更多数据源正在不断添加!

特征:

————————–

* 云采集,无需安装软件

* 自动发布到网站和匹配字段

*支持采集用户名或当前用户随机提供

*支持将主题保存到自动采集

如何使用:

1. 注册账户

(登录官方网站注册账号)。

2. 获取规则

(转到规则市场获取免费规则模板)。

3. 采集数据

4. 安装插件

(登录到WordPress后端以安装优采云WordPress插件)。

5. 设置地址

(在发布设置中填写WordPress上的发布地址,可以手动或自动发布)。

6.选择要发布的版本

(采集完成后,选中“发布”或“自动发布”

.)

友情提醒:

————————–

优采云云采集的官方网站地址是:

优采云云采集有关如何

使用它的官方网站的图像和链接在下面的相关链接中。

我们仍在改进。如果您有任何需求或建议,可以直接与我们联系。

优采云采集器是一种网站采集器,它会自动采集云中的相关文章,并根据用户提供的关键词发布到用户的网站。它可以自动识别各种网页上的标题、正文等信息,不需要用户编写任何采集规则即可实现全网采集。采集内容后,自动计算内容与设定关键词的相关性,只向用户推送相关文章。支持标题前缀、自动加粗关键词、插入永久链接、自动提取标签标签、自动内部链接、自动映射、自动伪原创、内容过滤和替换、电话号码和URL清理、定时采集、百度主动提交等一系列SEO功能。用户只需设置关键词和相关要求,即可实现完全托管、零维护网站内容更新。无限数量的网站,无论是单网站还是大批量站群,都可以非常方便地管理。

官方发布:墨子学院为你揭秘:如何使用百度站长平台分析网站?

虽然这三种工具的数据功能领域相互渗透,但习惯上将三种工具的功能分开,让它们各司其职。站长工具(SEO综合查询)负责最外层数据,数据专家(百度统计)负责统计数据,百度站长平台负责内部数据。因此,站长需要了解SEO优化的数据分析。数据从何而来?数据是通过一些站长工具获取的。然后我们将与您讨论如何使用百度站长平台。

首先,让我们澄清一个概念。百度站长平台用于统计网站的内部数据。内部数据包括死链接、URL、索引量、关键词等,理清了这个概念后,分析百度站长平台的使用就更方便了。

1. 添加站点。不用说,注册一个站长账号,在“站点管理”下添加我们自己的网站域名,然后会弹出一个“验证站点”页面。站点验证包括文件验证、HTML标签验证和CNAME验证。个人 如果您习惯使用便捷的文件验证,您可以大致分两步完成验证:

1.下载验证文件。

2. 使用FTP工具将验证文件上传到网站的根目录。

简单方便。无需输入站长的个人信息。这主要是为了方便以后百度站长平台和个人站长之间的联系。

2. 站点地图。这里的sitemap其实和前面提到的sitemap是一样的。不同的是,站点地图是主动提交给百度的。前面提到的sitemap存放在网站根目录下,写入robots.txt文件。,属于被动等待蜘蛛索引网页的性质。说白了,就是一句话:主动攻击,被动等待。

3.死链接提交。向百度提交死链接报告后,搜索引擎会根据该报告识别并删除死链接页面的快照。在此之前,死链接需要针对404页面进行优化。具体操作如下:

1.使用检测死链接的URL。

2.将死链接URL放在一个txt文本中,每个URL单独一行(动态URL使用xml)。

3.将准备好的文本上传到网站根目录,然后将文件地址提交给百度站长平台。

四、网址提交。这个功能有点鸡肋。对于大中型的网站,不可能更新一篇文章文章,提交一个URL,但是对于博客或者小型网站,不提交肯定是收录。,至少黑苹果的博客投了几次(包括其他大的网站投稿),我觉得不可能收录或者收录,不是很有用。建议直接使用站点地图。

5、网站修订版,网站修订版包括域名修订版和目录修订版。顾名思义,域名改版其实就是域名的变更。首先,必须设置 301 永久重定向以定向到新域名。这个工具的作用是当网站修改后的URL发生变化(包括域名变化)并使用301重定向时,百度对301重定向的响应极慢,而网站修改工具提交是为了加快百度的响应速度。

目录修订也是如此。例如,如果更改了目录名称,或者更改了文本名称,设置重定向后,使用此工具向百度提交数据将有助于加快百度的响应时间。

第六,百度指数。收录查询,该工具已有站点数量,可以作为网站收录的参考,查询也比较方便。尽管百度曾表示网站数据不准确,但仍不能否认它的作用。对于索引卷查询,可以查询索引卷。

但是,该索引仅表示已被百度索引,并不表示将被收录发布。对于用户来说,网站收录查询的是目录,百度索引查询工具数据和收录相比,也是不准确的,所以它的意义不算太大,而且仅供参考。建议使用 site 指令来替换此功能。

7.外链分析。外链查询可以说是百度站长工具中最重要、最实用的工具之一。可以更好的查询自己网站的外链数据,了解分析自身网站在外链的优势和信息,了解网站的信息是一个工具不容忽视;其次,它可以了解和分析竞争对手的外部链接,也可以从其他网站中找到外部链接资源。

分析对手一直是网站seo不可缺少的部分,其中外链是重点之一,而百度外链工具可以对竞争对手进行比较好的分析,也可以分析竞争对手并寻找其他站点的外部链接资源,然后指定响应策略以超越它,以增强网站的竞争力。

除此之外,拒绝反向链接工具是一项功能。可以拒绝网站中存在的垃圾外链,避免垃圾外链对网站造成负面影响。这个工具可以很好的避开竞争对手的框架和无意生成的外部链接。垃圾链接。唯一的缺点是响应速度较慢,但缺点掩盖不了优点,它的作用不可否认。

8. 至于其他工具,比如爬取异常、爬取诊断等,这些工具不作为重点,你只需要了解它们是如何工作的。一些函数如搜索关键词 是数据的统计类别。我个人认为这些功能只是对百度站长平台的附加补充。

以上八项对百度站长平台有一定的经验和分享,百度站长平台的其他功能会在后续深入探讨,如关键词搭建分析、开放平台连接等一系列使用方法技能…… 查看全部

汇总:免费的:WordPress自动采集多个网站数据并自动发布的免费插件

WordPress自动采集多个网站数据并自动发布免费插件

云简介采集

:

————————–

作为最新的采集器形式,云采集具有更新快的优点,没有传统软件采集器没有的本地操作。与插件采集器相比,它不会占用大量的服务器资源,将是新型采集器发展方向。

WordPress自动采集插件连接到免费优采云云采集系统,采集系统通过云采集自动发布模式进行真实*敏感*敏感*字*钱。

主要特点:

————————–

云配置采集脚本,自动发布到网站系统,支持网站,包括知乎、好搜索问答、天涯问答、豆瓣群、网站站长首页、汽车之家、*敏*感*字*知识、哔哔李碧丽视频、胡普论坛等。更多数据源正在不断添加!

特征:

————————–

* 云采集,无需安装软件

* 自动发布到网站和匹配字段

*支持采集用户名或当前用户随机提供

*支持将主题保存到自动采集

如何使用:

1. 注册账户

(登录官方网站注册账号)。

2. 获取规则

(转到规则市场获取免费规则模板)。

3. 采集数据

4. 安装插件

(登录到WordPress后端以安装优采云WordPress插件)。

5. 设置地址

(在发布设置中填写WordPress上的发布地址,可以手动或自动发布)。

6.选择要发布的版本

(采集完成后,选中“发布”或“自动发布”

.)

友情提醒:

————————–

优采云云采集的官方网站地址是:

优采云云采集有关如何

使用它的官方网站的图像和链接在下面的相关链接中。

我们仍在改进。如果您有任何需求或建议,可以直接与我们联系。

优采云采集器是一种网站采集器,它会自动采集云中的相关文章,并根据用户提供的关键词发布到用户的网站。它可以自动识别各种网页上的标题、正文等信息,不需要用户编写任何采集规则即可实现全网采集。采集内容后,自动计算内容与设定关键词的相关性,只向用户推送相关文章。支持标题前缀、自动加粗关键词、插入永久链接、自动提取标签标签、自动内部链接、自动映射、自动伪原创、内容过滤和替换、电话号码和URL清理、定时采集、百度主动提交等一系列SEO功能。用户只需设置关键词和相关要求,即可实现完全托管、零维护网站内容更新。无限数量的网站,无论是单网站还是大批量站群,都可以非常方便地管理。

官方发布:墨子学院为你揭秘:如何使用百度站长平台分析网站?

虽然这三种工具的数据功能领域相互渗透,但习惯上将三种工具的功能分开,让它们各司其职。站长工具(SEO综合查询)负责最外层数据,数据专家(百度统计)负责统计数据,百度站长平台负责内部数据。因此,站长需要了解SEO优化的数据分析。数据从何而来?数据是通过一些站长工具获取的。然后我们将与您讨论如何使用百度站长平台。

首先,让我们澄清一个概念。百度站长平台用于统计网站的内部数据。内部数据包括死链接、URL、索引量、关键词等,理清了这个概念后,分析百度站长平台的使用就更方便了。

1. 添加站点。不用说,注册一个站长账号,在“站点管理”下添加我们自己的网站域名,然后会弹出一个“验证站点”页面。站点验证包括文件验证、HTML标签验证和CNAME验证。个人 如果您习惯使用便捷的文件验证,您可以大致分两步完成验证:

1.下载验证文件。

2. 使用FTP工具将验证文件上传到网站的根目录。

简单方便。无需输入站长的个人信息。这主要是为了方便以后百度站长平台和个人站长之间的联系。

2. 站点地图。这里的sitemap其实和前面提到的sitemap是一样的。不同的是,站点地图是主动提交给百度的。前面提到的sitemap存放在网站根目录下,写入robots.txt文件。,属于被动等待蜘蛛索引网页的性质。说白了,就是一句话:主动攻击,被动等待。

3.死链接提交。向百度提交死链接报告后,搜索引擎会根据该报告识别并删除死链接页面的快照。在此之前,死链接需要针对404页面进行优化。具体操作如下:

1.使用检测死链接的URL。

2.将死链接URL放在一个txt文本中,每个URL单独一行(动态URL使用xml)。

3.将准备好的文本上传到网站根目录,然后将文件地址提交给百度站长平台。

四、网址提交。这个功能有点鸡肋。对于大中型的网站,不可能更新一篇文章文章,提交一个URL,但是对于博客或者小型网站,不提交肯定是收录。,至少黑苹果的博客投了几次(包括其他大的网站投稿),我觉得不可能收录或者收录,不是很有用。建议直接使用站点地图。

5、网站修订版,网站修订版包括域名修订版和目录修订版。顾名思义,域名改版其实就是域名的变更。首先,必须设置 301 永久重定向以定向到新域名。这个工具的作用是当网站修改后的URL发生变化(包括域名变化)并使用301重定向时,百度对301重定向的响应极慢,而网站修改工具提交是为了加快百度的响应速度。

目录修订也是如此。例如,如果更改了目录名称,或者更改了文本名称,设置重定向后,使用此工具向百度提交数据将有助于加快百度的响应时间。

第六,百度指数。收录查询,该工具已有站点数量,可以作为网站收录的参考,查询也比较方便。尽管百度曾表示网站数据不准确,但仍不能否认它的作用。对于索引卷查询,可以查询索引卷。

但是,该索引仅表示已被百度索引,并不表示将被收录发布。对于用户来说,网站收录查询的是目录,百度索引查询工具数据和收录相比,也是不准确的,所以它的意义不算太大,而且仅供参考。建议使用 site 指令来替换此功能。

7.外链分析。外链查询可以说是百度站长工具中最重要、最实用的工具之一。可以更好的查询自己网站的外链数据,了解分析自身网站在外链的优势和信息,了解网站的信息是一个工具不容忽视;其次,它可以了解和分析竞争对手的外部链接,也可以从其他网站中找到外部链接资源。

分析对手一直是网站seo不可缺少的部分,其中外链是重点之一,而百度外链工具可以对竞争对手进行比较好的分析,也可以分析竞争对手并寻找其他站点的外部链接资源,然后指定响应策略以超越它,以增强网站的竞争力。

除此之外,拒绝反向链接工具是一项功能。可以拒绝网站中存在的垃圾外链,避免垃圾外链对网站造成负面影响。这个工具可以很好的避开竞争对手的框架和无意生成的外部链接。垃圾链接。唯一的缺点是响应速度较慢,但缺点掩盖不了优点,它的作用不可否认。

8. 至于其他工具,比如爬取异常、爬取诊断等,这些工具不作为重点,你只需要了解它们是如何工作的。一些函数如搜索关键词 是数据的统计类别。我个人认为这些功能只是对百度站长平台的附加补充。

以上八项对百度站长平台有一定的经验和分享,百度站长平台的其他功能会在后续深入探讨,如关键词搭建分析、开放平台连接等一系列使用方法技能……

解决方案:如何获取百度云下载直链

采集交流 • 优采云 发表了文章 • 0 个评论 • 345 次浏览 • 2022-11-03 11:17

2021-07-27

最近在百度云学习资源上遇到了一个大问题。百度云把我的速度锁死了。然后百度了一个PanDownload神器,感觉很好用。总的原则是获取直接链接,然后全速下载。我很好奇,想看看如何获取百度云直连。我找到了一个现在仍然可以使用的方法。虽然有缺陷,只能用于从下载直链获取单个文件,但没关系。毕竟压缩后的文件也是单个文件哈哈哈。

1.将要下载的资源保存到自己的网盘中。

2. 右键分享。创建公共链接,一定要创建公共链接。得到下面的结果。

3.复制链接并用Chrome打开。打开控制台

4、输入如下js代码,用ajax发送请求。

$.ajax({

type: "POST",

url: "/api/sharedownload?sign="+yunData.SIGN+"×tamp="+yunData.TIMESTAMP,

data: "encrypt=0&product=share&uk="+yunData.SHARE_UK+"&primaryid="+yunData.SHARE_ID+"&fid_list=%5B"+yunData.FS_ID+"%5D",

dataType: "json",

success: function(d){

<p>

window.location.href = d.list[0].dlink;

}

});</p>

5. 然后它会自动开始作为直接链接下载。

当然,最后还是推荐使用 Pandownload 之类的。当然,这种东西大家都知道,传播得越快,死的也就越快。在这种情况下,我们可以通过上面的方法获取直接链接,然后愉快的下载。其实感觉就是处理后才能得到直链,最后向Pandownload的作者们致敬!

分类:

技术要点:

相关文章:

解决方案:调用链系列(三):解读UAVStack中的贪吃蛇-调用链

为了从请求中提取body和header,使代码的改动尽可能小,进入容器的请求必须被统一拦截,否则代码必须嵌入到所有的HttpServlet实现类中。在这里,我们需要再次感谢 servlet 说明符为我们提供的过滤机制。

该规范指定过滤器是一段可重用的代码,用于转换 HTTP 请求、响应和标头信息的内容。过滤器通常不会为请求创建响应,而是修改或调整请求和响应。其中,filter主要提供四种拦截方式:

这里我们只使用 REQUEST 模式。配置过滤器后,我们可以从过滤器的doFilter方法中获取HttpServletRequest和HttpServletResponse(简称请求和响应)。

获取标题

在上面,我们通过过滤机制获得了请求和响应。打开对应的源码实现,我们可以找到如下API:

规范为我们提供了一个 API 来直接获取标头。通过结合 getHeaderNames() 和 getHeader(String name) 方法,我们可以轻松获取请求和响应中的标头。

得到身体

获取请求体和响应体的方法大致相同。这里以request为例,后面会调整差异。

从请求API中我们可以发现body在java中是以ServletInputStream的形式存储的,而ServletInputStream是一个继承的InputStream。如果我们直接读取,用户获取到的body会是空的(因为InputStream只能读取一次),除非可以把指针放回去)。这里需要用到servlet的包装机制。

Servlet 中的包装器

有的人可能不会用到requestWrapper和responseWrapper,这里简单介绍一下。wrapper 是通过继承 servlet 规范中的 HttpServletResponseWrapper 和 HttpServletRequestWrapper 实现的装饰模式。相当于请求和响应的一个shell,类似于java中的代理,这样操作请求和响应的所有动作都会经过我们自定义的wrapper,使得在请求中重复获取body成为可能和回应。

编写自己的包装器

我们以 request 为例来说明如何编写自定义包装器。打开servlet-api源码可以看到HttpServletRequestWrapper继承了ServletRequestWrapper,实现了HttpServletRequest接口。

并且大部分方法已经在 ServletRequestWrapper 中为我们实现了。

我们只需要重写我们关心的几个方法,例如:getInputStream和getReader等。

当用户尝试调用 getReader 或 getInputStream 时,我们将其替换为自己的流,并额外提供一个 getContent() 方法来提前读取 StringBuilder 或 byte[] 中的正文内容进行提取。

编写好自定义包装器后,我们可以将其放入我们上面定义的过滤器中,替换原来的请求。然后把用户的请求变成我们的requestWrapper。

优化提取逻辑

上面提到的方法等价于预先读取收录body的inputStream,并将其存储在一个中间byte[]或StringBuilder中。当用户调用 getInputStream 时,byte[] 或 StringBuilder 被转换为 inputStream 返回给用户。如果用户根本不关心这个http请求的body,也就是用户根本不使用这个请求的body,那么我们提前把它读出来,相当于做了无用功(浪费宝贵的 CPU 时间和内存资源)。如何保证inputStream在用户使用时是只读的,当用户或后续逻辑多次获取body时,是我们的优化目标。

对于答案,我们继续从源码中寻找。既然我们的数据在 inputStream 中,我们就跟着源码看看是怎么读取的。在servlet规范中,inputStream被封装成ServletInputStream,ServletInputStream提供了readLine方法。往里面看,可以看到它们都调用了inputStream中的read方法,如下图:

既然read方法是一个统一的入口,那我们只要自定义一个ServletInputStream,重写里面的read()方法,就可以修改所有的read方法吗?答案是肯定的。只要用户调用了read方法,我们就悄悄地把我们关心的内容复制一份,这样我们只在用户使用body的时候才去采集。

下一步是如何确保用户调用 read 多次,我们总是只读取一次。在这里,我们需要使用一个 AtomicBoolean 标志,当执行完整读取时将其设置为 true,否则设置为 false。最终效果如下:

举一反三

在这里,我们使用 servlet 规范中的过滤器和包装器机制来获取进入我们容器(tomcat)的所有 http 请求的主体和标头。这个能力在我们实际生产中可以进一步扩展,比如:我们需要在客户端加密一些敏感数据然后在服务端进行统一解密,格式化客户端发送的数据格式等等。可以限制你的是你的想象力。希望本次技术分享对您以后的工作和生活有所帮助。

总结

读完这篇文章,读者应该可以在不影响原代码的情况下,通过简单的代码获取所有进入容器的http请求的body和header。虽然可能需要适配一些特殊的技术栈,比如如果项目中使用了jersey,参数等信息以application/x-www-form-urlencoded的形式传递,而服务端不使用@ FormParam注解获取参数,那么我们获取body后,用户将无法获取参数;例如,如何区分媒体类型,如果是图像,则不会被提取。但我们已经验证,这条路是可行的,而且是成功的一半。 查看全部

解决方案:如何获取百度云下载直链

2021-07-27

最近在百度云学习资源上遇到了一个大问题。百度云把我的速度锁死了。然后百度了一个PanDownload神器,感觉很好用。总的原则是获取直接链接,然后全速下载。我很好奇,想看看如何获取百度云直连。我找到了一个现在仍然可以使用的方法。虽然有缺陷,只能用于从下载直链获取单个文件,但没关系。毕竟压缩后的文件也是单个文件哈哈哈。

1.将要下载的资源保存到自己的网盘中。

2. 右键分享。创建公共链接,一定要创建公共链接。得到下面的结果。

3.复制链接并用Chrome打开。打开控制台

4、输入如下js代码,用ajax发送请求。

$.ajax({

type: "POST",

url: "/api/sharedownload?sign="+yunData.SIGN+"×tamp="+yunData.TIMESTAMP,

data: "encrypt=0&product=share&uk="+yunData.SHARE_UK+"&primaryid="+yunData.SHARE_ID+"&fid_list=%5B"+yunData.FS_ID+"%5D",

dataType: "json",

success: function(d){

<p>

window.location.href = d.list[0].dlink;

}

});</p>

5. 然后它会自动开始作为直接链接下载。

当然,最后还是推荐使用 Pandownload 之类的。当然,这种东西大家都知道,传播得越快,死的也就越快。在这种情况下,我们可以通过上面的方法获取直接链接,然后愉快的下载。其实感觉就是处理后才能得到直链,最后向Pandownload的作者们致敬!

分类:

技术要点:

相关文章:

解决方案:调用链系列(三):解读UAVStack中的贪吃蛇-调用链

为了从请求中提取body和header,使代码的改动尽可能小,进入容器的请求必须被统一拦截,否则代码必须嵌入到所有的HttpServlet实现类中。在这里,我们需要再次感谢 servlet 说明符为我们提供的过滤机制。

该规范指定过滤器是一段可重用的代码,用于转换 HTTP 请求、响应和标头信息的内容。过滤器通常不会为请求创建响应,而是修改或调整请求和响应。其中,filter主要提供四种拦截方式:

这里我们只使用 REQUEST 模式。配置过滤器后,我们可以从过滤器的doFilter方法中获取HttpServletRequest和HttpServletResponse(简称请求和响应)。

获取标题

在上面,我们通过过滤机制获得了请求和响应。打开对应的源码实现,我们可以找到如下API:

规范为我们提供了一个 API 来直接获取标头。通过结合 getHeaderNames() 和 getHeader(String name) 方法,我们可以轻松获取请求和响应中的标头。

得到身体

获取请求体和响应体的方法大致相同。这里以request为例,后面会调整差异。

从请求API中我们可以发现body在java中是以ServletInputStream的形式存储的,而ServletInputStream是一个继承的InputStream。如果我们直接读取,用户获取到的body会是空的(因为InputStream只能读取一次),除非可以把指针放回去)。这里需要用到servlet的包装机制。

Servlet 中的包装器

有的人可能不会用到requestWrapper和responseWrapper,这里简单介绍一下。wrapper 是通过继承 servlet 规范中的 HttpServletResponseWrapper 和 HttpServletRequestWrapper 实现的装饰模式。相当于请求和响应的一个shell,类似于java中的代理,这样操作请求和响应的所有动作都会经过我们自定义的wrapper,使得在请求中重复获取body成为可能和回应。

编写自己的包装器

我们以 request 为例来说明如何编写自定义包装器。打开servlet-api源码可以看到HttpServletRequestWrapper继承了ServletRequestWrapper,实现了HttpServletRequest接口。

并且大部分方法已经在 ServletRequestWrapper 中为我们实现了。

我们只需要重写我们关心的几个方法,例如:getInputStream和getReader等。

当用户尝试调用 getReader 或 getInputStream 时,我们将其替换为自己的流,并额外提供一个 getContent() 方法来提前读取 StringBuilder 或 byte[] 中的正文内容进行提取。

编写好自定义包装器后,我们可以将其放入我们上面定义的过滤器中,替换原来的请求。然后把用户的请求变成我们的requestWrapper。

优化提取逻辑

上面提到的方法等价于预先读取收录body的inputStream,并将其存储在一个中间byte[]或StringBuilder中。当用户调用 getInputStream 时,byte[] 或 StringBuilder 被转换为 inputStream 返回给用户。如果用户根本不关心这个http请求的body,也就是用户根本不使用这个请求的body,那么我们提前把它读出来,相当于做了无用功(浪费宝贵的 CPU 时间和内存资源)。如何保证inputStream在用户使用时是只读的,当用户或后续逻辑多次获取body时,是我们的优化目标。

对于答案,我们继续从源码中寻找。既然我们的数据在 inputStream 中,我们就跟着源码看看是怎么读取的。在servlet规范中,inputStream被封装成ServletInputStream,ServletInputStream提供了readLine方法。往里面看,可以看到它们都调用了inputStream中的read方法,如下图:

既然read方法是一个统一的入口,那我们只要自定义一个ServletInputStream,重写里面的read()方法,就可以修改所有的read方法吗?答案是肯定的。只要用户调用了read方法,我们就悄悄地把我们关心的内容复制一份,这样我们只在用户使用body的时候才去采集。

下一步是如何确保用户调用 read 多次,我们总是只读取一次。在这里,我们需要使用一个 AtomicBoolean 标志,当执行完整读取时将其设置为 true,否则设置为 false。最终效果如下:

举一反三

在这里,我们使用 servlet 规范中的过滤器和包装器机制来获取进入我们容器(tomcat)的所有 http 请求的主体和标头。这个能力在我们实际生产中可以进一步扩展,比如:我们需要在客户端加密一些敏感数据然后在服务端进行统一解密,格式化客户端发送的数据格式等等。可以限制你的是你的想象力。希望本次技术分享对您以后的工作和生活有所帮助。

总结

读完这篇文章,读者应该可以在不影响原代码的情况下,通过简单的代码获取所有进入容器的http请求的body和header。虽然可能需要适配一些特殊的技术栈,比如如果项目中使用了jersey,参数等信息以application/x-www-form-urlencoded的形式传递,而服务端不使用@ FormParam注解获取参数,那么我们获取body后,用户将无法获取参数;例如,如何区分媒体类型,如果是图像,则不会被提取。但我们已经验证,这条路是可行的,而且是成功的一半。

定制化方案:fluent-bit debug调试,采集kubernetes podIP

采集交流 • 优采云 发表了文章 • 0 个评论 • 168 次浏览 • 2022-10-30 09:19

有时候调试 fluent-bit 的配置以达到想要的输出效果并不是一件简单的事情,下面就是通过调试镜像来调试 fluent-bit 采集kubernetes pod 的 IP。

官方的流利位文档给出了一个用于调试的图像:docs.fluentbit.io/manual/installation/docker

dockerhub存储库链接到:/r/fluent/fluent-bit/

部署流畅位调试

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app.kubernetes.io/name: fluent-bit-debug

name: fluent-bit-debug

namespace: kubesphere-logging-system

spec:

progressDeadlineSeconds: 600

replicas: 1

revisionHistoryLimit: 10

selector:

matchLabels:

app.kubernetes.io/name: fluent-bit-debug

strategy:

rollingUpdate:

maxSurge: 25%

maxUnavailable: 25%

type: RollingUpdate

template:

metadata:

creationTimestamp: null

labels:

app.kubernetes.io/name: fluent-bit-debug

name: fluent-bit-debug

spec:

containers:

- env:

- name: NODE_NAME

valueFrom:

fieldRef:

apiVersion: v1

fieldPath: spec.nodeName

command:

- /usr/local/bin/sh

- -c

- sleep 9999

image: fluent/fluent-bit:1.6.9-debug

imagePullPolicy: IfNotPresent

name: fluent-bit

ports:

- containerPort: 2020

name: metrics

protocol: TCP

resources: {}

terminationMessagePath: /dev/termination-log

terminationMessagePolicy: File

volumeMounts:

- mountPath: /var/lib/docker/containers

name: varlibcontainers

readOnly: true

- mountPath: /fluent-bit/config

name: config

readOnly: true

- mountPath: /var/log/

name: varlogs

readOnly: true

- mountPath: /var/log/journal

name: systemd

readOnly: true

- mountPath: /fluent-bit/tail

name: positions

dnsPolicy: ClusterFirst

restartPolicy: Always

schedulerName: default-scheduler

securityContext: {}

serviceAccount: fluent-bit

serviceAccountName: fluent-bit

terminationGracePeriodSeconds: 30

volumes:

- hostPath:

path: /var/lib/docker/containers

type: ""

name: varlibcontainers

- name: config

secret:

defaultMode: 420

secretName: fluent-bit-debug-config

- hostPath:

path: /var/log

type: ""

name: varlogs

- hostPath:

path: /var/log/journal

type: ""

name: systemd

- emptyDir: {}

name: positions

使用的secret:fluent-bit-debug-config如下,收录两个键:

第一个 parsers.conf: 为空;配置详情请参考官方文档:配置文件

第二个 fluent-bit.conf 配置需要根据情况进行配置,下面主要针对不同场景给出。它还将涉及使用kubesphere和Filter CRD。

使用流利位exec 到容器中可以使用 /fluent-bit/

bin/fluent-bit 进行调试:

/fluent-bit/bin # ./fluent-bit -h

Usage: fluent-bit [OPTION]

Available Options

-b --storage_path=PATH specify a storage buffering path

-c --config=FILE specify an optional configuration file

-d, --daemon run Fluent Bit in background mode

-f, --flush=SECONDS flush timeout in seconds (default: 5)

-F --filter=FILTER set a filter

-i, --input=INPUT set an input

-m, --match=MATCH set plugin match, same as '-p match=abc'

-o, --output=OUTPUT set an output

-p, --prop="A=B" set plugin configuration property

-R, --parser=FILE specify a parser configuration file

-e, --plugin=FILE load an external plugin (shared lib)

-l, --log_file=FILE write log info to a file

-t, --tag=TAG set plugin tag, same as '-p tag=abc'

-T, --sp-task=SQL define a stream processor task

-v, --verbose increase logging verbosity (default: info)

-H, --http enable monitoring HTTP server

-P, --port set HTTP server TCP port (default: 2020)

-s, --coro_stack_size Set coroutines stack size in bytes (default: 24576)

-q, --quiet quiet mode

-S, --sosreport support report for Enterprise customers

-V, --version show version number

-h, --help print this help

Inputs

cpu CPU Usage

mem Memory Usage

thermal Thermal

kmsg Kernel Log Buffer

proc Check Process health

disk Diskstats

systemd Systemd (Journal) reader

netif Network Interface Usage

docker Docker containers metrics

docker_events Docker events

tail Tail files

dummy Generate dummy data

head Head Input

health Check TCP server health

collectd collectd input plugin

statsd StatsD input plugin

serial Serial input

stdin Standard Input

syslog Syslog

exec Exec Input

tcp TCP

mqtt MQTT, listen for Publish messages

forward Fluentd in-forward

<p>

random Random

Filters

alter_size Alter incoming chunk size

aws Add AWS Metadata

record_modifier modify record

throttle Throttle messages using sliding window algorithm

kubernetes Filter to append Kubernetes metadata

modify modify records by applying rules

nest nest events by specified field values

parser Parse events

expect Validate expected keys and values

grep grep events by specified field values

rewrite_tag Rewrite records tags

lua Lua Scripting Filter

stdout Filter events to STDOUT

Outputs

azure Send events to Azure HTTP Event Collector

azure_blob Azure Blob Storage

bigquery Send events to BigQuery via streaming insert

counter Records counter

datadog Send events to DataDog HTTP Event Collector

es Elasticsearch

exit Exit after a number of flushes (test purposes)

file Generate log file

forward Forward (Fluentd protocol)

http HTTP Output

influxdb InfluxDB Time Series

logdna LogDNA

loki Loki

kafka Kafka

kafka-rest Kafka REST Proxy

nats NATS Server

nrlogs New Relic