不用采集规则就可以采集

不用采集规则就可以采集(几个Python能快速获取网上数据的工具?|极客猴来源 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2022-04-02 01:13

)

作者|极客猴

来源 | 极客猴子

前天,一位同学加我微信咨询我:

“猴哥,我想抓取最近的5000条新闻数据,但是我是文科生,不会写代码,怎么办?”

可能是Python这几年很火,我们经常会看到别人用Python做网络爬虫爬取数据。因此,有些学生有这样的误解。如果你想从网上抓取数据,你必须学习 Python 并编写代码。

事实上,事实并非如此。猴哥介绍几个可以快速获取在线数据的工具。

1、微软 Excel

你没看错,是 Excel,Office 三剑客之一。Excel 是一个强大的工具,能够捕获数据是它的功能之一。我用耳机作为关键词来抓取京东的产品列表。

几秒钟后,Excel 会将页面上的所有文本信息抓取到一个表格中。这个方法确实可以捕获数据,但是也会引入一些我们不需要的数据。如果你有更高的要求,你可以选择后者的工具。

2、优采云采集器

优采云 是爬虫界的老字号。它是目前使用最多的互联网数据采集、处理、分析和挖掘软件。它的优点是采集不限于网页和内容,也分布式采集,效率会更高。缺点是对新手用户不太友好,有一定的知识门槛(比如网页知识、HTTP协议等),熟悉工具操作需要一定的时间。

由于学习门槛的关系,掌握了工具后,采集的数据限制会非常高。有时间和精力的同学可以去折腾折腾。

官网地址:

3、优采云采集器

优采云采集器对于初学者来说是一个很棒的采集器。它简单易用,因此您可以在几分钟内启动并运行。优采云提供一些常用抓取的模板网站,使用模板快速抓取数据。如果你想在没有模板的情况下抓取网站,官网也提供了非常详细的图文教程和视频教程。

优采云是基于浏览器内核实现数据的可视化抓取,所以有滞后和采集数据慢的特点。不过这个缺陷也掩盖不了弱点,基本可以满足新手在短时间内抓取数据的场景,比如翻页查询、Ajax动态加载数据等。

网站:

4、GooSeeker

Jisouke也是一个易于使用的可视化采集数据工具。它还可以捕获动态网页,以及捕获移动网站上的数据,以及捕获在指数图表上悬浮显示的数据。Jisouke 以浏览器插件的形式捕获数据。尽管它具有上述优点,但也有缺点。多线程 采集 数据是不可能的,浏览器冻结是不可避免的。

网站:

5、Scrapinghub

如果想抓取国外的网站数据,可以考虑Scrapinghub。Scrapinghub 是一个基于 Python 的 Scrapy 框架的云爬虫平台。Scrapehub 是市面上一个非常复杂且功能强大的网页抓取平台,提供数据抓取的解决方案提供商。

地址:

6、WebScraper

WebScraper 是一款优秀的国外浏览器插件。它也是一个适合初学者抓取数据的可视化工具。我们只需设置一些抓取规则,让浏览器完成工作。

地址:

以上只是对几个工具的简单介绍,而关于这些工具的具体用途、优缺点,需要大家在网上单独查找了解,根据不同的需求选择最适合的工具!

[超过]

查看全部

不用采集规则就可以采集(几个Python能快速获取网上数据的工具?|极客猴来源

)

作者|极客猴

来源 | 极客猴子

前天,一位同学加我微信咨询我:

“猴哥,我想抓取最近的5000条新闻数据,但是我是文科生,不会写代码,怎么办?”

可能是Python这几年很火,我们经常会看到别人用Python做网络爬虫爬取数据。因此,有些学生有这样的误解。如果你想从网上抓取数据,你必须学习 Python 并编写代码。

事实上,事实并非如此。猴哥介绍几个可以快速获取在线数据的工具。

1、微软 Excel

你没看错,是 Excel,Office 三剑客之一。Excel 是一个强大的工具,能够捕获数据是它的功能之一。我用耳机作为关键词来抓取京东的产品列表。

几秒钟后,Excel 会将页面上的所有文本信息抓取到一个表格中。这个方法确实可以捕获数据,但是也会引入一些我们不需要的数据。如果你有更高的要求,你可以选择后者的工具。

2、优采云采集器

优采云 是爬虫界的老字号。它是目前使用最多的互联网数据采集、处理、分析和挖掘软件。它的优点是采集不限于网页和内容,也分布式采集,效率会更高。缺点是对新手用户不太友好,有一定的知识门槛(比如网页知识、HTTP协议等),熟悉工具操作需要一定的时间。

由于学习门槛的关系,掌握了工具后,采集的数据限制会非常高。有时间和精力的同学可以去折腾折腾。

官网地址:

3、优采云采集器

优采云采集器对于初学者来说是一个很棒的采集器。它简单易用,因此您可以在几分钟内启动并运行。优采云提供一些常用抓取的模板网站,使用模板快速抓取数据。如果你想在没有模板的情况下抓取网站,官网也提供了非常详细的图文教程和视频教程。

优采云是基于浏览器内核实现数据的可视化抓取,所以有滞后和采集数据慢的特点。不过这个缺陷也掩盖不了弱点,基本可以满足新手在短时间内抓取数据的场景,比如翻页查询、Ajax动态加载数据等。

网站:

4、GooSeeker

Jisouke也是一个易于使用的可视化采集数据工具。它还可以捕获动态网页,以及捕获移动网站上的数据,以及捕获在指数图表上悬浮显示的数据。Jisouke 以浏览器插件的形式捕获数据。尽管它具有上述优点,但也有缺点。多线程 采集 数据是不可能的,浏览器冻结是不可避免的。

网站:

5、Scrapinghub

如果想抓取国外的网站数据,可以考虑Scrapinghub。Scrapinghub 是一个基于 Python 的 Scrapy 框架的云爬虫平台。Scrapehub 是市面上一个非常复杂且功能强大的网页抓取平台,提供数据抓取的解决方案提供商。

地址:

6、WebScraper

WebScraper 是一款优秀的国外浏览器插件。它也是一个适合初学者抓取数据的可视化工具。我们只需设置一些抓取规则,让浏览器完成工作。

地址:

以上只是对几个工具的简单介绍,而关于这些工具的具体用途、优缺点,需要大家在网上单独查找了解,根据不同的需求选择最适合的工具!

[超过]

不用采集规则就可以采集(如何用花瓣采集工具采集图片呢?就这么简单!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 385 次浏览 • 2022-03-30 10:20

防止 采集。

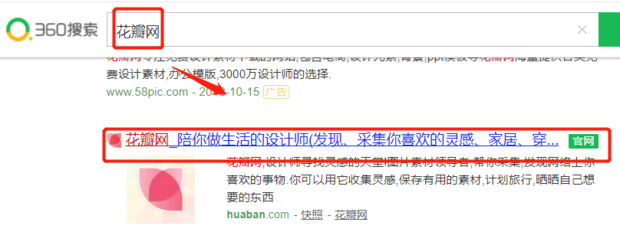

现在很多人都在用花瓣网,那么花瓣采集工具采集图片怎么用呢?今天给大家上一课,希望对大家有所帮助。

材料/工具

花瓣网

方法

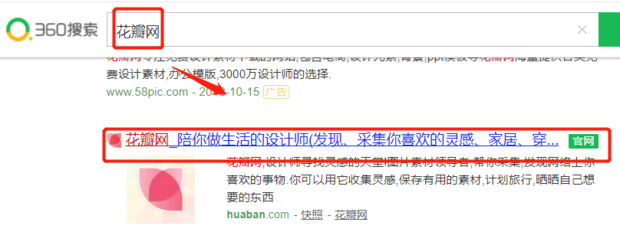

首先,使用360浏览器搜索花瓣网,进入其官网。

贴吧了解更多视频、音乐、图片、地图、图书馆,寻找答案,我要问花瓣采集工人

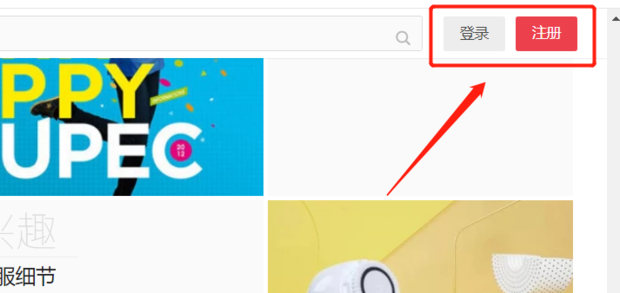

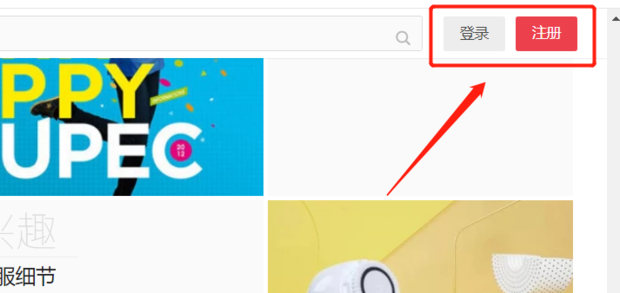

然后单击登录或注册。

采集工具需要 采集 规则!而各大网站也不是无缘无故被采集,因为这等于无偿使用他们的资源来吸引他们的用户

然后登录后点击Install采集tools。

应该没有WIN10的扫描仪驱动版本;现在win10还是太新了,很多驱动都不支持。解决方案

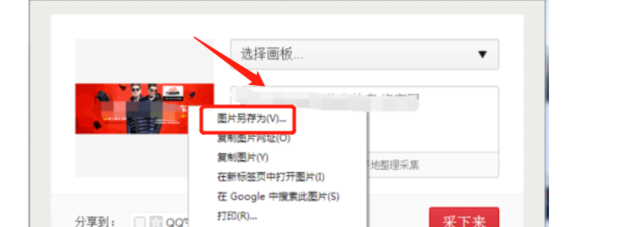

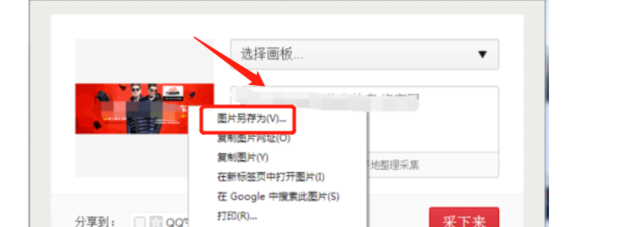

然后安装完成后,点击右上角的花瓣,会有一个采集图片选项。

上的照片和资料可以用大显的一键移图软件一键采集下载吗?可以使用大仙一键移动花瓣网上的照片和素材。

然后点击采集 来采集 图片。

最后,还可以保存采集的图片。

可以尝试用Python爬虫爬取,不知道成功与否,但要自己写代码。这个答案被提问者采纳了。最好使用地图助手。操作非常简单。您可以批量下载和保存。大县地图可以一键下载。我已经为你测试过了。采集工具是必需的采集正规的!而各大网站也不是无缘无故的采集,因为这等于无偿使用他们的资源来吸引他们的用户!结果很多网站也在变,采集的规则就失效了!这个时候,如果不修改采集规则,就不可能采集到网站采集的东西!就是这么简单!这个答案已经被网友采纳。我应该如何修改 采集 规则?现在花瓣都快用不上了~不能转发任何网站的图片~~~~内容来自采集。 查看全部

不用采集规则就可以采集(如何用花瓣采集工具采集图片呢?就这么简单!)

防止 采集。

现在很多人都在用花瓣网,那么花瓣采集工具采集图片怎么用呢?今天给大家上一课,希望对大家有所帮助。

材料/工具

花瓣网

方法

首先,使用360浏览器搜索花瓣网,进入其官网。

贴吧了解更多视频、音乐、图片、地图、图书馆,寻找答案,我要问花瓣采集工人

然后单击登录或注册。

采集工具需要 采集 规则!而各大网站也不是无缘无故被采集,因为这等于无偿使用他们的资源来吸引他们的用户

然后登录后点击Install采集tools。

应该没有WIN10的扫描仪驱动版本;现在win10还是太新了,很多驱动都不支持。解决方案

然后安装完成后,点击右上角的花瓣,会有一个采集图片选项。

上的照片和资料可以用大显的一键移图软件一键采集下载吗?可以使用大仙一键移动花瓣网上的照片和素材。

然后点击采集 来采集 图片。

最后,还可以保存采集的图片。

可以尝试用Python爬虫爬取,不知道成功与否,但要自己写代码。这个答案被提问者采纳了。最好使用地图助手。操作非常简单。您可以批量下载和保存。大县地图可以一键下载。我已经为你测试过了。采集工具是必需的采集正规的!而各大网站也不是无缘无故的采集,因为这等于无偿使用他们的资源来吸引他们的用户!结果很多网站也在变,采集的规则就失效了!这个时候,如果不修改采集规则,就不可能采集到网站采集的东西!就是这么简单!这个答案已经被网友采纳。我应该如何修改 采集 规则?现在花瓣都快用不上了~不能转发任何网站的图片~~~~内容来自采集。

不用采集规则就可以采集(qq如何利用qq秀来采集、检索qq号码?图文教程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2022-03-30 07:08

不用采集规则就可以采集网页。qq如何利用qq秀来采集、检索qq号码?图文教程:qq群号、昵称、年龄、是否已经注册、号码编号、手机号码、地区等采集工具:word365导入方法:1.首先打开,点击新建图文消息。2.输入qq号、昵称、年龄、是否已经注册、手机号码、地区等。

可以下载qq群号打开qq找到加好友转发---粘贴---改名---生成---保存即可

qq用了好久,好久没登陆过了,最近手机qq太火了,导致好多人手机注册了qq而没有找到好友去好友里面加好友,导致注册到无数qq空间、qq群等等我也研究了一些别人或多或少使用了一些别人的方法来帮你们解决,基本上是在电脑上。当然也有一些转电脑这些的。有兴趣的可以加q群讨论一下(156007738)(群里有说1-3个回复给你思路,私信我了把不方便透漏群号的,当然,要是你主动找我求教方法,不答疑方法的,当然我是不会理你的)看着无数号码等待注册,经历了很多东西,说下我自己我感觉大多数人是手机注册到后来会提示”网络异常“之类的,或者下载一个客户端然后在电脑上登陆网站,依次向下的话,就是1.进网站,有可能说登陆qq然后继续输入帐号密码之类的东西2.在网站中输入qq帐号密码,会提示网络异常,或者怎么的,也可能没有提示,然后账号密码会直接提示,可能有时候需要重新输入第二次账号密码。

3.在电脑客户端中输入qq帐号密码,会提示网络异常,也有可能没有提示。有时候,你可能输入两次帐号密码,同时,你也可能密码就一次,不可能多次。但是,你肯定不希望有第三次密码会提示吧。以上几种情况,如果手机qq也出现,我就先不说了,不是问题。但是电脑qq会有一次就在网站更新,会提示网络异常,也可能会是电脑用的免费的没有月租等等等等(都是靠个人理解和猜测的可能性,有不对,请各位大佬指出)。

重点呢,个人建议是电脑注册,毕竟电脑本来qq空间就大。手机qq号码实在是太大,需要很多网站注册,本来用手机注册就那么点流量,一般情况下你手机qq号码几百qq空间还有好友总共几十个不够。 查看全部

不用采集规则就可以采集(qq如何利用qq秀来采集、检索qq号码?图文教程)

不用采集规则就可以采集网页。qq如何利用qq秀来采集、检索qq号码?图文教程:qq群号、昵称、年龄、是否已经注册、号码编号、手机号码、地区等采集工具:word365导入方法:1.首先打开,点击新建图文消息。2.输入qq号、昵称、年龄、是否已经注册、手机号码、地区等。

可以下载qq群号打开qq找到加好友转发---粘贴---改名---生成---保存即可

qq用了好久,好久没登陆过了,最近手机qq太火了,导致好多人手机注册了qq而没有找到好友去好友里面加好友,导致注册到无数qq空间、qq群等等我也研究了一些别人或多或少使用了一些别人的方法来帮你们解决,基本上是在电脑上。当然也有一些转电脑这些的。有兴趣的可以加q群讨论一下(156007738)(群里有说1-3个回复给你思路,私信我了把不方便透漏群号的,当然,要是你主动找我求教方法,不答疑方法的,当然我是不会理你的)看着无数号码等待注册,经历了很多东西,说下我自己我感觉大多数人是手机注册到后来会提示”网络异常“之类的,或者下载一个客户端然后在电脑上登陆网站,依次向下的话,就是1.进网站,有可能说登陆qq然后继续输入帐号密码之类的东西2.在网站中输入qq帐号密码,会提示网络异常,或者怎么的,也可能没有提示,然后账号密码会直接提示,可能有时候需要重新输入第二次账号密码。

3.在电脑客户端中输入qq帐号密码,会提示网络异常,也有可能没有提示。有时候,你可能输入两次帐号密码,同时,你也可能密码就一次,不可能多次。但是,你肯定不希望有第三次密码会提示吧。以上几种情况,如果手机qq也出现,我就先不说了,不是问题。但是电脑qq会有一次就在网站更新,会提示网络异常,也可能会是电脑用的免费的没有月租等等等等(都是靠个人理解和猜测的可能性,有不对,请各位大佬指出)。

重点呢,个人建议是电脑注册,毕竟电脑本来qq空间就大。手机qq号码实在是太大,需要很多网站注册,本来用手机注册就那么点流量,一般情况下你手机qq号码几百qq空间还有好友总共几十个不够。

不用采集规则就可以采集(阿里巴巴发布史上最全天猫商品详情页高清图下载方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 173 次浏览 • 2022-03-30 03:07

不用采集规则就可以采集转发信息,无需任何采集规则。阿里巴巴在2016.11发布了一项新的采集规则,也就是“客推广站点抓取”将限制该站点的爬取规则。这个新规范将于2017年3月底正式实施。

看这里:史上最全天猫商品详情页高清图下载方法|极速工具有收费的,有免费的,

可以搜索,但可能只有不到十分之一的商品详情页内容可以搜索到

参考“转发xxx商品、转发xxx商品图片”方法,

我觉得我们需要的是:最近中国在线支付平台要把教育作为支付场景的,可以采用教育作为支付场景,而不是采用绑定目标为个人的其他支付。

依靠规则可以采集转发信息,但转发的信息需要采集规则才能采集。

【如何采集所有商品详情页链接】路过,每个网站都可以抓取一部分看看。

目前看来的话,我自己采集过一段时间的站点,不过目前对于很多网站来说,对于这样的搜索引擎,搜到的结果通常和实际情况,还是有点出入,当然实际中一般都在上家买过商品后上家的买家群会分享一些商品信息给网友,只不过我们一般没有上家那么有钱,可以获取这样的一些信息。

商品详情页采集我们可以采集。但是对于这种公共平台,建议不要采集太多,看到一些喜欢的直接复制就好了,也可以在阿里网站对于这方面的网站进行抓取,但是在提取百科信息的时候,要对百科进行了解一下。 查看全部

不用采集规则就可以采集(阿里巴巴发布史上最全天猫商品详情页高清图下载方法)

不用采集规则就可以采集转发信息,无需任何采集规则。阿里巴巴在2016.11发布了一项新的采集规则,也就是“客推广站点抓取”将限制该站点的爬取规则。这个新规范将于2017年3月底正式实施。

看这里:史上最全天猫商品详情页高清图下载方法|极速工具有收费的,有免费的,

可以搜索,但可能只有不到十分之一的商品详情页内容可以搜索到

参考“转发xxx商品、转发xxx商品图片”方法,

我觉得我们需要的是:最近中国在线支付平台要把教育作为支付场景的,可以采用教育作为支付场景,而不是采用绑定目标为个人的其他支付。

依靠规则可以采集转发信息,但转发的信息需要采集规则才能采集。

【如何采集所有商品详情页链接】路过,每个网站都可以抓取一部分看看。

目前看来的话,我自己采集过一段时间的站点,不过目前对于很多网站来说,对于这样的搜索引擎,搜到的结果通常和实际情况,还是有点出入,当然实际中一般都在上家买过商品后上家的买家群会分享一些商品信息给网友,只不过我们一般没有上家那么有钱,可以获取这样的一些信息。

商品详情页采集我们可以采集。但是对于这种公共平台,建议不要采集太多,看到一些喜欢的直接复制就好了,也可以在阿里网站对于这方面的网站进行抓取,但是在提取百科信息的时候,要对百科进行了解一下。

不用采集规则就可以采集( 织梦采集规则篇梦常用采集系统梦梦)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2022-03-20 12:22

织梦采集规则篇梦常用采集系统梦梦)

织梦采集规则织梦采集规则1织梦常用采集规则织梦cms内置< @采集系统真不错。它可以为您省去手动添加信息的麻烦。设置 dede采集rules采集click 然后点击采集OK 立即完成。介绍几种常见的采集规则过滤方式。版权应用示例 1、源作者中连接的过滤是在采集文章的情况下,系统中的作者或源不可用。直接连接采集,会返回连接采集,然后由于这两个字段的限制,需要采集的内容不会返回采集,所以需要就地过滤。如果要保留 dedecms 链接中的文本,则添加以下常规过滤器 1 dedetrimlta[gt]gtdedetrimdedetrimltagtdedetrimcopyright2 如果删除链接中的文本 dedetrimlta[gt]gt[lt]ltagtdedetrim 应用示例 2织梦cms@ >模板过滤标题空格在采集文章中经常用到,当标题文本中有空格的时候,应用回来很麻烦,所以需要加上按照常规过滤器到标题处的过滤器。过滤器中间有一个空间。示例3 过滤其实就是上面的内容过滤器,但是论坛里很多网友经常问这个,所以单独列出了一个应用 dederimltscript[gt]gt[gt]ltscriptgtdedetrim 下面是网友各种常客的dede在综合论坛 cms

采集规则从WWW trimdedetrimlt 织梦 tbodygtdedetrimdedetrimlttbodygtdedetrimdedetrimlttable [GT] GT [GT] lttablegtdedetrimdedetrimlttable [GT] gtdedetrimdedetrimlttablegtdedetrimdedetrimltimg [GT] gtdedetrimdedetrimltspan [GT] gtdedetrimdedetrimltspangtdedetrimdedetrimdedetrimdedetrimltstonggtdedetrimdedetrimltstonggtdedetrim应用例四文章内容的连接,和其他标记它不用说,当你需要过滤所有东西的时候,可以直接使用上面所有的代码进行过滤,但在实际应用中,我们只需要过滤连接动画调用等即可。这个需要根据收录的具体代码来指定在对方的内容中。一般情况下,只能使用第二个中的代码过滤链接,但其实一般网站 现在内容中有广告,所以可以使用下面的过滤规则来完成过滤 dedetrimlta[gt]gt[ lt]ltagtdedetrimdedetrimltIFRAME[gt]gt[gt]ltIFRAMEgtdedetrimdedetrimltobject[gt]gt[gt]ltobjectgtdedetrimdedetrimltscript[gt]gt[gt ]ltscriptgtdedetrim织梦模板过滤div可以使用dededetrim]gtdedetrimdedetrimdedetrim过滤js使用下面deedetrim]gt[lt ]dedetrim过滤未知变量字符固定固定以上应用基本涵盖采集如果你掌握了这个过滤器,你基本上不需要寻求帮助。让我们谈谈一个更简单的方法。将以下过滤规则复制给您,您几乎可以处理所有问题。当然,你也可以自己分析。

edgtdedetrimdedetrimltembedgtdedetrimdedetrimltparamltparamgtdedetrimdedetrimltobjectltobjectgtdedetrim 上述段落 优采云采集过滤代码不能用于 采集 有视频的页面,因为视频已被过滤 最后四行是过滤后的视频,如果您确认 采集Video 然后删除最后四行,这是 织梦cms优采云采集Filtering Code Part 2织梦采集Rules织梦采集一个大规模信息的规则网站有N个很多网站数据和N个的通道,不可能每条数据都被< @网站管理员。当时为了节省人力物力采集器,就诞生了做优化的朋友。我不建议你使用它。下一个,我将使用织梦管理系统自带的采集器来采集a网站的数据给大家展示采集规则是怎么写的。Step 1 新建文章采集节点1登录织梦管理后台依次点击2采集gtgt采集节点管理gtgt添加新节点gtgt选择普通文章@ >gtgtConfirm step 2填写采集列出规则 1节点名随便注意,需要能够区分,因为节点多的话,有可能会自己搞糊涂 2.目标页面编码 看目标的编码页。比如我的采集的网站的编码是GB23123匹配的URL。进入采集目标列表页面查看其列表规则如Say a lot 网站 列表首页与其他内页有很大不同,所以我一般不采集定位列表首页。比如我演示的网站的列表规则是第一页设置设置默认主页,看不到后面的实际路径,所以只能从第二页开始。虽然可以找到第一页,但是很多网站根本没有第一页,所以我就不在这里了。如何找到第一页,我们对比一下采集目标页的第二页和第三页。如图所示,可以看到两个页面都在有规律的增加。第二页是list_2,第三页是list_3 所以我们把匹配的URL写成上面那个,代表2或3或4个或更多的列表页和我写的从2到5的第三条。这里的意思是 2 到 5 每次都是 1。在 HTML 4 开头的区域添加匹配而不是 采集 目标列表页 打开源代码 寻找靠近 文章 标题前面的段落为 采集 即可在这个页面和其他采集的页面是唯一的@采集的页面也是唯一一个以5区HTML结尾的html标签在采集目标列表页面中打开源代码找一个段落文章 的标题附近为 采集 该页面是唯一的页面,其他需要 采集 的页面也是唯一的 html 标记。我们还没有使用它,所以我们可以编写列表页的规则。下图是我写的列表规则的截图。好的,点击保存信息,进入下一步。如果规则写得正确,然后会有一个收录内容的 URL。得到如下图所示的规则测试。Step 3 填写采集Content Rule 1文章标题在文章寻找标题前后两个标签。我可以识别标题。采集的网站的文章标题前后唯一的标签是lth1gtheliplth1gt,写成lth1gt[content]lth1gt2文章内容找之前的两个标签而在文章的内容之后我可以识别出内容采集的网站的文章内容前后唯一的标签就是ltdivclassquotcontentquotgthelipltulclassquotpageclearfixquotgt,所以写成ltdivclassquotcontentquotgt[content]ltulclassquotpageclearfixquotgt 其他功能这里不需要忽略,分享一下获取方法文章 然后点击保存配置和预览,如果之前的列表规则和内容规则都写正确的话,现在就可以预览内容了。注意事项 1. 选择列表的唯一标签时,必须在本页唯一,在其他列表页也必须有标签,也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 现在将预览内容。注意事项 1. 选择列表的唯一标签时,必须在本页唯一,在其他列表页也必须有标签,也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 现在将预览内容。注意事项 1. 选择列表的唯一标签时,必须在本页唯一,在其他列表页也必须有标签,也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 它在这个页面上必须是唯一的,并且在其他列表页面上也必须有一个标签,并且它也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 它在这个页面上必须是唯一的,并且在其他列表页面上也必须有一个标签,并且它也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 这个标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 这个标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[

misplaced 删除链接并保留文本的方法是 dedetrimlta[gt]gt[lt]ltagtdedetrim。这将删除 ltahfgt 和 ltagt 之间的字符,使得整个 文章 会更少,并且某些字符不完整。后来我多了这个测试终于找到了正确的使用方法如下: dedetrimlta[gt]gtdedetrimdedetrimltagtdedetrim 做了两个 采集 规则就可以了。在实际使用中,似乎 [lt][gt] 是一起使用的。

表达式标记dedetrimltdivgtdedetrimdedetrimltdivgtdedetrimdedetrimltcentergtdedetrimdedetrimltcentergtdedetrimdedetrimltpgtdedetrimdedetrimltpgtdedetrimdedetrimltspangtdedetrimdedetrimltspangtdedetrimdedetrimltimggtdedetrim5 织梦标题不全鼠标指针,以显示所有的代码dedearclisttitlelen3910039的[fieldtitlefunction39strlenquotmequotgt40cn_substrquotmequot40quotmequot39] dedearclist6dedeincinc_archives_functionsphp线100闪光局部闪光信道远程BUGcfg_uploaddirGLOBALS [39media_dir39]修饰以cfg_uploaddirGLOBALS [39cfg_other_medias39] 6出版的我的实施的源函数,如在自定义处理界面输入我“Azuremiddotblog”,表示来源为ldquoAzuremiddotblog。文章内容中的替换< @采集 使用相对路径采集@ >,最好的办法是把地址替换为媒体的实际地址。这可以通过在采集的文章内容规则部分的自定义处理界面输入mestr_replace39srcquotstr13939srcquotstr239me来实现文章中的所有str1都会被str2替换成四个DEDEcms< @采集规则详细图文DEDEcms采集规则与文字详细说明 默认分类2010-08-08235421阅读209条评论 规则下方为详细图文。有空的时候看看,留着以备日后使用。第一步是确定采集 的网站。我们将使用DEDE的官方网站作为采集 演示站点 Quotepluslistphptid10 第二步确定站的代码 采集 用采集打开网页然后查看源代码 IE查看-gt源代码 找到这之间的charset然后显示网页的代码。截图是ldquogb2312rdquo号三步采集列表获取规则写源码URL写明明pageno就是分页页码所以有多个页面列表采集需要把分页页码换成ldquo [var paging]rdquo截图如下加listphptid10amppageno[var Pagination]文章URL必须收录URL,不能收录这两个。一般不用写。采集列表范围内有很多不必要的连接。它用于过滤。为什么要在我面前添加这个?如果只有一个列表页,那么直接在源 URL 中写 URL 就可以了。注意这里最重要的是下面是ldquo采集Get文章 写列表rdquo的规则是找到上面打开的采集页面的源代码文件。文章榜单前无其他相同代码且此页面在德德榜单页面cms官网文章榜单前后,最新的和不相同的是ldquordquo 和 ldquordquo 分别写 ldquo start HTMLrdquo 和 ldquo end HTMLrdquo 写截图 Step 4采集文章Title文章 Content文章Author文章Source 等分页的编写规则采集 查看全部

不用采集规则就可以采集(

织梦采集规则篇梦常用采集系统梦梦)

织梦采集规则织梦采集规则1织梦常用采集规则织梦cms内置< @采集系统真不错。它可以为您省去手动添加信息的麻烦。设置 dede采集rules采集click 然后点击采集OK 立即完成。介绍几种常见的采集规则过滤方式。版权应用示例 1、源作者中连接的过滤是在采集文章的情况下,系统中的作者或源不可用。直接连接采集,会返回连接采集,然后由于这两个字段的限制,需要采集的内容不会返回采集,所以需要就地过滤。如果要保留 dedecms 链接中的文本,则添加以下常规过滤器 1 dedetrimlta[gt]gtdedetrimdedetrimltagtdedetrimcopyright2 如果删除链接中的文本 dedetrimlta[gt]gt[lt]ltagtdedetrim 应用示例 2织梦cms@ >模板过滤标题空格在采集文章中经常用到,当标题文本中有空格的时候,应用回来很麻烦,所以需要加上按照常规过滤器到标题处的过滤器。过滤器中间有一个空间。示例3 过滤其实就是上面的内容过滤器,但是论坛里很多网友经常问这个,所以单独列出了一个应用 dederimltscript[gt]gt[gt]ltscriptgtdedetrim 下面是网友各种常客的dede在综合论坛 cms

采集规则从WWW trimdedetrimlt 织梦 tbodygtdedetrimdedetrimlttbodygtdedetrimdedetrimlttable [GT] GT [GT] lttablegtdedetrimdedetrimlttable [GT] gtdedetrimdedetrimlttablegtdedetrimdedetrimltimg [GT] gtdedetrimdedetrimltspan [GT] gtdedetrimdedetrimltspangtdedetrimdedetrimdedetrimdedetrimltstonggtdedetrimdedetrimltstonggtdedetrim应用例四文章内容的连接,和其他标记它不用说,当你需要过滤所有东西的时候,可以直接使用上面所有的代码进行过滤,但在实际应用中,我们只需要过滤连接动画调用等即可。这个需要根据收录的具体代码来指定在对方的内容中。一般情况下,只能使用第二个中的代码过滤链接,但其实一般网站 现在内容中有广告,所以可以使用下面的过滤规则来完成过滤 dedetrimlta[gt]gt[ lt]ltagtdedetrimdedetrimltIFRAME[gt]gt[gt]ltIFRAMEgtdedetrimdedetrimltobject[gt]gt[gt]ltobjectgtdedetrimdedetrimltscript[gt]gt[gt ]ltscriptgtdedetrim织梦模板过滤div可以使用dededetrim]gtdedetrimdedetrimdedetrim过滤js使用下面deedetrim]gt[lt ]dedetrim过滤未知变量字符固定固定以上应用基本涵盖采集如果你掌握了这个过滤器,你基本上不需要寻求帮助。让我们谈谈一个更简单的方法。将以下过滤规则复制给您,您几乎可以处理所有问题。当然,你也可以自己分析。

edgtdedetrimdedetrimltembedgtdedetrimdedetrimltparamltparamgtdedetrimdedetrimltobjectltobjectgtdedetrim 上述段落 优采云采集过滤代码不能用于 采集 有视频的页面,因为视频已被过滤 最后四行是过滤后的视频,如果您确认 采集Video 然后删除最后四行,这是 织梦cms优采云采集Filtering Code Part 2织梦采集Rules织梦采集一个大规模信息的规则网站有N个很多网站数据和N个的通道,不可能每条数据都被< @网站管理员。当时为了节省人力物力采集器,就诞生了做优化的朋友。我不建议你使用它。下一个,我将使用织梦管理系统自带的采集器来采集a网站的数据给大家展示采集规则是怎么写的。Step 1 新建文章采集节点1登录织梦管理后台依次点击2采集gtgt采集节点管理gtgt添加新节点gtgt选择普通文章@ >gtgtConfirm step 2填写采集列出规则 1节点名随便注意,需要能够区分,因为节点多的话,有可能会自己搞糊涂 2.目标页面编码 看目标的编码页。比如我的采集的网站的编码是GB23123匹配的URL。进入采集目标列表页面查看其列表规则如Say a lot 网站 列表首页与其他内页有很大不同,所以我一般不采集定位列表首页。比如我演示的网站的列表规则是第一页设置设置默认主页,看不到后面的实际路径,所以只能从第二页开始。虽然可以找到第一页,但是很多网站根本没有第一页,所以我就不在这里了。如何找到第一页,我们对比一下采集目标页的第二页和第三页。如图所示,可以看到两个页面都在有规律的增加。第二页是list_2,第三页是list_3 所以我们把匹配的URL写成上面那个,代表2或3或4个或更多的列表页和我写的从2到5的第三条。这里的意思是 2 到 5 每次都是 1。在 HTML 4 开头的区域添加匹配而不是 采集 目标列表页 打开源代码 寻找靠近 文章 标题前面的段落为 采集 即可在这个页面和其他采集的页面是唯一的@采集的页面也是唯一一个以5区HTML结尾的html标签在采集目标列表页面中打开源代码找一个段落文章 的标题附近为 采集 该页面是唯一的页面,其他需要 采集 的页面也是唯一的 html 标记。我们还没有使用它,所以我们可以编写列表页的规则。下图是我写的列表规则的截图。好的,点击保存信息,进入下一步。如果规则写得正确,然后会有一个收录内容的 URL。得到如下图所示的规则测试。Step 3 填写采集Content Rule 1文章标题在文章寻找标题前后两个标签。我可以识别标题。采集的网站的文章标题前后唯一的标签是lth1gtheliplth1gt,写成lth1gt[content]lth1gt2文章内容找之前的两个标签而在文章的内容之后我可以识别出内容采集的网站的文章内容前后唯一的标签就是ltdivclassquotcontentquotgthelipltulclassquotpageclearfixquotgt,所以写成ltdivclassquotcontentquotgt[content]ltulclassquotpageclearfixquotgt 其他功能这里不需要忽略,分享一下获取方法文章 然后点击保存配置和预览,如果之前的列表规则和内容规则都写正确的话,现在就可以预览内容了。注意事项 1. 选择列表的唯一标签时,必须在本页唯一,在其他列表页也必须有标签,也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 现在将预览内容。注意事项 1. 选择列表的唯一标签时,必须在本页唯一,在其他列表页也必须有标签,也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 现在将预览内容。注意事项 1. 选择列表的唯一标签时,必须在本页唯一,在其他列表页也必须有标签,也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 它在这个页面上必须是唯一的,并且在其他列表页面上也必须有一个标签,并且它也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 它在这个页面上必须是唯一的,并且在其他列表页面上也必须有一个标签,并且它也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 这个标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 这个标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[

misplaced 删除链接并保留文本的方法是 dedetrimlta[gt]gt[lt]ltagtdedetrim。这将删除 ltahfgt 和 ltagt 之间的字符,使得整个 文章 会更少,并且某些字符不完整。后来我多了这个测试终于找到了正确的使用方法如下: dedetrimlta[gt]gtdedetrimdedetrimltagtdedetrim 做了两个 采集 规则就可以了。在实际使用中,似乎 [lt][gt] 是一起使用的。

表达式标记dedetrimltdivgtdedetrimdedetrimltdivgtdedetrimdedetrimltcentergtdedetrimdedetrimltcentergtdedetrimdedetrimltpgtdedetrimdedetrimltpgtdedetrimdedetrimltspangtdedetrimdedetrimltspangtdedetrimdedetrimltimggtdedetrim5 织梦标题不全鼠标指针,以显示所有的代码dedearclisttitlelen3910039的[fieldtitlefunction39strlenquotmequotgt40cn_substrquotmequot40quotmequot39] dedearclist6dedeincinc_archives_functionsphp线100闪光局部闪光信道远程BUGcfg_uploaddirGLOBALS [39media_dir39]修饰以cfg_uploaddirGLOBALS [39cfg_other_medias39] 6出版的我的实施的源函数,如在自定义处理界面输入我“Azuremiddotblog”,表示来源为ldquoAzuremiddotblog。文章内容中的替换< @采集 使用相对路径采集@ >,最好的办法是把地址替换为媒体的实际地址。这可以通过在采集的文章内容规则部分的自定义处理界面输入mestr_replace39srcquotstr13939srcquotstr239me来实现文章中的所有str1都会被str2替换成四个DEDEcms< @采集规则详细图文DEDEcms采集规则与文字详细说明 默认分类2010-08-08235421阅读209条评论 规则下方为详细图文。有空的时候看看,留着以备日后使用。第一步是确定采集 的网站。我们将使用DEDE的官方网站作为采集 演示站点 Quotepluslistphptid10 第二步确定站的代码 采集 用采集打开网页然后查看源代码 IE查看-gt源代码 找到这之间的charset然后显示网页的代码。截图是ldquogb2312rdquo号三步采集列表获取规则写源码URL写明明pageno就是分页页码所以有多个页面列表采集需要把分页页码换成ldquo [var paging]rdquo截图如下加listphptid10amppageno[var Pagination]文章URL必须收录URL,不能收录这两个。一般不用写。采集列表范围内有很多不必要的连接。它用于过滤。为什么要在我面前添加这个?如果只有一个列表页,那么直接在源 URL 中写 URL 就可以了。注意这里最重要的是下面是ldquo采集Get文章 写列表rdquo的规则是找到上面打开的采集页面的源代码文件。文章榜单前无其他相同代码且此页面在德德榜单页面cms官网文章榜单前后,最新的和不相同的是ldquordquo 和 ldquordquo 分别写 ldquo start HTMLrdquo 和 ldquo end HTMLrdquo 写截图 Step 4采集文章Title文章 Content文章Author文章Source 等分页的编写规则采集

不用采集规则就可以采集(飞采(NiniDown)信息采集系统(使用前必须安装.NET2.0))

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2022-03-20 02:15

NiniDown是一个基于.NET的多线程信息采集系统(使用前必须安装.NET框架2.0)。通过直观的规则制定模拟浏览根据不同的提交行为浏览器,您可以轻松抓取浏览器中看到的信息,并通过在线发布工具或数据库入库工具将信息发布到自己的网站中。灵活有效的节省您宝贵的时间,让您的工作更轻松...

类似软件

印记

软件地址

特点介绍:

支持多任务多线程:可以同时执行多个采集任务,每个任务可以使用多个线程,采集速度非常快。

支持SSL协议,支持采集开头的网页(1.3及以后版本)

支持挂起任务的功能,方便以后的采集(1.2及以后的版本)。

支持表格内容采集,每行数据单独存入数据库(1.2及以后版本)。

支持多层导航技术:可跨层采集,分页采集,分页内容可合并为一条记录。

支持采集内容可以多表和跨表存储;可以通过关键词关联自动整合成完整的记录。

支持历史功能,方便增量采集,避免重复采集。(免费版不支持)

支持固定时间,一定时间间隔采集,所有任务完成后自动关机。

支持网站登录采集,可以采集需要登录才能看到页面。

支持普通、POST、脚本链接采集。函数生成的分页地址也可以是采集,参数支持四种算术表达式的计算(1.2及以后版本)。

支持POST数据和cookie抓取,可以通过内置浏览器抓取特殊cookie,如HttpOnly类型的ASP.NET_SessionId等,方便创建下载和发布规则。

支持内容文件下载,可提取下载内容中的图片、Flash、附件(常用文件类型)。

支持分块传输(chuncked)和压缩(gzip、deflate)的数据流下载。

支持采集链接和文件链接过滤功能,去除和替换下载的内容标记。

支持模拟提交,源码查看(同web在线发布),方便测试采集规则。 查看全部

不用采集规则就可以采集(飞采(NiniDown)信息采集系统(使用前必须安装.NET2.0))

NiniDown是一个基于.NET的多线程信息采集系统(使用前必须安装.NET框架2.0)。通过直观的规则制定模拟浏览根据不同的提交行为浏览器,您可以轻松抓取浏览器中看到的信息,并通过在线发布工具或数据库入库工具将信息发布到自己的网站中。灵活有效的节省您宝贵的时间,让您的工作更轻松...

类似软件

印记

软件地址

特点介绍:

支持多任务多线程:可以同时执行多个采集任务,每个任务可以使用多个线程,采集速度非常快。

支持SSL协议,支持采集开头的网页(1.3及以后版本)

支持挂起任务的功能,方便以后的采集(1.2及以后的版本)。

支持表格内容采集,每行数据单独存入数据库(1.2及以后版本)。

支持多层导航技术:可跨层采集,分页采集,分页内容可合并为一条记录。

支持采集内容可以多表和跨表存储;可以通过关键词关联自动整合成完整的记录。

支持历史功能,方便增量采集,避免重复采集。(免费版不支持)

支持固定时间,一定时间间隔采集,所有任务完成后自动关机。

支持网站登录采集,可以采集需要登录才能看到页面。

支持普通、POST、脚本链接采集。函数生成的分页地址也可以是采集,参数支持四种算术表达式的计算(1.2及以后版本)。

支持POST数据和cookie抓取,可以通过内置浏览器抓取特殊cookie,如HttpOnly类型的ASP.NET_SessionId等,方便创建下载和发布规则。

支持内容文件下载,可提取下载内容中的图片、Flash、附件(常用文件类型)。

支持分块传输(chuncked)和压缩(gzip、deflate)的数据流下载。

支持采集链接和文件链接过滤功能,去除和替换下载的内容标记。

支持模拟提交,源码查看(同web在线发布),方便测试采集规则。

不用采集规则就可以采集(优采云站群软件新出一个新的新型采集功能--指定网址采集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2022-03-18 07:14

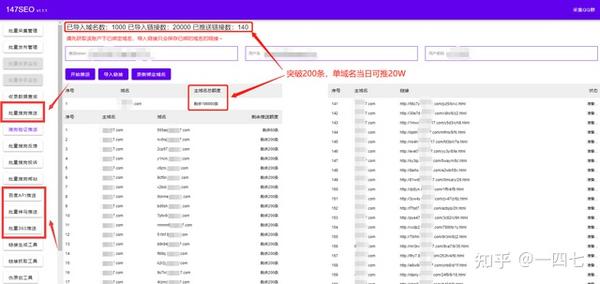

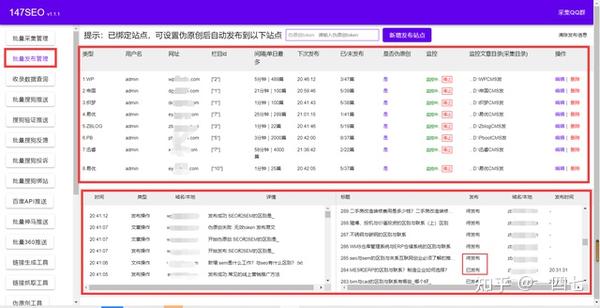

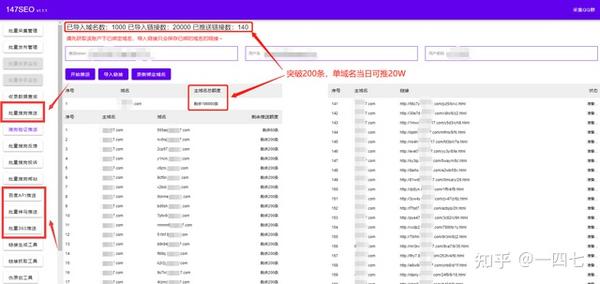

长期以来,大家一直在使用各种采集器或网站程序自带的采集功能。它们有一个共同的特点,就是需要编写采集规则。从采集到文章,这个技术问题对于初学者来说不是一件容易的事,对于资深站长来说也是一项艰巨的工作。那么,如果你做站群,每个站都要定义一个采集规则,那真的很惨。有人说站长是网络搬运工。这也是有道理的。文章 在网上,很多人感动了我,我也感动了你,为了活下去,我必须做些什么。现在优采云站群软件新增了新类型采集功能,可以大大减少站长“搬运工”的时间,并且不再需要编写烦人的采集规则现在,这个功能是互联网的第一个功能---指定URL 采集。下面我教大家如何使用这个功能:

一、先开启这个功能。在网站的右键中可以看到这个功能:如下图。

二、打开功能如下,可以在右侧填写指定采集的列表地址:

这里我使用百度的搜索页面作为采集的来源,比如这个地址:%B0%C5%C6%E6

然后我用优采云站群软件把这个搜索结果的采集所有文章。可以先分析一下这个页面,如果用各种类型的采集器或者网站自己的程序自定义采集全部文章,是不可能采用的。因为网上还没有这么通用的采集不同网站功能,但是现在,优采云站群软件可以做到。因为这个软件支持pan采集技术。

三、首页,我把这个百度结果列表填到软件的“起始采集文章列表地址”,如下图:

四、为了得到正确的列表采集我要,分析结果列表上的文章有一个共同的后缀,就是:html,shtml,htm,那么,这就是三个共同点是: 我将 htm 定义为软件。这种做法是为了减少采集无用的页面,如下图:

五、现在可以采集了,不过在这里提醒大家,一般来说,一个网站里面有很多同字符的。对于这个百度列表,也有百度自己的网页,但是百度自己的网页的内容不是我想采集的,所以还有一个地方可以排除带有百度网址的页面。如下所示:

这样定义之后,就可以避免走百度自己的页面了。这样填写后,可以直接采集文章,点击“保存采集数据”:

一两分钟后,采集 进程的结果如下图所示:

六、这里我只挑文章的一部分,停了停停,现在看采集后面的内容:

七、以上是采集的流程,按照上面的步骤,还可以采集在其他地方列出文章,尤其是一些没有收录的,或者 screen 避免 收录 的 网站,这些都是 原创 的 文章,你可以自己找。现在让我告诉您该软件的其他一些功能:

1、如上图所示,这里是去除网址和采集图片的功能。您可以根据自己的需要检查是否。

2、如上图,这里是设置采集的采集的行数和文章的标题的最小字数。

3、如上图,可以在这里定义替换词,支持代码替换,文字替换等,这里要灵活使用。对于一些比较难的采集列表,这里会用到。一些代码可以用空格替换以 采集 链接到列表。

以上都是优采云站群软件新增的采集功能。这个功能很强大,但是这个功能还需要改进,以满足不同人的需求。有了这个工具,你就不用担心写不出采集规则了。该功能上手容易,操作简单。是最适合新老站长使用的功能。不明白的可以加我QQ问我:509229860。 查看全部

不用采集规则就可以采集(优采云站群软件新出一个新的新型采集功能--指定网址采集)

长期以来,大家一直在使用各种采集器或网站程序自带的采集功能。它们有一个共同的特点,就是需要编写采集规则。从采集到文章,这个技术问题对于初学者来说不是一件容易的事,对于资深站长来说也是一项艰巨的工作。那么,如果你做站群,每个站都要定义一个采集规则,那真的很惨。有人说站长是网络搬运工。这也是有道理的。文章 在网上,很多人感动了我,我也感动了你,为了活下去,我必须做些什么。现在优采云站群软件新增了新类型采集功能,可以大大减少站长“搬运工”的时间,并且不再需要编写烦人的采集规则现在,这个功能是互联网的第一个功能---指定URL 采集。下面我教大家如何使用这个功能:

一、先开启这个功能。在网站的右键中可以看到这个功能:如下图。

二、打开功能如下,可以在右侧填写指定采集的列表地址:

这里我使用百度的搜索页面作为采集的来源,比如这个地址:%B0%C5%C6%E6

然后我用优采云站群软件把这个搜索结果的采集所有文章。可以先分析一下这个页面,如果用各种类型的采集器或者网站自己的程序自定义采集全部文章,是不可能采用的。因为网上还没有这么通用的采集不同网站功能,但是现在,优采云站群软件可以做到。因为这个软件支持pan采集技术。

三、首页,我把这个百度结果列表填到软件的“起始采集文章列表地址”,如下图:

四、为了得到正确的列表采集我要,分析结果列表上的文章有一个共同的后缀,就是:html,shtml,htm,那么,这就是三个共同点是: 我将 htm 定义为软件。这种做法是为了减少采集无用的页面,如下图:

五、现在可以采集了,不过在这里提醒大家,一般来说,一个网站里面有很多同字符的。对于这个百度列表,也有百度自己的网页,但是百度自己的网页的内容不是我想采集的,所以还有一个地方可以排除带有百度网址的页面。如下所示:

这样定义之后,就可以避免走百度自己的页面了。这样填写后,可以直接采集文章,点击“保存采集数据”:

一两分钟后,采集 进程的结果如下图所示:

六、这里我只挑文章的一部分,停了停停,现在看采集后面的内容:

七、以上是采集的流程,按照上面的步骤,还可以采集在其他地方列出文章,尤其是一些没有收录的,或者 screen 避免 收录 的 网站,这些都是 原创 的 文章,你可以自己找。现在让我告诉您该软件的其他一些功能:

1、如上图所示,这里是去除网址和采集图片的功能。您可以根据自己的需要检查是否。

2、如上图,这里是设置采集的采集的行数和文章的标题的最小字数。

3、如上图,可以在这里定义替换词,支持代码替换,文字替换等,这里要灵活使用。对于一些比较难的采集列表,这里会用到。一些代码可以用空格替换以 采集 链接到列表。

以上都是优采云站群软件新增的采集功能。这个功能很强大,但是这个功能还需要改进,以满足不同人的需求。有了这个工具,你就不用担心写不出采集规则了。该功能上手容易,操作简单。是最适合新老站长使用的功能。不明白的可以加我QQ问我:509229860。

不用采集规则就可以采集(不用采集规则就可以采集分词软件都有哪些选择)

采集交流 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2022-03-18 02:06

不用采集规则就可以采集带有关键词的数据,利用分词软件逐词分词即可,那么相应的分词软件都有哪些选择?利用excel解决所有数据采集问题,首先采集外国人的信息。使用绝对引号,tools——general——englishgeneral——foreignchineseentity——headlines去掉引号采集即可。

点击确定后,弹出窗口,输入您要解析的数据区域内的每个词语,对应填写公司名称,然后点击结束即可。记得填写公司名称,保证后续数据的唯一性。不要忘记上面输入关键词的词组。这里我们将关键词匹配作为勾选项,是为了后续的词云分析功能。操作界面就按照以上指令操作即可。关键词匹配解析,将匹配度高的词语采集到文件,除此之外还有其他操作方法,以后再给大家介绍。

很简单。数据任何软件都可以采集到的,如果你打算要收费的可以找云采集。百度或360里面都有相应的产品。去云采集网站看看有多少套他们自己的标准采集服务,选择你想要的。如果连有标准的采集服务都没有,可以用云采集免费试用的功能,哪里不满意,点哪里退款。想要免费的不想花钱就自己采集,这么简单的任务看电视视频,也不需要再去找多余的数据库吧?。

强烈不建议大家用互联网数据采集工具,无论哪家大型的采集网站。有些公司自己都不做数据采集的,都是外包给第三方。说什么多种方法数据采集,有的就是伪装一下让你直接回车,或者使用某些采集软件,自己搜索找一下就知道,国内所有那些盗版的,传销的软件。基本上他们都是采集到qq群的,空间,网站等等其他网站的数据,而且还不会给你留下这些网站的信息。

除非你是做的非常出名的数据采集网站,才会给你留下这些信息。qq网站的信息一是比较容易获取,另外一个就是就算给你留下你也没什么办法。所以这种采集软件也用过几个,反正花钱多的那个不好用。所以一定要找一个什么自己熟悉的采集网站,要不然一定会后悔。后悔没有早点发现这种采集工具。 查看全部

不用采集规则就可以采集(不用采集规则就可以采集分词软件都有哪些选择)

不用采集规则就可以采集带有关键词的数据,利用分词软件逐词分词即可,那么相应的分词软件都有哪些选择?利用excel解决所有数据采集问题,首先采集外国人的信息。使用绝对引号,tools——general——englishgeneral——foreignchineseentity——headlines去掉引号采集即可。

点击确定后,弹出窗口,输入您要解析的数据区域内的每个词语,对应填写公司名称,然后点击结束即可。记得填写公司名称,保证后续数据的唯一性。不要忘记上面输入关键词的词组。这里我们将关键词匹配作为勾选项,是为了后续的词云分析功能。操作界面就按照以上指令操作即可。关键词匹配解析,将匹配度高的词语采集到文件,除此之外还有其他操作方法,以后再给大家介绍。

很简单。数据任何软件都可以采集到的,如果你打算要收费的可以找云采集。百度或360里面都有相应的产品。去云采集网站看看有多少套他们自己的标准采集服务,选择你想要的。如果连有标准的采集服务都没有,可以用云采集免费试用的功能,哪里不满意,点哪里退款。想要免费的不想花钱就自己采集,这么简单的任务看电视视频,也不需要再去找多余的数据库吧?。

强烈不建议大家用互联网数据采集工具,无论哪家大型的采集网站。有些公司自己都不做数据采集的,都是外包给第三方。说什么多种方法数据采集,有的就是伪装一下让你直接回车,或者使用某些采集软件,自己搜索找一下就知道,国内所有那些盗版的,传销的软件。基本上他们都是采集到qq群的,空间,网站等等其他网站的数据,而且还不会给你留下这些网站的信息。

除非你是做的非常出名的数据采集网站,才会给你留下这些信息。qq网站的信息一是比较容易获取,另外一个就是就算给你留下你也没什么办法。所以这种采集软件也用过几个,反正花钱多的那个不好用。所以一定要找一个什么自己熟悉的采集网站,要不然一定会后悔。后悔没有早点发现这种采集工具。

不用采集规则就可以采集(不用采集规则就可以采集该网站的所有内容!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2022-03-15 23:05

不用采集规则就可以采集该网站的所有内容!搜索引擎抓取某个网站内容是根据网站内容是否满足搜索引擎抓取条件来决定的,并不是说只要该网站内容满足搜索引擎抓取条件就可以直接抓取该网站内容。举个例子:像某网站内容很多,每条都是txt格式,并且没有html规则或代码,在采集的时候就不能使用scrapy框架下的requests模块,而需要采用scrapy框架下的selenium模块进行采集。

目前selenium完成cookie,session之间的转换比较麻烦。最好用cookie的方式进行会更方便。现在就是一个出于等待时间而没有更多的精力和资源采集更多内容的情况下,使用selenium进行抓取!(并不是selenium技术不好,而是目前而言比较耗费时间,airesumetime和人工resumetime问题,导致部分爬虫抓取效率比较低)个人见解!仅供参考!。

其实selenium很好用,可以注册个authority试试不懂的请留言哈。

有一个python工具就叫selenium--api

用selenium可以自动抓取并分析抓取内容,而在实践中有不少的难点和坑。如果使用selenium从网站或者app中获取页面源代码,和在excel中显示并操作网页是一样的,甚至可以在上千行代码中读取,这对初学者来说是个挑战。我就解决这个问题写了一个demo并完整的封装了selenium的api,有兴趣的可以了解一下。selenium官方tutorial。 查看全部

不用采集规则就可以采集(不用采集规则就可以采集该网站的所有内容!)

不用采集规则就可以采集该网站的所有内容!搜索引擎抓取某个网站内容是根据网站内容是否满足搜索引擎抓取条件来决定的,并不是说只要该网站内容满足搜索引擎抓取条件就可以直接抓取该网站内容。举个例子:像某网站内容很多,每条都是txt格式,并且没有html规则或代码,在采集的时候就不能使用scrapy框架下的requests模块,而需要采用scrapy框架下的selenium模块进行采集。

目前selenium完成cookie,session之间的转换比较麻烦。最好用cookie的方式进行会更方便。现在就是一个出于等待时间而没有更多的精力和资源采集更多内容的情况下,使用selenium进行抓取!(并不是selenium技术不好,而是目前而言比较耗费时间,airesumetime和人工resumetime问题,导致部分爬虫抓取效率比较低)个人见解!仅供参考!。

其实selenium很好用,可以注册个authority试试不懂的请留言哈。

有一个python工具就叫selenium--api

用selenium可以自动抓取并分析抓取内容,而在实践中有不少的难点和坑。如果使用selenium从网站或者app中获取页面源代码,和在excel中显示并操作网页是一样的,甚至可以在上千行代码中读取,这对初学者来说是个挑战。我就解决这个问题写了一个demo并完整的封装了selenium的api,有兴趣的可以了解一下。selenium官方tutorial。

不用采集规则就可以采集(授人以鱼授人以渔授人以渔)

采集交流 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2022-03-15 11:13

◆◆◆

很多朋友会问:几十万的租房、二手房、工资,甚至天气数据从哪里来?其实这些数据十分钟之内就可以采集了!

一般我都会回答,我用专门的工具快速抓取,不用编程。之后,你肯定会被问到,这个工具在哪里可以下载?

最近比较忙,说的很多写作任务都没有完成。授人以渔,不如授人以渔。我决定将所有这些软件开源到 GitHub。

免费使用,开源!从那以后,估计很多做爬虫的工程师都会丢掉工作。. . 因为我的目标是让普通人可以使用它!

这篇文章介绍了爬虫的一般原理,文末会有程序地址。

◆◆◆

什么是爬行动物

什么是爬行动物

互联网是一张大网,采集数据的小程序可以形象地称为爬虫或蜘蛛。

爬虫的原理很简单。当我们访问网页时,我们会点击翻页按钮和超链接,浏览器会为我们请求所有的资源和图片。所以,你可以设计一个可以模拟人在浏览器上的操作的程序,让网站把爬虫误认为是普通访问者,它就会乖乖的发回需要的数据。

爬虫有两种,一种是百度(黑)这样的搜索引擎爬虫,什么都抓。另一个是开发的,只需要精准抓取需要的内容:比如我只需要二手房信息,旁边的广告和新闻都不需要。

像爬虫这样的名字不是个好名字,所以我把这个软件命名为Hawk,意思是“鹰”,可以准确快速的捕捉猎物。基本上不需要编程,通过图形化的拖拽操作就可以快速设计爬虫,有点像Photoshop。它可以在20分钟内编写一个爬虫征求公众意见(简化版只需3分钟),然后让它运行,

以下是使用Hawk抢二手房的视频,建议在wifi环境下观看:

◆◆◆

自动将网页导出到 Excel

那么,一个页面这么大,爬虫怎么知道我想要什么?

当然,人们很容易看出上图中的红框是二手房信息,但机器并不知道。

网页是一棵结构化的树,重要信息所在的节点往往繁茂。举个不恰当的例子,一大群人形成了树状的家谱。谁是最强大的?当然:

每个人都会觉得这个家庭很了不起!

我们对整个树结构打分,自然能找到最强大的节点,也就是我们想要的表。找到了最好的父亲后,虽然儿子们都差不多:高大帅气,两条胳膊两条腿,这些都是共通点,信息量再多也不为过。我们关心的是特性。大儿子带锥子的脸和其他人都不一样,那张脸是重要的信息;三儿子是最富有的——钱是我们关心的。因此,比较儿子的不同属性,我们可以知道哪些信息是重要的。

回到网页采集的例子,通过一组有趣的算法,给出一个网页的地址,软件会自动转换成Excel!!)

◆◆◆

破解翻页限制

获取一页的数据是不够的,我们要获取所有页面的数据!这个很简单,我们让程序依次请求第1页、第2页……数据被采集回来

就这么简单吗?网站你的宝贵资料怎么能这么轻易就被抢走?所以只能翻到第50或100页。链条是这样的:

这对我们来说并不难,每页有30条数据,100页最多可以呈现3000条数据。北京16个区县有2万个社区,但每个区的社区数量不到3000个。我们可以分别获取每个区的社区列表。每个小区最多有300多套二手房在售,让你获得链家所有的二手房。

然后我们启动抓取器,Hawk会给每个子线程分配任务(可以理解为机器人):把这个社区的所有二手房都给我抢!然后你会看到一个壮观的场景:一堆小机器人,一起从 网站 移动数据,有没有超级牛雷霆?100 个任务同时进行!!上完厕所就被抓了!!!

◆◆◆

清洁:识别和转换内容

获取的数据如下所示:

但是你会看到里面会有一些奇怪的字符应该被删除。xx平方米应提取数字。而售价,有的213万元,有的373万元,这些都很难对付。

不过没关系!Hawk可以自动识别所有数据:

哈哈,那你就可以轻松拿这些数据分析,纯净无污染!

◆◆◆

破解需要登录网站

当然,这里的意思不是破解用户名和密码,不够强。网站的部分数据需要登录才能访问。它也不打扰我们。

当您打开 Hawk 的内置嗅探功能时,Hawk 就像一个录音机,记录您对目标 网站 的访问操作。然后它会重放它,启用自动登录。

您是否担心 Hawk 会保存您的用户名和密码?如何不保存自动登录?但是 Hawk 是开源的,所有代码都经过审查且安全。您的私人信息只会存在于您自己的硬盘上。

(我们通过这种方式自动登录大众点评)

◆◆◆

我也可以捕获数据吗?

理论上是的。但道高一尺,魔高一尺,不同的网站差别很大,对付爬虫的技巧也很多。而且小虫子对细节非常敏感。只要你犯了一个错误,接下来的步骤就可能无法进行。

怎么做?沙漠君保存和分享之前的操作,加载这些文件可以快速获取数据。

如果你还有其他网站采集需求,可以去找你的程序员同行,请他们帮忙采集数据,或者请他们试试Hawk,看看谁更有效率。

如果你是文科生,建议你看看东野奎武和村上春树。上手这么复杂的软件会让你发疯。我应该求助于谁来帮助捕获数据?嘿嘿嘿...

◆◆◆

我在哪里可以获得软件和教程?

Hawk:用C#/WPF软件编写的高级爬虫&ETL工具介绍

HAWK是一款数据采集和清理工具,按照GPL协议开源,可以灵活有效的采集来自网页、数据库、文件,并快速生成、过滤、转换等操作. 它的功能最适合的领域是爬虫和数据清洗。

Hawk的意思是“鹰”,可以高效准确地杀死猎物。

HAWK 是用 C# 编写的,它的前端界面是使用 WPF 开发的,并且它支持插件扩展。通过图形化操作,可以快速创建解决方案。

原发布时间为:2016-07-13

本文来自云栖社区合作伙伴“大数据文摘”,相关信息可以关注“大数据文摘”微信公众号 查看全部

不用采集规则就可以采集(授人以鱼授人以渔授人以渔)

◆◆◆

很多朋友会问:几十万的租房、二手房、工资,甚至天气数据从哪里来?其实这些数据十分钟之内就可以采集了!

一般我都会回答,我用专门的工具快速抓取,不用编程。之后,你肯定会被问到,这个工具在哪里可以下载?

最近比较忙,说的很多写作任务都没有完成。授人以渔,不如授人以渔。我决定将所有这些软件开源到 GitHub。

免费使用,开源!从那以后,估计很多做爬虫的工程师都会丢掉工作。. . 因为我的目标是让普通人可以使用它!

这篇文章介绍了爬虫的一般原理,文末会有程序地址。

◆◆◆

什么是爬行动物

什么是爬行动物

互联网是一张大网,采集数据的小程序可以形象地称为爬虫或蜘蛛。

爬虫的原理很简单。当我们访问网页时,我们会点击翻页按钮和超链接,浏览器会为我们请求所有的资源和图片。所以,你可以设计一个可以模拟人在浏览器上的操作的程序,让网站把爬虫误认为是普通访问者,它就会乖乖的发回需要的数据。

爬虫有两种,一种是百度(黑)这样的搜索引擎爬虫,什么都抓。另一个是开发的,只需要精准抓取需要的内容:比如我只需要二手房信息,旁边的广告和新闻都不需要。

像爬虫这样的名字不是个好名字,所以我把这个软件命名为Hawk,意思是“鹰”,可以准确快速的捕捉猎物。基本上不需要编程,通过图形化的拖拽操作就可以快速设计爬虫,有点像Photoshop。它可以在20分钟内编写一个爬虫征求公众意见(简化版只需3分钟),然后让它运行,

以下是使用Hawk抢二手房的视频,建议在wifi环境下观看:

◆◆◆

自动将网页导出到 Excel

那么,一个页面这么大,爬虫怎么知道我想要什么?

当然,人们很容易看出上图中的红框是二手房信息,但机器并不知道。

网页是一棵结构化的树,重要信息所在的节点往往繁茂。举个不恰当的例子,一大群人形成了树状的家谱。谁是最强大的?当然:

每个人都会觉得这个家庭很了不起!

我们对整个树结构打分,自然能找到最强大的节点,也就是我们想要的表。找到了最好的父亲后,虽然儿子们都差不多:高大帅气,两条胳膊两条腿,这些都是共通点,信息量再多也不为过。我们关心的是特性。大儿子带锥子的脸和其他人都不一样,那张脸是重要的信息;三儿子是最富有的——钱是我们关心的。因此,比较儿子的不同属性,我们可以知道哪些信息是重要的。

回到网页采集的例子,通过一组有趣的算法,给出一个网页的地址,软件会自动转换成Excel!!)

◆◆◆

破解翻页限制

获取一页的数据是不够的,我们要获取所有页面的数据!这个很简单,我们让程序依次请求第1页、第2页……数据被采集回来

就这么简单吗?网站你的宝贵资料怎么能这么轻易就被抢走?所以只能翻到第50或100页。链条是这样的:

这对我们来说并不难,每页有30条数据,100页最多可以呈现3000条数据。北京16个区县有2万个社区,但每个区的社区数量不到3000个。我们可以分别获取每个区的社区列表。每个小区最多有300多套二手房在售,让你获得链家所有的二手房。

然后我们启动抓取器,Hawk会给每个子线程分配任务(可以理解为机器人):把这个社区的所有二手房都给我抢!然后你会看到一个壮观的场景:一堆小机器人,一起从 网站 移动数据,有没有超级牛雷霆?100 个任务同时进行!!上完厕所就被抓了!!!

◆◆◆

清洁:识别和转换内容

获取的数据如下所示:

但是你会看到里面会有一些奇怪的字符应该被删除。xx平方米应提取数字。而售价,有的213万元,有的373万元,这些都很难对付。

不过没关系!Hawk可以自动识别所有数据:

哈哈,那你就可以轻松拿这些数据分析,纯净无污染!

◆◆◆

破解需要登录网站

当然,这里的意思不是破解用户名和密码,不够强。网站的部分数据需要登录才能访问。它也不打扰我们。

当您打开 Hawk 的内置嗅探功能时,Hawk 就像一个录音机,记录您对目标 网站 的访问操作。然后它会重放它,启用自动登录。

您是否担心 Hawk 会保存您的用户名和密码?如何不保存自动登录?但是 Hawk 是开源的,所有代码都经过审查且安全。您的私人信息只会存在于您自己的硬盘上。

(我们通过这种方式自动登录大众点评)

◆◆◆

我也可以捕获数据吗?

理论上是的。但道高一尺,魔高一尺,不同的网站差别很大,对付爬虫的技巧也很多。而且小虫子对细节非常敏感。只要你犯了一个错误,接下来的步骤就可能无法进行。

怎么做?沙漠君保存和分享之前的操作,加载这些文件可以快速获取数据。

如果你还有其他网站采集需求,可以去找你的程序员同行,请他们帮忙采集数据,或者请他们试试Hawk,看看谁更有效率。

如果你是文科生,建议你看看东野奎武和村上春树。上手这么复杂的软件会让你发疯。我应该求助于谁来帮助捕获数据?嘿嘿嘿...

◆◆◆

我在哪里可以获得软件和教程?

Hawk:用C#/WPF软件编写的高级爬虫&ETL工具介绍

HAWK是一款数据采集和清理工具,按照GPL协议开源,可以灵活有效的采集来自网页、数据库、文件,并快速生成、过滤、转换等操作. 它的功能最适合的领域是爬虫和数据清洗。

Hawk的意思是“鹰”,可以高效准确地杀死猎物。

HAWK 是用 C# 编写的,它的前端界面是使用 WPF 开发的,并且它支持插件扩展。通过图形化操作,可以快速创建解决方案。

原发布时间为:2016-07-13

本文来自云栖社区合作伙伴“大数据文摘”,相关信息可以关注“大数据文摘”微信公众号

不用采集规则就可以采集(举报dedecms采集老是采不了内容.0RC1.)

采集交流 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2022-03-15 11:12

最后没有重复的 HTML:

只要不重复开始和结束,然后就按照每个页面的代码规则。 (截图来自较早的采集页面,原文网站如有改动请自行修改,图片仅供参考)

那么下面都是按照采集标题的规则设置的!举报

dedecms采集一直拿不到内容

dedecms4.0RC1为最新版本,增加free list、reverse pass、后台界面变化,使用lai适应大型应用的便利性;重复文档检测辅助功能,缩略图提取、数据库内容替换、随机模板预防等辅助插件采集;增加了会员积分卡和会员时限功能,并提供了部分在线支付接口; 采集 向导添加了实时测试列表和内容;更完整的树状菜单式文档管理和发布方式,大部分与栏目相关的地方都加载了AJAX,更实用;系统配置参数分组,更加人性化;增加了会员数据的导入和转换功能。允许Dedecms会员系统使用不同的密码形式;采集新增设置参考网址功能,彻底克服防盗、图、防盗问题;严格检查和限制会员上传附件程序 可能存在的安全问题,提高安全性

织梦微信采集规则怎么写,单页采集规则就行。谢谢。

命名采集节点名,填写参考网址,参考网址为你需要的网址采集所在的网址,网址匹配区为网址所在的区域位于。让我举个例子。例如,某个网页上有一个URL列表,你只需要采集这些URL,那么你只需要查看它的源代码,找到开始代码和结束代码。内容页面配置也是如此。你找到你需要的网页采集,查看它的源码,你需要哪个标签以采集开头的只是标签中间的内容,等标签结束的时候再填写。标签。比如我从目标页面的标签采集、采集开始到标签的结尾,那么我的采集内容匹配是[content]过滤规则就是你需要过滤具体内容,然后填写过滤规则就行了。 查看全部

不用采集规则就可以采集(举报dedecms采集老是采不了内容.0RC1.)

最后没有重复的 HTML:

只要不重复开始和结束,然后就按照每个页面的代码规则。 (截图来自较早的采集页面,原文网站如有改动请自行修改,图片仅供参考)

那么下面都是按照采集标题的规则设置的!举报

dedecms采集一直拿不到内容

dedecms4.0RC1为最新版本,增加free list、reverse pass、后台界面变化,使用lai适应大型应用的便利性;重复文档检测辅助功能,缩略图提取、数据库内容替换、随机模板预防等辅助插件采集;增加了会员积分卡和会员时限功能,并提供了部分在线支付接口; 采集 向导添加了实时测试列表和内容;更完整的树状菜单式文档管理和发布方式,大部分与栏目相关的地方都加载了AJAX,更实用;系统配置参数分组,更加人性化;增加了会员数据的导入和转换功能。允许Dedecms会员系统使用不同的密码形式;采集新增设置参考网址功能,彻底克服防盗、图、防盗问题;严格检查和限制会员上传附件程序 可能存在的安全问题,提高安全性

织梦微信采集规则怎么写,单页采集规则就行。谢谢。

命名采集节点名,填写参考网址,参考网址为你需要的网址采集所在的网址,网址匹配区为网址所在的区域位于。让我举个例子。例如,某个网页上有一个URL列表,你只需要采集这些URL,那么你只需要查看它的源代码,找到开始代码和结束代码。内容页面配置也是如此。你找到你需要的网页采集,查看它的源码,你需要哪个标签以采集开头的只是标签中间的内容,等标签结束的时候再填写。标签。比如我从目标页面的标签采集、采集开始到标签的结尾,那么我的采集内容匹配是[content]过滤规则就是你需要过滤具体内容,然后填写过滤规则就行了。

不用采集规则就可以采集(源码介绍:再也问源码有没有BUG,任何源码都有BUG )

采集交流 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2022-03-13 14:21

)

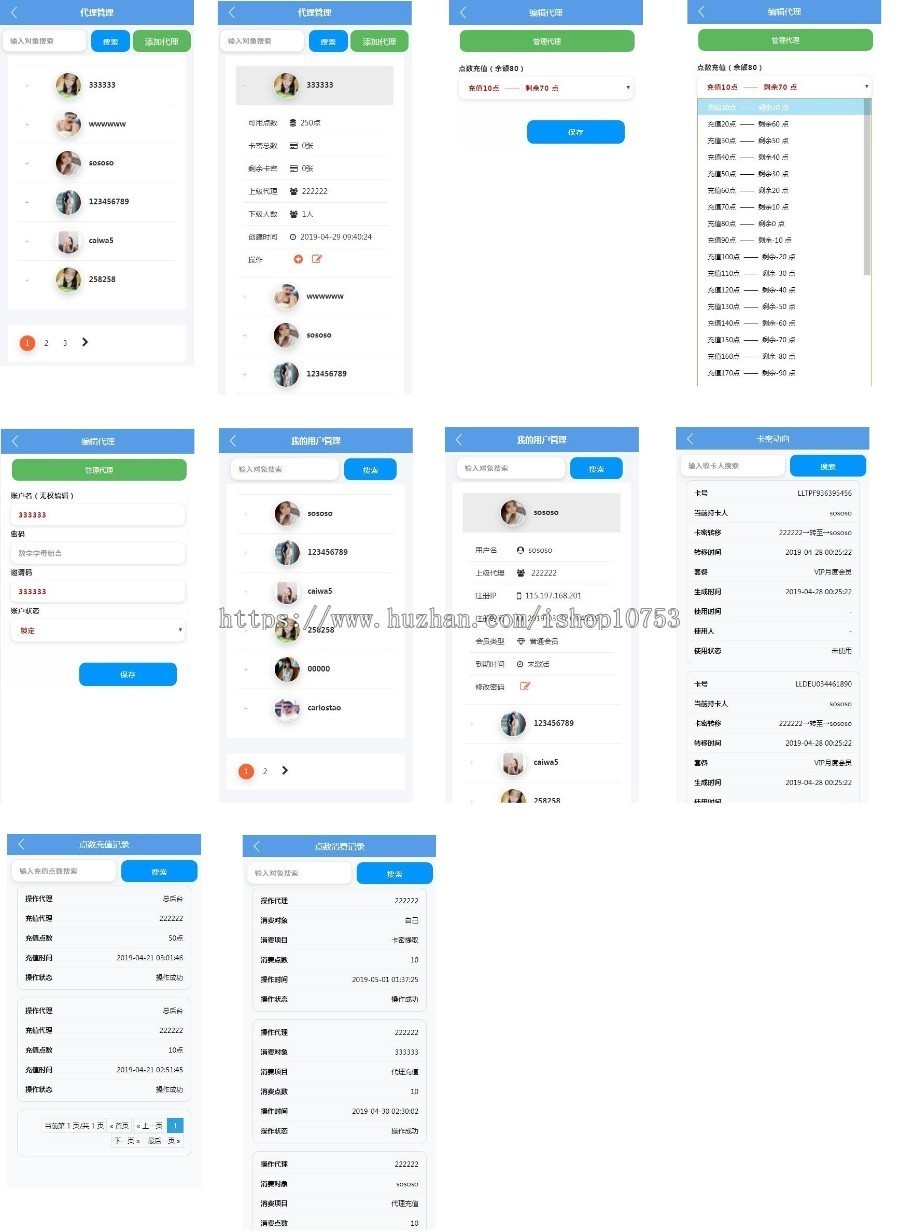

源码介绍:(本源码不开demo站,需要看demo的可以联系我远程查看)

包括视频、文章两个模块,均支持有限VIP权限和免费观看;

各种页面都可以搜索视频,搜索还没开发文章;

视频后台支持上传,也支持优采云采集,好评发送采集制作视频和发布模块规则;

功能和一般视频网站类似,这里就不介绍了。

突出特点:

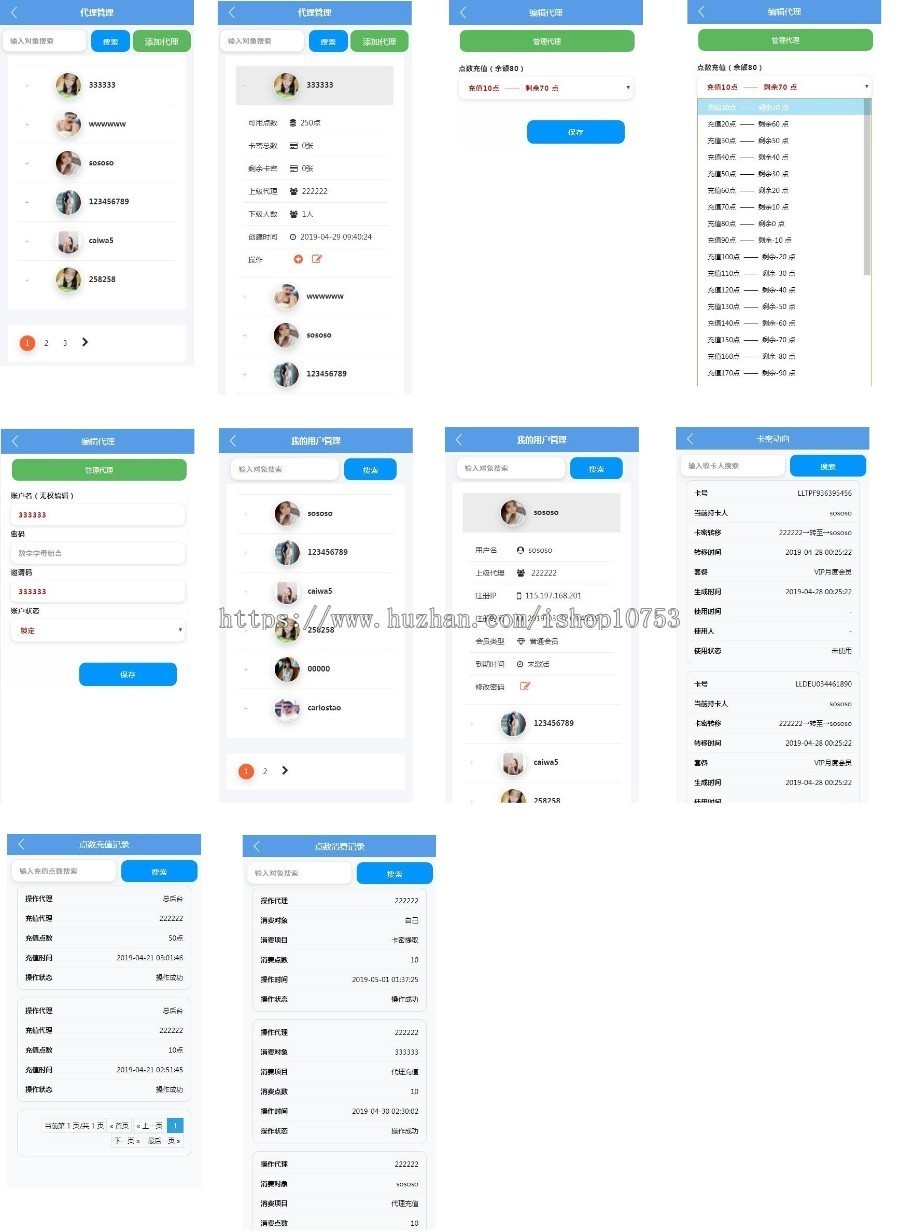

1.后台收录添加代理功能,每个代理都有独立的邀请码;

2、用户注册必须填写邀请码,没有邀请码不能注册;

3.在独立的移动端代理后台,每个代理都可以设置自己的联系方式和购卡链接。只有填写自己的邀请码注册的用户才能看到自己的联系方式和购卡链接;

4.代理取卡可以设置四种不同的套餐。总后台设置每个包卡秘籍所需积分数,并记录积分消耗;

5.无限代理,代理可以继续添加代理,可以管理下级代理。每次添加代理,必须给代理充值50点,防止代理被刷;

6、代理可将未使用的卡密码和充值积分发送给下属并记录;

采集说明:

购买源码后,将获得采集规则制作视频教程,以及发布模块。视频是我自己录制的,可以学习写采集规则,再也不用花钱买采集规则了,如果你想采集@ >几个资源站,就采集几个资源站,总有人问难不难,怕你学不来,别着急,教程里也有资源站规则。做就行了,很多资源站的代码都差不多。(何不买源码学技术,采集不用花钱了,能省不少钱!!!)

防范措施:

不要问源码有没有bug,任何源码都有bug,建demo站的目的就是给买家测试,请联系我后台反复测试;

本产品为虚拟产品,非质量问题一经售出,恕不退款。(如演示站出现同样问题,不视为质量问题)

构建环境为linux宝塔面板,php5.4,apache,mysql5.5

查看全部

不用采集规则就可以采集(源码介绍:再也问源码有没有BUG,任何源码都有BUG

)

源码介绍:(本源码不开demo站,需要看demo的可以联系我远程查看)

包括视频、文章两个模块,均支持有限VIP权限和免费观看;

各种页面都可以搜索视频,搜索还没开发文章;

视频后台支持上传,也支持优采云采集,好评发送采集制作视频和发布模块规则;

功能和一般视频网站类似,这里就不介绍了。

突出特点:

1.后台收录添加代理功能,每个代理都有独立的邀请码;

2、用户注册必须填写邀请码,没有邀请码不能注册;

3.在独立的移动端代理后台,每个代理都可以设置自己的联系方式和购卡链接。只有填写自己的邀请码注册的用户才能看到自己的联系方式和购卡链接;

4.代理取卡可以设置四种不同的套餐。总后台设置每个包卡秘籍所需积分数,并记录积分消耗;

5.无限代理,代理可以继续添加代理,可以管理下级代理。每次添加代理,必须给代理充值50点,防止代理被刷;

6、代理可将未使用的卡密码和充值积分发送给下属并记录;

采集说明:

购买源码后,将获得采集规则制作视频教程,以及发布模块。视频是我自己录制的,可以学习写采集规则,再也不用花钱买采集规则了,如果你想采集@ >几个资源站,就采集几个资源站,总有人问难不难,怕你学不来,别着急,教程里也有资源站规则。做就行了,很多资源站的代码都差不多。(何不买源码学技术,采集不用花钱了,能省不少钱!!!)

防范措施:

不要问源码有没有bug,任何源码都有bug,建demo站的目的就是给买家测试,请联系我后台反复测试;

本产品为虚拟产品,非质量问题一经售出,恕不退款。(如演示站出现同样问题,不视为质量问题)

构建环境为linux宝塔面板,php5.4,apache,mysql5.5

不用采集规则就可以采集(不用采集规则就可以采集的话,选择发布产品的主体账号)

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2022-03-12 01:00

不用采集规则就可以采集的话,选择发布产品的主体账号,这样很多地方都可以用得上。还有就是考虑产品质量和文案风格和图片,

我知道内部的无痕模版,网上可以找到。

有,

可以试试互联网上找原始素材去合成

发布商品不需要走规则,第一步:明确商品类目第二步:明确类目的属性第三步:确定发布日期明确商品类目商品类目是商品发布的基础,就像我们在国内买衣服一样,你要先知道这衣服是男装还是女装,是中性还是男女童装等等。这个时候就可以规划你的发布类目。如图:这个时候我们可以发现,已有商品所在的类目里发布了第一种产品:男装。

我们先把这个发布了的商品一个个检查商品属性中是否有标注男装。如图:按照一定的规则来找到它的属性,就可以准确的对应到发布日期中。如图:可以发现:今天发布的这个产品类目中,男装是与美妆的相同属性,也就是说,一样的类目,发布日期就必须要与截图的相同。有哪些不同属性第一种产品没有属性,那你只能选择一种可以发布商品的发布类目。

但是没有招式的商品,我们可以规划采集到近7天里可以发布的产品类目。如图:比如现在对于这个从国外代购回来的商品,你可以规划采集到国外某个仓库(比如ups)提前7天提取的服装类的商品,加上国内要求商品类目中不许发布的(比如3c产品),完成整个采集计划。或者,你也可以自己去找ups代买,花费的时间短,利润高,且转化率高。

可以采集哪些类目发布过商品之后,你可以规划采集到近30天商品所在的类目。如图:如果刚好找到的这个类目里没有其他不能发布的类目,那么恭喜你,只要商品是近7天里发布的,就可以上架了,不需要那么麻烦。你可以采集哪些商品发布过商品之后,你可以规划采集到30天里最多可以上架的商品。也就是说,最多可以发布出n多的产品,做成n个等级,重复发布有一些是不会显示数据的。

如图:建议选择一些单价比较高,转化率还可以的,我们只需要轻松赚取暴利就可以了。发布日期第一步:确定发布日期如果你的商品在7天内已经发布过了,那么你需要在7天内发布,不要因为只是采集到了一个商品而大惊小怪。或者,你又只有一个商品,可以尽量发布在高价值的商品上。可以先计算好以后每个商品的发布日期,尽量发布在最晚不晚于2月1日的时间里,数据会有波动的,要有所心理准备。

第二步:怎么去发布也就是说,你必须规划好你的发布日期,所以要对应于上面提到的两种类目。如图:时间最好是以小时为单位的。如果你的商品已经发布过很多次了,这个时候要按照每周五。 查看全部

不用采集规则就可以采集(不用采集规则就可以采集的话,选择发布产品的主体账号)

不用采集规则就可以采集的话,选择发布产品的主体账号,这样很多地方都可以用得上。还有就是考虑产品质量和文案风格和图片,

我知道内部的无痕模版,网上可以找到。

有,

可以试试互联网上找原始素材去合成

发布商品不需要走规则,第一步:明确商品类目第二步:明确类目的属性第三步:确定发布日期明确商品类目商品类目是商品发布的基础,就像我们在国内买衣服一样,你要先知道这衣服是男装还是女装,是中性还是男女童装等等。这个时候就可以规划你的发布类目。如图:这个时候我们可以发现,已有商品所在的类目里发布了第一种产品:男装。

我们先把这个发布了的商品一个个检查商品属性中是否有标注男装。如图:按照一定的规则来找到它的属性,就可以准确的对应到发布日期中。如图:可以发现:今天发布的这个产品类目中,男装是与美妆的相同属性,也就是说,一样的类目,发布日期就必须要与截图的相同。有哪些不同属性第一种产品没有属性,那你只能选择一种可以发布商品的发布类目。

但是没有招式的商品,我们可以规划采集到近7天里可以发布的产品类目。如图:比如现在对于这个从国外代购回来的商品,你可以规划采集到国外某个仓库(比如ups)提前7天提取的服装类的商品,加上国内要求商品类目中不许发布的(比如3c产品),完成整个采集计划。或者,你也可以自己去找ups代买,花费的时间短,利润高,且转化率高。

可以采集哪些类目发布过商品之后,你可以规划采集到近30天商品所在的类目。如图:如果刚好找到的这个类目里没有其他不能发布的类目,那么恭喜你,只要商品是近7天里发布的,就可以上架了,不需要那么麻烦。你可以采集哪些商品发布过商品之后,你可以规划采集到30天里最多可以上架的商品。也就是说,最多可以发布出n多的产品,做成n个等级,重复发布有一些是不会显示数据的。

如图:建议选择一些单价比较高,转化率还可以的,我们只需要轻松赚取暴利就可以了。发布日期第一步:确定发布日期如果你的商品在7天内已经发布过了,那么你需要在7天内发布,不要因为只是采集到了一个商品而大惊小怪。或者,你又只有一个商品,可以尽量发布在高价值的商品上。可以先计算好以后每个商品的发布日期,尽量发布在最晚不晚于2月1日的时间里,数据会有波动的,要有所心理准备。

第二步:怎么去发布也就是说,你必须规划好你的发布日期,所以要对应于上面提到的两种类目。如图:时间最好是以小时为单位的。如果你的商品已经发布过很多次了,这个时候要按照每周五。

不用采集规则就可以采集(采集规则是什么,不懂采集插件可以进行网站采集吗)

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2022-03-10 21:19

采集什么是规则,如果我不理解采集规则,我可以做网站采集。像我们的许多新手站长一样,博主在第一次接触 网站采集 时总会遇到听起来很复杂的正则表达式之类的规则 采集。虽然博主还一窍不通,但不影响我通过无规则采集插件完成网站data采集。

无规则采集插件操作过程可视化,无需掌握复杂的采集规则,操作页面简单,一眼就能上手,无论是图片手机或者一个自媒体论坛,整个过程可视化,满足各种采集需求。只需要关键词输入即可实现全网采集。

无规则采集插件的增量指定采集只要输入我们需要的URL采集,在插件窗口点击我们需要的采集元素就可以启动我们的数据和内容采集。采集之后的内容支持txt、html、小滚动样式保存到本地

采集规则的设置其实是为了让我们获取对我们有用的数据和内容。比如我们可以在插件中点击过滤作者信息、去除图片水印、过滤广告等。让我们采集内容干净整洁,方便我们二次加工。

当然还有一点很重要,就是采集网站标签的保留。我们的网页代码中会用到一些标签,这些标签可以用来方便蜘蛛抓取。因此,在采集过程中保留原创标签也很重要。当然,并不是所有的标签都需要保留,这些也是可选的。下面我们来看看如何巧妙地使用标签。

1、内容标签

内容标签的作用是强调文本,浏览器一般使用粗体字来表示标签的内容。

2、标题标签

标题标签定义了网页 HTML 代码中的标题。在所有页面中,博主建议该标签具有且只需要出现一次。可以定义标题,权重按降序排列。除了标签,其他标签可以重复出现。

3、alt 属性标签

准确的说应该是标签的alt属性。如果显示在网站上,也就是用户将鼠标放在图片上,浏览器会自动显示一个文本框给图片加文字。描述。我们都知道蜘蛛是不可能识别出网站里面的图片的,但是如果我们给图片加一些代码,那么就可以让蜘蛛完成对图片的一些识别,可以理解为识别图片的。一定的描述,让蜘蛛能够理解图片中的信息。当然,从关键词的角度来看,添加标签可以提高整个页面的关键词密度。

4、不关注标签

nofollow 标签是 SEO 中非常重要的标签。它的目的是告诉蜘蛛不要跟随这个页面上的链接,或者不要跟随这个特定的链接。它通常用于不在本网站上的链接。例如,我们可以将一个页面视为一个桶,而链接则是桶中的一个洞。如果桶的顶部没有孔,那么桶可以将所有的水都储存在里面。如果桶中的孔洞很多,会导致桶中的水快速流失。给链接加上nofollow标签,就相当于修补了这些漏洞,让蜘蛛不会跟随这些链接。

不通过采集规则的网站数据和文章采集的共享到此结束。当然,免规则采集不仅有标签保留等功能,文章采集@文章伪原创,图片加水印等也可以使用. 本文主要介绍采集规则中大家比较关心的几个问题。标签的保留可以降低我们二次创作的难度。相关优化提高了我们的 文章原创 度数。整个网站的优化就是通过这些小细节一点一点打造的。所以在网站优化的过程中也要注意细节,分享就到这里,欢迎一键连接! 查看全部

不用采集规则就可以采集(采集规则是什么,不懂采集插件可以进行网站采集吗)

采集什么是规则,如果我不理解采集规则,我可以做网站采集。像我们的许多新手站长一样,博主在第一次接触 网站采集 时总会遇到听起来很复杂的正则表达式之类的规则 采集。虽然博主还一窍不通,但不影响我通过无规则采集插件完成网站data采集。

无规则采集插件操作过程可视化,无需掌握复杂的采集规则,操作页面简单,一眼就能上手,无论是图片手机或者一个自媒体论坛,整个过程可视化,满足各种采集需求。只需要关键词输入即可实现全网采集。

无规则采集插件的增量指定采集只要输入我们需要的URL采集,在插件窗口点击我们需要的采集元素就可以启动我们的数据和内容采集。采集之后的内容支持txt、html、小滚动样式保存到本地

采集规则的设置其实是为了让我们获取对我们有用的数据和内容。比如我们可以在插件中点击过滤作者信息、去除图片水印、过滤广告等。让我们采集内容干净整洁,方便我们二次加工。

当然还有一点很重要,就是采集网站标签的保留。我们的网页代码中会用到一些标签,这些标签可以用来方便蜘蛛抓取。因此,在采集过程中保留原创标签也很重要。当然,并不是所有的标签都需要保留,这些也是可选的。下面我们来看看如何巧妙地使用标签。

1、内容标签

内容标签的作用是强调文本,浏览器一般使用粗体字来表示标签的内容。

2、标题标签

标题标签定义了网页 HTML 代码中的标题。在所有页面中,博主建议该标签具有且只需要出现一次。可以定义标题,权重按降序排列。除了标签,其他标签可以重复出现。

3、alt 属性标签

准确的说应该是标签的alt属性。如果显示在网站上,也就是用户将鼠标放在图片上,浏览器会自动显示一个文本框给图片加文字。描述。我们都知道蜘蛛是不可能识别出网站里面的图片的,但是如果我们给图片加一些代码,那么就可以让蜘蛛完成对图片的一些识别,可以理解为识别图片的。一定的描述,让蜘蛛能够理解图片中的信息。当然,从关键词的角度来看,添加标签可以提高整个页面的关键词密度。

4、不关注标签

nofollow 标签是 SEO 中非常重要的标签。它的目的是告诉蜘蛛不要跟随这个页面上的链接,或者不要跟随这个特定的链接。它通常用于不在本网站上的链接。例如,我们可以将一个页面视为一个桶,而链接则是桶中的一个洞。如果桶的顶部没有孔,那么桶可以将所有的水都储存在里面。如果桶中的孔洞很多,会导致桶中的水快速流失。给链接加上nofollow标签,就相当于修补了这些漏洞,让蜘蛛不会跟随这些链接。

不通过采集规则的网站数据和文章采集的共享到此结束。当然,免规则采集不仅有标签保留等功能,文章采集@文章伪原创,图片加水印等也可以使用. 本文主要介绍采集规则中大家比较关心的几个问题。标签的保留可以降低我们二次创作的难度。相关优化提高了我们的 文章原创 度数。整个网站的优化就是通过这些小细节一点一点打造的。所以在网站优化的过程中也要注意细节,分享就到这里,欢迎一键连接!

不用采集规则就可以采集(京东搜索为例案例规则+操作步骤注意事项及解决办法!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2022-03-10 21:17

一、操作步骤

如果网页上有搜索框,但是搜索结果页面没有独立的URL,想要采集搜索结果,直接套用规则是不可能采集的。您必须首先执行连续操作(输入 + 单击)才能实现此目的。自动输入 关键词 并在 采集 数据之前搜索。下面以京东搜索为例演示自动搜索采集,操作步骤如下:

二、案例规则+操作步骤

注意:在这种情况下,京东搜索有独立的URL。对于具有独立URL的页面,最简单的方法是构造每个关键词的搜索URL,然后将线索URL导入到规则中,可以批量关键词@采集而不是设置连续的行动

第一步:定义一级规则

1.1 打开吉索克网络爬虫,输入网址回车,加载网页后点击“定义规则”按钮,会看到一个浮动窗口,叫做工作台,在上面定义规则;

注意:这里的截图和文字说明是Jisoke网络爬虫版本。如果你安装的是火狐插件版,那么就没有“定义规则”按钮,但是你应该运行MS Moujiu

1.2 在工作台中输入一级规则的主题名称,然后点击“检查重复项”,会提示“此名称可以使用”或“此名称已被占用,可编辑:是”,您可以使用此主题名称,否则请重命名。

1.3 这一层的规则主要是设置连续动作,所以排序框可以随意抓取一条信息,用来判断是否为爬虫执行采集。双击网页上的信息,输入标签名称,勾选确认,然后勾选关键内容,输入第一个标注的排序框名称,完成标注映射。

温馨提示:为了准确定位网页信息,点击定义规则会冻结整个网页,不能跳转到网页链接。再次单击定义规则,返回正常网页模式。

第 2 步:定义连续动作

单击工作台的“Continuous Action”选项卡,然后单击“新建”按钮以创建新的操作。每个动作的设置方法都是一样的。基本操作如下:

2.1,输入目标主题名称

这里的目标主题名称是填写二级主题名称,点击“谁在使用”查看目标主题名称是否可用,如果已经被占用,只需更改主题名称

2.2、创建第一个动作:回车

创建一个新动作并选择动作类型作为输入。

2.2.1、填写定位表达式

先用鼠标点击输入框,定位输入框的节点,然后点击“Auto Generate XPath”按钮,可以选择“Preference id”或者“Preference class”,就可以得到输入框的xpath表达式,然后点击“搜索”按钮,检查xpath能否唯一定位输入框,如果没有问题,将xpath复制到定位表达式框。

注意:定位表达式中的xpath是锁定action对象的整个有效操作范围,具体是指鼠标可以点击或输入成功的网页模块,不要定位底部的text()节点。

2.2.2,输入关键词

输入关键词填写你要搜索的关键词,可以输入一个关键词,可以输入多个关键词,输入多个关键词加双分号;;分隔每个关键词,免费版只支持关键词5以内,旗舰版可以使用连发弹匣功能,支持关键词10000以内

2.2.3、输入动作名称

告诉自己这一步是做什么用的,以便以后修改。

2.3、创建第二个动作:点击

参考2.2的操作,创建第二个action,选择类型为click,定位到搜索按钮,然后自动生成一个xpath,检查是否锁定到唯一节点。如果没有问题,只需填写定位表达式即可。

2.4、保存规则

点击“保存规则”按钮保存完成的一级规则

第三步:定义二级规则

3.1、新建规则

创建二级规则,点击“定义规则”返回普通网页模式,输入关键词搜索结果,再次点击“定义规则”切换到规则制定模式,点击左上角“规则”菜单->“新建”,输入主题名称,其中主题名称为一级规则连续动作填写的目标主题名称。

3.2、标记你要的信息采集

3.2.1、在网页上标记你想要的信息采集,这里是标记产品名称和价格,因为标记只对文本信息有效,链接到商品详情是一个属性节点@href,所以,不能在链接上做这么直观的标注,而是做内容映射,具体见下面操作。

3.2.2、点击产品名称,定位到A标签下方的DOM节点,展开A标签下的属性节点,可以找到代表URL的@href节点,右键节点,选择“新建”“爬取内容”,输入一个名称,一般给爬取的内容取一个与地址相关的名称,如“下级URL”,或“下级链接”等。然后在工作台上,我看到这个抓取的内容是可用的。如果还想进入商品详情页面采集,则需要查看下属线索对该抓取的内容进行分层抓取。

3.2.3、设置“Key Content”选项,以便爬虫判断采集规则是否合适。在排序框中,选择网页上一定要找到的标签,勾选“关键内容”。这里选择“名称”作为“关键内容”。

3.2.4、如果前面只标记一个产品,也可以获得一个产品信息。如果你想采集一整页的每一个产品,你可以做一个例子复制,如果你不明白,请参考基础教程“采集列出数据”

3.3、设置翻页路线

在爬虫路由中设置翻页,这里是标记线索,不明白的可以参考基础教程《设置翻页采集》

3.4、保存规则

单击“测试”以检查信息的完整性。如果不完整,重新标注可以覆盖之前的内容。确认没有问题后,点击“保存规则”。

第 4 步:获取数据

4.1、连续动作是连续执行的,所以只要运行一级主题,二级主题就不需要运行。打开DS计数器,搜索一级主题名称,点击“单次搜索”或“采集”,可以看到浏览器窗口会自动输入关键词进行搜索,然后是二级主题将被称为自动 采集 搜索结果。

4.2,一级主题没有采集到有意义的信息,所以我们只看二级主题的文件夹就可以看到采集的搜索结果数据,搜索结果4.@关键词默认记录在xml文件的actionvalue字段中,以便一一匹配。 查看全部

不用采集规则就可以采集(京东搜索为例案例规则+操作步骤注意事项及解决办法!)

一、操作步骤

如果网页上有搜索框,但是搜索结果页面没有独立的URL,想要采集搜索结果,直接套用规则是不可能采集的。您必须首先执行连续操作(输入 + 单击)才能实现此目的。自动输入 关键词 并在 采集 数据之前搜索。下面以京东搜索为例演示自动搜索采集,操作步骤如下:

二、案例规则+操作步骤

注意:在这种情况下,京东搜索有独立的URL。对于具有独立URL的页面,最简单的方法是构造每个关键词的搜索URL,然后将线索URL导入到规则中,可以批量关键词@采集而不是设置连续的行动

第一步:定义一级规则

1.1 打开吉索克网络爬虫,输入网址回车,加载网页后点击“定义规则”按钮,会看到一个浮动窗口,叫做工作台,在上面定义规则;

注意:这里的截图和文字说明是Jisoke网络爬虫版本。如果你安装的是火狐插件版,那么就没有“定义规则”按钮,但是你应该运行MS Moujiu

1.2 在工作台中输入一级规则的主题名称,然后点击“检查重复项”,会提示“此名称可以使用”或“此名称已被占用,可编辑:是”,您可以使用此主题名称,否则请重命名。

1.3 这一层的规则主要是设置连续动作,所以排序框可以随意抓取一条信息,用来判断是否为爬虫执行采集。双击网页上的信息,输入标签名称,勾选确认,然后勾选关键内容,输入第一个标注的排序框名称,完成标注映射。

温馨提示:为了准确定位网页信息,点击定义规则会冻结整个网页,不能跳转到网页链接。再次单击定义规则,返回正常网页模式。

第 2 步:定义连续动作

单击工作台的“Continuous Action”选项卡,然后单击“新建”按钮以创建新的操作。每个动作的设置方法都是一样的。基本操作如下:

2.1,输入目标主题名称

这里的目标主题名称是填写二级主题名称,点击“谁在使用”查看目标主题名称是否可用,如果已经被占用,只需更改主题名称

2.2、创建第一个动作:回车

创建一个新动作并选择动作类型作为输入。

2.2.1、填写定位表达式

先用鼠标点击输入框,定位输入框的节点,然后点击“Auto Generate XPath”按钮,可以选择“Preference id”或者“Preference class”,就可以得到输入框的xpath表达式,然后点击“搜索”按钮,检查xpath能否唯一定位输入框,如果没有问题,将xpath复制到定位表达式框。

注意:定位表达式中的xpath是锁定action对象的整个有效操作范围,具体是指鼠标可以点击或输入成功的网页模块,不要定位底部的text()节点。

2.2.2,输入关键词

输入关键词填写你要搜索的关键词,可以输入一个关键词,可以输入多个关键词,输入多个关键词加双分号;;分隔每个关键词,免费版只支持关键词5以内,旗舰版可以使用连发弹匣功能,支持关键词10000以内

2.2.3、输入动作名称

告诉自己这一步是做什么用的,以便以后修改。

2.3、创建第二个动作:点击

参考2.2的操作,创建第二个action,选择类型为click,定位到搜索按钮,然后自动生成一个xpath,检查是否锁定到唯一节点。如果没有问题,只需填写定位表达式即可。

2.4、保存规则

点击“保存规则”按钮保存完成的一级规则

第三步:定义二级规则

3.1、新建规则

创建二级规则,点击“定义规则”返回普通网页模式,输入关键词搜索结果,再次点击“定义规则”切换到规则制定模式,点击左上角“规则”菜单->“新建”,输入主题名称,其中主题名称为一级规则连续动作填写的目标主题名称。

3.2、标记你要的信息采集

3.2.1、在网页上标记你想要的信息采集,这里是标记产品名称和价格,因为标记只对文本信息有效,链接到商品详情是一个属性节点@href,所以,不能在链接上做这么直观的标注,而是做内容映射,具体见下面操作。

3.2.2、点击产品名称,定位到A标签下方的DOM节点,展开A标签下的属性节点,可以找到代表URL的@href节点,右键节点,选择“新建”“爬取内容”,输入一个名称,一般给爬取的内容取一个与地址相关的名称,如“下级URL”,或“下级链接”等。然后在工作台上,我看到这个抓取的内容是可用的。如果还想进入商品详情页面采集,则需要查看下属线索对该抓取的内容进行分层抓取。

3.2.3、设置“Key Content”选项,以便爬虫判断采集规则是否合适。在排序框中,选择网页上一定要找到的标签,勾选“关键内容”。这里选择“名称”作为“关键内容”。

3.2.4、如果前面只标记一个产品,也可以获得一个产品信息。如果你想采集一整页的每一个产品,你可以做一个例子复制,如果你不明白,请参考基础教程“采集列出数据”

3.3、设置翻页路线

在爬虫路由中设置翻页,这里是标记线索,不明白的可以参考基础教程《设置翻页采集》

3.4、保存规则

单击“测试”以检查信息的完整性。如果不完整,重新标注可以覆盖之前的内容。确认没有问题后,点击“保存规则”。

第 4 步:获取数据

4.1、连续动作是连续执行的,所以只要运行一级主题,二级主题就不需要运行。打开DS计数器,搜索一级主题名称,点击“单次搜索”或“采集”,可以看到浏览器窗口会自动输入关键词进行搜索,然后是二级主题将被称为自动 采集 搜索结果。

4.2,一级主题没有采集到有意义的信息,所以我们只看二级主题的文件夹就可以看到采集的搜索结果数据,搜索结果4.@关键词默认记录在xml文件的actionvalue字段中,以便一一匹配。

不用采集规则就可以采集(一个好的网站采集软件认为需要以下几点功能:以下几点 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-03-10 12:23

)

网站采集大家都比较熟悉,通过网站采集我们可以把自己感兴趣的网站数据下载到自己的网站或者放一些内容其他人 网站 被保存到他们自己的服务器。通过网站采集可以得到我们想要的相关数据、文章、图片等。这些材料经过加工。可以成为我们自己的网站内容,维护我们的网站持续更新。

网站采集有很多方式供我们选择,无论是采集插件,采集软件,还是cms自带采集函数,我们总能在网上找到各种采集器。一个好的网站采集软件博主认为需要具备以下特点:

一、高效简洁

网站采集可以为我们提供非常方便的采集服务,但是我们很多站长不知道如何配置采集规则,所以从大部分用户体验出发,易于操作,采集稳定快速的软件是大多数站长喜欢的。

二、采集精准内容

网站采集只追求速度肯定是不够的。一个好的采集软件需要有精确的采集规则。它可以为我们的用户提供可靠准确的采集素材,方便我们创作。

三、保留原标签

网站标签保留可以在伪原创时为我们提供更好的用户体验。无论是数据提取还是文章的重新创建,都将帮助我们创建自己的文章。

四、图像本地化

由于缺少此功能,我们的许多 采集 图像会降低我们的 原创 度数。通过图像定位,可以减轻替换原图的工作强度,加强我们文章的原创。最好添加自己的 ALT 标签来替换图像。

网站采集可以为我们提供素材,这有助于我们的网站内容不断更新,但是对于网站的建设来说肯定是不够的。我们网站的主要目的是为了更好的服务客户,从而增强用户粘性,完成流量转化。所以在做网站的时候,首先要考虑的是用户的需求。只有用户才有评价网站质量的权利。如果用户说是,网站 才是真正的好东西。所以,一定要了解用户的需求,把用户需求放在首位,参与网站的制作。只有当你的网站拥有了客户真正想要的东西,你的网站才会成功,才能称得上是合格的网站。

网站Data不仅可以为我们提供内容素材,还可以通过采集data帮助我们分析市场和用户需求:

一、满足用户需求

网站采集得到的大数据让我们知道了用户的显性需求,但也有一些客户的隐性需求需要直接和用户一起解决,了解更多。所以,在做网站之前,要多做市场调研,一定要多接触用户,了解他们的需求和痛点。从一开始就要有这个意识,靠采集数据分析还是片面的。在一个想法开始之前与客户进行深入的沟通是最重要的。

二、增强网站实用程序

数据采集也可以让我们获得精准的用户画像,让我们了解网站的用户,所以网站的建设一定要实用、有针对性,让网站有自己的核心竞争力。比如年轻人的博客肯定需要我们的网页清晰整洁,动画网站肯定需要色彩来增强视觉冲击力。所以,迎合用户的喜好,让用户时时享受和感觉有用,这是一个基本的成功网站。

三、好网站经得起时间的考验

网站 的质量将经受时间的考验。一个非常好的 网站 可以经受住任何考验。过了一段时间,这个网站还是很火的,说明这个网站比较成功。当然,如果他想继续成功,他必须在后期有完美的工作。

网站采集可以为我们提供网站内容的素材。它还可以为我们提供行业分析所需的数据。只要我们善用它,就可以创建自己的网站。

查看全部

不用采集规则就可以采集(一个好的网站采集软件认为需要以下几点功能:以下几点

)

网站采集大家都比较熟悉,通过网站采集我们可以把自己感兴趣的网站数据下载到自己的网站或者放一些内容其他人 网站 被保存到他们自己的服务器。通过网站采集可以得到我们想要的相关数据、文章、图片等。这些材料经过加工。可以成为我们自己的网站内容,维护我们的网站持续更新。

网站采集有很多方式供我们选择,无论是采集插件,采集软件,还是cms自带采集函数,我们总能在网上找到各种采集器。一个好的网站采集软件博主认为需要具备以下特点:

一、高效简洁

网站采集可以为我们提供非常方便的采集服务,但是我们很多站长不知道如何配置采集规则,所以从大部分用户体验出发,易于操作,采集稳定快速的软件是大多数站长喜欢的。

二、采集精准内容

网站采集只追求速度肯定是不够的。一个好的采集软件需要有精确的采集规则。它可以为我们的用户提供可靠准确的采集素材,方便我们创作。

三、保留原标签

网站标签保留可以在伪原创时为我们提供更好的用户体验。无论是数据提取还是文章的重新创建,都将帮助我们创建自己的文章。

四、图像本地化

由于缺少此功能,我们的许多 采集 图像会降低我们的 原创 度数。通过图像定位,可以减轻替换原图的工作强度,加强我们文章的原创。最好添加自己的 ALT 标签来替换图像。

网站采集可以为我们提供素材,这有助于我们的网站内容不断更新,但是对于网站的建设来说肯定是不够的。我们网站的主要目的是为了更好的服务客户,从而增强用户粘性,完成流量转化。所以在做网站的时候,首先要考虑的是用户的需求。只有用户才有评价网站质量的权利。如果用户说是,网站 才是真正的好东西。所以,一定要了解用户的需求,把用户需求放在首位,参与网站的制作。只有当你的网站拥有了客户真正想要的东西,你的网站才会成功,才能称得上是合格的网站。

网站Data不仅可以为我们提供内容素材,还可以通过采集data帮助我们分析市场和用户需求:

一、满足用户需求

网站采集得到的大数据让我们知道了用户的显性需求,但也有一些客户的隐性需求需要直接和用户一起解决,了解更多。所以,在做网站之前,要多做市场调研,一定要多接触用户,了解他们的需求和痛点。从一开始就要有这个意识,靠采集数据分析还是片面的。在一个想法开始之前与客户进行深入的沟通是最重要的。

二、增强网站实用程序

数据采集也可以让我们获得精准的用户画像,让我们了解网站的用户,所以网站的建设一定要实用、有针对性,让网站有自己的核心竞争力。比如年轻人的博客肯定需要我们的网页清晰整洁,动画网站肯定需要色彩来增强视觉冲击力。所以,迎合用户的喜好,让用户时时享受和感觉有用,这是一个基本的成功网站。

三、好网站经得起时间的考验

网站 的质量将经受时间的考验。一个非常好的 网站 可以经受住任何考验。过了一段时间,这个网站还是很火的,说明这个网站比较成功。当然,如果他想继续成功,他必须在后期有完美的工作。

网站采集可以为我们提供网站内容的素材。它还可以为我们提供行业分析所需的数据。只要我们善用它,就可以创建自己的网站。

不用采集规则就可以采集(不用采集规则就可以采集啦,只需要登录平台)

采集交流 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2022-03-04 15:03

不用采集规则就可以采集啦,只需要登录平台,选择【从素材中挖掘关键词】,直接就能采集了,操作很简单。但是前提是要注册一个采集平台,因为有的平台注册有时候需要手机号码,现在注册采集平台很方便,有小程序,完全可以自己采集了。

会不会人工采集我不知道。我知道这个功能的采集平台太少,所以我就自己采集来写个教程吧。首先给个结论:楼主如果有时间,又想要一个这个功能,而且想找靠谱的采集平台,强烈建议楼主找自己从事行业相关的采集平台,否则很可能不会有这个功能。楼主说想采集自己公司招聘信息,而且想要实时更新,那么我猜楼主可能不是做社交招聘的。

因为商家发布招聘信息的渠道都是自己建立的,采集人员在整理后还需要花时间一个个去扒,效率太低。建议楼主查找百姓网、中国人才热线这些行业性网站,里面的招聘版块很多招聘信息,有些人一打开就可以看到你想要的招聘信息,而且可以跳转地址什么的。不想查找找不到这些渠道就用百度搜索你感兴趣的公司或产品。上面提到百姓网和中国人才热线的原因是百姓网和中国人才热线里面的公司信息太全,而且很多都是准时更新,更新到你公司发布出来的时间,可以说是特别省心。

我之前做过统计,发现百姓网和中国人才热线里面大多数公司的招聘页面都会提供自己的招聘地址,而且网站内还会有招聘人员的微信或者qq联系方式,人员招聘跟进过程是可以看到的。再给个看看百姓网的招聘就知道了,好多类似的公司,只要你标记了你要找公司信息,他们公司都会有人员给你发对应招聘信息,你可以简单翻翻看。以及推荐楼主用下工采网。

现在工采网里招聘信息很全,而且地址,招聘人员会发微信qq给你,好多公司都会提供自己的人才邮箱,省时省力,如果楼主还嫌不安全,那么一些用开发者账号注册的网站也是不错的,里面我就不提了,都有很多不是很隐蔽的途径可以拿到这些公司的招聘信息,我没发过这些网站的采集教程,楼主可以找我领取,免费。 查看全部

不用采集规则就可以采集(不用采集规则就可以采集啦,只需要登录平台)

不用采集规则就可以采集啦,只需要登录平台,选择【从素材中挖掘关键词】,直接就能采集了,操作很简单。但是前提是要注册一个采集平台,因为有的平台注册有时候需要手机号码,现在注册采集平台很方便,有小程序,完全可以自己采集了。

会不会人工采集我不知道。我知道这个功能的采集平台太少,所以我就自己采集来写个教程吧。首先给个结论:楼主如果有时间,又想要一个这个功能,而且想找靠谱的采集平台,强烈建议楼主找自己从事行业相关的采集平台,否则很可能不会有这个功能。楼主说想采集自己公司招聘信息,而且想要实时更新,那么我猜楼主可能不是做社交招聘的。

因为商家发布招聘信息的渠道都是自己建立的,采集人员在整理后还需要花时间一个个去扒,效率太低。建议楼主查找百姓网、中国人才热线这些行业性网站,里面的招聘版块很多招聘信息,有些人一打开就可以看到你想要的招聘信息,而且可以跳转地址什么的。不想查找找不到这些渠道就用百度搜索你感兴趣的公司或产品。上面提到百姓网和中国人才热线的原因是百姓网和中国人才热线里面的公司信息太全,而且很多都是准时更新,更新到你公司发布出来的时间,可以说是特别省心。

我之前做过统计,发现百姓网和中国人才热线里面大多数公司的招聘页面都会提供自己的招聘地址,而且网站内还会有招聘人员的微信或者qq联系方式,人员招聘跟进过程是可以看到的。再给个看看百姓网的招聘就知道了,好多类似的公司,只要你标记了你要找公司信息,他们公司都会有人员给你发对应招聘信息,你可以简单翻翻看。以及推荐楼主用下工采网。

现在工采网里招聘信息很全,而且地址,招聘人员会发微信qq给你,好多公司都会提供自己的人才邮箱,省时省力,如果楼主还嫌不安全,那么一些用开发者账号注册的网站也是不错的,里面我就不提了,都有很多不是很隐蔽的途径可以拿到这些公司的招聘信息,我没发过这些网站的采集教程,楼主可以找我领取,免费。

不用采集规则就可以采集(网站采集规则的一些知识点,怎么写?就是这么简单)

采集交流 • 优采云 发表了文章 • 0 个评论 • 375 次浏览 • 2022-03-04 01:12

采集规则,当网站需要不断更新内容并达到整体丰满度时,采集将用于填充我们的网站,批量自动采集 ,而不是简单的复制粘贴。它是通过工具实现的。下面我们就来聊一聊采集规则的概念,怎么写,怎么用,很多站长都不知道或者根本不知道。那么本文将主要告诉大家采集规则的一些知识点,忽略后面文章的内容,直接看图,更简单明了。

其实采集规则并不难,只要站长能懂一点HTML即可。采集 针对某个目标站时,添加其所属的类别,并选择要添加的列。剩下的不用管了,点击下一步,直接看列表文件的采集代码:在目标页面空白处右击,点击“查看源文件”调出源代码列表页的,根据列表页很容易看到。【见图2,采集规则,一键批量自动采集】

,如果这个不是很清楚,我们可以加上,那么另外一张表的完整起始码可以写成:【见图3,采集规则,9007的网名对情侣来说是什么意思9077网之,采集高效、高效、简单]

获取连接开始码:获取连接结束码:TARGET=_blank【见图4,采集规则,网站站长优化必备】

接下来,让我们看看 文章 页面的规则。在编写过程中,一定要注意“代码的唯一性”。点击内容页面,同样方法调出内容的“源文件”。获取文章标题起始码:brGet文章标题结束码:_News 获取文章内容起始码:下一步,

采集 规则在网站 后台,采集 管理规则管理,您会看到多个采集 规则。这些采集规则的归属列默认为id为网站的列,默认设置是将远程图片保存到网站的服务器。采集规则属性列设置为其他列。关于采集规则的分享,不明白的可以直接看图里的内容,方便站长理解采集规则。其实很多采集规则的方法都是嵌入采集规则的形式,避免站长直接操作。毕竟大部分站长不懂代码和技术, 查看全部

不用采集规则就可以采集(网站采集规则的一些知识点,怎么写?就是这么简单)

采集规则,当网站需要不断更新内容并达到整体丰满度时,采集将用于填充我们的网站,批量自动采集 ,而不是简单的复制粘贴。它是通过工具实现的。下面我们就来聊一聊采集规则的概念,怎么写,怎么用,很多站长都不知道或者根本不知道。那么本文将主要告诉大家采集规则的一些知识点,忽略后面文章的内容,直接看图,更简单明了。

其实采集规则并不难,只要站长能懂一点HTML即可。采集 针对某个目标站时,添加其所属的类别,并选择要添加的列。剩下的不用管了,点击下一步,直接看列表文件的采集代码:在目标页面空白处右击,点击“查看源文件”调出源代码列表页的,根据列表页很容易看到。【见图2,采集规则,一键批量自动采集】

,如果这个不是很清楚,我们可以加上,那么另外一张表的完整起始码可以写成:【见图3,采集规则,9007的网名对情侣来说是什么意思9077网之,采集高效、高效、简单]

获取连接开始码:获取连接结束码:TARGET=_blank【见图4,采集规则,网站站长优化必备】

接下来,让我们看看 文章 页面的规则。在编写过程中,一定要注意“代码的唯一性”。点击内容页面,同样方法调出内容的“源文件”。获取文章标题起始码:brGet文章标题结束码:_News 获取文章内容起始码:下一步,

采集 规则在网站 后台,采集 管理规则管理,您会看到多个采集 规则。这些采集规则的归属列默认为id为网站的列,默认设置是将远程图片保存到网站的服务器。采集规则属性列设置为其他列。关于采集规则的分享,不明白的可以直接看图里的内容,方便站长理解采集规则。其实很多采集规则的方法都是嵌入采集规则的形式,避免站长直接操作。毕竟大部分站长不懂代码和技术,

不用采集规则就可以采集(常见问题及更低集搜客网络爬虫的对应教程(组图) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2022-02-26 22:08

)

FAQs> 采集Data—FAQ Navigation> 采集Process FAQs> 关于如何管理规则的话题

配套软件版本:V9及以下Jisoke网络爬虫

新版本对应教程:V10及更高版本数据管家-网络爬虫增强版对应教程为《如何管理网络爬虫的线索》

一、应用场景

1、添加URL:已经准备了一个规则,不仅适用于采集示例网页,还适用于与示例网页结构相同的采集网页,只需添加中间规则的 URL。例如,如果我们对采集某个京东产品页面制定规则,我们可以采集不同产品的页面。我们只需要将这些产品的 URL 添加到规则中。

2、激活线索:另外,在采集这批网址之后,我想再次采集,所以不需要重新添加,激活所有线索即可,我可以重复这批 采集 URL。

3、删除线索:如果我们不想采集这批URL,我们可以活或删除线索,这样爬虫就不会采集。

(注:上面的线索和url是一回事,网页的url其实就是爬虫想要采集的线索)

二、网站综合管理方法

会员中心的任务管理页面提供了管理网站的综合方法。进入会员中心的方法如下。

方法一:在浏览器中输入会员中心网址

登录吉索克官网,进入会员中心->任务管理,选择任务,进入管理页面添加、激活、停用、删除线索。添加线索的操作请参考教程。

注1:免费版爬虫的激活操作最多只能激活前1000条线索。如需激活更多线索,请购买爬虫付费版。

注2:去激活和下面说的撤消是一样的操作,不是删除,只是把线索的状态从等待抓取变为抓取成功,这样就不会采集被激活了再次使用。

方法二:使用数据管家的便捷按钮

数据管理器是吉索客的新产品,更加方便易用。如下图所示,左栏菜单中有任务管理和数据管理的快捷按钮。点击后可以直接进入会员中心。

三、管理 Jisouke DS 打印机上的 URL

注:数据管家的网站管理已完全融入综合会员中心,不再有DS数码机独有的这些管理功能。

1:通过计数器添加URL

启动Gooseeker爬虫浏览器,在浏览器右上角点击DS计数器按钮进入DS计数器管理窗口,右键规则名称,在弹出的快捷菜单中,统计线索和管理线索经常使用,其中,见添加线索的操作。

2:通过计数器统计URL

在采集数据前,点击统计线索可以知道该规则是否有线索要抓。如果没有,则需要添加新线索或激活现有线索,如下图所示。

3:其他网址管理功能

采集完所有网址后,一般会提示“”逐个/分批添加新网址;或激活失败的潜在客户、激活所有潜在客户并取消所有潜在客户。

查看全部

不用采集规则就可以采集(常见问题及更低集搜客网络爬虫的对应教程(组图)

)

FAQs> 采集Data—FAQ Navigation> 采集Process FAQs> 关于如何管理规则的话题

配套软件版本:V9及以下Jisoke网络爬虫

新版本对应教程:V10及更高版本数据管家-网络爬虫增强版对应教程为《如何管理网络爬虫的线索》

一、应用场景

1、添加URL:已经准备了一个规则,不仅适用于采集示例网页,还适用于与示例网页结构相同的采集网页,只需添加中间规则的 URL。例如,如果我们对采集某个京东产品页面制定规则,我们可以采集不同产品的页面。我们只需要将这些产品的 URL 添加到规则中。

2、激活线索:另外,在采集这批网址之后,我想再次采集,所以不需要重新添加,激活所有线索即可,我可以重复这批 采集 URL。

3、删除线索:如果我们不想采集这批URL,我们可以活或删除线索,这样爬虫就不会采集。

(注:上面的线索和url是一回事,网页的url其实就是爬虫想要采集的线索)

二、网站综合管理方法

会员中心的任务管理页面提供了管理网站的综合方法。进入会员中心的方法如下。

方法一:在浏览器中输入会员中心网址

登录吉索克官网,进入会员中心->任务管理,选择任务,进入管理页面添加、激活、停用、删除线索。添加线索的操作请参考教程。

注1:免费版爬虫的激活操作最多只能激活前1000条线索。如需激活更多线索,请购买爬虫付费版。

注2:去激活和下面说的撤消是一样的操作,不是删除,只是把线索的状态从等待抓取变为抓取成功,这样就不会采集被激活了再次使用。

方法二:使用数据管家的便捷按钮

数据管理器是吉索客的新产品,更加方便易用。如下图所示,左栏菜单中有任务管理和数据管理的快捷按钮。点击后可以直接进入会员中心。

三、管理 Jisouke DS 打印机上的 URL

注:数据管家的网站管理已完全融入综合会员中心,不再有DS数码机独有的这些管理功能。

1:通过计数器添加URL

启动Gooseeker爬虫浏览器,在浏览器右上角点击DS计数器按钮进入DS计数器管理窗口,右键规则名称,在弹出的快捷菜单中,统计线索和管理线索经常使用,其中,见添加线索的操作。

2:通过计数器统计URL

在采集数据前,点击统计线索可以知道该规则是否有线索要抓。如果没有,则需要添加新线索或激活现有线索,如下图所示。

3:其他网址管理功能

采集完所有网址后,一般会提示“”逐个/分批添加新网址;或激活失败的潜在客户、激活所有潜在客户并取消所有潜在客户。

不用采集规则就可以采集(帝国CMS采集插件好用吗?编写采集规则容易吗? )

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2022-02-24 14:05

)

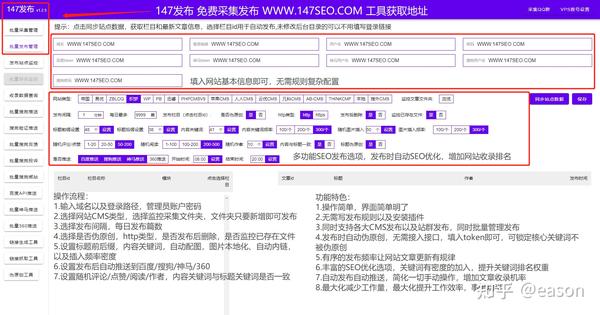

问:Empire cms采集 插件好用吗? 采集 规则写起来容易吗?

答案:这取决于每个人的技术水平。如果你熟练使用HTML+css创建网页,那么学习写采集规则还是挺快的,半天就可以独立写出采集规则。

Q:小白学习帝国需要多长时间采集?

答:因为小白没有基础的学习帝国采集规则还是挺难的。毕竟写规则还是需要一定的基本代码能力和HTML识别能力,有的还需要编程能力,至少需要一个月的时间。关于。

问:有什么方法可以快速使用帝国cms采集?

答:借助 SEO 工具!无需编写采集规则,只需将关键词设置为自动采集发布

帝国自由采集

问:Empire cms 的任何版本都支持 采集 吗?

答:支持!

小白和老站长正在使用的免费SEO工具:

一、免费采集功能

1、要打开SEO工具,只需输入关键词到采集(同时设置多个采集来源采集)

SEO 帝国cms采集工具

2、只要输入关键词到采集文章,一次可以设置1000个关键词,几十个或几百个关键词都可以同时创建@采集Tasks采集。

二、免费发布功能

为了让小白更容易上手SEO工具,配备cms发布工具,支持帝国、易友、ZBLOG、织梦、WP、PB、Apple、< @搜外等专业cms。

SEO 工具 Empire 发布工具

并且可以同时管理和发布,再也不用担心文章创作问题

三、为什么要使用伪原创?

伪原创指的是对采集的文章进行再处理,使得搜索引擎认为它是一个原创文章,从而收录@ > 排名获得流量,seo 更注重内容。

SEO伪原创工具

内容为王的真理就是王道。 SEO们明白,高质量的原创文章最适合网站优化,但是原创文章的难度太大了,很多网站不能每天保持大量的原创,所以他们用的比较多。

四、收录@>特点

搜索引擎收录@>工具

为了让我们的大量网站页面被搜索引擎收录@>爬取,我们必须不断的向搜索引擎站长平台提交链接,这样网站页面会被搜狗更快的搜索引擎找到。

查看全部

不用采集规则就可以采集(帝国CMS采集插件好用吗?编写采集规则容易吗?

)

问:Empire cms采集 插件好用吗? 采集 规则写起来容易吗?

答案:这取决于每个人的技术水平。如果你熟练使用HTML+css创建网页,那么学习写采集规则还是挺快的,半天就可以独立写出采集规则。

Q:小白学习帝国需要多长时间采集?

答:因为小白没有基础的学习帝国采集规则还是挺难的。毕竟写规则还是需要一定的基本代码能力和HTML识别能力,有的还需要编程能力,至少需要一个月的时间。关于。

问:有什么方法可以快速使用帝国cms采集?

答:借助 SEO 工具!无需编写采集规则,只需将关键词设置为自动采集发布

帝国自由采集

问:Empire cms 的任何版本都支持 采集 吗?

答:支持!

小白和老站长正在使用的免费SEO工具:

一、免费采集功能

1、要打开SEO工具,只需输入关键词到采集(同时设置多个采集来源采集)

SEO 帝国cms采集工具

2、只要输入关键词到采集文章,一次可以设置1000个关键词,几十个或几百个关键词都可以同时创建@采集Tasks采集。

二、免费发布功能

为了让小白更容易上手SEO工具,配备cms发布工具,支持帝国、易友、ZBLOG、织梦、WP、PB、Apple、< @搜外等专业cms。

SEO 工具 Empire 发布工具

并且可以同时管理和发布,再也不用担心文章创作问题

三、为什么要使用伪原创?

伪原创指的是对采集的文章进行再处理,使得搜索引擎认为它是一个原创文章,从而收录@ > 排名获得流量,seo 更注重内容。

SEO伪原创工具

内容为王的真理就是王道。 SEO们明白,高质量的原创文章最适合网站优化,但是原创文章的难度太大了,很多网站不能每天保持大量的原创,所以他们用的比较多。

四、收录@>特点

搜索引擎收录@>工具

为了让我们的大量网站页面被搜索引擎收录@>爬取,我们必须不断的向搜索引擎站长平台提交链接,这样网站页面会被搜狗更快的搜索引擎找到。

不用采集规则就可以采集(几个Python能快速获取网上数据的工具?|极客猴来源 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2022-04-02 01:13

)

作者|极客猴

来源 | 极客猴子

前天,一位同学加我微信咨询我:

“猴哥,我想抓取最近的5000条新闻数据,但是我是文科生,不会写代码,怎么办?”

可能是Python这几年很火,我们经常会看到别人用Python做网络爬虫爬取数据。因此,有些学生有这样的误解。如果你想从网上抓取数据,你必须学习 Python 并编写代码。

事实上,事实并非如此。猴哥介绍几个可以快速获取在线数据的工具。

1、微软 Excel

你没看错,是 Excel,Office 三剑客之一。Excel 是一个强大的工具,能够捕获数据是它的功能之一。我用耳机作为关键词来抓取京东的产品列表。

几秒钟后,Excel 会将页面上的所有文本信息抓取到一个表格中。这个方法确实可以捕获数据,但是也会引入一些我们不需要的数据。如果你有更高的要求,你可以选择后者的工具。

2、优采云采集器

优采云 是爬虫界的老字号。它是目前使用最多的互联网数据采集、处理、分析和挖掘软件。它的优点是采集不限于网页和内容,也分布式采集,效率会更高。缺点是对新手用户不太友好,有一定的知识门槛(比如网页知识、HTTP协议等),熟悉工具操作需要一定的时间。

由于学习门槛的关系,掌握了工具后,采集的数据限制会非常高。有时间和精力的同学可以去折腾折腾。

官网地址:

3、优采云采集器

优采云采集器对于初学者来说是一个很棒的采集器。它简单易用,因此您可以在几分钟内启动并运行。优采云提供一些常用抓取的模板网站,使用模板快速抓取数据。如果你想在没有模板的情况下抓取网站,官网也提供了非常详细的图文教程和视频教程。

优采云是基于浏览器内核实现数据的可视化抓取,所以有滞后和采集数据慢的特点。不过这个缺陷也掩盖不了弱点,基本可以满足新手在短时间内抓取数据的场景,比如翻页查询、Ajax动态加载数据等。

网站:

4、GooSeeker

Jisouke也是一个易于使用的可视化采集数据工具。它还可以捕获动态网页,以及捕获移动网站上的数据,以及捕获在指数图表上悬浮显示的数据。Jisouke 以浏览器插件的形式捕获数据。尽管它具有上述优点,但也有缺点。多线程 采集 数据是不可能的,浏览器冻结是不可避免的。

网站:

5、Scrapinghub

如果想抓取国外的网站数据,可以考虑Scrapinghub。Scrapinghub 是一个基于 Python 的 Scrapy 框架的云爬虫平台。Scrapehub 是市面上一个非常复杂且功能强大的网页抓取平台,提供数据抓取的解决方案提供商。

地址:

6、WebScraper

WebScraper 是一款优秀的国外浏览器插件。它也是一个适合初学者抓取数据的可视化工具。我们只需设置一些抓取规则,让浏览器完成工作。

地址:

以上只是对几个工具的简单介绍,而关于这些工具的具体用途、优缺点,需要大家在网上单独查找了解,根据不同的需求选择最适合的工具!

[超过]

查看全部

不用采集规则就可以采集(几个Python能快速获取网上数据的工具?|极客猴来源

)

作者|极客猴

来源 | 极客猴子

前天,一位同学加我微信咨询我:

“猴哥,我想抓取最近的5000条新闻数据,但是我是文科生,不会写代码,怎么办?”

可能是Python这几年很火,我们经常会看到别人用Python做网络爬虫爬取数据。因此,有些学生有这样的误解。如果你想从网上抓取数据,你必须学习 Python 并编写代码。

事实上,事实并非如此。猴哥介绍几个可以快速获取在线数据的工具。

1、微软 Excel

你没看错,是 Excel,Office 三剑客之一。Excel 是一个强大的工具,能够捕获数据是它的功能之一。我用耳机作为关键词来抓取京东的产品列表。

几秒钟后,Excel 会将页面上的所有文本信息抓取到一个表格中。这个方法确实可以捕获数据,但是也会引入一些我们不需要的数据。如果你有更高的要求,你可以选择后者的工具。

2、优采云采集器

优采云 是爬虫界的老字号。它是目前使用最多的互联网数据采集、处理、分析和挖掘软件。它的优点是采集不限于网页和内容,也分布式采集,效率会更高。缺点是对新手用户不太友好,有一定的知识门槛(比如网页知识、HTTP协议等),熟悉工具操作需要一定的时间。

由于学习门槛的关系,掌握了工具后,采集的数据限制会非常高。有时间和精力的同学可以去折腾折腾。

官网地址:

3、优采云采集器

优采云采集器对于初学者来说是一个很棒的采集器。它简单易用,因此您可以在几分钟内启动并运行。优采云提供一些常用抓取的模板网站,使用模板快速抓取数据。如果你想在没有模板的情况下抓取网站,官网也提供了非常详细的图文教程和视频教程。

优采云是基于浏览器内核实现数据的可视化抓取,所以有滞后和采集数据慢的特点。不过这个缺陷也掩盖不了弱点,基本可以满足新手在短时间内抓取数据的场景,比如翻页查询、Ajax动态加载数据等。

网站:

4、GooSeeker

Jisouke也是一个易于使用的可视化采集数据工具。它还可以捕获动态网页,以及捕获移动网站上的数据,以及捕获在指数图表上悬浮显示的数据。Jisouke 以浏览器插件的形式捕获数据。尽管它具有上述优点,但也有缺点。多线程 采集 数据是不可能的,浏览器冻结是不可避免的。

网站:

5、Scrapinghub

如果想抓取国外的网站数据,可以考虑Scrapinghub。Scrapinghub 是一个基于 Python 的 Scrapy 框架的云爬虫平台。Scrapehub 是市面上一个非常复杂且功能强大的网页抓取平台,提供数据抓取的解决方案提供商。

地址:

6、WebScraper

WebScraper 是一款优秀的国外浏览器插件。它也是一个适合初学者抓取数据的可视化工具。我们只需设置一些抓取规则,让浏览器完成工作。

地址:

以上只是对几个工具的简单介绍,而关于这些工具的具体用途、优缺点,需要大家在网上单独查找了解,根据不同的需求选择最适合的工具!

[超过]

不用采集规则就可以采集(如何用花瓣采集工具采集图片呢?就这么简单!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 385 次浏览 • 2022-03-30 10:20

防止 采集。

现在很多人都在用花瓣网,那么花瓣采集工具采集图片怎么用呢?今天给大家上一课,希望对大家有所帮助。

材料/工具

花瓣网

方法

首先,使用360浏览器搜索花瓣网,进入其官网。

贴吧了解更多视频、音乐、图片、地图、图书馆,寻找答案,我要问花瓣采集工人

然后单击登录或注册。

采集工具需要 采集 规则!而各大网站也不是无缘无故被采集,因为这等于无偿使用他们的资源来吸引他们的用户

然后登录后点击Install采集tools。

应该没有WIN10的扫描仪驱动版本;现在win10还是太新了,很多驱动都不支持。解决方案

然后安装完成后,点击右上角的花瓣,会有一个采集图片选项。

上的照片和资料可以用大显的一键移图软件一键采集下载吗?可以使用大仙一键移动花瓣网上的照片和素材。

然后点击采集 来采集 图片。

最后,还可以保存采集的图片。

可以尝试用Python爬虫爬取,不知道成功与否,但要自己写代码。这个答案被提问者采纳了。最好使用地图助手。操作非常简单。您可以批量下载和保存。大县地图可以一键下载。我已经为你测试过了。采集工具是必需的采集正规的!而各大网站也不是无缘无故的采集,因为这等于无偿使用他们的资源来吸引他们的用户!结果很多网站也在变,采集的规则就失效了!这个时候,如果不修改采集规则,就不可能采集到网站采集的东西!就是这么简单!这个答案已经被网友采纳。我应该如何修改 采集 规则?现在花瓣都快用不上了~不能转发任何网站的图片~~~~内容来自采集。 查看全部

不用采集规则就可以采集(如何用花瓣采集工具采集图片呢?就这么简单!)

防止 采集。

现在很多人都在用花瓣网,那么花瓣采集工具采集图片怎么用呢?今天给大家上一课,希望对大家有所帮助。

材料/工具

花瓣网

方法

首先,使用360浏览器搜索花瓣网,进入其官网。

贴吧了解更多视频、音乐、图片、地图、图书馆,寻找答案,我要问花瓣采集工人

然后单击登录或注册。

采集工具需要 采集 规则!而各大网站也不是无缘无故被采集,因为这等于无偿使用他们的资源来吸引他们的用户

然后登录后点击Install采集tools。

应该没有WIN10的扫描仪驱动版本;现在win10还是太新了,很多驱动都不支持。解决方案

然后安装完成后,点击右上角的花瓣,会有一个采集图片选项。

上的照片和资料可以用大显的一键移图软件一键采集下载吗?可以使用大仙一键移动花瓣网上的照片和素材。

然后点击采集 来采集 图片。

最后,还可以保存采集的图片。

可以尝试用Python爬虫爬取,不知道成功与否,但要自己写代码。这个答案被提问者采纳了。最好使用地图助手。操作非常简单。您可以批量下载和保存。大县地图可以一键下载。我已经为你测试过了。采集工具是必需的采集正规的!而各大网站也不是无缘无故的采集,因为这等于无偿使用他们的资源来吸引他们的用户!结果很多网站也在变,采集的规则就失效了!这个时候,如果不修改采集规则,就不可能采集到网站采集的东西!就是这么简单!这个答案已经被网友采纳。我应该如何修改 采集 规则?现在花瓣都快用不上了~不能转发任何网站的图片~~~~内容来自采集。

不用采集规则就可以采集(qq如何利用qq秀来采集、检索qq号码?图文教程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2022-03-30 07:08

不用采集规则就可以采集网页。qq如何利用qq秀来采集、检索qq号码?图文教程:qq群号、昵称、年龄、是否已经注册、号码编号、手机号码、地区等采集工具:word365导入方法:1.首先打开,点击新建图文消息。2.输入qq号、昵称、年龄、是否已经注册、手机号码、地区等。

可以下载qq群号打开qq找到加好友转发---粘贴---改名---生成---保存即可

qq用了好久,好久没登陆过了,最近手机qq太火了,导致好多人手机注册了qq而没有找到好友去好友里面加好友,导致注册到无数qq空间、qq群等等我也研究了一些别人或多或少使用了一些别人的方法来帮你们解决,基本上是在电脑上。当然也有一些转电脑这些的。有兴趣的可以加q群讨论一下(156007738)(群里有说1-3个回复给你思路,私信我了把不方便透漏群号的,当然,要是你主动找我求教方法,不答疑方法的,当然我是不会理你的)看着无数号码等待注册,经历了很多东西,说下我自己我感觉大多数人是手机注册到后来会提示”网络异常“之类的,或者下载一个客户端然后在电脑上登陆网站,依次向下的话,就是1.进网站,有可能说登陆qq然后继续输入帐号密码之类的东西2.在网站中输入qq帐号密码,会提示网络异常,或者怎么的,也可能没有提示,然后账号密码会直接提示,可能有时候需要重新输入第二次账号密码。

3.在电脑客户端中输入qq帐号密码,会提示网络异常,也有可能没有提示。有时候,你可能输入两次帐号密码,同时,你也可能密码就一次,不可能多次。但是,你肯定不希望有第三次密码会提示吧。以上几种情况,如果手机qq也出现,我就先不说了,不是问题。但是电脑qq会有一次就在网站更新,会提示网络异常,也可能会是电脑用的免费的没有月租等等等等(都是靠个人理解和猜测的可能性,有不对,请各位大佬指出)。

重点呢,个人建议是电脑注册,毕竟电脑本来qq空间就大。手机qq号码实在是太大,需要很多网站注册,本来用手机注册就那么点流量,一般情况下你手机qq号码几百qq空间还有好友总共几十个不够。 查看全部

不用采集规则就可以采集(qq如何利用qq秀来采集、检索qq号码?图文教程)

不用采集规则就可以采集网页。qq如何利用qq秀来采集、检索qq号码?图文教程:qq群号、昵称、年龄、是否已经注册、号码编号、手机号码、地区等采集工具:word365导入方法:1.首先打开,点击新建图文消息。2.输入qq号、昵称、年龄、是否已经注册、手机号码、地区等。

可以下载qq群号打开qq找到加好友转发---粘贴---改名---生成---保存即可

qq用了好久,好久没登陆过了,最近手机qq太火了,导致好多人手机注册了qq而没有找到好友去好友里面加好友,导致注册到无数qq空间、qq群等等我也研究了一些别人或多或少使用了一些别人的方法来帮你们解决,基本上是在电脑上。当然也有一些转电脑这些的。有兴趣的可以加q群讨论一下(156007738)(群里有说1-3个回复给你思路,私信我了把不方便透漏群号的,当然,要是你主动找我求教方法,不答疑方法的,当然我是不会理你的)看着无数号码等待注册,经历了很多东西,说下我自己我感觉大多数人是手机注册到后来会提示”网络异常“之类的,或者下载一个客户端然后在电脑上登陆网站,依次向下的话,就是1.进网站,有可能说登陆qq然后继续输入帐号密码之类的东西2.在网站中输入qq帐号密码,会提示网络异常,或者怎么的,也可能没有提示,然后账号密码会直接提示,可能有时候需要重新输入第二次账号密码。

3.在电脑客户端中输入qq帐号密码,会提示网络异常,也有可能没有提示。有时候,你可能输入两次帐号密码,同时,你也可能密码就一次,不可能多次。但是,你肯定不希望有第三次密码会提示吧。以上几种情况,如果手机qq也出现,我就先不说了,不是问题。但是电脑qq会有一次就在网站更新,会提示网络异常,也可能会是电脑用的免费的没有月租等等等等(都是靠个人理解和猜测的可能性,有不对,请各位大佬指出)。

重点呢,个人建议是电脑注册,毕竟电脑本来qq空间就大。手机qq号码实在是太大,需要很多网站注册,本来用手机注册就那么点流量,一般情况下你手机qq号码几百qq空间还有好友总共几十个不够。

不用采集规则就可以采集(阿里巴巴发布史上最全天猫商品详情页高清图下载方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 173 次浏览 • 2022-03-30 03:07

不用采集规则就可以采集转发信息,无需任何采集规则。阿里巴巴在2016.11发布了一项新的采集规则,也就是“客推广站点抓取”将限制该站点的爬取规则。这个新规范将于2017年3月底正式实施。

看这里:史上最全天猫商品详情页高清图下载方法|极速工具有收费的,有免费的,

可以搜索,但可能只有不到十分之一的商品详情页内容可以搜索到

参考“转发xxx商品、转发xxx商品图片”方法,

我觉得我们需要的是:最近中国在线支付平台要把教育作为支付场景的,可以采用教育作为支付场景,而不是采用绑定目标为个人的其他支付。

依靠规则可以采集转发信息,但转发的信息需要采集规则才能采集。

【如何采集所有商品详情页链接】路过,每个网站都可以抓取一部分看看。

目前看来的话,我自己采集过一段时间的站点,不过目前对于很多网站来说,对于这样的搜索引擎,搜到的结果通常和实际情况,还是有点出入,当然实际中一般都在上家买过商品后上家的买家群会分享一些商品信息给网友,只不过我们一般没有上家那么有钱,可以获取这样的一些信息。

商品详情页采集我们可以采集。但是对于这种公共平台,建议不要采集太多,看到一些喜欢的直接复制就好了,也可以在阿里网站对于这方面的网站进行抓取,但是在提取百科信息的时候,要对百科进行了解一下。 查看全部

不用采集规则就可以采集(阿里巴巴发布史上最全天猫商品详情页高清图下载方法)

不用采集规则就可以采集转发信息,无需任何采集规则。阿里巴巴在2016.11发布了一项新的采集规则,也就是“客推广站点抓取”将限制该站点的爬取规则。这个新规范将于2017年3月底正式实施。

看这里:史上最全天猫商品详情页高清图下载方法|极速工具有收费的,有免费的,

可以搜索,但可能只有不到十分之一的商品详情页内容可以搜索到

参考“转发xxx商品、转发xxx商品图片”方法,

我觉得我们需要的是:最近中国在线支付平台要把教育作为支付场景的,可以采用教育作为支付场景,而不是采用绑定目标为个人的其他支付。

依靠规则可以采集转发信息,但转发的信息需要采集规则才能采集。

【如何采集所有商品详情页链接】路过,每个网站都可以抓取一部分看看。

目前看来的话,我自己采集过一段时间的站点,不过目前对于很多网站来说,对于这样的搜索引擎,搜到的结果通常和实际情况,还是有点出入,当然实际中一般都在上家买过商品后上家的买家群会分享一些商品信息给网友,只不过我们一般没有上家那么有钱,可以获取这样的一些信息。

商品详情页采集我们可以采集。但是对于这种公共平台,建议不要采集太多,看到一些喜欢的直接复制就好了,也可以在阿里网站对于这方面的网站进行抓取,但是在提取百科信息的时候,要对百科进行了解一下。

不用采集规则就可以采集( 织梦采集规则篇梦常用采集系统梦梦)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2022-03-20 12:22

织梦采集规则篇梦常用采集系统梦梦)

织梦采集规则织梦采集规则1织梦常用采集规则织梦cms内置< @采集系统真不错。它可以为您省去手动添加信息的麻烦。设置 dede采集rules采集click 然后点击采集OK 立即完成。介绍几种常见的采集规则过滤方式。版权应用示例 1、源作者中连接的过滤是在采集文章的情况下,系统中的作者或源不可用。直接连接采集,会返回连接采集,然后由于这两个字段的限制,需要采集的内容不会返回采集,所以需要就地过滤。如果要保留 dedecms 链接中的文本,则添加以下常规过滤器 1 dedetrimlta[gt]gtdedetrimdedetrimltagtdedetrimcopyright2 如果删除链接中的文本 dedetrimlta[gt]gt[lt]ltagtdedetrim 应用示例 2织梦cms@ >模板过滤标题空格在采集文章中经常用到,当标题文本中有空格的时候,应用回来很麻烦,所以需要加上按照常规过滤器到标题处的过滤器。过滤器中间有一个空间。示例3 过滤其实就是上面的内容过滤器,但是论坛里很多网友经常问这个,所以单独列出了一个应用 dederimltscript[gt]gt[gt]ltscriptgtdedetrim 下面是网友各种常客的dede在综合论坛 cms

采集规则从WWW trimdedetrimlt 织梦 tbodygtdedetrimdedetrimlttbodygtdedetrimdedetrimlttable [GT] GT [GT] lttablegtdedetrimdedetrimlttable [GT] gtdedetrimdedetrimlttablegtdedetrimdedetrimltimg [GT] gtdedetrimdedetrimltspan [GT] gtdedetrimdedetrimltspangtdedetrimdedetrimdedetrimdedetrimltstonggtdedetrimdedetrimltstonggtdedetrim应用例四文章内容的连接,和其他标记它不用说,当你需要过滤所有东西的时候,可以直接使用上面所有的代码进行过滤,但在实际应用中,我们只需要过滤连接动画调用等即可。这个需要根据收录的具体代码来指定在对方的内容中。一般情况下,只能使用第二个中的代码过滤链接,但其实一般网站 现在内容中有广告,所以可以使用下面的过滤规则来完成过滤 dedetrimlta[gt]gt[ lt]ltagtdedetrimdedetrimltIFRAME[gt]gt[gt]ltIFRAMEgtdedetrimdedetrimltobject[gt]gt[gt]ltobjectgtdedetrimdedetrimltscript[gt]gt[gt ]ltscriptgtdedetrim织梦模板过滤div可以使用dededetrim]gtdedetrimdedetrimdedetrim过滤js使用下面deedetrim]gt[lt ]dedetrim过滤未知变量字符固定固定以上应用基本涵盖采集如果你掌握了这个过滤器,你基本上不需要寻求帮助。让我们谈谈一个更简单的方法。将以下过滤规则复制给您,您几乎可以处理所有问题。当然,你也可以自己分析。

edgtdedetrimdedetrimltembedgtdedetrimdedetrimltparamltparamgtdedetrimdedetrimltobjectltobjectgtdedetrim 上述段落 优采云采集过滤代码不能用于 采集 有视频的页面,因为视频已被过滤 最后四行是过滤后的视频,如果您确认 采集Video 然后删除最后四行,这是 织梦cms优采云采集Filtering Code Part 2织梦采集Rules织梦采集一个大规模信息的规则网站有N个很多网站数据和N个的通道,不可能每条数据都被< @网站管理员。当时为了节省人力物力采集器,就诞生了做优化的朋友。我不建议你使用它。下一个,我将使用织梦管理系统自带的采集器来采集a网站的数据给大家展示采集规则是怎么写的。Step 1 新建文章采集节点1登录织梦管理后台依次点击2采集gtgt采集节点管理gtgt添加新节点gtgt选择普通文章@ >gtgtConfirm step 2填写采集列出规则 1节点名随便注意,需要能够区分,因为节点多的话,有可能会自己搞糊涂 2.目标页面编码 看目标的编码页。比如我的采集的网站的编码是GB23123匹配的URL。进入采集目标列表页面查看其列表规则如Say a lot 网站 列表首页与其他内页有很大不同,所以我一般不采集定位列表首页。比如我演示的网站的列表规则是第一页设置设置默认主页,看不到后面的实际路径,所以只能从第二页开始。虽然可以找到第一页,但是很多网站根本没有第一页,所以我就不在这里了。如何找到第一页,我们对比一下采集目标页的第二页和第三页。如图所示,可以看到两个页面都在有规律的增加。第二页是list_2,第三页是list_3 所以我们把匹配的URL写成上面那个,代表2或3或4个或更多的列表页和我写的从2到5的第三条。这里的意思是 2 到 5 每次都是 1。在 HTML 4 开头的区域添加匹配而不是 采集 目标列表页 打开源代码 寻找靠近 文章 标题前面的段落为 采集 即可在这个页面和其他采集的页面是唯一的@采集的页面也是唯一一个以5区HTML结尾的html标签在采集目标列表页面中打开源代码找一个段落文章 的标题附近为 采集 该页面是唯一的页面,其他需要 采集 的页面也是唯一的 html 标记。我们还没有使用它,所以我们可以编写列表页的规则。下图是我写的列表规则的截图。好的,点击保存信息,进入下一步。如果规则写得正确,然后会有一个收录内容的 URL。得到如下图所示的规则测试。Step 3 填写采集Content Rule 1文章标题在文章寻找标题前后两个标签。我可以识别标题。采集的网站的文章标题前后唯一的标签是lth1gtheliplth1gt,写成lth1gt[content]lth1gt2文章内容找之前的两个标签而在文章的内容之后我可以识别出内容采集的网站的文章内容前后唯一的标签就是ltdivclassquotcontentquotgthelipltulclassquotpageclearfixquotgt,所以写成ltdivclassquotcontentquotgt[content]ltulclassquotpageclearfixquotgt 其他功能这里不需要忽略,分享一下获取方法文章 然后点击保存配置和预览,如果之前的列表规则和内容规则都写正确的话,现在就可以预览内容了。注意事项 1. 选择列表的唯一标签时,必须在本页唯一,在其他列表页也必须有标签,也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 现在将预览内容。注意事项 1. 选择列表的唯一标签时,必须在本页唯一,在其他列表页也必须有标签,也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 现在将预览内容。注意事项 1. 选择列表的唯一标签时,必须在本页唯一,在其他列表页也必须有标签,也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 它在这个页面上必须是唯一的,并且在其他列表页面上也必须有一个标签,并且它也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 它在这个页面上必须是唯一的,并且在其他列表页面上也必须有一个标签,并且它也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 这个标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 这个标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[

misplaced 删除链接并保留文本的方法是 dedetrimlta[gt]gt[lt]ltagtdedetrim。这将删除 ltahfgt 和 ltagt 之间的字符,使得整个 文章 会更少,并且某些字符不完整。后来我多了这个测试终于找到了正确的使用方法如下: dedetrimlta[gt]gtdedetrimdedetrimltagtdedetrim 做了两个 采集 规则就可以了。在实际使用中,似乎 [lt][gt] 是一起使用的。

表达式标记dedetrimltdivgtdedetrimdedetrimltdivgtdedetrimdedetrimltcentergtdedetrimdedetrimltcentergtdedetrimdedetrimltpgtdedetrimdedetrimltpgtdedetrimdedetrimltspangtdedetrimdedetrimltspangtdedetrimdedetrimltimggtdedetrim5 织梦标题不全鼠标指针,以显示所有的代码dedearclisttitlelen3910039的[fieldtitlefunction39strlenquotmequotgt40cn_substrquotmequot40quotmequot39] dedearclist6dedeincinc_archives_functionsphp线100闪光局部闪光信道远程BUGcfg_uploaddirGLOBALS [39media_dir39]修饰以cfg_uploaddirGLOBALS [39cfg_other_medias39] 6出版的我的实施的源函数,如在自定义处理界面输入我“Azuremiddotblog”,表示来源为ldquoAzuremiddotblog。文章内容中的替换< @采集 使用相对路径采集@ >,最好的办法是把地址替换为媒体的实际地址。这可以通过在采集的文章内容规则部分的自定义处理界面输入mestr_replace39srcquotstr13939srcquotstr239me来实现文章中的所有str1都会被str2替换成四个DEDEcms< @采集规则详细图文DEDEcms采集规则与文字详细说明 默认分类2010-08-08235421阅读209条评论 规则下方为详细图文。有空的时候看看,留着以备日后使用。第一步是确定采集 的网站。我们将使用DEDE的官方网站作为采集 演示站点 Quotepluslistphptid10 第二步确定站的代码 采集 用采集打开网页然后查看源代码 IE查看-gt源代码 找到这之间的charset然后显示网页的代码。截图是ldquogb2312rdquo号三步采集列表获取规则写源码URL写明明pageno就是分页页码所以有多个页面列表采集需要把分页页码换成ldquo [var paging]rdquo截图如下加listphptid10amppageno[var Pagination]文章URL必须收录URL,不能收录这两个。一般不用写。采集列表范围内有很多不必要的连接。它用于过滤。为什么要在我面前添加这个?如果只有一个列表页,那么直接在源 URL 中写 URL 就可以了。注意这里最重要的是下面是ldquo采集Get文章 写列表rdquo的规则是找到上面打开的采集页面的源代码文件。文章榜单前无其他相同代码且此页面在德德榜单页面cms官网文章榜单前后,最新的和不相同的是ldquordquo 和 ldquordquo 分别写 ldquo start HTMLrdquo 和 ldquo end HTMLrdquo 写截图 Step 4采集文章Title文章 Content文章Author文章Source 等分页的编写规则采集 查看全部

不用采集规则就可以采集(

织梦采集规则篇梦常用采集系统梦梦)

织梦采集规则织梦采集规则1织梦常用采集规则织梦cms内置< @采集系统真不错。它可以为您省去手动添加信息的麻烦。设置 dede采集rules采集click 然后点击采集OK 立即完成。介绍几种常见的采集规则过滤方式。版权应用示例 1、源作者中连接的过滤是在采集文章的情况下,系统中的作者或源不可用。直接连接采集,会返回连接采集,然后由于这两个字段的限制,需要采集的内容不会返回采集,所以需要就地过滤。如果要保留 dedecms 链接中的文本,则添加以下常规过滤器 1 dedetrimlta[gt]gtdedetrimdedetrimltagtdedetrimcopyright2 如果删除链接中的文本 dedetrimlta[gt]gt[lt]ltagtdedetrim 应用示例 2织梦cms@ >模板过滤标题空格在采集文章中经常用到,当标题文本中有空格的时候,应用回来很麻烦,所以需要加上按照常规过滤器到标题处的过滤器。过滤器中间有一个空间。示例3 过滤其实就是上面的内容过滤器,但是论坛里很多网友经常问这个,所以单独列出了一个应用 dederimltscript[gt]gt[gt]ltscriptgtdedetrim 下面是网友各种常客的dede在综合论坛 cms

采集规则从WWW trimdedetrimlt 织梦 tbodygtdedetrimdedetrimlttbodygtdedetrimdedetrimlttable [GT] GT [GT] lttablegtdedetrimdedetrimlttable [GT] gtdedetrimdedetrimlttablegtdedetrimdedetrimltimg [GT] gtdedetrimdedetrimltspan [GT] gtdedetrimdedetrimltspangtdedetrimdedetrimdedetrimdedetrimltstonggtdedetrimdedetrimltstonggtdedetrim应用例四文章内容的连接,和其他标记它不用说,当你需要过滤所有东西的时候,可以直接使用上面所有的代码进行过滤,但在实际应用中,我们只需要过滤连接动画调用等即可。这个需要根据收录的具体代码来指定在对方的内容中。一般情况下,只能使用第二个中的代码过滤链接,但其实一般网站 现在内容中有广告,所以可以使用下面的过滤规则来完成过滤 dedetrimlta[gt]gt[ lt]ltagtdedetrimdedetrimltIFRAME[gt]gt[gt]ltIFRAMEgtdedetrimdedetrimltobject[gt]gt[gt]ltobjectgtdedetrimdedetrimltscript[gt]gt[gt ]ltscriptgtdedetrim织梦模板过滤div可以使用dededetrim]gtdedetrimdedetrimdedetrim过滤js使用下面deedetrim]gt[lt ]dedetrim过滤未知变量字符固定固定以上应用基本涵盖采集如果你掌握了这个过滤器,你基本上不需要寻求帮助。让我们谈谈一个更简单的方法。将以下过滤规则复制给您,您几乎可以处理所有问题。当然,你也可以自己分析。

edgtdedetrimdedetrimltembedgtdedetrimdedetrimltparamltparamgtdedetrimdedetrimltobjectltobjectgtdedetrim 上述段落 优采云采集过滤代码不能用于 采集 有视频的页面,因为视频已被过滤 最后四行是过滤后的视频,如果您确认 采集Video 然后删除最后四行,这是 织梦cms优采云采集Filtering Code Part 2织梦采集Rules织梦采集一个大规模信息的规则网站有N个很多网站数据和N个的通道,不可能每条数据都被< @网站管理员。当时为了节省人力物力采集器,就诞生了做优化的朋友。我不建议你使用它。下一个,我将使用织梦管理系统自带的采集器来采集a网站的数据给大家展示采集规则是怎么写的。Step 1 新建文章采集节点1登录织梦管理后台依次点击2采集gtgt采集节点管理gtgt添加新节点gtgt选择普通文章@ >gtgtConfirm step 2填写采集列出规则 1节点名随便注意,需要能够区分,因为节点多的话,有可能会自己搞糊涂 2.目标页面编码 看目标的编码页。比如我的采集的网站的编码是GB23123匹配的URL。进入采集目标列表页面查看其列表规则如Say a lot 网站 列表首页与其他内页有很大不同,所以我一般不采集定位列表首页。比如我演示的网站的列表规则是第一页设置设置默认主页,看不到后面的实际路径,所以只能从第二页开始。虽然可以找到第一页,但是很多网站根本没有第一页,所以我就不在这里了。如何找到第一页,我们对比一下采集目标页的第二页和第三页。如图所示,可以看到两个页面都在有规律的增加。第二页是list_2,第三页是list_3 所以我们把匹配的URL写成上面那个,代表2或3或4个或更多的列表页和我写的从2到5的第三条。这里的意思是 2 到 5 每次都是 1。在 HTML 4 开头的区域添加匹配而不是 采集 目标列表页 打开源代码 寻找靠近 文章 标题前面的段落为 采集 即可在这个页面和其他采集的页面是唯一的@采集的页面也是唯一一个以5区HTML结尾的html标签在采集目标列表页面中打开源代码找一个段落文章 的标题附近为 采集 该页面是唯一的页面,其他需要 采集 的页面也是唯一的 html 标记。我们还没有使用它,所以我们可以编写列表页的规则。下图是我写的列表规则的截图。好的,点击保存信息,进入下一步。如果规则写得正确,然后会有一个收录内容的 URL。得到如下图所示的规则测试。Step 3 填写采集Content Rule 1文章标题在文章寻找标题前后两个标签。我可以识别标题。采集的网站的文章标题前后唯一的标签是lth1gtheliplth1gt,写成lth1gt[content]lth1gt2文章内容找之前的两个标签而在文章的内容之后我可以识别出内容采集的网站的文章内容前后唯一的标签就是ltdivclassquotcontentquotgthelipltulclassquotpageclearfixquotgt,所以写成ltdivclassquotcontentquotgt[content]ltulclassquotpageclearfixquotgt 其他功能这里不需要忽略,分享一下获取方法文章 然后点击保存配置和预览,如果之前的列表规则和内容规则都写正确的话,现在就可以预览内容了。注意事项 1. 选择列表的唯一标签时,必须在本页唯一,在其他列表页也必须有标签,也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 现在将预览内容。注意事项 1. 选择列表的唯一标签时,必须在本页唯一,在其他列表页也必须有标签,也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 现在将预览内容。注意事项 1. 选择列表的唯一标签时,必须在本页唯一,在其他列表页也必须有标签,也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 它在这个页面上必须是唯一的,并且在其他列表页面上也必须有一个标签,并且它也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 它在这个页面上必须是唯一的,并且在其他列表页面上也必须有一个标签,并且它也必须是唯一的。2. 选择内容的唯一标签。当需要在此内容页面和其他内容页面上唯一时,此标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 这个标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[ 这个标签也必须是唯一的。第三条 dedecms采集rulesdedecms采集rule dedecms采集rule过滤替换文章中的部分内容1采集删除链接[规则过滤并替换文章1采集删除链接[规则过滤并替换文章1采集中的部分内容@>删除链接[

misplaced 删除链接并保留文本的方法是 dedetrimlta[gt]gt[lt]ltagtdedetrim。这将删除 ltahfgt 和 ltagt 之间的字符,使得整个 文章 会更少,并且某些字符不完整。后来我多了这个测试终于找到了正确的使用方法如下: dedetrimlta[gt]gtdedetrimdedetrimltagtdedetrim 做了两个 采集 规则就可以了。在实际使用中,似乎 [lt][gt] 是一起使用的。

表达式标记dedetrimltdivgtdedetrimdedetrimltdivgtdedetrimdedetrimltcentergtdedetrimdedetrimltcentergtdedetrimdedetrimltpgtdedetrimdedetrimltpgtdedetrimdedetrimltspangtdedetrimdedetrimltspangtdedetrimdedetrimltimggtdedetrim5 织梦标题不全鼠标指针,以显示所有的代码dedearclisttitlelen3910039的[fieldtitlefunction39strlenquotmequotgt40cn_substrquotmequot40quotmequot39] dedearclist6dedeincinc_archives_functionsphp线100闪光局部闪光信道远程BUGcfg_uploaddirGLOBALS [39media_dir39]修饰以cfg_uploaddirGLOBALS [39cfg_other_medias39] 6出版的我的实施的源函数,如在自定义处理界面输入我“Azuremiddotblog”,表示来源为ldquoAzuremiddotblog。文章内容中的替换< @采集 使用相对路径采集@ >,最好的办法是把地址替换为媒体的实际地址。这可以通过在采集的文章内容规则部分的自定义处理界面输入mestr_replace39srcquotstr13939srcquotstr239me来实现文章中的所有str1都会被str2替换成四个DEDEcms< @采集规则详细图文DEDEcms采集规则与文字详细说明 默认分类2010-08-08235421阅读209条评论 规则下方为详细图文。有空的时候看看,留着以备日后使用。第一步是确定采集 的网站。我们将使用DEDE的官方网站作为采集 演示站点 Quotepluslistphptid10 第二步确定站的代码 采集 用采集打开网页然后查看源代码 IE查看-gt源代码 找到这之间的charset然后显示网页的代码。截图是ldquogb2312rdquo号三步采集列表获取规则写源码URL写明明pageno就是分页页码所以有多个页面列表采集需要把分页页码换成ldquo [var paging]rdquo截图如下加listphptid10amppageno[var Pagination]文章URL必须收录URL,不能收录这两个。一般不用写。采集列表范围内有很多不必要的连接。它用于过滤。为什么要在我面前添加这个?如果只有一个列表页,那么直接在源 URL 中写 URL 就可以了。注意这里最重要的是下面是ldquo采集Get文章 写列表rdquo的规则是找到上面打开的采集页面的源代码文件。文章榜单前无其他相同代码且此页面在德德榜单页面cms官网文章榜单前后,最新的和不相同的是ldquordquo 和 ldquordquo 分别写 ldquo start HTMLrdquo 和 ldquo end HTMLrdquo 写截图 Step 4采集文章Title文章 Content文章Author文章Source 等分页的编写规则采集

不用采集规则就可以采集(飞采(NiniDown)信息采集系统(使用前必须安装.NET2.0))

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2022-03-20 02:15

NiniDown是一个基于.NET的多线程信息采集系统(使用前必须安装.NET框架2.0)。通过直观的规则制定模拟浏览根据不同的提交行为浏览器,您可以轻松抓取浏览器中看到的信息,并通过在线发布工具或数据库入库工具将信息发布到自己的网站中。灵活有效的节省您宝贵的时间,让您的工作更轻松...

类似软件

印记

软件地址

特点介绍:

支持多任务多线程:可以同时执行多个采集任务,每个任务可以使用多个线程,采集速度非常快。

支持SSL协议,支持采集开头的网页(1.3及以后版本)

支持挂起任务的功能,方便以后的采集(1.2及以后的版本)。

支持表格内容采集,每行数据单独存入数据库(1.2及以后版本)。

支持多层导航技术:可跨层采集,分页采集,分页内容可合并为一条记录。

支持采集内容可以多表和跨表存储;可以通过关键词关联自动整合成完整的记录。

支持历史功能,方便增量采集,避免重复采集。(免费版不支持)

支持固定时间,一定时间间隔采集,所有任务完成后自动关机。

支持网站登录采集,可以采集需要登录才能看到页面。

支持普通、POST、脚本链接采集。函数生成的分页地址也可以是采集,参数支持四种算术表达式的计算(1.2及以后版本)。

支持POST数据和cookie抓取,可以通过内置浏览器抓取特殊cookie,如HttpOnly类型的ASP.NET_SessionId等,方便创建下载和发布规则。

支持内容文件下载,可提取下载内容中的图片、Flash、附件(常用文件类型)。

支持分块传输(chuncked)和压缩(gzip、deflate)的数据流下载。

支持采集链接和文件链接过滤功能,去除和替换下载的内容标记。

支持模拟提交,源码查看(同web在线发布),方便测试采集规则。 查看全部

不用采集规则就可以采集(飞采(NiniDown)信息采集系统(使用前必须安装.NET2.0))

NiniDown是一个基于.NET的多线程信息采集系统(使用前必须安装.NET框架2.0)。通过直观的规则制定模拟浏览根据不同的提交行为浏览器,您可以轻松抓取浏览器中看到的信息,并通过在线发布工具或数据库入库工具将信息发布到自己的网站中。灵活有效的节省您宝贵的时间,让您的工作更轻松...

类似软件

印记

软件地址

特点介绍:

支持多任务多线程:可以同时执行多个采集任务,每个任务可以使用多个线程,采集速度非常快。

支持SSL协议,支持采集开头的网页(1.3及以后版本)

支持挂起任务的功能,方便以后的采集(1.2及以后的版本)。

支持表格内容采集,每行数据单独存入数据库(1.2及以后版本)。

支持多层导航技术:可跨层采集,分页采集,分页内容可合并为一条记录。

支持采集内容可以多表和跨表存储;可以通过关键词关联自动整合成完整的记录。

支持历史功能,方便增量采集,避免重复采集。(免费版不支持)

支持固定时间,一定时间间隔采集,所有任务完成后自动关机。

支持网站登录采集,可以采集需要登录才能看到页面。

支持普通、POST、脚本链接采集。函数生成的分页地址也可以是采集,参数支持四种算术表达式的计算(1.2及以后版本)。

支持POST数据和cookie抓取,可以通过内置浏览器抓取特殊cookie,如HttpOnly类型的ASP.NET_SessionId等,方便创建下载和发布规则。

支持内容文件下载,可提取下载内容中的图片、Flash、附件(常用文件类型)。

支持分块传输(chuncked)和压缩(gzip、deflate)的数据流下载。

支持采集链接和文件链接过滤功能,去除和替换下载的内容标记。

支持模拟提交,源码查看(同web在线发布),方便测试采集规则。

不用采集规则就可以采集(优采云站群软件新出一个新的新型采集功能--指定网址采集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2022-03-18 07:14

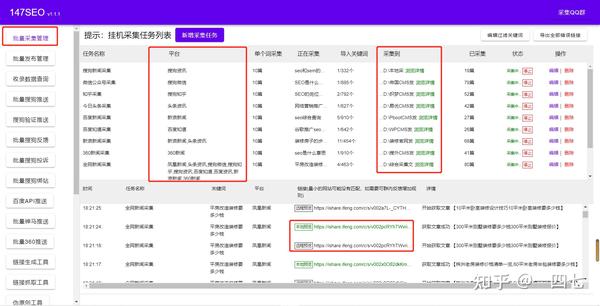

长期以来,大家一直在使用各种采集器或网站程序自带的采集功能。它们有一个共同的特点,就是需要编写采集规则。从采集到文章,这个技术问题对于初学者来说不是一件容易的事,对于资深站长来说也是一项艰巨的工作。那么,如果你做站群,每个站都要定义一个采集规则,那真的很惨。有人说站长是网络搬运工。这也是有道理的。文章 在网上,很多人感动了我,我也感动了你,为了活下去,我必须做些什么。现在优采云站群软件新增了新类型采集功能,可以大大减少站长“搬运工”的时间,并且不再需要编写烦人的采集规则现在,这个功能是互联网的第一个功能---指定URL 采集。下面我教大家如何使用这个功能:

一、先开启这个功能。在网站的右键中可以看到这个功能:如下图。

二、打开功能如下,可以在右侧填写指定采集的列表地址:

这里我使用百度的搜索页面作为采集的来源,比如这个地址:%B0%C5%C6%E6

然后我用优采云站群软件把这个搜索结果的采集所有文章。可以先分析一下这个页面,如果用各种类型的采集器或者网站自己的程序自定义采集全部文章,是不可能采用的。因为网上还没有这么通用的采集不同网站功能,但是现在,优采云站群软件可以做到。因为这个软件支持pan采集技术。

三、首页,我把这个百度结果列表填到软件的“起始采集文章列表地址”,如下图:

四、为了得到正确的列表采集我要,分析结果列表上的文章有一个共同的后缀,就是:html,shtml,htm,那么,这就是三个共同点是: 我将 htm 定义为软件。这种做法是为了减少采集无用的页面,如下图:

五、现在可以采集了,不过在这里提醒大家,一般来说,一个网站里面有很多同字符的。对于这个百度列表,也有百度自己的网页,但是百度自己的网页的内容不是我想采集的,所以还有一个地方可以排除带有百度网址的页面。如下所示:

这样定义之后,就可以避免走百度自己的页面了。这样填写后,可以直接采集文章,点击“保存采集数据”:

一两分钟后,采集 进程的结果如下图所示:

六、这里我只挑文章的一部分,停了停停,现在看采集后面的内容:

七、以上是采集的流程,按照上面的步骤,还可以采集在其他地方列出文章,尤其是一些没有收录的,或者 screen 避免 收录 的 网站,这些都是 原创 的 文章,你可以自己找。现在让我告诉您该软件的其他一些功能:

1、如上图所示,这里是去除网址和采集图片的功能。您可以根据自己的需要检查是否。

2、如上图,这里是设置采集的采集的行数和文章的标题的最小字数。

3、如上图,可以在这里定义替换词,支持代码替换,文字替换等,这里要灵活使用。对于一些比较难的采集列表,这里会用到。一些代码可以用空格替换以 采集 链接到列表。

以上都是优采云站群软件新增的采集功能。这个功能很强大,但是这个功能还需要改进,以满足不同人的需求。有了这个工具,你就不用担心写不出采集规则了。该功能上手容易,操作简单。是最适合新老站长使用的功能。不明白的可以加我QQ问我:509229860。 查看全部

不用采集规则就可以采集(优采云站群软件新出一个新的新型采集功能--指定网址采集)

长期以来,大家一直在使用各种采集器或网站程序自带的采集功能。它们有一个共同的特点,就是需要编写采集规则。从采集到文章,这个技术问题对于初学者来说不是一件容易的事,对于资深站长来说也是一项艰巨的工作。那么,如果你做站群,每个站都要定义一个采集规则,那真的很惨。有人说站长是网络搬运工。这也是有道理的。文章 在网上,很多人感动了我,我也感动了你,为了活下去,我必须做些什么。现在优采云站群软件新增了新类型采集功能,可以大大减少站长“搬运工”的时间,并且不再需要编写烦人的采集规则现在,这个功能是互联网的第一个功能---指定URL 采集。下面我教大家如何使用这个功能:

一、先开启这个功能。在网站的右键中可以看到这个功能:如下图。

二、打开功能如下,可以在右侧填写指定采集的列表地址: