技巧:网站数据抓取国内五大主流网站内容抓取工具、采集软件大盘点

优采云 发布时间: 2020-09-26 11:06网站五个主要的国内数据捕获网站内容捕获工具,采集软件清单

摘要:大数据技术需要花费数年的时间才能发展起来,从看起来很酷的新技术变为企业在生产和运营中实际部署的服务。其中,data 采集产品已经迎来了广阔的市场前景,*敏*感*词*市场上都有许多具有不同技术一、的采集软件。今天,我们将比较五种主要的国产采集软件的优缺点,以帮助您选择最适合的采集器并体验数据搜寻的乐趣。在自定义采集的过程中,优采云采集器系统的自写Xpath和自动生成的过程可能不符合数据采集的要求。使用自定义采集的学生,尽管优采云操作简单,但学习起来更容易。结论:优采云是适合新手用户试用的采集软件。云功能强大。当然,旧的爬虫也可以开发其高级功能。

网站五个主要的国内数据捕获网站内容捕获工具,采集软件清单

网站数据捕获

大数据技术已经发展了多年,它已经从看起来很酷的新技术变成了企业在生产和运营中实际部署的服务。其中,data 采集产品迎来了广阔的市场前景,*敏*感*词*市场上有许多具有不同技术一、的采集软件。

今天,我们将比较五种主要的国产采集软件的优缺点,以帮助您选择最合适的采集器并体验数据狩猎的乐趣。

国内文章

1.优采云

作为采集世界的前身,我们优采云是Internet数据捕获,处理,分析和挖掘软件,可以捕获网络上分散的数据信息,并通过一系列分析和处理,准确地挖掘出所需的数据。它的用户定位主要是针对具有一定代码基础的人员,适合对退伍军人进行编程。

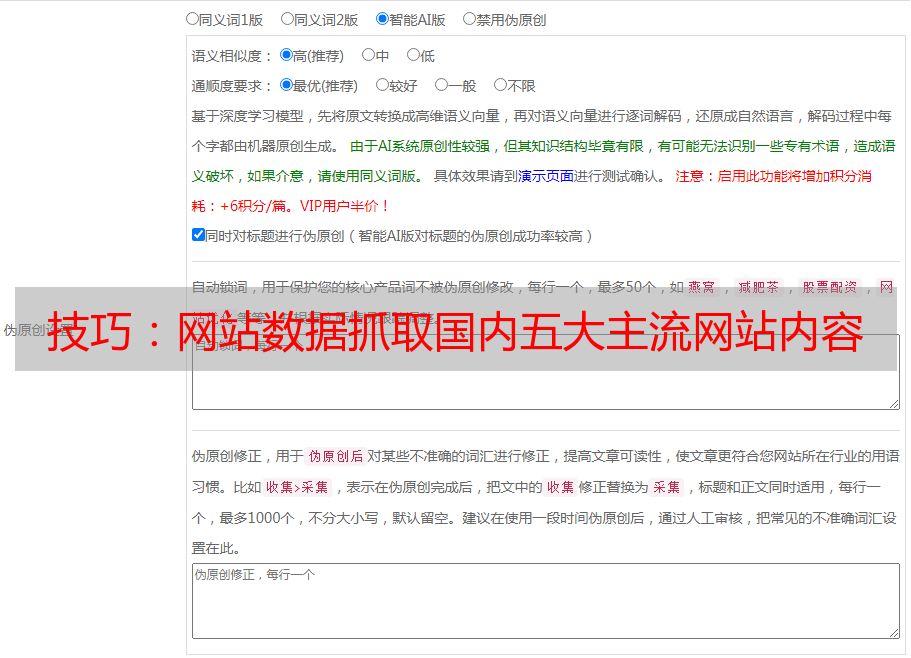

采集具有完整的功能,无限制的网页和内容,可以下载任何文件格式。拥有智能的多重识别系统和可选的验证方法,以保护安全性。支持PHP和C#插件扩展,以方便数据的修改和处理。同义词和同义词替换,参数替换,伪原创基本技能结论:优采云适合编程专家,规则易于编写,软件定位更加专业和准确。

2.优采云

一种无需视觉编程的网页采集软件,可以快速从不同的网站中提取标准化数据,帮助用户实现数据自动化采集,进行编辑和标准化并降低工作成本。云采集是其主要功能。与其他采集软件相比,云采集可以更加精确,高效和*敏*感*词*。

在自定义采集的过程中,优采云采集器系统的自写Xpath和自动生成的过程可能不符合数据采集的要求。对于高数据质量要求,您需要自己编写Xpath并将其调整为流程图以优化规则。

对于使用自定义采集的学生,尽管优采云易于操作,但更易于学习。但是,仍然有必要了解优采云采集的原理,逐步阅读相关教程后,生长周期会更长。

视觉操作,无需编写代码,生产规则采集,适合零编程的用户云采集是其主要功能,支持关机采集,并实现自动计时采集

结论:优采云是适合新手用户试用的采集软件。它具有强大的云功能。当然,旧的爬虫也可以开发其高级功能。

3.Jisouke

一个简单易用的Web信息爬网软件,可以捕获网页文本,图表,超链接和其他Web元素。它也可以通过简单的可视化过程采集进行,从而为需要数据的任何人采集服务。

可视化的过程操作与优采云不同。采集客户的过程着重于定义捕获的数据和爬网路线。 优采云的规则过程非常清晰,用户可以决定软件操作的每个步骤

支持获取浮动显示在索引图上的数据,以及获取手机上的数据网站

成员可以互相帮助,提高采集的效率,并且可以使用模板资源

结论:采集和采集客户的操作相对简单,适合初学者。就功能而言,功能并不多,对后续付款的要求也更高。

4.优采云云端爬虫

基于优采云分布式云采集器框架的新型云在线智能采集器/ 采集器可帮助用户快速获取大量标准化的Web数据。

直接访问代理IP以避免IP阻塞

自动登录验证码识别,网站自动完成验证码输入

可以在线生成图标,以丰富的表格形式显示采集结果以进行本地化隐私保护,云采集,可以隐藏用户IP

结论:优采云与爬虫系统框架相似,具体来说采集要求用户编写自己的爬虫,并且需要代码基础。

5.优采云采集器

一组专业的网站内容采集软件,支持各种论坛帖子和回复采集,网站和博客文章内容捕获,子论坛采集器,cms采集器和Blog 采集器是三种类型。

支持批量替换和过滤文章内容中的文本和链接。批量同时发布到网站或论坛的多个部分。具有采集或发布任务完成后的自动关机功能

结论:专注于论坛和博客文本内容的爬网。 采集对于整个网络数据不是很通用。

注意:针对优采云采集器新手的一些学习建议

优采云采集器是一款非常专业的数据捕获和数据处理软件,对软件用户有更高的技术要求,并且用户必须具有基本的HTML基础并了解网页的源代码。结构。

同时,如果您使用Web发布或数据库发布,则必须对文章系统和数据存储结构有充分的了解。

网站 Data Capture Excel自动捕获网页数据,并一键完成数据捕获

网站数据捕获

网站上的数据源是我们进行统计分析的重要信息来源。我们在生活中经常听到一个叫做“ crawler”的词,它可以快速对网页上的数据进行爬网,这对于与数据分析相关的工作非常重要,它也是必要的技能之一。但是,大多数爬虫都需要编程知识,这对大多数人来说都是很难上手的。今天,我将向您介绍如何使用Excel快速获取Web数据。

1、首先打开要获取的数据的网站,然后复制网站的地址。

2、要创建新的Excel工作簿,请在“数据”菜单>“获取外部数据”标签中单击“来自网站”选项。

在弹出的“新建网络查询”对话框中,在地址栏中输入要捕获的网站地址,然后单击“执行”

单击*敏*感*词*导入箭头,然后选择需要捕获的零件,如图所示。只需单击导入。

3、选择存储数据的位置(默认情况下选中的单元格),然后单击“确定”。通常建议将数据存储在“ A1”单元格中。

4、如果要基于网站中的数据实时自动自动更新Excel工作簿数据,则需要在“属性”中进行设置。您可以设置“允许后台刷新”,“刷新频率”,“打开文件时刷新数据”等。

获取数据后,需要处理数据。处理数据是更重要的部分。有关更多数据处理技能,请关注我!

如果有帮助,请记住喜欢并重新发布。

跟随我学习更多的Excel技能并简化工作。