完美:各大企业都在用的数据采集配置,轻松日采数据千亿条

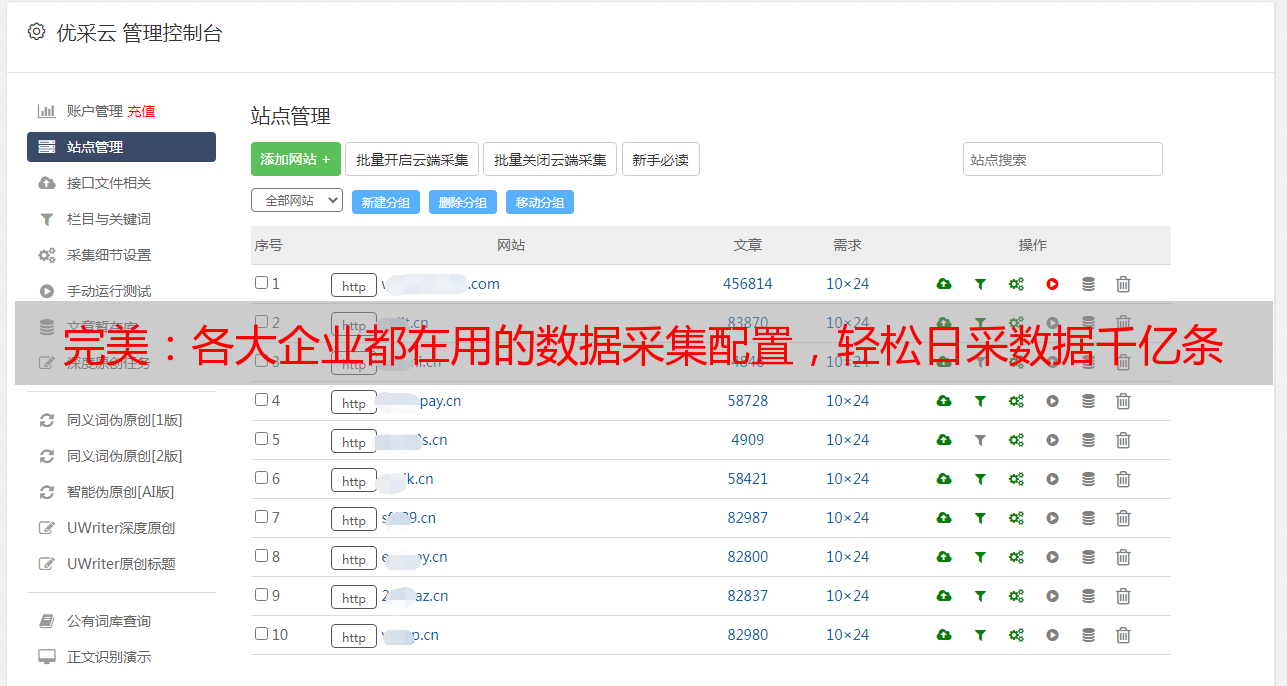

优采云 发布时间: 2020-09-19 12:01所有主要企业使用的数据采集配置,每天轻松采集数千亿个数据

本文介绍了根据我多年的行业经验在巨人的肩膀上开发的data 采集应用程序,这就是我们通常所说的履带系统。说到系统,它不是一个单独的采集器脚本,而是一整套自动化的内容采集。因为我尝试了许多构建此系统的方法,所以这里是最简单,易于实现和共享的最佳内容。现在,每个主要的日常数据相关企业都基本采用了此数据采集技术,该技术简单,快速且实用。这是基于Python的产品设计和应用的简要说明。

编程语言:Python

使用框架:Scrapy,Gerapy

数据仓库:Mongodb

其他内容:IP池

简短地讨论一般业务流程。

安排数据爬网的目录并将其分类为文件。

根据文档编写Scrapy采集器脚本。

在Gerapy中部署Scrapy脚本并进行相关设置以实现24小时自动化采集。

对应中会有一些问题。

如何确定抓取的网站失败了?

如何使用IP池?

在部署过程中的任何时候都会遇到各种坑。

以后如何使用捕获的数据?

对于使用中的各种问题,请检查我的技术文章。这里我们仅介绍业务流程和功能使用。

靠近主题,开始就是内容

组织数据采集文档

如果您使用傻瓜式方式而不是穷举的方式进行采集,则此步骤是不可避免的。它是组织我们要爬网的目标页面。根据Scrapy捕获的格式要求进行组织。

例如,例如《新华网》和《人民日报在线》,此网站页实际上很多,并且由于该页的CSS不同,因此对其进行分类很令人讨厌,但您只能使用它完成一次之后。

Spider下与脚本名称相对应的py文件以记录形式组织。