事实:新型爬虫如何重构“网站URL采集”这件小事?(内附视频演示)

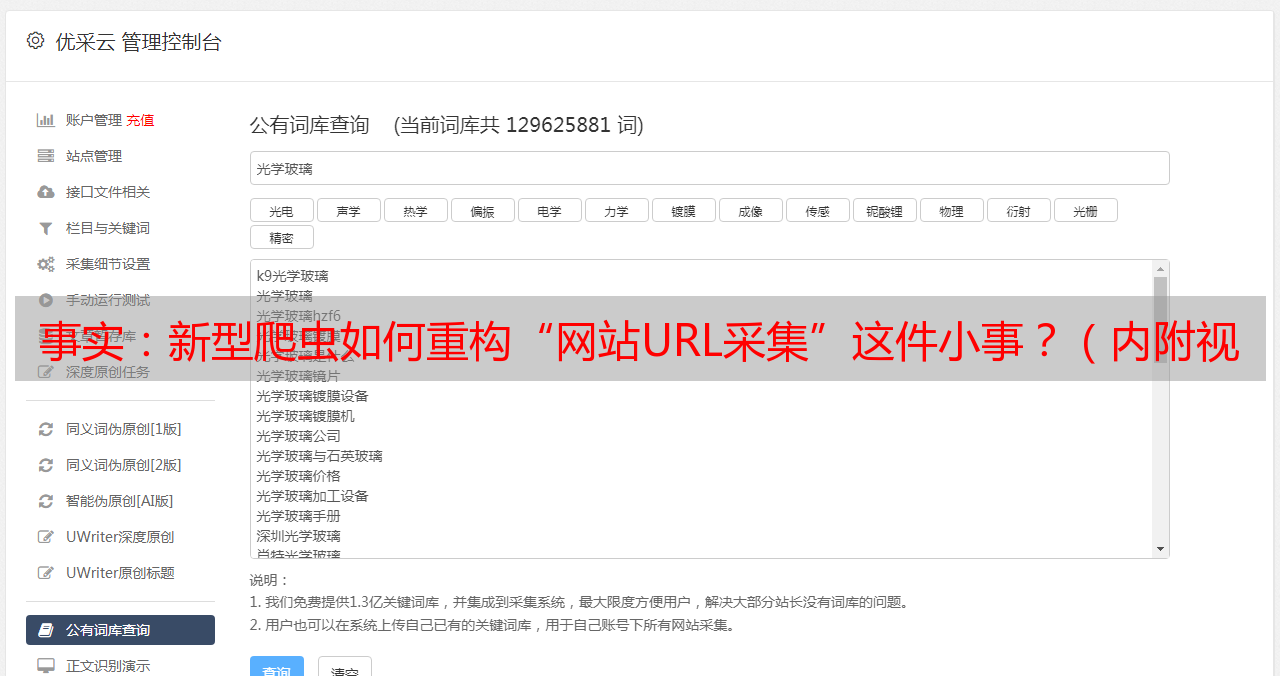

优采云 发布时间: 2020-09-06 17:04如何使用新的采集器重构“ 网站 URL 采集”的琐碎问题? (包括视频演示)

随着网络的日趋成熟,人们已经开始进入“数字生存”时代。网上银行,电子商务,个人空间,云存储等不断涌现,Web应用程序安全性问题日益突出。

根据Gartner的调查,75%的信息安全攻击发生在Web应用程序而不是网络级别。同时,OWASP发布的数据还显示,三分之二的网站非常容易受到攻击。

手动测试和审核Web应用程序的安全性是一项复杂且耗时的任务。对于安全运维人员,基于安全的管理需要大量的工作时间。自动化的Web漏洞扫描程序可以极大地简化安全风险的检测,并帮助安全操作和维护人员将精力转移到如何处理安全风险上。

网络漏洞扫描器

通常来说,Web漏洞扫描程序是基于URL的漏洞扫描工具。 采集和核心检测这两个关键问题需要在工作期间解决:

如何采集输入源(即采集 网站 URL)

如何调用扫描插件(即扫描URL)

如何评估扫描仪的质量?首先要注意的是:采集的URL是否足够全面?如果资产采集不完整,就无法谈及检测的准确性。

发现率低,是传统爬虫的技术

在Web遗漏扫描中,采集个输入源通常包括采集器,流量,代理和日志。抓取工具是用于获取扫描的网站 URL的最常见且必不可少的活动采集模式。

Web漏洞扫描程序爬网程序比其他Web爬网程序面临更高的技术挑战。这是因为漏洞扫描程序爬网程序不仅需要爬网内容和分析链接信息,而且还需要触发尽可能多的网页各种事件以获得更有效的链接信息。

但是,现有的采集器受到其固有的技术缺陷的限制,这给使用Web漏洞扫描工具的安全运营和维护人员带来了许多问题:

1、可以轻松触发WAF设置的IP访问限制

通常,网站的防火墙将限制在一定时间内可以请求固定IP的次数。如果未超过该限制,则将正常返回数据,如果超过该限制,则该请求将被拒绝。值得注意的是,大多数时候IP限制是出于网站安全原因,以抵御DOS攻击,而不是专门针对爬虫。但是,当传统爬虫工作时,机器和IP受到限制,并且很容易达到WAF设置的IP上限并导致请求被拒绝。

2、无法自动处理网页中的互动问题

在Web 2. 0时代,Web应用程序与用户的交互非常频繁,这对丢失的爬网程序造成了干扰。以输入验证码登录为例,网站将生成带有一串随机生成的数字或符号的图片,并在图片中添加一些干扰像素(以防止OCR),并且用户将在视觉上识别出该验证代码信息并输入表单以提交网站验证,此功能仅在验证成功后才能使用。当传统的爬虫遇到这种情况时,通常很难自动对其进行处理。

3、无法完全抓取JavaScript解析的网页

JavaScript框架的诞生对于效率时代的R&D工程师是一个巨大的福音。工程师可以摆脱开发和维护的痛苦。毫无疑问,用于单页应用程序(例如Angular,React和Vue)的Web框架已成为开发人员的首选。 JavaScript解析的网页越来越受欢迎,因此网页中的大多数有用数据都是通过ajax / fetch动态获取的,然后通过js填充到网页的DOM树中,纯净的有用数据很少HTML静态页面,直接导致Web漏网爬网程序的不完全爬网。

传统爬虫和集中爬虫

从市场上常用的漏洞扫描产品来看,使用的爬虫通常包括以下两类,即传统爬虫和集中式爬虫:

传统爬虫

其工作流程是从一个或几个初始网页的URL开始,获取初始网页上的URL,并在抓取网页的过程中将当前页面的新URL连续提取到队列中,直到系统设置为止满足一系列停止条件后,爬网操作停止。

传统的爬虫流程图主要针对爬虫

聚焦爬虫的工作流程比传统爬虫更复杂。有必要根据某些Web分析算法过滤与扫描目标无关的URL,保留有用的URL,然后将其放入等待抓取的URL队列中。然后,它将根据某种搜索策略从队列中选择要爬网的下一个网页的URL,并重复上述过程,直到达到系统的某种条件时停止。此外,系统将存储由采集器搜寻到的所有网页,以进行某些分析,过滤和索引,以供以后查询和检索;因此,一个完整的,集中的采集器通常收录以下三个模块:Web请求模块,搜寻过程控制模块,内容分析和提取模块。

但是,由于它固有的技术缺陷,无论是传统的采集器还是专注的采集器,当采集 网站出现时,都无法自动处理网页交互,JavaScript解析以及对外部WAF防御措施的限制URL很容易触发。问题。

X-Ray创新技术提高了采集器的发现率

X-Ray安全评估系统创造性地提出了一种基于语义分析,机器学习技术和*敏*感*词*真的实时渲染DOM遍历算法,以应对用户当前遇到的缺少扫描爬虫的问题采集 。 “新的抓取工具”:

1、创新地添加了js语义分析算法,以避免IP访问超限

对于传统的网站,长汀科技创新在专注于爬虫的基础上,使用js语义分析算法来防止WAF的IP访问限制措施来抵御DOS攻击。 X-Ray爬虫将对本地JS文件进行分析,并在理解语义的基础上解析网站结构,并且不会疯狂地触发请求,从而避免了由于超出IP访问而被拒绝访问的情况限制。

X-Ray关注爬虫过程原理图2、通过机器学习技术实现交互行为分析

对于单页应用程序网站,X-Ray嵌入了一个模拟的浏览器采集器。通过使用机器学习技术,X-Ray的模拟浏览器采集器使用各种Web应用程序页面结构作为训练样本。当访问每个页面时,它可以智能地判断各种交互操作。判断逻辑大概是这样的:

判断是表单输入,单击事件等;

自动确定表单输入框中应填写哪些内容,例如用户名,密码,IP地址等,然后填写相应的内容样本;

自动触发click事件以成功发起请求3、高度仿真的实时呈现DOM遍历算法,是JavaScript解析的完美解决方案

对于用JavaScript解析的单页Web应用程序,X-Ray模拟浏览器的创新引入了高模拟实时渲染DOM遍历算法。由该算法引擎驱动,可以完美地分析Angular,React和Vue。其他Web框架实现的单页面应用程序网站对网页的所有内容进行操作,以达到获取目标URL信息的目的。 网站。判断逻辑如下:

找到网页的DOM节点以形成DOM树;

内置的浏览器,从深度和广度两个层面,以高度模拟网页的方式遍历DOM树;

真正的浏览器屏幕,实时渲染DOM树遍历过程

在机器学习技术和*敏*感*词*真实时渲染DOM遍历算法的驱动下,X-Ray模拟浏览器爬虫的行为并智能地模拟人类行为,并自动执行单击,双击和拖动之类的操作为了避免传统的采集器无法满*敏*感*词*互要求,并且无法在获取URL时处理JavaScript解析。

以下是访问DVWA的示例,以演示模拟浏览器的行为

点击dvwa浏览器

以在线银行,电子商务,云存储等Web应用程序为代表的Web 3. 0时代已经到来,并且X射线安全评估系统正在蓬勃发展。准备好了吗?