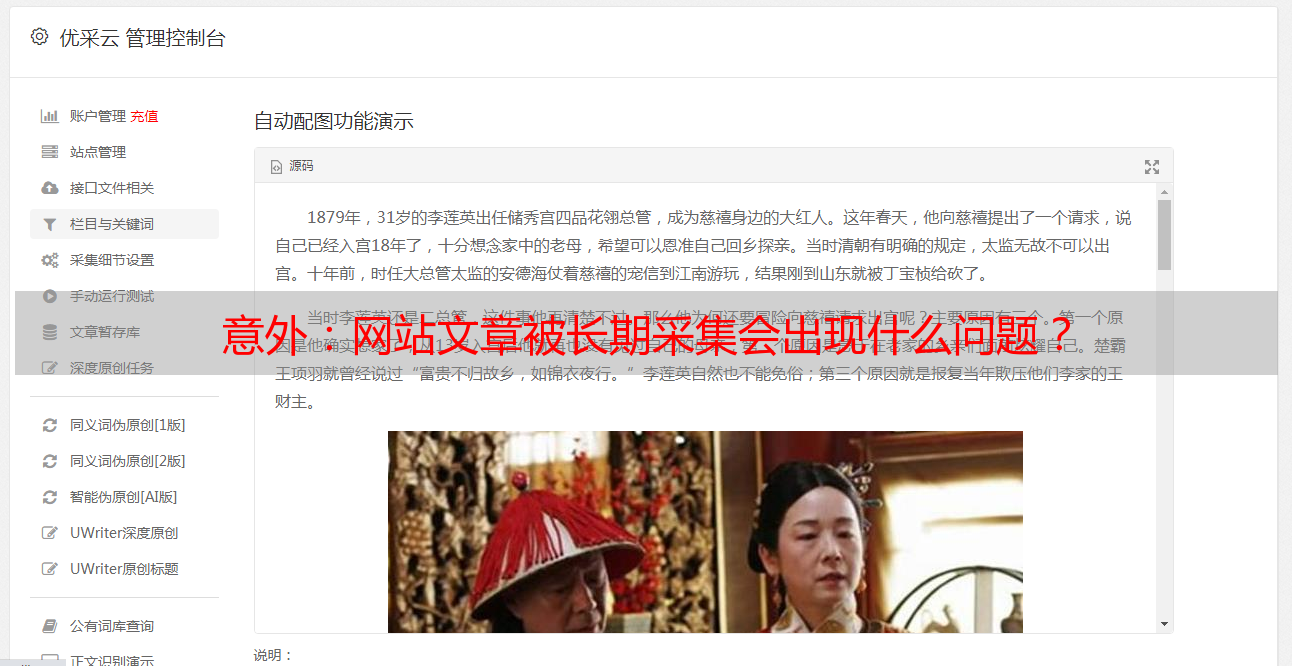

意外:网站文章被长期采集会出现什么问题?

优采云 发布时间: 2020-09-02 07:29网站 文章是长期的采集会发生什么?

定期更新站中的文章是几乎每个网站都会做的事情,当然不是每个网站都关注原创,也不是每个网站都愿意花这个时间做原创的文章,许多人正在使用采集更新其网站 文章. 更不用说会对采集个其他文章中的网站发生什么,这里根据网站的实际情况,对采集 文章中的网站会发生什么被他人困扰很久的后果,以及避免被他人采集感染的方法.

百度BaiduSpider喜欢原创的东西,但是百度蜘蛛对原创来源的判断还不准确,并且无法完全确定某一篇文章文章的来源. 当我们更新文章文章并很快被其他人采集感染时,蜘蛛可能会同时与很多相同的文章接触,这将非常令人困惑,并且不清楚哪个是[ k8]并被复制.

因此,当我们的网站长时间处于采集的状态时,我们网站上更新的文章的大部分内容在互联网上都具有相同的内容,并且如果[如果k2]仍然不够高,则蜘蛛可能会将您的网站列为采集电台,并且它认为您的网站的文章是互联网上的采集,而不是互联网上的其他电台是采集是您的文章.

1. 网站 采集的内容会出现很长时间

网站中出现以下情况时,表示搜索引擎蜘蛛可能将网站内容误判为采集. 作为专业的SEO人员,您应该开始仔细检查网站内容是否长时间处于采集.

1. 首先文章页停止收录,然后整个网站而不是收录

这肯定会发生,因为百度将其错误地视为采集网站,因此您的文章页面肯定会被百度列为审查期. 在此期间,文章页面肯定会停止收录. 当然,此停止收录不仅会影响您的文章页面,还会使百度重新查看您的整个网站,因此其他页面将不会收录逐渐开始. 作者的网站在收录中没有页面了半个月,原因是因为这个.

2,网站 收录开始减少,快照停滞

如前所述,百度将重新考虑您的网站. 这时,您肯定会发现网站的某些页面与Internet上的页面相似. 百度会在不考虑您的情况下减少这些页面. 收录的收录,所以很多人发现网站停止收录之后,它会慢慢导致网站和整个收录的减少. 这就是原因. 该页面不是收录,百度对网站的信任度下降了,最终快照将停滞了一段时间.

3. 排名没有波动,访问量正常

当收录减少且快照停滞时,我们最担心的是排名问题,并且我们担心排名会受到影响. 可以肯定这一点,因为文章为采集,这导致了百度对其网站的评估. 这只会影响百度对网站的信任,并不会导致网站的权重降低,因此[k2的关键字排名]不会受到影响.

4. 经过改进,网站 收录仍然有异常

假设我们发现网站为采集后,我们对网站进行了一些改进,并成功避免了网站为采集,那么您的网站将有一个适应期,在整个适应期为: 网站逐渐开始进入收录 文章页面,但是收录并不立即更新文章,它可能在前一天或前天进行了更新. 这些症状将持续约1周,之后收录会逐渐恢复正常,快照也会慢慢恢复.

5. 搜索引擎蜘蛛会爬行,但不会爬行

分析网站的日志,您会发现蜘蛛程序将对通常为采集 文章的页面进行爬网,但很长一段时间后它们将不再爬网. 这可能是因为在搜索引擎蜘蛛的眼中,您的网站的内容全部来自采集,并且Internet上有太多重复的内容. 浪费资源来吸引一个像您这样的小网站,无疑对网站 收录产生了很大的影响.

通常,从事SEO的人都知道搜索引擎蜘蛛将在在线营销搜索引擎的索引链接中执行重复数据删除处理. 实际上,他们已经在检查蜘蛛何时爬行. 当Spider爬行和爬行文件时,它们将执行一定程度的复制内容检测,当在网站促销中以低权重遇到大量重印或抄袭的内容时,极有可能不会继续爬行. 这就是为什么许多网站管理员在检查日志时会发现蜘蛛,但页面从未被爬网的原因. 由于抓取会发现重复的内容,因此它将放弃抓取,而停留在抓取阶段.

6. 排名不会上升,即使上升也会变得不稳定

当您发现自己写了原创 文章时,在收录之后,排名无法上升. 搜索时看到的所有链接都从其他站点重新发布,甚至排名也不稳定. 一天后,排名再次降低. 在这种情况下,您必须仔细检查网站的原创 文章是否长时间处于采集.

7. 隐形功耗降低

这已达到搜索引擎的“续航力极限”. 长期以来采集,网站的收录的排名都不稳定,并且蜘蛛程序每次都无法获得他想要的内容. 您不喜欢的网站将减少为用户讨厌的网站. 这时,百度会将所有之前的排名都降低,甚至将您踢出前100名,也就是降低的权利. 电源降级是网站面临的最严重的问题.

无论您是采集别人的文章还是其他采集您的文章的人,尽管我们的选择方法和目的不同,但过度使用采集的后果是相同的,所以我们必须在采集之前权衡一下是否值得.

网站长时间处于采集的情况下,会出现这一系列现象,因此,当您自己的网站中存在某些此类现象时,您应该首先找出原因是[ k5]我每天都会更新,以供他人采集使用.

2. 如果我采集已经很长时间了该怎么办?

如果您的网站已经处于长期采集的境地,那么作为搜索引擎优化人员,您必须找到一种解决方法. 当然,如果其他人想要采集您的文章,则您不能完全禁止该禁令,以阻止其他人使用采集,因此我们可以做的就是对自己进行一些更改.

1. 增加页面重量

提高页面的重量可以从根本上解决此问题. 我们都知道,像A5和Chinaz这样的网站每天都会是采集,但这根本不影响A5和Chinaz 网站. 收录的原因是它们的重量足够高,当其他人网站与他们出现相同的文章时,蜘蛛会默认使用文章作为原创的来源.

因此,我们必须增加文章页面的权重,并为此页面做更多的外部链接.

2. 合理使用Rss

也有必要开发这种功能. 更新网站 文章后,请尽快让搜索引擎知道并主动对其进行攻击. 这对收录非常有用. 而且Rss还可以有效地增加网站的流量,可以说用一块石头杀死了两只鸟.

3. 详细说明并限制机器的采集

手动采集没什么. 如果没有人使用工具来计时并且大量采集您的网站 文章确实很头疼,那么我们应该对页面的详细信息进行一些处理,至少可以防止机器[k1 ]. 例如,页面不应设计得过于传统和流行. Url的文字应该可以更改,并且不应是默认的覆盖图和其他设置;图像应尽可能加水印,以增加其他人采集 文章后处理的时间成本.

4. 采集更新的文章主要与他的网站

有关

其他采集和我们的文章是因为它们也需要我们更新内容,因此,如果我们更新与网站相关的信息,我们经常会在采集中插入我们的网站名称],我们认为文章对他们没有太大的意义. 这也是避免采集的好方法.

5. 搜索引擎算法的改进

毕竟,要保持良好的心态,百度还推出了一种飓风算法来打击惩罚. 原创 文章被采集窃. 这是一个难题. 技术一直在改进和优化,而Google搜索引擎无法完美解决. 问题是,最好自己动手网站,以便文章可以达到第二收录的最佳策略.

文章通常是采集,肯定会对我们产生影响,因此我们应该避免使用它,让我们的网站内容在互联网上是唯一的,并改善百度对我们的待遇网站信任级别使我们的优化工作更加顺畅.

摘要:

我们回到搜索引擎工作原理的本质,即满足和解决用户搜索结果时的需求. 换句话说,无论您的文章是怎么来的(采集 文章也可以解决用户需求),并且布局良好,逻辑表达式清晰,可读性强,并且与搜索匹配引擎用户提供有价值的内容来解决用户搜索需求的本质?所以有排名.

但是,采集的这种行为是不可行的. 如果您想长时间给采集更好的排名,那肯定会引起原创作者的厌恶. 这种情况继续存在,网站管理员开始制作采集内容或or窃内容,而不是制作原创 文章或伪原创 文章. 因此,当用户使用搜索引擎进行查询时,他们解决用户需求的能力将越来越弱.

因此,为了创建一个更好的Internet内容生态系统,搜索引擎将继续推出与采集个网站作斗争的算法,并对原创个内容给予某些排名首选项,以鼓励原创个作者创建更多内容质量内容.