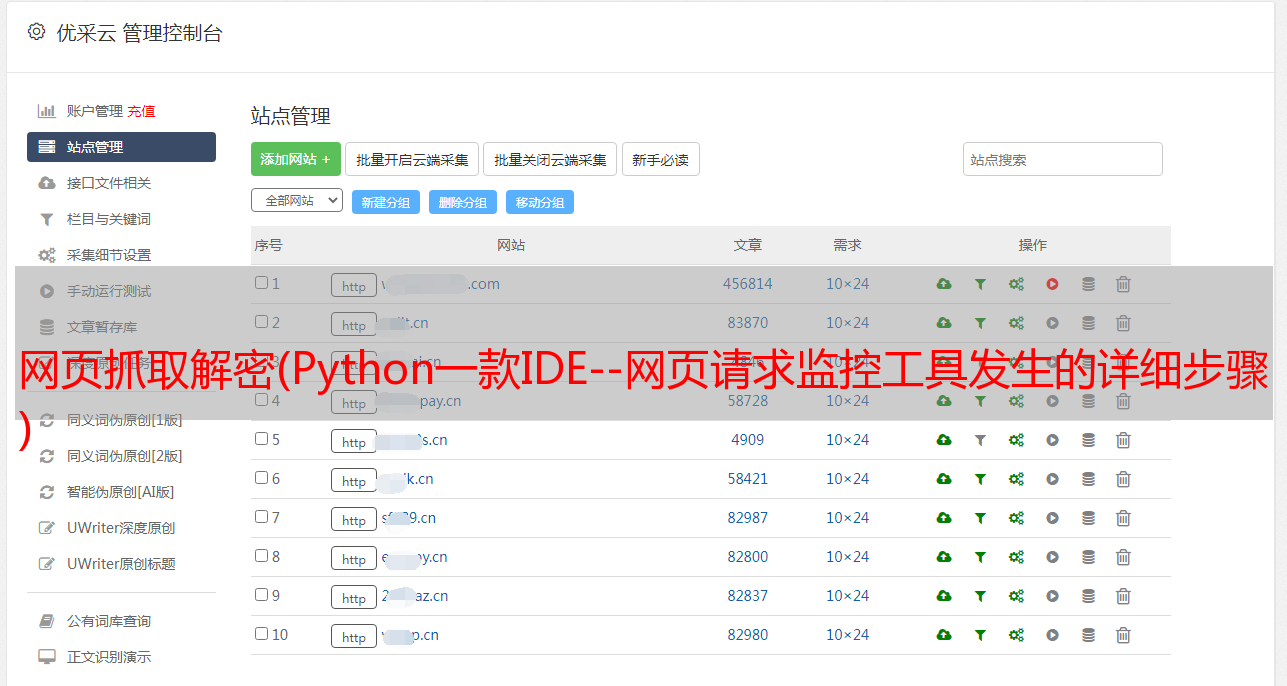

网页抓取解密(Python一款IDE--网页请求监控工具发生的详细步骤 )

优采云 发布时间: 2021-10-06 06:26网页抓取解密(Python一款IDE--网页请求监控工具发生的详细步骤

)

1)首先,客户端和服务器需要建立连接。只需单击某个超链接,HTTP 工作就会开始。

2) 连接建立后,客户端向服务器发送请求。请求的格式为:统一资源标识符(URL)、协议版本号和 MIME 信息,包括请求修饰符、客户端信息和可能的内容。

3) 服务器收到请求后,会给出相应的响应信息。格式为状态行,包括信息的协议版本号、成功或错误码,MIME信息包括服务器信息、实体信息和可能性。内容。

4)客户端接收服务器返回的信息,通过浏览器显示在用户的显示屏上,然后客户端与服务器断开连接。

如果上述过程的某个步骤发生错误,则将导致错误的信息以显示屏幕输出的方式返回给客户端。对于用户来说,这些过程都是由HTTP本身完成的,用户只需要点击鼠标,等待信息显示出来。

二:了解Python中的urllib库

Python2系列使用的是urllib2,Python3之后都会集成到urllib中;我们需要学习的是几个常用的函数。详情可上官网查看。

三:开发工具

Python自带一个编译器——IDLE,非常简洁;PyCharm - 具有良好交互性的 Python IDE;Fiddler - 一个网页请求监控工具,我们可以使用它来了解用户触发网页请求后发生的详细步骤;

简单的网络爬虫

代码

'''

第一个示例:简单的网页爬虫

爬取豆瓣首页

'''

import urllib.request

#网址

url = "https://www.douban.com/"

#请求

request = urllib.request.Request(url)

#爬取结果

response = urllib.request.urlopen(request)

data = response.read()

#设置解码方式

data = data.decode('utf-8')

#打印结果

print(data)

#打印爬取网页的各类信息

print(type(response))

print(response.geturl())

print(response.info())

print(response.getcode())

结果

截取的部分结果如下: