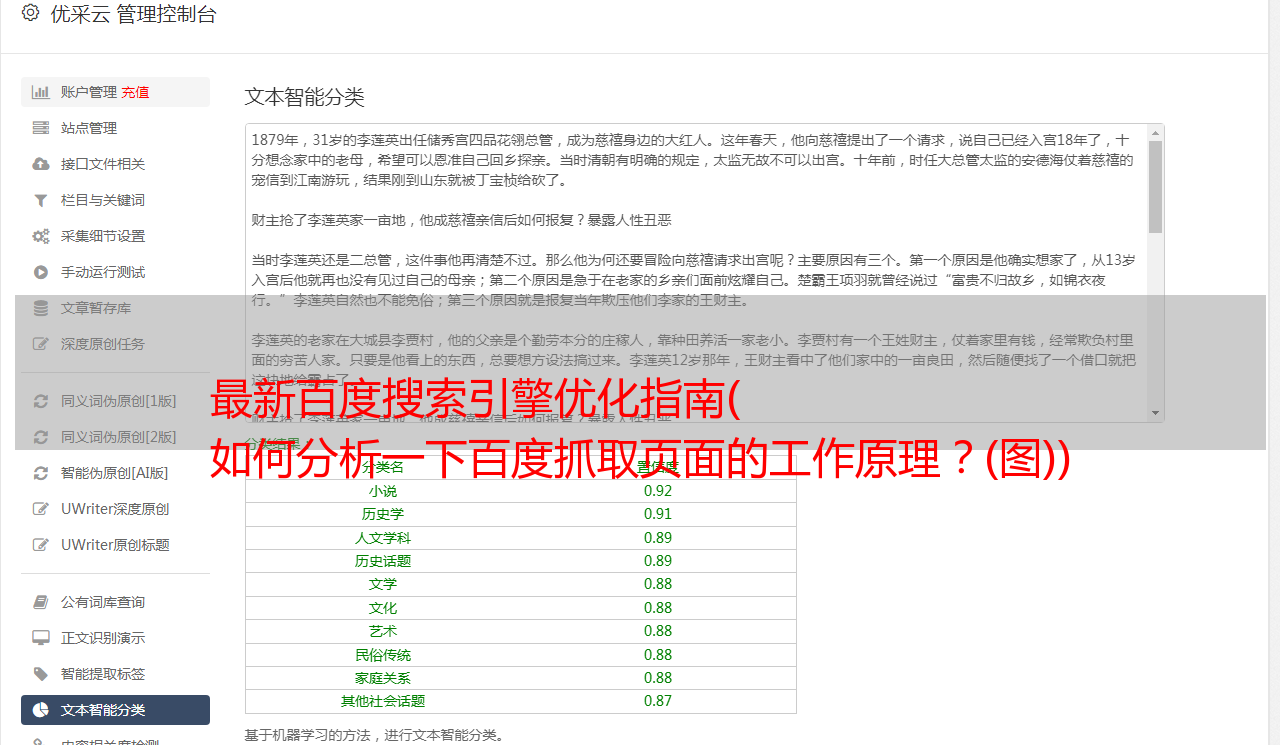

最新百度搜索引擎优化指南( 如何分析一下百度抓取页面的工作原理?(图))

优采云 发布时间: 2021-10-05 00:00最新百度搜索引擎优化指南(

如何分析一下百度抓取页面的工作原理?(图))

立即注册,结交更多朋友,享受更*敏*感*词*,让您轻松畅玩NB5社区。

需要登录才能下载或查看,还没有账号?开放注册

X

关于伪原创,为什么不提倡呢?下面我们试着从程序的角度来分析一下百度抓取页面的工作原理。人们编写复杂的程序,因此一些基本原则是相同的。百度工程师写了一个爬虫程序叫spider,可能是C语言写的,也可能是JAVA写的,反正就是爬网页的功能。该函数通过URL到达网站的内容页面,将网站的内容抓取到服务器中的数据库中。首先过滤一些敏感词(在抓取页面的过程中不能过滤词)。比如一些不合法的词如“*敏*感*词*、*敏*感*词*、*敏*感*词*”等,如果出现这些词,整个URL将被丢弃,留下主域名,从而导致这个网站的内容 被判定为非法。如果通过上述检测,则进行内容检测,将抓取到的内容与互联网上已经存在的信息进行比较。如果没有重复信息,则判断此文章为原创 ,给5星权重(没有这样的说法,方便我们理解和定制)。如果有部分重复,它会被评为3星,如果有更多的重复,评级会更低。整个检测过程非常复杂繁琐。可想而知百度的服务器算力有多么强大!判断这个文章是原创,给5星权重(没有这样的说法,方便我们理解和定制)。如果有部分重复,它会被评为3星,如果有更多的重复,评级会更低。整个检测过程非常复杂繁琐。可想而知百度的服务器算力有多么强大!判断这个文章是原创,给5星权重(没有这样的说法,方便我们理解和定制)。如果有部分重复,它会被评为3星,如果有更多的重复,评级会更低。整个检测过程非常复杂繁琐。可想而知百度的服务器算力有多么强大!

那么百度已经判断了文章的原创的程度,如何判断文章的相关性?通过分词技术,提取网站中的部分关键词,与现有的行业相关关键词进行匹配。如果匹配成功,则判断您网站属于该行业 相关内容放置在相应服务器上。匹配度越高,评分越高。

关于文章的专业性,笔者假设是用户自行判断。通过用户浏览行为的粘性,判断这个文章的专业度与用户体验有很大关系。

所以,要认真、诚实原创!