抓取网页数据工具(网络爬虫工具越来越工具)

优采云 发布时间: 2021-10-04 12:35抓取网页数据工具(网络爬虫工具越来越工具)

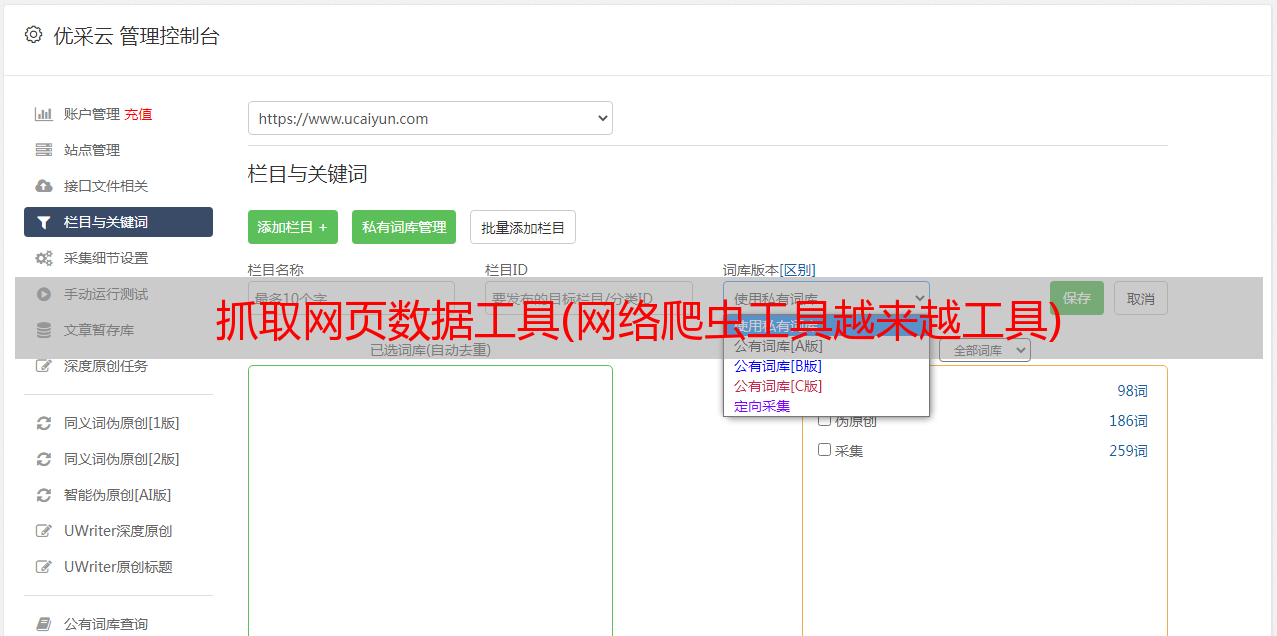

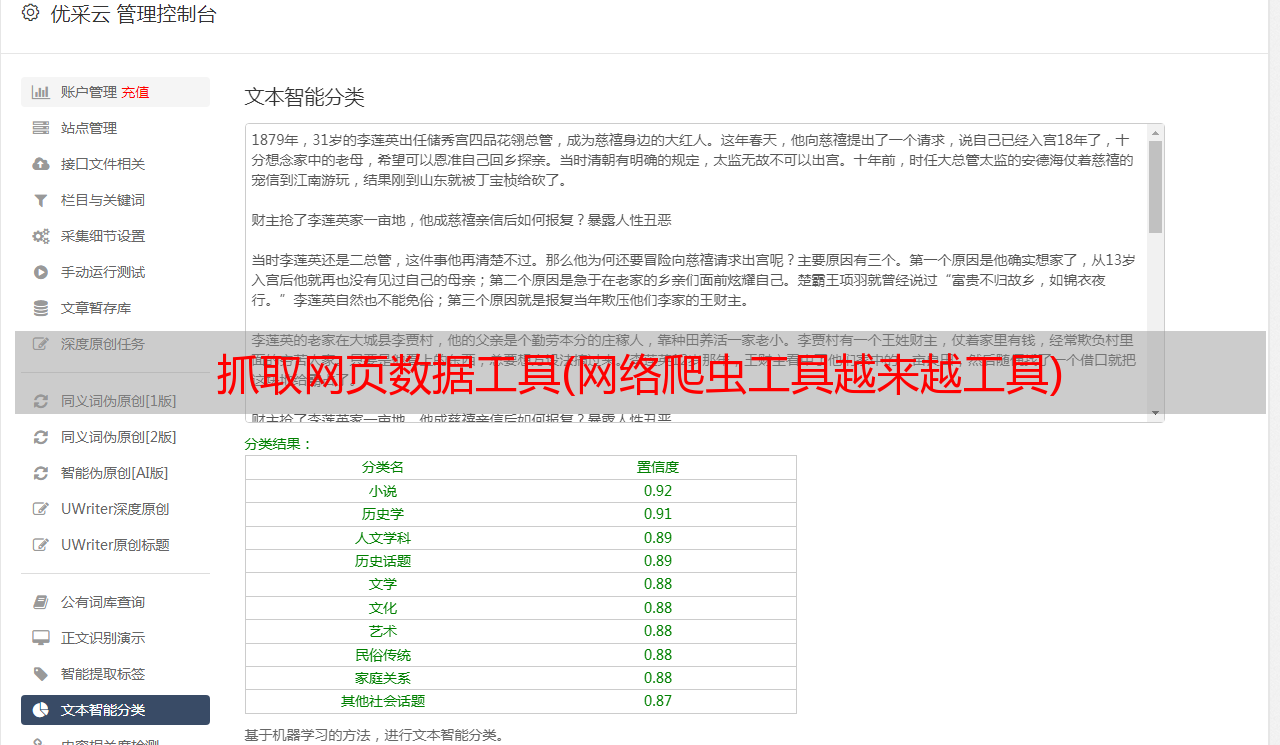

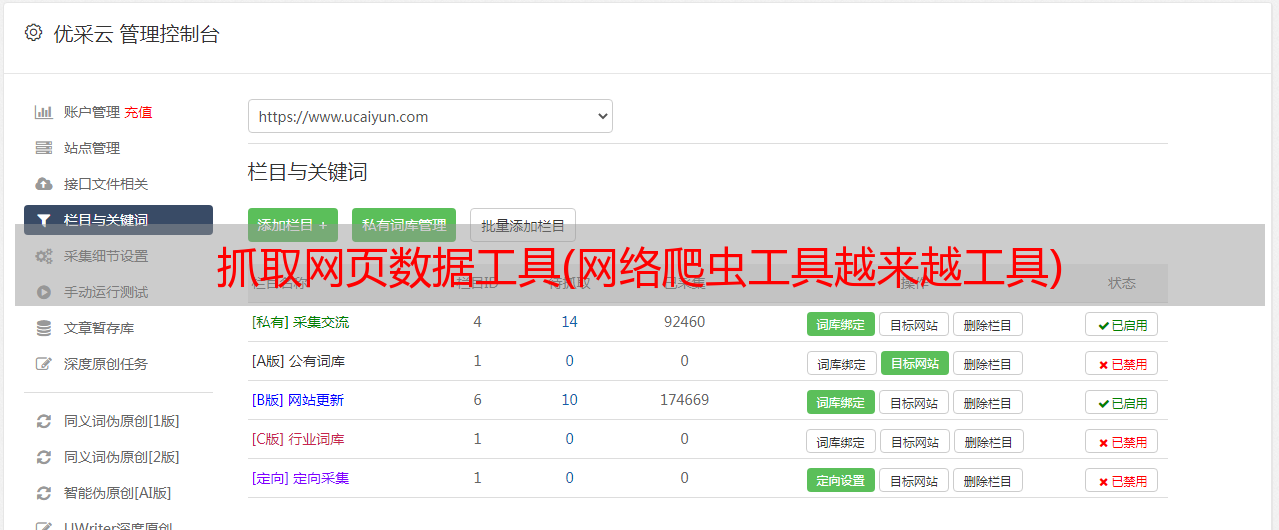

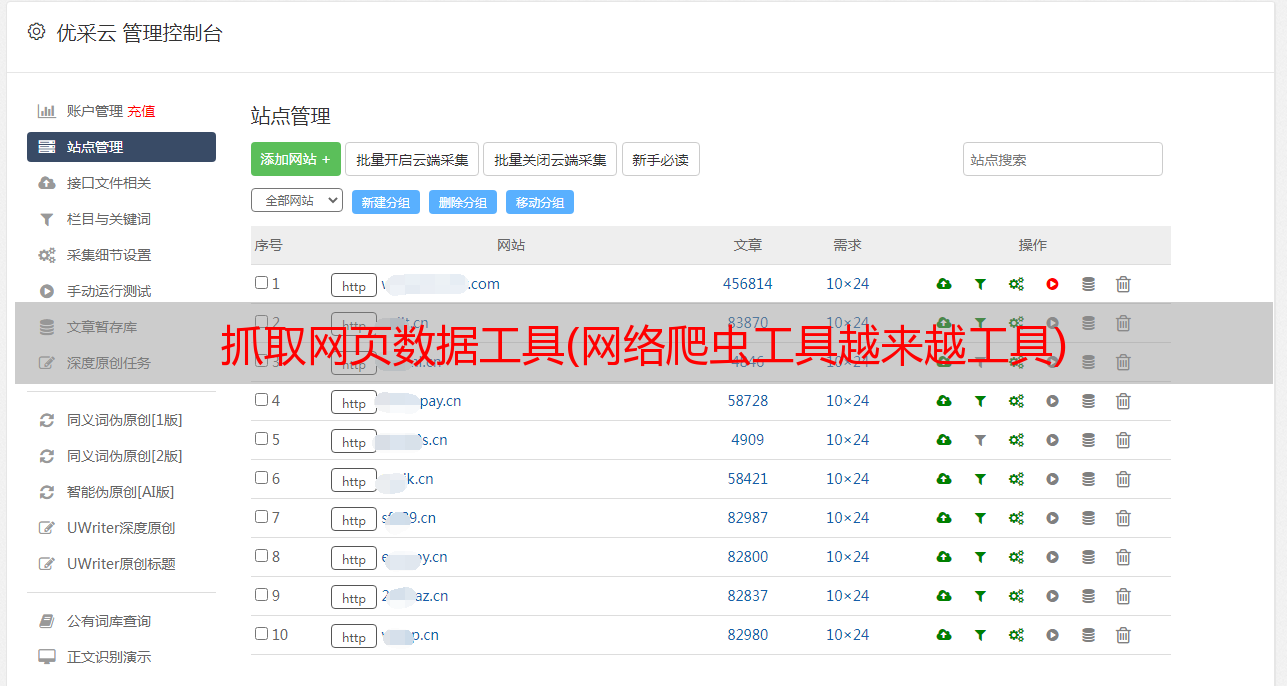

网络爬虫广泛应用于许多领域。它的目标是从 网站 获取新数据并将其存储以便于访问。网络爬虫工具越来越广为人知,因为它可以简化和自动化整个爬虫过程,让每个人都可以轻松访问网络数据资源。

1. Octoparse

Octoparse 是一款免费且功能强大的 网站 爬虫工具,用于从 网站 中提取所需的各种类型的数据。它有两种学习模式——向导模式和高级模式,所以非程序员也可以使用它。您可以下载网站的几乎所有内容,并以EXCEL、TXT、HTML或数据库等结构化格式保存。通过定时云抽取功能,您可以获得网站的最新信息。提供IP代理服务器,不用担心被攻击性的网站检测到。

总之,Octoparse 应该可以满足用户最基本或者高端的爬虫需求,不需要任何编码技能。

2. Cyotek WebCopy

WebCopy 是一款免费的爬虫工具,允许将部分或完整的网站 内容本地复制到硬盘上以供离线阅读。在将网站的内容下载到硬盘之前,它会扫描指定的网站,并自动重新映射网站中的图像和其他网络资源的链接以匹配它们的本地路径。还有其他功能,例如下载副本中收录的 URL,但不抓取它。您还可以配置域名、用户代理字符串、默认文档等。

但是,WebCopy 不包括虚拟 DOM 或 JavaScript 解析。

3. HTTrack

作为一款网站免费爬虫软件,HTTrack提供的功能非常适合将整个网站从网上下载到您的PC上。它提供了适用于 Windows、Linux、Sun Solaris 和其他 Unix 系统的版本。它可以镜像一个或多个站点(共享链接)。在“设置”下决定下载网页时同时打开的连接数。您可以从整个目录中获取照片、文件、HTML 代码,更新当前镜像 网站 并恢复中断的下载。

此外,HTTTrack 提供代理支持以最大限度地提高速度并提供可选的身份验证。

4. 左转