seo网站日志分析工具(如何分析日志为SEO服务呢?——日志源文件)

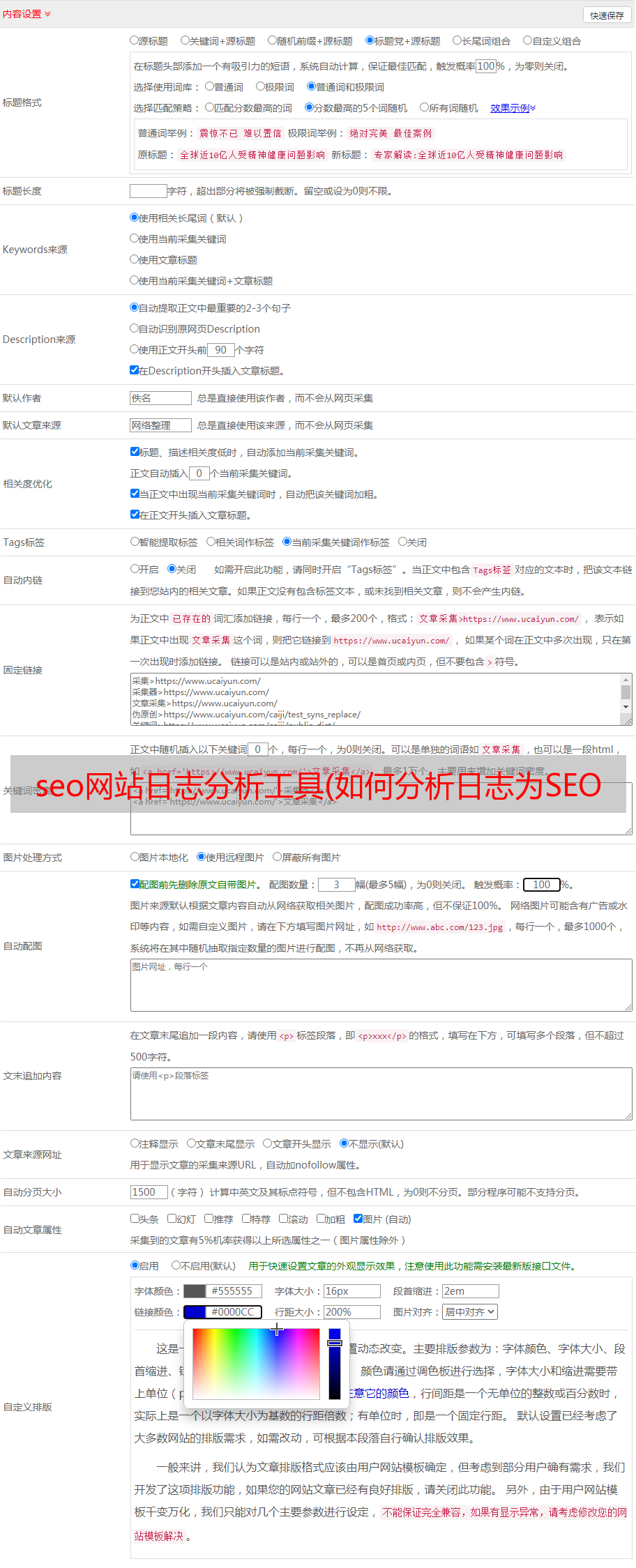

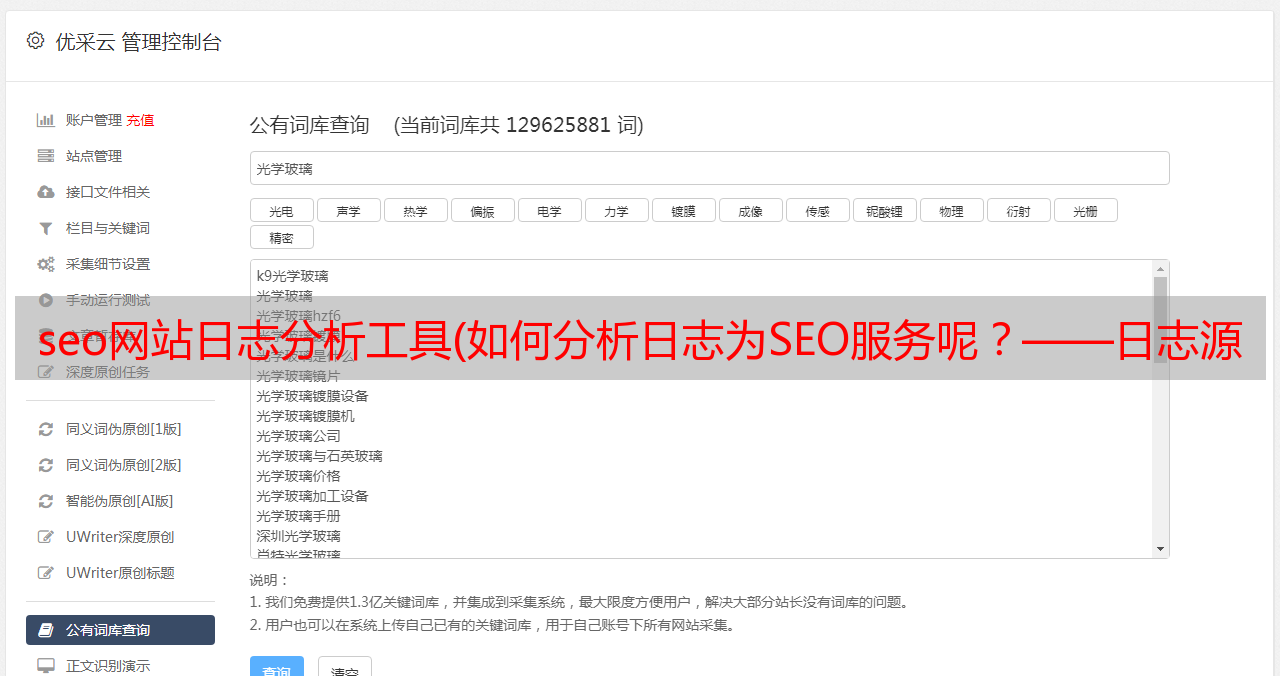

优采云 发布时间: 2021-10-01 12:14seo网站日志分析工具(如何分析日志为SEO服务呢?——日志源文件)

什么是日志文件?

日志文件收录服务器上发生的所有行为的记录。对于SEO来说,最有用的是搜索引擎爬虫和用户访问行为。日志源文件如下所示:

乍一看,是不是觉得乱七八糟,别慌,我们会仔细分解里面的每一个参数。

例如

50.56.92.47 – – [01/March/2018:12:21:17 +0100] “GET” – “/wp-content/themes/esp/ help.php” – “404” “-” “Mozilla/5.0(兼容;Googlebot/2.1;+)” – –

每个日志收录:IP、访问日期、获取方式、返回码、User-Agent、URL、主机等参数

日志的重要性

因为日志是搜索引擎访问和抓取网站的唯一渠道。虽然搜索引擎站长背景、第三方爬虫、搜索说明可以给你一些参考,但只有日志文件才能给你最全面、最详细的信息。

如何分析SEO服务的日志?

对SEO分析日志文件的帮助如下:

1.判断哪些页面可以被爬虫抓取,哪些页面不能

2.查看搜索引擎访问过的页面的返回码,尤其是分析时返回302和404的页面

3.找出爬虫问题及背后的原因(网站导航,内部链结构)

4.定位搜索引擎经常抓取的页面以及原因

5.分析爬虫爬取的资源是否有浪费

如何获取日志文件?

可以直接从服务器下载,根据需要选择相应的时间段。一些网站 一周的日志文件足以进行分析,而一些网站 需要一个月或更长时间的原创数据。下载前最好和运维人员聊一聊,日志是否收录多个域名和http协议的数据。

使用什么工具来分析日志文件?

可以用excel进行分析,下次写个相关的文章。目前国外分析日志的工具有Screaming Frog和Log File Analyser、Splunk、GamutLogViewer,国内的光年分析工具也不错。

分析日志的具体步骤

A. 用于寻找爬虫的资源在哪里?

首先什么叫做爬虫资源,谷歌曾经给过一个定义:“Googlebot 可以抓取(crawl rate)和愿意抓取(crawl demand)的网址数”

换句话说,爬虫资源就是搜索引擎每次爬取的网站页面的数量,爬取多少与网站的权重和内链的权重有关。

另外需要指出的是,爬虫资源有时会浪费在不相关的页面上。这时候如果输出新的内容,说明爬虫资源已经耗尽,搜索引擎无法使用收录。这也是监控爬虫日志的一个重要功能,可以找出资源浪费在哪里。

优化爬虫资源配置,让搜索引擎更好的抓取网站核心页面。

影响爬虫资源的因素

过多的低质量页面会影响爬虫资源的分配。低质量页面包括但不限于:

1.多个过滤器和参数过多的页面

2. 重复内容页面

3.被劫持的页面

4. 低质量和垃圾邮件内容页面

允许爬虫爬取这些页面是没有意义的。反而会挤压真正高价值页面的爬取资源,导致优质内容无法及时被搜索引擎收录和排名。

B. 解决SEO技术问题

通过分析日志文件,可以更好的定位和解决以下问题:

特定目录的爬取频率,例如:商品页、列表页、文章页等。

目标搜索引擎的所有爬虫都访问过网站吗?

哪些页面有抓取问题,去检查这些返回码为 3xx、4xx 和 5xx 的页面

日志分析实际案例

这是screafrog最近为一个客户做的日志分析

从日志中发现,谷歌经常抓取一些奇怪的页面。爬取的前15个页面大部分都是302重定向的页面,或者是404打不开的页面。

所以建议客户处理一下这些跳转和参数页面,禁止爬虫通过Robots抓取,更新跳转状态,解决软404问题(打开的页面是404页面,但是http返回码是200) 做了这些动作后,谷歌对这个网站的抓取效率确实有了很大的提升,对收录和排名都有积极的影响。