搜索引擎优化原理(衡阳搜索引擎优化爬行与抓取的工作原理(一))

优采云 发布时间: 2021-09-22 12:00搜索引擎优化原理(衡阳搜索引擎优化爬行与抓取的工作原理(一))

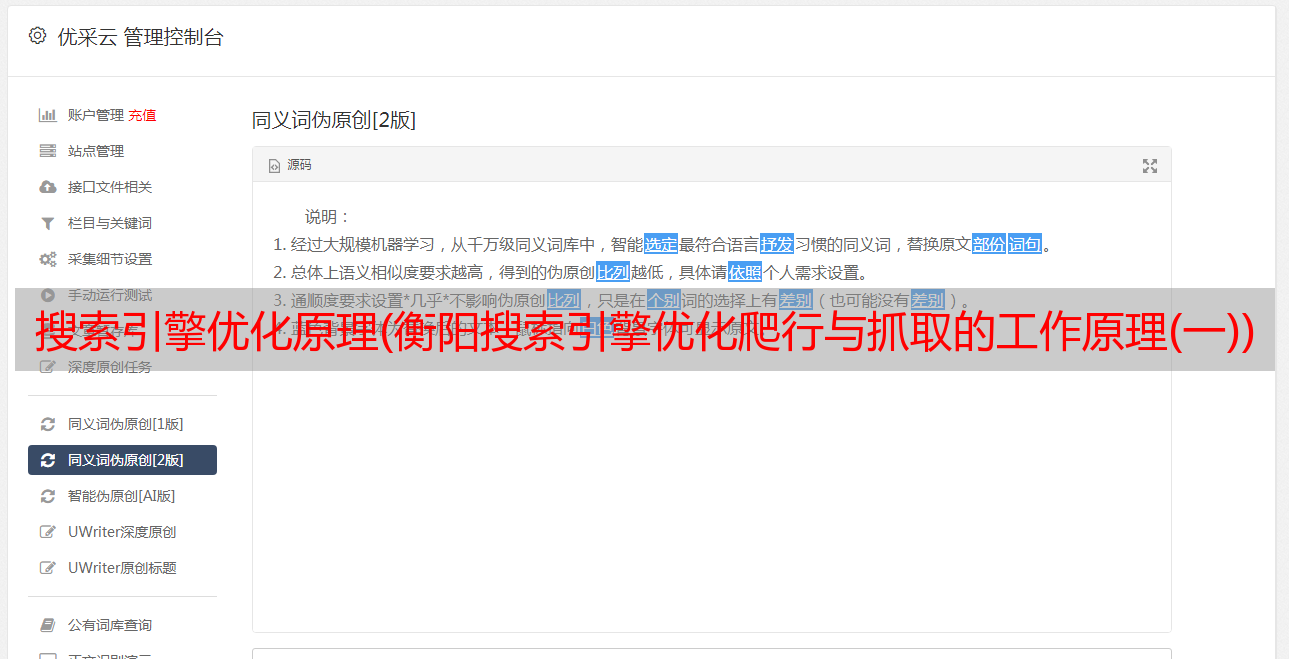

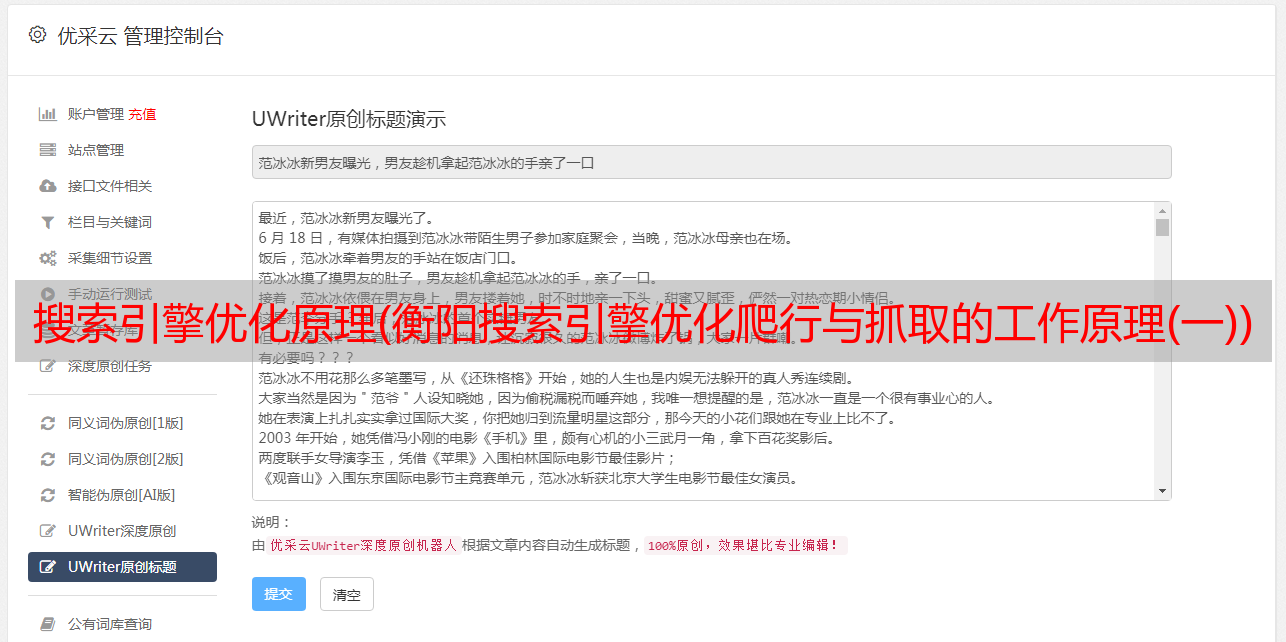

衡阳搜索引擎优化的工作原理非常复杂。大致可以分为三个阶段:爬行和爬行、预处理和排名,如图1-4所示。详情如下:

图1-4搜索引擎的工作原理

一,。衡阳搜索引擎优化爬行与爬行

爬行和爬行是搜索引擎的第一步,即在互联网上查找和采集网页信息,提取信息,建立索引数据库。“抓取”的具体内容包括以下几点

(1)搜索引擎蜘蛛)

搜索引擎用来抓取和访问网页的程序被称为“蜘蛛”或网络机器人,这是一个程序或脚本,根据一定的规则自动抓取互联网信息

蜘蛛的角色是浏览互联网上的信息,然后将所有这些信息抓取到搜索引擎服务器,然后建立索引库。我们可以将蜘蛛与用户进行比较,然后用户访问网站并将网站内容保存到自己的计算机中

与浏览器一样,搜索引擎爬行器也有代理名称来表示其身份。网站管理员可以在网站日志文件中看到搜索引擎的特定代理名称,从而知道哪些搜索引擎爬虫抓取了他们的网站页面。常见的搜索引擎蜘蛛包括百度蜘蛛、雅虎中国蜘蛛、雅虎英语蜘蛛、谷歌蜘蛛、微软必应蜘蛛、搜狗蜘蛛、搜索蜘蛛、有道蜘蛛

(2)tracking link)

为了抓取更多的页面,搜索引擎蜘蛛会跟踪页面上的链接并从一个页面抓取到下一个页面,就像蜘蛛在蜘蛛网上抓取一样。整个互联网由互联的网站和页面组成。从理论上讲,爬行器可以从任何页面沿着链接爬行到Internet上的其他页面

由于网站和页面链接结构极其复杂,爬行器需要采用某些爬行策略来爬升互联网上的所有页面。搜索引擎爬行器的爬行策略分为两种,一种是深度优先搜索,另一种是广度优先搜索

① 深度优先搜索

深度优先搜索意味着爬行器沿着找到的链接爬行,直到没有其他链接,然后返回到第一页并沿着另一个链接爬行

图1-5显示了一个无向图。如果爬行器从点a开始爬行(访问顺序不是唯一的,第二个点可以是点C或点B和D),则获得以下访问过程:a→ B→ E.此时,没有下一个方法,它将返回点a,然后继续下一个访问过程:a→ C→ F→ H→ G→ D(没有办法,最后回到a)。返回点a后,在点a没有未访问的相邻节点。此搜索结束

② 广度优先搜索

广度优先搜索意味着,当爬行器在一个页面上找到多个链接时,它不会直接沿着一个链接爬行,而是沿着页面上的所有第一级页面爬行,然后沿着第二级页面上找到的链接爬行到第三级链接。如图1-6所示,爬行器从a页爬行到B、C和d页,直到a页上的所有链接爬行完链接后,从B页上的链接爬行到E和F页

图1-5深度优先搜索示例

图1-6宽度优先搜索示例

在深度优先搜索算法中,首先扩展深度较大的节点。如果将算法改为根据搜索中的节点级别进行搜索,当该层的节点未被搜索和处理时,较低的节点不能被处理,即深度较小的节点先展开,即第一个生成的节点可以先展开。这种搜索算法称为广度优先搜索算法

从理论上讲,蜘蛛可以爬行一个完整的网络,无论是深度优先还是广度优先,只要给它们足够的时间。然而,在实际工作中,spider的宽带资源和时间是有限的,因此不可能爬到所有页面。深度优先和广度优先通常是混合的,因为它们可以照顾更多的“K14用户”(广度优先),它也可以考虑一些网站页面(深度优先),并且还考虑页面权重、网站量表和外部链接

等因素。

(3)吸引蜘蛛

虽然从理论上讲,蜘蛛会抓取所有的网页,但事实上,由于很多因素的影响,它们无法抓取所有的网页。因此,SEO人员想要网站有更多的网页成为收录,他们必须找到吸引蜘蛛抓取的方法。那么什么因素可以吸引蜘蛛抓取呢

·网站和页面权重。一般来说,质量高、时间长的网站的权重相对较高,搜索引擎蜘蛛爬行更频繁。在网站上爬行的页面深度相对较高,收录有很多网页

·页面的更新频率。蜘蛛每次爬行时都会存储页面数据。如果发现页面内容与第一次收录时间完全相同,则表示页面未更新,蜘蛛不会经常抓取。页面内容更新频繁,蜘蛛会更频繁地访问页面当新链接出现在页面上时,蜘蛛会更快地跟踪和捕获

·网站的原创内容对百度蜘蛛很有吸引力,这也是搜索引擎蜘蛛每天都需要的。对于原创文章的写作,站长需要有敏锐的观察和写作技巧,原创内容应该有吸引力,不能陈词滥调或含糊不清,否则他将失去对蜘蛛的吸引力

·网站map网站map就像一个灯塔,只有清晰的灯塔才能指引蜘蛛的路线。如果网站map清晰,很容易吸引蜘蛛爬行。相反,如果网站内部链接凌乱,蜘蛛经常迷路,蜘蛛很少爬行,这不利于捕获网站页面

(4)地址库)

为了避免爬行器爬行和重复爬行网址,搜索引擎会建立一个地址库,记录已找到但尚未捕获的页面和已捕获的页面。地址库中的URL主要来自以下四个方面:

·手动输入*敏*感*词*网站

·蜘蛛抓取页面后,从HTML解析新的链接URL,并将其与地址库中的数据进行比较。如果地址库中没有这样的URL,它将存储在要访问的地址库中

·网站管理员通过搜索引擎页面提交表单提交的网站地址

·站长通过XML网站map和站长平台提交的网址

爬行器根据重要性从要访问的地址库中提取URL,从访问井中抓取页面,然后从要访问的地址库中删除URL并将其放入已访问的地址库中

一般来说,搜索引擎会为站长提供一个提交网址的表单。但是,这些提交的网址只存储在地址库中。是否收录取决于页面的重要性。搜索引擎收录的大部分页面都是通过蜘蛛跟踪链接获得的。可以说提交的地址ges基本上是无用的,搜索引擎更喜欢跟随他们找到新页面的链接

(5)文件存储)

文件存储意味着搜索引擎爬行器捕获的数据存储在原创页面数据库中。页面数据与用户浏览器获取的HTML完全相同。每个URL都有一个唯一的文件号

(6)爬行检测内容)

众所周知,重复数据消除处理将在搜索引擎的索引链接中进行。事实上,它是在蜘蛛爬行时被检测到的。当蜘蛛爬行并抓取文件时,它会在一定程度上检测到复制的内容。当它在网站上遇到大量重印或复制的内容且权重较低时,it很可能不会继续爬行

衡阳搜索引擎优化,所以对于新站点,不要采集和复制其他网站内容。这也是为什么很多站长在查看日志时会发现蜘蛛,但页面不会被捕获。因为蜘蛛在发现重复内容时会放弃爬行,所以蜘蛛只停留在爬行阶段