云端采集器 这些不用编程的爬虫工具,你一定要知道

优采云 发布时间: 2020-08-25 22:01云端采集器 这些不用编程的爬虫工具,你一定要知道

随着Scrapy等框架的流行,利用编程语言写爬虫已然成为一种潮流,好像每位互联网人就会一点爬虫。

大神借助爬虫将中学所有重要的在线服务集合成了一套JSON API ,然后开发成了App;

爬了知乎12万用户的头像,把长得象的头像放到一起,方便浏览:然后采集了知友们的点击,预测下来这是大家(平均)最喜欢的人长的样子;

网友写了个爬虫按标签爬出来豆瓣所有的书,按现有标签来分类检索豆瓣图书,并按分数从高到低排序。

......

这些有趣的故事均来自知乎上的一个热门话题:利用爬虫技术能做到什么太酷太有趣很有用的事情?

人人就会爬虫

初期的互联网,写爬虫是门技术活,往大的方向说,爬虫技术是搜索引擎的组成部分。

随着互联网技术的发展,写爬虫的门槛一降再降,一些编程语言甚至直接提供爬虫框架,例如python的Scrapy框架,它们使写爬虫走进“寻常百姓家”。

我们早已发觉,写爬虫是一件炫目的事情,但即便是这样,学习爬虫依然有一定的技术门槛。

当前的主流爬虫手段是用Python编程,Python的强悍毋庸置疑,但初学者学习Python还是须要一两个月时间的。

有没有一些更简单的爬取数据方式呢?答案是有的。

一些可视化的爬虫工具通过策略来爬取特定的数据, 虽然没有自己写爬虫操作精准,但是学习成本低好多,下面就来介绍几款可视化的爬虫工具。

国内工具

01 Microsoft Excel

首先教你们一个用Excel爬取数据的方式,这里用的Microsoft Excel 2013版本,下面*敏*感*词*开始教学~

(1)新建Excel,打开它,如下图所示

(2)点击“数据”——“自网站”

(3)在弹出的对话框中输入目标网址,这里以全省实时空气质量网站为例,点击转入,再导出

选择导出位置,确定

(4)结果如下图所示,怎么样,是不是很赞?

(5)如果要实时更新数据,可以在“数据”——“全部更新”——“连接属性”中进行设置,输入更新频度即可

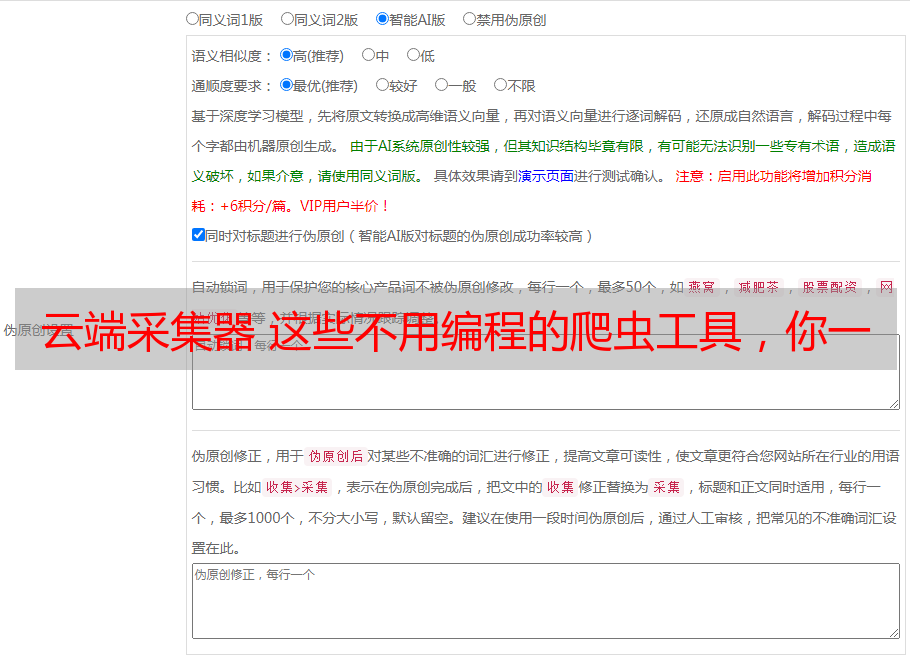

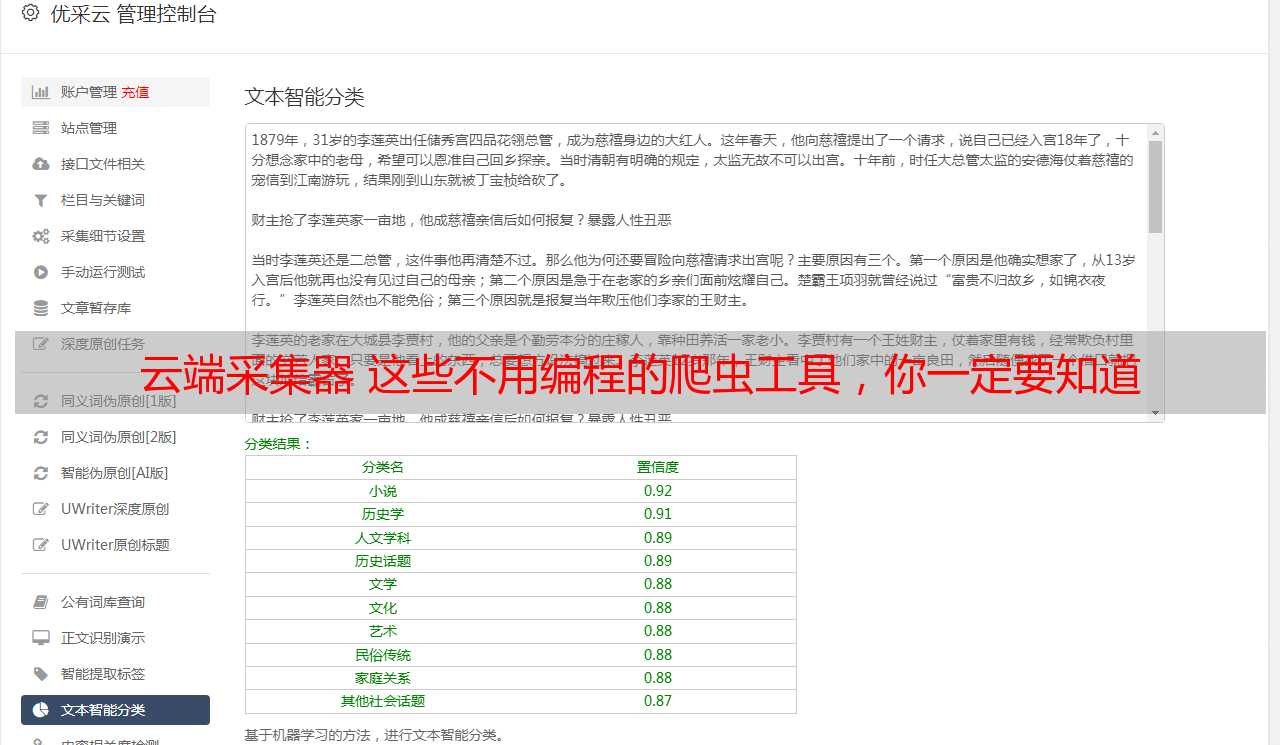

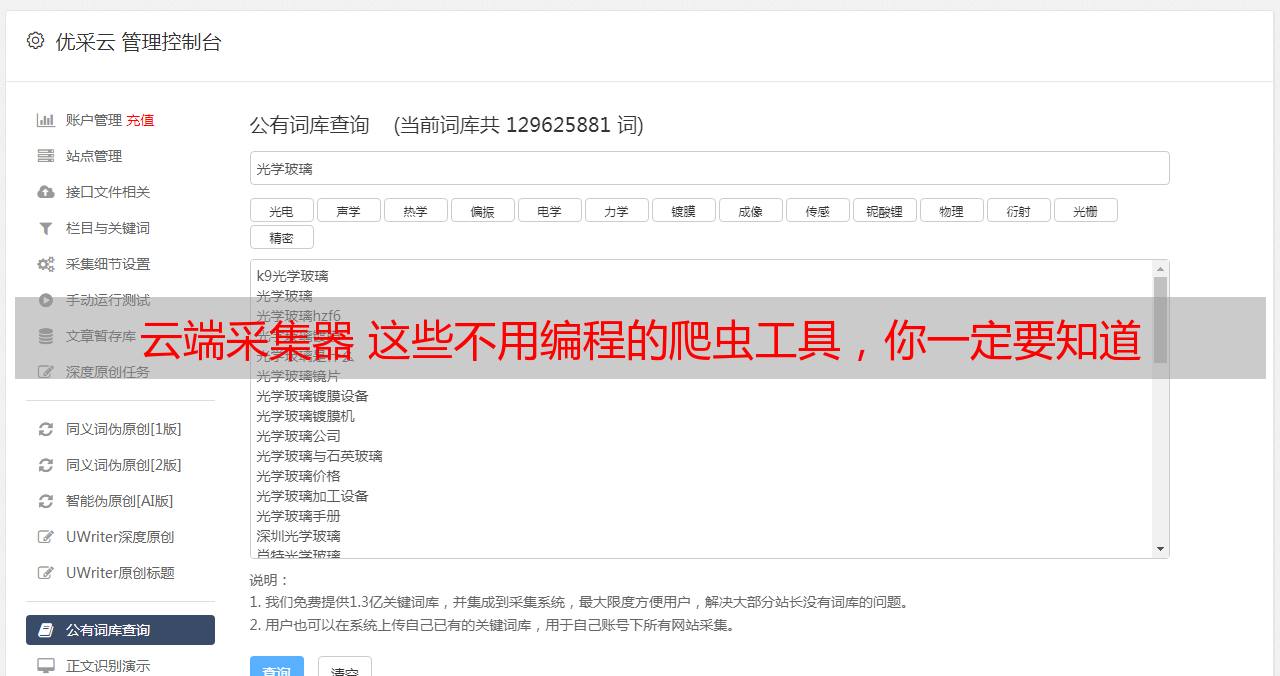

02 优采云

一款可视化免编程的网页采集软件,可以从不同网站中快速提取规范化数据,帮助用户实现数据的自动化采集、编辑以及规范化,降低工作成本。

简易模式采集步骤

是一款适宜小白用户尝试的采集软件,云功能强悍,当然爬虫老鸟也能开拓它的中级功能。

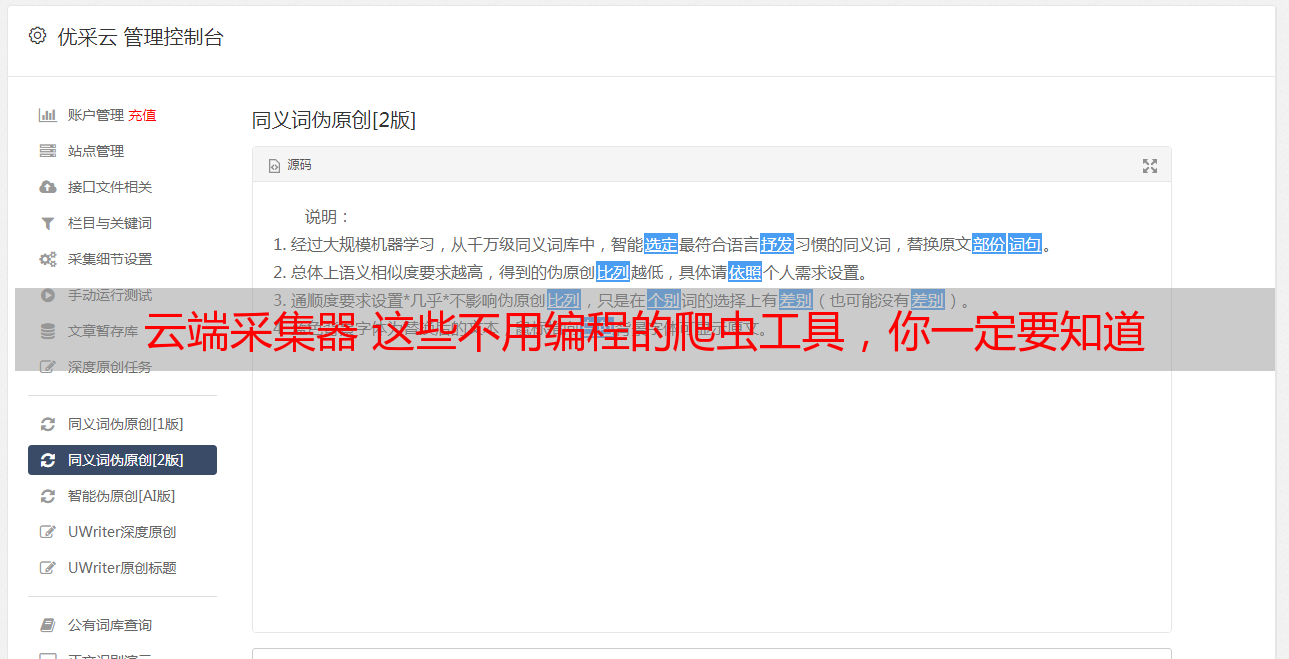

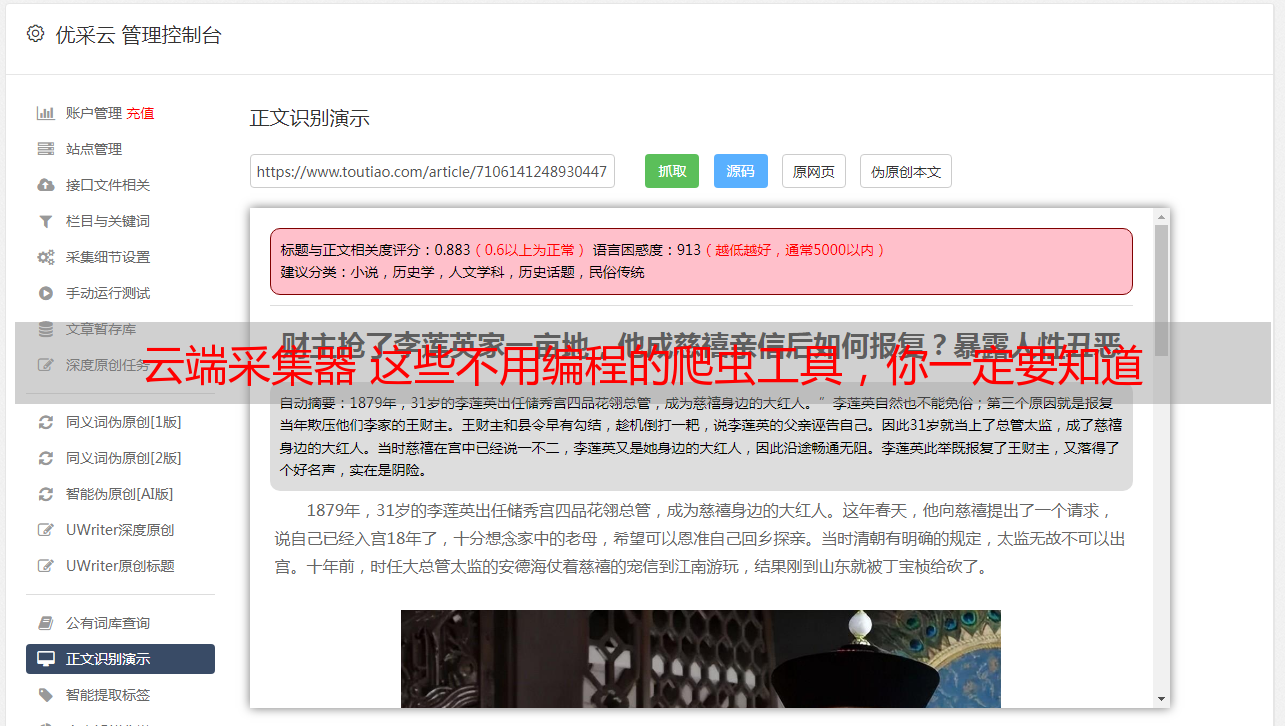

03 优采云

优采云是一款互联网数据抓取、处理、分析,挖掘软件,采集功能健全,不限网页与内容,任意文件格式都可下载,号称能采集99%的网页。

软件定位比较专业并且精准化,使用者须要有基本的HTML基础,能看得懂网页源码,网页结构,但软件提供相应教程,新手也才能学习上手。

04 集搜客

一款简单易用的网页信息抓取软件,能够抓取网页文字、图表、超链接等多种网页元素。

操作较简单,适用于中级用户,功能方面没有很大的特色,后续付费要求比较多。

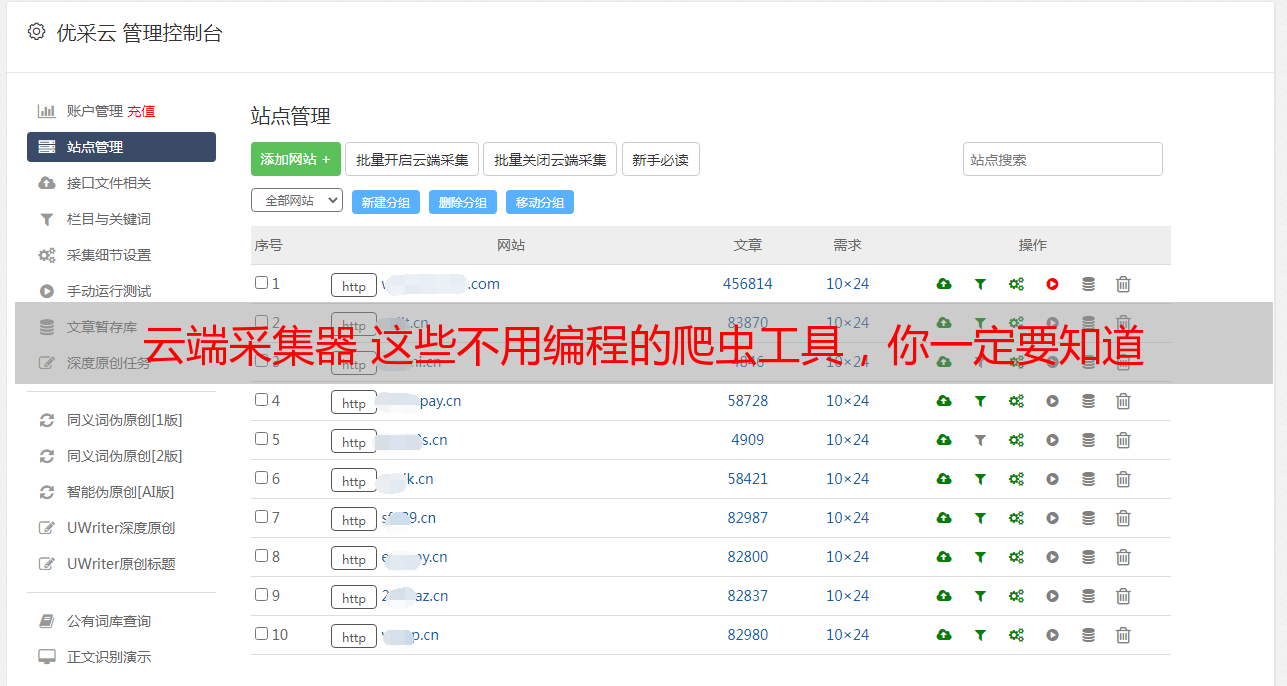

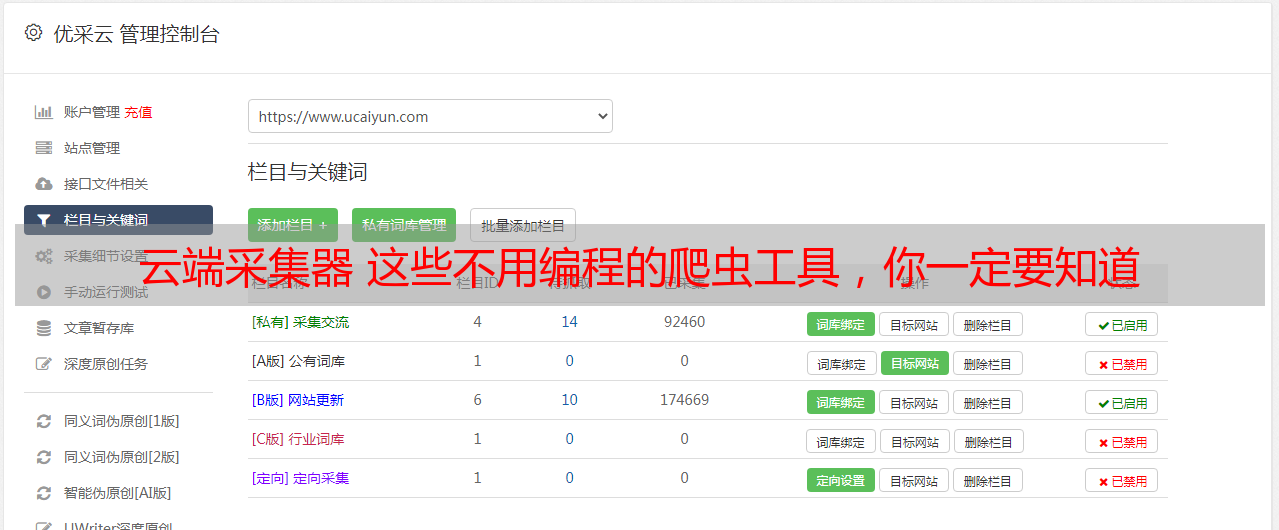

05 优采云云爬虫

一款新颖的云端在线智能爬虫/采集器,基于优采云分布式云爬虫框架,帮助用户快速获取大量规范化的网页数据。

类似一个爬虫系统框架,具体采集还需用户自写爬虫,需要代码基础。

06 优采云采集器

一套专业的网站内容采集软件,支持各种峰会的贴子和回复采集,网站和博客文章内容抓取,分峰会采集器、CMS采集器和博客采集器三类。

专注峰会、博客文本内容的抓取,对于全网数据的采集通用性不高。

国外工具

01 Google Sheet

使用Google Sheet爬取数据前,要保证三点:使用Chrome浏览器、拥有Google帐号、电脑已翻墙。如果这三个条件具备了的话,下面我们就开始吧~

(1)打开Google Sheet网站:/sheets/about/

(2)在首页上点击“转到Google表格”,然后登陆自己的帐号,可以看见如下界面,再点击“+”创建新的表格

新建的表格如下:

(3)打开要爬取的目标网站,一个全省实时空气质量网站pm25.in/rank,目标网站上的表格结构如下图所示

(4)回到Google sheet页面,使用函数=IMPORTHTML(网址, 查询, 索引),“网址”就是要爬取数据的目标网站,“查询”中输入“list”或“table”,这个取决于数据的具体结构类型,“索引”填阿拉伯数字,从1开始,对应着网站中定义的哪一份表格或列表

对于我们要爬取的网站,我们在Google sheet的A1单元格中输入函数=IMPORTHTML("pm25.in/rank","table",1),回车后就爬得数据啦

(5)将爬取好的表格存到本地

是不是觉得超级简单?

02 you-get

这是一个程序员基于python 3开发的项目,已经在github里面开源,支持64个网站,包括优酷、土豆、爱奇艺、b站、酷狗音乐、虾米……总之你能想到的网站都有!

还有一个黑科技的地方,即使是名单上没有的网站,当你输入链接,程序也会猜想你想要下载哪些,然后帮你下载。

当然you-get要在python3环境下进行安装,用pip安装好后,在终端输入“you get+你想下载资源的链接”就可以等着采集资源了。

这里给一个you-get的英文使用说明,按照说明上写的按步骤操作就可以啦。

03 import.io

Import.io是一个基于Web的网页数据采集平台,用户无需编撰代码点选即可生成一个提取器。相比国外大多采集软件,Import.io较为智能,能够匹配并生成同类元素列表,用户输入网址也可一键采集数据。

Import.io智能发展,采集简便,但对于一些复杂的网页结构处理能力较为薄弱。

04 Octoparse

Octoparse是优采云的海外版,采集页面设计简单友好,完全可视化操作,适用于菜鸟用户。

运行并获取数据

Octoparse功能健全,价格合理,能够应用于复杂网页结构,如果你想无需翻墙直采亚马逊、Facebook、Twitter等平台,Octoparse是一种选择。

05 visual web ripper

VisualWebRipper是一个自动化的Web抓取工具,支持各类功能。

它适用于个别中级且采集难度较大的网页结构,用户需具备较强的编程技能。

06 content Grabber

ContentGrabber是功能最强悍的Web抓取工具之一。它更适宜具有中级编程技能的人群,提供了许多强大的脚本编辑,调试界面。允许用户编撰正则表达式,而不是使用外置的工具。

ContentGrabber网页适用性强,功能强悍,不完全为用户提供基础功能,适合具有中级编程技能的人群。

07 Mozenda

Mozenda是一个基于云服务的数据采集软件,为用户提供许多实用性功能包括数据云端储备功能。

适合拥有基础爬虫经验的人群。