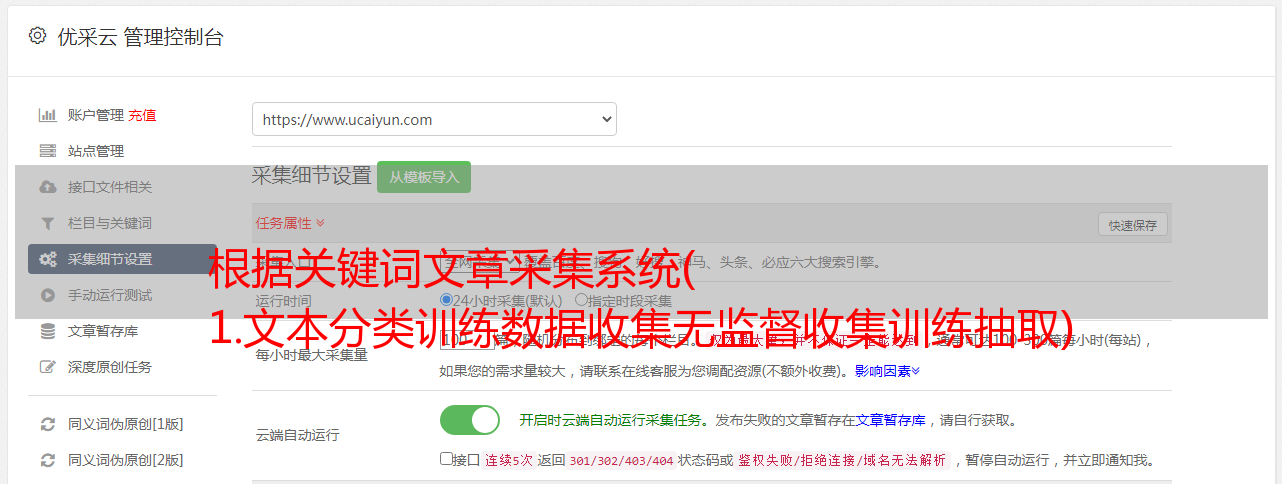

根据关键词文章采集系统( 1.文本分类训练数据收集无监督收集训练抽取)

优采云 发布时间: 2021-09-20 08:071.文本分类训练数据收集无监督收集训练抽取)

1.文本分类培训数据采集

无监督地采集训练数据毫无意义。目前,无监督的方法主要是抓取网页数据,将网页文本标签作为类别,然后使用现有的分类器或相似性度量来决定是否将网页文本添加到训练数据集中。该方法对于训练数据集中有足够数据的类别更为有效。对于数据不多的类别,分类预测的概率值和相似度计算的值都不会太高。因此,大部分爬网文本将被过滤掉,从而失去扩展数据的目的

本文文章给出了一些培训数据的下载地址。如果您发现付费链接或无效链接,请留言并将其删除

白子玉:文本分类语料库

专栏里写了那么多文章文章,但是没有人喜欢上面的文章。我不知道每个人都在做什么。我每天学习算法。我甚至没有语言材料。我该谈什么算法?别告诉我,我只是用成千上万的数据做实验

2.category关键词extraction

对于类别关键词的提取,只有一种有效的方法,那就是统计单词的TF值和IDF值,然后保留高频单词,不加区分地删除单词。当然,人工筛选的过程仍然是必要的。有关实现脚本,请参见

关键词抽取的辅助方法是对类别下的文本进行kmeans聚类,聚类后得到的每个聚类的特征词作为类别关键词. 有关实现脚本,请参见

3.category关键词extension

当你手头有一定数量的类别关键词后,展开关键词以获得更多类别关键词。扩展关键词的方法与扩展训练语料库的思想相同,但这里我们只能使用相似性度量的方法。所采用的技术是单程的。主要步骤是:

(1)vectorize关键词在每个类别内

(2)求和并平均每个类别中的关键词向量,以获得每个类别的向量

(3)使用类别向量来检索单词嵌入模型中最相似的单词。请注意,相似度阈值不应设置得太低。同时,可以手动检索相似的单词以确保准确性。有关相似的单词检索,请参阅白子玉:文本分类在5天内征服你-第1天单词嵌入和文本向量空间模型

如果您想了解更多关于category关键词扩展的信息,请阅读本文文章baiziyu:单一-Pass关键词扩展

4.向hanlp分词系统添加新词

(1)HanLP分类模块的分类器使用基于维特比算法的内容词分类器。详情请参阅本文文章baiziyu:hanlp-分类模块的分词器

(2)有关hanlp分词的详细过程,请参阅《白子玉:hanlp停止列表的使用》

(3)自定义用户叙词表,请参考白子语:hanlp-自定义用户叙词表和白子语:hanlp-禁用叙词表的使用

5.各种项目下的数据净化

数据净化对于文本分类系统的效果尤为重要,当分类系统的效果特别差(准确率低于70%)时,我们经常尝试各种算法或改进方法我们必须直接从语料库开始,因为如此低的准确度只能表明类别之间的数据在主题上重叠。此时,净化各个类别下的数据非常重要,即我们应该将文本的主题集中在每个类别下,而不是sam下有多个主题的文本e类,或同一主题的文本分散在多个类别中

数据净化有两个步骤。步骤1过滤掉不属于某个类别的文本,步骤2将过滤后的文本放入适当的类别。当数据足够时,直接过滤掉过滤后的文本,因为步骤2可能会使训练数据更加混乱

当然,过滤文本的方法是使用category关键词.如果文本收录超过1(2)个类别关键词,则将保留该文本,否则将对其进行筛选

另一种辅助净化方法是对每个类别下的文本进行聚类,并过滤掉小聚类中的文本

6.category系统的合理性验证

类别体系一般由用户指定,如果类别体系本身有相似的类别,即同一主题上有多个类别,则需要合并该类别,采用分层分类体系;另一方面,如果一个类别收录多个主题,则类别nEED被划分为多个子类别。简言之,对于某个级别的分类模型,所有类别都是直接相关的,以下主题不能重叠,每个类别中的主题都应该集中

主要使用混淆矩阵,如果混淆矩阵的一列中只有一个非零值元素,且该元素位于对角线上,则表示对角线元素对应的类别已经合适,类别下的数据已经纯净

本节要录制的学习视频

结合5天的内容,构建了一个工业多类别文本分类系统