搜索引擎禁止的方式优化网站(,一个网站使用ROBOTS文件的禁止机制是什么?如何设置)

优采云 发布时间: 2021-09-17 19:06搜索引擎禁止的方式优化网站(,一个网站使用ROBOTS文件的禁止机制是什么?如何设置)

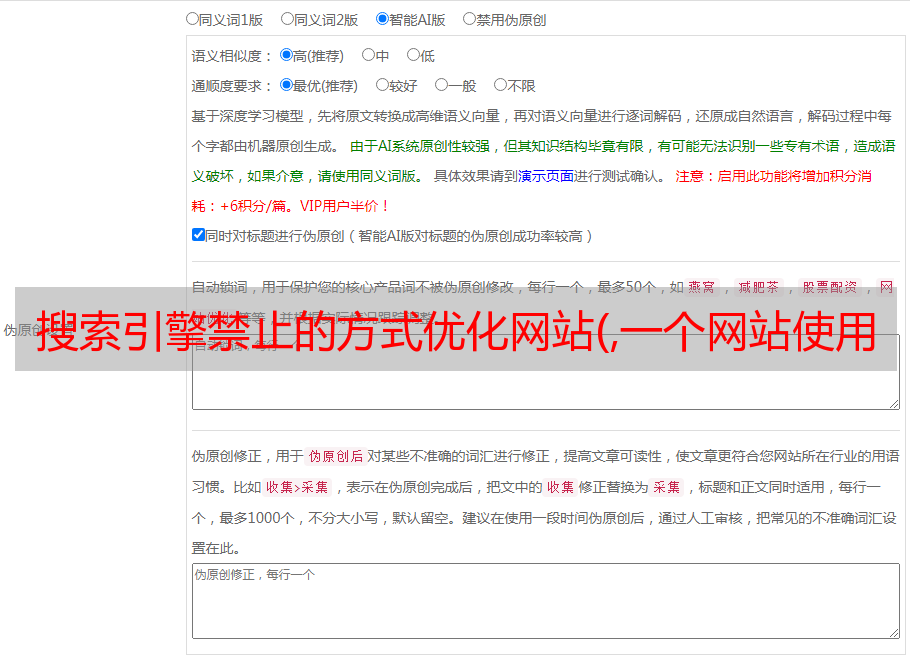

很多时候,网站内容不希望被搜索引擎捕获并显示在搜索结果中,例如网站后台管理页面、一些付款页面、登录页面等。此时,在制作网站时,我们应该学会正确使用robots文件或配对robots标签

机器人文件的禁止机制

当搜索引擎到达一个站点时,它将首先检查网站的根目录中是否有robots.txt文件,这是一个文本文件。它用于告诉搜索引擎网站的内容或特定部分不希望被搜索引擎捕获,因为许多页面对排名或涉及网站隐私的部分没有意义。如果找不到文件或其中的内容为空,搜索引擎会认为网站中的所有内容都可以自己访问和捕获

关键字段是用户代理:通常使用*表示所有搜索引擎,也可以指定特定搜索引擎的爬行器。不允许:在指定的文件目录之后写入禁止访问收录的文件目录。如果没有写,就意味着它是允许的。应该注意的是,如果有多个目录,它们必须单独编写。每个不需要收录的页面都使用一个不允许的

目前,大多数搜索引擎都会遵守此指令,但此指令禁止的页面的URL也可以以URL的形式收录在搜索结果中。如果您希望URL根本不出现,最好在页面上使用meta robots标记。因此,建议所有正在进行网站构建的朋友根据自己的需要进行设置,千万不要设置错误

元机器人标签的禁止机制

此标记是网页的元标记。它的主要功能是使搜索引擎不索引此页面的内容。meta的名称是robots,内容是搜索未跟踪的内容。例如,以下各项:

Noindex:让搜索引擎不要索引此页面

Nofollow:让搜索引擎不跟踪此页面上的链接

Noarchive:使搜索引擎不显示网页快照

这里需要强调的是,在使用Noindex之后,页面仍然可以被捕获,并且不会被索引,但是搜索引擎仍然可以跟踪网页上的一些链接,并通过链接传递权重

上海网站制作小编:很多时候,业内的一些朋友会因为记忆错误或理解力差而犯错。这里提醒你要注意这一点

本文由()原创editor转载。请说明

之前:网站应该避免在生产中优化搜索引擎。下一步:要打造一个“高大”的专业人士网站需要了解搜索引擎的高层指令

相关新闻