【5118大数据剖析工具】干货!关键词库能够做*敏*感*词*原创生产线?

优采云 发布时间: 2020-08-25 03:44【5118大数据剖析工具】干货!关键词库能够做*敏*感*词*原创生产线?

01、建立基础词库

大部分中级SEO在步入一个行业时,第一件事情就是打算好该行业的一个词库,不断地建立和维护。当然这个工作不可能做到完全自动化,你可以利用一些外部挖掘关键词的工具,例如:百度的竞价后台的关键词推荐功能,或者是借助5118的关键词挖掘的导入Excel功能。

例如:我要研究seo行业,那么我都会搜索seo,来瞧瞧seo行业什么词汇是热门的,将这种热门词装入基础词库通过5118的长尾词导入功能,获得的Excel表,如下图:

将这种关键词整理到自己的关键词管理系统,有了海量的基础关键词后,我们便可以开始做打算数据源的工作了。

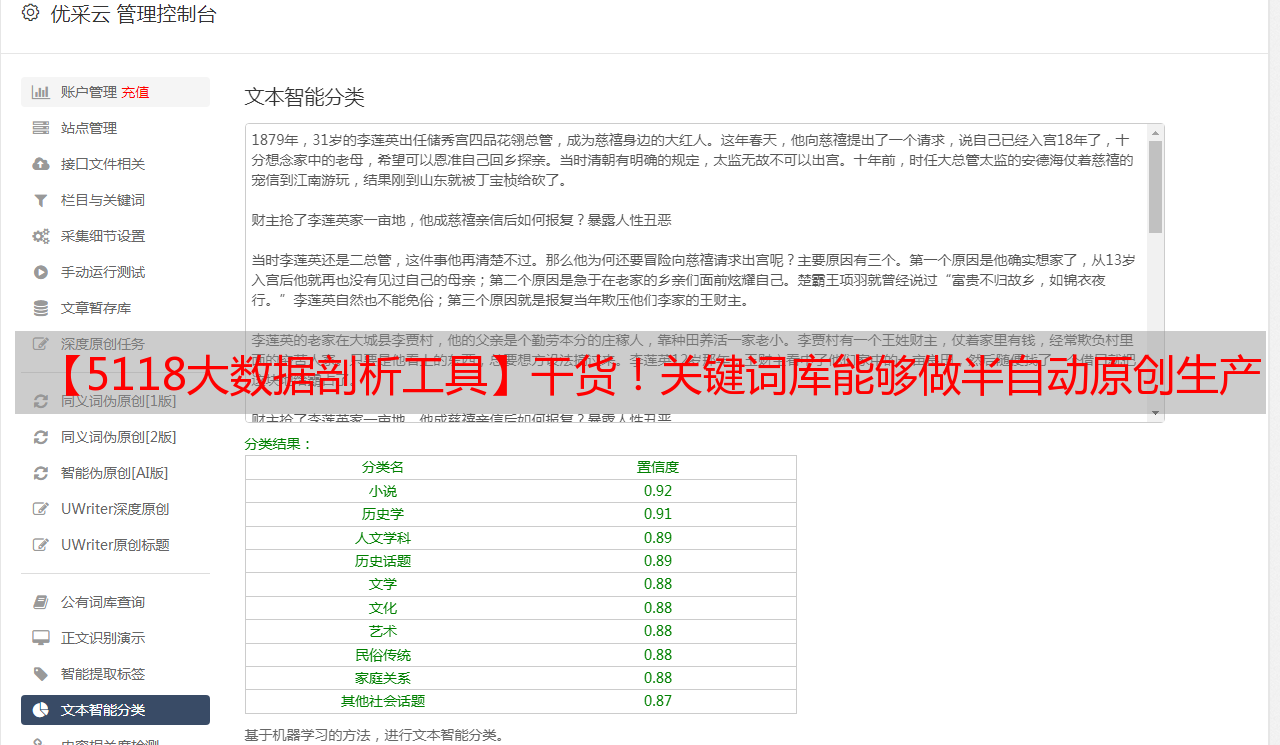

(上图是5118为顾客订制的一套系统,其中的关键词和素材的相关统计。列表还显示等待审批的素材多少,7天内该词的素材是多少。)

02、寻找文章和资讯采集源

有了海量的行业基础关键词,我们就要利用这种关键词,来找寻对口的数据源了。

● 如果你营运的是垂直B2B网站,你的数据源可以是1688、慧聪等这种大牌的B2B网站,或者垂直行业网站。

可以通过采集这些数据源的爬虫程序,让爬虫将你打算的行业关键词库的每位词装入到这种数据源中进行搜索,这样就得到大量的产品、厂家和文章。这样通过不断积累数据源爬虫,这些爬虫每晚将会源源不断的从几十个数据源获得数据,慢慢的你的B2B网站就将拥有大量的数据。

当然那些数据最好才能通过去重处理,同时一些低质量的,或者没有图片的可以通过程序手动过滤掉。

● 如果你营运的是娱乐类的网站,你的数据可以是陌陌、今日头条这种海量的数据源。

通过爬虫将关键词装入搜狗陌陌搜索和明日头条的引擎中搜索,这样你将每晚获得数以千计的文章。

因为陌陌的文章相对比较封闭,不象互联网上的文章会立刻被大量转载,所以陌陌的文章如果你能第一时间获取到,将会更容易当成原创被收录。

03、通过爬虫从素材采集源搜集素材

当我们制做了大量的素材采集源的爬虫后,我们将会获得海量的围绕基础词库的文章,这些就是我们日后拿来做伪原创的素材。

当然假如你不做伪原创也没问题,不过要被百度认可,那就不是一件容易的事情,除非你还能第一时间将文章提交给百度,让百度觉得你真正的原创。

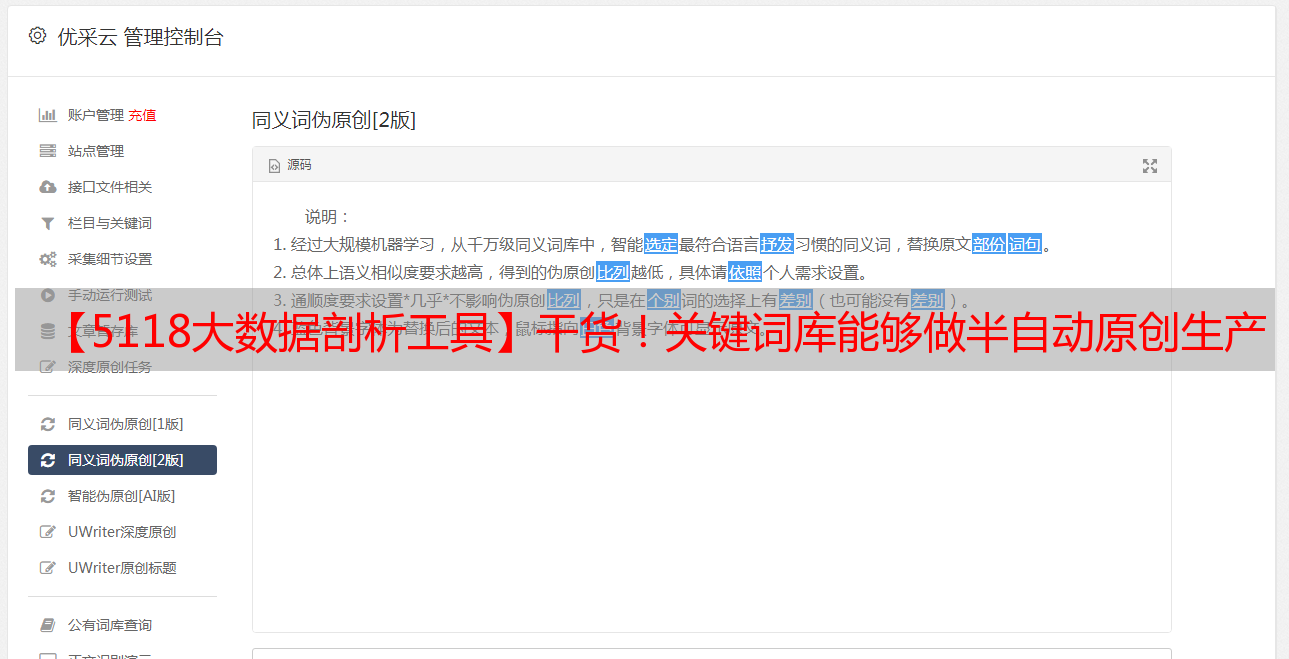

(图为5118为SEO服务商制做的资讯管理系统)

04、素材库整合

编辑人员可以通过素材库整合,完成明日的原创发布原创。

爬虫将文章源源不断地汇入文章素材库,这个时侯通过文章素材管理系统,编辑人员就可以开始有目的的,将几篇有关联的文章整合成一篇文章。

通过手工编辑,以及词汇的替换,同时可以通过百度图片和优酷视频等外部资源,将一些更高价值的内容刚好的这篇文章中。

这样一来,编辑人员就不单单是简单的码字,而是可以对互联网上的资源进行整合。

甚至百度图片和优酷视频都可以作为第三步的素材源。

这样一来,编辑人员的工作脱离了冗长的搜集,既不会倍感无趣。同时,通过整合大大提高了文章价值,也大大提升了工作性质的满足感。于是,前面说到的那种“蝴蝶效应”就完美破解了!

以上就从词库到数据源,再到素材,再到编辑整合的大致流程。

这个流程5118早已实践于数以百计的各种网站后台,让那些网站可以从繁杂而乏味的内容编辑工作中解脱下来,通过人工的参与,而非单纯的采集,实现了更高的价值。

例如:百度百科,实际上百度百科上的信息早就在互联网上,但是通过一个有组织的整合,百度百科的价值就远远超过了零散的信息。说到这儿,你明白了吗?

作为一个聪明的SEO从业人员或则领导,可不要小看了这些日积月累的力量。内容为王的时代,沉下心整合出用户喜欢的内容,比起不断重复的复制,采集,垃圾伪原创,要更有价值的多。

数以百计的网站通过5118正在用这些方法进行着内容维护,你落伍了吗?