百度搜索引擎优化原理( 搜索引擎如何对页面代码文本进行分析判断?(图))

优采云 发布时间: 2021-09-15 14:07百度搜索引擎优化原理(

搜索引擎如何对页面代码文本进行分析判断?(图))

搜索引擎原理对搜索引擎优化的启示

网站页面捕获

当我们的网站发送新内容后,蜘蛛会在一段时间后来抓取我们的页面内容。我们看到的表现是我们的页面是收录(当然,有些情况下收录不可用,这里没有首先提到)。这里涉及到两个主要操作,页面爬行和页面复制收录. 今天我想分享一下百度的收录机制,也就是搜索引擎的原理

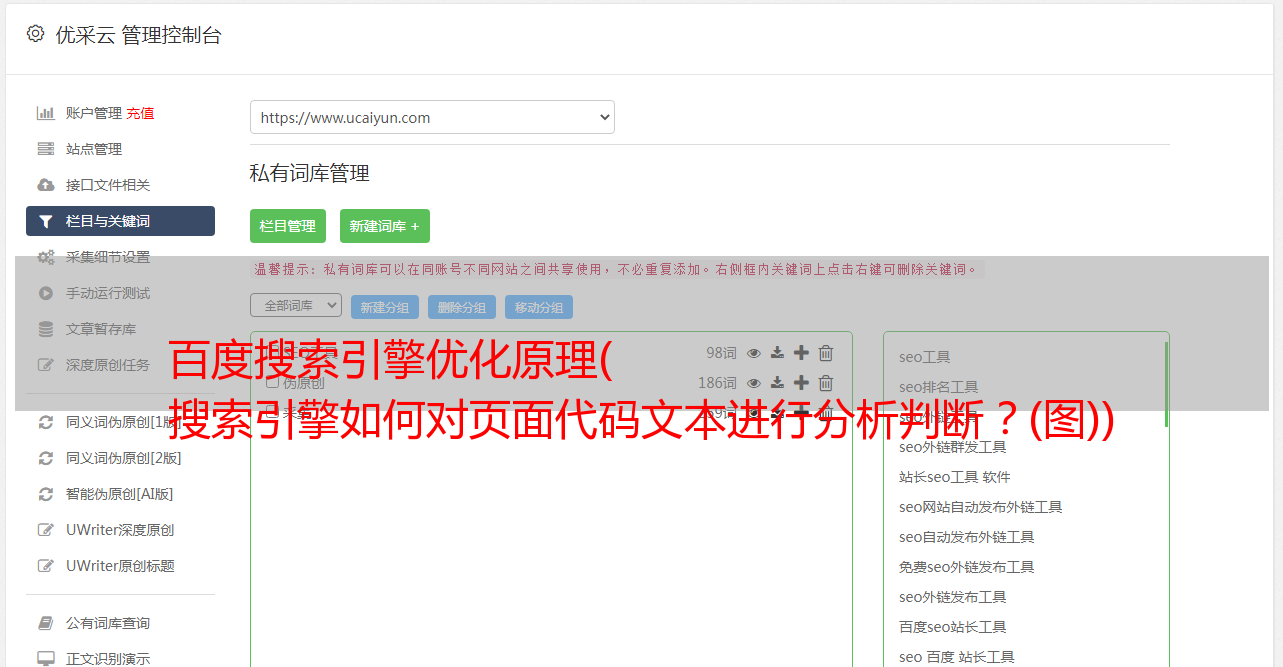

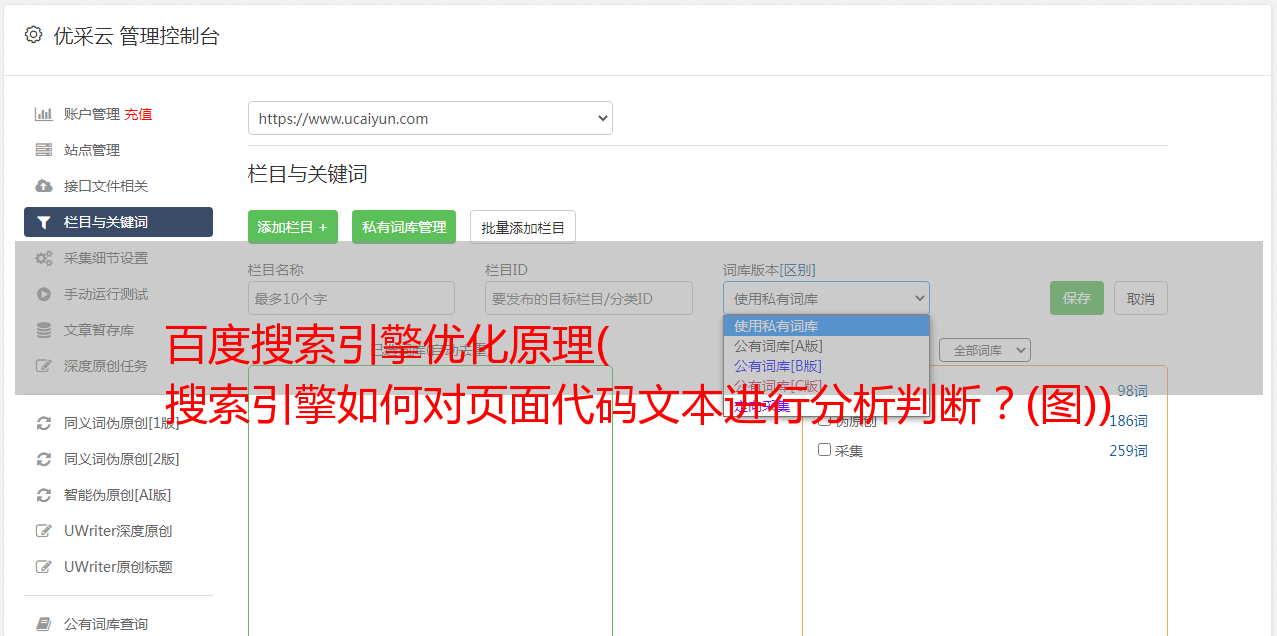

在我们看来,页面是这样的:

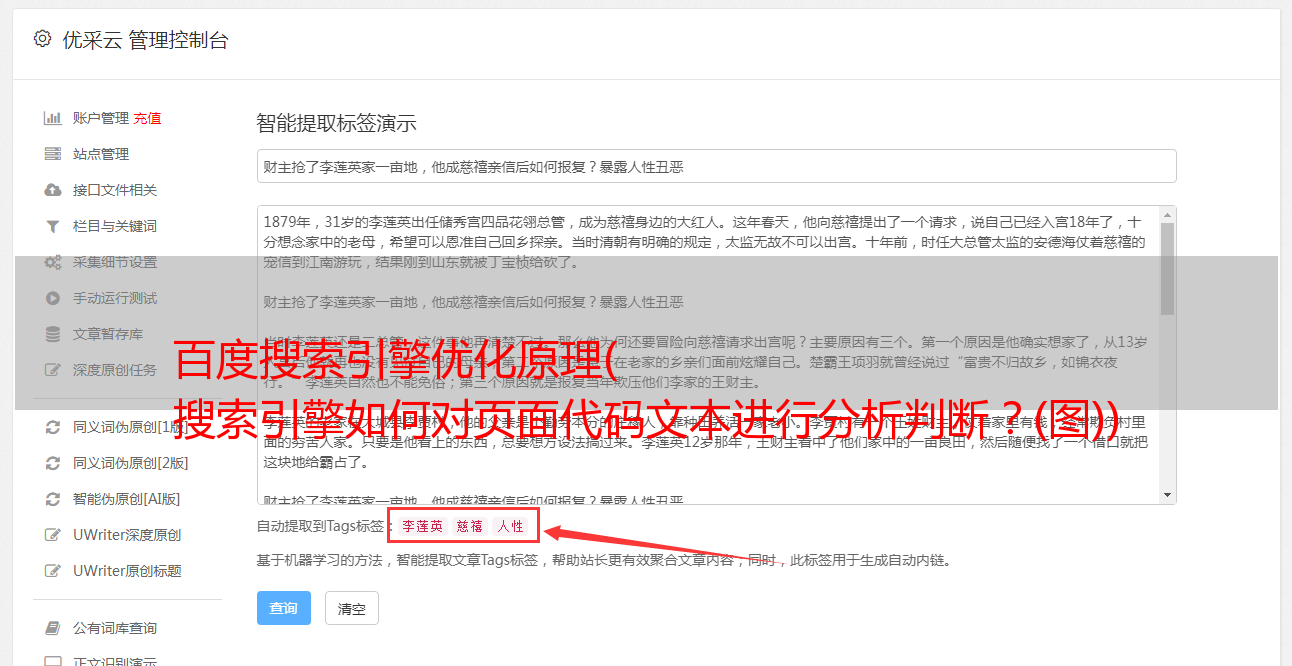

但是我们知道这样的页面是由浏览器解析的,用户可以看到效果。当搜索引擎判断时,页面实际上应该是逐行的。计算机通过代码0101识别任何计算机语言。如下图所示:

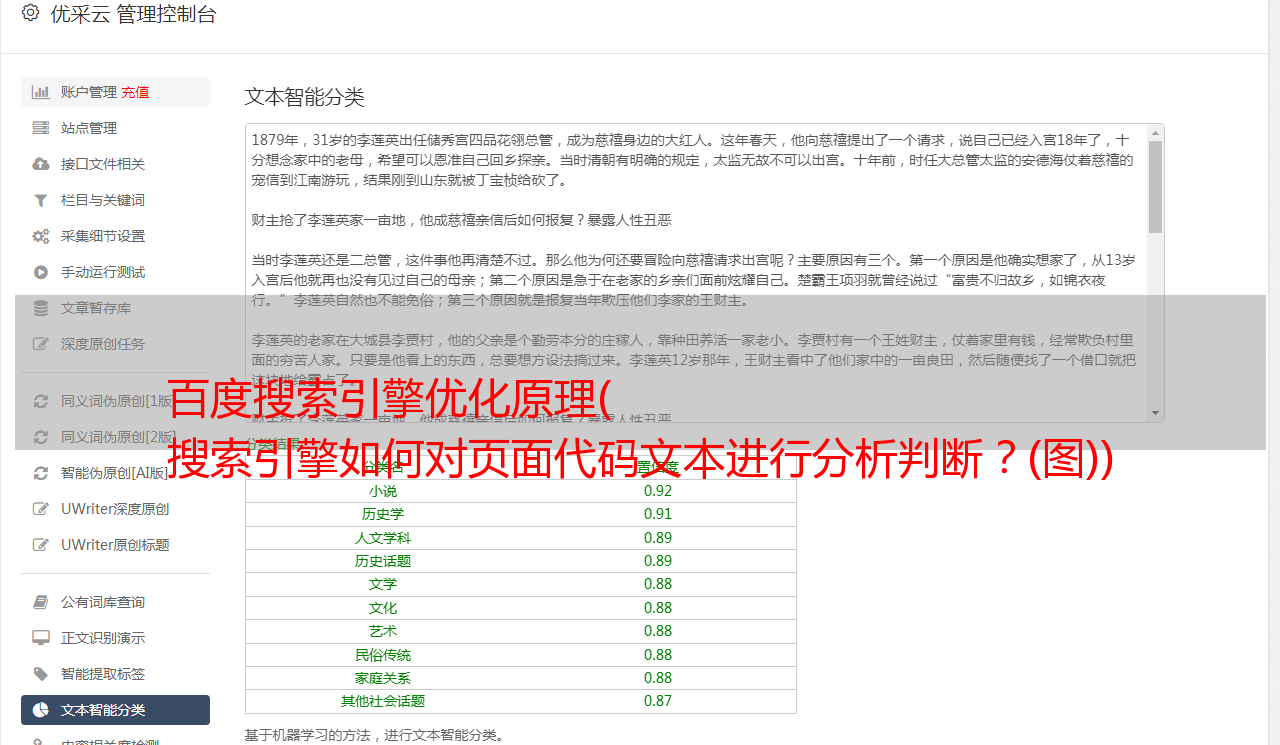

搜索引擎分析和判断这些页面代码文本到收录our网站,并给出排名(这里的分析和判断是我们今天内容分享的重点)。排名表实际上是这样一个数据库列表:

该表存在于搜索引擎数据库中,所有排名机制的最终体现在该表中

具体来说,我们可以在水平数据表中列出这样一个表,这是我们搜索引擎排名的显示形式:搜索搜索引擎优化(SEO)一词时出现的排名:

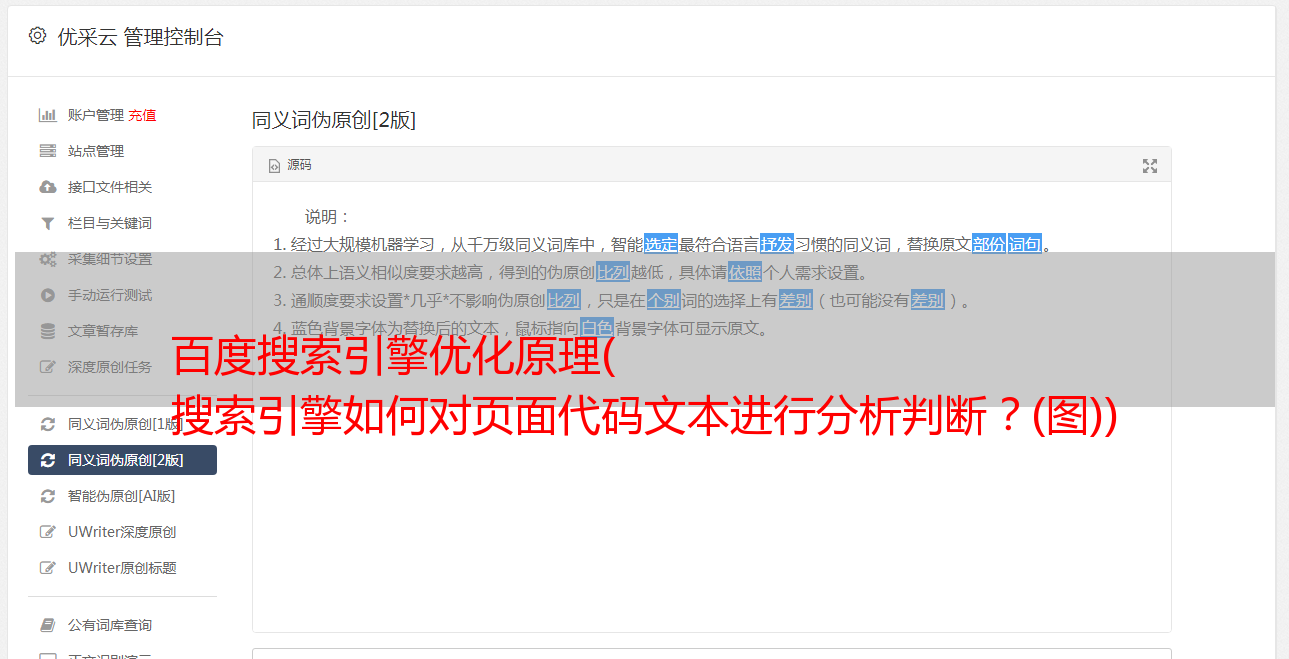

在了解了整个搜索引擎的过程之后,让我们关注一下搜索引擎如何分析和判断页面代码文本

在正常情况下,我们经常会说,我们想发出链条,吸引蜘蛛,对吗?领先蜘蛛的概念是一个隐喻,网站管理员生动地描述了蜘蛛在网页上爬行的过程。事实上,在这里引入蜘蛛也存在误解。例如,让我们转到A5并发布一篇文章软文. 一般的理解是,当蜘蛛爬到A5上的软文页面时,它会通过页面上留下的链接爬到我们的网站页面,对吗?你明白吗?事实上,这不是一个原则

当爬行器在A5上找到这篇软文文章时,它会将这些链接放入URL地址索引数据库(即与前面的表类似的表),首先放入,然后在一段时间后抓取与要捕获的URL对应的页面

也可以理解,在找到A5上面的软文文章后,搜索引擎将记录页面中的所有链接,然后将spider发送到这些URL对应的页面进行抓取和计算

当我们在这里谈论蜘蛛时,我们也应该提到它们。我们理解这样的蜘蛛吗

但事实上,蜘蛛是深棕色的:

为什么??因为爬行器类似于浏览器。当我们使用浏览器访问URL时,浏览器会向服务器发送请求。收到请求后,服务器将数据传输到浏览器,然后在浏览器中解析并显示页面。蜘蛛的工作原理是相似的。如上所述,搜索引擎在A5中记录从页面提取的URL后,会发送一个爬行器进行爬行。爬行器还向浏览器发送请求。服务器将页面数据发送给spider,spider可以加载页面,从而获取页面信息并进行深入计算

现在,你对搜索引擎和蜘蛛有了新的认识吗

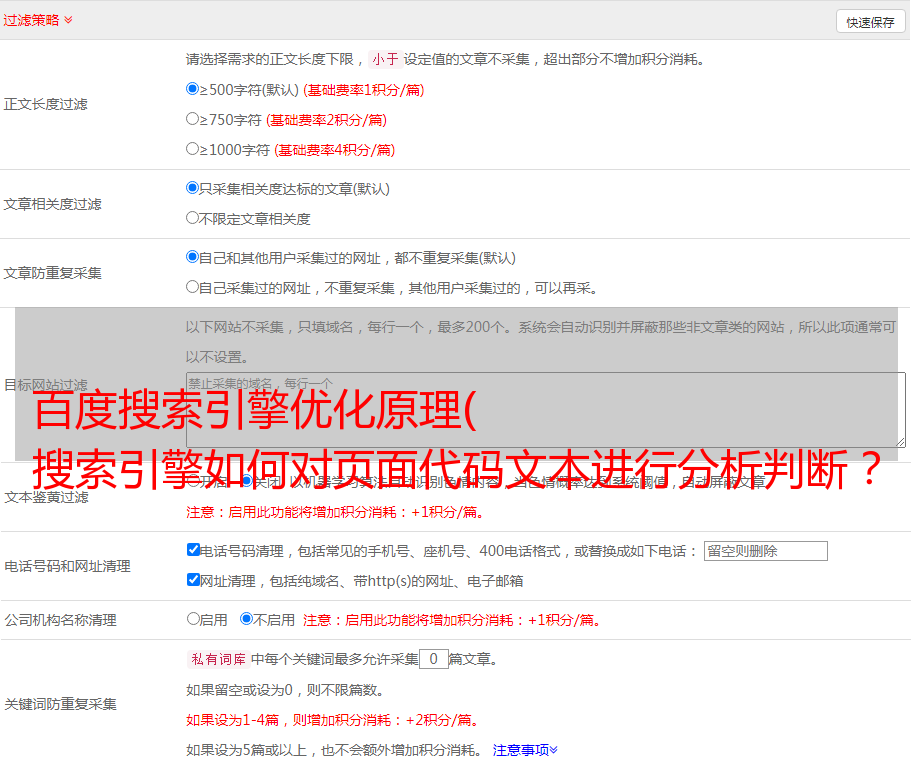

我们讲过,蜘蛛获取页面信息后,会再次放入百度数据库进行系统判断,我们称之为“深度处理”。这里将涉及各种算法,就像几层屏幕和逐层过滤一样

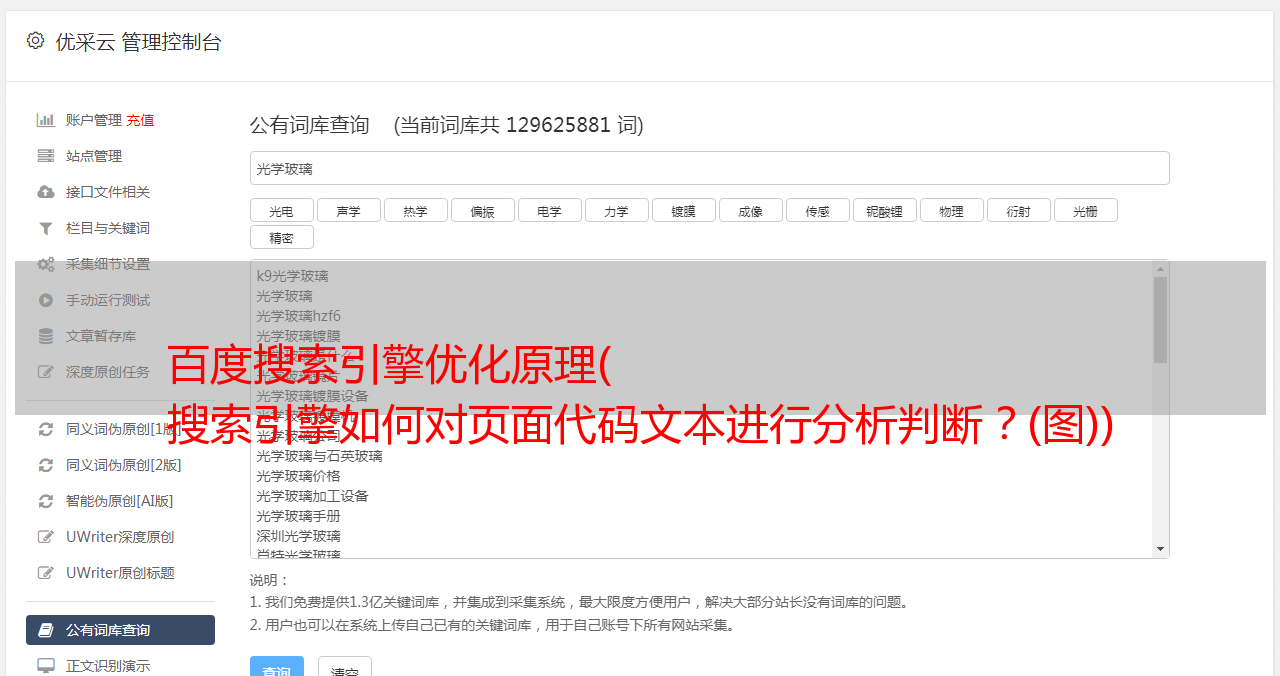

搜索引擎计算并分类软文A5中的所有链接,然后对它们进行详细分类,并将它们放入这样一个数据列表中

这是什么样的名单?这是分类表。分类基于显示的URL链接对应的根域名。例如,软文中有几个链接:

这将把链接记录放在根域名下。这样,经过一段时间的循环计算,整个互联网会通过这个列表计算出你根域名对应的内部页面收录的数量?有效外部链的数量是多少?这会直接影响你的网站排名

这里我们可以导出几个概念。第一个概念:如果我们网站执行非法操作,或者这里的记录值没有记录当前值,导致有效页数减少。这里我们包括我们自己的收录数量网站和有效外链的数量。或者直接删除列表并将所有数据重置为零。这是一个被严重K的案例。因此我们遇到了一些被惩罚的案例,其中网站all data为0,即列表被删除。你了解一些搜索引擎的原理吗

扩展点2:独立站点具有独立的记录值列表。同样,次要域名也是一个独立的URL。它也有自己的独立记录列表。Suuny昨天在微信上问了我类似的问题。这就是答案。搜索引擎还将次要域名作为独立站点进行调查。还有一个数据值记录列表。我们传统的二级域名方法将有大量链接与主域名站进行交互。这也是一种误解。大量的互动。如果一个车站右转,其他车站也将参与其中。因此,如果你想做站群,并使用辅助域名做站群,你应该作为你的独立站点来做。尽量不要在站点之间进行交互,即链接

扩展点3:

如前所述,搜索引擎提取页面中的所有URL,并将它们放入列表中一段时间,然后发送爬行器抓取它们。为什么需要一个周期?你想过这个吗

蜘蛛不能一直抓取网页,因为搜索引擎的资源是有限的。面对巨大的页面数据,搜索引擎会太忙吗?因此,设置一个周期可以合理分配搜索引擎的资源。同样,由于谷歌的资源,无论是计算速度还是存储空间,都比百度好得多,你有没有发现大多数网站Google收录比百度收录多得多?对吗?导致谷歌和百度之间差异的不是算法,而是资源收录外链数量的问题。这些数据的差异会影响我们的排名

扩展点4:我们通常认为网站的物理结构很深,这不利于蜘蛛的抓取。因此,我们提倡扁平树网站结构。事实上,这里也有一个误解。我们主张清晰的物理层和浅层可以提高爬行器的爬行效率,但许多页面仅仅因为网站结构而无法爬行。让我们看看这样一页。物理结构是我们存储此页面的位置和路径。在FTP中,我们将此页面存储在:

¥%%.html

如果URL太长,文件将不会存储在数据库中。(因为路径太长,使用过数据的学生会知道,当我们的路径太长且数据名太长时,数据库会报告错误或数据不会存储。)这是关键。这将导致我们的页面不可用收录. 原因很简单。路径太长,无法存储。URL优化应尽可能使用短字符来标准化网站URL路径。当然,要做好物理结构的调整,合理布局,而不是传统的物理结构调整

扩展点5:

每个域名都有相应的爬网频率。默认情况下,此捕获频率是百度给出的综合默认值,用于判断您的网站更新频率、带宽、访问者数量和其他数据。当然,此值可以手动控制。百度站长平台,抢压

在这一点上,我不打算继续谈论搜索引擎的原理。为什么?因为搜索引擎的原理是一个庞大的系统概念。不可能包罗万象。你说得越多,你就越不明白。问题太多了,连人都睡不着。让我们先了解一下最基本的知识

现在总结一下以上内容:

你今天收获很多吗?至少我们知道这些因素:

一,。为什么URL地址需要规范化

二,。蜘蛛抓取网站的频率是可控的

三,。为什么所有的搜索引擎操作都需要一个时间周期

四,。蜘蛛的形状和工作原理是什么

5、网站为什么降级或处罚时数据量会减少

当然,如果你继续学习,你会发现很多细节。我想说的是,搜索引擎优化是一门系统的学科。你可以看到其他人如何操作很多事情,但你必须找出你为什么需要这样做?这个原则是什么?这样做的好处是什么?它是?如果每个人都有这样的思维方式来思考我们接触到的SEO知识,那么获取信息的方式和速度就会比其他人更好。因为你找到了方向,找到了重点。那么你的进步会更快

现在让我们来讨论几天前的一个热门话题:#新浪博客节能#

在讨论减少新博客权利的话题之前,我们来考虑一下这个问题:百度是如何获得所有行业的流量的?这是一个简单的问题吗?排名对

百度给业界最大受众群体的网站最佳排名,那么它就会解决这个问题。因为对于用户来说,他们有一个搜索习惯。即使他们知道网站的域名:如果他们不去地址框直接输入URL,他们需要百度。我们知道