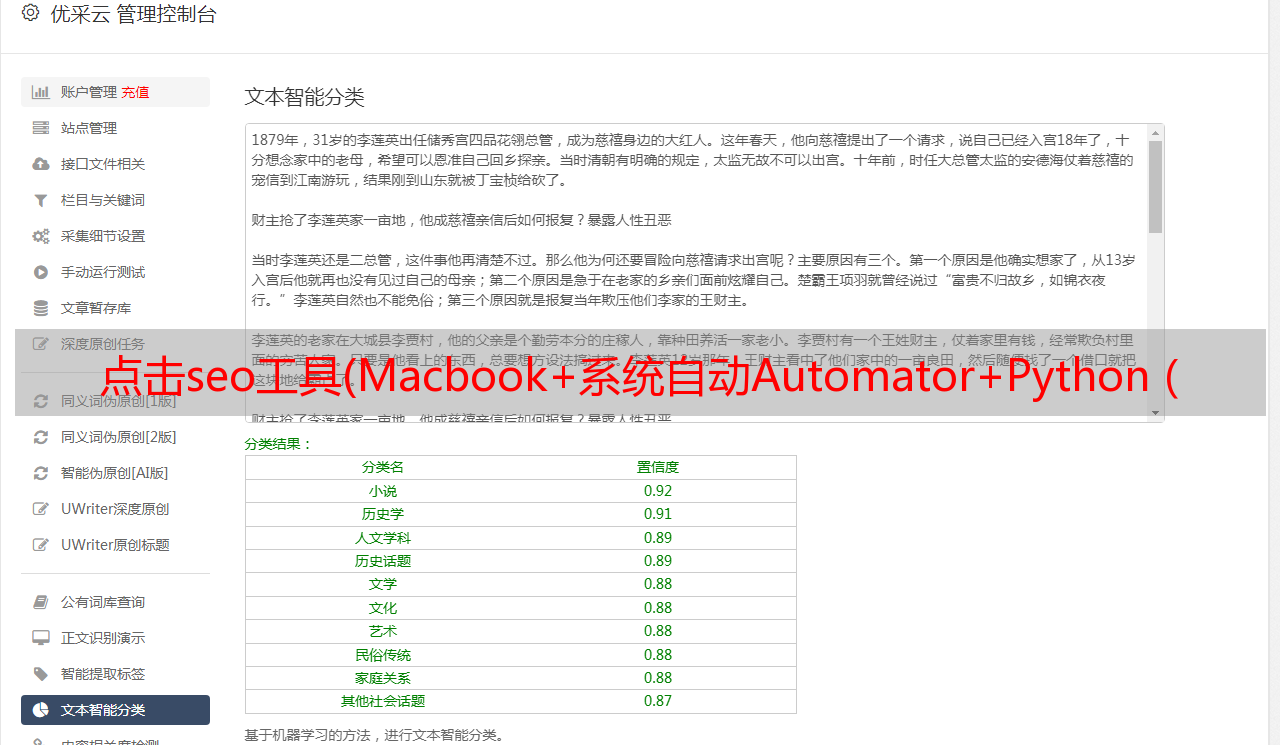

点击seo工具(Macbook+系统自动Automator+Python(或代码实现按网址查流量))

优采云 发布时间: 2021-09-15 14:03点击seo工具(Macbook+系统自动Automator+Python(或代码实现按网址查流量))

也许是因为专业原因,每次我看到一个网站,我都对它的流量感到好奇。我不知道你是否和我一样

此时,一般做法是打开爱站网络,进入网站进行查询

284.jpg

对其他人来说,这可能不是一个很大的需求,但我只想简化这个过程

我以前考虑过一个解决方案:制作一个浏览器插件。如果要查看当前网站流量数据,请单击弹出窗口以显示该数据

理论上,这种方法是可行的,但研究chrome插件开发需要时间

后来,我选择了一个可以实现类似效果的变通方法,并从浏览器中退出

工具实现思想

预期效果

复制任意网址(不一定是网站主页),然后按快捷键自动提取域名(可以转到子域名级别),提交给爱站网络查询,然后将结果返回到弹出窗口

经过仔细研究,结果如下:

822.jpg

如何实现

开发环境:MacBook+系统自动化+python(或PHP)

通过URL检查流量的Python代码

<p># coding = utf-8

__author = 'joe'

# 导入 requests库,一般简单采集都推荐使用这个库

import requests

# 导入BeautifulSoup做DOM解析,避免有些网站代码不规范让lxml不好用

from bs4 import BeautifulSoup as bs

# 导入正则库

import re

# 导入随机数库

import random

# 这个库可以从URL中解析域名

from tld import get_tld

# 判断是否为URL的库

import validators

# 导入系统库

import sys

import io

# 解决编码问题

sys.stdout = io.TextIOWrapper(sys.stdout.buffer,encoding='utf-8')

# 定义一个获取HTML代码的方法

def get_html(url):

# 定义http的请求Header

headers = {}

# random.randint(1,99) 为了生成1到99之间的随机数,让UserAgent变的不同。

headers['User-Agent'] = "Mozilla/5.0 (Windows NT 5.1; rv:31.0) Gecko/20100101 Firefox/31.0" + str(random.randint(1,99))

# Referer地址使用待查询的网址

headers['Referer'] = url

# 如果是一个URL,则执行

if validators.url(url):

# 通过URL获取域名

domain = get_tld(url)

# 构造爱站网查询地址

aizhan_url = "http://baidurank.aizhan.com/baidu/" + domain + "/"

# 发送请求,获取页面HTML

html = requests.get(aizhan_url, headers = headers, timeout=10).text

# 输出网址域名

print("网站:" + domain)

# 分析页面元素,提取需要字段

get_data(html)

# 更多内容查看爱站

print("更多查看:" + aizhan_url)

else:

# 提示错误URL

print("wrong url")

# 定义提取页面元素的方法

def get_data(html):

# 使用lxml解析器,这样效率更高

soup = bs(html, "lxml")

# 提取页面中的总流量数据

all_pv = soup.select("span.blue")[0].get_text()

# 提取页面中的总PC流量数据

pc_pv = soup.select(".ip strong")[0].get_text()

# 提取页面中的总移动流量数据

mobile_pv = soup.select(".ip strong")[1].get_text()

# 提取PC权重

pc_weight = soup.select(".fl .br strong")[0].get_text()

# 提取移动权重

mobile_weight = soup.select(".fl .br strong")[1].get_text()

# 提取PC关键词量,数值越大,说明网站越强

pc_words = soup.select("a#cc1 strong")[0].get_text()

# 提取M关键词量,越大越好

mobile_words = soup.select("a#cc2 strong")[0].get_text()

# 下面是输出

print("总流量:" + all_pv)

print("PC总流量:" + pc_pv)

print("M总流量:" + mobile_pv)

print("PC权重:" + pc_weight)

print("M权重:" + mobile_weight)

print("PC关键词量:" + pc_words)

print("M关键词量:" + mobile_words)

print("流量大的目录:")

# 循环读取流量大的目录URL,显示5条。

for index,item in enumerate(soup.select("ul.urlpath li a")):

if(index